Как найти robots txt

Найти robots.txt можно, задав в адресной строке браузера фразу — /имя_вашего_сайта/robots.txt (рис.1).

Рис.1 Найти файл robots txt можно через браузер

Откроется страница с содержимым файла robots txt (рис.2).

Рис.2 Найти robots txt и посмотреть можно в браузере.

Так вы можете найти и просмотреть файл robots.txt.

Конечно, файл robots.txt должен быть предварительно создан и помещен в корневую папку сайта на сервере, где он собственно и находится.

Таким способом вы можете найти robot txt, но не сможете его изменить.

Для того, чтобы внести изменения в файл, нужно его найти и открыть непосредственно на сервере.

Итак, файл robots.txt находится в корневой папке на сервере провайдера. Соответственно, для того чтобы найти его, нужно войти в панель управления на сервере, далее открыть корневую папку вашего сайта и… найти файл robots.txt.

Здесь, в корневой папке, находятся все файлы вашего сайта, в том числе и файл robots.txt (рис. 3)

Рис.3 Где находится файл robots.txt – корневая папка сайта.

Таким образом, если нужно найти и просто просмотреть файл robots txt, то это можно сделать через браузер, задав адрес имя_сайта/rodots.txt.

Если вам нужно не только просмотреть, но и изменить файл robots.txt, то нужно зайти на сервер провайдера и открыть корневую папку сайта, где и находится файл robots.txt.

Найдя и открыв файл robots.txt, можно будет его изменить. Наиболее часто подвергается изменению директива disallow robots txt.

Где находится файл robots.txt в wordpress, где лежит и как найти

Если вы посетили эту страницу тогда вас интересует где находится файл robots.txt в WordPress. С данной проблемой обычно сталкиваются чайники в WordPress. После прочтения короткой статьи вы выясните все что вам нужно знать.

По большому счету я могу написать просто «Файл расположен в корневой директории сайта». Увы этот ответ удовлетворит лишь часть посетителей, не все знают о «корнях» и тому подобном. По этому давайте все разберем, как в первый раз.

Как проверить существует ли файл robots.txt

Сперва проверим есть ли нужный файл вообще, для этого вписываем в строке браузера адрес-сайта.ru/robots.txt, если документ откроется, и вы увидите текст на английском, примерно такого рода:

Значит все в порядке, файл существует, в противном случае, скорее всего, отсутствует, или находиться не там где нужно, его потребуется создать.

Давайте для начала определимся как вам удобно работать с файлами сайта. Для этого существует несколько способов. Первый не очень удобный, но зато более привычен для любителей Windows — это программа на вашем хостинге, с помощью которой вы создаете и удаляете файлы и папки своего сайта. Выглядеть это все дело должно примерно так:

В папке WWW/ВАШ-САЙТ должны быть папки wp-includes, wp-content, wp-admin ниже них расположен нужный вам файл роботс. Один способ разобрали, можно идти к следующему.

Если вы умеете пользоваться FTP, тогда заходим в соответствующую программу на вашем компьютере и переходим на ваш сайт, проходим тот же путь по папкам что в примере выше и находим необходимый документ.

Файл robots.txt в WordPress должен лежать именно в той же папке, что и wp-includes, wp-content, wp-admin. Не ищите его в других местах, его либо там нет либо он там валяется без толку, роботы его не найдут.

Создать правильное руководство для поисковых систем поможет эта статья.

Как настроить robots txt для сайта WordPress. Как создать robots txt для WordPress

От автора: одним из файлов, которые используют поисковики при индексации вашего сайта, есть файл robots.txt. Не сложно понять из названия файла, что он используется для роботов. И действительно, этот файл позволяет указать поисковому роботу что можно индексировать на вашем сайте, а что вы не хотите видеть в поисковом индексе. Итак, давайте посмотрим, как настроить robots txt для сайта WordPress.

Статей на эту тему в сети множество. Практически в каждой из этих статей можно найти свой вариант файла robots txt, который можно взять и использовать практически без правок на своем сайте WordPress. Я не буду в очередной раз переписывать в данной статье один из таких вариантов, поскольку особого смысла в этом нет — все эти варианты вы без труда сможете найти в сети. В этой же статье мы просто разберем, как как создать robots txt для WordPress и какой минимум правил там должен быть.

Начнем с того, где должен располагаться файл robots.txt и что в него писать. Данный файл, как и файл sitemap.xml, должен быть расположен в корне вашего сайта, т.е. он должен быть доступен по адресу http://site/robots.txt

Попробуйте обратиться по такому адресу, заменив слово site адресом вашего сайта. Вы можете увидеть при этом примерно такую картину:

Как создать сайт самому?

Какие технологии и знания необходимы сегодня, чтобы создавать сайты самостоятельно? Узнайте на интенсиве!

ЗарегистрироватьсяХотя можете увидеть и вот такую картину:

Странная ситуация — скажете вы. Действительно, адрес один и тот же, но в первом случае файл доступен, во втором — нет. При этом если заглянуть в корень сайта, то никакого файла robots.txt вы там не обнаружите. Как так и где же находится robots.txt в WordPress?

Все дело в простой настройке — это настройка ЧПУ. Если на вашем сайте включены ЧПУ, тогда вы увидите динамически сгенерированный движком robots.txt. В противном случае будет возвращена ошибка 404.

Включим ЧПУ в меню Настройки — Постоянные ссылки, отметив настройку Название записи. Сохраним изменения — теперь файл robots.txt будет динамически генерироваться движком.

Как видно на первом рисунке, в этом файле используются некие директивы, задающие определенные правила, а именно — разрешить или запретить индексировать что-либо по заданному адресу. Как несложно догадаться, директива Disallow запрещает индексирование. В данном случае это все содержимое папки wp-admin. Ну а директива Allow разрешает индексирование. В моем случае разрешено индексирование файла admin-ajax.php из запрещенной выше папки wp-admin.

В общем, поисковикам этот файл, конечно, без надобности, даже и не представляю, из каких соображений WordPress прописал это правило. Ну да мне и не жалко, в принципе ![]()

К слову, я специально добавлял выше фразу «в моем случае «, поскольку в вашем случае содержимое robots.txt уже может отличаться. Например, может быть запрещена к индексированию папка wp-includes.

Кроме директив Disallow и Allow в robots.txt мы видим директиву User-agent, для которой в качестве значения указана звездочка. Звездочка означает, что идущий далее набор правил относится ко всем поисковикам. Также можно вместо звездочки указывать названия конкретных поисковиков. Файл robots.txt поддерживает и другие директивы. Я на них останавливаться не буду, все их с примерами можно посмотреть в консоли для веб-мастеров Гугла или Яндекса. Также можете прочесть информацию на данном сайте.

Как создать robots txt для WordPress

Итак, файл для поисковых роботов у нас есть, но вполне вероятно, что он вас не устроит в текущем виде. Как же составить свой файл. Здесь есть несколько вариантов. Начнем с первого — ручное создание файла. Создайте обычный текстовый документ в блокноте и сохраните его под именем robots с расширением txt. В этом файле запишите необходимый набор правил и просто сохраните его в корень вашего сайта WordPress, рядом с файлом конфигурации wp-config.php.

На всякий случай проверьте, что файл загрузился и доступен, обратившись к нему из браузера. Это был первый способ. Второй способ — это все та же динамическая генерация файла, только теперь это сделает плагин. Если вы используете популярный плагин All in One SEO, тогда можно воспользоваться одним из его модулей.

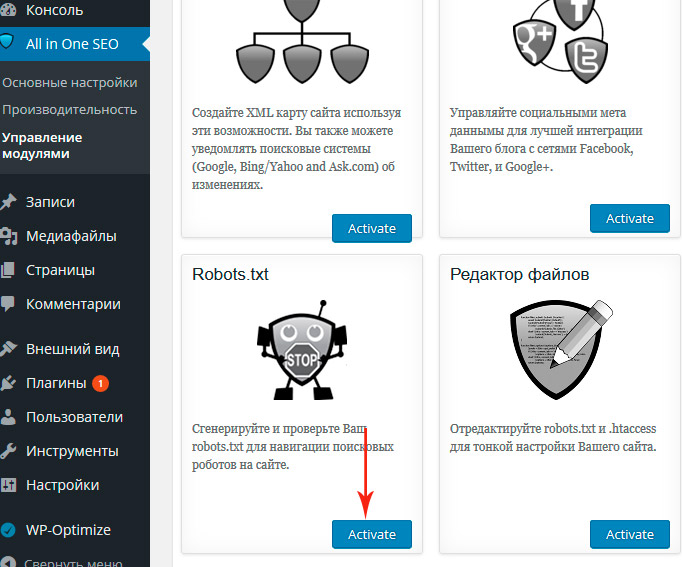

Сначала этот модуль нужно включить. Идем в меню All in One SEO — Управление модулями и активируем модуль Robots.txt.

После этого в меню плагина появится новый пункт — Robots.txt. Перейдем туда и увидим уже предлагаемый набор правил, который можно сохранить.

Давайте сохраним и проверим изменения, обратившись на сайте WordPress к robots.txt.

Как видим, все работает. Теперь вы можете написать robots txt для WordPress на свой вкус и так, как вам нужно. Ну а у меня на этом все. Удачи!

Как создать сайт самому?

Какие технологии и знания необходимы сегодня, чтобы создавать сайты самостоятельно? Узнайте на интенсиве!

Зарегистрироваться

WordPress-Ученик

12 фишек без которых Вы не создадите полноценный сайт на WordPress!

СмотретьГде находится robots.txt в WordPress? — Хабр Q&A

Добрый день. Дали сайт на вордпрессе, набираю домент site.ru/robots.txt — в нёмUser-agent: *

Disallow: /Лезу по ftp, в корне лежит robots.txt

User-agent: *

Disallow: /cgi-bin

Disallow: /search

Disallow: /author/

Disallow: *?attachment_id=

Disallow: */trackback

Disallow: */feed

Disallow: */embed

#Disallow: /wp/

Host: www.site.ruКак убрать Disallow то от всех поисковиков?

.htaccess

RewriteBase /

RewriteRule ^index\.php$ - [L]

RewriteCond %{REQUEST_FILENAME} !-f

RewriteCond %{REQUEST_FILENAME} !-d

RewriteRule . /index.php [L]

</IfModule>

# BEGIN W3TC Browser Cache

<IfModule mod_deflate.c>

<IfModule mod_headers.c>

Header append Vary User-Agent env=!dont-vary

</IfModule>

AddOutputFilterByType DEFLATE text/css text/x-component application/x-javascript application/javascript text/javascript text/x-js text/html text/richtext image/svg+xml text/plain text/xsd text/xsl text/xml image/bmp application/java application/msword application/vnd.ms-fontobject application/x-msdownload image/x-icon application/json application/vnd.ms-access application/vnd.ms-project application/x-font-otf application/vnd.ms-opentype application/vnd.oasis.opendocument.database application/vnd.oasis.opendocument.chart application/vnd.oasis.opendocument.formula application/vnd.oasis.opendocument.graphics application/vnd.oasis.opendocument.presentation application/vnd.oasis.opendocument.spreadsheet application/vnd.oasis.opendocument.text audio/ogg application/pdf application/vnd.ms-powerpoint application/x-shockwave-flash image/tiff application/x-font-ttf application/vnd.ms-opentype audio/wav application/vnd.ms-write application/font-woff application/font-woff2 application/vnd.ms-excel

<IfModule mod_mime.c>

# DEFLATE by extension

AddOutputFilter DEFLATE js css htm html xml

</IfModule>

</IfModule>

<FilesMatch "\.(bmp|class|doc|docx|eot|exe|ico|json|mdb|mpp|otf|_otf|odb|odc|odf|odg|odp|ods|odt|ogg|pdf|pot|pps|ppt|pptx|svg|svgz|swf|tif|tiff|ttf|ttc|_ttf|wav|wri|woff|woff2|xla|xls|xlsx|xlt|xlw|BMP|CLASS|DOC|DOCX|EOT|EXE|ICO|JSON|MDB|MPP|OTF|_OTF|ODB|ODC|ODF|ODG|ODP|ODS|ODT|OGG|PDF|POT|PPS|PPT|PPTX|SVG|SVGZ|SWF|TIF|TIFF|TTF|TTC|_TTF|WAV|WRI|WOFF|WOFF2|XLA|XLS|XLSX|XLT|XLW)$">

<IfModule mod_headers.c>

Header unset Last-Modified

</IfModule>

</FilesMatch>

# END W3TC Browser Cache

# BEGIN W3TC CDN

<FilesMatch "\.(ttf|ttc|otf|eot|woff|woff2|font.css)$">

<IfModule mod_headers.c>

Header set Access-Control-Allow-Origin "*"

</IfModule>

</FilesMatch>

# END W3TC CDN

# BEGIN W3TC Page Cache core

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteBase /

RewriteCond %{HTTP:Accept-Encoding} gzip

RewriteRule .* - [E=W3TC_ENC:_gzip]

RewriteCond %{HTTP_COOKIE} w3tc_preview [NC]

RewriteRule .* - [E=W3TC_PREVIEW:_preview]

RewriteCond %{REQUEST_METHOD} !=POST

RewriteCond %{QUERY_STRING} =""

RewriteCond %{HTTP_COOKIE} !(comment_author|wp\-postpass|w3tc_logged_out|wordpress_logged_in|wptouch_switch_toggle) [NC]

RewriteCond "%{DOCUMENT_ROOT}/wp-content/cache/page_enhanced/%{HTTP_HOST}/%{REQUEST_URI}/_index%{ENV:W3TC_PREVIEW}.html%{ENV:W3TC_ENC}" -f

RewriteRule .* "/wp-content/cache/page_enhanced/%{HTTP_HOST}/%{REQUEST_URI}/_index%{ENV:W3TC_PREVIEW}.html%{ENV:W3TC_ENC}" [L]

</IfModule>

# END W3TC Page Cache core

# BEGIN WordPress

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteBase /

RewriteRule ^index\.php$ - [L]

RewriteCond %{REQUEST_FILENAME} !-f

RewriteCond %{REQUEST_FILENAME} !-d

RewriteRule . /index.php [L]

</IfModule>Как создать правильный robots.txt для WordPress

Выполняю данное мною обещание, сегодня речь пойдет о том, как настроить правильный файл robots.txt для WordPress. Что это за файл такой, и насколько он важен для сайта или блога я писал в недавней статье о robots txt для Яндекс.

Совершая «прогулки» по блогам, которые созданы на платформе вордпресс, я заметил, что почти на каждом из них есть ошибки в роботсе. Пусть у некоторых они и не значительны, но из вот таких мелочей порой и складываются в будущем огромные проблемы. Многие блогеры понятия не имеют об этом файлике, а уж тем более о том, где он находится.

Где находится robots.txt в WordPress

Расположение robots.txt в Вордпресс ни чем, ни отличается от другого любого сайта – корневая папка сайта. Где находится данная папка? Естественно на вашем хостинге, эта та папка, в которой находятся все файлы вашего блога или сайта. На каждом хостинге это выглядит по-своему. Достут к корневой директории (папке) возможен через файловый менеджер панели управления вашим хостингом, либо по FTP.

Тот, кто знает, что можно зайти в корень сайта по SSH, может воспользоваться и этим методом.

Как создать robots.txt для WordPress

Для начала создадим простой текстовый файл с именем «robots». От кроем его и начинаем прописывать директивы для поисковых систем. Для примера я сделал скрин роботса своего блога, скопировать его можно перейдя по ссылке (если скопировали, не забудьте в дальнейшем его отредактировать).

А теперь пройдемся по всем директивам, что бы вам было понятно что и для чего.

User-agent: Yandex – открываем доступ всем поисковым роботам Яндекса

Allow: /wp-content/uploads/ — разрешаем индексировать картинки, это обязательная директива!!!

Disallow: /wp- — запрет на индексацию всех системных папок и файлов

Disallow: /webstat – это не обязательная директива, добавил ее исключительно в собственных целях, возможно у вас в корне сайта лежат такие папки

Disallow: /cgi-bin — без объяснений, это очень долго, да и не нужно

Disallow: */trackback – и

Disallow: */trackback/ — запрет индексации трекбеков

Disallow: */feed – и

Disallow: */feed/ — и

Disallow: /?feed= — запрещаем индексировать фид, почему так много директив? Все зависит от используемого шаблона, поэтому я сделал так

Disallow: */comments – и

Disallow: */comments/ – дабы не плодить дубли страниц с комментариями, закрываем, не волнуйтесь, все комментарии будут проиндексированы

Disallow: /tag – тут я думаю все понятно, закрываем страницы тегов, лично я их не прописываю, что бы не плодить лишних страниц, которые дублируют контент, но всякий случай директиву прописал

Disallow: /category – спорный запрет, если хотите что бы ваши страницы категорий попали в индекс поисковика, уберите эту строчку

Disallow: /archive – яснее не куда, закрываем страницы с архивами

Disallow: /?wysija- — это я закрыл страницы создаваемые одним из плагинов, вам это не обязательно, об этом плагине я напишу в ближайшем будущем

Disallow: /?s= — запрет на индексацию страниц с поиска сайта

Disallow: /lin – это тоже вам не нужно, использую эту папку для файлов редиректа

Host: platon-shhukin.ru – понятно?

Sitemap: http:platon-shhukin.ru/sitemap.xml Sitemap: http:platon-shhukin.ru/sitemap.xml.gz — думаю тоже не возникло проблем.

User-agent: * — открываем доступ к сайту всем роботам

Директивы прописаны отдельно для Яндекса, и отдельно для всех остальных поисковых роботов.

Вот и все, рабочий файл robots.txt для блога на WordPress готов, остается проверить его, но вы то уже знаете как это сделать? Если забыли, то смотрите еще раз в конце статьи проверка и анализ файла robots txt. Теперь остается загрузить файл в коревую папку вашего сайта, и поисковые системы приступят к правильной индексации вашего блога.

Есть вопросы, спрашивайте в комментариях, постараюсь помочь в меру своих знаний.

Файл robots txt — что это такое и зачем он вообще нужен

Сегодня мы подробно рассмотрим файл robots txt – что это такое, зачем он нужен и как с ним работать. Понятие термина robots txt описывается на множестве сайтов и блогов. Однако везде статьи данной тематики существенно отличаются друг от друга. А потому пользователи путаются в них, как рыба в сетях.

Файл Robots txt – что за страшный зверь?

Robots.txt представляет собой файл. Это стандартный текстовый документ, сохраненный с применением кодировки UTF-8. Он создается специально для работы с такими протоколами, как:

Файл несет в себе важную функцию – он нужен для того, чтобы показывать поисковому роботу, что конкретно подлежит сканированию, а что закрыто от сканирования.

Обратите внимание! Крайне важно, чтобы файл сохранялся в кодировке UTF-8. Если это условие будет не выполнено, поисковые роботы неправильно интерпретируют команды, заложенные в документе.

Все правила, требования, рекомендации, которые указаны в robots.txt актуальны лишь для конкретного хоста, а также протокола и номера порта, где непосредственно и находится описываемый нами файл.

Кстати, сам robots.txt находится в корневом каталоге и представляет собой стандартный текстовый документ. Его адрес следующий https://admin.com /robots.txt., где admin.com – имя вашего сайта.

В прочих файлах ставится специальная пометка Byte Order Mark или ее еще называют аббревиатурой ВОМ. Данная пометка представляет собой юникод-символ – он требуется для того, чтобы установить четкую последовательность считываемой информации в байтах. Кодовый символ – U+FEFF.

А вот в начале нашего robots.txt пометка последовательной считываемости пренебрегается.

Важно! Следите за «весом» файла robots.txt. Так, поисковая система Google требует, что его размер не превышал 500 килобайт.

Отметим непосредственно технические характеристики robots.txt. В частности, упоминания заслуживает тот факт, что файл являет описание, представляемой в BNF-форме. И применяются правила RFC 822.

Что именно и как обрабатывает файл?

Считывая указанные в файле команды, роботы поисковых систем получают от следующие команды к исполнению (одну из нижеперечисленных):

- сканирование только отдельных страниц – это называется частичный доступ;

- сканирование всего сайта в целом – полный доступ;

- запрет на сканирование.

Проводя обработку сайта, роботы получают определенные ответы, которые могут быть следующими:

- 2хх – сканирование сайта было выполнено успешно;

- 3хх – робот переходит по переадресации, пока ему не удалось получить другой ответ. В большинстве случаев для этого необходимо пять попыток, дабы найти ответ, который будет отличаться от 3хх. Если за пять попыток ответ не получен, будет зафиксирована ошибка 404;

- 4хх – робот уверен, что следует провести сканирование всего сайта;

- 5хх – такой ответ расценивается, как временная ошибка сервера, а проведение сканирования запрещается. Поисковый робот будет «стучаться» к файлу так долго, пока им не будет получен ответ. При этом робот от Google проводит оценку корректности или некорректности ответов. В данном случае следует говорить о том, что если вместо традиционной ошибки 404 получен ответ 5хх, то в данной ситуации робот обработает страницу с ответом 404.

Обратите внимание! На момент написания статья так еще и не было понятно, как именно проводится обработка файла robots.txt, который в момент обращения к нему поисковых роботов недоступен из-за того, что у сервера возникают проблемы с доступом к интернету.

Дерективы файла Robots txt – для каких целей они необходимы?

К примеру, есть ситуации, когда необходимо ограничить посещение роботами:

- страниц, на которых располагает личная информация владельца;

- страниц, на которых размещены те или иные формы для передачи информации;

- зеркал сайта;

- страниц, на которых помещаются результаты поиска и т.д.

Обратите внимание! Даже если вы ограничите посещение страницы поисковыми роботами, она может в конечном итоге появится в результатах поисковой выдачи, но только в том случае, если на нее имеется ссылка либо на вашем сайте, либо на каком-то другом ресурсе.

На схеме ниже представлено, как поисковые роботы видят отдельные страницы сайта при наличии robots.txt и при его отсутствии.

Если не использовать дерективы файла robots txt, то все данные, информация, которые не предназначены для людей, в конечном итоге будет оказываться в результатах поисковой выдачи, от чего будете страдать не только вы, как владелец сайта, но и сам сайт!

Как создать файл robots txt: подробная инструкция

Для создания такого файла можете использовать фактически любой редактор текста, например:

- Notepad;

- Блокнот;

- Sublime и др.

В этом «документе» описывается инструкция User-agent, а также указывается правило Disallow, но есть и прочие, не такие важные, но необходимые правила/инструкции для поисковых роботов.

User-agent: кому можно, а кому нет

Наиболее важная часть «документа» — User-agent. В ней указывается, каким именно поисковым роботам следует «посмотреть» инструкцию, описанную в самом файле.

В настоящее время существует 302 робота. Чтобы в документе не прописывать каждого отдельного робота персонально, необходимо указать в файле запись:

User-agent: *

Такая пометка указывает на то, что правила в файле ориентированы на всех поисковых роботов.

У поисковой системы Google основной поисковый робот Googlebot. Чтобы правила были рассчитаны только на него, необходимо в файле прописать:

User-agent: Googlebot_

При наличии такой записи в файле прочие поисковые роботы будут оценивать материалы сайта по своим основным директивам, предусматривающим обработку пустого robots.txt.

У Яндекс основной поисковый робот Yandex и для него запись в файле будет выглядеть следующим образом:

User-agent: Yandex

При наличии такой записи в файле прочие поисковые роботы будут оценивать материалы сайта по своим основным директивам, предусматривающим обработку пустого robots.txt.

Прочие специальные поисковые роботы

- Googlebot-News — используется для сканирования новостных записей;

- Mediapartners-Google — специально разработан для сервиса Google AdSense;

- AdsBot-Google — оценивает общее качество конкретной целевой страницы;

- YandexImages — проводит индексацию картинок Яндекс;

- Googlebot-Image — для сканирования изображений;

- YandexMetrika — робот сервиса Яндекс Метрика;

- YandexMedia — робот, индексирующий мультимедиа;

- YaDirectFetcher — робот Яндекс Директ;

- Googlebot-Video — для индексирования видео;

- Googlebot-Mobile — создан специально для мобильной версии сайтов;

- YandexDirectDyn — робот генерации динамических баннеров;

- YandexBlogs — робот поиск по блогам, он проводит сканирование не только постов, но даже комментарие;

- YandexDirect — разработан для того, чтобы анализировать наполнение партнерский сайтов Рекламной сети. Это позволяет определить тематику каждого сайта и более эффективно подбирать релевантную рекламу;

- YandexPagechecker — валидатор микроразметки.

Перечислять прочих роботов не будем, но их, повторимся, всего насчитывается более 300-т. Каждый из них ориентирован на те или иные параметры.

Что такое Disallow?

Disallow – указывает на то, что именно не подлежит сканировании на сайте. Чтобы весь сайт был открыт для сканирования поисковыми роботами, необходимо вставить запись:

User-agent: *

Disallow:

А если вы хотите, чтобы весь сайт был закрыт для сканирования поисковыми роботами, в файле введите следующую «команду»:

User-agent: *

Disallow: /

Такая «запись» в файле будет актуальна в том случае, если сайт еще не полностью готов, вы планируете вносить в него изменения, но чтобы в нынешнем своем состоянии он не отображался в поисковой выдаче.

Обратите внимание! Однако эту команду следует снять, как только сайт будет окончательно сформирован. Хотя некоторые веб-мастера забывают об этом.

И еще несколько примеров, как прописать ту или иную команду в файле robots.txt.

Чтобы роботы не просматривали конкретную папку на сайте:

User-agent: *

Disallow: /papka/

Чтобы закрыть от сканирования определенный URL:

User-agent: *

Disallow: /private-info.html

Чтобы закрыть от сканирования определенный файл:

User-agent: *

Disallow: /image/имя файла и его расширение

Чтобы закрыть от сканирования все файлы конкретного разрешения:

User-agent: *

Disallow: /*.имя расширение и значок $ (без пробела)

Allow — команда для направления роботов

Allow – эта команда дает разрешение на сканирования определенных данных:

- файла;

- директивы;

- страницы и т.д.

В качестве примера рассмотрим ситуацию, когда важно, чтобы роботы могли просмотреть лишь те страницы, которые начинаются с /catalog, а все остальное содержимое сайта подлежит закрытию. Команда в файле robots.txt будет выглядеть следующим образом:

User-agent: *

Allow: /catalog

Disallow: /

Обратите внимание! «Правила» Allow и Disallow отсортировываются в зависимости от длины префикса URL, в частности сортировка идет от наиболее маленького к наибольшему. Их применение осуществляется строго последовательно. Однако, если для одной страницы сайта будут актуальными сразу несколько правил, поисковый робот выберет последнее из них в отсортированном списке команд.

Host + в файл robots txt или как выбрать зеркало для вашего сайта

Внесение команды host + в файл robots txt является одной из нескольких обязательных задач, которые нужно сделать в первую очередь. Она предусмотрена для того, чтобы поисковый робот понимал, какое зеркало сайта подлежит индексации, а какое – не следует учитывать при проведении сканирования страниц сайта.

Кстати! Зеркалом сайта называют копию ресурса (точную или весьма близкую к основному сайту), доступ к которой возможен по нескольким адресам.

Такая команда позволит роботу избежать путаницы в случае обнаружения зеркала, а также понять, что является главным зеркалом ресурса – оно указывается в файле robots.txt.

При этом адрес сайта указывается без «https://», однако, если ваш ресурс работает на HTTPS, в таком случае соответствующая приставка должна быть обязательно указана.

Данное правило прописывается следующим образом:

User-agent: * (имя поискового робота)

Allow: /catalog

Disallow: /

Host: имя сайта

Если же сайт работает по протоколу HTTPS, команда будет прописана следующим образом:

User-agent: * (имя поискового робота)

Allow: /catalog

Disallow: /

Host: https:// имя сайта

Sitemap – что это такое и как работать с ней?

Sitemap необходима для того, чтобы передать поисковым роботам информацию о том, что все URL-адреса сайта, открытые для сканирования и индексации, расположены по адресу https://site.ua/sitemap.xml.

Во время каждого посещения и сканирования сайта, поисковый робот будет изучать, какие именно изменения были внесены в данный файл, тем самым обновляя информацию о сайте в своей базе данных.

Вот как правильно прописать эти «команды» в файле robots.txt:

User-agent: *

Allow: /catalog

Disallow: /

Sitemap: https://site.ua/sitemap.xml.

Crawl-delay — если сервер слабый

Crawl-delay необходимый параметр для тех сайтов, которые находятся на слабых серверах. С его помощью у вас есть возможность устанавливать конкретный период, через который будут загружаться страницы вашего ресурса.

Ведь слабые серверы провоцируют образование задержек во время обращения к ним поисковых роботов. Такие задержки фиксируются в секундах.

Вот пример, как прописывается данная команда:

User-agent: *

Allow: /catalog

Disallow: /

Crawl-delay: 3

Clean-param — если имеет дублирование контента

Clean-param – предназначен для того, чтобы «сражаться» с get-параметрами. Это необходимо для того, чтобы исключить вероятное дублирование контента, который в итоге будет доступен поисковым роботам по различным динамическим адресам. Подобные адреса появляются в том случае, если на ресурсе имеются разные сортировки или т.п.

К примеру, конкретная страница может быть доступна по следующим адресам:

- www.vip-site.com/foto/tele.ua?ref=page_1&tele_id=1

- www.vip-site.com/foto/tele.ua?ref=page_2&tele_id=1

- www.vip-site.com/foto/tele.ua?ref=page_3&tele_id=1

В подобной ситуации в файле robots.txt будет присутствовать следующая команда:

User-agent: Yandex

Disallow:

Clean-param: ref /foto/ tele.ua

В данном случае параметр ref показывает, из какого именно места идет ссылка, а потому она прописывается непосредственно в самом начале, а только после этого прописывается оставшаяся часть адреса.

Какие символы используются в robots.txt

Чтобы не ошибиться при написании файла, следует знать все символы, которые используются, а также понимать их значение.

Вот основные символы:

/ — он необходим, чтобы закрыть что-то от сканирования поисковыми роботами. Например, если поставить /catalog/ — в начале и в конце отдельной директории сайта, то эта папка будет полностью закрыта от сканирования. Если же команда будет выглядеть, как /catalog, то на сайте окажутся закрытыми все ссылки на сайте, начало которых прописано, как /catalog.

* — указывается на любую последовательность символов в файле и устанавливается в конце каждого правила.

Например, запись:

User-agent: *

Disallow: /catalog/*.gif$

Такая запись говорить, что все роботам запрещено сканирование и индексирование файлов с расширением .gif, которые помещены в папку сайта catalog.

«$» — используется для того, чтобы ввести ограничения на действия знака *. К примеру, вам нужно наложить запрет на все, что находится в папке catalog, но также нельзя запрещать URL, в которых присутствует /catalog, необходимо сделать следующую запись:

User-agent: *

Disallow: /catalog?

— «#» — такой значок предназначен для комментариев, заметок, которые веб-мастер формирует для себя или прочих веб-мастеров, которые также будут работать с сайтом. Такой значок запрещает сканирование этих комментариев.

Выглядеть запись будет следующим образом (к примеру):

User-agent: *

Allow: /catalog

Disallow: /

Sitemap: https://site.ua/sitemap.xml.

#инструкции

Идеальный файл robots.txt: какой он?

Вот пример фактически идеального файла robots.txt, который подойдет если не для всех, то для многих сайтов.

User-agent: *

Disallow:

User-agent: GoogleBot

Disallow:

Host: https://имя сайта

Sitemap: https://имя сайта/sitemap.xml.

Давайте проанализируем, что представляет собой данный файл robots.txt. Итак, он позволяет индексировать все страницы сайта и весь контент, который там размещен. Также в нем указываются хост и карта сайта, благодаря чему поисковики будут видеть все адреса, открытые для индексирования.

Кроме того, отдельно указываются рекомендации для поисковых роботов Google.

Однако не стоит просто скопировать этот файл для своего сайта. Во-первых, для каждого ресурса следует предусмотреть отдельные правила и рекомендации. Они напрямую зависят от платформы, на которой вы создали сайт. Поэтому помните все правила заполнения файла.

Как проверить файл robots.txt

Чтобы убедиться, что файл создан правильно, для его проверки воспользуйтесь сервисами инструментов веб-мастеров от Яндекс и Google.

Сделать это весьма просто – достаточно просто указать исходный код вашего файла, поместив его в специальную форму, а также указать сайт, который вы собираетесь проверить.

Как не стоит заполнять файл robots.txt: простые рекомендации

Нередко веб-мастера допускают ошибки – зачастую, досадные. Чаще всего причина таких ошибок кроется в банальной невнимательности. Мы представим вам несколько примеров таких ошибок, а также укажем, как должно быть правильно.

Ошибки в инструкциях

Неправильно:

User-agent:/

Disallow: YandexBot

Правильно:

User-agent: YandexBot

Disallow: /

В одной инструкции указано несколько папок

Неправильно:

User-agent: YandexBot

Disallow: /catalog/ /papka/ /photo/

Подобные инструкции приведут к тому, что поисковые роботы просто запутаются, что именно подлежит индексации, а что нет. То ли первая папка, то ли последняя. Поэтому нужно каждое правильно прописывать отдельно.

User-agent: YandexBot

Disallow: /catalog/

Disallow: /papka/

Disallow: /photo/

Прочие ошибки

- Ошибки в названии файла. Название – только robots.txt, но не Robots.txt, не ROBOTS.TXT и никак по-другому!

- Правило User-agent обязательно должно быть заполненным – нужно указывать, либо какой конкретно робот должен учитывать его, либо вообще все.

- Наличие лишних знаков.

- Присутствует в файле страниц, которые не должны индексироваться.

Что мы узнали о файле robots txt

Файл Robots txt – играет важную роль для каждого отдельного сайта. В частности, он необходим, чтобы устанавливать определенные правила для поисковых роботов, а также продвигать свой сайт, компанию.

Кроме того, данный файл открывает широкое поле для экспериментов, но проводить их следует только в том случае, если вы досконально разобрались, как именно прописывать инструкции!

Подробнее о файле Robots txt и о создании сайтов в целом, вы можете узнать придя на мой бесплатный 4-х дневный тренинг по созданию сайтов с нуля, где я дам пошаговую инструкцию. Я помогу вам воплотить в жизнь свою мечту. Единственное, о чем хотел бы вас предупредить – будьте готовы к тому, что вам придется много работать. Успех просто так никому не дается!