Правильный файл robots txt для сайта на MODx — видео урок

Всем привет друзья! Продолжаю вместе с вами осваивать премудрости системы управления сайтом под названием MODx и сегодняшний урок я вместе с вами решил посвятить созданию файла robots txt для нее.

Скажу честно, эта CMS немного непонятная…была, как мне показалось, но как только стал в ней «ковыряться», крутить болтики и гаечки, то все вроде как стало на свои места.

Ничего сложного никогда не бывает, только в самом начале пути, а потом все нормально.

Итак, будем вместе составлять правильный robots txt для поисковых роботов яндекса и гугла, чтобы наш сайт на MODx быстрее проиндексировался и в него попали только страницы с информативным содержанием.

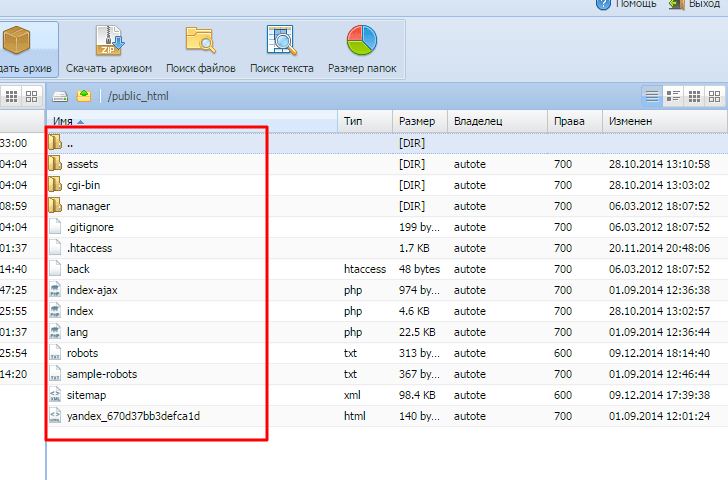

У меня есть клиентский сайт интернет магазин автомагнитол у него имеется вот такая структура файлов и папок.

Для этого сайта мой правильный robots для modx был вот таким:

User-agent: * Disallow: /assets/cache/ Disallow: /assets/docs/ Disallow: /assets/export/ Disallow: /assets/import/ Disallow: /assets/modules/ Disallow: /assets/plugins/ Disallow: /assets/snippets/ Disallow: /install/ Disallow: /manager/ Host: ms-autotech.ru Sitemap: http://ms-autotech.ru/sitemap.xml

User-agent: * Disallow: /assets/cache/ Disallow: /assets/docs/ Disallow: /assets/export/ Disallow: /assets/import/ Disallow: /assets/modules/ Disallow: /assets/plugins/ Disallow: /assets/snippets/ Disallow: /install/ Disallow: /manager/

Host: ms-autotech.ru Sitemap: http://ms-autotech.ru/sitemap.xml |

Обязательно сделайте sitemap, чтобы поисковый робот занес к себе в базу нужные страницы.

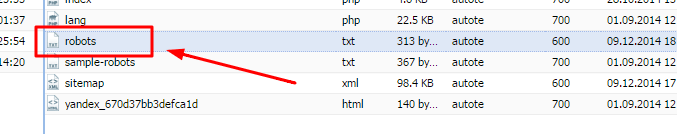

Далее все просто. Сохраняете выше приведенную инструкцию в файлик с расширением robots.txt и заливаете его в корень вашего сайта, как это показано у меня вот здесь:

И с последующей переиндексацией служебные и ненужные страницы не будут ранжироваться и показываться во всех поисковых системах, поскольку вы указали следующее правило User-agent: * , эта запись говорит, что содержимое должны сканировать все без исключения роботы.

Важно! Если вы не используете на своем сайте файл robots.txt, то вы сильно рискуете в продвижении своего проекта в интернете. В индекс будет попадать весь «мусор» и поисковые системы просто будут понижать вас в выдаче и не давать вашему сайту пробиться в ТОП. Внимательно отнеситесь к этому.

На этом урок завершен. Записал небольшое короткое видео для любителей посмотреть все в живую. Всем спасибо и до встречи в следующих выпусках!

[sociallocker id=»3259″][/sociallocker]

начальная seo оптимизация сайта: правильный robots, настройка htaccess, установка счетчика яндекс метрики и др.

Тематический трафик – альтернативный подход в продвижении бизнеса

Получи нашу книгу «Контент-маркетинг в социальных сетях: Как засесть в голову подписчиков и влюбить их в свой бренд».

Подпишись на рассылку и получи книгу в подарок!

CMS MODx имеет большую популярность среди разработчиков и как следствие SEO специалистам приходится с ней работать. Сложностей в продвижении сайтов на MODx нет, если при старте сделать правильную SEO оптимизацию проекта.

Первый этап

SEO оптимизация начинается с закрытия различных дублей на проекте

robots.txt для MODx evolution

ser-agent: * Disallow: /assets/cache/ Disallow: /assets/docs/ Disallow: /assets/export/ Disallow: /assets/import/ Disallow: /assets/modules/ Disallow: /assets/plugins/ Disallow: /assets/snippets/ Disallow: /install/ Disallow: /manager/ Disallow: /? Disallow: /*? Disallow: /index.php Host: endseo.ru Sitemap: http://endseo.ru/sitemap.xml

robots.txt для MODx revolution

User-agent: * Disallow: /manager/ Disallow: /assets/components/ Disallow: /core/ Disallow: /connectors/ Disallow: /index.php Disallow: *? Host: endseo.ru Sitemap: http://endseo.ru/sitemap.xml

Установка Яндекс Метрики или Google Analytics в MODX

Самый простой и легкий вариант — это просто установить счетчик. Код счетчика необходимо поставить в шаблон layout.tpl

Также для Яндекс Метрики существуют 2 плагина:

- Плагин для подключения Yandex.Metrika в MODx

- Модуль Яндекс.Метрика для CMS MODx Evolution

Настройка ЧПУ в MODx

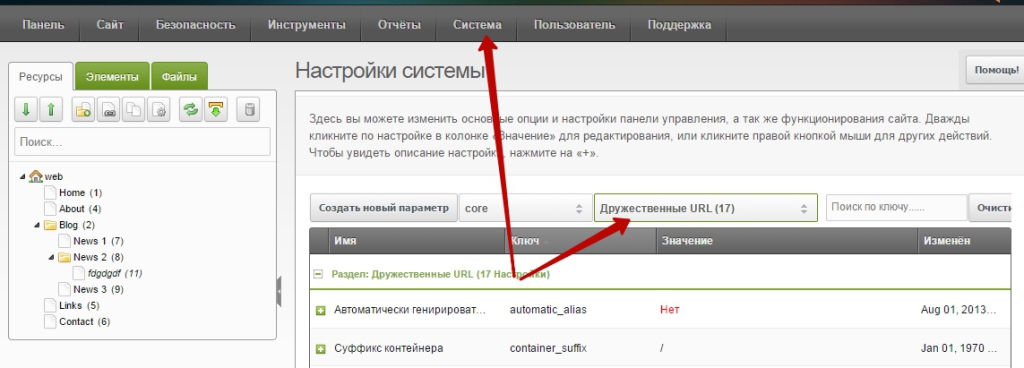

«Система» (System ) –> «Настройки системы» (System settings) –> выбираем «Дружественные URL» (Friendly URL):

Выбираем следующие значения:

- автоматически генирировать псевдоним – ставим «Нет»;

- использовать дружественные URL – «Да»;

- использовать вложенные урлы – «Да».

Потом установите «дополнение Translit» (modx.com/extras/package/translit)

.htaccess для MODX revolution

Что важно для этой CMS? Для директории “public_html“ :

<IfModule mod_rewrite.c> Options +FollowSymlinks RewriteEngine On RewriteBase / </IfModule>

Для “subdirectory“:

<IfModule mod_rewrite.c> Options +FollowSymlinks RewriteEngine On RewriteBase /subdirectory/ </IfModule>

Сайт с www или без www в MODX через .htaccess

Для поисковых систем важно, чтобы была одна версия сайта. Какая из них вам по душе — выбирайте сами, но правильнее бы без www:

для сайта с www:

RewriteCond %{HTTP_HOST} .

RewriteCond %{HTTP_HOST} !^www\.example-domain-please-change\.com [NC]

RewriteRule (.*) http://www.example-domain-please-change.com/$1 [R=301,L]

для сайта без www

RewriteCond %{HTTP_HOST} .

RewriteCond %{HTTP_HOST} !^example-domain-please-change\.com [NC]

RewriteRule (.*) http://example-domain-please-change.com/$1 [R=301,L]

Правильный Robots.txt для Modx — Бери и внедряй!

Robots.txt для Modx

Создайте текстовый файл с названием robots.txt и скопируйте в него следующее содержание, после загрузите этот файл в корень сайта.

User-agent: *

Disallow: /manager/

Disallow: /assets/components/

Disallow: /assets/export/

Disallow: /assets/import/

Disallow: /assets/cache/

Disallow: /assets/plagins/

Disallow: /assets/modules/

Disallow: /assets/snippets/

Disallow: /install/

Disallow: /core/

Disallow: /connectors/

Disallow: /index.php

Disallow: /search

Disallow: /profile/

Disallow: *?

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Наш блог

-

Конструктор сайтов — ТОП-10 лучших сервисов!

18:37 28/01/2020Перед тем, как создавать собственные проекты, я изучил множество решений на рынке и составил свой рейтинг ТОП-10 конструкторов сайтов!

-

Онлайн-Бухгалтерия — Сервисы для ИП и ООО!

23:42 17/01/2020Сегодня бухгалтерия онлайн используется многими предпринимателями и ООО. Этот способ ведения бухгалтерского учета позволяет экономить на штате и во многом упрощает документооборот.

-

КАК выбрать SEO-компанию?

18:34 09/01/2020Ощутимый поток клиентов получают, только те компании, которые выйдут в ТОП-3 по наиболее популярным запросам. Как выбрать SEO-компанию, которая поднимет вас в ТОП?

-

CRM-Cистемы — что это такое? Обзор + Рейтинг лучших!

22:37 17/12/2019Эффективный отдел продаж возможно создать только с помощью автоматизации, в этом и помогает CRM-система!

MODX — Карта сайта и Robots.txt — OLDESIGN.RU

КАРТА САЙТА для MoDx:

- Создайте ресурс с именем sitemap

Во вкладке настроек ресурса выберите:

Тип содержимого (Content Type) — XML,

Шаблон документа — Пустой (Blank template)

- Установите дополнение GoogleSiteMap

- В настройках Ресурса отключите «использовать html-редактор»

- В содержимое поле контента вставьте вызов сниппета [ [ !GoogleSiteMap? ] ], убрав пробелы.

- Cохраните ресурс.

Карта сайта готова!

ROBOTS.TXT для MoDx

- Создайте ресурс с именем robots

Во вкладке настроек ресурса выберите:

Тип содержимого — text,

Шаблон документа — Пустой

- В настройках Ресурса отключите «использовать html-редактор»

- В содержимое поле контента вставьте код ниже

- Замените«domen.ru» на адрес домена вашего сайта.

- Cохраните ресурс.

User-agent: * Disallow: /manager/ Disallow: /assets/components/ Disallow: /core/ Disallow: /connectors/ Disallow: /index.php Disallow: *? Host: domen.ru Sitemap: http://domen.ru/sitemap.xml

Ваш правильный robots.txt для MoDx Revo готов, и карта сайта теперь находится по адресу:

http://вашдомен/sitemap.xml

Скажите спасибо — поделитесь:

robots.txt и .htaccess в MODX Revo // Веб-студия Cat-Art

Навигация по статье:

Корректный robots.txt

User-agent: *

Disallow: /assets/components/

Disallow: /connectors/

Disallow: /core/

Disallow: /manager/

Disallow: /index.php

Disallow: *?

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

- index.php — это дубль главной страницы сайта;

- с помощью *? мы удаляем дубли для внутренних страниц, например, http://www.site.ru/index.php?id=5.

Важно! index.php и *? закрываем в robots.txt ТОЛЬКО если у вас включены ЧПУ-ссылки, иначе вы можете закрыть весь сайт от индексации!

Полезные директивы .htaccess

.htaccess — файл дополнительной конфигурации веб-сервера Apache, если у вас другой сервер, то файл у вас работать не будет (практически на всех современных серверах используют nginx + Apache, так что работать должен)!

#Редирект на HTTPS:

#RewriteCond %{HTTPS} =off

#RewriteRule (.*) https://%{HTTP_HOST}%{REQUEST_URI} [R=301,L]

#Редирект С www на БЕЗ www:

#RewriteCond %{HTTP_HOST} ^www\.(.*) [NC]

#RewriteRule ^(.*)$ http://%1/$1 [R=301,L]

#Редирект с БЕЗ www на С www. !НЕ используйте одновременно с «Редирект С www на БЕЗ www»:

#RewriteCond %{HTTP_HOST} ^([^www].*)$

#RewriteRule ^(.*)$ http://www.%1/$1 [R=301,L]

#Редирект с http://site.com/index.html и http://site.com/index.php на http://site.com:

#RewriteCond %{THE_REQUEST} ^[A-Z]{3,9}\ /index\.(php|html|htm)\ HTTP/

#RewriteRule ^(.*)index\.(php|html|htm)$ $1 [R=301,L]

#Редирект с одного домена на другой:

#RewriteCond %{HTTP_HOST} old.ru

#RewriteRule (.*) http://new.ru/$1 [R=301,L]

#Добавление слэша к url

#RewriteCond %{REQUEST_URI} /+[^.]+$

#RewriteRule ^(.+[^/])$ %{REQUEST_URI}/ [R=301,L]

#301 Редирект страниц:

#RewriteRule ^category/old-page.html$ category/new-page [R=301,NC,L]

Все директивы выключены через символ комментария в начале строк — #, для работы просто удалите # у нужных.

На поддержку блога

Оптимизированный Robots.txt для Opencart и других CMS на 2019-2020 год

Я заканчиваю доделывать интернет магазин одному из своих заказчиков на платформе opencart3 и перед выкладкой его в интернет и началом его индексирования поисковыми системами решил посмотреть на официальном форуме по Opencart как там дела обстоят с robots.txt к третьей версии, да и вообще почитать что и кто там порекомендует основываясь на своем опыте. Честно скажу, был немного удивлен, потому как там, информация был из серии:

используйте стандартный робот из коробки и все дела!

как вы понимаете этот вариант может устроить если тех, кто вообще не разбирается и у кого есть впереди свободных пару лет на тесты и изучение поведения паучков)

Следующим шагом решил попытать счастье у своих коллег, но был и там опечален, потому как даже те, кто позиционирует себя как веб студия выкладывали один и тот же скопированный у другого robots без каких то либо пояснений и обоснований — что очень опечалило меня и в итоге буду писать статью на свой стандартный robots.txt который себя зарекомендовал на многих сайтах и ни один год уже в работе и пока не знаю с ним бед!

Итак, представляю Вам идеальный и правильный файл robots.txt для Opencart, WordPress, Bitrix, Joomla, Shop-Script, MODX, NetCat, UMI.CMS, Drupal оптимизированный под СЕО продвижение в Яндексе и Гугле!

Фал Robots.txt

User-agent: *

Disallow: /admin

Disallow: /system

Disallow: /login

Disallow: /forgot-password

Disallow: /index.php?*

Disallow: /*route=*

Disallow: /*?*

Disallow: /*&*User-agent: YandexImages

Disallow: /

Allow: /image/User-agent: Googlebot-Image

Disallow: /

Allow: /image/Sitemap: https://site/sitemap.xls

Данный ROBOTS.TXT работает при условии:

- что у вас включено ЧПУ для всех ссылок

- стоят canonical на всех ненужных для индексации страницах

- есть четкое понимание, что должно быть в индексе, а что нет!

Но что бы объяснить Вам почему мой файл в разы меньше чем те, которые представлены в интернете прошу Вас прочитать весь текст ниже.

User-agent: *

На всех сайтах я постоянно вижу да и что говорить на моем блоге https://www.nibbl.ru/robots.txt висит тоже «детище» какого то очень «высоко квалифицированного» блогера который рекомендовал делать именно такие роботсы на wordpress, но так как это было ну очень давно, а я блогом особо не занимаюсь и успеваю только писать статьи мне некогда заняться его оптимизацией.

Так вот, все рекомендуют делать директиву User-agent: для всех и каждой поисковой системы) Тоесть все инструкции начинаются с того, что сначала идет блок правил:

- User-agent:*

- User-agent: Yandex

- User-agent: Google

- и т.д.

и самое смешное что правила одни и те же для каждого паука! Для наглядности посмотрим на скрин с яндекс помощи:

Комментарий:

- Фиолетовый маркер — в них учитываются подстроки Yandex (регистр значения не имеет) или * — тут четко дается понять, что яндексу все равно, что будет указанно, главное должно быть или-или

- Зеленый маркер — Если обнаружена строка User-agent: Yandex, то строка User-agent: * не учитывается — соответственно это правило действует и наоборот! Если обнаружена User-agent: * то яндекс не будет учитывать User-agent: Yandex

Тоесть тут уже четко дано понять, что для яндекса все равно будет это звездочка или Yandex он будет учитывать первую считанную директиву и с ней работать!

Вывод: Не нужно плодить блоки директив для каждой поисковой системы достаточно все сделать в User-agent: *

Исключение: как вы понимаете бывают и исключения, если вам надо, что бы в одной поисковой системе это индексировалось, а в другой нет — тогда имеет смысл распределять правила для каждого поискового бота! Но это из разряда какого то мистицизма или шизофрении))))

Allow и Disallow :

Директивы которые позволяют нам дать запрет на показ или индексирование разделов или страниц сайта!

Сразу хочу пояснить что эти директивы не означают, что поисковики не будут ходить по этим ссылкам!!! Они только означают, что эти страницы не попадут в индекс! Все поисковые роботы сканируют Ваш сайт вдоль и поперек и знают о нем больше чем вы!

По правилам логики разрешения и запрета сперва должны идти разрешающие правила Allow, а только потом идет Disallow (у запрета всегда больший приоритет) , это можно увидеть на самом сайте яндекса https://yandex.ru/robots.txt

блок строк:

Allow: /local Disallow: /local/api Disallow: /local/create Disallow: /local/profile Disallow: /local/*?event_id

Allow: /local Disallow: /local/api Disallow: /local/create Disallow: /local/profile Disallow: /local/*?event_id |

Мы разрешаем индексировать категорию local, НО страницы или подкатегории с именами: api, create, profile и event_id Запрещено!

Для более подробного разбора можно почитать в яндекс помощи (читать)

если почитать инструкцию яндекса, то можно данный код оптимизировать и упростить в несколько строк, для примера в опенкарте есть стандартный страницы:

https://сайт/index.php?route=account/wishlist

https://сайт/index.php?route=checkout/simplecheckout

https://сайт/index.php?route=account/account

https://сайт/index.php?route=account/simpleregister

https://сайт/index.php?route=account/login

https://сайт/index.php?route=product/manufacturer

https://сайт/index.php?route=product/special

https://сайт/index.php?route=information/sitemap

https://сайт/index.php?route=product/compare

https://сайт/index.php?route=account/simpleedit

https://сайт/index.php?route=account/password

https://сайт/index.php?route=account/address

и т.д.

что бы не засорять файл robots перечислениями мы просто пропишем повторяющееся элемент во всех этих строках и закроем его к индексации.

Disallow: /*route=*

таким образом у нам не будут индексироваться данные страниц и все остальные которые имеют в своем url текст route= что бы подкрепить мои слова фактами, вот берем стандартную утилиту яндекс вебмастера, в которой можно проверить на индексацию страницы запрещены она или нет:

Как видите, все страницы запрещены к индексации, тогда как рабочие страницы индексируются нормально!

и все эти правила можно оптимизировать для всех популярных CMS на сегодняшний день:

Виде Бонуса выкладываю стандартные robots.txt для самых популярных CMS России и Мира

HOST

от 20 марта 2018 года на официальном блоге яндекс вебмастеров выложена статья по поводу прекращения поддержик директивы host — статья

где черным по белому сказано:

её можно удалить из robots.txt или оставить, робот её просто игнорирует

Sitemap

Файл sitemap.xml — это файл или как его еще называют карта сайта, который содержит все актуальные страницы сайта которые необходимо показать поисковым роботам для улучшения индексации. С помощью sitemap мы сообщаем поисковым системам (Яндексу и Гуглу), какие страницы Вашего сайта нужно индексировать, как часто обновляется информация на сайте, а также индексирование каких страниц наиболее важно.

Это очень важный файл для интернет магазинов у которых количество страниц очень большое и есть проблемы с индексацией — карта сайта эту проблему решает!

noindex

Это конечно не относится к самому файлу robots.txt но имеет прямое отношение к индексации сайта! Это использование метатег <meta name=»robots» content=»noindex, follow»> который четко запрещает к индексации страницы сайта, а также передачу ссылочного веса.

С помощью этого метатега вы можете полностью контролировать и управлять поисковыми роботами на каждой отдельной странице сайта:

- noindex — Не индексировать текст страницы.

- nofollow — Не переходить по ссылкам на странице

- none — Соответствует директивам noindex, nofollow

- noarchive — Не показывать ссылку на сохраненную копию в результатах поиска

- noyaca — Не использовать сформированное автоматически описание

- all — Соответствует директивам index и follow — разрешено индексировать текст и ссылки на странице

Бонус

Стандартный robots.txt для Opencart

Посмотреть стандартный robots.txt для Ocstore

User-agent: *

Disallow: /*route=account/

Disallow: /*route=affiliate/

Disallow: /*route=checkout/

Disallow: /*route=product/search

Disallow: /index.php?route=product/product*&manufacturer_id=

Disallow: /admin

Disallow: /catalog

Disallow: /system

Disallow: /*?sort=

Disallow: /*&sort=

Disallow: /*?order=

Disallow: /*&order=

Disallow: /*?limit=

Disallow: /*&limit=

Disallow: /*?filter=

Disallow: /*&filter=

Disallow: /*?filter_name=

Disallow: /*&filter_name=

Disallow: /*?filter_sub_category=

Disallow: /*&filter_sub_category=

Disallow: /*?filter_description=

Disallow: /*&filter_description=

Disallow: /*?tracking=

Disallow: /*&tracking=

User-agent: Yandex

Disallow: /*route=account/

Disallow: /*route=affiliate/

Disallow: /*route=checkout/

Disallow: /*route=product/search

Disallow: /index.php?route=product/product*&manufacturer_id=

Disallow: /admin

Disallow: /catalog

Disallow: /system

Disallow: /*?sort=

Disallow: /*&sort=

Disallow: /*?order=

Disallow: /*&order=

Disallow: /*?limit=

Disallow: /*&limit=

Disallow: /*?filter=

Disallow: /*&filter=

Disallow: /*?filter_name=

Disallow: /*&filter_name=

Disallow: /*?filter_sub_category=

Disallow: /*&filter_sub_category=

Disallow: /*?filter_description=

Disallow: /*&filter_description=

Clean-param: tracking

Стандартный robots.txt для WordPress

Посмотреть стандартный robots.txt для WordPress

User-agent: *

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /*?*

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm=

Disallow: *openstat=

Disallow: */attachment/*

Стандартный robots.txt для Bitrix

Скачать стандартный robots.txt для Bitrix

User-agent: *

Disallow: /bitrix/

Disallow: /search/

Allow: /search/map.php

Disallow: /auth/

Disallow: /auth.php

Disallow: /*?print=

Disallow: /*&print=

Disallow: /*register=yes

Disallow: /*forgot_password=yes

Disallow: /*change_password=yes

Disallow: /*login=yes

Disallow: /*logout=yes

Disallow: /*auth=yes

Disallow: /*backurl=*

Disallow: /*BACKURL=*

Disallow: /*back_url=*

Disallow: /*BACK_URL=*

Disallow: /*back_url_admin=*

Disallow: /*index.php$

Стандартный robots.txt для Umi-cms

Скачать стандартный robots.txt для umi-cms

User-Agent: GooglebotDisallow: /?

Disallow: /dlya_vstavki/

Disallow: /admin

Disallow: /index.php

Disallow: /emarket/addToCompare

Disallow: /emarket/basket

Disallow: /emarket/gateway

Disallow: /go-out.php

Disallow: /cron.php

Disallow: /filemonitor.php

Disallow: /search

User-Agent: Yandex

Disallow: /?

Disallow: /dlya_vstavki/

Disallow: /admin

Disallow: /index.php

Disallow: /emarket/addToCompare

Disallow: /emarket/basket

Disallow: /emarket/gateway

Disallow: /go-out.php

Disallow: /cron.php

Disallow: /filemonitor.php

Disallow: /search

User-Agent: *

Disallow: /?

Disallow: /dlya_vstavki/

Disallow: /admin

Disallow: /index.php

Disallow: /emarket/addToCompare

Disallow: /emarket/basket

Disallow: /emarket/gateway

Disallow: /go-out.php

Disallow: /cron.php

Disallow: /filemonitor.php

Disallow: /search

Host: http://ваш сайт

Sitemap: http://ваш сайт

Crawl-delay: 3

Стандартный robots.txt для Webasyst / Shop-Script

Скачать стандартный robots.txt для Webasyst или shop-script

User-agent: *

Crawl-delay: 2

Стандартный robots.txt для Joomla

Скачать стандартный robots.txt для Joomla

User-agent: *

Disallow: /administrator/

Disallow: /bin/

Disallow: /cache/

Disallow: /cli/

Disallow: /components/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /layouts/

Disallow: /libraries/

Disallow: /logs/

Disallow: /modules/

Disallow: /plugins/

Disallow: /tmp/

На этом все! Надеюсь что моя статья была Вам полезна, если у вас есть чем дополнить или покритиковать пишите в комментариях.

Правильный robots.txt для WordPress, Opencart, Bitrix и Joomla!

Мы подготовили для Вас правильные robots.txt для самых популярных CMS Рунета. Но нужно понимать, что мы исключили лишь общие файлы и страницы. Если на сайте появится Ваш собственный «мусор», его придется убирать самостоятельно.

Ниже все инструкции прописаны для User-agent: Yandex. По желанию Вы можете добавить эти же инструкции и для User-agent: *

Не забывайте вписывать свое главной зеркало и актуальный путь к Вашей sitemap.xml

Для корректной работы на всех сайтах должно быть включено ЧПУ. Поисковые системы любят небольшие читаемые URL, особенно, если они отражают суть страницы.

Выберите свою CMS:

Robots.txt для WordPress

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /tag Host: ГЛАВНОЕ ЗЕРКАЛО САЙТА Sitemap: http://ВАШ ДОМЕН/sitemap.xml

Robots.txt для Joomla!

User-agent: Yandex Disallow: /administrator/ Disallow: /cache/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /libraries/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/ Disallow: /layouts/ Disallow: /cli/ Disallow: /bin/ Disallow: /logs/ Disallow: /components/ Disallow: /component/ Disallow: /component/tags* Disallow: /*mailto/ Disallow: /*% Disallow: /index.php Host: ГЛАВНОЕ ЗЕРКАЛО САЙТА Sitemap: http://ВАШ ДОМЕН/sitemap.xml

Robots.txt для MODx EVO

User-agent: Yandex Disallow: /assets/cache/ Disallow: /assets/docs/ Disallow: /assets/export/ Disallow: /assets/import/ Disallow: /assets/modules/ Disallow: /assets/plugins/ Disallow: /assets/snippets/ Disallow: /install/ Disallow: /manager/ Disallow: /? Disallow: /*? Disallow: /index.php Host: ГЛАВНОЕ ЗЕРКАЛО САЙТА Sitemap: http://ВАШ ДОМЕН/sitemap.xml

Robots.txt для Bitrix

User-agent: Yandex Disallow: /bitrix/admin/ Disallow: /admin/ Disallow: /bitrix/ Disallow: /about/pics/ Disallow: /blog/user/ Disallow: /blog/friends/ Disallow: /sitemanager/projects/ Disallow: /partners/list/ Disallow: /support/forum/topic/new/ Disallow: /support/forum/users/ Disallow: /support/forum/user/ Disallow: /support/forum/search/ Disallow: /support/forum/rules/ Disallow: /support/forum/help/ Disallow: /support/forum/pm/ Disallow: /support/forum/subscribe/ Host: ГЛАВНОЕ ЗЕРКАЛО САЙТА Sitemap: http://ВАШ ДОМЕН/sitemap.xml

Robots.txt для Opencart

User-agent: Yandex Disallow: /*route=account/ Disallow: /*route=affiliate/ Disallow: /*route=checkout/ Disallow: /*route=product/search Disallow: /index.php?route=product/product*&manufacturer_id= Disallow: /admin Disallow: /catalog Disallow: /download Disallow: /export Disallow: /system Disallow: /*?sort= Disallow: /*&sort= Disallow: /*?order= Disallow: /*&order= Disallow: /*?limit= Disallow: /*&limit= Disallow: /*?filter_name= Disallow: /*&filter_name= Disallow: /*?filter_sub_category= Disallow: /*&filter_sub_category= Disallow: /*?filter_description= Disallow: /*&filter_description= Disallow: /*?tracking= Disallow: /*&tracking= Disallow: /*?page= Disallow: /*&page= Disallow: /wishlist Disallow: /login Disallow: /index.php?route=product/manufacturer Disallow: /index.php?route=product/compare Disallow: /index.php?route=product/category Host: ГЛАВНОЕ ЗЕРКАЛО САЙТА Sitemap: http://ВАШ ДОМЕН/sitemap.xml

Robots.txt для DLE

User-agent: Yandex Disallow: /engine/go.php Disallow: /engine/download.php Disallow: /user/ Disallow: /newposts/ Disallow: /statistics.html Disallow: /*subaction=userinfo Disallow: /*subaction=newposts Disallow: /*do=lastcomments Disallow: /*do=feedback Disallow: /*do=register Disallow: /*do=lostpassword Disallow: /*do=addnews Disallow: /*do=stats Disallow: /*do=pm Disallow: /print/ Disallow: /tags/ Disallow: /admin.php?mod=main Disallow: /backup/ Disallow: /engine/ Disallow: /index.php?do=search Disallow: /page/ Host: ГЛАВНОЕ ЗЕРКАЛО САЙТА Sitemap: http://ВАШ ДОМЕН/sitemap.xml