Robots.txt — как настроить и загрузить на сайт

Михаил Шумовский

07 октября, 2022

Кому нужен robots.txt Как настроить robots.txt Как создать robots.txt Требования к файлу robots.txt Как проверить правильность Robots.txt

Читайте наc в Telegram

Разбираемся, что происходит в мире рассылок и digital-маркетинга. Публикуем анонсы статей, обзоры, подборки, мнения экспертов.

Смотреть канал

Станьте email-рокером 🤘

Пройдите бесплатный курс и запустите свою первую рассылку

Подробнее

Robots.txt — документ, который нужен для индексирования и продвижения сайта.

Если у сайта нет robots.txt, поисковые роботы считают все страницы ресурса открытыми для индексирования. Если файл есть, владелец сайта может запретить роботам индексировать определённые страницы.

Например, контентным ресурсам или медиа можно работать без robots.txt — тут все страницы участвуют в индексации.

На других ресурсах могут быть страницы, которые не нужно показывать поисковым роботам:

- Админ-панели сайта: пути, которые начинаются с /user, /admin, /administrator и т.д.

- Пустые страницы ресурса: если на них нет контента, в индексации они не помогут.

- Формы регистрации.

- Личные страницы в интернет-магазинах: кабинеты пользователей, корзины и т.

д.

д.

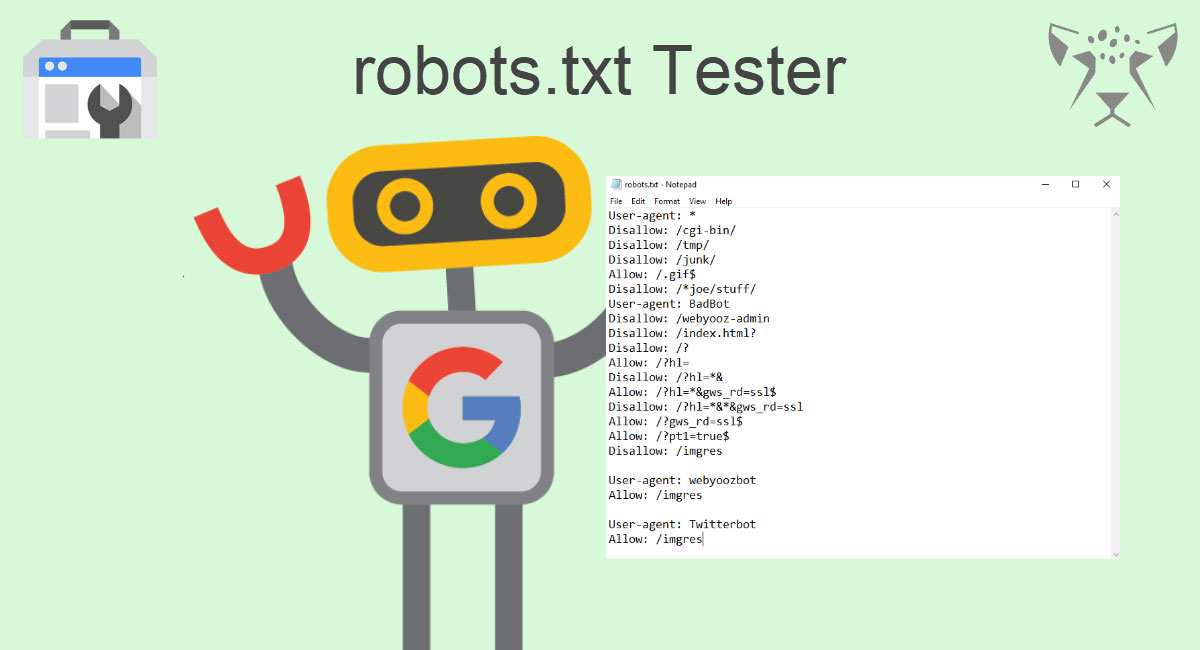

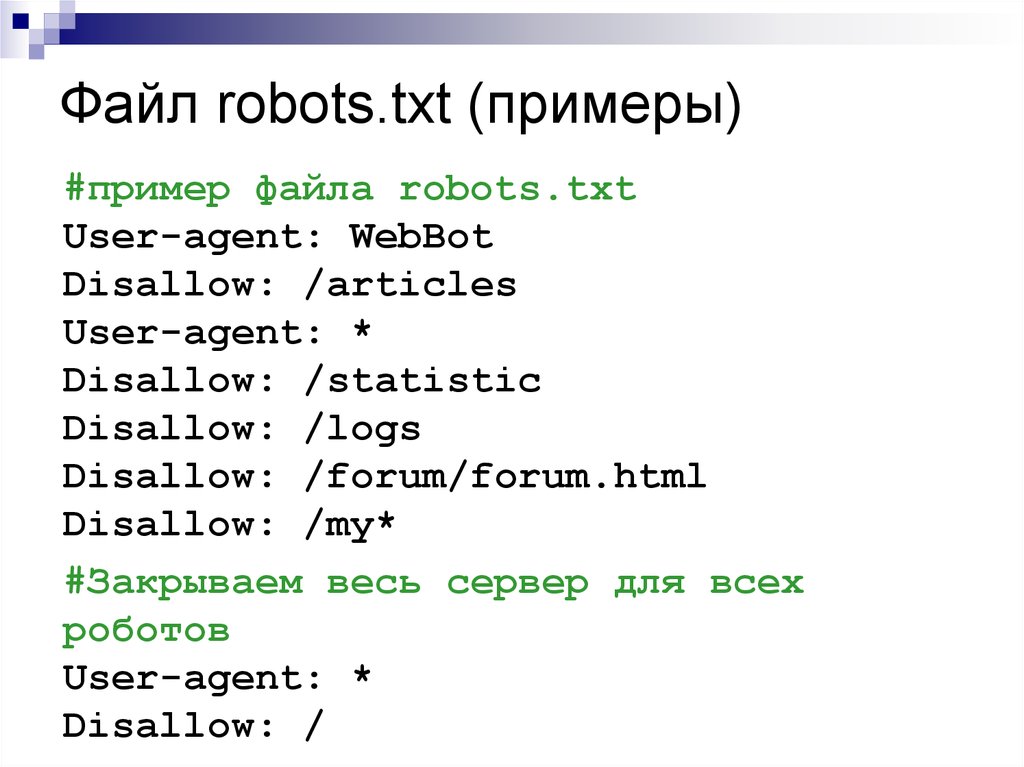

Начну с основных параметров.

User-agent: Yandex

Disallow: catalog/

Allow: /catalog/cucumbers/

Sitemap: http://www.example.com/sitemap.xml

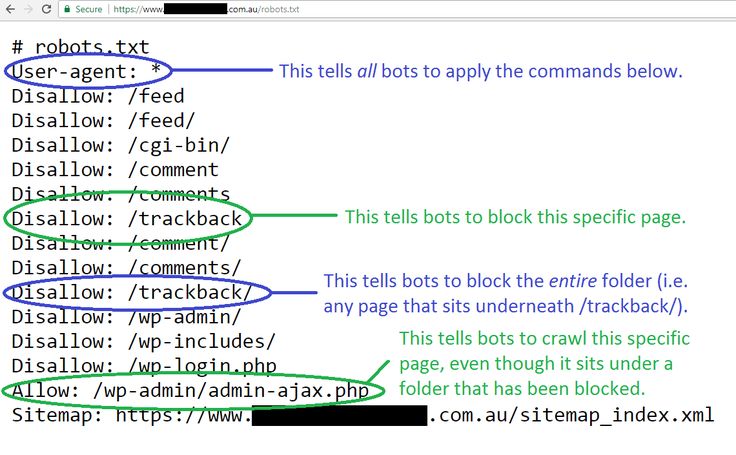

User-agent — указывает название робота, к которому применяется правило. Например, User-agent: Yandex означает, что правило применяется к роботу Яндекса.

А user-agent: * означает, что правило применяется ко всем роботам. Но о звёздочках поговорим ниже.

Основные типы роботов, которые можно указать в User-agent:

- Yandex. Все роботы Яндекса.

- YandexBot. Основной робот Яндекса

- YandexImages. Индексирует изображения.

- YandexMedia. Индексирует видео и другие мультимедийные данные.

- Google. Все роботы Google.

- Googlebot. Основной робот Google.

- Googlebot-Image.

Индексирует изображения.

Индексирует изображения.

Disallow. Указывает на каталог или страницу ресурса, которые роботы индексировать не будут. Если нельзя индексировать конкретную страницу, например, определённый раздел в каталоге, нужно указывать полный путь к ней — как в поисковой строке браузера.

В начале строки должен быть символ /. Если правило касается каталога, строка должна заканчиваться символом /.

Например, disallow: /catalog/gloves. Так мы запретим индексацию раздела с перчаткам.

Если оставить disallow пустым, роботы будут индексировать все страницы сайта.

Allow. Указывает на каталог или страницу, которые можно сканировать роботу. Его используют, чтобы внести исключения в пункт disallow и разрешить сканирование подкаталога или страницы в каталоге, который закрыт для обработки.

Если требуется индексировать конкретную страницу, нужно указывать к ней полный путь. Как и в disallow. Например, allow: /story/marketing. Так мы разрешили индексировать статью о маркетинге.

Так мы разрешили индексировать статью о маркетинге.

Если правило касается каталога, строка должна заканчиваться символом /.

Если allow пустой, робот не будет индексировать никакие страницы.

Sitemap. Необязательная директива, которая может повторяться несколько раз или не использоваться совсем. Её используют, чтобы описать структуру сайта и помочь роботам индексировать страницы.

Лендингам и небольшим сайтам sitemap не нужен. А вот таким ресурсам без sitemap не обойтись:

- Cайтам без хлебных крошек (навигационных цепочек).

- Большим ресурсам. Например, если сайт содержит большой объём мультимедиа или новостного контента.

- Сайтам с глубокой вложенностью. Например, «Главная/Каталог/Перчатки/Резиновые».

- Молодым ресурсам, на которые мало внешних ссылок, — их роботам сложно найти.

- Сайтам с большим архивом страниц, которые изолированы или не связаны друг с другом.

Файл нужно прописывать в XML-формате. Создание sitemap — тема для отдельной статьи. Подробную инструкцию читайте на Google Developers или в Яндекс.Справке.

Основные моменты robots.txt разобрали. Теперь расскажу про дополнительные параметры, которые используют в коде.

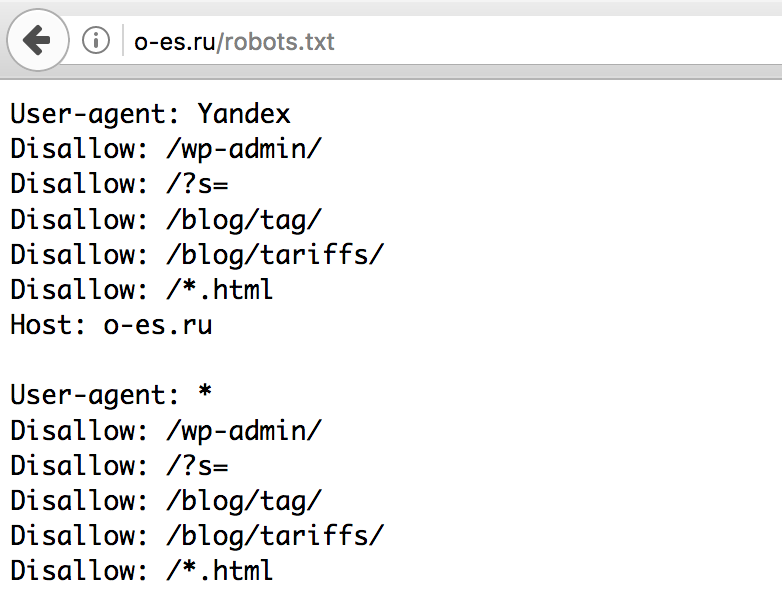

Для начала посмотрим на robots.txt Unisender. Для этого в поисковой строке браузера пишем Unisender.com/robots.txt.

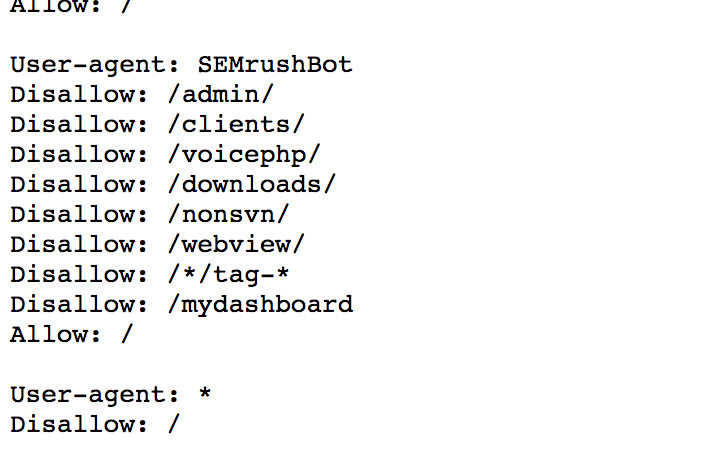

По такой же формуле можно проверять файлы на всех сайтах: URL сайта + домен/robots.txt.Robots.txt Unisender отличается от файла, который я приводил в пример. Дело в том, что здесь использованы дополнительные параметры:

Директива # (решётка) — комментарий. Решётки прописывают для себя, а поисковые роботы комментариев не видят.

User-agent: Yandex

Allow: /example/* # разрешает ‘/example/blog’

# разрешает ‘/example/blog/test’

Звёздочку роботы видят, а решётку — нет

Директива * (звёздочка) — любая последовательность символов после неё.

Например, если поставить звёздочку в поле disallow, то всё, что находится на её месте, будет запрещено.

User-agent: Yandex

Disallow: /example/* # запрещает ‘/example/blog’

# запрещает ‘/example/blog/test’

# но и ‘/example/shop’

Также и с полем allow: всё, что стоит на месте звёздочки, — разрешено для индексации.

User-agent: Yandex

Allow: /example/* # разрешает ‘/example/blog’

# разрешает ‘/example/blog/test’

Allow: */shop # разрешает не только ‘/shop’,

# но и ‘/example/shop’

Например, у Google есть особенность: компания рекомендует не закрывать от поисковых роботов файлы с css-стилями и js-скриптами. Вот как это нужно прописывать:

User-agent: Googlebot

Disallow: /site

Allow: *.css

Allow: *. js

js

Директива $ (знак доллара) — точное соответствие указанному параметру.

Например, использование доллара в disallow запретит доступ к определённому пути.

User-agent: Yandex

Disallow: /example # запрещает ‘/example’,

# запрещает ‘/example.html’

Disallow: /example$ # запрещает ‘/example’,

# не запрещает ‘/example.html’

# не запрещает ‘/example1’

# не запрещает ‘/example-new’

Таким способом можно исключить из сканирования все файлы определённого типа, например, GIF или JPG. Для этого нужно совместить * и $. Звёздочку ставим до расширения, а $ — после.

User-agent: Yandex

Disallow: / *.gif$ # вместо * могут быть любые символы,

# $ запретит индексировать файлы gif

Директива Clean-param — новый параметр Яндекс-роботов, который не будет сканировать дублированную информацию и поможет быстрее анализировать ресурс.

Дело в том, что из-за повторяющейся информации роботы медленнее проверяют сайт, а изменения на ресурсе дольше попадают в результаты поиска. Когда роботы Яндекса увидят эту директиву, не будут несколько раз перезагружать дубли информации и быстрее проверят сайт, а нагрузка на сервер снизится.

www.example.com/dir/get_card.pl?ref=site_1&card_id=10

www.example.com/dir/get_card.pl?ref=site_2&card_id=10

Параметр ref нужен, чтобы отследить, с какого ресурса сделан запрос. Он не меняет содержимое страницы, значит два адреса покажут одну и ту же страницу с книгой card_id=10. Поэтому директиву можно указать так:

User-agent: Yandex

Disallow:

Clean-param: ref /dir/get_card.pl

Робот Яндекса сведёт страницы к одной: www.example.com/dir/get_card.pl?card_id=10

Чтобы директива применялась к параметрам на страницах по любому адресу, не указывайте адрес:

User-agent: Yandex

Disallow:

Clean-param: utm

Директива Crawl-delay — устанавливает минимальный интервал в секундах между обращениями робота к сайту. Это помогает снизить нагрузку на сервер ресурса. Чем выше указанное значение, тем меньше страниц робот загрузит за сессию.

Это помогает снизить нагрузку на сервер ресурса. Чем выше указанное значение, тем меньше страниц робот загрузит за сессию.

Значения можно указывать целыми или дробными числами через точку.

User-agent: Yandex

Disallow:

Crawl-delay: 0.5

Для Яндекса максимальное значение в crawl-delay — 2. Более высокое значение можно установить инструментами Яндекс.Вебмастер.

Для Google-бота можно установить частоту обращений в панели вебмастера Search Console.

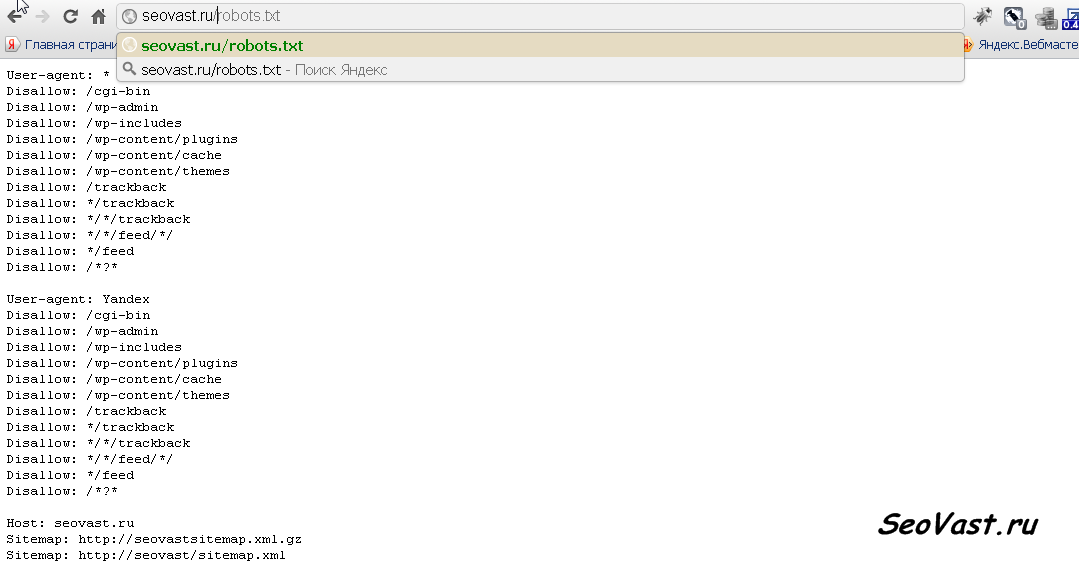

Директива Host — инструкция для робота Яндекса, которая указывает главное зеркало сайта. Нужна, если у сайта есть несколько доменов, по которым он доступен. Вот как её указывают:

Disallow: /example/

Host: example.ru

Если главное зеркало сайта — домен с протоколом HTTPS, его указывают так:

Host: https://site.ru

Как создать robots.txtСпособ 1. Понадобится текстовый редактор: блокнот, TextEdit, Vi, Emacs или любой другой. Не используйте приложения Microsoft Office, потому что они сохраняют файлы в неподходящем формате или добавляют в них лишние символы, которые не распознаются поисковыми роботами.

Не используйте приложения Microsoft Office, потому что они сохраняют файлы в неподходящем формате или добавляют в них лишние символы, которые не распознаются поисковыми роботами.

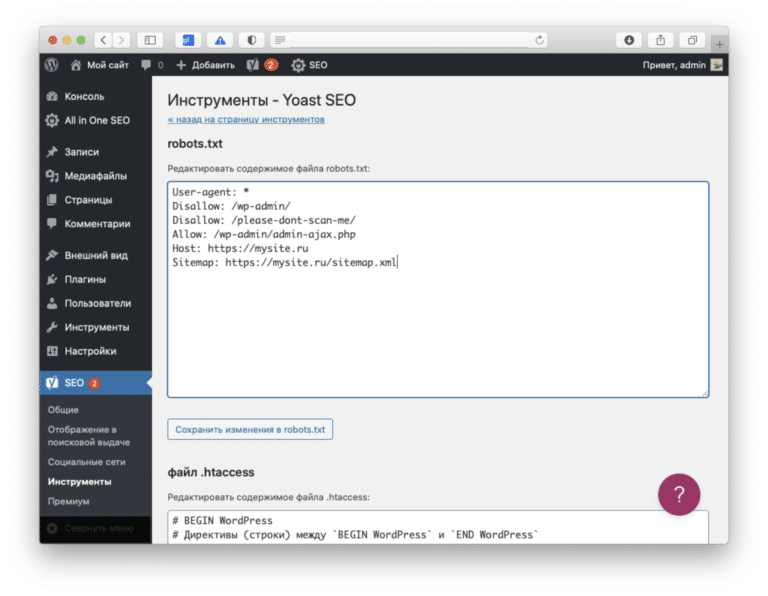

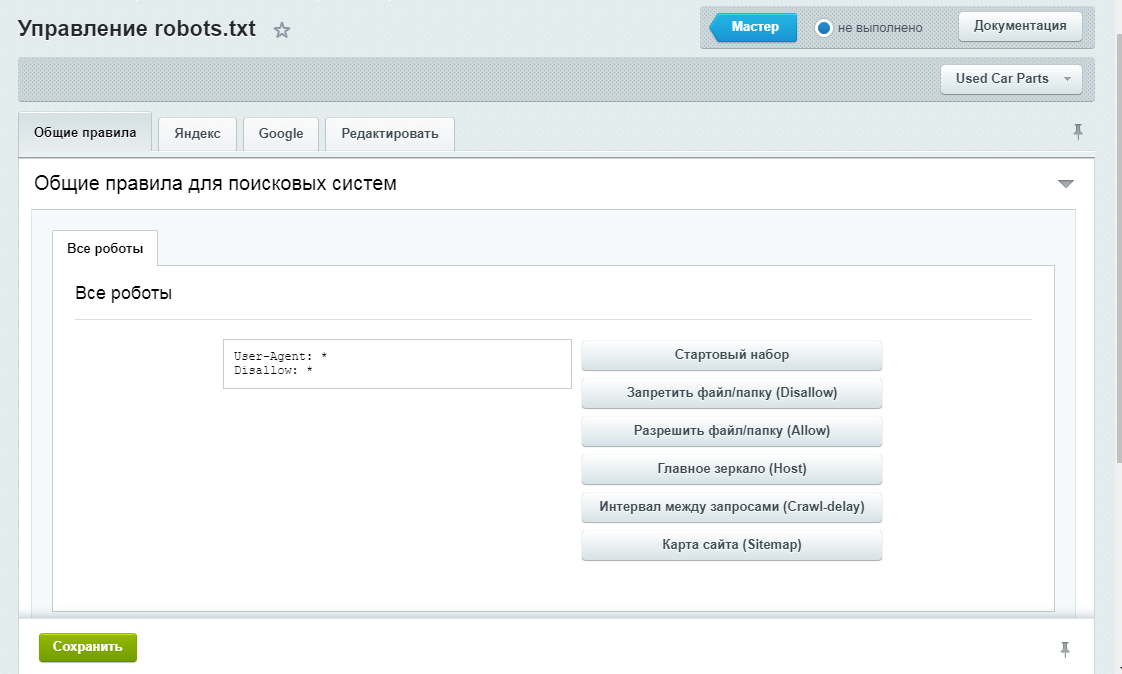

Способ 2. Создать на CMS с помощью плагинов — в этом случае robots.txt установится сам.

Если вы используете CMS хостинга, редактировать файл robots.txt не потребуется. Скорее всего, у вас даже не будет такой возможности. Вместо этого провайдер будет указывать поисковым системам, нужно ли сканировать контент, с помощью страницы настроек поиска или другого инструмента.

Способ 3. Воспользоваться генератором robots.txt — век технологий всё-таки.

Сгенерировать файл можно на PR-CY, IKSWEB, Smallseotools.

Требования к файлу robots.txtКогда создадите текстовый файл, сохраните его в кодировке utf-8. Иначе поисковые роботы не смогут прочитать документ. После создания загрузите файл в корневую директорию на сайте хостинг-провайдера. Корневая директория — это папка public. html.

html.

Папка, в которой нужно искать robots.txt. Источник

Если файла нет, его придётся создавать самостоятельно.

Требования, которым должен соответствовать robots.txt:

- Каждая директива начинается с новой строки.

- Одна директива в строке, сам параметр также написан в одну строку.

- В начале строки нет пробелов.

- Нет кавычек в директивах.

- Директивы не нужно закрывать точкой или точкой с запятой.

- Файл должен называться robots.txt. Нельзя называть его Robots.txt или ROBOTS.TXT.

- Размер файла не должен превышать 500 КБ.

- robots.txt должен быть написан на английском языке. Буквы других алфавитов не разрешаются.

Если файл не соответствует одному из требований, весь сайт считается открытым для индексирования.

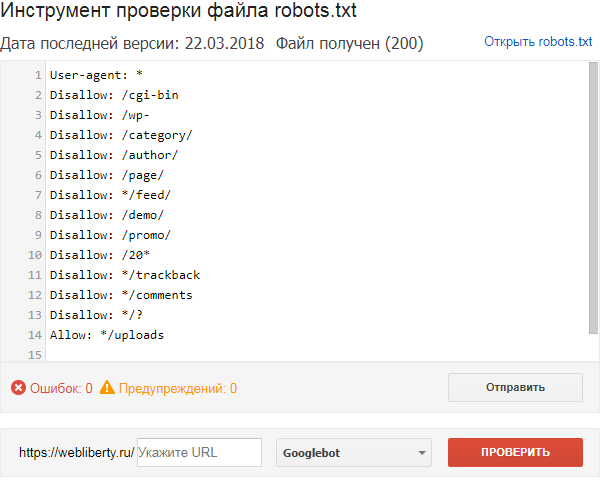

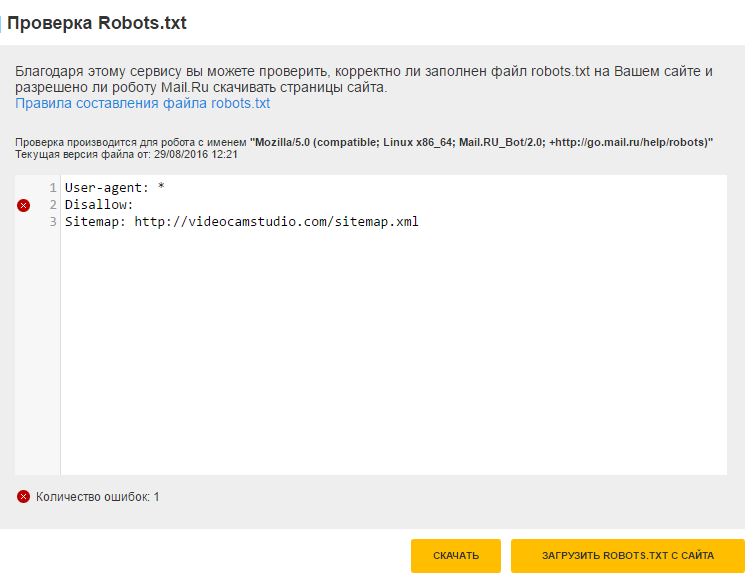

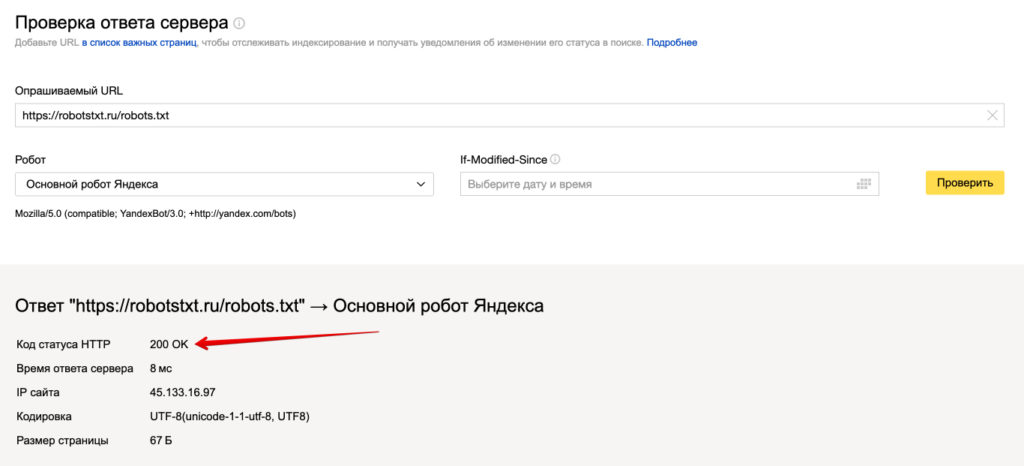

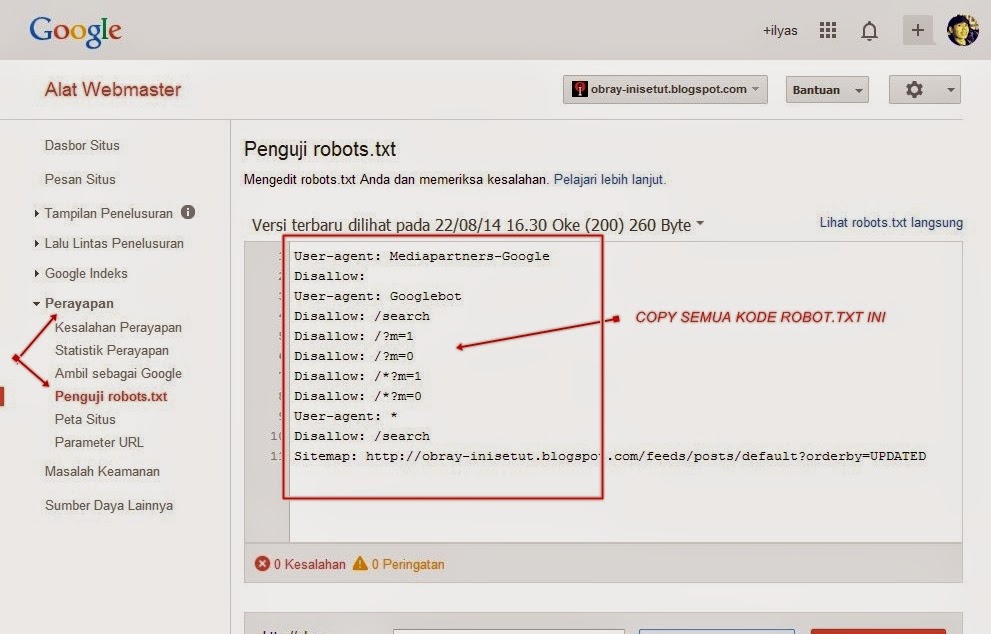

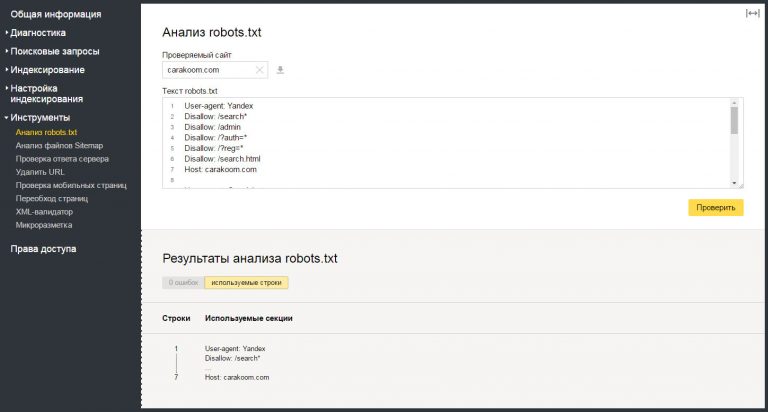

Как проверить правильность Robots.txtПроверить robots. txt помогают сервисы от Яндекс и Google. В Яндексе можно проверять файл даже без сайта — например, если вы написали robots.txt, но пока не загрузили его на сайт.

txt помогают сервисы от Яндекс и Google. В Яндексе можно проверять файл даже без сайта — например, если вы написали robots.txt, но пока не загрузили его на сайт.

Вот как это сделать:

- Перейдите на Яндекс.Вебмастер.

- В открывшееся окно вставьте текст robots.txt и нажмите проверить.

Если файл написан правильно, Яндекс.Вебмастер не увидит ошибок.

А если увидит ошибку — подсветит её и опишет возможную проблему.

На Яндекс.Вебмастер можно проверить robots.txt и по URL сайта. Для этого нужно указать запрос: URL сайта/robots.txt. Например, unisender.com/robots.txt.

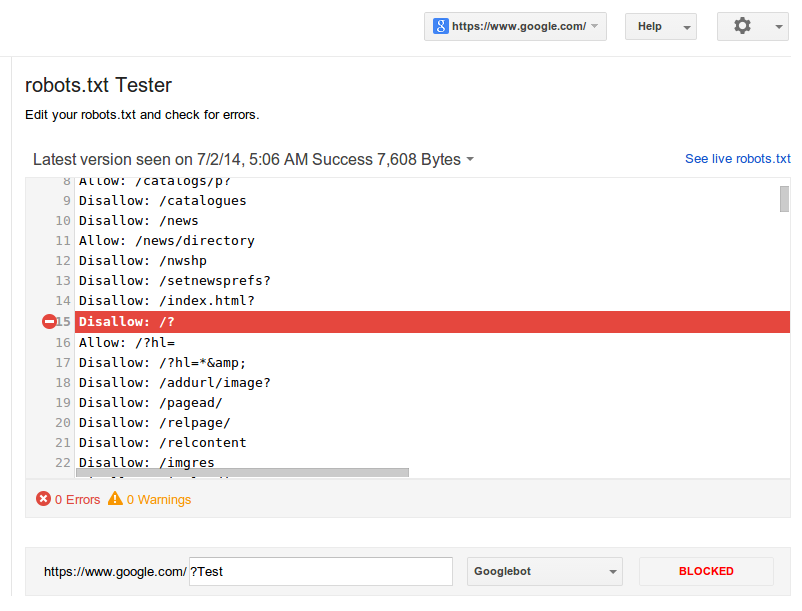

Ещё один вариант — проверить файл robots.txt через Google Search Console. Но сначала нужно подтвердить владение сайтом. Пошаговый алгоритм проверки robots.txt описан в видеоинструкции:

Поделиться

СВЕЖИЕ СТАТЬИ

Другие материалы из этой рубрики

Не пропускайте новые статьи

Подписывайтесь на соцсети

Делимся новостями и свежими статьями, рассказываем о новинках сервиса

Статьи почтой

Раз в неделю присылаем подборку свежих статей и новостей из блога. Пытаемся

шутить, но получается не всегда

Пытаемся

шутить, но получается не всегда

Наш юрист будет ругаться, если вы не примете 🙁

Как запустить email-маркетинг с нуля?

В бесплатном курсе «Rock-email» мы за 15 писем расскажем, как настроить email-маркетинг в компании. В конце каждого письма даем отбитые татуировки об email ⚡️

*Вместе с курсом вы будете получать рассылку блога Unisender

Оставляя свой email, я принимаю Политику конфиденциальностиНаш юрист будет ругаться, если вы не примете 🙁

Файл robots txt настройки директивы как редактировать

Файл robots. txt устанавливается в корень сайта для поисковых роботов. Это нужно чтобы они понимали какие ссылки можно и нельзя индексировать. Правила для роботов называются директивами. Процесс индексации статей сайта автоматический. Роботы работают быстро и пребывают на сайте секунды. За это время им нужно забрать всю информацию.

txt устанавливается в корень сайта для поисковых роботов. Это нужно чтобы они понимали какие ссылки можно и нельзя индексировать. Правила для роботов называются директивами. Процесс индексации статей сайта автоматический. Роботы работают быстро и пребывают на сайте секунды. За это время им нужно забрать всю информацию.

Если мы не установим совсем файл, то наш сайт работать будет, но только в индексе окажутся различные технические, черновые материалы. Например, страницы автора, поиска, теги, архивы, номера страниц. Потому появится повторение одних и тех же материалов, они являются дубликатами наших статей или не каноническими документами.

Пять лет назад, на веб. курсах «твой старт» нам дали готовый файл robots. txt. Нужно создать «текстовый документ», скопировать в него содержание и сохранить на компьютере. Долго у меня стоял, файл robots.txt, состав которого нам рекомендовали на курсах. Для начала работы над сайтом он хорош, и ничего другого можно не устанавливать.

Однако, с течением времени произошли изменения, особенно в поисковой системе Гугл. В настоящее время 2018 году, robots.txt выглядит на сайте так, как показано у меня в конце данной статьи. Эту статью постепенно тоже редактирую, также как изменяется файл, но не убираю прошлые материалы. Мне кажется, что если показывать это файл в процессе изменений, то файл robot. txt будет понятнее начинающим блогерам.

В настоящее время 2018 году, robots.txt выглядит на сайте так, как показано у меня в конце данной статьи. Эту статью постепенно тоже редактирую, также как изменяется файл, но не убираю прошлые материалы. Мне кажется, что если показывать это файл в процессе изменений, то файл robot. txt будет понятнее начинающим блогерам.

User-agent: *

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

User-agent: Yandex

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

Host: ваш_сайт. ru

Sitemap: http://ваш_сайт.ru /sitemap.xml.gz

Sitemap: http://ваш_сайт.ru /sitemap.xml

ru

Sitemap: http://ваш_сайт.ru /sitemap.xml.gz

Sitemap: http://ваш_сайт.ru /sitemap.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 | User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /tag

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /trackback Disallow: */trackback Disallow: */*/trackback Disallow: */*/feed/*/ Disallow: */feed Disallow: /*?* Disallow: /tag Host: ваш_сайт. Sitemap: http://ваш_сайт.ru /sitemap.xml.gz Sitemap: http://ваш_сайт.ru /sitemap.xml |

Однако, теперь, когда плагин Yoast SEO генерирует файл sitemap на лету, уже не нужно ссылаться в robots.txt на файл Sitemap: https://ваш_сайт.ru /sitemap.xml.gz. Например, мои сайты вместо протокола http, давно переведены на безопасный https. Это тоже должно отобразиться в ссылке на файл sitemap.

Файл robots.txt — значения Disallow

Опишу значения, которые теперь знаю.

Первая строчка предназначена для роботов Google, Googlboot.

Allow* — приветствие — путь свободен.

Звездочка обозначает свободный доступ к материалам сайта.

Все значения Disallow – представляют собой запрещения.

Disallow:/ cgi-bin – запрещение индексации каталога сервера.

Disallow: /?s= не показывать результаты поиска.

Хост -пишем только 1 раз, это основное зеркало сайта, указывается только для Яндекса.

Host:site.ru — без «http», далее записываем файлы sitemap. xml.

xml.

«Sitemap:» — является ссылкой на XML-карты блога. Раньше было таких файла 2 простой и сжатый. Звездочка * — означает последовательность символов в произвольном порядке.

Файл robots.txt — место расположения

Файл robits.txt закачиваем на хостинг, куда мы платим за наш домен и сайт. Например, у меня это Sprimthost.ru. Заходим в панель управления хостинга, переходим в файловый менеджер.

Открывается новое окно, здесь и есть корень сайта. Далее находим папку public_html и выбираем нужный сайт. Так было раньше. Сейчас переходим в файловый менеджер, выбираем сайт и он сразу открывается в папке public html.

Сюда загружаем наш документ, для этого спускаемся в самый низ, под все списки, нажимаем самую длинную кнопку — «загрузить в текущую директорию». Открывается новое окно, где и произойдет загрузка документа. Далее нужно произвести правильность установки файла. Затем нужно вернуться и проверить, как установился файл robots.txt. Возвращаемся по тому же пути.

Файл robots.txt —ошибки

Вначале ведения первого сайта у меня файл robots.txt был с такой ошибкой, что не действовал совсем. Оказалось, что у меня 2 пула для роботов разъехались на большее расстояние, чем это полагается. Нужно чтобы это расстояние составляло 1 интервал, а у меня их было 2, это заметила только через полгода.

Редактирование

Однако в дальнейшем, на протяжении всего периода ведения блога, файл robots.txt приходиться постоянно редактировать для поисковой системы Яндекс.

Сервис «Яндекс вебмастер» сейчас стал открытым, для блогеров и мы можем редактировать проиндексированные страницы. Просматривать нужно все отделы, в тех случаях, где замечаем неправильную индексацию.

Запретим эти файлы правилами disallow. Например, заметили, что в индексе появились лишние страницы сайта. Например, это могут быть категорий, страницы комментариев, или страницы с медиафайлами. Запретим их, как показано ниже. Правила добавлены потому, что у меня в индексе Яндекса появились страницы вложения.

Disallow: */attachment/* Disallow:/?attachment_id

Disallow: */attachment/* Disallow:/?attachment_id |

После запретов в поисковой системе Гугл появились заблокированные ресурсы. В связи с этим для Гугла файл robots.txt пришлось совсем открыть, но установить запретительный мета -тег robots. Он влияет на обе основные поисковые системы: Яндекс и Гугл.

Однако для Яндекса настраиваются более конкретные запреты в файле robots.txt. Считаю, что это лучше, чем это происходит с индексацией Google. Что происходит в Гугле, блогеру почти ничего неизвестно, в настоящее время — в 2017 году.

Например, на сегодня — 10.07.2021 года мой файл robots.txt для «моего любимого блога» выглядит следующим образом.

User-agent: *

Disallow:*/wp-admin

Allow:*/admin-ajax.php

User-agent: Yandex

Disallow: /wp-admin

Disallow:*/karta-sajta

Disallow:/karta-sajta/?pg=

Disallow: /xmlrpc. php

Disallow: /wp-content/uploads

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /rezervnye-obyavleniya

Disallow: /trackback/

Disallow: /tag/

Disallow:/category/

Disallow:/page/

Disallow:/*wp-json

Disallow:/?utm_source=feedburner&utm

Disallow: /*?*

Disallow: /?s=

Disallow:/?p=

Disallow: /poisk.html$

Disallow:/*?*

Disallow: */feed

Disallow:/feed/

Disallow:/amp/

Disallow:/author/admin/page/*

Disallow:/autor/admin/*

Disallow:*/comments

Disallow:*/comment-page

Disallow:*/optimizatsiya/

Disallow:*/sitemap.hml

Disallow:*/seo/

Disallow:*/obzory-statej-interneta/

Disallow:*http://sites.reformal.ru/m

oylubimiblog.ru

Disallow:*http://www.urlw.ru/w.moylu

bimiblog.ru

Disallow:*http://www.sbup.com/audit/

moylubimiblog.ru/

Disallow:*https://moylubimiblog.ru/p

rodvizhenie-sajta/

Disallow:*https://moylubimiblog.

php

Disallow: /wp-content/uploads

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /rezervnye-obyavleniya

Disallow: /trackback/

Disallow: /tag/

Disallow:/category/

Disallow:/page/

Disallow:/*wp-json

Disallow:/?utm_source=feedburner&utm

Disallow: /*?*

Disallow: /?s=

Disallow:/?p=

Disallow: /poisk.html$

Disallow:/*?*

Disallow: */feed

Disallow:/feed/

Disallow:/amp/

Disallow:/author/admin/page/*

Disallow:/autor/admin/*

Disallow:*/comments

Disallow:*/comment-page

Disallow:*/optimizatsiya/

Disallow:*/sitemap.hml

Disallow:*/seo/

Disallow:*/obzory-statej-interneta/

Disallow:*http://sites.reformal.ru/m

oylubimiblog.ru

Disallow:*http://www.urlw.ru/w.moylu

bimiblog.ru

Disallow:*http://www.sbup.com/audit/

moylubimiblog.ru/

Disallow:*https://moylubimiblog.ru/p

rodvizhenie-sajta/

Disallow:*https://moylubimiblog. ru/z

arabotok-na-sajte/

Disallow:*https://moylubimiblog.ru/a

naliz-sajta/yandeks-metrika/

Disallow:*https://moylubimiblog.ru/r

ubrika-komputernie-programmy/

Host: https://moylubimiblog.ru

Sitemap:https://moylubimiblog.ru/sitemap_index.xml

ru/z

arabotok-na-sajte/

Disallow:*https://moylubimiblog.ru/a

naliz-sajta/yandeks-metrika/

Disallow:*https://moylubimiblog.ru/r

ubrika-komputernie-programmy/

Host: https://moylubimiblog.ru

Sitemap:https://moylubimiblog.ru/sitemap_index.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 | User-agent: * Disallow:*/wp-admin Allow:*/admin-ajax.php

User-agent: Yandex Disallow: /wp-admin Disallow:*/karta-sajta Disallow:/karta-sajta/?pg= Disallow: /xmlrpc. Disallow: /wp-content/uploads Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /rezervnye-obyavleniya Disallow: /trackback/ Disallow: /tag/ Disallow:/category/ Disallow:/page/ Disallow:/*wp-json Disallow:/?utm_source=feedburner&utm Disallow: /*?* Disallow: /?s= Disallow:/?p= Disallow: /poisk.html$ Disallow:/*?* Disallow: */feed Disallow:/feed/ Disallow:/amp/ Disallow:/author/admin/page/* Disallow:/autor/admin/* Disallow:*/comments Disallow:*/comment-page Disallow:*/optimizatsiya/ Disallow:*/sitemap.hml Disallow:*/seo/ Disallow:*/obzory-statej-interneta/ Disallow:*http://sites.reformal.ru/m oylubimiblog.ru Disallow:*http://www.urlw.ru/w.moylu bimiblog.ru Disallow:*http://www.sbup.com/audit/ moylubimiblog.ru/ Disallow:*https://moylubimiblog.ru/p rodvizhenie-sajta/ Disallow:*https://moylubimiblog. arabotok-na-sajte/ Disallow:*https://moylubimiblog.ru/a naliz-sajta/yandeks-metrika/ Disallow:*https://moylubimiblog.ru/r ubrika-komputernie-programmy/ Host: https://moylubimiblog.ru

Sitemap:https://moylubimiblog.ru/sitemap_index.xml |

Файл sitemap_index.xml, который находится внизу строчки, теперь не вносится в готовом виде на хостинг. Он обновляется на лету, в плагине Yoast Seo. В дальнейшем файл будет изменяться, в соответствии с индексированием в ПС Яндекс. Однако некоторые правила могут быть добавлены или удалены. Получается, что файл robots.txt имеет общие директивы на всех сайтах, но вместе с тем есть индивидуальные запреты и разрешения для каждого блога.

2021 год

В вебмастер Яндекс захожу часто, но не все вкладки там смотрю. Однако сейчас зашла в статистику и посмотрела ее с 2017 года. Обнаружилась масса запретов на важные статьи. Все дело в том, что у меня в файле запрещены категории, в пуле для Яндекса. Решила их освободить. Для этого просто удалила строчку: Disallow: /category*. Теперь буду наблюдать, что будет.

Решила их освободить. Для этого просто удалила строчку: Disallow: /category*. Теперь буду наблюдать, что будет.

Еще заменила запреты для фидов. Они появились, потому что я удалила страницы турбо. Но, как известно фиды — это дубли. В файле robots.txt они были запрещены следующим образом:

Disallow: /?feed= Disallow:/feed/

Disallow: /?feed= Disallow:/feed/ |

Однако в заявках на удаление поисковые роботы отвечали -«отклонено». Меняю запись запрета для фидов.

Так будет правильно.

Disallow: */feed Disallow: /feed

Disallow: */feed Disallow: /feed |

После этой записи, в файле robots.txt, роботы Яндекса стали удалять фиды из поиска.

Опять изменения файла для ПС Гугл

ПС Гугл индексирует не все мои статьи. Об этом узнала в Гугл вебмастере. Стала разбираться и выяснила, что много ресурсов опять блокирует файл robots. txt. Изменяю его опять, но теперь только для Гугл, для Яндекса файл остается без изменения. Файл для Гугл выглядит, как код ниже.

txt. Изменяю его опять, но теперь только для Гугл, для Яндекса файл остается без изменения. Файл для Гугл выглядит, как код ниже.

User-agent: Mediapartners-Google Allow: /*/<папка содержащая css>/*.css Allow: /*/<папка содержащая js>/*.js Disallow: User-agent: * Disallow: /cgi-bin Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /wp-admin Disallow: /wp-content/cache Disallow: /xmlrpc.php

1 2 3 4 5 6 7 8 9 10 11 | User-agent: Mediapartners-Google Allow: /*/<папка содержащая css>/*.css Allow: /*/<папка содержащая js>/*.js Disallow: User-agent: * Disallow: /cgi-bin Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /wp-admin Disallow: /wp-content/cache Disallow: /xmlrpc.php |

После такого изменения, блокировка ресурсов была снята. Это видно по ссылкам со страниц проверки, в вебмастере Гугл.

Это видно по ссылкам со страниц проверки, в вебмастере Гугл.

Но не тут-то было. Потому что вскоре опять появились сообщения, Googlebot не смог пройти к 1-3 ресурсам. Тогда опять переписываю совсем свободный вход Гуглу.

User-agent:Google Allow:/*

User-agent:Google Allow:/* |

Но один ресурс закрывает еще Гугл adsense. Однако эта претензия уже не ко мне — надеюсь.

поисковые роботы — Robots.txt не препятствует сканированию моего сайта

У меня проблема с robots.txt.

Я положил файл robots.txt в основной каталог сайта (а также в /var/www/html — чтобы он работал на всех серверах), но роботы продолжают сканировать мои сайты.

это мой robots.txt:

User-agent: YandexBot Запретить: / Агент пользователя: SemrushBot Запретить: / Агент пользователя: AhrefsBot Запретить: / Агент пользователя: SemrushBot/1.2~bl Запретить: /

У вас есть предложения?

- поисковые роботы

- robots.

txt

txt - яндекс

4

Обратите внимание, что ваш файл robots.txt недействителен (но это не обязательно означает, что это является причиной вашей проблемы; боты могут игнорировать такие ошибки).

Если бот будет разбирать ваш файл robots.txt строго в соответствии со спецификацией robots.txt, то этот бот увидит только одну запись, и эта запись будет относиться только к ботам с именем «ЯндексБот». Всем другим ботам будет позволено сканировать все.

Причина в том, что записи должны быть разделены пустыми строками. Так и должно быть:

User-agent: YandexBot Запретить: / Агент пользователя: SemrushBot Запретить: / Агент пользователя: AhrefsBot Запретить: / Агент пользователя: SemrushBot/1.2~bl Запретить: /

Если у вас всегда будет один и тот же Disallow для всех этих ботов, вы можете использовать одну запись с несколькими строками User-agent , если хотите:

User-agent: YandexBot Агент пользователя: SemrushBot Агент пользователя: AhrefsBot Агент пользователя: SemrushBot/1.2~bl Запретить: /

(Возможно, вам придется использовать разные имена для некоторых ботов, которых вы собираетесь заблокировать, как предлагает @StephenOstermiller в своем ответе.)

После создания файла robots.txt сканерам потребуется день или больше почтить его, чтобы получить его.

Яндекс имеет ряд ботов и документацию о том, как запретить их всех с помощью robots.txt здесь: https://yandex.com/support/webmaster/controlling-robot/robots-txt.xml Возможно, вы захотите рассмотреть меняем свой robots.txt на этот для яндекса:

User-agent: Яндекс Запретить: /

SEM У Раша есть два бота. Их документация по этому поводу находится здесь: https://www.semrush.com/bot/ Вы правильно запретили одно из них, но ваше второе правило с номером версии бота не будет действовать. Вам следует рассмотреть возможность использования этих правил, чтобы запретить все сканирование SEM Rush:

Агент пользователя: SemrushBot Запретить: / Агент пользователя: SemrushBot-SA Запретить: /

Вы уже запрещаете AhrefsBot в соответствии с их документацией: https://ahrefs. com/robot

com/robot

Агент пользователя: AhrefsBot Запретить: /

Зарегистрируйтесь или войдите в систему

Зарегистрируйтесь с помощью Google

Зарегистрироваться через Facebook

Зарегистрируйтесь, используя адрес электронной почты и пароль

Опубликовать как гость

Электронная почта

Требуется, но не отображается

Опубликовать как гость

Электронная почта

Требуется, но не отображается

Нажимая «Опубликовать свой ответ», вы соглашаетесь с нашими условиями обслуживания, политикой конфиденциальности и политикой использования файлов cookie

.

robots.txt — Яндекс игнорирует Crawl-delay?

Задай вопрос

спросил

Изменено 2 года, 7 месяцев назад

Просмотрено 234 раза

Я пытаюсь взять под контроль бота Яндекса и близок к тому, чтобы его заблокировать.

После 2 месяцев корректировки robots.txt он все еще продолжает долбить мой сервер с нескольких IP-адресов.

Агент пользователя: * Задержка сканирования: 4 User-agent: Яндекс Задержка сканирования: 6

За неделю средняя задержка составляет 7,6 секунды (секунды/количество строк access_log). Но все же каждый день бывают пики, когда он продолжает долбить по минутам, используя разные IP-адреса.

Вот и пример: 336 запросов страниц (не считая файлов/скриптов и т.д.) с 12 IP за 276 секунд (~1,2 сек)

5.255.253.3 - - [27/Apr/2019:10:43:14 +0200] "ПОЛУЧАТЬ … 5.255.253.3 - - [27/апр/2019:10:43:15 +0200] "ПОЛУЧИТЬ… 141.8.132.29- - [27/Апр/2019:10:43:16 +0200] "ПОЛУЧИТЕ… 5.255.253.3 - - [27/апр/2019:10:43:16 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:17 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:43:18 +0200] "ПОЛУЧИТЬ… 37.9.113.7 - - [27/апр/2019:10:43:18 +0200] "ПОЛУЧИТЬ… 37.9.113.156 - - [27/апр/2019:10:43:18 +0200] "ПОЛУЧИТЬ… 141.8.132.26 - - [27/апр/2019:10:43:19 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:43:19 +0200] "ПОЛУЧИТЬ… 95.108.181.94 - - [27/апр/2019:10:43:19 +0200] "ПОЛУЧИТЬ… 87.250.224.50 - - [27 апреля 2019 г.:10:43:20 +0200] "ПОЛУЧИТЕ... 87.250.224.55 - - [27/апр/2019:10:43:21 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:22 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:43:23 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:24 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:43:24 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:25 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:28 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:28 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:43:29 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:43:31 +0200] "ПОЛУЧИТЕ... 5.255.253.3 - - [27/апр/2019:10:43:43 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:44 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:43:45 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:46 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:43:47 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:48 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:43:48 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:49 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:43:50 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:43:51 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:43:52 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:53 +0200] "ПОЛУЧИТЬ… 141.

8.132.29 - - [27/апр/2019:10:43:54 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:54 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:43:55 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:43:56 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:43:56 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:43:57 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:43:58 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:43:59 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:43:59 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:00 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:01 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:44:01 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:02 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:03 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:04 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:04 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:05 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27 апреля 2019 г.

:10:44:06 +0200] "ПОЛУЧИТЕ... 5.255.253.3 - - [27/апр/2019:10:44:06 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:07 +0200] "ПОЛУЧИТЬ... 141.8.132.29 - - [27/апр/2019:10:44:08 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:10 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:10 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:10 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:11 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:12 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:44:12 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:44:14 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:44:15 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:16 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:17 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:17 +0200] "ПОЛУЧИТЬ… 141.8.142.118 - - [27/апр/2019:10:44:18 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:19 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:19 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27/апр/2019:10:44:21 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:21 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:44:21 +0200] "ПОЛУЧИТЕ... 213.180.203.61 - - [27/апр/2019:10:44:22 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:23 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:24 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:24 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:25 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:25 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:44:25 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:26 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:27 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27 апреля 2019 г.:10:44:27 +0200] "ПОЛУЧИТЕ... 5.255.253.3 - - [27/апр/2019:10:44:28 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:29 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:30 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:31 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:32 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27/апр/2019:10:44:33 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:34 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:35 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:36 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:44:37 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:44:37 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:44:37 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:38 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:38 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:44:39 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:39 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:40 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:41 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:42 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:44:42 +0200] "ПОЛУЧИТЕ... 141.8.142.118 - - [27/апр/2019:10:44:42 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:43 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:44:43 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27/апр/2019:10:44:44 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:45 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:46 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:47 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:48 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:49 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:44:50 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:44:51 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:51 +0200] «ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:52 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:53 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:55 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:55 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:44:56 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:44:57 +0200] «ПОЛУЧИТЕ… 141.8.132.29 - - [27/апр/2019:10:44:59 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:45:00 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:45:00 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27/апр/2019:10:45:02 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:03 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:05 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:05 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:05 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:07 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:07 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:07 +0200] "ПОЛУЧИТЬ… 141.8.132.29- - [27/Апр/2019:10:45:08 +0200] "ПОЛУЧИТЕ… 213.180.203.61 - - [27/апр/2019:10:45:09 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:10 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:10 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:11 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:12 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:13 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:13 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:14 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:15 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27 апреля 2019 г.:10:45:15 +0200] "ПОЛУЧИТЕ... 5.255.253.3 - - [27/апр/2019:10:45:16 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:17 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:45:17 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:17 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:19 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:20 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:22 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:23 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:23 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:45:24 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:45:25 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:26 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:26 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:27 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:29 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:29 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:30 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27/апр/2019:10:45:31 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:32 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:45:32 +0200] "ПОЛУЧИТЕ... 213.180.203.61 - - [27/апр/2019:10:45:33 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:33 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:33 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:45:34 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:35 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:36 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:37 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:37 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:39 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27 апреля 2019 г.:10:45:39 +0200] "ПОЛУЧИТЕ... 87.250.224.119 - - [27/апр/2019:10:45:39 +0200] "ПОЛУЧИТЬ… 141.8.132.26 - - [27/апр/2019:10:45:40 +0200] "ПОЛУЧИТЬ… 141.8.142.118 - - [27/апр/2019:10:45:40 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:45:40 +0200] "ПОЛУЧИТЬ… 87.250.224.119 - - [27/апр/2019:10:45:41 +0200] "ПОЛУЧИТЬ… 141.

8.132.26 - - [27/апр/2019:10:45:41 +0200] "ПОЛУЧИТЬ… 141.8.142.118 - - [27/апр/2019:10:45:41 +0200] "ПОЛУЧИТЬ… 213.180.203.40 - - [27/апр/2019:10:45:42 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:43 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:45:44 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:45:44 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:45:45 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:46 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:48 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:49 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:49 +0200] "GET…" Mozilla/5.0 (iPhone; ЦП iPhone OS 8_1, как Mac OS X) AppleWebKit/600.1.4 (KHTML, как Gecko) Версия/8.0 Mobile/12B411 Safari/600.1.4 (совместимо; YandexMobileBot/3.0; +http://yandex.com/bots)" 141.8.132.29- - [27/Апр/2019:10:45:51 +0200] "ПОЛУЧИТЕ… 213.180.203.61 - - [27/апр/2019:10:45:51 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:51 +0200] "ПОЛУЧИТЬ… 141.8.132.

26 - - [27/апр/2019:10:45:52 +0200] "ПОЛУЧИТЬ… 141.8.142.118 - - [27/апр/2019:10:45:52 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:53 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:53 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:45:54 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:54 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27 апреля 2019 г.:10:45:54 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:45:56 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:56 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:57 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:45:57 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:45:59 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:45:59 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:02 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:02 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:03 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:46:05 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:46:05 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27/апр/2019:10:46:06 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:07 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:08 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:08 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:08 +0200] "ПОЛУЧИТЬ… 87.250.224.119 - - [27/апр/2019:10:46:09 +0200] "ПОЛУЧИТЬ… 141.8.132.26 - - [27/апр/2019:10:46:09 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:10 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:46:10 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:46:10 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:12 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:13 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:14 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:15 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:17 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:17 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:18 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:19 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27 апреля 2019 г.:10:46:20 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:46:22 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:22 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:24 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:24 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:24 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:25 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:27 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:27 +0200] "ПОЛУЧИТЬ... 141.8.132.29 - - [27/апр/2019:10:46:28 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27 апреля 2019 г.:10:46:28 +0200] "ПОЛУЧИТЕ... 5.255.253.3 - - [27/апр/2019:10:46:29 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:29 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:30 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:32 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:32 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:32 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:33 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27/апр/2019:10:46:34 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:35 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:46:35 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:46:35 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:36 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:36 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:36 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:37 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:38 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:38 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:39 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:40 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:46:41 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:46:42 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:43 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:44 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:46 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:48 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27/апр/2019:10:46:48 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:48 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:50 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:50 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:46:50 +0200] "ПОЛУЧИТЕ... 5.255.253.3 - - [27/апр/2019:10:46:51 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:52 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:52 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:53 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:53 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:54 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:46:55 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:55 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:55 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:46:56 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:46:56 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:46:56 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:46:58 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27/апр/2019:10:46:59 +0200] «ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:01 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:02 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:03 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:04 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:05 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:47:06 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:47:07 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:08 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:10 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:11 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:11 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:12 +0200] «ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:47:13 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:13 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:14 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:47:15 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:47:15 +0200] "ПОЛУЧИТЬ… 141.

8.132.29 - - [27/апр/2019:10:47:16 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:17 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:18 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:19 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:19 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:20 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:20 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:47:21 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27 апреля 2019 г.:10:47:22 +0200] "ПОЛУЧИТЕ... 141.8.132.29 - - [27/апр/2019:10:47:22 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:47:23 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:23 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:23 +0200] "ПОЛУЧИТЬ… 87.250.224.119 - - [27/апр/2019:10:47:24 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:26 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:27 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:27 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:28 +0200] "ПОЛУЧИТЬ… 141.

8.132.29- - [27/Апр/2019:10:47:28 +0200] "ПОЛУЧИТЕ… 213.180.203.61 - - [27/апр/2019:10:47:29 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:29 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:30 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:31 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:33 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:34 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:34 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:35 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27 апреля 2019 г.:10:47:36 +0200] "ПОЛУЧИТЕ... 213.180.203.61 - - [27/апр/2019:10:47:37 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:37 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:37 +0200] "ПОЛУЧИТЬ… 213.180.203.61 - - [27/апр/2019:10:47:38 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:39 +0200] "ПОЛУЧИТЬ… 141.8.132.29 - - [27/апр/2019:10:47:39 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:48 +0200] "ПОЛУЧИТЬ… 5.255.253.3 - - [27/апр/2019:10:47:50 +0200] "ПОЛУЧИТЬ… 5.

255.253.3 - - [27/апр/2019:10:47:50 +0200] "ПОЛУЧИТЬ…

Это всего лишь выдержка из 40-минутного «посещения» с 1547 запросами страниц с 18 IP-адресов (~1,57 с).

Когда боты Google и Bing активны одновременно, я получаю высокую загрузку ЦП.

Значит, Яндекс игнорирует мое правило Crawl-delay ?

Как я могу заставить его не забивать сервер, как указано выше?

- robots.txt

- скорость сканирования

- yandex

Если вы считаете, что yandex не соблюдает директиву Crawl-delay , попробуйте зарегистрироваться в Yandex Webmasters и подтвердить свой домен.

После завершения проверки вы можете вручную установить скорость сканирования ниже 9.0120 Индексирование -> Скорость сканирования

Рекомендуем прочитать эту статью в Руководстве Яндекса для веб-мастеров по инструментам Яндекса для веб-мастеров

2

От службы поддержки Yandex Webmastertools

С 22 февраля 2018 года Яндекс не учитывает директиву Crawl-delay.

д.

д. Индексирует изображения.

Индексирует изображения.

ru

ru php

php ru/z

ru/z txt

txt 2~bl

Запретить: /

2~bl

Запретить: /

8.132.29 - - [27/апр/2019:10:43:24 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:25 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:28 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:28 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:29 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:43:31 +0200] "ПОЛУЧИТЕ...

5.255.253.3 - - [27/апр/2019:10:43:43 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:44 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:45 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:46 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:47 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:48 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:48 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:49 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:43:50 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:43:51 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:43:52 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:53 +0200] "ПОЛУЧИТЬ…

141.

8.132.29 - - [27/апр/2019:10:43:24 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:25 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:28 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:28 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:29 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:43:31 +0200] "ПОЛУЧИТЕ...

5.255.253.3 - - [27/апр/2019:10:43:43 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:44 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:45 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:46 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:47 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:48 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:48 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:49 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:43:50 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:43:51 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:43:52 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:53 +0200] "ПОЛУЧИТЬ…

141. 8.132.29 - - [27/апр/2019:10:43:54 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:54 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:43:55 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:56 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:56 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:43:57 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:58 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:43:59 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:43:59 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:00 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:01 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:01 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:02 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:03 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:04 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:04 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:05 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27 апреля 2019 г.

8.132.29 - - [27/апр/2019:10:43:54 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:54 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:43:55 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:43:56 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:56 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:43:57 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:43:58 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:43:59 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:43:59 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:00 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:01 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:01 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:02 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:03 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:04 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:04 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:05 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27 апреля 2019 г. :10:44:06 +0200] "ПОЛУЧИТЕ...

5.255.253.3 - - [27/апр/2019:10:44:06 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:07 +0200] "ПОЛУЧИТЬ...

141.8.132.29 - - [27/апр/2019:10:44:08 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:10 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:10 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:10 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:11 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:12 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:12 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:44:14 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:44:15 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:16 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:17 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:17 +0200] "ПОЛУЧИТЬ…

141.8.142.118 - - [27/апр/2019:10:44:18 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:19 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:19 +0200] "ПОЛУЧИТЬ…

5.

:10:44:06 +0200] "ПОЛУЧИТЕ...

5.255.253.3 - - [27/апр/2019:10:44:06 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:07 +0200] "ПОЛУЧИТЬ...

141.8.132.29 - - [27/апр/2019:10:44:08 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:10 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:10 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:10 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:11 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:12 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:12 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:44:14 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:44:15 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:16 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:17 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:17 +0200] "ПОЛУЧИТЬ…

141.8.142.118 - - [27/апр/2019:10:44:18 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:19 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:19 +0200] "ПОЛУЧИТЬ…

5. 255.253.3 - - [27/апр/2019:10:44:21 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:21 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:44:21 +0200] "ПОЛУЧИТЕ...

213.180.203.61 - - [27/апр/2019:10:44:22 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:23 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:24 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:24 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:25 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:25 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:25 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:26 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:27 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27 апреля 2019 г.:10:44:27 +0200] "ПОЛУЧИТЕ...

5.255.253.3 - - [27/апр/2019:10:44:28 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:29 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:30 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:31 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:32 +0200] "ПОЛУЧИТЬ…

5.

255.253.3 - - [27/апр/2019:10:44:21 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:21 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:44:21 +0200] "ПОЛУЧИТЕ...

213.180.203.61 - - [27/апр/2019:10:44:22 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:23 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:24 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:24 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:25 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:25 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:25 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:26 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:27 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27 апреля 2019 г.:10:44:27 +0200] "ПОЛУЧИТЕ...

5.255.253.3 - - [27/апр/2019:10:44:28 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:29 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:30 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:31 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:32 +0200] "ПОЛУЧИТЬ…

5. 255.253.3 - - [27/апр/2019:10:44:33 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:34 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:35 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:36 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:44:37 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:44:37 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:37 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:38 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:38 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:39 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:39 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:40 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:41 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:42 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:44:42 +0200] "ПОЛУЧИТЕ...

141.8.142.118 - - [27/апр/2019:10:44:42 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:43 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:43 +0200] "ПОЛУЧИТЬ…

5.

255.253.3 - - [27/апр/2019:10:44:33 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:34 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:35 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:36 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:44:37 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:44:37 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:37 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:38 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:38 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:39 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:39 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:40 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:41 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:42 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:44:42 +0200] "ПОЛУЧИТЕ...

141.8.142.118 - - [27/апр/2019:10:44:42 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:43 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:44:43 +0200] "ПОЛУЧИТЬ…

5. 255.253.3 - - [27/апр/2019:10:44:44 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:45 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:46 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:47 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:48 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:49 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:44:50 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:44:51 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:51 +0200] «ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:52 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:53 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:55 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:55 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:56 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:57 +0200] «ПОЛУЧИТЕ…

141.8.132.29 - - [27/апр/2019:10:44:59 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:45:00 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:45:00 +0200] "ПОЛУЧИТЬ…

5.

255.253.3 - - [27/апр/2019:10:44:44 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:45 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:46 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:47 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:48 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:49 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:44:50 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:44:51 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:51 +0200] «ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:52 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:53 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:55 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:55 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:44:56 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:44:57 +0200] «ПОЛУЧИТЕ…

141.8.132.29 - - [27/апр/2019:10:44:59 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:45:00 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:45:00 +0200] "ПОЛУЧИТЬ…

5. 255.253.3 - - [27/апр/2019:10:45:02 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:03 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:05 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:05 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:05 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:07 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:07 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:07 +0200] "ПОЛУЧИТЬ…

141.8.132.29- - [27/Апр/2019:10:45:08 +0200] "ПОЛУЧИТЕ…

213.180.203.61 - - [27/апр/2019:10:45:09 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:10 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:10 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:11 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:12 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:13 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:13 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:14 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:15 +0200] "ПОЛУЧИТЬ…

5.

255.253.3 - - [27/апр/2019:10:45:02 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:03 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:05 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:05 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:05 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:07 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:07 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:07 +0200] "ПОЛУЧИТЬ…

141.8.132.29- - [27/Апр/2019:10:45:08 +0200] "ПОЛУЧИТЕ…

213.180.203.61 - - [27/апр/2019:10:45:09 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:10 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:10 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:11 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:12 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:13 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:13 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:14 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:15 +0200] "ПОЛУЧИТЬ…

5. 255.253.3 - - [27 апреля 2019 г.:10:45:15 +0200] "ПОЛУЧИТЕ...

5.255.253.3 - - [27/апр/2019:10:45:16 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:17 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:17 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:17 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:19 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:20 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:22 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:23 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:23 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:45:24 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:45:25 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:26 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:26 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:27 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:29 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:29 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:30 +0200] "ПОЛУЧИТЬ…

5.

255.253.3 - - [27 апреля 2019 г.:10:45:15 +0200] "ПОЛУЧИТЕ...

5.255.253.3 - - [27/апр/2019:10:45:16 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:17 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:17 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:17 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:19 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:20 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:22 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:23 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:23 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:45:24 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:45:25 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:26 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:26 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:27 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:29 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:29 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:30 +0200] "ПОЛУЧИТЬ…

5. 255.253.3 - - [27/апр/2019:10:45:31 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:32 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:45:32 +0200] "ПОЛУЧИТЕ...

213.180.203.61 - - [27/апр/2019:10:45:33 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:33 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:33 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:34 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:35 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:36 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:37 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:37 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:39 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27 апреля 2019 г.:10:45:39 +0200] "ПОЛУЧИТЕ...

87.250.224.119 - - [27/апр/2019:10:45:39 +0200] "ПОЛУЧИТЬ…

141.8.132.26 - - [27/апр/2019:10:45:40 +0200] "ПОЛУЧИТЬ…

141.8.142.118 - - [27/апр/2019:10:45:40 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:40 +0200] "ПОЛУЧИТЬ…

87.250.224.119 - - [27/апр/2019:10:45:41 +0200] "ПОЛУЧИТЬ…

141.

255.253.3 - - [27/апр/2019:10:45:31 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:32 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:45:32 +0200] "ПОЛУЧИТЕ...

213.180.203.61 - - [27/апр/2019:10:45:33 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:33 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:33 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:34 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:35 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:36 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:37 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:37 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:39 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27 апреля 2019 г.:10:45:39 +0200] "ПОЛУЧИТЕ...

87.250.224.119 - - [27/апр/2019:10:45:39 +0200] "ПОЛУЧИТЬ…

141.8.132.26 - - [27/апр/2019:10:45:40 +0200] "ПОЛУЧИТЬ…

141.8.142.118 - - [27/апр/2019:10:45:40 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:40 +0200] "ПОЛУЧИТЬ…

87.250.224.119 - - [27/апр/2019:10:45:41 +0200] "ПОЛУЧИТЬ…

141. 8.132.26 - - [27/апр/2019:10:45:41 +0200] "ПОЛУЧИТЬ…

141.8.142.118 - - [27/апр/2019:10:45:41 +0200] "ПОЛУЧИТЬ…

213.180.203.40 - - [27/апр/2019:10:45:42 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:43 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:45:44 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:45:44 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:45 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:46 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:48 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:49 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:49 +0200] "GET…" Mozilla/5.0 (iPhone; ЦП iPhone OS 8_1, как Mac OS X) AppleWebKit/600.1.4 (KHTML, как Gecko) Версия/8.0 Mobile/12B411 Safari/600.1.4 (совместимо; YandexMobileBot/3.0; +http://yandex.com/bots)"

141.8.132.29- - [27/Апр/2019:10:45:51 +0200] "ПОЛУЧИТЕ…

213.180.203.61 - - [27/апр/2019:10:45:51 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:51 +0200] "ПОЛУЧИТЬ…

141.8.132.

8.132.26 - - [27/апр/2019:10:45:41 +0200] "ПОЛУЧИТЬ…

141.8.142.118 - - [27/апр/2019:10:45:41 +0200] "ПОЛУЧИТЬ…

213.180.203.40 - - [27/апр/2019:10:45:42 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:43 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:45:44 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:45:44 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:45 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:46 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:48 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:49 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:49 +0200] "GET…" Mozilla/5.0 (iPhone; ЦП iPhone OS 8_1, как Mac OS X) AppleWebKit/600.1.4 (KHTML, как Gecko) Версия/8.0 Mobile/12B411 Safari/600.1.4 (совместимо; YandexMobileBot/3.0; +http://yandex.com/bots)"

141.8.132.29- - [27/Апр/2019:10:45:51 +0200] "ПОЛУЧИТЕ…

213.180.203.61 - - [27/апр/2019:10:45:51 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:51 +0200] "ПОЛУЧИТЬ…

141.8.132. 26 - - [27/апр/2019:10:45:52 +0200] "ПОЛУЧИТЬ…

141.8.142.118 - - [27/апр/2019:10:45:52 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:53 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:53 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:54 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:54 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27 апреля 2019 г.:10:45:54 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:45:56 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:56 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:57 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:57 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:59 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:59 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:02 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:02 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:03 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:46:05 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:46:05 +0200] "ПОЛУЧИТЬ…

5.

26 - - [27/апр/2019:10:45:52 +0200] "ПОЛУЧИТЬ…

141.8.142.118 - - [27/апр/2019:10:45:52 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:53 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:53 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:54 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:54 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27 апреля 2019 г.:10:45:54 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:45:56 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:56 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:57 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:45:57 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:45:59 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:45:59 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:02 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:02 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:03 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:46:05 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:46:05 +0200] "ПОЛУЧИТЬ…

5. 255.253.3 - - [27/апр/2019:10:46:06 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:46:07 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:46:08 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:08 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:46:08 +0200] "ПОЛУЧИТЬ…

87.250.224.119 - - [27/апр/2019:10:46:09 +0200] "ПОЛУЧИТЬ…

141.8.132.26 - - [27/апр/2019:10:46:09 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:46:10 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:46:10 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:46:10 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:12 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:13 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:14 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:15 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:17 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:17 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:18 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:19 +0200] "ПОЛУЧИТЬ…

5.

255.253.3 - - [27/апр/2019:10:46:06 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:46:07 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:46:08 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:08 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:46:08 +0200] "ПОЛУЧИТЬ…

87.250.224.119 - - [27/апр/2019:10:46:09 +0200] "ПОЛУЧИТЬ…

141.8.132.26 - - [27/апр/2019:10:46:09 +0200] "ПОЛУЧИТЬ…

213.180.203.61 - - [27/апр/2019:10:46:10 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27 апреля 2019 г.:10:46:10 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:46:10 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:12 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:13 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:14 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:15 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:17 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:17 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:18 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:19 +0200] "ПОЛУЧИТЬ…

5. 255.253.3 - - [27 апреля 2019 г.:10:46:20 +0200] "ПОЛУЧИТЕ...

141.8.132.29 - - [27/апр/2019:10:46:22 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:22 +0200] "ПОЛУЧИТЬ…

141.8.132.29 - - [27/апр/2019:10:46:24 +0200] "ПОЛУЧИТЬ…

5.255.253.3 - - [27/апр/2019:10:46:24 +0200] "ПОЛУЧИТЬ…