Блокировка пауков, кэшированные страницы и многое другое

На прошлой неделе я рассказал о новой команде для мета-тега robots, которая предотвращает использование поисковыми системами заголовков и описаний Yahoo. При этом возник ряд вопросов о самом синтаксисе метатегов robots. Google Webmaster Central теперь опубликовал «Использование метатега robots», внося некоторую ясность от Google. Кроме того, и Yahoo, и Microsoft прислали мне информацию об использовании этого тега. Я пройдусь по тому, что все говорят ниже, вместе с диаграммами для легкого сравнения.

Метатег robots был открытым стандартом, созданным более десяти лет назад и первоначально предназначенным для того, чтобы позволить авторам страниц предотвращать индексацию страниц. За прошедшие годы различные поисковые системы добавили тегу дополнительную поддержку.

Позвольте мне начать с того, что если вы ДЕЙСТВИТЕЛЬНО хотите, чтобы ваши страницы были в поисковых системах, то НЕ используйте тег. По умолчанию основные поисковые системы индексируют любую найденную страницу.

Существует также форма, которую вы можете использовать, которая добавляет команду «follow», которая сообщает поисковым системам проиндексировать вашу страницу, а также переходить по любым ссылкам, которые они находят на этой странице, на другие страницы, которые они затем могут проиндексировать. Это выглядит так:

Вам НЕ нужно использовать ни одну из форм, если вы ДЕЙСТВИТЕЛЬНО хотите, чтобы ваши страницы были в поисковых системах. Без какой-либо формы они, естественно, будут индексировать ваши страницы и переходить по вашим ссылкам. Вот что они делают.

Я всегда шучу, что размещение этих форм метатега robots на ваших веб-страницах равносильно тому, чтобы приклеить себе на грудь записку с надписью «дышите».

Теперь, если вы НЕ хотите, чтобы ваши страницы попадали в поисковик, то, возможно, пришло время выбить метатег robots, если по какой-то причине альтернатива robots.txt не подходит. Хотите сохранить определенную страницу вне? Затем поместите это на эту страницу:

Видите значение «noindex»? Это говорит поисковым системам, которые видят эту страницу, не включать их в свои списки. Помните — как я объяснял ранее — это не предотвратит сканирование страниц. Это связано с тем, что поисковые системы должны постоянно просматривать страницу, чтобы убедиться, что тег удален. Тег только удерживает страницу. Вот мой предыдущий график на эту тему.

| Система | Роботы. тхт | Мета Роботы | Yahoo Удалить Вариант URL |

| Остановка сканирования | Да | № | № |

| Включение указателя остановок | Да | Да | Да |

| Останавливает только список ссылок | № | Нет (Да, для Google) | Да |

| Зачем использовать? | Легко заблокировать несколько страниц одновременно | Не удается получить доступ к корневому домену | Не нужно даже отображать URL-адрес или нужно быстро вывести страницу |

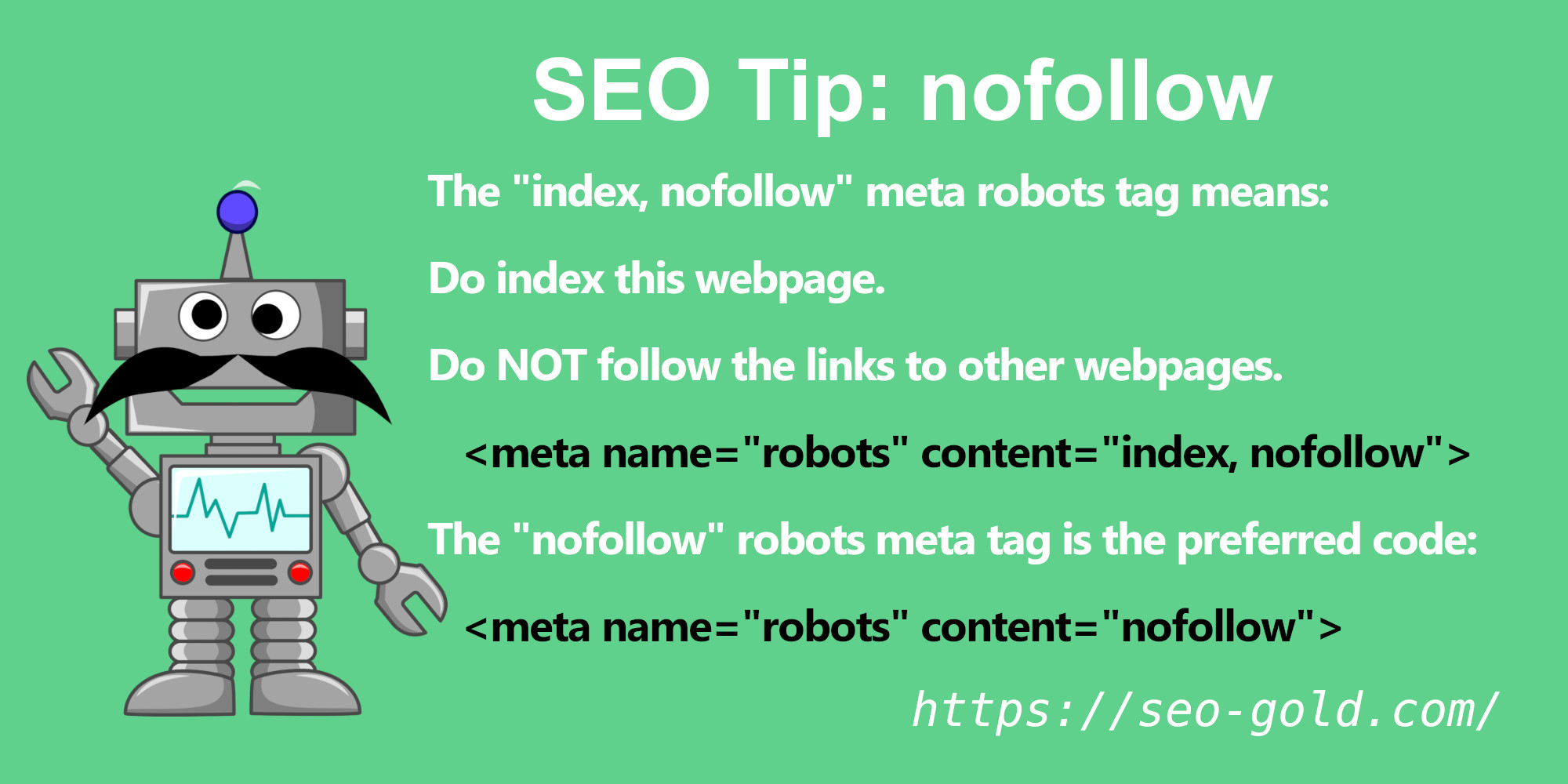

Что делать, если вы не хотите переходить по ссылкам? Конечно, вы можете сделать это:

Эта дополнительная команда «nofollow» говорит поисковым системам не переходить ни по каким ссылкам на этой странице.

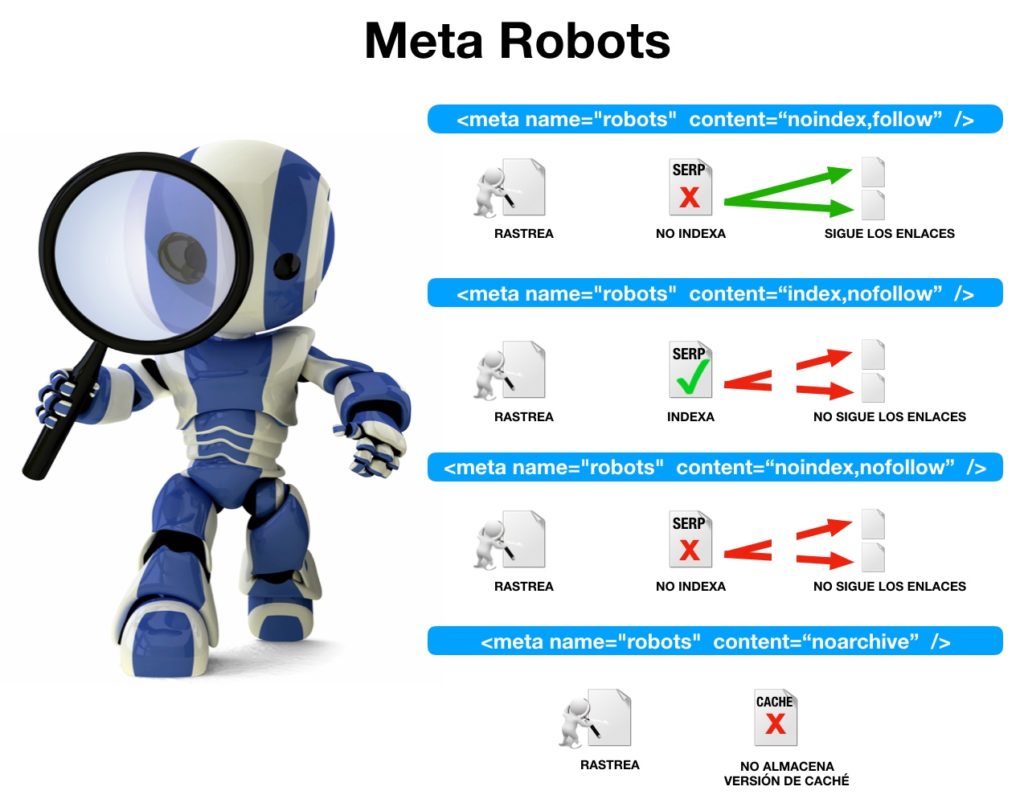

До сих пор я рассмотрел все команды, которые изначально были созданы с помощью тега еще в мае 1996 года. С тех пор было добавлено больше команд (также называемых значениями или атрибутами). Например, Google пишет сегодня, чтобы обобщить несколько вариантов, которые вы можете использовать. Цитирование Google:

- NOINDEX — предотвращает попадание страницы в индекс.

- NOFOLLOW — запрещает роботу Googlebot переходить по любым ссылкам на странице. (Обратите внимание, что это отличается от атрибута NOFOLLOW на уровне ссылки, который не позволяет роботу Googlebot переходить по отдельной ссылке.)

- NOARCHIVE — запрещает кэшированную копию этой страницы быть доступной в результатах поиска.

- NOSNIPPET — предотвращает появление описания под страницей в результатах поиска, а также предотвращает кеширование страницы.

- NOODP — блокирует использование описания страницы Open Directory Project в описании, которое появляется под страницей в результатах поиска.

Иногда может понадобиться использовать более одной из этих команд. Я вернусь к этому. Но сначала, как насчет другого графика? Ниже я расскажу об основных командах, которые вы, возможно, захотите использовать:

| КОМАНДА | Майкрософт | Yahoo | ||

| НОИНДЕКС | Да | Да | Да | Да |

| NOFOLLOW | Да | Да | Да | Да |

| НОАРХИВ | Да | Да | Да | Да |

| НООДП | № | Да | Да | Да |

| НОЙДИР | № | № | № | Да |

| НОСНИППЕТ | № | Да | № | № |

| Робот Имя | ТЕОМА | ГУГЛБОТ | МСНБОТ | ХЛЕБ |

| ??? | № | № | № |

Некоторые из них уже объяснены выше, в том, что я цитировал из Google. Точно так же они работают и с другими основными поисковыми системами. Я также дал ссылку на справочную информацию от каждой поисковой системы для получения более конкретных советов.

Точно так же они работают и с другими основными поисковыми системами. Я также дал ссылку на справочную информацию от каждой поисковой системы для получения более конкретных советов.

Команда NOYDIR полностью объяснена в моем предыдущем посте Yahoo Предоставляет NOYDIR Opt-Out Of Yahoo Directory Titles & Descriptions. Это поддерживает только Yahoo, но ни одна из других крупных поисковых систем не использовала заголовки и описания Yahoo для списков, поэтому для них это не имеет большого значения.

Теперь перейдем к теме метатега robots, имеющего несколько значений. Что делать, если вы хотите, чтобы страница не кэшировалась всеми основными поисковыми системами, а также гарантировать, что ни описания Open Directory, ни Yahoo Directory не используются. Во-первых, вам нужны значения команд, чтобы сказать это. Из таблицы выше это:

- NOARCHIVE

- НООДП

- НОЙДИР

Далее вам нужно решить, на каких роботов нацелиться. Мы пока не будем усложнять. Чтобы настроить таргетинг на ВСЕХ роботов, используйте это значение: 9.0003

Чтобы настроить таргетинг на ВСЕХ роботов, используйте это значение: 9.0003

- РОБОТЫ

Теперь к формату мета-роботов. Без значений это выглядит так:

Мы заменяем эту часть NAME-OF-ROBOTS-TO-TARGET на имя роботов, на которых мы нацелены. Как объяснено, это РОБОТЫ, чтобы нацеливаться на них всех. Ниже я выделен жирным шрифтом:

Затем вы сообщите всем основным поисковым системам не кэшировать страницу и не используйте заголовки или описания Open Directory или Yahoo Directory для своих списков страниц.

Обратите внимание, что в приведенном выше теге нет пробелов между командами. Что, если бы я сделал это?

Google сегодня пишет, что пробелы не имеют значения. Используйте их, хотите вы или нет, тег означает то же самое. Microsoft говорит мне то же самое, что и Yahoo.

Что, если бы вы сделали это, без запятых:

Microsoft говорит мне, что все в порядке. Я не спрашивал Yahoo об этом, и Google говорит, что запятые ДОЛЖНЫ использоваться. Так что ставьте запятые и не мучайтесь.

А что, если вы хотите сообщить поисковой системе разные вещи. Возможно, вы хотите, чтобы Microsoft не использовала описания ODP, Google не кэшировал страницы, Yahoo не переходил по ссылкам на странице и попросил вообще не индексировать страницу. Может быть, вы тоже хотите проверить свою голову на предмет ее странности. Но помимо вашего психического здоровья, все это можно сделать.

Но помимо вашего психического здоровья, все это можно сделать.

У вас должен быть тег robots для каждой конкретной поисковой системы, на которую вы хотите настроить таргетинг. Видите этот график выше? Внизу есть строка «Имя робота». Это показывает вам имя «робота» или «паука» каждой поисковой системы, которому вы дадите команду. С именами роботов мы затем даем каждому из них свои конкретные команды:

Вы также можете указать всем роботам сделать одну вещь — сказать не переходить по ссылкам — а также выдать вторую специфичную для роботов команду, например запретить кэширование страницы только Google:

9 0039

Но разве поисковая система не будет следовать только определенному тегу, написанному для нее? Другими словами, если вы нацелите Google на определенную команду в теге «GOOGLEBOT», не будет ли он следовать только этому тегу и игнорировать другой?

Google, Microsoft и Yahoo заявили, что почтит их обоих. Не знаю насчет Аска. Вот почему вы видите «???» в этом «Тег, специфичный для робота, переопределяет все теги роботов?» часть диаграммы выше. Я постараюсь получить на это ответ.

Не знаю насчет Аска. Вот почему вы видите «???» в этом «Тег, специфичный для робота, переопределяет все теги роботов?» часть диаграммы выше. Я постараюсь получить на это ответ.

Что делать, если у вас есть более одного тега «все» роботы, например:

Как объяснялось, вы можете легко сделать это вместо этого: 900 03

Но если по какой-то причине вы сделали это по-другому, Microsoft и Yahoo сказали мне, что это нормально. Они учитывают информацию в ОБОИХ тегах robots. Сегодняшний пост Google говорит то же самое.

Наконец, сообщение Google подтверждает, что использование заглавных букв не имеет значения. Выше я показывал вещи по-разному, иногда команды ВСЕМИ ЗАГЛАВНЫМИ БУКВАМИ, иногда строчными буквами. Как говорит Google, регистр значения не имеет. Цитирую их пост:

Googlebot понимает любую комбинацию строчных и прописных букв.

.Таким образом, каждый из этих метатегов интерпретируется одинаково:

Ах, а как насчет чего-то вроде этого:

Ну, Google не зашел так далеко. Но мой опыт за последнее десятилетие показал, что метатеги вообще не чувствительны к регистру в основных поисковых системах. Так что я думаю, что вы в безопасности в любом случае, для всех основных поисковых систем.

Мнения, высказанные в этой статье, принадлежат приглашенному автору и не обязательно принадлежат Search Engine Land. Штатные авторы перечислены здесь.

Нет: в метатеге Robots обнаружен Noindex — подробное руководство по пониманию и устранению проблемы | by Teamcode

4 минуты чтения·

11 мая Вы когда-нибудь сталкивались с термином «noindex» в метатегах robots и задавались вопросом, что он означает? Если это так, вы находитесь в правильном месте! Правильная индексация вашего веб-сайта необходима для поисковой оптимизации (SEO), поскольку она помогает поисковым системам понимать и ранжировать ваш контент. В этом подробном руководстве мы углубимся в мир метатегов noindex и robots, чтобы помочь вам понять и исправить любые проблемы, которые могут повлиять на видимость вашего сайта в поисковых системах.

В этом подробном руководстве мы углубимся в мир метатегов noindex и robots, чтобы помочь вам понять и исправить любые проблемы, которые могут повлиять на видимость вашего сайта в поисковых системах.

Noindex — это директива, используемая в метатегах роботов, чтобы запретить поисковым роботам индексировать определенные страницы на вашем веб-сайте. Это может быть полезно, если вы хотите скрыть определенный контент от результатов поиска. Метатеги robots — это фрагменты кода, размещенные в разделе заголовка веб-страницы, которые предоставляют поисковым роботам инструкции о том, как обрабатывать контент.

Сканеры поисковых систем, такие как Googlebot, переходят по ссылкам в Интернете для обнаружения и индексации веб-страниц. Когда они сталкиваются со страницей с тегом noindex, они пропускают ее индексацию, эффективно предотвращая ее появление в результатах поиска.

Теги Noindex могут быть обнаружены на вашем веб-сайте по разным причинам. Иногда они размещаются намеренно, чтобы определенные страницы, такие как области администрирования, экраны входа в систему или дублированный контент, были скрыты от результатов поиска. Однако они также могут быть добавлены непреднамеренно во время разработки или обновления веб-сайта.

Однако они также могут быть добавлены непреднамеренно во время разработки или обновления веб-сайта.

Еще одна причина, по которой вы можете обнаружить теги noindex на своем сайте, связана со сторонними плагинами и темами, которые могут автоматически добавлять их на определенные страницы. Системы управления контентом, такие как WordPress, также могут вводить теги noindex во время обновлений или в результате определенных настроек. Наконец, неправильные директивы в вашем файле robots.txt также могут вызвать проблемы с отсутствием индекса.

Чтобы выявить проблемы с отсутствием индекса, можно использовать несколько методов. Google Search Console — отличный инструмент, предоставляющий отчеты об индексации, позволяющие увидеть, какие страницы были исключены из-за тегов noindex. Еще один способ выявить проблемы с отсутствием индекса — вручную проверить исходный код страницы. Это позволит вам найти метатег robots и проверить директивы noindex. Кроме того, инструменты SEO, такие как SEMrush, Ahrefs или SEO-GO, могут помочь в обнаружении проблем с отсутствием индекса на вашем веб-сайте.

Обнаружив проблемы с отсутствием индекса, вы можете предпринять следующие шаги для их устранения:

- Отредактируйте HTML-код своего веб-сайта, чтобы удалить директиву noindex из метатега robots.

- Убедитесь, что ваш файл robots.txt не блокирует непреднамеренно индексацию ваших страниц роботами поисковых систем.

- Проверьте настройки CMS на наличие параметров, которые могут вызвать проблемы с отсутствием индекса, и исправьте их.

- Выявите и устраните любые конфликты, вызванные плагинами или темами, которые могут добавлять теги noindex.

После решения проблем с отсутствием индекса крайне важно убедиться, что ваш сайт индексируется правильно. Вы можете сделать это, повторно отправив карту сайта вашего веб-сайта в Google Search Console, используя инструмент «Просмотреть как Google» или «Проверка URL», чтобы запросить повторное сканирование ваших страниц, и отслеживая статус индексации в Google Search Console.

Чтобы оптимизировать индексацию вашего веб-сайта, следуйте этим рекомендациям:

- Используйте теги noindex только для страниц, которые вы хотите исключить из результатов поиска, и теги index для страниц, которые поисковые системы должны сканировать и индексировать.

- Регулярно обновляйте карту сайта новыми и измененными страницами, чтобы помочь поисковым системам быстрее находить и индексировать ваш контент.

- Оптимизируйте свой краулинговый бюджет, уменьшив количество некачественных или нерелевантных страниц на своем веб-сайте, обеспечив эффективное использование ресурсов сканерами поисковых систем.

- Упростите для поисковых систем и пользователей навигацию по вашему веб-сайту, используя четкие структуры URL-адресов, логические внутренние ссылки и удобные меню навигации.

Понимание важности метатегов noindex и robots имеет решающее значение для успеха SEO вашего сайта. Активно отслеживая и оптимизируя индексацию вашего веб-сайта, вы можете гарантировать, что ваш контент достигнет целевой аудитории через результаты поисковых систем. Помните о советах и рекомендациях из этого руководства, чтобы решить любые проблемы с отсутствием индекса, и наблюдайте, как ваш веб-сайт поднимается на вершину рейтинга поисковых систем.

Таким образом, каждый из этих метатегов интерпретируется одинаково:

Таким образом, каждый из этих метатегов интерпретируется одинаково: