В чем разница dofollow и nofollow ссылки. Все правила применения атрибута nofollow в SEO в 2022

Споры о том, нужны ли nofollow-ссылки для SEO — бесконечны. Главный тезис спора

Если nofollow-ссылки не передают ссылочный вес, а значит не влияют на продвижение сайта, зачем их добывать?

Если вы согласны с этим мнением, то сегодня ваш мир изменится 😉

В этой статье мы разберем, что такое dofollow-ссылка и nofollow-ссылка, чем они отличаются и нужно ли использовать nofollow-ссылки при продвижении сайта в 2021.

Но обо всем по порядку …

Содержание:

- Что такое dofollow-ссылки?

- Что такое nofollow-ссылки?

- В чем разница между dofollow-ссылкой и nofollow-ссылкой?

- Зачем нужны nofollow ссылки в линкбилдинге?

- Аргумент №1: доверяем лидерам

- Аргумент № 2: сайтов со 100% dofollow ссылками нет

- Аргумент № 3: огромное количество топовых площадок размещают только nofollow

- Что вам дает использование nofollow ссылок?

- Как понять, что ссылка nofollow? И что такое nofollow noopener?

- Nofollow в Google

- Зачем вообще нужны ссылки бизнесу?

- Повышение узнаваемости

- Лидогенерация

- Ссылки порождают ссылки

- Где взять лучшие nofollow-ссылки?

- Видеохостинги

- Социальные сети

- Форумы

- Q/A

- Вместо заключения

Что такое dofollow-ссылки?

Техническое определение:

Dofollow — гиперссылки, ведущие на определенный сайт или страницу. Дуфоллоу-ссылки дают роботам поисковых систем сигнал к переходу и сканированию страницы, на которой расположены.

Дуфоллоу-ссылки дают роботам поисковых систем сигнал к переходу и сканированию страницы, на которой расположены.

Пример:

<a href="url" rel="dofollow">текст ссылки</a>

Что такое nofollow-ссылки?

Техническое определение:

Nofollow — это значение атрибута rel для HTML-тега «a» (rel="nofollow").

Пример:

<a href="http://site.com/" rel="nofollow">текст ссылки</a>

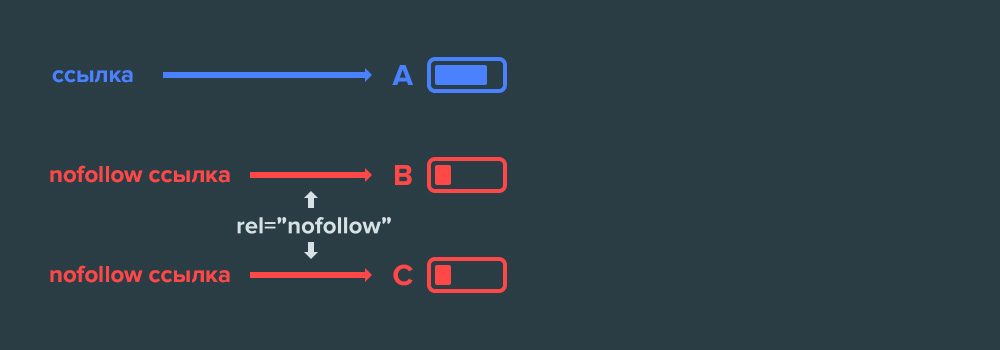

В чем разница между dofollow-ссылкой и nofollow-ссылкой?

Дуфоллоу-ссылки 100% учитываются поисковыми системами, а нофоллоу учитываются выборочно. Они больше работают как подсказки при ранжировании.

Поэтому при ссылочном продвижении сайта, специалисты стараются добыть с внешних площадок больше dofollow-ссылок. Но если вы хотите максимально естественный ссылочный профиль, стоит добывать ссылки разных видов.

Зачем нужны nofollow ссылки в линкбилдинге?

Последнее время я все чаще сталкиваюсь с мнением, что nofollow ссылки — это плохо. Большинство наших клиентов указывают в ТЗ к крауд-кампании 100% dofollow. Меня это настораживает, особенно, если заказчик — молодой сайт.

Большинство наших клиентов указывают в ТЗ к крауд-кампании 100% dofollow. Меня это настораживает, особенно, если заказчик — молодой сайт.

Зачем нужны нофоллоу ссылки сайту? Да и нужны ли они вообще, может они бесполезны и нужно их максимально избегать или стараться вообще не получать. На эти вопросы отвечу в видео:

Для тех, кто предпочитает текстовый формат, ниже коротко и по сути 😉

Аргумент №1: доверяем лидерам

Первый аргумент в пользу того, зачем все-таки нужно использовать nofollow ссылки — это справка Google.

Существует мнение, что если присвоить атрибут nofollow ссылке, то google не будет по ней переходить. Если дословно перевести, “nofollow” означает “не следовать”.

Мы как бы запрещаем поисковым роботам переходить по этой ссылке. Соответственно, она не будет проиндексирована и учтена. Но! Как мы видим, в справке Google добавлено фраза “как правило”. А это не значит “всегда”.

Я глубоко убежден, что nofollow ссылки учитываются. Особенно, если они трафиковые и стоят в нужном месте. Такие ссылки безусловно важны и работают. Вы можете с этим спорить, но если это написано в справке Google, то, скорее всего, так и есть. Тем более, эта корректировка была внесена в справку недавно.

Такие ссылки безусловно важны и работают. Вы можете с этим спорить, но если это написано в справке Google, то, скорее всего, так и есть. Тем более, эта корректировка была внесена в справку недавно.

Аргумент № 2: сайтов со 100% dofollow ссылками нет

При внедрении крауд-маркетинга, гостевых публикаций и т.д., все хотят dofollow ссылки с коммерческими анкорами. Это, конечно, здорово, но далеко от реальности.

А реальность такова, что практически не существует сайтов, у которых 0% nofollow ссылок. Как правило, их достаточно много. Для примера, давайте возьмем запрос “кадастровые работы в Москве”.

Выгружаем топ по этому запросу и с ahrefs берем показатели этих сайтов.

Как мы видим, у этих площадок разные показатели DR. При этом, они достаточно посредственные. Кроме этого, видим разное количество доменов, ссылок и т.д. И у всех сайтов абсолютно разные пропорции dofollow/nofollow ссылок.

Сразу скажу, что в этих замерах может быть неточность в связи с тем, что я замерял не по одной ссылке с домена, а в общем количестве. Поэтому цифры могут быть разные. Но моя задача была не высчитать конкретный процент, а просто показать, что nofollow ссылок достаточно много и что в любом ссылочном профиле они присутствуют. Их не 0, их там 10, 20, 30%…

Поэтому цифры могут быть разные. Но моя задача была не высчитать конкретный процент, а просто показать, что nofollow ссылок достаточно много и что в любом ссылочном профиле они присутствуют. Их не 0, их там 10, 20, 30%…

На скриншоте выше видно, что где-то nofollow ссылок может быть 1%, а где-то цифра переваливает за 45%. Разлет широкий, но сами ссылки присутствуют в любом ссылочном профиле. Это нормально и с этим нет смысла бороться.

Количество nofollow ссылок в профиле зависит от того, каким методам ссылочного продвижения вы отдаете предпочтение. Если вы только начали работать с сайтом, регистрируйте его в каталогах и работаете с форумами, то на таких площадках априори доля nofollow и redirect ссылок выше.

Если вы базируетесь на крауд-маркетинге и у вас 100% dofollow ссылок — это странно, потому, что такого точно не бывает. Такая ситуация точно привлечет внимание поисковых систем, что может привести к наложению санкций на сайт.

Аргумент № 3: огромное количество топовых площадок размещают только nofollow

Существует огромное количество крутых площадок, которые размещают только nofollow ссылки и нет причины с такими площадками не работать. Они дают вам переходы на целевой сайт, узнаваемость компании в сети и, собственно, клиентов.

Они дают вам переходы на целевой сайт, узнаваемость компании в сети и, собственно, клиентов.

Да, они не дадут вам dofollow ссылку, но nofollow линка, которую они разместят даст вам переходы заинтересованной целевой аудитории. Обратите внимание на пару примеров из строительной ниши:

forum.vashdom(.)ru. Трафик у форума более 711 тысяч посетителей в месяц, согласно данным SimilarWeb:

Теперь возьмем для примера ссылку на какую-то блоговую статью.

Видим, что она с атрибутом nofollow. При этом хорошая трафиковая площадка и много комментариев в обсуждении.

best-stroy(.)ru/forum. Трафик у форума более 672 тысяч посетителей в месяц, согласно данным SimilarWeb:

Крутая площадка в своей нише. Что мы видим в профиле? Тоже nofollow ссылка. При этом, очень активное обсуждение, большая аудитория.

Следующая площадка из компьютерной индустрии — forum.ixbt(.)com. Это прям флагманская площадка, одна из старейших в рунете в данной нише. Я ее знаю и читаю очень давно.

Я ее знаю и читаю очень давно.

Здесь мы видим тоже самое — nofollow ссылка.

В этом нет ничего плохого. Если вы не используете nofollow ссылки — вы теряете возможности.

Что вам дает использование nofollow ссылок?

- Безопасность ссылочного профиля. Если вы будете стараться размещать максимальное количество dofollow ссылок — это будет выглядеть странно на фоне других сайтов вашей ниши.

- Естественность. При работе над ссылочным, нужно помнить о том, что “показательный” профиль без nofollow и redirect ссылок, обратит на себя внимание поисковых систем и, в будущем, может привести к попаданию под фильтры.

- Больше возможностей. Это самое главное. Не боясь получить nofollow ссылки, перед вами открываются новые возможности: работа с лучшими площадками, трафиковыми, трастовыми, интересными.

Использование nofollow ссылок откроет перед вашим сайтом новые горизонты. Только представьте, если вы будете избегать таких ссылок, а ваши конкуренты — наоборот? Они будут размещаться на самых топовых площадках и общаться на крутых форумах со своей целевой аудиторией, а вы нет. Потому, что у вас в голове обосновался миф о том, что nofollow — это плохо.

Потому, что у вас в голове обосновался миф о том, что nofollow — это плохо.

Я рекомендую вам отходить от этого стереотипа и все же использовать потенциал nofollow ссылок.

Как понять, что ссылка nofollow? И что такое nofollow noopener?

Выбирая площадки для получения ссылок, нужно уметь определять dofollow, nofollow, redirect ссылки.

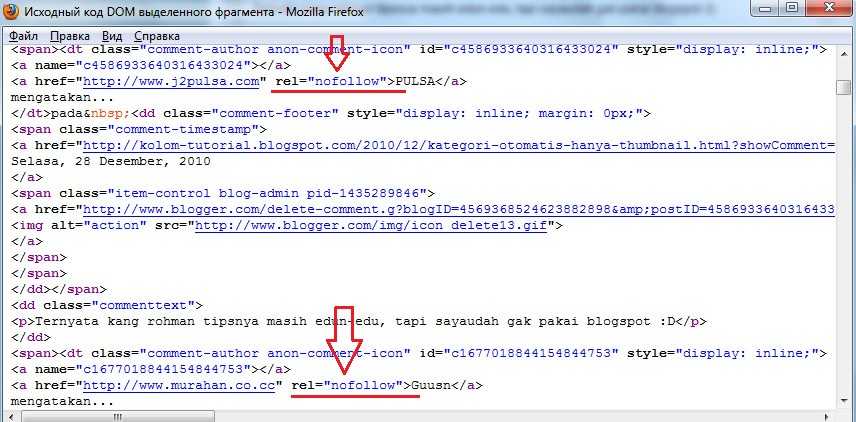

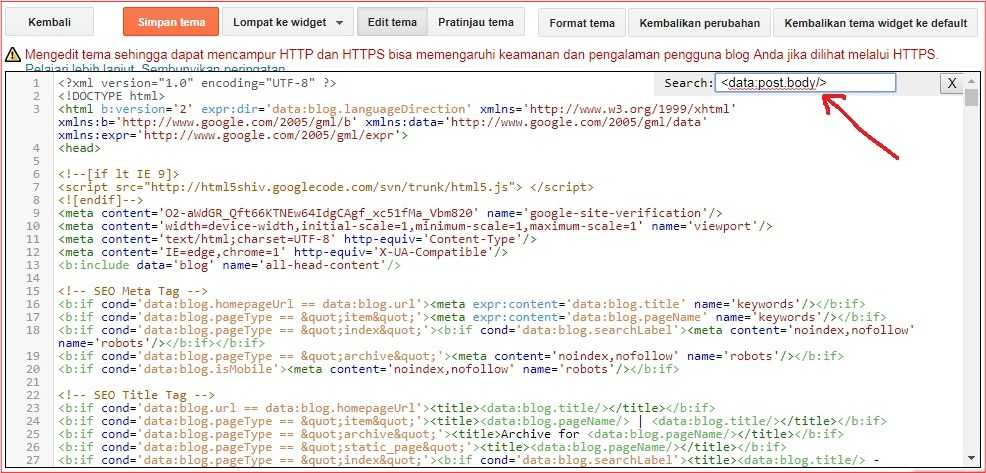

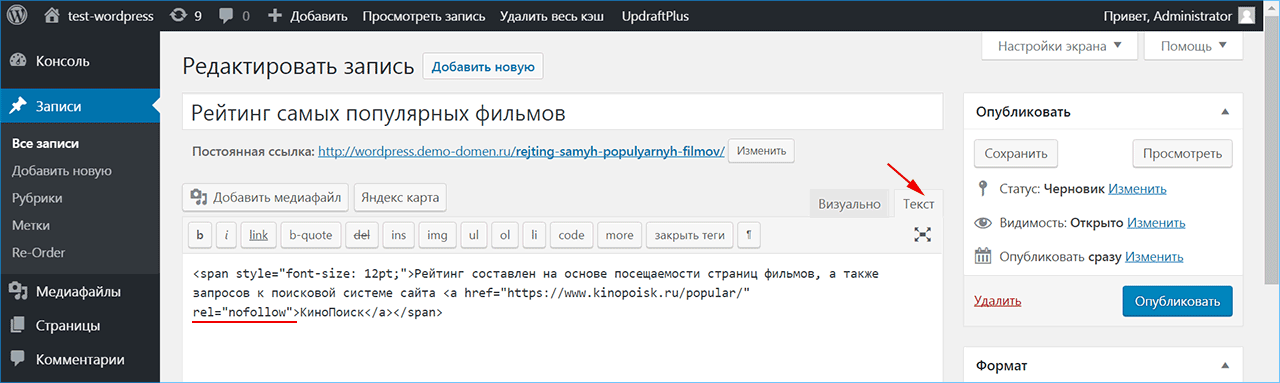

Самый простой способ это найти внешнюю ссылку и посмотреть ее в коде.

Открываем контекстное меню:

Жмем Inspect и смотрим, что в коде:

Видим тег rel="nofollow noopener"

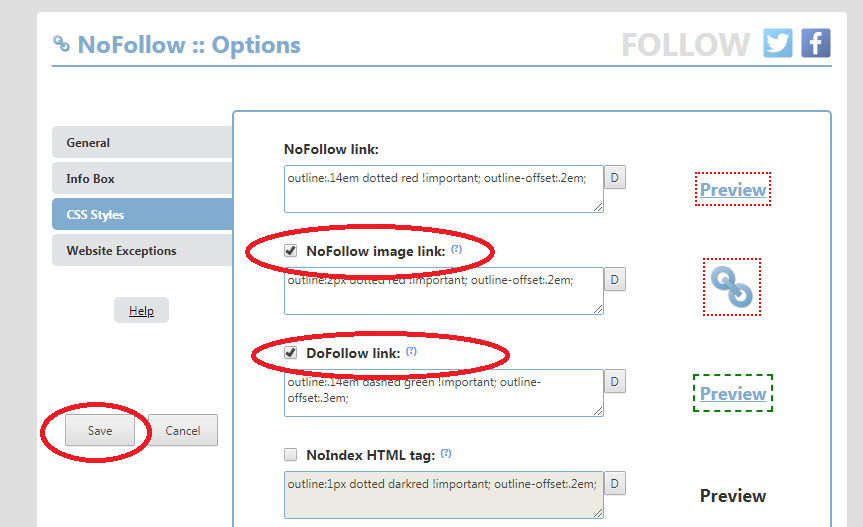

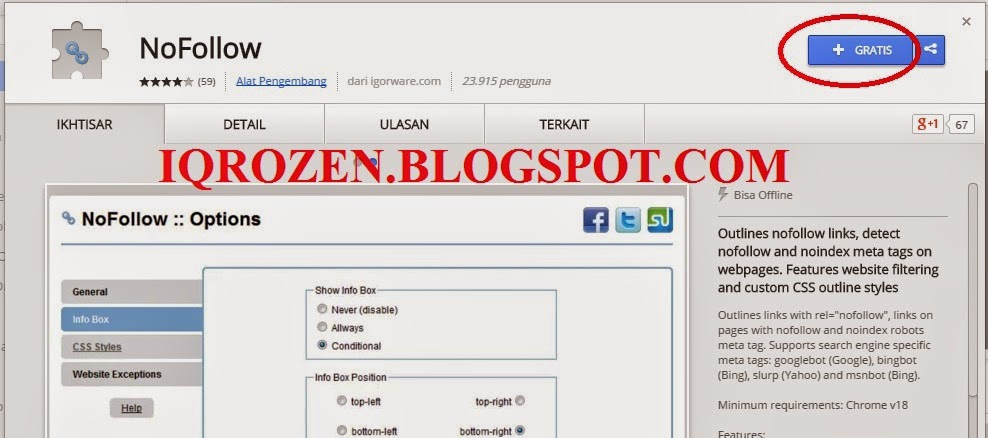

Еще один вариант, это использовать расширение для браузера RDS Bar, либо другие аналогичные.

Выставьте в настройках подсветку nofollow ссылок:

Заходя на сайты с этим тегом, вы будете видеть зачеркнутые ссылки:

Установили себе уже RDS Bar?

Больше полезных расширений для SEO вы найдете по ссылке.

Сейчас переходим к интересному, к тому как поисковые системы воспринимают nofollow.

Вы ведь этого ждали? 😉

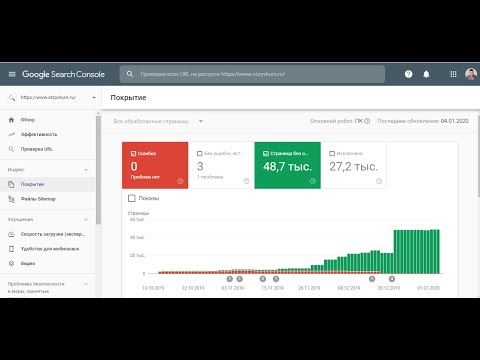

Nofollow в Google

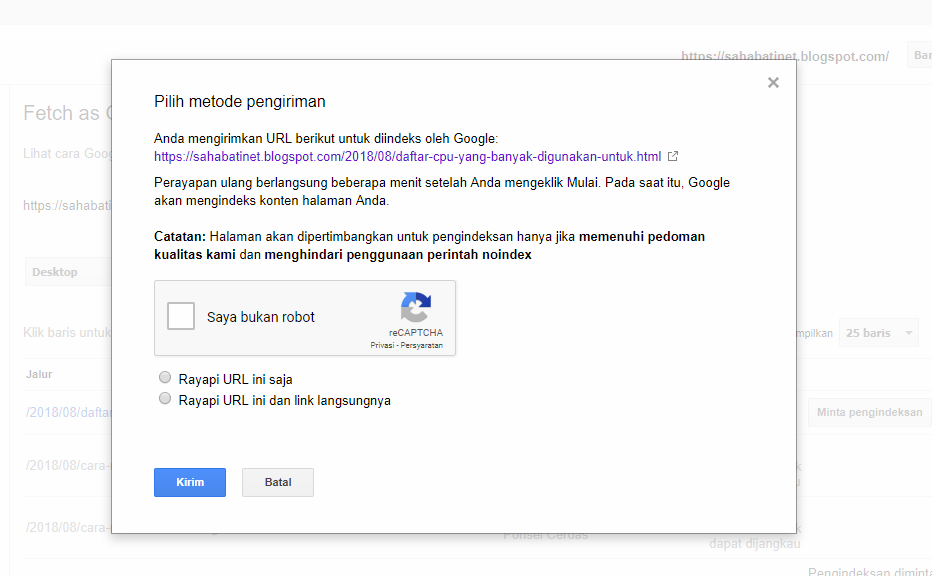

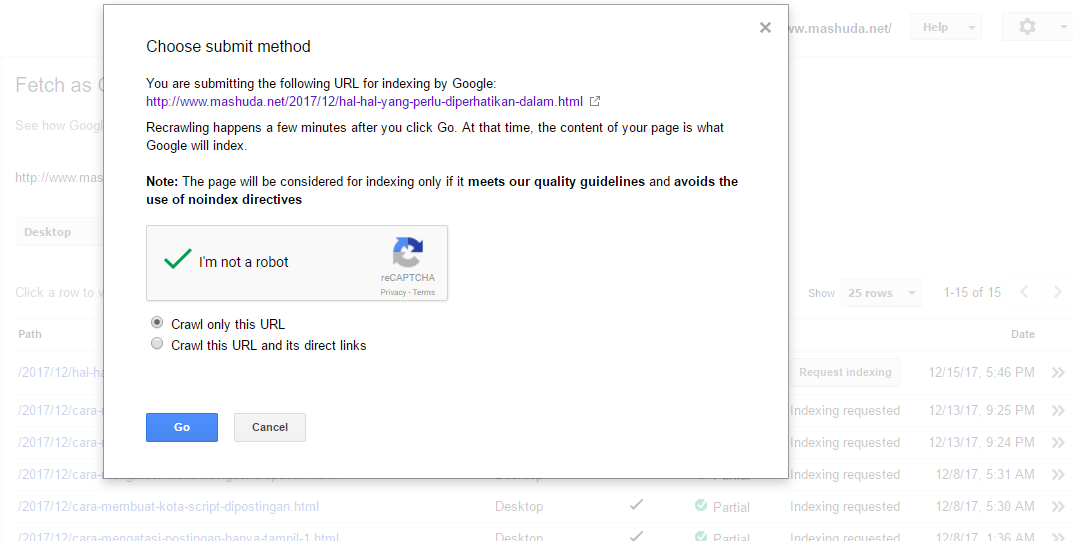

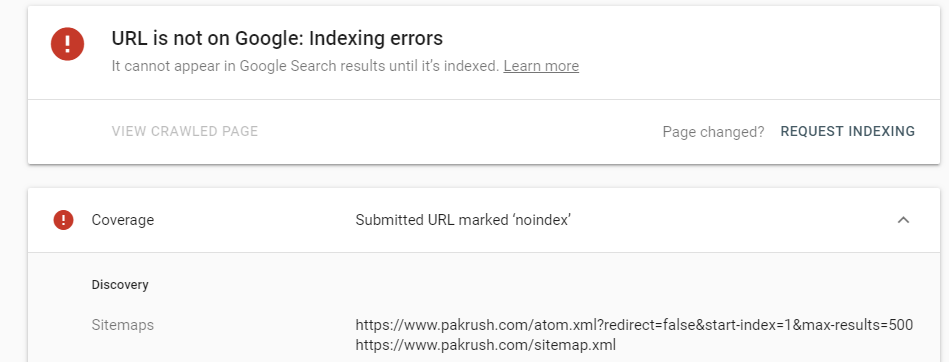

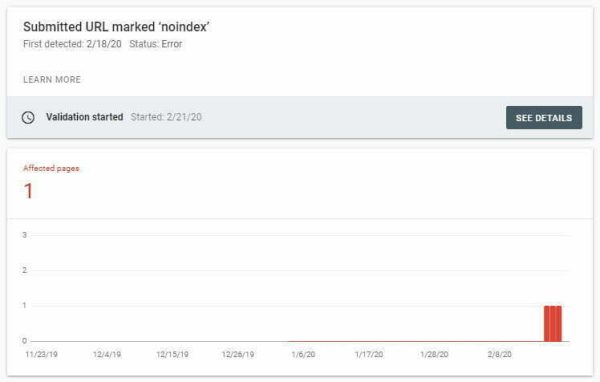

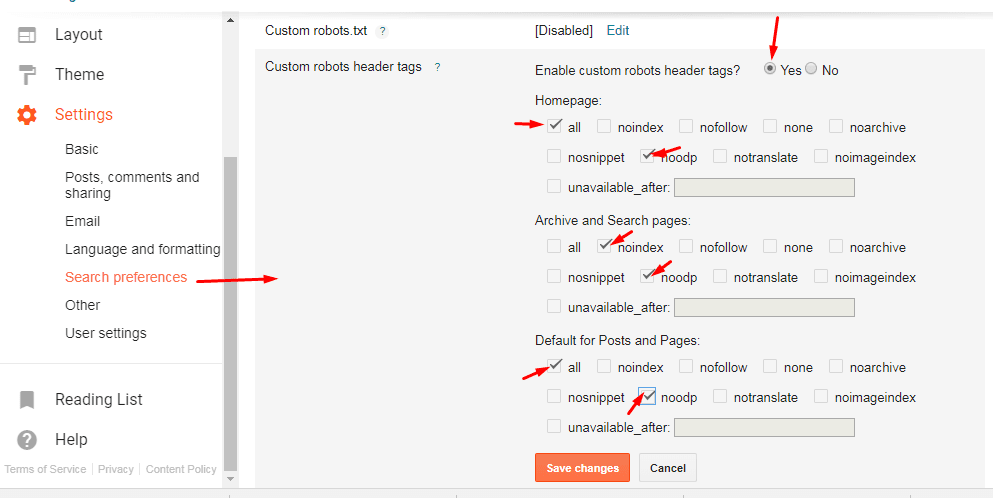

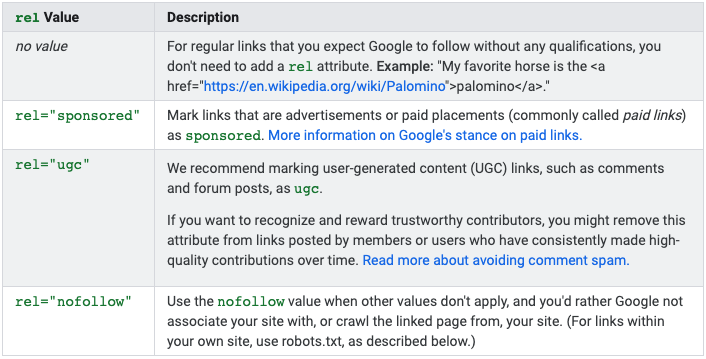

Осенью 2019 года по всему миру прошла неожиданная новость! Google официально заявил, что будет учитывать nofollow-ссылки. Об этом говорится в его официальном блоге:

Кроме этого, поисковая система ввела два новых атрибута: rel=»sponsored» и rel=»ugc». Первый рекомендуется использовать для купленных ссылок (ссылок в рекламных постах, спонсорском контенте), второй — для ссылок в органическом пользовательском контенте (к примеру, в комментариях).

Подробнее о новых атрибутах Google и о том, как их использовать при продвижении сайта крауд-маркетингом можно узнать из нашей статьи.

Рекомендуем быть с новыми атрибутами максимально осторожными. Если вы используете атрибут rel=»ugc» на платных ссылках, то это может привести ваш сайт к санкциям.

А в случае, когда вам нужно скрыть от индексации спонсорскую ссылку, то вы вполне можете применить сочетание rel=“sponsored nofollow”. Главное не перепутать 😄

Главное не перепутать 😄

Ранее в SEO-кругах бытовало утверждение, что если закрыть все исходящие ссылки от индексации, то сайт будет лучше ранжироваться.

Google считает его неправильными и аргументирует это тем, что закрытие всех исходящих ссылок в nofollow может навредить сайту, то есть понизить позиции в поисковой выдаче.

Подробнее об этом в видео:

Зачем вообще нужны ссылки бизнесу?

Вне зависимости от того, передают nofollow, redirect, span ссылки какой-то вес или нет, главное, что они выполняют свою основную функцию — переводят пользователя с одной страницы на другую.

Повышение узнаваемости

Это значит, что люди будут попадать на ваш сайт, проводить на нем время, касаться вашего бизнеса.

Если у вас качественный продукт, удобный сайт, то вы получите хорошие поведенческие факторы страниц, что непременно повлияет на SEO. Вы получите брендовый и прямой трафик, который имеет большое значение для поисковых систем.

Лидогенерация

Если вы размещаете ссылки на релевантных страницах, то вы получите переходы аудитории, которой интересен ваш продукт и если он качественный, то однозначно получите лиды и заказы.

Ссылки порождают ссылки

Ссылки размещенные в социальных сетях могут не дать вам ожидаемый SEO-эффект, но могут спровоцировать инфоповод и принести ссылки с других площадок.

Не самый приятный кейс, но…

Федор Овчинников (CEO dodopizza) опубиковал пост:

который спровоцировал большое количество публикаций в СМИ:

- https://secretmag.ru/news/fyodor-ovchinnikov-rasskazal-o-doprose-iz-za-narkotikov-v-dodo-pizza-30-01-2018.htm

- https://vc.ru/32524-osnovatel-dodo-piccy-rasskazal-o-nastoychivyh-vyzovah-na-dopros-iz-za-odnoy-moskovskoy-piccerii

- http://www.bbc.com/russian/news-42985879

- https://www.novayagazeta.ru/articles/2018/02/08/75435-ugolovnoe-delo-idet-po-stsenariyu

И так далее. Сотни публикаций 🤯

Если вы способны сгенерировать такой инфоповод, какая разница как будут реализованы ссылки?

Где взять лучшие nofollow-ссылки?

Лучшая ссылка = трафиковая.

Если по ссылке переходит релевантная аудитория — это полезная ссылка.

Видеохостинги

Youtube — самый популярный видеохостинг в мире и вы думаете, что Гугл не учитывает ссылки, которые стоят под популярными видео?

Или vimeo:

Рекомендации от видеоблогеров могут дать большой объем трафика с очень хорошими поведенческими:

Социальные сети

Twitter, flickr.com, tumblr.com и десятки других социальных сетей позволяют поставить ссылку и получить аудиторию:

The @Tesla Model 3 is a love letter to the road (by @etherington) https://t.co/Nd9KXftYbJ pic.twitter.com/qmfymUiaZa

— TechCrunch (@TechCrunch) March 8, 2018

Хотите узнать больше о том, как эффективнее всего продвигать сайт в социальных сетях? Тогда обязательно прочтите это.

Форумы

Многие лидирующие форумы закрывают свои ссылки в nofollow или noindex, но это абсолютно не повод не работать с ними.

Например, форум Винского (крупнейший туристический форум с аудиторией 5-10 миллионов в месяц):

Но если вы хотите dofollow-ссылку, то конечно же исключайте его из своего списка подходящих площадок 😜

Больше о том как правильно отбирать обсуждения для размещения крауд-маркетинговых ссылок рассказывает Игорь Рудник на youtube-канале referr:

Q/A

- reddit.com

- quora.com

- otvet.mail.ru

Это платформы с миллиардным месячным трафиком и у них также ссылки в nofollow, а у quora ссылки реализованы через span. Но я не думаю, что поисковые системы не учитывают эти ссылки. Это не логично.

Пример ссылки quora.com:

И таких платформ сотни и тысячи, которые вы исключаете из-за SEO мифов.

Рекомендуем также прочесть про грамотное ссылочное продвижение сайта на quora и reddit.

Вместо заключения

Главная цель поисковых систем — улучшить результаты выдачи, существенно подняв экспертный контент. Однако тот факт, что ссылки с Википедии и других трастовых ресурсов не учитывались по причине того, что они nofollow, создал замкнутый круг.

Однако тот факт, что ссылки с Википедии и других трастовых ресурсов не учитывались по причине того, что они nofollow, создал замкнутый круг.

После того, как Google пересмотрел свое отношение к таким ссылкам, можно смело утверждать, что они работают и будут работать в дальнейшем.

Поэтому, не стоит опасаться nofollow. Если вы добываете их с качественных площадок — это пойдет только на пользу ссылочному профилю вашего сайта.

Хотите получать ссылки уже сегодня? Просто зарегистрируйтесь в referr-service.com. Наши менеджеры помогут вам во всем разобраться и запустить крауд-маркетинговую кампанию.

Можем с уверенностью сказать, что у нас самые лучшие менеджеры в нише крауд-маркетинга и мы поможем решить вам абсолютно любую задачу!

Что такое dofollow и nofollow-ссылки: что нужно знать

Автор Webline Promotion На чтение 5 мин. Просмотров 4.9k. Опубликовано

Dofollow — это атрибут тега rel, который дает роботам поисковых систем разрешение к переходу на страницу, на которой размещены ссылки.

Ссылочная масса – важная часть SEO, которая помогает поднять сайт в выдаче, придать ему «вес» в глазах поисковых систем. Google оперирует понятием PageRank, «ссылочный сок». Он активно влияет на ранжирование интернет-площадки, особенно если сайты-доноры – авторитетные площадки. С повышением роли PR в SEO появилась масса спам-линков, которые размещались в комментариях к записям и постам, на авторитетных форумах. Это привело к неразберихе с ранжированием. В 2005 году Джейсоном Шелленом и Мэттом Каттсом был введен атрибут nofollow. В чем отличие параметра от dofollow?

Содержание

- Разница между понятиями, обозначение

- Почему закрывают ссылки

- Открывать или закрывать?

- Как определить, закрыта ли ссылка

- Открытые форумы

- Полезные ресурсы с закрытой линковкой

Разница между понятиями, обозначение

- Dofollow – гиперссылки, ведущие на определенный сайт или страницу. Увеличение их количества повышает «ссылочный сок» ресурса в рейтинге Google.

Логическая схема: на сайт (или отдельную страницу) ссылаются сотни людей – материал интересен, полезен. Поисковые роботы считают все линки по умолчанию dofollow, если не указан другой параметр.

Логическая схема: на сайт (или отдельную страницу) ссылаются сотни людей – материал интересен, полезен. Поисковые роботы считают все линки по умолчанию dofollow, если не указан другой параметр. - Nofollow – атрибут тега, указывающий поисковику, что переходить по линку не нужно. PageRank донора не меняется при переходе, ссылочный вес сайта-источника не учитывается. WordPress и некоторые другие движки автоматически прописывают этот атрибут всем ссылкам, которые размещают пользователи (например, в комментариях). Аналогичная система работает и в Википедии.

Почему закрывают ссылки

Чем больше входящих и исходящих линков связано с конкретной площадкой, тем выше ссылочная масса и PageRank в поисковике Google. Результат закономерен – привлекательная позиция в выдаче. Однако линкбилдинг может использоваться как инструмент «черного SEO»: публикация линков на качественных площадках приводит к повышению рейтинга сайта, на который они ведут. Если же этот сайт попадает под Гугл-фильтры, то страдает и ресурс-донор. Чтобы избежать такой ситуации, используют nofollow, который особенно актуален для блогеров. Это позволило сократить объемы спама и нерелевантных линков при комментировании.

Чтобы избежать такой ситуации, используют nofollow, который особенно актуален для блогеров. Это позволило сократить объемы спама и нерелевантных линков при комментировании.

Сегодня чаще всего закрывают такие виды линков:

- на «непроверенный» (незащищенный с точки зрения Google) контент;

- в комментариях;

- на форумах.

Также Гугл рекомендует закрывать платные линки.

Открывать или закрывать?

Реакция поисковиков на обнаружение nofollow различается:

- Google переходит по цепочке, но не учитывает ее в качестве обратной;

- MSN не всегда переходит, но учитывает линк при подсчете позиции;

- Yahoo следует, но не принимает в расчет при вычислении релевантности;

- Яндекс отправляет своего робота при такой линковке, учитывая этот показатель в позиционировании выдачи.

Если вы хотите увеличить трафик и привлечь максимум посетителей в блог или на форум, можно использовать dofollow. Это своеобразное награждение за активность, однако оно может привести к наплыву ботов. Изменить атрибут можно в любое время, для этого достаточно использовать специальные плагины, позволяющие закрыть линки и в старых записях комментаторов.

Изменить атрибут можно в любое время, для этого достаточно использовать специальные плагины, позволяющие закрыть линки и в старых записях комментаторов.

При использовании цитат рекомендуется давать открытую ссылку на первоисточник – это показатель уважения к источнику и способ повысить PageRank. Русскоязычные ресурсы такой метод применяют редко, но в англоязычной Сети это востребованная практика. Такая линковка не «ударит» по ранжированию самой площадки с цитатой.

По закрытым ссылкам пользователи могут совершать переходы, что способно увеличить трафик. Это косвенно влияет на вес страницы и ее место в выдаче, поэтому совсем неактуальными nofollow назвать нельзя. Если их разместить на авторитетных ресурсах, в правильном контексте, это положительно скажется на ранжировании.

Внутренняя перелинковка должна быть открытой. Если не нужно переиндексировать страницу, применяют дополнительный тег – noindex, который не мешает роботу отслеживать линковку. Его указывают в описании архивных материалов, чтобы не дублировать страницы. Исходящие линки, которые указывают на продающие площадки, лучше закрывать.

Исходящие линки, которые указывают на продающие площадки, лучше закрывать.

Как определить, закрыта ли ссылка

Проще всего сделать это при помощи контекстного меню. Откройте код страницы и просмотрите его. При отслеживании большой массы ресурсов можно воспользоваться специальными плагинами и расширениями для браузеров, которые подсвечивают закрытые линки.

Открытые форумы

В русскоязычном интернете осталось не так много открытых форумов и блогов, особенно бесплатных. Англоязычных ресурсов больше, но при размещении комментариев на них стоит учитывать релевантность. Иногда авторы и владельцы блогов специально открывают возможность линковки для комментаторов. Это может быть как способ поощрения, так и вариант заработка (разместить комментарий со ссылочной массой можно только после внесения оплаты).

Если линковка открытая и бесплатная, комментарии должны быть полезными, поддерживать и расширять тему поста. Спам-комментарии удаляются блогерами и могут привести к бану.

Для продвижения сайта можно и нужно использовать nofollow-линки. Если они органично вписаны в текст, эффект от их применения будет заметнее, чем от dofollow на сомнительном одностраничнике.

- Видеохостинги. Лучший вариант – это упоминание вашего сайта видеоблогерами под роликом. На ранжирование влияет несущественно, но повышает интерес аудитории, привлекает трафик и улучшает конверсию.

- Социальные сети. Весомый аргумент для поисковых роботов – ссылки с Твиттера или Фейсбука, даже с атрибутом закрытости, положительно расцениваются поисковиками. Это инструмент «два-в-одном», который повышает PR и привлекает новую аудиторию.

- Форумы с миллионными аудиториями.

Линкбилдинг – важный SEO-инструмент. Но, кроме nofollow и dofollow, на ранжирование влияет релевантность. Линковка со статьи о рыбе на магазин, продающий тапочки, не понравится поисковым системам и не приведет новых посетителей. Такая «разножанровость» может негативно повлиять на сайт, привести к штрафным санкциям и попаданию под фильтры.

Подпишись на рассылку дайджеста новостей от Webline Promotion

Email*

Предоставлено SendPulse

html теги для текста | SEO продвижение сайта в Санкт-Петербурге

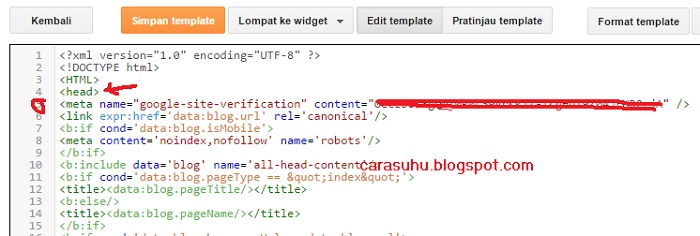

Сегодня поговорим о том, что такое html теги для текста, чем они отличаются от простых метатегов.

html теги для текста и метатеги — в чем разница

Пришло время прояснить некоторую путаницу вокруг метатегов и HTML-метатегов. Разница между двумя типами тегов в значительной степени условна, а синтаксис метатега HTML означает, что он будет содержать слово meta, тогда как у тега, определенного как метатег, его может не быть.

Решение, где какой тег, принимается валидатором W3C и может изменяться с течением времени, однако важно помнить, что оба они выполняют одну и ту же цель – используются для обеспечения поисковых систем информацией о веб-странице.

Примечание: Некоторые люди включают теги title в метатеги, но поскольку они описывают один элемент страницы, а не содержимое страницы в целом, мы решили их не включать.

Однако, само собой разумеется, что оптимизация тегов title поможет поисковым системам и, что еще важнее, пользователям понять, о чем же ваш контент.

Теперь, когда мы это выяснили, можно приступить к делу и взглянуть на подборку тегов как HTML, так и метатегов, которые, по нашему мнению, полезны для SEO продвижения.

Hreflang

Итак, для начала следует сказать, что тег Hreflang технически не тег. Это атрибут, но атрибут важный, который сообщит Google, какой язык вы используете на веб-странице.

Если у вашего сайта есть несколько переводов или он обслуживает разные территории, вы должны обязательно использовать Hreflang для обеспечения правильной языковой версии в правильных версиях Google.

Это может помочь поисковым системам лучше оценить ваш контент и, что еще более важно, обеспечить пользователям из разных точек земного шара правильный выбор.

Пример фрагмента кода для таргетинга веб-страницы на пользователей из Великобритании, использующих английский язык:

<link rel=”alternate” href=”http://example.

com” hreflang=”en-gb” />

Тег canonical

Другой очень важный тег — тег canonical. Установите его неправильно, и вы рискуете пропасть из результатов поиска, что вызовет реальные проблемы для SEO сайта. Однако если он используется правильно, это будет отличным способом сказать поисковым системам, что URL-адрес веб-страницы является её оригинальной версией.

Так вы избежите проблем с дублированным контентом на вашем сайте, что вызвано поисковиками, которые сканируют несколько URL-адресов, содержащих одинаковый или почти идентичный контент.

Обычно, если поисковая система находит несколько URL-адресов с одинаковым контентом, ей будет сложнее определить, что является оригиналом, а что дубликатом. Это может привести к снижению рейтинга для обоих, или, что еще хуже, важная страница не будет ранжироваться.

Пример фрагмента кода с использованием тега canonical:

<link rel=”canonical” href=”https://www.example.

com” />

Тег content-type

Тег content-type используется для определения типа содержимого страниц и набора символов, который он использует. Его использование помогает вашему браузеру понять и расшифровать страницу, и поэтому он важен.

Пример фрагмента кода для тега content-type:

<meta http-equiv=”Content-Type” content=”text/html; charset=utf-8 />

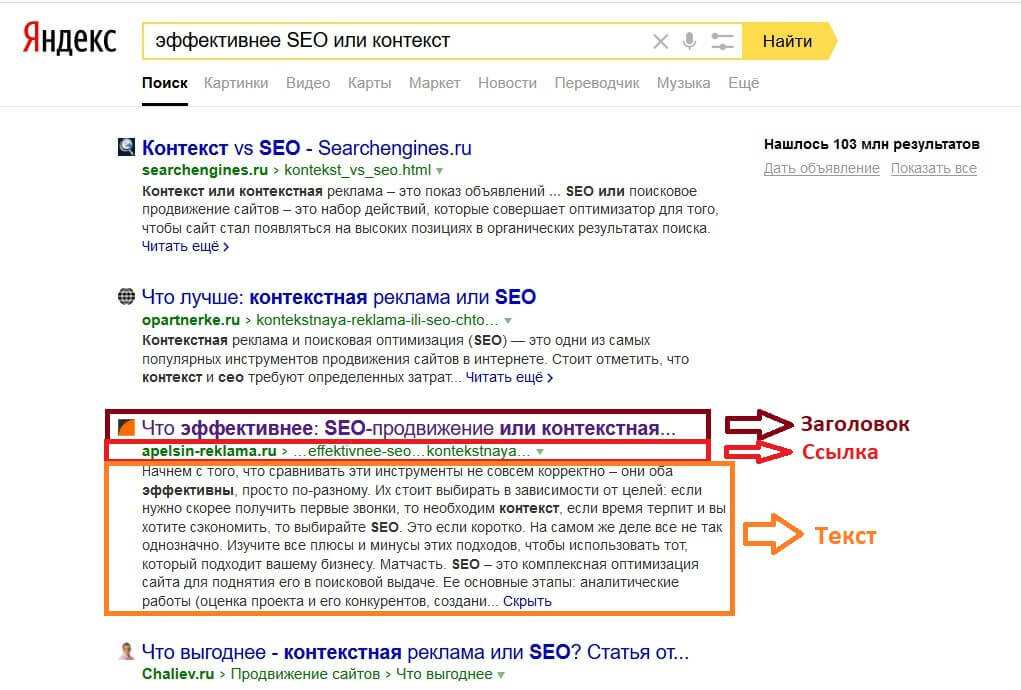

Тег title

Вероятно, один из наиболее узнаваемых и используемых тегов для тех, кто занимается SEO. Тег title используется для указания того, что представляет собой веб-страница. Он отображается на вкладке браузера, чтобы пользователь понял, о чем контент, и, что еще важнее, используется поисковыми системами для генерирования результатов, которые мы видим в поиске.

С точки зрения SEO оптимизация тега title, чтобы он содержал тему/ключевые слова контента на странице, может помочь улучшить ваше ранжирование по этим темам/ключевым словам. В настоящее время вы можете ожидать, что Google отобразит от 50 до 60 символов названия до его усечения, поэтому при написании следите за длиной.

В настоящее время вы можете ожидать, что Google отобразит от 50 до 60 символов названия до его усечения, поэтому при написании следите за длиной.

Пример фрагмента кода для тега title, который находится внутри основного тега в верхней части веб-страницы:

<title>Example.com | Лучшие примеры в Интернете</title>

Метатег description

Подобно тегу title, тег description хорошо известен и дает вам возможность рассказать поисковым системам и пользователям в результатах поиска, о чем контент вашей веб-страницы. Хотя это не прямой фактор ранжирования, вы должны оптимизировать свое метаописание, чтобы интересно и кратко сообщить о содержании ваших веб-страниц.

Если Google не считает, что вы проделали достаточно хорошую работу, он может заменить ваш метатег description своей собственной версией, часто используя контент из нескольких начальных параграфов вашего сайта.

Пример фрагмента кода для метатега description:

<meta name=”description” content=” Это мета-описание”>

Тег viewport

Тег viewport – полезный HTML тег, который помогает браузерам понять и контролировать размеры вашей веб-страницы.

Раньше в этом теге не было необходимости, поскольку все просматривали сайты на рабочем столе с дисплеев одинакового размера, но с ростом использования смартфонов и планшетов, многие из которых имеют разные размеры, теперь более важно обеспечить, что вы сообщаете браузеру эту информацию, обеспечивая сайту хорошую кросбраузерность.

Правильное внедрение тега viewport гарантирует, что пользователи будут правильно работать с вашим сайтом.

Пример фрагмента кода для метатега viewport:

<meta name=”viewport” content=”width=device-width, initial-scale=1>

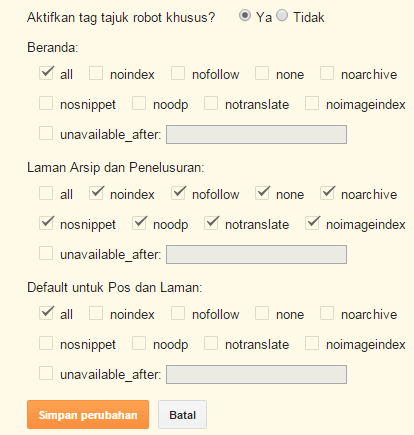

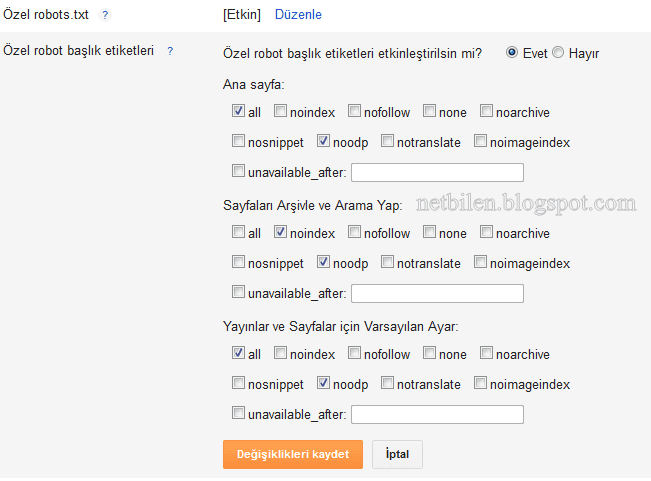

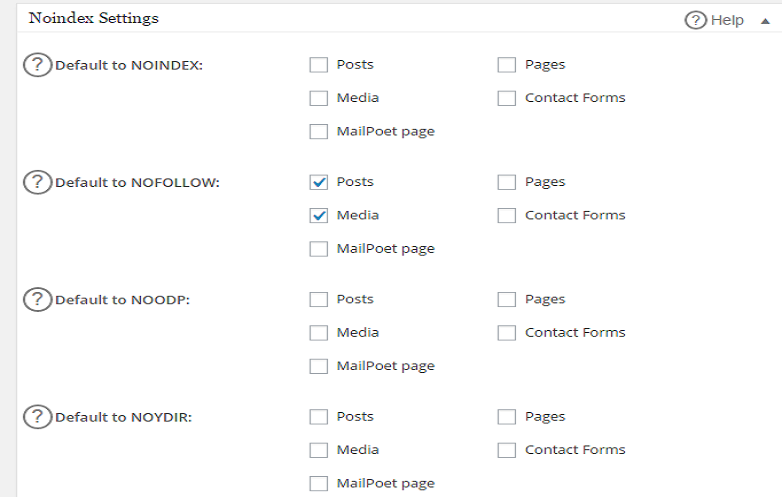

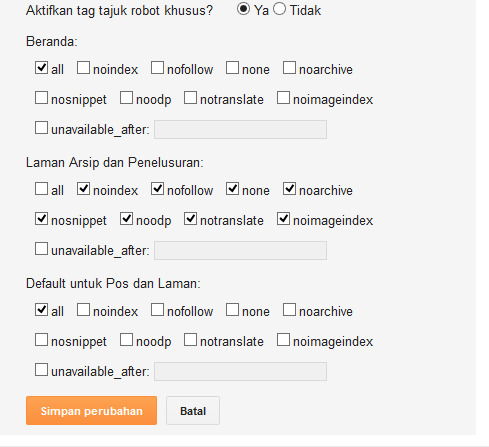

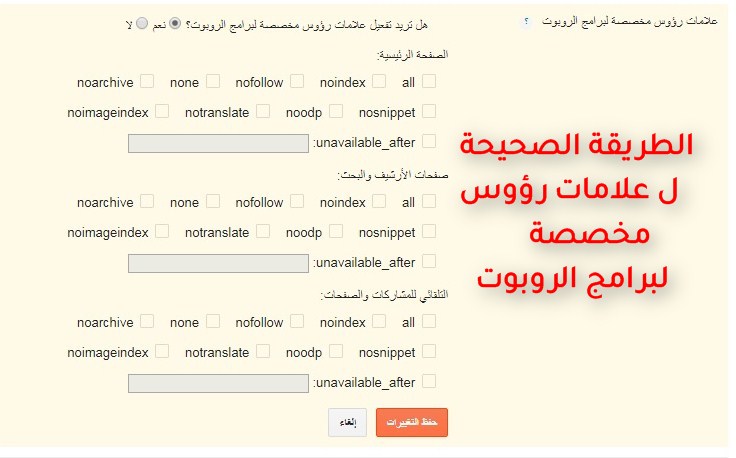

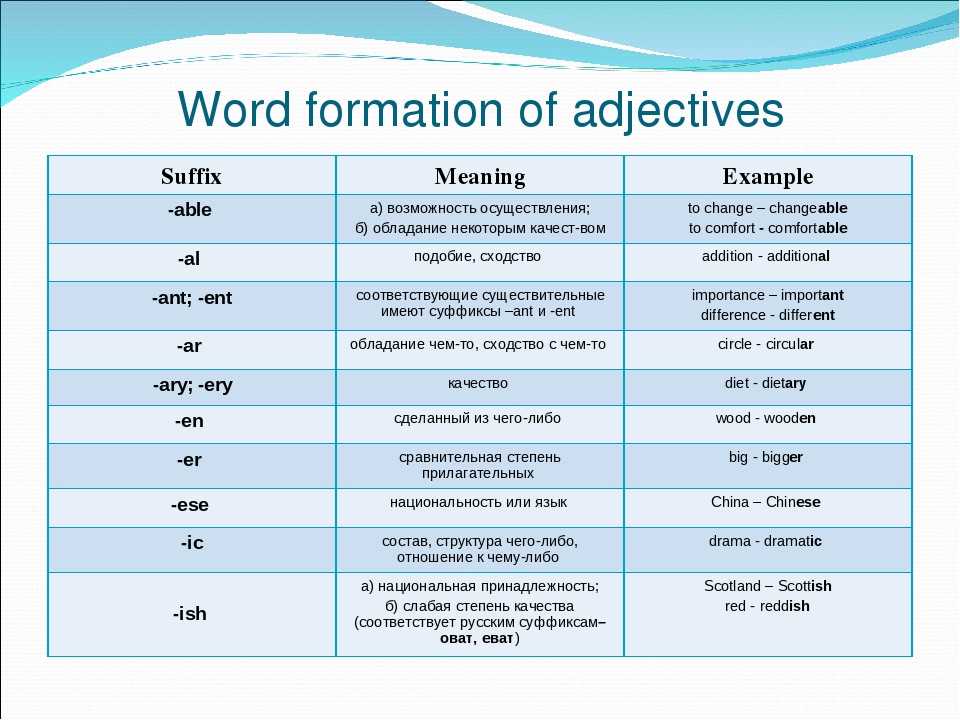

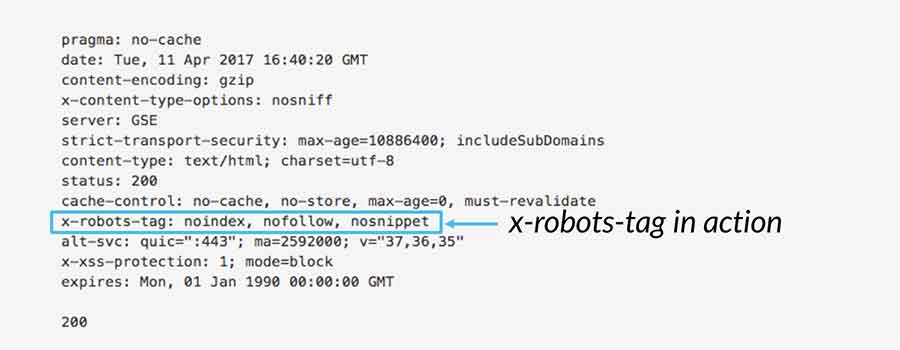

Метатеги для роботов

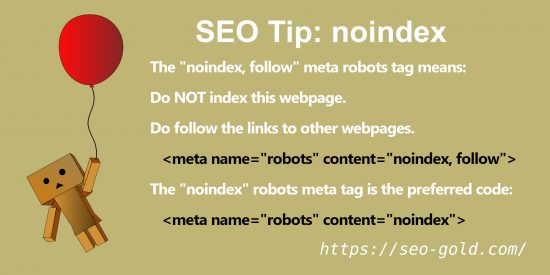

Существует большое количество метатегов для роботов, которые вы можете использовать, и все они помогут поисковым роботам выполнять свою работу по сканированию и индексированию веб-страниц в Интернете. Не все поисковики будут следовать всем командам, но ниже приведено несколько примеров метатегов для роботов и то, что они сообщают сканерам:

Nofollow

Тэг nofollow сообщает сканерам не следовать ни по одной из ссылок, перечисленных на этой странице, а также не передавать какого-либо права странице по ссылке

Noindex

Noindex сообщает сканерам не индексировать эту страницу

Noimageindex

Noimageindex сообщает сканерам не индексировать изображения с этой страницы

Noarchive

Noarchive сообщает сканерам не включать кешированную версию

Пример фрагмента HTML кода метатега для роботов:

<meta name=”robot” content=”noindex, nofollow”>

Метатеги Open graph (OG) для соцсетей

И наконец, существуют метатеги OG для соцсетей. Хотя это меньше относится к SEO, правильно реализуйте метатеги OG для соцсетей – и вы можете помочь вашему контенту хорошо выглядеть, когда им делятся, что улучшит взаимодействие пользователей с постами и в конечном итоге увеличит трафик.

Хотя это меньше относится к SEO, правильно реализуйте метатеги OG для соцсетей – и вы можете помочь вашему контенту хорошо выглядеть, когда им делятся, что улучшит взаимодействие пользователей с постами и в конечном итоге увеличит трафик.

<meta property=”og:title” content=”Статья о тегах”/>

<meta property=”og:image” content=”https://example.com/img/facebooklogo.png”/>

<meta property=”og:site_name” content=”Блог о SEO”/>

<meta property=”og:description” content=”В этой статье будет говориться о тегах”/>

Излишне говорить, что есть целый ряд других html тегов для текста, которые вы можете использовать на своем сайте, и этот список не является исчерпывающим. Но все же, надеемся, он даст вам руководство по некоторым из наиболее важных и полезных тегов, которые вы можете использовать для вашего WEB-проекта, чтобы сделать этот опыт лучше для поисковых систем и сканеров.

Вместо заключения

Хотите выйти в ТОП10 Яндекс и долго там оставаться? Продвигайте свои сайты и интернет-магазины исключительно белыми SEO методами! Не умеете? Могу научить! Тем, кто хочет разобраться во всех премудростях SEO, предлагаю посетить мои курсы по SEO обучению, которые я провожу индивидуально, в режиме онлайн по скайпу.

Записаться на SEO обучение

Для тех, у кого нет времени проходить обучение и самостоятельно заниматься продвижением своих интернет-магазинов, предлагаю и в этом вопросе помощь. Я могу взять ваш сайт на SEO продвижение и за несколько месяцев вывести его в ТОП10 Яндекс.

Для того чтобы убедиться в моей экспертности, предлагаю ознакомиться с моими последними SEO кейсами и только после этого заказать у меня SEO продвижение. Ниже на видео один из примеров успешного продвижения строительного сайта в Санкт-Петербурге.

Заказать SEO продвижение сайта

SEO продвижение сайта по России:

Рейтинг моего сайта в Яндекс:

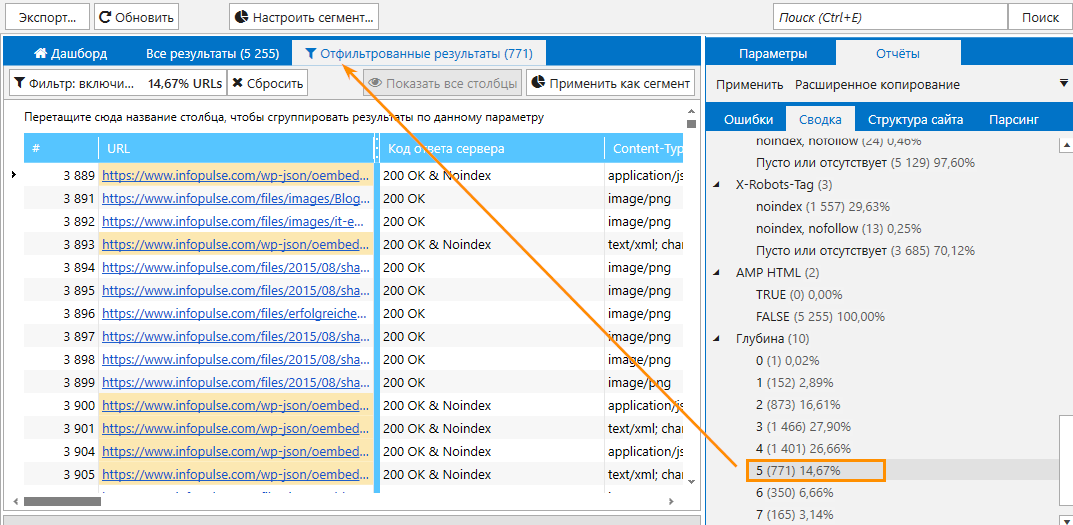

Screaming Frog Seo Spider — подробное руководство по программе

Attention! Много букв! Много скринов! Много смысла!

Доброго времени суток, друзья. Сегодня я хочу рассказать вам о настройке Screaming Frog (он же SF, он же краулер, он же паук, он же парсер — сразу определимся со всеми синонимами, ок?).

Сегодня я хочу рассказать вам о настройке Screaming Frog (он же SF, он же краулер, он же паук, он же парсер — сразу определимся со всеми синонимами, ок?).

SF — очень полезная программа для анализа внутрянки сайтов. С помощью этой утилиты можно быстро выцепить технические косяки сайта, чтобы составить грамотное ТЗ на доработку. Но чтобы увидеть проблему, надо правильно настроить краулера, верно? Об этом мы сегодня с вами и поговорим.

- Примечание автора: сразу скажу — программа имеет много вкладок и настроек, которые по сути не нужны рядовому пользователю, потому я подробно опишу только наиболее важные моменты, а второстепенные пройдем вскользь… хотя кого я обманываю, когда это у меня были статьи меньше 30 к символов? *Зануда mode on*

- Примечание автора 2: при написании статьи я пользовался дополнительными материалами в виде официального мануала от разработчиков. Если что, почитать его можно тут https://www.screamingfrog.

co.uk/seo-spider/user-guide/. Не пугайтесь английского, Google-переводчик в помощь — вполне себе сносная адаптация получается.

- Примечание автора 3: я люблю оставлять примечания…

- File

- Configuration

- Spider — настройки парсинга сайта

- Robots.txt — определяем каким правилам следовать при парсинге

- URL Rewriting — функция перезаписи URL

- CDNs — парсим поддомены

- Include/Exclude — сканирование/удаление определенных папок

- Speed — регулируем скорость парсинга сайта

- User-Agent — выбираем под кого маскируемся

- HTTP Header — настройка реагирования на разные http-заголовки

- Custom — дополнительные настройки поиска

- User Interface — обнуление настроек для колонок таблицы

- API Access — интеграция с разными сервисами

- Authentification — настройки аутентификации

- System — внутренние настройки самой программы

- Mode

- Bulk export

- Reports

- Sitemaps

- Visualisations

- Crawl Analysis

- License

- Help

Настройка Screaming Frog по шагам

Рассмотрим основное меню программы, для того чтобы понимать что где лежит и что за что отвечает (тавтология… Вова может в копирайт!).

Верхнее меню — управление парсингом, выгрузкой и многое другое

File

Из названия понятно, что это работа с файлами программы (загрузка проектов, конфиги, планирование задач — что-то вроде того).

- Open — открыть файл с уже проведенным парсингом.

- Open Recent — открыть последний парсинг (если вы его сохраняли отдельным файлом).

- Save — собственно, сохранить парсинг.

- Configuration — загрузка/сохранение специальных настроек парсинга вроде выведения дополнительных параметров проверки и т.д. (про то, как задавать эти настройки, я далее расскажу подробнее).

- Crawl Recent — повторно парсить один из последних сайтов, который уже проверялся в этой программе.

- Scheduling — отложенное планирование задач для программы… ни разу не пользовался этой опцией…стыдно.

- Exit — призвать к ответу Друзя… нет, ну серьезно,тут все очевидно.

Configuration

Один из самых интересных и важных пунктов меню, тут мы задаем настройки парсинга.

Ох, сейчас будет сложно — у многих пунктов есть подпункты, у этих подпунктов всплывающие окна с вкладками и кучей настроек…в общем крепитесь, ребята, будет много инфы.

Spider — собственно, настройки парсинга сайта

Вкладка Basic — выбираем что парсить

- Check Images — в отчет включаем анализ картинок.

- Check CSS — в отчет включаем анализ css-файлов (скрипты).

- Check JavaScript — в отчет включаем анализ JS-файлов (скрипты).

- Check SWF — в отчет включаем анализ Flash-анимации.

- Check External Link — в отчет включаем анализ ссылок с сайта на другие ресурсы.

- Check Links Outside of Start Folder — проверка ссылок вне стартовой папки. Т.е. отчет будет только по стартовой папке, но с учетом ссылок всего сайта.

- Follow internal “nofollow” — сканировать внутренние ссылки, закрытые в тег “nofollow”.

- Follow external “nofollow” — сканировать ссылки на другие сайты, закрытые в тег “nofollow”.

- Crawl All Subdomains — парсить все поддомены сайта, если ссылки на них встречаются на сканируемом домене.

- Crawl Outside of Start Folder — позволяет сканировать весь сайт, однако проверка начинается с указанной папки.

- Crawl Canonicals — выведение в отчете атрибута rel=”canonical” при сканировании страниц.

- Crawl Next/Prev — выведение в отчете атрибутов rel=”next”/”prev” при сканировании страниц пагинации.

- Extract hreflang/Crawl hreflang — при сканировании учитываются языковой атрибут hreflang и отображаются коды языка и региона страницы + формирование отчета по таким страницам.

- Extract AMP Links/Crawl AMP Links — извлечение в отчет ссылок с атрибутом AMP (определение версии контента на странице).

- Crawl Linked XML Sitemap — сканирование карты сайта. Тут краулер либо берет sitemap из robots.txt (Auto Discover XML Sitemap via robots.txt), либо берет карту по указанному пользователем пути (Crawl These Sitemaps).

Ну что, сложно? На самом деле просто нужна привычка и немного практики, чтобы освоить основные настройки SF и понять что нужно использовать в конкретных случаях, а от чего можно отказаться. Все, передохнули, теперь дальше… будет проще (нет).

Вкладка Limits — определяем лимиты парсинга

- Limit Crawl Total — задаем лимиты страниц для сканирования. Сколько всего страниц выгружаем для одного проекта.

- Limit Crawl Depth — задаем глубину парсинга. До какого уровня может дойти краулер при сканировании проекта.

- Limit Max Folder Depth — можно контролировать глубину парсинга вплоть до уровня вложенности папки.

- Limit Number of Query Strings — тут, если честно, сам не до конца разобрался, потому объясню так, как понял — мы ограничиваем лимит страниц с параметрами. Другими словами, если на одной статической странице есть несколько фильтров, то их комбинация может породить огромное количество динамических страниц.

Вот чтобы такие “полезные” страницы не парсились (увеличивает время анализа в разы, а толковой информации по сути ноль), мы и выводим лимиты по Query Strings. Пример динамики — site.ru/?query1&query2&query3&queryN+1.

Вот чтобы такие “полезные” страницы не парсились (увеличивает время анализа в разы, а толковой информации по сути ноль), мы и выводим лимиты по Query Strings. Пример динамики — site.ru/?query1&query2&query3&queryN+1. - Max Redirects to Follow — задаем максимальное количество редиректов, по которым паук может переходить с одного адреса.

- Max URL Length to Crawl — максимальная длина URL для обхода (указываем в символах, я так понимаю).

- Max Links per URL to Crawl — максимальное количество ссылок на URL для обхода (указываем в штуках).

- Max Page Size (KB) to Crawl — максимальный размер страницы для обхода (указываем в килобайтах).

Вкладка Rendering — настраиваем параметры рендеринга (только для JS)

На выбор три опции — “Text Only” (паук анализирует только текст страницы, без учета Аякса и JS), “Old AJAX Crawling Scheme” (проверяет по устаревшей схеме сканирования Аякса) и “JavaScript” (учитывает скрипты при рендеринге). Детальные настройки есть только у последнего, их и рассмотрим.

Детальные настройки есть только у последнего, их и рассмотрим.

- Enable Rendered Page Screen Shots — SF делает скриншоты анализируемых страниц и сохраняет их в папке на ПК.

- AJAX Timeout (secs) — лимиты таймаута. Как долго SEO Spider должен разрешать выполнение JavaScript, прежде чем проверять загруженную страницу.

- Window Size — выбор размера окна (много их — смотрим скриншот).

- Sample — пример окна (зависит от выбранного Window Size).

- Чекбокс Rotate — повернуть окно в Sample.

Вкладка Advanced — дополнительные опции парсинга

- Allow Cookies — учитывать Cookies, как это делает поисковый бот.

- Pause on High Memory Used — тормозит сканирование сайта, если процесс забирает слишком много оперативной памяти.

- Always Follows Redirect — разрешаем краулеру идти по редиректам вплоть до финальной страницы с кодом 200, 4хх, 5хх (по факту все ответы сервера, кроме 3хх).

- Always Follows Canonicals — разрешаем краулеру учитывать все атрибуты “canonical” вплоть до финальной страницы. Полезно, если на страницах сайта бардак с настройкой этого атрибута (например, после нескольких переездов).

- Respect Noindex — страницы с “noindex” не отображаются в отчете SF.

- Respect Canonical — учет атрибута “canonical” при формировании итогового отчета. Полезно, если у сайта много динамических страниц с настроенным rel=”canonical” — позволяет убрать из отчета дубли по метаданным (т.к. на страницах настроен нужный атрибут).

- Respect Next/Prev — учет атрибутов rel=”next”/”prev” при формировании итогового отчета. Полезно, если у сайта есть страницы пагинации с настроенными “next”/”prev”- позволяет убрать из отчета дубли по метаданным (т.к. на страницах настроен нужный атрибут).

- Extract Images from img srscet Attribute — изображения извлекаются из атрибута srscet тега <img>. SRSCET — атрибут, который позволяет вам указывать разные типы изображений для разных размеров экрана/ориентации/типов отображения.

- Respect HSTS Policy — если чекбокс активен, SF будет выполнять все будущие запросы через HTTPS, даже если перейдет по ссылке на URL-адрес HTTP (в этом случае код ответа будет 307). Если же чекбокс неактивен, краулер покажет «истинный» код состояния за перенаправлением (например, постоянный редирект 301).

- Respect Self Referencing Meta Refresh — учитывать принудительную переадресацию на себя же (!) по метатегу Refresh.

- Response Timeout — время ожидания ответа страницы, перед тем как парсер перейдет к анализу следующего урла. Можно сделать больше (для медленных сайтов), можно меньше.

- 5хх Response Retries — количество попыток “достучаться” до страниц с 5хх ответом сервера.

- Store HTML — можно сохранить статический HTML-код каждого URL-адреса, просканированного SEO Spider, на диск и просмотреть его до того, как JavaScript “вступит в игру”.

- Store Rendered HTML — позволяет сохранить отображенный HTML-код каждого URL-адреса, просканированного SEO Spider, на диск и просмотреть DOM после обработки JavaScript.

- Extract JSON-LD — извлекаем микроразметку сайта JSON-LD. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

- Extract Microdata — извлекаем микроразметку сайта Microdata. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

- Extract RDFa — извлекаем микроразметку сайта RDFa. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

Вкладка Preferences — так называемые “предпочтения”

Здесь задаем желаемые параметры для некоторых сканируемых элементов (title, description, url, h2, h3, alt картинок, размер картинок). Соответственно, если сканируемые элементы сайта не будут соответствовать нашим предпочтениям, программа нам об этом сообщит в научно-популярной форме. Совершенно необязательные настройки — каждый прописывает для себя свой идеал… или вообще их не трогает, от греха подальше (как делаю я).

- Page Title Width — оптимальная ширина заголовка страницы. Указываем желаемые размеры от и до в пикселях и в символах.

- Meta Description Width — оптимальная ширина описания страницы. Аналогично, как и с тайтлом, указываем желаемые размеры.

- Other — сюда входит максимальная желаемая длина урл-адреса в символах (Max URL Length Chars), максимальная длина h2 в символах (Max h2 Length Chars), максимальная длина h3 в символах (Max h3 Length Chars), максимальная длина ALT картинок в символах (Max Image Length Chars) и максимальный вес картинок в КБ (Max Image Size Kilobytes).

Robots.txt — определяем каким правилам следовать при парсинге

Вкладка Settings — настраиваем парсинг относительно правил robots.txt

- Respect robots.txt — следуем всем правилам, прописанным в robots.txt. Т.е. учитываем в анализе те папки и файлы, которые открыты для робота.

- Ignore robots.txt — не учитываем robots.

txt сайта при парсинге. В отчет попадают все папки и файлы, относящиеся к домену.

txt сайта при парсинге. В отчет попадают все папки и файлы, относящиеся к домену. - Ignore robots.txt but report status — не учитываем robots.txt сайта при парсинге, однако в дополнительном меню выводится статус страницы (индексируемая или не индексируемая).

- Show internal/external URLs blocked by robots.txt — отмечаем в чекбоксах хотим ли мы видеть в итоговом отчете внутренние и внешние ссылки, закрытые от индексации в robots.txt. Данная опция работает только при условии выбора “Respect robots.txt”.

Вкладка Custom — ручное редактирование robots.txt в пределах текущего парсинга

Удобно, если вам нужно при парсинге сайта учитывать (или исключить) только определенные папки, либо же добавить правила для поддоменов. Кроме того, можно быстро сформировать и проверить свой рабочий robots, чтобы потом залить его на сайт.

Шаг 1. Прописать анализируемый домен в основной строке

Шаг 2. Кликнуть на Add, чтобы добавить robots..png) txt домена

txt домена

Тут на самом деле все очень просто, поэтому я по верхам пробегусь по основным опциям (а в конце будет видео, где я бездумно прокликиваю все кнопки).

- Блок Subdomains — сюда, собственно, можно добавлять домены/поддомены, robots.txt которых мы хотим учитывать при парсинге сайта.

- Окно справа — для редактирования выгруженного robots.txt. Итоговый вариант будет считаться каноничным для парсера.

- Окошко снизу — проверка индексации url в зависимости от настроенного robots.txt. Справа выводится статус страницы (Allowed или Disallowed).

URL Rewriting — функция перезаписи URL «на лету»

Тут мы можем настроить перезапись урл-адресов домена прямо в ходе парсинга. Полезно, когда нужно заменить определенные регулярные выражения, которые засоряют итоговый отчет по парсингу.

Вкладка Remove Parameters

Вручную вводим параметры, которые нужно удалять из url при анализе сайта, либо исключить вообще все возможные параметры (чекбокс “Remove all”). Полезно, если у страниц сайта есть идентификаторы сеансов, отслеживание контекста (utm_source, utm_medium, utm_campaign) или другие фишки.

Вкладка Regex Replace

Изменяет все сканируемые урлы с использованием регулярных выражений. Применений данной настройки масса, я приведу только несколько самых распространенных примеров:

- Изменение всех ссылок с http на https (Регулярное выражение: http Заменить: https).

- Изменение всех ссылок на site.by на site.ru (Регулярное выражение: .by Заменить: .ru).

- Удаление всех параметров (Регулярное выражение: \?. * Заменить: ).

- Добавление параметров в URL (Регулярное выражение: $ Заменить: ?ПАРАМЕТР).

Вкладка Options

Вы рассчитывали увидеть здесь еще 100500 дополнительных опций для суперточной настройки URL Rewriting, я прав? Как бы странно это ни звучало, но здесь мы всего лишь определяем перезаписывать все прописные url-адреса в строчные или нет… вот как-то так, не спрашивайте, я сам не знаю почему для этой опции сделали целую отдельную вкладку.

Вкладка Test

Тут мы можем предварительно протестировать видоизменение url перед началом парсинга и, соответственно, подправить регулярные выражения, чтобы на выходе не получилось какой-нибудь ерунды.

CDNs — парсим поддомены, не отходя от кассы

Использование настройки CDNs позволяет включать в парсинг дополнительные домены/поддомены/папки, которые будут обходиться пауком и при этом считаться внутренними ссылками. Полезно, если нужно проанализировать массив сайтов, принадлежащих одному владельцу (например, крупный интернет-магазин с сетью сайтов под регионы). Также можно прописывать регулярные выражения на конкретные пути сканирования — т.е. парсить только определенные папки.

Во вкладке Test можно посмотреть как будут определяться урлы в зависимости от используемых параметров (Internal или External).

Include/Exclude — сканирование/удаление определенных папок

Можно регулярными выражениями задать пути, которые будут сканироваться внутри домена. Также можно запретить парсинг определенных папок. Единственный нюанс в настройках — при использовании Include будут парситься только УКАЗАННЫЕ папки, если же мы добавляем урлы в Exclude, сканироваться будут все папки, КРОМЕ УКАЗАННЫХ.

Также можно запретить парсинг определенных папок. Единственный нюанс в настройках — при использовании Include будут парситься только УКАЗАННЫЕ папки, если же мы добавляем урлы в Exclude, сканироваться будут все папки, КРОМЕ УКАЗАННЫХ.

Выбираем папки для парсинга

Удаляем папки из парсинга

Примеры регулярных выражений для Exclude:

- http://site.by/obidnye-shutki-pro-seo.html (исключение конкретной страницы).

- http://site.by/obidnye-shutki-pro-seo/.* (исключение целой папки).

- http://site.by/.*/obidnye-shutki-pro-seo/.* (исключение всех страниц, после указанной).

- .*\?price.* (исключение страниц с определенным параметром).

- .*jpg$ (исключение файлов с определенным расширением).

- .*seo.* (исключение страниц с вхождением в url указанного слова).

- .*https.* (исключение страниц с https).

- http://site.by/.* (исключение всех страниц домена/поддомена).

Speed — регулируем скорость парсинга сайта

Можно выставить как количество потоков (по умолчанию 5), так и число одновременно сканируемых адресов. Влияет на скорость парсинга и вероятность бана бота, так что тут лучше не усердствовать.

Влияет на скорость парсинга и вероятность бана бота, так что тут лучше не усердствовать.

User-Agent — выбираем под кого маскируемся

В списке user-agent можно выбрать от лица какого бота будет происходить парсинг сайта. Удобно, если в настройках сайта есть директивы, блокирующие того или иного бота (например, запрещен google-bot). Также полезно иногда прокраулить сайт гугл-ботом для смартфона, чтобы проверить косяки адаптива или мобильной версии.

Скажу сразу — это опция очень индивидуальна, лично я ее не пользую, потому что чаще всего незачем. В любом случае, настройка реагирования на http-заголовки позволяет определить, как паук будет их обрабатывать (если указаны нюансы в настройках). По крайней мере я так это понял.

Т.е. можно индивидуально настроить, например, какого формата контент обрабатывать, учитывать ли cookie и т.д. Нюансов там довольно много.

Custom — дополнительные настройки поиска по исходному коду

Custom Search

По сути обычный фильтр, с помощью которого можно вытягивать дополнительные данные, например, страницы, в которых вместо тега <strong> используется <bold> или еще лучше — страницы, которые НЕ содержат определенного контента (например, без кода счетчика метрики). Фактически в настройках можно задать все что угодно.

Фактически в настройках можно задать все что угодно.

Custom Extraction

Это пользовательское извлечение любых данных из html (например, текстовое содержимое).

User Interface — обнуление настроек для колонок таблицы

Просто сбрасывает сортировку столбцов, ничего особенного, проходим дальше, граждане, не толпимся.

API Access — интеграция с разными сервисами

Для того чтобы получать больше данных по сайту, можно настроить интеграцию с разными сервисами статистики типа Google Analytics или Majestic, при условии того, что у вас есть аккаунт в этом сервисе.

При этом для каждого сервиса отдельные настройки выгрузки по типам данных.

На примере GA

Authentification — настройки аутентификации (если есть запрос от сайта)

Есть два вида аутентификации — Standart Based и Form Based. По умолчанию используется Standart Base — если при парсинге от сайта приходит запрос на аутентификацию, в программе появляется соответствующее окно.

Form Based — использование для аутентификации встроенного в SF браузера (полезно, когда для подтверждения аутентификации нужно, например, пройти капчу). В данном случае необходимо вручную вводить урл сайта и в открывшемся окне браузера вводить логин/пароль, кликать recaptcha и т.д.

System — внутренние настройки самой программы

Настройки работы самой программы — сколько оперативной памяти выделять на процесс, куда сохранять экспорт и т.д.

Давайте как обычно — подробнее о каждом пункте.

- Memory — выделяем лимиты оперативной памяти для парсинга. По дефолту стоит 2GB, но можно выделить больше (если ПК позволяет).

- Storage — выбор базы для хранения данных. Либо сохранение в ОЗУ (для этого у SF есть свой движок), либо в указанной папке на ПК пользователя.

- Proxy — подключение прокси-сервера для парсинга.

- Embedded Browser — использование встроенного в программу браузера (вкл/выкл).

Mode

- Spider (Режим паука) — классический парсинг сайта по внутренним ссылкам. Просто вводим нужный домен в адресную строку программы и запускаем работу.

- List — парсим только предварительно собранный список урл-адресов! Адреса можно выгрузить из файла (From a file), вбить вручную (Enter Manually), подтянуть их из карты сайта (Download Sitemap) и т.д. Если честно, этих трех способов получения списка урлов должно быть более чем достаточно.

- SERP Mode — в этом режиме нет сканирования, зато здесь можно загружать мета-данные сайта, редактировать их и предварительно понимать как они будут отображаться в браузере.

Делать все это можно пакетно, что вполне себе удобно.

Делать все это можно пакетно, что вполне себе удобно.

Bulk export

В этом пункте меню висят все опции SF, отвечающие за массовый экспорт данных из основного и дополнительного меню отчета…сейчас покажу на скриншоте.

В общем и целом с помощью bulk export можно вытянуть много разной полезной информации для последующей постановки ТЗ на доработки. Например, выгрузить в excel страницы, на которых найдены ссылки с 3хх ответом сервера + сами 3хх-ссылки, что позволяет сформировать задание для программиста или контент-менеджера (зависит от того, где зашиты 3хх-ссылки) на замену этих 3хх-ссылок на прямые с кодом 200. Теперь подробнее про то, что можно экспортировать при помощи Bulk Export.

- All Inlinks — получаем все входящие ссылки на каждый URI, с которым столкнулся краулер при сканировании сайта.

- All Outlinks — получаем все исходящие ссылки с каждого URI, с которым столкнулся краулер при сканировании сайта.

- All Anchor Text — выгрузка анкоров всех ссылок.

- All Images — выгрузка всех картинок (урл-адресами, естественно).

- Screenshots — экспорт снимков экрана.

- All Page Source — получаем статический HTML-код или обработанный HTML-код просканированных страниц (рендеринг HTML доступен только в режиме рендеринга JavaScript) .

- External Links — все внешние ссылки со всех просканированных страниц.

- Response Codes — все страницы в зависимости от выбранного кода ответа сервера (закрытые от индекса, с кодом 200, с кодом 3хх и т.д.).

- Directives — все страницы с директивами в зависимости от выбранной (Index Inlinks, Noindex Inlinks, Nofollow Inlinks и т.д.).

- Canonicals — страницы, содержащие канонические атрибуты, страницы без указания этих атрибутов, каноникализированные (*перекрестился*) страницы и т.д.

- AMP — страницы с AMP, ссылки с AMP (но код ответа не 200) и т.д.

- Structured Data — выгрузка страниц с микроразметкой.

- Images — выгрузка картинок без альт-текста, тяжелых картинок (в соответствии с указанным в настройках размером).

- Sitemaps — выгрузка всех страниц в карте сайта, неиндексируемых страниц в карте сайта и проч.

- Custom — выгрузка пользовательских фильтров.

Reports

Здесь содержится множество различных отчетов, которые также можно выгрузить.

- Crawl Overview — в этом отчете содержится сводная информация о сканировании, включая такие данные, как количество найденных URL-адресов, заблокированных robots.txt, число сканированных, тип контента, коды ответов и т. д.

- Redirect & Canonical Chains — отчет о перенаправлении и канонических цепочках. Здесь отображаются цепочки перенаправлений и канонических символов, показывается количество переходов по пути и идентифицируется источник, а также цикличность (если есть).

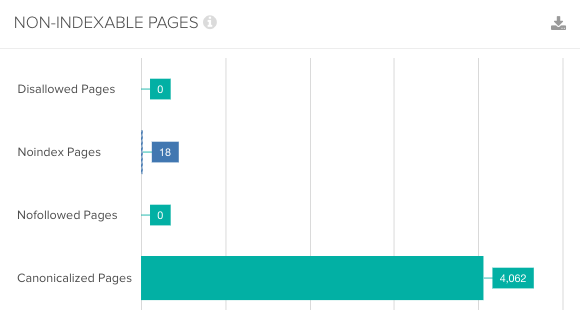

- Non-Indexable Canonicals — здесь можно получить выгрузку, в которой освещаются ошибки и проблемы с canonical.

В частности, этот отчет покажет любые канонические файлы, которые не отдают корректного ответа сервера — заблокированы файлом robots.txt, с перенаправлением 3хх, ошибкой 4хх или 5хх (вообще все что угодно, кроме ответа «ОК» 200).

В частности, этот отчет покажет любые канонические файлы, которые не отдают корректного ответа сервера — заблокированы файлом robots.txt, с перенаправлением 3хх, ошибкой 4хх или 5хх (вообще все что угодно, кроме ответа «ОК» 200). - Pagination — ошибки и проблемы с атрибутами rel=”next” и rel=”prev”, которые используются для обозначения содержимого, разбитого на пагинацию.

- Hreflang — проблемы с атрибутами hreflang (некорректный ответ сервера, страницы, на которые нет гиперссылок, разные коды языка на одной странице и т.д.).

- Insecure Content — показаны любые защищенные (HTTPS) URL-адреса, на которых есть небезопасные элементы, такие как внутренние ссылки HTTP, изображения, JS, CSS, SWF или внешние изображения в CDN, профили социальных сетей и т. д.

- SERP Summary — этот отчет позволяет быстро экспортировать URL-адреса, заголовки страниц и мета-описания с соответствующими длинами символов и шириной в пикселях.

- Orphan Pages — список потерянных страниц, собранных из Google Analytics API, Google Search Console (Search Analytics API) и XML Sitemap, которые не были сопоставлены с URL-адресами, обнаруженными во время парсинга.

- Structured Data — отчет содержит данные об ошибках валидации микроразметки страниц.

Sitemaps

С помощью этого пункта можно сгенерировать XML-карту сайта (страницы и картинки).

Все просто — выбираем что будем генерировать. В появившемся окне при необходимости выбираем нужные параметры и создаем карту сайта, которую потом заливаем в корневой каталог сайта.

Рассмотрим подробнее параметры, которые нам предлагают выбрать при генерации карты сайта.

Вкладка Pages — выбираем какие типы страниц включить в карту сайта.

- Noindex Pages — страницы, закрытые от индексации.

- Canonicalised — каноникализированные (опять это страшное слово!) страницы . Другими словами, динамика, у которой есть rel=”canonical”.

- Paginated URLs — страница пагинации.

- PDFs — PDF-документы.

- No response — страницы с кодом ответа сервера 0 (не отвечает).

- Blocked by robots.

txt — страницы закрытые от индекса в robots.txt.

txt — страницы закрытые от индекса в robots.txt. - 2xx — страницы с кодом 2хх (они будут в карте в любом случае).

- 3хх — страницы с кодом ответа 3хх (редиректы).

- 4хх — страницы с кодом ответа 4хх (битые ссылки на несуществующие страницы).

- 5хх — страницы с кодом ответа 5хх (проблема сервера при загрузке).

Вкладка Last Modified — выставляем дату последнего обновления карты.

- nclude <lastmod> tag — использовать в sitemap тег <lastmod> (дата последнего обновления карты).

- Use server report — использовать ответ сервера при создании карты, либо проставить дату вручную.

Вкладка Priority — выставляем приоритет ссылки в зависимости от глубины залегания страницы.

- Include <priority> tag — добавляет в карту сайта тег <priority>, показывающий приоритет страницы.

- Crawl Depth 0-5+ — в зависимости от глубины залегания страницы, можно проставить ее приоритет сканирования для поискового робота.

Вкладка Change Frequency — выставляем вероятную частоту обновления страниц.

- Include <changefreq> tag — использовать тег <changefreq> в карте сайта. Показывает частоту обновления страницы.

- Calculate from Last Modified header — рассчитать тег по последнему измененному заголовку.

- Use crawl depth settings — проставить тег в зависимости от глубины страницы.

Вкладка Images — добавляем картинки в карту сайта.

- Include Images — выводить в общей карте сайта картинки.

- Include Noindex Images — добавить картинки, закрытые от индекса.

- Include only relevant Images with up to … inlinks — добавить только картинки с заданным числом входящих ссылок.

- Regex list of CDNs hosting images to be included — честно, так и не понял что это такое… возможно настройка выгрузки в карту сайта картинок из хостинга (т.е. можно вбить списком несколько хостов и оттуда подтянуть картинки), но это всего лишь мои предположения.

Вкладка Hreflang — использовать в sitemap атрибут <hreflang> (или не использовать).

Visualisations

Это выбор интерактивной визуализации структуры сайта в программе. Можно получить отображение дерева сканирования и дерева каталогов. Основная фишка в том, что открываются эти карты и диаграммы во встроенном браузере программы, что позволяет эффективнее с ними работать (настраивать выведение, масштабировать, перескакивать к нужным урлам через поиск и т.д.).

Crawl Tree Graph — визуализация сканирования. По факту после завершения краулинга показывает текущую структуру сайта на основании анализа.

Directory Tree Graph — показывает ВСЕ каталоги после сканирования. Т.е. отличие от Crawl Tree Graph в том, что в этом отчете показываются, например, папки, закрытые от индекса.

Назначение Crawl Tree Graph и Directory Tree Graph в основном заключается в упрощении анализа структуры текущего сайта, можно глазами пробежаться по всем папкам, зацепиться за косяки (т. к. они выделены цветом). При наведении на папку, показывается ее данные (url, title, h2, h3 и т.д.).

к. они выделены цветом). При наведении на папку, показывается ее данные (url, title, h2, h3 и т.д.).

Force Directed Crawl-Diagram — по сути то же самое, что и Crawl Tree Graph, только оформленное по-другому + показывает сканирование сайта относительно главной страницы (ну или стартовой). Кому-то покажется нагляднее, хотя по мне, выглядит гораздо сложнее для восприятия.

Force Directed Tree-Diagram — аналогично, другой тип визуализации дерева каталогов сайта.

Inlink Anchor Text Word Cloud — визуализация анкоров (ссылочного текста) внутренней ссылки. Анализирует каждую страницу по-отдельности. Помогает понять какими анкорами обозначена страница, как их много, насколько разнообразны и т.д.

Р- Разнообразие

Body Text Word Cloud — визуализация плотности отдельных слов на странице. По сути выглядит так же, как и Inlink Anchor Text Word Cloud, так что отдельный скрин делать смысла особого нет — обычное облако слов, по размеру можно определить какое слово встречается чаще, по общему числу посмотреть разнообразие слов на странице и т. д.

д.

Каждая визуализация имеет массу настроек вывода данных, маркировки — про них я писать не буду, если станет интересно, сами поиграетесь, ок? Там ничего сложного.

Crawl Analysis

Большинство параметров сайта вычисляется пауком в ходе сбора статистики, однако некоторые данные (Link Score, некоторые фильтры и прочее) нуждаются в дополнительном анализе, чтобы попасть в финальный отчет. Данные, которые нуждаются в Crawl Analysis, помечены соответствующим образом в правом меню навигации.

Crawl Analysis запускается после основного парсинга. Перед запуском дополнительного анализа, можно настроить его (какие данные выводить в отчет).

- Link Score — присвоение оценок всем внутренним ссылкам сайта.

- Pagination — показывает петлевые пагинации, а также страницы, которые обнаружены только через атрибуты rel=”next”/”prev”.

- Hreflang — урлы hreflang без гиперссылки, битые ссылки.

- AMP — страницы без тегов “html amp”, теги не с 200 кодом ответа.

- Sitemaps — неиндексируемые страницы в карте сайта, урлы в нескольких картах сайта, потерянные страницы (например, есть в Google Analytics, есть в sitemap, не обнаружено при парсинге), страницы, которых нет в карте сайта, страницы в карте сайта.

- Analytics — потерянные страницы (есть в аналитике, нет в парсинге).

- Search Console — потерянные страницы (есть в вебмастере, нет в парсинге).

License

Исходя из названия, логично предположить, что этот пункт меню отвечает за разного рода манипуляции с активацией продукта…иии так оно и есть!

Buy a License — купить лицензию. При клике переход на соответствующую страницу официалов https://www.screamingfrog.co.uk/seo-spider/licence/. Стоимость ключа для одного ПК — 149 фунтов стерлинга. Есть пакеты для нескольких ПК, там, как обычно, идут скидки за опт.

Enter License — ввести логин и ключ лицензии, чтобы активировать полный функционал парсера.

Заметили, да? Лицензия покупается на год, не бессрочная

Help

Помощь юзеру — гайды, FAQ, связь с техподдержкой, в общем все, что связано с работой программы, ее багами и их решением.

- User Guide — мануал по работе с программой. Собственно, его я использовал, как один из источников, для написания этой статьи. При желании, можете ознакомиться, если я что-то непонятно рассказал или не донес. Еще раз оставлю ссылку https://www.screamingfrog.co.uk/seo-spider/user-guide/.

- FAQ — часто задаваемые вопросы по работе с SF и ответы на них https://www.screamingfrog.co.uk/seo-spider/faq/.

- Support — обратная связь с техподдержкой https://www.screamingfrog.co.uk/seo-spider/support/. Если программа ведет себя некрасиво (например, не принимает ключ лицензии), можно пожаловаться куда надо и все починят.

- Feedback — обратная связь. Та же самая страница, что и в Support. Т.е. можно не только жаловаться, но и вносить предложения по работе программы, предлагать партнерку, сказать банальное “спасибо” за такой крутой сервис (думаю ребятам будет приятно).

- Check for Updates и Auto Check for Updates — проверка на наличие обновлений программы. Screaming Frog нерегулярно, но довольно часто дорабатывается, поэтому есть смысл периодически проверять апдейты. Но лучше поставить галочку на Auto Check for Updates и программа сама будет автоматически предлагать обновиться при выходе нового апа.

- Debug — отчет о текущем состоянии программы. Нужно, если вы словили какой-то баг и хотите о нем сообщить разработчику. Там еще дополнительно есть настройки дебага, но я думаю, нет смысла заострять на этом внимание.

- About — собственно, краткая информация о самой программе (копирайт, сервисы, которые использовались при разработке).

Итог

Screaming Frog — очень гибкая в плане настройке утилита, с помощью которой можно вытянуть массу данных для анализа, нужно только (только… ха-ха) правильно настроить парсинг. Я надеюсь, мой мануал поможет вам в этом, хотя и не все я рассмотрел как надо, есть пробелы, но основные функции должны быть понятны.

Теперь от себя — текста много, скринов много, потому, если вы начинающий SEO-специалист, рекомендую осваивать SF поэтапно, не хватайтесь за все сразу, ибо есть шанс упустить важные нюансы.

Ну вот и все, ребята, я отчаливаю за новым материалом для нашего крутого блога. Подписывайтесь, чтобы не пропустить интересные публикации от меня и моих коллег. Всем удачи, всем пока!

Владимир Еленский

Практикующий SEO-специалист MAXI.BY media. Опыт работы более 5-ти лет. Хороший человек и просто красавчик.

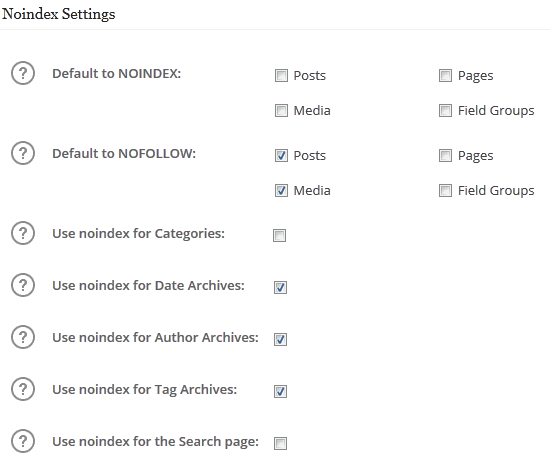

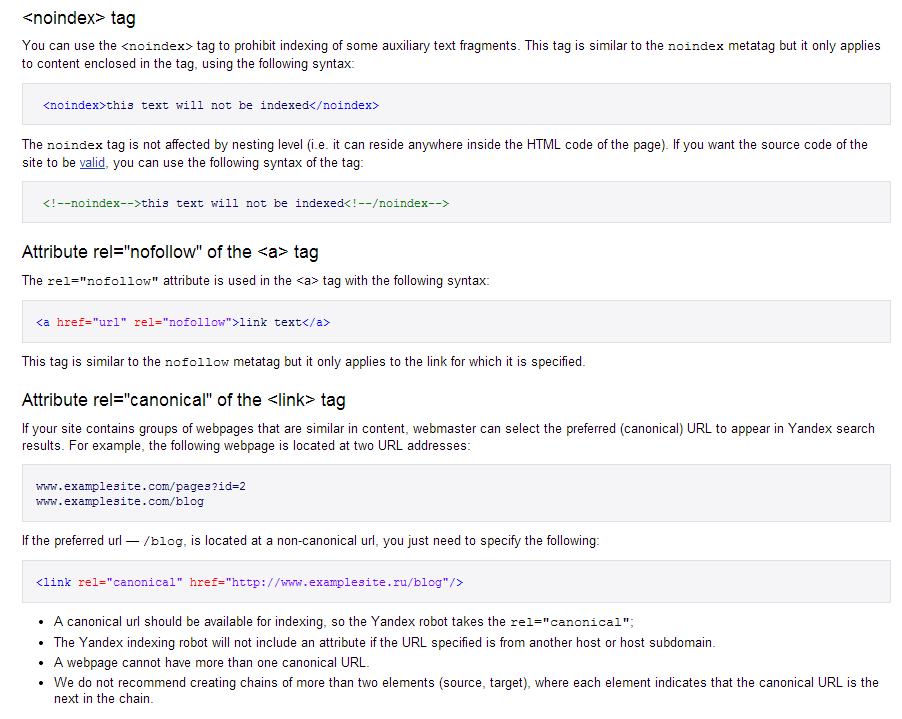

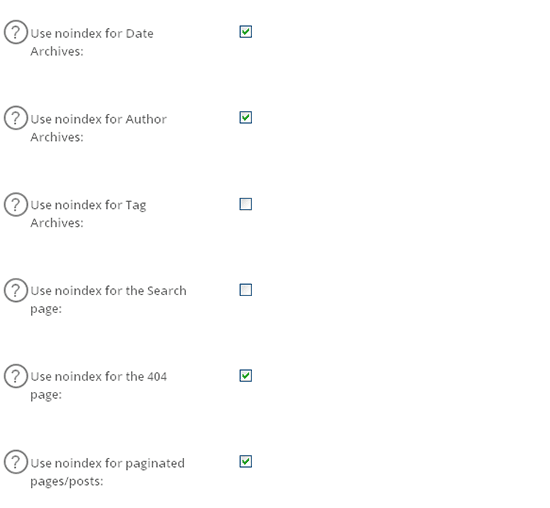

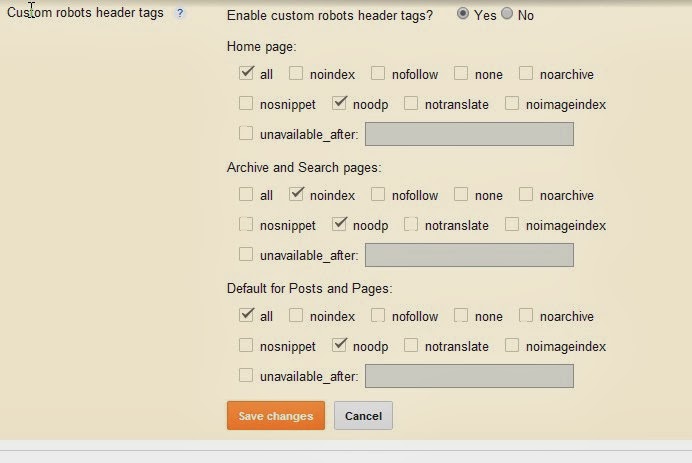

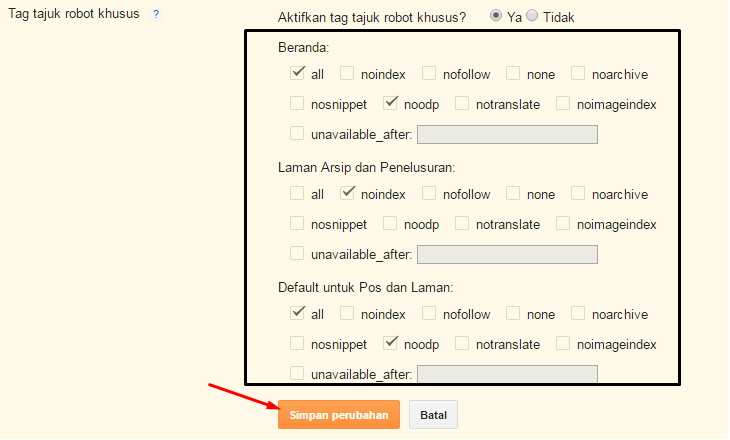

Теги Noindex и Nofollow — в чем разница, зачем нужны и примеры использования

На каждом сайте есть контент, который владельцы не хотят показывать поисковым системам или не хотят, чтобы он оказывал какое-либо влияние на продвижение. Чаще всего мы хотим скрыть от индексации исходящие ссылки, чтобы не повышать заспамленность сайта ссылками. Вот для этих целей и применяются тег noindex и атрибут nofollow.

Прежде чем мы начнем говорить об использовании наших тегов, хотелось бы отметить несколько важных моментов. Необходимость скрывать от роботов поисковых систем различные фрагменты кода страниц была всегда. Разработчики и оптимизаторы сайтов уже много лет знают, что есть вещи, которые поисковикам лучше не показывать.

Необходимость скрывать от роботов поисковых систем различные фрагменты кода страниц была всегда. Разработчики и оптимизаторы сайтов уже много лет знают, что есть вещи, которые поисковикам лучше не показывать.

Но пик популярность пришелся на эпоху роста рынка купли-продажи ссылок и активизации поисковых систем в направлении борьбы с ними.

Noindex и nofollow это самые первые и простые инструменты, которые позволяют сказать поисковику, что нужно индексировать, а что трогать не стоит. И несмотря на то, что эти теги активно используются владельцами сайтов уже много лет, отказываться от них сегодня никто не собирается, и популярность они ни сколько не потеряли.

При использовании этих тегов нет никаких негативных последствий. Более того, Яндекс даже рекомендует применять noindex и nofollow для настройки индексации сайта и оптимизации контента на страницах.

В сервисе Яндекс.Вебмастер в разделе «Помощь» существует специальная страница, на который представители поисковой системы рассказывают обо всех возможностях использования данных инструментов.

Применение этих тегов не требует каких-либо особых знаний и навыков работы с программным html кодом. Даже новички без проблем смогут использовать эти теги.

Что делает тег noindex

Для начала очень важная особенность. Все мы знаем, что сегодня в Рунете существует два самых главных поставщика поискового трафика на наши с вами сайты — это Яндекс и Google.

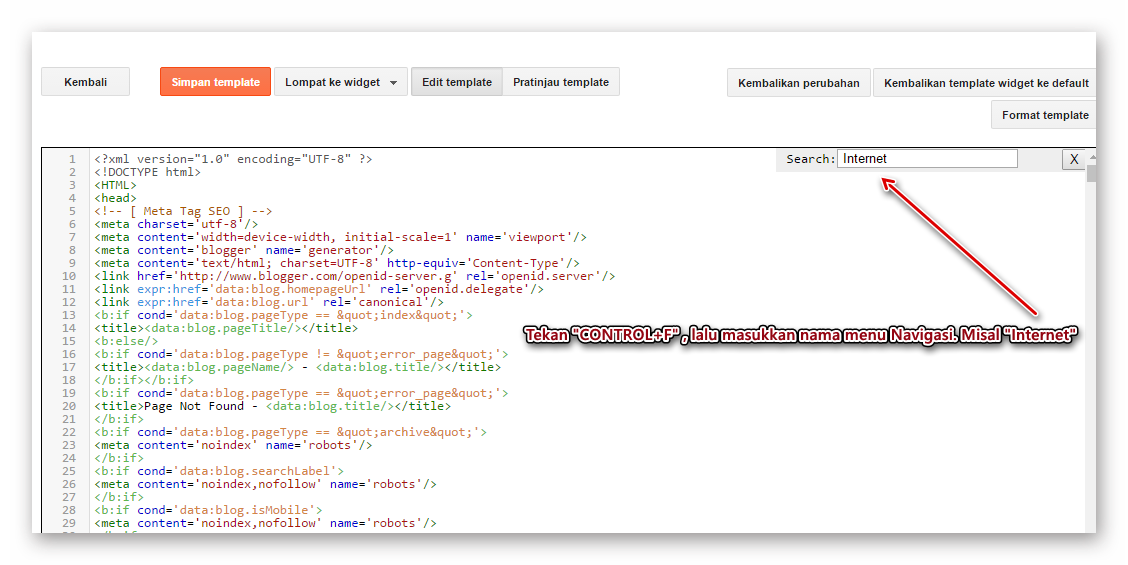

Тег noindex работает только для поисковой системы Яндекс и указывает на ту часть кода, который поисковая система не должна индексировать (добавлять в свою базу) и который не должен влиять на ранжирование страницы в результатах поиска. Google мета тег не видит и никак не учитывает.

Применять тег noindex нужно следующим образом:

<noindex><a href="http://DmitriyZhilin.ru">Проверка ссылок</a></noindex>

Сначала идет открывающийся тег — <noindex>, затем прописывается часть текста или программного кода, которую нужно скрыть от индексации Яндексом, и затем уже закрывающийся тег — </noindex>.

C помощью данного инструмента можно скрывать не только исходящие ссылки на сайте, но и любой программный код или текст. Просто помещаем нужный нам фрагмент между открывающим и закрывающим тегом, и готово.

Когда нам нужно скрывать программный код от индексации? Когда он не связан напрямую с темой вашей статьи и может неправильно повлиять на понимание текста поисковиком. Чаще всего это какой-нибудь опрос, несколько счетчиков, код для анализа поведенческих факторов или еще что-то в таком роде.

Что делает атрибут nofollow

Хотя эти два параметра часто употребляются вместе и многие думают, что это одно и то же, только для разных поисковых систем, разница между noindex и nofollow огромна.

Nofollow является параметром тега «rel» и может запрещать индексировать только ссылки, даже не индексировать, а переходить по ним поисковику (передавать ссылочный вес), сам анкорный текст будет спокойно читаться роботами. Этот параметр можно применять только к HTML ссылкам (<a>).

Другими словами, данный параметр не cможет cпрятать фрагменты программного кода или же часть какого-то текста, как это делает noindex.

Применяется параметр nofollow следующим образом:

<a href="http://DmitriyZhilin.ru" rel="nofollow">Проверка ссылок</a>

Я вам привел обычный программный код, которым выводим на страницах наших сайтов исходящие ссылки, где:

http://DmitriyZhilin.ru/ — ссылка, которую мы закрываем от индексации роботами Google.

rel=”nofollow” — присваиваем тегу «rel» значение nofollow.

Текст “Проверка ссылок” — это анкор скрываемой ссылки.

Для того, чтобы закрыть ссылку от индексации полностью, можно воспользоваться и тегом noindex, и параметром nofollow одновременно. В этом случае программный код будет выглядеть следующим образом:

<noindex><a href="http://DmitriyZhilin.ru" rel="nofollow">Проверка ссылок</a></noindex>

Получается тег noindex закрывает текст ссылки от индексации, а параметр nofollow запрещает передачу ссылочного веса.

Как я уже сказал выше, использование этих инструментов для закрытия ссылок это очень старый и проверенный метод.

Сегодня уже существует целый ряд альтернативных способов закрытия ссылок, например с помощью JavaScript, они сложнее в реализации, поэтому еще не так распространены.

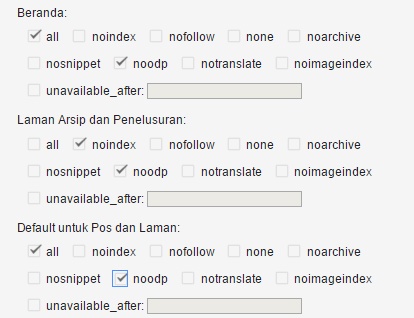

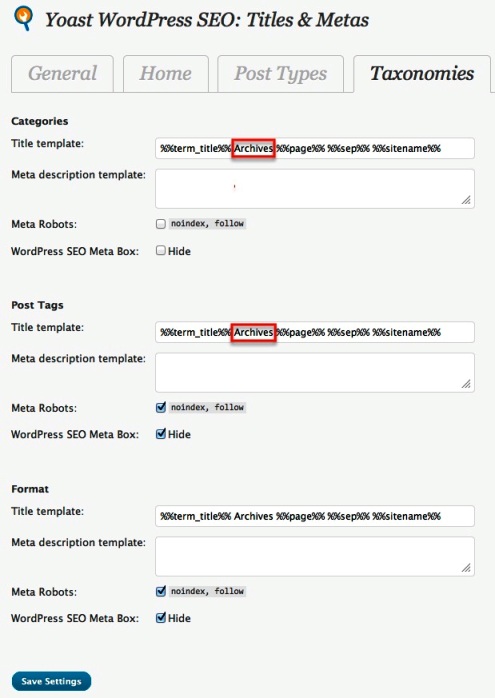

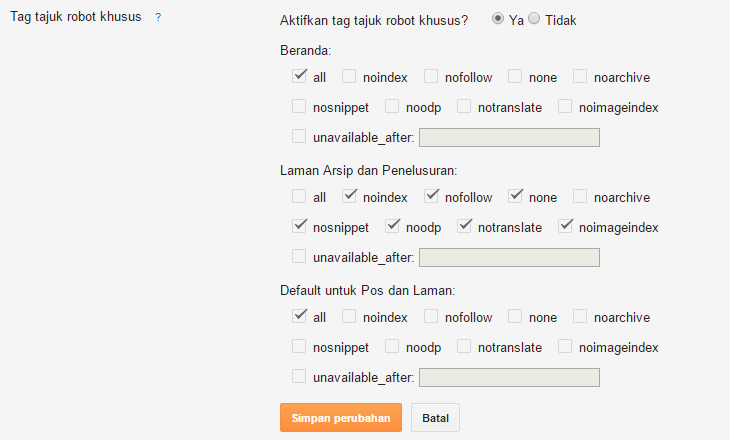

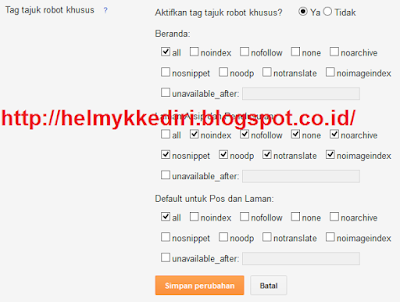

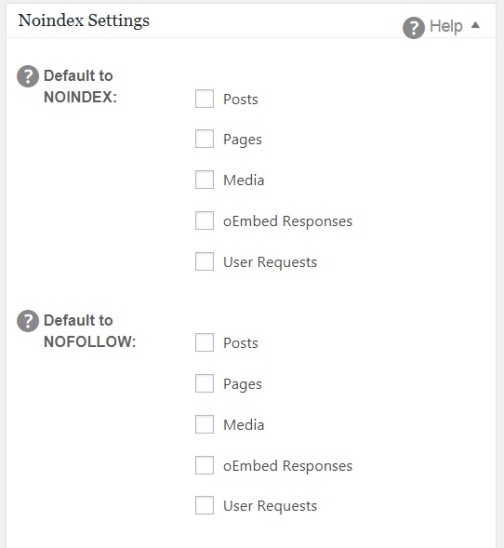

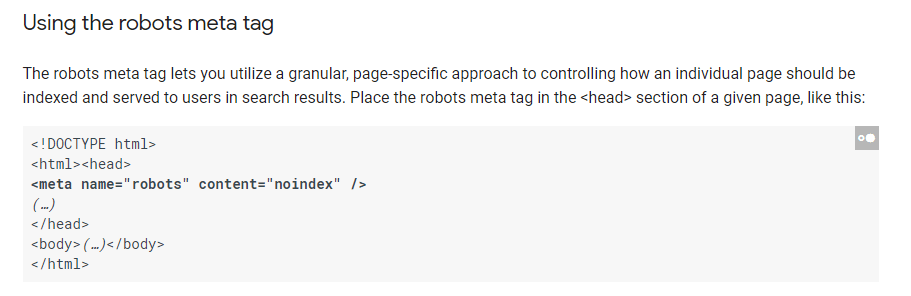

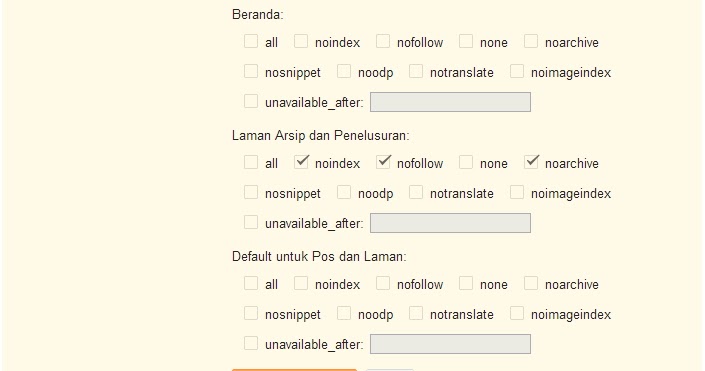

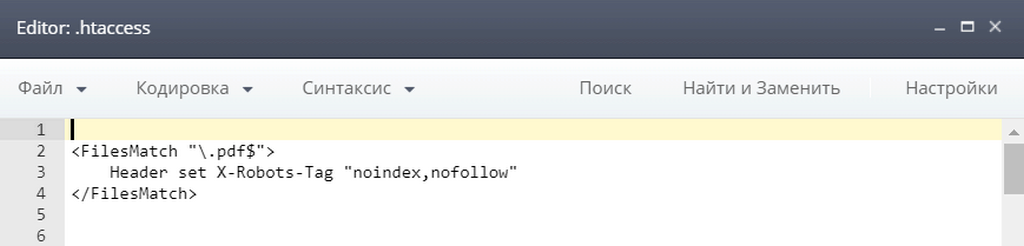

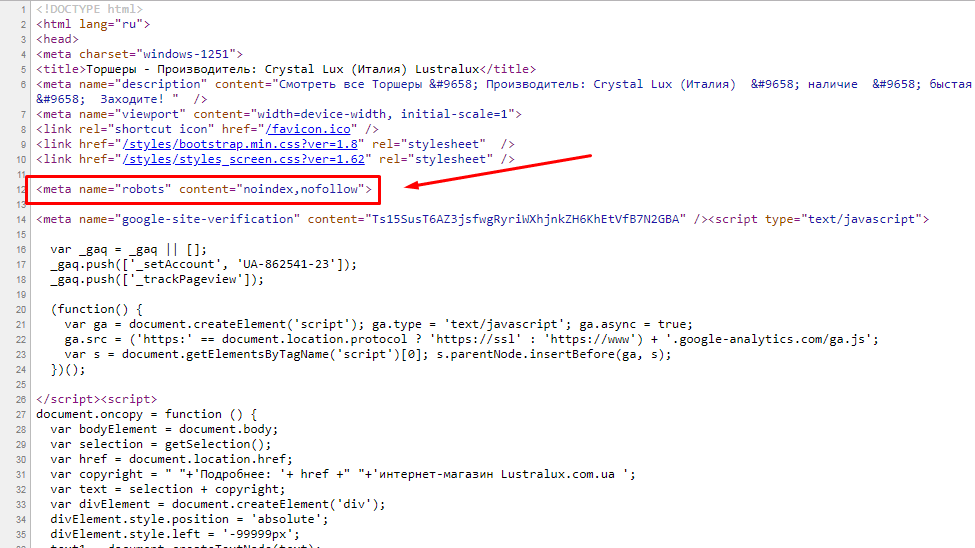

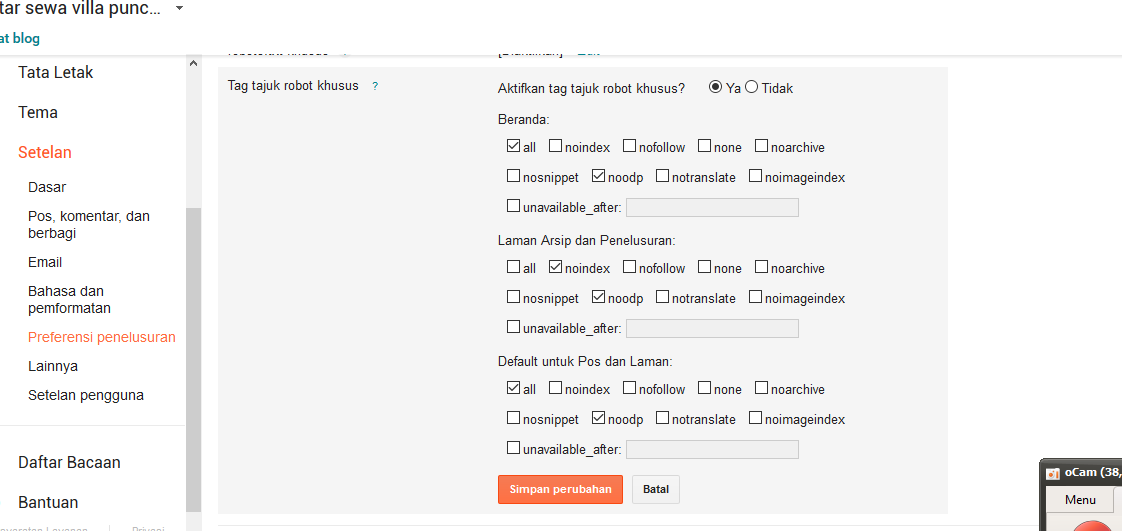

Применение Noindex и Nofollow для всей страницы

Еще один способ применения данных тегов – это запрет на индексацию всей страницы и запрет на учет всех ссылок с неё.

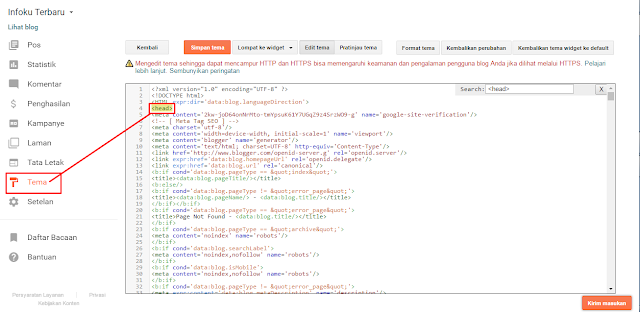

Для этого используется мета тег в разделе head кода сайта, выглядит он следующим образом:

<meta name="robots" content="noindex,nofollow" />

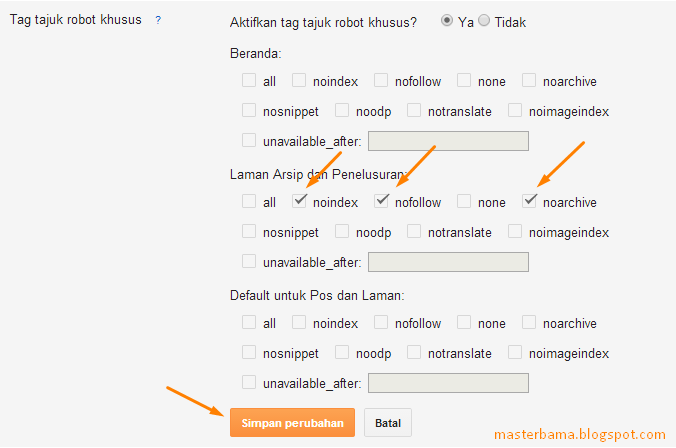

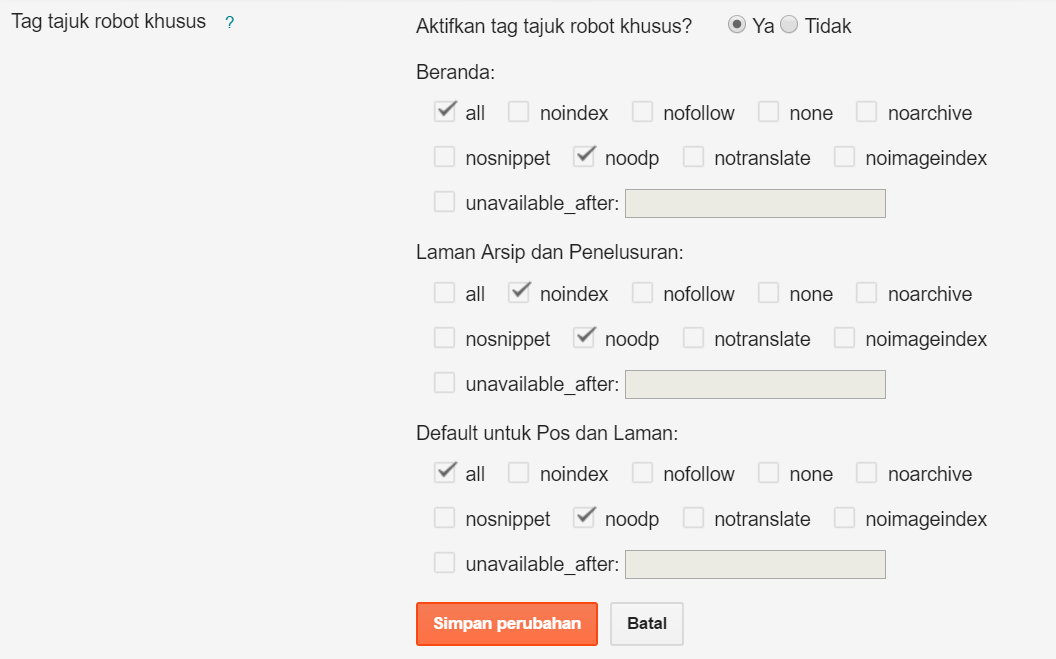

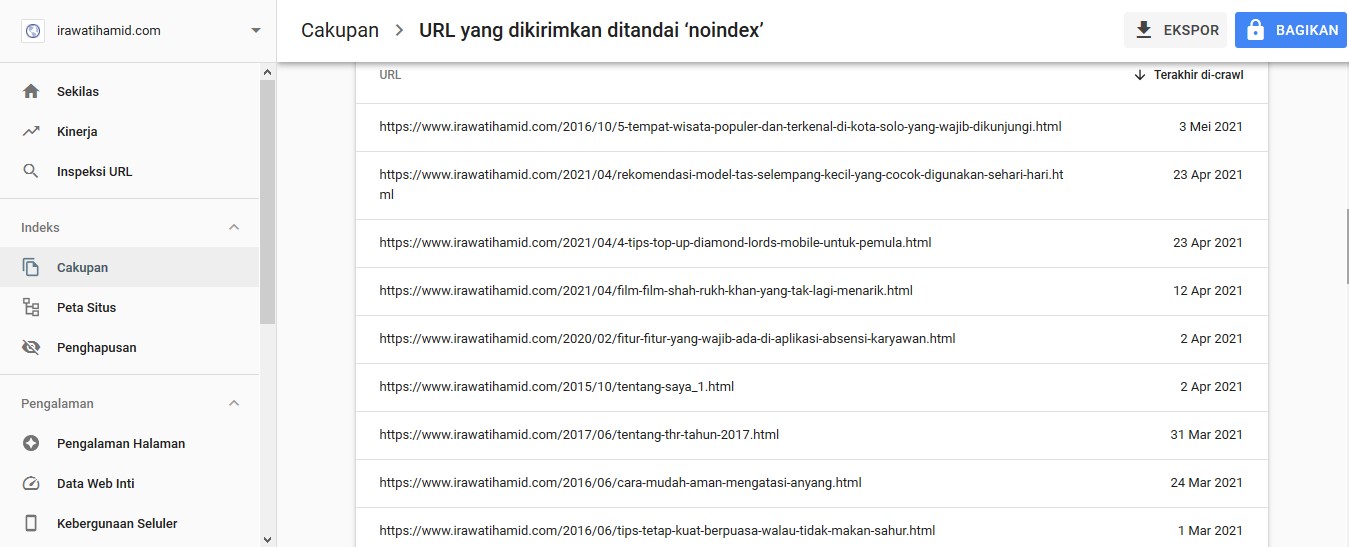

Задача такой конструкции в запрете на попадание в поиск различных дублей страниц, которые могут создаваться на сайте, например, архивы в WordPress.

Теперь вы знаете, когда и как нужно применять теги noindex и nofollow и в чем между ними разница.

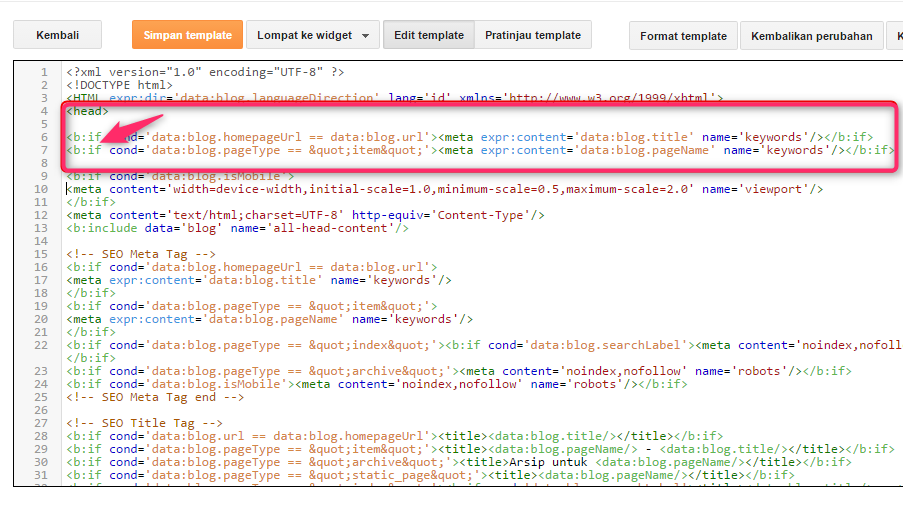

Мета тег Robots и файл Robots.txt – как управлять индексацией страниц сайта ~ SEO простым языком

[yandex2]

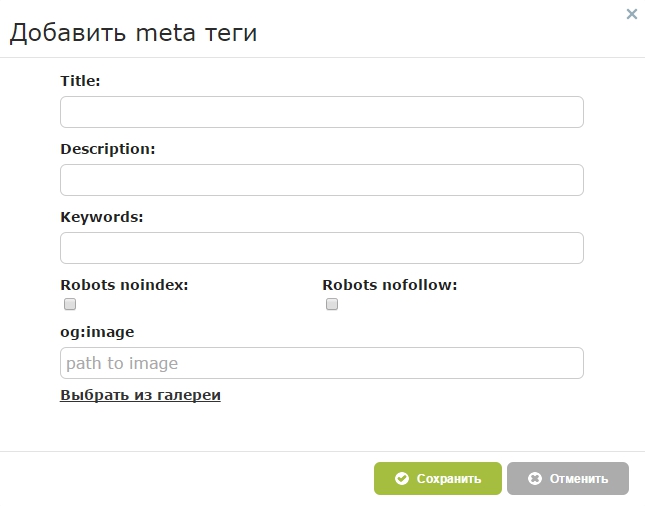

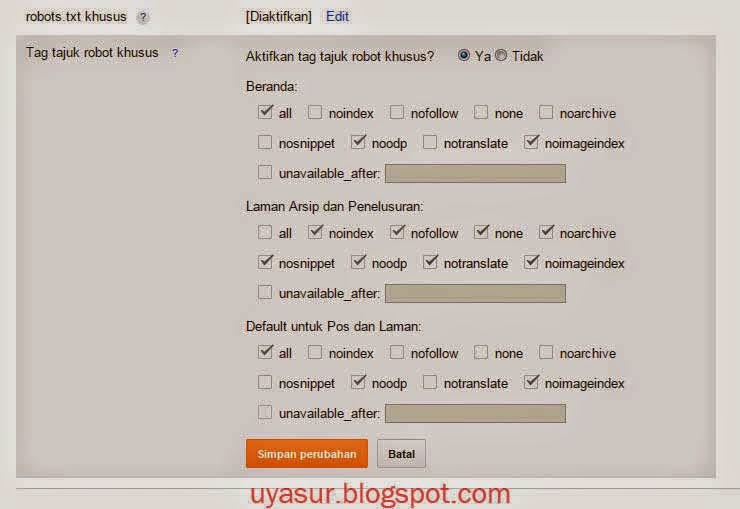

Доброго времени суток, уважаемые читатели. Задумала я тут поделиться с вами одним интересным материалом на тему внутренней оптимизации WordPress, а именно про установку мета тегов, и поняла, что чтобы получился хороший материал, необходимо прояснить ситуацию с тем, что такое мета тег Robots. Когда и для чего применяется. В чем разница использования файла Robots.txt и мета тега Robots.

Задумала я тут поделиться с вами одним интересным материалом на тему внутренней оптимизации WordPress, а именно про установку мета тегов, и поняла, что чтобы получился хороший материал, необходимо прояснить ситуацию с тем, что такое мета тег Robots. Когда и для чего применяется. В чем разница использования файла Robots.txt и мета тега Robots.

Robots.txt – это файл, с помощью которого мы можем управлять индексацией своего блога, указывая запрещающие директивы непосредственно в файле как для отдельных страниц, так и для целых каталогов. Более подробно об этом файле я писала применительно к WordPress в статье от 28 декабря 2011 года Файл Robots.txt.

Метатег Robots – это тег, с помощью которого мы можем управлять индексацией своего блога, указывая запрещающие команды для каждой отдельной страницы.

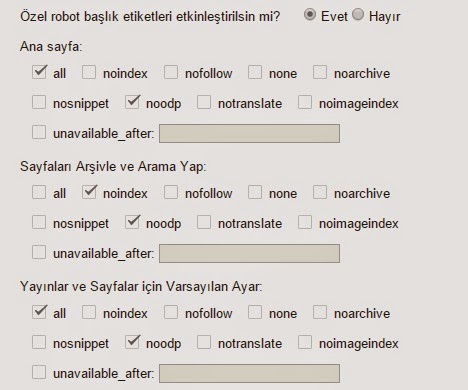

К слову, нет единого написания слова «мета тег». Даже Яндекс и Google по разному их пишут в своих справочных материалах. Мета тег, Мета-тег и Метатег – все это одно слово и используется в сети одновременно. При этом в справке Яндекс он имеет написание Мета-тег, а в Google – Метатег. Давайте сначала разберемся, каким вообще бывает мета тег Robots. Независимо от того, указываете вы этот метатег или нет, его значение всегда — «all», что означает индексировать. Т.е. есть три «состояния» данного мета тега:

При этом в справке Яндекс он имеет написание Мета-тег, а в Google – Метатег. Давайте сначала разберемся, каким вообще бывает мета тег Robots. Независимо от того, указываете вы этот метатег или нет, его значение всегда — «all», что означает индексировать. Т.е. есть три «состояния» данного мета тега:

- Полное его отсутствие.

- <meta name=»robots» content=»all» />

- <meta name=»robots» content=»index, follow» />

Все это означает, что страница будет проиндексирована. Поэтому если вам не нужно запрещать страницу к индексации, то используется первый вариант, т.е. вообще ничего не используем. Если же вы хотите полностью запретить страницу к индексации, то запись будет такой:

<meta name=»robots» content=»noindex, nofollow»/>

или более короткий вариант

<meta name=»robots» content=»none»/>

Как вы думаете, почему значение имеет два параметра – index/noindex и follow/nofollow?

- Значение index/noindex применяется только к тексту страницы.

- Значение follow/nofollow применяется только к ссылкам на странице.

Вот в этом, а также в самом определении кроется одно значительное преимущество мета тега Robots перед одноименным файлом.

Если вы сравните оба определения, то увидите, что они, практически, одинаковые. Но при этом имеют небольшое различие.

Да, оба способа – создание файла или указание мета тега – одно и тоже, выполняют абсолютно одинаковые функции и обладают абсолютно одинаковой значимостью. Другими словами нельзя сказать, что одно важнее другого. Они абсолютно равнозначны. Но как уже сказала, в них есть некоторые различия.

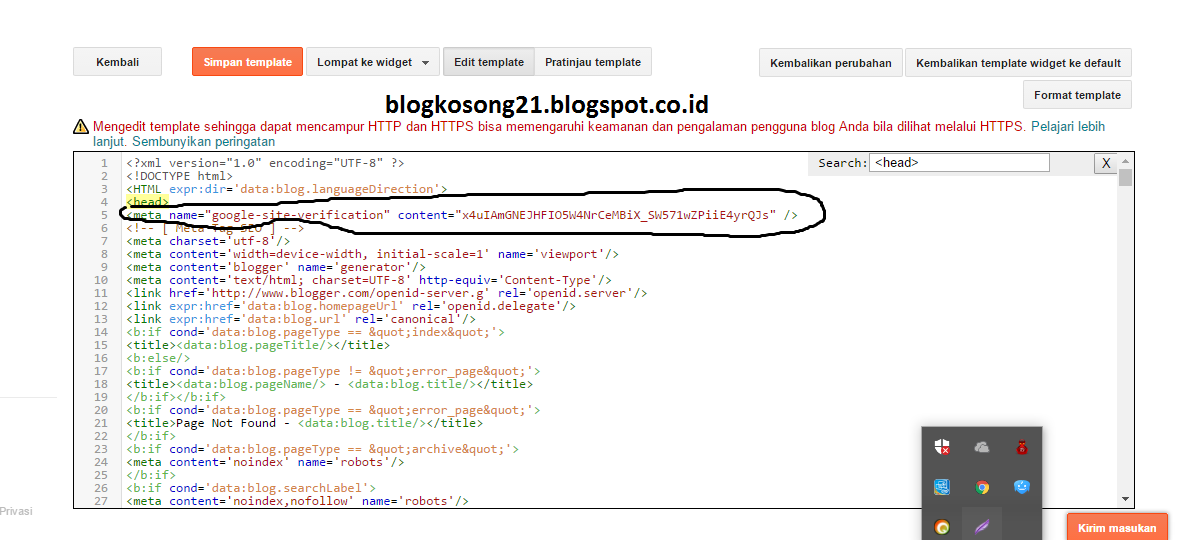

Вообще метатеги были придуманы не в противовес файлу, а для облегчения жизни тем вебмастерам, которые не имеют доступа к корневым папкам своего сайта, как это, например, происходит на Blogger. Т.е. сами поисковики рекомендуют настраивать файл Robots.txt когда есть доступ к папкам сайта, если же такого доступа нет, то рекомендуется использовать метатег.

Преимущества файла Robots.

txt перед мета тегом

txt перед мета тегомНа мой взгляд преимущество заключается в том, что в файле Robots.txt мы можем указывать целые каталоги своего сайта, запретить к индексации сразу все теги, рубрики и любые другие каталоги. При чем данный запрет выставляется единой строкой. Если же мы хотим запретить весь каталог, но при этом разрешить к индексации одну-две страницы, то так же в файле мы можем настроить исключения. Обо всем этом я писала в статье, на которую дала ссылку выше, поэтому сейчас кратко передаю суть.

Как же дела обстоят с мета тегом? Мета тег невозможно выставить один раз сразу всему каталогу, он устанавливается для каждой страницы в отдельности. Т.е. им удобно пользоваться тогда, когда на вашем сайте вы с каждой новой публикацией решаете, разрешать поисковому роботу индексировать данную страницу или нет.

Лично мне сложно представить такой сайт, где могло бы это понадобиться. Но факт остается фактом. Если вы не настраиваете файл Robots.txt, но при этом многие страницы закрываете от индексации, то каждый раз вам нужно быть начеку, чтобы не забыть закрыть страницу от индексации. Согласитесь, это неудобно.

Согласитесь, это неудобно.

Если вы свободны от такой рутины, то всегда значительно удобней и проще настроить один раз и навсегда файл Robots.txt и больше об этом не думать.

Преимущества мета тега Robots перед файлом или, когда лучше использовать мета тег

Я уже обратила ваше внимание на то, что мета тег можно выставлять каждой отдельной странице, так же значительное преимущество нам могут дать разные команды index/noindex и follow/nofollow, которые можно применять в мета теге, и при определенных обстоятельствах все это является большим преимуществом перед файлом.

[yandex]

Ситуация 1. Вы публикуете неуникальный контент. Не обязательно это должен быть копипаст (ворованный контент), это могут быть какие-то официальные документы, законодательные акты, статьи кодексов, т.е. любые материалы, которые создадут на вашем сайте большое количество неуникального контента, при этом страницы с неуникальным контентом не имеют отдельного каталога, а размещаются в вперемешку с основным контентом. Такие страницы вы можете запретить к индексации, как полностью, указав мета тег

Такие страницы вы можете запретить к индексации, как полностью, указав мета тег

<meta name=»robots» content=»none»/>

так и частично, запретив индексировать только контент, но разрешив индексировать ссылки.

<meta name=»robots» content=»noindex, follow»/>

или просто

<meta name=»robots» content=»noindex»/>