Что такое robots.txt и какие инструменты для его проверки существуют?

Содержание

- Что такое Robots.txt и зачем он нужен?

- Из чего же, из чего же сделан robots.txt?

- Не правилами едиными…

- Чем проверить robots.txt?

- Какие ошибки часто возникают при работе с индексным файлом?

- Не так просто как кажется

Впервые о файле robots.txt (его ещё называют индексным) услышали в 1994 году. За 26 лет его существования изменилось многое, кроме одного – большинство владельцев сайтов до сих пор ничего о нём не знают. Почему стоит познакомиться с robots.txt вашего сайта? Почему так важна его грамотная настройка? Какие ошибки обычно возникают при работе с robots.txt? И как понять, что в файл пора вносить правки? Давайте разбираться.

Robots.txt по праву можно назвать помощником поисковых роботов. Этот файл подсказываем им, какие разделы есть на сайте, какие страницы стоит посмотреть, а на какие заглядывать нет никакой необходимости.

В рамках SEO файл robots.txt тщательно анализируют с помощью инструментов для его проверки. Почему это так важно? Потому что всего одна ошибка в содержимом этого помощника поисковых роботов может стоить вам бюджета продвижения. Заглянем внутрь этого файла и изучим его подробнее.

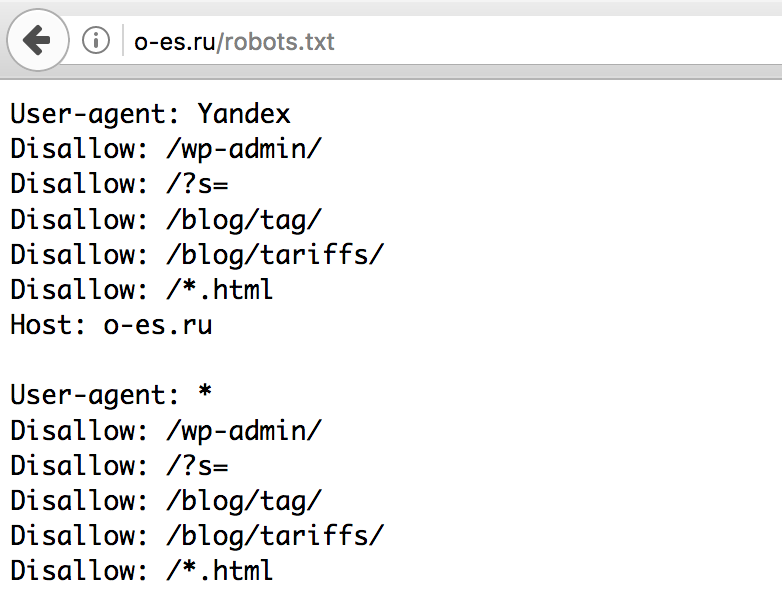

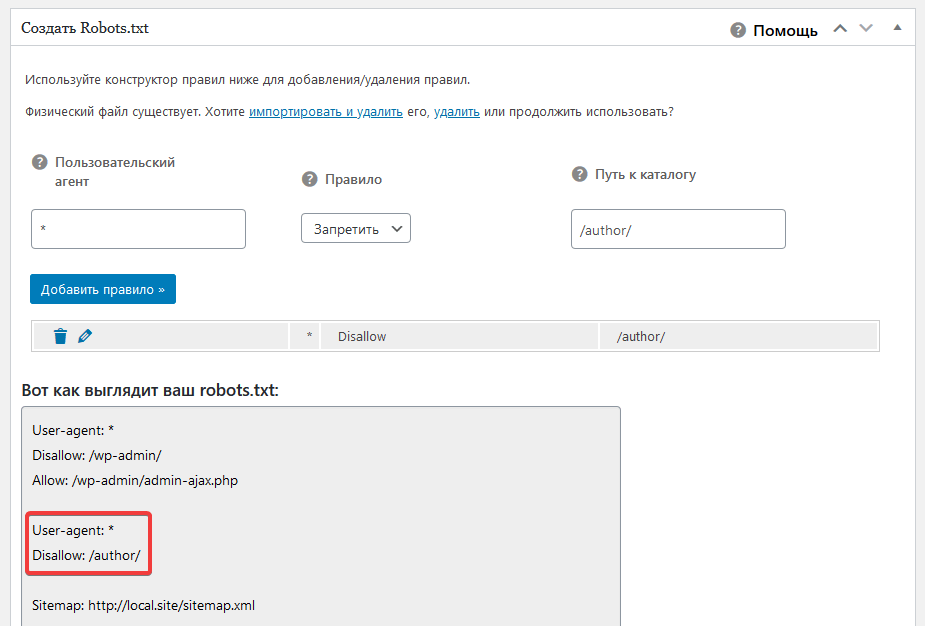

Чтобы изучить индексный файл своего сайта, откройте его. Для этого зайдите на главную страницу своего ресурса, в адресной строке после адреса сайта поставьте слэш, а затем введите название файла, который вам нужен (robots.txt). Загрузите страницу. Перед вами тот самый индексный файл. Первая часть нашего robots.

Ваш robots.txt сильно отличается? Не спешите расстраиваться.

User-agent

Если напротив User-agent в вашем индексном файле прописан Googlebot или Yandex, значит правила задаются только для указанного робота. Звездочка, использованная в примере ниже, показывает, что правила действуют для всех поисковых роботов без исключения. Ошибки в этом правиле можно найти и без инструмента для проверки файла robots.txt.

Disallow

Если на сайте нет страниц, которые нужно закрывать от сканирования, robots.txt может выглядеть вот так:

Если сайт полностью закрыт от индексации, то запись будет отличаться всего на один символ:

Вроде мелочь, а для роботов поисковых систем — совершенно другая картина. Если разработчик закрыл от индексации только часть контента (например, папку, отдельный URL или файл), это отображается напротив правила Disallow.

Allow

Тогда как предыдущее правило запрещает индексирование определенного контента, то это, наоборот, разрешает. Когда его использовать? Например, вы хотите показывать только те страницы, которые располагаются в разделе «Каталог». Все остальные страницы в таком случае закрываются от индексации с помощью правила Disallow.

Host

Это правило используется для показа роботу главного зеркала сайта, которое нужно индексировать. Если сайт работает на HTTPS, протокол обязательно прописывается в индексном файле. Если на HTTP, название протокола можно опустить. Выяснить, верно ли прописано это правило на вашем сайте, можно и не используя инструмент для проверки файла robots.txt. Достаточно найти строку со словом host и сравнить её с образцом.

Sitemap

С помощью этого правила вы показываете роботам поисковых систем, где можно посмотреть все урлы вашего сайта, которые он должен проиндексировать. Чтобы их найти, роботу придётся прогуляться по адресу типа https://site.ua/sitemap.xml. Всё это вписывается в индексный файл. У нас это сделано вот так:

Чтобы их найти, роботу придётся прогуляться по адресу типа https://site.ua/sitemap.xml. Всё это вписывается в индексный файл. У нас это сделано вот так:

Crawl-delay

Правило стоит использовать, если у вашего ресурса слабый сервер. Оно позволяет увеличивать длину промежутка загрузки страниц. Параметр по умолчанию измеряется в секундах.

Clean-param

Это правило призвано бороться с дублированием контента, связанным с динамическими параметрами. Из-за сортировок, разных id сессий и других причин на сайте одна и та же страница может быть доступна по нескольким адресам. Чтобы поисковый робот не расценил такое явление как дублирование, его прописывают в robots.txt. Если страница отвечает по адресам:

www.site.com/catalog/get_phone.ua?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_3&phone_id=1

www.site. com/catalog/get_phone.ua?ref=page_2&phone_id=1,

com/catalog/get_phone.ua?ref=page_2&phone_id=1,

то правило выглядит следующим образом:

Прежде чем познакомиться с инструментами для проверки файла robots.txt рассмотрим символы, применяемыми в нем.

Чаще всего в robots.txt используются следующие символы:

- Звездочка

Необходима для обозначения любой последовательности. Например, с её помощью можно спрятать от робота все файлы с расширением gif, хранящиеся в папке catalog. - Слэш

Ставится для обозначения местонахождения файла в корневом каталоге, а также в тех случаях, когда нужно закрывать от индексации весь сайт. - Знак доллара

Этот символ показывает, где перестает действовать звездочка. В примере на скриншоте мы закрываем от индексации содержимое папки каталог, но при этом урлы, в которых содержится элемент catalog, индексировать разрешено.

- Решётка

Используется значительно реже, чем все остальные символы, потому как нужна только для комментариев. После решётки можно написать любую подсказку, которая поможет в работе вам или веб-мастеру, работающему с сайтом.

В интернете можно найти добрую сотню сервисов, разбирающих по косточкам индексные файлы сайтов. Мы доверяем только тем, которые учитывают все изменения в алгоритмах поисковых систем. А таких сервисов всего 2: Google Webmaster Tools и «Анализ robots.txt» от Яндекса. Покажем, как работать с каждым из них.

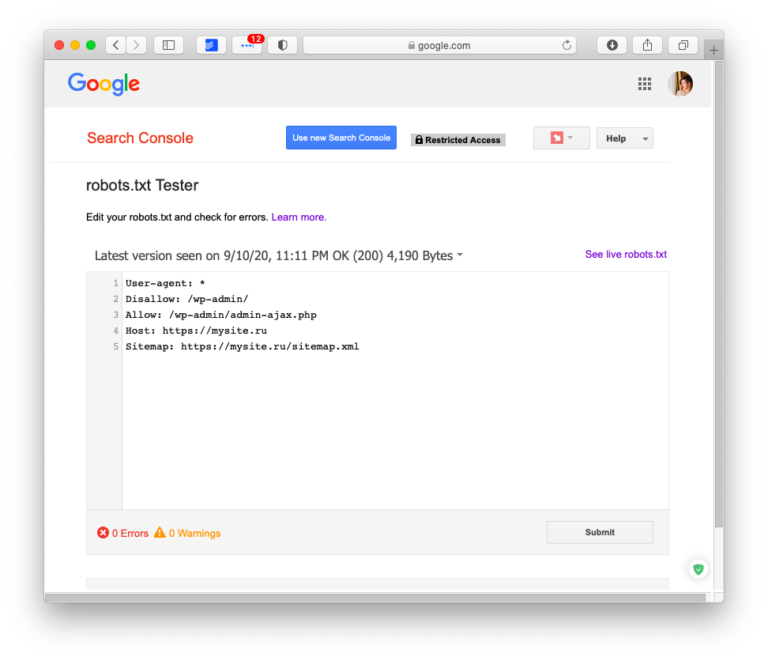

Google Webmaster Tools

Чтобы начать пользоваться этим инструментом, нужно войти в свой Google-аккаунт, а потом открыть эту ссылку.

Если это ваше первое знакомство с Google Webmaster, придётся добавить сайт и подтвердить свои права на него. Сделать это можно несколькими способами. Самый простой из них – закачка файлов.

После подтверждения прав на сайт вы получите полный доступ к инструменту для проверки файла robots.txt. Выберите этот сервис в панели меню, затем укажите, что хотите проанализировать индексный файл своего сайта. И получите результаты проверки. Выглядеть это будет примерно так:

Красным прямоугольником мы выделили строку, на которую вам нужно обратить своё внимание в первую очередь. Здесь показывается, есть ли ошибки в robots.txt. Если инструмент нашёл ошибки, пролистайте содержимое файла с помощью бегунка и найдите значок белый крест в красном круге на полях. В тех строках, где есть такие значки, что-то написано неправильно. К сожалению, Google ещё не научился сразу же говорить, что именно не так, и предлагать исправления. Поэтому с ошибками придётся разбираться самостоятельно. Или обращаться за советом к профессионалам.

Новая версия этого инструмента для проверки файла robots.txt даёт возможность смотреть, открыты ли для индексации новые страницы.

В связке с этим инструментом стоит использовать просмотр сайта глазами Googlebot. Применяя эту функцию, вы сможете проанализировать, понравится ли роботу поисковых систем ваш сайт или нет.

«Анализ robots.txt»

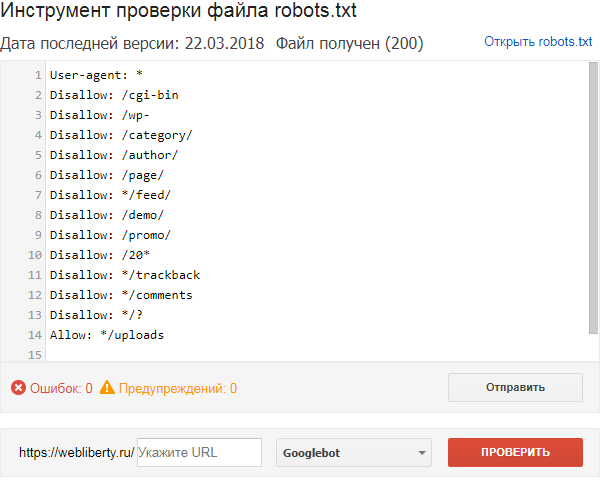

С этим сервисом всё проще, хотя бы потому что он приспособлен для русскоязычного пользователя. Прежде чем приступить к непосредственной работе с инструментом для проверки robots.txt, придется пройти те же этапы, что и с Google Webmaster Tools. Когда получите доступ к сервису, загляните в боковое меню и найдите в нём интересующий нас сервис.

На этой странице вы увидите результаты анализа индексного файла. Если в нём есть ошибки, их количество отобразится в нижней части страницы. В верхней части, где помещается robots.txt, можно будет подробно просмотреть ошибки и тут же исправить их.

Если в нём есть ошибки, их количество отобразится в нижней части страницы. В верхней части, где помещается robots.txt, можно будет подробно просмотреть ошибки и тут же исправить их.

В разделе «Анализ robots.txt» также можно узнать, индексируются ли определённые страницы сайта или нет. Для этого урлы вносят в нижнее окно и отправляют на проверку.

Правильная настройка robots.txt напрямую влияет на то, какие страницы сайта попадут в индекс и будут выводиться в поиске, а какие никогда там не окажутся. Поэтому так важно свести риск возникновения ошибок в работе индексного файла к минимуму. Вот самые частотные:

- В файле прописано правило, закрывающее весь сайт от индексации, например, Disallow со значком слэш;

- Sitemap указан некорректно;

- Применяются только стандартные правила и не прорабатываются каталоги, страницы, технические папки и другие категории.

Как результат, роботы индексируют всё подряд.

Как результат, роботы индексируют всё подряд.

Думали, что разберетесь с robots.txt за 5 минут и тут же внесете в него правки, но что-то пошло не так? Не расстраивайтесь. Специалисты Студии ЯЛ решат вашу проблему. Позвоните нам и мы дадим профессиональный совет. Ну а если вы не хотите разбираться с индексным файлом, поручите это нам. В рамках оптимизации и SEO-продвижения сотрудники Студии ЯЛ приведут в порядок ваш robots.txt и не только.

Другие материалы:

- Настройка цели в Google Analytics для нажатия на кнопку. Пошаговая инструкция

- Таргетированная реклама в Инстаграм (признана экстремистской организацией, деятельность которой запрещена в Российской Федерации): виды и правила настройки

- Тильда: возможности и преимущества, недостатки и нюансы

Правильная настройка файла robots, как проверить и исправить ошибки

Содержание:

- Что такое файл robots.

txt

txt - Что делает robots.txt

- Опасность ошибок в файле robots.txt

- Шесть главных ошибок robots.txt

- Файл находится в другом каталоге

- Неправильно используется символ подстановки

- Использование тега noindex

- Закрыт доступ к скриптам и страницам стилей

- Нет ссылки на карту сайта

- Открыт доступ к страницам, находящимся в разработке

- Как восстановиться после ошибок в файле

- Профилактика robots.txt

Файл robots.txt относится к текстовому типу. По нему поисковые роботы узнают, как именно необходимо сканировать сайт. Алгоритм его работы позволяет дополнительно защитить сервер, так как снижается количество запросов со стороны поисковых систем.

Иногда может возникнуть необходимость заблокировать индексацию всех или некоторых страниц. К такому решению прибегают, например, в случае использования динамических URL и других методов, которые способны привести к генерации большого числа страниц.

В этой статье мы собрали самые распространенные проблемы, возникающие при работе с robots.txt, а также описали их влияние на сайт и его положение в выдаче. Кроме того, мы перечислили и способы устранения ошибок.

Что такое файл robots.txt

Он представляет собой простейший текстовый документ. Найти файл robots.txt можно в корневом каталоге, который является верхним в иерархии. Если же разместить файл в другом каталоге, то поисковые роботы его проигнорируют. Создать robots.txt можно абсолютно в любом текстовом редакторе.

Функции robots.txt зачастую выполняют метатеги, которые можно разместить в коде конкретной страницы.

Что делает robots.txt

Данный файл обладает довольно обширным функционалом. Приведём наиболее важные цели, которые достигаются с его помощью:

- Блокировка индексации определенных страниц. При этом в поисковой выдаче они все еще могут появляться, однако текстового описания у них уже не будет;

- Блокировка медиафайлов, которая позволяет избежать попадания приватного контента в поисковую выдачу;

- Блокировка файлов ресурсов с плохими внешними скриптами.

Если файл ресурсов у конкретной страницы заблокирован, поисковый робот приходит к выводу, что такой страницы не существует. Это оказывает негативное влияние на индексацию сайта в целом. При помощи robots.txt можно предотвратить полное исчезновение страницы из результатов поиска.

Если файл ресурсов у конкретной страницы заблокирован, поисковый робот приходит к выводу, что такой страницы не существует. Это оказывает негативное влияние на индексацию сайта в целом. При помощи robots.txt можно предотвратить полное исчезновение страницы из результатов поиска.

Читайте также:

Dofollow и nofollow ссылки: что это такое и как с ними работать

Опасность ошибок в файле robots.txt

Если при настройке файла robots будут допущены ошибки, определенные последствия, конечно, наступят, однако не станут фатальными. Исправив их, можно быстро восстановить полноценную работу сайта.

Поисковые роботы действуют в соответствии с различными алгоритмами, поэтому незначительные ошибки могут и вовсе не сказаться на их работе. В самом печальном случае робот проигнорирует неправильную директиву. Однако же лучше не допускать ошибок в этом файле.

Шесть главных ошибок robots.txt

Если вы заметили, что ранжирование сайта как-то странно изменилось, необходимо в первую очередь проверить файл robots. Остановимся подробно на каждой из наиболее распространённых ошибок.

Остановимся подробно на каждой из наиболее распространённых ошибок.

Файл находится в другом каталоге

Поисковые роботы видят robots.txt только в том случае, если он располагается в корневом каталоге. Таким образом, домен и название файла в URL должны быть разделены только одним слэшем. Если между ними находится хотя бы одна дополнительная папка, поисковые роботы могут не увидеть файл. В этом случае сайт будет работать так, словно robots не существует.

Чтобы исправить ошибку, достаточно перенести файл в корневой каталог. Для этого нужен доступ к серверу. К сожалению, некоторые системы управления по умолчанию загружают robots.txt в подпапки с медиафайлами и другим аналогичным контентом. В этом случае придется найти способ обойти данную настройку.

Неправильно используется символ подстановки

*пример правильной настройки robots txt

Символом подстановки или символом-джокером называется символ, который используют для замены других. Файл robots. txt поддерживает всего два типа:

txt поддерживает всего два типа:

- Звездочка, которая представляет любые варианты допустимого символа;

- Значок доллара, который означает конец URL и позволяет добавлять к последней части правила. Например, файловое расширение.

Используя эти символы, необходимо проявлять умеренность, так как они способны привести к ограничениям для значительной части сайта. Если вы неправильно используете звездочку (астериск), может произойти блокировка поискового робота. Для устранения этой ошибки необходимо найти соответствующий символ, а затем переместить его или удалить.

Использование тега noindex

Чаще всего такая проблема встречается у сайтов, которые существуют уже долгие годы. В сентябре 2019 года Google перестал выполнять команду noindex в соответствующем файле. Если robots был создан до этого периода или содержит данный метатег, его страницы все равно будут индексироваться.

Для того, чтобы остановить индексацию и устранить ошибку, необходимо использовать альтернативные методы. Например, добавить метатег robots в элемент страницы head.

Например, добавить метатег robots в элемент страницы head.

Закрыт доступ к скриптам и страницам стилей

Зачастую может показаться, что решение заблокировать для поисковых роботов доступ к внутреннему коду Java и CSS является логичным. Однако доступ к таким файлам необходим поисковым системам для того, чтобы правильно сканировать страницы.

Если ресурс отображается в выдаче некорректно, имеет смысл провести проверку файла robots.txt. Если вы обнаружили запрет на доступ поискового робота к внутренним ресурсам, удалите эту строчку. Если вы нуждаетесь в блокировке определенных файлов, используйте исключение, которое позволит разрешить доступ только к нужным файлам.

Нет ссылки на карту сайта

Файл sitemap.xml позволяет поисковым роботам получить полноценную информацию о структуре сайта, а также страницах, которые необходимо считать приоритетными. Именно его поисковые роботы сканируют в первую очередь, поэтому он обязательно должен быть в файле robots. *. Также можно применить строчку Disallow: /

*. Также можно применить строчку Disallow: /

Косая черта сделает сайт невидимым для поисковиков. Строчку можно корректировать в зависимости от эффекта, которого вы хотите добиться.

Как восстановиться после ошибок в файле

Если допущенные ошибки привели к тому, что изменилось отображение сайта в поисковой выдаче, то первое, что вы должны сделать — это предоставить поисковым роботам правильный файл robots.txt, а также удостовериться, что новые правила дают необходимый эффект. Проверить это можно при помощи специальных сервисов, таких как Screaming Frog.

После того, как вы убедитесь, что файл robots работает, как требуется, необходимо отправить запрос на проведение нового сканирования. Это можно сделать при помощи Google Search Console: необходимо добавить обновленную карту сайта и запросить новое сканирование страниц, в отношении которых были замечены нарушения.

Конкретного срока восстановления в выдаче, к сожалению, не существует. Все, что вы можете сделать — это выполнить соответствующие шаги и ждать, когда робот снова проиндексирует ваш сайт.

Профилактика robots.txt

Устранить допущенные ошибки не так сложно, как кажется, однако полезнее будет не допускать их вовсе. Файл robots.txt необходимо редактировать аккуратно и внимательно. Лучше всего привлечь для этой цели опытного специалиста. Кроме того, не лишним будет несколько раз все проверить, а также выслушать альтернативное мнение.

Прежде чем внедрять изменения на реальный сервер, имеет смысл протестировать их в так называемой песочнице. Это специально выделенная среда, в которой можно безопасно использовать любые программы.

Благодаря этому вы сможете избежать ошибок, которые часто допускаются непроизвольно. Если же худшее уже произошло, самое главное — не паниковать. Вместо этого проанализируйте возникшую проблему, оперативно внесите изменения в robots.txt и отправьте запрос на повторное сканирование. Если все было сделано вовремя, возвращение на исходные позиции произойдет в течение нескольких дней.

Robots.txt Tester: используйте бесплатный онлайн-инструмент для SEO

Файл robots. txt представляет собой текстовый файл, размещаемый на веб-сайтах для информирования роботов поисковых систем (таких как Google ), какие страницы в этом домене могут сканироваться . Если на вашем веб-сайте есть файл robots.txt, вы можете выполнить проверку с помощью нашего бесплатного генератора Robots.txt инструмента . Вы можете интегрировать ссылку на XML-карту сайта в файл robots.txt.

txt представляет собой текстовый файл, размещаемый на веб-сайтах для информирования роботов поисковых систем (таких как Google ), какие страницы в этом домене могут сканироваться . Если на вашем веб-сайте есть файл robots.txt, вы можете выполнить проверку с помощью нашего бесплатного генератора Robots.txt инструмента . Вы можете интегрировать ссылку на XML-карту сайта в файл robots.txt.

Прежде чем роботы поисковых систем просканируют ваш сайт, они сначала найдут файл robots.txt сайта. Таким образом, они увидят инструкции, какие страницы сайта можно индексировать, а какие нельзя индексировать консолью поисковой системы.

С помощью этого простого файла вы можете установить параметров сканирования и индексирования для поисковых роботов. А чтобы проверить, настроен ли файл Robots.txt на вашем сайте, вы можете воспользоваться нашими бесплатными и простыми инструментами для тестирования Robots. txt. В этой статье объясняется, как проверить файл с помощью инструмента и почему важно использовать Robots.txt Tester на вашем сайте.

txt. В этой статье объясняется, как проверить файл с помощью инструмента и почему важно использовать Robots.txt Tester на вашем сайте.

Использование средства проверки Robots.txt: пошаговое руководство

Проверка файла robots.txt поможет вам протестировать файл robots.txt в вашем домене или любом другом домене, который вы хотите проанализировать.

Средство проверки robots.txt быстро обнаружит ошибки в настройках файла robots.txt. Наш инструмент проверки очень прост в использовании и может помочь даже неопытному профессионалу или веб-мастеру проверить файл Robots.txt на своем сайте. Вы получите приводит к через несколько секунд.

Шаг 1: введите URL-адрес и начните бесплатную пробную версию

Вы можете подписаться на бесплатную пробную версию без предоставления кредитной карты. Все, что вам нужно сделать, это подтвердить свой адрес электронной почты или использовать свою учетную запись Google. Начать работу легко и быстро.

Шаг 2: Получите результаты тестера Robots.txt

После добавления URL-адреса в наш инструмент мы быстро просканируем сайт. Через несколько секунд вы получите результаты, включающие сведения о странице и данные о директивах robots.txt для конкретной страницы. Аудит также включает в себя обзор всех проблем, присутствующих на каждой веб-странице.

Возможности Robots.txt Checker

После создания пробной учетной записи полный аудит сайта может выявить различные типы проблем и перечислить URL-адреса, по которым эти проблемы возникают. Кроме того, мы предоставляем инструкции и видеоруководства по устранению выявленных проблем. Это бесценная услуга, которая может помочь улучшить производительность и рейтинг вашего сайта.

Раздел «Сканирование и индексирование» поможет вам обнаружить любые проблемы с индексацией на вашем сайте, чтобы их можно было быстро исправить. Вы также будете получать уведомления, если эти проблемы возникнут в будущем с добавлением новых страниц!

Если вы хотите избежать возможных проблем с директивой robot. txt на определенной странице, вы можете использовать наш инструмент проверки на странице в своей учетной записи. Это поможет убедиться, что все настроено правильно, и избежать возможных проблем в будущем.

txt на определенной странице, вы можете использовать наш инструмент проверки на странице в своей учетной записи. Это поможет убедиться, что все настроено правильно, и избежать возможных проблем в будущем.

Найдите все страницы с проблемами индексации прямо сейчас!

Проведите полный аудит, чтобы найти и исправить проблемы с файлом robots.txt, чтобы улучшить техническое SEO.

Случаи, когда требуется средство проверки robots.txt

Проблемы с файлом robots.txt или его отсутствие могут негативно повлиять на ваш рейтинг в поисковых системах. Вы можете потерять рейтинговые очки в SERP . Анализ этого файла и его значения перед сканированием вашего веб-сайта означает, что вы можете избежать проблем с сканированием . Кроме того, вы можете предотвратить добавление контента вашего веб-сайта на страницы исключения из индекса , которые вы не хотите сканировать. Используйте этот файл, чтобы ограничить доступ к определенным страницам вашего сайта. Если есть пустой файл, вы можете получить ошибку Robots.txt not Found Issue в SEO-сканере.

Если есть пустой файл, вы можете получить ошибку Robots.txt not Found Issue в SEO-сканере.

Вы можете создать файл с помощью простого текстового редактора. Во-первых, укажите пользовательский агент для выполнения инструкции и поместите директиву блокировки, например, disallow, noindex. После этого перечислите URL-адреса, которые вы ограничение сканирования . Перед запуском файла убедитесь, что он правильный. Даже опечатка может привести к тому, что Googlebot проигнорирует ваши инструкции по проверке .

Чем могут помочь средства проверки Robots.txtПри создании файла robots.txt необходимо проверить, не содержит ли он ошибок. Есть несколько инструментов, которые помогут вам справиться с этой задачей.

Google Search Console Теперь только в старой версии Google Search Console есть инструмент для тестирования файла robots. Войдите в учетную запись с текущим сайтом, подтвержденным на его платформе, и используйте этот путь, чтобы найти валидатор.

Старая версия Google Search Console > Сканирование > Robots.txt Tester

Этот тест robot.txt позволяет:

- сразу обнаружить все ваши ошибки и возможные проблемы;

- проверьте наличие ошибок и внесите необходимые исправления прямо здесь, чтобы установить новый файл на свой сайт без дополнительных проверок;

- проверьте, правильно ли вы закрыли страницы, которые не хотите сканировать, и правильно ли открыли те, которые должны пройти индексацию.

Войдите в учетную запись веб-мастера Яндекса, подтвердив текущий сайт на своей платформе, и используйте этот путь, чтобы найти инструмент.

Яндекс Вебмастер > Инструменты > Анализ robots.txt

Этот тестер предоставляет практически такие же возможности для проверки, как и описанный выше. Разница в том, что:

- здесь не нужно авторизоваться и подтверждать права на сайт, который предлагает сразу проверить ваш файл robots.

txt;

txt; - нет необходимости вставлять постранично: весь список страниц можно проверить за один сеанс;

- вы можете убедиться, что Яндекс правильно идентифицировал ваши инструкции.

Это решение для массовой проверки, если вам нужно просканировать веб-сайт. Наш краулер помогает проверить весь сайт и определить, какие URL-адреса запрещены в robots.txt, а какие закрыты от индексации с помощью метатега noindex.

Обратите внимание: для обнаружения запрещенных страниц необходимо просканировать веб-сайт с настройкой «игнорировать robots.txt» .

Обнаружьте и проанализируйте не только файл robots.txt, но и другие проблемы SEO на вашем сайте!

Проведите полный аудит, чтобы выявить и устранить проблемы с вашим сайтом, чтобы улучшить результаты поисковой выдачи.

Часто задаваемые вопросы

Зачем мне проверять файл robots.txt?

Robots. txt показывает поисковым системам, какие URL-адреса на вашем сайте они могут сканировать и индексировать, в основном, чтобы не перегружать ваш сайт запросами. Рекомендуется проверить этот действительный файл, чтобы убедиться, что он работает правильно.

txt показывает поисковым системам, какие URL-адреса на вашем сайте они могут сканировать и индексировать, в основном, чтобы не перегружать ваш сайт запросами. Рекомендуется проверить этот действительный файл, чтобы убедиться, что он работает правильно.

Является ли нарушение файла Robot’s.txt незаконным?

На сегодняшний день нет закона о том, что нужно строго следовать инструкциям в файле. Это не обязывающий договор между поисковыми системами и сайтами .

Что делает robots.txt?

Robots.txt показывает агентам поисковых систем, какие страницы вашего сайта могут быть просканированы и проиндексированы, а какие страницы были исключены из просмотр . Разрешение поисковым системам сканировать и индексировать некоторые страницы вашего сайта — это возможность контролировать конфиденциальность некоторых страниц. Это необходимо для поисковой оптимизации вашего сайта .

Безопасен ли Robot.

txt?

txt?Файл robots.txt не поставит под угрозу безопасность вашего сайта, поэтому его правильное использование может стать отличным способом защитить конфиденциальных страниц вашего сайта. Тем не менее, не ожидайте, что все сканеры поисковых систем будут следовать инструкциям в этом файле. Злоумышленники смогут отключить инструкции и сканирование запрещенных страниц.

Интеллектуальные программные роботы — автономные и обслуживаемые роботы

Программные роботы UiPath интеллектуальны, надежны, гибки и готовы выполнять огромное количество утомительных задач. Они также просты в создании и управлении, поэтому вы можете запустить целую рабочую силу роботов, чтобы быстро обеспечить эффективность, более высокую производительность и высокую рентабельность инвестиций.

Познакомьтесь с роботами, которые могут автоматизировать практически все

UiPath Роботы взаимодействуют с экранами, системами и данными так же, как люди. И они делают это с людьми тоже! Честно говоря, впечатляет, как много они могут выдержать. Для любой технологии — старой и новой — они являются идеальным связующим звеном благодаря отличной автоматизации пользовательского интерфейса и мощной интеграции API. И мы упомянули все их навыки ИИ?

Для любой технологии — старой и новой — они являются идеальным связующим звеном благодаря отличной автоматизации пользовательского интерфейса и мощной интеграции API. И мы упомянули все их навыки ИИ?

Выберите своих роботов. От SaaS до собственного хостинга, все управляется из Automation Cloud™

Automation Cloud™ Robot

Нет инфраструктуры? Без проблем! Быстро создавайте и запускайте роботов в любое время. длительные рабочие процессы. Эти боты неустанно работают в бэкенде и согласовывают с вами направление.

Собственный хост, локально или в общедоступном облаке

Управление из Automation Cloud Orchestrator

Attended Robot

Цифровой помощник на каждом рабочем столе, выполняющий множество повседневных задач приложения и системы, которые запутывают нас сегодня.

Установка на рабочий стол

Управление из Automation Cloud Orchestrator

Тестовый робот

Тестируйте роботов и приложения легко и полностью для обеспечения надежной работы.

Собственный хост, локально или в общедоступном облаке

Управление с помощью Automation Cloud Orchestrator в рамках UiPath Test Suite

С какой бы технологией вы ни работали, наши роботы тоже

Программные роботы UiPath отлично взаимодействуют с несколькими платформами. Они очень удобны для корпоративных приложений, таких как SAP, Salesforce, Oracle, Microsoft, Google и ServiceNow, и это лишь некоторые из них. Посмотреть все совместимые технологииДобавление навыков ИИ для автоматизации когнитивных процессов

Научите программных роботов новым навыкам ИИ: чтению документов, распознаванию динамических интерфейсов и пониманию разговоров для принятия сложных решений. Используйте готовые модели ИИ от UiPath, сообщества открытого исходного кода или наших более чем 100 партнеров — или интегрируйте свои собственные модели ИИ.

Узнайте, что вы можете автоматизировать, внедрив ИИ в RPAУправляйте своими роботами из любого места

Отслеживайте программных роботов, управляйте их производительностью в масштабе и получайте мобильные оповещения в Orchestrator — мгновенно как SaaS из облака автоматизации UiPath или на в помещении, на виртуальных машинах, в частном или общедоступном облаке, виртуальной машине Linux или в виде единого облачного контейнерного пакета через UiPath Automation Suite.

Веб-семинар

Участие в саммите по автоматизации UiPath

Узнайте, как люди и роботы, работая вместе, влияют на бизнес в больших масштабах записьПросмотреть все вебинары

«У нас в компании много талантов, и роботы позволяют нам выявить и использовать их, освобождая нас от тех задач, которые, как мы все знаем, должны быть выполнены, но не удовлетворяют нас ни лично, ни профессионально.»

Хавьер Кастельянос

Руководитель завода по производству роботов, Orange

См. историю клиента«Роботы упрощают использование систем, поэтому агенты могут сосредоточиться на клиентах, а не на технологиях. Они также сокращают время обучения. Поскольку роботы также фиксируют действия после звонков, персонал может быть доступен для других клиентов».

Фиби Вудс

Бизнес-аналитик, RMG

См. историю клиента«Быстро стало очевидно, что RPA предлагает нам решение, которое может обеспечить автоматизацию со скоростью, позволяющей нашему бизнесу трансформироваться по мере необходимости.

Другой технологии, которая могла бы это сделать, просто не было».

Другой технологии, которая могла бы это сделать, просто не было».Роберт Гиори

Финансовый директор (CFO), Atea

См. историю клиента«У нас в компании много талантов, и роботы позволяют нам выявить и использовать их, освобождая нас от этих задач. которые, как мы все знаем, должны быть сделаны, но не удовлетворяют нас ни лично, ни профессионально».

Хавьер Кастелланос

Руководитель завода по производству роботов, Orange

См. историю клиента«Роботы упрощают использование систем, поэтому агенты могут сосредоточиться на клиентах, а не на технологиях. Они также сокращают время обучения. Поскольку роботы также фиксируют действия после звонков, персонал может быть доступен для других клиентов».

Фиби Вудс

Бизнес-аналитик, RMG

См. историю клиента«Быстро стало очевидно, что RPA предлагает нам решение, которое может обеспечить автоматизацию со скоростью, позволяющей нашему бизнесу переходить по мере необходимости. Другой технологии, которая могла бы это сделать, просто не было».

Как результат, роботы индексируют всё подряд.

Как результат, роботы индексируют всё подряд. txt

txt Если файл ресурсов у конкретной страницы заблокирован, поисковый робот приходит к выводу, что такой страницы не существует. Это оказывает негативное влияние на индексацию сайта в целом. При помощи robots.txt можно предотвратить полное исчезновение страницы из результатов поиска.

Если файл ресурсов у конкретной страницы заблокирован, поисковый робот приходит к выводу, что такой страницы не существует. Это оказывает негативное влияние на индексацию сайта в целом. При помощи robots.txt можно предотвратить полное исчезновение страницы из результатов поиска. txt;

txt; Другой технологии, которая могла бы это сделать, просто не было».

Другой технологии, которая могла бы это сделать, просто не было».