Сайт попал под фильтры Гугла. Что делать?

Иногда бывает, что на сайт внезапно перестает идти трафик из гугла. Вероятнее всего, ресурс попал под один из фильтров, про который пойдет речь в этой статье. Я расскажу, как проверить сайт на фильтры гугла, а также, как вывести его из-под фильтров.

Почему Google накладывает фильтры?

Любые фильтры и ужесточения правил — это реакция на работу сеошников. Когда они начинают особо ожесточенно бить в один из факторов ранжирования (например, во вхождение ключей в текст или в покупные ссылки), то поисковой системе приходится подстраивать свои алгоритмы, чтобы влияние этих факторов было уменьшено или исключено вовсе.

Вот типичная картина трафика сайта, попавшего под фильтр:

Данные аналитики сайта, попавшего под фильтры

Данные аналитики сайта, попавшего под фильтры

В SEO тусовке распространено мнение, что использованием черных методов сеошники помогают поиску развиваться. Отчасти это правда!

Итак, какие фильтры накладывает Google и за что?

Sandbox (песочница)

Данный фильтр используется гуглом для молодых сайтов (до 1 года). Он направлен на то, чтобы оценить качество развития ресурса за это время, не будут ли использованы какие-либо «незаконные методы». Часто в песочницу попадают сайты и за агрессивные ссылочные стратегии.

Как проявляется песочница

- Сайт полностью отсутствует в индексе

Как лечить

- Наполнять сайт новым и уникальным контентом

- Проводить внутреннюю оптимизацию

- Привлекать трафик не только с Google (активно работать с соцсетями, закупать контекстную рекламу)

- Можно пытаться загонять страницы в индекс через Google Webmaster Tools

Domain Name Age (Возраст домена)

Практически аналогичен песочнице. Суть фильтра — пока сайт не набрал определенного уровня возрастного доверия, его продвинуть очень сложно. Разница в том, что в данном фильтре, в отличие от «песочницы», страницы находятся в индексе, просто трафика с гугла идет очень мало.

Как проявляется

- Страницы есть в индексе Google, но трафика по ним практически нет

Как лечить

- Запуск сайта на домене «с историей». Вариант очень сомнительный, т.к. на предыдущем домене могли быть санкции. У меня в практике были такие случаи, на выведение домена из-под санкций ушло 3 месяца.

- Постоянное развитие сайта. Это нужно делать в любых ситуациях

- Привлечение трафика из других источников.

Too many links at once (много ссылок сразу)

Данный фильтр накладывается за бурный рост внешних ссылок (ссылочный взрыв). Есть интересная история про этот фильтр. Одно время можно было сильно провалить конкурента в поиске, организовав ему ссылочный взрыв (это можно было сделать относительно дешево). Теперь данная лазейка закрыта.

Как проявляется

- Традиционно: резким падением трафика из Google, обнулением всех внешних ссылок

Как лечить

- Перестать закупать ссылки!

- Текущую ссылочную массу не трогать.

- Подождать от 1 до 5 месяцев

Bombing (Бомбежка)

Этот фильтр накладывается гуглом не на весь сайт сразу (это не доменный фильтр), а только на те страницы, которые алгоритм посчитал спамными. Важный фактор — закупка ссылок с одинаковым анкором на одну и ту же страницу.

Как проявляется Bombing

- Некоторые страницы выпадают из индекса

- Резко сокращается трафик из Гугла

Как лечить

- Удалить все такие ссылки, либо разбавить анкор лист

- Подождать от 2 месяцев до полутора лет 🙂

Broken Links (Битые ссылки)

Данный фильтр накладывается за возросшее количество ссылок, отдающих 404 код ошибки. Фильтр не представляет особой опасности и снимается относительно легко

Как проявляется

- В Google Webmaster Tools появляется сообщение о возросшем количестве ошибок

Как лечить

- Найти и устранить все битые ссылки

SEO-Links

Фильтр за «взаимный обмен ссылками». Раньше многие использовали способ прямого обмена ссылками для продвижения своих сайтов. Теперь злоупотребление этим строго карается гуглом

Как проявляется фильтр

- Падение трафика из гугла

Как устранить

- Сократить число исходящих ссылок со своего сайта

CO-citation linking filter (социтирование)

Google строго следит за тематикой площадок. Если на ваш сайт о юридических услугах начинают ссылаться медицинские сайты — то есть вероятность понижения вашего ресурса в поиске и даже присвоения ему другой тематики.

Как проявляется

- Существенная просадка позиций по тематикообразующим запросам

- Снижение трафика по таким запросам

Как лечить

- Срочно снять все нетематические ссылки

- Если это сделать невозможно, то отклонить их через Disavow Links в Google Webmaster Tools

Фильтр за медленную загрузку

Если ваш сайт медленно загружается, то есть высокая вероятность понижения сайта в выдаче Google.

Как выявить

- Сайт стал необоснованно проседать в выдаче

Как лечить

- Проверить сайт на Page Speed Insights

- Оптимизировать скорость загрузки сайта

Omitted results (опущенные результаты)

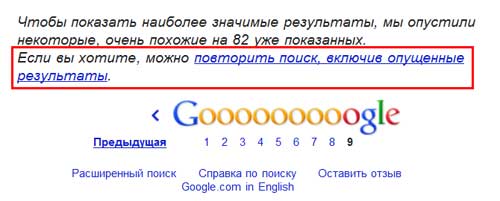

Данный фильтр чаще всего налагается за дубли страниц на сайте. Поэтому нужно следить за сайтом!

Как выявить

- Страницы сайта отсутствуют в основном индексе гугла

- Они могут показаться после нажатия на ссылку «Показать скрытые результаты»

Как лечить

- Устранить дубли страниц

- Уникализировать контент

- Внимательно делать перелинковку

-30 позиций

Жесткий фильтр за использование черного СЕО: клоакинг, дорвеи, скрытый контент на страницах сайта

Как определить

- Весь сайт понижается в выдаче на 30 позиций

Как выйти из-под фильтра

- Устранить факт вышеуказанных причин и связаться с техподдержкой. Рекомендую следующий алгоритм: сначала написать в поддержку, затем устранить проблему и примерно через месяц после устранения написать повторно. Чаще лучше не писать. Это важно!

Over optimization (переоптимизация)

Классический фильтр за излишнее употребление ключевых слов в контенте сайта.

Как обнаружить

- Сайт выпадает из индекса либо пессимизируется

- Сильно падает трафик из гугла

Как выйти из-под фильтра

- Переписать весь контент

- Написать в поддержку спустя 2-3 месяца после устранения проблемы

Фильтр Панда

Это фильтр, который вобрал в себя несколько из вышеперечисленных. Основные нарушения, за которые может быть пессимизирован сайт: переоптимизация, спамные ссылки, продажа ссылок, агрессивная реклама на страницах сайта.

Как обнаружить

- Пессимизация страниц

- Выпадение из индекса

- Резкое падение трафика

Как выйти из-под фильтра Панда

- Удалить все продажные ссылки с сайта

- Переписать контент

- Сделать качественную внутреннюю оптимизацию

- Полезно будет сменить дизайн сайта

Фильтр Google Пингвин

Накладывается также за комплексные нарушения: агрессивную закупку ссылок, за бездумный обмен ссылками, за переспам анкор-листа.

Как обнаружить

- Пессимизация страниц

- Выпадение из индекса

- Резкое падение трафика

Как выйти из-под фильтра Пингвин

- Удалить все ссылки, в том числе покупные

- Подождать примерно 6 месяцев

Часто после попадания сайта под Панду или Пингвин самое разумное решение — разработка нового сайта по всем правилам Google. Качественный сайт — лучшая защита от всех санкций Google!

Вопрос-ответ

В: У меня статейный сайт, статьи — качественный рерайт. Но нет трафика из Google. Почему такое может быть?

О: Вероятно, Гугл расценил ваш сайт, как низкокачественный и наложил фильтр (скорее всего — переоптимизация). Придется решать вопрос с контентом. Это долго и трудно.

В: Многие предлагают выход из-под Панды или Пингвина за месяц. Это реально?

О: Очень сомнительный срок. Скорее всего, вам врут.

Как проверить дроп-домен на фильтры в Google и не облажаться? – maxaffiliate

Автор maxaffiliate На чтение 4 мин. Опубликовано

Просмотров: 3 326

Update июнь 2019 – стал тупо регить мощные дропы и не париться и не проверять фильтры. Если сайт идет – отлично. Не идет – следующий.

Первый метод – сокращалка гугла

Часто советуют метод проверку сайта в сокращалке гугла (goo.gl) – добавляешь урл проверяемого сайта и если сервис выдает ошибку, то сайт забанен. Это верно, но отчасти.

Я проверял множество сайтов, метод не совсем надежен. Мягко говоря не совсем.

Я недавно рискнул и купил на аукционе домен без индекса, он оказался в бане, сокращалка исправно работает. До этого проверял пачку баненных 100% сателлитов – примерно в 80% случаях не показывает проблем в сокращалке.

Я не использую этот метод щас.

Второй метод – не брать сайты без индекса

Сайт может очень долго не работать, но в гугле ИМЕТЬ В ИНДЕКСЕ СТРАНИЦЫ. Это факт. Если вы берете сайт с количеством страниц 0 и у него по ahrefs не было трафика за последние года, то это лотерея, как повезет. Да и кстати тот сайт, что я взял, был с трафиком ранее. 🙁 Но все равно в бане.

Индекс гугла – это уже очень сильный фактор, лучше чем просто сокращалка, но от ручных санкций в панели гугла не защитит никак.

Третий метод – spamzilla.io

Случайно нашел сервис этот и не пожалел – https://www.spamzilla.io/

Он очень круто смотрит сайт, что на нем было. Есть функция поиска по стоп словам. Если была фарма в анкорах ссылок по ahrefs, он это видит. Если был китайский сайт – тоже. Очень удобно смотреть. Можно свои стоп-слова добавлять для проверки или наоборот удалять, если он неверно помечает. У меня такое было, часть слов удалил.

Здесь нашел слово replica в анкоре. Это не значит, что сайт прямо совсем плох, но ТО, ЧТО ЕГО ПЫТАЛИСЬ ОТЖАТЬ ПО ПОЛНОЙ – это правда. Он не пошел в поиске и на него забили.

Вот сайт без проблем обнаружился при проверке, его можно смотреть детальнее.

По вебархиву видно, что на нем вообще было.

Такой удобной функции я не видел нигде. Видно, что на сайте особо ничего не менялось. Тематика была та же самая.

По анкорам также все чисто.

Если ставились редиректы, то оно бы это показало. Такой функции я тоже ни у кого не видел. Редиректы = Сеошник поработал над сайтом.

Вот например у сайта резко выросло число страниц и Спамзилла накинул ему баллов за спамность

А вот чистый сайт вообще, на нем мало что менялось

Update июнь 2019 – сейчас и Spamzilla перестал пользоваться. слишком много ложных срабатываний. смотрю все руками.

Четвертый метод – domain com

Ввводите в гугле адрес сайта пробел доменная зона типа вот так just4pooches com и смотрите, есть ли сайт на первом месте. Если есть – это хороший знак. Но опять-таки метод не 100% рабочий. У меня есть сайт с трафиком который так не искался и был в заднице, но сейчас он так ищется и все окей.

Чекайте, проверяйте, но к сожалению на 100% гарантию Вам не даст никто. Просто больше делать и больше ошибаться. Какой-то сайт выходит в топ и мы окупаем все затраты. Главное на начальном этапе не вкладывать много денег в сайт.

Update июнь 2019 – по domain com также больше не проверяю

Вот пост вчерашний из моего телеграм канала

Там же в канале я показываю примеры, насколько быстро стреляют статьи, если сайт имеет доверие гугла (спойлер: 3 месяца и некоторые статьи окупаются)

На этом все, всем трафа и как можно больше дохода с сайтов!

UPDATE: появились вопросы

Сейчас я специально заморочился и взял 308 свободных доменов com и проверил их на индексацию.

Результат: 207 доменов в индексе – 70% от общей массы. Вполне можно найти хорошие варианты из оставшихся.

Мнение: “если домен заэкспайрился, то он долго не будет в индексе, даже хороший” – это не совсем верно.

Подпишись: Мой Телеграм канал, Инстаграм

Простой способ проверить фильтры google | Ua-Blogger

До того, как Вы начнете продвигать свой сайт, не помешает узнать о фильтрах google. Поисковые системы создают их с целью отсортировать некачественные сайты. Из-за фильтров ваш сайт рискует существенно снизить позиции при выдаче в поисковых запросах.

Чтобы не дать своему сайту затеряться среди множества других, Вам следует проверить фильтры google. В поисковике существует немало таких фильтров. Принцип их работы очень простой, а значит, вы без труда сможете обойти их и повысить популярность сайта. Перед тем, как проверить фильтры google, ознакомьтесь с основными их разновидностями..

Песочница

В этот фильтр попадают только что созданные страницы. В «песочнице» они могут находиться несколько месяцев или даже лет. Новые страницы не попадают в выдачу по низкочастотным запросам.

Bombing

Применим к сайтам, использующим неуникальный анкор – текст ссылки, расположенный между тегами. Старайтесь не прописывать уже существующий анкор. Тогда Вы не попадете под фильтр.

Дополнительные результаты

Если поисковик посчитал информацию станицы недостаточно полезной для юзеров, он отправляет сайт в этот фильтр. Тогда при поиске страницы будут выводиться только после полезных ссылок. Разместите на странице несколько входящих ссылок. После этого фильтр уже не страшен.

Возраст домена

Чем старше сайт, тем высшую позицию он будет иметь при поисковом запросе.

Фильтр – 30

Если на сайте используются коды дорвея или редиректа, его позиция при выдаче в google снижается фильтром на 30 пунктов. Чтобы не попасть в этот фильтр, удалите кодыдорвея и редиректа.

Дублирующий контент

Если сайт пользуется информацией с других ресурсов, google помещает его в фильтр. Это существенно снижает позиции сайта при выдаче. Сделайте наполнение сайта уникальным, и Вы сможете избежать попадания в фильтр контента.

Много ссылок сразу

Аккуратно закупайте ссылки, которые собираетесь размещать на сайте. Активное и беспорядочное размещение ссылок повышает риск быть «забаненным» поисковой системой.

Чрезмерная оптимизация

В этот фильтр попадают страницы, в которых чересчур много ключевых слов. Поэтому будьте умеренны в своем желании оптимизировать сайт.

Время загрузки страниц

Слишком тяжелые страницы долго загружаются, и это тоже влияет на позицию в выдаче. Поэтому разбивайте страницы на несколько менее тяжелых.

Если трафик вашего сайта резко снизился, или уменьшилось число проиндексованных страниц, нужно проверить фильтры google. Это поможет исправить ошибки и вернуть рейтинг сайта на высокие позиции.

В этот день я написал…

Почему ваш сайт может потерять свое место в ТОПе? Обзор фильтров Google

В прошлом мастер-классе я рассмотрел фильтры поисковой системы Яндекс. Сегодня я расскажу, за что Google может пессимизировать ваш сайт в выдаче и какие фильтры используются этим поисковиком. Также я дам советы, как избежать этих фильтров и что делать, если вы все же под них попали.

В целом для сайтов, оптимизированных в первую очередь под ПС Яндекс, актуальны лишь несколько основных фильтров Google. Это объясняется тем, что большинство требований Яндекса к качеству сайта жестче, чем требования Google, и на практике чаще всего сайт пессимизируется именно в Яндексе. При этом в Google позиции могут стабильно расти по мере индексации доработок, текстов и внешних ссылок. Случаев, когда позиции сайтов в Google были бы хуже, чем в Яндексе, значительно меньше.

Поэтому при постоянном развитии ресурса и следовании требованиям Яндекса, большинство фильтров Google не будут страшны вашему сайту.

Прежде чем перейти к основным фильтрам, которые используются Google, я остановлю свое внимание на одном алгоритме, который был введен весной 2012 года и заставил понервничать многих владельцев сайтов и веб-мастеров — “Пингвин”. Тогда именно из-за действий этого алгоритма сайты стали терять свои позиции и требовалось приложить большие усилия, чтобы вернуть их в ТОП.

Алгоритм “Пингвин”

Об алгоритме:

Новый алгоритм “Пингвин”, запущенный Google 25 апреля 2012 года, направлен на борьбу со спамом в различных его проявлениях и учитывает множество внешних и внутренних факторов ранжирования сайта. Вот анонс разработчиков Google за несколько дней до релиза “Пингвина”:

“В ближайшие дни мы запускаем важное изменение алгоритмов, направленных на Webspam. Изменения снизят рейтинги сайтов, которые, как мы считаем, нарушают требования Google к качеству сайтов”.

Как не попасть под санкции “Пингвина”:

Чтобы избежать действий данного фильтра Google, вам необходимо:

- В первую очередь следует проверить технические ошибки (“битые” внутренние ссылки, неправильные редиректы, долгое время загрузки страниц) и страницы сайта на предмет “спамных” текстов.

Фильтры и стратегии в сервисе Rookee уже актуализированы для продвижения сайтов в ПС Google в условиях алгоритма “Пингвин”. Вам доступна функция подключения white-листа (в настройках стратегии продвижения). Подключив white-лист, вы сможете застраховать свой сайт от попадания под пессимизацию алгоритма “Пингвин”.

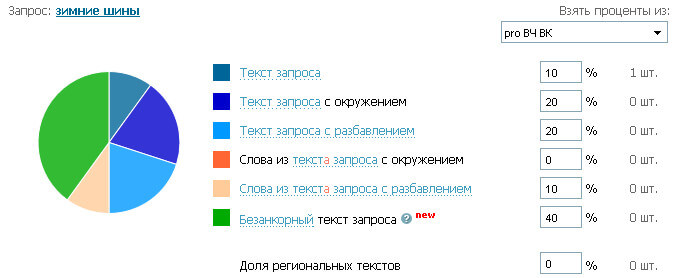

- Проверить качество анкоров внешних ссылок. Если большинство из них — только точные вхождения, необходимо сменить такие анкоры на более естественные, разбавить их неточными вхождениями и альтернативными текстами. Такая возможность реализована в системе Rookee с помощью редактора текстов ссылок:

Помимо данного алгоритма, независимо друг от друга существуют и используются несколько фильтров Google, связанных с определенными характеристиками сайтов. Ниже я рассмотрю наиболее известные из них.

Фильтр Google “Песочница” (Sand Box)

Признаки наложения:

Молодой сайт, не достигший определенного возраста, не попадет в индекс от 3 месяцев до года. Подразумевается, что занимать высокие позиции по конкурентным запросам должны относительно старые качественные сайты.

За что ваш сайт мог попасть под фильтр:

Сайт только недавно создан.

О фильтре:

Так как новые сайты, скорее всего, не смогут ранжироваться лучше старых авторитетных сайтов по конкурентным запросам, они помещаются в так называемую “песочницу”. Цель ПС — понять, насколько сайт будет полезен пользователям в основной выдаче по конкурентным запросам: будет ли ресурс развиваться, наполняться контентом и т.п., и сможет ли в дальнейшем составить конкуренцию старым авторитетным сайтам.

Как вывести сайт из-под фильтра:

Чтобы как можно скорее выйти из-под фильтра, рекомендуется постоянно развивать сайт — обновлять контент, добавлять новые материалы, создавать внутреннюю перелинковку. Ссылочную массу следует наращивать планомерно, без резких скачков. Необходимо также, чтобы качество площадок, с которых устанавливаются ссылки, удовлетворяло требованиям последних изменений алгоритмов Google.

Фильтр Google «Дополнительные результаты» (Supplementary Results)

Признаки наложения:

Страница не показывается в результатах поиска по запросу. Она будет показываться, только если будет недостаточно страниц, на которые не наложен фильтр. Обычно такое происходит только для низкочастотных запросов.

За что ваш сайт мог попасть под фильтр:

Ваш сайт мог попасть под этот фильтр, если на нем есть страницы, которые дублируют друг друга.

О фильтре:

Часто многие страницы сайтов, хоть и дают ответ на запрос, но или он неполный, или страница, на которой есть ответ, считается некачественной. Причинами, по которым страница считается некачественной, могут быть: некачественная или “спамная” внутренняя перелинковка, использование дублированного контента с других сайтов и т.д. Такие страницы не показываются в основных результатах поиска, а помещаются в “Дополнительные результаты”.

Как не попасть под фильтр:

Чтобы страницы сайта всегда показывались в основной выдаче, необходимо соблюдать все рекомендации поисковой системы, размещать уникальный и полезный для пользователей контент, ставить ссылки с авторитетных источников.

Как вывести сайт из-под фильтра:

Чтобы страница показывалась по всем запросам в основных результатах поиска, следует поставить на нее несколько ссылок с качественных площадок, уникализировать контент или добавить больше информации. Также следует обратить внимание на технические ошибки на сайте и все исправить.

Другие фильтры Google

Кроме вышеперечисленных, часто встречающихся, в кругах оптимизаторов можно услышать и о других фильтрах Google:

- “Возраст домена” (Domain name Age). Этот фильтр Google накладывается на сайт, доменное имя которого зарегистрировано менее полугода назад. Так как такие сайты имеют меньший уровень доверия, чем старые, они медленнее индексируются. Чтобы сайт начал хорошо индексироваться, необходимо постоянно развивать его, тогда ПС увидит, что сайт создается для людей, и будет лучше его индексировать.

- “Бомбежка” (Bombing). Этот фильтр Google накладывается за большое количество ссылок с одинаковыми анкорами. Действие таких ссылок не учитывается в ранжировании сайта, и, как следствие, не виден рост позиций. Чтобы ссылки начали приносить результат, необходимо разбавить ссылочную массу уникальными текстами.

- “Битые ссылки” (Broken Links). Накладывается на сайт, имеющий большое количество внутренних ссылок, ведущих на несуществующие страницы (отдающие 404 ошибку). Такой сайт теряет позиции в выдаче. Чтобы выйти из-под фильтра, необходимо исправить все подобные ссылки на сайте таким образом, чтобы они вели на существующие страницы.

- “Много ссылок сразу” (Too Many Links at once). Если за короткое время на сайт установлено слишком много ссылок, они перестают влиять на ранжирование сайта. Чтобы не попасть под этот фильтр Google, рекомендуется планомерная закупка ссылок в ограниченном количестве. Особенно это актуально для молодых сайтов.

- “Линкопомойка” (Links). Проверяются страницы сайта, имеющие большое количество исходящих нетематичных ссылок. Кроме этого, могут ухудшиться позиции самого сайта-донора и начать выпадать из индекса страницы. Рекомендуется удалить страницы, количество внешних ссылок на которых больше 5.

- “Фильтр по времени загрузки” (Page Load Time). Страницы, которые загружаются очень долго, исключаются из результатов выдачи. Чтобы выйти из-под данного фильтра Google, необходимо проверить технические параметры страниц (это можно сделать с помощью сервиса Rooletka) и исправить возможные ошибки.

- “Минус тридцать” (- 30). Этот фильтр понижает позиции сайта по большинству запросов примерно на 30 пунктов. Накладывается за использование “черных” методов продвижения — дорвеи, редиректы через JavaScript, клоакинг (предоставление пользователю и ПС разной информации) и т.п. Чтобы вернуть позиции, необходимо устранить причины наложения фильтра.

- “Дублирующийся контент” (Dublicate Content). Позиции сайта с неуникальным контентом искусственно понижаются в результатах поиска. Чтобы избежать пессимизации, необходимо следить за уникальностью контента и переписывать его в случае ухудшения позиций.

- “Чрезмерная оптимизация” (Over Optimization). Если текст на страницах сайта перенасыщен ключевыми словами, такие страницы значительно теряют позиции или полностью исключаются из выдачи. Чтобы не попасть под фильтр, рекомендуется придерживаться плотности каждого ключа в тексте (это отношение ключевого слова или ключевых фраз к общему количеству слов на странице) не более 5-7%.

Заключение

Чтобы избавиться от влияния большинства фильтров Google и обезопасить сайт от их наложения, достаточно следовать нескольким простым советам:

1. Постоянно наполнять сайт уникальным контентом.

2. Обновлять контент как можно чаще. Самый лучший вариант — добавлять информацию каждый день.

3. Не использовать “черные” методы оптимизации.

4. Следить за техническими аспектами работоспособности сайта.

5. Следовать рекомендациям Google по созданию и развитию сайтов.

Если после прочтения мастер-класса у вас возникли какие-либо вопросы, буду рад на них ответить!