Дубли страниц сайта — поиск и устранение дубликатов страниц

Алексей Думчев20 Октября 2014 г, 15:05

1344

Чем опасны дубли страниц

Во всех поисковых системах дублированные страниц негативно влияют на продвижение, так как поисковики видят несколько полностью релевантных страниц для одного и того же запроса, и в результаты органической выдачи будут добавляться постоянно разные страницы. Известно, что из-за дубликатов позиции проседают на 10-30 пунктов буквально за 2-3 недели. Чтобы избежать этого, советуем хотя бы 1 раз в месяц проверять контент и мета-теги. Как найти дубли страниц сайта — читайте в этой статье.

Поиск дубликатов страниц

1. Фразы в кавычках

Простой и доступный способ найти дубли страниц в Яндексе, хотя далеко не самый эффективный.

— выделяем 5-7 слов без знаков препинаний и заглавных букв;;

— включаем расширенный поиск по сайту;

— ставим весь текст в кавычки и копируем в адресную строку Яндекса.

В результатах выдачи получаем страницы, где есть точное вхождение данной фразы. Если есть 2 или более страниц — верный сигнал того, что у нас есть дублированный контент.

2. Сервер для проверки уникальности текста

На наш взгляд, наиболее эффективный способ поиска дублированного контента. Копируем текст и заливаем его на проверку уникальности в любой автоматический сервер. На выходе имеем полную картину о дубликатах.

— какие именно куски текста имеют дубликаты;

— адреса одинаковых страниц;

Чтобы не попасть под различные фильтры поисковых систем, делаем такую проверку для продвигаемых страниц ежемесячно. Для небольшого сайта поиск дубликатов таким образом занимает не много времени, но позволяет избежать неприятностей.

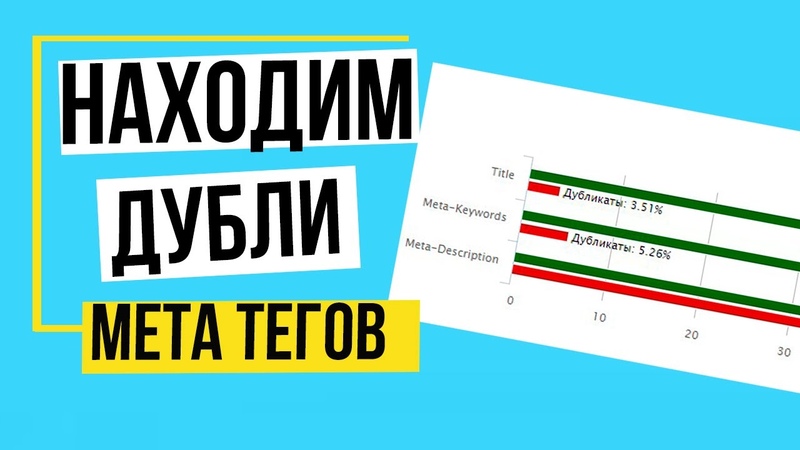

3. Программы-пауки

Бесплатные программы-пауки, которые определяют на каждой странице (даже те, которые не в индексе) мета-теги и теги h2.Вбиваем УРЛ сайта, и программа начинает парсить данные.

Проверяем глазами – на одинаковые значения и устраняем ошибки. Этот способ хорош тем, что позволяет найти не только дублированный контент, но и одинаковые мета-теги. А как говорилось в предыдущих статьях, за идентичные мета-теги вырастает вероятность наложения фильтра, особенно это касается Google.

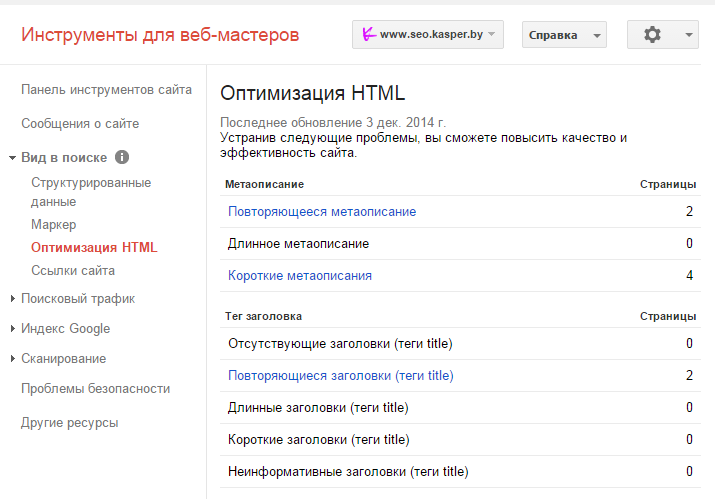

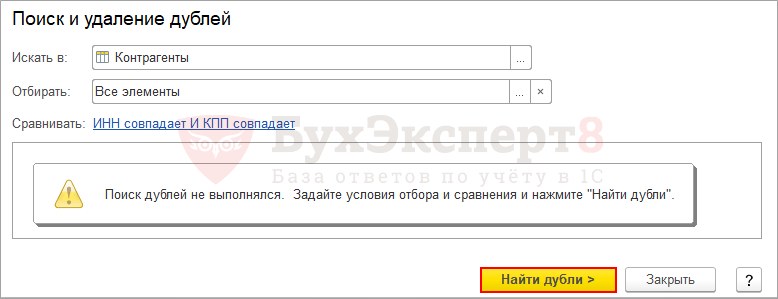

4. Гугл Вебмастер: оптимизация HTML

Полезный инструмент для поиска дублей находится в панели Гугл-вебмастер. Заходим в панель для веб-мастеров Google и переходим в раздел – “Вид в поиске”, там выбираем вкладку – “Оптимизация HTML”. Гугл сообщает нам о дубликатах мета-тегов и предоставляет рекомендации по их устранению.

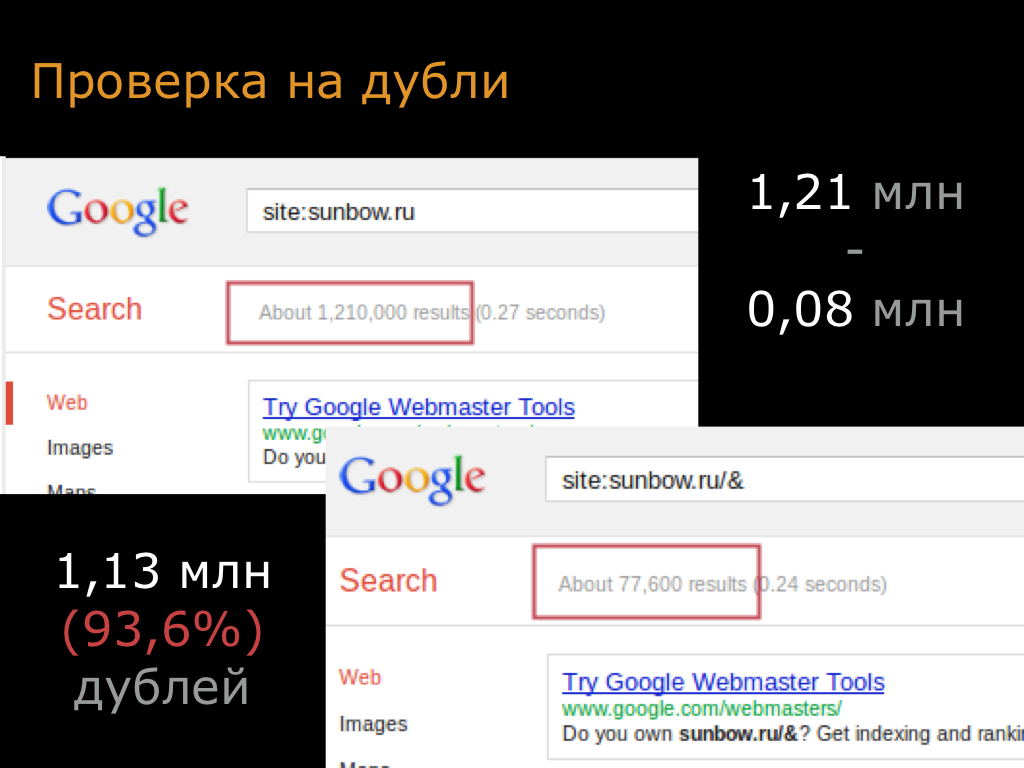

5. Ручная проверка выдачи

Длительный и затруднительный способ, который требует много внимания.

Как убрать дубли страниц

1. Если дублируется контент, то достаточно переписать текст, через некоторое время поисковики проиндексируют сайт, и дублированный контент исчезнет из основного поиска.

2. При наличие одинаковых мета-тегов, находим причину (возможно, происходит автоматическая генерация) и устраняем неполадки.

3. Если дубли страниц образуются вследствие действия фильтров, то закрываем подобные страницы в файле robots.txt. Особенно характерно для интернет-магазинов.

А теперь рассмотрим типичные дубли для наиболее популярных CMS: Joomla и Openstat.

Joomla — дубли страниц

Для любых версий этой CMS наиболее характерны 2 типа дубликатов.

1. Дубли главной страницы

В следствии технических ошибок сайта, на Joomla появляются дубликаты или полу-дубликаты главной страницы. Обязательно проверяем “морду” любым из предложенных способов и устраняем проблемы. Чаще всего необходимо закрыть дубли в файле robots.txt

2. Дубли модуля статей

Для Joomla существуют много модулей для статей, которые дублируют контент новых статей на одну страницу – Статьи. То есть на одной страницы мы получаем сразу все материалы. В более современных версиях такого уже не встретишь.

Чтобы устранить проблему – просто закрываем общую страницу статей от индексации.

Дубли страниц Opencart

Для данного CMS характерно наличие множества фильтров, которые создают дублированный контент. Чтобы решить проблему – закрываем все подобные фильтры от индикации.

Дублированные страницы – характерная проблема абсолютно для всех сайтов без исключения. Используйте вышеприведенные методы для поиска дубликатов, ежемесячно делайте мониторинг сайта и устраняйте проблемы, тогда степень доверия поисковых система к вашему ресурсу останется на высоком уровне.

Используйте вышеприведенные методы для поиска дубликатов, ежемесячно делайте мониторинг сайта и устраняйте проблемы, тогда степень доверия поисковых система к вашему ресурсу останется на высоком уровне.

Оцените статью:

Поделиться:

Дублирование контента: как найти и исправить

Дубли контента на сайте влечет целый ряд проблем. В этой статье мы подробно разберем причины дублей, поговорим об их влияние на сайте, выясним как обнаружить и исправить дублирование контента.

Что такое дублированный контент?

Дубли – это страницы, которые либо полностью совпадают друг с другом, либо частично. И те, и другие негативно влияют на сайт. Далее поговорим какой именно вред несут дубли страниц.

Чем опасен дублированный контент

Ухудшение индексации

При индексации сайта расходуется краулинговый бюджет. При большом количестве дублей краулингового бюджета может не хватать на индексацию важных страниц.

Ухудшение ранжирования

Поисковые системы негативно относятся к дублям и могут пессимизировать страницу с дублированным контентом. При большом количестве дублей на сайте пессимизицая может коснуться сайта целиком.

При большом количестве дублей на сайте пессимизицая может коснуться сайта целиком.

Каннибализация запросов

Каннибализация запросов – это ситуация, когда несколько страниц сайта оптимизированы под одно и тоже. Поисковые системы должны определить какая страница является более релевантной. В такой ситуации в поиске может оказаться именно дубль страницы и, следовательно, вы получите более низкие позиции, чем у посадочной страницы. Причина в том, что дубль в большинстве случаев менее оптимизирован и имеет более низкие показатели поведенческих факторов и ссылочной массы.

Причины появления дублей

Очевидные дубли

Очевидные (явные) дубли – это дубли, которые полностью совпадают по содержанию. Причина появления таких дублей в следующем:

Некорректная настройка кода ответа несуществующих страниц

Несуществующие страницы должна отдавать код ответа 404. В некоторых случаях несуществующие страницы отдают код ответа 200 и тем самым создают большое количество дублей. Подобная проблема часто встречается на сайтах, работающих на CMS Bitrix в информационных разделах. Все несуществующие страницы должна отдавать корректный код ответа – 404. Проверьте все разделы сайта отдельно, т.к. один раздел может отдавать корректный код ответа, а другой нет. Проверить код ответа можно через сервис Яндекс.Вебмастер.

Подобная проблема часто встречается на сайтах, работающих на CMS Bitrix в информационных разделах. Все несуществующие страницы должна отдавать корректный код ответа – 404. Проверьте все разделы сайта отдельно, т.к. один раздел может отдавать корректный код ответа, а другой нет. Проверить код ответа можно через сервис Яндекс.Вебмастер.

Дублирование товаров по категориям

Бывают ситуации, когда один товар выводится в нескольких категориях и в каждой категории имеет отдельный url с вложенностью текущей категории. Это распространенная проблема для интернет-магазинов с большой структурой каталога.

Варианты решения:

- Настроить вывод тега canonical для дублей товара с указанием основного url.

- Настроить вывод товара в дополнительных категориях по одному основному url.

- Сделать для товаров короткий вариант url. В таком случае вложенность товаров будет вида site.ru/product.

Самый неэффективный первый вариант, т. к. поисковые системы часто игнорируют тег canonical и в таком случае не удастся полностью избавиться от дублей. Второй и третий вариант полностью избавят вас от дублей, но есть последствия. Если ваш проект ещё на старте продвижение, то идеальный будет 3 вариант, т.к. вы ничем не рискуете и полностью избавляете ваш проект от дублирования товаров. Но если ваш сайт уже имеет хорошие позиции и трафик на карточки товара, то смена url скажется негативно, поэтому в этом случае стоит выбрать второй вариант.

к. поисковые системы часто игнорируют тег canonical и в таком случае не удастся полностью избавиться от дублей. Второй и третий вариант полностью избавят вас от дублей, но есть последствия. Если ваш проект ещё на старте продвижение, то идеальный будет 3 вариант, т.к. вы ничем не рискуете и полностью избавляете ваш проект от дублирования товаров. Но если ваш сайт уже имеет хорошие позиции и трафик на карточки товара, то смена url скажется негативно, поэтому в этом случае стоит выбрать второй вариант.

Дублирование материалов по нескольким категориям

Дубли, которые появились в результате дублирования материалов по нескольким категориям. Они могли появиться в результате ручной привязки, либо из-за ошибок работы cms. В случае ручной привязки решается аналогично как с карточками товара.

При некорректной работе cms важно исправить это дублирование. Например, такая проблема часто встречается на сайтах, работающих на cms Joomla. В случае, если материал не привязан к пункту меню он дублируется по всем категориям сайта. В случае с джумлой это лечится с помощью плагина jl no doubles.

В случае с джумлой это лечится с помощью плагина jl no doubles.

Отсутствие редиректа со слэша

Дубли вида https://site.ru/page и https://site.ru/page/.

Решение: настройка либо 301-редиректа, либо кода ответа 404.

Что касается выбора какие оставить url со слэшем на конце или без, то здесь стоить смотреть каких url у вас на сайте было больше. После настройки редиректа стоит спарсить сайт и убедиться, что не появились лишние внутренние редиректы.

Отсутствие редиректа с www

Аналогично со слэшем, но помимо дублирования контента это грозит ещё сменной главного зеркала. Фактически site.ru и www.site.ru — это разные домены. Решается также — настройкой 301-редиректа. Но здесь важно определить правильно главное зеркало.

Неочевидные дубли

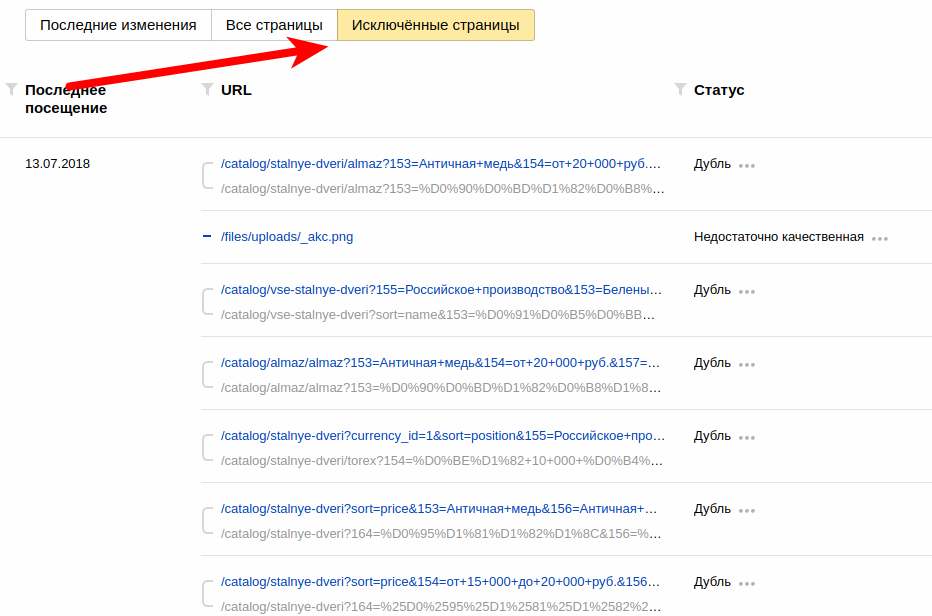

Страницы с GET-параметрами

Одна из самых распространенных причин дублирования. Страницы с get-параметрами могут появиться при использовании фильтров, сортировки, поиска по сайту. Пример страницы с GET-паратмерами: example.com?q=search-test. Решается данная проблема закрытием от индексации. Закрыть страницы от индексации можно в файле robots.txt, либо добавлением мета-тега. В идеале использовать два способа вместе.

Пример страницы с GET-паратмерами: example.com?q=search-test. Решается данная проблема закрытием от индексации. Закрыть страницы от индексации можно в файле robots.txt, либо добавлением мета-тега. В идеале использовать два способа вместе.

Страницы пагинации

Обычно категории товары разделены на страницы пагинации. Это делается для того, чтобы сэкономить ресурсы на загрузку страницы и не грузить сразу весь каталог. Каждая страница пагинации — это отдельная страница, которая дублирует основную категорию. Закрыть страницы пагинации от индексации как остальные страницы с GET-параметрами — плохое решение, т.к. нужно, чтобы содержимое этих страниц тоже индексировалось. В этом случае отличным решением будет добавление на страницы пагинации тега <meta name="robots" content="noindex, follow" />. В таком случае содержимое страниц будет индексироваться, а дубли пагинации не будут заходить в индекс поисковых систем.

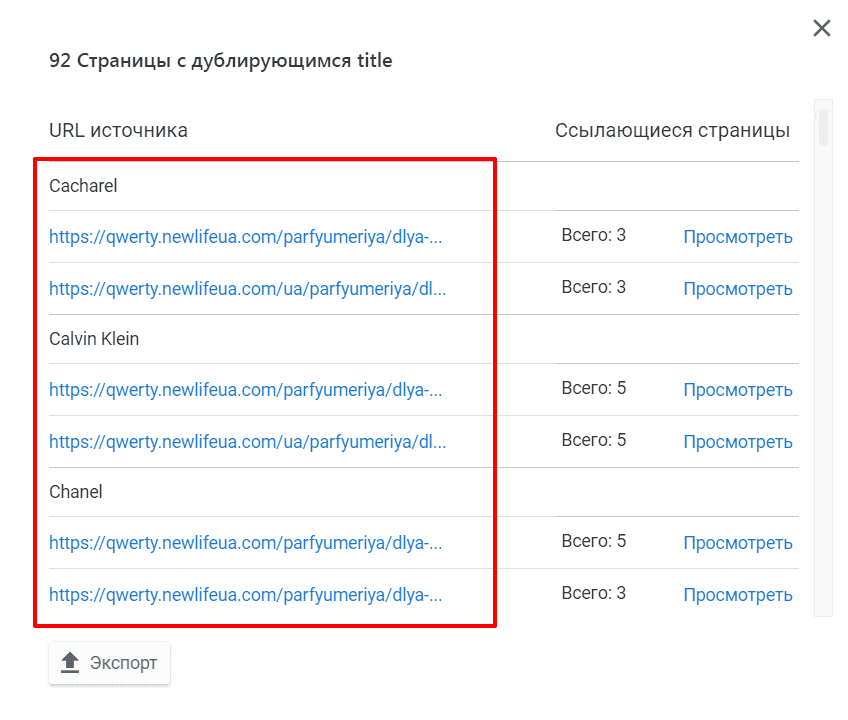

Ошибки генерации мета-тегов

Этот вид дублей относиться к нетипичным, потому что страницы полностью отличаются по содержанию, но их мета-теги задублированы из-за некорректной настройки шаблона генерации.

Решение: просканировать сайт краулером и проверить мета-теги всех страниц сайта.

Неуникализация карточек товара

Данный вид дублей касается дублирования названий товаров. Решается уникализацией заголовков за счет вывода в заголовок каких-либо характеристик.

Пример неуникальных карточек товара:

Пример уникализации карточек товара:

Повторяющиеся блоки

Данный вид дублирования встречается на шаблонных страницах, где повторяются одни и те же блоки. Этими блоками могут быть: отзывы, галерея, форма заявки и т.п. Решается оборачиванием шаблонных блоков в тег noindex.

Как проверить сайт на наличие дублей

Сервисы вебмастеров

Первым делом идем в панель Яндекс.Вебмастера и Google Search Console. Проверяем наличие дублей и первым делом исправляем эти дубли, т.к. они уже известны поисковым системам.

Поиск дублей через сервисы проверки на уникальность

Например, через сервис text.ru. После проверки текста в отчете будут все найденные страницы в интернете с проверяемым текстом.

На скриншоте видно на каких страницах найден проверяемый текст.

Поиск дублей с помощью краулеров

Один из самых эффективных способов поиска дублей на сайте. Проверить сайт можно с помощью программы Screaming Frog SEO Spider.

Процесс поиска прост:

- Сканируем сайт;

- Проверяем дубли в h2, title, description. Для этого идем по вкладкам: Page Titles, Meta Description, h2 и фильтруем по Duplicate;

- Проверяем все дубли и разбираемся с причиной их появления.

Этот метод отлично помогает при поиске дублей. Буквально за несколько минут вы обнаружите все дубли на сайте даже с десятками тысяч страниц.

Как устранить дублирование контента на сайте

В статье мы подробно разобрали способы устранения дублей для разных типов дублирования.

Подведем итог:

- Страницы с GET-параметрами закрываем в файле robots.txt и добавляем тег robots “noindex”.

- Для страниц пагинации добавляем тег

<meta name="robots" content="noindex, follow"/>.

- При дублировании материалов и карточек товаров по нескольким категориям либо настраиваем тег canonical, либо настраиваем вывод по основному url, либо делаем короткий вариант url.

- Настраиваем код ответа для несуществующих страниц 404.

- Настраиваем все редиректы на главное зеркало. Варианты редиректов: с www, с index.php, с http, с “/”.

- Дублированные шаблонные блоки оборачиваем в тег

<noindex>.

Поиск дубликатов страниц в pdf-документе

Если ваши «идентичные» страницы выглядят одинаково на экране, для поиска дубликатов может помочь следующий алгоритмический подход:

- Преобразование каждой страницы в TIFF или JPEG с низким разрешением файл с использованием Ghostscript (например, с использованием 72dpi).

- Если вы используете TIFF: запустите одну из утилит командной строки libtiff , чтобы «нормализовать» метаданные TIFF.

- Запустите md5sum.exe на каждой странице TIFF или JPEG и запомните Md5sum для каждой страницы.

- Отсортируйте список сумм MD5, чтобы найти повторяющиеся страницы.

- Запомнить все повторяющиеся номера страниц, которые необходимо удалить.

- Запустите командную строку

pdftk.exeв исходном PDF-файле, чтобы удалить дубликаты.

Вы можете закодировать этот алгоритм на любом языке, который вам нравится (даже пакетном в Windows или bash в Linux/Unix/MacOSX).

Первый: Несколько замечаний по использованию Ghostscript. Создайте 1200 страниц в формате TIFF (или JPEG) (в Linux вы использовали бы 9# используйте -sDEVICE=jpeg для создания файлов *.jpeg + соответствующим образом адаптируйте -sOutputFile= # page-%06d.tif создает файлы TIFF с именами от page-000001.tif до page-012000.tif*

Второй: Несколько замечаний о необходимости использования (бесплатно доступных) утилит libtiff. Когда Ghostscript создает страницу TIFF, он отмечает ее текущую версию, дату и время, а также некоторые другие метаданные внутри TIFF.

tiffinfo page-000001.tif или tiffdump page-000001.tif , чтобы понять, что я имею в виду. Вы могли видеть что-н. вот так:c:\downloads> tiffdump.exe page-000001.tif страница-000001.tif: Magic: 0x4949Версия: 0x2a Каталог 0: смещение 2814 (0xafe) следующий 0 (0) SubFileType (254) LONG (4) 1<2> ImageWidth (256) SHORT (3) 1<595> ImageLength (257) SHORT (3) 1<842> BitsPerSample (258) SHORT (3) 1<1> Сжатие (259) КОРОТКИЙ (3) 1<4> Фотометрический (262) КОРОТКИЙ (3) 1<0> FillOrder (266) SHORT (3) 1<1> StripOffsets (273) LONG (4) 8<8 341 1979 1996 2013 2030 2047 2064> Ориентация (274) КОРОТКАЯ (3) 1<1> SamplesPerPixel (277) SHORT (3) 1<1> RowsPerStrip (278) SHORT (3) 1<109> StripByteCounts (279) LONG (4) 8<333 1638 17 17 17 17 17 13> XРазрешение (282) RATIONAL (5) 1<72> YРазрешение (283) RATIONAL (5) 1<72> PlanarConfig (284) КОРОТКИЙ (3) 1<1> Group4Options (293) ДЛИННЫЙ (4) 1<0> РазрешениеЕдиница (296) КОРОТКИЙ (3) 1<2> Номер страницы (297) КОРОТКИЙ (3) 2<0 0> Программное обеспечение (305) ASCII (2) 21 сделать tiffset -s 306 "0000:00:00 00:00:00" %i

Третий и четвертый: Запустите md5sum.exe и отсортируйте список файлов, чтобы найти дубликаты. Вот используемая командная строка:

c:\downloads> md5sum.exe C:\temp\tiffs\*.tif | Сортировать

В результате вы должны легко увидеть, какие файлы/страницы имеют одинаковый хэш MD5. Это будет выглядеть примерно так:

c:\> md5sum.exe c:/temp/tiffs/page-0*.tif [....] fae9fa136c4f7ecca23b6a34d620fb02 *c:\temp\tiffs\page-000032.tif fae9fa136c4f7ecca23b6a34d620fb02 *c:\temp\tiffs\page-000033.tif fb5fef1732148d71bfff841c214cf836 *c:\temp\tiffs\page-000076.tif fb5fef1732148d71bfff841c214cf836 *c:\temp\tiffs\page-000077.tif fb86c1bdbc697eef7cb869f4e2e2957b *c:\temp\tiffs\page-000187.tif fb86c1bdbc697eef7cb869f4e2e2957b *c:\temp\tiffs\page-000188.tif fbb801ab3ef7ea33619132f97dcab045 *c:\temp\tiffs\page-000443.tif fbb801ab3ef7ea33619132f97dcab045 *c:\temp\tiffs\page-000444.tif fbc33cc0ff3e1252de1653ef2e978f94 *c:\temp\tiffs\page-000699.tif fbc33cc0ff3e1252de1653ef2e978f94 *c:\temp\tiffs\page-000700.tif fc3fd164e20bb707acddeabbc4e60f7e *c:\temp\tiffs\page-000899.tif fc3fd164e20bb707acddeabbc4e60f7e *c:\temp\tiffs\page-0009вывод без дубликатов.pdf

* Редактировать: Не знаю, почему я сначала предложил TIFF — разумнее было бы использовать BMP. *

Если вы используете -sDEVICE=bmp256 и -sOutputFile=C:\temp\tiffs\page-%06d.bmp , вам не придется иметь дело с этапом «нормализации», описанным выше. Остальная часть процедуры ( md5sum ... ) такая же….

Автоматически определять дубликаты документов во время обработки

До четырех

поля документа могут быть использованы для выявления дубликатов

документы в интерпретации на основе текущей соответствующей информации в базе данных для ранее обработанных

документы.

Идентифицированные таким образом документы затем помещаются в папку Дубликаты в

Входящие в Verify. Это настроено

в два этапа:

Это настроено

в два этапа:

- Определите, какие поля используются для идентификации дубликатов документы

- Создать папку для дубликатов документы в папке «Входящие»

Определите, какие поля используются для идентификации повторяющихся документы

Примечания:

- В приложении «Менеджер» нажмите «Настройки» > «Входящие». конфигурации, а затем щелкните Настроить дубликаты документов.

- в Настройте поля для диалогового окна дублирования счетов, определите до четырех полей, используя И или ИЛИ модификаторы для идентификации документы. Обратите внимание, что приоритет полей в диалоговом окне сверху вниз, и если Для поля не указано значение None, как для этого поля, так и для любых последующих полей, указанных в диалоговом окне. не будет учитываться при поиске дубликатов документы.

- Нажмите ОК, чтобы сохранить изменения.

- Примечания:

- Когда данные журнала процесса

удаленный

из базы данных с помощью плана обслуживания или

очистив базу данных, не будет никаких

документировать данные для сравнения с использованием этой функции до тех пор, пока не будет добавлено

документы обработаны.

- Вы можете ограничить поля, доступные для выбора в раскрывающиеся списки, перечисляя только нужные поля в Раздел [DuplicateIdentifier] Eiglobal.ini (дополнительную информацию см. в справке по файлу INI).

- Когда данные журнала процесса

удаленный

из базы данных с помощью плана обслуживания или

очистив базу данных, не будет никаких

документировать данные для сравнения с использованием этой функции до тех пор, пока не будет добавлено

документы обработаны.

Создать папку для дубликатов документы в папке «Входящие»

Для отображения документы, идентифицированные как дубликаты, для пользователей в папке «Входящие» в определенной папке, выполните следующие действия:

- В рамках процесса к создать или отредактировать почтовый ящик, в Входящие диалоговое окно конфигурации, нажмите Редактировать папки.

- в Изменить папку «Входящие» диалоговое окно папок, нажмите для создания корневого узла с именем Duplicates в иерархии выбора.

- В зависимости от того, что лучше для вашей ситуации, вы можете нажать

один раз, чтобы создать один дочерний узел для всех дубликатов

документы, или вы можете использовать его несколько раз, чтобы создать дочерний узел для каждого

профиль документа, например.

- Щелкните дочерний узел, чтобы выбрать его, а затем щелкните Примените критерии выбора к этой папке/группе справа на экране, чтобы отобразить критерии которые можно указать для папки. Если было создано более одного дочернего узла, необходимо выполнить этот и следующие шаги. сделано для каждого.

- На Профили документов нажмите кнопку профиль(и) документа, для которого вы хотите дублировать документы для размещения в дочернем узле.

- На Вкладка Статусы, нажмите Дублируйте, чтобы выбрать его, и снимите выделение любых других статусов, если таковые имеются.

- Необязательно: можно указать дополнительные критерии, если вы хотите, чтобы любой из этих дочерних узлов применялся к дубликату. документы для конкретных приемники, очереди или пользовательские переменные. Однако обратите внимание, что все указанные критерии должны быть соблюдены для документы должны быть помещены в соответствующую папку входящих сообщений.

- Нажмите ХОРОШО.

- Если вы хотите, чтобы эти папки видели только определенные пользователи, вы можете

создайте роли авторизации пользователей для этой цели, а затем свяжите соответствующих пользователей с

роль.

Обратите внимание, что если выбранный вами пользователь

ограничено от просмотра

а

профиль документа, выбранный для роли, они не увидят дубликат

документы на это

профиль документа в папке в Верифицировать во время обработки.

Обратите внимание, что если выбранный вами пользователь

ограничено от просмотра

а

профиль документа, выбранный для роли, они не увидят дубликат

документы на это

профиль документа в папке в Верифицировать во время обработки. - Когда закончите, нажмите ОК, чтобы сохранить изменения.

Как это работает

При выявлении дубликатов документы настроены в соответствии с вышеизложенным, Вход Kofax ReadSoft проверяет указанные поля в Interpret и сравнивает их с информацией о дубликате счета-фактуры, найденной в база данных. Если потенциал найдены документы с совпадающими полями, им даются Статус дубликата, и они помещаются в соответствующую папку Duplicates в папке «Входящие» в Verify в зависимости от того, как он был настроен.

Только те

документы, для которых все поля получают

Полный статус, рассматриваются как потенциальный дубликат

документы. Кроме того, если какое-либо поле на

а

документ имеет более одного предложенного значения, что

документ не рассматривается как потенциальный дубликат

документ, даже если поле получает

Полный статус.

tif

fbc33cc0ff3e1252de1653ef2e978f94 *c:\temp\tiffs\page-000699.tif

fbc33cc0ff3e1252de1653ef2e978f94 *c:\temp\tiffs\page-000700.tif

fc3fd164e20bb707acddeabbc4e60f7e *c:\temp\tiffs\page-000899.tif

fc3fd164e20bb707acddeabbc4e60f7e *c:\temp\tiffs\page-0009вывод без дубликатов.pdf

tif

fbc33cc0ff3e1252de1653ef2e978f94 *c:\temp\tiffs\page-000699.tif

fbc33cc0ff3e1252de1653ef2e978f94 *c:\temp\tiffs\page-000700.tif

fc3fd164e20bb707acddeabbc4e60f7e *c:\temp\tiffs\page-000899.tif

fc3fd164e20bb707acddeabbc4e60f7e *c:\temp\tiffs\page-0009вывод без дубликатов.pdf

Обратите внимание, что если выбранный вами пользователь

ограничено от просмотра

а

профиль документа, выбранный для роли, они не увидят дубликат

документы на это

профиль документа в папке в Верифицировать во время обработки.

Обратите внимание, что если выбранный вами пользователь

ограничено от просмотра

а

профиль документа, выбранный для роли, они не увидят дубликат

документы на это

профиль документа в папке в Верифицировать во время обработки.