Почему не индексируется сайт? Причины по которым Google и Yandex не индексируют ваш сайт

2333

| SEO | – Читать 20 минут |

Прочитать позже

Анастасия Сотула

Редактор блога Serpstat

Если вы занимаетесь продвижением бизнеса в интернете, первое, что нужно отслеживать — индексацию страниц сайта. Здесь возникает несколько вопросов: «Зачем нужна эта индексация сайта?» (спойлер: чтобы у пользователей была возможность найти ваш сайт в поисковой выдаче), «Где проверить сайт на индексацию» и «Что делать, если сайт не индексируется?». Ответы на них мы и разберем в данной статье.

Содержание

Как проверить индексацию сайта

Google и Яндекс пока не нашел ваш сайт

— Как добавить сайт в Гугл вебмастер (Google Search Console)?

— Как добавить сайт в Яндекс.Вебмастер?

Сайт или страницы закрыты в robots.txt

Включены приватные настройки

Сайт закрыт от индексации в noindex в метатегах

Ошибки сканирования

Сайт заблокирован в . htaccess

htaccess

Хостинг или сервер работает нестабильно

Проблемы с AJAX/JavaScript

У вас на сайте много дублированного контента

Очень медленная скорость загрузки сайта

Ваш домен ранее был забанен

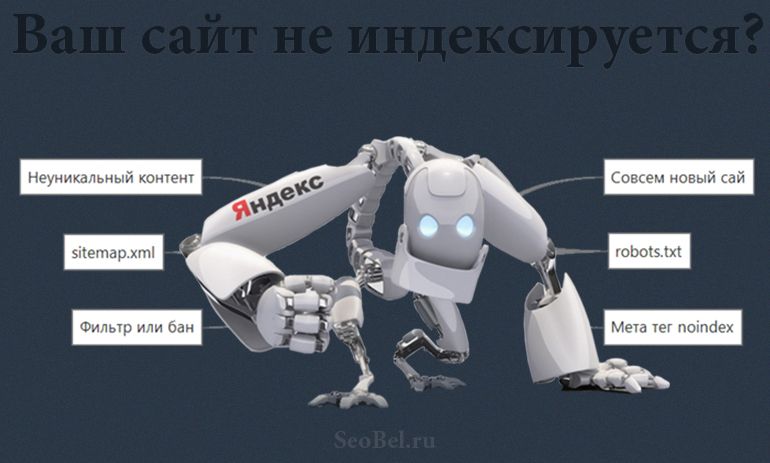

У вас нет sitemap на сайте

FAQ

Выводы

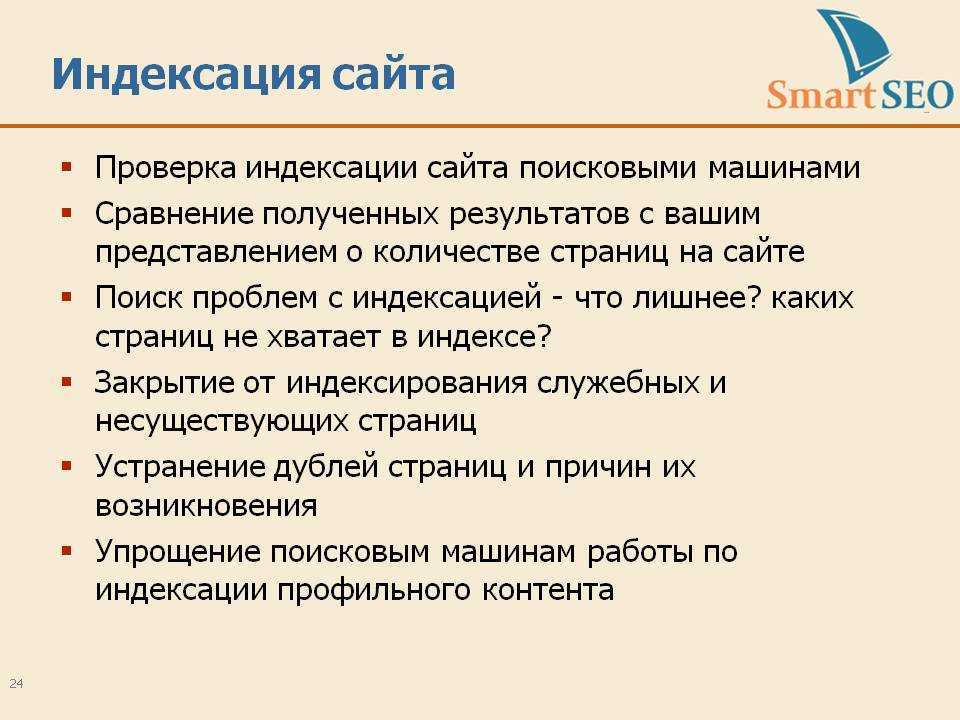

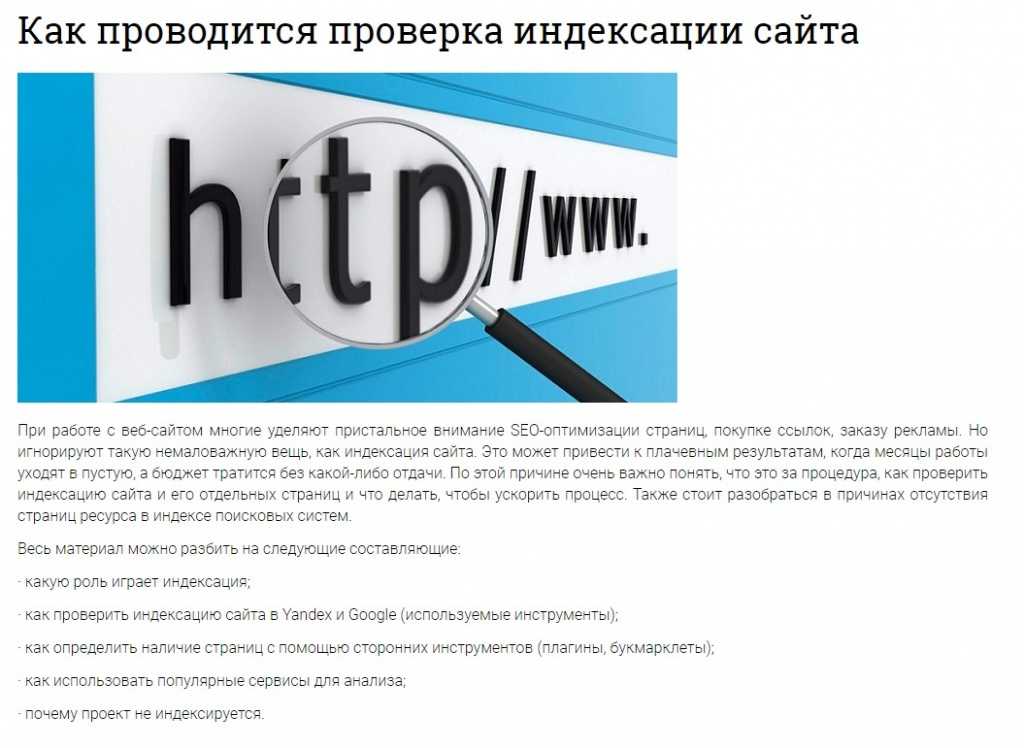

Как проверить индексацию сайта

Перед тем, как поднять сайт в поисковиках, нужно оценить его видимость в популярных поисковых системах. Узнать видимость сайта можно с помощью специализированных ресурсов, например, Serpstat.

Чтобы узнать, насколько ваш сайт «виден» поисковикам, достаточно ввести адрес домена в поисковую строку и нажать «Поиск». Данный показатель относительный и его нужно смотреть в сравнении с основными конкурентами.

Проверка видимости сайта в Serpstat

Если показатель видимости низкий, необходимо проверить индексацию вашего веб-ресурса и добавить информацию про него в базу данных поисковиков.

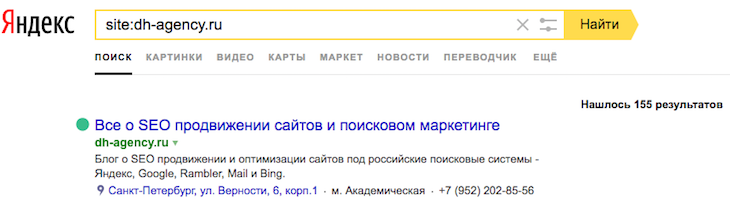

Самый простой способ узнать, индексируется ли ваш сайт, – воспользоваться панелью вебмастера. Для этого нужно иметь к ней доступ (почта в Google, регистрация-идентификация). Если доступ получен, то заходим в Панель, находим меню Search Console, достаем вкладку Индекс Google. В ней выбираем и смотрим Статус индексирования.

Статус индексации сайта в Search Console

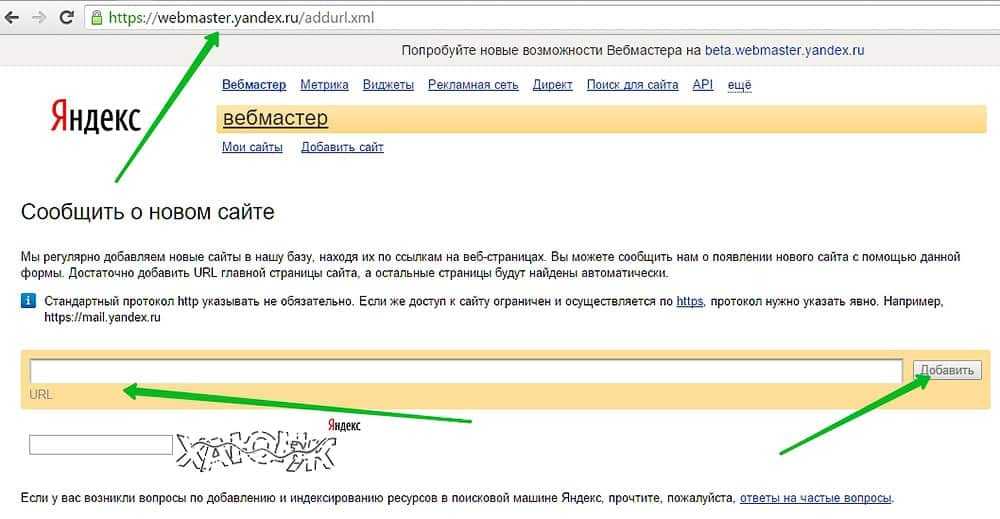

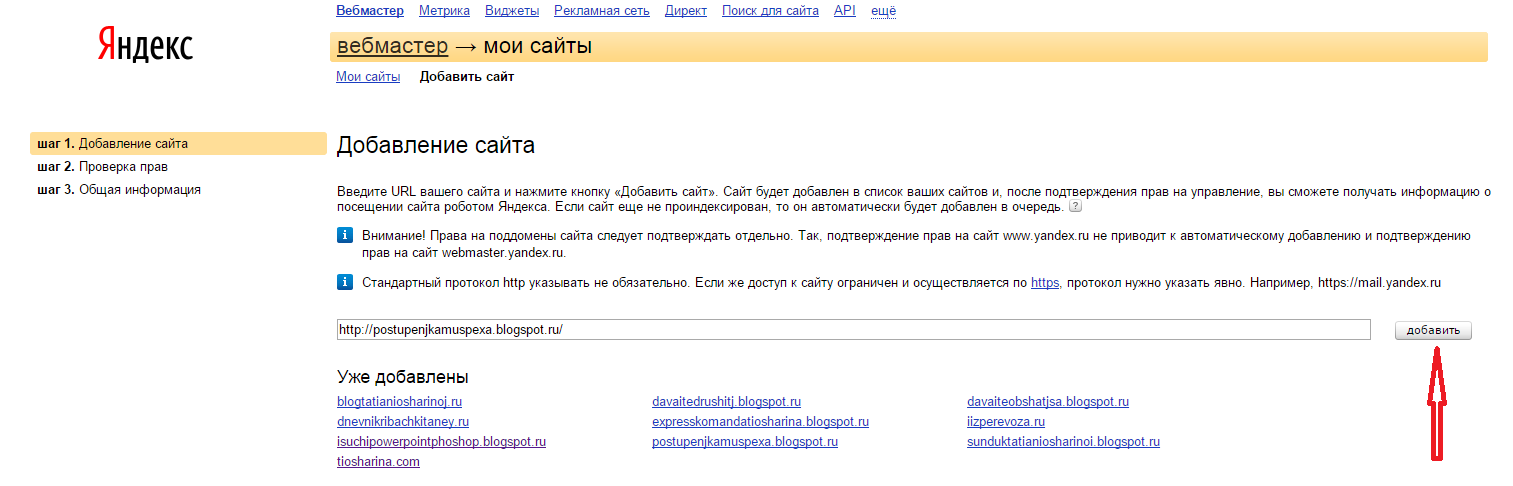

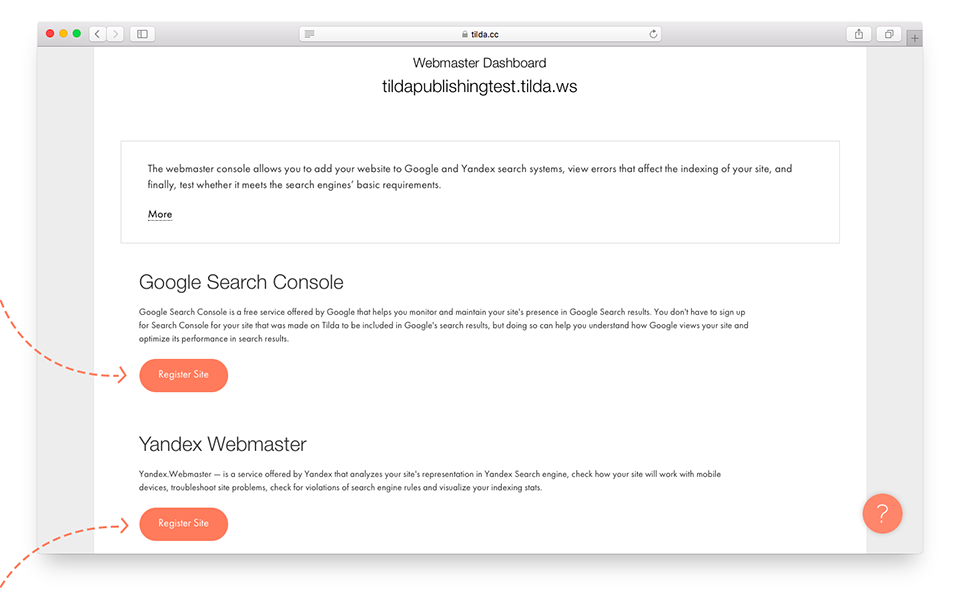

Чтобы добавить сайт в Яндекс, нужно выполнить следующие операции:

- Авторизоваться в Яндекс.Почте. В идеальном виде свежесозданную почту лучше использовать только для работы.

- Перейти в Яндекс.Вебмастер.

- Добавить url веб-ресурса в специальном окошечке «Добавить сайт».

- После этого нужно подтвердить свои права на сайт с помощью мета-тега, HTML-файла, DNS-записи или WHOIS.

- Доступом к панели можно поделиться с коллегами.

Добавление сайта в Яндекс Вебмастер

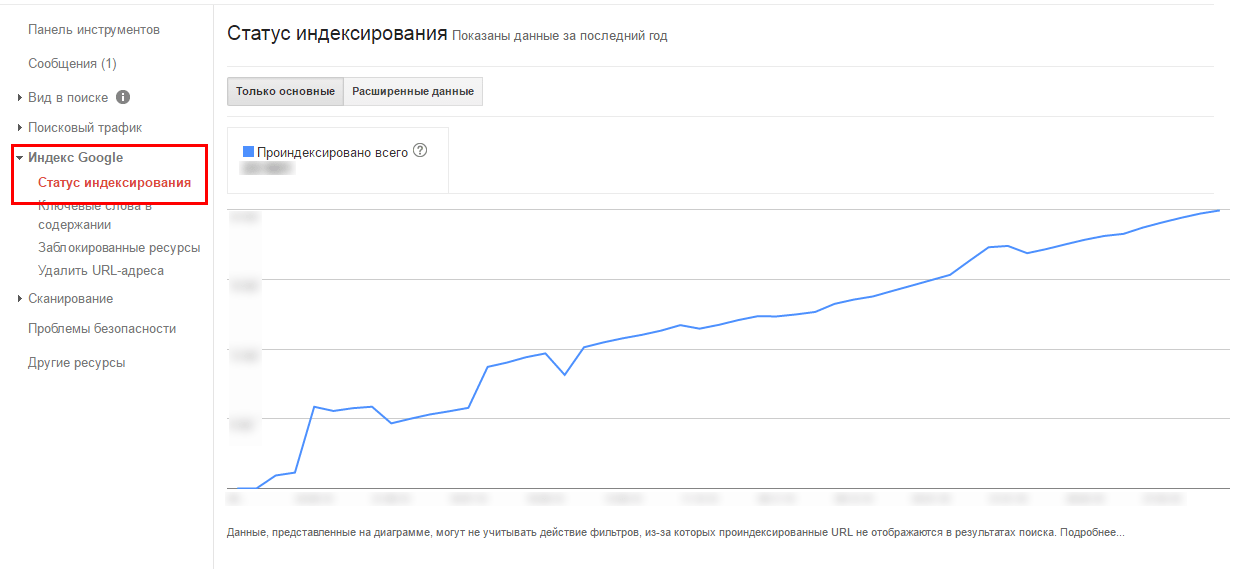

Индексация сайта – это работа бота поисковой системы. Бот бесконечно сканирует тексты, изображения, видео, а потом добавляет информацию про веб-страницу или веб-ресурс в базу поисковой системы. Благодаря этой работе по накоплению базы пользователь получает релевантный ответ на свой запрос. Благодаря собранной ботом информации происходит ранжирование сайтов в конкретной поисковой системе.

Бот бесконечно сканирует тексты, изображения, видео, а потом добавляет информацию про веб-страницу или веб-ресурс в базу поисковой системы. Благодаря этой работе по накоплению базы пользователь получает релевантный ответ на свой запрос. Благодаря собранной ботом информации происходит ранжирование сайтов в конкретной поисковой системе.

А теперь подробнее разберемся в причинах того, почему поисковые системы могут не индексировать ваш сайт.

Google и Яндекс пока не нашел ваш сайт

Иногда Google и Яндекс просто «не видят» ваш сайт. Особенно это характерно для молодых площадок. Дело в том, что молодые сайты попадают в так называемую Песочницу – эдакий отстойник для веб-ресурсов, пока поисковая система не разберется, что это за сайт – какой он, чем дышит и для кого он предназначен.

Если сайту больше 6 месяцев (максимальное время зависания в Песочнице), то его «видимость» могут сдерживать фильтры поисковых систем. Потому что им не нравится, если контент на сайте не уникальный (стыренный у других авторов), а его содержание выходит за рамки морали, пропагандирует насилие или не имеет подтвержденной экспертизы. Пример: на сайте про лечебные средства отсутствуют имена и биографии авторов, которые их рекомендуют.

Потому что им не нравится, если контент на сайте не уникальный (стыренный у других авторов), а его содержание выходит за рамки морали, пропагандирует насилие или не имеет подтвержденной экспертизы. Пример: на сайте про лечебные средства отсутствуют имена и биографии авторов, которые их рекомендуют.

Если сайт не молодой, и с контентом все в порядке, то в теории нужно дать поисковым системам время на индексирование сайта в Гугле – минимум 2 недели.

Правда, процесс можно ускорить, чтобы поисковики быстрее увидели сайт, его нужно вручную добавить в поисковые системы (Add url), а также в Google и Яндекс вебмастер.

Запрос на индексирование url вручную

Как проиндексировать сайт в Гугл? Для этого нужно постоянно обновлять контент (в этом случае в преимущественном положении находятся сайты-новостники), создавать новые страницы (преимущество имеют блогеры и интернет-магазины с растущим ассортиментом), а также осуществлять внутреннюю перелинковку страниц в комплексе со ссылками с авторитетных внешних ресурсов.

Как добавить сайт в Гугл вебмастер (Google Search Console)?

Правда, есть еще возможность проиндексировать сайт в Google быстро. Для этого выполняем 5 элементарных операций:

- Открываем Google Search Console – раз!

- Переходим в Инструмент проверки URL – два.

- Вставляем в строку поиска URL, который нужно сделать видимым в индексе Google – три.

- Ожидаем, пока Google проверяет адрес – четыре.

- Нажимаем кнопку «Запросить индексирование» – пять!

Мы подготовили для вас самую подробную инструкцию, как добавить сайт в Google Search Console.

Как добавить сайт в Яндекс.Вебмастер?

Индексирование сайта в Яндекс происходит следующим образом:

- Регистрируем сайт в Яндекс-вебмастере.

- Создаем карту сайта (это html страница сайта или специальный xml файл, в котором отражены ссылки на все важные страницы сайта).

- Добавляем ключевые, а лучше – все, URL страницы сайта с помощью опции «Сообщить о новом сайте».

А вот еще одна супер-инструкция для наших читателей – самым детальным образом разбираем, как добавить сайт в Яндекс.Webmaster.

Важно понимать, что индексация Гугла существенно отличается от внесения страницы (веб-ресурса) в базу Яндекса. После того, как вы прошли квест в Яндекс-вебмастере, вы всего лишь встали в очередь. Когда до вас дойдет очередь, тогда Яндекс и будет индексировать ваш сайт.

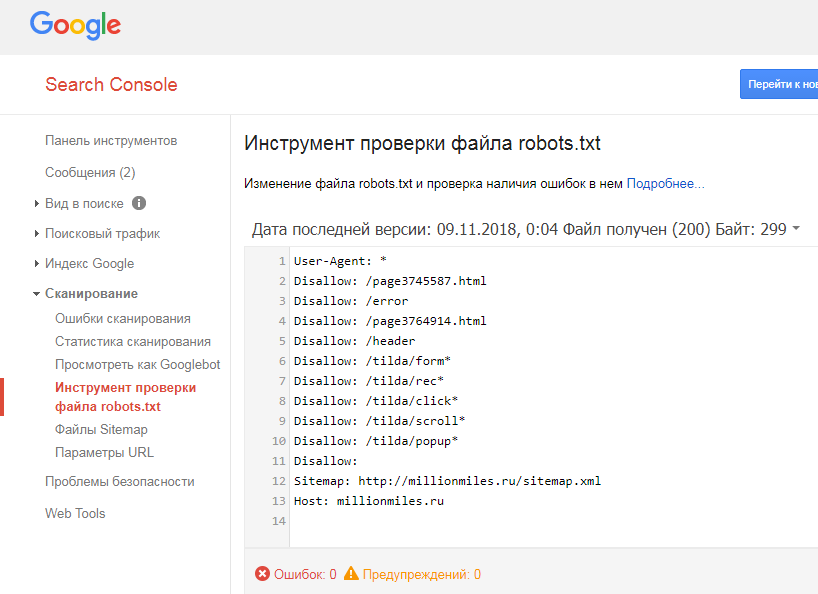

Сайт или страницы закрыты в robots.txt

Файл robots.txt — запретный инструмент Гугла. В нем содержатся инструкции для поисковых роботов: какие страницы они могут обрабатывать на вашем сайте. С помощью файла robots.txt можно искусственно ограничить количество запросов на сканирование. Это поможет снизить нагрузку на сервер. Актуально для неважной или повторяющейся информации. Для этого на веб-страницу сайта, которую нужно убрать из поля видимости Гугла, нужно добавить директиву noindex.

Важно! Даже если запретить индексацию в robot txt для какой-то веб-страницы, то она все равно может быть проиндексирована роботом Googlebot, при условии, что на нее есть ссылки с других сайтов. Это относится только к контенту в формате HTML. А вот заблокированные файлы PDF, изображения или видео будут надежно спрятаны от Google. Чтобы гарантированно исключить индексацию страницы с контентом в формате HTML в Гугле, нужно использовать директиву noindex в мета теге или HTTP-заголовке ответа.

А теперь, внимание, рассказываем, как задать в robots.txt директивы для роботов Google и Яндекса. Чтобы индексировать сайт в Гугл, необходимо в файле robots.txt позволить агентам роботов Googlebot, AdsBot-Google, Googlebot-Image позволить сканировать веб-ресурс. Для этого нужно добавить в файл robots.txt следующие строки:

- User-agent: Googlebot

Disallow:

- User-agent: AdsBot-Google

Disallow:

- User-agent: Googlebot-Image

Disallow:

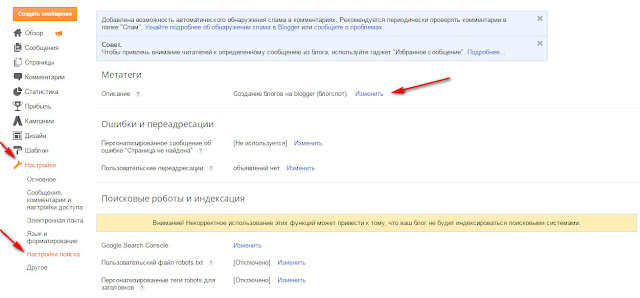

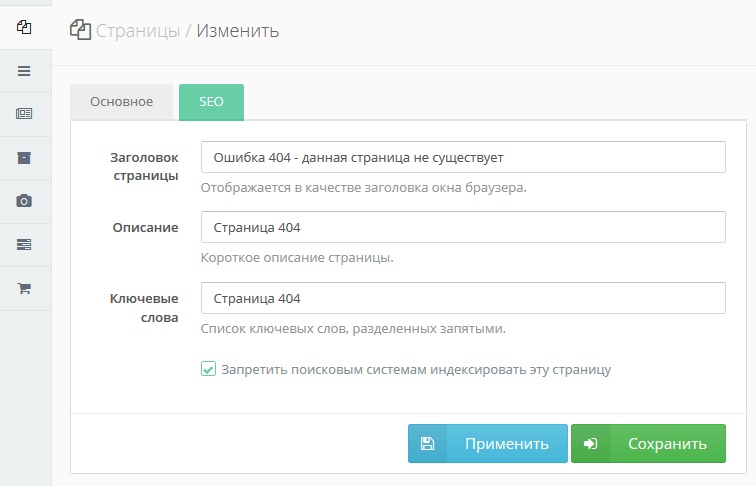

Включены приватные настройки

Иногда сайт не индексируется Гуглом по самой банальной причине – в CMS включены приватные настройки. CMS – это движок сайта, например WordPress, Joomla, OpenCart. CMS — это набор скриптов, которые позволяют создавать, редактировать и управлять контентом на website.Чтобы индексация страницы состоялась, нужно проверить настройки страницы в конкретной CMS.

CMS – это движок сайта, например WordPress, Joomla, OpenCart. CMS — это набор скриптов, которые позволяют создавать, редактировать и управлять контентом на website.Чтобы индексация страницы состоялась, нужно проверить настройки страницы в конкретной CMS.

Сайт закрыт от индексации в noindex в метатегах

Мета-теги (HTML) нужны для того, чтобы структурировать содержимое веб-страницы. Как правило, мета-теги указываются в заголовке HTML-документа. Обязательным является атрибут content, а уже к нему добавляются остальные.

Появление meta noindex nofollow означает, что интернет-боты не должны трогать (индексировать) эту страницу. Причина запрета может быть в том, что страница имеет временное содержимое, быть версией для печати или содержать приватную информацию. Детальную инструкцию, какие страницы нужно закрыть от индексации, смотрите на нашем сайте.

Вот как meta noindex выглядит в HTML-документе, блокируя этим бота Google:

<meta name="googlebot" content="noindex">

Чтобы заблокировать видимость веб-страницы в глазах бота MSN’s bot, пишем «волшебные слова»:

<meta name="msnbot" content="noindex">

Чтобы отключить индексацию целой страницы убираем слово «noindex» из кода.

Наличие метатега robots в коде страницы в сочетании со словом noindex показывает поисковым роботам запрет на индексирование сайта в Гугл.

Выглядит robots txt noindex в HTML-документе вот так:

<meta name="robots" content="noindex">

Где искать информацию про robots noindex? Заходим в Google Search Console. Открываем отчет «Индекс», выбираем «Покрытие», переходим во вкладку «Исключено». Если там написано, что индексирование страницы запрещено тегом rel noindex, то становится понятным, почему веб-ресурс закрыт от индексации. Ах, да, и не забудьте снять запрет, если ищете способ, как как проиндексировать страницу в Гугл.

Ошибки сканирования

Ошибки сканирования также останавливают индексацию в Гугл, ранжирование сайта в выдаче, а также отношение посетителей к веб-ресурсу. Эксперты выделяют три группы причин ошибок сканирования:

- Ошибки в настройках сервера (серверов).

- Сбои CMS (система управления контентом).

- Изменение структуры URL.

Ошибки сканирования можно найти в инструментах Google Search Console и Яндекс.Вебмастер. Для этого потребуется зайти в статистику сканирования web-ресурса. Если вы вычислили «свою» ошибку, то рядом должно быть объяснение для вебмастера – причина ее появления и способы ликвидации. Но, мы тоже подготовили для вас текст, как устранить ошибки сканирования. Пользуйтесь!

Важно! Информация в Search Console попадает с небольшой оттяжкой во времени. Поэтому ошибки могут быть уже устранены, а в консоли по-прежнему будет отображаться их наличие.

Сайт заблокирован в .htaccess

Сайт может быть заблокирован в .htaccess. Это делается для того, чтобы лишить случайных посетителей доступа к какому-то файлу, папке, админ-панели сайта. Пароль на эти структурные элементы владелец ставить не хочет, но и непрошенных гостей здесь не ждет. Для этого в папке с инкогнито нужно создать 1 файл с именем htaccess.

В коде запрет доступа по IP адресу к файлу file.php выглядит вот так:

<Files file.php> Order Deny,Allow Deny from all Allow from Ваш IP адрес </Files>

После этого все обращения к указанному файлу с чужого IP будет давать ответ 403 «Access denied». Если владелец ресурса хочет ограничить доступ ко всем файлам с одним расширением, то первую строчку делают вот такой <Files «*.conf»>. Если расширений несколько, то они пишутся через разделитель <Files ~ «\.(inc|conf|cfg)$»>.

Чтобы проверить, находим на сервере файл .htaccess. Высматриваем в коде, не были ли когда-то закрыт сайт или его часть. Редко кто думает в этом направлении, но этот вариант обязательно нужно проверить, когда ищешь причины, почему сайт закрыт от поисковика.

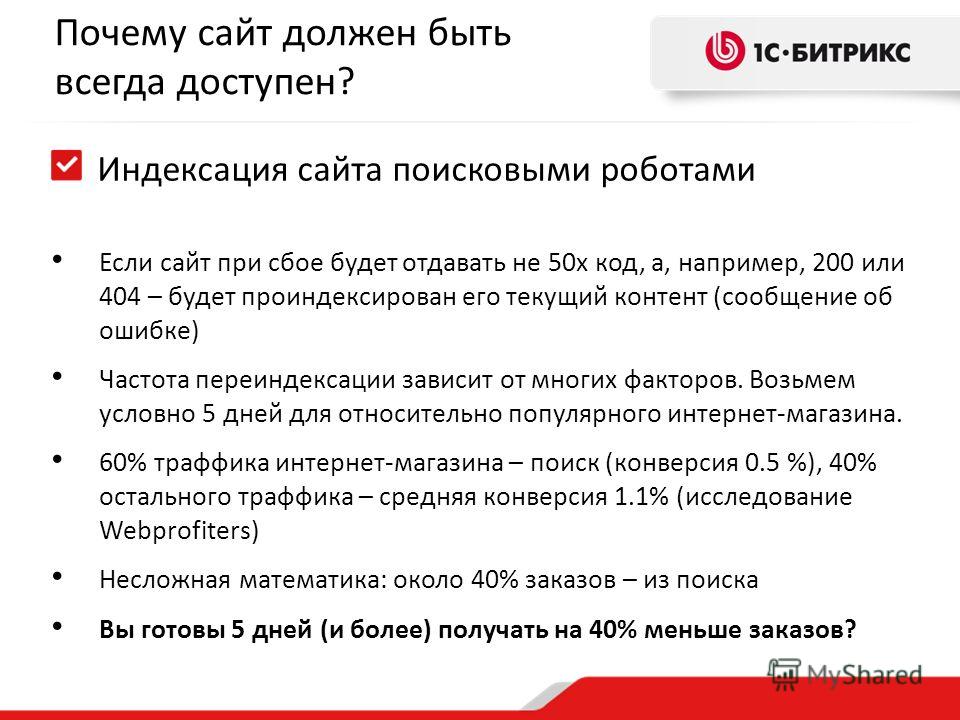

Хостинг или сервер работает нестабильно

Если хостинг или сервер работают с перебоями, то это может стать причиной того, что индексация не состоялась. Представьте себе ситуацию: поисковый бот пришел на сайт (заглянул в гости) проиндексировать страницы, а там никого нет. Поэтому задача владельца ресурса — озаботиться тем, чтобы сервер был качественным, а хостинг — стабильным.

Представьте себе ситуацию: поисковый бот пришел на сайт (заглянул в гости) проиндексировать страницы, а там никого нет. Поэтому задача владельца ресурса — озаботиться тем, чтобы сервер был качественным, а хостинг — стабильным.

Контроль за состоянием доступа к сайту ведем с помощью множества сервисов. Например, Яндекс Метрика сразу же показывает периоды проблем с доступностью сайта. Другие сервисы подбираем в поисковиках по запросу uptime checker – получаем множество вариантов сервисов, которые позволяют отследить стабильность работы хостинга. А также читаем нашу статью, как выбрать надежный хостинг для сайта, если услуга доказано некачественная.

Проблемы с AJAX/JavaScript

Google также индексирует AJAX и JavaScript, но делает это не так просто, как HTML. Поэтому разработчик должен вручную настроить все для поиска AJAX и JavaScript, чтобы «насильственно» заставить Гугл проиндексировать сайт и нужные вам страницы. Если интересно, то вот мнение экспертов про то, как устранить проблемы с видимостью сайтов на JavaScript-движках.

У вас на сайте много дублированного контента

Дублированный контент в 2021-2022 году после появления фильтров и, особенно, Панды, может стать одной из ключевых причин, почему на сайт накладывают санкции, а задача, как поднять сайт в поисковике, начинает «выедать» время и финансы. Правда, господа-сеошники уже давно разработали несколько действенных технологий, как избежать фильтров поисковиков за контент сайта без ущерба для этой самой оптимизации.

Дублированный контент может быть в страницах, а может и в метатегах. Чтобы исключить дублированный контент, нужно сначала отыскать все дубликаты страниц на сайте, а потом удалить их или закрыть от индексации. Читайте, нашу статью про то, как найти и удалить дубли страниц на сайте, чтобы зря не злить поисковых роботов.

Очень медленная скорость загрузки сайта

Скорость загрузки сайта является одним из факторов ранжирования и попадания в первую десятку топ-выдачи.

Поэтому скорость загрузки сайта прямо влияет на конверсию, снижает количество отказов, увеличивает глубину просмотра страниц, поэтому косвенно дает рост среднего чека и выручки. В общем, если сайт грузится долго, а страницы открываются удручающе медленно, то и индексироваться поисковиками он нормально тоже не будет.

Чтобы уменьшить размер страниц на сайте, нужно сократить объем графики, убрать лишние изображения, сократить объем загружаемых страницы путем сжатия gzip, кэшировать данные, сократить размер кода CSS и JavaScript.

Одновременно с этим можно озаботиться тем, как увеличить скорость загрузки сайта. Для этого проводятся исследования скорости загрузки страниц. Потом находятся слабые места и устраняются поштучно.

На всякий случай ловите 8 основных способов, как ускорить загрузку сайта, с примерами и картинками. А также абсолютно уникальный мануал про то, как ускорить загрузку верхней части страницы сайта – header.

Ваш домен ранее был забанен

Иногда вебмастер делает хороший сайт, регистрирует для него хороший и звучный домен, заказывает отличный дизайн, наполняет его уникальным, экспертным контентом, проводит перелинковку, выстраивает систему обратных ссылок, а поисковые системы не видят этот веб-ресурс принципиально. Как сделать чтобы сайт отображался в поисковике? Причина нелюбви Яндекса или Гугла может быть в домене, который ранее был забанен.

Чтобы решить эту задачу нужно:

- Продолжать развивать проект.

- Написать запрос в Яндекс на пересмотр возможной причины блокировки домена.

- Написать в Google, на форум, чтобы выяснить причину блокировки, а потом ее устранять.

- Развивать проект на другом домене, чтобы сэкономить время и деньги.

У вас нет sitemap на сайте

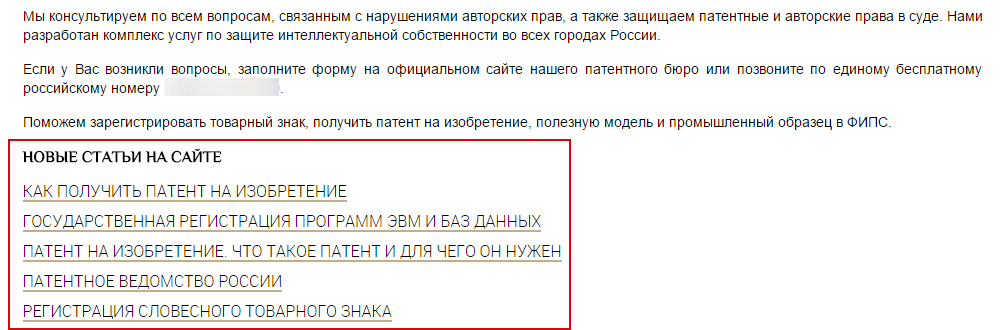

Одной из возможных причин того, что вам потребуется проверка факта индексации сайта, может быть отсутствие на нем sitemap (список веб-страниц в пределах домена). Поисковые боты, которые заходят на сайт, рандомно индексируют несколько страниц, а потом, удовлетворенные этим, уходят. Поэтому сайтмап нужно сделать. Вот одна из лучших инструкций, как создать и настроить карту сайта (sitemap.xml) для Google и Яндекс, а уже потом добавить ее в Google и Яндекс вебмастер.

Полезно! Если хотите, то ту же инструкцию, как создать XML карту сайта, можно посмотреть для видео.

Это отдельный, масштабный, как пирамида Хеопса и Великая Китайская стена взятые вместе, кусок работы по созданию карты сайта для новостей или другого динамического информационного контента. Для блока новостей делают собственную XML карту сайта, потом отправляют запрос в Новости Google и добавляют ее в news.google.com, чтобы поисковые роботы находили и индексировали такой контент еще быстрее.

Для блока новостей делают собственную XML карту сайта, потом отправляют запрос в Новости Google и добавляют ее в news.google.com, чтобы поисковые роботы находили и индексировали такой контент еще быстрее.

Кроме того, собственная карта сайта – Image sitemap XML создается для изображений. Она нужна, чтобы обеспечить быстрое, правильное, естественное индексирование картинок. Ловите детальный мануал, как создать XML карту сайта для изображений.

Хотите узнать, как с помощью Serpstat оптимизировать сайт?

Нажимайте на космонавта и заказывайте бесплатную персональную демонстрацию сервиса! Наши специалисты вам все расскажут! 😉

Почему сайт не индексируется в Гугле?

Первейшая причина – поисковая система Гугл просто «не видит» ваш сайт. Ей нужно помочь – вручную проиндексировать сайт. Кроме того, возможны ошибки сканирования поисковыми роботами, неприятие Гуглом языков AJAX/JavaScript, наличие на сайте дублированного контента или забаненный ранее домен.![]()

Почему не индексируются страницы сайта?

Одна из самых распространенных причин — страницы сайта закрыты в robots.txt.

Как часто Гугл индексирует сайт?

Google проводит индексацию постоянно – поисковые роботы загружают страницы сайта, а потом выкладывают их в обновленный индекс.

Выводы

Индексация сайта — один из первейших моментов в деле поискового продвижения сайта. Если сайт поисковики не видят, то ищем причину, а потом ее устраняем. В идеале, лучше не допускать проблем с индексацией сайта вообще.

Финальный чек-лист, почему сайт не индексируется в Гугле?

- Google и Яндекс пока не нашел ваш сайт. Ждем, пока увидят, или вручную ускоряем процесс индексации.

- Сайт или страницы закрыты в robots.txt. Открываем.

- Включены приватные настройки в CMS. Открываем.

- Сайт закрыт от индексации в noindex в метатегах.

Убираем noindex из метатегов.

Убираем noindex из метатегов. - Ошибки сканирования. Ищем одну из трех известных ошибок сканирования: ошибки в настройках сервера, сбои CMS, изменение структуры URL. Устраняем.

- Сайт заблокирован в .htaccess — проверяем файл .htaccess., удаляем из него страницы и папки, которые нуждаются в индексации.

- Хостинг или сервер работает нестабильно — отслеживаем проблему, меняем хостинг.

- Проблемы с AJAX/JavaScript – вручную настраиваем все для поиска AJAX и JavaScript и уговариваем Гугл проиндексировать сайт (страницы).

- У вас на сайте много дублированного контента, находим и удаляем дубли.

- Очень медленная скорость загрузки сайта, облегчаем (сжимаем) контент.

- Ваш домен ранее был забанен – пишем запрос на апелляцию или развиваем ресурс на другом, чистом, домене.

- Сайт лишен sitemap – нужно сделать и добавить сайтмап в Google и Яндекс вебмастер.

Чтобы быть в курсе всех новостей блога Serpstat, подписывайтесь рассылку. А также вступайте в чат любителей Серпстатить

А также вступайте в чат любителей Серпстатить

Сэкономьте время на изучении Serpstat

Хотите получить персональную демонстрацию сервиса, тестовый период или эффективные кейсы использования Serpstat?

Оставьте заявку и мы свяжемся с вами 😉

Мнение авторов гостевого поста может не совпадать с позицией редакции и специалистов компании Serpstat.

Оцените статью по 5-бальной шкале

5 из 5 на основе 3 оценок

Нашли ошибку? Выделите её и нажмите Ctrl + Enter, чтобы сообщить нам.

Рекомендуемые статьи

SEO

Анастасия Сотула

Как оптимизировать плотность ключевых слов

SEO

Инна Arsa

Голосовой поиск: как получать больше трафика из мобильной выдачи

SEO +1

Анастасия Сотула

Топ-20 SEO-мифов и заблуждений

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.

Поделитесь статьей с вашими друзьями

Вы уверены?

Спасибо, мы сохранили ваши новые настройки рассылок.

Сообщить об ошибке

Отменить

9 причин почему Google не индексирует сайт

Google не индексирует ваш сайт? Распространенная проблема, у которой есть много причин. Ниже рассмотрены 9 наиболее популярных и способы их решения.

Долгая загрузка сайта

Долго загружающиеся сайты не нравятся Google и индексируются дольше. У медленной загрузки есть множество причин. Например, слишком большое количество контента для обработки пользовательским браузером. Или использование устаревших серверов с ограниченными ресурсами.

Читайте также:

Как проверить скорость загрузки сайта и как ускорить загрузку

Проверить скорость загрузки сайта можно с помощью двух инструментов:

- PageSpeed Insights.

Этот инструмент Google анализирует скорость загрузки

сайта и дает рекомендации для оптимизации. Хороший показатель — от 70 баллов. Чем ближе к 100, тем лучше.

Этот инструмент Google анализирует скорость загрузки

сайта и дает рекомендации для оптимизации. Хороший показатель — от 70 баллов. Чем ближе к 100, тем лучше. - WebPageTest. Этот инструмент оценивает скорость загрузки сайта и выделяет элементы, которые ее снижают.

Более быстрый хостинг или использование CDN (сеть доставки содержимого) увеличат скорость загрузки сайта.

Присоединяйтесь к нашему Telegram-каналу!

- Теперь Вы можете читать последние новости из мира интернет-маркетинга в мессенджере Telegram на своём мобильном телефоне.

- Для этого вам необходимо подписаться на наш канал.

У сайта бесконечный цикл переадресации

Бесконечный цикл переадресации — еще одна частая проблема, мешающая индексации. Она может появиться из-за банальной опечатки. Но решить ее просто.

Она может появиться из-за банальной опечатки. Но решить ее просто.

Если используется WordPress, файл .htaccess поможет найти страницы, с которых перенаправляется трафик. Просто вставьте в поиск Redirect 301, чтобы обнаружить все файлы с перенаправлением. Исправьте опечатки. Если присутствует 302 редирект, его стоит поменять на 301.

Читайте также:

Как сделать редирект — подробное руководство по настройке и использованию

С помощью инструмента Screaming Frog можно найти дополнительные ошибки на сайте. После их устранения воспользуйтесь Google Search Console, чтобы повторно подать запрос на индексацию. Обычно процесс занимает около семи дней.

Использование плагинов, блокирующих Googlebot

Некоторые плагины могут блокировать работу поискового робота Googlebot. В таком случае поисковая система не сможет просканировать сайт. Если вы настраиваете файл robots. txt через одноименный плагин для WordPress, Googlebot будет заблокирован.

txt через одноименный плагин для WordPress, Googlebot будет заблокирован.

Самостоятельная настройка файла решит проблему. Robots.txt должен размещаться в корневой папке сайта и быть доступен по адресу ваш_домен.ru/robots.txt. Убедитесь, что в файле нет косой черты в строчке Disallow:

User-agent: *

Disallow: /

Наличие косой черты «/» блокирует все страницы из корневой папки сайта. Чтобы поисковый робот мог проиндексировать весь сайт, ее нужно убрать.

Читайте также:

Robots.txt: что это, как создать и правильно настроить

Для рендеринга используется JavaScript

В процессе рендеринга веб-страницы браузер преобразует код в картинку. Использование JavaScript не всегда приводит к проблемам с индексацией. Но они точно возникнут, если JavaScript используется для маскировки.

Маскировка — это прием, при котором сайт предоставляет пользователям и поисковым системам неодинаковый контент или разные URL. Это нарушение рекомендаций Google.

Это нарушение рекомендаций Google.

Иногда рендерная и сырая версия страницы отличаются друг от друга, что может восприниматься как маскировка. В таком случае индексация остановится. Скрытие файлов JavaScript и CSS также не позволит Google проиндексировать сайт.

В Google Search Console не указаны все варианты домена

В Google Search Console должны быть указаны и верифицированы все варианты вашего домена. Это особенно важно, если вы мигрируете с http:// на https://.

Установлены метатеги noindex, nofollow

Установка метатегов noindex, nofollow бывает необходима. Но если метатеги появляются не на той странице или применяются ко всему сайту, он не будет индексироваться.

Читайте также:

4 метатега, которые стоит использовать: Robots, Rel canonical, Hreflang, Schema.org

Решить эту проблему просто — поменяйте все метатеги noindex, nofollow на index, follow.

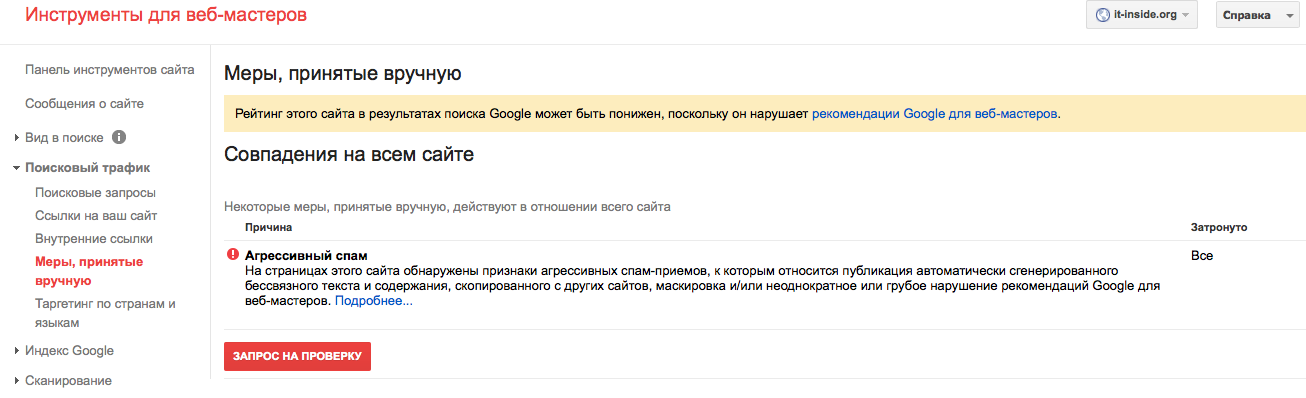

Штрафные санкции со стороны Google

За нарушение рекомендаций Google может пессимизировать сайт. Штрафные санкции накладываются как вручную, так и автоматически. Например, после обновления алгоритмов.

Да за что?!До тех пор, пока нарушения не устранены, сайт не будет индексироваться. Чаще всего штрафы накладываются за наличие:

- вредоносного и нежелательного ПО на сайте;

- скрытого текста и ссылок;

- маскировки;

- скрытой переадресации;

- нерелевантных ключевых слов;

- избыточного количества ключевых слов;

- дублированного контента.

Сайт не адаптирован под мобильные платформы

Адаптация сайта под мобильные платформы — критический момент. С 1 июля 2019 года Google при индексации отдает приоритет мобильному контенту.

Необязательно вносить много изменений. Бывает достаточно плавающей сетки и медиавыражений. Под плавающей сеткой понимается макет сайта, адаптирующийся под меняющиеся размеры экрана или устройство пользователя. А медиавыражения позволяют CSS адаптироваться под параметры или характеристики устройства.

А медиавыражения позволяют CSS адаптироваться под параметры или характеристики устройства.

Специальный инструмент Google позволит проверить оптимизацию для мобильных устройств. Он подскажет, не было ли нагромождений кода при написании сайта, что также влияет на индексацию.

Проблемы с техническим SEO

Техническое SEO — важный элемент при работе с сайтом. Именно техническая оптимизация помогает поисковым системам сканировать, понимать и индексировать страницы.

С помощью грамотно выполненного технического SEO можно идентифицировать проблемы с основными интернет-показателями, сканированием и индексацией. Порой может казаться, что проще запустить новые сайт, но качественное техническое SEO поможет решить проблемы.

Технический аудит сайта

- Наличие дублей страниц, безопасность, корректность всех технических параметров: переадресаций, robots.

txt, sitemap.xml скорость загрузки и др.

txt, sitemap.xml скорость загрузки и др. - Техническая оптимизация — один из основных этапов в продвижении.

Поисковые роботы, вперед!

Чтобы сайт был успешным, важно размещать на нем хороший контент, работать с техническим SEO и создавать качественные обратные ссылки. Но все это будет впустую, если он не индексируется.

Убедитесь, что все проблемы с индексацией решены, и тогда Google отблагодарит вас хорошим трафиком.

Почему сайт не индексируется и что с этим делать

Чтобы пользователи узнали о вашем сайте и, к примеру, совершили покупку или прочитали статью — он должен отображаться в поисковых системах, вроде Google и Яндекс. Для этого каждый ресурс проходит индексацию. Этот процесс отличается от ранжирования тем, что при индексации сайт просто попадает в базу данных поисковиков, а при ранжировании — встает на конкретное место.

Мы спросили мнение у экспертов в области веб-оптимизации и рассказали в статье о том, как происходит индексация сайтов и что делать, если ваши страницы не индексируются поисковиками.

Что значит индексация сайта и почему она важна

«Индексирование сайта — это процесс, в ходе которого поисковые системы получают информацию о страницах ресурса. Полученные данные хранятся в базе, которую называют поисковым индексом. Так Яндекс, Google и другие поисковики узнают, что ваш сайт существует и наполнен полезным контентом. Индексация нужна для того, чтобы юзеры могли найти ваши страницы при поиске», — так определяет индексацию Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group.

Эксперт Роман Огрин добавляет, что индексация — важный этап запуска любого проекта, на котором планируется активное SEO-продвижение или есть планы по развитию органического трафика. Исключения составляют рекламные форматы, вроде контекстной рекламы, — для них процесс индексации не является ключевым.

Для индексирования поисковик, например Яндекс или Google, отправляет на сайт роботов, они считывают код и регулярно посещают страницы ресурса. Периодичность зависит от того, как часто меняется контент, от количества страниц и объема трафика.

Как происходит индексация сайта

Анастасия Шестова, руководитель направления поискового продвижения в ИнтерЛабс, сравнивает индексацию с добавлением книги в библиотеку: когда определен жанр, автор и название книги, она занимает свое место в библиотеке, и читатель может ее найти. Поэтому индексацию сайта вернее рассматривать как двухэтапный процесс: сначала идет сканирование страниц, затем — их обработка.

Сканирование страниц

Сканирование страниц — это основная задача поискового робота. Когда он попадает на новую страницу, то получает два набора данных:

- Содержание, информацию о сервере и служебные данные.

- Перечень ссылок на страницах.

Затем робот передает данные в обработку, а после — сохраняет в базе. Самый простой способ индексации страниц в рамках домена — создание карты сайта sitemap.xml.

Чтобы Google и Яндекс увидели ваш сайт, нужно cначала добавить его в сервисы, а затем прикрепить ссылку на файл Sitemap в Google Search Console и Яндекс. Вебмастере. Это специальные сервисы для веб-мастеров, которые помогают работать с индексацией.

Вебмастере. Это специальные сервисы для веб-мастеров, которые помогают работать с индексацией.

Чтобы добавить файл Sitemap в Google Search Console, зайдите в сервис, добавьте свой сайт и перейдите в раздел «Сканирование». В пункте «Файлы Sitemap» выберите «Добавить файл Sitemap» и вставьте ссылку на файл Sitemap.

В Яндекс.Вебмастере путь похож: зайдите в ваш аккаунт, выберите нужный сайт. Затем в левом меню нажмите на раздел «Индексирование» и выберите вкладку «Файлы Sitemap». В строку «Добавить файл Sitemap» вставьте ссылку файла и нажмите «Добавить». Кстати, если вы внесли изменения в карту сайта, то просто отправьте карту на перепроверку, нажав на стрелочки рядом с файлом Sitemap.

Обработка страниц

После сбора роботами информация проходит обработку и потом попадает в базу данных. Это необходимо для ускорения дальнейшего поиска.

В начале программа формирует страницу со всем содержимым: скрипты, эффекты, стили. Важно, чтобы робот имел полный доступ ко всем файлам, потому что без них индексатор не сможет понять структуру.

Вы можете посмотреть, одинаково ли видят страницу пользователи и поисковой робот. Для этого зайдите в Google Search Console, выберите отчет «Посмотреть как Googlebot» в разделе «Сканирование».

Затем робот анализирует текст страницы: упрощает слова и определяет частоту упоминания ключевого слова, проверяет уникальность. Так, если ваш контент уже индексировали в интернете, то у страниц будет низкая уникальность. Значит, робот может не добавить их в поисковый индекс. Поэтому важно наполнять свой сайт уникальным и полезным контентом.

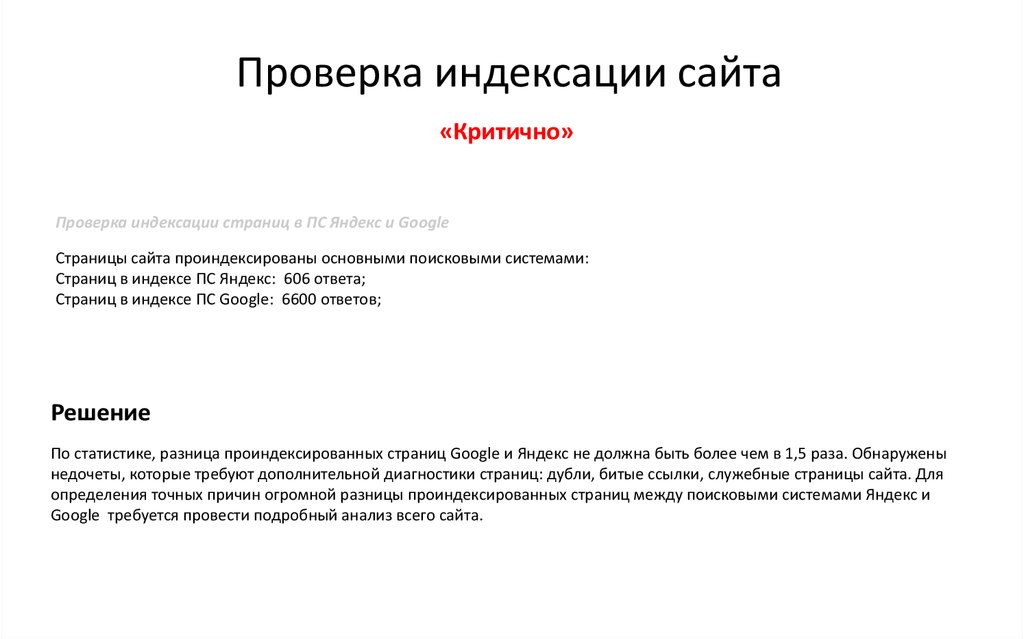

Как проверить индексацию

Эксперты выделяют три способа, чтобы проверить, отображается ли сайт в поисковиках: запрос в поисковой системе, использование бесплатных сервисов для автоматической проверки и использование сервисов для веб-мастеров.

«Если значения проиндексированных страниц в Google и Яндекс сильно различаются, это свидетельствует о проблемах в оптимизации сайта», — Дарья Каблаш, основатель маркетингового агентства Dvizh

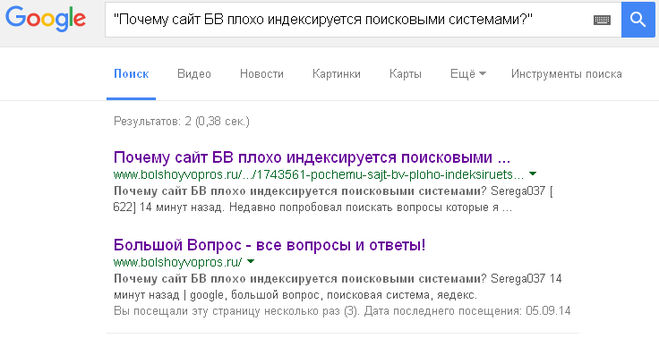

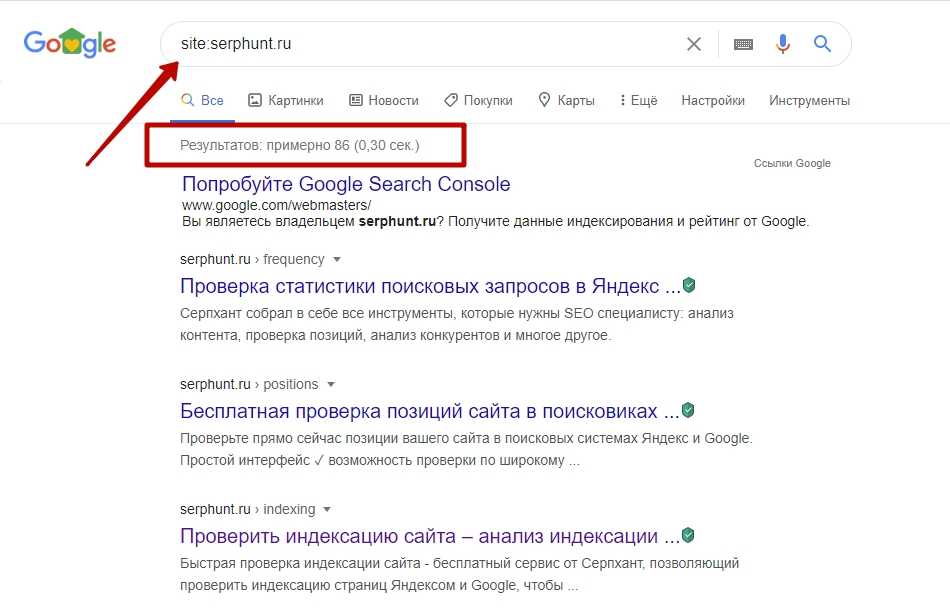

Поисковая строка

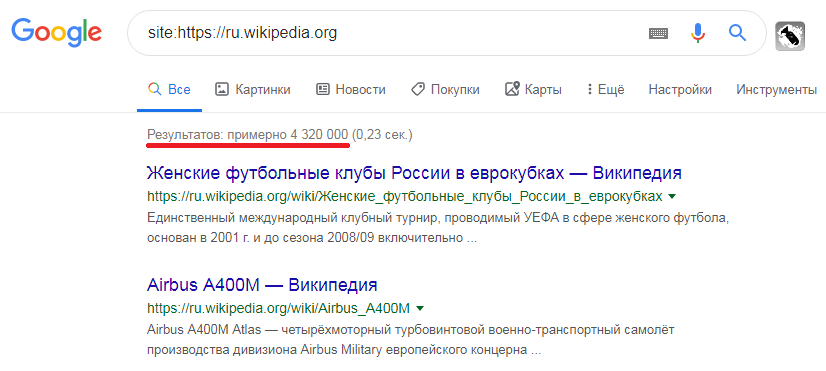

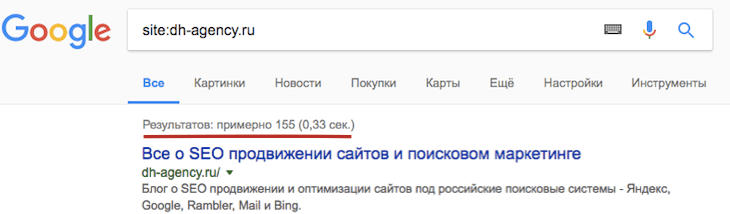

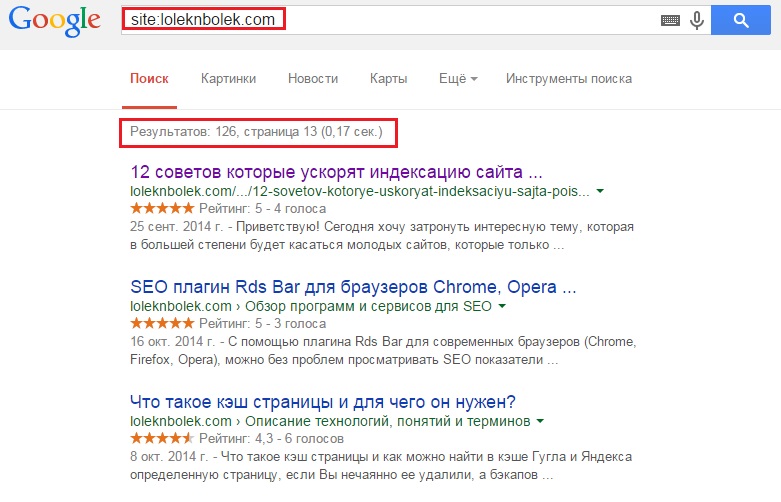

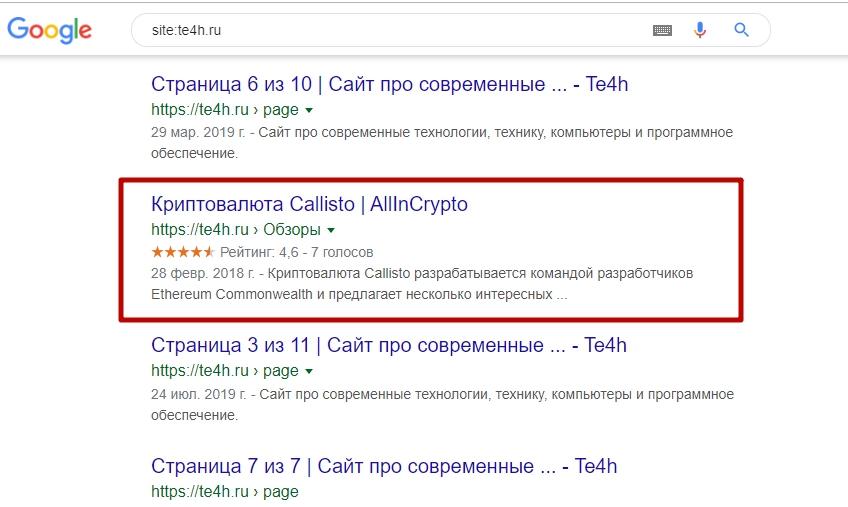

Роман Огрин, руководитель группы оптимизации в Kokoc Group, называет специальные операторы самым быстрым и простым способом проверки индексации. Яндекс и Google поддерживают оператор site, который помогает отображать проиндексированные страницы. Базовый синтаксис использования: site:sitename.com

Яндекс и Google поддерживают оператор site, который помогает отображать проиндексированные страницы. Базовый синтаксис использования: site:sitename.com

Например: site:gosuslugi.ru

Но поисковые системы могут ограничить работу этих операторов для снижения нагрузки. Поэтому рекомендуют использовать дополнительные способы для проверки индексации.

Бесплатные плагины

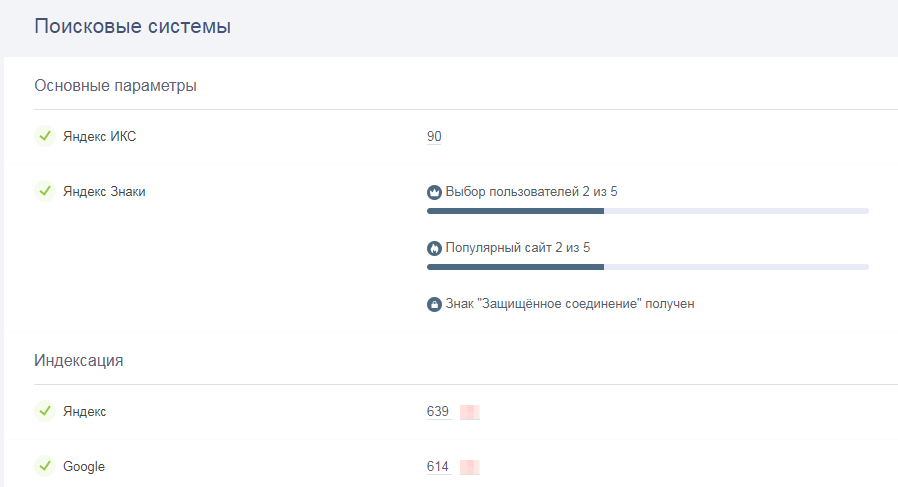

«Можно использовать специальные бесплатные сервисы, например, be1.ru и pr-cy.ru. Для проверки введите адрес сайта в специальную строку и нажмите «Проверить». Обычно такие сервисы, помимо количества страниц в индексе популярных поисковиков, предоставляют еще много интересных данных», — Николай Полушкин, директор веб-студии DIUS.

Веб-сервисы Яндекс.Вебмастер и Google Search Console

Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group, считает веб-сервисы поисковых систем самым достоверным источником информации о наличии страницы в индексе. В этих инструментах можно получить данные о количестве, динамике индексации, причинах удаления или включения страницы в базу данных, а также многое другое. Минус в том, что доступы к этой информации могут получить только владельцы сайта или те, у кого есть права владельцев.

Минус в том, что доступы к этой информации могут получить только владельцы сайта или те, у кого есть права владельцев.

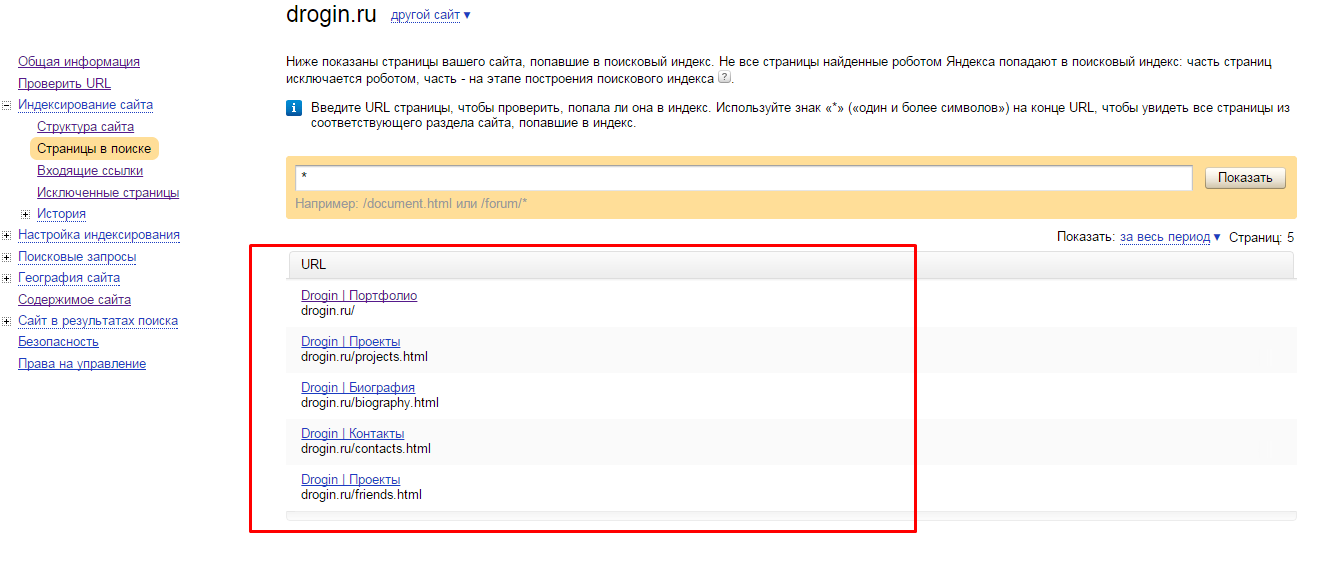

Эксперт Роман Огрин рассказывает, как именно посмотреть индексацию в Яндекс.Вебмастере и Google Search Console. Оба сервиса сначала надо «привязать» к исследуемому домену и только потом смотреть точную статистику.

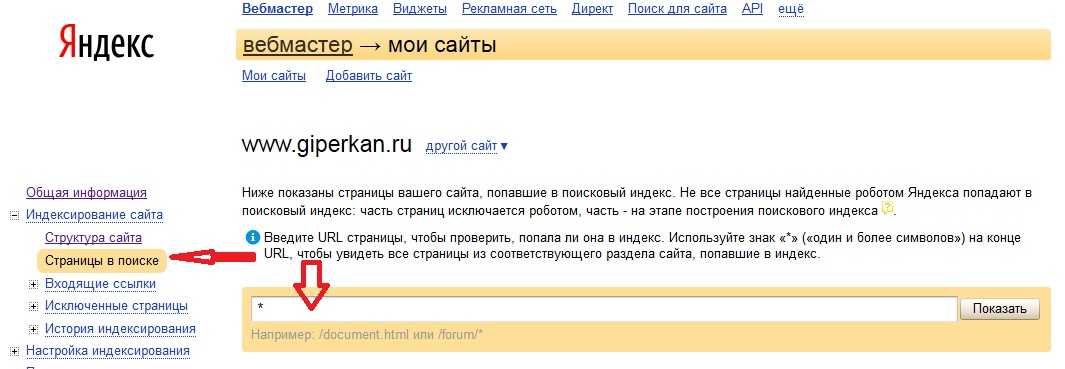

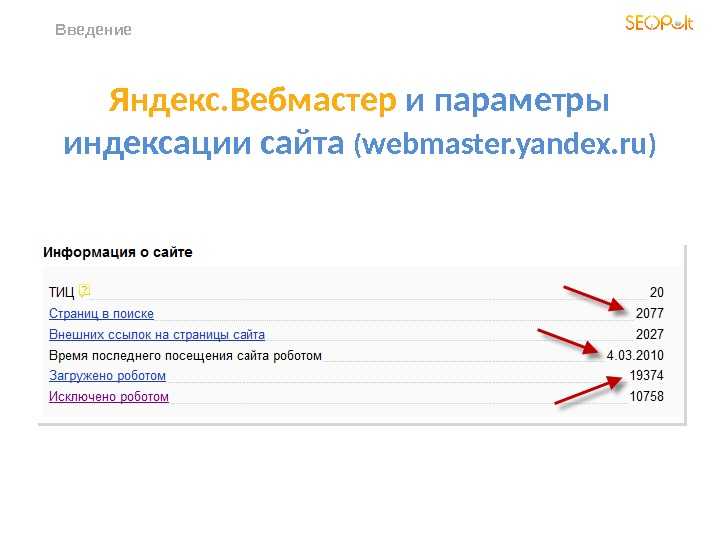

В Яндекс.Вебмастере есть раздел «Индексирование» с подразделом «Страницы в поиске». По клику на вкладку «Все страницы» сервис выдает список проиндексированных на данный момент документов. В Search Console аналогичный инструмент — отчет «Покрытие».

Помимо простого анализа страниц в индексе, оба сервиса предоставляют много полезной статистики. Эта информация поможет сделать правильные выводы при проблемах с индексацией.

Например, посмотрите, совпадает ли количество проиндексированных страниц с количеством страниц вашего сайта. Если у вас 240 страниц, а в индексе только 100, это означает, что есть проблемы с индексацией, ведь поисковая система не знает о большей части контента.

Управление индексацией сайта

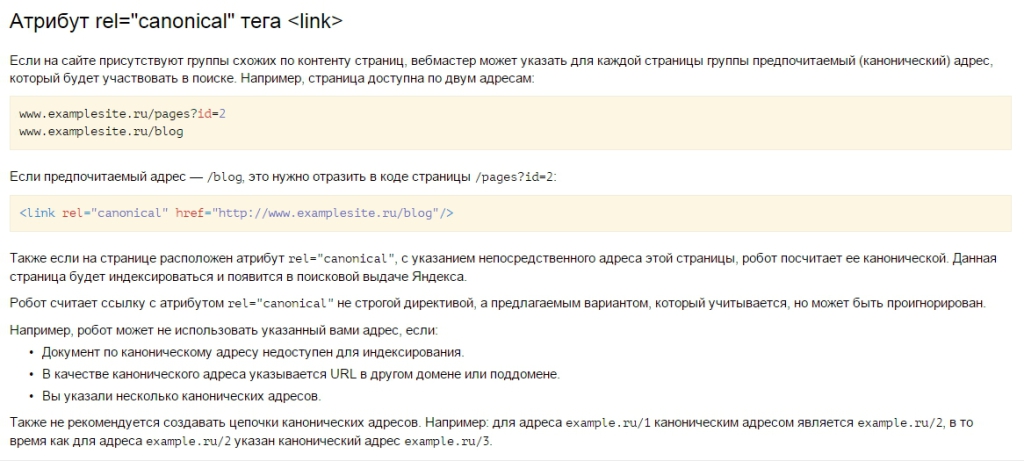

Вы можете сами задать параметры индексирования для роботов поисковых систем. Например, настройка канонического адреса необходима, если есть страницы с одинаковым содержанием. Она позволяет указать, какая из них приоритетна для индексации.

Текстовый файл robots.txt также позволяет управлять поисковыми роботами с помощью директив.

- Директива Disallow закрывает сайт или конкретные страницы от индексации роботами.

- User-Agent указывает поисковую систему для индексации по написанной инструкции.

- Crawl-delay задает частоту обращения роботов к ресурсу. Работает для Яндекса.

- Clean-param закрывает индексирование с конкретными динамическими параметрами.

- Директива Allow разрешает роботам индексирование отдельных страниц.

Что делать, если сайт не индексируется

Есть множество причин, почему сайт не индексируется. Эксперт Сергей Шабуров условно разделяет причины на технические и контентные. Ниже рассмотрим основные из них с примерами из опыта специалистов.

Ниже рассмотрим основные из них с примерами из опыта специалистов.

Технические причины

Сайт может быть случайно закрыт от сканирования роботами или из-за ошибки разработчиков. Это можно определить, если проверить:

- Директиву Disallow в файле robots.txt. Как мы писали выше, эта директива закрывает конкретные страницы от индексации.

- Мета-теги в разделе <head> HTML-документа, например, <meta name=»robots» content=»noindex» />. Они определяют отношение к сканированию контента в документе.

- HTTP-заголовок X-Robot-Tag — информация о запрете или разрешении индексации сайта в HTTP-заголовках ответа сервера.

- Код ответа сервера. В индекс попадают только доступные страницы с кодом ответа сервера 200 Ок, а ресурсы с другими кодами ответа удаляются. Изменение кода ответа — один из способов управления индексацией.

- Настройки сервера. Для разных IP адресов, User-agent и других параметров серверная часть ресурса может регулировать как скорость, так и саму отдачу информации о странице и ее содержимом.

- Наличие входящих внутренних или внешних ссылок. Индекс может исключать такие страницы.

- Низкий трафик. Это может быть следствием малополезной страницы или отсутствием семантического спроса со стороны пользователей по данному контенту.

Николай Полушкин, директор веб-студии DIUS, делится недавним случаем из практики. «Пришел сайт на бесплатный аудит. Клиент жаловался на резкую просадку трафика. SEO-специалист сразу открыл файл robots.txt и нашел строчку Disallow. Мы сообщили об этом клиенту и объяснили, что сайт закрыт от индексации, и страницы постепенно удаляются из поиска. Заказчик был удивлен и попросил выяснить, кто и когда это сделал. Недавно компания делала редизайн и наш специалист предположил, что страницы на время работ закрыли от индексации, а потом забыли убрать запрещающую директиву».

Контентные причины

Важно помнить, что индексация занимает некоторое время. Поэтому, если страницы нет в индексе, иногда это может значить, что роботы поисковых систем не успели до нее дойти. Либо есть ошибки в контентном наполнении страниц:

Либо есть ошибки в контентном наполнении страниц:

- Отсутствие индексируемого контента. Контент может быть реализован на технологии, которую поисковые системы не умеют считывать или плохо воспринимают к индексации. Так векторная графика, например Flash, не индексируется.

- Контент без пользы или вредный для пользователей. Сюда относят: спам, малый по объему контент, устаревшая информация, которая никогда не будет востребована, наличие вирусов, фишинга.

- Дублирующийся контент. Поисковые системы стараются не индексировать или удалять из выдачи страницы, которые содержат повторяющуюся информацию.

«У нас была такая ситуация с кулинарной онлайн-школой. В Google сайт показал хорошие результаты уже в первый месяц работы и вышел в ТОП-3 по прямым запросам. Но в Яндексе страницы вообще отсутствовали.

Чтобы узнать причину, мы зарегистрировали сайт в Яндекс.Вебмастере и отправили на проверку. Результаты показали критическую ошибку. Дело было в том, что на ресурсе дублировались страницы. Владельцы школы публиковали для разных таргетологов страницы с одинаковым контентом, но разными ссылками. Яндекс видел в этом неуникальный контент и не индексировал страницы.

Владельцы школы публиковали для разных таргетологов страницы с одинаковым контентом, но разными ссылками. Яндекс видел в этом неуникальный контент и не индексировал страницы.

Мы удалили дублирующиеся страницы, перейдя на utm-метки, и отправили сайт на переиндексацию. Через несколько дней проблема решилась, сайт стал отображаться в Яндексе», — Дарья Каблаш, основатель маркетингового агентства Dvizh.

Иные причины

Более редкие случаи неиндексации могут быть связаны, например, с фильтром «для взрослых».

Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group, приводит свежий пример из практики. «Сайт одного из российских операторов мобильной связи перестал ранжироваться по навигационному запросу: «<Название оператора> тарифы» в Яндексе. В выдаче присутствовали побочные сайты, а ресурс оператора отсутствовал. Это неслыханная вещь, при учете, что целевая страница и все остальные были в индексе по данным Яндекс.Вебмастера. По данному запросу сайт должен был занимать как минимум несколько строчек поисковой выдачи. Проблема выявилась при переключении настроек поиска с умеренного фильтра на фильтр без ограничений.

Проблема выявилась при переключении настроек поиска с умеренного фильтра на фильтр без ограничений.

Это значит, что страница перешла из основного индекса в специальный “Фильтр для взрослых” или «Adult-фильтр». После обращения в службу поддержки Яндекса обнаружилось, что это ошибка на стороне поисковой системы, так как на странице не было какой-либо специфичной информации».

Также возможен редкий случай неиндексации — «плохая история» домена. В этом случае был куплен домен, на котором ранее был поисковый спам или adult-ресурс, поэтому сайт сразу может быть под фильтром.

«В нашей практике был пример сайта на домене, на котором ранее был размещен белый каталог сайтов. Ресурс индексировался нормально и потом резко пропадал из индекса поисковых систем. Помогли письма в техподдержку Яндекса и отправка страниц на принудительную переиндексацию. Но даже после этого периодически сайт продолжал полностью вылетать из индекса, за этим приходилось отдельно следить. Чтобы таких моментов не было, перед покупкой домена лучше всего проверять его историю», — Анастасия Шестова, руководитель направления поискового продвижения в ИнтерЛабс.

Заключение

Без индексации пользователи не увидят ваш сайт даже при прямом поисковом запросе. Поэтому индексация — обязательный процесс для ресурсов, которым важен органический трафик.

Во время индексации роботы сканируют и обрабатывают информацию на страницах, заносят ее в специальную базу данных — поисковый индекс. Можно легко проверить, есть ли ваши страницы в поисковой выдаче, например, в Google. Самый надежный способ — использование сервисов для веб-мастеров: Яндекс.Вебмастер и Google Search Console.

Часто сайты, которые должны быть проиндексированы, все равно не попадают в поиск. В таком случае нужно проанализировать возможные технические и контентные причины. В редких случаях работы могут убрать ресурс из выдачи из-за ошибки на стороне поисковой системы или плохой истории домена.

Источник

Предыдущий пост Назад Следующий пост Вперед

Это нормально, что страницы сайта не индексируются

Джон Мюллер из Google ответил на вопрос об индексации, предложив информацию о том, как общее качество сайта влияет на шаблоны индексации. Он также предположил, что в рамках нормы не индексируется 20% контента этого конкретного сайта.

Он также предположил, что в рамках нормы не индексируется 20% контента этого конкретного сайта.

Страницы обнаружены, но не просканированы

Человек, задавший вопрос, предоставил справочную информацию о своем сайте.

Особое беспокойство вызывал заявленный факт, что сервер был перегружен и могло ли это повлиять на количество страниц, индексируемых Google.

Когда сервер перегружен, запрос веб-страницы может привести к ответу с ошибкой 500. Это связано с тем, что когда сервер не может обслуживать веб-страницу, стандартным ответом является сообщение 500 Internal Server Error.

Человек, задавший вопрос, не упомянул, что консоль поиска Google сообщила, что робот Googlebot получил 500 кодов ответов об ошибках.

Таким образом, если Googlebot не получил ответ с ошибкой 500, проблема перегрузки сервера, вероятно, не является причиной того, что 20% страниц не индексируются.

Человек задал следующий вопрос:

«20% моих страниц не индексируются.

Пишет, что они обнаружены, но не просканированы.

Связано ли это с тем, что он не просканирован из-за потенциальной перегрузки моего сервера?

Или это связано с качеством страницы?»

Бюджет на сканирование не всегда Почему на небольших сайтах есть неиндексированные страницы

Джон Мюллер из Google предложил интересное объяснение того, как общее качество сайта является важным фактором, определяющим, будет ли робот Googlebot индексировать больше веб-страниц.

Но сначала он обсудил, что краулинговый бюджет обычно не является причиной того, что страницы остаются неиндексированными для небольшого сайта.

Джон Мюллер ответил:

«Возможно, немного того и другого.

Таким образом, обычно, если мы говорим о небольшом сайте, то в основном это не тот случай, когда мы ограничены возможностями сканирования, что является частью бюджета сканирования.

Если мы говорим о сайте с миллионами страниц, то я бы рассмотрел вопрос о краулинговом бюджете.

Но на небольших сайтах, наверное, меньше».

Связанный: Бюджет сканирования: все, что вам нужно знать для поисковой оптимизации

Общее качество сайта определяет индексацию

Затем Джон подробно рассказал о том, как общее качество сайта может повлиять на то, какая часть веб-сайта просматривается и индексируется.

Эта часть особенно интересна, потому что дает представление о том, как Google оценивает сайт с точки зрения качества и как общее впечатление влияет на индексацию.

Мюллер продолжил свой ответ:

«Что касается качества, когда дело доходит до понимания качества веб-сайта, это то, что мы очень сильно учитываем в отношении сканирования и индексации остальной части. веб-сайт.

Но это не обязательно связано с отдельным URL.

Таким образом, если у вас есть пять страниц, которые в данный момент не проиндексированы, это не значит, что эти пять страниц мы считаем низкокачественными.

Более того… в целом, мы считаем, что этот веб-сайт может быть немного более низкого качества. И поэтому мы не будем уходить и индексировать все на этом сайте.

Потому что, если у нас не будет проиндексирована эта страница, мы на самом деле не узнаем, высокое это качество или низкое.

Я бы выбрал именно это направление… если у вас небольшой сайт и вы видите, что значительная часть ваших страниц не индексируется, я бы сделал шаг назад и попытался пересмотреть общее качество веб-сайта и не уделяйте столько внимания техническим вопросам для этих страниц». 9

Технические факторы и индексация способ индексации.

Мюллер заметил:

«Потому что я думаю, что современные сайты по большей части технически разумны.

Если вы используете обычную CMS, то действительно сложно сделать что-то не так.

И часто это больше вопрос общего качества.

Связанный: 5 наиболее распространенных проблем индексации Google в зависимости от размера веб-сайта

Это нормально, что 20% сайта не индексируются как то, что находится в пределах нормы.

У Мюллера больше доступа к информации о том, сколько сайтов обычно не индексируется, поэтому я верю ему на слово, потому что он говорит с точки зрения Google.

Мюллер объясняет, почему страницы могут не индексироваться:

«Что касается индексации, то это совершенно нормально, что мы не индексируем все, что находится за пределами веб-сайта.

Итак, если вы посмотрите на любой более крупный веб-сайт или даже на любой веб-сайт среднего или меньшего размера, вы увидите колебания индексации.

Он будет расти и падать, и мы никогда не будем индексировать 100% всего, что есть на веб-сайте.

Итак, если у вас есть сотня страниц и (я не знаю) 80 из них индексируются, то я не вижу в этом проблемы, которую нужно исправить.

Иногда так бывает на данный момент.

И со временем, когда вы наберете 200 страниц на своем веб-сайте, а мы проиндексируем 180 из них, этот процент станет немного меньше.

Но всегда будет так, что мы не будем индексировать 100% всего, о чем мы знаем».

Не паникуйте, если страницы не проиндексированы

Существует довольно много информации, которой Мюллер поделился об индексации.

Возможно, технические проблемы не помешают индексации. Общее качество сайта может определить, какая часть сайта будет проиндексирована. Степень индексации сайта колеблется. Небольшим сайтам обычно не нужно беспокоиться о краулинговом бюджете. Цитата

Это нормально, что 20% сайта не проиндексированы

Посмотрите, как Мюллер обсуждает нормальную индексацию примерно с 27:26 минуты.Категория Новости SEO

8 Решения для обнаруженных — в настоящее время не проиндексированных URL-адресов

Итак, у вас есть URL-адреса со статусом «Обнаруженные — в настоящее время не проиндексированные» в Google Search Console. Я понимаю, как должно быть неприятно, что Google не просканировал и не проиндексировал ваши страницы.

Эта статья поможет вам. Я расскажу вам:

- Что означает этот статус

- Почему ваши веб-страницы могут иметь этот статус

- Как исправить веб-страницы с этим статусом

Пристегнуться; давайте разместим ваш контент на странице результатов поисковой системы Google (SERP).

1 Что означает статус «Обнаружено – в настоящее время не проиндексировано»?

2 8 решений для обнаруженных — в настоящее время не проиндексированных URL-адресов

2.1 Проблемы с качеством контента

2.1.1 Как вы решаете проблемы с качеством контента?

2.2 Проблемы с внутренними ссылками

2.2.1 Как вы решаете проблемы с внутренними ссылками?

2.3 Сканирующий бюджет

2.3.1 Как вы решаете проблемы с краулинговым бюджетом?

2,4 Когда оптимизировать Обнаруженные — в настоящее время не проиндексированные страницы

2.

4.1 Инструмент проверки URL

2,5 Подведение итогов

Обнаружен — в настоящее время не проиндексирован — это означает две вещи. Один, Google нашел вашу страницу. Два, В настоящее время Google не просматривал и не индексировал вашу страницу.

На странице справки Google Search Console указана причина:

Как правило, Google хотел просканировать URL-адрес, но ожидалось, что это приведет к перегрузке сайта; поэтому Google перепланировал сканирование. Вот почему дата последнего обхода в отчете пуста.

источник: Отчет о покрытии индекса Google

Итак, Google знает о вашей веб-странице, но решает не сканировать ее или еще не добрался до нее.

Не беспокойтесь. Это не означает, что ваш контент никогда не будет просканирован и проиндексирован. Как указано в документации Google, возможно, Google вернется к сканированию вашей страницы позже без каких-либо действий с вашей стороны.

Однако изменение графика сканирования Google является лишь одной из нескольких возможных причин этой проблемы. Давайте рассмотрим каждую возможную причину «Обнаружено — в настоящее время не проиндексировано» и как их устранить, чтобы улучшить SEO.

Обнаружены три причины — в настоящее время не проиндексированные URL-адреса. Это:

- Проблемы с качеством контента

- Проблемы с внутренним связыванием

- Проблемы с бюджетом сканирования

Каждая проблема имеет разные решения. Давайте посмотрим на них.

Проблемы с качеством контента

Google не может сканировать и индексировать все в Интернете. Каждый сайт должен соответствовать стандарту качества, чтобы быть в ходу. Google сосредоточится на сканировании страниц более высокого качества, а может вообще не сканировать низкокачественные страницы.

Итак, если ваш контент не просканирован и не проиндексирован, вам может потребоваться решить его качество.

Это относится не только к страницам, отмеченным как обнаруженные — в настоящее время не проиндексированные; речь может идти и о качестве всего сайта. Джон Мюллер из Google упомянул, что обнаружение – в настоящее время не проиндексировано может быть вызвано проблемой качества контента на всем сайте.

Как устранить проблемы с качеством контента?

Вы не можете точно знать, как Google оценивает качество вашего сайта. Но есть несколько вещей, которые вы можете сделать, чтобы начать решать эту проблему.

Решение 1. Прочтите Руководство по оценке качества

- Ознакомьтесь с Руководством по оценке качества.

- Убедитесь, что каждая затронутая страница содержит уникальный контент.

Я рекомендую вам ознакомиться с Руководством по оценке качества Google. Руководство по оценке качества подробно описывает, как оценивать качество контента веб-страницы.

Наша статья о правилах оценки качества подытоживает эти правила.

Просмотрите его, чтобы лучше понять, что такое качественный веб-контент в соответствии с определением Google. Затем вы можете применить концепцию качества Google к своим страницам.

Если вы хотите глубже погрузиться в тему, ознакомьтесь с нашей статьей о E-A-T. Это понятие используется в Руководстве по оценке качества для определения компетентности, авторитетности и надежности веб-страницы.

Решение 2. Убедитесь, что ваш контент уникаленGoogle может игнорировать ваши URL-адреса, если сочтет их дубликатами. Поскольку ресурсы Google ограничены, он уделяет особое внимание сканированию (и индексированию) наиболее ценных URL-адресов. Это влечет за собой наличие уникального контента, нацеленного на конкретное намерение пользователя.

Проверьте уязвимые URL-адреса, чтобы убедиться, что:

[…] вы не случайно генерируете URL-адреса с разными шаблонами URL-адресов, […] такие вещи, как параметры, которые у вас есть в вашем URL-адресе, верхний и нижний регистр, все эти вещи могут привести к дублированию контента.

И если мы обнаружим много таких повторяющихся URL-адресов, мы можем подумать, что нам на самом деле не нужно сканировать все эти дубликаты, потому что у нас уже есть некоторая вариация этой страницы.

источник: Джон Мюллер

Подводя итог тому, что сказал Джон Мюллер, дважды проверьте свой веб-сайт на наличие дублирующегося контента. Если у вас есть повторяющийся контент, ознакомьтесь с нашей статьей о том, как оптимизировать повторяющийся контент. Если у вас много похожих URL-адресов, рассмотрите возможность использования канонических тегов. Эти теги говорят Google индексировать только основную версию вашей страницы.

Помните, что Google может игнорировать неправильно созданные канонические теги. Если Google игнорирует ваш канонический тег, вы можете заметить это благодаря статусу «Дубликат, Google выбрал другой канонический тег, чем пользовательский» в GSC.

Просмотрите список затронутых URL-адресов и убедитесь, что каждая страница содержит уникальный контент.

Это повысит вероятность того, что ваша страница будет просканирована и проиндексирована. Кроме того, это улучшит качество вашего сайта и повысит удовлетворенность пользователей.

Проблемы с внутренними ссылками

Робот Googlebot переходит по внутренним ссылкам, чтобы обнаруживать различные страницы на вашем сайте и понимать их связи. Внутренние ссылки также помогают распространять PageRank — сигнал о важности страницы, используемый при ранжировании.

Предположим, что Google не находит достаточное количество ссылок, ведущих на URL-адрес. В этом случае он может пропустить сканирование из-за недостаточного количества сигналов, указывающих на его важность. Google может предположить, что страницы с плохими внутренними ссылками не важны. В результате эти страницы могут попасть в статус «Обнаружено – в настоящее время не проиндексировано».

Как устранить проблемы с внутренними ссылками?

Правильная внутренняя перелинковка предполагает соединение ваших страниц для создания логической структуры.

Эта структура позволяет поисковым системам и пользователям понять иерархию ваших страниц и то, как они связаны.

Правильно используя внутренние ссылки, вы помогаете роботу Googlebot находить весь ваш контент и повышаете его шансы на высокий рейтинг. В контексте исправления обнаруженных — в настоящее время не проиндексированных, внутренние ссылки на страницы, которые не были просканированы и не проиндексированы, повышают их шансы на обнаружение Google.

Решение 3. Следуйте рекомендациям по внутренним ссылкамНекоторые из рекомендаций по внутренним ссылкам включают:

- Определите основной контент и свяжите с ним другие страницы

- Применение контекстных ссылок в вашем контенте

- Связать страницы на основе иерархии, например, связать основные страницы с дополнительными страницами и наоборот

- Не засоряйте свой сайт ссылками

- Не переоптимизируйте якорный текст

- Включите ссылки на похожие продукты или сообщения

- Добавление внутренних ссылок на непреднамеренные страницы-сироты

Хотите узнать больше? Ознакомьтесь с нашей статьей о внутренних ссылках.

Вы также можете связаться с Onely для оптимизации внутренней перелинковки.

Бюджет сканирования

Бюджет сканирования – это количество страниц, которые робот Googlebot может и хочет просканировать на веб-сайте.

Факторы, определяющие бюджет сканирования сайта:

- Ограничение скорости сканирования — сколько страниц может сканировать Google. Ограничение скорости настраивается в соответствии с возможностями вашего сервера.

- Спрос на сканирование — сколько страниц Google хочет просканировать в зависимости от важности страницы. Популярность страницы и частота обновления страницы определяют важность.

Любой веб-сайт может страдать от проблем с краулинговым бюджетом. Тем не менее, они распространены на крупных веб-сайтах. Чем больше веб-сайт, тем выше вероятность того, что страницы будут не просканированы из-за недостаточного краулингового бюджета.

Обнаружено — в настоящее время не проиндексировано, что часто является следствием проблем с краулинговым бюджетом.

Это просто — , если потребность в сканировании слишком низкая или скорость сканирования ограничена, некоторые из ваших страниц не будут сканироваться .

Многие факторы могут вызвать проблемы с краулинговым бюджетом, в том числе:

- Плохая внутренняя связь

- Разрешение Google сканировать низкокачественный контент

- Отсутствие или недостаточная карта сайта

- Ошибки при реализации редиректов

- Перегруженные серверы

- Веб-сайты с большим объемом ресурсов

Мы уже рассмотрели важность внутренних ссылок. Теперь давайте рассмотрим другие факторы, вызывающие проблемы с краулинговым бюджетом.

Как решить проблемы с бюджетом сканирования?

В связи с вышеперечисленными факторами существуют способы решения проблемы с краулинговым бюджетом. Давайте посмотрим на них.

Решение 4. Запретите Google сканировать и индексировать некачественные страницыПредоставление Google возможности просматривать весь ваш веб-сайт без ограничений имеет два негативных последствия.

Во-первых, робот Googlebot будет посещать каждую страницу вашего веб-сайта до тех пор, пока не будет исчерпан краулинговый бюджет. Если робот Googlebot сканирует некачественные страницы, он может достичь предела сканирования, прежде чем доберется до наиболее важных страниц.

Во-вторых, если вы позволите Google сканировать и индексировать некачественные страницы, он может меньше думать о качестве весь ваш сайт. Это может повредить вашему рейтингу, но также снизить спрос на сканирование, создавая порочный круг проблем с краулинговым бюджетом.

К страницам низкого качества относятся:

- Устаревший контент

- Страницы, сгенерированные окном поиска на веб-сайте

- Дублированный контент

- Страницы, созданные с применением фильтров

- Контент, созданный автоматически

- Пользовательский контент

Если вы уже боретесь с неиндексированным контентом, вам следует запретить Google сканировать и индексировать эти страницы.

Заблокируйте сканирование некачественных страниц в файле robots.txt и используйте метатег noindex для предотвращения индексации.

Необходимо определиться со стратегией индексации? Ознакомьтесь с нашей статьей о том, как создать стратегию индексации для вашего сайта.

Решение 5. Создайте оптимизированную карту сайтаОптимизированная карта сайта может помочь роботу Googlebot в процессе сканирования и индексирования. По сути, это карта, которую Google использует для просмотра вашего контента.

Но если ваша карта сайта не оптимизирована должным образом, это может негативно сказаться на вашем краулинговом бюджете и привести к тому, что робот Googlebot пропустит ваш важный контент.

Карта сайта должна содержать:

- URL-адреса, отвечающие кодами состояния 200 (ОК)

- URL-адреса без метатегов robots, которые блокируют их индексацию

- Только канонические версии ваших страниц

На приведенном ниже снимке экрана показан пример файла индекса XML Sitemap.

Если вы хотите узнать больше об оптимизации карты сайта, ознакомьтесь с этим исчерпывающим руководством по картам сайта XML.

Решение 6. Исправление переадресацийЦепочки перенаправления — это когда вы хотите перенаправить трафик со страницы A на страницу B, но сначала без необходимости перенаправляете на страницу C.

Циклы перенаправления — это когда вы создаете цепочку перенаправлений, которая начинается и заканчивается на одной и той же странице, заманивая пользователей и ботов в бесконечный цикл.

Как цепочки перенаправлений, так и циклы вынуждают Google отправлять несколько ненужных запросов на ваш сервер, что снижает ваш краулинговый бюджет.

Чтобы не тратить краулинговый бюджет на ненужные перенаправления, не ссылайтесь на перенаправленные страницы. Вместо этого обновите их, чтобы они указывали на 200 страниц OK.

Обязательно придерживайтесь лучших практик реализации перенаправлений.

Решение 7.Исправьте перегруженные серверы

Проблемы со сканированием могут возникать из-за того, что ваш сервер перегружен (отвечает медленнее, чем ожидалось). Если робот Googlebot не может посетить определенную страницу из-за перегрузки сервера, он сократит свою активность сканирования (требование сканирования). Это может привести к тому, что часть вашего контента не будет просканирована.

Google попытается повторно посетить ваш веб-сайт в будущем, но весь процесс индексации будет отложен.

Обратитесь к своему хостинг-провайдеру на предмет проблем с сервером на вашем сайте.

А пока проверьте свой отчет о статистике сканирования в Google Search Console. Откройте отчет, выберите свой домен и щелкните Среднее время ответа (мс). Это покажет вам, сколько времени требуется для загрузки вашего сервера. Скорее всего, вы заметите корреляцию между общим количеством запросов на сканирование и средним временем ответа.

Чтобы узнать больше о том, как связаны веб-производительность и краулинговый бюджет, прочитайте нашу статью о веб-производительности и краулинговом бюджете.

Решение 8. Исправьте ресурсоемкие веб-сайтыРесурсоемкие веб-сайты — еще одна причина проблем со сканированием.

Если страница требует сканирования и отображения нескольких дополнительных ресурсов (например, нескольких таблиц стилей CSS или файлов JavaScript), это оказывает особенно негативное влияние на ваш краулинговый бюджет.

Это потому, что каждый ресурс, который робот Googlebot использует для отображения вашей страницы, учитывается в вашем краулинговом бюджете.

Вам следует оптимизировать файлы JavaScript и CSS вашего сайта (основные нарушители). Оптимизация этих файлов уменьшит негативное влияние вашего кода.

СЛЕДУЮЩИЕ ШАГИ

Вот что вы можете сделать сейчас:

- Свяжитесь с нами.

- Получите от нас индивидуальный план решения ваших проблем с индексацией.

- Наслаждайтесь своим контентом в индексе Google!

Все еще не уверены, стоит ли писать нам? Прочитайте, как технические услуги SEO может помочь вам улучшить ваш сайт.

Когда оптимизировать Обнаруженные — в настоящее время не проиндексированные страницы

В некоторых случаях URL-адреса со статусом Обнаруженные — в настоящее время не проиндексированные не требуют обновления. Вам не нужно ничего делать, если:

- Количество уязвимых URL-адресов невелико, и они со временем сканируются и индексируются.

- Отчет содержит URL-адреса, которые не следует сканировать или индексировать, например, с тегами canonical или noindex. Или те, которые заблокированы от сканирования в вашем файле robots.txt.

Крайне важно проверить, должны ли ваши URL-адреса сканироваться в первую очередь. Это нормально, когда некоторые страницы помечаются как обнаруженные — в настоящее время не проиндексированные. Но если:

- Количество URL увеличивается

- Основные URL-адреса имеют статус «Обнаружено — в настоящее время не проиндексировано»

Затем вам необходимо проверить и оптимизировать затронутые URL-адреса, так как это может привести к значительному падению рейтинга и трафика.

Инструмент проверки URL

После того, как вы решили обновить свой контент и URL-адреса, вы можете запросить индексацию определенных страниц с помощью инструмента проверки URL-адресов Google.

Откройте инструмент проверки URL в Google Search Console. Вставьте URL-адрес, который вы хотите проиндексировать, в строку поиска в верхней части страницы.

Затем нажмите кнопку «запросить индексацию».

Использование инструмента проверки URL-адресов для запроса индексации не гарантирует, что данная страница будет просканирована и проиндексирована. Он только посылает сигнал Google о том, что вы хотите, чтобы эта страница была просканирована и проиндексирована с высоким приоритетом.

Завершение

URL-адреса в Обнаружено ‐ , которые в настоящее время не проиндексированы, вызваны проблемами с качеством сайта, внутренними ссылками и краулинговым бюджетом.

Вот ключевые моменты, которые могут помочь сканировать и индексировать ваши страницы:

- Проверьте качество и оригинальность затронутых страниц

- Использовать внутренние ссылки, особенно на важные страницы

- Используйте файл robots.

txt, чтобы запретить роботу Googlebot сканировать некачественные страницы

- Разработайте стратегию индексации, которая фокусируется на самых важных страницах

- Оптимизируйте свой краулинговый бюджет, чтобы у Google было больше ресурсов для сканирования этих страниц.

У вас также есть страницы со статусом Просканировано – в настоящее время не проиндексировано? Узнайте, как проиндексировать эти URL-адреса, в нашем руководстве «Просканировано — в настоящее время не проиндексировано».

Почему Google не проиндексировал ваше сообщение, страницу и/или веб-сайт? » Rank Math

Вам кажется, что вы все сделали правильно, но ваш сайт по-прежнему не отображается в результатах поиска?

Если вы хотите, чтобы ваш сайт отображался в результатах поиска, он должен быть проиндексирован . Однако вы не хотите, чтобы ваш сайт был проиндексирован только один раз — вы хотите убедиться, что поисковые системы могут повторно сканировать и постоянно индексировать страницы вашего сайта (включая новые, которые вы публикуете).

Что ж, поисковые системы, такие как Google, не всегда мгновенно обновляют свой индекс, чтобы отражать фактические изменения на веб-сайтах. На самом деле Google может потребоваться несколько дней или даже недель, чтобы проиндексировать ваш сайт. Проще говоря, совершенно нормально, что для недавно опубликованной публикации/страницы/веб-сайта требуется некоторое время, прежде чем она будет просканирована или проиндексирована Google.

Существуют различные факторы, которые Google учитывает при индексировании. Частота публикаций и авторитет домена вашего сайта — это лишь два из многих факторов, которые Google учитывает при индексации новых веб-страниц.

Google назначает краулинговый бюджет вашему веб-сайту в зависимости от этих факторов (особенно этих двух), и это напрямую влияет на то, как скоро (то есть насколько эффективно) ваш контент может быть проиндексирован.

Кроме того, мы обнаружили, что, за исключением таких проблем, как копирование/DMCA/некачественный контент, Google обычно индексирует сообщения в течение недели или двух.

Итак, мы просим вас подождать, поскольку они подтвердили это в официальном заявлении на своем веб-сайте поддержки.

Содержание

- Почему мой сайт не отображается в поиске Google?

- Дважды проверьте, что ваш URL-адрес точно не был проиндексирован

- Убедитесь, что ваша публикация, страница и веб-сайт не имеют атрибута Noindex

- Проверьте глобальные настройки WordPress

- Убедитесь, что правила robots.txt позволяют индексировать ваш веб-сайт

- Проверьте, просканированы ли ваши страницы, но не проиндексированы

- Запрос ручного индексирования

Почему мой сайт не отображается в поиске Google?

Для начала вот список вещей, которые необходимо проверить, чтобы убедиться, что ничто не мешает Google проиндексировать весь ваш веб-сайт или конкретную веб-страницу на вашем сайте:

1 Дважды проверьте, что ваш URL-адрес определенно не был проиндексирован

Ранее мы погружаемся, важно проверить, действительно ли ваша веб-страница не проиндексирована или просто не ранжируется по поисковым запросам, которые вы проверяете.

Существует явное различие, и один из способов его быстрой проверки показан на изображении выше. Просто введите URL-адрес страницы, которую вы хотите проверить в поиске Google, и в этом случае введенный URL-адрес явно проиндексирован.

К счастью, Rank Math значительно упростил использование преимуществ Google Instant Indexing API, а также Bing Instant Indexing / URL Submit API. Это означает, что после настройки вам больше не нужно беспокоиться о том, чтобы поисковые системы сканировали и повторно просканируйте ваши URL-адреса, как только вы их опубликуете или обновите.

2 Убедитесь, что ваша публикация, страница и веб-сайт НЕ имеют атрибута Noindex

Существует вероятность того, что даже небольшая упущенная деталь может оказать большое влияние.

Робот Googlebot посещает сайт, чтобы определить, какие страницы индексируются или не индексируются. Другими словами, он информирует поисковые системы о страницах, которые они могут посещать, и о страницах, которые они не могут посещать.

Вам необходимо убедиться, что вы не установили для своих сообщений, страниц или всего веб-сайта значение noindex, , так как это помешает поисковым системам индексировать ваш сайт.

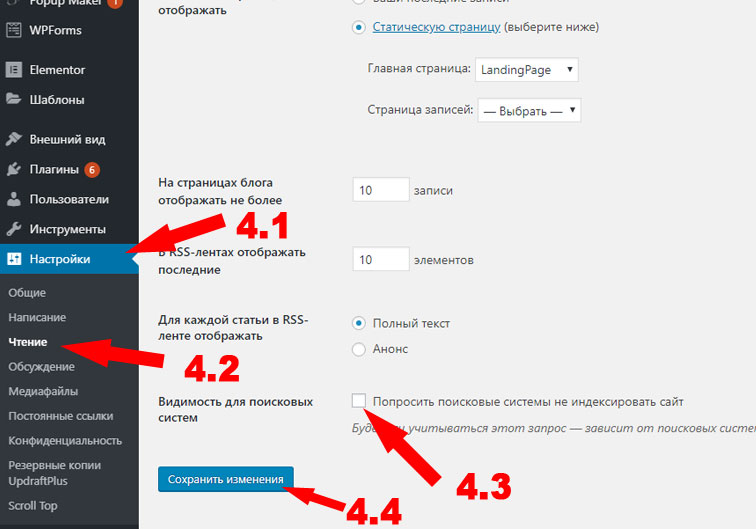

3 Проверьте свои глобальные настройки WordPress

Если нет индекса, проверьте глобальные настройки в Панель управления WordPress > Математика рейтинга > Заголовки и метаданные > Сообщения/Страницы/Продукты/CPT.

Кроме того, убедитесь, что параметр Отключить поисковые системы… включен , а не в Панель управления WordPress > Настройки > Чтение

Многие веб-разработчики выбирают указанный выше вариант, чтобы запретить Google индексировать сайт в процессе разработки (на тестовых веб-сайтах), но забывают удалить его перед публикацией.

4 Убедитесь, что правила robots.txt позволяют индексировать ваш веб-сайт

Тег Disallow (в файле robots.txt вашего веб-сайта) запрещает Google сканировать все страницы вашего сайта.

Вы можете проверить наличие тега disallow и убедиться, что в файле robots.txt нет такого тега, который препятствует индексации вашей страницы.

Если есть запрещающий тег, измените его с помощью редактора robots.txt в Rank Math по адресу Панель управления WordPress > Rank Math > Общие настройки > Изменить Robots.txt

Связанный: Файлы Robots.txt и как они работают, обширное руководство ContentKing по файлам Robots.txt является превосходным чтением.

5 Проверьте, просканированы ли ваши страницы, но не проиндексированы

Ваша учетная запись Google Search Console может указать вам больше причин, по которым ваш контент не проиндексирован. Вы можете выполнить поиск своего URL-адреса в Инструменте проверки URL-адресов, чтобы выяснить причину, по которой ваш URL-адрес не индексируется, и одна из таких причин/ошибок, которую вы можете обнаружить, — 9.0017 Просканировано — в настоящее время не проиндексировано

.Ошибка просто означает, что Google просканировал ваш URL, но решил не индексировать его.

Может быть ряд причин, по которым поисковая система решила это сделать.

Джон Мюллер из Google заявляет, что проблема может касаться всего сайта, а не конкретной страницы, и рекомендует улучшить структуру и общее качество вашего сайта.

Вы не можете принудительно индексировать страницы — это нормально, что мы не индексируем все страницы на всех веб-сайтах. Это не проблема «этой страницы», это больше касается всего сайта. Создание хорошей структуры сайта и обеспечение максимально возможного качества сайта — это, по сути, направление.

— 🫕 John 🫕 (@JohnMu) 28 июня 2021 г.Проще говоря, чтобы страница была проиндексирована, она (и веб-сайт) должна пройти проверку качества. Поскольку Google не раскрыл ничего конкретного, что они ищут при индексировании, вы должны рассмотреть возможность оценки вашего веб-сайта по известным факторам качества, таким как

Внутренняя структура ссылок : если вы пытаетесь проиндексировать важную страницу, убедитесь, что они внутренние ссылки с соответствующих страниц вашего веб-сайта.

Чтобы начать создавать внутренние ссылки, вы можете установить важные страницы в качестве основного контента и позволить Rank Math предлагать соответствующие внутренние ссылки.

Дублирование контента : Проверьте, не дублируются ли страницы, которые вы пытаетесь проиндексировать, на вашем сайте. В случае, если вы их найдете, добавьте канонический URL-адрес с этих дубликатов страниц, указывающий на исходный контент, который вы хотите проиндексировать.

Запрос на ручное индексирование

Если вы проверили все вышеперечисленное, но ваш веб-сайт все еще не проиндексирован даже через несколько недель после попытки, рекомендуем отправить запрос на ручное индексирование.

Однако важно отметить, что Джон Мюллер из Google заявил, что , если ваш веб-сайт полагается на ручную отправку индекса для обычного контента, это признак того, что вам необходимо значительно улучшить свой веб-сайт. Консоль поиска Google не может исправить ваш сайт, вам нужно сделать это самостоятельно .

Убираем noindex из метатегов.

Убираем noindex из метатегов. Этот инструмент Google анализирует скорость загрузки

сайта и дает рекомендации для оптимизации. Хороший показатель — от 70 баллов. Чем ближе к 100, тем лучше.

Этот инструмент Google анализирует скорость загрузки

сайта и дает рекомендации для оптимизации. Хороший показатель — от 70 баллов. Чем ближе к 100, тем лучше. txt, sitemap.xml скорость загрузки и др.

txt, sitemap.xml скорость загрузки и др.

4.1

Инструмент проверки URL

4.1

Инструмент проверки URL

Просмотрите его, чтобы лучше понять, что такое качественный веб-контент в соответствии с определением Google. Затем вы можете применить концепцию качества Google к своим страницам.

Просмотрите его, чтобы лучше понять, что такое качественный веб-контент в соответствии с определением Google. Затем вы можете применить концепцию качества Google к своим страницам. И если мы обнаружим много таких повторяющихся URL-адресов, мы можем подумать, что нам на самом деле не нужно сканировать все эти дубликаты, потому что у нас уже есть некоторая вариация этой страницы.

И если мы обнаружим много таких повторяющихся URL-адресов, мы можем подумать, что нам на самом деле не нужно сканировать все эти дубликаты, потому что у нас уже есть некоторая вариация этой страницы.

Эта структура позволяет поисковым системам и пользователям понять иерархию ваших страниц и то, как они связаны.

Эта структура позволяет поисковым системам и пользователям понять иерархию ваших страниц и то, как они связаны.

Это просто — , если потребность в сканировании слишком низкая или скорость сканирования ограничена, некоторые из ваших страниц не будут сканироваться .

Это просто — , если потребность в сканировании слишком низкая или скорость сканирования ограничена, некоторые из ваших страниц не будут сканироваться .

Исправьте перегруженные серверы

Исправьте перегруженные серверы

txt, чтобы запретить роботу Googlebot сканировать некачественные страницы

txt, чтобы запретить роботу Googlebot сканировать некачественные страницы

Итак, мы просим вас подождать, поскольку они подтвердили это в официальном заявлении на своем веб-сайте поддержки.

Итак, мы просим вас подождать, поскольку они подтвердили это в официальном заявлении на своем веб-сайте поддержки.

Вы можете проверить наличие тега disallow и убедиться, что в файле robots.txt нет такого тега, который препятствует индексации вашей страницы.

Вы можете проверить наличие тега disallow и убедиться, что в файле robots.txt нет такого тега, который препятствует индексации вашей страницы. Может быть ряд причин, по которым поисковая система решила это сделать.

Может быть ряд причин, по которым поисковая система решила это сделать.