9 причин почему Google не индексирует сайт

Google не индексирует ваш сайт? Распространенная проблема, у которой есть много причин. Ниже рассмотрены 9 наиболее популярных и способы их решения.

Долгая загрузка сайта

Долго загружающиеся сайты не нравятся Google и индексируются дольше. У медленной загрузки есть множество причин. Например, слишком большое количество контента для обработки пользовательским браузером. Или использование устаревших серверов с ограниченными ресурсами.

Читайте также:

Как проверить скорость загрузки сайта и как ускорить загрузку

Проверить скорость загрузки сайта можно с помощью двух инструментов:

- PageSpeed Insights. Этот инструмент Google анализирует скорость загрузки

сайта и дает рекомендации для оптимизации. Хороший показатель — от 70 баллов. Чем ближе к 100, тем лучше.

Более быстрый хостинг или использование CDN (сеть доставки содержимого) увеличат скорость загрузки сайта.

Присоединяйтесь к нашему Telegram-каналу!

- Теперь Вы можете читать последние новости из мира интернет-маркетинга в мессенджере Telegram на своём мобильном телефоне.

- Для этого вам необходимо подписаться на наш канал.

У сайта бесконечный цикл переадресации

Бесконечный цикл переадресации — еще одна частая проблема, мешающая индексации. Она может появиться из-за банальной опечатки. Но решить ее просто.

Если используется WordPress, файл .htaccess поможет найти страницы, с которых перенаправляется трафик.

Читайте также:

Как сделать редирект — подробное руководство по настройке и использованию

С помощью инструмента Screaming Frog можно найти дополнительные ошибки на сайте. После их устранения воспользуйтесь Google Search Console, чтобы повторно подать запрос на индексацию. Обычно процесс занимает около семи дней.

Использование плагинов, блокирующих Googlebot

Некоторые плагины могут блокировать работу поискового робота Googlebot. В таком случае поисковая система не сможет просканировать сайт. Если вы настраиваете файл robots.txt через одноименный плагин для WordPress, Googlebot будет заблокирован.

Самостоятельная настройка файла решит проблему. Robots.txt должен размещаться в корневой папке сайта и быть доступен по адресу ваш_домен.

User-agent: *

Disallow: /

Наличие косой черты «/» блокирует все страницы из корневой папки сайта. Чтобы поисковый робот мог проиндексировать весь сайт, ее нужно убрать.

Читайте также:

Robots.txt: что это, как создать и правильно настроить

Для рендеринга используется JavaScript

В процессе рендеринга веб-страницы браузер преобразует код в картинку. Использование JavaScript не всегда приводит к проблемам с индексацией. Но они точно возникнут, если JavaScript используется для маскировки.

Маскировка — это прием, при котором сайт предоставляет пользователям и поисковым системам неодинаковый контент или разные URL. Это нарушение рекомендаций Google.

Иногда рендерная и сырая версия страницы отличаются друг от друга, что может восприниматься как маскировка. В таком случае индексация остановится. Скрытие файлов JavaScript и CSS также не позволит Google проиндексировать сайт.

В таком случае индексация остановится. Скрытие файлов JavaScript и CSS также не позволит Google проиндексировать сайт.

В Google Search Console не указаны все варианты домена

В Google Search Console должны быть указаны и верифицированы все варианты вашего домена. Это особенно важно, если вы мигрируете с http:// на https://.

Установлены метатеги noindex, nofollow

Установка метатегов noindex, nofollow бывает необходима. Но если метатеги появляются не на той странице или применяются ко всему сайту, он не будет индексироваться.

Читайте также:

4 метатега, которые стоит использовать: Robots, Rel canonical, Hreflang, Schema.org

Решить эту проблему просто — поменяйте все метатеги noindex, nofollow на index, follow.

Штрафные санкции со стороны Google

Штрафные санкции накладываются как вручную, так и автоматически. Например, после обновления алгоритмов.Да за что?!

Штрафные санкции накладываются как вручную, так и автоматически. Например, после обновления алгоритмов.Да за что?!До тех пор, пока нарушения не устранены, сайт не будет индексироваться. Чаще всего штрафы накладываются за наличие:

- вредоносного и нежелательного ПО на сайте;

- скрытого текста и ссылок;

- маскировки;

- скрытой переадресации;

- нерелевантных ключевых слов;

- избыточного количества ключевых слов;

- дублированного контента.

Сайт не адаптирован под мобильные платформы

Адаптация сайта под мобильные платформы — критический момент. С 1 июля 2019 года Google при индексации отдает приоритет мобильному контенту.

Необязательно вносить много изменений. Бывает достаточно плавающей сетки и медиавыражений. Под плавающей сеткой понимается макет сайта, адаптирующийся под меняющиеся размеры экрана или устройство пользователя. А медиавыражения позволяют CSS адаптироваться под параметры или характеристики устройства.

Специальный инструмент Google позволит проверить оптимизацию для мобильных устройств. Он подскажет, не было ли нагромождений кода при написании сайта, что также влияет на индексацию.

Проблемы с техническим SEO

Техническое SEO — важный элемент при работе с сайтом. Именно техническая оптимизация помогает поисковым системам сканировать, понимать и индексировать страницы.

С помощью грамотно выполненного технического SEO можно идентифицировать проблемы с основными интернет-показателями, сканированием и индексацией. Порой может казаться, что проще запустить новые сайт, но качественное техническое SEO поможет решить проблемы.

- Наличие дублей страниц, безопасность, корректность всех технических параметров: переадресаций, robots.txt, sitemap.xml скорость загрузки и др.

- Техническая оптимизация — один из основных этапов в продвижении.

Поисковые роботы, вперед!

Чтобы сайт был успешным, важно размещать на нем хороший контент, работать с техническим SEO и создавать качественные обратные ссылки. Но все это будет впустую, если он не индексируется.

Убедитесь, что все проблемы с индексацией решены, и тогда Google отблагодарит вас хорошим трафиком.

5 основных причин. Блог Web-студии РостСайт

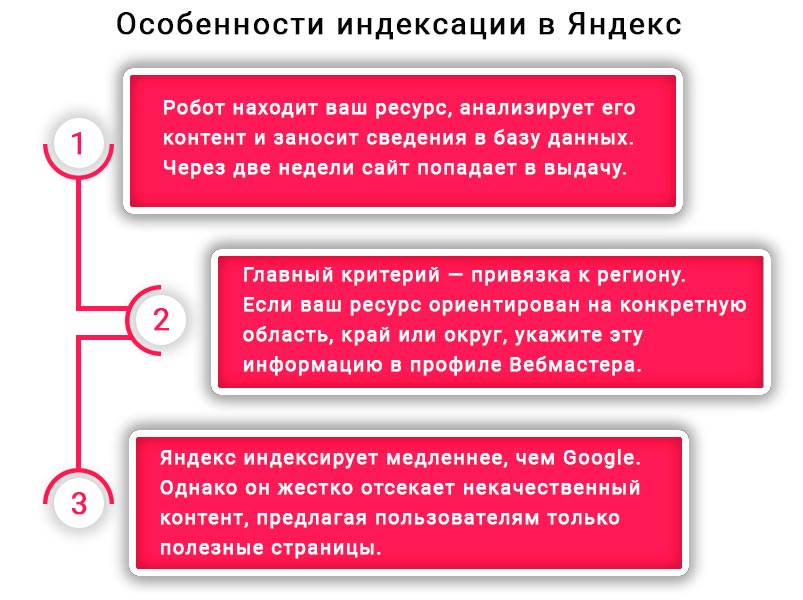

Чтобы на Ваш веб-ресурс пришли посетители из поиска, кроме раскрутки сайта, его должны проиндексировать Яндекс и Google. Лишь после успешной индексации он начнёт показываться в выдаче. Сегодня Вы узнаете 5 главных причин, делающих ресурс «невидимым» для поисковиков.

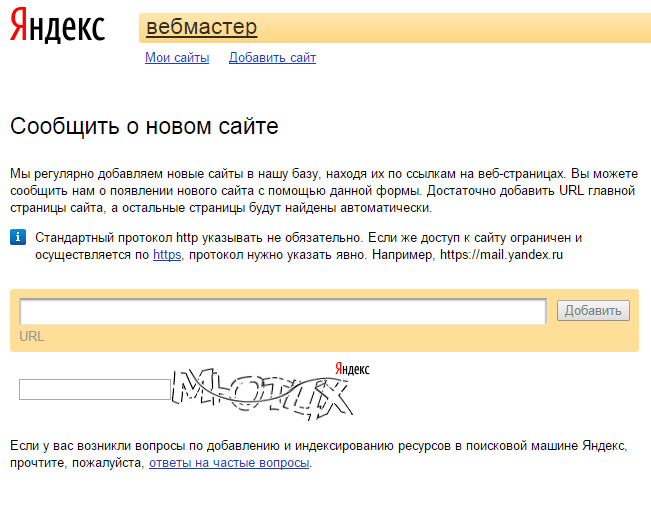

Проверить, прошла ли индексация

Не стоит поднимать тревогу раньше времени, сначала проверьте, возможно, проблем и нет. Для этого Вам потребуется перейти в Яндекс.Вебмастер, раздел «Индексирование», а затем в подпункт «Страницы в поиске».

Для Google Console порядок следующий – зайти в пункт «Покрытие» и выбрать «Индекс».

Там есть все данные о индексациях. Возможно, что робот и не посещал сайт вовсе.

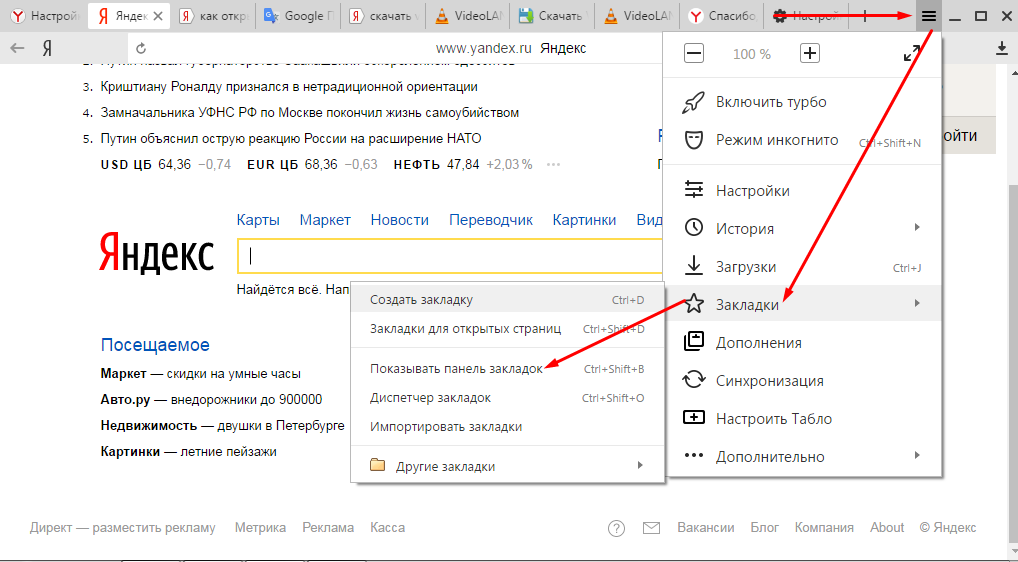

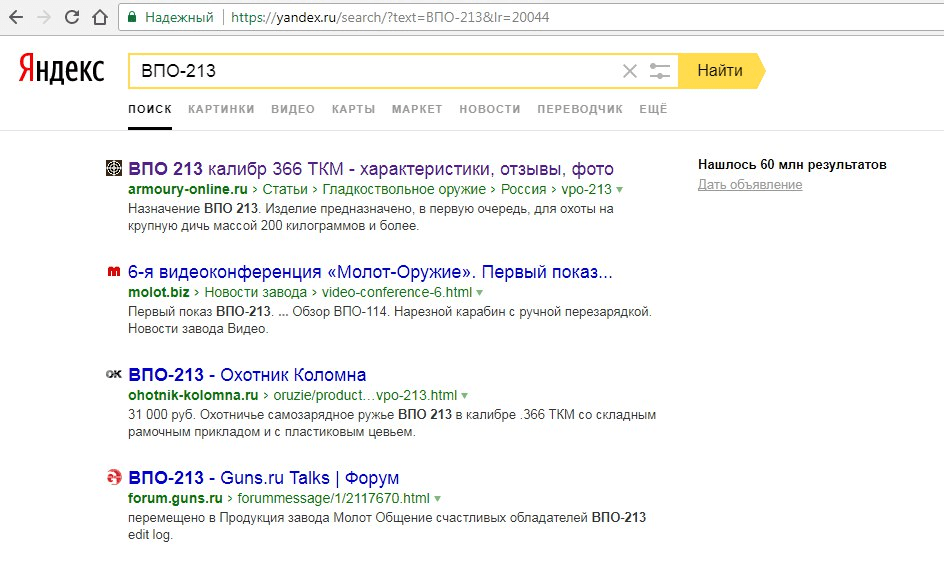

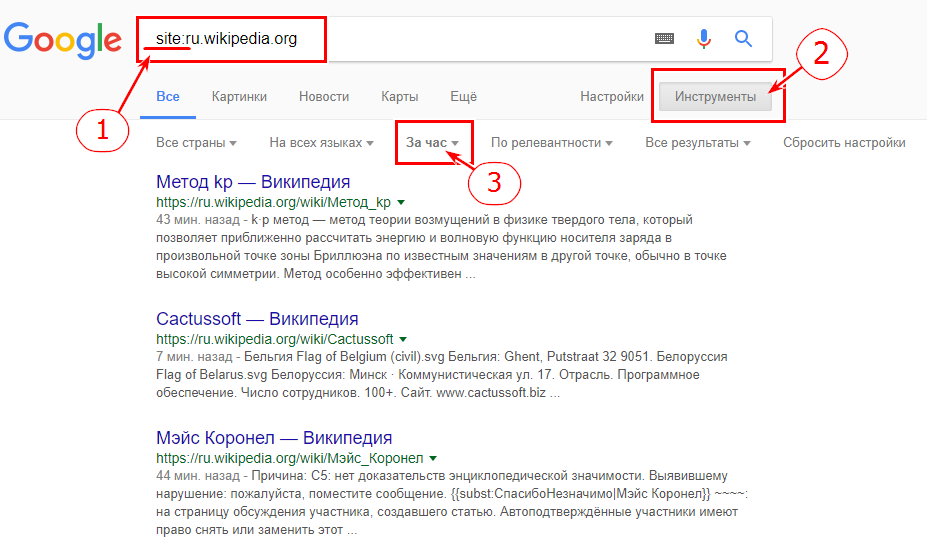

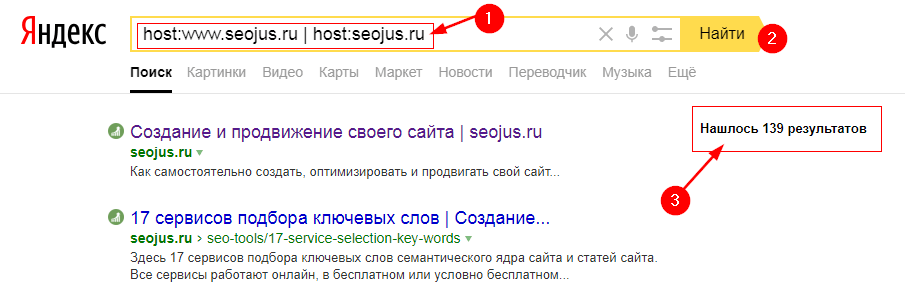

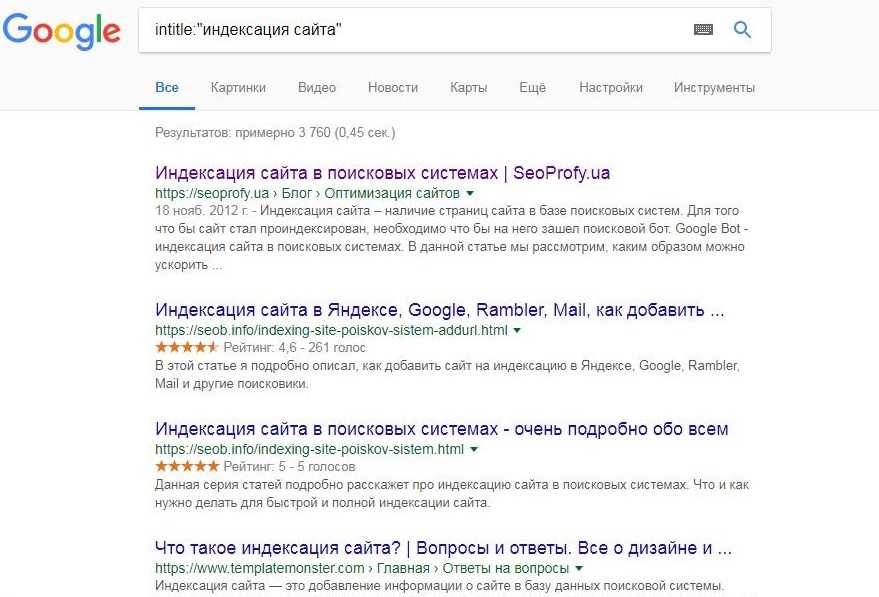

Проверка с использованием поискового оператора

Чтобы задействовать этот метод, достаточно перейти на страницу поиска и добавить оператора (site:) перед названием Вашего домена, например, (site:mysite.net).

Проблема есть в случае отсутствия каких-либо результатов по такому запросу, либо если в одной поисковой системе их будет существенно больше, нежели в другой.

Далее рассмотрим 5 самых частых причин, которые мешают SEO продвижению сайта.

Причина 1. Индексация запрещена в настройках файла robots.txt

Если в данном файле прописать следующие команды:

User Agent:*

Disallow:/

Тогда можно и не ждать, что поисковые роботы зайдут на страницу. Вторую строчку из приведённого примера необходимо удалить, т.к. она запрещает посещать все страницы портала поисковым роботам.

Кроме этого, есть ещё несколько возможных причин подобного рода:

- Приватные настройки в движке сайта.

- Есть запрет в командах файла .htaccess.

- Домен может быть не делегированным (особенно это касается доменных имён, которые ранее использовались).

- Тег noindex работает неправильно и блокирует индексацию нужным страницам, но и всем остальным.

Попросите Вашего программиста проверить сайт по этим параметрам.

Поисковики не знают, что сайт есть

Через это проходят все новые веб-сервисы. В данном случае просто нужно подождать хотя бы пару недель, но продолжайте оптимизировать сайт. Также причиной плохой индексации могут стать редкие обновления и отсутствие внешних ссылок. В связи с этим не стоит забывать о перелинковке, добавляя свежие страницы, а также стоит позаботиться о появлении ссылок с авторитетных площадок.

Ваш веб-ресурс могли забанить

Есть ряд нечестных методов продвижения, из-за которых онлайн-площадки попадают под санкции от поисковых систем. Как следствие, на них не приходят поисковые роботы. В некоторых случаях могут случайно пострадать даже честные проекты.

У каждого поисковика свои особенности. Если например, Яндекс оповещает, что с сайтом есть проблемы и их требуется исправлять, то от Google Вы их не дождётесь и придётся нанимать SEO-специалиста, который сможет обнаружить причины блокировки.

Чаще всего причины оказываются следующими:

- Наличие очень навязчивых блоков с рекламой.

- Семантическое ядро слишком заспамлено.

- Содержимое сайта нерелевантно и низкого качества.

- Проводилась накрутка посещений (один из чёрных методов продвижения).

- Код веб-ресурса содержит вирусы.

- Поисковик признал ресурс аффилиатом.

Проверить сайт на запрет в Яндексе можно по ссылке https://seolik.ru/check-sanctions-yandex.

Ошибки технического плана

Есть параметры, которые очень просты, но в тот же момент полностью блокируют индексацию. Всё нормализуется как только Вы их исправите. Примеры таких неполадок:

- Нестабильно работает хостинг.

- Файла sitemap нет или работает он неправильно.

- Неверные настройки редиректа.

- HTTP-заголовки настроены некорректно.

- Не та кодировка тоже влияет на отображение, потому что впоследствии вместо нормальных символов на сайте будут нечитаемые «буквы».

Страницы низкого качества

Ещё одна из распространённых причин плохой индексации – контент на сайте плохого качества. Порой оно может быть настолько ужасным, что поисковые системы налагают запрет на сканирование проекта. Но это крайности, которые происходят редко.

Чаще всего, сайт просто падает вниз при выдаче, а выше располагаются конкуренты, у которых содержимое страниц лучше.

Возможные причины пессимизации при поиске:

- Изобилие ошибок 404 или битых ссылок.

- Контент не уникальный (Google и Яндекс попросту не видят смысла в добавлении на страницы выдачи дублирующегося контента).

- Сайт медленно загружается у пользователей.

- Структура заголовков идентична, метатеги повторяются.

В большинстве случаев достаточно исправить перечисленные причины, чтобы индексация наладилась.

Почему Google не проиндексировал ваше сообщение, страницу и/или веб-сайт? » Rank Math

Вам кажется, что вы все сделали правильно, но ваш сайт по-прежнему не отображается в результатах поиска?

Если вы хотите, чтобы ваш сайт отображался в результатах поиска, он должен быть проиндексирован . Однако вы не хотите, чтобы ваш сайт был проиндексирован только один раз — вы хотите убедиться, что поисковые системы могут повторно сканировать и постоянно индексировать страницы вашего сайта (включая новые, которые вы публикуете).

Что ж, поисковые системы, такие как Google, не всегда мгновенно обновляют свой индекс, чтобы отражать фактические изменения на веб-сайтах. На самом деле Google может потребоваться несколько дней или даже недель, чтобы проиндексировать ваш сайт. Проще говоря, совершенно нормально, что для недавно опубликованной публикации/страницы/веб-сайта требуется некоторое время, прежде чем она будет просканирована или проиндексирована Google.

Существуют различные факторы, которые Google учитывает при индексировании. Частота публикаций и авторитет домена вашего сайта — это лишь два из многих факторов, которые Google учитывает при индексации новых веб-страниц.

Google назначает краулинговый бюджет вашему веб-сайту в зависимости от этих факторов (особенно этих двух), и это напрямую влияет на то, как скоро (то есть насколько эффективно) ваш контент может быть проиндексирован.

Кроме того, мы обнаружили, что, за исключением таких проблем, как копирование/DMCA/некачественный контент, Google обычно индексирует сообщения в течение недели или двух. Итак, мы просим вас подождать, поскольку они подтвердили это в официальном заявлении на своем веб-сайте поддержки.

Содержание

- Почему мой сайт не отображается в поиске Google?

- Дважды проверьте, что ваш URL-адрес точно не был проиндексирован

- Убедитесь, что ваша публикация, страница и веб-сайт не имеют атрибута Noindex

- Проверьте свои глобальные настройки WordPress

- Убедитесь, что правила robots.

txt позволяют индексировать ваш веб-сайт

txt позволяют индексировать ваш веб-сайт - Проверьте, просканированы ли ваши страницы, но не проиндексированы

- Запрос ручного индексирования

Почему мой сайт не отображается в поиске Google?

Для начала вот список вещей, которые нужно проверить, чтобы убедиться, что ничто не мешает Google проиндексировать весь ваш веб-сайт или конкретную веб-страницу на вашем сайте:

1 Дважды проверьте, что ваш URL определенно не был проиндексирован

Ранее мы погружаемся, важно проверить, действительно ли ваша веб-страница не проиндексирована или просто не ранжируется по поисковым запросам, которые вы проверяете.

Существует явное различие, и один из способов его быстрой проверки показан на изображении выше. Просто введите URL-адрес страницы, которую вы хотите проверить в поиске Google, и в этом случае введенный URL-адрес явно проиндексирован.

К счастью, Rank Math упростил использование преимуществ Google Instant Indexing API, а также Bing Instant Indexing / URL Submission API. Это означает, что после настройки вам больше не нужно беспокоиться о том, чтобы поисковые системы сканировали и повторно просканируйте ваши URL-адреса, как только вы их опубликуете или обновите.

Это означает, что после настройки вам больше не нужно беспокоиться о том, чтобы поисковые системы сканировали и повторно просканируйте ваши URL-адреса, как только вы их опубликуете или обновите.

2 Убедитесь, что ваша публикация, страница и веб-сайт НЕ имеют атрибута Noindex

Существует вероятность того, что даже небольшая упущенная деталь может оказать большое влияние.

Робот Googlebot посещает сайт, чтобы определить, какие страницы индексируются или не индексируются. Другими словами, он информирует поисковые системы о страницах, которые они могут посещать, и о страницах, которые они не могут посещать.

Убедитесь, что вы не установили для своих сообщений, страниц или всего веб-сайта значение noindex, , так как это помешает поисковым системам индексировать ваш веб-сайт.

3 Проверьте глобальные настройки WordPress

Если нет индекса, проверьте глобальные настройки в Панель управления WordPress > Расчет рейтинга > Заголовки и метаданные > Сообщения/Страницы/Продукты/CPT.

Кроме того, убедитесь, что Отключить поисковые системы… параметр , а не включен в Панель управления WordPress > Настройки > Чтение

процессе разработки (на промежуточных веб-сайтах), но забудьте удалить его перед публикацией.

4 Убедитесь, что правила robots.txt позволяют индексировать ваш веб-сайт

Тег Disallow (в файле robots.txt вашего веб-сайта) запрещает Google сканировать все страницы вашего сайта. Вы можете проверить наличие тега disallow и убедиться, что в файле robots.txt нет такого тега, который препятствует индексации вашей страницы.

Если есть запрещающий тег, измените его с помощью редактора robots.txt в Rank Math по адресу Панель управления WordPress > Rank Math > Общие настройки > Изменить Robots.txt

Связано: Файлы Robots.txt и как они работают, обширное руководство ContentKing по файлам Robots.txt является превосходным чтением.

5 Проверьте, просканированы ли ваши страницы, но не проиндексированы

Ваша учетная запись Google Search Console может указать вам больше причин, по которым ваш контент не проиндексирован. Вы можете выполнить поиск своего URL-адреса в Инструменте проверки URL-адресов, чтобы выяснить причину, по которой ваш URL-адрес не индексируется, и одна из таких причин/ошибок, которую вы можете обнаружить, — Просканировано — в настоящее время не проиндексировано .

Ошибка просто означает, что Google просканировал ваш URL, но решил не индексировать его. Может быть ряд причин, по которым поисковая система решила это сделать.

Джон Мюллер из Google заявляет, что проблема может касаться всего сайта, а не конкретной страницы, и рекомендует улучшить структуру и общее качество вашего сайта.

Вы не можете принудительно индексировать страницы — это нормально, что мы не индексируем все страницы на всех веб-сайтах.

— Джона Мюллера здесь почти нет 🐀 (@JohnMu) 28 июня 2021 г.Это не проблема «этой страницы», это больше касается всего сайта. Создание хорошей структуры сайта и обеспечение максимально возможного качества сайта — это, по сути, направление.

Проще говоря, чтобы страница была проиндексирована, она (и веб-сайт) должна пройти проверку качества. Поскольку Google не раскрыл ничего конкретного, что они ищут при индексировании, вы должны рассмотреть возможность оценки вашего веб-сайта по известным факторам качества, таким как

Внутренняя структура ссылок : если вы пытаетесь проиндексировать важную страницу, убедитесь, что они внутренние ссылки с соответствующих страниц вашего веб-сайта. Чтобы начать создавать внутренние ссылки, вы можете установить важные страницы в качестве основного контента и позволить Rank Math предлагать соответствующие внутренние ссылки.

Дублирование контента : Проверьте, не дублируются ли страницы, которые вы пытаетесь проиндексировать, на вашем веб-сайте.![]() В случае, если вы их найдете, добавьте канонический URL-адрес с этих дубликатов страниц, указывающий на исходный контент, который вы хотите проиндексировать.

В случае, если вы их найдете, добавьте канонический URL-адрес с этих дубликатов страниц, указывающий на исходный контент, который вы хотите проиндексировать.

Запрос на индексирование вручную

Если вы проверили все вышеперечисленное, но ваш веб-сайт все еще не проиндексирован даже через несколько недель после попытки, мы рекомендуем отправить запрос на индексирование вручную.

Однако важно отметить, что Джон Мюллер из Google заявил, что , если ваш веб-сайт полагается на ручную отправку индекса для обычного контента, это признак того, что вам необходимо значительно улучшить свой веб-сайт. Консоль поиска Google не может исправить ваш сайт, вам нужно сделать это самостоятельно .

С учетом сказанного, с точки зрения следующих шагов, которые вы можете предпринять — вот хорошая статья от команды Ahrefs о том, как обеспечить регулярное индексирование вашего веб-сайта.

Вот оно! Если у вас по-прежнему возникают проблемы с индексацией вашего контента, не стесняйтесь обращаться в нашу службу поддержки прямо отсюда, и мы всегда готовы помочь.

Почему 100% индексация невозможна и почему это нормально

Когда речь заходит о таких темах, как краулинговый бюджет, историческая риторика всегда сводилась к тому, что это проблема крупных веб-сайтов (классифицированных Google как более 1 миллиона веб-сайтов). веб-страницы) и веб-сайты среднего размера с высокой частотой смены контента.

Однако в последние месяцы сканирование и индексирование стали более распространенными темами на форумах SEO и в вопросах, задаваемых сотрудникам Google в Twitter.

По моему собственному неподтвержденному опыту, с ноября веб-сайты разного размера и частоты изменений претерпевают более значительные колебания и сообщают об изменениях в Google Search Console (как в статистике сканирования, так и в отчетах о покрытии), чем это было раньше.

Ряд крупных изменений покрытия, которые я наблюдал, также коррелировали с неподтвержденными обновлениями Google и высокой волатильностью датчиков/наблюдателей SERP. Учитывая, что ни один из веб-сайтов не имеет слишком много общего с точки зрения стека, ниши или даже технических проблем, является ли это признаком того, что 100% индексация (для большинства веб-сайтов) сейчас невозможна, и это нормально?

Это имеет смысл.

Google в своих собственных документах отмечает, что сеть расширяется такими темпами, которые намного превосходят ее собственные возможности и средства сканирования (и индексации) каждого URL-адреса.

Получайте ежедневный информационный бюллетень, на который полагаются поисковые маркетологи.

В той же документации Google описывает ряд факторов, влияющих на их способность сканирования, а также спрос на сканирование, в том числе:

- Популярность ваших URL-адресов (и контента).

- Это затхлость.

- Насколько быстро сайт отвечает.

- Знание Google (воспринимаемый перечень) URL-адресов на нашем веб-сайте.

Из разговоров с Джоном Мюллером из Google в Твиттере известно, что популярность вашего URL не обязательно зависит от популярности вашего бренда и/или домена.

Имея непосредственный опыт крупного издателя, не индексирующего контент на основе его уникальности по отношению к аналогичному контенту, уже опубликованному в Интернете, — как будто он падает ниже порога качества и не имеет достаточно высокого значения включения SERP.

Вот почему, работая со всеми веб-сайтами определенного размера или типа (например, электронной коммерции), я с первого дня заявляю, что 100% индексация не всегда является показателем успеха.

Уровни и сегменты индексации

Google довольно откровенно объяснил, как работает их индексация.

Они используют многоуровневую индексацию (некоторый контент на лучших серверах для более быстрого доступа) и что у них есть индекс обслуживания, хранящийся в нескольких центрах обработки данных, который, по сути, хранит данные, обслуживаемые в поисковой выдаче.

Еще больше упрощая:

Содержимое документа веб-страницы (документ HTML) затем токенизируется и сохраняется в сегментах, а сами сегменты индексируются (как глоссарий), чтобы их можно было быстрее и проще запрашивать по определенным ключевым словам. (когда пользователь ищет).

В большинстве случаев в проблемах с индексированием обвиняют техническое SEO, и если у вас есть отсутствие индекса или проблемы и несоответствия, мешающие Google индексировать контент, то это технические проблемы, но чаще всего это проблема ценностного предложения.

Полезная цель и значение включения в поисковую выдачу

Когда я говорю о ценностном предложении, я имею в виду две концепции из рекомендаций Google по оценке качества (QRG), а именно:

- Полезная цель

- Качество страницы

В совокупности они создают то, что я называю значением включения в поисковую выдачу.

Обычно по этой причине веб-страницы попадают в категорию «Обнаруженные — в настоящее время не проиндексированные» в отчете о покрытии Google Search Console.

В QRG Google делает следующее заявление:

Помните, что если страница не имеет полезной цели, она всегда должна быть оценена как «Самое низкое качество страницы», независимо от рейтинга страницы «Удовлетворены потребности» или от того, насколько хорошо оформлена страница.

Что это значит? Чтобы страница могла ориентироваться на правильные ключевые слова и ставить правильные галочки. Но если он обычно повторяется в другом контенте и не имеет дополнительной ценности, Google может не индексировать его.

Здесь мы сталкиваемся с порогом качества Google, концепцией того, соответствует ли страница необходимому «качеству» для индексации.

Ключевой момент в том, как работает этот порог качества, заключается в том, что он работает почти в реальном времени и плавно.

Гэри Иллиес из Google подтвердил это в Твиттере, где URL-адрес может быть проиндексирован при первом обнаружении, а затем удален при обнаружении новых (лучших) URL-адресов или даже получить временное повышение «свежести» за счет ручной отправки в GSC.

Определение наличия проблемы

Первое, что нужно определить, — это если вы видите, что количество страниц в отчете о покрытии Google Search Console перемещается из включенных в исключенные.

Одного этого графика, вырванного из контекста, достаточно, чтобы вызвать беспокойство у большинства маркетологов.

Но сколько из этих страниц вам нужно? Сколько из этих страниц приносят пользу?

Вы сможете определить это по своим коллективным данным. Вы увидите, уменьшаются ли трафик и доход/лиды в вашей аналитической платформе, и вы заметите в сторонних инструментах, если вы потеряете общую видимость на рынке и рейтинг.

Вы увидите, уменьшаются ли трафик и доход/лиды в вашей аналитической платформе, и вы заметите в сторонних инструментах, если вы потеряете общую видимость на рынке и рейтинг.

После того, как вы определили, что ценные страницы выпадают из индекса Google, следующие шаги заключаются в том, чтобы понять, почему, и Search Console разбивает исключенные на дополнительные категории. Основные из них, которые вам нужно знать и понимать, это:

Просканировано — в настоящее время не проиндексировано

Это то, с чем я сталкивался чаще в электронной коммерции и недвижимости, чем в любой другой вертикали.

В 2021 году количество регистраций новых бизнес-приложений в США побило предыдущие рекорды, и, поскольку все больше компаний конкурируют за пользователей, публикуется много нового контента, но, вероятно, не так много новой и уникальной информации или перспектив.

Обнаружено — в настоящее время не проиндексировано

При отладке проблем с индексацией я часто обнаруживаю это на веб-сайтах электронной коммерции или веб-сайтах, которые используют значительный программный подход к созданию контента и публикуют большое количество страниц одновременно.

Основные причины, по которым страницы попадают в эту категорию, могут быть связаны с краулинговым бюджетом, поскольку вы только что опубликовали большое количество контента и новых URL-адресов и экспоненциально увеличили количество сканируемых и индексируемых страниц на сайте, а также краулинговый бюджет который Google определил для вашего сайта, не предназначен для такого количества страниц.

Вы мало что можете сделать, чтобы повлиять на это. Тем не менее, вы можете помочь Google с помощью карт сайта в формате XML, карт сайта в формате HTML и хороших внутренних ссылок, чтобы передать рейтинг страницы с важных (проиндексированных) страниц на эти новые страницы.

Вторая причина, по которой контент может попасть в эту категорию, связана с его качеством, и это часто встречается на сайтах программного контента или электронной коммерции с большим количеством продуктов и PDP, которые являются похожими или вариативными продуктами.

Google может идентифицировать шаблоны в URL-адресах, и если он посещает определенный процент этих страниц и не находит никакой ценности, он может (и иногда будет) делать предположение, что HTML-документы с похожими URL-адресами будут одинакового (низкого) качества, и он решит не сканировать их.

Многие из этих страниц были созданы преднамеренно с целью привлечения клиентов, например, программные страницы местоположения или страницы сравнения, ориентированные на нишевых пользователей, но поиск по этим запросам осуществляется с низкой частотой, они, скорее всего, не привлекут много внимания, а содержание может быть недостаточно уникальным по сравнению с другими программными страницами, поэтому Google не будет индексировать контент с низкой ценностью, когда доступны другие альтернативы.

В этом случае вам необходимо оценить и определить, могут ли цели быть достигнуты в рамках ресурсов и параметров проекта без избыточных страниц, которые забивают сканирование и не считаются ценными.

Дублированный контент

Дублированный контент является одним из самых простых и часто встречается в электронной коммерции, издательском деле и программатике.

Если основной контент страницы, содержащий ценностное предложение, дублируется на других веб-сайтах или внутренних страницах, Google не будет вкладывать ресурсы в индексирование контента.

Это также связано с ценностным предложением и концепцией полезной цели. Я сталкивался с многочисленными примерами, когда на крупных авторитетных веб-сайтах контент не индексировался, потому что он такой же, как и другой доступный контент — не предлагает уникальных перспектив или уникальных ценностных предложений.

Принятие мер

Для большинства крупных веб-сайтов и веб-сайтов среднего размера добиться 100% индексации будет только сложнее, поскольку Google должен обрабатывать весь существующий и новый контент в Интернете.

Если вы обнаружите, что качество ценного контента ниже порогового, какие действия следует предпринять?

- Улучшение внутренней перелинковки со страниц с «высокой ценностью» : Это не обязательно означает страницы с наибольшим количеством обратных ссылок, но те страницы, которые ранжируются по большому количеству ключевых слов и имеют хорошую видимость, могут передавать положительные сигналы через описательные привязки к другим страницам.

txt позволяют индексировать ваш веб-сайт

txt позволяют индексировать ваш веб-сайт Это не проблема «этой страницы», это больше касается всего сайта. Создание хорошей структуры сайта и обеспечение максимально возможного качества сайта — это, по сути, направление.

Это не проблема «этой страницы», это больше касается всего сайта. Создание хорошей структуры сайта и обеспечение максимально возможного качества сайта — это, по сути, направление.