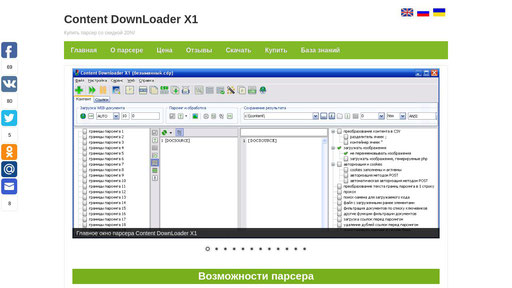

Content Downloader — универсальный парсер контента

>>> Экспресс-курс по изучению основ работы с Content Downloader

Готовые файлы проектов

Данные файлы проектов (в основном) доступны только для Content Downloader с типом лицензии ULTIMATE (UNLIMITED)

Апгрейд типа лицензии и покупка UNLIMITED подписки осуществляется на этой странице (клик)

Проект парсинга товаров с Озон (на WBAppCEF3)

Проект парсинга выдачи Google

Проект парсинга телефонов с Auto.ru (на WBAppCEF3)

Проект парсинга телефонов с kolesa.kz (на WBAppCEF3)

Проект парсинга Wildberries

Автоматический перевод текста при парсинге с использованием сервиса Google переводчик

Файлы проектов для демо версии (подойдут для обучения и парсинга)

Файлы проектов от энтузиастов

Разделы

Основное

Парсинг контента (текст, картинки)

Парсинг и добавление ссылок

Создание дополнительных HTTP-запросов при парсинге во вкладке “Контент”

Обработка контента при парсинге во вкладке “Контент”

Парсинг товаров из интернет магазинов или XML файлов

Парсинг с использованием движков браузера (с выполнением Javascript на WEB страницах и автоматизацией/имитацией действий пользователя в браузере)

Типичные задачи и примеры парсинга

Парсинг в различные форматы и CMS

Подключение файлов к шаблону вывода

Автоматизация

Редактор CSV файлов

Решение различных проблем

Рекомендации по настройке системы

Дополнительно

Полезное с форума

Для возврата к меню навигации пользуйтесь клавишей home

Создать запрос на пополнение/редактирование материалов системы помощи!

Основное

Экспресс курс по изучению основ работы с программой (необходимо его освоить в первую очередь)

Как загружаются WEB страницы в браузере (ТАКЖЕ НЕОБХОДИМО ИЗУЧИТЬ)!

Знакомство с элементами интерфейса

Шаблон вывода (в нем вы создаете структуру результирующего файла (результат парсинга контента) и работаете с данными, используя различные макросы шаблона вывода)

– Редактирование шаблона вывода в виде таблицы

– Работа со строкой заголовка и шаблоном вывода при настройке парсинга в CSV

– Как выборочно отключить контейнер ячеек для определенных ячеек CSV (оператор {NOCONTAINER})

Дополнительные макросы шаблона вывода

Работа с вложенными блоками кода шаблона вывода (для удобной работы с громоздкими конструкциями макросов в шаблоне вывода или в шаблонах повторяющихся границ парсинга)

Добавление текстовых комментариев к коду шаблона вывода, комментирование частей кода шаблона вывода и лишних переносов строк

Менеджер макросов шаблонов вывода

Менеджер шаблонов вывода, макросов и правил поиск-замены

Программные операторы разделителей ячеек CSV: [CSVCS], [CSVLB], {CSVCS}, {CSVLB}, [CSVCS]→

Лог парсинга WEB документов (для вкладок “Контент” и “Ссылки”)

Если последовательность макросов или вложенные в друг-друга макросы шаблона вывода «работают некорректно» (или: как пользоваться логом выполнения функций и макросов)

Как парсить «вхолостую» (без отправки запросов, только лишь выполняя макросы шаблона вывода) во вкладке «Контент» (оператор [BLANK])

Функция создания шаблона вывода на основе заданных границ парсинга

Как генерировать в строке заголовка текст по шаблону с нарастающими переменными

Как быстро просматривать контент границ парсинга в главном окне программы

Основы парсинга контента

Нюансы парсинга и настройки программы (важно усвоить)

Авторизация на сайтах

Как передать Cookie и другие HTTP заголовки в программу

Передача cookie из браузера в программу

Использование списка прокси-серверов в программе

Функции поиск-замены и регулярные выражения

– Как производить поиск-замену в только что загруженном коде WEB-документа при парсинге (выполняется перед вычислением границ парсинга)

– Режим поиска-замены слов ([WORDMODE])

– Как обходить замену уже замененных частей текста при использовании нескольких правил поиск-замены ([AVOID_RE])/Как быстро обработать текст большим количеством правил поиск-замены (1000+)

– Выполнение правил поиск-замены в указанных сегментах текста (между заданным start и end)

– Парсинг JSON-элементов с помощью функций поиск-замены

– Извлечение данных в функциях поиск замены с помощью задания границ парсинга

Как парсить контент, которого нет в коде страницы (часть данных отсутствует в коде, контент подгружается скриптами в браузере)

Как добавить к основному документу (который парсите) дополнительные подгружаемые данные (чтобы задать границы парсинга и с подгруженными данными, макрос [APPENDDOCSOURCE])

Использование оператора [PARAM] в элементах списка ссылок

Как парсить большие XML YML файлы в CSV

Как сделать, чтобы сайт при парсинге отправлял сжатые данные GZip (для экономии WEB трафика)

Как ускорить парсинг (путем снижения нагрузки на процессор)

Как создавать заявки для получения услуг специалистов по настройке

Парсинг контента (текст, картинки)

Задание обычных границ парсинга (когда нужно спарсить до 20 различных частей WEB-документа)

– Поиск конца обычных границ парсинга в обратном направлении (параметр инверсия)

– Автоматический поиск закрывающего HTML-тега (параметр [AUTO] для конца границы парсинга)

– Автоматический поиск закрывающей фигурной или квадратной скобки (параметр [JSONAUTO] для конца границы парсинга)

Задание обычных границ парсинга внутри повторяющейся (для парсинга каждого цикла повторяющейся границы обычными границами, например, когда нужно спарсить несколько товаров с одной WEB-страницы)

Задание динамических границ парсинга (КОГДА НУЖНО ЗАДАТЬ БОЛЕЕ 20 ГРАНИЦ ПАРСИНГА, работают аналогично обычным границам парсинга, но поддерживают регулярные выражения и не ограничены по количеству)

Как использовать контент одной границы парсинга в качестве начала или конца другой

Задание повторяющихся границ парсинга (когда нужно спарсить множество частей WEB-документа, заключенных в одинаковые участки кода, например, спарсить комментарии)

– Автоматический поиск закрывающего HTML-тега (параметр [AUTO] для конца границы парсинга)

– Автоматический поиск закрывающей фигурной или квадратной скобки (параметр [JSONAUTO] для конца границы парсинга)

– Фильтрация циклов повторяющихся границ

– Задание повторяющихся границ парсинга внутри повторяющейся

– Как производить поиск элементов нужной повторяющейся границы в тексте обычной границы парсинга (в определенной части кода WEB-документа), а не в целом коде WEB-документа

– Как выводить каждый цикл повторяющихся границ парсинга с новой строки CSV в том же столбце

– Как сделать, чтобы количество столбцов CSV, создаваемых повторяющимися границами парсинга было всегда одинаковым, вне зависимости от количества найденных циклов (чтобы столбцы справа не плавали)

– Создание комбинаций из значений циклов выбранных повторяющихся границ парсинга

– Вставка в шаблон одной повторяющейся границы парсинга смежных (параллельных) значений циклов из любых других повторяющихся границ

– Вставка в каждый цикл повторяющихся границ парсинга нужных значений переменных, заданных (в другом месте) с помощью макроса [VAR]

– Как быстро добавить макросы в шаблон нужной повторяющейся границы парсинга

– Удаление дублей циклов повторяющихся границ парсинга

– Как выводить определенные данные только в первом цикле повторяющихся границ прсинга

– Как выводить повторяющуюся границу на нескольких строках столбца CSV (парсинг в HostCMS) или как вытягивать определенные данные вниз в определенном столбце CSV (макросы [EXPANDV] и [EXPANDV_FILL])

Настройка сохранения результатов парсинга контента в указанные файл(ы) на диск с помощью макроса [DOCNAME] (задание имен сохраняемых документов, кодировки сохраняемых документов, парсинг в один файл/в отдельные файлы и другое)

Парсинг одного WEB-документа в несколько разных файлов на диск (сохранение произвольных частей шаблона вывода в указанные файлы макросом [SAVETOFILE])

Загрузка файлов на диск, их переименование и указание папки (пути) для сохранения (загрузка картинок, pdf-файлов, архивов, mp3, flv и так далее)

– Скачивание нескольких картинок с использованием повторяющихся границ парсинга

– Парсинг картинок из JSON блоков кода

– Вывод одних и тех же картинок в каждом цикле повторяющихся границ парсинга (с помощью макроса [VAR])

– Изменение размеров изображений, скачиваемых макросом DOWNLOADFILE

– Наложение watermark (водяных знаков) при парсинге картинок

– Как автоматически удалять из результата парсинга IMG теги нескачанных картинок (с нерабочими ссылками)

– Вывод в результат парсинга контента имен файлов, скачанных макросом DOWNLOADFILE

– Вывод в результат парсинга контента размеров файлов/изображений, скачанных макросом DOWNLOADFILE

– Вывод в результат парсинга контента размерностей изображений (ширина и высота), скачанных макросом DOWNLOADFILE

– Использование [DFSTATUS] для вывод статуса работы макросов DOWNLOADFILE

– Как с помощью макроса DOWNLOADFILE скачивать картинки из HTML-тегов IMG

– Как парсить определенное количество WEB-документов в каждый файл и создавать отдельную папку с картинками для каждого такого файла

– Если не скачиваются файлы по HTTPS-протоколу

– Если в коде WEB-документа нет URL-адресов картинок

– Как отключить автоматическое переименование файлов (и другие опции DOWNLOADFILE)

– Как пропускать скачивание файлов по одинаковым ссылкам и вставлять нужные данные в результат

– Как удалять из картинок все мета данные (meta data) при их скачивании

Парсинг BASE64-картинок

Если вам нужно быстро и легко собрать, скажем, ссылки на все товары или статьи, первым делом рекомендуется проверить наличие карты сайта. Обычно карта имеет актуальный набор ссылок и располагается по адресу типа https://***.ru/sitemap.xml (в корне сайта). Просто попробуйте открыть подобный адрес у себя в браузере. Если карты сайта по такому адресу нет, проанализируйте файл robots.txt (https://***.ru/robots.txt), в котором может быть строка с ее другим адресом типа Sitemap: https://***.ru/map/sitemap.xml (как парсить XML-карту сайта описано в этом разделе ниже).

Обычно карта имеет актуальный набор ссылок и располагается по адресу типа https://***.ru/sitemap.xml (в корне сайта). Просто попробуйте открыть подобный адрес у себя в браузере. Если карты сайта по такому адресу нет, проанализируйте файл robots.txt (https://***.ru/robots.txt), в котором может быть строка с ее другим адресом типа Sitemap: https://***.ru/map/sitemap.xml (как парсить XML-карту сайта описано в этом разделе ниже).

Если ссылки на некоторых сайтах не парсятся

Фильтры ссылок (отсеивание лишних ссылок при парсинге)

– Использование регулярных выражений в фильтрах ссылок и в фильтрах списка очереди сканера сайтов

Парсинг ссылок со страниц рубрики сайта (сбор ссылок во вкладке «ссылки»)

– Генерация списков ссылок с использованием заданных числовых и/или строковых значений (ключевых слов)

– Использование в URL-адресах динамического оператора {num:a,b} при парсинге во вкладке «Ссылки» (автоматическая генерация ссылок, когда конечное число диапазона неизвестно или может изменяться)

– Парсинг поисковых форм сайта с использованием списка запросов

Сканер сайтов (робот обойдет страницы сайта и спарсит с них ссылки)

– Если сканер сайтов находит не все ссылки (или вообще не находит ни одной ссылки)

– Запись выдачи ссылок в файл при работе сканера сайтов (для оптимизации потребления памяти)

– Парсинг товаров из указанных рубрик с помощью сканера сайтов (когда количество страниц со списком товаров в каждой рубрике разное)

– Как сканером сайтов выполнять поиск ссылок только в определенных частях WEB-страниц сайта

– Как сканером парсить сразу несколько XML карт сайтов

Парсинг ссылок из XML-карты сайта

– Парсинг составных XML-карт сайтов (в карте сайта находятся ссылки на несколько XML-карт)

– Как парсить ссылки с определенным proirity из XML карты сайта

Парсинг ссылок, подгружаемых при клике по кнопке типа «показать еще» (с помощью WBApp)

Парсинг ссылок или товаров с автоматическим прокликиванием всех страниц рубрики сайта (с помощью WBApp)

Автоматическое добавление файлов из указанной папки локального диска в список ссылок при парсинге (SCANDIR)

Другие методы парсинга ссылок, методы добавления ссылок в программу, парсинг файлов с локального диска

Создание дополнительных HTTP-запросов при парсинге во вкладке “Контент”

>>> Базовая информация по созданию GET или POST запросов в Content Downloader

Парсинг телефонов с сайтов, где для отображения телефона нужно кликнуть по кнопке (парсим с помощью макросов PHP_SCRIPT и GETMORECONTENT)

Смотрите также: Как парсить во вкладке “Контент” или “Ссылки” с использованием POST-запросов

Обработка контента при парсинге во вкладке “Контент”

Дополнительные макросы шаблона вывода

– Как разбить текст на части по количеству символов (макрос шаблона вывода [SLICE_STRING])

Функции поиск-замены и регулярные выражения

– Как производить поиск-замену в только что загруженном коде WEB-документа при парсинге (выполняется перед вычислением границ парсинга)

– Режим поиска-замены слов ([WORDMODE])

– Как обходить замену уже замененных частей текста при использовании нескольких правил поиск-замены ([AVOID_RE])/Как быстро обработать текст большим количеством правил поиск-замены (1000+)

– Выполнение правил поиск-замены в указанных сегментах текста (между заданным start и end)

– Парсинг JSON-элементов с помощью функций поиск-замены

Удаление дублей информации при парсинге контента

Настройка правил транслитизации (транслитерации)

Обработка данных с помощью отправки запросов к сторонним API при парсинге контента (например, для перевода или синонимизации контента)

Автоматический перевод текста при парсинге

Макросы шаблона вывода для задания и вывода переменных ([VARF], [VAR])

| Преобразование HTML-таблиц с объединенными ячейками (атрибуты rowspan и colspan) в обычный вид (макрос [APPLYTABLESPANS]) Загрузка HTML-таблиц в память и вывод данных в нужном формате (макросы шаблона вывода: [LOADHTMLTABLE], [GETTDATA], [REBUILD]) Преобразование многострочных HTML-таблиц в двухстрочные (методом объединения данных первых нескольких рядов ячеек, кроме последнего, макрос [MERGETABLEROWS]) Удаление лишних атрибутов HTML-тегов (макрос шаблона вывода [CLEARTAGSATTRS]) |

Парсинг определенных (перечисленных) слов из текста или очистка текста от определенных (перечисленных) слов (макрос [EXTRACTWORD])

Парсинг определенных характеристик товаров из неформатированного текста (макрос [EXTRACTATTR])

Использование встроенного синонимайзера (макрос шаблона вывода [SYN]…[/SYN])

Вычисление математических и логических конструкций с помощью макроса шаблона вывода [MATH]

Генерация в цикле текста/кода с использованием нарастающей числовой переменной (макрос [GENERATE])

Как объединять массивы данных из разных частей WEB-документа по ключевым значениям

Сортировка строковых или числовых элементов текста (макрос шаблона вывода [SORT])

Парсинг товаров из интернет магазинов или XML файлов

Сопоставление товаров из разных интернет магазинов

Парсинг товаров интернет-магазинов в CSV

– Общая и базовая информация по поводу парсинга характеристик товаров

– Парсинг товаров по списку артикулов/наименований

– Парсинг товаров с несколькими размерами или цветами (от выбранного размера или цвета меняются картинки товара, цены и описание)

– Пример парсинга товаров с несколькими ценами и вариантами характеристик (цены и варианты характеристик выведены рядом в обычном виде)

– Парсинг товаров с изменяющимися атрибутами (например, размеры меняются в зависимости от выбранного цвета, размеры и цвета в разных местах кода WEB-документа)

– Парсинг характеристик товаров в случаях, когда имена и значения характеристик идут не поочередно, а отдельно (сначала перечислены имена, потом значения)

– Парсинг в CSV всех характеристик товара РАЗОМ в одну или в отдельные ячейки CSV

Автоматический парсинг сразу всех характеристик товаров с автоматическим созданием соответствующих колонок CSV (макрос [DYNAMICVALUES])

– Задание порядка столбцов (по введенным наименованиям) для макроса [DYNAMICVALUES] (также для: [HORIZTABLE], [VERTTABLE], [XMLELEMENTSTOCSV]) + ввод только определенных наименований характеристик для парсинга (параметр {LISTEDONLY})

– Парсинг характеристик товаров из JSON в CSV с помощью макроса [DYNAMICVALUES]

Автоматический парсинг характеристик товаров HTML-таблиц в CSV (макросы: [HORIZTABLE] и [VERTTABLE])

– Задание порядка столбцов (по введенным наименованиям) для макроса [DYNAMICVALUES] (также для: [HORIZTABLE], [VERTTABLE], [XMLELEMENTSTOCSV]) + ввод только определенных наименований характеристик для парсинга (параметр {LISTEDONLY})

– Как преобразовать HTML-таблицу с атрибутами rowspan и colspan в обычный вид (метод размножения ячеек)

Автоматический парсинг XML элементов (характеристик товаров) в CSV с помощью макроса шаблона вывода [XMLELEMENTSTOCSV]

– Задание порядка столбцов (по введенным наименованиям) для макроса [DYNAMICVALUES] (также для: [HORIZTABLE], [VERTTABLE], [XMLELEMENTSTOCSV]) + ввод только определенных наименований характеристик для парсинга (параметр {LISTEDONLY})

Получение атрибутов, внутреннего текста тегов/Получение вложенной структуры рубрик товаров из XML (макрос [GETTAGDATA])

Прокликивание опций товаров в браузере WBAppCEF для парсинга их на разные строки CSV (универсальный метод)

Создание с помощью повторяющихся границ в CSV нескольких строк одного товара, где на каждой строке будет изменяться какой-либо атрибут товара (например, цвет)

Парсинг товаров с опциями, представленными в коде WEB-страницы в виде массива JSON

Парсинг товаров с опциями (при выборе которых меняется, например, стоимость) в разные строки CSV (все данные есть в коде WEB-документа)

Парсинг товаров с выбором опций (напрмер, цвет, размер) в случае, когда при смене опций меняется URL товара в адресной строке браузера

Парсинг товаров с выбором опций (напрмер, цвет, размер) в случае, когда при смене опций происходит подгрузка данных с помощью POST или GET запроса

Парсинг картинок товаров в случаях, когда картинки подгружаются при выборе/смене цвета товара (или другой опции) (всех нужных данных нет в коде WEB-документа и они подгружаются дополнительными запросами)

Парсинг названий рубрик товаров с помощью макроса [BREADCRUMBS]

Извлечение ID или артикула товара из строки заголовка с помощью макроса [EXTRACTID]

Генерация уникальных ID товаров или статей при парсинге контента с помощью макроса [SKU_UNIQUE]

Если столбцы CSV плавают на разных товарах при парсинге контента

Методы фильтрации товаров при парсинге (отсеивание лишних товаров по заданным условиям)

Фильтрация товаров при парсинге по нескольким условиям

Как парсить только новые товары на сайте (спарсенные ранее фильтровать)

Как производить мониторинг, анализ и сравнение цен товаров от разных магазинов

Как парсить только новые и обновленные товары

Парсинг с использованием движков браузера (с выполнением Javascript на WEB страницах и автоматизацией/имитацией действий пользователя в браузере)

WBAppCEF (с использованием движка Chrome) (запуск пользовательских Javascript) (только для ULTIMATE версий)

– Загрузка списка прокси из файла на диске и автоматическая смена прокси при каждом вызове события [PROXYFILE]

– Скачивание изображений в WBAppCEF (функциями браузера) и их передача в Content Downloader (с возможностью преобразования webp в JPG)

– Автоматизация действий клика по страницам выдачи сайта в браузере

– Автоматизация действий пользователя в браузере при парсинге (на примере использования Api конвертации XLSX в CSV)

WBApp2 – программа/Api для быстрого парсинга сайтов с помощью движка браузера Chromium

WBAppIE (с использованием движка Internet Explorer) (имитация кликов по элементам веб-страниц, прокрутка веб-страниц, заполнение форм и многое другое) (только для ULTIMATE версий)

– Значительное ускорение процесса парсинга и исключение пропусков WEB-страниц при парсинге с использованием библиотеки Internet Explorer (WBApp)

– Как в WBApp прокликивать страницы выдачи сайта по кнопке типа «перейти на следующую страницу»

– Передача текстовых данных из Content Downloader в WBApp

– Создание скриншотов WEB-страниц с помощью приложения WBApp

– Парсинг HTML-кода фрейма WEB-документа с помощью WBApp

– Запись текущего кода WEB-страницы в файл на диске

– Вызов WBApp для смены пользователя (на сайте) через каждые n документов при парсинге во вкладке «Контент»

– Имитация нажатий кнопок мыши и клавиатуры в WBApp

– Если событие вставки текста в поля WEB-страницы не срабатывает или срабатывает некорректно

– Рендеринг (создание изображений) элементов WEB-страниц с помощью WBApp

– Автоматическая авторизация через WBApp при парсинге

Типичные задачи и примеры парсинга

Как допарсить данные в прайс поставщика

Парсинг статей с сайтов (с картинками и без)

Как парсить заскриптованные сайты (информация на WEB страницах подгружается скриптами в браузере)

Парсинг поисковых форм сайтов с передачей в результат ключевых слов (по которым производился поиск) с помощью [PARAM]

Парсинг XML файла в CSV (преобразование XML в CSV)

Как парсить контактные данные (e-mail, номера телефонов, адреса)

Автоматический парсинг e-mail адресов и номеров телефонов из кода WEB-документов

Как парсить адреса e-mail из кода WEB-документа

Как парсить многостраничные комментарии или отзывы

Обработка файлов на локальном диске (как обработать содержимое файлов и затем сохранить изменения)

Парсинг фильтров товаров (характеристик) со страниц рубрик сайта

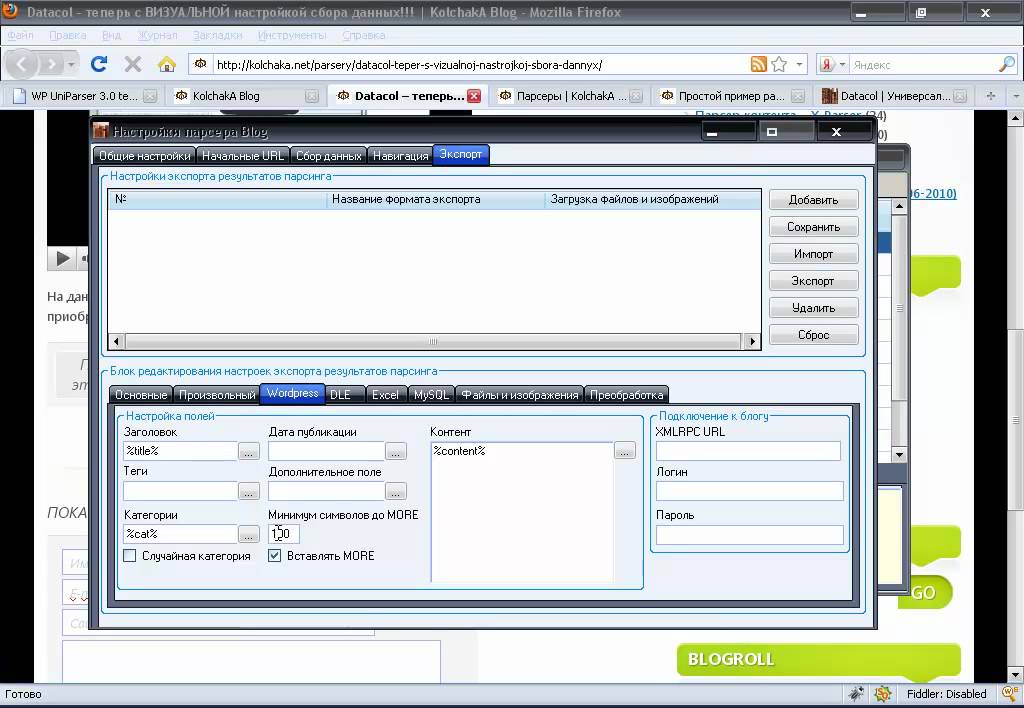

Парсинг в различные форматы и CMS

Парсинг WEB-документов в XML файлы

– Создание структуры рубрик XML (с Id и parentId)

Как парсить сразу в MYSQL-базу (обновление цен товаров, добавление записей и многое другое)

Создание XML-файла импорта в WordPress

Переименование изображений для CMS OpenCart (задание имен файлов дополнительных изображений с нарастающим индексом)

Подключение файлов к шаблону вывода

Работа с подключаемыми таблицами CSV (чтение и запись данных из/в CSV-файлы на диске и многое другое, макросы: [LOADCSV], [GETCSVDATA], [PUTCSVDATA], [GETCSVCOORD], [COPYCSVDATA], [CSVREPLACE])

– Подключение CSV файлов с их предварительным скачиванием по URL

– Закачка подключенных CSV на FTP при завершении парсинга контента

– Как допарсить данные в CSV-файл на диске (например, загрузить картинки)

– Как производить мониторинг, анализ и сравнение цен товаров от разных магазинов

Подключение XML-файлов к шаблону вывода (для дозаписи, макросы: [LOADXML], [XMLADD])

Макрос шаблона вывода [FILE] (вставка данных из файла на диске)

Автоматизация

Загрузка любых файлов с локального диска на FTP сервер

Запуск PHP-скриптов перед парсингом контента

Автоматизация выполнения различных действий (автозагрузка списка ссылок перед парсингом, постобработка CSV, зарузка картинок на FTP и прочее)

Запуск программы с передачей параметров (например, из командной строки или планировщика Windows с возможностью запуска по расписанию)

Загрузка (UPLOAD) документов (в которые парсим контент), файлов и картинок на FTP-сервер при парсинге контента

Распознавание каптчи с помощью сервиса Antigate

Распознавание каптчи, отправка текста каптчи и получение ответных cookies (с использованием WBApp) при парсинге контента

Автоматическое пересохранение полученных CSV файлов в формат XLS при завершении парсинга контента

Выключение компьютера при завершении парсинга контента

Как разбить CSV-файлы на части при завершении процедуры парсинга контента

Как автоматически загрузить в список ссылок файлы из папки на локальном диске с помощью SCANDIR (просканировать папку на наличие файлов и приступить к парсингу контента)

Использование встроенного планировщика программы (запуск цепочек проектов по расписанию)

Автоматическая приостановка парсинга во вкладке “Контент” при появлении капчи для ее ручного разгадывания (макрос шаблона вывода [WAITFORME])

Редактор CSV файлов

Редактор CSV файлов (общее)

Как объединить (склеить) несколько CSV файлов (простым методом)

Объединение нескольких CSV файлов с автоматическим распределением данных по столбцам

Слияние (объединение) двух CSV файлов (двух таблиц товаров) по ключевым столбцам

Разбивка CSV файла по количеству строк или по названиям рубрик (именам в ячейках)

Изменение структуры CSV таблицы (перенос имен характеристик из строки заголовка в соответствующие столбцы)

Загрузка (скачивание) картинок из интернет по ссылкам в таблице CSV

Как наполнить таблицу CSV картинками из Google (выбирая их вручную)

Просмотр и удаление картинок в таблицах CSV

Объединение в CSV строк одинаковых товаров, которые имеют разные рубрики (или какие-то другие данные)

Размножение строк (товаров) с несколькими атрибутами в ячейке

Заполнение пустых ячеек в указанных столбцах CSV

Как переделать CSV прайс поставщика для импорта в интернет магазин (пример для Simpla CMS)

Решение различных проблем

Устранение проблемы западания модальных окон программы друг за друга (при кликах по окну программы слышен звук и программа не реагирует на нажатия кнопок клавиатуры и мыши)

Устранение ошибки «Error reading ImageList. Bitmap: Failed to read ImageList data from stream»

Bitmap: Failed to read ImageList data from stream»

Решение проблем с возможными ошибками загрузки WEB-страниц (в том числе парсинг “проблематичных” HTTPS-сайтов)

Если при предпросмотре все WEB-страницы загружаются, а при парсинге происходят пропуски некоторых WEB-страниц

Отключение появления в Internet Explorer предупреждения системы безопасности “вы хотите отображать только безопасное содержимое веб-страниц?”

Отключение появления в Internet Explorer предупреждения системы безопасности “не удается подтвердить подлинность этого веб-сайта или целостность этого соединения” (или “возникла проблема с сертификатом безопасности этого веб-сайта”)

Решение проблем с возможными “зависаниями” программы или с ошибками “out of memory”, “thread creation error…” при парсинге во вкладке “контент” или в сканере сайтов

Решение проблем с кодировкой при парсинге

Антивирусы могут вмешиваться в работу программы и воздействовать на результат

Рекомендации по настройке системы

Отключите сглаживание неровностей экранных шрифтов Windows

Дополнительно

Как быстро парсить (получить) выделенные мышкой ссылки из браузера

Как производить разбивку CSV файлов (по точному количеству строк) в случае парсинга нескольких товаров с каждой WEB-страницы

Как начать парсить в 1 поток и затем увеличить количество потоков при парсинге во вкладке “Контент” (макрос шаблона вывода [MORE_THREADS])

Добавление последнего WEB-документа в список ссылок с указанным шаблоном вывода при парсинге во вкладке “Контент” с помощью макроса [ADDFINALDOCUMENT]

Как получать MD5 файлов с помощью макроса [GETMD5]

Генерация уникальных ЧПУ из любой текстовой строки (макрос [SURLUNIQUE])

Работа с нарастающими целочисленными переменными ([INT_ID], [COUNT])

Мониторинг данных на WEB-странице и отправка оповещений на почту (например, отправить сообщение, когда цена станет больше указанной)

Парсинг сайтов с экзотическими языками (китайский и прочие)

Парсинг контента и ссылок с использованием POST-запросов

Как парсить несколько картинок с одной страницы с присвоением каждой уникального имени файла

Парсинг сайтов, где названия рубрик на страницах товаров не указаны (названия рубрик товаров указаны только на страницах категорий сайта)

Получение редиректов ссылок (макрос [GETREDIRECT])

Передача произвольных HTTP-заголовков (custom headers) при парсинге контента и ссылок

Как избежать бана при парсинге некоторых сайтов (изменить количество потоков, выставить паузу между запросами, использовать прокси)

Как избежать повторной загрузки одних и тех же WEB-документов при следующем парсинге (во вкладке «контент»)

Инструмент расширенного удаления дублей ссылок

Выполнение операций с файлами на диске (копирование, перемещение, удаление) с помощью макроса шаблона вывода [FILEACTIONS] / Удаление указанных файлов с FTP сервера

Удаление файлов на FTP-сервере с помощью макроса шаблона вывода [FILEACTIONS]

Удаление определенных строк из текстового файла на диске с использованием макроса [DELFILESTRING]

Как выполнить определенные макросы только при парсинге первого WEB-документа

Нюансы парсинга ссылок с символом решетки в них

Задание значения переменной, используемой в ссылках WEB-документов (макрос шаблона вывода [DATAFORURL])

Проверка изменений контента на WEB страницах с последующим выполнением нужных действий (макрос шаблона вывода [CHECKCHANGES])

Поисковый бот для парсинга данных с разных сайтов, URL которых взяты, например, из выдачи Google (макрос шаблона вывода [CRAWLER])

Парсинг контактных данных (e-mail, телефоны) со списка разных сайтов, URL которых взяты, например, из выдачи Google (макрос шаблона вывода [CRAWLER])

Как парсить только свежие статьи или товары (фильтрация по дате публикации)

Генерация комбинаций из нескольких массивов значений (макрос шаблона вывода [COMBINE])

Макрос шаблона вывода [EXTRACTTABLE] – извлечение HTML таблиц из кода WEB страницы

Как парсить сайты с каптчей Recaptca без сервиса разгадывания каптчи и прокси

Полезная информация

Полезное с форума

Использование регулярных выражений в функциях поиск замены

Подстановка Cookie в WBApp с использованием Fiddler

Пример парсинга характеристик по заданным вхождениям из списка строк (с помощью функций поиск-замены)

Как при парсинге отфильтровать товары по количеству характеристик или по количеству других даннных в них

Запись ссылок WEB-документов вместе со значениями [PARAM] в файл на диск при парсинге контента

Как загрузить WEB-страницы сайта в Chrome и затем спарсить их в Content Downloader

Автоматический перевод текста при парсинге через Яндекс Переводчик с использованием WBApp

Как подгрузить список прокси запросом к HTTP-Api и переформатировать ответ из формата JSON в нужный (login:pass@ip:port)

Proxy сервисы которые пригодятся для Content Downloader

Как в каждом цикле повторяющейся границы выводить значения предыдущих циклов повторяющейся границы

Как во вкладке “Контент” повторно спарсить элемент, если результирующий документ оказался пустым (без ошибки загрузки WEB-страницы)

Если на Windows 10 с помощью макроса DOWNLOADFILE не скачиваются картинки (по рабочим ссылкам) даже с помощью библиотеки WIN2 (выбранной в окне shift+ctrl+l)

Пояснения по поводу максимальной длины пути для сохраняемых файлов при парсинге во вкладке “Контент”

Заготовки для популярных CMS в виде готовых .

cdp

cdpРекомендуемые прокси сервисы для парсинга (клик)

Парсинг изображений Content Downloader X1 — Страница 4

|

#31 15.04.2021, 11:54 |

|||

|

|||

|

Граббер картинок Content Downloader X1

В бесплатной версии есть ограничения: либо по объему парсинга данных, либо по времени пользования сервисом. |

|

#32 15.04.2021, 11:55 |

|||

|

|||

|

Программа парсинга картинок Content Downloader X1 Штрихкодированный учет на небольшом складе. [Ссылки только для зарегистрированных… ] Для этого предлагаю вспомнить общеизвестную задачу «банерокрутилку». [Ссылки только для зарегистрированных… ] Они необходимы для начальной настройки парсинга для каждого нового источника. [Ссылки только для зарегистрированных… ] |

|

#33

15. |

|||

|

|||

|

Программа для парсинга картинок с сайтов Content Downloader X1

Для получения уникальных текстов в данном случае нужно будет вручную уникализировать описания или прогонять их через специальные сервисы — уникализаторы контента. [Ссылки только для зарегистрированных… ] Можно изменить отображаемый текст, используя элементы редактирования (вырезать, скопировать, вставить), а также вставить новые строки и столбцы, щелкнув правой кнопкой мыши по списку. |

|

#34 15.04.2021, 11:56 |

|||

|

|||

|

Программа сбора данных Content Downloader X1

Мы вбиваем адрес нужной нам страницы. |

|

#35 15.04.2021, 11:57 |

|||

|

|||

|

Граббер объявлений Content Downloader X1 А это означает, что нельзя ко всем изображениям прописать один виртуальный путь. [Ссылки только для зарегистрированных… ] Это и есть автоматическое сопоставление товаров. [Ссылки только для зарегистрированных… ] В обязанности технической поддержки входит только решение проблем с активацией программы! [Ссылки только для зарегистрированных… ] |

|

#36

15. |

|||

|

|||

|

Парсинг интрнет магазинов Content Downloader X1

Например, высокую скорость обработки материалов и их анализ даже в огромном объеме. [Ссылки только для зарегистрированных… ] У сервиса есть и дополнительные возможности и специальные функции — можно скачивать только новые объявления или платить только за уникальные номера, получать полную статистику просмотров за 14 дней или тип оператора сотовой связи. |

|

#37 15.04.2021, 11:59 |

|||

|

|||

|

Парсер картинок Content Downloader X1

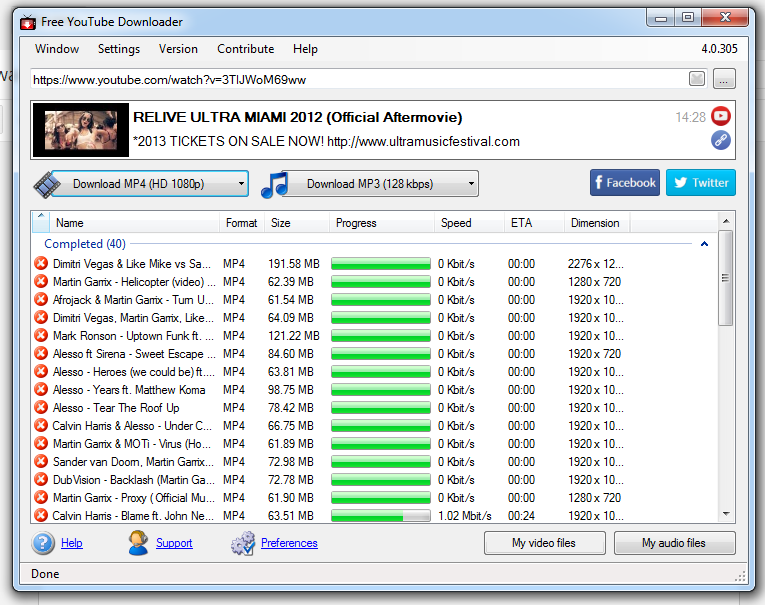

С помощью видео граббера вы сможете автоматизировать этот процесс. |

|

#38 15.04.2021, 12:00 |

|||

|

|||

|

Граббер статей Content Downloader X1 Вам становится известно место проживания, род занятий, увлечения и многое другое. [Ссылки только для зарегистрированных… ] Парсеры, способные в течение суток перебрать большую часть веб-ресурсов в поисках нужной информации, автоматизируют ее. [Ссылки только для зарегистрированных… ] Для чего применяется парсер контента? [Ссылки только для зарегистрированных… ] |

|

#39

15. |

|||

|

|||

|

Граббер товаров Content Downloader X1

Копируем адрес фотографии и вставляем в адресной строке браузера. [Ссылки только для зарегистрированных… ] К примеру, критериев, по которым оценивает сайт Яндекс, порядка 700. [Ссылки только для зарегистрированных… ] В этих тегах, обычно, содержатся нужные для парсинга данные. [Ссылки только для зарегистрированных. |

|

#40 15.04.2021, 12:01 |

|||

|

|||

|

Программа для парсинга картинок с сайтов Content Downloader X1

Если вам приходилось работать с форматированными строками программно, то вы знаете, какая это боль. |

Как парсить картинки с сайтов

При подготовке статейных материалов, каталогов товаров для интернет-магазинов и оформлении групп в социальных сетях сложно обойтись без картинок. Распространенное решение – искать картинки по ключевым словам в поисковиках – не всегда является лучшим. Например, как быть с подбором картинок к товарному каталогу размером 100 000 позиций? Чаще всего актуальнее делать парсинг картинок. О том, что это такое, зачем он нужен и как проводится, мы расскажем подробно далее.

Парсинг изображений – это автоматический процесс сбора картинок из интернета. Найденные картинки релевантны запросам пользователя, поскольку их парсинг происходит по ключевому слову или артикулу. Плюс состоит в том, что можно задать ограничения на размер и вес изображения, выбрать для поиска только определенные сайты и т.д. Как результат, вы получаете нужный и качественный контент в формате картинок, затратив на поиск минимум времени и усилий.

Найденные картинки релевантны запросам пользователя, поскольку их парсинг происходит по ключевому слову или артикулу. Плюс состоит в том, что можно задать ограничения на размер и вес изображения, выбрать для поиска только определенные сайты и т.д. Как результат, вы получаете нужный и качественный контент в формате картинок, затратив на поиск минимум времени и усилий.

Форма парсинга картинок

Существует две формы парсинга картинок: в виде изображений и URL на них. Первый вариант оптимален в случае, когда происходит добавление фото через стандартный функционал административной панели сайта или при размещении в социальных сетях. URL картинок используют, когда их добавляют через модуль импорта CMS: зачастую админки интернет-магазинов сами скачивают их по внешним урлам, и размещают в файловой системе. Исходя из формы парсинга выбирается оптимальный вариант для поиска изображений.

Обзор инструментов для парсинга картинок

Для парсинга изображений создано огромное количество инструментов. Все они подразделяются на несколько основных категорий. Разберем каждую из них подробно.

Все они подразделяются на несколько основных категорий. Разберем каждую из них подробно.

Онлайн-сервисы

Бесплатный парсер картинок онлайнБольшой популярностью пользуются онлайн-сервисы. Они позволяют сразу перейти к парсингу картинок, минуя необходимость проводить установку ПО. Вы задаете параметры поиска, запускаете процесс и ожидаете результатов. Выгрузку найденных изображений можно проводить на ПК, съемный носитель или облачное хранилище.

К преимуществам онлайн-сервисов для поиска изображений относится:

- Простота использования.

- Не нужно тратить время на скачивание и инсталляцию софта.

- Быстрый процесс поиска изображений.

- Возможность создания общего архива для файлов с одного источника.

Есть у онлайн-сервисов ряд недостатков, к ним относится:

- Многопоточный режим обычно ограничивается 5-10 сайтами.

- Небольшое количество настроек для поиска.

Есть ограничения на количество фото, которое можно спарсить из социальных сетей в рамках одного запроса.

Десктопные парсеры картинок

Десктопные парсеры картинок – программные решения для поиска изображений. Софт отличается по интерфейсу, функционалу, параметрам поиска и другим критериям. Для начала работы нужно выполнить установку программки на компьютер, выполнить предварительную настройку, а потом запустить парсинг фото. Их загрузка будет выполнена в выбранную директорию.

К основным преимуществам использования десктопных парсеров картинок относится:

- Не нужно каждый раз выполнять настройку, можно проводить поиск изображений по выбранным параметрам.

- Поддержка широкого функционала (выборка размеров картинок, их ориентации, разрешения и т.д.).

- Удобное сканирование нескольких ресурсов. Например, парсинг картинок с Content Downloader можно проводить в многопоточном режиме, активировав автоматическую загрузку результативных файлов в выбранные папки.

- Поддержка уникализации найденных картинок.

Есть у десктопных парсеров некоторые недостатки, в их числе:

- Нужно тратить время на установку.

- Есть ограничения в бесплатных версиях

- Большая часть софта предлагается на платной основе.

Сервисы по подписке

Существуют онлайн-сервисы по подписке. Пользователям предлагаются разные тарифные планы. Они могут предусматривать оплату за парсинг определенного количества картинок или право на пользование сервисом в течение дня, недели, месяца или полугода.

У онлайн-сервисов для парсинга изображений по подписке следующие преимущества:

- Поддержка более широко спектра возможностей, чем у бесплатных сервисов для парсинга контента в формате фото.

- Нет ограничений по массовой выгрузке.

- Возможность задействовать в многопоточном режиме более 10 источников.

Недостаток таких онлайн-сервисов понятен – нужно оплачивать подписки. Стоимость на них варьируется, начиная от $5 и достигая $100.

Парсеры надстройки картинок

Есть также парсеры надстройки картинок. Здесь идет речь о специальных скриптах, которые создаются для MS Excel. По сути, они представляют собой набор макросов, которые отвечают за выполнение определенных функций.

По сути, они представляют собой набор макросов, которые отвечают за выполнение определенных функций.

К парсерам надстройки обязательно идут скрипты для их управления.

К преимуществам парсеров в виде надстроек для поиска изображений относится:

- Скрипт не нагружает операционную систему ПК.

- Удобный формат формирования базы с URL картинками.

- Легкий поиск нужных изображений.

К недостаткам парсеров в формате надстройки для поиска картинок относится:

- Небольшой функционал.

- Невысокая скорость работы.

- Часто возникновение ошибок.

Программы для парсинга картинок

Существует десятки программ для парсинга картинок. Большинство из них схожи по функционалу и принципу работы. Некоторые предполагают покупку лицензии, другие доступны пользователям бесплатно. Мы решили рассмотреть самые популярные ПО для поиска картинок.

Image Parser

Image Parser – бесплатный парсер картинок, представленный в качестве расширения для Google Chrome. Значок плагина появляется в панели браузера после установки.

Значок плагина появляется в панели браузера после установки.

Чтобы запустить поиск изображений, нужно открыть сайт и кликнуть по иконке расширения. В новом окне появятся все найденные изображения на выбранном ресурсе. Находит данный софт картинки в тегах IMG и подключаемых файлах стилей, а также в «защищенных» страницах. Все изображения можно сохранить в ZIP архив.

- Бесплатная программа

- Можно скачивать картинки в форматах png, jpg, jpeg, gif.

- Парсит «защищенные» с данными страницы.

Поддерживается парсинг ссылок на картинки.

Минусы

- Для запуска программы нужно открыть сайт.

- Нельзя парсить одновременно несколько ресурсов, что снижает скорость поиска картинок.

- Нет фильтров для выборки изображений.

ImageGrabber RX

ImageGrabber RX – платная программа для парсинга изображений. Может анализировать одновременно десятки сайтов, искать картинки на определенном источнике. Поддерживается фильтрация изображений по размеру. При поиске происходит сравнение фото-контента с базой. Происходит выгрузка только уникальных картинок, которые ранее не скачивались в локальное хранилище.

Поддерживается фильтрация изображений по размеру. При поиске происходит сравнение фото-контента с базой. Происходит выгрузка только уникальных картинок, которые ранее не скачивались в локальное хранилище.

- Высокая скорость работы.

- Анализ картинок с базой для выборки уникальных изображений.

- Фильтрация мелких картинок.

Минусы

- Нужно покупать лицензию на использование.

- Не всегда ПО обходит защиту страниц.

GoogleImageFinder

GoogleImageFinder – парсер картинок с сайта images.google. Отличается интуитивно понятным интерфейсом и простым запуском для работы. Для поиска изображений требуется указать их количество, нужное разрешение и размер, ключевые слова и директорию для загрузки. После нажатия на кнопку «Старт» программа начнет парсинг. Для каждого запроса можно создавать отдельные папки, а потом уникализировать скачанные изображения по выбранным параметрам.

- Есть демо-версия.

- Поддерживается широкий набор инструментов.

- Быстрая работа.

- Можно сохранять исходные названия картинок.

- Поддерживается парсинг ссылок на картинки с сайта, чтобы чтобы сэкономить место в своем хранилище.

- Уникализация картинок по заданным параметрам.

Минусы

- Нужно покупать лицензию после использования программы в демо-версии.

Не поддерживается парсинг картинок с Яндекс, поиск происходит только с images.google.

PictureGoogleGraber

PictureGoogleGraber – бесплатный парсер картинок с Гугл с простым интерфейсом. По умолчанию программа скачивает самые большие изображения из доступных, но можно задать свои параметры по высоте и ширине. Также можно выбрать ориентацию и тип разрешения. Скачиваются не только картинки, но и их URL. Сохранение происходит одновременно из 10 потоков.

- Не нужно покупать лицензию.

- Быстрая работа.

- Загрузка URL картинок в отдельный файл.

Минусы

- Небольшой спектр настроек для выборки картинок.

- Иногда блокируется антивирусными программами.

Как парсить картинки с социальных сетей

Парсинг фотов из Инстаграм, ВКонтакте, Фейсбук и других социальных сетей обычно происходит с помощью онлайн-сервисов. Но чаще всего пользователям доступна такая услуга по подписке.

На некоторых сервисах предусмотрена возможность выполнить парсинг фото из ВКонтакте, Инстаграм и других социальных сетей бесплатно. Но есть ограничения на количество запросов или скачиваемых фото. По исчерпанию установленного лимита нужно платить деньги.

Парсинг фото из социальной сетей происходит по следующему алгоритму:

- Нужно открыть сервис.

- Указать в специальной форме адрес личной страницы или паблика в социальной сети.

- Установить нужные фильтры (по дате, количеству фото и т.д.).

- Нажать кнопку «Парсить».

Онлайн-сервис проведет поиск нужных фото, а потом предложит их выгрузку удобным вам способов.

Парсим поиск картинок

При рассмотрении программ выше, мы упоминали о возможности парсинга изображения из поисковых систем.

Это наиболее простой и удобный вариант в случаях, когда нет конкретных источников для скачивания картинок – есть только ключевые слова. Но поскольку в поисковых системах многомиллионная база изображений, то важно делать правильную выборку. Запуская парсер картинок по ключевым словам, обязательно укажите следующие параметры:

- графический формат изображения;

- ориентация картинки;

- минимальный и максимальный размер изображения;

- максимальный объем файла.

Указав такие свойства картинок, вы сможете сузить поиск. Парсер вам выдаст наиболее подходящие изображения из выдачи, что упростит их дальнейшую выборку для своего сайта или паблика в социальной сети.

Обход защит от парсинга картинок

При парсинге картинок с сайтов нередко приходится сталкиваться с защитами. Некоторые программы и сервисы предусматривают обход большинства из них. Но когда ресурсы создаются на языке программирования высокого уровня, то чаще всего с них не удается скачать нужные изображения. Например, затруднителен парсинг картинок с сайтов на Python. Но есть пути решения такой проблемы.

Но когда ресурсы создаются на языке программирования высокого уровня, то чаще всего с них не удается скачать нужные изображения. Например, затруднителен парсинг картинок с сайтов на Python. Но есть пути решения такой проблемы.

Основной принцип обхода защиты от парсинга изображения на Python, PHP и других сайтах состоит в изменении поведенческих факторов. Нужно выставлять такие параметры для программы, которые будут схожи с пользовательскими запросами:

- Задержки. Их устанавливают между запросами к чужим сайтам. Но учтите, что в этом случае скорость парсинга картинок с Python PHP и других сайтов снизится.

- Смена IP. Если вы часто парсите фото на одном ресурсе, то меняйте IP. Для этого достаточно перезагрузить роутер.

- Активируйте получение и отправку куки, если такая опция доступна в выбранной программе.

Когда парсинг картинок с PHP, Python и других сайтов блокируется, попробуйте воспользоваться их мобильными версиями. Обычно они менее защищены, что позволяет скачивать с них любой нужный фото-контент.

Парсинг изображения с относительным путем

При настройке парсинга фото нужно учитывать, что на многих сайтах ссылки на них представлены в относительном виде. Иными словами, путь файлу изображению указан относительно корневой папке на сервере. В данном случае есть два момента, которые нужно запомнить:

- Во-первых, когда ищите в коде странице ссылку на фото, то абсолютной ссылки для копирования в браузер вы не найдете. Поэтому перед поиском нужно удалить из нее название домена с последним слешем. Например, http://conter.ru/wp-content/uploads/2018/10/SHpargalka-po-git-720×414.jpg. Для получения относительной ссылки удаляем http://conter.ru/wp-content/uploads/, получаем: /uploads/2018/10/SHpargalka-po-git-720×414.jpg. В этом случае у вас получится относительная ссылка на картинку.

- Во-вторых, относительной ссылки недостаточно для парсинга. Нужно указывать полный адрес к изображению. Для этого чаще всего нужно добавить домен, сбросить параметры размера и дописать img.

png. В итоге полный адрес к изображению из нашего примера будет выглядит следующим образом: http://conter.ru/wp-content/uploads/2018/10/img.png.

png. В итоге полный адрес к изображению из нашего примера будет выглядит следующим образом: http://conter.ru/wp-content/uploads/2018/10/img.png.

Проблемы при парсинге картинок из поисковой выдачи

Все парсеры поисковых выдач работают по одной принципиальной схеме: эмулируют запрос пользователя по ключевому слову, и выдают картинку из топа выдачи как нужную.

При этом постоянно возникают следующие проблемы:

- Если поиск производится по артикулу, весьма вероятна выдача в топ товара другой расцветки или параметра. Например, поиск люстры SW04100-1 будет неизменно выводить первую релевантную SW04100-4, так как SW04100-1 пока в выдаче нет. Для поисковой системы эти два ключа – почти одно и то же. А на самом деле это совершенно два разных товара: первый – с одним плафоном, второй – люстра с четырьмя рожками. В итоге в вашем каталоге будет неверное изображение.

- Вывод картинок с водными знаками. По нужному запросу поисковик выводит как правило картинку из первой позиции.

Как правило, это данные с хороших сайтов, с грамотно прописанными title у изображений. И такие сайты защищаются от парсинга вотермарками. На втором месте может стоять весьма неплохая фотография без водных знаков, однако вам достанется не она 🙁

Как правило, это данные с хороших сайтов, с грамотно прописанными title у изображений. И такие сайты защищаются от парсинга вотермарками. На втором месте может стоять весьма неплохая фотография без водных знаков, однако вам достанется не она 🙁 - В случае использования достаточно редких артикулов или запросов, в выдачу может попасть совершенно что угодно – и если у вас смешанные запросы, то вы можете и не увидеть аномалию с первого взгляда.

- Баны поисковиков. В определенный момент поисковик может забанить ваш IP, и в выдачу пойдут например, картинки со страницы Google 404.

решение тут к сожалению, лишь одно: постоянный контроль. Для беглого осмотра мы обычно составляем табличку эксель с выведенными основными параметрами. В отдельный столбец макросом мы вставляем картинки из папки в соответствующие ячейки в минимально различимом размере. Теперь, фильтруя и пробегаясь глазами, мы можем выявить неверный цвет, форму, тип товара, водные знаки, и отобрать большую часть ошибок достаточно быстро.

Парсинг картинок – это оптимальное решение в случаях, когда необходимо найти большое количество изображений для размещения на сайтах или в социальных сетях. На поиск вы затратите минимум времени, при этом получите релевантные картинки. Они помогут вам повысить конверсию посещений в целевые действия.

Для парсинга можно использовать любые доступные инструменты. А если вдруг у вас возникнут сложности с поиском подходящих картинок в нужных объемах, то обращайтесь к нам. Мы всегда рады оказать помощь в парсинге!

Как поставить маркет яндекса на паузу

Как парсить товары с Яндекс Маркет и интернет-магазинов. Парсер контента сайтов Content Downloader и его настройка

Довольно часто бывают ситуации, когда нам нужно получить контент того или иного сайта в удобной для нас форме. Это особенно актуально для интернет-магазинов и каталогов товаров, которые повсеместно используют практически одни и те же данные – товары. В данной статье я подробно рассмотрю процесс парсинга контента сайтов на примере товаров с Яндекс Маркета.

Использовать для этого мы будем программу Content Downloader (чтобы получить скидку 5%, укажите в примечаниях платежа мой идентификатор — Dmitriy), которую я приобрел очень давно, но до сих пор так и не удосужился написать о ней. Content Downloader — это универсальный парсер контента сайтов, который с успехом может быть использован как парсер Яндекс Маркета или парсер товаров интернет-магазинов. Однако Яндекс Маркетом и интернет-магазинами работа программы не ограничивается. Используя широкие настройки, ее можно настроить для работы с абсолютно любым сайтом.

К сожалению, рассмотреть все имеющиеся настройки в рамках данной статьи невозможно в силу их большого количества. В связи с этим мы рассмотрим только основные из них, чтобы любой желающий смог без проблем по примеру парсить контент нужного сайта.

- Весь процесс работы можно разделить на 5 этапов:

- Установка и активация программы (рассматриваться не будет).

- Настройка регионов в Яндекс Маркете.

- Получение ссылок на товары.

- Непосредственно парсинг товаров.

- Проверка результатов.

Настройка регионов в Яндекс Маркет

Первое, что нужно сделать, это установить нужный регион в Яндекс Маркете. Для этого запускам программу и жмем на кнопку «авторизация/cookies».

После этого вводим в адресную строку «market.yandex.ru», жмем «Enter», переходим на сайт Яндекс Маркета и авторизируемся, используя стандартную форму авторизации.

Далее в правом верхнем углу сразу под именем пользователя ищем ссылку на регион и при необходимости изменяем значение. После этого жмем на кнопку «передать cookies из webbrowser».

Сразу скажу, что если вы пытаетесь установить город, который находится в другой стране, то могут возникнуть сложности, так как Яндекс автоматически определяет IP адрес и его принадлежность к тому или иному региону, после чего принудительно редиректит на местный сайт. В связи с этим, можно будет выбирать только города, находящиеся в рамках вашей страны.

Парсинг ссылок на товары в Яндекс Маркет

Итак, регион мы указали. Теперь можно приступать к получению ссылок на товары. Этот процесс будет состоять из пяти шагов:

- Выбираем нужный раздел Яндекс Маркета.

- Определяем часть ссылки, отвечающую за постраничную навигацию, и создаем шаблон ссылки страницы выбранного раздела.

- Парсим ссылки на страницы раздела при помощи шаблона, полученного на втором шаге (п. 2).

- Определяем шаблон ссылок для товаров (повторяющуюся часть).

- Парсим ссылки на страницы товаров Яндекс Маркета при помощи страниц разделов (п. 3) и шаблона ссылок на страницы товаров (п. 4).

Теперь разберем более подробно каждый шаг. Первым делом открываем браузер и ищем нужный нам раздел, после чего переходим на страницу со всеми моделями товаров (ссылка внизу страницы сразу под товарами). В качестве примера мы рассмотрим раздел холодильников.

Далее переходим на другие страницы раздела и смотрим за изменениями ссылки, чтобы определить параметр, отвечающий за постраничную навигацию. Его не сложно заметить. На Яндекс Маркет это параметр BPOS.

Его не сложно заметить. На Яндекс Маркет это параметр BPOS.

Копируем ссылку на страницу раздела и вставляем ее в поле шаблона программы Content Downloader, как это показано на изображении ниже. Не забываем при этом изменить значение параметра постраничной навигации на , как это написано сразу над полем ввода.

После этого нам необходимо сгенерировать ссылки на страницы раздела. Для этого выставляем диапазон от нуля до 5000 (4839 товаров по 10 шт. на странице), а также шаг, который равен 10. Я выбрал именно 10, так как по умолчанию в аккаунте на странице отображается именно 10 элементов. Если в настройках указано другое значение – выставьте его.

Далее жмем на кнопку «добавить ссылки» и выбираем значение «используя диапазон».

Программа сгенерирует ссылки на страницы выбранного раздела, которые мы будем использовать для получения ссылок отдельные товары.

Для получения ссылок на товары, нам необходимо определить их шаблон. Для этого переходим на сайт Яндекс Маркета, выбираем товар на странице раздела и копируем его ссылку.

Возвращаемся к программе, переходим во вкладку «ссылки» и жмем на кнопку «фильтры ссылок».

В открывшемся окне отмечаем чекбокс «задать шаблон для ссылок (используйте * как маску» и вводим в поле ниже часть ссылки, ведущей на страницу товара, которая не изменяется (легко проверить, сравнив несколько ссылок на страницы товаров). В нашем случае шаблоном будет «market.yandex.ua/model.xml?modelid=». Как вы заметили, «http://» мы тоже удаляем. Оставляем только шаблон. После этого жмем на кнопку «готово».

Чтобы проверить корректность работы, выберите любую ссылку на страницу раздела в окне программы и дважды кликните по ней левой кнопкой мыши. В результате должно открыться окно с 10-ю ссылками на страницы товаров.

Если этого не произошло, то причин может быть как минимум две:

- Вы выбрали битую ссылку, например, ссылок сгенерировано больше, чем имеется на сайте в выбранном вами разделе. Попробуйте взять ссылку как можно ближе к началу списка.

- Допущена ошибка при настройке программы. Следует пересмотреть настройки или же повторить процедуру с нуля.

Итак, с шаблонами ссылок страниц товаров мы разобрались. Теперь можно переходить к завершающей части данного шага – парсингу ссылок на страницы товаров Яндекс Маркет. Для этого жмем на кнопку «сканер сайтов (сбор ссылок с сайта)» в главном меню программы.

В открывшемся окне отмечаем чекбокс «не пополнять очередь», жмем кнопку «добавить ссылки из списка парсинга (из главного окна программы)», после чего жмем «начать/продолжить сканирование».

После завершения парсинга, жмем «очистить список парсинга» для очистки главного окна программы и «добавить полученные ссылки к списку парсинга» для копирования полученных ссылок в освободившийся главный список программы. Закрываем всплывающее окно, так как оно больше нам не нужно, и возвращаемся к главному окну программы.

Для проверки полученных ссылок достаточно кликнуть правой кнопкой мыши по ссылке и выбрать пункт «посмотреть страничку в интернете». В результате откроется окно браузера с выбранным вами товаром.

В результате откроется окно браузера с выбранным вами товаром.

В нашем случае в списке программы 4839 элементов. Столько же отображалось товаров на сайте Яндекс Маркет во время начала парсинга, следовательно, парсинг ссылок на товары прошел успешно.

Итак, ссылки мы получили. Теперь можно переходить к наиболее трудоемкой части – непосредственно парсингу товаров.

Парсинг контента (товаров) с Яндекс Маркет

Первым делом изменяем количество потоков и паузу между запросами. Это желательно делать при работе с любым серьезным сайтом, так как из-за большой нагрузки, создаваемой программой, вас могут забанить. Чтобы этого не произошло, выставляем один поток и паузу между запросами порядка 5000 мс или более.

Теперь можем задавать границы парсинга, то есть, укажем программе, какие части страницы нам нужны (страницы товаров шаблонны). Их у нас будет 3 – это название товара, производитель и картинка. Больше нам особо ничего не нужно, так как описание товара и другая информация все равно будет заказываться у копирайтеров. Крайне не рекомендую использовать неуникальный контент из других сайтов на своем проекте без предварительной его уникализации.

Крайне не рекомендую использовать неуникальный контент из других сайтов на своем проекте без предварительной его уникализации.

Для настройки границ парсинга, во вкладке «контент» жмем на кнопку «задать границы парсинга» слева от радиокнопки «парсить заданные части документа».

В открывшемся окне выбираем первую границу и жмем на кнопку настройки (с тремя точками), как это показано на изображении ниже.

В результате этого откроется окно с исходным кодом страницы товара. Для большего удобства работы переходим в двухоконный режим, нажав на кнопку «браузер (открыть/закрыть)».

Далее выбираем нужную нам часть страницы и при помощи поиска ищем соответствующий ей участок в исходном коде страницы. Для перехода между совпадениями используем сочетание клавиш CTRL+F или соответствующую кнопку в меню программы.

Как видно с изображения, процесс поиска границ в программе Content Downloader практически ничем не отличается от обычного поиска кода при помощи плагина FireBug. Нашей задачей на данном шаге является поиск уникальных участков кода, чтобы использовать их в качестве границ для парсера контента.

Нашей задачей на данном шаге является поиск уникальных участков кода, чтобы использовать их в качестве границ для парсера контента.

После нахождения нужного участка кода, выделяем его и жмем на клавишу «задать начало парсинга» или «задать конец парсинга». Все зависит от того, какой границей является выделенный код.

Кроме того, вы можете выделить нужный участок кода, скопировать его или ввести вручную в нужное поле программы. Разницы здесь никакой нет.

Также можете ввести название границы, чтобы было легче ориентироваться при работе. Для этого используйте специально предназначенное для этого поле.

После завершения всех операций жмем на кнопку «готово».

Следующий этап – добавление второй границы, отвечающий за парсинг производителя товара. Для этого в окне со списком границ жмем на кнопку настроек следующей границы парсинга.

В открывшемся окне выбираем участок, отвечающий за производителя, и аналогичным образом добавляем вторую границу. В данном случае в качестве источника мы можем использовать участок из «хлебных крошек».

В данном случае в качестве источника мы можем использовать участок из «хлебных крошек».

Для усложнения задачи мы используем расширенные границы. Поскольку между ними присутствует лишний HTML код, то чтобы избавиться от него нам потребуется совершить дополнительные действия. Для этого переходим в меню дополнительных настроек (кнопка в правом верхнем углу окна программы) и отмечаем чекбокс «htm to text».

Далее в списке границ отмечаем чекбокс «парсить с границами».

Итак, с названиями товаров и производителями мы разобрались. Для проверки корректности работы в главном окне программы во вкладке контент дважды кликните по ссылке на страницу товара. В результате этого откроется окно с отфильтрованными по шаблону данными.

Как видно с изображения, парсер контента работает корректно. Теперь можно переходить к завершающей части статьи и рассмотреть процесс парсинга изображений.

Парсинг картинок в Яндекс Маркет

Парсинг изображений практически ничем не отличается от парсинга текста, за исключением некоторых моментов. Для начала, как обычно, открываем страницу со списком границ и добавляем новую границу.

Для начала, как обычно, открываем страницу со списком границ и добавляем новую границу.

Теперь нам необходимо включить скрипты, чтобы иметь возможность увеличивать изображения по клику. Для этого жмем по кнопке «опции браузера» и включаем скрипты, как это показано на изображении ниже.

После этого можем переходить к настройке границ. Нажимаем на миниатюру изображения товара, затем на большое всплывшее изображение (в данном случае выбираем первое, пройдя по кругу, чтобы выбрать нужное изображение, если их несколько).

Далее в качестве первой границы выбираем общую часть ссылки (повторяющуюся) вместе с атрибутом href. В качестве второй границы указываем закрывающие кавычки. Также не забываем дать название границе для большего удобства работы.

Теперь нам необходимо добавить шаблон ссылки в дополнительных настройках границ парсинга. Для этого вызываем соответствующее меню и в поле «добавить в начало» прописываем часть ссылки из окна с границами парсинга изображений.

Поскольку в Яндекс Марет изображения выводятся скриптом, то нам необходимо активировать соответствующую настройку в настройках парсера. Заодно настроим и формирование названий изображений. Для этого переходим во вкладку «контент» и жмем по кнопке «дополнительные параметры загрузки изображений», попутно отметив чекбокс «без адресов», чтобы избавиться от ссылок в именах файлов.

Далее возвращаемся к списку границ парсинга и жмем на кнопку «шаблон вывода».

Выбираем границу, отвечающую за парсинг изображений, кликаем правой кнопкой мыши и жмем «<NIMG>…</NIMG», после чего закрываем окно и возвращаемся к списку границ парсинга.

Теперь для проверки работы парсера Яндекс Маркета достаточно дважды кликнуть по ссылке в списке программы.

Итак, основы создания границ мы рассмотрели. Аналогичным образом можно добавить другие границы, например, для парсинга второй картинки, цен и т.д. Теперь давайте рассмотрим параметры сохранения результатов работы программы. Основные настройки находятся во вкладке «контент» в главном окне программы.

Основные настройки находятся во вкладке «контент» в главном окне программы.

Здесь мы можем настроить путь к папке назначения, в каком виде сохранять данные (csv, htm, txt, php), а также другие параметры. В данном случае я лишь изменил путь к папке и установил сохранение каждого товара в отдельный файл для большего удобства работы. Вы же можете сохранять данные, например, в формате CSV. В этом случае необходимо будет настроить параметры сохранения в редакторе шаблона вывода (см. выше).

Итак, с настройками мы разобрались. Для начала парсинга достаточно нажать кнопку «начать парсинг» в главном меню программы или клавишу F5.

После этого программа начнет парсинг контента, который может занять достаточно длительное время. Все зависит от количества потоков, паузы между запросами и количества ссылок на страницы товаров. В среднем при текущих настройках один товар будет обрабатываться от 5 до 10 секунд. По завершению работы вы получите список папок с названиями товаров, содержащих внутри текстовый файл с названием производителя и картинки, а также папку с самим изображением товара, если, конечно, вы выбрали те же настройки, что и в статье.

Как установить информер Яндекс.Маркет?

Данная опция работает только при наличии собственного подключенного домена.

2. Зарегистрируйте сайт в Яндекс.Маркете.

3. Там же на странице статистики сайта внизу нажмите ссылку «Опубликуйте рейтинг».

4. Выберите информер, скопируйте код.

5. Перейдите на свой сайт в Nethouse.

6. Найдите блок «Статистика» на сайте. Нажмите «Редактировать», откроется всплывающее окно.

В шаблонах Профессиональный, Лендинг и Презентационный (Дизайн №1) блок статистики находится в самом низу страницы.

7. Выберите Яндекс.Маркет и вставьте полученный ранее код в открывшееся поле.

Как пользоваться яндекс маркетом

Приветствую тебя, уважаемый гость(я)! Из этой статьи вы узнаете, что такое Яндекс Маркет и как им пользоваться. Как он работает: для чайников и продвинутых пользователей, которые пока не интересовались этой темой, как его использовать покупателю с максимальной выгодой, стоит ли доверять Яндекс Маркет.

Что это такое – Яндекс Маркет?

Вопреки мнению, которое может сложиться по названию сервиса, это не интернет‐магазин, а скорее агрегатор, помогающий найти подходящие вещи, не слишком разбираясь в их характеристиках, сравнить предложения от разных интернет‐магазинов, принять участие в акции или получить скидку, если это предусмотрено торговой площадкой.

Сервис успешно работает с 2000 года и сегодня пользуется огромной популярностью – на конец 2018–2019 года на платформе зарегистрировано более 20 000 интернет‐магазинов.

Сколько товаров продается ежедневно, с помощью такого инструмента, я ответить затрудняюсь.

Как работает: для покупателя и продавца

Сервис ориентирован больше на покупателей. Яндекс Маркет – место, где собраны в воедино предложения от всех магазинов, продающих интересующие изделия. Покупатель может:

- Посетить сервис без конкретных предпочтений относительно бренда, модели и выбрать что‐то конкретное из огромного числа предложений: от тонального крема до автомобиля;

- Найти подходящие предложения, исходя из намеченного бюджета;

- Получить представление об ассортименте и отличиях тех и иных моделей;

- Сравнить характеристики похожих вещей и выбрать наиболее подходящий;

- Почитать обзоры о товаре и магазине, который его продает;

- Отфильтровать все лишнее, с помощью большого числа настроек;

- Проанализировать, какие позиции пользуются наибольшей популярностью;

- Получать уведомления о динамике цен и скидках;

- Выбрать магазин недалеко от собственного дома или с быстрой доставкой;

- Определиться с покупкой даже в случае, если клиент сам толком не знает, чего хочет;

- Получить дополнительные аксессуары к большинству девайсов: например, чехол для планшета или защитную экипировку для велосипеда.

Удобство сервиса в том, что здесь хранится история переходов пользователя. Бывает, что ссылка на интересный предмет или магазин прячется среди множества подобных, и отыскать ее не так то и просто. Яндекс Маркет поможет быстро найти ранее посещенную торговую площадку и даже карточку товара.С точки зрения продавца, сервис не менее полезен. Платформа позволяет купить товар в несколько кликов, даже без перехода на сайт интернет‐магазина.

Огромное преимущество в том, что клиенты здесь уже «горячие»: они готовы тратить деньги, но пока не решили, кому их отдать. Единственное, что требуется от продавца – зарегистрировать магазин на платформе.

Как пользоваться Яндекс Маркетом

И так, переходим на сервис. Отдельной регистрации в сервисе не требуется – используется единый аккаунт, привязанный к Яндекс Почте. Это необязательно, однако регистрация и авторизация открывает перед пользователем больше возможностей – например, добавить товар в корзину.

Прежде чем перейти к использованию сервиса, рекомендую выполнить кое‐какие настройки (кликнуть по аватарке профиля в верхнем правом углу и выбрать «Настройки Маркета»). Это упростит покупку товаров и поможет «подогнать» платформу под себя.Достаточно указать персональные данные – ФИО, адрес электронной почты, контактный номер и дату рождения, а также город, в котором вы находитесь. При желании, можно привязать аккаунт одной или нескольких социальных сетей, что упростит доступ к сервису, а также настроить уведомления об ответах на комментарии, акциях и скидках.

Это упростит покупку товаров и поможет «подогнать» платформу под себя.Достаточно указать персональные данные – ФИО, адрес электронной почты, контактный номер и дату рождения, а также город, в котором вы находитесь. При желании, можно привязать аккаунт одной или нескольких социальных сетей, что упростит доступ к сервису, а также настроить уведомления об ответах на комментарии, акциях и скидках.

Пользоваться платформой удобно – все товары разделены по категориям и есть строка поиска (которая ищет необходимое именно в пределах платформы, а не по всему интернету). В мобильном приложении, которое можно установить на девайс под управлением iOS или Андроид, функционал не отличается.

Как выбрать товар на Яндекс Маркет

Магазин имеет собственный искусственный интеллект, который носит имя Гуру, помогающий выбрать товар, исходя из потребностей покупателя. Даже если вы пока не решили, что конкретно вам нужно, сделать выбор просто:

- Выбираете категорию;

- Переходите в конкретный раздел;

- С помощью фильтров справа устанавливаете требуемые параметры: цену, производителя, акционные предложения, состояние, особенности предмета.

По выбранным фильтрам Яндекс покажет подходящие позиции. Выбрав конкретный товар, можно перейти в его карточку и уже определиться, в каком именно магазине его купить.

Как покупать в самом Яндекс Маркете: функция доступна, если интернет‐магазин подключил ее в настройках. Как и переходы из Яндекс Маркета, такая опция оплачивается продавцом отдельно, поэтому ее может и не быть на самой платформе.

Как заказывать с сервисом, так и непосредственно в магазине одинаково удобно – остается только нажать кнопку «Купить» и заполнить открывшуюся форму заказа.

Если вы еще не «созрели» для покупки или не окончательно определились с выбором бренда и модели, любой товар можно добавить в отложенные. Иконка для быстрого доступа в этот раздел, в виде сердечка, расположена в шапке сайта в правой его части.

Для удаления товара из корзины достаточно нажать кнопку с изображением корзины. Если не удалять товары вручную, в отложенных они будут отображать до тех пор, пока будут присутствовать на площадке (именно товар, а не определенный магазин).

Как сравнить 2 товара в Яндекс Маркете

В карточке товара есть кнопка «Сравнить». Этот раздел также отображается в шапке сайта – правее от отложенных. Для нескольких товаров, которые попали сюда, отображаются все ключевые отличия: общий рейтинг, а также характеристики, исходя из назначение конкретной вещи.Например, для компьютерного кресла это будут назначение, материал, габариты, сведения о спинке и сидении и доступные цвета. Можно отображать все характеристики, но тогда сравнить товары станет труднее.

Стоит ли покупать на Маркете

Несомненно, сервис заслуживает доверие, однако хочу добавить небольшую ложечку дегтя в эту вкусную бочку меда.

Несмотря на жесткую модерацию отзывов, известны случаи накрутки рейтинга магазина и написания одобрительных отзывов. Естественно, делается это за деньги, а для поиска исполнителей есть специальные площадки.

Если вы не уверены в кристально чистой репутации магазина и достойном сервисе, перепроверьте мнение покупателей о нем, воспользовавшись сайтами‐отзовиками.

Также рекомендую ознакомиться с публикацией «Кэшбэк сервис Letyphops: что это такое и какая там выгода»(уже на блоге). Чтобы не пропустить эту тему, можете подписаться на обновления блога. И не забывайте делиться постами этого блога в социальных сетях. Увидимся завтра, пока!

p, blockquote 22,0,0,0,0 –> p, blockquote 23,0,0,0,1 –>

Яндекс.Маркет, о котором мы пишем не впервые — широко известный сервис сравнения товаров интернет-магазинов. Он предоставляет возможность сопоставлять и выбирать из множества вариантов любого интересующего вида товара. Поэтому у многих маркетологов возникает вопрос о том, как пользоваться Яндекс Маркетом с максимальной отдачей.

Сегодня проанализируем процесс работы с данным сервисом — причем со стороны маркетолога, или владельца магазина. Мы разберем, как зарегистрировать магазин в Яндекс.Маркет, как загрузить туда прайс — и что, собственно, делать дальше.

Содержание

Размещение магазинаСтоит сказать, что Маркет — прекрасный выбор для повышения продаж. Судите сами — более 20 тысяч человек каждый месяц пользуются сервисом, сравнивая товары, представленные более чем 10 тысячами магазинов. Как видите, аудитория огромная и предельно целевая — но и конкуренция очень существенная. Для многих современных пользователей перед покупкой нет более оптимального варианта, кроме как сравнить товары в Яндекс.Маркете — забавно, но часто люди делают это прямо в оффлайн-точках продаж. Действительно удобно — прийти в ближайший магазин, посмотреть на технику своими глазами, зайти на Маркет и купить в интернете за меньшие деньги.

Судите сами — более 20 тысяч человек каждый месяц пользуются сервисом, сравнивая товары, представленные более чем 10 тысячами магазинов. Как видите, аудитория огромная и предельно целевая — но и конкуренция очень существенная. Для многих современных пользователей перед покупкой нет более оптимального варианта, кроме как сравнить товары в Яндекс.Маркете — забавно, но часто люди делают это прямо в оффлайн-точках продаж. Действительно удобно — прийти в ближайший магазин, посмотреть на технику своими глазами, зайти на Маркет и купить в интернете за меньшие деньги.

Для начала необходимо собственно зарегистрироваться на Яндексе — если вы этого еще не сделали. Далее — переходите на Маркет, найдите надпись «Разместить магазин» и нажмите на соответствующую кнопку. Потом нужно будет заполнить информацию о компании. Интерфейс сервиса вполне продуман — здесь сложностей у вас не будет. После этого необходимо разместить в системе прайс — мы подходим к тому, как добавить товар в Яндекс.Маркет, и тут уже не все так просто.

Прайс — это файл в определенном формате, откуда система берет данные о ваших товарах, их характеристиках и тому подобном. Данный файл может быть размещен либо на ресурсе магазина, либо загружен в систему с вашего компьютера — также можете просто указать путь к нему. Здесь многое зависит от того, как устроен ваш интернет-магазин, через какую систему создан и т. д. Поддерживаемые форматы: exel, yml, а также csv. На данном этапе очень важно задаться вопросом, как выгрузить товары в Яндекс.Маркет без ошибок. Посмотрите, что справка Яндекса предлагает по этому поводу.

Если вы решили указать путь к файлу, то Яндекс проверит его на предмет ошибок — возможно, с первого раза сделать все правильно не получится. После самой выгрузки, когда процесс пройдет успешно, может оказаться, что не все товары были перенесены с верными характеристиками. Исправьте недочеты вручную. Мы разобрали, как разместить товары на Яндекс.Маркете — теперь идем дальше. После того, как ваш магазин зарегистрирован в системе, а прайс импортирован, необходимо настроить характеристики размещения. Заполните информацию, требуемую Маркетом (правила доставки, данные о магазине, оффлайн-представительства, время их работы и т. д).

Заполните информацию, требуемую Маркетом (правила доставки, данные о магазине, оффлайн-представительства, время их работы и т. д).

Важный момент — на ресурсе вашего магазина должна быть представлена юридическая информация. Убедитесь в этом, иначе можете не пройти проверку. Когда вы сделали все необходимое — отправляйте свой магазин на модерацию, или проверку. Это займет несколько дней. Немаловажно, что у вас есть всего 6 попыток пройти данную процедуру — так что будьте внимательны. Можете найти множество познавательного контента о том, как настроить Яндекс.Маркет: видео на YouTube, рассылки, статьи и прочая информация широко представлена в интернете. К сожалению, не можем останавливаться на этом слишком подробно — потому постараемся кратко осветить каждый аспект вопроса.

После модерации пополните счет на своем аккаунте в системе — с него будет списываться плата за переходы. Теперь логичным шагом будет не что иное, как добавить объявление на Яндекс.Маркет. Кстати, сервис также использует СРА-модель (цена за целевое действие), но она недоступна новичкам. Воспользоваться этой стратегией вы сможете после трех месяцев работы с площадкой.

Воспользоваться этой стратегией вы сможете после трех месяцев работы с площадкой.

Важно также знать, как правильно настроить Яндекс.Маркет. Каждому зарегистрированному владельцу магазина доступен функционал настройки непосредственно размещения через Маркет, корректировки информации о магазине и прочих данных. Все это можно сделать через функцию «Управление пользователями», как на изображении ниже.