Как быстро собрать данные с сайтов

Что такое парсеры и как они работают Для сбора контента Для мониторинга конкурентов Для парсинга SEO-параметров Для сбора контактных данных

Мы в Telegram

В канале «Маркетинговые щи» только самое полезное: подборки, инструкции, кейсы.

Не всегда на серьёзных щах — шуточки тоже шутим =)

Подписаться

Станьте email-рокером 🤘

Пройдите бесплатный курс и запустите свою первую рассылку

Подробнее

Парсинг помогает быстро собрать, обработать и проанализировать большие объёмы информации на различных сайтах.

Сделали подборку парсеров для сбора данных с сайтов и разобрались, для каких целей они подходят.

Что такое парсеры и как они работают

Парсеры — это специальные программы, которые собирают различные данные с сайтов по заданным критериям. Общий принцип работы всех парсеров примерно одинаков:

- переход на нужный ресурс и копирование его кода;

- анализ кода и нахождение необходимой информации;

- структуризация и сохранение данных.

Работу парсера можно представить так, как будто человек ходит по разным сайтам и копирует нужные данные. В случае с парсингом по сайтам ходит робот, который выполняет нужные задачи в десятки раз быстрее.

Вид информации, которую собирает парсер, зависит от его исходной функции и настроек. Можно собирать самые разные данные: цены конкурентов, товарные позиции, характеристики и описания товаров, контактные данные, контент определённых тематики и формата.

После анализа и обработки парсер сохраняет все данные в определённом формате — например, в таблице Excel, документах PDF или TXT.

Насколько законно применение парсеров

О законности использования парсеров много спорят. Есть мнение, что автоматический сбор данных нарушает сразу несколько законов — о защите персональных данных, об охране конфиденциальной информации, об авторском праве и т.д. Это не совсем так.

Согласно Конституции РФ каждый человек может «свободно искать, получать, передавать, производить и распространять информацию любым законным способом». То есть теоретически ручной или автоматический сбор информации, выложенной в общий доступ, преступлением не является. Но есть нюансы.

Для законного использования парсеров важно соблюдать три основных условия:

- Все данные, которые собирает сервис, должны находиться в открытом доступе и не попадать под закон об авторском праве.

- Сбор информации не должен негативно влиять на анализируемый сайт и вызывать сбои в его работе.

- Собирать данные можно только законными способами, без взлома сайта.

Если кратко, то парсинг любых данных, которые можно найти в открытом доступе и скопировать вручную — это законная деятельность.

Программу для парсинга можно разработать с нуля специально под конкретную задачу. Но такое решение будет дороже в использовании. В большинстве случаев можно обойтись готовыми инструментами. Рассмотрим парсеры для разных задач.

Для сбора контента

Под сбором контента подразумевают парсинг новостей и заголовков, описаний к товарам, комментариев, любых публикаций по ключевым словам, видеоматериалов, картинок, постов в соцсетях.

При парсинге контента важно учитывать один важный нюанс , который касается последующего использования данных. Если вы собираете информацию, например, для отслеживания ситуации в нише или поиска актуальных идей, то вы не совершаете ничего противозаконного. Если же планируете публикацию собранных данных, то не забывайте об авторском праве. При размещении спарсенного материала в исходном виде обязательно указывайте источник и/или запрашивайте согласие автора на публикацию.

При размещении спарсенного материала в исходном виде обязательно указывайте источник и/или запрашивайте согласие автора на публикацию.

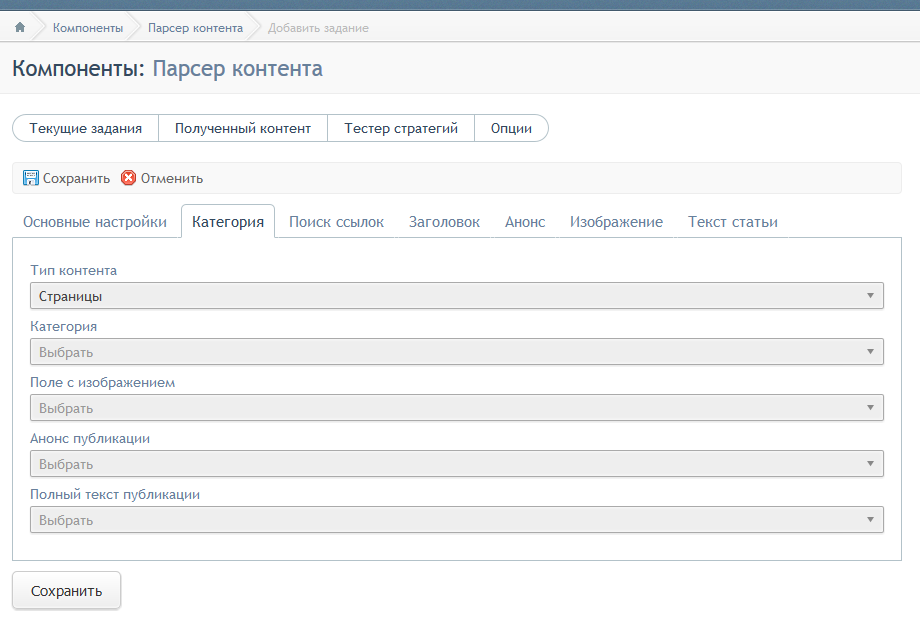

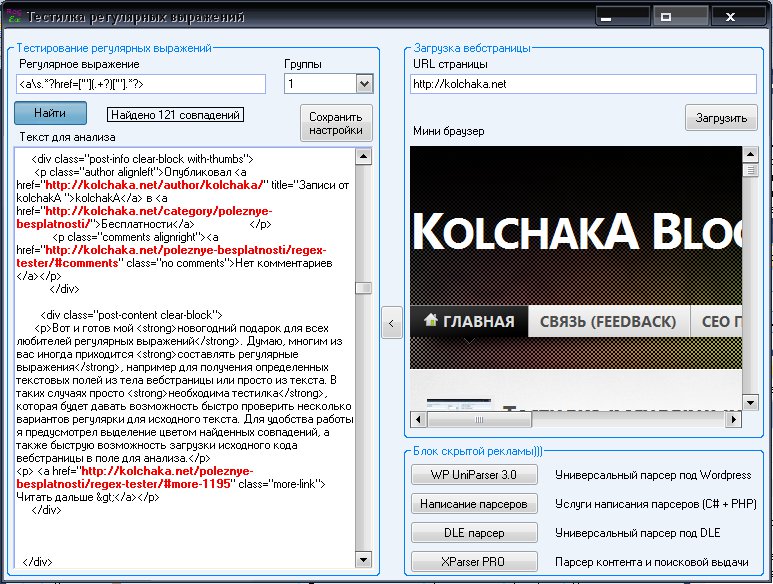

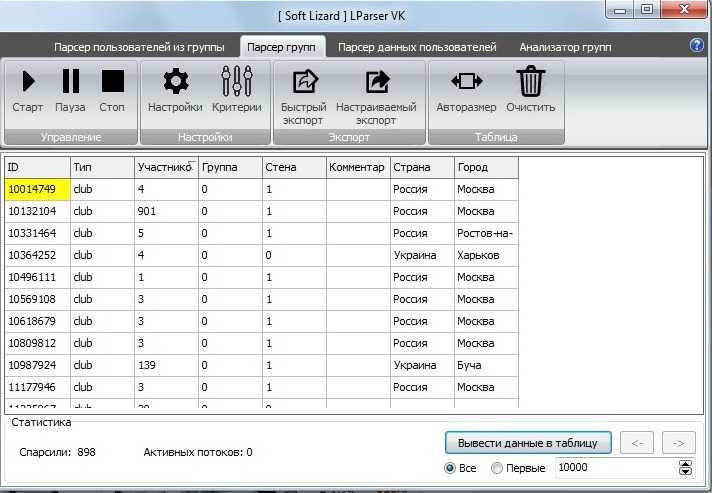

Примеры парсеров для сбора контента:

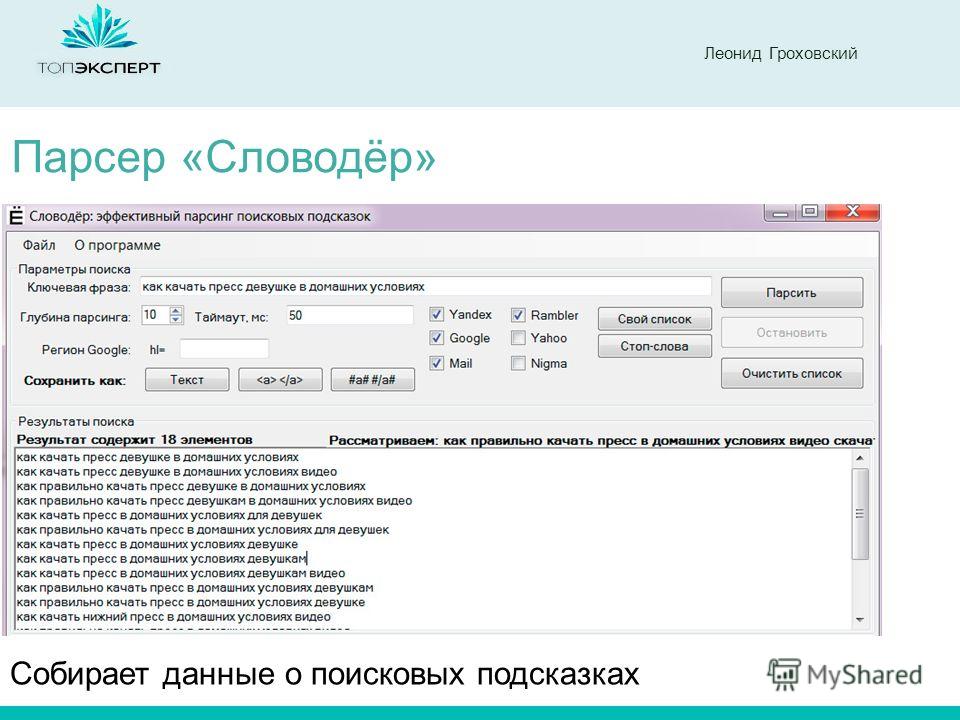

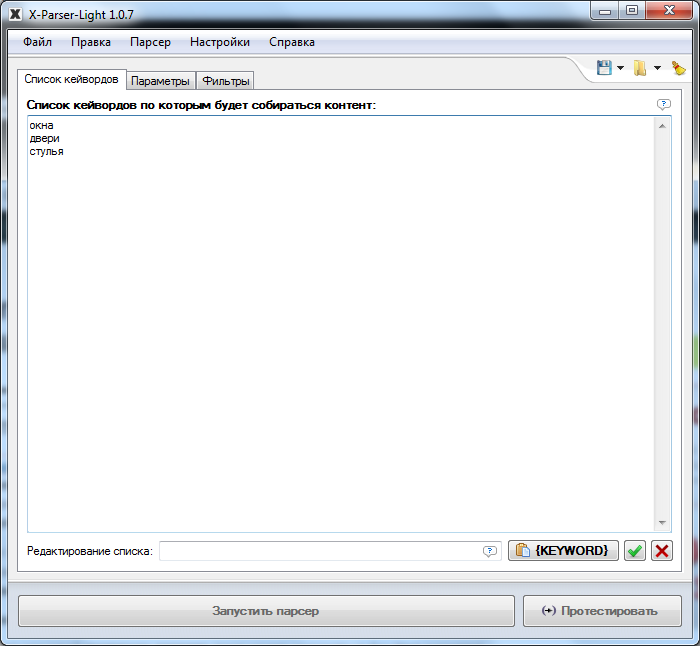

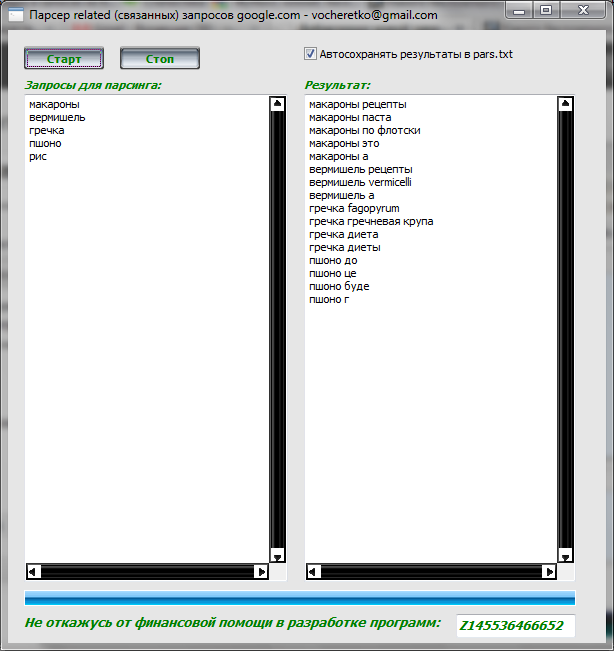

X-Parser Light. Собирает тематический контент по списку ключевых слов или ссылок. Кроме текстовых данных парсит видео и изображения. Поддерживает любые поисковые системы и практически любой язык. Работает в формате десктопного приложения. Стоимость — 4 100 ₽ единоразово (периодически бывают скидки).

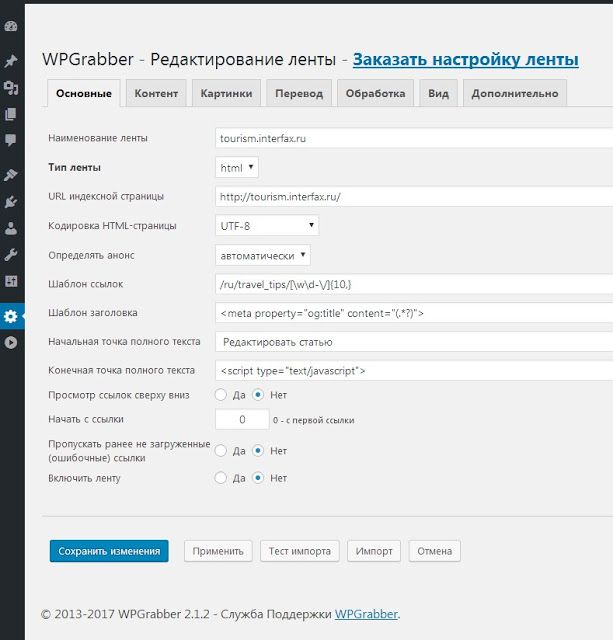

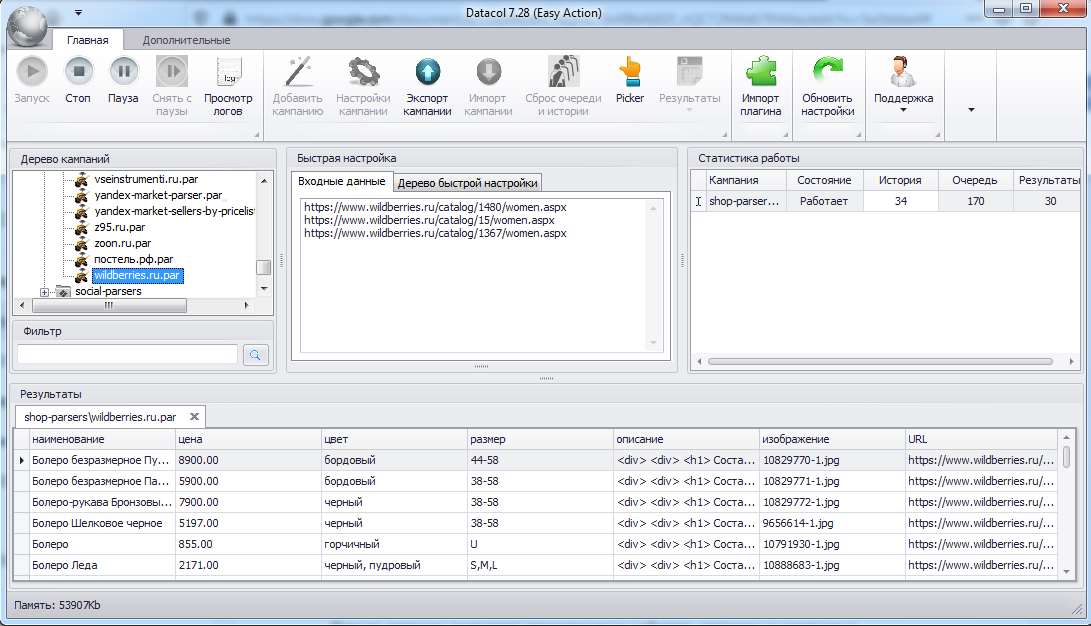

Catalogloader. Умеет парсить информацию с сайтов интернет-магазинов — описания товаров, фото, характеристики, артикулы и пр. Можно самостоятельно настраивать критерии сбора. Весомый плюс — парсер работает в облаке, без скачивания на ПК. Есть бесплатная версия. Платные тарифы начинаются от 5 400 ₽/мес.

XMLDATAFEED. Сервис позиционирует себя как инструмент для парсинга любой информации, которую можно собрать законным способом. Например, можно искать товарные описания, тексты, фото и изображения, ассортимент и характеристики. Особенность сервиса — в отсутствии готовых решений. Под каждый запрос команда разработчиков создаёт уникальный парсер для нужной задачи. Стоимость — индивидуально.

Особенность сервиса — в отсутствии готовых решений. Под каждый запрос команда разработчиков создаёт уникальный парсер для нужной задачи. Стоимость — индивидуально.

Диггернаут. Облачный сервис, предлагающий платные и бесплатные парсеры. Стоимость платных решений — от 700 ₽/мес. С помощью специальных инструментов пользователь может создать собственный парсер (диггер) под нужный запрос. Можно заказать разработку сложных решений.

Примеры парсеров для мониторинга конкурентов:

Marketparser. Сервис мониторит цены в интернет-магазинах и на маркетплейсах. Достаточно загрузить список товаров, и в течение 3–20 минут по ним будет составлен актуальный отчёт. Можно использовать функцию автоматического ценообразования — на основе собранных данных сервис определит оптимальную стоимость товаров. Стоимость парсера зависит от количества проверок и начинается от 4 500 ₽/мес.

ALL RIVAL. Этот парсер собирает цены конкурентов по указанным ссылкам. Из преимуществ — есть бесплатное автосопоставление результатов. Сервис доступен на бесплатном тарифе с ограничением до двух сайтов. Стоимость платного тарифа начинается от 5 099 ₽/мес.

Сервис доступен на бесплатном тарифе с ограничением до двух сайтов. Стоимость платного тарифа начинается от 5 099 ₽/мес.

Priceva. С помощью этого сервиса можно собирать цены конкурентов. Есть функция автоматической переоценки товаров пользователя. Все собранные цены конвертируются в валюту аккаунта на любом тарифе. Стоимость от 7 000 ₽/мес. Есть бесплатный тариф с мониторингом до десяти сайтов.

uXprice. Это SaaS-решение. Программа собирает цены из рекламных объявлений, по ссылкам на конкретные товары и на указанных сайтах. Есть возможность сравнительного анализа цен конкурентов. Можно использовать функции конкурентного ценообразования для определения оптимальной стоимости своих товаров. Сервис умеет мониторить цены конкурентов в 36 странах. Стоимость парсера — от $99/мес. Есть бесплатная версия на 7 дней.

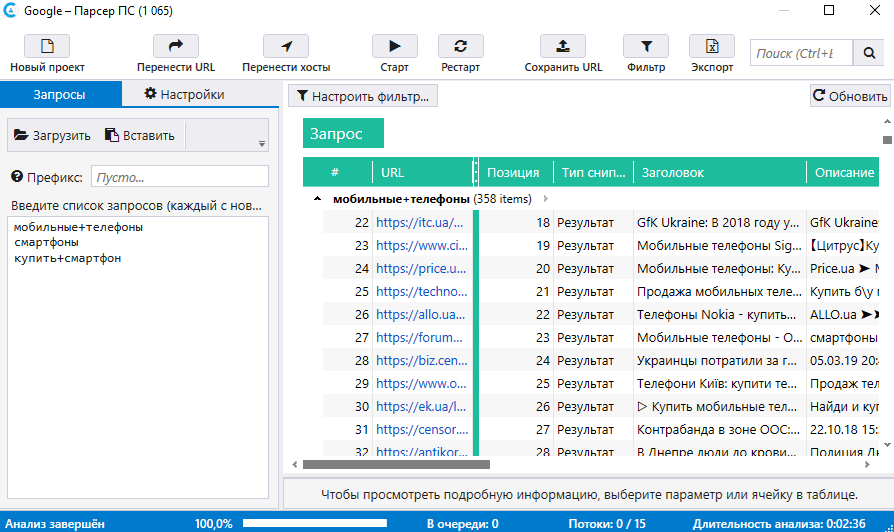

Для парсинга SEO-параметров

Сбор SEO-данных полезен при внутренней, технической и внешней оптимизации. Парсеры помогают быстро осуществить комплексный анализ ресурса. Некоторые инструменты имеют узкий функционал, другие умеют собирать самые разные параметры.

Некоторые инструменты имеют узкий функционал, другие умеют собирать самые разные параметры.

SEO-парсеры можно применять как для анализа собственного ресурса, так и для отслеживания конкурентов.

Примеры парсеров для сбора SEO-данных:

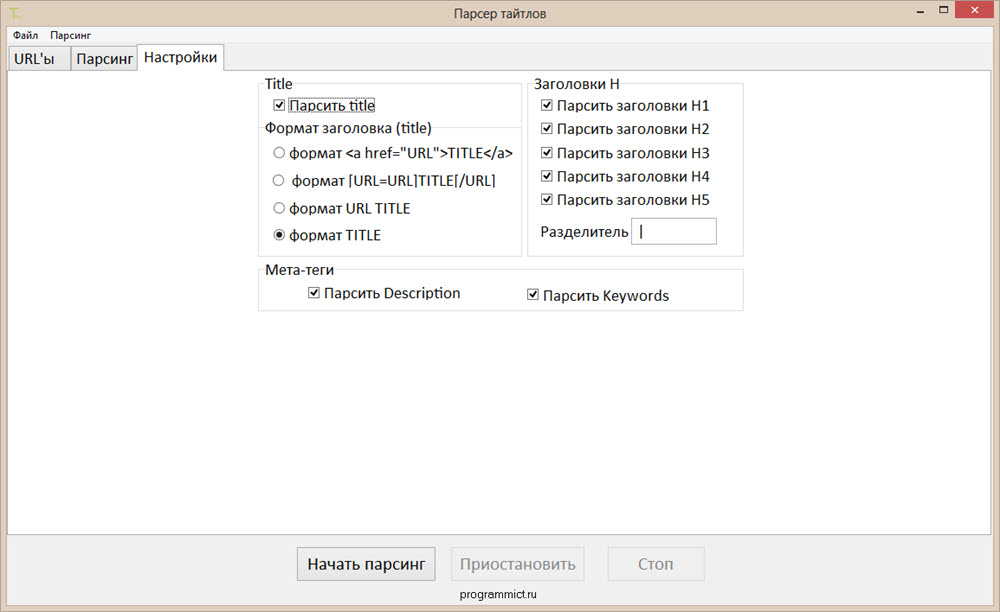

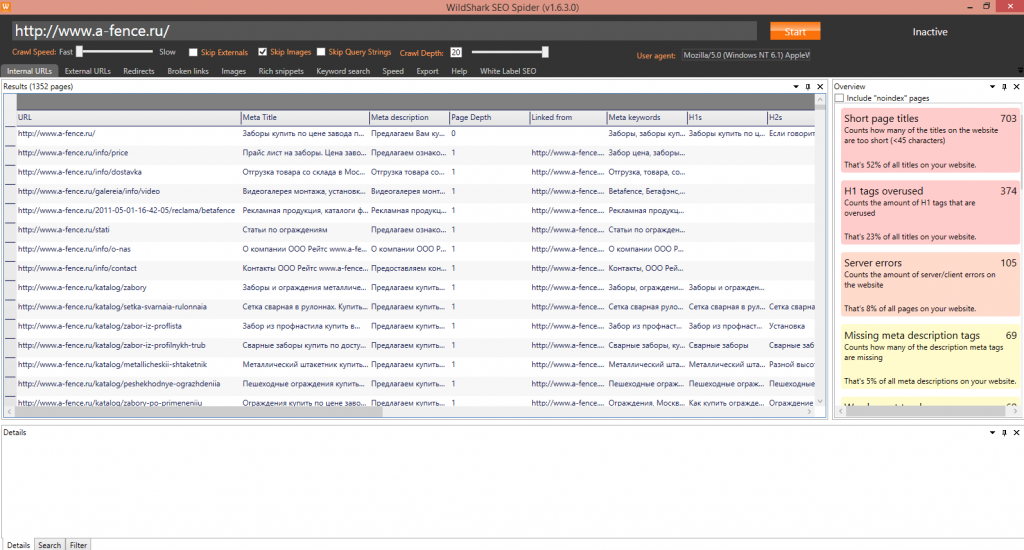

Screaming Frog SEO Spider. Многофункциональный парсер-сканер, который умеет собирать огромное количество разных данных — метатеги, XML-карты, битые ссылки, атрибуты Alt у картинок, дублированный контент, сведения о технической оптимизации и многое другое. Бесплатно можно проверить до 500 URL-адресов. Платная версия — $209/год. SEO Spider работает в формате приложения для ПК.

PR-CY. Сервис позволяет в режиме онлайн выполнить SEO-аудит сайта. Можно искать позиции ресурса в поиске, мета-теги, коды ответов сервера, заголовки, внешние исходящие ссылки, проблемные страницы. Стоимость — от 990 ₽/месяц. Есть бесплатный доступ на 7 дней.

Xenu’s Link Sleuth. Бесплатный парсер для поиска неработающих ссылок. Список собранных URL можно сортировать по любым критериям. Отчёт можно запросить в любое время. Работает как декстопное приложение.

Отчёт можно запросить в любое время. Работает как декстопное приложение.

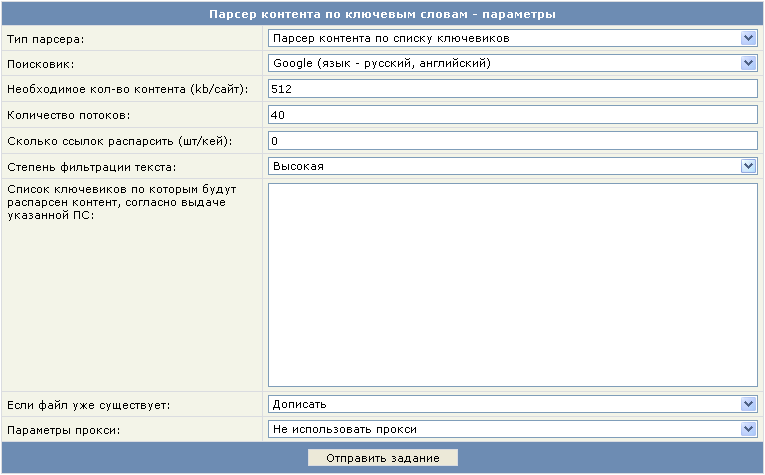

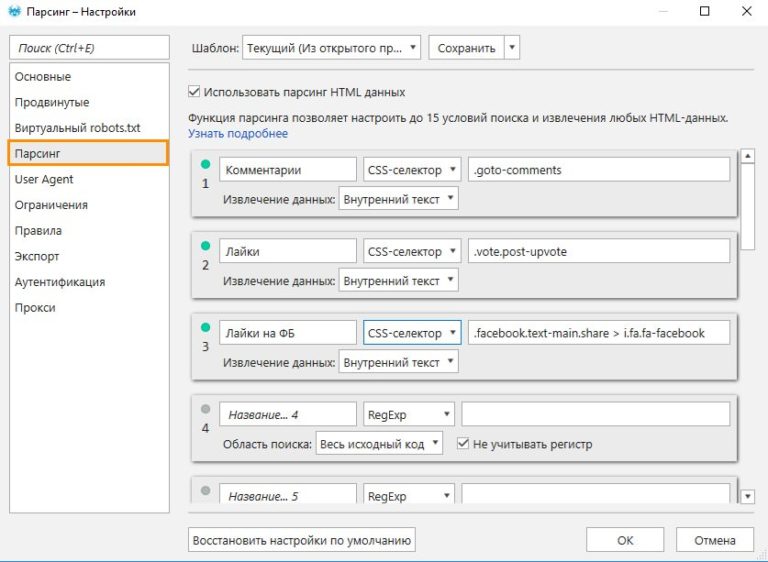

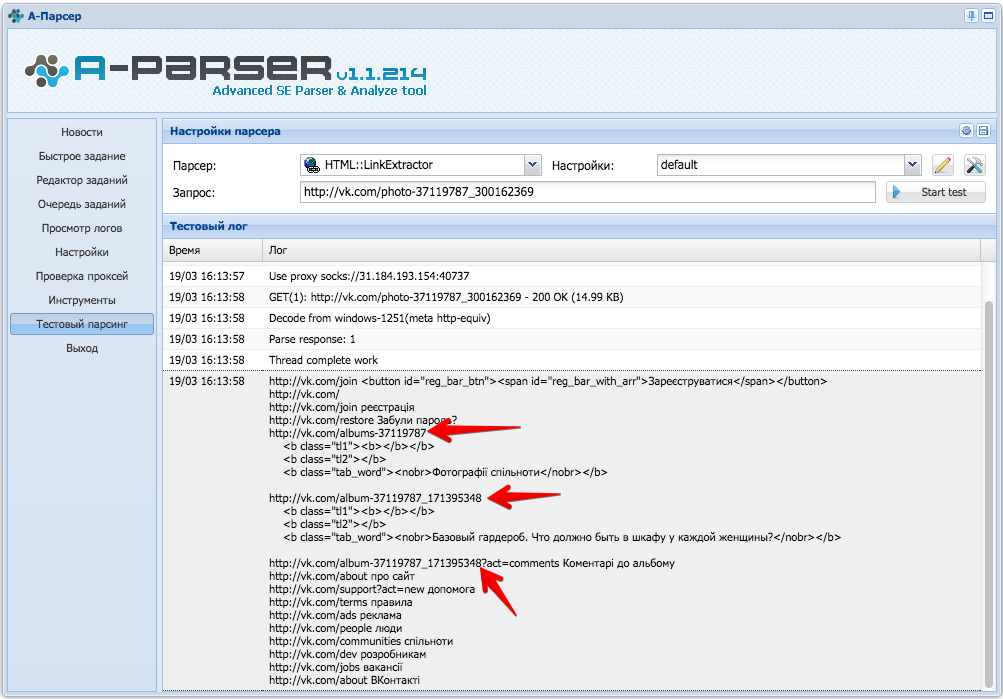

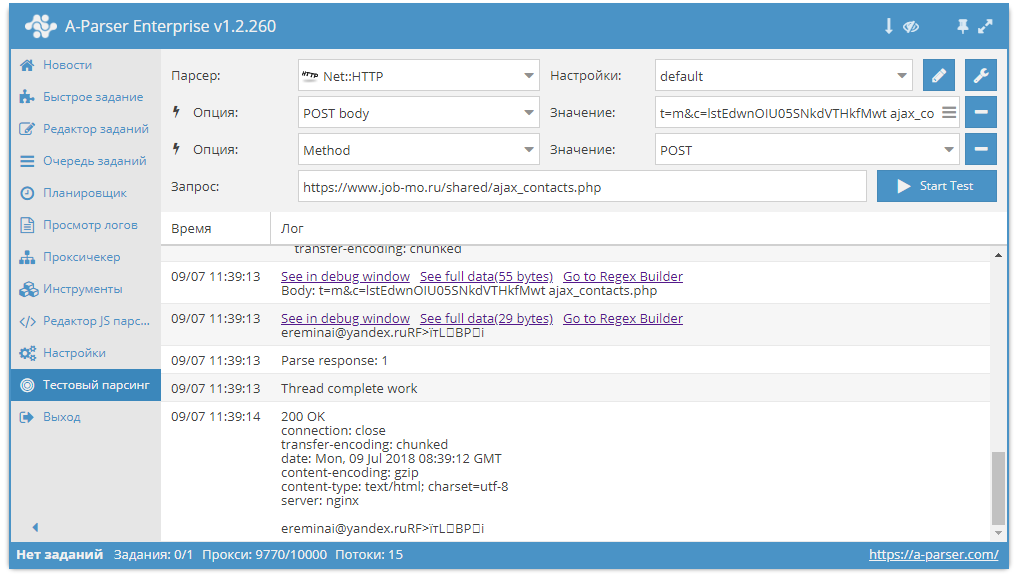

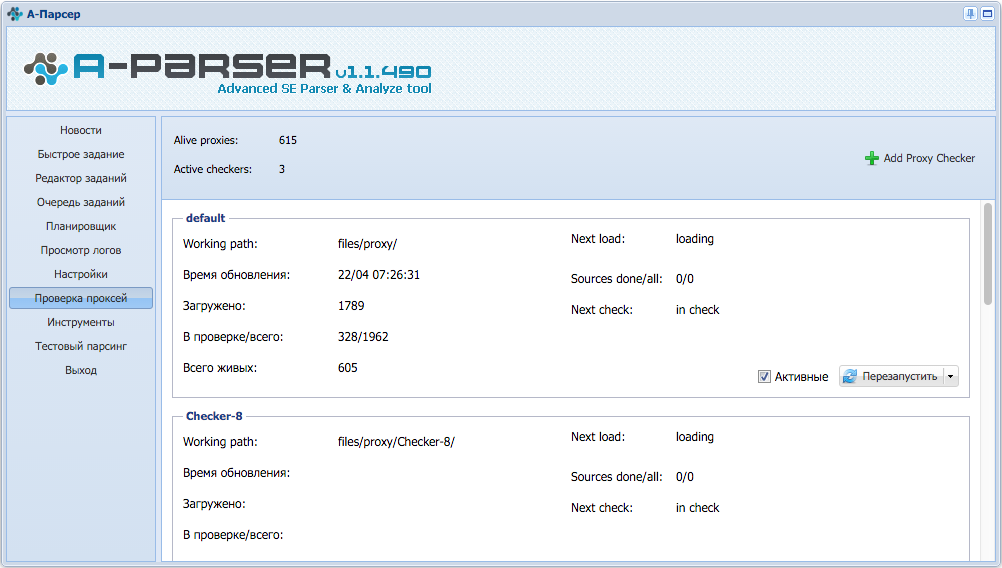

A-Parser. Многофункциональный инструмент для профессионального использования. Умеет парсить любые данные в неограниченном объёме: ссылки, анкоры, сниппеты, позиции в поиске, рекламные блоки, ключевые слова и многое другое. Всего в сервисе доступно 90+ разных парсеров. Стоимость от $179 за пожизненную лицензию. При необходимости здесь можно заказать индивидуальную разработку парсеров по нужным параметрам.

Для сбора контактных данных

Больше всего сомнений в законности парсинга возникает при сборе контактных данных — телефонов, email-адресов, контактных лиц. Здесь важно понимать разницу между персональными и общедоступными данными. Кроме того, имеет значение способ использования собранной информации.

Например, собрать базу контактов потенциальных партнёров или поставщиков — это законно. А вот автоматический сбор email-адресов для рассылки нарушает закон о персональных данных. А за массовую рассылку по адресам, собранным из открытых источников, можно улететь в спам.

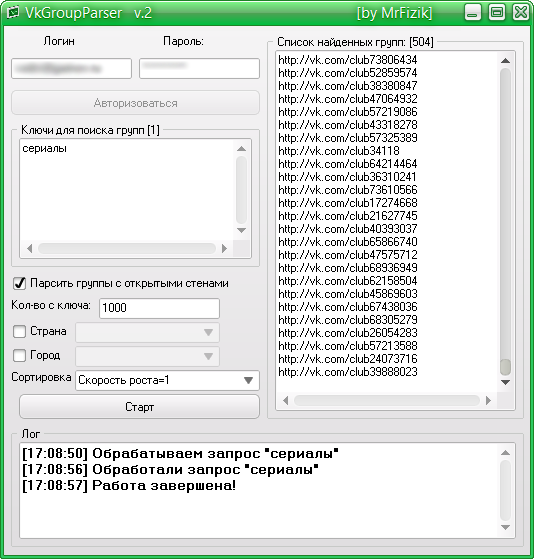

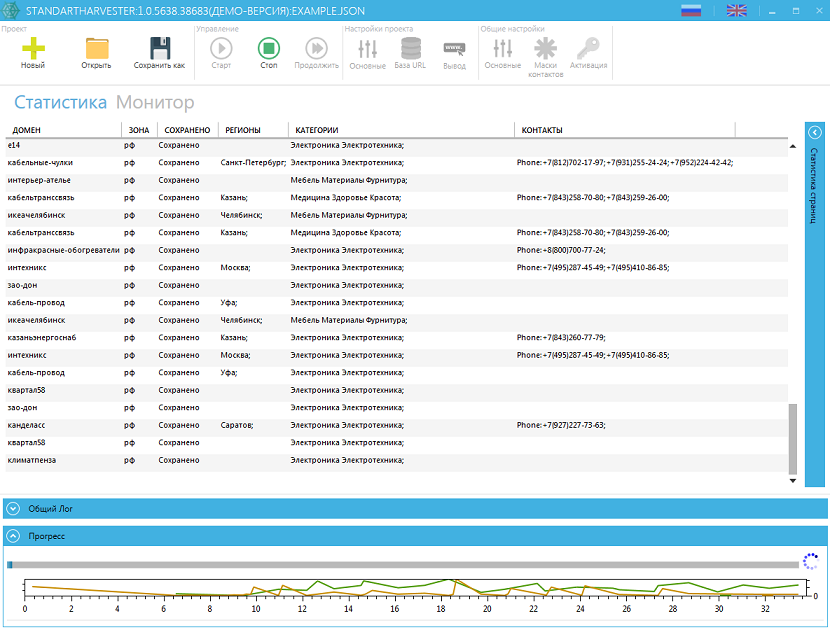

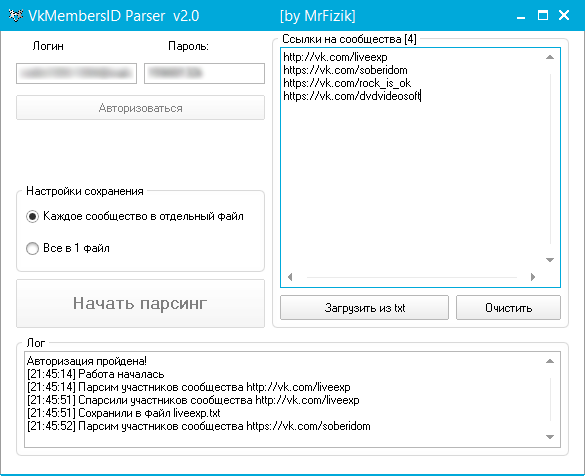

Примеры парсеров для сбора контактных данных:

ZoomInfo. Собирает контактные данные B2B — номера телефонов, email-адреса, ссылки на профили в соцсетях. Дополнительно можно парсить и другие важные данные о клиентах и партнёрах — веб-упоминания, должностные обязанности и иную информацию из публичного доступа. Стоимость сервиса — по запросу. Есть бесплатная пробная версия.

Hunter. Парсер для поиска людей, работающих в определённой компании, с их именем и адресом электронной почты. Дополнительное преимущество — бесплатный сервис для рассылки «холодных» писем. Стоимость парсера — от $49/мес. Есть бесплатный тариф с ограничениями.

Scrapebox Email Scraper. Собирает email-адреса в разных поисковых системах, на разных сайтах и из локальных файлов. При экспорте можно сохранять URL-адрес, с которого получен email. Стоимость приложения для парсинга — $97 за лицензию (цена без скидки $197).

Выбирая подходящий парсер, учитывайте ваши задачи и периодичность использования. Часто за один раз можно собрать определённый тип данных — для этого хватит бесплатного инструмента или триал-версии платного сервиса. Для регулярного сбора данных выбирайте парсер, который настроен на работу с нужным вам типом данных. Если планируете собирать большое количество разной информации и в приоритете гибкие настройки парсинга, то, вероятно, стоит заказать индивидуальное решение.

Часто за один раз можно собрать определённый тип данных — для этого хватит бесплатного инструмента или триал-версии платного сервиса. Для регулярного сбора данных выбирайте парсер, который настроен на работу с нужным вам типом данных. Если планируете собирать большое количество разной информации и в приоритете гибкие настройки парсинга, то, вероятно, стоит заказать индивидуальное решение.

Поделиться

СВЕЖИЕ СТАТЬИ

Другие материалы из этой рубрики

Не пропускайте новые статьи

Подписывайтесь на соцсети

Делимся новостями и свежими статьями, рассказываем о новинках сервиса

Статьи почтой

Раз в неделю присылаем подборку свежих статей и новостей из блога. Пытаемся шутить, но получается не всегда

Оставляя свой email, я принимаю Политику конфиденциальностиНаш юрист будет ругаться, если вы не примете 🙁

Как запустить email-маркетинг с нуля?

В конце каждого письма даем отбитые татуировки об email ⚡️

В конце каждого письма даем отбитые татуировки об email ⚡️*Вместе с курсом вы будете получать рассылку блога Unisender

Оставляя свой email, я принимаю Политику конфиденциальностиНаш юрист будет ругаться, если вы не примете 🙁

Бесплатный веб-парсер 2023: 10 лучших бесплатных инструментов и программ для веб-парсинга

Почему вы думаете, что за использование веб-парсеров нужно платить, на самом деле существуют бесплатные веб-парсеры, которые предоставляют вам основные возможности веб-парсинга бесплатно. В статье ниже мы рассмотрим некоторые из лучших бесплатных веб-парсеров на рынке.

1 Обзор лучших бесплатных веб-парсеров на рынке

2 Топ-10 инструментов и программного обеспечения для веб-парсинга в 2022 году

3 Часто задаваемые вопросы

4 Заключение

4. 1

Похожие публикации:

1

Похожие публикации:

Обзор лучших бесплатных веб-парсеров на рынке

- ParseHub: Бесплатный с ограничениями — <Mac, Windows и Linux> — Лучший бесплатный веб-парсер.

- Octoparse: Бесплатно с ограничениями — <Mac и Windows> — Расширенный веб-парсер

- io Extension: Совершенно бесплатно — <Расширение Chrome> — Лучшее бесплатное расширение Chrome для веб-парсинга

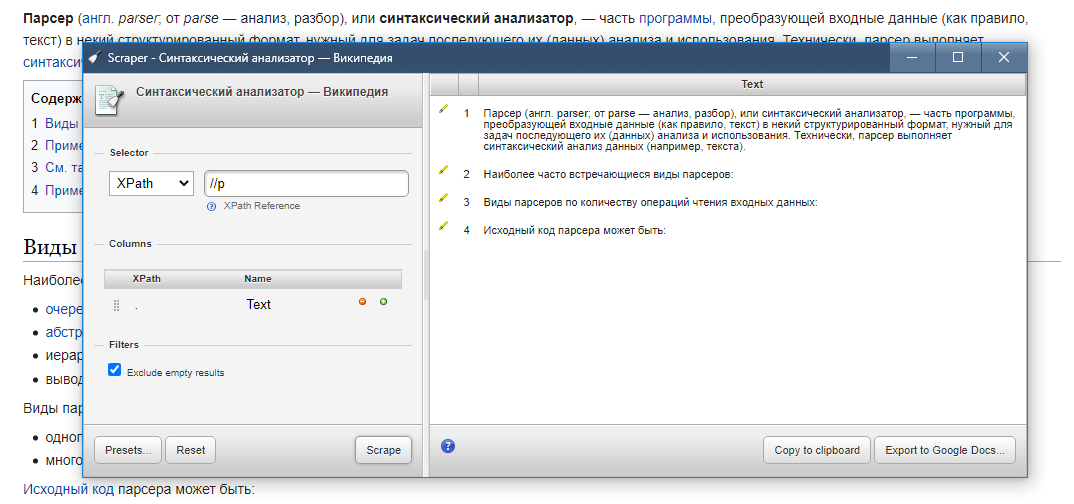

- Scraper: Полностью бесплатно — <Chrome Extension> — Лучший для промежуточных и продвинутых пользователей XPATH

- Apify: Некоторые актеры бесплатны с ограничениями — <NodeJS и Python> — Лучшее для кодеров

₽0.00

Скачать бесплатно

₽0.00

Скачать бесплатно

₽399.00

Скачать бесплатно

₽0.00

Скачать бесплатно

₽0.00

Скачать бесплатно

₽0. 00

00

Скачать бесплатно

₽0.00

Скачать бесплатно

₽0.00

Скачать бесплатно

Топ-10 инструментов и программного обеспечения для веб-парсинга в 2022 году

Как вы думаете, зачем вам нужен веб-парсер? Если вы можете скопировать и вставить информацию на веб-страницу вручную, то зачем вам инструмент для веб-парсинга? В случаях, когда количество информации невелико и может быть собрано на одной веб-странице, то копирования и вставки будет достаточно. А как быть в случае, когда вам нужны большие объемы данных со многих веб-страниц со сложной структурой? Вы все еще копируете и вставляете? Это может быть громоздко и утомительно. Конечно, вы подумаете о том, как собрать эти данные за короткое время. Отсюда возникает необходимость в веб-парсере. Боты для веб-парсинга используют методы автоматизации для извлечения данных с веб-страниц в кратчайшие сроки. Лучшие веб-парсеры на рынке — это платные веб-парсеры. Однако это не означает, что вы не можете получить веб-парсеры для бесплатного использования. На самом деле, есть некоторые веб-парсеры, которые полностью бесплатны, в то время как другие являются платными веб-парсерами с бесплатными уровнями. Мы прочесали рынок в поисках работающих бесплатных веб-парсеров, и в этой статье мы откроем вам некоторые из лучших веб-парсеров на рынке, которые вы можете использовать для своих легких задач веб-парсинга без оплаты.

На самом деле, есть некоторые веб-парсеры, которые полностью бесплатны, в то время как другие являются платными веб-парсерами с бесплатными уровнями. Мы прочесали рынок в поисках работающих бесплатных веб-парсеров, и в этой статье мы откроем вам некоторые из лучших веб-парсеров на рынке, которые вы можете использовать для своих легких задач веб-парсинга без оплаты.

Parsehub — лучший бесплатный веб-парсер

- Ценообразование: Бесплатно с платным планом

- Бесплатные пробные версии: Бесплатно — дополнительные функции предоставляются за дополнительную плату

- Формат вывода данных: Excel, JSON,

- Поддерживаемые платформы: Облако, настольный компьютер

Parsehub — это бесплатный инструмент для сбора данных с веб-страниц. Он с легкостью извлекает данные с веб-страниц. Этот инструмент способен извлекать данные с веб-страниц, которые построены и закодированы на JavaScript, технологиях AJAX и даже cookies. Таким образом, это эффективный веб-парсер для парсинга данных со всех видов веб-сайтов, включая интерактивные веб-страницы. Это настольное приложение полезно для исследователей, маркетологов, научных работников и специалистов по мониторингу изменений. Это не зависит от их знаний в области кодирования или программирования. Это объясняется тем, что вам не придется писать ни строчки кода, поскольку программа предоставляет интерфейс «укажи и щелкни» для определения интересующих данных на странице. Parsehub совместим с такими устройствами, как Windows, Linux и macOS. Кроме того, вы можете воспользоваться расширением для браузера для немедленного сбора данных. Хотя инструмент позволяет установить только пять задач по сбору данных для бесплатных пользователей, это количество проектов может достигать 20, если вы решите заплатить за премиум-пакет, при этом вы по-прежнему будете наслаждаться большой анонимностью с помощью IP-прокси.

Таким образом, это эффективный веб-парсер для парсинга данных со всех видов веб-сайтов, включая интерактивные веб-страницы. Это настольное приложение полезно для исследователей, маркетологов, научных работников и специалистов по мониторингу изменений. Это не зависит от их знаний в области кодирования или программирования. Это объясняется тем, что вам не придется писать ни строчки кода, поскольку программа предоставляет интерфейс «укажи и щелкни» для определения интересующих данных на странице. Parsehub совместим с такими устройствами, как Windows, Linux и macOS. Кроме того, вы можете воспользоваться расширением для браузера для немедленного сбора данных. Хотя инструмент позволяет установить только пять задач по сбору данных для бесплатных пользователей, это количество проектов может достигать 20, если вы решите заплатить за премиум-пакет, при этом вы по-прежнему будете наслаждаться большой анонимностью с помощью IP-прокси.

Data Scraper — бесплатный для легкого веб-парсинга

- Ценообразование: Бесплатно 500 страниц ежемесячно

- Бесплатные пробные версии: 500 страниц в месяц бесплатно

- Формат вывода данных: CSV, XSL

- Поддерживаемые платформы: Chrome

Этот веб-парсер представляет собой плагин, работающий в браузере Chrome. Он обеспечивает легкий парсинг страницы, содержащей табличный или списочный тип данных. Извлеченные данные будут отформатированы в файлы CSV или XSL. Бесплатный пакет этого инструмента представляет собой персонализированный браузер на chrome и позволяет извлекать данные о страницах до 500 в месяц. Этого будет достаточно для нетяжелого парсинга экрана с небольшим объемом данных. В дополнение к этим функциям платный тарифный план собирает больше страниц и даже предлагает услуги API и IP-прокси. Таким образом, можно не беспокоиться о сайтах с жесткими ограничениями для парсеров. Вы можете рассмотреть платную версию и изучить многие другие возможности.

Он обеспечивает легкий парсинг страницы, содержащей табличный или списочный тип данных. Извлеченные данные будут отформатированы в файлы CSV или XSL. Бесплатный пакет этого инструмента представляет собой персонализированный браузер на chrome и позволяет извлекать данные о страницах до 500 в месяц. Этого будет достаточно для нетяжелого парсинга экрана с небольшим объемом данных. В дополнение к этим функциям платный тарифный план собирает больше страниц и даже предлагает услуги API и IP-прокси. Таким образом, можно не беспокоиться о сайтах с жесткими ограничениями для парсеров. Вы можете рассмотреть платную версию и изучить многие другие возможности.

Расширение WebScraper.io — лучший веб-парсер для Chrome

- Ценообразование: Freemium

- Бесплатные испытания: Freemium

- Формат вывода данных: CSV, XLSX и JSON

- Поддерживаемая платформа: Браузерное расширение (Chrome и Firefox)

WebScraper — это инструмент, имеющий расширение для хрома для мгновенного парсинга экрана. За годы его существования было зарегистрировано более 400 тысяч пользователей. Это один из визуальных веб-парсеров с интерфейсом «наведи и щелкни», что делает его удобным для использования не кодерами. Его хромированная версия очень гибкая, поскольку вы можете создать карту, по которой будет осуществляться путешествие по сайту. Проще говоря, вы можете создавать карты для навигации по сайту и маршрутов парсинга данных. Помимо расширения для браузера. Этот сервис предлагает услугу облачного парсинга. Это версия, с помощью которой можно собирать большое количество данных, а также выполнять несколько одновременных задач. И расширение Chrome, и облачный сервис способны извлекать данные со страниц с JavaScript или AJAX. Версия для браузера экспортирует данные в CSV, а облачная версия делает это в форматах CSV, XLSX и JSON. Все эти документы с данными могут быть доступны с помощью веб-крючков или API. Таким образом, вы можете экспортировать их через Dropbox, Google Sheets или Amazon S3. На сайте компании есть бесплатная пробная версия для изучения возможностей платного пакета.

За годы его существования было зарегистрировано более 400 тысяч пользователей. Это один из визуальных веб-парсеров с интерфейсом «наведи и щелкни», что делает его удобным для использования не кодерами. Его хромированная версия очень гибкая, поскольку вы можете создать карту, по которой будет осуществляться путешествие по сайту. Проще говоря, вы можете создавать карты для навигации по сайту и маршрутов парсинга данных. Помимо расширения для браузера. Этот сервис предлагает услугу облачного парсинга. Это версия, с помощью которой можно собирать большое количество данных, а также выполнять несколько одновременных задач. И расширение Chrome, и облачный сервис способны извлекать данные со страниц с JavaScript или AJAX. Версия для браузера экспортирует данные в CSV, а облачная версия делает это в форматах CSV, XLSX и JSON. Все эти документы с данными могут быть доступны с помощью веб-крючков или API. Таким образом, вы можете экспортировать их через Dropbox, Google Sheets или Amazon S3. На сайте компании есть бесплатная пробная версия для изучения возможностей платного пакета.

Scraper — бесплатный веб-парсер для пользователей XPATH

- Ценообразование: Бесплатно

- Бесплатные испытания: Бесплатно

- Формат вывода данных: CSV, JSON

- Поддерживаемые платформы: Chrome

Scraper — это простой в использовании инструмент для сбора данных на веб-страницах, предназначенный для средних и опытных пользователей с опытом работы с XPATH. Это расширение для браузера Chrome собирает данные с веб-страниц, которые не являются сложными по структуре. Оно делает это и представляет извлеченные данные в виде электронной таблицы для использования. Таким образом, оно облегчает ваши исследования в Интернете, поскольку вы можете быстро собирать данные. Этим инструментом могут пользоваться как новички, так и профессионалы. Лучше всего он работает при сборе данных, которые находятся в табличной форме на веб-страницах. Для этого просто щелкните правой кнопкой мыши после выбора набора данных, которые вы хотите извлечь. Затем нажмите «Scrape Similar» в меню браузера. Это так просто. С помощью Scraper вы можете копировать данные в буфер обмена и даже обновлять документы для мгновенного экспорта в Google Docs. Вы также можете добавить дополнительные столбцы с помощью JQuery или Xpath. Следует отметить, что воспользоваться этой функцией могут люди, предварительно владеющие XPath.

Затем нажмите «Scrape Similar» в меню браузера. Это так просто. С помощью Scraper вы можете копировать данные в буфер обмена и даже обновлять документы для мгновенного экспорта в Google Docs. Вы также можете добавить дополнительные столбцы с помощью JQuery или Xpath. Следует отметить, что воспользоваться этой функцией могут люди, предварительно владеющие XPath.

Octoparse

- Ценообразование: От 75 долларов в месяц

- Бесплатные пробные версии: 14 дней бесплатной пробной версии с ограничениями

- Формат вывода данных: CSV, Excel, JSON, MySQL, SQLServer

- Поддерживаемые платформы: Облако, настольный компьютер

Инструмент для парсинга Octoparse — это один из парсеров, который можно использовать как с навыками кодирования, так и без них. Проще говоря, его можно назвать парсером «наведи и щелкни». Он настолько эффективен для поиска данных и удобен не только для исследователей, но и для предпринимателей. Бесплатная версия парсера может служить вам достаточно долго, если вам нужны только основные данные с веб-страниц. Однако если вы хотите добывать большие объемы данных, вам, возможно, придется приобрести платную версию. Стоит отметить совместимость программы как с Windows, так и с Mac OS. Интересно, что на официальной странице есть демо-версия, демонстрирующая простоту использования. Более того, вам будет предоставлена двухнедельная бесплатная пробная версия. Это также можно увидеть на сайте. Octoparse отлично справляется со сбором данных на веб-страницах, построенных с использованием JavaScript, AJAX, cookies и т.п. Наконец, все собранные данные можно загрузить в желаемом формате, например, CSV, Excel или API.

Бесплатная версия парсера может служить вам достаточно долго, если вам нужны только основные данные с веб-страниц. Однако если вы хотите добывать большие объемы данных, вам, возможно, придется приобрести платную версию. Стоит отметить совместимость программы как с Windows, так и с Mac OS. Интересно, что на официальной странице есть демо-версия, демонстрирующая простоту использования. Более того, вам будет предоставлена двухнедельная бесплатная пробная версия. Это также можно увидеть на сайте. Octoparse отлично справляется со сбором данных на веб-страницах, построенных с использованием JavaScript, AJAX, cookies и т.п. Наконец, все собранные данные можно загрузить в желаемом формате, например, CSV, Excel или API.

Data Miner — лучшее бесплатное расширение веб-парсера для браузера Edge

Data Miner — это американский инструмент для веб-парсинга. Его бесплатная версия является расширением для браузеров Google Chrome и Edge. Этот инструмент способен просматривать не только отдельные страницы, но и веб-сайты с множеством страниц и собирать полезные данные в соответствии с вашими интересами. Таким образом, Data miner проникает на веб-страницы и накапливает данные для использования в загружаемых форматах, таких как CSV и таблицы Excel. Это облегчает составление заключений о вашем бизнесе с помощью инструментов анализа данных. Иногда мощный инструмент может показаться сложным в использовании, судя по его интерфейсу. С Data Miner дело обстоит иначе. Его пользовательский интерфейс легко понять, поскольку он требует меньше осознанности. На самом деле, достаточно одного клика, чтобы извлечь данные из массива правил анализа данных, которых насчитывается до 60 тысяч. Как будто этого недостаточно. Если у вас есть желаемый шаблон извлечения, вы также можете настроить правило для задачи добычи данных.

Таким образом, Data miner проникает на веб-страницы и накапливает данные для использования в загружаемых форматах, таких как CSV и таблицы Excel. Это облегчает составление заключений о вашем бизнесе с помощью инструментов анализа данных. Иногда мощный инструмент может показаться сложным в использовании, судя по его интерфейсу. С Data Miner дело обстоит иначе. Его пользовательский интерфейс легко понять, поскольку он требует меньше осознанности. На самом деле, достаточно одного клика, чтобы извлечь данные из массива правил анализа данных, которых насчитывается до 60 тысяч. Как будто этого недостаточно. Если у вас есть желаемый шаблон извлечения, вы также можете настроить правило для задачи добычи данных.

Scrapestack — бесплатный API для веб-парсинга

- Цены: От $20 в месяц

- Бесплатные испытания: 100 запросов в месяц бесплатно

- Формат вывода данных: CSV, JSON

- Поддерживаемые платформы: Облако

Scrapestack — известный поставщик услуг API-парсеров и прокси. За годы работы они обслужили более 200 компаний. Они утверждают, что парсят веб-страницы за миллисекунды. Scrapestack предлагает бесплатный сервис API веб-парсинга. Этот инструмент предлагает вам решение проблем, связанных с добычей данных. Он обладает сложными функциями, которые решают проблему CAPTCHA, позволяют отправлять несколько API-запросов одновременно, а также работает с браузерами. Несмотря на то, что вы будете удовлетворены бесплатным планом, вы хотели бы увидеть больше возможностей, которые могут быть открыты в платном плане. Он стоит всего 19,99 долларов США в месяц. Этот инструмент имеет широкий спектр применения. Это эффективный сборщик данных для поисковых систем, таких как Google и Youtube. Кроме того, он также собирает данные для таких онлайн-рынков, как eBay и Amazon. Не исключены и социальные сети, такие как Instagram, Facebook и Twitter.

За годы работы они обслужили более 200 компаний. Они утверждают, что парсят веб-страницы за миллисекунды. Scrapestack предлагает бесплатный сервис API веб-парсинга. Этот инструмент предлагает вам решение проблем, связанных с добычей данных. Он обладает сложными функциями, которые решают проблему CAPTCHA, позволяют отправлять несколько API-запросов одновременно, а также работает с браузерами. Несмотря на то, что вы будете удовлетворены бесплатным планом, вы хотели бы увидеть больше возможностей, которые могут быть открыты в платном плане. Он стоит всего 19,99 долларов США в месяц. Этот инструмент имеет широкий спектр применения. Это эффективный сборщик данных для поисковых систем, таких как Google и Youtube. Кроме того, он также собирает данные для таких онлайн-рынков, как eBay и Amazon. Не исключены и социальные сети, такие как Instagram, Facebook и Twitter.

Apify — бесплатный веб-парсер для разработчиков

- Ценообразование: От $49 в месяц за 100 вычислительных единиц Actor.

- Бесплатные пробные версии: Стартовый план включает 10 вычислительных блоков Actor

- Формат вывода данных: JSON

- Поддерживаемые ОС: облачные — доступ через API

Apify — это готовый к использованию мощный инструмент для веб-парсинга и автоматизации. Он предлагает различные услуги, начиная от сбора данных, автоматизации и заканчивая услугами прокси. Следовательно, он хорош в том, что делает. Он предлагает группу ботов, известных как агенты, которые вы можете бесплатно использовать для сбора данных, причем наиболее популярным является общий агент для сбора данных. Помимо бесплатных веб-парсеров, эта служба также предоставляет вам бесплатные общие прокси. Однако следует знать, что Apify предназначен для кодеров, которые не хотят изобретать велосипед. Если вы не являетесь разработчиком nodeJS или Python, веб-парсеры Apify не для вас. С Apify у вас есть шанс свободно парсить неограниченное количество данных в структурированных форматах. Наборы данных, извлеченные Apify, автоматически форматируются в CSV или JSON. Таким образом, они становятся читаемыми для аналитических машин. Это активно подразумевает, что вы можете интегрировать набор данных в существующий рабочий процесс или создать новый с помощью API и Webhooks.

Наборы данных, извлеченные Apify, автоматически форматируются в CSV или JSON. Таким образом, они становятся читаемыми для аналитических машин. Это активно подразумевает, что вы можете интегрировать набор данных в существующий рабочий процесс или создать новый с помощью API и Webhooks.

ProxyCrawl — бесплатные специализированные веб-парсеры для конкретных веб-сайтов

- Цена: От $29 в месяц

- Бесплатные испытания: 100 кредитов API

- Формат вывода данных: CSV, JSON

- Поддерживаемые платформы: Облако

ProxyCrawl — это инструмент для веб-парсинга, который работает как прокси-сервер. Он был создан с учетом технических требований, чтобы помочь владельцам бизнеса с легкостью собирать данные. Они могут добывать и извлекать данные с веб-страниц с высокой анонимностью. Он отлично работает как с большими, так и с малыми объемами данных. Proxy crawl имеет возможность собирать данные со всех типов веб-сайтов. Хотя для получения доступа к полному пакету услуг вам придется заплатить всего лишь символическую сумму, есть возможность создать бесплатный аккаунт и собирать данные точного качества и размера, но с определенными ограничениями. Кроме того, встроенная в него прокси-программа обходит ограничения веб-сайтов и преодолевает CAPTCHA. Она извлекает данные с крупных сайтов и поисковых систем, таких как Yahoo, Amazon, Yandex, Glassdoor, и даже с платформ социальных сетей, таких как Facebook, LinkedIn и им подобных. Интересно, что API делает скриншот сайта, который просматривается.

Хотя для получения доступа к полному пакету услуг вам придется заплатить всего лишь символическую сумму, есть возможность создать бесплатный аккаунт и собирать данные точного качества и размера, но с определенными ограничениями. Кроме того, встроенная в него прокси-программа обходит ограничения веб-сайтов и преодолевает CAPTCHA. Она извлекает данные с крупных сайтов и поисковых систем, таких как Yahoo, Amazon, Yandex, Glassdoor, и даже с платформ социальных сетей, таких как Facebook, LinkedIn и им подобных. Интересно, что API делает скриншот сайта, который просматривается.

Mozenda — веб-парсер премиум-класса

- Ценообразование: Индивидуальное предложение

- Бесплатные пробные версии: Доступен 30-дневный бесплатный ограниченный план

- Формат вывода данных: CSV, JSON

- Поддерживаемые платформы: Облако

В мире, где многие владельцы бизнеса нанимают разработчиков и сборщиков данных, Mozenda сделает лучшую работу за более короткий срок и с более высокой точностью. С 2007 года Mozenda является одним из самых первых разработчиков технологии парсинга. За это время он просмотрел миллиарды веб-страниц. Многие клиенты полагаются на этот инструмент для ежедневного сбора данных. Это просто потому, что он помогает парсить данные, которые представляют собой не только текст, но и изображения, файлы и даже PDF-контент на веб-сайтах. После этого данные будут оформлены в формате, подходящем для публикации. Таким образом, API можно использовать для экспорта собранных данных в CSV, JSON, TSV или XML. Кроме того, Mozenda дает вам возможность интегрировать данные с выбранных вами партнерских платформ. Вы получите 30 дней бесплатного использования Mozenda. Эти 30 дней предназначены для того, чтобы показать вам, на что способен этот инструмент. Попробуйте, и вы будете убеждены в необходимости приобретения платных услуг.

С 2007 года Mozenda является одним из самых первых разработчиков технологии парсинга. За это время он просмотрел миллиарды веб-страниц. Многие клиенты полагаются на этот инструмент для ежедневного сбора данных. Это просто потому, что он помогает парсить данные, которые представляют собой не только текст, но и изображения, файлы и даже PDF-контент на веб-сайтах. После этого данные будут оформлены в формате, подходящем для публикации. Таким образом, API можно использовать для экспорта собранных данных в CSV, JSON, TSV или XML. Кроме того, Mozenda дает вам возможность интегрировать данные с выбранных вами партнерских платформ. Вы получите 30 дней бесплатного использования Mozenda. Эти 30 дней предназначены для того, чтобы показать вам, на что способен этот инструмент. Попробуйте, и вы будете убеждены в необходимости приобретения платных услуг.

Часто задаваемые вопросы

Что такое бесплатные веб-парсеры? Веб-парсеры — это, по сути, автоматизированные боты, предназначенные для извлечения общедоступных данных из Интернета. Обычно эти веб-парсеры имеют свою цену. Веб-парсеры, за использование которых вам не нужно платить, можно назвать бесплатными веб-парсерами. Возможно, вам будет интересно узнать, что бесплатность не означает, что вы не будете тратить деньги на их использование. Большинство из них требуют прокси для работы, и вам нужно купить вращающиеся прокси для веб-парсинга, так как бесплатные не являются надежными или даже пригодными для использования. Большинство бесплатных веб-парсеров не являются полностью бесплатными, так как существуют ограничения, согласно которым только платные пользователи получают все возможности.

Обычно эти веб-парсеры имеют свою цену. Веб-парсеры, за использование которых вам не нужно платить, можно назвать бесплатными веб-парсерами. Возможно, вам будет интересно узнать, что бесплатность не означает, что вы не будете тратить деньги на их использование. Большинство из них требуют прокси для работы, и вам нужно купить вращающиеся прокси для веб-парсинга, так как бесплатные не являются надежными или даже пригодными для использования. Большинство бесплатных веб-парсеров не являются полностью бесплатными, так как существуют ограничения, согласно которым только платные пользователи получают все возможности.

Является ли веб-парсинг законным? В прошлом веб-парсинг находился в серой зоне, и некоторые спорили о том, является ли это законной деятельностью или нет. Теперь это не так, поскольку существуют судебные запреты, которые сделали его законным. Вы можете парсить общедоступные данные с помощью веб-парсинга при условии, что вы не нанесете вреда целевому веб-серверу. Важно знать, что это не юридическая консультация, за которой лучше обратиться к компетентному юристу. Также важно знать, что региональные законы могут отличаться, но в целом веб-парсинг считается законным.

Важно знать, что это не юридическая консультация, за которой лучше обратиться к компетентному юристу. Также важно знать, что региональные законы могут отличаться, но в целом веб-парсинг считается законным.

Зачем использовать бесплатные веб-парсеры? Веб-парсеры стоят денег и времени на разработку, обслуживание и управление. По этим причинам веб-парсеры должны иметь свою цену. Именно поэтому бесплатные веб-парсеры имеют некоторые ограничения. Однако не всегда вам нужны все возможности веб-парсера или даже расширенные возможности веб-парсеров. Если вы легкий пользователь, которому нужно парсить всего несколько страниц с сайта, вы можете воспользоваться бесплатными веб-парсерами и использовать деньги для других аспектов вашего бизнеса.

Хороши ли бесплатные веб-парсеры? Платные веб-парсеры являются лучшими, поскольку при их использовании вы получаете максимум возможностей и преимуществ. Однако бесплатные веб-парсеры не так уж плохи, поскольку их тоже можно использовать для сбора данных. Некоторые из бесплатных веб-парсеров, включая WebScraper.io Extension, вполне удобны в использовании и предлагают вам множество дополнительных функций бесплатно. Возможно, им не хватает некоторых премиум-функций платных веб-парсеров, но они также хороши для веб-парсинга, и если вам нужно просто парсить данные из Интернета без дополнительных функций, то они вполне подойдут для этого.

Некоторые из бесплатных веб-парсеров, включая WebScraper.io Extension, вполне удобны в использовании и предлагают вам множество дополнительных функций бесплатно. Возможно, им не хватает некоторых премиум-функций платных веб-парсеров, но они также хороши для веб-парсинга, и если вам нужно просто парсить данные из Интернета без дополнительных функций, то они вполне подойдут для этого.

Заключение

В итоге, появление технологии веб-парсинга — это большая победа в извлечении и анализе данных. Это, несомненно, облегчает задачу в развитии технологии. Если данные по-прежнему будут собираться и упорядочиваться вручную путем копирования и вставки, то сравнение и актуальные выводы о рыночных ценах, колебаниях в бизнесе, изменениях в окружающей среде и даже научных исследованиях всегда будут оставаться утомительной задачей. Таким образом, использование таких технологий, несомненно, является обязательным для всех, кто хочет принимать обоснованные решения в кратчайшие сроки. К счастью, многие из них бесплатны, а некоторые имеют бесплатный период использования. Вы можете взять любой из перечисленных выше веб-парсеров и с легкостью извлечь данные.

Вы можете взять любой из перечисленных выше веб-парсеров и с легкостью извлечь данные.

Просмотров: 1 610

Программное обеспечение для анализа электронной почты и автоматизации рабочих процессов

Собирайте данные из входящих сообщений электронной почты и отправляйте их в электронные таблицы, документы Google, базы данных, API, службы интеграции и т. д.

Кредитная карта не требуется

Пересылать электронные письма с данными, попавшими в их тело или вложения, на наш анализатор электронной почты.

Mailparser извлекает все соответствующие поля данных на основе ваших пользовательских правил анализа.

Данные автоматически отправляются в приложения, которые вы уже используете, или доступны для загрузки.

Собирайте данные из входящих сообщений электронной почты и перемещайте их туда, где они находятся. Как только новое электронное письмо обработано, ваши данные передаются туда, где они должны быть — в бизнес-приложениях, которые вы уже используете каждый день.

Отправляйте свои данные в Salesforce или множество других интеграций. Вы также можете внедрить собственную интеграцию на основе веб-перехватчиков или загрузить проанализированные данные электронной почты в Excel, CSV, JSON и XML.

Отправляйте свои данные в Salesforce или множество других интеграций. Вы также можете внедрить собственную интеграцию на основе веб-перехватчиков или загрузить проанализированные данные электронной почты в Excel, CSV, JSON и XML.Электронная почта в Excel

Mailparser автоматически извлекает данные из повторяющихся электронных писем и сохраняет их в виде структурированных данных в Excel. После настройки правил пересылайте письма в Mailparser, а мы сделаем все остальное.

Электронная почта для потенциальных клиентов

Электронная почта для потенциальных клиентов Пересылайте все новые лиды в Mailparser, и мы извлечем и записывайте данные в свою любимую CRM, включая Salesforce, HubSpot и Пайпдрайв.

Электронная почта в Google Sheet

Mailparser может извлекать данные из электронной почты, PDF, DOC, DOCX, XLS или CSV и автоматически импортировать данные в Google Таблицы. Обычное использование включает копирование потенциальных клиентов по электронной почте, анализ заказов и уведомлений о доставке.

1 500 интеграций

Мы предлагаем более 1 500 интеграций с вашим любимые приложения через Zapier. Автоматически извлекайте и отправляйте данные из повторяющихся писем в приложения, которые вы уже используете и любите.

Вложения файлов в Excel

Обрабатывать текст, хранящийся во вложениях электронной почты, а затем сохранять его как полезные данные. Извлекайте текст из файлов форматов PDF, DOC, DOCX, XLS, XLSX, CSV, TXT и XML.

Электронная почта в Slack

Используйте веб-перехватчики для автоматической отправки важные уведомления в Slack. Анализируйте важные уведомления (предупреждения, новые продажи) из электронных писем и отправляйте их на любой канал Slack.

Посмотрите наш вводный видеоролик и узнайте, как легко начать работу

Воспроизвести видео

Не верьте нам на слово. Прочитайте, что говорят некоторые из наших счастливых клиентов!

Обзор MailParser Выдающийся. Как только вы научитесь его использовать, вы сможете сэкономить тысячи долларов и часов в неделю.

☺Полезность этого велика. Так много вариантов использования. Вы можете анализировать не только тело электронной почты, но и вложения электронной почты.

☹Поначалу может быть немного сложно. Как только вы получите свое первое правило синтаксического анализа и интеграцию за пояс, все станет очень просто.

Как только вы научитесь его использовать, вы сможете сэкономить тысячи долларов и часов в неделю.

☺Полезность этого велика. Так много вариантов использования. Вы можете анализировать не только тело электронной почты, но и вложения электронной почты.

☹Поначалу может быть немного сложно. Как только вы получите свое первое правило синтаксического анализа и интеграцию за пояс, все станет очень просто.

Интуитивный, впечатляющий, удобный Я лично искал сайт, чтобы оставить отзыв о mailparser, потому что он действительно фантастический. невероятно полезный продукт: отлично подходит для начинающих, щедрые бесплатные функции и, безусловно, сэкономит время, ускорит прогресс и повысит производительность.

☺Я долго искал программу для анализа основного текста моих электронных писем о бронировании для автоматического создания контактов/контактных данных. У меня есть Power Automate, но он далеко не так удобен для пользователя, как mailparser. Я смог полностью настроить и автоматически экспортировать конкретную информацию, которая мне была нужна менее чем за час (это включает в себя настройку, инструктаж и обзор системы, подключение нескольких приложений, анализ и проверку более 20 ключей данных, а затем редактирование немного больше, чтобы сузить текстовые поля по моему вкусу) После первой интеграции остальные были на одном дыхании! На самом деле, mailparser действительно упростил для меня автоматизацию! Я определенно рассматриваю возможность перехода на платную подписку (но хотелось бы видеть больше интеграции с Google Apps для максимальной рентабельности инвестиций). ☹Как уже упоминалось, хотелось бы большего количества интеграций с Google Apps и, возможно, немного более низкой ценовой категории для платных подписок.

☹Как уже упоминалось, хотелось бы большего количества интеграций с Google Apps и, возможно, немного более низкой ценовой категории для платных подписок.

Инструмент синтаксического анализа Great Mail Извлечение данных из электронных писем, на написание которых вручную ушло бы много часов. ☺1. Проще в использовании, чем другие инструменты синтаксического анализа, которые я использовал. 2. Отлично подходит для извлечения данных из электронных писем для создания файла Excel и, таким образом, повышает производительность. 3. Наличие бесплатной версии. ☹ В сервисе нет ничего, что мне могло бы не понравиться, и он надежно и без проблем выполняет функцию анализа электронной почты.

Простой, недорогой, отлично работает, необходим для интеграции Простой и плавно работающий инструмент для анализа почтовых данных по очень доступной цене. Действительно полезно, если вам нужно автоматически обрабатывать электронные письма, извлекать из них данные и использовать другие инструменты. Экономит кучу времени! Рекомендовать!

☺Интуитивно понятный рабочий процесс с настройкой почтовых ящиков и правил обработки. Бесплатно до 30 писем в месяц, что отлично подходит для пробной версии сервиса. Отлично работает, используя его для передачи данных в zapier и обработки интеграции данных с другими инструментами.

☹Все работает отлично. Приходилось некоторое время привыкать к настройке правил, но вы довольно быстро их понимаете.

Экономит кучу времени! Рекомендовать!

☺Интуитивно понятный рабочий процесс с настройкой почтовых ящиков и правил обработки. Бесплатно до 30 писем в месяц, что отлично подходит для пробной версии сервиса. Отлично работает, используя его для передачи данных в zapier и обработки интеграции данных с другими инструментами.

☹Все работает отлично. Приходилось некоторое время привыкать к настройке правил, но вы довольно быстро их понимаете.

Отличный инструмент для экономии времени ☺Было намного точнее и надежнее, чем другие инструменты, которые я пробовал. ☹Не имея технических знаний, мне потребовалось немного времени, чтобы разобраться с настройкой, хотя команда Mailparser упростила задачу, предоставив несколько отличных учебных пособий и доступную поддержку

Бесценный технический стек маркетинга Это бесценный продукт для специалистов по цифровому маркетингу, которые хотят создавать структурированные данные из контента, отправленного по электронной почте. Он может находиться в стеке автоматизации и помогать передавать данные между системами. Я использовал это, чтобы выйти из ряда узких мест и упростить свою жизнь, автоматизируя поток данных в отчеты или инициируя маркетинговые действия на основе электронных писем, поступающих с издательских платформ, или обратно в CRM.

☺Очень прост в использовании для простых задач, вы можете начать анализировать структурированные данные и отправлять их на конечную точку через веб-перехватчик за считанные минуты.

☹ Сначала это кажется слишком простым, и может потребоваться некоторое время для обучения, если вы хотите сделать что-то действительно сложное.

Он может находиться в стеке автоматизации и помогать передавать данные между системами. Я использовал это, чтобы выйти из ряда узких мест и упростить свою жизнь, автоматизируя поток данных в отчеты или инициируя маркетинговые действия на основе электронных писем, поступающих с издательских платформ, или обратно в CRM.

☺Очень прост в использовании для простых задач, вы можете начать анализировать структурированные данные и отправлять их на конечную точку через веб-перехватчик за считанные минуты.

☹ Сначала это кажется слишком простым, и может потребоваться некоторое время для обучения, если вы хотите сделать что-то действительно сложное.

Отличное и доступное ПО для автоматизации Мне это нравится, команда была очень полезной и помогла мне настроить его. Особенно, когда мне нужна была помощь в открытии PDF-файла с паролем и на японском языке.

Это здорово сэкономило время для ежедневных уведомлений и т. д. и избавило меня от ручных повторяющихся задач.

☺Простота использования, функциональность и соотношение цены и качества

☹Я не могу сказать ничего плохого, так как это соответствует моей цели.

Отличное и простое программное обеспечение Это был отличный инструмент для нас с хорошим соотношением цены и качества. ☺Его очень легко настроить, и он делает именно то, что вам нужно. Процесс синтаксического анализа — это отличная пошаговая модель, которая извлекает действительно все данные, которые вы хотите, из любого электронного письма. ☹На самом деле нам ничего не нравилось в программном обеспечении.

Мощное решение — устранение огромных затрат Мне это нравится, это позволяет мне передавать важные данные в несколько точек через Zap of Zapier, плавную интеграцию и просто очень рад, что у них отличная поддержка. Они отправили электронное письмо с вопросом, что я думаю, и я сказал им, как впечатлен. Не ожидал ответа, но я получил ответ, поблагодаривший меня за то, что я нашел время, чтобы дать им обратную связь. Это также был быстрый ответ, и это было оценено. Я знаю, что они на это, когда или если мне может понадобиться поддержка в будущем. ☺Он работает именно так, как мне нужно, без потери данных при передаче. В то же время это помогло снизить затраты на ввод данных вручную или изменение способа работы некоторых служб. На самом деле я смог найти этот инструмент и сэкономить от 500 до 1000 долларов в месяц на расходах на виртуального помощника, которые я хотел увеличить. Он обеспечивает безопасную передачу данных в наши системы и очень удобен в работе. Рад заплатить 29 долларов0,00 в месяц сверх указанного.

☹Ничего не могу найти на данный момент. Это SAAS, который делает именно то, что вам нужно, несколькими способами, и у меня не было случая, чтобы он сломался, поэтому мне просто нравится, что он работает.

☺Он работает именно так, как мне нужно, без потери данных при передаче. В то же время это помогло снизить затраты на ввод данных вручную или изменение способа работы некоторых служб. На самом деле я смог найти этот инструмент и сэкономить от 500 до 1000 долларов в месяц на расходах на виртуального помощника, которые я хотел увеличить. Он обеспечивает безопасную передачу данных в наши системы и очень удобен в работе. Рад заплатить 29 долларов0,00 в месяц сверх указанного.

☹Ничего не могу найти на данный момент. Это SAAS, который делает именно то, что вам нужно, несколькими способами, и у меня не было случая, чтобы он сломался, поэтому мне просто нравится, что он работает.

Просто… УДИВИТЕЛЬНО — Не знаю, с чего начать или закончить! Я должен скинуться, что обслуживание клиентов ВЫДАЮЩЕЕСЯ — я НИКОГДА не сталкивался с чем-то подобным раньше, никогда! Время отклика эпическое, но качество каждого ответа выше всего, с чем я когда-либо сталкивался — они не просто отвечают подробно и полезно, часто они даже решают проблему непосредственно для вас. ..!

☺Программа просто потрясающая, помимо экономии 2-3 часов ежедневного ручного труда, мы повысили уровень сервиса для наших клиентов!

☹ Честно говоря, мне нечего здесь постить — КАЖДЫЙ раз, когда мне приходила в голову очередная безумная идея, я обращался в службу поддержки, и они всегда решали проблему!

..!

☺Программа просто потрясающая, помимо экономии 2-3 часов ежедневного ручного труда, мы повысили уровень сервиса для наших клиентов!

☹ Честно говоря, мне нечего здесь постить — КАЖДЫЙ раз, когда мне приходила в голову очередная безумная идея, я обращался в службу поддержки, и они всегда решали проблему!

134119087

Электронные сообщения обработаны

3605741055

Проанализированы точки данных

269799045

Вебхуки отправлены

Зарегистрируйте бесплатную учетную запись. Нет кредитной карты, ноль обязательств.

Кредитная карта не требуется

HTML Parser — извлечение информации с РЕАЛЬНОГО веб-сайта

Hello Coder,

В этой статье я представлю краткий список фрагментов кода, полезных для извлечения информации с работающего веб-сайта. Код написан на Python поверх библиотеки HTML Parsing BeautifulSoup.

Спасибо! Контент предоставлен AppSeed — генератором приложений .

Согласно Википедии, Разбор или синтаксический анализ — это процесс анализа строки символов либо на естественном языке, либо на компьютерных языках, в соответствии с правилами формальной грамматики. Смысл синтаксического анализа HTML , примененного здесь, в основном заключается в сканировании HTML-кода и извлечении, обработке соответствующей информации, такой как заголовок заголовка, ресурсы страницы, основные разделы.

Настройка среды

Для выполнения примера кода нам нужна среда Python и несколько полезных зависимостей:

$ pip install ipython # консоль, где мы выполняем код $ pip install request # библиотека для загрузки всей HTML-страницы $ pip install BeautifulSoup # настоящее волшебство здесьВойти в полноэкранный режимВыйти из полноэкранного режима

Если все пойдет хорошо, мы можем начать кодирование. Введите ipython , чтобы запустить интерактивную консоль Python:

# импорт библиотек запросы на импорт из bs4 импортировать BeautifulSoup как bs # определить URL для сканирования и анализа # не стесняйтесь менять этот URL в своем приложении app_url = 'https://flask-bulma-css.Войти в полноэкранный режимВыйти из полноэкранного режимаappseed.us/' # сканирование страницы. Это может занять несколько секунд страница = запросы.получить (приложение_url) # чтобы проверить статус сканирования, просто введите: страница

# все хорошо # для печати содержимого страницы введите: страница.содержание

На данный момент у нас есть содержимое страницы, давайте внедрим HTML в BeautifulSoup и получим некоторую информацию с удаленной страницы.

суп = bs(page.content, 'html.parser') # напечатать весь заголовок страницы суп.голова # выводим только заголовок суп.голова.названиеВойти в полноэкранный режимВыйти из полноэкранного режимаFlask Bulma CSS — приложение BulmaPlay с открытым исходным кодом

Чтобы проверить точность результата, мы можем проверить источник страницы.

Куда пойти отсюда?

Используя библиотеку BS, мы можем легко манипулировать DOM. Например, давайте напечатаем файлы Javascript, используемые файлом HTML, используя всего несколько строк кода:

# код для скрипта в soap.Войти в полноэкранный режимВыйти из полноэкранного режимаbody.find_all('script', recursive=False): print(' Js = ' + скрипт ['src']) # выход Js = /static/assets/js/jquery.min.js Js = /static/assets/js/jquery.lazy.min.js Js = /static/assets/js/slick.min.js Js = /static/assets/js/scrollreveal.min.js Js = /static/assets/js/jquery.waypoints.min.js Js = /static/assets/js/jquery.waypoints-sticky.min.js Js = /static/assets/js/jquery.counterup.min.js Js = https://cdnjs.cloudflare.com/ajax/libs/modernizr/2.8.3/modernizr.min.js Js = /static/assets/js/app.js

Распечатаем содержимое файла app.js :

# app_url инициализируется несколькими строками выше: # app_url = 'https://flask-bulma-css.appseed.us/' app_js = request.get(app_url + '/static/assets/js/app.js') # чтобы проверить статус, просто введите имя объекта app_jsВойти в полноэкранный режимВыйти из полноэкранного режима# все хорошо, давайте распечатаем содержимое удаленного файла app_js.content # здесь будет указан некоторый неминифицированный код js.

Напечатаем элементы первого уровня из тела страницы:

# код

для элемента в супе.тело.дети:

if elem.name: # нам нужна эта проверка, некоторые элементы не имеют имени

print( ' -> элемент ' + элемент.имя )

# выход

-> элемент div

-> раздел элементов

-> раздел элементов

-> раздел элементов

-> раздел элементов

-> раздел элементов

-> раздел элементов

-> нижний колонтитул элемента

-> элемент div

-> элемент div

-> элемент div

-> скрипт элемента

-> скрипт элемента

-> скрипт элемента

-> скрипт элемента

-> скрипт элемента

-> скрипт элемента

-> скрипт элемента

-> скрипт элемента

-> скрипт элемента

Войти в полноэкранный режимВыйти из полноэкранного режима Напечатать нижний колонтитул:

суп.нижний колонтитул # чтобы получить красивый отпечаток элементов, мы можем использовать хелпер BS prettify() # используя prettify(), вывод имеет хороший отступ печать (суп.нижний колонтитул.prettify()) # выход <нижний колонтитул> <дел> <дел> <дел> <дел>

appseed.us/'

# сканирование страницы. Это может занять несколько секунд

страница = запросы.получить (приложение_url)

# чтобы проверить статус сканирования, просто введите:

страница

appseed.us/'

# сканирование страницы. Это может занять несколько секунд

страница = запросы.получить (приложение_url)

# чтобы проверить статус сканирования, просто введите:

страница

body.find_all('script', recursive=False):

print(' Js = ' + скрипт ['src'])

# выход

Js = /static/assets/js/jquery.min.js

Js = /static/assets/js/jquery.lazy.min.js

Js = /static/assets/js/slick.min.js

Js = /static/assets/js/scrollreveal.min.js

Js = /static/assets/js/jquery.waypoints.min.js

Js = /static/assets/js/jquery.waypoints-sticky.min.js

Js = /static/assets/js/jquery.counterup.min.js

Js = https://cdnjs.cloudflare.com/ajax/libs/modernizr/2.8.3/modernizr.min.js

Js = /static/assets/js/app.js

body.find_all('script', recursive=False):

print(' Js = ' + скрипт ['src'])

# выход

Js = /static/assets/js/jquery.min.js

Js = /static/assets/js/jquery.lazy.min.js

Js = /static/assets/js/slick.min.js

Js = /static/assets/js/scrollreveal.min.js

Js = /static/assets/js/jquery.waypoints.min.js

Js = /static/assets/js/jquery.waypoints-sticky.min.js

Js = /static/assets/js/jquery.counterup.min.js

Js = https://cdnjs.cloudflare.com/ajax/libs/modernizr/2.8.3/modernizr.min.js

Js = /static/assets/js/app.js

нижний колонтитул.prettify())

# выход

<нижний колонтитул>

<дел>

<дел>

<дел>

<дел>

нижний колонтитул.prettify())

# выход

<нижний колонтитул>

<дел>

<дел>

<дел>

<дел>