Как закрыть страницу (сайт) от индексации с помощью meta-тега robots (noindex, follow) по GET-параметру в URL или по вхождению строки

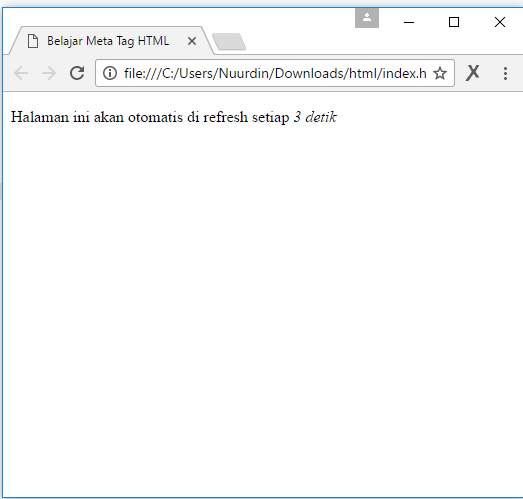

В ряде случаев полезным, оказывается, закрыть ряд страниц сайта от индексации с помощью meta-тега robots, при этом оставив возможность роботу переходить по ссылкам со страницы. Делается это с помощью проверки наличия строки или запрашиваемого параметра в URL-адресе страницы.

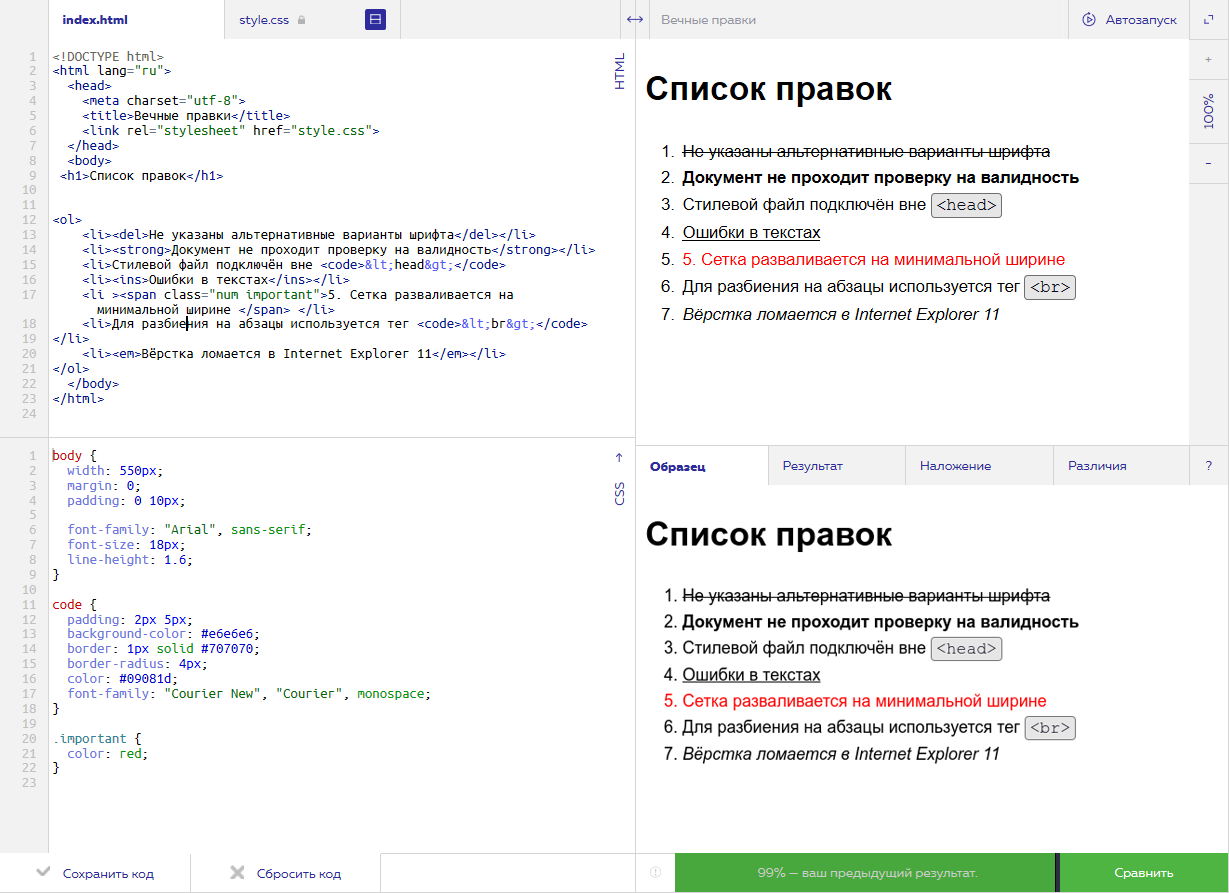

Проверка запроса GET-параметра

Используйте строчки указанные ниже для проверки запроса параметра SHOWALL_1 при формировании страницы и установке meta-тега noindex, follow. Вы можете заменить параметр SHOWALL_1 на любой другой удобный для вас, скажем, PAGEN_1, page и так далее.

<? if ($_REQUEST[‘SHOWALL_1’]) { ?>

<meta name=»robots» content=»noindex, follow»/>

<?} else {?>

<meta name=»robots» content=»index, follow»/>

<?}?>

Таким образом, мы установим значение meta-тега (noindex, follow) для страниц с параметром и значение (index, follow) для страниц без параметра.

Проверка вхождения строки в URL

Если требуется закрыть таким образом от индексации папку или какой-то тип страниц по строчке в URL-адресе, то производится проверка наличия этой строки в URL с помощью представленных ниже строк.

<? if (strstr($_SERVER[«REQUEST_URI»],»detail»)!=false) { ?>

<meta name=»robots» content=»noindex, follow»/ >

<meta name=»robots» content=»index, follow»/ >

<?}?>

Таким образом, мы установим значение meta-тега (noindex, follow) для страниц с наличием строки detail и значение (index, follow) для страниц без этой строки. Набор символов detail вы можете заменять по своему желанию на другие наборы, скажем, archive, old, print и так далее.

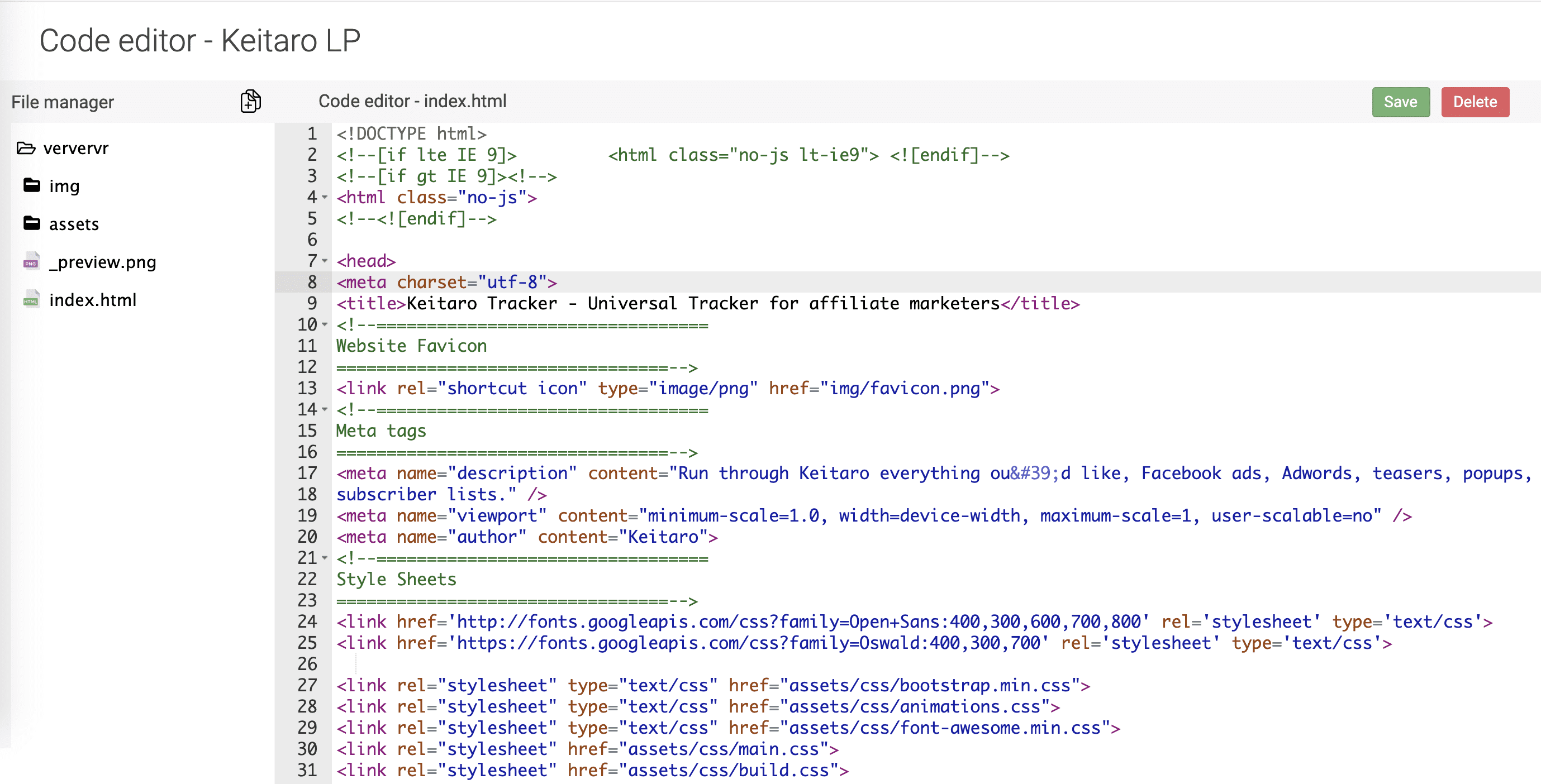

Или GET-параметр или строка

Полезным оказывается одном правилом закрыть от индексации и страницы с GET-параметром и страницы с наличием строчки в URL, делается это с применением оператора ИЛИ. Пример с запросом параметра PAGEN_2 ИЛИ вхождением строки print.

<? if ((strstr($_SERVER[«REQUEST_URI»],»print»)!=false)||$_REQUEST[‘PAGEN_2’]) { ?>

<meta name=»robots» content=»noindex, follow»/ >

<meta name=»robots» content=»index, follow»/ >

<?}?>

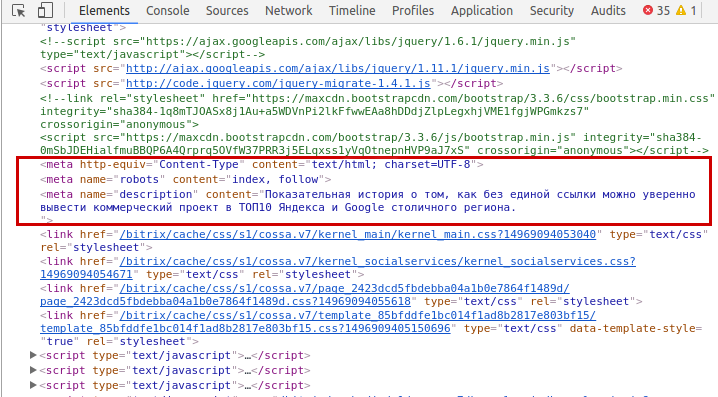

Внимание! Важно проверять, чтобы в других местах шаблона (1С-Битрикс или другой CMS) не было второго подключения meta-тега с противоречившими значениями. Иначе можно не добиться желаемого эффекта. При наличии двух и большего числа различных тегов, робот Яндекса выбирает самый разрешающий/положительный из них (индексировать и следовать по ссылкам), если такой вариант указан в meta-теге. Имеется возможность отдельно указывать правила именно для робота Яндекса или для робота Google, тогда используйте строчки.

= Яндекс =

<? if ($_REQUEST[‘SHOWALL_2’]) { ?>

<meta name=»yandex» content=»noindex, follow»/>

<?} else {?>

<meta name=»yandex» content=»index, follow»/>

<?}?>

= Google =

<? if ($_REQUEST[‘SHOWALL_2’]) { ?>

<?} else {?>

<meta name=»googlebot» content=»index, follow»/>

<?}?>

Добавить в избранное

Оптимизация веб-контента для поискового робота | Документация по корпоративному поиску [8.

7]

7] В этой документации объясняется, как оптимизировать веб-контент для искателя.

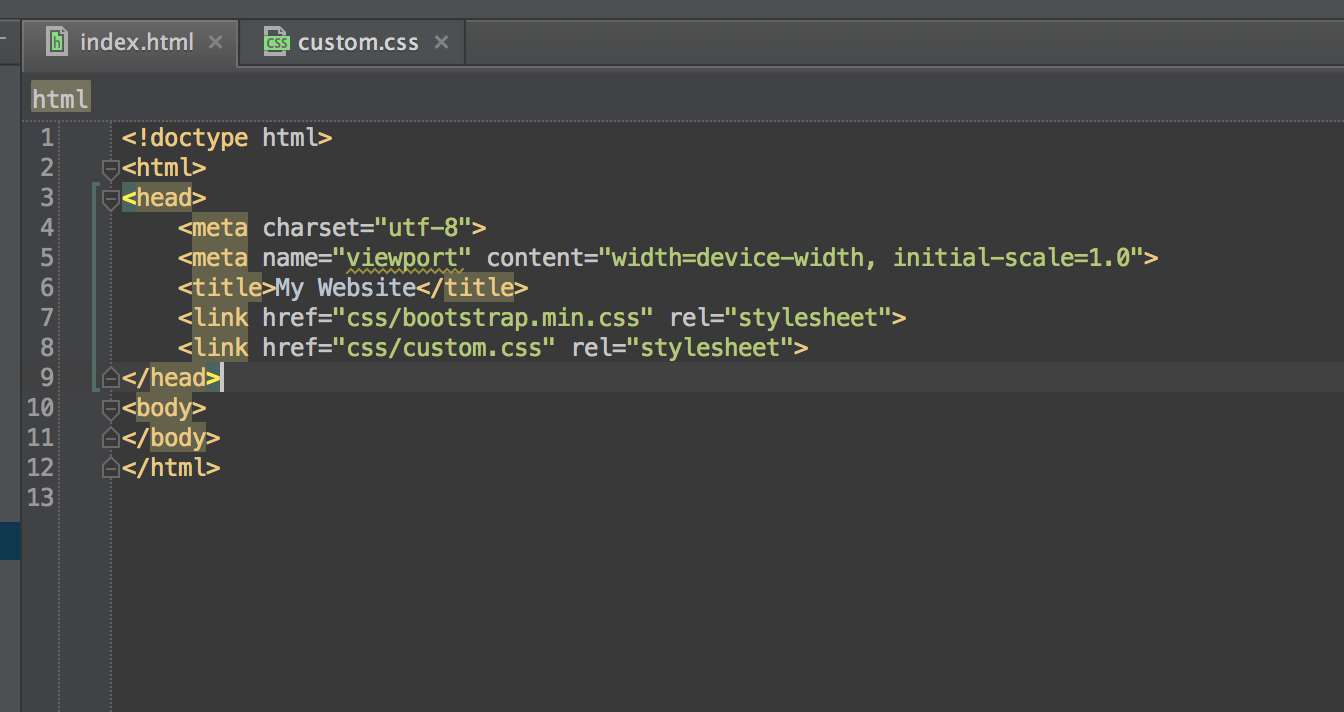

Для этого у вас должен быть доступ и возможность изменять файлы HTML, robots.txt или исходные файлы карты сайта.

Если вы не можете получить доступ к этим файлам, управляйте сканированием в Kibana.

Вы можете оптимизировать исходные файлы веб-содержимого для поискового робота.

Эти методы аналогичны методам поисковой оптимизации (SEO), используемым для других веб-сканеров и роботов. Например, вы можете встроить инструкции для поискового робота в свой HTML-контент. Вы также можете запретить сканеру переходить по ссылкам или индексировать любой контент для определенных веб-страниц. Используйте эти инструменты для управления веб-страницей обнаружение и извлечение содержимого .

Обнаружение относится к индексируемым веб-страницам и файлам из просканированных доменов:

- Канонические теги URL-ссылок

- Метатеги роботов

- Nofollow-ссылки

-

robots.файла txt

txt - карты сайта

Извлечение касается того, как содержимое индексируется и сопоставляется с полями в документах Elasticsearch:

- Атрибуты данных для включения и исключения

- Метатеги и атрибуты данных для извлечения настраиваемых полей

HTML-элементы и атрибутыedit

В следующих разделах описаны инструкции сканера, которые вы можете встроить в HTML-элементы и атрибуты.

Теги канонических URL-ссылокedit

Тег канонических URL-ссылок — это HTML-элемент, который можно встраивать в страницы, дублирующие содержимое других страниц. Подробную информацию об управлении повторяющимся содержимым с помощью пользовательского интерфейса Kibana см. в разделе Обработка повторяющихся документов. Тег ссылки canonical URL указывает канонический URL для этого контента.

Канонический URL-адрес хранится в документе в поле url , а поле Additional_urls содержит все другие URL-адреса, где сканер обнаружил то же самое содержимое. Если ваш сайт содержит страницы, которые дублируют содержимое других страниц, используйте теги ссылок канонических URL-адресов, чтобы явно указать, какой URL-адрес хранится в поле

Если ваш сайт содержит страницы, которые дублируют содержимое других страниц, используйте теги ссылок канонических URL-адресов, чтобы явно указать, какой URL-адрес хранится в поле url проиндексированного документа.

Шаблон:

Пример:

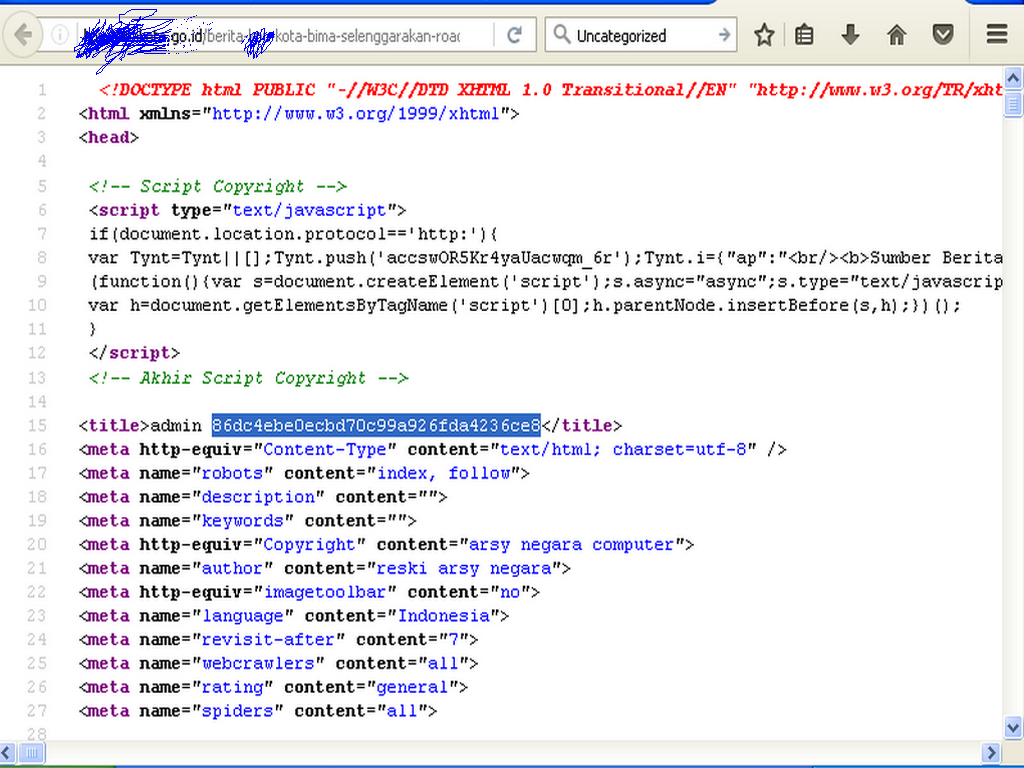

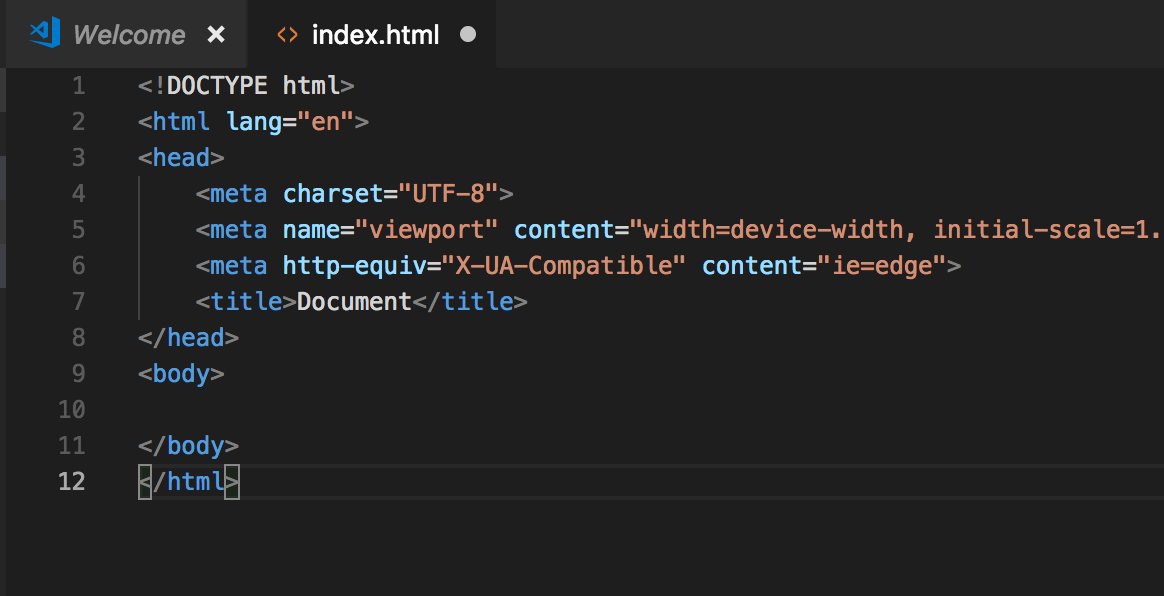

Метатеги роботов

Метатеги роботов — это HTML-элементы, в которые вы можете встраивать страницы, чтобы сканер не мог переходить по ссылкам или индексировать контент. Эти теги связаны с правилами сканирования. Дополнительные сведения о правилах сканирования см. в разделе Правила сканирования.Шаблон:

Поддерживаемые директивы:

-

без индекса - Поисковый робот не будет индексировать страницу.

Если вы хотите проиндексировать часть, но не все содержимое страницы, см.

раздел Атрибуты данных для включения и исключения.

раздел Атрибуты данных для включения и исключения. -

nofollow Поисковый робот не будет переходить по ссылкам со страницы. Поисковый робот регистрирует событие

url_discover_deniedдля каждой ссылки.Директива не запрещает поисковому роботу индексировать страницу.

В настоящее время удаление содержимого (очистка или обход процесса) не соблюдает директивы noindex и nofollow .

Сканирование не будет удалять ранее проиндексированные страницы, которые теперь имеют директивы noindex и nofollow из механизма в конце каждого сканирования.

Чтобы вручную удалить устаревшее содержимое, создайте соответствующие правила обхода, чтобы исключить страницы и запустить обход процесса.

Примеры:

Атрибуты данных для включения и исключения

Внедрите атрибуты данных HTML в свои веб-страницы, чтобы указать веб-сканеру включать или исключать определенные разделы из извлеченного содержимого.

Эти атрибуты работают следующим образом:

- Для всех страниц, содержащих HTML-теги с параметром data-elastic-include

.0004, сканер будет индексировать только содержимое этих тегов. - Для всех страниц, содержащих теги HTML с атрибутом

data-elastic-exclude, сканер пропустит эти теги при извлечении контента. Вы также можете вкладывать тегиdata-elastic-includeиdata-elastic-exclude. - Поисковый робот по-прежнему будет сканировать любые ссылки, которые появляются внутри исключенных разделов, если это разрешено настроенными правилами сканирования.

Примеры

Пример простого правила исключения контента:

Это содержимое вашей страницы, которое будет проиндексировано поисковым роботом.

В этом более сложном примере с вложенными правилами исключения и включения поисковый робот будет извлекать со страницы только "test1 test3 test5 test7".

<тело> тест1тест2тест7тест3 тест4 test5

тест6

Метатеги и атрибуты данных для извлечения настраиваемых полей

Поисковый робот извлекает предопределенный набор полей (url, основной текст и т. д.) с каждой посещаемой страницы. Просмотрите свои документы, чтобы увидеть полную схему. С помощью метатегов и атрибутов данных вы можете извлекать настраиваемые поля со своих HTML-страниц.

Шаблон:

<тело>

{FIELD_VALUE}

Просканированный документ для этого примера

<тело>Принтер

будет включать 2 дополнительных поля.

{

"product_price": "99,99",

"product_name": "Принтер"

} Можно указать несколько тегов class="elastic" и data-elastic-name .

Шаблон:

<тело>{FIELD_VALUE_1}{FIELD_VALUE_2}

{FIELD_NAME} должно соответствовать правилам имени поля

Возможно, не удастся настроить исходный код HTML для веб-страниц, которые вы хотите сканировать. Обратитесь к Настраиваемые поля с использованием прокси-сервера для получения информации о том, как извлекать настраиваемые поля с помощью прокси-сервера.

Ссылки Nofollowedit

Ссылки Nofollow — это HTML-ссылки, которые предписывают сканеру не переходить по URL-адресу.

Поисковый робот не будет переходить по ссылкам, содержащим rel="nofollow" (т. е. не будет добавлять ссылки в очередь сканирования).

Поисковый робот регистрирует событие

е. не будет добавлять ссылки в очередь сканирования).

Поисковый робот регистрирует событие url_discover_denied для каждой ссылки.

Ссылка не мешает поисковому роботу индексировать страницу, на которой она появляется.

Шаблон:

{LINK_TEXT}

Пример:

Изменить эту категорию

robots.txt filesedit Невозможно настроить поисковый робот так, чтобы он игнорировал или обходил доменный файл robots.txt .

Помните об этом, если вы сканируете домен, который не контролируете.

В домене может быть файл robots.txt .

Это обычный текстовый файл, содержащий инструкции для поисковых роботов.

Инструкции в файле, также называемые директивами, сообщают, какие пути в этом домене запрещены (и разрешены) для обхода.

Вы также можете использовать robots.txt , чтобы указать карты сайта для домена. См. файлы Sitemap.

См. файлы Sitemap.

Большинство поисковых роботов автоматически извлекают и анализируют файл robots.txt для каждого сканируемого домена.

Если вы уже опубликовали файл robots.txt для других поисковых роботов, имейте в виду, что поисковый робот извлечет этот файл и будет соблюдать содержащиеся в нем директивы.

Вы можете добавить, удалить или обновить файл robots.txt для каждого из ваших доменов.

Пример: добавить файл robots.txt в домен

Чтобы добавить файл robots.txt в домен https://shop.example.com :

- Определите, какие пути в домене вы хотите исключить.

Создайте файл robots.txt с соответствующими директивами стандарта исключения роботов. Например:

Агент пользователя: * Запретить: /корзина Запретить: /логин Запретить: /аккаунт

- Опубликуйте файл с именем

robots.txtв корне домена:https://shop.. example.com/robots.txt

example.com/robots.txt

В следующий раз, когда веб-сканер посетит домен, он извлечет и проанализирует файл robots.txt .

Поисковый робот будет сканировать только те пути, которые разрешены правилами сканирования для домена и директивами в файле robots.txt для домена.

Подробную информацию о правилах обхода см. в правилах обхода.

Нестандартные расширения

Поисковый робот Elastic не поддерживает все нестандартные расширения стандарта исключения роботов.

Sitemapsedit

Карта сайта — это XML-файл, связанный с доменом, который информирует поисковые роботы о страницах в этом домене. Элементы XML в карте сайта определяют конкретные URL-адреса, доступные для сканирования. Каждый домен может иметь одну или несколько карт сайта.

Если вы уже опубликовали карты сайта для других поисковых роботов, поисковый робот может использовать те же карты сайта.

Чтобы сделать ваши карты сайта доступными для обнаружения, укажите их в течение robots. файла. txt

txt

Файлы Sitemap связаны с точками входа. Смотрите точки входа. Вы можете отправлять URL-адреса поисковому роботу, используя карты сайта, точки входа или их комбинацию.

Вы можете предпочесть использование карт сайта точкам входа по любой из следующих причин:

- Вы уже публиковали карты сайта для других поисковых роботов.

- У вас нет доступа к пользовательскому интерфейсу веб-краулера в Kibana.

- Вы предпочитаете интерфейс файла карты сайта пользовательскому интерфейсу Kibana.

Используйте карты сайта, чтобы информировать поисковый робот о страницах, которые вы считаете важными, или страницах, которые изолированы и не связаны с другими страницами.

Однако имейте в виду, что поисковый робот будет посещать только те страницы из карты сайта, которые разрешены правилами сканирования домена и директивами файла robots.txt .

Обнаружение карты сайта и управление

Чтобы добавить карту сайта в домен, вы можете указать ее в файле robots..

В начале каждого обхода веб-сканер извлекает и обрабатывает 9 доменов каждого домена.0003 robots.txt и каждая карта сайта, указанная в этих файлах  txt

txt robots.txt .

Формат карты сайта и технические характеристики

Стандарт карт сайта определяет формат и техническую спецификацию карт сайта. Обратитесь к стандарту для обязательных и необязательных элементов, экранирования символов и других технических соображений и примеров.

Поисковый робот не обрабатывает необязательные метаданные, определенные стандартом. Поисковый робот извлекает список URL-адресов из каждой карты сайта и игнорирует всю остальную информацию.

Нет гарантии, что страницы (и соответствующие связанные с ними страницы) будут проиндексированы в том порядке, в котором они указаны в карте сайта, поскольку сканирование выполняется асинхронно .

Убедитесь, что каждый URL-адрес в вашей карте сайта точно соответствует домену — здесь он определяется как схема + хост + порт — для вашего сайта. Различные поддомены (например,

Различные поддомены (например, www.example.com и blog.example.com ) и разные схемы (например, http://example.com и https://example.com ), требуются отдельные файлы Sitemap.

Поисковый робот также поддерживает файлы индекса карты сайта. Подробные сведения и примеры файлов индекса карты сайта см. в разделе Использование файлов индекса карты сайта в рамках стандарта карты сайта.

Manage sitemapsedit

Пример: Добавить карту сайта через robots.txt

Чтобы добавить карту сайта в домен https://shop.example.com :

Создайте файл карты сайта с соответствующими элементами стандарта карты сайта. Например:

sitemaps.org/schemas/sitemap/0.9"> <ссылка> https://shop.example.com/products/1/ <ссылка>https://shop.example.com/products/2/ <ссылка>https://shop.example.com/products/3/

https://shop.example.com/sitemap.xml . Создайте или измените файл robots.txt для домена, расположенного по адресу https://shop.example.com/robots.txt .

В любом месте файла добавьте директиву Sitemap , указывающую расположение карты сайта.

Например:

Карта сайта: https://shop.example.com/sitemap.xml

файл robots.txt . В следующий раз, когда веб-сканер посетит домен, он извлечет и проанализирует файл robots.txt и карту сайта.

Кроме того, вы также можете управлять картами сайта для домена через пользовательский интерфейс Kibana. Отсюда вы можете просматривать, добавлять, редактировать и удалять карты сайта.

Используйте пользовательский интерфейс для добавления пользовательских определений карты сайта, которые не находятся в домене и используются только вашим поисковым роботом.

См. Точки входа и карты сайта.

Отсюда вы можете просматривать, добавлять, редактировать и удалять карты сайта.

Используйте пользовательский интерфейс для добавления пользовательских определений карты сайта, которые не находятся в домене и используются только вашим поисковым роботом.

См. Точки входа и карты сайта.

поисковых роботов. Почему одновременное использование файла robots.txt и метатега robots вызывает проблемы?

спросил

Изменено 1 год, 7 месяцев назад

Просмотрено 686 раз

Кажется общеизвестным, что использование X-Robots-Tag / мета-роботов с robots.txt для блокировки URL-адреса от индексации «может вызвать проблемы», например:

Использование мета-роботов

X-Robots-Tagив URL является излишним потому что они эквивалентны и используют какrobots., так и любой из другие для URL-адреса могут вызвать проблемы, потому чтоtxt

robots.txtблокирует сканирование, а сканирование требуется для того, чтобы бот даже увидел любой из другие, поскольку они являются директивами уровня документа.Источник: https://webmasters.stackexchange.com/a/130710

Однако я не понимаю, в чем «проблема». Предположим, у меня есть URL /foo.html , для которого сканирование заблокировано с помощью robots.txt . Тогда бот не будет сканировать страницу, но она все равно может быть проиндексирована, если foo.html перейдет с другого сайта. Однако, если мы добавим meta robots в foo.html , индексация будет заблокирована, когда бот зайдет на страницу с другого сайта, независимо от того, что окажется в robots.txt .

Таким образом, хотя использование обоих методов может быть излишним, я не уверен, почему это может привести к foo. для индексации. html

html

- поисковые роботы

- robots.txt

- метатеги

- noindex

- http-заголовки

1

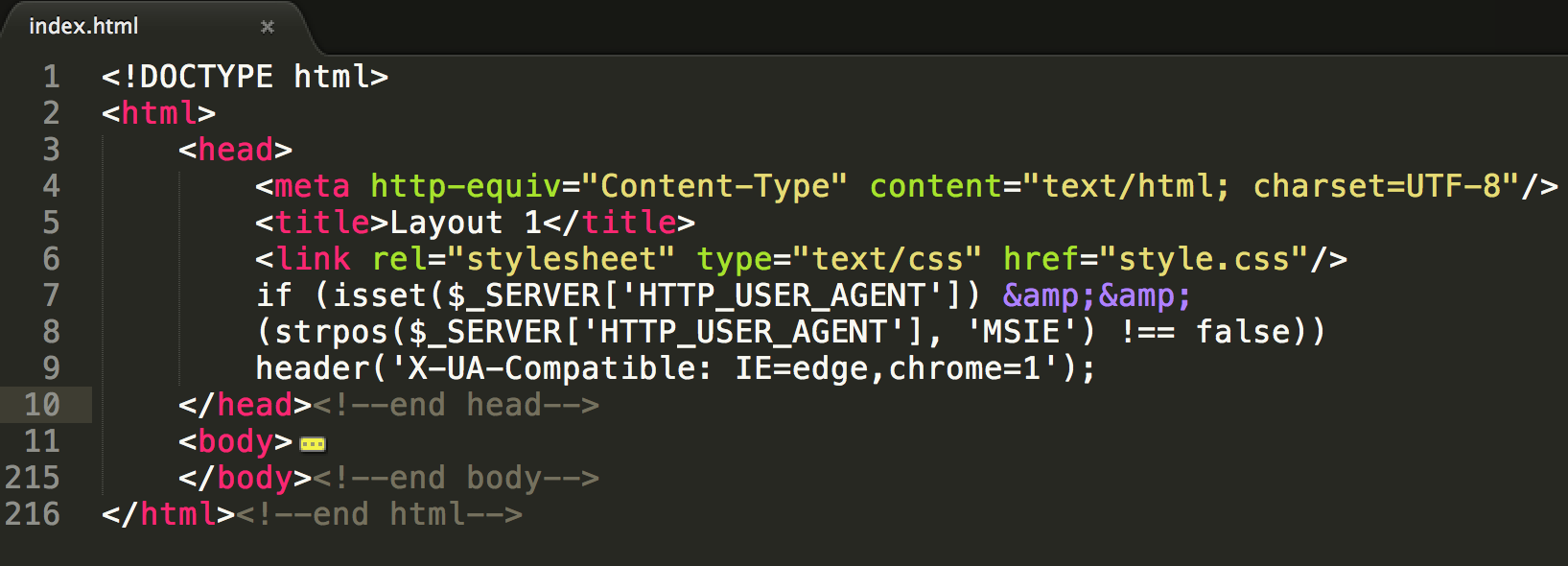

Стандарт robots.txt определяет, может ли бот просматривать foo.html при любых обстоятельствах. Тот факт, что бот видит ссылку на него с другого сайта, не дает боту права подглядывать за ним!

Предположим, у меня есть URL-адрес

/foo.html, сканирование которого заблокировано с помощьюrobots.txt. Тогда бот не будет сканировать страницу, но она все равно может быть проиндексирована, еслиfoo.htmlперейдет с другого сайта.

Правильно.

Однако, если мы добавим

meta robotsвfoo.html, индексация будет заблокирована, когда бот зайдет на страницу с другого сайта, независимо от того, что окажется вrobots..txt

Здесь есть тонкое недоразумение — бот никогда не заходит на страницу. Происходит следующее:

Бот видит ссылку на

foo.htmlна внешнем сайте.Бот готовится к сканированию

foo.html, но сначала извлекает файлrobots.txtиз домена, на котором размещенfoo.html, чтобы убедиться, что ему разрешено сканироватьfoo.html.Бот замечает, что сканирование

foo.htmlзапрещено, поэтому вообще не запрашиваетfoo.html. Он не может увидеть содержимоеfoo.html, включая метатегrobots noindex.Невозможно увидеть, имеет ли страница метатег

noindexили нет, поисковый робот самостоятельно принимает решение о том, следует ли индексировать страницу. Он может решить проиндексировать страницу, что ему разрешено, потому что он не виделnoindexдиректива запрещающая индексацию.

txt

txt  раздел Атрибуты данных для включения и исключения.

раздел Атрибуты данных для включения и исключения.

example.com/robots.txt

example.com/robots.txt  txt

txt  txt

txt