Настройка robots.txt | 2DOMAINS.RU ✔️

Помощь 0 Регистрация Вход

- Домены

- Хостинг

- Выбор и заказ хостинга

Продвинутым пользователям

Продвинутым пользователям- Настройка переадресации (редиректа)

- Почта

- Проблемы в работе сайта

- Часто задаваемые вопросы

- Сайты

- Личный кабинет

- VPS и серверы

- SSL-сертификаты

- Общие вопросы

- Как настроить robots.

txt

txt - Указать временной интервал посещения сайта поисковыми роботами

- Закрыть индексацию для конкретных папок или URL

- Закрыть весь сайт от индексации

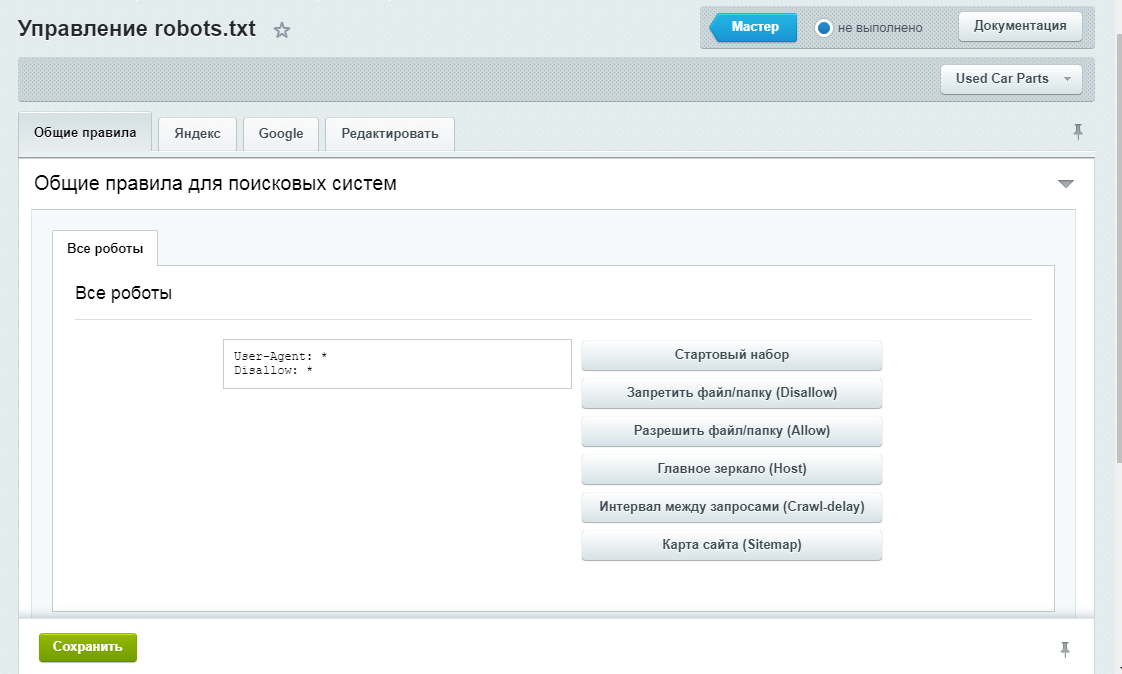

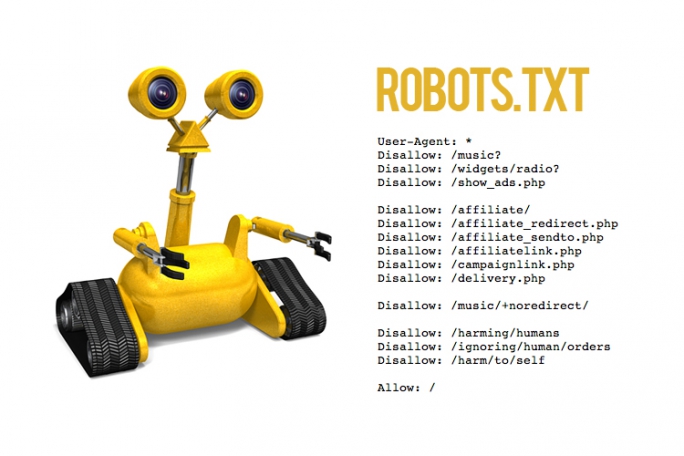

Чтобы выставить для сайта настройки индексирования поисковыми роботами, используйте файл «robots.txt». Обратите внимание: если файла «robots.txt» ещё нет в каталоге вашего сайта, просто создайте его.

Какие настройки можно указать с помощью robots.txt:

- интервал, с которым поисковые роботы будут посещать ваш сайт;

- запретить индексацию конкретными работами и скрыть от индексации конкретные страницы сайта;

- скрыть от индексации весь сайт.

Как настроить robots.txt

Обратите внимание! Для некоторых браузеров настройки индексации нужно выставлять индивидуально. Например:

- в Google: не все поисковые роботы браузера следуют правилам в «robots.txt». Так робот «Googlebot» следует запрещающим правилам («Disallow»), но не следует директиве «Crawl-delay».

Поэтому «Googlebot» нужно донастроить через инструменты для веб-мастеров Google. Подробнее в справке Google;

Поэтому «Googlebot» нужно донастроить через инструменты для веб-мастеров Google. Подробнее в справке Google; - в Yandex: для робота «Yandex Bot» максимально возможное ограничение через «robots.txt» составляет 2 секунды. Чтобы указать нужную частоту, с которой робот будет индексировать ваш сайт, используйте Яндекс.Вебмастер. Подробнее в справке Яндекс.

Указать временной интервал посещения сайта поисковыми роботами

Чтобы задать временной интервал обращения, авторизуйтесь в Яндекс.Вебмастер. Подробнее в справке Яндекса.

Обратите внимание:

— снижение скорости обхода сайта нужно, только если создается избыточная нагрузка на сервер;

— снижение скорости обхода сайта не влияет на позиции в поисковой выдаче браузера Яндекс.

Закрыть индексацию для конкретных папок или URL

За это отвечает директива User-agent — она определяет, для каких роботов будут применяться правила. С её помощью можно как задать отдельные правила для конкретных роботов, так и указать общие правила для всех роботов сразу.

# закрываем индексацию страницы vip.html для Googlebot:

User-agent: Googlebot

Disallow: /vip.html # закрываем индексацию папки private всеми роботами:

User-agent: *

Disallow: /private/# разрешаем доступ только к страницам, начинающимся с ‘/shared’ для Yandexbot

User-agent: Yandex

Disallow: /

Allow: /sharedЗакрыть весь сайт от индексации

Чтобы запретить индексацию сайта для всех поисковых роботов, добавьте в «robots.txt» следующие строки:

User-agent: *

Disallow: /

Популярные статьи

- Как указать (изменить) DNS-серверы для домена

- Я зарегистрировал домен, что дальше

- Как добавить запись типа A, AAAA, CNAME, MX, TXT, SRV для своего домена

- Что такое редирект: виды и возможности настройки

- Как создать почту со своим доменом

Домены

- Регистрация доменов

- Освободившиеся домены

- Промоакции

- Перенос домена

- Переадресация

- Магазин доменов

Сайты

- Конструктор сайтов

- Сайты на WordPress

Хостинг сайтов

- Хостинг

- Windows хостинг

VPS и серверы

- VPS хостинг

- Windows VPS

- Аренда серверов

Дополнения

- SSL-сертификаты //=url(‘/free-mail’)?>

Сервисы

- Бесплатный хостинг

- Whois

- Связь с администратором домена

- Определить свой IP-адрес

- Проверка порта на доступность

- Узнать местоположение по IP

- Проверить доступность сайта

Поддержка

- Справка

- Стоимость услуг

- Способы оплаты

- Связаться с нами

Компания

- О компании

- Документы

- Офис

- Дата-центр

- Новости

- Блог

- Акции и скидки

© 2DOMAINS — регистрация доменов

- Домены оптом

- Географические домены

- Кириллические домены

- Административные домены

- Национальные домены

- Новые домены первого уровня

- Где купить домен дешево

- Дешевый хостинг

- CloudVPS

- Хостинг для сайта-визитки

- Хостинг с PHP и MySQL

- Надежный хостинг

- Самые дешевые домены

- Хостинг WordPress

- Хостинг для 1С-Битрикс

- Хостинг для Drupal

- Хостинг для Joomla

- Хостинг для MODX

- Хостинг для OpenCart

- Антивирус для хостинга

- Бэкап сайта

- Защита от DDoS-атак

- Хостинг с ISPmanager

- SSL бесплатно

- AlphaSSL

- AlphaSSL WildCard

- ExtendedSSL

- GlobalSign-сертификаты

- Comodo / Sectigo — сертификаты

- GeoTrust-сертификаты

- Symantec-сертификаты

- Thawte-сертификаты

- TrustWave-сертификаты

- Wildcard-сертификаты

Политика обработки

персональных данных

Тех. поддержка: [email protected]

поддержка: [email protected]

Указанные на сайте цены могут не включать стоимость применимых комиссий.

При заказе услуги стоимость может быть уточнена исполнителем.

Настройка robots.txt для Joomla 3

Ниже приведена инструкция по настройке и созданию идеального файла robots.txt, открыв свой сайт на Joomla 3.x для поисковых роботов и пользователей из поисковой выдачи.

Одной из важных задач в SEO-оптимизации является открытие своего сайта для роботов поисковых систем.

Представьте: вы решили продать квартиру, но всеми силами не пускаете туда покупателей, а только позволяете посмотреть в замочную скважину. Что они там увидят? Как смогут оценить подходит им ваша квартира или нет?

Поэтому в первую очередь для того, чтобы поисковые роботы видели наш сайт так же, как видят его пользователи нужно, обеспечить им доступ к сканированию с помощью файла robots.txt.

Важно знать:

Файл robots.txt позволяет управлять сканированием страниц сайта поисковыми роботами.

К сожалению, по умолчанию, если мы ничего не делаем с файлом robots.txt для сайта на Joomla, то мы разрешаем поисковым роботам именно подглядывать в щелку и, как следствие, получаем посредственный результат.

Работы на несколько минут, но многие терпят годами и ругаются на плохие результаты продвижения сайта на Joomla.

Изначально robots.txt имеет такой вид:

User-agent: *

Disallow: /administrator/

Disallow: /bin/

Disallow: /cache/

Disallow: /cli/

Disallow: /components/

Disallow: /images/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /layouts/

Disallow: /libraries/

Disallow: /logs/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/

Стандартный robots.txt в Joomla

Мало кто знает, что в стандартном файле robots.txt в Joomla до версии 3.3 поисковые роботы не видят изображений, не понимают оформления сайта и могут не видеть части контента, а иногда и вовсе не смогут переходить по сквозным ссылкам из меню.

Начиная с Joomla 3.3 разработчики изменили файл robots.txt и это похвально, но

- при обновлении Джумла с предыдущей версии данный файл не перезаписывается автоматически

- всё равно требуется его небольшая доработка.

Правильный robots.txt, который рекомендуется использовать на CMS Joomla 2.5 и 3.x:

User-agent: Yandex

Disallow: /administrator/

Disallow: /cache/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /modules/

Disallow: /plugins/

Disallow: /tmp/

Disallow: /layouts/

Disallow: /cli/

Disallow: /bin/

Disallow: /logs/

Disallow: /components/

Disallow: /component/

Disallow: /component/tags*

Disallow: /*mailto/

Disallow: /*.pdf

Disallow: /*%

Disallow: /index.php

Host: vashsait.ru (или www.vashsait.ru)

Sitemap: http://путь к вашей карте XML форматаUser-agent: *

Allow: /.css?$

Allow: /.js?$

Allow: /.jpg?$

Allow: /.png?$

Disallow: /administrator/

Disallow: /cache/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /modules/

Disallow: /plugins/

Disallow: /tmp/

Disallow: /layouts/

Disallow: /cli/

Disallow: /bin/

Disallow: /logs/

Disallow: /components/

Disallow: /component/

Disallow: /*mailto/

Disallow: /*.pdf

Disallow: /*%

Disallow: /index.php

Sitemap: http://путь к вашей карте XML формата

Настройки робота

Настройками выполнения робота можно управлять из Orchestrator для каждого робота без необходимости каждый раз подключаться к машине робота.

Параметры из конфигурации робота или из помощника UiPath перезаписываются выбранным параметром всякий раз, когда роботы подключаются к Orchestrator или когда задания инициируются из Orchestrator.

Эти настройки остаются неизменными независимо от типа робота и папки.

| Поле | Описание |

|---|---|

| Уровень регистрации | Уровень, на котором робот должен регистрировать информацию. Доступны следующие параметры: Подробно Трассировка Информация — это значение по умолчанию. Предупреждение Ошибка Критическая Выкл. |

| Разрешить ведение журнала разработки | Позволяет выбрать, хотите ли вы получать журналы выполнения или отладки, отправленные из Studio во время процессов разработки. По умолчанию установлено значение Да . |

| Вход в консоль | Позволяет роботу подключаться к сеансу консоли машины, на которой он установлен. Кроме того, он указывает, можно ли подключить несколько роботов к Orchestrator с помощью нескольких пользователей ( Роботы высокой плотности ) или нет. По умолчанию установлено значение По умолчанию установлено значение Да . Чтобы включить роботов высокой плотности, установите значение Нет . Если установлено значение Нет , автоматический робот создает сеанс RDP при выполнении процесса. |

| Ширина разрешения | Ширина разрешения экрана устройства. По умолчанию для этого параметра установлено значение 0, что означает, что он автоматически извлекает и использует обнаруженную ширину разрешения. Вы можете использовать пользовательское значение, если оно поддерживается рабочей станцией. |

| Высота разрешения | Высота разрешения дисплея машины. По умолчанию для этого параметра установлено значение 0, что означает, что он автоматически извлекает и использует обнаруженную высоту разрешения. Вы можете использовать пользовательское значение, если оно поддерживается рабочей станцией. |

| Глубина разрешения | Глубина разрешения дисплея аппарата. По умолчанию для этого параметра установлено значение 0, что означает, что он автоматически извлекает и использует обнаруженную глубину разрешения. Вы можете использовать пользовательское значение, если оно поддерживается рабочей станцией. Обратите внимание, что Windows 10 не поддерживает Глубина разрешения значение, отличное от 32. |

| Сглаживание шрифта | Улучшает распознавание текста. Если установлено значение True , параметр Font Smoothing через соединения RDP включен. Это означает, что на целевой машине включено ClearType . По умолчанию установлено значение Нет . |

| Процессы автоматической загрузки | Если этот параметр включен, доступные процессы автоматически загружаются при запуске агента робота. По умолчанию установлено значение По умолчанию установлено значение № . |

📘

Примечание:

Если вы хотите изменить разрешение робота, рекомендуется использовать сеанс RDP и установить для параметра Login To Console значение

No. Учтите, что для того, чтобы настройки разрешения вступили в силу, необходимо создать новый сеанс, поэтому вам необходимо выйти из системы, а затем снова войти в нее.

- Перейдите к Tenant > Управление доступом в Orchestrator.

- Для учетной записи, соответствующей роботу, нажмите Изменить , а затем откройте вкладку Настройки робота .

- Включите переключатель, соответствующий каждому параметру, чтобы сделать его редактируемым. Внесите изменения и нажмите Обновить , чтобы сохранить.

Обновлено 6 месяцев назад

Настройки робота

Настройки выполнения робота UiPath, которыми можно управлять из Orchestrator для каждого робота без необходимости каждый раз подключаться к машине робота. Эти параметры остаются неизменными независимо от типа робота и папки.

Эти параметры остаются неизменными независимо от типа робота и папки.

📘

Управление Меню> Роботы Страница> ADD/EDIT ROBOT WINTH Окно > Настройки робота

| Поле | Описание |

|---|---|

| Уровень ведения журнала | 2|

| . процессы разработки. По умолчанию значение равно Да . | |

| Вход в консоль | Позволяет роботу подключаться к сеансу консоли машины, на которой он установлен. Кроме того, он указывает, можете ли вы подключить несколько роботов к Orchestrator с помощью нескольких пользователей ( Роботы высокой плотности ) или нет. По умолчанию значение равно Кроме того, он указывает, можете ли вы подключить несколько роботов к Orchestrator с помощью нескольких пользователей ( Роботы высокой плотности ) или нет. По умолчанию значение равно Нет . Чтобы включить роботов высокой плотности, установите значение Нет . Если установлено значение Нет , автоматический робот создает сеанс RDP при выполнении процесса. |

| Ширина разрешения | Ширина разрешения экрана устройства. По умолчанию для этого параметра установлено значение 0, что означает, что он автоматически извлекает и использует обнаруженную ширину разрешения. Вы можете использовать пользовательское значение, если оно поддерживается рабочей станцией. |

| Высота разрешения | Высота разрешения дисплея машины. Для этого параметра установлено значение 0 по умолчанию, что означает, что он автоматически извлекает и использует обнаруженную высоту разрешения. Вы можете использовать пользовательское значение, если оно поддерживается рабочей станцией. Вы можете использовать пользовательское значение, если оно поддерживается рабочей станцией. |

| Глубина разрешения | Глубина разрешения дисплея аппарата. По умолчанию для этого параметра установлено значение 0, что означает, что он автоматически извлекает и использует обнаруженную глубину разрешения. Вы можете использовать пользовательское значение, если оно поддерживается рабочей станцией. Обратите внимание, что Windows 10 не поддерживает значение Глубина разрешения , отличное от 32. |

| Сглаживание шрифта | Улучшает распознавание текста. Если установлено значение True , параметр Font Smoothing* по соединениям RDP включен. Это означает, что на целевой машине включено ClearType . По умолчанию установлено значение Нет . |

| Процессы автоматической загрузки | Если этот параметр включен, доступные процессы автоматически загружаются при запуске агента робота. |

Продвинутым пользователям

Продвинутым пользователям txt

txt Поэтому «Googlebot» нужно донастроить через инструменты для веб-мастеров Google. Подробнее в справке Google;

Поэтому «Googlebot» нужно донастроить через инструменты для веб-мастеров Google. Подробнее в справке Google; js?$

js?$