python — driver.page_source возвращает только мета-имя = «ROBOTS» content = «NOINDEX, NOFOLLOW» с использованием Selenium

спросил

Изменено 3 года, 3 месяца назад

Просмотрено 932 раза

Я хочу очистить один веб-сайт, чтобы получить содержимое страницы с помощью этого кода:

из веб-драйвера импорта селена

из selenium.webdriver.common.desired_capabilities импортировать DesiredCapabilities

driver = webdriver.Remote("http://адрес:4444/wd/hub", DesiredCapabilities.CHROME)

ссылка = 'веб-сайт_url'

driver.get (ссылка)

s = driver.page_source

печать((s.encode("utf-8")))

водитель.выйти()

вот что получите:

Я также пробовал много разных способов, Luminati, прокси newipnow, phantomjs, но не работает, есть предложения, что еще я могу попробовать решить?

- python

- selenium

- веб-скрейпинг

- метатеги

- мета

90 метатег about the search Engines разные 90 действия, которые им разрешено и не разрешено выполнять на определенной странице. Этот метатег можно разместить в любом месте внутри тегов

Этот метатег можно разместить в любом месте внутри тегов и . Примечание :: Как это 9Тег 0034 не действует на весь сайт, он может содержать разные значения на разных страницах одного и того же сайта.

Допустимые значения :

-

Индекс(значение по умолчанию) -

Без индекса -

Нет -

Подписаться -

Нет подписки -

Без архива -

Nosnippet

Эти значения также можно комбинировать для формирования желаемого действительного метатега robots.

Пример:

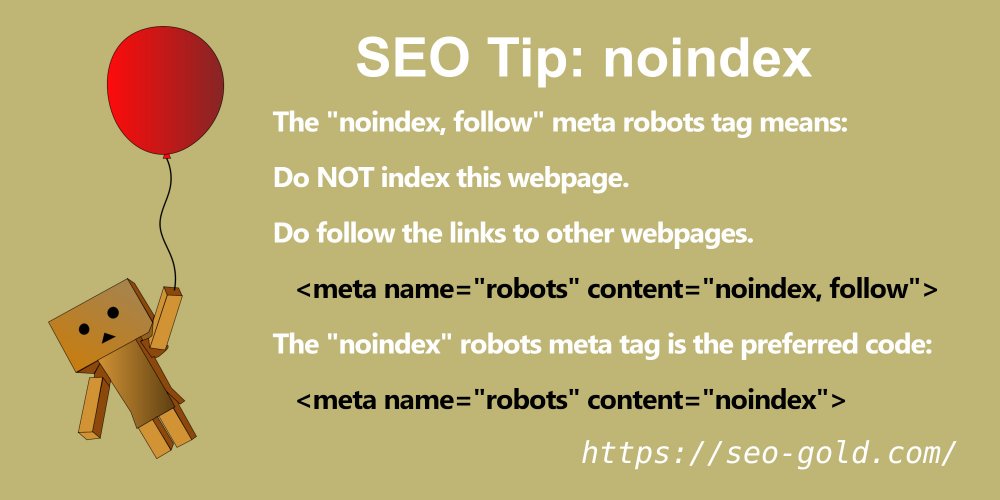

Значение NOINDEX указывает поисковым системам NOT индексировать страницу, поэтому страница не должна отображаться в результатах поиска. Значение

Значение NOFOLLOW передает поисковым системам НЕ , чтобы отслеживать или открывать страницы, которые ССЫЛКАЮТСЯ НА на этой странице.

Веб-разработчики добавляют метатег роботов NOINDEX , NOFOLLOW на веб-сайты разработки, поэтому поисковые системы случайно не начинают отправлять трафик на веб-сайт, который все еще находится в стадии разработки.

Почему ты видишь?

Причина может быть одной из следующих:

- Вы пытаетесь выполнить автоматические тесты в Среда разработки .

- Команда разработчиков случайно добавила этот тег на действующий веб-сайт.

- Команда разработчиков забыла удалить его с действующих веб-сайтов после запуска.

Ссылка

Что означает метатег «роботы»

Outro

Использование метатега robots

0

Зарегистрируйтесь или войдите в систему

Зарегистрируйтесь с помощью Google

Зарегистрироваться через Facebook

Зарегистрируйтесь, используя электронную почту и пароль

Опубликовать как гость

Электронная почтаОбязательно, но не отображается

Опубликовать как гость

Электронная почта

Требуется, но не отображается

seo — Google индексирует страницы с метатегом noindex

спросил

Изменено 5 лет, 3 месяца назад

Просмотрено 4к раз

Я получил сообщение в Инструментах Google для веб-мастеров о том, что "бот Googlebot обнаружил чрезвычайно большое количество URL-адресов на вашем сайте" с длинным списком примеров URL-адресов.

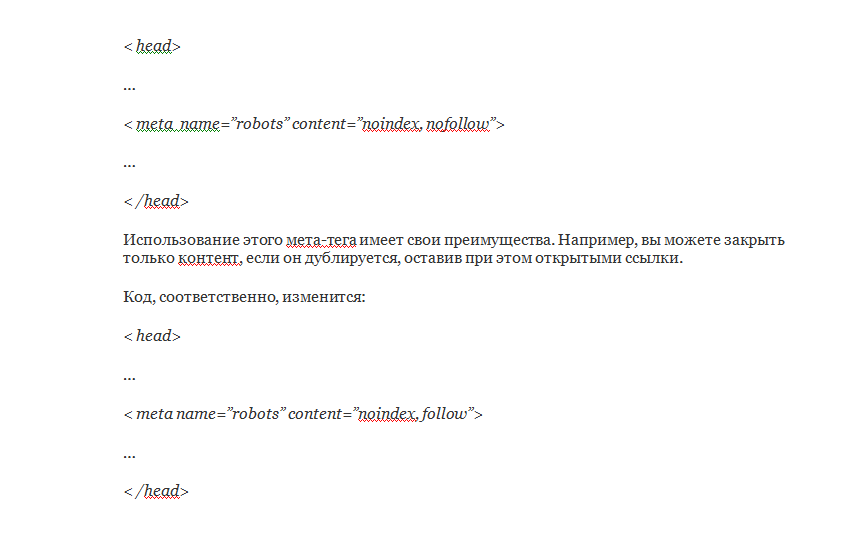

Для некоторых из перечисленных страниц ничто не мешало их индексации. Однако для некоторых URL-адресов у меня есть метатега «noindex, nofollow» следующим образом:

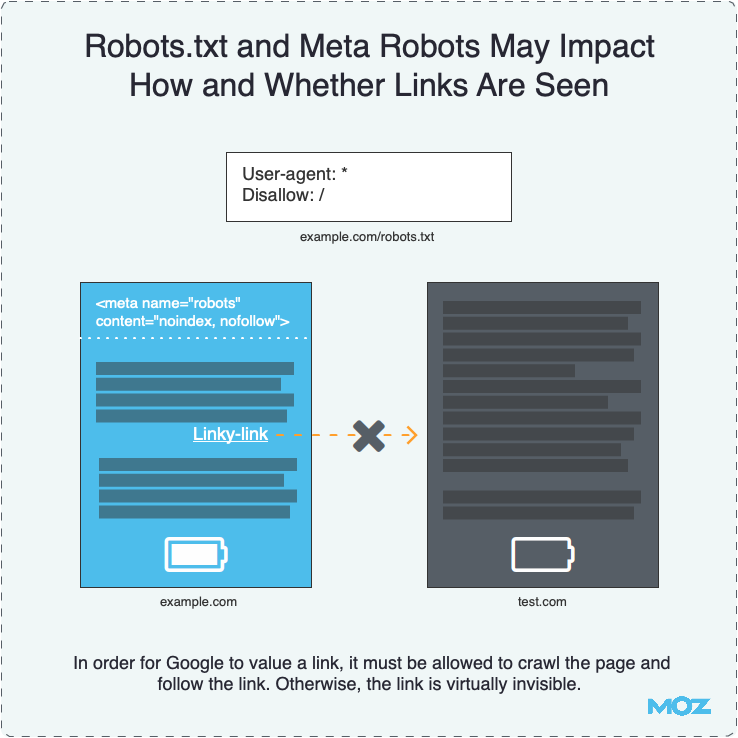

Я читал, что Google иногда индексирует страницы, которые вы заблокировали в robots.txt, если находит другую ссылку, указывающую на страницу, но якобы они соблюдают метатеги?

- seo

- google-search-console

- search-engines

- robots.txt

- noindex

не сканируются, на самом деле эти страницы все еще могут быть проиндексированы, но скорее скрыты от общедоступных результатов поиска (да, Google капризничает, но это правда). Вы видите, что при использовании noindex на странице Google должен просканировать страницу, чтобы найти этот тег, Googlebot не просто обрабатывает одну строку за раз, а затем останавливается, когда он натыкается на этот тег, он загружает всю страницу, поэтому, скорее всего, сообщается в Инструментах Google для веб-мастеров.

Таким образом, вы можете видеть эти страницы в Инструментах для веб-мастеров, но это не значит, что они включены в фактические результаты поиска, просто введите site:yourdomain.com в поиске Google и посмотрите, найдены ли эти страницы, что я подозреваю. это не так, или каким-то образом тег был проигнорирован.

Google фактически рекомендует использовать как метаимя, так и роботов для блокировки контента, доступного в общедоступных результатах поиска. Также вам не нужно использовать botname в мета-имени и простой "роботы" должны помочь.

Ваше метаимя должно выглядеть так:

И вы должны сделать robots.txt вот так

User-agent: * Запретить: /имя папки/

2

Похоже, это должно быть правильно, согласно инструкциям от Google. Несколько предложений:

Убедитесь, что метатеги находятся в пределах

Убедитесь, что метатеги действительно говорят «noindex, nofollow» (ваш код говорит «noindex, follow» — не уверен, что это просто ошибка копирования)

Используйте стандартный

Подождите, пока Google снова просканирует ваши страницы, если вы только недавно добавили/изменили метатеги, или используйте запрос на удаление URL-адресов, чтобы попытаться ускорить удаление некоторых URL-адресов.

Сообщение Инструментов для веб-мастеров "Бот Googlebot обнаружил очень большое количество URL-адресов на вашем сайте" означает, что робот Googlebot нашел эти URL-адреса и сканирует их. В Google есть URL-адрес, который немного объясняет это и показывает примеры, такие как «страницы календаря», которые продолжаются вечно.

С помощью вашего метатега вы просто говорите Google прочитать страницу и выбросить содержимое noindex - но чтобы перейти по всем ссылкам на этой странице. Если вы не хотите, чтобы Google переходил по этим ссылкам, используйте вместо nofollow .

Установка запрета в robots.txt предотвратит доступ бота к вашему сайту, но не сохранит ваши (связанные) страницы в поисковом индексе.

Не добавляйте nofollow к вашему noindex, так как вы хотите, чтобы PageRank нормально проходил через эти страницы к другим; вы просто не хотите, чтобы они индексировались.

Поэтому на страницах, которые вы не хотите индексировать, просто добавьте в раздел .