Изучаем команду wget на 12 примерах / Хабр

Все мы иногда качаем файлы из интернета. Если для этого использовать программы с графическим интерфейсом, то всё оказывается предельно просто. Однако, при работе в командной строке Linux дело несколько усложняется. Особенно — для тех, кто не знаком с подходящими инструментами. Один из таких инструментов — чрезвычайно мощная утилита wget, которая подходит для выполнения всех видов загрузок. Предлагаем вашему вниманию двенадцать примеров, разобрав которые, можно освоить основные возможности wget.

1. Загрузка одного файла

Если всё, что нужно — это загрузка одного файла, нам подойдёт следующая конструкция:

$ wget https://downloads.sourceforge.net/project/nagios/nagios-4.x/nagios-4.3.1/nagios-4.3.1.tar.gz?r=&ts=1489637334&use_mirror=excellmedia

После ввода такой команды начнётся скачивание Nagios Core. В ходе этого процесса можно будет видеть данные о загрузке, например — сведения о том, какой объём данных уже загружен, текущую скорость, и то, сколько времени осталось до конца загрузки.

В ходе этого процесса можно будет видеть данные о загрузке, например — сведения о том, какой объём данных уже загружен, текущую скорость, и то, сколько времени осталось до конца загрузки.

2. Загрузка файла и сохранение его с новым именем

Если мы хотим сохранить загруженный файл под именем, отличающимся от его исходного имени, нам пригодится команда wget с параметром -O:

$ wget -O nagios_latest https://downloads.sourceforge.net/project/nagios/nagios-4.x/nagios-4.3.1/nagios-4.3.1.tar.gz?r=&ts=1489637334&use_mirror=excellmedia

При таком подходе загруженный файл будет сохранён под именем nagios_latest.

3. Ограничение скорости загрузки файлов

При необходимости скорость загрузки файлов с помощью wget можно ограничить. В результате эта операция не будет занимать весь доступный канал передачи данных и не повлияет на другие процессы, связанные с сетью. Сделать это можно, используя параметр

Сделать это можно, используя параметр --limit-rate и указав ограничение скорости, выраженное в байтах (в виде обычного числа), килобайтах (добавив после числа K) или мегабайтах (M) в секунду:

$ wget ––limit-rate=500K https://downloads.sourceforge.net/project/nagios/nagios-4.x/nagios-4.3.1/nagios-4.3.1.tar.gz?r=&ts=1489637334&use_mirror=excellmedia

Здесь задано ограничение скорости загрузки, равное 500 Кб/с.

4. Завершение прерванной загрузки

Если в ходе загрузки файлов эта операция была прервана, можно возобновить загрузку с помощью параметра -c команды wget:

$ wget –c https://downloads.sourceforge.net/project/nagios/nagios-4.x/nagios-4.3.1/nagios-4.3.1.tar.gz?r=&ts=1489637334&use_mirror=excellmedia

Если этот параметр не использовать, то загрузка недокачанного файла начнётся сначала.

5. Фоновая загрузка файла

Если вы загружаете файл огромного размера и хотите выполнять эту операцию в фоне, сделать это можно, используя параметр -b:

$ wget –b https://downloads.sourceforge.net/project/nagios/nagios-4.x/nagios-4.3.1/nagios-4.3.1.tar.gz?r=&ts=1489637334&use_mirror=excellmedia

6. Загрузка нескольких файлов

Если имеется список URL файлов, которые надо загрузить, но вам не хочется вручную запускать загрузки этих файлов, можно использовать параметр -I. Однако, перед тем, как начинать загрузку, нужно создать файл, содержащий все адреса. Например, сделать это можно такой командой:

$ vi url.txt

В этот файл нужно поместить адреса — по одному в каждой строке. Далее, осталось лишь запустить wget, передав этой утилите только что созданный файл со списком загрузок:

$ wget –I url.txt

Выполнение этой команды приведёт к поочерёдной загрузке всех файлов из списка.

7. Увеличение общего числа попыток загрузки файла

Для того, чтобы настроить число повторных попыток загрузки файла, можно использовать параметр --tries:

wget ––tries=100 https://downloads.sourceforge.net/project/nagios/nagios-4.x/nagios-4.3.1/nagios-4.3.1.tar.gz?r=&ts=1489637334&use_mirror=excellmedia

8. Загрузка файлов с FTP-сервера

Команда загрузки файла с анонимного FTP-сервера с помощью wget выглядит так:

$ wget FTP-URL

Если для доступа к файлу требуются имя пользователя и пароль, то команда примет такой вид:

$ wget –-ftp-user=dan ––ftp-password=********* FTP-URL

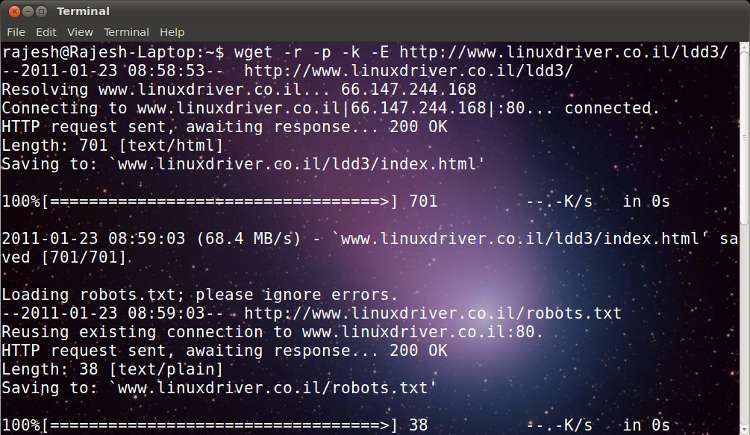

9. Создание локальной копии веб-сайта

Если нужно загрузить содержимое целого веб-сайта, сделать это можно, воспользовавшись параметром --mirror:

$ wget --mirror -p --convert-links -P /home/dan xyz.com

Обратите внимание на дополнительные параметры командной строки:

-p: производится загрузка всех файлов, необходимых для корректного отображения HTML-страниц.--convert-links: ссылки в документах будут преобразованы для целей локального просмотра сайта.-P /home/dan: материалы будут сохранены в папку/home/dan.

10. Загрузка с сайта только файлов определённого типа

Для того, чтобы загрузить с сайта только файлы определённого типа, можно воспользоваться параметрами -r -A:

$ wget -r -A.txt Website_url

11. Пропуск файлов определённого типа

Если вы хотите скопировать целый веб-сайт, но при этом вам не нужны файлы определённого типа, отключить их загрузку можно с помощью параметра --reject:

$ wget --reject=png Website_url

12.

Загрузка с использованием собственного .log-файла

Загрузка с использованием собственного .log-файла

Для того, чтобы загрузить файл и использовать при этом собственный .log-файл, воспользуйтесь параметром -o и укажите имя файла журнала:

$ wget -o wgetfile.log https://downloads.sourceforge.net/project/nagios/nagios-4.x/nagios-4.3.1/nagios-4.3.1.tar.gz?r=&ts=1489637334&use_mirror=excellmedia

Итоги

Wget — довольно простая в использовании, но весьма полезная утилита Linux. И, на самом деле то, о чём мы рассказали — лишь малая часть того, что она умеет. Надеемся, этот обзор поможет тем, кто не был знаком с wget, оценить эту программу, и, возможно, включить её в свой повседневный арсенал инструментов командной строки.

Уважаемые читатели! Пользуетесь ли вы инструментами командной строки Linux для загрузки файлов? Если да — просим о них рассказать.

Примеры: wget

/ → *nix → wget

№1

Загрузка всех URL, указанных в файле FILE:

$ wget -i FILE

№2

Скачивание файла в указанный каталог (-P):

$ wget -P /path/for/save ftp://ftp.example.org/some_file.iso

№3

Использование имя пользователя и пароля на FTP/HTTP:

$ wget ftp://login:[email protected]/some_file.iso $ wget --user=login --password=password ftp://ftp.example.org/some_file.iso

№4

Скачивание в фоновом режиме (-b):

$ wget -b ftp://ftp.example.org/some_file.iso

№5

Продолжить (-c continue) загрузку ранее не полностью загруженного файла:

$ wget -c http://example.org/file.iso

№6

Скачать страницу с глубиной следования 10, записывая протокол в файл log:

$ wget -r -l 10 http://example.org/ -o log

№7

Скачать содержимое каталога http://example.org/~luzer/my-archive/ и всех его подкаталогов, при этом не поднимаясь по иерархии каталогов выше:

$ wget -r --no-parent http://example.org/~luzer/my-archive/

№8

Для того, чтобы во всех скачанных страницах ссылки преобразовывались в относительные для локального просмотра, необходимо использовать ключ -k:

$ wget -r -l 10 -k http://example.org/

№9

Также поддерживается идентификация на сервере:

$ wget --save-cookies cookies.txt \ --post-data 'user=foo&password=bar' \ http://example.org/auth.php

№10

Скопировать весь сайт целиком:

$ wget -r -l 0 -k http://example.org/

№11

Скачивание галереи картинок с превьюшками.

$ wget -r -k -p -l1 -I /images/ -I /thumb/ \ --execute robots=off www.example.com/gallery.html

№12

Сохранить веб страницу (как она открывается локально) в текущую директорию

$ (cd cli && wget -nd -pHEKk http://www.pixelbeat.org/cmdline.html)

№13

Продолжить скачивание частично скаченного файла

$ wget -c http://www.example.com/large.file

№14

Скачать множество файлов в текущую директорию

$ wget -r -nd -np -l1 -A '*.jpg' http://www.example.com/

№15

Отображать вывод напрямую (на экран)

$ wget -q -O- http://www.pixelbeat.org/timeline.html | grep 'a href' | head

№16

Скачать url в 01:00 в текущую директорию

$ echo 'wget url' | at 01:00

№17

Сделать закачку с уменьшенной скоростью В данном случае 20 КB/s

$ wget --limit-rate=20k url

№18

Проверить ссылки в файле

$ wget -nv --spider --force-html -i bookmarks.html

№19

Оперативно обновлять локальную копию сайта (удобно использовать с cron)

$ wget --mirror http://www.example.com/

№20

Используем wildcard для того чтобы скачать несколько страниц

$ wget http://site.com/?thread={1..100}

$ wget http://site.com/files/main.{css,js}

№21

Запустить скачивание списка ссылок в 5 потоков

$ cat links.txt | xargs -P 5 wget {}

№22

Проверить ссылки из файла на живость

$ cat list.txt

http://yandex.ru http://google.ru http://yandex.ru/qweqweqweqwe

$ wget -nv --spider -i list.txt

2013-08-08 22:40:20 URL: http://www.yandex.ru/ 200 Ok 2013-08-08 22:40:20 URL: http://www.google.ru/ 200 OK http://yandex.ru/qweqweqweqwe: Удалённый файл не существует — битая ссылка!

Команда Wget в Linux/Unix — GeeksforGeeks

Wget — это неинтерактивный сетевой загрузчик, который используется для загрузки файлов с сервера, даже когда пользователь не вошел в систему, и может работать в фоновом режиме, не мешая текущей процесс.

- GNU wget — бесплатная утилита для неинтерактивной загрузки файлов из Интернета. Он поддерживает протоколы HTTP, HTTPS и FTP, а также поиск через HTTP-прокси.

- wget не является интерактивным, то есть может работать в фоновом режиме, пока пользователь не вошел в систему. Это позволяет начать поиск и отключиться от системы, позволяя wget завершить работу. В отличие от этого, большинство веб-браузеров требуют постоянного присутствия пользователя, что может быть большой помехой при передаче большого количества данных.

- wget может переходить по ссылкам на страницах HTML и XHTML и создавать локальные версии удаленных веб-сайтов, полностью воссоздавая структуру каталогов исходного сайта. Иногда это называют рекурсивной загрузкой. При этом wget соблюдает стандарт исключения роботов (/robots.txt). wget можно указать преобразовать ссылки в загруженных HTML-файлах в локальные файлы для просмотра в автономном режиме.

- wget обеспечивает устойчивость к медленным или нестабильным сетевым подключениям; если загрузка не удалась из-за проблемы с сетью, она будет повторяться до тех пор, пока не будет получен весь файл. Если сервер поддерживает возобновление, он даст указание серверу продолжить загрузку с того места, где она была остановлена.

Синтаксис:

wget [опция] [URL]

Пример:

1. Чтобы просто загрузить веб-страницу: 90 003

wget http://example.com/sample.php

2. Для загрузки файла в фоновом режиме

Для загрузки файла в фоновом режиме

wget -b http://www.example.com/samplepage.php

3. Для перезаписи журнала во время выполнения команды wget

wget http://www. example.com/filename.txt -o /path/filename.txt

4. Чтобы возобновить частично загруженный файл

wget -c http://example.com/samplefile.tar.gz

5. Чтобы попытаться заданное количество раз

wget --tries=10 http: //example.com/samplefile.tar.gz

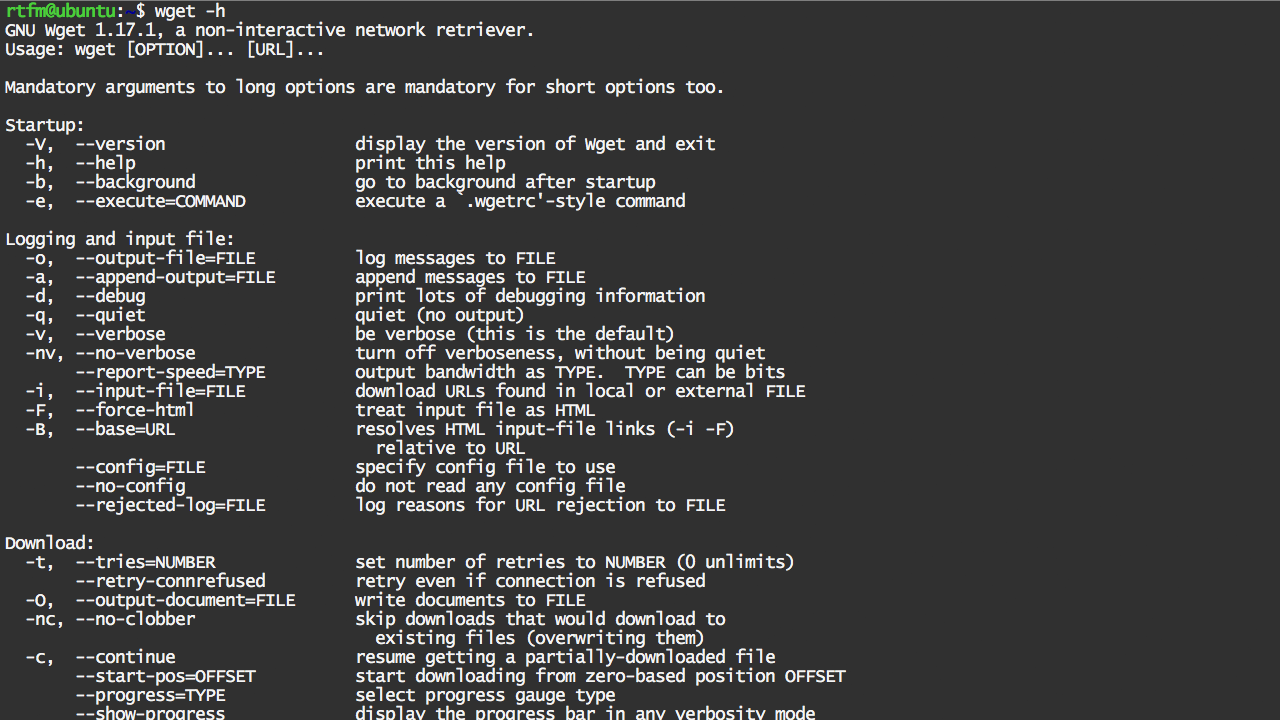

Параметры:

1. -v / –version : Используется для отображения версии wget, доступной в вашей системе.

Синтаксис

$wget -v

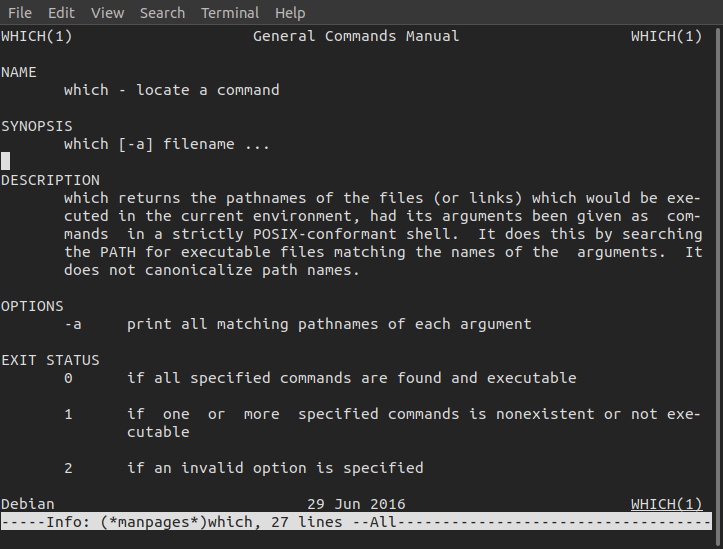

2. -h / –help : Используется для печати справочного сообщения, отображающего все возможные параметры команды строки, которые доступны с параметрами командной строки wget

Синтаксис

$wget -h [URL]

3. -o файл журнала : Этот параметр используется для направления всех сообщений, сгенерированных системой, в файл журнала, указанный параметром, и когда процесс завершено, все сгенерированные таким образом сообщения доступны в файле журнала. Если файл журнала не указан, выходные сообщения перенаправляются в файл журнала по умолчанию, т. е. wget -log

-o файл журнала : Этот параметр используется для направления всех сообщений, сгенерированных системой, в файл журнала, указанный параметром, и когда процесс завершено, все сгенерированные таким образом сообщения доступны в файле журнала. Если файл журнала не указан, выходные сообщения перенаправляются в файл журнала по умолчанию, т. е. wget -log

Синтаксис

$wget -o logfile [URL]

4. -b / –background : Эта опция используется для перевода процесса в фоновый режим сразу после его запуска, чтобы можно было выполнять другие процессы. Если выходной файл не указан с помощью параметра -o, вывод по умолчанию перенаправляется в wget-log.

Синтаксис

$wget -b [URL]

5. -a : Эта опция используется для добавления выходных сообщений к текущему выходному файлу журнала без перезаписи файла, поскольку опция -o вывод файл журнала перезаписывается, но при использовании этой опции журнал предыдущей команды сохраняется, а текущий журнал записывается после журнала предыдущих.

Синтаксис

$wget -a файл журнала [URL]

6. -i : Этот параметр используется для чтения URL-адресов из файла. Если -i указан как файл, URL-адреса считываются из стандартного ввода. Если используется эта функция, в командной строке не требуется указывать URL-адреса. Если есть URL-адреса и в командной строке, и во входном файле, те, что в командных строках, будут извлечены первыми. Файл не обязательно должен быть HTML-документом, если URL-адреса просто перечислены последовательно.

Синтаксис

$wget -i входной файл $wget -i inputfile [URL]

7. -t число / –tries=число : Эта опция используется для установки количества попыток в указанное количество раз. Укажите 0 или inf для бесконечных повторных попыток. По умолчанию повторяется 20 раз, за исключением фатальных ошибок, таких как отказ в подключении или ссылка не найдена, которые не повторяются после возникновения ошибки.

Синтаксис

$wget -t номер [URL]

8. -c : Эта опция используется для возобновления частично загруженного файла, если для возможности возобновления файла задано значение «да», в противном случае загрузка файла не может быть возобновлена, если возможность возобновления данного файла отсутствует или не указана .

Синтаксис

$wget -c [URL]

9. -w : Этот параметр используется для установки системы на ожидание указанного количества секунд между извлечениями. Рекомендуется использовать этот параметр, так как он снижает нагрузку на сервер, делая запросы менее частыми. Вместо секунд время можно указать в минутах с помощью суффикса m, в часах с суффиксом h или в днях с суффиксом d. Указание большого значения для этой опции полезно, если сеть или хост назначения не работают, так что wget может ждать достаточно долго, чтобы разумно ожидать, что сетевая ошибка будет исправлена до повторной попытки.

Синтаксис

$wget -w число в секундах [URL]

10. -r : эта опция используется для включения рекурсивного получения указанной ссылки в случае фатальных ошибок. Эта опция является рекурсивным вызовом данной ссылки в командной строке.

Синтаксис

$wget -r [URL]

Эта статья предоставлена Mohak Agrawal . Если вам нравится GeeksforGeeks и вы хотите внести свой вклад, вы также можете написать статью с помощью write.geeksforgeeks.org или отправить ее по адресу [email protected]. Посмотрите, как ваша статья появится на главной странице GeeksforGeeks, и помогите другим гикам.

Пожалуйста, пишите комментарии, если вы обнаружите что-то неправильное, или вы хотите поделиться дополнительной информацией по теме, обсуждаемой выше.

12 Примеры полезных команд Wget в Linux

Команда Wget в Linux используется для загрузки файлов из Интернета с использованием протоколов HTTP, HTTPS и FTP. Другими словами, мы можем сказать, что wget — это неинтерактивный инструмент загрузки из командной строки для систем Linux. Он также поддерживает загрузку файлов через HTTP-прокси.

Другими словами, мы можем сказать, что wget — это неинтерактивный инструмент загрузки из командной строки для систем Linux. Он также поддерживает загрузку файлов через HTTP-прокси.

Здесь неинтерактивный означает, что он может работать в фоновом режиме, пока пользователь не вошел в систему. Когда мы делаем минимальную установку дистрибутивов Linux, команда wget не устанавливается. Поэтому, чтобы установить wget в дистрибутивах Linux, запустите

$ sudo yum install -y wget // CentOS 7 / RHEL 7 $ sudo dnf install -y wget // CentOS 8/ RHEL 8/ Rocky Linux 8 $ sudo apt install -y wget // Ubuntu/Debian $ sudo pacman -S wget // Arch Linux $ sudo zypper install wget // OpenSUSE

В этом руководстве мы рассмотрим 12 полезных примеров команд wget. Эти примеры помогут вам начать использовать команду wget как профессионал. Итак, давайте углубимся в примеры.

1) Загрузка одного файла с помощью wget

Чтобы загрузить файл с помощью команды wget, просто введите команду wget, а затем абсолютный путь к файлу, пример показан ниже:

$ wget https://download.rockylinux.org/pub/rocky/8/isos/x86_64 /Rocky-8.4-x86_64-minimal.iso

Эта команда загрузит ISO-файл Rocky Linux 8 в текущий рабочий каталог пользователя.

2) Возобновить частичную загрузку файла (-c)

Есть несколько сценариев, когда мы начинаем скачивать большой файл, но посередине Интернет отключается, поэтому, используя опцию ‘-c’ в команде wget, мы можем возобновить загрузку. откуда он отключился. Пример показан ниже,

$ wget -c https://download.rockylinux.org/pub/rocky/8/isos/x86_64/Rocky-8.4-x86_64-minimal.iso

3) Загрузить файлы в фоновом режиме (-b)

Используйте параметр «-b» в команде wget для загрузки файлов в фоновом режиме. Эта опция становится очень полезной, когда файл слишком большой и вы хотите использовать терминал для других задач.

$ wget -b https://download.rockylinux.org/pub/rocky/8/isos/x86_64/Rocky-8.4-x86_64-dvd1.iso Продолжаем в фоновом режиме, pid 4505. Вывод будет записан в «wget-log».

Как мы видим выше, процесс загрузки фиксируется в файле «wget-log» в текущем каталоге пользователя. Используйте команду tail для просмотра статуса загрузки.

Используйте команду tail для просмотра статуса загрузки.

$ хвост -f wget-журнал 2300К .......... .......... .......... .......... ......... 0% 48.1К 18ч5м 2350К .......... .......... .......... .......... ......... 0% 53,7К 18ч9м 2400К ........................ .......... .......... ......... 0% 52.1К 18ч23м 2450К .......... .......... .......... .......... ......... 0% 58.3К 18ч24м 2500К ........................ .......... .......... ......... 0% 63.6К 18ч24м 2550К .......... .......... .......... .......... ......... 0% 63.4К 18ч23м 2600К ........................ .......... .......... ......... 0% 72.8К 18ч20м 2650К .......... .......... .......... .......... ......... 0% 59.8К 18х21м 2700К .......... .......... .......... .......... ......... 0% 52.8К 18ч24м 2750К .......... .......... .......... .......... ......... 0% 58.4К 18ч25м 2800К ........................ .......... .......... ......... 0% 58.2К 18х26м 2850К ........................ .......... .......... ......... 0% 52.2K 18h30m

4) Ограничение скорости загрузки в команде wget

По умолчанию команда wget пытается использовать полную пропускную способность, но может быть случай, когда вы используете общий интернет, поэтому, если вы попытаетесь загрузить огромный файл используя wget , это может замедлить Интернет других пользователей. Этой ситуации можно избежать, если ограничить скорость загрузки с помощью опции «–limit-rate».

$ wget --limit-rate=100k https://download.rockylinux.org/pub/rocky/8/isos/x86_64/Rocky-8.4-x86_64-dvd1.iso

В приведенной выше команде wget мы имеем установите ограничение на загрузку 100K.

5) Загрузка нескольких файлов с помощью wget

Если вы хотите загрузить несколько файлов с помощью команды wget , сначала создайте текстовый файл и добавьте в него все URL-адреса. Пример показан ниже:

$ cat download-list.txt https://download.rockylinux.org/pub/rocky/8/isos/x86_64/Rocky-8.4-x86_64-dvd1.iso https://releases.ubuntu.com/20.04.2.0/ubuntu-20.04.2.0-desktop-amd64.iso https://download.opensuse.org/distribution/leap/15.3/iso/openSUSE-Leap-15.3-DVD-x86_64-Current.iso

Теперь выполните приведенную ниже команду,

$ wget -i download-list.txt

Приведенная выше команда wget начнет загрузку файлов ISO последовательно.

6) Увеличить количество повторных попыток в wget

Мы можем увеличить количество повторных попыток, используя опцию «–tries» в wget. По умолчанию команда wget повторяет попытку 20 раз, чтобы загрузка прошла успешно.

Эта опция становится очень полезной, когда у вас проблемы с интернет-соединением и вы загружаете большой файл.

$ wget --tries=75 https://download.opensuse.org/distribution/leap/15.3/iso/openSUSE-Leap-15.3-DVD-x86_64-Current.iso

Приведенная выше команда wget попытается загрузить файл макс 75 раз.

7) Перенаправить вывод команды wget в файл журнала

Мы можем перенаправить вывод команды wget в файл журнала, используя опцию «-o». Пример показан ниже,

Пример показан ниже,

$ wget -o download.log https://releases.ubuntu.com/20.04.2.0/ubuntu-20.04.2.0-desktop-amd64.iso

файл download.log будет создан автоматически в текущем каталоге пользователя.

8) Загрузите полный веб-сайт для локального просмотра

С помощью команды wget мы можем загрузить полный веб-сайт для локального просмотра, синтаксис показан ниже,

$ wget --mirror -p --convert-links -P ./веб-сайт-URL

Где

- –зеркало : включите параметры, подходящие для зеркального отображения.

- -p : загрузить все файлы, необходимые для правильного отображения данной HTML-страницы.

- –convert-links : после загрузки преобразовать ссылки в документе для локального просмотра.

- -P ./Local-Folder : сохранить все файлы и каталоги в указанный каталог.

9) Отклонять типы файлов при загрузке

Если вы планируете загрузить полный веб-сайт, мы можем заставить команду wget не загружать изображения, используя опцию ‘ –reject ‘ .

$ wget --reject=png <Веб-сайт для загрузки>

10) Установка квоты загрузки в wget

Мы можем заставить команду wget прекратить загрузку, когда размер загрузки превышает определенный размер. Используйте параметр «-Q» в команде wget, чтобы установить квоту загрузки.

$ wget -Q10m -i download-list.txt

Обратите внимание, что квота никогда не влияет на загрузку одного файла. Поэтому, если вы укажете wget -Q10m ftp://wuarchive.wustl.edu/ls-lR.gz, будут загружены все файлы ls-lR.gz. То же самое происходит, даже если в командной строке указано несколько URL-адресов. Однако квота будет работать только при извлечении либо рекурсивно, либо из входного файла. Поэтому вы можете смело набирать «wget -Q10m -i download-list.txt», загрузка будет прервана при превышении квоты.

11) Загрузка файла с сайта, защищенного паролем или $ wget —user

Другой способ указать имя пользователя и пароль — указать сам URL.

Любой метод раскрывает ваш пароль любому, кто потрудится запустить «ps». Чтобы пароли не были видны, сохраните их в .wgetrc или .netrc и обязательно защитите эти файлы от других пользователей с помощью «chmod». Если пароли действительно важны, не оставляйте их лежать в этих файлах, либо отредактируйте файлы и удалите их после того, как wget начнет загрузку.

12) Загрузка файла с пропуском проверки сертификата

В некоторых сценариях мы хотим загрузить файл с портов https и пропустить проверку сертификата, поэтому это можно сделать с помощью параметра «–no-check-certificate» в команде wget. ,

$ wget https://about.gitlab.com/ --no-check-certificate

Загрузка Oracle Java с помощью команды wget с портала https и пропуск проверки сертификата

$ wget --header "Cookie: oraclelicense=accept -securebackup-cookie" https://download.oracle.com/otn-pub/java/jdk/12.0.1+12/69cfe15208a647278a19ef0990eea691/jdk-12.0.1_linux-x64_bin.rpm --no-check-certificate

Загрузка файлов через прокси

В некоторых ситуациях наша система работает за прокси-сервером, поэтому в таких ситуациях сначала нам нужно установить прокси а затем мы можем использовать команду wget для загрузки файла из Интернета. Чтобы установить прокси в командной строке, используйте следующие переменные и команду экспорта

Чтобы установить прокси в командной строке, используйте следующие переменные и команду экспорта

$ export http_proxy=http://<Ваш-Proxy-IP>:$ export https_proxy=http://<ваш-прокси-IP>:<прокси-порт> $ export ftp_proxy=http://<ваш-прокси-IP>:<прокси-порт>

В случае, если для работы прокси требуются имя пользователя и пароль, используйте следующую команду:

$ export http_proxy=http://: @ : $ export https_proxy=http://<имя-пользователя>:<пароль>@<ваш-прокси-IP>:<прокси-порт> $ export ftp_proxy=http:// : @ :

Дополнительный пример

Загрузка и извлечение tar-файла с помощью одной команды wget

Предположим, мы хотим загрузить последнюю версию tar-файла WordPress и извлечь его в определенную папку, например /var/www/html, поэтому для выполнения этой задачи используйте следующую команду wget:

# wget -q -O - http ://wordpress.

txt

txt com

com

org/

org/

pixelbeat.org/timeline.html | grep 'a href' | head

pixelbeat.org/timeline.html | grep 'a href' | head

txt

txt

rockylinux.org/pub/rocky/8/isos/x86_64 /Rocky-8.4-x86_64-minimal.iso

rockylinux.org/pub/rocky/8/isos/x86_64 /Rocky-8.4-x86_64-minimal.iso  2K 18h30m

2K 18h30m  ubuntu.com/20.04.2.0/ubuntu-20.04.2.0-desktop-amd64.iso

https://download.opensuse.org/distribution/leap/15.3/iso/openSUSE-Leap-15.3-DVD-x86_64-Current.iso

ubuntu.com/20.04.2.0/ubuntu-20.04.2.0-desktop-amd64.iso

https://download.opensuse.org/distribution/leap/15.3/iso/openSUSE-Leap-15.3-DVD-x86_64-Current.iso