Запрет индексации страниц сайта в robots.txt

При посещении сайта, поисковый робот использует ограниченое количество ресурсов для индексации. То есть поисковый робот за одно посещение может скачать определенное количество страниц. В зависимости от частоты обновления, объема, количества документов и многих других факторов, роботы могут приходить чаще и скачивать больше страниц.

Чем больше и чаще скачиваются страницы — тем быстрее информация с Вашего сайта попадает в поисковую выдачу. Кроме того, что страницы будут быстрее появляться в поиске, изменения в содержании документов также быстрее вступают в силу.

Быстрая индексация сайта

Быстрая индексация страниц сайта помогает бороться с воровством уникального контента, позволяет повысить релевантность страницы сайта за счет ее свежести и актуальности. Но самое главное. Более быстрая индексация позволяет отслеживать как те или иные изменения влияют на позиции сайта в поисковой выдаче.

Плохая, медленная индексация сайта

Почему сайт плохо индексируется? Причин может быть множество и вот основные причины медленной индексации сайта.

- Страницы сайта медленно загружаются. Это может стать причиной полного исключения сайта из индекса.

- Сайт редко обновляется. Зачем роботу часто приходить на сайт, на котором новые страницы появляются раз в месяц.

- Неуникальный контент. Если на сайте размещен ворованый контент (статьи, фотографии), поисковая система снизит трастовость (доверие) к вашему сайту и снизит расход ресурсов на его индексацию.

- Большое количество страниц. Если на сайте много страниц и не настроен last modified, то на индексацию или переиндексацию всех страниц сайта может уйти очень много времени.

- Сложная структура сайта. Запутанная структура сайта и большие количество вложений сильно затрудняют индексацию страниц сайта.

Если подобные страницы существуют, их как правило очень много, но в индексацию попадают далеко не все. А страницы, которые попадают — конкурируют с целевыми страницами. Все эти страницы регулярно переиндексируются, расходуя и так ограниченый ресурс, выделенный на индексацию вашего сайта.

Если подобные страницы существуют, их как правило очень много, но в индексацию попадают далеко не все. А страницы, которые попадают — конкурируют с целевыми страницами. Все эти страницы регулярно переиндексируются, расходуя и так ограниченый ресурс, выделенный на индексацию вашего сайта.- Динамические страницы. Если на сайте существуют страницы, содержимое которых не зависит от динамических параметров (пример: site.ru/page.html?lol=1&wow=2&bom=3), в результате может появиться множество дублей целевой страницы site.ru/page.html.

Есть и другие причины плохой индексации сайта. Однако, самой распространенной ошибкой является плохо настроенный robots.txt.

Убрать из индексации все лишнее

Существует множество возможностей рационально использовать ресурсы, которые выделяют поисковики на индексацию сайта. И широкие возможности для управления индексацией сайта открывает именно robots.txt.

Используя дерективы Allow, Disallow, Clean-param и другие, можно эффективно распределить не только внимание поискового робота, но и существенно снизить нагрузку на сайт.

Для начала, нужно исключить из индексации все лишнее, используя дерективу Disallow.

Например, запретим страницы логина и регистрации:

Disallow: /login Disallow: /register

Запретим индексацию тегов:

Disallow: /tag

Некоторых динамических страниц:

Disallow: /*?lol=1

Или всех динамических страницы:

Disallow: /*?*

Или сведем на нет страницы с динамическими параметрами:

Clean-param: lol&wow&bom /

На многих сайтах, число страниц найденых роботом может отличаться от числа страниц в поиске в 3 и более раз. То есть, более 60% страниц сайта не участвуют в поиске и являются баластом, который нужно либо ввести в поиск, либо избавится от него. Исключив, нецелвые страницы и приблизив количество страниц в поиске к 100% вы увидите существенный прирост к скорости индексации сайта, рост позиций в поисковой выдаче и больше трафика.

Подробнее про индексацию сайта, влияние индексации на выдачу, правильную настройку robots. txt, генерацию sitemap.xml, настройку last modified страниц сайта, другие способы ускорения индексации сайта и причины плохой индексации сайта читайте в следующих постах. А тем временем.

txt, генерацию sitemap.xml, настройку last modified страниц сайта, другие способы ускорения индексации сайта и причины плохой индексации сайта читайте в следующих постах. А тем временем.

Сбрасывайте ненужный баласт и быстрее идите в топ.

Получайте бесплатные уроки и фишки по интернет-маркетингу

Как запретить индексацию страницы или раздела на сайте с помощью файла robots.txt

Содержание

- Немного теории

- Использование файла robots.txt

- Инструменты для работы с файлом robots.txt

Если вы хоть раз создавали свой собственный сайт, то наверняка сталкивались с ситуацией, когда необходимо закрыть от поиска яндекса (гугла, рамблера, бинга…) некоторые странички сайта или целые разделы. Специально для этого случая поисковые роботы руководствуются файлом robots.txt, который должен лежать у вас в корневом каталоге сайта. Как работать с этим файлом описано в данной хаутошке.

Немного теории

Наверное ни для кого не секрет, что поисковые системы работают не в режиме настоящего времени. Поисковый робот постоянно обходит новые сайты, заносит их тексты в базу поисковика, а также обновляет ресурсы, уже внесённые в базу. Именно поэтому новые сайты попадают в поисковики далеко не сразу.

Поисковый робот постоянно обходит новые сайты, заносит их тексты в базу поисковика, а также обновляет ресурсы, уже внесённые в базу. Именно поэтому новые сайты попадают в поисковики далеко не сразу.

Обычно поисковый робот обнаруживает новый сайт по чьей-либо ссылке или в результате добавления его через специальные формы поисковиков (так называемые «аддурилки», от фразы «add url» — добавить url).

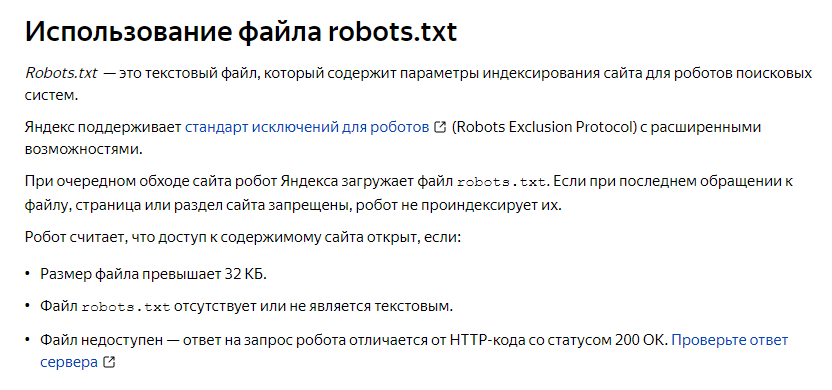

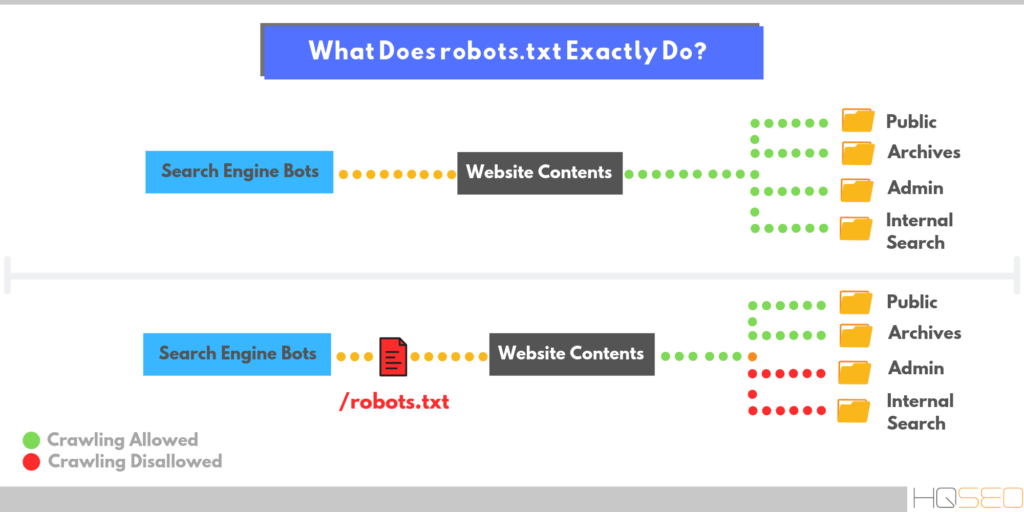

Как только поисковый робот попадает на сайт, он сразу же запрашивает файл robots.txt. Если он его не находит — он действует по-умолчанию. Поэтому файл robots.txt иногда называют файлом исключений для поисковых роботов.

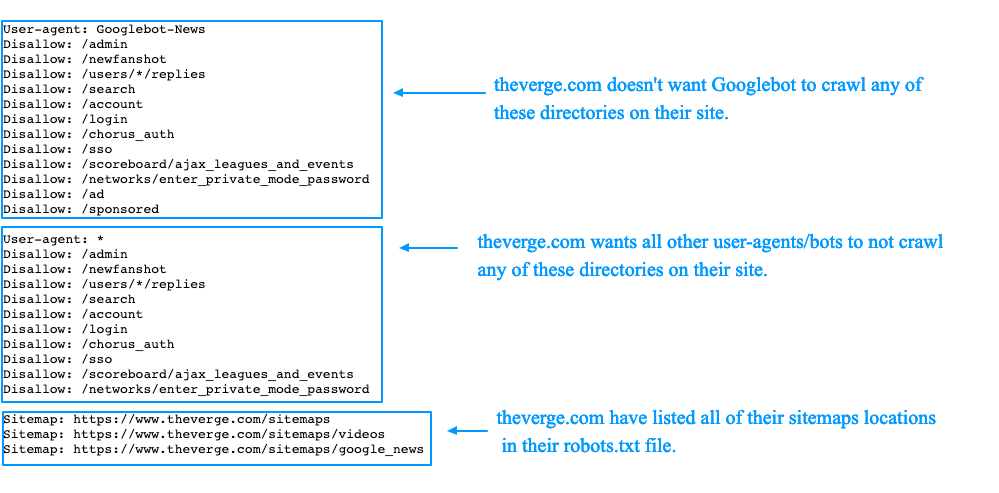

Файл robots.txt используется для запрета индексации некоторых страниц и целых разделов сайта, а также для передачи поисковому роботу файла sitemap.xml (файл карты сайта).

Использование файла robots.txt

Файл состоит из специальных записей. Записи должны быть разделены символом конца строки (при редактировании файла в текстовом редакторе символ конца строки выставляется при нажатии Enter, т. е. при переходе на новую строку).

е. при переходе на новую строку).

Мы рассмотрим работу файла robots.txt на примерах.

Запрет индексации всего сайта

Для того, чтобы запретить индексацию всего сайта необходимо в robots.txt внести следующие строчки:

User-agent: *

Disallow: /

Запрет индексации отдельной папки

Запись User-agent указывает кому именно запрещена индексация (вместо звёздочки * здесь может быть написано «yandex» или «googlebot»), а запись «Disallow» описывает, что именно запрещено к индексации.

User-agent: *

Disallow: /private/

Запрет индексации отдельных типов файлов

Если вы используете CMS (движок сайта), то практически наверняка вы используете специальный модуль SEF URL (Search Engine Friendly URL— дружественные к поисковым системам url-адреса страниц). Это подразумевает автоматическую замену адресов вида:

www.website.ru/index.php?option=com_content&format=feed&type=atom&view=f…

на более дружественные к поисковой системе адреса типа www. website.ru./atom.html

website.ru./atom.html

При этом будет очень полезным запретить индексацию страничек типа «index.php?…» в принципе.

Сделать это можно следующим образом:

User-agent: * Allow: /$ Allow: /*.php$ Allow: /*.jpg$ Allow: /*.gif$ Allow: /*.xml$

Disallow: /index.php?*

Таким образом мы разрешаем индексацию всего, а в самом конце запрещаем индексацию адресов «index.php?…»

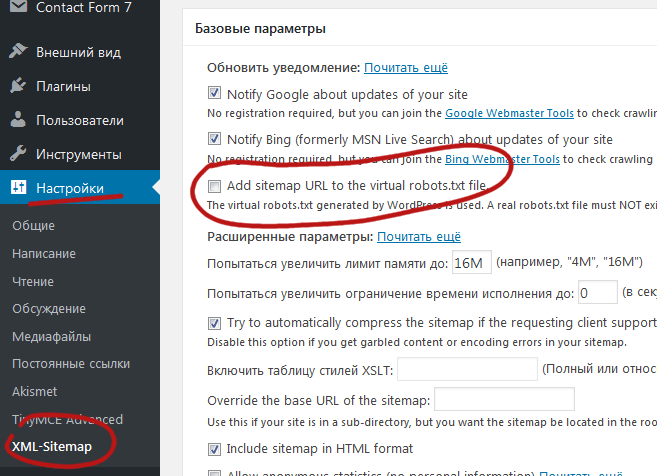

Передача поисковому роботу файла sitemap.xml

Файл sitemap.xml предназначен для передачи поисковому боту списка адресов страниц сайта, предназначенных для индексации. Этот файл помогает поисковым системам разобраться во внутренней структуре сайта. Его наличие практически обязательно, если вы хотите, чтобы ваш сайт уверенно индексировался в поисковых системах.

Мы не будем подробно останавливаться на написании этого файла. Предположим, что с этим файлом вы разобрались. Покажем один из способов передачи этого файла поисковой системе, а именно передачу файла через robots.txt. Для этого необходимо в robots.txt добавить следующую строчку:

Для этого необходимо в robots.txt добавить следующую строчку:

Sitemap: http://www.website.ru/sitemap.xml

Подразумевается, что файл sitemap.xml существует и написан правильно.

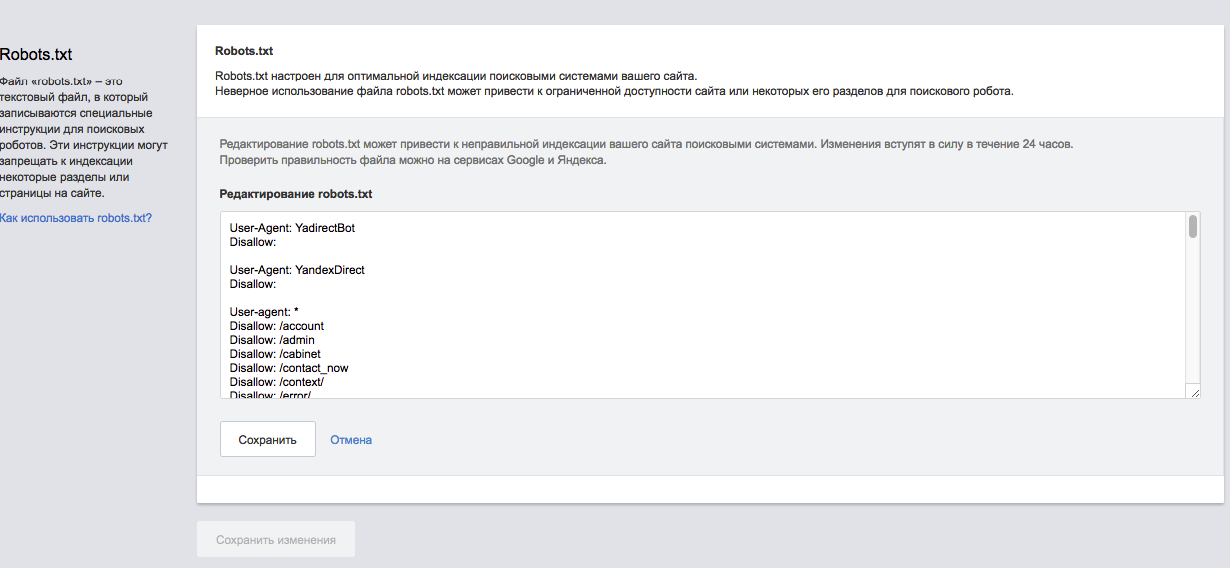

Инструменты для работы с файлом robots.txt

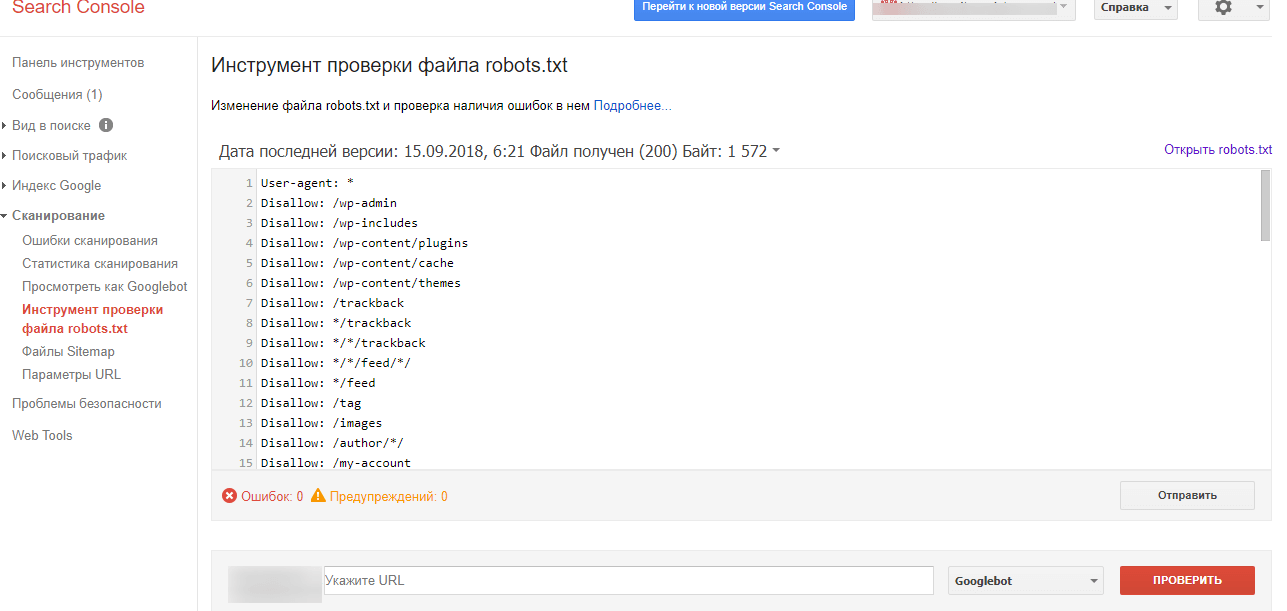

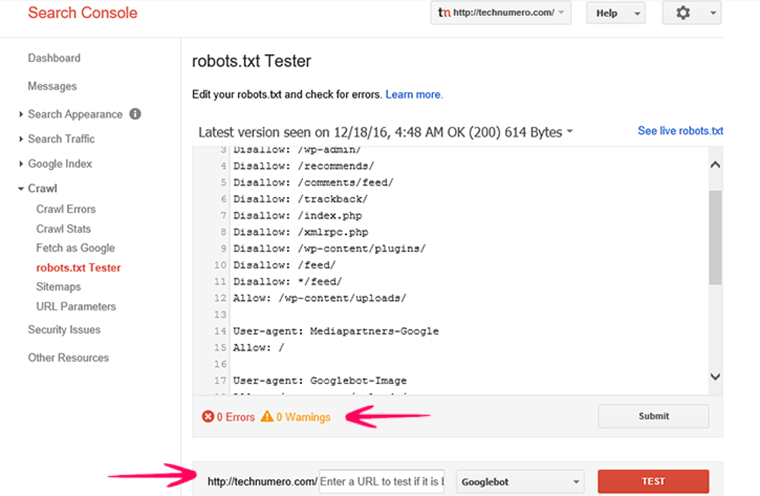

Вообще при работе с файлом достаточно самого простого текстового редактора, поэтому речь тут пойдёт о других инструментах. Существуют специальные сервисы для проверки правильности составления robots.txt. Из таких сервисов следует выделить инструмент, предоставляемый Яндексом на своём сервисе «Яндекс.Вебмастер»: http://webmaster.yandex.ru

Запретить поисковым системам индексировать ваши веб-сайты

- Применяется к: Grid

- Сложность: Легко

- Необходимое время: 10

- Необходимые инструменты: wp-admin. FTP-клиент, текстовый редактор

- Применяется к: VPS-хостингу

- Сложность: Легко

- Необходимое время: 10

- Необходимые инструменты: wp-admin, FTP-клиент, текстовый редактор

- Применяется к: управляемому WordPress

- Сложность: Легко

- Необходимое время: 10

- Необходимые инструменты: wp-admin, FTP-клиент, текстовый редактор

Обзор

Веб-роботы, также известные как веб-бродяги, поисковые роботы или пауки, представляют собой программы, которые перемещаются по сети автоматически. Поисковые системы, такие как Google или Yahoo, используют их для индексации веб-контента вашего сайта. Однако их также можно использовать ненадлежащим образом, например, спамеры используют их для сканирования адресов электронной почты. Ниже приведены несколько методов, которые вы можете использовать, чтобы предотвратить это.

Поисковые системы, такие как Google или Yahoo, используют их для индексации веб-контента вашего сайта. Однако их также можно использовать ненадлежащим образом, например, спамеры используют их для сканирования адресов электронной почты. Ниже приведены несколько методов, которые вы можете использовать, чтобы предотвратить это.

ЗАЯВЛЕНИЕ О ПОДДЕРЖКЕ:

Имейте в виду, что устранение неполадок в конфигурации/функциональности сторонних приложений не входит в наше заявление о поддержке. Эти ресурсы были предоставлены в качестве любезности, чтобы помочь вам в меру наших возможностей. Для получения дополнительной информации о нашем заявлении о поддержке щелкните здесь.

Инструкции

WordPress

Если вы используете WordPress в качестве CMS, есть встроенная функция, позволяющая запретить поисковым системам индексировать ваш сайт.

- Войдите в панель администратора WordPress.

- Нажмите Настройки >> Чтение.

- Убедитесь, что установлен флажок Видимость для поисковых систем .

Как следует из описания, поисковые системы не будут индексировать ваш сайт, но поисковая система должна выполнить этот запрос.

Robots.txt

В качестве альтернативы описанному выше решению WordPress вы также можете использовать файл robots.txt, чтобы поисковые роботы не запрашивали ваш сайт.

- Используйте файловый менеджер File Manager или FTP FTP FTP для перехода в корневой каталог вашего веб-сайта

- Отредактируйте файл robots.txt или создайте новый, если его еще нет.

- Введите в robots.txt следующее:

Агент пользователя: * Запретить: /

- Сохраните изменения. Вот и все!

Если вам нужны дополнительные инструкции для файла robots.txt, ознакомьтесь с приведенной ниже информацией. Не забудьте удалить знак # для любой команды, которой вы хотите, чтобы роботы следовали, но обязательно не раскомментируйте описание команды. Для получения подробной информации обо всех правилах, которые вы можете создать, посетите: http://www.

# Пример robots.txt из (mt) Media Temple # Узнайте больше на http://mediatemple.net # (мт) Форумы - http://forum.mediatemple.net/ # (mt) Статус системы - http://status.mediatemple.net # (mt) Заявление о поддержке - http://mediatemple.net/support/statement/ # Как проверить, что мой файл robots.txt работает должным образом # http://www.google.com/support/webmasters/bin/answer.pyanswer=35237 # Для просмотра списка роботов посетите: http://www.robotstxt.org/db.html # Инструкции # Удалите "#", чтобы раскомментировать любую строку, которую вы хотите использовать, но убедитесь, что не раскомментировали описание. # Предоставить доступ роботам ################################################### ###################################### # В этом примере всем роботам разрешен доступ ко всем файлам, поскольку подстановочный знак "*" указывает всех роботов: #User-agent: * #Запретить: #Чтобы разрешить одного робота, вы должны использовать следующее: #Агент пользователя: Google #Запретить: #User-agent: * #Запретить: / # Запретить доступ роботам ################################################### ###################################### # Этот пример удерживает всех роботов: #User-agent: * #Запретить: / # Следующий пример указывает всем поисковым роботам не входить в четыре каталога веб-сайта: #User-agent: * #Запретить: /cgi-bin/ #Запретить: /изображения/ #Запретить: /tmp/ #Запретить: /частное/ # Пример, который сообщает определенному сканеру не входить в один конкретный каталог: #Агент пользователя: BadBot #Запретить: /частное/ # Пример, который сообщает всем поисковым роботам не вводить один конкретный файл с именем foo.html #User-agent: * #Запретить: /domains/example.com/html//var/www/vhosts/example.com/httpdocs/

Защита паролем ваших страниц/веб-сайта

Поисковые системы и сканеры не имеют доступа к защищенным паролем страницам. Таким образом, он довольно эффективен для предотвращения индексации. Однако этот метод потребует от пользователей ввода пароля для просмотра вашего контента. Это может быть реализовано на отдельных страницах или на всем сайте. Подробные инструкции можно найти в статье ниже:

- Защита паролем каталогов. Защита паролем каталогов. Защита паролем каталогов.

php — Достаточно ли тегов robots.txt и метаданных, чтобы поисковые системы не индексировали динамические страницы, зависящие от переменных $_GET?

спросил

Изменено 6 лет, 11 месяцев назад

Просмотрено 942 раза

Я создал php-страницу, доступную только с помощью токена/пароля, полученного через $_GET

Поэтому, если вы перейдете по следующему URL-адресу, вы получите общую или пустую страницу

.http://fakepage11.com/secret_page.php

Однако, если вы использовали ссылку с токеном, она показывает вам специальный контент

http://fakepage11.com/secret_page.php?token=344ee833bde0d8fa008de206606769e4

Конечно, это не так безопасно, как страница входа, но моя единственная забота — создать динамическую страницу, которая не индексируется и доступна только по предоставленной ссылке.

Индексируются ли динамические страницы, зависящие от переменных $_GET, Google и другими поисковыми системами?

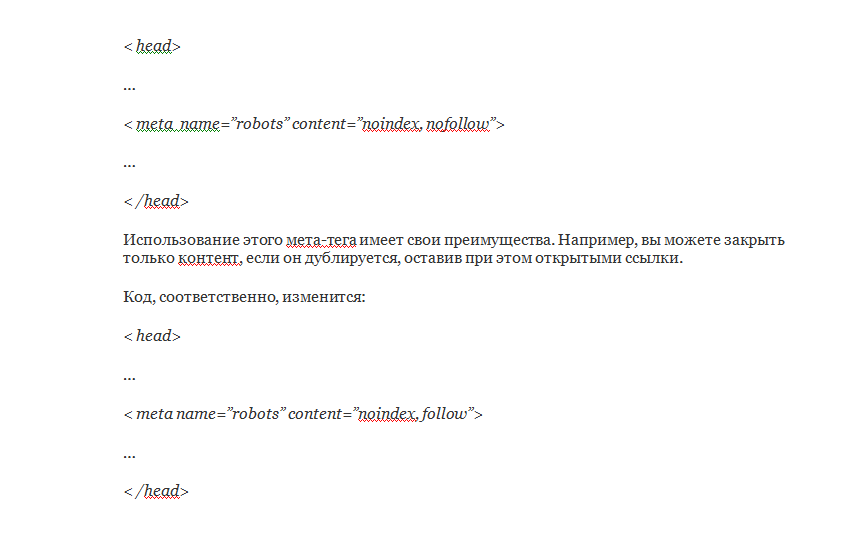

Если да, будет ли достаточно включить следующее, чтобы скрыть это?

Даже если я наберу в гугле:

сайт:fakepage11.com/

Спасибо!

- php

- get

- web-crawler

- robots.txt

- google-crawlers

Если поисковый бот находит ссылку с токеном, он может каким-то образом просканировать и проиндексировать ее¹.

Если вы используете robots.txt , чтобы запретить сканирование страницы, соответствующие боты поисковых систем не будут сканировать страницу, но они все равно могут проиндексировать ее URL-адрес (который затем может появиться в сайте: поиск).

Если вы используете мета — роботов , чтобы запретить индексирование страницы, соответствующие поисковые роботы не будут индексировать страницу, но они все равно смогут ее сканировать.

Вы не можете иметь оба : Если вы запретите сканирование, соответствующие боты никогда не узнают, что вы также запрещаете индексирование, потому что им не разрешено посещать страницу, чтобы увидеть ваши мета — роботы элемент.

¹ Поисковые системы могут найти ссылку бесчисленным множеством способов. Например, пользователь, который посещает страницу, может использовать панель инструментов браузера, которая автоматически отправляет все посещенные URL-адреса в поисковую систему.

1

Если ваша страница недоступна для обнаружения, она не будет проиндексирована.

под «обнаруживаемым» мы подразумеваем:

- это стандартная веб-страница, т.е. индекс.*

- на него ссылается другая ссылка либо ваша, либо с другого сайта

Таким образом, в вашем случае, используя параметр get для доступа, вы получаете 1, но не обязательно 2, поскольку кто-то может ссылаться на эту ссылку и, следовательно, на «скрытую» страницу.

Вы можете использовать файл robots.txt , который вы дали, и в этом случае страница не будет проиндексирована ботом, который это соблюдает (не все подойдут). Отсутствие индексации вашей страницы, конечно, не означает, что «скрытый» URL-адрес страницы не будет находиться в открытом доступе.

Кроме того, еще одна проблема — в зависимости от ваших требований — заключается в том, что вы используете незашифрованный HTTP, что означает, что ваши «скрытые» URL-адреса и содержимое страниц видны каждому серверу между вашим сервером и пользователем.

Если подобные страницы существуют, их как правило очень много, но в индексацию попадают далеко не все. А страницы, которые попадают — конкурируют с целевыми страницами. Все эти страницы регулярно переиндексируются, расходуя и так ограниченый ресурс, выделенный на индексацию вашего сайта.

Если подобные страницы существуют, их как правило очень много, но в индексацию попадают далеко не все. А страницы, которые попадают — конкурируют с целевыми страницами. Все эти страницы регулярно переиндексируются, расходуя и так ограниченый ресурс, выделенный на индексацию вашего сайта.