Как закрыть страницы от индексации?

Поисковым роботам закрывают доступ к ресурсам, которые находятся в разработке или процессе редизайна. Запрет на индексацию накладывают также на сайты, где вебмастера тестируют доработки и проводят эксперименты. Из поиска стоит убрать служебные разделы блога, страницы с личными кабинетами, неактуальные данные, версии для печати, страницы различных фильтраций. Чтобы уменьшить нагрузку на сервер и ускорить индексацию, рекомендуем закрыть от поисковых ботов скрипты информеров и онлайн-консультантов, pop-up-окна, баннеры и тяжелые файлы, например, фотографии.

В статье расскажем, как закрыть от индексации сайт целиком и его отдельные элементы с помощью файла robots.txt.

Закрываем сайт

Создайте файл robots.txt и загрузите его в корневую папку сайта. Включите в файл строчку вида:

User-agent: *

Disallow: /

Так вы наложите вето на индексацию сайта всем поисковикам без исключения.

Если вы хотите закрыть сайт только от Яндекса, строчка будет выглядеть так:

User-agent: Yandex

Disallow: /

Аналогичным образом, подставляя вместо Yandex имена других поисковых ботов, вы можете запретить индексацию и для них:

Googlebot. Из имени видно, что этот робот принадлежит системе Google.

Slurp. Индексирует сайты в системе Yahoo!.

MSNBot. Работает в поисковике Bing.

SputnikBot. Поисковый бот системы «Спутник» .

Закрываем папку и файлы

Чтобы закрыть конкретную папку, пропишите ее название в строке, которая запрещает индексацию. Например, вы хотите спрятать от поисковиков папку «papka1». Пропишите в файле robots.txt:

User-agent: *

Disallow: /papka1/

В этом случае она будет недоступна для поисковых ботов вместе со всеми файлами, которые в нее входят.

Если вы хотите один из файлов в закрытой папке сделать открытым для индексации, используйте одновременно две директивы — Allow (разрешить) и Disallow (запретить):

User-agent: *

Allow: /papka1/file1.php

Disallow: /papka1/

Закрываем картинки

Если вы хотите закрыть все картинки из конкретной папки, в robots.txt пропишите директиву Disallow для этой папки, например:

User-agent: *

Disallow: /imgpapka/

Если вам нужно закрыть только одну картинку, укажите путь к ней:

User-Agent: *

Для запрещения картинок определенного формата используйте строчки:

User-Agent: *

Disallow: *.jpg

В зависимости от задачи вместо *. jpg можно указать *.png или *.gif.

jpg можно указать *.png или *.gif.

Закрываем поддомен

Как правило, файл robots.txt есть у каждого поддомена в его корневой папке. Если файла нет, создайте его. Далее выполните процедуру таким же образом, как это описано для сайта.

Если вы используете Content Distribution Network (CDN), то дубль на поддомене может ухудшить результаты по SEO. Есть два варианта решения проблемы.

Первый — создать на поддомене с CDN отдельный файл robots.txt, в котором прописать запрет на индексацию. Однако в этом случае пострадают поведенческие факторы. Поисковая система не будет учитывать посетителей сайта, если они посещают страницы, размещенные на поддомене.

Второй — выполнить настройку атрибута rel=»canonical» тега <link> с отсылкой к основному домену. В этом случае данные о поведенческих факторах на сайте и поддомене будут суммироваться.

Закрываем сайт или страницу мета-тегом «robots»

Поисковые боты с большей вероятностью обойдут ваш сайт стороной, если вы запретите индексацию путем использования тега robots. Его прописывают в начале кода между тегами <head> и </head>.

Его прописывают в начале кода между тегами <head> и </head>.

Запись для всех роботов:

<meta name=»robots» content=»noindex, nofollow»/>

Или:

<meta name=»robots» content=»none»/>

Для конкретного робота robots заменяется на имя робота, например:

<meta name=»yandex» content=»noindex, nofollow»/>

Другие директивы в robots.txt для робота Яндекс

Вы можете использовать дополнительные параметры для бота поисковой системы Яндекс:

-

Установить минимальный промежуток времени между концом загрузки одной страницы и началом загрузки следующей. Это позволяет снизить нагрузку на сервер сайта. Например:

Crawl-delay: 0.3

где 0,3 — время в секундах. -

Отказаться от многократной перезагрузки дублирующихся данных для повышения эффективности обхода сайта.

Рекомендовано использовать в том случае, если страницы блога содержат ref-ссылки, идентификаторы сессий, UTM-метки или другие GET-параметры. Записывается в виде:

Рекомендовано использовать в том случае, если страницы блога содержат ref-ссылки, идентификаторы сессий, UTM-метки или другие GET-параметры. Записывается в виде:Clean-param: utm/catalog/get_book.p1

-

Подсказать поисковым роботам, какие страницы сайта нужно проиндексировать. Запись выглядит следующим образом:

Sitemap: https://site.ru/sitemap.xml

2 апреля 2019

Как закрыть сайт от индексации в поисковых системах

Доброго дня, дорогие читатели.

В этой статье мы расскажем о том, как закрыть сайт от индексации с помощью самых разных способов. Индексация – это процесс занесения информации вашего ресурса в базы поисковых систем. При этом поисковые роботы могут заносить абсолютно любую информацию вашего проекта. Даже ту, что не нужно. Подобное особенно часто встречается в случаях, когда сам сайт только создан, и какой-то полезной информации там еще нет.

Естественно, ПС все равно могут начать индексацию, что в дальнейшем может создать некоторые проблемы с SEO-продвижением. Сегодня мы разберем наиболее популярные способы сокрытия проекта от взора поисковых роботов. Давайте начинать!

Сегодня мы разберем наиболее популярные способы сокрытия проекта от взора поисковых роботов. Давайте начинать!

Индексация – это процесс, который подразумевает считывание всей информации вашего ресурса для дальнейшего занесения ее в базы ПС. Иными словами, это когда поисковики анализируют ваш сайт, чтобы потом выдавать его пользователям в поисковой выдаче. В процессе индексации учитывается абсолютно все: начиная от дизайна и заканчивая количеством текста в статьях.

В процессе индексации сайта ПС могут делать для себя определенные пометки. Например, если вы начнете размещать на своем веб-ресурсе копипаст, то ваш сайт может попасть под фильтр. В таком случае он больше не будет участвовать в поисковом ранжировании на равных условиях с другими проектами. Поисковик будет просто занижать ресурс в позициях либо вовсе уберет его из результатов.

То же касается и каких-то других аспектов SEO-продвижения. Во время индексации поисковые роботы анализируют все показатели, чтобы определить качество сайта и возможность размещения страниц по каким-то определенным запросам. Если на проекте отсутствует информация (статьи и страницы), то разместить его где-то либо не представляется возможным.

Во время индексации поисковые роботы анализируют все показатели, чтобы определить качество сайта и возможность размещения страниц по каким-то определенным запросам. Если на проекте отсутствует информация (статьи и страницы), то разместить его где-то либо не представляется возможным.

Такой веб-ресурс будет доступен только по прямому обращению с использованием специальных регулярных выражений. В общих результатах его не встретить.

Роботы ПС начинают индексацию всех открытых сайтов сразу же после их создания. Вы даже можете не добавлять свой проект в Яндекс.Вебмастер и Google Search Console, но роботы все равно придут на ваш ресурс и начнут аудит всей доступной информации. Если вы только что создали свой проект, естественно, вам подобная индексация не нужна. Например, очень часто при создании проектов люди пользуются шаблонами.

Чтобы лучше настроить внешний вид ресурса, они загружают специальные демо-конфигурации, которые в автоматическом режиме создают тестовые варианты статей. Это, как правило, копипастные материалы, которые нужны только для того, чтобы тема оформления выглядела должным образом. Согласитесь, настраивать шаблон намного проще, если ты сразу видишь, как это все будет выглядеть в конечном итоге. Когда ресурс пустой, настроить шаблон должным образом бывает очень сложно.

Это, как правило, копипастные материалы, которые нужны только для того, чтобы тема оформления выглядела должным образом. Согласитесь, настраивать шаблон намного проще, если ты сразу видишь, как это все будет выглядеть в конечном итоге. Когда ресурс пустой, настроить шаблон должным образом бывает очень сложно.

Это особенно актуально для проектов на WordPress, потому как тема на заполненном проекте и тема на пустом выглядят совершенно по-разному. Пользователи выгружают демо-контент, чтобы настроить внешний вид, и в случае, если проект не был закрыт от ПС, эти самые страницы с демо-контентом могут попасть в поисковую выдачу.

Естественно, они будут на самых последних страницах, но тем не менее это будет создавать негативный эффект для SEO-продвижения. По сути, это можно рассматривать как попадание мусорных страниц и документов в ПС. Потом вам придется удалять их все, на что может потребоваться определенное время.

Видимого негативного эффекта от этого, конечно, быть не должно. Однако некоторые трудности возникнут. Ваш веб-ресурс не будет классифицироваться как полностью уникальный, и в некоторых случаях поисковые роботы будут занижать позиции уже настоящих статей в выдаче. Даже после удаления всех этих демо-материалов эффект может держаться еще какое-то время.

Однако некоторые трудности возникнут. Ваш веб-ресурс не будет классифицироваться как полностью уникальный, и в некоторых случаях поисковые роботы будут занижать позиции уже настоящих статей в выдаче. Даже после удаления всех этих демо-материалов эффект может держаться еще какое-то время.

Именно поэтому при начальной разработке проекта лучше закрыть его от индексации и открывать уже только после того, как он будет полностью готов. Причем это касается не только демо-контента, но и, вообще, любой разработки – дизайна, скорости загрузки и т. д. Если что-то на ресурсе не работает должным образом, лучше это на время скрыть от глаз пользователей и ПС.

Помимо закрытия на этапе разработки, есть и другие причины для того, чтобы исключить свой проект из поисковой выдачи. К примеру, это может понадобиться специализированным ресурсам, материалы которых не должны быть в общем доступе. Обычно это какие-то специальные закрытые проекты, информация на которых предназначена для ограниченного количества людей.

Естественно, если поисковые системы начнут считывать информацию с таких проектов, то ни о какой приватности речь идти не будет. Все данные будут доступны для изучения с помощью различных сервисов. Сами ПС сохраняют слепки сайтов, поэтому, даже если владельцы проекта решат удалить информацию, которая по ошибке попала в поисковик, где-то может остаться сохраненная копия.

Также закрытие проекта от индексации актуально для внутренних ресурсов различных компаний, которые создают такие сайты для своих сотрудников. Это могут быть специальные панели управления, страницы с расписанием и т. д.

В общем, причин для закрытия проекта от поисковых систем очень много. Да и способов реализации этого тоже.

Закрываем сайт от поисковиков разными способамиСпособов скрыть свой сайт от взгляда поисковиков очень много. Например, в WordPress для этого есть специальная галочка, которая автоматически проставляет специальный тег на всех страницах проекта. Подобный функционал есть и в некоторых других платформах. Достаточно просто перейти в панель управления, найти нужный параметр и активировать его. Также есть и более универсальные способы, которые будут работать на большинстве известных CMS. Даже на самописных или HTML-сайтах подобные способы будут работать. О них мы и расскажем далее.

Достаточно просто перейти в панель управления, найти нужный параметр и активировать его. Также есть и более универсальные способы, которые будут работать на большинстве известных CMS. Даже на самописных или HTML-сайтах подобные способы будут работать. О них мы и расскажем далее.

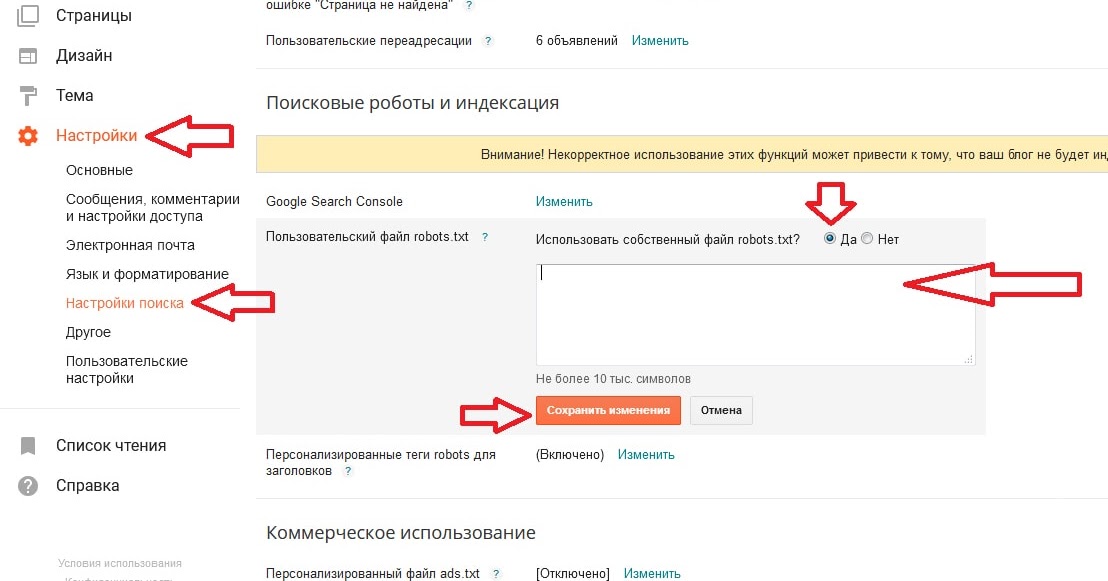

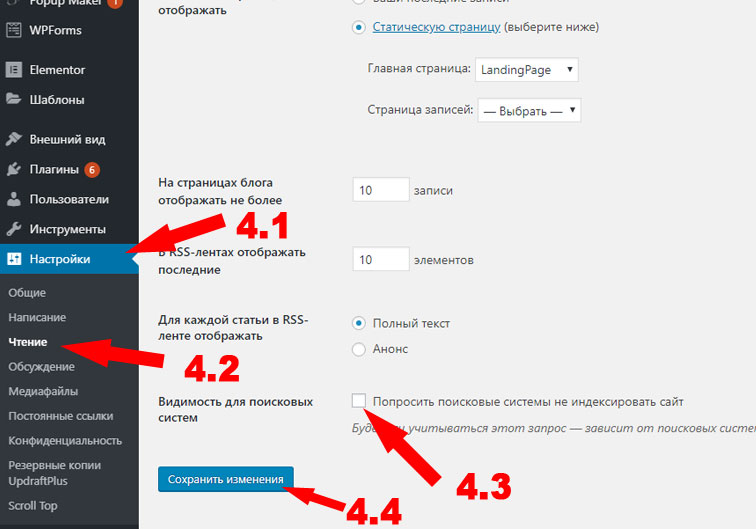

Для скрытия ресурса от ПС вам достаточно активировать настройку, которая отвечает за видимость для роботов ПС. Перейдите в панель управления, наведите курсор на пункт “Настройки” и выберите там подпункт “Чтение”. Откроется страница, где самой последней опцией будет нужная нам галочка.

Активируйте чекбокс с галочкой, после чего кликните на кнопку “Сохранить изменения”. Отныне ваш ресурс не будет индексироваться поисковыми системами. WordPress проставит на всех страницах ресурса специальные теги, которые сообщают, что данный материал не должен участвовать в поисковом ранжировании.

При этом даже в самих настройках сообщается, что далеко не всегда поисковые системы следуют этому запросу. Яндекс и Google, скорее всего, последуют, а вот менее популярные ПС могут проиндексировать ваш ресурс несмотря на все усилия.

Яндекс и Google, скорее всего, последуют, а вот менее популярные ПС могут проиндексировать ваш ресурс несмотря на все усилия.

В любой момент вы можете вернуться в настройки и отключить эту галочку. Тогда метатег автоматически уберется со всех страниц, и вы сможете отправить их на переобход с помощью Яндекс.Вебмастера или Google Search Console.

Помимо полного закрытия ресурса, вы можете делать то же самое, но только с нужными статьями или страницами. Для этого вам необходимо будет установить плагин для поисковой оптимизации Yoast SEO или любое аналогичное расширение. В рамках этой статьи мы рассмотрим именно Yoast SEO.

Чтобы закрыть нужную страницу или статью, вы должны открыть редактор в панели управления, после чего прокрутить страницу вниз. Вплоть до сниппета с Yoast SEO, где расположено окно с title, описанием и ключевым словом для вашего материала.

Перейдите во вкладку “Дополнительно” (значок шестеренки), после чего выберите пункт “Нет” в раскрывающемся меню “Разрешить поисковым системам показывать Запись в результатах поиска?”

Здесь же вы можете указать и другие настройки. Например, расширить метатег robots для этой конкретной страницы. Однако новичкам вряд ли потребуются эти функции. Достаточно будет выбрать соответствующий пункт в настройках записи, после чего сохранить изменения с помощью нужной кнопки.

Например, расширить метатег robots для этой конкретной страницы. Однако новичкам вряд ли потребуются эти функции. Достаточно будет выбрать соответствующий пункт в настройках записи, после чего сохранить изменения с помощью нужной кнопки.

Это можно сделать с любой записью и страницей. Также это можно сделать с метками (тегами) и другими кастомными таксономиями.

Чтобы закрыть полностью все страницы или полностью все записи, вы также можете воспользоваться параметрами плагина Yoast SEO. Просто перейдите в меню “SEO” – “Отображение в поисковой выдаче”. Откроется страница, где в верхнем меню необходимо выбрать пункт “Типы содержимого”. Там будут указаны все таксономии вашего ресурса.

К каждой таксономии будет свой набор настроек, который, как правило, имеет один шаблон. Вам необходимо перейти к нужной таксономии (например, к записям), развернуть содержимое вкладки и выбрать “Нет” в пункте “Показать Записи в результатах поиска?” После этого вам нужно просто сохранить настройки.

На всех записях автоматически проставится метатег robots, который будет сообщать поисковикам, что именно эти документы индексировать не нужно. В то же время другие таксономии и страницы будут доступны для индексации.

То же самое вы можете сделать и со страницами, и с архивами, и с метками. Нужно просто перейти к нужному пункту, изменить эту настройку, после чего сохранить изменения.

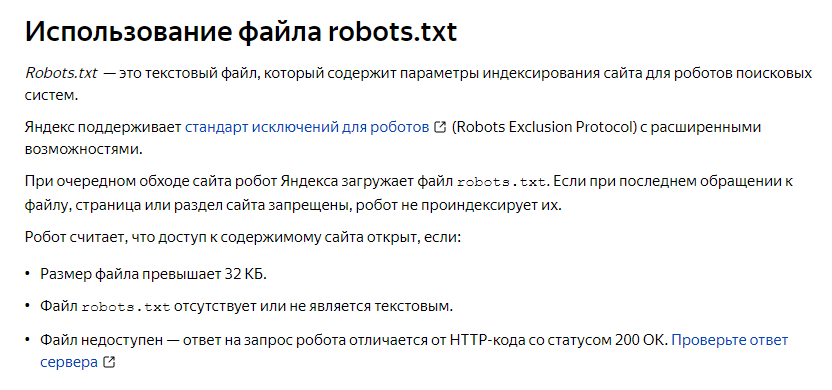

Запрет через robots.txtЗакрыть ресурс от взгляда ПС можно с помощью самого стандартного способа – через robots.txt, который есть практически на каждом проекте. Данный файл имеет очень большое значение для поисковиков, потому что именно в нем описываются все правила для роботов. Если этого файла нет, ПС классифицируют подобное как ошибку.

Для закрытия всего проекта вам необходимо стереть все нынешнее содержимое файла, после чего добавить туда следующие строки.

User-agent: *

Disallow: /

Эти правила будут закрывать ваш сайт от всех ПС. При желании вы можете закрыть ресурс только от одного поисковика. Для этого вместо звездочки необходимо указать название робота.

При желании вы можете закрыть ресурс только от одного поисковика. Для этого вместо звездочки необходимо указать название робота.

Например, чтобы скрыть проект конкретно от Google, вам нужно использовать такой код.

User-agent: Googlebot

Disallow: /

Также вместо Googlebot можно прописать “Yandex”, тогда ваш ресурс будет скрыт только от Яндекса.

Чтобы скрыть конкретную папку или страницу, вы должны указать ее в файле, используя директиву “Disallow”.

К примеру, вы хотите закрыть страницу /blog/ от всех ПС. Остальные материалы по вашему замыслу должны индексироваться. Для этого вы должны использовать следующие строчки в robots.txt.

User-agent: *

Disallow: /blog/

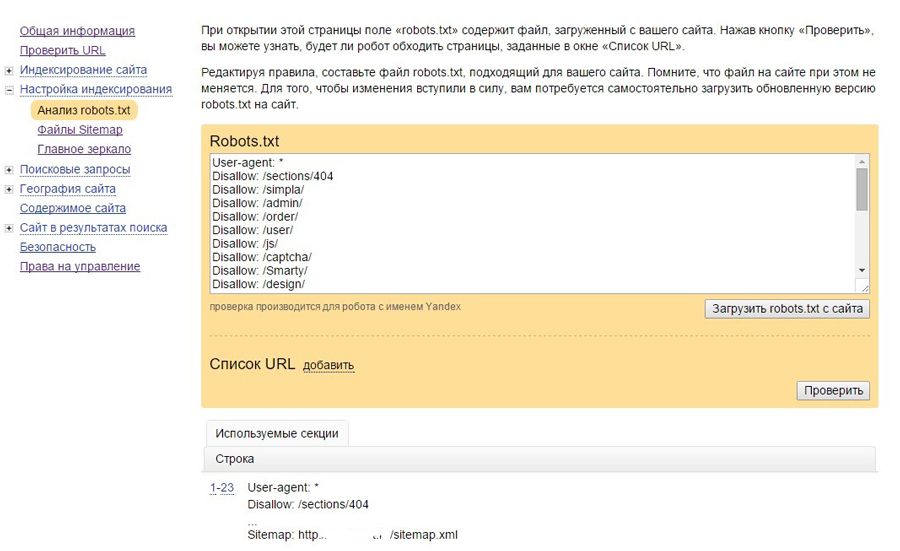

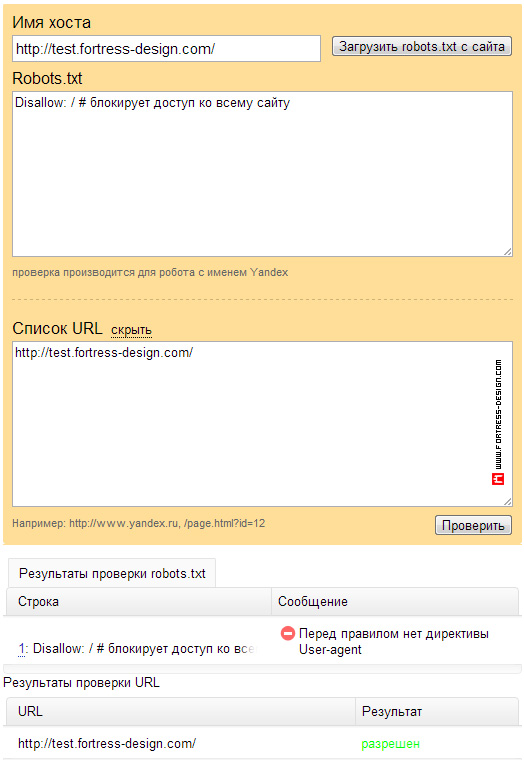

Проверить правильность использования robots.txt вы можете в панелях управления для вебмастеров. Подобные инструменты есть и в Яндексе, и в Google.

Кстати говоря, использование правильного файла robots. txt – залог успешного SEO-продвижения. О том, как создать правильный robots.txt для WordPress и Joomla мы рассказывали в отдельном материале. Рекомендуем ознакомиться.

txt – залог успешного SEO-продвижения. О том, как создать правильный robots.txt для WordPress и Joomla мы рассказывали в отдельном материале. Рекомендуем ознакомиться.

Этот способ очень похож на самый первый, где мы рассказывали, как закрыть ресурс от индексации в WordPress через настройки и плагин. Только в этом случае вам придется добавлять нужный метатег в код самостоятельно без всяких интерфейсов и т. д.

Во все страницы, которые вы хотите закрыть от ПС, нужно добавить следующий тег.

<meta name=”robots” content=”noindex, nofollow”/>

В WordPress это можно сделать при помощи редактора тем, который расположен в меню “Внешний вид”. Просто перейдите в панель управления, найдите там нужный пункт, наведите на него курсор и выберите “Редактор тем”.

Далее, вам нужно будет выбрать файл заголовка (header.php), который используется почти на всех страницах проекта. Туда-то и нужно вставить данный метатег.

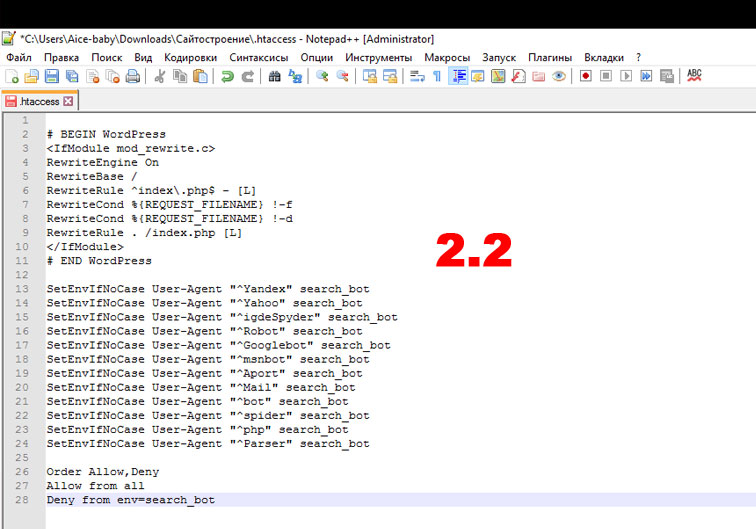

Нужно добавить их в файл. Эти правила закроют ваш проект от всех известных ПС.

ЗаключениеКак видите, способов закрытия проекта от ПС очень много. Мы рассмотрели наиболее популярные и действенные варианты. Надеемся, что этот материал поможет вам в решении ваших проблем. Все на самом деле очень просто, особенно если вы используете WordPress или аналогичную платформу. Достаточно просто активировать настройку, и проект будет закрыт.

Также можно воспользоваться универсальным способом и закрыть ресурс через robots.txt. Таким вариантом пользуется абсолютное большинство вебмастеров, и никаких нареканий у них не возникает. В любой удобный момент можно просто изменить содержимое файла и отправить сайт на переиндексацию.

Как исправить «Проиндексировано, но заблокировано robots.txt» в Google Search Console

26 ноябрь

26 ноябрь

Содержание

Краткий обзор

Укажите затрагиваемые страницы или URL-адреса

Укажите причину уведомления

Неверный формат URL-адреса

Страницы, которые следует проиндексировать проверить своих роботов . txt корректен в WordPress?

txt корректен в WordPress?

Страницы, которые не следует индексировать

Старые URL-адреса

Виртуальные файлы robots.txt

В заключение

Краткий обзор

Если вы получили предупреждение Уведомление «Проиндексировано, хотя и заблокировано robots.txt» в Google Search Console, вы Я хочу исправить это как можно скорее, так как это может повлиять на способность ваших страниц вообще ранжироваться на страницах результатов поисковой системы (SERPS).

Файл robots.txt — это файл, который находится в каталоге вашего веб-сайта и содержит некоторые инструкции для сканеров поисковых систем, таких как бот Google, относительно того, какие файлы они должны и не должны просматривать.

«Проиндексировано, хотя и заблокировано robots.txt» означает, что Google нашел вашу страницу, но также обнаружил указание игнорировать ее в вашем файле robots (что означает, что она не будет отображаться в результатах).

Иногда это делается намеренно, а что-то случайно, по ряду причин, изложенных ниже, и их можно исправить.

Вот снимок экрана с уведомлением:

Укажите затрагиваемые страницы или URL-адреса

Если вы получили уведомление от Google Search Console (GSC), вам необходимо указать конкретные страницы или URL-адреса, о которых идет речь.

Вы можете просматривать страницы с пометкой «Проиндексировано, но заблокировано robots.txt» в Google Search Console>>Coverage. Если вы не видите предупреждающую метку, то вы свободны и чисты.

Проверить файл robots.txt можно с помощью нашего тестера robots.txt. Вы можете обнаружить, что у вас все в порядке с тем, что все, что блокируется, остается «заблокированным». Поэтому никаких действий предпринимать не нужно.

Вы также можете перейти по этой ссылке GSC. Далее вам необходимо:

- Откройте список заблокированных ресурсов и выберите домен.

- Щелкните по каждому ресурсу. Вы должны увидеть это всплывающее окно:

Укажите причину уведомления

Уведомление может быть вызвано несколькими причинами. Вот наиболее распространенные из них:

Но, во-первых, это не обязательно проблема, если есть страницы, заблокированные robots.txt. Он может быть разработан по причинам, таким как желание разработчика заблокировать ненужные страницы / страницы категорий или дубликаты. Итак, в чем расхождения?

Неверный формат URL-адреса

Иногда проблема может возникать из-за того, что URL-адрес на самом деле не является страницей. Например, если URL-адрес https://www.seoptimer.com/?s=digital+marketing, вам необходимо знать, на какую страницу он указывает.

Если это страница с важным содержанием, которое вам действительно нужно, чтобы ваши пользователи увидели, вам необходимо изменить URL-адрес. Это возможно в системах управления контентом (CMS), таких как WordPress, где вы можете редактировать ярлык страницы.

Если страница не важна, или в нашем примере /?s=digital+marketing это поисковый запрос из нашего блога, то ошибку GSC исправлять не нужно.

Не имеет значения, проиндексирован он или нет, так как это даже не настоящий URL, а поисковый запрос. Кроме того, вы можете удалить страницу.

Страницы, которые должны быть проиндексированы

Существует несколько причин, по которым страницы, которые должны быть проиндексированы, не индексируются. Вот некоторые из них:

- Вы проверили свои директивы для роботов? Возможно, вы включили в файл robots.txt директивы, запрещающие индексацию страниц, которые действительно должны быть проиндексированы, например теги и категории. Теги и категории — это фактические URL-адреса на вашем сайте.

- Вы указываете роботу Googlebot цепочку переадресации? Робот Google просматривает все ссылки, которые может найти, и делает все возможное, чтобы прочитать их для индексации.

- Правильно ли реализована каноническая ссылка? Тег canonical используется в заголовке HTML, чтобы сообщить роботу Googlebot, какая страница является предпочтительной и канонической в случае дублирования контента. Каждая страница должна иметь канонический тег. Например, у вас есть страница, переведенная на испанский язык. Вы сами сделаете каноническим URL-адрес на испанском языке и захотите вернуть страницу к английской версии по умолчанию.

Как проверить правильность файла Robots.txt в WordPress?

Для WordPress: если ваш файл robots.txt является частью установки сайта, используйте плагин Yoast для его редактирования. Если вызывающий проблемы файл robots.txt находится на другом сайте, который не принадлежит вам, вам необходимо связаться с владельцами сайта и попросить их отредактировать файл robots. txt.

txt.

Страницы, которые не следует индексировать

Существует несколько причин, по которым страницы, которые не следует индексировать, индексируются. Вот некоторые из них:

Директивы robots.txt, которые «говорят», что страницу не следует индексировать . Обратите внимание, что вам нужно разрешить сканирование страницы с директивой noindex, чтобы роботы поисковых систем «знали», что ее нельзя индексировать.

В файле robots.txt убедитесь, что:

- Строка «disallow» не следует сразу за строкой «user-agent».

- Существует не более одного блока «агент пользователя».

- Невидимые символы Unicode — вам нужно запустить файл robots.txt через текстовый редактор, который преобразует кодировки. Это удалит любые специальные символы.

Страницы, на которые есть ссылки с других сайтов . Страницы могут быть проиндексированы, если на них есть ссылки с других сайтов, даже если это запрещено в файле robots. txt. Однако в этом случае в результатах поиска отображаются только URL-адрес и текст привязки. Вот как эти URL-адреса отображаются на странице результатов поисковой системы (SERP):

txt. Однако в этом случае в результатах поиска отображаются только URL-адрес и текст привязки. Вот как эти URL-адреса отображаются на странице результатов поисковой системы (SERP):

источник изображения Веб-мастера StackExchange

Одним из способов решения проблемы блокировки robots.txt является защита паролем файлов на вашем сервере. .

Либо удалите страницы из robots.txt или используйте следующий метатег, чтобы заблокировать

их:

Старый URL-адреса

Если вы создали новый контент или новый сайт и использовали директиву noindex в файле robots.txt, чтобы убедиться, что он не проиндексирован, или недавно зарегистрировались в GSC, есть два варианта устранения заблокированного Ошибка robots.txt:

- Дайте Google время удалить старые URL из своего индекса

- 301 перенаправить старые URL-адреса на текущие

В первом случае Google в конечном итоге удаляет URL-адреса из своего индекса, если все, что они делают, — это возвращает 404 (это означает, что страницы не существуют). Не рекомендуется использовать плагины для перенаправления ошибок 404. Плагины могут вызвать проблемы, которые могут привести к тому, что GSC отправит вам предупреждение «заблокировано robots.txt».

Не рекомендуется использовать плагины для перенаправления ошибок 404. Плагины могут вызвать проблемы, которые могут привести к тому, что GSC отправит вам предупреждение «заблокировано robots.txt».

Виртуальные файлы robots.txt

Есть возможность получения уведомления, даже если у вас нет файла robots.txt. Это связано с тем, что сайты на основе CMS (Customer Management Systems), например WordPress, имеют виртуальные файлы robots.txt. Плагины также могут содержать файлы robots.txt. Это могут быть те, которые вызывают проблемы на вашем сайте.

Эти виртуальные файлы robots.txt необходимо перезаписать вашим собственным файлом robots.txt. Убедитесь, что в файле robots.txt есть директива, позволяющая всем ботам поисковых систем сканировать ваш сайт. Это единственный способ указать URL-адресам индексировать их или нет.

Вот директива, позволяющая всем ботам сканировать ваш сайт:

User-agent: *

Disallow: /

Это означает «ничего не запрещать». .

.

В заключение

Мы рассмотрели предупреждение «Проиндексировано, но заблокировано robots.txt», что оно означает, как определить затронутые страницы или URL-адреса, а также причину предупреждения. Мы также рассмотрели, как это исправить. Обратите внимание, что предупреждение не означает ошибку на вашем сайте. Однако если вы не исправите это, ваши самые важные страницы могут не индексироваться, что не очень хорошо для пользователей.

Как легко изменить или удалить robots.txt с веб-сайта

Хотите отредактировать или удалить файл robots.txt для своего веб-сайта?

Бывают случаи, когда боты поисковых систем не могут проиндексировать веб-сайт из-за неправильно настроенного файла robots.txt.

Если ваша веб-страница проиндексирована в Google и вы хотите срочно удалить ее, вам необходимо обновить/добавить файл robots.txt в корневой каталог вашего домена или поддоменов.

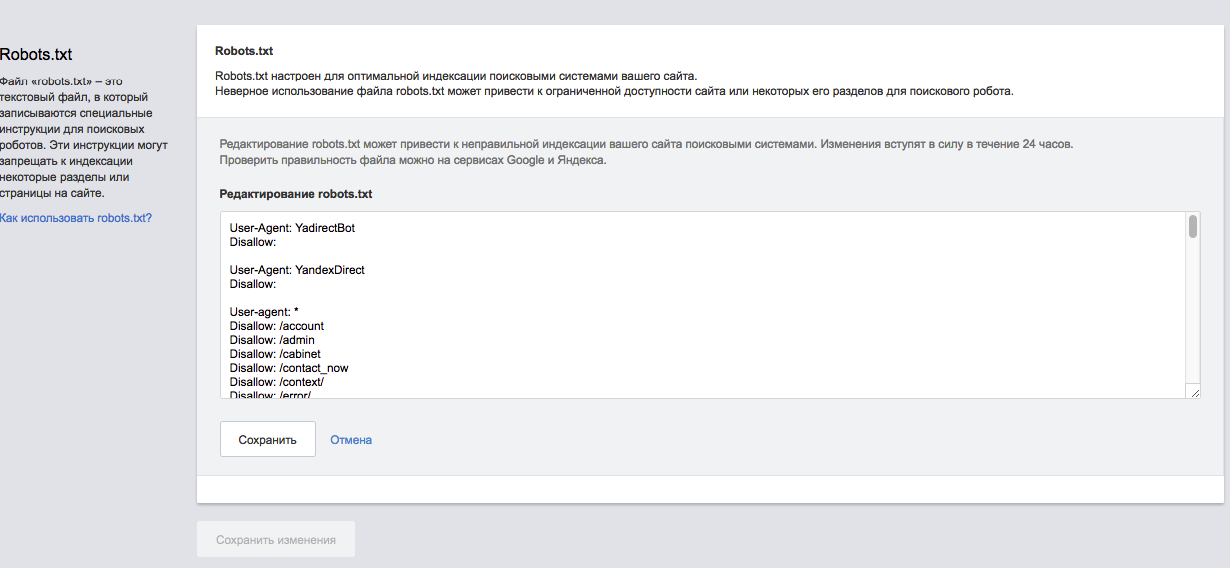

Используя robots. txt, вы можете запретить/разрешить индексацию страницы веб-сайта поисковой системой. В этом кратком руководстве я покажу вам, как отредактируйте и удалите файл robots.txt из WordPress .

txt, вы можете запретить/разрешить индексацию страницы веб-сайта поисковой системой. В этом кратком руководстве я покажу вам, как отредактируйте и удалите файл robots.txt из WordPress .

Disallow: /wp-admin/ указывает ботам не посещать вашу страницу wp-admin.

Что делает robots.txt ?Robots.txt можно использовать для управления трафиком поисковых роботов на вашем веб-сайте и предотвращения индексации определенных файлов поисковыми системами. Он также указывает местоположение карты сайта. Вы также можете использовать файл robots.txt для блокировки таких ресурсов, как неважные изображения, файлы стилей или скрипты.

Однако, если отсутствие этих ресурсов затрудняет понимание вашей веб-страницы поисковым роботом Google, вам не следует их блокировать.

All-in-One SEO (AIOSEO) — один из лучших SEO-плагинов WordPress , который можно использовать для редактирования файла robots.txt. Он дает вам контроль над вашим сайтом и настраивает файл robots.txt, который заменит файл WordPress по умолчанию.

AIOSEO — это SEO-плагин для WordPress, который поможет вам повысить рейтинг вашего сайта в поиске, чтобы вы могли развивать свой бизнес и получать максимальный трафик.

Чтобы отредактировать файл robots.txt, нажмите «Инструменты» в меню «Все в одном SEO». Затем вам нужно нажать на вкладку «Редактор Robots.txt».

AIOSEO создаст динамический файл robots.txt . Содержимое файла хранится в вашей базе данных WordPress, и вы можете просмотреть его в своем веб-браузере.

После входа в редактор Robots.txt Включить пользовательский файл Robots. txt.

txt.

После этого вы увидите раздел «Предварительный просмотр Robots.txt», в котором показаны правила WordPress по умолчанию, которые вы можете перезаписать. Правила по умолчанию предписывают ботам не сканировать ваши файлы WordPress.

Вы можете добавить свои собственные правила с помощью конструктора правил.

Конструктор правил поможет вам указать, какие страницы должны сканировать боты, а какие нет.

Например, , если вы хотите добавить правило, которое блокирует всех ботов из временного каталога, вы можете использовать для этого конструктор правил.

Чтобы добавить правило, вы должны ввести пользовательский агент в поле «Пользовательский агент». Вы можете использовать *, чтобы применить правило ко всем пользовательским агентам.

Теперь вам нужно выбрать, хотите ли вы «Запретить» или «Разрешить» поисковым системам сканировать.

После этого введите путь к каталогу или имя файла в поле «Путь к каталогу».

Правило будет автоматически применено к вашему файлу robots.txt. Нажмите кнопку « Добавить правило », чтобы добавить другое правило.

Вы можете продолжать добавлять правила, пока не создадите идеальный формат robots.txt.

Кроме того, ваши пользовательские правила будут выглядеть так.

Когда вы закончите, нажмите кнопку «Сохранить изменения».

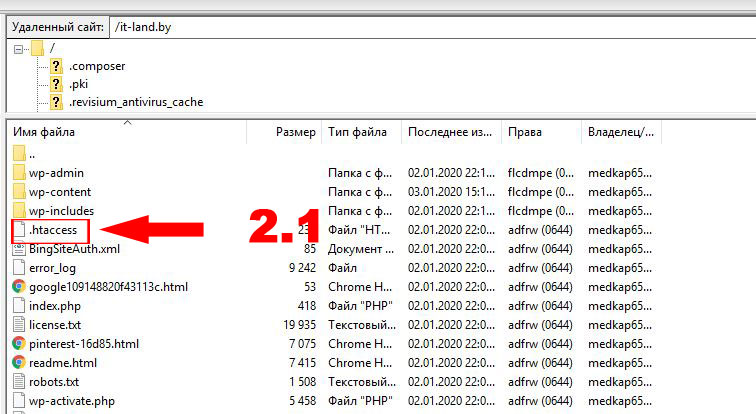

Способ 2. Редактирование файла Robots.txt вручную с помощью FTPЧтобы отредактировать файл robots.txt с помощью этого метода, используйте FTP-клиент.

Оказавшись внутри, вы увидите файл robots.txt в корневой папке вашего сайта.

Если вы этого не видите, у вас нет файла robots.txt. В этом случае вам придется создать его

. Вы можете загрузить Robots.txt на свой компьютер и отредактировать его с помощью обычного текстового редактора, такого как TextEdit или Блокнот.

После сохранения изменений загрузите их в корневую папку вашего сайта.

Чтобы удалить robots.txt с веб-сайта WordPress, следуйте этим инструкциям.

Перейдите в настройки WordPress и посмотрите, установлен ли этот флажок:

Если да, снимите его, и файл robots.txt изменится на

User-agent: *Как создать файл robots.txt, если вы хотите вернуть его после удаления?

Disallow:

Вы можете использовать SEOToolr Robot.txt Generator для создания файла робота, если хотите вернуть его после удаления.

- Выберите вариант из раскрывающегося списка и введите URL-адрес вашей карты сайта. Вы можете сделать это, вставив ссылку на карту сайта вашего сайта. Оставьте поле пустым, если у вас его нет.

- После этого введите каталог файла, который вы хотите запретить.

- Наконец, нажмите кнопку «Создать robots txt», и будет создан файл robots.txt.

Рекомендовано использовать в том случае, если страницы блога содержат ref-ссылки, идентификаторы сессий, UTM-метки или другие GET-параметры. Записывается в виде:

Рекомендовано использовать в том случае, если страницы блога содержат ref-ссылки, идентификаторы сессий, UTM-метки или другие GET-параметры. Записывается в виде: