Как убрать страницы из индекса Google и Яндекс

Бывает ситуации, когда нужно не быстро проиндексировать страницы, а убрать их с результатов поиска.

Например, когда вы купили доменное имя, и создаете на нем совершенно новый сайт, который никак не связан с предыдущим. Или в индекс попали страницы, которые там не должны быть. Или вы просто решили закрыть раздел на сайте, который больше не актуален.

Сегодня речь про то, как убрать страницы из индекса поисковых систем Google и Яндекс.

Мы детально рассмотрим основные способы, с помощью которых можно быстро убрать страницы из результатов поиска.

Давайте сразу перейдем к делу!

Способы убрать страницы из индекса поисковых систем:

1. Удаление в инструментах Вебмастеров

Самым простым вариантом удаления страниц из индекса является удаление через Google Webmaster Tools и Яндекс Вебмастер.

Удаление страниц из поиска Google

Заходим в:

— индекс Google

— удалить URL адреса

Далее нажимаем «создать новый запрос на удаление» и добавляем в него нужный адрес URL, который удаляем.

После чего отправляем запрос на удаление страницы.

Далее URL страницы вноситься в список удаляемых, и переходит в статус ожидания.

Сразу возникает вопрос, а сколько ждать?

Удаление страниц происходит очень быстро. Вот тот же сайт, через 8 часов, после добавления:

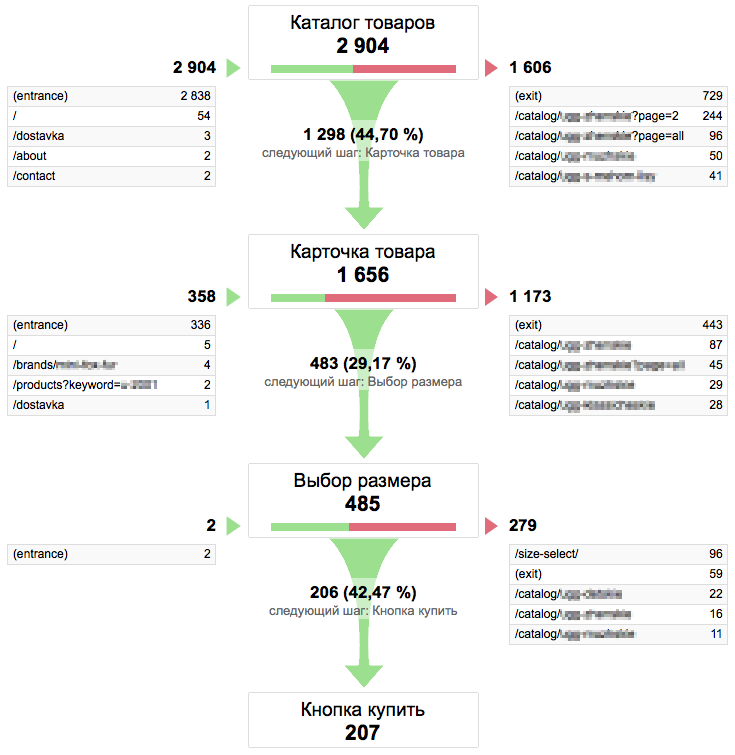

Даже при не малом объеме страниц, можно убрать их из индекса крайне быстро. Например, тот же сайт, немногим ранее:

То есть было более 1200 страниц, потом стало пару десятков. А сейчас осталась практически одна главная страница.

Удаление страниц из поиска Яндекса

Переходим по ссылке: http://webmaster.yandex.ua/delurl.xml

Добавляем нужный адрес страницы, который необходимо удалить.

В итоге можем получить такой ответ:

То есть, все равно придётся сделать ниже описанные моменты, которые ускорят процесс удаления страниц из индекса Яндекса.

2. Robots.txt

Файл robots.txt очень нужный инструмент, если дело идет к разрешению или запрещению индексации сайта от поисковых ботов.Для того, чтобы удалить конкретные страницы с помощью robots.txt, то в сам файл дописываем такое:

За не индексацию или исключение страниц или разделов отвечает функция: «Disallow:».

Можно закрывать от индексации, как отдельные страницы, так и целые разделы сайта. То есть то, что вы не хотите индексировать поисковыми системами. Robots.txt учитывается Google и Яндекс.

Например – закрытие раздела:

User-Agent: *

Disallow: /razdel

Закрытие страницы:

User-Agent: *

Disallow: /stranica1.html

Закрытие страниц поиска:

User-Agent: *

Disallow: /seoprofy.ua/?s*

Про robots.txt скоро будет очень объемный пост с многими техническими моментами, которые как минимум стоит знать и применять для решения задач сайтов.

3. 404 ошибка

Так же важно создать страницу 404 ошибки, чтобы сервер отдавал 404. Тогда при очередной индексации сайта поисковыми ботами они выкинут эти страницы из индекса.

Ответ сервера 404 ошибки создается по умолчанию, так как если ее не делать, на сайте может быть множество дубликатов страниц, которые плохо повлияют на рост трафика.

Хочу заметить, что удаление страниц из индекса таким способом может занять время, так как нужно дождаться ботов поисковых систем.

Это основные моменты, которые могут повлиять на удаление страниц из индекса поисковых систем.

В практике очень редко использует другое, как:

— 301 редирект

— мета тег robots

— X-robots-Tag

Но чтобы убрать нужные страницы из индекса наверняка, то лучше использовать все 3 выше описанные методы. Тогда это будет на порядок быстрее.

Так же можно просто удалить страницы и оставить лишь заглушку сайта, но не факт, что страницы пропадут из индекса очень быстро, поэтому лучше им в этом помочь.

Статьи которые дополняют:

— 5 способов удалить страницу из поиска Яндекса или Google

— Как использовать robots.txt рекомендации Яндекса

— Окончательное удаление страницы из индекса Google

А какие способы вы еще знаете, чтобы быстро удалить страницы из поиска?

Оцените статью

seoprofy.ua

как легко удалить страницу из индекса Яндекса

Есть проблемы с ранжированием, проект не растет, хотите проверить работу своих специалистов по продвижению? Закажите профессиональный аудит в Семантике

Мы выпустили новую книгу «Контент-маркетинг в социальных сетях: Как засесть в голову подписчиков и влюбить их в свой бренд».

Подпишись на рассылку и получи книгу в подарок!

Часто при создании и функционировании сайта возникают страницы удаленные или с изменившимися адресами. Проблема в том, что если до удаления поисковик успел их проиндексировать, при запросе система выдаст пользователю всю информацию, содержащуюся на странице. Или страницы служебные становятся достоянием общественности — а ведь на них может быть расположена информация, не предназначенная для чужих глаз. Так как же избежать подобной неприятности, как удалить страницу в Google и других поисковиках и сделать видимое невидимым?

Казусы с устаревшими страницами встречаются в сети сплошь и рядом. Поиск может выдать личную информацию клиентов, все их заказы в подробностях. Ведь сплошь и рядом нас просят заполнить формы с очень личной информацией, которая должна быть скрыта ото всех. Как избежать подобных ошибок мы и расскажем в этой статье.

Причины, по которым поисковики выводят нас на несуществующие страницы

Самая распространенная причина — страница удалена, не существует. И веб-мастер забыл убрать ее из индекса Яндекса (или других ПС) или сайт поддерживает новичок, который просто не знает, как удалить страницу в поисковике. Или вследствие редактирования сайта вручную страница стала недоступна. Этим часто грешат начинающие администраторы веб-сайтов, относясь пренебрежительно к работе своего ресурса.

Продолжим разговор о структуре сайта. Часто системы управления контентом (так называемые CMS) изначально настроены не оптимально. Например, при установке сайта на хостинг широко известного блогового движка WordPress, ресурс не удовлетворяет требованиям оптимизации, так как url состоит из цифровых и буквенных идентификаторов. Веб-мастеру приходится вносить изменения в структуру страниц на ЧПУ, вследствие чего может появиться множество нерабочих адресов, на которые и будет выводить поисковик при запросе.

Поэтому не забывайте отслеживать изменившиеся адреса и используйте редирект 301, который будет направлять запросы со старого адреса на новые. В идеале все настройки сайта должны быть завершены до его открытия. А здесь поможет локальный сервер.

Причины появления в индексе, казалось бы, удаленных страниц

Иногда вам кажется, что все ненужные или лишние страницы закрыты от посторонних глаз, но они тем не менее отлично отслеживаются поисковиками без каких-либо ограничений. Возможно, это при:

- неправильном написании файла robots.txt;

- администратор слишком поздно удалил лишние страницы из индекса — поисковики уже успели их проиндексировать;

- если сторонние сайты или другие страницы этого же сайта ссылаются на страницы с адресами до их изменения веб-мастером.

Итак, казусов может быть великое множество. Рассмотрим варианты решения проблемы.

Как удалить страницу из индекса Яндекса и других поисковиков

- robots.txt

Любимый многими способ удаления страниц из индекса — применение файла robots.txt. Написано множество опусов на тему правильной настройки этого файла. Переписывать их здесь не будем, но этот файл поможет удобно скрыть от поиска целый раздел сайта или отдельный файл.

Этот способ также требует ожидания — пока робот поисковика прочтет файл и вычеркнет страницу, раздел из поиска. Как уже говорилось ранее, наличие внешних ссылок на закрытые страницы делают их доступными для просмотра, будьте внимательны. - Мета-тег robots

Этот тэг задается в самом HTML — коде страницы. Метод удобен своей простотой. Рекомендую начинающим веб-мастерам, создающим свой сайт страничку за страничкой. Тэг с легкостью добавляется на все необходимые страницы, содержимое которых необходимо скрыть от посторонних глаз. При этом не засоряется излишними указаниями файл robots.txt, оставаясь простым и понятным. У этого способа удаления из видимости поисковиков есть один недостаток — сложность применения к динамическому сайту. Подобные ресурсы, благодаря шаблонному подключению модулей, могут закрыть все страницы ресурса вместо нескольких выбранных — здесь надо быть внимательным! - X-Robots-Tag

Метод пока что годится только для зарубежных поисковых систем, таких как Google. Яндекс этот тэг пока что не поддерживает, может быть в будущем что-то изменится. Очень похож на мета-тег robots, основное его отличие его то, что пишем тэг в самих http-заголовках, скрытых в коде страницы. Иногда использование данного способа очень удобно, но не забывайте что страницы закрываются только частично. Поисковик Яндекса будет по прежнему их находить без проблем. Этим приемом частенько пользуются мастера «черного SEO», скрывающие от поисковиков страницы со ссылками.

Как удалить страницу в поисковике Google и Yandex

- 404 ошибка. Простейший способ удалить страницы из индекса поисковиков — это фактически удалить ее и применить правило, чтобы по этому адресу сервер выдавал ошибку 404, извещающая нас что запрашиваемая страница не существует. Большинство CMS, не исключение и WordPress, при удалении страницы корректно сообщают роботу что документ отсутствует и необходимо его выкинуть из индекса поисковика.

Однако код 404 начнет действовать только после посещения ресурса роботом. Все зависит от того, когда страница была проиндексирована, это может иногда занимать довольно значительное время.

Этот метод не подходит, если страница еще нужна для работы сайта, к примеру, это служебная информация. Рекомендую использовать приведенные ниже способы. - Ручное удаление. Надежный, быстрый и простой способ, а вместе с тем всем доступный — это ручной. Ссылки для веб-мастеров, по которым можно удалить страницы из Яндекса и Google:

Только здесь есть условие — для работы этого метода нужные страницы должны быть предварительно закрыты от робота любым из уже перечисленных выше способов. Если ресурс большой, то этот метод недостаточно быстр по исполнению. Придется удалять каждую страницу в отдельности. Зато он прост и понятен даже новичкам. Из практики Google затрачивает на обработку запроса несколько часов, Яндекс действует чуть помедленнее, придется ждать обновления. И все же, если сравнивать с предыдущими методами удаления страниц в поисковике — этот самый быстрый.

Правильно составленная структура сайта облегчает его работу, улучшает видимость для поисковых систем и составляет о сайте положительное впечатление у его посетителей. Ведь что может быть важнее для ресурса, чем репутация и доверие к нему.

semantica.in

Как быстро удалить страницы сайта из индекса поисковых систем

🔋 В телеграме @sosnovskij я публикую посты, которых нет в блоге. Подпишись, чтобы не пропустить ничего интересного 💪. Например, недавно я рассказал историю про покупку домена за 35К и его продажу за 215К.Привет, друзья! Надеюсь, что вы отлично отдохнули на майские праздники: наездились на природу, наелись шашлык и нагулялись по расцветающей природе. Теперь же нужно возвращаться к активной работе =) .

Сегодня я покажу результаты одного небольшого эксперимента по удалению всех страниц сайта из поисковых систем Яндекса и Google. Его выводы помогут при выборе одного из методов для запрета индексирования всего ресурса или отдельных его частей.

Передо мной встала задача — закрыть сайт к индексированию без потери его функционала. То есть ресурс должен работать, но удалиться из индекса поисковых систем. Конечно, самый верный способ просто удалить проект с хостинга. Документы будут отдавать 404-ошибку и со временем «уйдут» из базы поисковиков. Но задача у меня была другая.

Детали эксперимента

Цели:

- определить, какой метод запрета индексации приоритетней для поисковых систем;

- понаблюдать в динамике за скоростью удаления страниц из индекса;

- собственно, удалить проекты из баз ПС.

В эксперименте участвовало 2 сайта (всем больше года). Первый: в индексе Яндекса 3000 страниц, Google — 2090. Второй: Яндекс — 734, Google — 733. Если не удалять ресурс с хостинга, то остаются 2 популярных варианта: тег meta name=»robots» и запрет в robots.txt.

Для первого сайта на каждой странице была добавлена строка:

<meta name=»robots» content=»noindex, nofollow»/>

Для второго был составлен следующий robots.txt:

User-agent: *

Disallow: /

Эксперимент стартовал 14 декабря и продолжился до 9 мая. Данные снимались примерно на даты апдейтов Яндекса.

Результаты

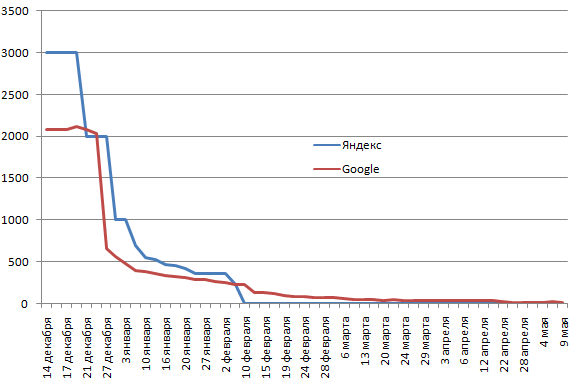

Ниже графики динамики количества проиндексированных страниц. Сначала сайт №1 (метод удаления тег meta name=»robots»).

Как видно, поисковые системы вели себя примерно по одному сценарию. Но есть и различия. В Яндексе ресурс был полностью удален 10 февраля, когда в Google оставалось еще 224 страницы. Что говорить, спустя 5 месяцев там еще остается 2 десятка документов. Гугл очень трепетно относится к проиндексированным страницам и не хочет никак их отпускать  .

.

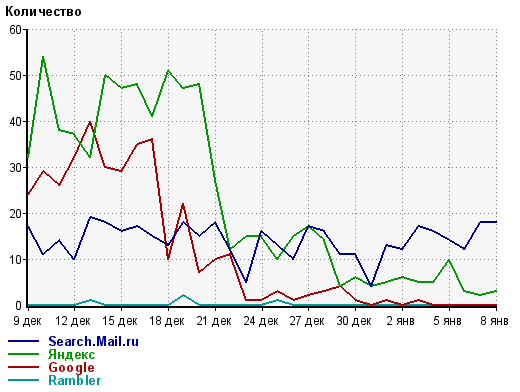

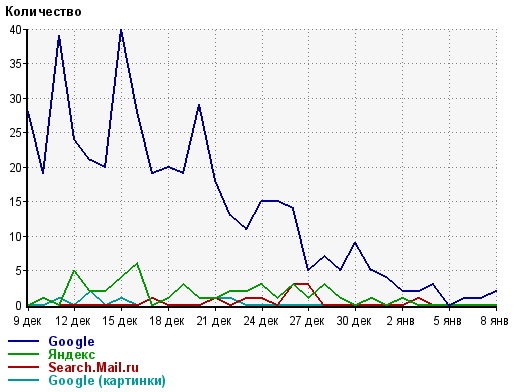

Сайт №2 (способ запрета файл — robots.txt).

Здесь ситуация разворачивалась интереснее  . Яндекс достаточно быстро (меньше чем за месяц) удалил все страницы. Гугл же за месяц выкинул из индекса около 100 документов, потом через месяц еще 200 и практически застыл на месте.

. Яндекс достаточно быстро (меньше чем за месяц) удалил все страницы. Гугл же за месяц выкинул из индекса около 100 документов, потом через месяц еще 200 и практически застыл на месте.

4 апреля мне надоело ждать и я поменял метод запрета с robots.txt на meta name=»robots». Это принесло свои плоды — через месяц в базе Google осталось только 160 страниц. Примерно такое же количество остается и по сей день.

Примечателен еще один момент. Несмотря на то, что страницы из индекса удалялись достаточно долго, трафик с поисковиков начал падать значительно быстрее.

Получается, что ПС понимают, что вебмастер запретил ресурс или его документы к индексированию, но почему-то продолжают их там держать  .

.

Выводы

- Яндекс любит больше работу с robots.txt;

- Google любит больше работу с meta name=»robots». В связи с тем, что Гугл крайне не любит robots.txt, то универсальным будет именно способ с тегом. Совмещать методы нельзя, потому как, запретив ресурс в robots.txt, поисковый паук не сможет прочитать правила для meta name=»robots».

- Зеркало Рунета достаточно быстро удаляет документы при любом методе. Зарубежный поисковик делает это неохотно — очень тяжело добиться полного удаления из базы.

Вот такой получился небольшой эксперимент. Да, конечно, выборка совсем небольшая, но и она смогла подтвердить мои предположения. В прикладном плане это можно использовать, когда есть необходимость закрыть определенные документы для индексирования: предпочтительно использовать meta name=»robots» вместо директив в robots.txt.

А какие наблюдения по этой теме есть у вас? Поделитесь своим опытом в комментариях  !

!

sosnovskij.ru

Как удалить страницу из Яндекса или Google поиска? 5 способов

Удаление документа из поисковиков

Обычно при поисковом продвижении сайта все стараются как можно быстрее «загнать» документ в индекс поисковика. Но бывает и так, что в поиске оказывается совсем не нужная страница. Например, с какими-либо конфиденциальными данными или с устаревшим содержанием.

Кроме того, если при создании сайта вы не настроили файл Роботс.тхт, то в поиске Гугла, Yandex и других ПС могут оказаться страницы-дубли. Особенно характерно это для блогов на WordPress. Данная CMS традиционно создаёт множество документов с идентичным контентом.

Если «нехорошие» страницы попали в поисковую выдачу, то нужно произвести их удаление. На данный момент сделать это можно 5-ю способами, причём 5-й не подействует без первых 4-х.

Как удалить страницу из Яндекса

1-й способ — сделать так, чтобы данной страницы вообще не было на сайте. Тогда поисковик, при последующем к ней обращении, выкинет её из своего индекса.

Это просто осуществить, если страницы физические, а не динамические. Если они динамические (т.е. генерируются сервером — как на большинстве современных движков), то фактически их нет, поэтому и удалять нечего. В данном случае необходимо, чтобы при обращении к этой странице сервер выдавал бы т.н. код 404 (Not Found):

HTTP/xx 404 Not Found

Большинство современных CMS (в том числе, и WordPress) делают это корректно для удалённых страниц.

Такой код сообщает поисковому роботу, что документ отсутствует и надо выкинуть его из индекса.

Стоит сразу добавить, что удаляются страницы из Яндекса не так быстро, как хотелось бы. Обычно происходит это за 1 и более обновлений выдачи. Нужно подождать.

2-й способ — обнаружив, что ненужные документы попали в SERP, необходимо проверить файл Robots.txt и запретить эти документы к индексации (директивой Disallow или Clean-param). Со временем ПС удалит их из поиска.

3-й способ — добавить в код «нежелательных» документов мета-тег Robots. Как это делать почитайте в статье про meta name robots.

Как удалить страницу из индекса Гугла

Для Google подходят все 3 вышеперечисленных способа.

4-й способ — дополнительно для данного поисковика можно использовать специальный HTTP-заголовок X-Robots-Tag. Суть этого метода в том, что в HTML-коде документа нет следов о том, что изменён характер его обхода поисковым роботом.

X-Robots-Tag представляет из себя обычный заголовок, который на PHP можно задать так (в данной статье не буду подробно расписывать про этот метод):

— такая запись аналогична простановке в HTML-коде документа мета-тега meta name=»robots» content=»noindex,nofollow».

Обратите внимание, что этот приём действует только для Гугла (возможно, ещё Bing и кого-то ещё). Удалить страницу из Яндекса таким способом не получится!

Ну и 5-й способ — исключение страниц из поиска Yandex b Google через специальные сервисы самих ПС.

Только что «свалилось» видео по теме от Гугла (25 июня):

Для Яндекс — можно перейти по этому адресу http://webmaster.yandex.ru/delurl.xml и ввести нужный URL.Как я и писал выше, данный способ подействует лишь при выполнении одного из 4-х условий, указанных выше. Иначе конкуренты удаляли бы страницы сайтов друг друга:

Не удаляется

В Google аналогичная операция производится в аккаунте вебмастера — https://www.google.com/webmasters/tools/. Для этого слева выбираем «Оптимизация — Удалить Url-адреса«:

Исключение URL из Гугла

и создаём новый запрос:

Запрос на удаление URL из Google

Удаление ссылок из индекса Гугла происходит гораздо быстрее, нежели из Яндекса. Там обычно всё быстрее.. Можно ознакомиться также с официальным руководством о продвижении сайта в Google.

Ну а вообще, чтобы не приходилось проделывать все эти действия, лучше сразу продумать, какие разделы и отдельные страницы сайта закрыть от индексации, а какие — оставить роботам.

Loading…

Loading…

web-ru.net

Как удалить страницу из поиска Яндекса

Автор Алексей На чтение 4 мин. Опубликовано

Иногда из результатов поиска нужно убрать страницу сайта, например, если она содержит конфиденциальную информацию, является дублем другой страницы или была удалена.

Сообщите Яндексу о том, что страницу нужно удалить

Сделать это можно несколькими способами:

Если страница удалена с сайта

- Запретите индексирование страницы с помощью директивы Disallow в файле robots.txt.

Настройте сервер так, чтобы при обращении робота к адресу страницы он отправлял HTTP-статус с кодом 404 Not Found, 403 Forbidden или 410 Gone.

Если страница не должна отображаться в поиске

- Запретите индексирование страницы с помощью директивы Disallow в файле robots.txt.

- Закройте страницы от индексирования с помощью мета-тега noindex.

Если вы настроили ответ сервера на код 4XX или использовали мета-тег noindex для множества страниц, робот узнает об изменении каждой страницы постепенно. В этом случае запретите индексирование страниц с помощью директивы Disallow.

Когда робот Яндекса посетит сайт и узнает о запрете на индексирование, страница пропадет из результатов поиска в течение недели. После этого адрес удаленной страницы отобразится в списке исключенных в разделе Индексирование → Страницы в поиске Яндекс.Вебмастера.

В течение некоторого времени робот еще будет посещать страницу, чтобы убедиться, что ее статус не изменился. Если страница остается недоступной, она пропадет из базы робота.

Страница может снова появиться в результатах поиска, если вы уберете запрет на индексирование в файле robots.txt или ответ сервера изменится на 200 OK.

Если страница удалена с сайта из-за нарушения авторских прав, порядок удаления ее из результатов поиска не меняется и не является приоритетным.

Ускорьте удаление страницы из поиска

Если после того, как вы запретили индексирование станиц, робот еще не посетил ваш сайт, вы можете сообщить Яндексу о необходимости убрать страницу с помощью инструмента «Удаление страниц из поиска» в Яндекс.Вебмастере.

Удалить отдельные страницы сайта из поиска Яндекса

Если ваш сайт не добавлен в Яндекс.Вебмастер:

- Перейдите на страницу Яндекс Вебмастера Удаление страниц из поиска.

- В поле введите адрес страницы, например http://ururu.com/ololo.html.

- Нажмите кнопку Удалить.

Чтобы убрать из поиска несколько страниц, удалите адрес каждой страницы последовательно.

Если ваш сайт добавлен и подтвержден в Яндекс.Вебмастере:

- Перейдите на страницу Инструменты → Удаление страниц из поиска.

- Установите переключатель в положение По URL.

- В поле введите адрес страницы, например http://ururu.com/ololo.html.

- Нажмите кнопку Удалить.

Вы можете указать до 500 адресов одного сайта в сутки.

Удалить отдельные страницы сайта из поиска Яндекса

Вы можете удалить каталог, все страницы сайта или страницы с параметрами в URL. Для этого добавьте и подтвердите сайт в Яндекс.Вебмастере.

В Яндекс.Вебмастере перейдите на страницу Инструменты → Удаление страниц из поиска.

Проверьте, что в файле robots.txt указана директива Disallow для страниц, которые нужно удалить. Если в robots.txt робот найдет другие директивы для указанных в Яндекс.Вебмастере страниц, то не смотря на них, удалит страницы из поиска.

Вы можете удалить каталог, все страницы сайта или страницы с параметрами в URL. Для этого добавьте и подтвердите сайт в Яндекс.Вебмастере.

В Яндекс.Вебмастере перейдите на страницу Инструменты → Удаление страниц из поиска.

Проверьте, что в файле robots.txt указана директива Disallow для страниц, которые нужно удалить. Если в robots.txt робот найдет другие директивы для указанных в Яндекс.Вебмастере страниц, то не смотря на них, удалит страницы из поиска.

- Установите переключатель в положение По префиксу.

- Укажите префикс:

Что удалить Пример Каталог сайта http://example.com/catalogue/ Все страницы сайта http://example.com/ URL с параметрами http://example.com/page?

Можно отправить до 20 указаний для одного сайта в сутки.

- Нажмите кнопку Удалить.

Статусы после отправки URL

Статус Описание «В очереди на удаление» Робот проверяет ответ сервера и наличие запрета на индексирование страницы в файле robots.txt. Проверка может занимать несколько минут. «Удалена» В течение часа после проверки страница будет удалена из результатов поиска. «Отклонено» - В файле robots.txt отсутствует запрет на индексирование.

- При обращении к адресу страницы ответ сервера отличается от 404 Not Found, 403 Forbidden или 410 Gone.

Как вернуть страницу в результаты поиска

Уберите запрещающие индексирование директивы: в файле robots.txt или мета-тег noindex. Страницы вернуться в результаты поиска, когда робот обойдет сайт и узнает об изменениях. Это может занять до трех недель.

webmaster-seo.ru

5 способов удалить страницу из поиска Яндекса или Google — Devaka SEO Блог

Многие вебмастера рано или поздно сталкиваются с необходимостью удалить из поисковой системы страницы сайта, которые попали туда по ошибке, перестали быть актуальными, являются дублями или содержат конфиденциальную информацию клиентов (причины могут быть разные). Яркий пример тому уже нашумевшая ситуация с Мегафоном, смс-ки пользователей которого проиндексировал Яндекс, ситуация с интернет-магазинами, когда в поиске можно было найти личную информацию клиентов и подробности их заказов, ситуация с банками и транспортными компаниями и так далее…

Не будем касаться в этой статье причин описанных выше казусов, а рассмотрим, как удалить из Яндекса или Google ненужные страницы. Подразумевается, что они пренадлежат вашему сайту, в противном случае необходимо связываться с владельцем нужного ресурса с соответствующей просьбой.

5 способов удаления страниц из поисковых результатов

1. 404 ошибка

Один из простых способов удаления страницы из поиска это удаление её со своего сайта, с условием, что в дальнейшем, при обращении по старому адресу, сервер выдавал 404-ую ошибку, означающую, что страницы не существует.

HTTP/1.1 404 Not Found

В данном случае придётся подождать, пока робот ещё раз не зайдёт на страницу. Иногда это занимает значительное время, в зависимости от того, как она попала в индекс.

Если страница при удалении её из поиска должна существовать на сайте, то данный способ не подходит, лучше использовать другие, представленные ниже.

2. Файл robots.txt

Очень популярный метод закрыть от индексации целые разделы или отдельные страницы это использование корневого файла robots.txt. Существует множество мануалов, как правильно настроить этот файл. Здесь приведём лишь несколько примеров.

Закрыть раздел администраторской панели от попадания её в индекс поисковиков:

User-Agent: *

Disallow: /admin/

Закрыть определенную страницу от индексации:

User-Agent: *

Disallow: /my_emails.html # закрытие страницы my_emails.html

Disallow: /search.php?q=* # закрытие страниц поиска

В случае с robots.txt тоже придётся ждать переиндексации, пока робот не выкинет из индекса страницу или целый раздел. При этом, некоторые страницы могут остаться в индексе, если причиной их попадания туда было несколько внешних ссылок.

Данный метод неудобно использовать в случае необходимости удаления разных страниц из разных разделов, если невозможно составить общий шаблон для директивы Disallow в robots.txt.

3. Мета-тег robots

Это альтернатива предыдущего метода, только правило задаётся непосредственно в HTML-коде страницы, между тегами <head>.

<meta name="robots" content="noindex,nofollow" />

Удобство мета-тега в том, что его можно добавить на все нужные страницы (с помощью системы управления), попадание которых нежелательно в индекс поисковика, оставляя файл robots.txt при этом простым и понятным. Недостаток данного метода лишь в том, что его сложно внедрить для динамического сайта, использующего один шаблон header.tpl, если отсутствуют специальные навыки.

4. Заголовки X-Robots-Tag

Данный метод используют зарубежные поисковые системы, в том числе Google, как альтернативу предыдущему методу. У Яндекса пока нет официальной информации о поддержке этого http-заголовка, но возможно, в ближайшее время будет.

Суть его использования очень похожа на мета-тег robots, за исключением того, что запись должна находиться в http-заголовках, которые не видны в коде страницы.

X-Robots-Tag: noindex, nofollow

В некоторых, часто неэтичных, случаях его использование очень удобно (например, при обмене ссылками и скрытии страницы линкопомойки).

5. Ручное удаление из панели для вебмастеров

Наконец последний, и самый быстрый способ удаления страниц из индекса – это их ручное удаление.

Яндекс: http://webmaster.yandex.ru/delurl.xml

Google: https://www.google.com/webmasters/tools/

Единственное условие для ручного удаления страниц – они должны быть закрыты от робота предыдущими методами (в robots.txt, мета-теге или 404-ой ошибкой). Замечено, что Google обрабатывает запросы на удаление в течение нескольких часов, в Яндексе придётся подождать следующего апдейта. Используйте этот метод, если вам надо срочно удалить небольшое количество страниц из поиска.

Полезные ссылки по теме

5 советов по созданию практичной 404 страницы

Улучшение юзабилити 404-ых страниц уменьшает показатель отказов. В статье приведены несколько советов, которые помогут сделать 404-ую страницу более эффективной.

Всё о файле robots.txt

Для тех, кто ещё не сталкивался с настройкой файла robots.txt, данный ресурс будет полезной отправной точкой. Здесь собрано много примеров и другой полезной информации.

Яндекс: Использование robots.txt

Официальные примеры использования файла robots.txt от Яндекса. Также там представлены учитываемые Яндексом директивы и другие советы.

Использование HTTP заголовков X-Robots для скрытого удаления линкопомоек

Пример использования HTTP-заголовка X-Robots-Tag в Apache.

devaka.ru

Как удалить не нужную страницу из индекса Яндекс.

Бывает такая ситуация, что вы опубликовали какую-то страницу на сайте, но вам бы не хотелось, чтобы эта страница была в индексе поисковых систем.

Конечно, идеальная ситуация, чтобы этого не произошло, страницу, перед ее публикацией, следует указать в файле robots.txt. Но, если страница все-таки попала в индекс, есть способ ее убрать оттуда. Давайте посмотрим, как это можно сделать.

У Яндекса есть специальный инструмент, который называется «Удалить URL». Он не требует ввода логина и пароля.

Вот ссылка на эту страницу.

http://www.webmaster.yandex.ru/delurl.xml

Все, что нужно сделать – это вписать url-адрес той страницы, которую нужно удалить из индекса.

Но, здесь есть важное ограничение: чтобы страница удалилась, должны выполняться следующие условия:

1) url-адрес страницы должен быть прописан в файле robots.txt.

2) страница должна быть в индексе поисковой системы.

Если бы этих условий не было, любой человек мог бы удалить страницы вашего сайта из индекса. Пользуйтесь этим инструментом, чтобы удалять нежелательные для поисковых систем страницы вашего сайта.

Кстати, если хотите узнать конверсии и ключевые показатели (KPI) для вашего продающего сайта, могу настроить веб-аналитику.

Яндекс Метрика и Google Analytics. Цели, события, отчеты.

Подробнее здесь. Обращайтесь.

webgyry.info

Любимый многими способ удаления страниц из индекса — применение файла robots.txt. Написано множество опусов на тему правильной настройки этого файла. Переписывать их здесь не будем, но этот файл поможет удобно скрыть от поиска целый раздел сайта или отдельный файл.

Этот тэг задается в самом HTML — коде страницы. Метод удобен своей простотой. Рекомендую начинающим веб-мастерам, создающим свой сайт страничку за страничкой. Тэг с легкостью добавляется на все необходимые страницы, содержимое которых необходимо скрыть от посторонних глаз. При этом не засоряется излишними указаниями файл robots.txt, оставаясь простым и понятным. У этого способа удаления из видимости поисковиков есть один недостаток — сложность применения к динамическому сайту. Подобные ресурсы, благодаря шаблонному подключению модулей, могут закрыть все страницы ресурса вместо нескольких выбранных — здесь надо быть внимательным!

Метод пока что годится только для зарубежных поисковых систем, таких как Google. Яндекс этот тэг пока что не поддерживает, может быть в будущем что-то изменится. Очень похож на мета-тег robots, основное его отличие его то, что пишем тэг в самих http-заголовках, скрытых в коде страницы. Иногда использование данного способа очень удобно, но не забывайте что страницы закрываются только частично. Поисковик Яндекса будет по прежнему их находить без проблем. Этим приемом частенько пользуются мастера «черного SEO», скрывающие от поисковиков страницы со ссылками.

Как удалить страницу в поисковике Google и Yandex

- 404 ошибка. Простейший способ удалить страницы из индекса поисковиков — это фактически удалить ее и применить правило, чтобы по этому адресу сервер выдавал ошибку 404, извещающая нас что запрашиваемая страница не существует. Большинство CMS, не исключение и WordPress, при удалении страницы корректно сообщают роботу что документ отсутствует и необходимо его выкинуть из индекса поисковика.

Однако код 404 начнет действовать только после посещения ресурса роботом. Все зависит от того, когда страница была проиндексирована, это может иногда занимать довольно значительное время.

Этот метод не подходит, если страница еще нужна для работы сайта, к примеру, это служебная информация. Рекомендую использовать приведенные ниже способы. - Ручное удаление. Надежный, быстрый и простой способ, а вместе с тем всем доступный — это ручной. Ссылки для веб-мастеров, по которым можно удалить страницы из Яндекса и Google:

Только здесь есть условие — для работы этого метода нужные страницы должны быть предварительно закрыты от робота любым из уже перечисленных выше способов. Если ресурс большой, то этот метод недостаточно быстр по исполнению. Придется удалять каждую страницу в отдельности. Зато он прост и понятен даже новичкам. Из практики Google затрачивает на обработку запроса несколько часов, Яндекс действует чуть помедленнее, придется ждать обновления. И все же, если сравнивать с предыдущими методами удаления страниц в поисковике — этот самый быстрый.

Правильно составленная структура сайта облегчает его работу, улучшает видимость для поисковых систем и составляет о сайте положительное впечатление у его посетителей. Ведь что может быть важнее для ресурса, чем репутация и доверие к нему.

semantica.in

Как быстро удалить страницы сайта из индекса поисковых систем

🔋 В телеграме @sosnovskij я публикую посты, которых нет в блоге. Подпишись, чтобы не пропустить ничего интересного 💪. Например, недавно я рассказал историю про покупку домена за 35К и его продажу за 215К.Привет, друзья! Надеюсь, что вы отлично отдохнули на майские праздники: наездились на природу, наелись шашлык и нагулялись по расцветающей природе. Теперь же нужно возвращаться к активной работе =) .

Сегодня я покажу результаты одного небольшого эксперимента по удалению всех страниц сайта из поисковых систем Яндекса и Google. Его выводы помогут при выборе одного из методов для запрета индексирования всего ресурса или отдельных его частей.

Передо мной встала задача — закрыть сайт к индексированию без потери его функционала. То есть ресурс должен работать, но удалиться из индекса поисковых систем. Конечно, самый верный способ просто удалить проект с хостинга. Документы будут отдавать 404-ошибку и со временем «уйдут» из базы поисковиков. Но задача у меня была другая.

Детали эксперимента

Цели:

- определить, какой метод запрета индексации приоритетней для поисковых систем;

- понаблюдать в динамике за скоростью удаления страниц из индекса;

- собственно, удалить проекты из баз ПС.

В эксперименте участвовало 2 сайта (всем больше года). Первый: в индексе Яндекса 3000 страниц, Google — 2090. Второй: Яндекс — 734, Google — 733. Если не удалять ресурс с хостинга, то остаются 2 популярных варианта: тег meta name=»robots» и запрет в robots.txt.

Для первого сайта на каждой странице была добавлена строка:

<meta name=»robots» content=»noindex, nofollow»/>

Для второго был составлен следующий robots.txt:

User-agent: *

Disallow: /

Эксперимент стартовал 14 декабря и продолжился до 9 мая. Данные снимались примерно на даты апдейтов Яндекса.

Результаты

Ниже графики динамики количества проиндексированных страниц. Сначала сайт №1 (метод удаления тег meta name=»robots»).

Как видно, поисковые системы вели себя примерно по одному сценарию. Но есть и различия. В Яндексе ресурс был полностью удален 10 февраля, когда в Google оставалось еще 224 страницы. Что говорить, спустя 5 месяцев там еще остается 2 десятка документов. Гугл очень трепетно относится к проиндексированным страницам и не хочет никак их отпускать ![]() .

.

Сайт №2 (способ запрета файл — robots.txt).

Здесь ситуация разворачивалась интереснее ![]() . Яндекс достаточно быстро (меньше чем за месяц) удалил все страницы. Гугл же за месяц выкинул из индекса около 100 документов, потом через месяц еще 200 и практически застыл на месте.

. Яндекс достаточно быстро (меньше чем за месяц) удалил все страницы. Гугл же за месяц выкинул из индекса около 100 документов, потом через месяц еще 200 и практически застыл на месте.

4 апреля мне надоело ждать и я поменял метод запрета с robots.txt на meta name=»robots». Это принесло свои плоды — через месяц в базе Google осталось только 160 страниц. Примерно такое же количество остается и по сей день.

Примечателен еще один момент. Несмотря на то, что страницы из индекса удалялись достаточно долго, трафик с поисковиков начал падать значительно быстрее.

Получается, что ПС понимают, что вебмастер запретил ресурс или его документы к индексированию, но почему-то продолжают их там держать ![]() .

.

Выводы

- Яндекс любит больше работу с robots.txt;

- Google любит больше работу с meta name=»robots». В связи с тем, что Гугл крайне не любит robots.txt, то универсальным будет именно способ с тегом. Совмещать методы нельзя, потому как, запретив ресурс в robots.txt, поисковый паук не сможет прочитать правила для meta name=»robots».

- Зеркало Рунета достаточно быстро удаляет документы при любом методе. Зарубежный поисковик делает это неохотно — очень тяжело добиться полного удаления из базы.

Вот такой получился небольшой эксперимент. Да, конечно, выборка совсем небольшая, но и она смогла подтвердить мои предположения. В прикладном плане это можно использовать, когда есть необходимость закрыть определенные документы для индексирования: предпочтительно использовать meta name=»robots» вместо директив в robots.txt.

А какие наблюдения по этой теме есть у вас? Поделитесь своим опытом в комментариях ![]() !

!

sosnovskij.ru

Как удалить страницу из Яндекса или Google поиска? 5 способов

Удаление документа из поисковиков

Обычно при поисковом продвижении сайта все стараются как можно быстрее «загнать» документ в индекс поисковика. Но бывает и так, что в поиске оказывается совсем не нужная страница. Например, с какими-либо конфиденциальными данными или с устаревшим содержанием.

Кроме того, если при создании сайта вы не настроили файл Роботс.тхт, то в поиске Гугла, Yandex и других ПС могут оказаться страницы-дубли. Особенно характерно это для блогов на WordPress. Данная CMS традиционно создаёт множество документов с идентичным контентом.

Если «нехорошие» страницы попали в поисковую выдачу, то нужно произвести их удаление. На данный момент сделать это можно 5-ю способами, причём 5-й не подействует без первых 4-х.

Как удалить страницу из Яндекса

1-й способ — сделать так, чтобы данной страницы вообще не было на сайте. Тогда поисковик, при последующем к ней обращении, выкинет её из своего индекса.

Это просто осуществить, если страницы физические, а не динамические. Если они динамические (т.е. генерируются сервером — как на большинстве современных движков), то фактически их нет, поэтому и удалять нечего. В данном случае необходимо, чтобы при обращении к этой странице сервер выдавал бы т.н. код 404 (Not Found):

HTTP/xx 404 Not Found

Большинство современных CMS (в том числе, и WordPress) делают это корректно для удалённых страниц.

Такой код сообщает поисковому роботу, что документ отсутствует и надо выкинуть его из индекса.

Стоит сразу добавить, что удаляются страницы из Яндекса не так быстро, как хотелось бы. Обычно происходит это за 1 и более обновлений выдачи. Нужно подождать.

2-й способ — обнаружив, что ненужные документы попали в SERP, необходимо проверить файл Robots.txt и запретить эти документы к индексации (директивой Disallow или Clean-param). Со временем ПС удалит их из поиска.

3-й способ — добавить в код «нежелательных» документов мета-тег Robots. Как это делать почитайте в статье про meta name robots.

Как удалить страницу из индекса Гугла

Для Google подходят все 3 вышеперечисленных способа.

4-й способ — дополнительно для данного поисковика можно использовать специальный HTTP-заголовок X-Robots-Tag. Суть этого метода в том, что в HTML-коде документа нет следов о том, что изменён характер его обхода поисковым роботом.

X-Robots-Tag представляет из себя обычный заголовок, который на PHP можно задать так (в данной статье не буду подробно расписывать про этот метод):

— такая запись аналогична простановке в HTML-коде документа мета-тега meta name=»robots» content=»noindex,nofollow».

Обратите внимание, что этот приём действует только для Гугла (возможно, ещё Bing и кого-то ещё). Удалить страницу из Яндекса таким способом не получится!

Ну и 5-й способ — исключение страниц из поиска Yandex b Google через специальные сервисы самих ПС.

Только что «свалилось» видео по теме от Гугла (25 июня):

Для Яндекс — можно перейти по этому адресу http://webmaster.yandex.ru/delurl.xml и ввести нужный URL.Как я и писал выше, данный способ подействует лишь при выполнении одного из 4-х условий, указанных выше. Иначе конкуренты удаляли бы страницы сайтов друг друга:

Не удаляется

В Google аналогичная операция производится в аккаунте вебмастера — https://www.google.com/webmasters/tools/. Для этого слева выбираем «Оптимизация — Удалить Url-адреса«:

Исключение URL из Гугла

и создаём новый запрос:

Запрос на удаление URL из Google

Удаление ссылок из индекса Гугла происходит гораздо быстрее, нежели из Яндекса. Там обычно всё быстрее.. Можно ознакомиться также с официальным руководством о продвижении сайта в Google.

Ну а вообще, чтобы не приходилось проделывать все эти действия, лучше сразу продумать, какие разделы и отдельные страницы сайта закрыть от индексации, а какие — оставить роботам.

Loading…

web-ru.net

Как удалить страницу из поиска Яндекса

Автор Алексей На чтение 4 мин. Опубликовано

Иногда из результатов поиска нужно убрать страницу сайта, например, если она содержит конфиденциальную информацию, является дублем другой страницы или была удалена.

Сообщите Яндексу о том, что страницу нужно удалить

Сделать это можно несколькими способами:

Если страница удалена с сайта

- Запретите индексирование страницы с помощью директивы Disallow в файле robots.txt.

Настройте сервер так, чтобы при обращении робота к адресу страницы он отправлял HTTP-статус с кодом 404 Not Found, 403 Forbidden или 410 Gone.

Если страница не должна отображаться в поиске

- Запретите индексирование страницы с помощью директивы Disallow в файле robots.txt.

- Закройте страницы от индексирования с помощью мета-тега noindex.

Если вы настроили ответ сервера на код 4XX или использовали мета-тег noindex для множества страниц, робот узнает об изменении каждой страницы постепенно. В этом случае запретите индексирование страниц с помощью директивы Disallow.

Когда робот Яндекса посетит сайт и узнает о запрете на индексирование, страница пропадет из результатов поиска в течение недели. После этого адрес удаленной страницы отобразится в списке исключенных в разделе Индексирование → Страницы в поиске Яндекс.Вебмастера.

В течение некоторого времени робот еще будет посещать страницу, чтобы убедиться, что ее статус не изменился. Если страница остается недоступной, она пропадет из базы робота.

Страница может снова появиться в результатах поиска, если вы уберете запрет на индексирование в файле robots.txt или ответ сервера изменится на 200 OK.

Если страница удалена с сайта из-за нарушения авторских прав, порядок удаления ее из результатов поиска не меняется и не является приоритетным.

Ускорьте удаление страницы из поиска

Если после того, как вы запретили индексирование станиц, робот еще не посетил ваш сайт, вы можете сообщить Яндексу о необходимости убрать страницу с помощью инструмента «Удаление страниц из поиска» в Яндекс.Вебмастере.

Удалить отдельные страницы сайта из поиска Яндекса

Если ваш сайт не добавлен в Яндекс.Вебмастер:

- Перейдите на страницу Яндекс Вебмастера Удаление страниц из поиска.

- В поле введите адрес страницы, например http://ururu.com/ololo.html.

- Нажмите кнопку Удалить.

Чтобы убрать из поиска несколько страниц, удалите адрес каждой страницы последовательно.Если ваш сайт добавлен и подтвержден в Яндекс.Вебмастере:

- Перейдите на страницу Инструменты → Удаление страниц из поиска.

- Установите переключатель в положение По URL.

- В поле введите адрес страницы, например http://ururu.com/ololo.html.

- Нажмите кнопку Удалить.

Вы можете указать до 500 адресов одного сайта в сутки.

Удалить отдельные страницы сайта из поиска Яндекса

Вы можете удалить каталог, все страницы сайта или страницы с параметрами в URL. Для этого добавьте и подтвердите сайт в Яндекс.Вебмастере.

В Яндекс.Вебмастере перейдите на страницу Инструменты → Удаление страниц из поиска.

Проверьте, что в файле robots.txt указана директива Disallow для страниц, которые нужно удалить. Если в robots.txt робот найдет другие директивы для указанных в Яндекс.Вебмастере страниц, то не смотря на них, удалит страницы из поиска.Вы можете удалить каталог, все страницы сайта или страницы с параметрами в URL. Для этого добавьте и подтвердите сайт в Яндекс.Вебмастере.

В Яндекс.Вебмастере перейдите на страницу Инструменты → Удаление страниц из поиска.

Проверьте, что в файле robots.txt указана директива Disallow для страниц, которые нужно удалить. Если в robots.txt робот найдет другие директивы для указанных в Яндекс.Вебмастере страниц, то не смотря на них, удалит страницы из поиска.

- Установите переключатель в положение По префиксу.

- Укажите префикс:

Что удалить Пример Каталог сайта http://example.com/catalogue/ Все страницы сайта http://example.com/ URL с параметрами http://example.com/page? Можно отправить до 20 указаний для одного сайта в сутки.

- Нажмите кнопку Удалить.

Статусы после отправки URL

Статус Описание «В очереди на удаление» Робот проверяет ответ сервера и наличие запрета на индексирование страницы в файле robots.txt. Проверка может занимать несколько минут. «Удалена» В течение часа после проверки страница будет удалена из результатов поиска. «Отклонено»

- В файле robots.txt отсутствует запрет на индексирование.

- При обращении к адресу страницы ответ сервера отличается от 404 Not Found, 403 Forbidden или 410 Gone.

Как вернуть страницу в результаты поиска

Уберите запрещающие индексирование директивы: в файле robots.txt или мета-тег noindex. Страницы вернуться в результаты поиска, когда робот обойдет сайт и узнает об изменениях. Это может занять до трех недель.

webmaster-seo.ru

5 способов удалить страницу из поиска Яндекса или Google — Devaka SEO Блог

Многие вебмастера рано или поздно сталкиваются с необходимостью удалить из поисковой системы страницы сайта, которые попали туда по ошибке, перестали быть актуальными, являются дублями или содержат конфиденциальную информацию клиентов (причины могут быть разные). Яркий пример тому уже нашумевшая ситуация с Мегафоном, смс-ки пользователей которого проиндексировал Яндекс, ситуация с интернет-магазинами, когда в поиске можно было найти личную информацию клиентов и подробности их заказов, ситуация с банками и транспортными компаниями и так далее…

Не будем касаться в этой статье причин описанных выше казусов, а рассмотрим, как удалить из Яндекса или Google ненужные страницы. Подразумевается, что они пренадлежат вашему сайту, в противном случае необходимо связываться с владельцем нужного ресурса с соответствующей просьбой.

5 способов удаления страниц из поисковых результатов

1. 404 ошибка

Один из простых способов удаления страницы из поиска это удаление её со своего сайта, с условием, что в дальнейшем, при обращении по старому адресу, сервер выдавал 404-ую ошибку, означающую, что страницы не существует.

HTTP/1.1 404 Not FoundВ данном случае придётся подождать, пока робот ещё раз не зайдёт на страницу. Иногда это занимает значительное время, в зависимости от того, как она попала в индекс.

Если страница при удалении её из поиска должна существовать на сайте, то данный способ не подходит, лучше использовать другие, представленные ниже.

2. Файл robots.txt

Очень популярный метод закрыть от индексации целые разделы или отдельные страницы это использование корневого файла robots.txt. Существует множество мануалов, как правильно настроить этот файл. Здесь приведём лишь несколько примеров.

Закрыть раздел администраторской панели от попадания её в индекс поисковиков:

User-Agent: *Disallow: /admin/Закрыть определенную страницу от индексации:

User-Agent: *Disallow: /my_emails.html # закрытие страницы my_emails.htmlDisallow: /search.php?q=* # закрытие страниц поискаВ случае с robots.txt тоже придётся ждать переиндексации, пока робот не выкинет из индекса страницу или целый раздел. При этом, некоторые страницы могут остаться в индексе, если причиной их попадания туда было несколько внешних ссылок.

Данный метод неудобно использовать в случае необходимости удаления разных страниц из разных разделов, если невозможно составить общий шаблон для директивы Disallow в robots.txt.

3. Мета-тег robots

Это альтернатива предыдущего метода, только правило задаётся непосредственно в HTML-коде страницы, между тегами <head>.

<meta name="robots" content="noindex,nofollow" />Удобство мета-тега в том, что его можно добавить на все нужные страницы (с помощью системы управления), попадание которых нежелательно в индекс поисковика, оставляя файл robots.txt при этом простым и понятным. Недостаток данного метода лишь в том, что его сложно внедрить для динамического сайта, использующего один шаблон header.tpl, если отсутствуют специальные навыки.

4. Заголовки X-Robots-Tag

Данный метод используют зарубежные поисковые системы, в том числе Google, как альтернативу предыдущему методу. У Яндекса пока нет официальной информации о поддержке этого http-заголовка, но возможно, в ближайшее время будет.

Суть его использования очень похожа на мета-тег robots, за исключением того, что запись должна находиться в http-заголовках, которые не видны в коде страницы.

X-Robots-Tag: noindex, nofollowВ некоторых, часто неэтичных, случаях его использование очень удобно (например, при обмене ссылками и скрытии страницы линкопомойки).

5. Ручное удаление из панели для вебмастеров

Наконец последний, и самый быстрый способ удаления страниц из индекса – это их ручное удаление.

Яндекс: http://webmaster.yandex.ru/delurl.xml

Google: https://www.google.com/webmasters/tools/

Единственное условие для ручного удаления страниц – они должны быть закрыты от робота предыдущими методами (в robots.txt, мета-теге или 404-ой ошибкой). Замечено, что Google обрабатывает запросы на удаление в течение нескольких часов, в Яндексе придётся подождать следующего апдейта. Используйте этот метод, если вам надо срочно удалить небольшое количество страниц из поиска.

Полезные ссылки по теме

5 советов по созданию практичной 404 страницы

Улучшение юзабилити 404-ых страниц уменьшает показатель отказов. В статье приведены несколько советов, которые помогут сделать 404-ую страницу более эффективной.Всё о файле robots.txt

Для тех, кто ещё не сталкивался с настройкой файла robots.txt, данный ресурс будет полезной отправной точкой. Здесь собрано много примеров и другой полезной информации.Яндекс: Использование robots.txt

Официальные примеры использования файла robots.txt от Яндекса. Также там представлены учитываемые Яндексом директивы и другие советы.Использование HTTP заголовков X-Robots для скрытого удаления линкопомоек

Пример использования HTTP-заголовка X-Robots-Tag в Apache.devaka.ru

Как удалить не нужную страницу из индекса Яндекс.

Бывает такая ситуация, что вы опубликовали какую-то страницу на сайте, но вам бы не хотелось, чтобы эта страница была в индексе поисковых систем.

Конечно, идеальная ситуация, чтобы этого не произошло, страницу, перед ее публикацией, следует указать в файле robots.txt. Но, если страница все-таки попала в индекс, есть способ ее убрать оттуда. Давайте посмотрим, как это можно сделать.

У Яндекса есть специальный инструмент, который называется «Удалить URL». Он не требует ввода логина и пароля.

Вот ссылка на эту страницу.

http://www.webmaster.yandex.ru/delurl.xml

Все, что нужно сделать – это вписать url-адрес той страницы, которую нужно удалить из индекса.

Но, здесь есть важное ограничение: чтобы страница удалилась, должны выполняться следующие условия:

1) url-адрес страницы должен быть прописан в файле robots.txt.

2) страница должна быть в индексе поисковой системы.

Если бы этих условий не было, любой человек мог бы удалить страницы вашего сайта из индекса. Пользуйтесь этим инструментом, чтобы удалять нежелательные для поисковых систем страницы вашего сайта.

Кстати, если хотите узнать конверсии и ключевые показатели (KPI) для вашего продающего сайта, могу настроить веб-аналитику.

Яндекс Метрика и Google Analytics. Цели, события, отчеты.

Подробнее здесь. Обращайтесь.

webgyry.info

Loading…

Loading…