Как работает поисковая система и какие бывают поисковики? | Интернет

Интернет необходим многим пользователям для того, чтобы получать ответы на запросы (вопросы), которые они вводят.

Интернет необходим многим пользователям для того, чтобы получать ответы на запросы (вопросы), которые они вводят.

Если бы не было поисковых систем, пользователям пришлось бы самостоятельно искать нужные сайты, запоминать их, записывать. Во многих случаях найти «вручную» что-то подходящее было бы весьма сложно, а часто и просто невозможно.

За нас всю эту рутинную работу по поиску, хранению и сортировке информации на сайтах делают поисковики.

Содержание статьи:

1. Поисковые системы в Интернете на русском языке

2. Цель поисковиков

3. Работа поисковика и действия вебмастеров

4. Как работает поисковая система?

5. Сканирование

6. Индексирование

7. Ранжирование

Начнем с известных поисковиков Рунета.

Поисковые системы в Интернете на русском

1) Начнем с отечественной поисковой системы. Яндекс работает не только в России, но также работает в Белоруссии и Казахстане, в Украине, в Турции. Также есть Яндекс на английском языке.

Яндекс https://www.yandex.ru/

2) Поисковик Google пришел к нам из Америки, имеет русскоязычную локализацию:

Google https://www.google.ru/

3)Отечественный поисковик Майл ру, который одновременно представляет социальную сеть ВКонтакте, Одноклассники, также Мой мир, известные Ответы Mail.ru и другие проекты.

Майл ру https://mail.ru/

4) Интеллектуальная поисковая система

Nigma (Нигма) http://www.nigma.ru/

С 19 сентября 2017 года “интеллектуалка” nigma не работает. Она перестала для её создателей представлять финансовый интерес, они переключились на другой поисковик под названием CocCoc.

5) Известная компания Ростелеком создала поисковую систему Спутник.

Спутник http://www.sputnik.ru/

Есть поисковик Спутник, разработанный специально для детей, про который я писала ТУТ.

6) Рамблер был одним из первых отечественных поисковиков:

Рамблер http://www.rambler.ru/

В мире есть другие известные поисковики:

подробнее о них ЗДЕСЬ.

Попробуем разобраться, как же работает поисковая система, а именно, как происходит индексация сайтов, анализ результатов индексации и формирование поисковой выдачи. Принципы работы поисковых систем примерно одинаковые: поиск информации в Интернете, ее хранение и сортировка для выдачи в ответ на запросы пользователей. А вот алгоритмы, по которым работают поисковики, могут сильно отличаться. Эти алгоритмы держатся в тайне и запрещено ее разглашение.

Введя один и тот же запрос в поисковые строки разных поисковиков, можно получить разные ответы. Причина в том, что все поисковики используют собственные алгоритмы.

Цель поисковиков

В первую очередь нужно знать о том, что поисковики – это коммерческие организации. Их цель – получение прибыли. Прибыль можно получать с контекстной рекламы, других видов рекламы, с продвижения нужных сайтов на верхние строчки выдачи. В общем, способов много.

Прибыль поисковика зависит от того, какой размер аудитории у него, то есть, сколько человек пользуется данной поисковой системой. Чем больше аудитория, тем большему числу людей будет показываться реклама. Соответственно, стоить эта реклама будет больше. Увеличить аудиторию поисковики могут за счет собственной рекламы, а также привлекая пользователей за счет улучшения качества своих сервисов, алгоритма и удобства поиска.

Самое главное и сложное здесь – это разработка полноценного функционирующего алгоритма поиска, который бы предоставлял релевантные результаты на большинство пользовательских запросов.

Работа поисковика и действия вебмастеров

Каждый поисковик обладает своим собственным алгоритмом, который должен учитывать огромное количество разных факторов при анализе информации и составлении выдачи в ответ на запрос пользователя:

- возраст того или иного сайта,

- характеристики домена сайта,

- качество контента на сайте и его виды,

- особенности навигации и структуры сайта,

- юзабилити (удобство для пользователей),

- поведенческие факторы (поисковик может определить, нашел ли пользователь то, что он искал на сайте или пользователь вернулся снова в поисковик и там опять ищет ответ на тот же запрос)

- и т.д.

Все это нужно именно для того, чтобы выдача по запросу пользователя была максимально релевантной, удовлетворяющей запросы пользователя. При этом алгоритмы поисковиков постоянно меняются, дорабатываются. Как говорится, нет предела совершенству.

С другой стороны, вебмастера и оптимизаторы постоянно изобретают новые способы продвижения своих сайтов, которые далеко не всегда являются честными. Задача разработчиков алгоритма поисковых машин – вносить в него изменения, которые бы не позволяли «плохим» сайтам нечестных оптимизаторов оказываться в ТОПе.

Как работает поисковая система?

Теперь о том, как происходит непосредственная работа поисковой системы. Она состоит как минимум из трех этапов:

- сканирование,

- индексирование,

- ранжирование.

Число сайтов в интернете достигает просто астрономической величины. И каждый сайт – это информация, информационный контент, который создается для читателей (живых людей).

Сканирование

Это блуждание поисковика по Интернету для сбора новой информации, для анализа ссылок и поиска нового контента, который можно использовать для выдачи пользователю в ответ на его запросы. Для сканирования у поисковиков есть специальные роботы, которых называют поисковыми роботами или пауками.

Поисковые роботы – это программы, которые в автоматическом режиме посещают сайты и собирают с них информацию. Сканирование может быть первичным (робот заходит на новый сайт в первый раз). После первичного сбора информации с сайта и занесения его в базу данных поисковика, робот начинает с определенной регулярностью заходить на его страницы. Если произошли какие-то изменения (добавился новый контент, удалился старый), то все эти изменения будут поисковиком зафиксированы.

Главная задача поискового паука – найти новую информацию и отдать ее поисковику на следующий этап обработки, то есть, на индексирование.

Индексирование

Поисковик может искать информацию лишь среди тех сайтов, которые уже занесены в его базу данных (проиндексированы им). Если сканирование – это процесс поиска и сбора информации, которая имеется на том или ином сайте, то индексация – процесс занесения этой информации в базу данных поисковика. На этом этапе поисковик автоматически принимает решение, стоит ли заносить ту или иную информацию в свою базу данных и куда ее заносить, в какой раздел базы данных. Например, Google индексирует практически всю информацию, найденную его роботами в Интернете, а Яндекс более привередлив и индексирует далеко не все.

Для новых сайтов этап индексирования может быть долгим, поэтому посетителей из поисковых систем новые сайты могут ждать долго. А новая информация, которая появляется на старых, раскрученных сайтах, может индексироваться почти мгновенно и практически сразу попадать в «индекс», то есть, в базу данных поисковиков.

Ранжирование

Ранжирование – это выстраивание информации, которая была ранее проиндексирована и занесена в базу того или иного поисковика, по рангу, то есть, какую информацию поисковик будет показывать своим пользователям в первую очередь, а какую информацию помещать «рангом» ниже. Ранжирование можно отнести к этапу обслуживания поисковиком своего клиента – пользователя.

На серверах поисковой системы происходит обработка полученной информации и формирование выдачи по огромному спектру всевозможных запросов. Здесь уже вступают в работу алгоритмы поисковика. Все занесенные в базу сайты классифицируются по тематикам, тематики делятся на группы запросов. По каждой из групп запросов может составляться предварительная выдача, которая впоследствии будет корректироваться.

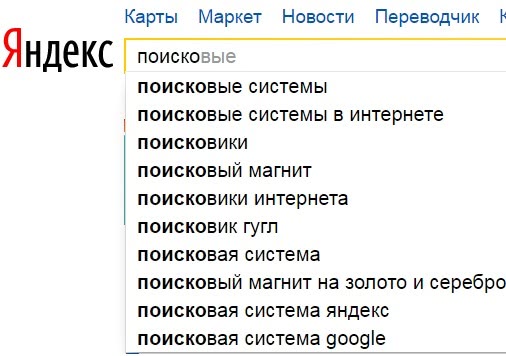

Рис. 1 Упреждающий поиск – выдаются подсказки при вводе первых букв в строку поиска

Рис. 1 Упреждающий поиск – выдаются подсказки при вводе первых букв в строку поискаПредварительная выдача называется еще «упреждающим поиском» – это когда пользователь только начинает вводить свой запрос, а ему уже предлагаются различные варианты ответов.

В каждой поисковой системе есть модераторы – люди, отвечающие за оценку сайтов и результаты выдачи по определенным группам запросов. Модераторы нужны для того, что контролировать работу поисковика, а также замещать алгоритм там, где он работает недостаточно хорошо (корректировать его работу). Модераторы могут вручную менять позиции тех или иных сайтов, если видят, что алгоритм поисковика в каких-то случаях сработал некорректно.

Голосование

Спасибо за Ваш голос!

P.S. К статье отлично подходит:

1. Что полезно знать о запросах в поисковых системах Google и Яндексе

2. Основная миссия и задачи поисковика Google

3. Поиск информации ВКонтакте

4. Семь необычных поисковых систем

www.inetgramotnost.ru

Как работают поисковые системы Яндекс и Google?

Продвижение сайта своими руками является одновременно простой и сложной задачей. Для человека опытного в этой теме раскрутка представляет собой набор простых и четких шагов, сводящихся, в большей степени, к механических действиям. Но для новичка, который только вчера узнал слово SEO и еще не разобрался в его значении, «победить» поисковые системы и конкурентов практически нереально.

Прежде чем приступить к продвижению, необходимо понять, как работают поисковые системы Яндекс и Google. Можете считать эту статью вводной для моего курса по продвижению сайтов “Бесплатный трафик с Поисковиков”, поэтому рекомендую дочитать ее до конца, прежде чем начнете его изучать.

Задача поисковых систем

Интернет непрерывно растет и развивается, вместе с ним эволюционируют и поисковики интернета, но их главная задача остается неизменной – они должны помочь пользователю найти самый лучший ответ на запрос, который он ввел в поле для поиска. Чем более качественные результаты в выдаче показывает поисковик, тем больше ему доверяют люди. Чем больше людей ему доверяют, тем больше денег он может заработать на контекстной рекламе, но это я уже пошел в сторону…

Поисковые системы постоянно анализируют терабайты информации, размещенной на миллионах web страниц, стараясь при этом определить какие сайты заслуживают попадания в ТОП выдачи, а какие являются лучшими кандидатами для попадания в бан.

Как действует поисковая система?

Поисковик – это набор сложных программ и баз данных, которые действуют по определенному алгоритму. Упрощенно, этот алгоритм можно разбить на 3 этапа.

Этап 1. Поиск новых страниц

Вопреки заблуждению многих чайников, поисковые системы выдают информацию не о страницах, находящихся в интернете, а о страницах, находящихся в базе данных поисковой машины. То есть, если сайт неизвестен Яндексу или Goоgle, то и в выдаче он не появится.

Задача поисковика на этом этапе заключается в поиске всех возможных адресов страниц в интернете. Выполняет эту работу так называемый робот «паук». Интернет это ссылки, ссылки и еще раз ссылки и этот «паук» просто переходит по всевозможным ссылкам, записывая в свою базу адреса всех найденных страниц.

Попал на главную страницу сайта, на ней нашел ссылки на страницы рубрик, на страницах рубрик нашел ссылки на страницы со статьями, карточками товаров, ссылки на файлы или другой информацией. На каких-то из посещенных страниц одного сайта, он нашел ссылки на другие сайты – поисковая система переходит по ним и сканирует все, что нашла там.

Прекрасно помогают роботам для ориентирования файлы Robots.txt и карты сайта Sitemap.xml, их надо обязательно сделать, особенно, если сайт имеет много страниц. Тут смотрите, как правильно сделать Robots для WordPress, а про настройку Sitemap расскажу чуть позже.

Задача робота создать адресный справочник по типу – Город, Улица, Дом, Квартира.

Если ваш сайт долгое время не появляется в поисковиках, возможно, его не может найти робот, в этом с

biznessystem.ru

Как работает Google Поиск? / ua-hosting.company corporate blog / Habr

Как работает Google Поиск, основные алгоритмы обновленийВ наше время поисковые системы, в частности Google, напоминают «витрину» Интернета и являются наиболее важным каналом распространения информации в цифровом маркетинге. С помощью глобальной рыночной доли, которая составляет более 65% по данным за январь 2016 года, Google явно доминирует в поисковой индустрии. Хотя компания официально не раскрывает степень своего роста, к 2012 году было подтверждено, что их инфраструктура обслуживает около 3 миллиардов поисковых запросов в день.

Google.com глобально занял звание сайта номер 1 в Alexa Top 500 Global Sites. Учитывая эти цифры, владельцам собственных веб-страниц особенно важно иметь хорошую видимость своих сайтов поисковой системой.

Но не смотря на такую всеобщую популярность Google, знаете ли вы, как он действительно работает и что это за панды, пингвины, калибри?

Чем нужнее становится Google для современного маркетинга, тем важнее понимать функции поиска и алгоритмы обновлений, которые оказывают непосредственное влияние на ранжирование результатов. Moz предполагает, что Google изменяет свои алгоритмы по 600 раз за год. Многие из этих изменений и связанные с ними факторы ранжирования держатся в секрете. И только о крупных обновлениях объявляют публично.

В этой статье мы рассмотрим основы функциональности поисковой системы и объясним основные обновления алгоритма Google, начиная с 2011 года. Выведем также стратегии, следуя которым можно идти в ногу с изменениями поисковой системы. Так что читайте дальше…

Как работает Google?

Своим появлением поисковые системы напрочь изменили привычный для нас способ сбора информации. Интересует ли вас обновление данных фондового рынка или вы хотите найти лучший ресторан в районе, либо пишете академический отчет об Эрнесте Хемингуэе — поисковик даст ответ на все запросы. В 80 годы ответы на вопросы потребовали бы посещения местной библиотеки. Теперь же все решается в течении миллисекунды с использованием алгоритмических полномочий поисковика. В этом отношении главная цель поисковой системы заключается в том, чтобы максимально быстро найти уместную и актуальную информацию, как ответ на введенные поисковые термины, также называемые ключевыми словами. Поэтому центральным аспектом для любой поисковой системы, желающей выдать действительно полезный результат, является понятие цели поиска, того, как именно люди ищут.

Результат работы Google можно сравнить с интернет-каталогом, отобранным с помощью рейтинговой системы на основе алгоритмов. Более конкретно алгоритм поиска можно описать как «нахождение элемента с заданными свойствами среди списка элементов».

Давайте теперь подробнее рассмотрим привлеченные процессы сканирования, индексирования и позиционирования.

Сканирование

Сканирование может быть описано, как автоматизированный процесс систематического изучения общедоступных страниц в Интернете. Проще говоря, во время этого процесса Google обнаруживает новые или обновленные страницы и добавляет их в свою базу. Для облегчения работы он использует специальную программу. «Googlebots» (можно встретить альтернативные названия: «боты» или «роботы») посещают список URL-адресов, полученных в процессе прошлого сканирования и дополненных данными карты сайта, которую предоставляют веб-мастера и анализируют их содержание. При обнаружении ссылок на другие страницы во время посещения сайта, боты также добавляют их в свой список и устанавливают систематические связи. Процесс сканирования происходит на регулярной основе в целях выявления изменений, изъятия «мертвых» ссылок и установления новых взаимосвязей. И это при том, что только по данным на сентябрь 2014 года насчитывается около миллиарда веб-сайтов. Можете себе представить сложность такой задачи? Тем ни менее, боты не посещают абсолютно каждый сайт. Чтобы попасть в список проверяемых, веб-ресурс должен быть рассмотрен, как достаточно важный.

Индексация

Индексация — процесс сохранения полученной информации в базе данных в соответствии с различными факторами для последующего извлечения информации. Ключевые слова на странице, их расположение, мета-теги и ссылки представляют особый интерес для индексации Google.

Для того чтобы эффективно хранить информацию о миллиардах страниц в базе данных поисковой системы, Google использует крупные центры обработки данных в Европе, Азии, Северной и Южной Америке. В этих центрах, как было подсчитано, на основе энергопотребления Google в 2010 году, работает около 900,000 серверов.

Основная цель процесса индексации: быстро реагировать на поисковой запрос пользователя. Его как раз мы и будем обсуждать на следующей стадии.

Обработка

Когда пользователь вводит запрос, Google производит в базе данных поиск, подходящий под условия и алгоритмически определяет актуальность содержания, что выводит к определенному рейтингу среди найденных сайтов. Логично, что результаты, которые считаются более релевантными для пользователя поисковой системы, намеренно получают более высокий ранг, чем результаты, которые имеют меньше шансов обеспечить адекватный ответ.

Хотя Google и не выпустил официальных данных об этом, компания подтверждает, что использует более 200 факторов для определения релевантности и значимости конкретной страницы.

Естественно, всем веб-разработчикам важно знать, каковы факторы ранжирования, которые влияют на позицию страницы в поисковой выдаче. Иногда Google дает определенные намеки, объявив важные изменения в обновлениях своих алгоритмов.

Все вышеописанные процессы сканирования, индексирования и позиционирования можно изобразить с помощью такой схемы:

Теперь, когда у вас есть базовое понимание того, как работает Google, рассмотрим основные обновления алгоритмов поиска, начиная с 2011 года.

Обновление алгоритмов начиная с 2011

Как вы и сами понимаете, Google никогда не будет публично раскрывать свои алгоритмы поиска и факторы ранжирования результатов. Это было бы равносильно тому, чтоб компания Coca-Cola выкладывала рецепты своей знаменитой газировки в Интернет. Тем ни менее, Google желает улучшать уровень пользовательского опыта и обеспечивать самые лучшие результаты поиска. Для того, чтобы уменьшить внедряемый контент в результатах поиска, компания хочет проинформировать веб-мастеров о том, когда и как изменились главные стандарты качества отбора. Поэтому вполне вероятно, что перед проведением крупного обновления алгоритма, последует анонс на Google Webmaster Central Blog.

Итак, давайте рассмотрим основные обновления, которые были осуществлены, начиная с 2011 года:

Panda

Обновление Panda впервые было представлено в конце февраля 2011 года. После было выпущено достаточно много его апдейтов, на данный момент текущая версия: 4.2. Обновление можно рассматривать, как значительное улучшение алгоритма поиска, потому что оно нацелено на повышение качества контента веб-сайтов. Основная идея заключается в том, что оригинальные сайты с авторским контентом в поисковой системе должны занять место выше, чем страницы с низким качеством, повторяющие то, что уже и так известно или же являющиеся копиями других сайтов. Обновление Panda установило новый базовый уровень стандартов качества:

- содержимое на странице должно иметь существенный объем. Больший объем информации статистически занимает место выше, чем содержащий меньше 1500 слов;

- информация, представленная на сайте должна быть оригинальной. Если вы просто копируете содержимое других веб-ресурсов, Google накажет за это;

- содержание сайта должно вносить что-то новое к теме. Мало кому будет интересно в сотый раз перечитывать одно и тоже. Для успешного продвижения контент должно быть то, чего нет на других сайтах;

- текст сайта должен быть орфографически и грамматически правильным и основываться на проверенных фактах;

- если вы собираетесь автоматически генерировать контент из базы данных, содержание должно соответствовать описанным стандартам.

Page Layout (Top Heavy)

Обновление, впервые выпущенное в январе 2012 года, предусматривает наказание сайтов, которые используют слишком много рекламы в верхней части страницы или делают ее чрезмерно агрессивной, отвлекающей от основного содержания. Это спровоцировано большим количеством жалоб от пользователей, которым бывало сложно найти нужную информацию и приходилось долго прокручивать страницу вниз. Данным обновлением Google призывает веб-мастеров размещать содержимое сайта в центре внимания. В этом отношении большое число рекламы мешает удобству усвоения информации.

Penguin

Был выпущен в апреле 2012 года. Новый алгоритм, направленный на борьбу с поисковым спамом. Сайты, которые использовали спам-методы, были значительно понижены в рейтинге или вовсе удалены из него.

Pirate

С обновлением Pirate, которое было введено в августе 2012 года, Google снизил рейтинг сайтов, нарушающих авторские права и интеллектуальную собственность. Для измерения этих нарушений, Google использует систему запросов о нарушении авторских прав, основанную на Digital Millenium Copyright Act. Правообладатели могут применять инструмент, чтобы сообщить и удалить содержание сайта плагиаторов из базы данных Google.

Exact Match Domain(EMD)

Выпущено в сентябре 2012 года и направлено на борьбу с доменами, похожими на MFA.

MFA(made-for-adsense) – домен, который создан специально для контекстно-медийной системы Google. Обычно такой домен предназначен для какого-то одного запроса (или семейства запросов) и на нем установлен Google Adsense. Пользователь, попавший на этот домен, не видит ничего, кроме рекламы и в итоге либо закрывает сайт, либо переходит дальше по контекстному объявлению. После выпуска алгоритма EMD, сайты, содержащие в доменном имени запрос, были изъяты или очень существенно понижены в рейтинге.

Payday Loan

Выпущен в июне 2013 года и направлен на уменьшение страниц, которые содержат переспамленные запросы. Такие запросы часто используются веб-мастерами для продвижения страниц определенной тематики.

Обновление было запущенно в связи с многочисленными жалобами, в которых говорилось, что даже после внедрения Panda и Penguin чистота выдачи оставляла желать лучшего.

Рассмотрим это обновление на обычном примере. Допустим, вам нужно купить дверь. Если ввести запрос, Google выдаст фотографии дверей. Из них: 2-3 страницы, где непосредственно можно купить двери, 3-4 сайта компаний-производителей дверей и 2-3 сайта о том, как выбрать и поменять дверь. Если бы не было обновления Payday Loan, вы бы увидели 15-20 запросов на одну тематику (к примеру, где купить дверь).

Критерии, по которым происходит отбор таких сайтов, Google раскрывать не хочет, но данный алгоритм явно упростил жизнь пользователям поисковой системы.

Hummingbird

С сентября 2013 года Google реализовал замену алгоритма поиска, которая была названа Hummingbird. Основные обновления, как Panda и Penguin, были интегрированы с этим новым алгоритмом. Имя Hummingbird выбрали в качестве синонима для описания гибкости, точности и скорости нового обновления.

Вместо того, чтобы возвращать точные ответы на запросы, используя введенные пользователем ключевые слова (как это было раньше), Google интерпретирует намерения и контекст поиска. Цель состоит в том, чтобы понять смысл поискового запроса пользователя и возвращать соответствующие результаты. Это означает, что точные совпадения ключевых слов становятся менее важными в пользу поиска намерения. В качестве примера: если вы вводите запрос «погода», то вряд ли ожидаете получить полное объяснение самого термина. Скорее в данном случае имеются в виду погодные условия. Что-то наподобие:

Pigeon

Обновление Pigeon впервые выпущено в июле 2014 года. Основное внимание в нем уделяется результатам геозависимого поиска. Расстояние и местоположение пользователя являются ключевыми параметрами ранжирования, чтобы обеспечить точность результата. Это обновление тесно связано с Google Maps. Например:

Mobilegeddon

Было выпущено в апреле 2015 года. Это обновление влияет только на мобильный поиск, оно дает преимущество страницам, дружественным к мобильным устройствам.

В текущем состоянии, обновление не влияет на результаты поиска со стационарных компьютеров или планшетов. В отличие от Panda или Penguin, алгоритм работает в режиме реального времени.

Существует специальный тест, с помощью которого веб-мастера могут проверить совместимость своего сайта с мобильными устройствами. Также можно использовать отчеты о мобильном юзабилити в Google Webmaster Tools, только они могут работать с задержкой.

Как идти в ногу с изменениями алгоритмов?

Обсуждение основных обновлений алгоритмов за последние годы, вероятно ставит перед вами вопрос, как не отставать от этих изменений? Основная задача Google — постоянно двигаться в направлении обеспечения самого высокого качества и надежности ответов на пользовательские запросы. В то время как технические особенности могут модифицироваться, широкая стратегия вряд ли изменится.

Поскольку поведение человека постоянно меняется, задача Google также адаптировать свои алгоритмы согласно изменениям. К примеру, «Mobilegeddon» было введено в качестве реакции на растущую тенденцию поисков с мобильных устройств.

Главное — это понимание того, кто ваши клиенты. Сосредоточенность на реальных потребностях этих клиентов имеет фундаментальное значение для того, чтобы идти в ногу с изменениями.

Итак, если вы — веб-программист, вам особенно важно быть в курсе изменений алгоритмов поиска Google. Вот подборка нескольких полезных ресурсов, которые могут помочь оставаться в курсе событий:

Google Webmaster Central Blog — ваш главный источник для официальных новостей и обновлений, на нем довольно часто впервые объявляли об алгоритмических изменениях.

Moz Google Algorithm Change History — в этой базе данных Moz опубликовал каждое из заметных изменений алгоритма и обновлений начиная с 2000 года.

Search Engine Land – один из наиболее важных онлайн журналов для SEO и SEM. В нем есть целый раздел об обновлениях алгоритмов Google с соответствующими статьями.

Search Engine Roundtable – также включает в себя интересный раздел об обновлениях алгоритмов.

Mozcast — это визуальное представление об изменениях алгоритмов в виде сводки погоды.

Algoroo — инструмент, который отслеживает результаты поиска колебания вокруг 17000 ключевых слов в связи с изменением алгоритма. Очень полезный сайт для обнаружения немедленных обновлений.

Сохраняя традицию. Вот тут можно найти первоисточник.

habr.com

Основные принципы работы поисковых систем в Интернете

Какой бы вопрос не волновал современного человека, ответы он не ищет в книгах. Он ищет их в интернете. Причем не нужно знать адрес сайта, на котором лежит нужная тебе информация. Таких сайтов миллионы, а помогает найти нужный поисковая система.

На просторах нашего отечественного интернета самые популярные две поисковые системы – Google и Яндекс.

Вы хотя бы раз задумывались, как работает поисковая система? Как она понимает, какой сайт показать, на каком из миллионов ресурсов точно есть ответ на ваш запрос?

Если да – читайте дальше.

Что представляет собой поисковая система?

Поисковая система – это огромная база веб-документов, которая постоянно пополняется и расширяется. У каждой поисковой системы есть поисковые пауки, роботы – это специальные боты, которые обходят сайты, индексируют размещенный на них контент, а затем ранжируют по степени его качества и релевантности поисковым запросам пользователей.

Поисковые системы работают для того, чтобы любой человек мог найти любую информацию. Потому они стараются показывать в первую очередь те веб-документы, в которых есть максимально подробный ответ на вопрос человека.

По своей сути поисковая система – это каталог сайтов, справочник, основная функция которого – поиск информации по этому самому каталогу.

Как я уже написал выше, у нас популярные две системы – Google (мировая) и Яндекс (русскоязычный сегмент). Но есть еще такие системы, как Rambler, Yahoo, Bing, Mail.Ru и другие. Принцип работы похож у них у всех, отличаются только алгоритмы ранжирования (и то не сильно существенно).

Как работает поисковая система в Интернете

Принцип работы поисковых систем очень сложный, но я попробую объяснить простыми словами.

Поисковый робот (паук) обходит страницы сайта, скачивает их содержимое и извлекает ссылки. Далее начинает свою работу индексатор – это программа, которая анализирует все скачанные пауками материалы, опираясь на собственные алгоритмы работы.

Таким образом, создается база данных поисковой системы, в которой хранятся все обработанные алгоритмом документы.

Работа с поисковым запросом проводится следующим образом:

- анализируется введенный пользователем запрос;

- результаты анализы передаются специальному модулю ранжирования;

- обрабатываются данные всех документов, выбираются самые релевантные введенному запросу;

- генерируется сниппет – заголовок, дескрипшн, слова из запроса подсвечиваются полужирным;

- результаты поиска представляются пользователю в виде SERP (страницы выдачи).

Принципы работы поисковых машин

Главная задача любой поисковой системы – предоставить пользователю наиболее полезную и точную информацию по его запросу. Потому поисковый робот обходит сайты постоянно. Сразу после вашего запуска, согласно определенному распорядку, паук заходит к вам в гости, обходит ряд страниц, после чего проходит их индексация.

Принцип работы поисковых машин базируется на двух основных этапах:

- обход страниц, с помощью которого собираются данные;

- присвоение индекса, благодаря которому система сможет быстро проводить поиск по содержимому данной страницы.

Как только страница сайта проиндексирована, она уже появится в результатах поиска по определенному поисковому запросу. Проверить, попала ли новая страница в индекс поисковой системы, можно с помощью инструментов для вебмастеров. Например, в Яндекс.Вебмастере сразу видно, какие страницы проиндексированы и когда, и какие выпали из индекса и по какой причине.

Но вот на какой странице она окажется – зависит от степени индексации и качества ее содержания. Если на вашей странице дается самый точный ответ на запрос – она будет выше всех остальных.

Принципы ранжирования сайтов в поисковых системах

По какому принципу работают поисковые роботы, мы разобрались. Но вот каким образом проходит ранжирование сайтов?

Ранжирование базируется на двух основных «китах» — текстовое содержание страницы и нетекстовые факторы.

Текстовое содержание – это контект страницы. Чем он полнее, чем точнее, чем релевантнее запросу – тем выше будет страница в результатах выдачи. Кроме самого текста, поисковая система обращает внимание на заполнение тегов title (заголовок страницы), description (описание страницы), h2 (заголовок текста).

Нетекстовые факторы – это внутренняя перелинковка и внешние ссылки. Суть в чем: если сайт интересен, полезен, значит, на него ссылаются другие тематические ресурсы. И чем больше таких ссылок – тем авторитетнее ресурс.

Но это – самые основные принципы, очень кратко. Вникнем чуть глубже.

Основные факторы ранжирования сайта

Есть целый ряд факторов, влияющих на ранжирование сайта. Основные из них – это:

1. Внутренние факторы ранжирования сайта

Это текст на сайте и его оформление – подзаголовки, выделение важных моментов в тексте. Использование внутренней перелинковки тоже сюда относится. Также важны визуальные элементы: использование картинок, фотографий, видео, графиков. Немаловажно также качество самого текста, его содержание.

2. Внешние факторы ранжирования сайта, которые определяют его популярность. Это те самые внешние ссылки, которые ведут на ваш сайт с других ресурсов. Определяется не только количество этих сайтов, но их качество (желательно, чтобы сайты были схожей тематики с вашим), а также общее качество ссылочного профиля (насколько быстро появились эти ссылки, естественным путем или с помощью закупки на бирже).

3. Поведенческие факторы ранжирования сайта. Поисковые системы начали отслеживать поведение пользователей на сайте и на основе этого поведения понимать, интересен ли ваш сайт людям, полезен ли он, нравится ли посетителям. Обращают внимание на: показатель отказов (чем он ниже – тем лучше), глубину просмотра, время на сайте. Подробнее об этом здесь https://adtimes.ru/povedencheskie-faktory-ranzhirovaniya-sajta-chto-eto-takoe-i-kak-ix-uluchshit/

4. Коммерческие факторы ранжирования сайта. Они важны в первую очередь для тех, кто ставит на продвижение в Яндексе. Коммерческие факторы определяют, насколько удобен ваш сайт для осуществления заказа или совершения покупки Подробнее можете прочесть здесь https://adtimes.ru/kommercheskie-faktory-ranzhirovaniya-i-chto-k-nim-otnositsya/

Исходя из всего вышесказанного, можно сделать один вывод: поисковые системы стараются работать так, чтобы показывать пользователю те сайты, которые дают максимально полный ответ на его запрос и уже заслужили определенный авторитет. При этом учитываются самые разные факторы: и содержание сайта, и его настройка, и отношение пользователей к нему. Хороший во всех отношениях сайт непременно займет высокое место на выдаче.

adtimes.ru

Сравниваем поисковые системы Яндекса и Google

Рассказываем, как устроены поисковые системы, чем они отличаются между собой, где пользователи чаще всего ищут коммерческие предложения и как распределяется поисковый трафик.

Тезисно, о чем мы сегодня будем говорить:

- что такое поисковая система;

- как делят между собой рынок Яндекс и Google;

- из чего состоит структура страниц выдачи информации Яндекса и Google;

- принцип работы поисковых систем;

- структура страниц Яндекса и Google и их визуальные отличия;

- как распределяется поисковый трафик по темам и по типу устройств;

- различие поисковых систем на живом примере.

Что такое поисковая система?

Поисковая система — это программно-аппаратный комплекс, который ищет и выдает информацию по запросу пользователя. То есть, вы заходите на сайт Google или Яндекс, вводите интересующий вас запрос (например, боулинг-центр в Москве) и поисковая машина находит для вас соответствующую информацию — сайты, где вы видите ответ на свой запрос.

Как делят рынок Яндекс и Google

Сейчас российский рынок почти поровну поделен между Яндексом (48,13%) и Google (46,79%). Есть еще Рамблер и Mail.ru, но это скорее не поисковые системы, а порталы, использующие поисковую строку и алгоритмы от Яндекса и Google. Раньше распределение позиций на рынке было другим: более 60% занимал Яндекс и, соответственно, менее 40% было у Google. Почему? Дело в том, что Яндекс — это локальная система и в России она оказалась более востребованной, чем Google (компании понадобилось время, чтобы компенсировать разницу и занять нишу, которую она занимает сейчас). Догнать Яндекс получилось благодаря развитию мобильного рынка: появилось больше мобильных устройств, доступный мобильный интернет стал данностью и люди начали активнее им пользоваться. Как это связано с успехом Google? Что у Andriod, что у Apple по умолчанию установлена поисковая система Google (кстати, компания выплачивает $3 млрд. в пользу Apple каждый год), поэтому ей и удалось догнать Яндекс на российском рынке. У последнего такой возможности нет (в Яндексе работали над созданием своей операционной системы на базе Android, но пока ничего не получилось).

Доли рынка поисковых систем в России, %:

Как работают поисковые системы

Как работает поисковая система? У каждой поисковой машины есть роботы, которые ежедневно переходят по ссылкам и находят информацию. Далее она заносится в базу и хранится до востребования (момента, когда пользователь делает соответствующий запрос), а все найденные ссылки используются для того, чтобы перейти дальше по ссылкам и найти новую информацию (получается такой бесконечный круговорот ссылок). Когда вы вводите запрос (например, вейкборд-москва-лебедка), поисковая система обращается к базе и выстраивает документы на основании их релевантности (уровню соответствия документа запросу). То есть, чем больше документ отвечает запросу, тем более он релевантный. Процесс выстраивания документов по релевантности называется ранжирование поисковой системы. И как раз ранжирование определяет тот топ-10 сайтов, которые мы видим на первой странице после того, как ввели запрос и нам выдали результаты.

Структура страниц Яндекс и Google и их визуальные отличия

Как выглядит страница выдачи информации у Яндекса и Google? Визуально они повторяют друг друга, но у Google она более строгая, у Яндекса предусматривает больший интерактив и выглядит чуть привлекательнее.

У Яндекса страница состоит из четырех разделов:

- поисковая строка;

- блок контекстной рекламы;

- органическая выдача;

- колдунщики (последнее звучит дико, знаем).

Теперь чуть подробнее по пунктам: поисковая строка — это та страница, где вы вбили запрос и получили ответ в виде ссылок на сайты. Блок контекстной рекламы — это объявления, которые могут находиться вверху, внизу или по бокам страницы (обычно они помечены словом «реклама»). На эти позиции может попасть любой сайт, который заплатил деньги Яндексу или Google за размещение информации о себе или своих услугах. Блок органической выдачи (следующая ступень) — это те результаты, которые строятся на основании релевантности документа. То есть на первое место в органику попадает тот сайт, который наиболее полно отвечает ключевому запросу. Поэтому в ваших же интересах, чтобы информация была качественной, так как пользователи чаще ищут ответы в органике, чем в блоке рекламы. Последний элемент выдачи — это колдунщики, или внутренние сервисы поисковиков. Колдунщики делают выдачу более живой, интерактивной и, как правило, точечно отвечают на запросы. Пример колдунщиков у Яндекса: Яндекс-авто, Яндекс-фото, Яндекс-недвижимость.

Как выглядит страница выдачи у Google? Фактически она повторяет внешний вид Яндекса (за исключением того, что выглядит более строго) и состоит из тех же четырех элементов. Что касается колдунщиков, то их меньше, чем в Яндексе (с точки зрения коммерческих запросов) и в основной массе они работают для информационных запросов из разряда «что такое», «почему», «как работает».

Распределение поискового трафика по темам и типу устройств

Если говорить о распределении поискового трафика по типам устройств, получается следующая ситуация: Google больше ориентирован на мобильную аудиторию (это причина его популярности, как мы и говорили выше), у Яндекса больший упор на десктопную версию.

Доли рынка поисковых систем в России, %:

Еще один важный момент: распределение трафика в зависимости от тематики, с которой связан запрос. Например, недвижимость менее популярна в Google, чем в Яндексе (74% против 26%). Всему виной, что изначально Google строился так, чтобы искать конкретную информацию (ему легче найти и отранжировать большой документ: статью, исследование), а Яндекс задумывался как машина, которой проще отыскать информацию, основываясь на коммерческих составляющих. Поэтому в Яндексе вы найдете больше ответов на запрос «купить-продать», а в Google быстрее отыщите информацию. По этой причине мы рекомендуем направлять запросы по недвижимости, туризму, автотематике и производству в Яндекс.

Распределение трафика по тематикам, %:

Немного практики

Предлагаем рассмотреть различия двух поисковых систем на примере одного из наших проектов. На скриншоте из аналитики видно, что количество пользователей, пришедших на наш сайт из Google превышает количество пользователей из Яндекса на 25%. Учитывая, что показатель отказов и среднее время, проведенное на сайте, приблизительно одинаковы, можно сделать первоначальный вывод о том, что трафик идентичен. Но не тут-то было. Несмотря на преимущество трафика с Google, конверсия в покупку у пользователей Яндекса выше на 20-25% и, несмотря на разрыв в количестве посетителей, Яндекс генерирует на порядок больше выручки.

Оказавшись в такой ситуации, необходимо сделать правильные выводы и с умом распределить свои ресурсы. Мы поняли, что должны бросить основные силы на работу над SEO в Яндексе, но это было довольно очевидно, и мы решили копнуть глубже. Оказалось, что очень много пользователей выбирали себе квест в течение рабочего времени с телефона и, похоже, просто боялись его бронировать в рабочей обстановке. Затем, вернувшись домой, они совершали бронирование уже с компьютера, и, очевидно, использовали Яндекс для поиска нужного квеста. Здесь мы также сделали правильные выводы — учитывая наше более низкое ранжирование в Яндексе, мы не могли позволить клиенту уйти к конкурентам, когда он выбрал квест через наш сайт. Поэтому большую часть рекламного бюджета мы распределили на ретаргетинг своих пользователей из Яндекса — это помогло нам лучше понять поведение клиентов, а также подтвердило на практике, что Яндекс более коммерческий сервис, а Google — информационный.

Если у вас есть вопросы по статье, задавайте их в нашем телеграм-канале, а также подписывайтесь на нашу группу vk и заходите на наш сайт, чтобы быть в курсе последних новостей.

www.bookform.ru

SEO-дебри, или Как работают поисковые системы?

Зачем маркетологу знать базовые принципы поисковой оптимизации? Все просто: органический трафик — это прекрасный источник входящего потока целевой аудитории для вашего корпоративного сайта и даже лендингов.

Встречайте серию образовательных постов на тему SEO.

Что такое поисковая система?

Поисковая система представляет собой большую базу документов (контента). Поисковые роботы обходят ресурсы и индексируют разный тип контента, именно эти сохраненные документы и ранжируют в поиске.

По факту, Яндекс — это «слепок» Рунета (еще Турция и немного англоязычных сайтов), а Google — мирового интернета.

Цель поисковой системы — показывать ссылки на документы, которые максимально соответствуют (релевантны) поисковому запросу.

Поисковый индекс — структура данных, содержащая информацию о документах и расположении в них ключевых слов.

По принципу работы поисковые системы схожи между собой, различия заключаются в формулах ранжирования (упорядочивание сайтов в поисковой выдаче), которые строятся на основе машинного обучения.

Ежедневно миллионы пользователей задают запросы поисковым системам.

«Реферат написать»:

«Купить»:

Но больше всего интересуются…

Как устроена поисковая система?

Чтобы предоставлять пользователям быстрые ответы, архитектуру поиска разделили на 2 части:

- базовый поиск,

- метапоиск.

image source api.yandex.ru

Базовый поиск

Базовый поиск — программа, которая производит поиск по своей части индекса и предоставляет все соответствующие запросу документы.

Метапоиск

Метапоиск — программа, которая обрабатывает поисковый запрос, определяет региональность пользователя, и если запрос популярный, то выдает уже готовый вариант выдачи, а если запрос новый, то выбирает базовый поиск и отдает команду на подбор документов, далее методом машинного обучения ранжирует найденные документы и предоставляет пользователю.

image source api.yandex.ru

Классификация поисковых запросов

Чтобы дать релевантный ответ пользователю, поисковик сначала пытается понять, что ему конкретно нужно. Происходит анализ поискового запроса и параллельный анализ пользователя.

Поисковые запросы анализируются по параметрам:

- Длина;

- четкость;

- популярность;

- конкурентность;

- синтаксис;

- география.

Тип запроса:

- навигационный;

- информационный;

- транзакционный;

- мультимедийный;

- общий;

- служебный.

После разбора и классификации запроса происходит подбор функции ранжирования.

Обозначение типов запросов является конфиденциальной информацией и предложенные варианты — это догадка специалистов по поисковому продвижению.

Если пользователь задает общий запрос, то поисковая система выдает разные типы документов. И стоит понимать, что продвигая коммерческую страницу сайта в ТОП-10 по общему запросу, вы претендуете попасть не на одно из 10 мест, а в число мест

для коммерческих страниц, которое выделяется формулой ранжирования. И следовательно, вероятность вывода в топ по таким запросам ниже.

MatrixNet

Машинное обучение МатриксНет — алгоритм, введенный в 2009 году Яндексом, подбирающий функцию ранжирования документов по определенным запросам.

image source api.yandex.ru

МатриксНет используется не только в поиске Яндекса, но и в научных целях. К примеру, в Европейском Центре ядерных исследований его используют для редких событий в больших объемах данных (ищут бозон Хиггса).

Первичные данные для оценки эффективности формулы ранжирования собирает отдел асессоров. Это специально обученные люди, которые оценивают выборку сайтов по экспериментальной формуле по следующим критериям.

Оценка качества сайта

Витальный — официальный сайт (Сбербанк, LPgenerator). Поисковому запросу соответствует официальный сайт, группы в социальных сетях, информация на авторитетных ресурсах.

Полезный (оценка 5) — сайт, который предоставляет расширенную информацию по запросу.

Пример — запрос: баннерная ткань.

Сайт, соответствующий оценке «полезный», должен содержать информацию:

- что такое баннерная ткань;

- технические характеристики;

- фотографии;

- виды;

- прайс-лист;

- что-то еще.

Примеры запроса в топе:

Релевантный+ (оценка 4) — это оценка означает, что страница соответствует поисковому запросу.

Релевантный- (оценка 3) — страница не точно соответствует поисковому запросу.

Допустим, по запросу «стражи галактики сеансы» выводится страница о фильме без сеансов, страница прошедшего сеанса, страница трейлера на youtube.

Нерелевантный (оценка 2) — страница не соответствует запросу.

Пример: по названию отеля выводится название другого отеля.

Чтобы продвинуть ресурс по общему или информационному запросу, нужно создавать страницу соответствующую оценке «полезный».

Для четких запросов достаточно соответствовать оценке «релевантный+».

Релевантность достигается за счет текстового и ссылочного соответствия страницы поисковым запросам.

Выводы

- Не по всем запросам можно продвинуть коммерческую целевую страницу;

- Не по всем информационным запросам можно продвинуть коммерческий сайт;

- Продвигая общий запрос, создавайте полезную страницу.

Частой причиной, почему сайт не выходит в топ, является несоответствие контента продвигаемой страницы, поисковому запросу.

Об этом поговорим в следующей статье «Чек-лист по базовой оптимизации сайта».

image source Maryanne Gobble

Автор этого поста:

Автор этого поста:Погодаев Сергей, руководитель компании «Бюро Погодаева»

- Занимается исследованиями алгоритмов поисковых систем с 2009;

- Провел более 150 технических, поисковых и маркетинговых аудитов сайтов;

- Проводил оптимизацию социальных сетей «Мой Мир» и «AlterGeo»;

- Изучает и развивает направление «Продвижение Landing Page».

14-08-2014

lpgenerator.ru

Из чего состоит и как работает поисковая система Яндекс и Google?

В этой статье я опишу основные элементы поисковой системы, покажу, как они связаны, и затрону немного истории возникновения поисковиков. Но вначале разберем, что такое поисковая система и для чего она нужна?

Поисковая система – это специальный сервис для быстрого поиска информации в Интернете. Пользователь задает в поисковик запрос, в котором формулирует, что хочет найти. Поисковая система в ответ выдает результаты поиска – ссылки на страницы сайтов, где может находиться интересующая пользователя информация.

Давайте разберемся, из чего состоит поисковая система и как она работает. Нужно отметить, что принципы действия у любого поисковика схожи: Яндекс, Google и другие поисковики работают по аналогичным алгоритмам, которые отличаются нюансами.

История развития поисковиков: не путайте Wandex и Yandex!

Начнем с истории: первый в мире поисковик в WWW появился в 1993 году, и это был Wandex. Не путайте с Яндексом. После него появились Aliweb, Webcrawler, Lycos, Altavista, Рамблер, Google и только потом Яндекс.

Первым именно российским поисковиком был Рамблер. Сейчас Рамблер все еще существует, но для поиска использует движок Яндекса. На его долю приходится около 1% от всех поисковых запросов.

Самой популярной поисковой системой в России на момент подготовки статьи является Яндекс, который используют для поиска информации около 61% россиян по данным РБК. На втором месте по количеству пользователей в России идет Google – около 26%, но в последнее время процент пользователей Google растет. Обе поисковые системы были запущены в 1997 году, но в Россию Google пришел гораздо позже (официально – в 2006 году).

Перейдем к вопросу, как устроена и как работает поисковая система

Поисковая система состоит из трех основных элементов:

1. Роботы-пауки (агенты, роботы, обходящие все интернет пространство, и сканирующие сайты)

У поисковой системы существует множество роботов-агентов, каждый из них выполняет свою функцию:

- основной работ, сканирующий сайты;

- робот, сканирующий картинки;

- робот, сканирующий видео;

- робот мобильных сервисов;

- быстроробот выполняет функцию сбора свежей информации и новостей для индексации;

- другие роботы.

У каждого робота есть список адресов, которые он должен обойти. Этот список автоматически увеличивается, если робот находит новую ссылку и адрес сайта. Робот проверяет тип найденного документа, кодировку и язык и отправляет эти данные на дальнейшую обработку.

2. Индекс (база документов и дополнительных параметров в обработанном виде)

Индекс – это хранилище поисковой системы, где вся информация находится в обработанном и упорядоченном виде. Например, документы хранятся в очищенном от html-разметки виде, в индексе имеются данные о местоположении различных слов в документе и другая информация. Индекс обновляется постоянно.

В ряде поисковых систем имеются выраженные апдейты. В этом случае полноценное обновление поискового индекса, на основе которого формируются результаты поиска, происходит не постоянно, а через некоторое время. Апдейт – это момент обновления поисковой системы, в который результаты поиска по многим запросам серьезно меняются.

3. Поисковый алгоритм (механизм, который позволяет формировать выдачу)

Когда в поисковую систему поступает запрос, алгоритмы поисковой системы обрабатывают его. В обработанном виде он поступает дальше в систему.

Если запрос популярный, результаты поиска по нему могут кешироваться (сохраняться в поисковой системе) и в дальнейшем при поступлении такого же запроса результаты поиска поднимаются из кеша. Если запрос уникальный, то поисковые алгоритмы на основе имеющихся в них формул формируют ответ на запрос из индекса поисковой системы.

Формула, по которой формируются результаты поиска, может отличаться в зависимости от запроса, его типа (коммерческий, информационный, навигационный и т.д.), географии (формула для региональных запросов может быть проще, чем для московского региона).

Мы рассмотрели упрощенную модель поисковой системы. Реальные поисковые системы намного сложнее и включают в себя механизмы борьбы по спамом, колдунщики и множество других вещей.

Что такое машинное обучение?

Поисковая система Яндекс создает формулы для ранжирования сайтов на основе машинного обучения.

Очень упрощенно данную систему можно представить так:

- В программу машинного обучения загружаются факторы, по которым осуществляется ранжирование документов, и отранжированные результаты поиска по множеству запросов. Программа ищет закономерности между результатами поиска и факторами «хороших» и «плохих» страниц. Найденные закономерности включаются в формулу ранжирования. Например, если на всех «хороших» сайтах фон был синим, а на всех «плохих» – желтым, то программа может заложить в формулу повышение позиций страниц с синим фоном и занижение позиций страниц с желтым фоном.

- Полученные формулы тестируются, и разработчики по определенным параметрам определяют, улучшилось качество поиска по новым формулам или нет.

- Если качество поиска повысилось – формулы загружаются в основной поиск и начинают обрабатывать пользовательские запросы.

Резюме: как работает поисковик?

Как мы видим, даже упрощенная модель работы поисковой системы достаточно сложна и состоит из множества систем. Реальные же поисковые системы намного сложнее, поэтому процесс продвижения сайтов представляется не только сложным, но и крайне интересным.

В данный момент при ранжировании сайтов поисковая система Google учитывает более 200 факторов, а поисковик Яндекс — более 800 факторов. Все они подразделяются на группы: технические, доменные, текстовые, ссылочные, региональные, поведенческие, коммерческие, юзабилити и ряд других.

Читайте также:

Рекомендуем

Технический аудит сайта выявляет ошибки в работе веб-ресурса, которые могут вызвать проблемы в поисковых системах. Например, усложнить индексацию …

Продвижение сайта – это процесс, целью которого является повышение видимости сайта в поисковых системах. Например, у Вас есть сайт о пластиковых …

www.kadrof.ru