Как посмотреть сколько страниц сайта в индексе Яндекса: где узнать количество

Индексация сайта — задача поисковых роботов, заключающаяся в поиске, обработке и добавлении в базу документов. После сканирования содержимое страниц принимает участие в поиске и ранжируется по определенным ключевым запросам.

Интернет можно сравнить с огромной библиотекой. В каждой библиотеке есть каталог, основная задача которого — обеспечить удобство поиска информации. В середине 90-х годов XX века весь процесс индексации сводился к подобной каталогизации. Поисковые роботы сканировали сайты и структурировали информацию по ключевым словам в общую базу данных (БД).

Сейчас принцип индексации изменился — боты находят и анализируют информацию по определенным показателям (уникальность, читабельность, полезность и так далее.) и только потом материалы попадают в базу и показываются пользователям.

Алгоритмы Гугл и Яндекс постоянно меняются и становятся все совершеннее. БД переполнены информацией, среди которой роботы определяют самые качественные материалы и присваивают высокие позиции.

Особенности индексации в ПС Яндекс и Google

Google и Яндекс — самые популярные поисковые системы у пользователей Рунета. Чтобы ресурс принимал участие в поиске, расскажите о нем ботам. «Пригласить» их на сайт можно следующими способами:

- Добавить сайт в «Яндекс.Вебмастер» и Google Webmasters. После чего робот обязательно посетит ресурс и вскоре его страницы проиндексируются.

- Проставить внешние ссылки на сайт с других ресурсов — страницы, которые были найдены таким способом, считаются полезными. Робот переходит по ним, передает вашему сайту определенный вес, одновременно индексируя его страницы.

В среднем на сканирование новых сайтов уходит от одной до двух недель. Но вебмастера отмечают, что индексация в Google быстрее. Все потому, что роботы сканируют все страницы: и качественные, и не очень. Но в поиск попадают только полезные материалы.

Пауки Яндекса работают в этом плане медленнее, но недостаточно качественные страницы не участвуют в поиске, так как их анализ происходит прямо на этапе индексирования.

Как индексируется сайт:

- поисковый бот заходит и анализирует контент;

- содержимое добавляется в БД;

- через некоторое время (до 2-х недель) проиндексированный документ участвует в поиске.

Анализ индексации своего сайта

Мониторить индексацию сайта — одна из ключевых SEO-работ. Существует несколько простых способов: «Яндекс.Вебмастер» и Google Webmasters.

Это самый простой способ убедиться прошла ли индексация страниц.

Яндекс.Вебмастер

- Добавьте сайт в сервис (привязка к почте).

- Откройте «Индексирование сайта» — «Страницы в поиске».

Так можно проверить насколько быстро новые страницы попадают в выдачу Яндекса.

- Добавьте проект в сервис для вебмастеров Google.

- Перейдите во вкладку «Индекс» — «Покрытие».

Как проверить вручную

Внимание! Если количество страниц проиндексированных в Гугл и Яндекс сильно отличаются, значит у сайта какие-то проблемы: неправильное содержимое файла robots.txt, проблемы со структурой или еще хуже — наложение санкций.

Для более детальной информации по индексации сайта, можно прибегнуть к специальным инструментам. С их помощью вы узнаете, сколько страниц было проиндексировано за определенный промежуток времени. Например, в Гугле выберите «Инструменты» и задайте интересующий период:

С помощью плагинов и расширений

Собрать информацию о проиндексированных документах можно и автоматически. Эту задачу решают специальные плагины и расширения для браузеров. Они сэкономят вам время.

Самое популярное расширение — RDS bar, его можно установить на любой популярный браузер.

Еще один удобный вариант — букмарклет «Проверка индексации». Активируйте программу, перетянув ссылку на панель браузера, после чего откройте сайт и кликните на значок расширения. Откроется новая вкладка с Гугл или Яндекс, где будет информация об индексации.

Специальные сервисы

Наличие удобного функционала позволяет наглядно увидеть какие страницы принимают участие в поисковой выдаче, а каких нет.

Одним из популярнейших сервисов — «Серпхант». Бесплатный лимит — 50 страниц в сутки. Проверка индекса Google и Яндекс.

Еще один бесплатный онлайн-сервис — pr-cy.ru. Просто указываете URL своего сайта и нажимаете «Анализировать».

Среди платных сервисов — Topvisor. Цена проверки 1 страницы — 0,024 рубля. Загружаете в сервис страницы и запускаете проверку.

Как ускорить индексацию

От скорости индексации зависит то, насколько быстро на страницах появится трафик. Это особенно важно для новостных ресурсов, которые должны индексироваться моментально, чтобы получить переходы из ПС. Иначе теряется актуальность их материалов.

Существует несколько простых способов заставить роботов чаще посещать ваш сайт:

- Добавьте ресурс в сервисы инструментов для вебмастеров Гугл и Яндекс.

- Регулярно добавляйте новые материалы на сайт (чем чаще, тем лучше).

- Проработайте удобную навигацию (в идеале, чтобы страницы имели вложенность не больше, чем три клика от главной).

- Выберите хороший хостинг, который не будет давать сбоев в работе сайта.

- Закрыть от индексации ненужные страницы в robots.txt.

- Перелинковать страницы между собой (удобно и для пользователей, и для ботов).

- Нарастить ссылки из соцсетей.

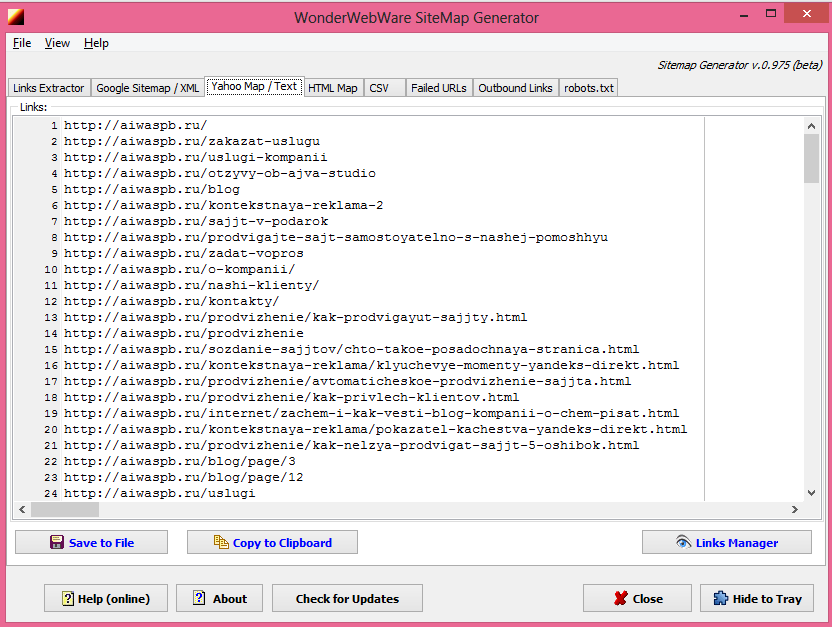

- Создать карту сайта в двух вариантах — .xml и .html.

Почему сайт не индексируется

Хорошо, если все страницы сайта проиндексированы и их примерно одинаковое количество в индексе ПС. Но порой бывает не все так гладко.

- Новый ресурс. На индексацию новых сайтов у поисковых роботов может потребоваться больше времени.

- Неправильная настройка файла robots.txt. В этом файле указываются команды боту, какие страницы и файлы индексировать, а какие нельзя. Если вы допустите ошибку, то рискуете навредить индексации.

- Нет карты сайта sitemap.xml. Карта сайта для ПС, которая сигнализирует о появлении новых страниц.

- Сайт закрыт от индексации. Запрещено посещение сайта роботом через админку (например, на движке WordPress есть такая возможность) или через тот же файл robots.txt. Еще одна типичная ошибка — от индексации закрыто содержимое страниц с помощью тега «noindex».

- Плохое качество страниц. Если контент не уникальный и не несет никакой пользы для посетителей, поисковые роботы могут принять решение не показывать его в поиске.

Выводы

Индексация сайта — необходимое условие для роста трафика и развития веб-проекта. Алгоритмы поисковых систем Гугл и Яндекс постоянно меняются. Обеспечьте стабильный и беспрепятственный доступ роботов к тем страницам сайта, которые должны участвовать в поиске. Регулярно добавляйте уникальные и полезные материалы, наращивайте ссылочную массу с посторонних ресурсов и с индексацией никогда не будет проблем.

А как обстоят дела с индексацией страниц ваших сайтов? Поделитесь опытом в комментариях.

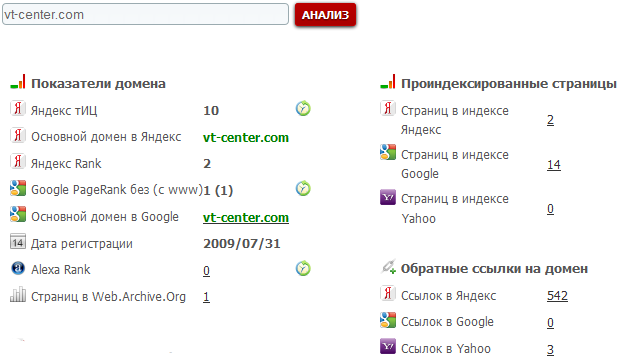

Проверь своих доноров / Статьи / CS Sape Master

Очень важная (по крайней мере, для тех, кто занимается продвижением веб-сайтов в сети) функциональная возможность. При помощи CS Sape Master можно проверять купленные ссылки по 39-ти показателям:

Таким образом, располагая подобным инструментом, можно «устроить» массовую модерацию ссылок по одному и нескольким проектам. Ну и, кроме того, CS Sape Master, благодаря таким возможностям, позволяет оптимизатору проводить множество экспериментов со ссылочной массой.

Для проверки показателей доноров по уже размещенным ссылкам необходимо перейти в раздел «Оптимизатору / Ссылки», выбрать слева в древовидном списке интересующие проекты, нажать кнопку . Затем отметить интересующие ссылки и нажать на нижней панели инструментов кнопку :

Затем отметить интересующие ссылки и нажать на нижней панели инструментов кнопку :

В появившемся диалоговом окне «Параметры проверки данных» необходимо отметить галками интересующие вас показатели и нажать кнопку «ОК»:

Рассмотрим подробнее, как проверяется тот или иной показатель и как это можно применить на практике.

Индексация доноров в Яндексе (YAP). Очень важный показатель. По последним статистическим данным нашей компании, около 10-50% купленных ссылок находятся на страницах, отсутствующих в индексе Яндекса. Соответственно, по умолчанию от 10 до 50% бюджета на продвижение сайта расходуется впустую.

Индексация ссылок в Яндексе (YAL). Очень неоднозначный показатель. Связано это с тем, что корректно проверить индексацию ссылки на сегодняшний день довольно сложно. Поиск текста ссылки на странице не всегда адекватен, равно как и анализ того, что находится в кэше Яндекса. Так, например, страница, отсутствующая в индексе Яндекса, иногда показывается в кэше Яндекса (если сформировать URL запроса вручную). В CS Sape Master проверка индексации ссылки осуществляется через поиск текста ссылки на заданной странице-доноре (аналог YAL в SAPE).

Страниц в индексе Яндекса (у донора). У хороших, контентных сайтов данный показатель врядли будет ниже 1000-1500. У сайтов, предназначенных не для людей и созданных специально под SAPE, число страниц в индексе Яндекса редко превышает 500—700 страниц.

Наличие в Яндекс.Вебмастер. Программа соединяется с сервисом Яндекс.Вебмастер и проверяет, что ссылка есть в списке обратных ссылок по данным этого сервиса. Для использования, необходимо указывать логин и пароль от аккаунта Яндекс.Вебмастер в настройках программы.

Индексация доноров в Google. Проверка индексации страницы, на которой размещается ссылка в поисковой системе Google. Данный параметр не важен при продвижении под Яндекс.

Индексация ссылок в Google. Неточный параметр, проверяется косвенным методом — проверяется индексация анкора на указанной странице.

Неточный параметр, проверяется косвенным методом — проверяется индексация анкора на указанной странице.

Уникальность. Определяется уникальность текста страницы путём проверки в Яндексе. В результате показывается процентное содержание уникальных пассажей в тексте страницы.

тИЦ Яндекса. Актуализация значений тИЦ сайтов, на которых куплены ваши ссылки. Обычно полученные значения совпадают со значениями, полученными с SAPE. Однако, во время и после апдейтов тИЦ значения могут отличаться.

Склейка тИЦ. Недобросоветсные вебмастера могут использовать склейку сайтов через зеркала, в этом случае параметры основного зеркала передаются второстепенному. Данный параметр помогает определить склейку сайтов и показывает главное зеркало.

Google PR (страницы). В последние годы показатель PR стал более адекватно давать представление о качестве сайта (сайтам, активно продающим ссылки в больших количествах, часто стали обнулять Google PR). Рекомендуется периодически проверять значения Google PR для купленной ссылочной массы.

Google PR главной («морды»). Качественные сайты, как правило, имеют довольно большие значения Google PR главных страниц. Если PR главной страницы донора нулевой, то стоит подробнее изучить данный сайт.

Склейка PR. Недобросоветсные вебмастера могут использовать склейку сайтов через зеркала, в этом случае параметры основного зеркала передаются второстепенному. Данный параметр помогает определить склейку сайтов и показывает главное зеркало.

Уровень вложенности (УВ). Очень часто, покупая ссылку со страницы второго уровня вложенности, мы получаем через некоторое время ссылку с третьего, а то и более высокого уровня вложенности. Связано это с тем, что на динамических сайтах, коих сейчас большинство, контентные страницы со временем «уходят» в архив. Теоретически, чем меньше уровень вложенности страницы-донора, тем весомей купленная на этой странице ссылка (при прочих равных).

Количество внешних ссылок. По количеству внешних ссылок также существует возможность «обмана» оптимизатора вебмастером. Как известно, боты SAPE ходят с одних и тех же IP-адресов. Ничего не мешает «нечистым на руку» вебмастерам обманывать ботов SAPE, «показывая» заниженное число внешних ссылок. Теперь, благодаря CS Sape Master, можно легко сравнить заявленное и реальное количество ВС. Однако, следует помнить, что не всегда отличие в количестве внешних ссылок говорит о «нечистоплотности» вебмастера. В SAPE очень часто встречаются сайты / страницы с динамическим содержимым, на которых число внешних ссылок может меняться само по себе.

Количество внутренних ссылок. Большое количество внутренних ссылок скорее всего приводит к снижению ссылочного веса, который передаётся внешним ссылкам на доноре. Некоторые оптимизаторы рекомендуют не размещать ссылки на донорах, где имеется большое количество внутренних ссылок.

Тематика донора. Рубрика Яндекс.Каталога (если сайт опубликован в нем) или просто тематика по версии Яндекса. Рекомендуется покупать ссылки с сайтов той же или близкой тематики что и сайт-акцептор.

Точная тематика. Программа пытается определить тематику сайта, лучше всего работает для достаточно авторитетных ресурсов. Формулировки тематик берутся из Яндекс.Каталога.

DMOZ. Рубрика Открытого каталога, к которой отнесён сайт.

Alexa Rank. Ранг сайта по версии alexa.com.

Регион по Яндексу. Принадлежность сайта к тому или иному региону. В свете новых алгоритмов ранжирования в Яндексе параметр является очень актуальным. Считается, что ссылки с сайтов того же региона что и сайт-акцептор более эффективны при поисковом продвижении.

Текст ссылки. При помощи данного показателя можно проверять наличие и корректность установки ссылок на страницах-донорах.

Стоп-слова. Проверка наличия в тексте донора нежелательного текста. Список стоп-слов можно указать в настройках программы. Имеется возможность проверять стоп-слова в различных словоформах.

Список стоп-слов можно указать в настройках программы. Имеется возможность проверять стоп-слова в различных словоформах.

Шаблоны. Специфический параметр для поиска текстовых шаблонов в HTML-коде страниц. Шаблоны задаются в настройках программы в виде регулярных выражений.

Тайтл. Определяет и выводит текст заголовка страницы (текст в теге <title>).

Возраст, дней. Проверка возраста доменов. Проверка проводится через сервис SEOBudget бесплатно. Определяется возраст только для RU доменов. Для проведения проверки нужно зарегистрироваться на сервисе SEOBudget и указать данные от аккаунта в настройках программы.

Solomono BL. Количество обратных ссылок на донора по данным Solomono. Если на донор не ссылается ни одного сайта (значение параметра равно нулю), то скорее всего эффект от размещения ссылки на таком доноре минимален.

Страниц в индексе Solomono. Количество страниц, проиндексированных сервисом Solomono.ru.

Входящих к исходящим. Программа рассчитывает соотношение количества входящих ссылок к исходящим по всему сайту по данным сервиса Solomono. То есть определяется число беклинков исследуемого сайта и число всех внешних ссылок на нём, рассчитывается их отношение. Не рекомендуется покупать ссылки на тех сайтах, соотношение которых менее 1.

Исходящих на страницу. Данный параметр показывает усреднённое количество внешних ссылок на каждую страницу сайта.

Объем текста. Страницы-доноры с минимальным объемом контент чаще других «выпадают» из индекса Яндекса (т. к. несут никакой ценности для пользователя). Рекомендуется выбрать для себя оптимальный объем страницы-донора и ориентироваться на него.

Расстояние. Среднегеометрическое расстояние между ссылками, выраженное в количестве символов. Этот параметр позволяет выявлять «блочное» расположение ссылок на доноре. Чем меньше значение параметра, тем «кучнее» расположены внешние ссылки на странице.

Позиция на странице. Показывает в какой части страницы размещена ссылка. Параметр рассчитывается в процентах от всего конетента страницы. 90-100% означает, что ссылка расположена в «подвале» страниц и размещение даной ссылки скорее всего не принесёт эффекта.

Модули. Определение популярных модулей и скриптов, которые использовал вебмастер при создании донора. В частности, не рекомендуется размещать ссылки на сайтах с форумными и блоговыми движками.

XT rank. Траст страницы-донора, данные получаются с сервиса http://xtool.ru/

XTD rank. Траст сайта-донора, данные получаются с сервиса http://xtool.ru/

SeoMoz PA. Расшифровывается как SeoMoz Page Authority, альтернативная интерпретация траста страницы, подробное описание тут

SeoMoz DA. Расшифровывается как SeoMoz Domain Authority, альтернативная интерпретация траста сайта, подробное описание тут

Посещаемость. Определяется посещаемость из открытого счётчика LiveInternet, если он установлен.

IP донора. Позволяет вычислить сетки сайтов и сайты, располженные на одном IP адресе. Некоторые оптимизаторы не советуют размещать ссылки на сайтах, расположенных на одном IP адресе.

Быстрая проверка индексации страниц / сайтов в Яндексе, возможность работы через прокси-серверы (http), проверка показателей доноров

Николай И. Яровой, 23.10.2009

← К списку статей

Инструкция по работе с Яндекс.Вебмастер для владельцев сайтов

Яндекс.Вебмастер – инструмент, который является своеобразным посредником между поисковой системой и вашим сайтом. Сервис был запущен в 2007 году и за 8 лет существования стал незаменимым помощником для многих веб-мастеров.

Для чего необходим Яндекс.Вебмастер?

С помощью данного сервиса вы сможете дать сигнал поисковой системе, о том, что появился новый сайт, на который ей необходимо обратить свое внимание.

Как всегда, все начинается с регистрации почтового ящика на Яндексе (если у вас его еще нет). Он будет служить вашим логином для Вебмастера.

После этого задача становится сложнее. Необходимо предоставить доказательства, что сайт действительно ваш. Для этого нужно разместить мета-тег, предложенный сервисом, на главной странице сайта. Однако подробнее на этом моменте мы остановимся позднее, а сейчас продолжим знакомство с остальными функциями.

Для чего необходимо добавлять сайт в Яндекс.Вебмастер?Первым по счету идет раздел «Общая информация». С помощью него вы сможете узнать о количестве внешних ссылок и страниц в поиске, а также узнать когда в последний раз заходил поисковый робот и сколько ему удалось загрузить страниц. Ну и, естественно, просмотреть данные о тематическом индексе цитирования (ТИЦ).

Так выглядит общая информация о сайте на Яндекс.Вебмастер.

Раздел «Проверить URL»

Здесь вы сможете проверить наличие определенной страницы веб-ресурса в поисковой системе. Для этого просто введите ее адрес и кликните на кнопку «Проверить URL».

Так происходит проверка индексации страницы в Яндекс.Вебмастер.

Несмотря на кажущуюся простоту, данный раздел имеет неочевидные функции, о которых мы поговорим в следующих статьях.

Подраздел «Индексирование сайта»Очень важно, чтобы все страницы ресурса были правильно проиндексированы и корректно отображались в поисковой выдаче.

Для того, чтобы поисковый робот загрузил страницы сайта нужно, чтобы он на них как-то попал. Чаще всего это происходит после перехода с другой внутренней страницы ресурса. Поэтому стоит уделить огромное внимание грамотной перелинковке статей, а также создать карту сайта (как для роботов так и для пользователей). Посмотреть, как Яндекс видит навигацию вашего сайта можно в разделе «Структура сайта».

Посмотреть, как Яндекс видит навигацию вашего сайта можно в разделе «Структура сайта».

Пункт «Структура сайта» в сервисе Яндекс.Вебмастер.

Кроме того, стоит обратить внимание на конкретные страницы отображающиеся в поисковой выдаче.

Подраздел «История»Сервис способен отражать историю обращений робота к страницам сайта. Открыв вкладку «Количество запросов» вы увидите график доступности сайта.

На вкладке «HTTP коды» вы получите более подробную информацию о том, какой ответ возвращал сервер поисковому роботу. Наиболее распространенные из них:

- 1Зеленый график (ОК) – все работает корректно.

- 2Синий график (3ХХ) – означает, что страница перенаправляет на другой URL.

- 3Красный график (4ХХ) – ошибка доступа клиентского запроса.

В интерфейсе Яндекс.Вебмастера это выглядит следующим образом:

График ответа сервера в Яндекс.Вебмастер.

Раздел «Настройка индексирования»

Чтобы исключить из индекса мусорные страницы (например, страницы постраничной навигации, теги и др.) нужно установить запрет на их индексацию в специальном файле – robots.txt.

Правильно составленный robots.txt – еще один немаловажный шаг, который позволит поисковому роботу корректно проиндексировать ваш сайт. Описание тонкостей работы с robots.txt займет не одну страницу, поэтому более подробно о нем мы расскажем в следующих статьях.

Подраздел «Главное зеркало»Для того, чтобы не потерять ваш ресурс после склеивания доменов, необходимо определиться с главным зеркалом сайта.

- Для начала нужно выбрать главный домен (стоит помнить, что он может начинаться с префикса WWW). Если этого не сделать, то сервис определит основной домен автоматически. При таком раскладе все ссылки, установленные не на основное зеркало потеряют вес.

- Если у вас есть 2 сайта с одинаковым контентом, которые расположены на разных доменах, то риск применения санкций от Яндекса очень велик. Указание главного зеркала поможет избежать бана в поисковой системе.

Раздел «Поисковые запросы»

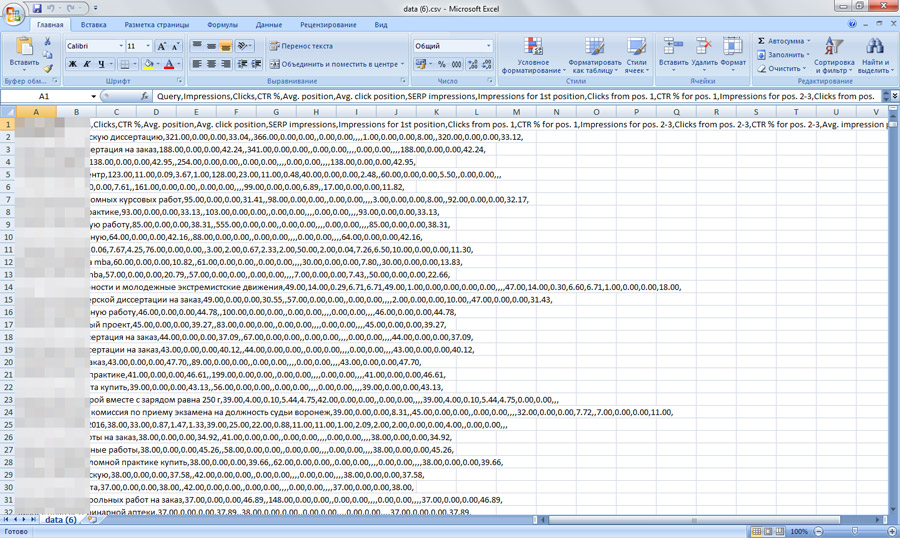

Яндекс.Вебмастер предоставляет возможность просматривать запросы, по которым сайт чаще всего показывался в поисково выдаче Яндекса. Сделать это можно в разделе «Поисковые запросы». Открыв раздел, вы увидите таблицу с запросами, разбитую на 4 колонки. Ее можно отсортировать по показам или кликам. Большим плюсом является возможность сохранения таблицы в файл Excel.

Раздел «География сайта»

Ваш сайт имеет региональную направленность? Тогда данная функция окажется весьма полезной. Раздел «География сайта» может помочь подняться в выдаче определенного региона, так как Яндекс использует особенные методы ранжирования для ресурсов имеющих географическую привязку.

Функция «Оригинальные тексты»Яндекс.Вебмастер имеет очень полезную функцию, которая позволит защитить контент, размещаемый на страницах вашего сайта.

Функция «Оригинальные тексты»

Загрузив свой текст в специальную форму, вы дадите сигнал Яндексу об истинном авторстве контента. Это обезопасит вас от случаев, когда кто-то нагло ворует ваши труды, до появления их в индексе поисковой системы.

Раздел «Сайт в результатах поиска»

В этом разделе находится пункт «Быстрые ссылки». Они представляют из себя набор популярных ссылок, которые наиболее интересны посетителям.

Быстрые ссылки в поисковой выдаче.

К сожалению, система определяет их автоматически. Указать вручную их невозможно. Однако есть некоторые рекомендации, позволяющие помочь поисковому роботу корректно определить быстрые ссылки для вашего сайта. Опять-таки, их выполнение не дает никаких гарантий, что Яндекс будет их учитывать.

Опять-таки, их выполнение не дает никаких гарантий, что Яндекс будет их учитывать.

Подраздел «Регистр имени сайта» может пригодится в том случае, если вы захотите подкорректировать название сайта изменив прописные буквы на строчные (или наоборот). Это никак не отразится на позициях в поисковой системе.

Раздел «Безопасность»

На данной странице вы увидите вредоносный код, который Яндекс может обнаружить на сайте. Стоит отметить, что страницы сканируются выборочно и это не гарантирует полной безопасности.

Раздел «Права на управление»

При необходимости передачи прав на управление другому пользователю, вы можете зайти в раздел «права на управление». На странице, вам понадобится указать логин пользователя на Яндексе и кликнуть на кнопку «Делегировать права». Выглядит это следующим образом:

Форма добавления юзера для управления сайтом.

Данная функция пригодится вам, при заказе продвижения сайтов у нашей веб-студии. Это позволит нашим специалистам учесть все нюансы вашего проекта и помочь ему занять высокие места в поисковых системах.

Назад

Способы ускорения индексации сайта в Яндексе и Гугле

В общем случае ситуация обстоит следующим образом: чем чаще обновляется информация на сайте, тем чаще её посещают поисковые роботы. Таким образом, если вы хотите, чтобы страницы быстрее попадали в индекс поисковых систем, нужно как можно чаще обновлять информацию.

Но все мы понимаем, что сайты бывают разные, и для многих из них просто нет особой нужды в регулярных обновлениях. Поэтому, когда у подобного сайта настаёт необходимость «загнать» в индекс новую страницу, могут возникнуть проблемы.

Проблемы с индексацией сайта

Проблемы с индексацией сайта:

- Страницы вообще не индексируются поисковыми системами.

- Страницы слишком долго индексируются Яндексом и Гуглом.

- Страницы слишком долго индексируются какой-то одной поисковой системой (а в другой всё в порядке).

Итак, если ваш сайт совсем не индексируется, то первое, что нужно проверить — записи в файле robots.txt. Не исключено, что в директивах этого файла установлен запрет на обход вашего сайта (всего сайта, раздела, группы разделов) поисковыми роботами. Просмотрите также на предмет индексации настройки хостинга, мета-теги robots и настройки системы управления сайтом (в некоторых CMS можно выставлять запрет/разрешение индексации).

Если страницы слишком долго индексируются Яндексом и Гуглом, но никакого запрета к индексации нет, причины этого могут крыться в самом широком диапазоне — от плохой внутренней оптимизации до некачественных с точки зрения поисковых систем материалов на сайте.

Если страницы быстро «залетают» в индекс Яндекса, а в Гугл ни в какую (или наоборот), то не исключено, что ваш сайт находится под фильтром одной из поисковых систем. В таком случае следует тщательно проанализировать сайт, в том числе используя инструменты для вебмастеров. Стоит отдавать себе отчёт, что не все санкции будут видны в консолях. И даже если вы переписывались с Яндексом, и поддержка сообщила, что с сайтом всё в порядке — относитесь к их речам скептически и слепо не верьте всему, что они пишут.

Способы ускорения индексации сайта

- Добавьте сайт в вебмастер Яндекса и консоль Гугла. Во-первых, внутри этих вебмастерских есть отличные инструменты, с помощью которых вы можете отследить проблемы с индексацией документов. Во-вторых, вы можете отправить на переиндексацию в ручном режиме нужные страницы (в Яндексе «переобход страниц», в Гугле «запросить индексирование»).

- Создайте карту сайта sitemap.xml. Карта сайта необходима для того, чтобы роботы быстрее ориентировались в структуре ресурса. Карта должна быть динамической, чтобы каждый раз вручную не добавлять в неё адреса новых страниц.

После того, как вы создадите карту, добавьте её в вебмастер Яндекса и консоль Гугла.

После того, как вы создадите карту, добавьте её в вебмастер Яндекса и консоль Гугла. - Прогоните сайт по каталогам. Смысл такой: чем больше ссылок стоит на документ, тем выше вероятность того, что поисковые роботы быстрее до него доберутся. Не стоит забывать и про положительный побочный эффект прогона сайта по каталогам и RSS-лентам (прирост ссылочной массы со всеми вытекающими последствиями). Минус этого способа — потребуется потратить небольшие деньги.

- Поставьте ссылку с регулярно обновляемого сайта. Если у вас есть собственный блог, который вы регулярно обновляете, просто поставьте с него ссылку на сайт. Самый верный вариант, который точно ускорит индексацию — простановка ссылки с новостного ресурса. Сделать это можно несколькими способами: купить ссылку с новостника на ссылочной бирже, договориться с владельцем такого ресурса напрямую, ворваться в студию новостного канала и под угрозой самоподрыва потребовать проставить на их сайте ссылку. Вариантов масса.

- Используйте соцсети. Разместите посты со ссылками на необходимые страницы в различных соцсетях — вконтакте, фейсбуке и т. п. Раньше для быстрой индексации отлично помогало размещение ссылок в твиттере, сейчас, в 2020-м году этот метод можно едва ли назвать рабочим.

- Полить трафиком. С учётом того, что поисковые системы, особенно Яндекс, последнее время всё больше учитывают в своих алгоритмах поведенческие факторы, сам бог велел использовать этот метод. Сделайте так, чтобы на страницы вашего сайта пошло как можно больше посетителей (да хоть бы и ботов). Есть немало сервисов, которые буквально за копейки обеспечат вам трафик в необходимом количестве.

- Используйте онлайн-сервисы для ускорения индексации. Принцип их работы схож с пунктами 3-5. Разумеется, сервисы платные, но иногда проще воспользоваться ими, если у вас нет времени или все остальные способы не помогли. Стоимость услуг невысока, самыми популярными сервисами являются bulkaddurl.

com и indexgator.com.

com и indexgator.com.

Ускорение индексации ссылок

Допустим, вы купили на свой сайт множество ссылок на разных площадках. Пока роботы обойдут все доноры, пока проиндексируют, пока поисковые системы начнут учитывать ссылки… может пройти не один месяц. Нужно роботов подтолкнуть и направить в нужную сторону.

Есть достаточно эффективный, простой и бесплатный способ ускорить индексацию ссылок. Для этого вам всего лишь нужно иметь свой сайт, например, блог, который регулярно обновляется и хорошо индексируется поисковыми системами. Механизм следующий:

- Собираете адреса всех площадок-доноров, где вы разместили ссылки на свой сайт.

- Пишете любой пост в своём блоге и вставляете прямо списком все эти адреса в запись.

- Принудительно отправляете на переобход в консоли Гугла (и вебмастере Яндекса) урл написанного поста.

- В Гугле страница сразу же после переиндексации попадает в индекс.

- После того, как страница попала в индекс, можете отредактировать пост и убрать список адресов из записи.

- Робот уже пробежал по всем размещённым ссылкам и посетил страницы доноров.

- Вы молодец. Да и робот тоже красавчик.

Это отличный способ, позволяющий ускорить индексацию ссылок, прежде всего для Гугла, т. к. инструмент в консоли «запросить индексирование» принудительно и мгновенно индексирует страницу. В Яндексе инструмент «переобход страниц» работает не так быстро, но если ваш блог действительно регулярно обновляется, то, как правило, новые страницы в индекс попадают достаточно быстро. Поэтому этот способ годится и для Яндекса.

Как ускорить индексацию сайта в Яндексе и Google одновременно?

1. Карта сайта

Карта сайта – файл, в котором содержатся адреса всех страниц ресурса, он находится в корне файловой системы и носит имя Sitemap. Перед началом индексирования, поисковый робот обращается к этому файлу, после проходит все (если не позволяет краулинговый бюджет, то часть) указанные в нем страницы. Такая карта создается в формате XML, как вручную, так и с помощью специальных сервисов или плагинов для CMS. Кроме XML карты, можно создать отдельную HTML страницу, содержащую в себе ссылки на все страницы сайта.

Такая карта создается в формате XML, как вручную, так и с помощью специальных сервисов или плагинов для CMS. Кроме XML карты, можно создать отдельную HTML страницу, содержащую в себе ссылки на все страницы сайта.

После создания карты, ее нужно загрузить в Вебмастере Яндекса и в Google Search Console в соответствующие разделы.

Загрузка карты сайта в Яндекс Вебмастер

Загрузка карты сайта в Google Search Console

Нужно понимать, что карта сайта должна либо обновляться автоматически, либо вручную при добавлении нового материала.

2. Создание robots.txt

В данном файле указывают правила индексирования тех или иных страниц, разделов и сайта в целом. Не все страницы могут быть полезны для пользователя, поэтому их важно закрыть от индексации. Сделать это можно в файле robots.txt, прописав специальную директиву.

Путь до карты сайта прописывается также в этом файле.

Синтаксис позволяет применять для определенных поисковиков уникальные правила.

Если robots.txt заполнен корректно и исключает из индекса все мусорные страницы, то это положительно влияет на скорость индексации (а в некоторых случаях и на ранжирование) ресурса. Подробнее про файл robots.txt можно прочитать в Яндекс Справке.

3. Сайт с правильной структурой

Один из основных факторов, влияющих на скорость индексации – логически правильная структура сайта. Желательно избегать таких структур, при которых страница может оказаться более чем на 5-ом уровне вложенности, что усложнит работу краулеру. Идеал до 3-х уровней вложенности. О том, как проверить и сократить уровень вложенности страниц мы писали в соответствующей статье блога.

4. Перелинковка внутренних страниц

Кроме ссылок в общем меню, рекомендуется продумать дополнительную перелинковку страниц. Дело в том, что краулер имеет возможность посещать только те страницы, на которые имеются ссылки. Наиболее действенным вариантом будет размещение URL-адресов на посещаемых страницах, например, главной.

К внутренней перелинковке также относятся блоки рекомендованных товаров, похожих или новых материалов, гиперссылки внутри статьи с анкорами, которые могут содержать ключевые слова.

Рекомендуется проставлять ссылки обдуманно, чтобы страница донора и акцептора были релевантными между собой. Также должен соблюдаться принцип, при котором на любую полезную для пользователя страницу, ведет внутренняя ссылка.

Хлебные крошки являются элементом навигации и улучшают внутреннюю перелинковку.

5. Качество текстов

Не допускается публикация дублей текстового контента с других ресурсов, с этим поисковики активно и успешно борются. Контент в первую очередь, должен быть уникальным и полезным для посетителя. Что касается уникальности, то она легко проверяется в одном из многочисленных сервисов, в том числе и на поверхностный рерайт.

К качеству текстов можно отнести и подход к их SEO оптимизации. Если на странице присутствует большое количество переспама и воды, то она скорее всего не проиндексируется краулером.

Помните, поисковые алгоритмы хорошо понимают структуру текста, и даже неправильные окончания или многочисленные орфографические ошибки, могут стать причиной плохой индексации сайта или даже попадания его под фильтры.

Объем текста может влиять на индексацию страницы в целом, поэтому рекомендуется публиковать статьи более 1500 символов.

6. Дубли страниц

Созданием дублей грешат многие CMS. Одна и та же страница может иметь разные URL-адреса, в зависимости от того, в каком месте она публикуется.

Примеры дублей страниц:

- url.ru/str.html

- url.ru/str

- url.ru/str/

По факту, это одна страница, но для поисковика разные, точнее по разным адресам он видит одну и ту же. Если сайт небольшой, то робот отбросит 3 URL, оставив в индексе один, но если страниц много, то проблем с индексацией не избежать.

Чтобы закрыть вопрос создания дублей, следует установить и настроить плагин на свою CMS систему, благо под большинство они уже есть в готовом варианте. Плагин, как правило, не только удаляет дубли, но и создает 301 редиректы в файле .htaccess.

Плагин, как правило, не только удаляет дубли, но и создает 301 редиректы в файле .htaccess.

7. Регулярное наполнение сайта

Если ресурс наполняется нерегулярно, то робот может растянуть диапазон между своими визитами, что в свою очередь, значительно замедлит попадание новых страниц в индекс.

Если говорить о публикации новых материалов, то рекомендуется делать это не реже раза в неделю, тогда сайт будет выглядеть «живым» в глазах поисковиков. А если же страницы будут появляться ежедневно, то через определенное время краулер будет посещать ресурс по несколько раз в сутки.

8. Панели вебмастеров

Новый сайт сразу после его создания, рекомендуется добавить в панели вебмастеров Яндекса и Гугла: Вебмастер и Search Console.

Добавление сайта в Яндекс Вебмастер

Добавление сайта в Google Search Console

Внутри этих панелей происходит добавление файлов карт сайта, отслеживание основных показателей, а также там можно увидеть многочисленные рекомендации по улучшению ресурса в целом.

При добавлении, будьте готовый к тому, что придется подтвердить права владельца ресурса. Делается это разными способами, например, с помощью специального файла, который необходимо будет разместить в корне сайта.

9. Переобход страниц

Чтобы сообщить Яндексу о новых страницах, следует в Вебмастере зайти в «Индексирование-Переобход страниц», и добавить список URL-адресов.

Добавление списка URL для переобхода

О статусе переобхода отправленных страниц можно узнать на этой же странице Яндекс Вебмастера.

10. Google Indexing API

Чтобы ускорить индексацию новых страниц в Google, имеется специальная технология – Google Indexing API. В официальной справке сказано, что она ориентирована лишь на сайты с видеоконтентом и вакансиями. Но по факту, поддерживаются ресурсы с другими типами контента.

После подключения Indexing API, в Google будут автоматически отправляться запросы с информацией о новых, обновленных или удаленных страницах.

11. Скорость загрузки страниц

Важнейший параметр, который влияет на качество индексации и ранжирования в целом. Для проверки скорости загрузки отдельно взятой страницы можно использовать сервис PageSpeed Insights, там же будут даны подробные рекомендации по оптимизации ресурсов (медиа, кода и т.д.).

Также эта информация доступна в Яндекс Метрике, в отчете «Время загрузки страниц».

Отчет о времени загрузки страниц

12. Обратные ссылки с тематических ресурсов

Ссылочная масса – один из основных инструментов SEO продвижения. Но влияет она не только на ранжирование сайта, но и на скорость его индексации. К примеру, разместив ссылку на тематическом ресурсе (сайт схожей тематики), ведущую на новую страницу вашего сайта, вы поможете крайлеру быстрее о ней узнать.

13. Ссылки с социальных сетей

Получить ссылку на страницу сайта можно путем ведения своей группы в одной из ведущих социальных сетей (ВК, FB, Instagram, Твиттер). Особенное влияние это имеет на пауков Google, при такой публикации, новая страница может «залетать» в индекс буквально за считанные часы. Особенно это касается ссылок из Твиттера. Для Яндекса к Твиттеру стоит добавить «ВКонтакте». Правило простое – чем больше активности в соц. сетях, тем чаще вас посещают краулеры.

Если нет возможности полноценно вести соц. сети, то как вариант, стоит попробовать кросс-постинг. То есть после публикации материала на сайте, его вступительная часть копируется в пост социальной сети и делается ссылка на страницу. В таком случае первоисточником будет выступать сайт, но краулер гораздо быстрее доберется до опубликованной страницы.

14. Размещение сайта в различных рейтингах

Также увеличивает ссылочную массу ресурса и ускоряет его индексацию. В качестве таких рейтингов можно выделить:

- Рейтинг Mail.ru.

- Рамблер Топ 100.

- LiveInternet.

Добавление сайта в рейтинг Mail. ru

ru

Размещение сайта в рейтинге Рамблер Топ 100

Рейтинг LiveInternet

15. Ссылки в комментариях

Большинство блогов работают на системе WordPress, у которой имеется возможность комментирования с прикреплением ссылки на свой сайт. Первое, что нужно сделать – найти тематические блоги, в которых автор разбирает смежную тематику. После идем в комментарии, пишем осмысленный текст, но вместо ссылки на сайт, ставим ее на страницу.

Главное правило – блог должен быть схожей тематики, иначе такая ссылка может засчитаться за неестественную (поставленную для манипуляций факторами ранжирования). Если добавить ссылку в тело комментария, она, скорее всего, не пройдет модерацию.

16. Ссылки с форумов

На форумах можно (если допускается администрацией) вести диалоги, ссылаясь на свой ресурс. Кроме этого, в настройках профиля часто встречается поле «Сайт», которое рекомендуется заполнить. Однако этот метод довольно-таки сложен в исполнении, т.к. высокопосещаемые форумы активно модерируются, посторонние ссылки не допускаются.

Постинг на форумах с обратными ссылками имеет свои нюансы, и если нет опыта, то лучше доверить это специалистам. Услуга называется «Крауд-маркетинг».

17. Пингование

С помощью пингования, поисковые системы оповещаются при появлении нового контента. В WordPress эта функция реализована уже «из коробки», достаточно указать в админке ссылки на специальные сервисы.

Функция пингования в WordPress

Вот сервисы, которые используются для пингования:

- Pingomatic;

- Pingler;

- Pingoat.

Помните, при частом пинговании, поисковики могут принять это за спам.

18. Ловец ботов

Схема актуальна для многостраничных проектов, достаточно сложна в исполнении. Ловец ботов – программный алгоритм, которые следит за процессом индексации краулером, указывая ему ссылки на нужные (непроиндексированные ранее) страницы. Работает он по принципу отслеживания посещенных роботом страниц в логах сервера. В рамках данной статьи не будем углубляться в эту тему, но при продвижении крупных сайтов стоит иметь ее в виду, обратившись при этом к компетентным командам (SEO, программисты).

Работает он по принципу отслеживания посещенных роботом страниц в логах сервера. В рамках данной статьи не будем углубляться в эту тему, но при продвижении крупных сайтов стоит иметь ее в виду, обратившись при этом к компетентным командам (SEO, программисты).

Проверка индексации сайта в Google и Яндекс

Ситуация не из приятных: сканирование сайта поисковыми роботами проходит достаточно быстро, но процесс добавления страниц в индекс не оправдывает ожиданий. Одни страницы сайта не попадают в базу поисковых систем, а другие удаляются. В результате ресурс ранжируется по проиндексированным данным. Если в индекс попали целевые страницы, вам повезло чуть больше. Так или иначе на позиции сайта в выдаче проблемы с индексацией влияют отрицательно.

Мы подготовили чек-лист, который поможет быстро оценить видимость страниц индексе и их количество.

Корректное управление индексацией позволяет оптимизировать расход краулингового бюджета: роботы индексируют только важные для продвижения страницы.

- Панели веб-мастеров

В Google Search Console проверяем «Статус индексирования» в разделе «Индекс». Проблемы с индексацией выглядят следующим образом:

Отметка «Проиндексировано всего» указывает число адресов, добавленных в индекс.

Просмотр удаленных страниц, прошедших индексацию успешно или с ошибкой доступен в отчете «Покрытие». Также можете проверить определенную страницу на попадание в индекс.

Проверка в Яндекс.Вебмастере осуществляется через путь «Индексирование сайта» — «Страницы в поиске». Далее при выборе «История» получим динамику количества страниц в поиске.

Пример сайта, не имеющего проблем с индексацией в Яндексе

Пример сайта с регулярно удаляемыми страницами.

- Проверка вручную: поисковые операторы

Операторы поисковых систем используются для уточнения результатов поиска. Оператор «site:» выводит список проиндексированных страниц. Для применения параметра в поисковую строку Google или Яндекс введите «site:[url сайта]». Для получения точных данных в Google необходимо перейти на последнюю страницу поиска. Различия в полученных цифрах — показатель наличия проблем на сайте или его попадания под фильтр поисковых систем.

Для получения точных данных в Google необходимо перейти на последнюю страницу поиска. Различия в полученных цифрах — показатель наличия проблем на сайте или его попадания под фильтр поисковых систем.

Оператор Cache проверяет частоту посещения сайта поисковым ботом. Настройте дополнительные инструменты поиска, чтобы просмотреть данные об индексации за час, день, неделю, месяц, год или все время.

- Автоматизированная проверка: плагины и букмарклеты

Букмарклеты — скрипты, сохраняемые в закладках браузера. Принцип работы плагинов и букмарклетов одинаковый: открываете сайт для проверки и призываете на помощь закладку из браузера. В результате получаете необходимую информацию за один клик, ничего не прописывая и не настраивая.

Расширения: SEO-tools, RDS bar, SimilarWeb, MozBar.

Работа с плагином RDS bar

- Специальные сервисы проверки

Специальные сервисы облегчают работу SEO-специалистов: позволяют не только проверить индексацию, но и выявить возможные проблемы. Среди таких сервисов: Netpeak Spider, SEO-reports, Rush Analytics. Кроме проиндексированных страниц дополнительно получаете код ответа, заголовки, метаописания, robots.txt и пр.

Возможные причины выпадения страниц из индекса и их решение:

- Недавний запуск сайта.

Индексирование недавно появившегося сайта занимает много времени. Для ускорения процесса пройдите регистрацию в «Add url», разместите сайт в каталоге и добавьте ссылки с рейтинговых ресурсов, социальных сетей.

- Отсутствие карты сайта (sitemap.xml).

Ее основная функция: сообщать поисковым системам об изменениях на ресурсе и задавать частоту проверки. Такие карты помогают сайту индексироваться быстрее с более эффективной скоростью обхода.

Чтобы проверить, есть ли страница в файле sitemap, используйте инструмент проверки URL в Search Console.

- Приватные настройки WordPress.

В настройках чтения уберите галочку с пункта «Видимость для поисковых систем».

- Ошибка в метатегах в коде страниц<meta name = “robots” content = “noindex”, nofollow” />.

Чтобы найти все страницы с метатегом noindex на вашем сайте, выполните аудит сайта через Ahrefs: просмотрите предупреждения в отчете “Внутренние страницы”. Для борьбы с этой ошибкой необходимо избавиться от строки или заменить элементы на «index» и«follow».

- Ошибка в использовании директив в файле robots.txt. Закрытие доступа в robots.txt черезUser-agent: * Disallow: /

Подробнее о работе с индексным файлом читайте здесь.

- Отсутствие уникального контента.

- Дублирование страниц.

Заполните сайт качественным и собственным контентом, удалите мусорные страницы, чтобы избежать санкций от поисковиков.

Чтобы максимально повысить скорость индексации, обновляйте сайт не реже 3 раз в неделю. Например, размещайте новые публикации и обновляйте старый контент. Google будет чаще сканировать ваш сайт, а обновленные старые публикации сохранят актуальность для новых посетителей.

Собирайте информацию о соотношении проиндексированных страниц, динамике их индексации, отслеживайте тренды. Необходимо регулярно отслеживать индексирование сайта, чтобы своевременно решать проблемы и предотвращать отрицательные последствия, вносить изменения в стратегию продвижения.

Павел Савицкий, SEO-специалист GUSAROV:

В большинстве случаев я пользуюсь таким сервисом, как Netpeak Spider. После сканирования сайта можно определить не просто страницы, которые не индексируются, но и выявить причины непопадания их в индекс поисковых систем. Этих причин может быть много: отсутствие или некорректно заполненные заголовки, мета-теги (заголовки в выдаче), закрытие от индексации в служебном файле robots.txt, некорректно настроенный редирект и т.д. Наличие многофункциональных возможностей Netpeak Spider позволяет выгрузить различные типы страниц (например, индексируемые и неиндексируемые) с техническими ошибками в Excel, что в дальнейшем приводит к ускорению работы по исправлению неиндексируемых URL.

04.03.2020

10 примеров применения операторов поиска Яндекс и Google

В работе SEO-специалиста есть необходимость отслеживать различные показатели своего сайта и сайтов конкурентов, например: количество страниц в индексе, наличие санкций, релевантность текстов, учет ссылок и т.д.

Многие параметры удобно проверять с помощью языка запросов поисковых систем. В этой статье мы научимся использовать его для решения следующих задач:

- Определение количества проиндексированных страниц сайта

- Проверка индексации страницы

- Определение даты первой индексации страницы

- Поиск мусорных страниц по URL

- Поиск дублей по title

- Поиск дублей текста по его фрагменту

- Поиск всех внутренних ссылок, ссылающихся на страницу

- Проверка документа на фильтр «переоптимизация»

- Проверка ссылок на «непот фильтр»

- Проверка сайтов на наличие фильтра «аффилирование»

Для некоторых проверок мы подготовили так называемые букмарклеты.

Букмарклет (Wiki: англ. bookmarklet; bookmark — «закладка» и applet — «апплет») — небольшая JavaScript-программа, оформленная как javascript:URL и сохраняемая как браузерная закладка.

Другим словами, букмарклет — это скрипт в закладке, после нажатия на которую он сработает. Для установки просто перенесите ссылку на панель закладок.

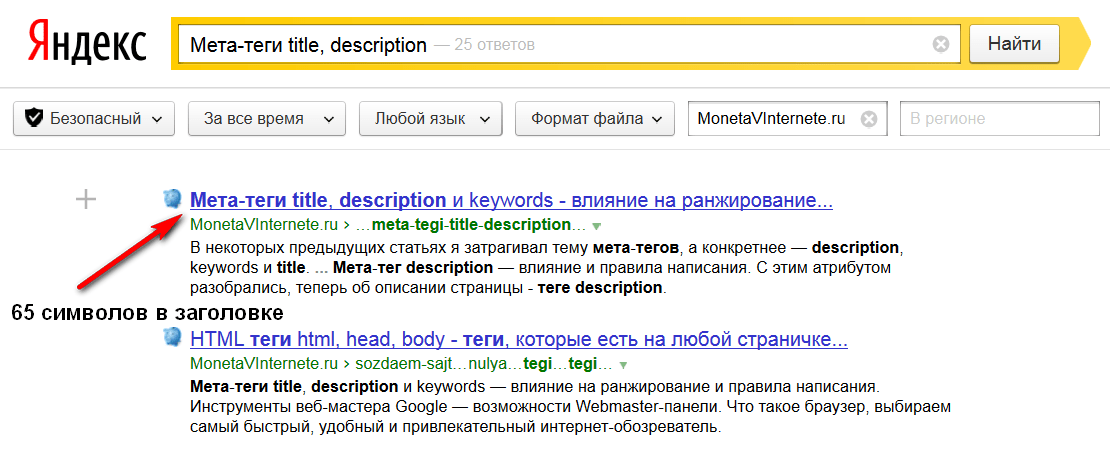

1. Определение количества проиндексированных страниц сайта

Нужно отметить, что самый лучший способ узнать количество страниц в поиске — посмотреть в SearchConsole Google или Вебмастере.Яндекс. Эти сервисы отражают самые точные данные.

Однако, если у вас нет доступа к упомянутым сервисам, можно использовать поисковые операторы.

Яндекс

Для того чтобы проверить количество проиндексированных страниц в Яндексе, есть два способа:

Способ № 1

Используем оператор site:. Этот оператор позволит осуществлять поиск по заданному сайту.

Букмарлет: Ya.site:

Если у вас на сайте несколько поддоменов, и вы хотите узнать количество страниц в индексе основного домена, то вместо оператора site: следует использовать оператор host.

Способ № 2

Запрос: url:www.domain.ru/* | url:domain.ru/* | url:domain.ru | url:www.domain.ru

В данном способе мы используем следующие операторы поиска Яндекс:

url: — позволяет осуществить поиск по страницам, размещенным по заданному URL

| — оператор «или». Позволяет осуществлять поиск документов, в которых присутствует любое слово из запроса.

Пример: при запросе [Спартак | ЦСКА]будут найдены документы, в которых присутствует хотя бы одно слово из запроса:

«цска» или «спартак».

* — оператор соответствует любому знаку.

Такой прием аналогичен способу с оператором host: поиск осуществляется по хосту, а не по всему сайту.

Надо отметить, что так проверяет индексацию популярный тулбар RDS-бар, из-за чего часто бывает, что количество страниц в Яндексе намного меньше, чем в Google.

Так вот, это связано не с проблемами на сайте, а из-за способа проверки.

Букмарлет: Ind.Ya

Google

Аналогично Яндексу, в Google для того, чтобы узнать количество страниц сайта в поиске, используется оператор site:.

Букмарлет: Go.site:

2. Проверка индексации страницы

В практике достаточно часто приходится проверять, проиндексирована страница или нет. Это очень просто проверить с помощью операторов:

Яндекс

url:www.site.ru/ | url:site.ru/

Важно! Нужно проверять на индексацию страницу с www и без www — это позволит вам вовремя отслеживать дубли и проблемы с зеркалами.

Пример:

В этом примере в индексе находятся дубли с www и без, что является ошибкой.

Букмарлет: Ind.Page.Y

Google

В Google для проверки индексации следует использовать оператор info и только его.

Букмарлет: Ind.Page.Go

3. Определение даты первой индексации страницы

В Яндекс есть возможность узнать дату первой индексации документа (возраст документа). Для этого нужно осуществить проверку индексации страницы как в предыдущем примере, и в URL Яндекс добавить GET параметр «&how=tm».

4. Поиск мусорных страниц по URL

С помощью операторов поиска можно легко найти мусорные страницы в индексе поисковой системы. К мусорным страницам относятся: корзина (cart), регистрация (register| login),страницы пользователей (users), файлы (files) , страницы сортировки (sort), страницы фильтров и поиска (filter, search).

Для того чтобы найти данные страницы можно использовать оператор siteсовместно с оператором inurl.

Inurl — оператор, с помощью которого можно осуществлять поиск по страницам в URL, где есть заданный фрагмент.

В Google-поиск осуществляется аналогичным способом.

5. Поиск дублей title

Яндекс

Данный поиск осуществляется с помощью оператора title: и site:.

Пример:

На скриншоте видно, что точного совпадения не найдено, но они точно есть. Для того чтобы найти все дубли в URL, нужно добавить GET параметр &noreask=1— он отключает исправление опечаток и добавляет результаты выдачи по схожим запросам.

Результат: мы нашли 46 совпадений по title.

Дополнительно в данной конструкции используются следующие операторы:

« — поиск в заданной словоформе и последовательности;

() — используются для группировки.

Букмарлет: Дубли по title Ya

Google

В Google есть аналогичный оператор intitle.

6. Поиск дублей текста по его фрагменту

Часто бывает, что большие фрагменты текста дублируются внутри сайта: это может негативно сказываться на ранжировании. Для того чтобы найти такие дубли, нужно осуществить поиск внутри сайта по фрагменту из нужного текста. В URL Яндекса также рекомендуем добавлять &noreask=1.

Пример:

Букмарлет: Text.Ya — Выделите текст и нажмите на ссылку. Букмарлет без оператора site:.

7. Поиск всех внутренних ссылок, ссылающихся на страницу

Для того чтобы узнать количество внутренних ссылок на страницу, можно использовать оператор linkint.

Рекомендуем использовать его вместе с оператором site:.

Букмарлет:linkint:

8. Проверка документа на фильтр «переоптимизация»

Как проявляется фильтр «переоптимизация»: резкая просадка группы запросов на странице — более чем на 30 пунктов.

Гипотеза: при использовании языка запросов фильтр «переоптимизация» снимается.

Тогда, что бы диагностировать «переоптимизацию», нужно проделать следующие шаги:

- Берем 5 сайтов, которые находится выше пациента на 1–5 позиции.

- С помощью следующего запроса сравниваем релевантности:

[запрос] (site:пациент.ру |site: конкурент.ру). - Если 3 и более сайта конкурента находятся ниже, можно говорить о переоптимизации.

Пример:

Пациент выше, можно говорить о переоптимизации.

9. Проверка ссылок на «непот фильтр»

«Непот фильтр» — это фильтр, который занижает влияние входящей ссылки на ранжирование в Яндекс.

Как проявляется «непот фильтр»: документ-акцептор становится невозможно найти по уникальному анкору — нивелируется динамический (анкорный) вес.

Для диагностики необходимо проверить, ищется ли документ по уникальному анкору

1. Сделать это можно следующим образом:

Проверить, проиндексирована ли ссылка (в сохраненной копии)

2. Проверить, что ссылка была учтена в Яндекс.Вебмастере.

3. Проверить, нет ли прямого вхождения в тексте документа: для этого можно использовать оператор intext, который позволяет осуществлять поиск только по тексту.

4. Если документ не найден, переходим к поиску по анкор-листу с помощью оператора inlink.

В данном примере документ найден — на ссылку «непот фильтр» не наложен.

В этой конструкции были использованы следующие операторы:

& — поиск документов, в которых слова встречаются в одном предложении;

! — поиск слова в заданной форме;

/+n, где n — максимальное расстояние между словами — поиск документов, в которых заданные слова располагаются в пределах n-слов друг от друга.

Замечания:

- Анкор должен быть уникальным.

- Используемая методика определения не до конца корректна и утверждение, что она показывает наличие «непот-фильтра», является допущением.(подробнее о непот фильтре можно почитать в статье Сергея Людкевича

10. Проверка сайтов на фильтр «аффилирование»

Фильтр аффилирования накладывается на сайты одного владельца, продвигающиеся по одинаковым запросам.

Как проявляется фильтр «аффилирование»: по запросам высоко ранжируется только один из сайтов.

Подробнее о фильтре тут.

Диагностика

Способ № 1

Запрос: lang:ru ~~ domain:ua<< (url:www.site1.ru | url:www.site2.ru)

Если показывается только один сайт, то можно говорить о том, что на сайты наложен фильтр аффилирования:

Способ № 2

Запрос: url:site.ru | url:site.ru ~~ url:qwerty

Если показывается только один сайт, то можно говорить о том, что на сайты наложен фильтр аффилирования.

В этой статье мы познакомились с поисковыми операторами и научились их применять для решения практических задач. Их использование не ограничивается только приведенными примерами. Экспериментируйте и ищите другие варианты применений.

Полезные ссылки:

Справка Яндекс

Справка Google

Статья по аффилированию Людкевича

Статья по аффилированию Бакалова

Еще по теме:

Евгений Аралов

SEO-аналитик SiteClinic.ru

Продвигаю сайты с 2009 года.

Выступал на конференциях AllInTop, Optimization

Публикую полезные статьи на различных блогах: siteclinic.ru, optimizatorsha.ru, searchengines.ru и веду Telegram-канал.

Сейчас руковожу SEO-отделом в компании SiteClinic: строю и координирую команду, обучаю специалистов.

Девиз: вперёд!

Оцените мою статью:

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

Как мне исключить страницы из поиска?

Иногда необходимо исключить страницу сайта из результатов поиска, например, если она содержит конфиденциальную информацию, является дубликатом другой страницы или была удалена с сайта.

- Шаг 1. Запретить индексирование страницы или каталога

- Шаг 2. Ускорить удаление страницы

- Как вернуть страницу в результаты поиска?

- FAQ

Есть несколько способов сделать это:

- Если страница удалена с сайта

- Если страница не должна отображаться в поиске

Проверить, соответствуют ли инструкции в роботы.txt верны, воспользуйтесь инструментом анализа Robots.txt.

Примечание. При сканировании сайта робот сначала обращается к файлу robots.txt, если он есть, а затем просматривает страницы сайта. Постраничное сканирование может занять некоторое время. Если вы хотите удалить много страниц из поиска, добавьте директиву Disallow для нужных страниц.

| Метод исключения | Поведение робота |

|---|---|

| Запрет в robots.txt файл | Робот прекращает доступ к странице в течение 24 часов. |

| Статус HTTP с кодом 404, 403 или 410 | Робот продолжает посещать страницу в течение некоторого времени, чтобы убедиться, что ее статус не изменился. Если страница остается недоступной, робот перестает ее сканировать. |

| Мета-тег robots с директивой noindex |

Когда робот заходит на сайт и обнаруживает, что ему запрещено индексировать, страница исчезает из результатов поиска в течение недели.URL удаленной страницы отображается в списке исключенных страниц на странице в Яндекс.Вебмастере.

Исключение из поиска страниц, нарушающих авторские права, не является приоритетной задачей робота. Чтобы исключить страницу из поиска, воспользуйтесь методами, описанными в этом разделе.

Исключенные из результатов поиска страницы могут отображаться в Яндекс.Вебмастере до следующего сканирования сайта.

Чтобы ускорить удаление страницы из поиска, попросите Яндекс удалить ее, не дожидаясь запланированного сканирования робота.

Если ваш сайт не добавлен или не верифицирован в Яндекс.Вебмастере:

- Перейдите на страницу Удалить страницы из результатов поиска в Яндекс.Вебмастере.

Введите URL-адрес страницы, которую нужно исключить, в поле, например http://example.com/page.html.

Нажмите кнопку «Удалить».

Чтобы исключить несколько страниц из поиска, удаляйте их по одной.

Если ваш сайт добавлен в Яндекс.Вебмастер и вы подтвердили свои права на управление сайтом:

Перейдите на страницу.

Установите переключатель в положение По URL.

Введите URL-адрес страницы в поле, например http://example.com/page.html.

Нажмите кнопку «Удалить».

Вы можете указать до 500 URL-адресов на сайт в день.

Вы можете удалить все страницы сайта, отдельные каталоги или страницы с указанными параметрами в URL, если ваш сайт добавлен в Яндекс.Веб-мастер и вы подтвердили свои права на управление сайтом.

В Яндекс.Вебмастере перейдите на страницу.

Установите переключатель в положение По префиксу.

- Укажите префикс:

Что удалить Пример Каталог сайта http://example.com/catalogue / Все страницы сайта http: // example.com / URL с параметрами http://example.com/page ? Вы можете отправлять до 20 префиксов на сайт в день.

Нажмите кнопку «Удалить».

Примечание. Робот удалит страницы, указанные в Яндекс.Вебмастере, только если эти страницы указаны в директиве Disallow в файле robots.txt.

После отправки URL в Яндекс.Вебмастер вы можете отслеживать изменения статусов на:

| Статус | Описание |

|---|---|

| «В очереди на удаление» | Робот проверяет ответ сервера и запрет на индексацию страницы.Проверка может занять несколько минут. |

| «В процессе» | Робот проверил страницу. Страница будет удалена из результатов поиска в течение 24 часов. |

| «Удалено» | Страница была удалена из результатов поиска. |

| «Отклонено» | Страница разрешена для индексации или когда робот обращается к URL-адресу страницы, ответ сервера отличается от 404 Not Found, 403 Forbidden или 410 Gone. |

Убрать запрет на индексацию: директива Disallow в файле robots.txt или метатегом noindex. Страницы возвращаются к результатам поиска, когда робот просматривает сайт и узнает об изменениях. Это может занять до трех недель.

- Я настроил перенаправление на новые страницы, но старые по-прежнему отображаются в результатах поиска.

Если вы используете перенаправление, робот будет постепенно отслеживать перенаправления, и старые страницы будут исчезать из результатов поиска по мере сканирования сайта. Чтобы робот быстрее узнал об изменениях, отправьте страницы на переиндексацию.

Если URL-адреса страниц изменились из-за изменения доменного имени сайта, обновление данных поиска может занять больше месяца. Проверьте правильность настройки зеркал.

Полное руководство по поисковой оптимизации Яндекса

Хотя Google имеет сильные позиции в России, очень важно, чтобы ваша стратегия SEO учитывала Яндекс.

Яндекс — ведущая поисковая система в России (по смешанной доле на рынке), и благодаря недавним изменениям в законодательстве (Google получил пощечину в российских судах), они также ликвидировали пробел в мобильной рекламе.

Яндекс. Помимо поисковой системы, Яндекс также предоставляет браузер (YaBrowser), электронную почту, новости, карты, платную рекламу и услуги переводчика на российском рынке, а также в Беларуси, Казахстане, Украине и Турции.

Яндекс предлагает ряд бесплатных сервисов, подобных Google.Яндекс Техническое SEO

Хотя между Google и Яндексом есть много общего, российский движок имеет свой собственный набор правил и нюансов, которые необходимо учитывать при проектировании и разработке вашего русскоязычного веб-сайта (или альтернативной версии).

Реклама

Продолжить чтение ниже

| Элемент | Важность | |

| Тег заголовка | Очень важно | |

| Тег заголовка | Очень важно | Тег слова Важно |

| Ключевые слова в URL-адресах | Очень важно | |

| Структура внутренних ссылок | Немного важно |

Индексирование в Яндексе

Google избаловал нас своим обновлением Caffeine и тем, как быстро они обнаруживают и индексируют свежие содержание.

Яндексу требуется немного больше времени для обнаружения новых сайтов и URL-адресов.

Для более эффективной индексации контента в Яндексе важно отправлять карты сайта через Яндекс.Вебмастер.

JavaScript и CSS

В ноябре 2015 года Яндекс сообщил в своем блоге для веб-мастеров, что они начали сканировать JavaScript и CSS, а в более поздней статье поддержки они рассказали, как Яндекс обрабатывает веб-сайты AJAX.

Короче говоря, Ирстлена Першина, активный публичный представитель Яндекса в своем блоге для веб-мастеров, в 2018 рекомендовала следующее в ответ на вопрос об Angular, AngularDart и о том, нужен ли им рендеринг на стороне сервера:

Общее правило: для робота должен быть статический контент.Ирстлена Першина, 7 мая 2018 г., 18:18

Hreflang и XML-карты сайта

Хотя реализация XML-карты сайта дает ряд преимуществ, таких как повышение скорости загрузки страницы (поскольку отдельные теги hreflang не нужно читать краулеры при загрузке страницы), они не будут работать в Яндекс.

Реклама

Читать ниже

Яндекс поддерживает только разметку , поэтому, если у вас много языковых вариаций, вам, возможно, придется пересмотреть свой подход для России.

Теги уровня страницы

В отличие от Google, Яндекс поддерживает метатег ключевые слова в качестве элемента HTML:

— Может использоваться при определении релевантность страницы поисковым запросам.

Маскировка

В 2008 году Яндекс представил алгоритм с кодовым именем Находка с целью предотвращения и выявления маскировки гораздо более агрессивным образом. Судя по многочисленным сообщениям в блогах, похоже, что это сработало.

Intrusive Pop-Ups

В 2012 году Яндекс обновил свой основной алгоритм для защиты веб-сайтов с навязчивыми (и поддельными) всплывающими окнами. Позже в 2014 году это было обновлено, чтобы еще строже относились к всплывающим окнам, которые мешали работе пользователей и доступности контента.

SEO на странице для Яндекса

В Яндексе есть ряд алгоритмов, которые гарантируют, что пользователи найдут качественный, полезный контент, соответствующий их поисковому намерению.

Этот процесс начался в 2007 году с безымянного обновления, в котором были введены новые ранжирование и переменные веса для поисковых запросов, состоящих из одного и нескольких слов.

8-SP1

За безымянным обновлением в 2008 году последовал первый официально названный алгоритм, цепляющий 8-SPI1. В течение этого времени в истории Яндекса более старые веб-сайты занимали более высокие позиции из-за своего возраста, и этот алгоритм работал, чтобы изменить это, чтобы дать более свежим (и потенциально более качественным доменам) больше шансов занять лидирующие позиции.

Этот алгоритм также изменил то, как обратные ссылки были взвешены как фактор ранжирования, в том смысле, что он уменьшил их силу.За

8-SP1 последовали некоторые более мелкие изменения в алгоритме качества, а именно Magadan (2008), которые позволили поисковой системе понимать аббревиатуры, а также начать понимать разницу между коммерческими и некоммерческими запросами и уникальность контента.

Фильтр AGS

Фильтр AGS был впервые представлен в сентябре 2008 года и обновлялся в 2009, 2013, 2014 и 2015 годах. Вы можете называть это алгоритмом Яндекс Панды.

Первая итерация алгоритма в первую очередь касалась дублированного и некачественного контента.Более поздние обновления означали, что Яндекс может понизить рейтинг веб-сайтов, созданных для привлечения трафика для показов рекламы на странице, и наказать веб-сайты, ориентированные на продажу и размещение ссылок.

Реклама

Продолжить чтение ниже

Рейкьявик и Калининград

Рейкьявик (2011 г.) и Калининград (2012 г.) были первыми шагами в персонализации поиска. История поиска, файлы cookie и поведение пользователей начали влиять на персонализированные результаты поиска и создавать их.

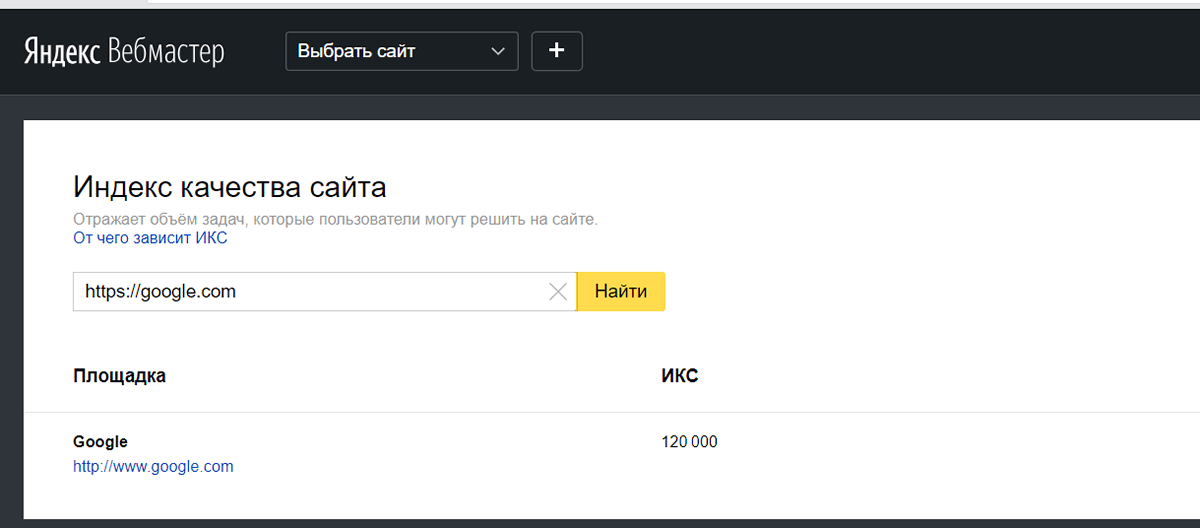

Тематический индекс цитирования (TIC) ЯндексаЯндекс использует показатель TIC для анализа воспринимаемой популярности веб-сайта, тематической релевантности и на основе этого вывода о авторитете.Здесь вы можете сделать вывод о сходстве с PageRank.

Оценка варьируется от нуля до 150 000, более высокая оценка означает, что качество веб-сайта выше. Однако, как и DA (показатель авторитета домена Moz), показатель TIC не отражает рейтинг сайта и не учитывается как фактор ранжирования.

Последние серьезные изменения в том, как они рассчитывают TIC, произошли в 2016 году (через этот пост в блоге), но недавно все страницы поддержки Яндекса, окружающие TIC, начали использовать 404 ‘и их плагин для проверки TIC (Яндекс.Element) теперь 302 перенаправляет на страницу загрузки YaBrowser.

4TIC — это метрика тщеславия, как и DA, и ее следует избегать в качестве ключевого показателя эффективности кампании.

Реклама

Продолжить чтение ниже

Однако, если вы хотите улучшить свой показатель TIC, вам необходимо убедиться, что у вас есть:

- Хорошие внутренние ссылки, которые повышают ценность для пользователя, а не случайные ссылки на первый экземпляр каждого слова на странице и т. д.

- Пишите хороший, высококачественный контент, который удовлетворяет потребности пользователей (не слишком отличается от Google).

- Убедитесь, что содержание актуально.

Yandex Local SEO

Из-за огромных размеров России локализованный поиск работает несколько иначе, чем то, к чему мы привыкли с Google, даже в таких же крупных странах, как США.

В Яндекс.Вебмастере вы можете указать регион, на который вы ориентируетесь (если применимо), и с точки зрения пользователя поиск по геотаргетингу является важной частью получения полезных и релевантных результатов.

Арзамас и Конаково

В 2006 году обновление для Арзамаса позволило пользователям вручную определять, видят ли они результаты национального или регионального поиска, а в обновлении Конаково 2009 года это было развернуто в более чем 1250 городах, включая Украину, Беларусь и Казахстан.

Яндекс проверяет IP вашего сайта, контактную информацию (убедитесь, что она структурирована и четко отображается), а также информацию о регистрации домена.

Реклама

Продолжить чтение ниже

Если все сигналы здесь указывают на регион Ненецкого автономного округа, но на самом деле вы нацелены на регион Мурманской области, то ваш рейтинг в локальном поиске может оказаться не таким высоким.

Эта функциональность была дополнительно улучшена в 2010 году с помощью алгоритма Обнинск, который также привел к тому, что веб-сайты повысили местный рейтинг, а списки спам-каталогов были наказаны.

Смена региона в Яндексе

Как уже упоминалось, вы можете указать свой регион в своем аккаунте Яндекс.Вебмастера. Однако это всего лишь просьба, и поисковая система не воспринимает это как евангелие.

Если вы не ориентируетесь на конкретный регион (например, вы являетесь интернет-магазином, который может доставлять товары куда угодно), локализованный поиск Яндекс по запросам розничной торговли в Интернете не повлияет на вас.

В Яндекс.Вебмастере можно указать до семи регионов, но для этого вы должны быть указаны в Яндекс.Каталоге.

Реклама

Продолжить чтение ниже

Яндекс Offsite SEO

Хотя алгоритм Google Penguin не стал частью нашей жизни до 2012 года, Яндекс представил свой первый алгоритм на основе ссылок в 2005 году (официального названия нет, но он стал известен как фильтр Nepot), чтобы уменьшить влияние, которое генерирует обмен ссылками, PBN и другие спам-ссылки.

Помимо качества связи, фильтр Непот специально искал неестественные шаблоны получения ссылок. Неофициально это, похоже, было обновлено снова в 2008 году.

Рейтинг без ссылок

В 2013 году в Москве был развернут бета-алгоритм для некоторых вертикалей (а именно, путешествия, недвижимость и бытовая техника), и он произвел ранжирование без учета ссылки во внимание.

Существует очень мало информации о том, насколько успешным было испытание, но в 2015 году был запущен новый алгоритм на основе ссылок под названием Минусинск (поэтому мы можем сделать вывод, что рейтинг «без ссылок» не сработал).

После объявления Минусинска веб-мастера, которые использовали тактику ссылочного спама, получили уведомления через Яндекс.Вебмастер, и внедрение алгоритма имело три ключевых даты воздействия:

Реклама

Продолжить чтение Ниже

Yandex Mobile SEO

По оценкам, в России 80 миллионов пользователей смартфонов. Если текущий рост продолжится, то к 2021 году он достигнет 93 миллионов.

Рынок мобильного поиска в России также переживает период бурных перемен.В мае 2017 года российская антимонопольная служба постановила, что стандартная ОС Android от Google является слишком ограничительной и не отвечает интересам потребителя, и вынудила Google разработать виджет и новую ОС Android, чтобы пользователи могли легко изменить поисковую систему по умолчанию.

Учитывая, что самые последние данные показывают, что Android занимает около 70 процентов рынка, это привело к огромному скачку доли рынка мобильных поисковых систем: Яндекс увеличился с 29 процентов до 44 процентов за год, при за счет гугла.

Владивосток Алгоритм

Яндекс представил изменение алгоритма с кодовым именем Владивосток, и это было направлено на улучшение взаимодействия с мобильными пользователями.

Реклама

Продолжить чтение Ниже

Исторически (с ноября 2015 года) Яндекс помечал сайты, оптимизированные для мобильных устройств, в результатах поиска (что составляло примерно 18 процентов сайтов в то время). Это был действительно первый «толчок», который заставил веб-мастеров задуматься о мобильных впечатлениях и начать планировать адаптивные, динамические веб-сайты или веб-сайты с многоточечными точками.

Владивосток разрешил небольшой льготный период для веб-сайтов, которые еще не обеспечивали удобную работу с мобильными устройствами для пользователей, но на них наблюдались некоторые колебания и постепенный спад.

Один интересный вывод из факторов ранжирования мобильных устройств Яндекса (которые не сильно отличаются от факторов ранжирования мобильных устройств, к которым мы привыкли в Google, и обеспечивающих удобство использования пользователей), заключается в том, что в удобном для мобильных устройств средстве проверки Яндекса это критерии для мобильных устройств. удобный размер текста.

Если размер шрифта составляет 12 пикселей или больше, он считается удобным для мобильных устройств.Если страница имеет меньший размер шрифта, это негативно отразится на страницах результатов поисковой системы.

Реклама

Читать ниже

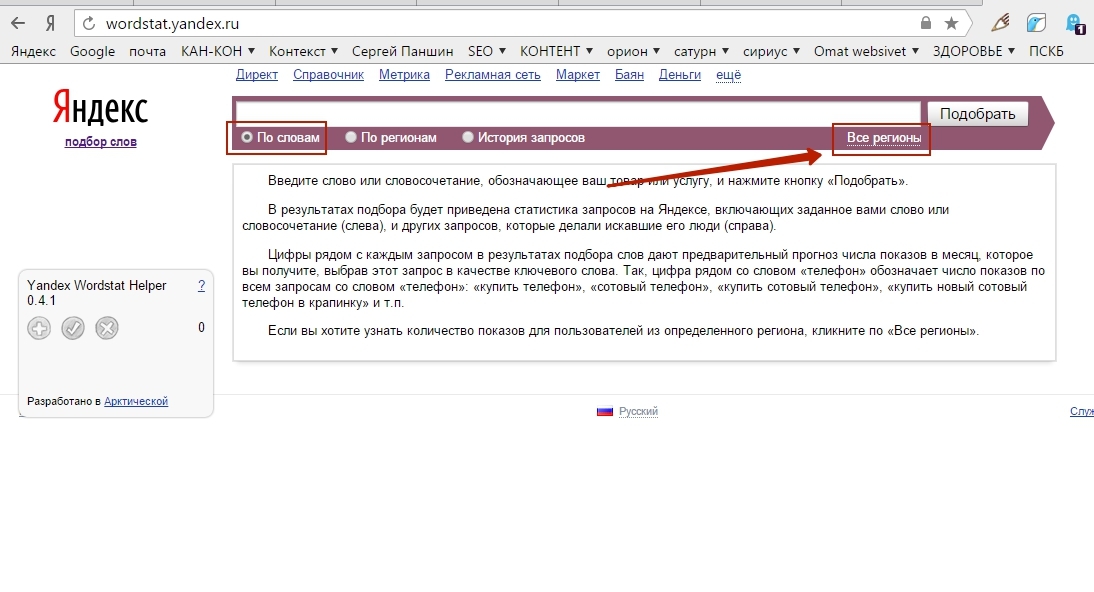

Инструменты поиска ключевых слов Яндекса

Основа любой SEO-кампании, исследование ключевых слов для российского рынка так же важно, как и прежде.

Ряд доступных инструментов упрощает проведение глубокого исследования ключевых слов на российском рынке.

Яндекс WordstatWordstat — один из моих любимых инструментов для исследования ключевых слов в России.Это часть платного инструментария поиска Яндекса, позволяющая разбить поиск по регионам.

По своему опыту я также склонен доверять представленным здесь данным о впечатлениях намного больше, чем второму инструменту в этом разделе.

Планировщик ключевых слов GoogleУчитывая, что Google является второй по величине поисковой системой в России (при смешанной статистике устройств), инструмент Планировщик ключевых слов AdWords работает для российского рынка. Он также дает более широкие и обширные списки связанных ключевых слов, хотя иногда страдает релевантность, поэтому длинный список может потребовать значительного сокращения.

Приведенные объемы поиска также, по опыту, менее точны, чем Wordstat.

Реклама

Продолжить чтение ниже

Инструмент подсказки ключевых слов Mail.ruMail.ru является третьей по величине поисковой системой в России (примерно 8 процентов рынка), но, хотя сама поисковая система не пользуется популярностью, Инструменты для веб-мастеров предоставляют данные о поведенческих факторах пользователей, а также разбивают ключевые слова по возрасту и полу.

Объединение данных из этих инструментов и других основных компонентов пакета, таких как SEMrush, действительно может помочь в создании всеобъемлющих списков исследования ключевых слов.

Бонус: поисковые операторы Яндекса

Поисковые операторы, такие как site: и inurl: , могут быть неоценимы для профессионалов SEO при диагностике проблем с индексами.

В Яндексе также есть несколько операторов, которые немного отличаются от операторов Google. Хорошо иметь под рукой:

- Заголовок [ключевое слово] — поиск по заданному ключевому слову в теге заголовка, работает так же, как и оператор Google intitle: .

- Inurl = «keyword» — работает так же, как оператор Google inurl: .

- Mime = ”html / pdf / doc / ppt / xls / rtf / swf” — поиск файлов определенных типов, например: seo << mime = ”ppt” вернет результаты, которые являются файлами PowerPoint, связанными с SEO.

Вы можете структурировать ключевые слова по большинству операторов и их переменных в следующем формате:

Ключевое слово << [Оператор] = «переменная»

Дополнительные ресурсы для международного поиска:

Реклама

Продолжить чтение Ниже

Изображение предоставлено

Рекомендуемое изображение: 360b / Shutterstock.com

Доля рынка мобильной связи в России, взято с сайта Statcounter.com, май 2018 г.

Средство проверки мобильных устройств Яндекса (снимок экрана с размером текста), сделано автором, май 2018 г.

Скриншоты, сделанные автором, май 2018 г.

Узнайте, почему ваш сайт занимает высокие позиции в Google, но не в Яндексе

Почему у меня высокий рейтинг в Google, а не в Яндексе?

Один из самых часто задаваемых вопросов! Многоязычные компании часто сталкиваются с проблемами при попытке ранжироваться в Яндексе с поддоменом или подкаталогом своей сильной стороны.COM-сайт. Я слышал этот вопрос на конференциях по SEO и от сообщества веб-мастеров.

Так что, если у вас проблемы с рейтингом на Яндексе, в то время как ваш рейтинг в Google отличный, стоит проверить эти вещи:

— Яндекс не любит автоматическое перенаправление (например, если вы показываете версию на определенном языке на основе IP посетителя). У Яндекса проблемы с индексированием таких страниц.

— Яндекс медленнее, чем Google , когда дело касается новых сайтов и страниц.Если для Google требуется 1-2 дня, чтобы проиндексировать новую страницу и отобразить ее в поисковой выдаче, для Яндекса это займет не менее 1-2 недель, и страница не будет отображаться высоко. Чтобы новая страница попала в топ-10, может потребоваться до 1-2 месяцев, даже если конкуренция низкая.

— Google лучше справляется с поиском и индексированием страниц , особенно когда речь идет о крупных сайтах со сложной структурой ссылок. Не редкость ситуация, когда Яндекс видит 1000 страниц вашего сайта, а Google — 2500.

— Яндекс и Google индексируют Flash и Java-скрипт по-разному .У меня нет опыта в этом, но это общеизвестно, и это может вызвать проблемы с ранжированием.

— Вы выбираете создание языковых версий в качестве поддоменов или подкаталогов, рассчитывая, что они получат большую силу от сайта .COM, верно? PR будет течь и ранжировать будет легче. Верно. Но ваш сайт .COM не является авторитетом для Яндекс (во всяком случае, в большинстве случаев). Он не проиндексирован должным образом, у него нет ТИЦ (тематического индекса цитирования), поэтому кредит не будет получен, и получить рейтинг в Яндексе будет намного сложнее, чем в Google.

— Для ранжирования в Яндексе необходимо ссылок с сайтов на русском языке . Хотя обратные ссылки на английском языке могут помочь немецкому сайту занять место в Google, в России этого не произойдет. Мы имеем дело с Яндексом, местной поисковой системой с ограниченной возможностью индексировать и оценивать зарубежные сайты. Так что здесь никакого жульничества! Хотите рейтинги Яндекса — получите русские ссылки.