Как проиндексировать сайт в гугл максимально быстро

В этой статье мы расскажем как проиндексировать сайт в гугл за минимально возможное время.

- Что такое индексирование Google и как оно работает?

- Как проверить, проиндексировал ли Google ваш сайт?

- Создайте и отправьте в поисковые системы файл Sitemap

- Удалите теги Nofollow для внутренних ссылок

- Удалите ненужные теги Noindex

- Проверьте Robots.txt на наличие блокировки поискового сканирования

- Блокируйте или перенаправляйте веб-страницы низкого качества

- Убедитесь, что нет дублирования веб-страниц

- Поделитесь своим контентом в социальных сетях

- Получите качественные обратные ссылки

- Создание мощных внутренних ссылок

Индексирование – добавление сайта и его страниц в базу данных Google. Благодаря чему ваш сайт отображается в результатах поиска.

Благодаря чему ваш сайт отображается в результатах поиска.

Поисковик обнаруживает новый контент на сайте, переходя по различным гиперссылкам. Найдя новые веб-страницы, Google добавляет их в свою базу данных.

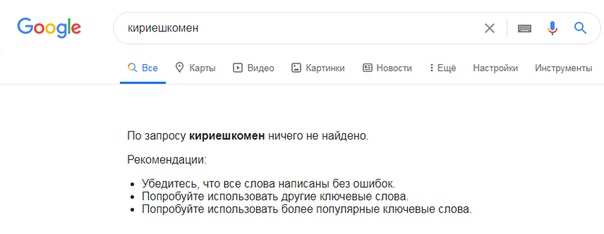

Есть два простых способа узнать, проиндексировал ли сайт в Google:

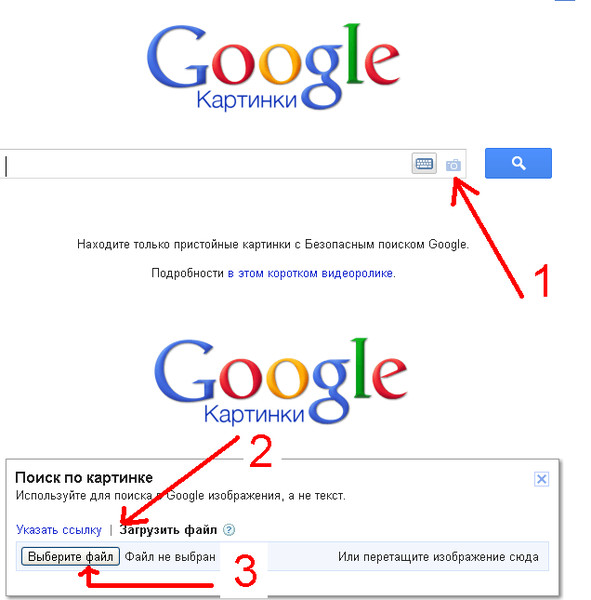

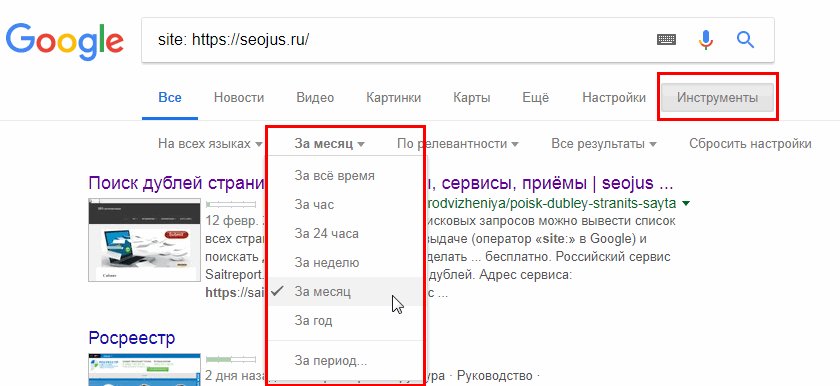

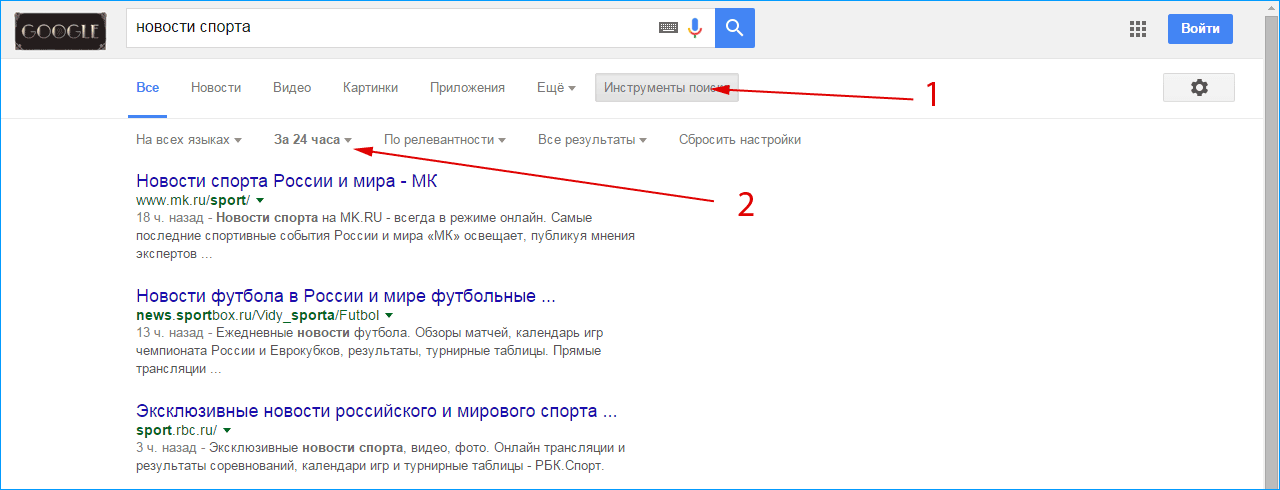

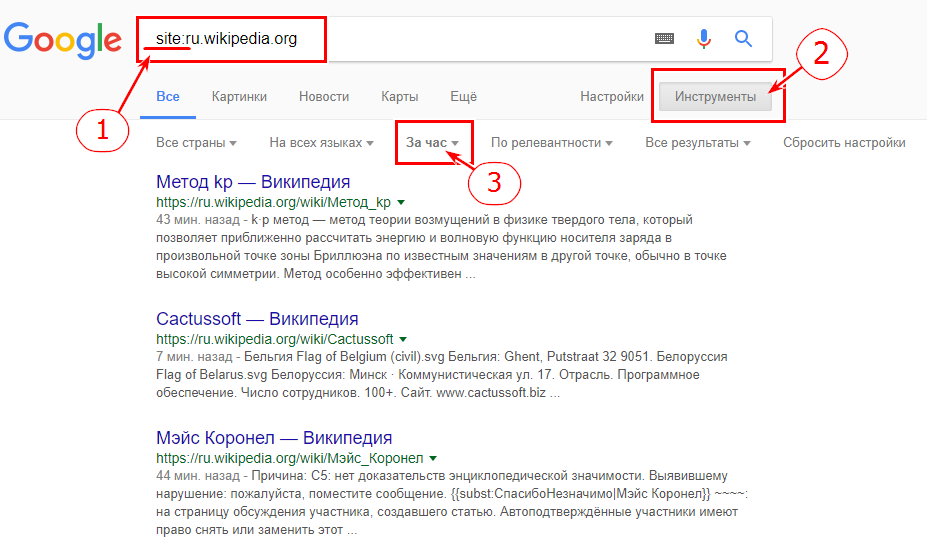

- Выполнить поиск в Google.

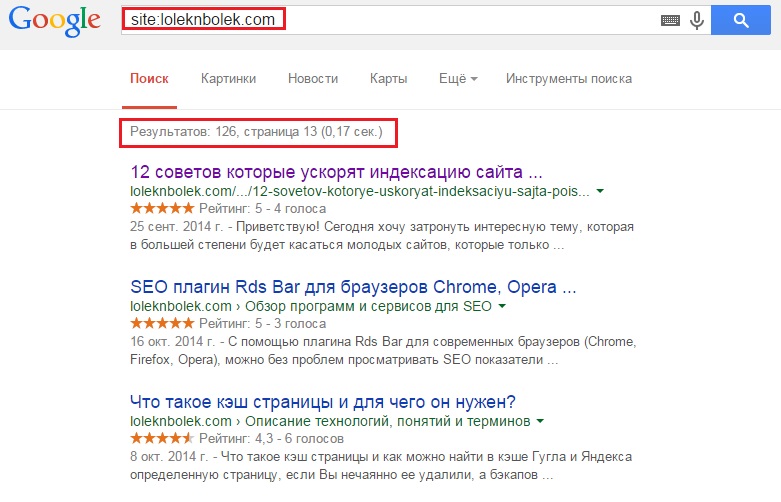

- Используя операторы поиска Google. Например, site:www.example.com. Также можно ввести URL-адрес веб-страницы: site:www.example.com/your-web-page.

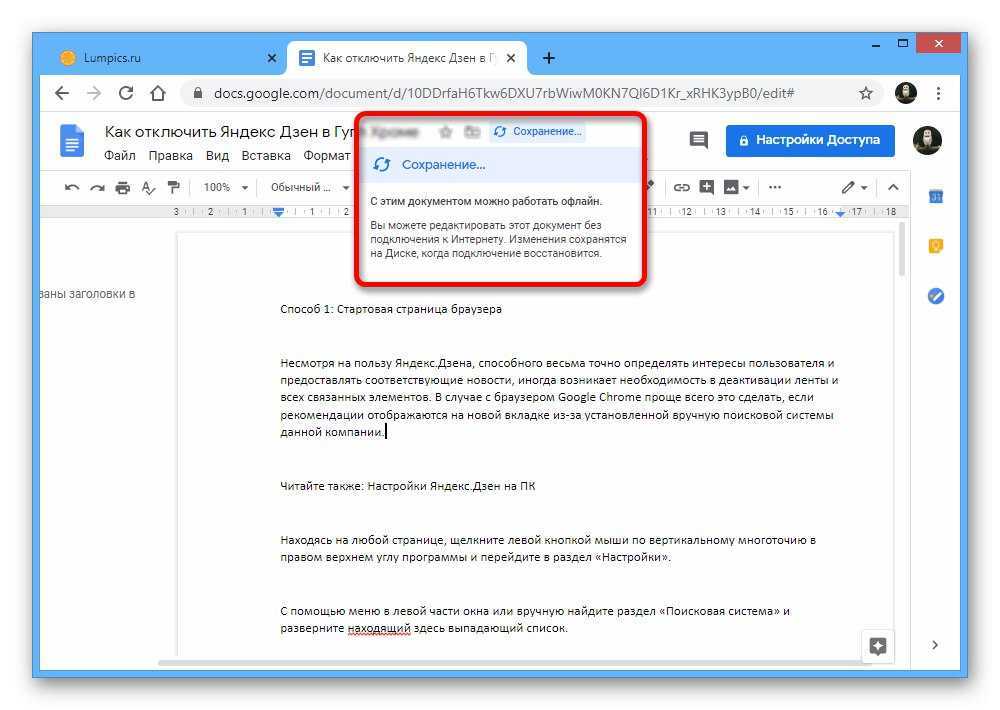

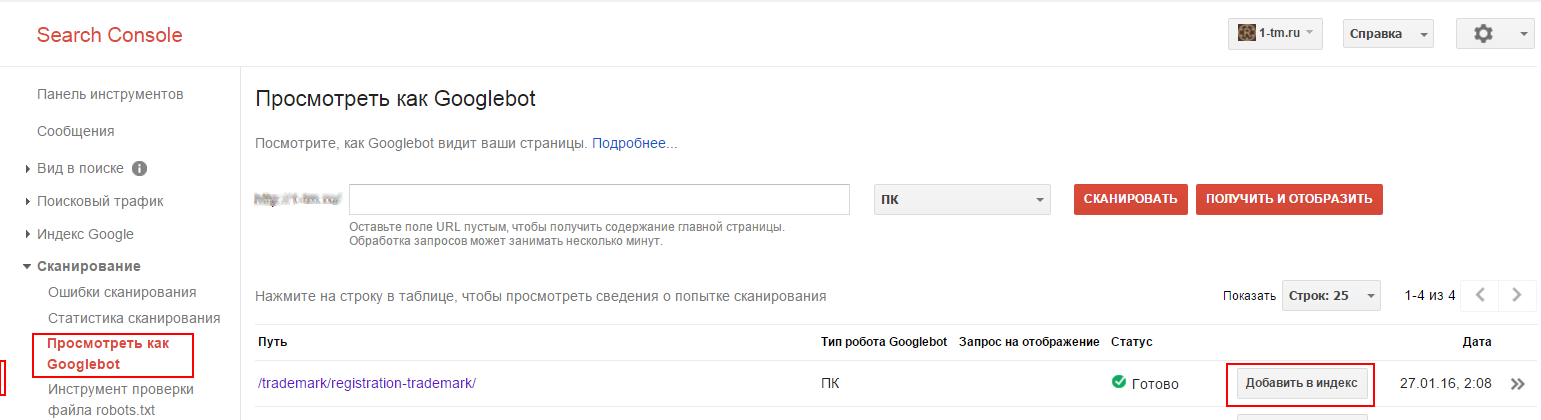

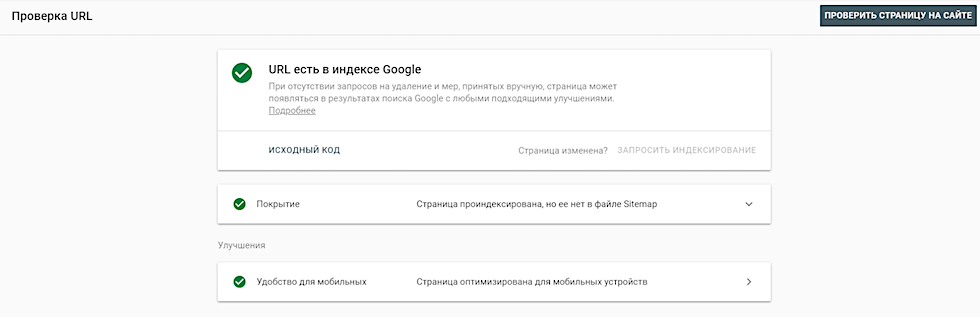

Кроме этого можно использовать Google Search Console, чтобы проверить статус индексирования конкретных веб-страниц (инструмент «проверка URL»).

Далее мы рассмотрим несколько простых способов быстрой индексации сайта в Google:

Карта сайта – это список важных страниц сайта, представленный в формате XML.

С помощью Sitemap.xml вы помогаете поисковым роботам перемещаться по сайту, находить новый контент и индексировать веб-страницы. Это повышает видимость сайта в поиске и новых веб-страниц, которые еще не имеют обратных ссылок.

Веб-страницы сайта не будут индексироваться, если на нем есть внутренние ссылки с тегом rel=«nofollow». Этот атрибут запрещает поисковым роботам сканировать ссылку.

В результате этого веб-страница не будет отображаться в результатах поиска. Чтобы преодолеть эту проблему, необходимо проверить внутренние ссылки и удалить теги nofollow.

Теги Noindex сообщают Google об исключении веб-страницы из процесса индексации. В результате поисковая система не сохранит веб-страницу в своей базе данных и не отобразит ее в результатах поиска. Тег noindex расположен в разделе <head> веб-страницы.

Для запрета индексации боту Google атрибут name будет включать googlebot.

Удалите этот тег, чтобы Google мог проиндексировать веб-страницу.

Еще один способ поиска тегов noindex – использование инструмента проверки URL-адреса в Search Console.

Если на веб-странице присутствует тег noindex, в http-заголовке «X-Robots-Tag» появится сообщение «обнаружено «Noindex».

Файл Robots. txt сообщает поисковым роботам, какие веб-страницы они обходить не должны. Вы можете найти файл robots.txt, введя robots.txt в конце URL-адреса сайта (example.com/robots.txt). Теперь найдите следующий фрагмент кода и удалите его.

txt сообщает поисковым роботам, какие веб-страницы они обходить не должны. Вы можете найти файл robots.txt, введя robots.txt в конце URL-адреса сайта (example.com/robots.txt). Теперь найдите следующий фрагмент кода и удалите его.

Этот код не позволяет поисковой системе сканировать сайт. Кроме этого URL-адрес веб-страницы не должен быть заблокирован, особенно для user-agent: googlebot.

Если на сайте тысячи записей, но большинство из них не несет для пользователей никакой пользы, Google сократит количество поисковых сканирований и индексаций площадки.

Если поисковый бот постоянно находит веб-страницы низкого качества, это замедлит обнаружение нового контента, появляющегося на сайте.

Чтобы избежать возникновения подобной проблемы, можно настроить редирект 301 для низкокачественных веб-страниц и перенаправить их на другие более качественные публикации.

Наличие дублированного контента может быть еще одной причиной медленной индексации сайта. Если веб-страница дублируется, Google вряд ли ее проиндексирует.

Чтобы ускорить индексацию сайта, делиться новыми публикациями в социальных сетях. Это повышает шансы на индексацию вашего сайта.

Например, Twitter, отлично подходит для популяризации контента. Google регулярно сканирует Twitter и даже демонстрирует соответствующий сниппет в результатах поиска.

Веб-страницы с высококачественными обратными ссылками будут иметь большее значение для Google, чем те, которые их не имеют. Когда сайт получает обратные ссылки с авторитетных площадок, Google сочтет его заслуживающим доверия и начнет быстрее индексировать контент ресурса.

Если на сайте есть веб-страница, на которой нет внутренних ссылок, Google не сможет найти через нее другой контент. В результате этого для индексации остальных страниц сайта может потребоваться много времени.

На площадке должны быть веб-страницы, которые получают наибольшее количество трафика. Эти веб-страницы могут занимать хорошие позиции в поисковой выдаче Google и должны приносить пользу пользователям. Размещая в них гиперссылки на другие страницы сайта, вы создадите мощные внутренние ссылки.

Размещая в них гиперссылки на другие страницы сайта, вы создадите мощные внутренние ссылки.

Если у вас возникли проблемы с индексацией сайта в Google, воспользуйтесь советами, перечисленными в этой статье.

Дайте знать, что вы думаете по данной теме в комментариях. За комментарии, отклики, подписки, лайки, дизлайки низкий вам поклон!

Вадим Дворниковавтор-переводчик статьи «9 Proven Ways to Get Google to Index Your Website Right Away»

Почему не индексируется сайт? Причины по которым Google не индексирует ваш сайт

4206

| SEO | – Читать 19 минут |

Прочитать позже

Анастасия Сотула

Редактор блога Serpstat

Если вы занимаетесь продвижением бизнеса в интернете, первое, что нужно отслеживать — индексацию страниц сайта. Здесь возникает несколько вопросов: «Зачем нужна эта индексация сайта?» (спойлер: чтобы у пользователей была возможность найти ваш сайт в поисковой выдаче), «Где проверить сайт на индексацию» и «Что делать, если сайт не индексируется?». Ответы на них мы и разберем в данной статье.

Ответы на них мы и разберем в данной статье.

Содержание

Как проверить индексацию сайта

Google пока не нашел ваш сайт

— Как добавить сайт в Гугл вебмастер (Google Search Console)?

Сайт или страницы закрыты в robots.txt

Включены приватные настройки

Сайт закрыт от индексации в noindex в метатегах

Ошибки сканирования

Сайт заблокирован в .htaccess

Хостинг или сервер работает нестабильно

Проблемы с AJAX/JavaScript

У вас на сайте много дублированного контента

Очень медленная скорость загрузки сайта

Ваш домен ранее был забанен

У вас нет sitemap на сайте

FAQ

Выводы

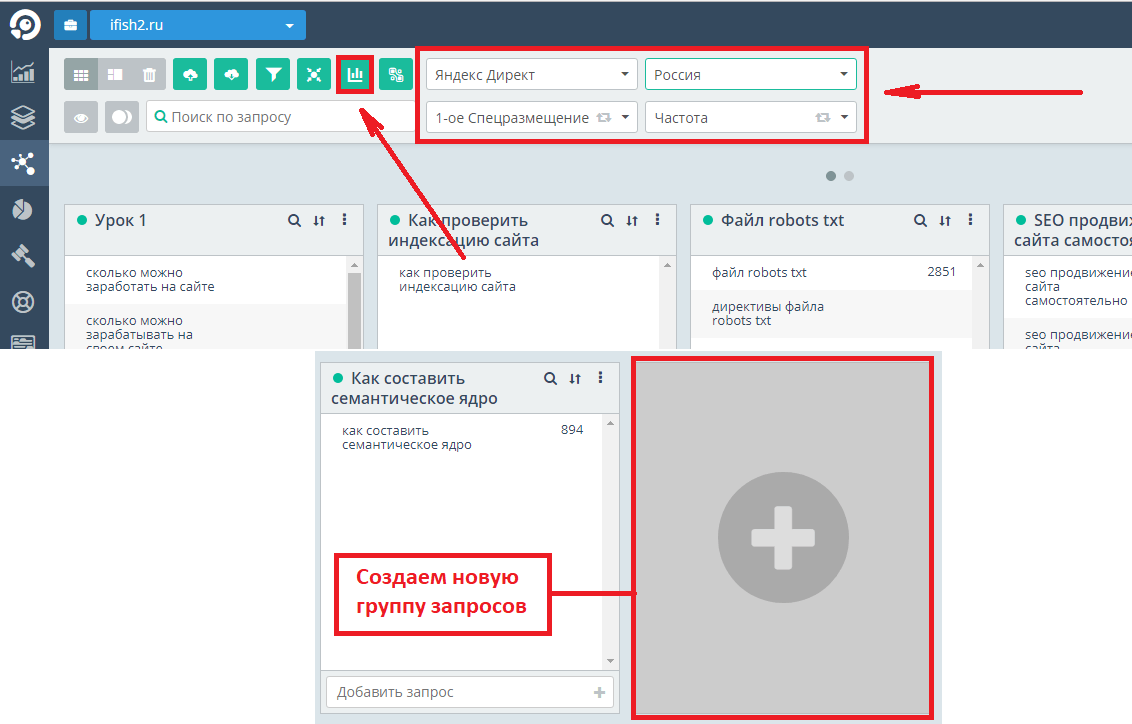

Как проверить индексацию сайта

Перед тем, как поднять сайт в поисковиках, нужно оценить его видимость в популярных поисковых системах. Узнать видимость сайта можно с помощью специализированных ресурсов, например, Serpstat.

Чтобы узнать, насколько ваш сайт «виден» поисковикам, достаточно ввести адрес домена в поисковую строку и нажать «Поиск». Данный показатель относительный и его нужно смотреть в сравнении с основными конкурентами.

Данный показатель относительный и его нужно смотреть в сравнении с основными конкурентами.

Проверка видимости сайта в Serpstat

Если показатель видимости низкий, необходимо проверить индексацию вашего веб-ресурса и добавить информацию про него в базу данных поисковиков.

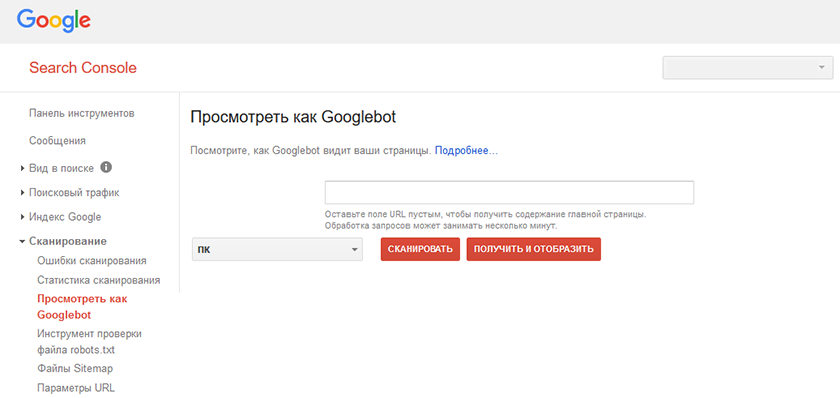

Самый простой способ узнать, индексируется ли ваш сайт, – воспользоваться панелью вебмастера. Для этого нужно иметь к ней доступ (почта в Google, регистрация-идентификация). Если доступ получен, то заходим в Панель, находим меню Search Console, достаем вкладку Индекс Google. В ней выбираем и смотрим Статус индексирования.

Статус индексации сайта в Search Console

Индексация сайта – это работа бота поисковой системы. Бот бесконечно сканирует тексты, изображения, видео, а потом добавляет информацию про веб-страницу или веб-ресурс в базу поисковой системы. Благодаря этой работе по накоплению базы пользователь получает релевантный ответ на свой запрос. Благодаря собранной ботом информации происходит ранжирование сайтов в конкретной поисковой системе.

Благодаря собранной ботом информации происходит ранжирование сайтов в конкретной поисковой системе.

А теперь подробнее разберемся в причинах того, почему поисковые системы могут не индексировать ваш сайт.

Google пока не нашел ваш сайт

Иногда Google просто «не видит» ваш сайт. Особенно это характерно для молодых площадок. Дело в том, что молодые сайты попадают в так называемую Песочницу – эдакий отстойник для веб-ресурсов, пока поисковая система не разберется, что это за сайт – какой он, чем дышит и для кого он предназначен.

Если сайту больше 6 месяцев (максимальное время зависания в Песочнице), то его «видимость» могут сдерживать фильтры поисковых систем. Потому что им не нравится, если контент на сайте не уникальный (стыренный у других авторов), а его содержание выходит за рамки морали, пропагандирует насилие или не имеет подтвержденной экспертизы. Пример: на сайте про лечебные средства отсутствуют имена и биографии авторов, которые их рекомендуют.

Если сайт не молодой, и с контентом все в порядке, то в теории нужно дать поисковым системам время на индексирование сайта в Гугле – минимум 2 недели.

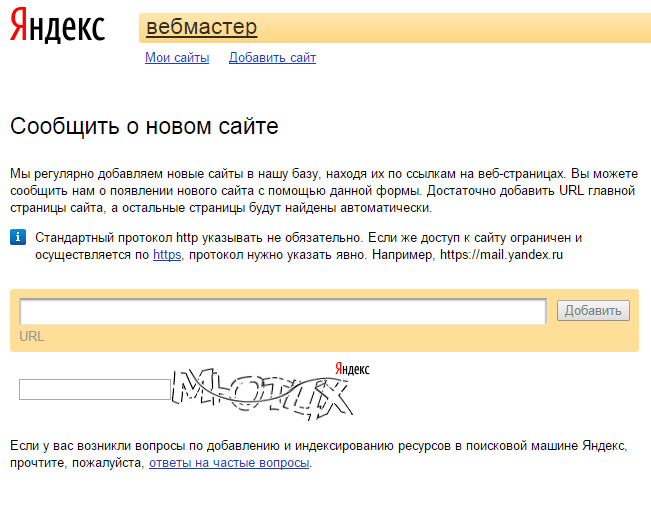

Правда, процесс можно ускорить, чтобы поисковики быстрее увидели сайт, его нужно вручную добавить в поисковую систему (Add url), а также в Google Search Console.

Запрос на индексирование url вручную

Как проиндексировать сайт в Гугл? Для этого нужно постоянно обновлять контент (в этом случае в преимущественном положении находятся сайты-новостники), создавать новые страницы (преимущество имеют блогеры и интернет-магазины с растущим ассортиментом), а также осуществлять внутреннюю перелинковку страниц в комплексе со ссылками с авторитетных внешних ресурсов.

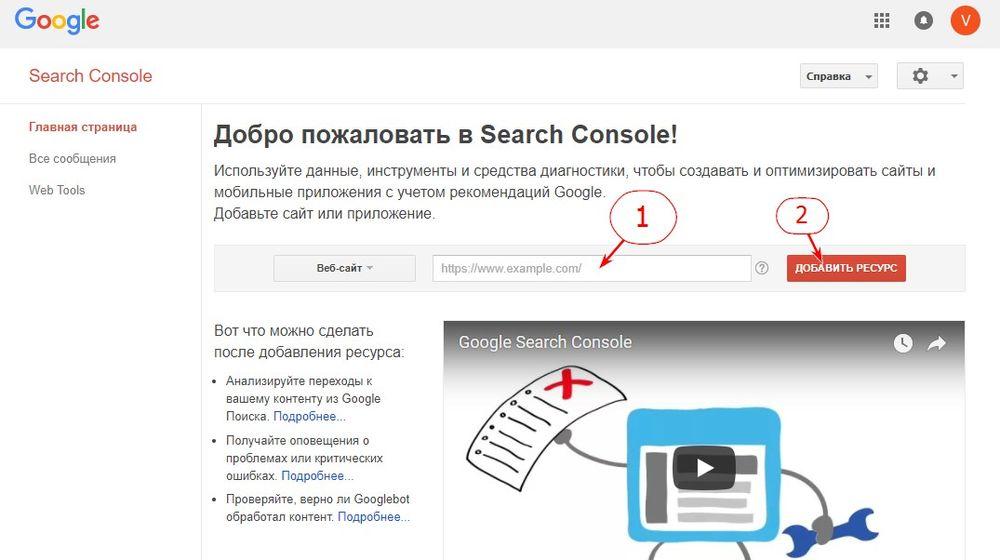

Как добавить сайт в Гугл вебмастер (Google Search Console)?

Правда, есть еще возможность проиндексировать сайт в Google быстро. Для этого выполняем 5 элементарных операций:

- Открываем Google Search Console – раз!

- Переходим в Инструмент проверки URL – два.

- Вставляем в строку поиска URL, который нужно сделать видимым в индексе Google – три.

- Ожидаем, пока Google проверяет адрес – четыре.

- Нажимаем кнопку «Запросить индексирование» – пять!

Мы подготовили для вас самую подробную инструкцию, как добавить сайт в Google Search Console.

Сайт или страницы закрыты в robots.txt

Файл robots.txt — запретный инструмент Гугла. В нем содержатся инструкции для поисковых роботов: какие страницы они могут обрабатывать на вашем сайте. С помощью файла robots.txt можно искусственно ограничить количество запросов на сканирование. Это поможет снизить нагрузку на сервер. Актуально для неважной или повторяющейся информации. Для этого на веб-страницу сайта, которую нужно убрать из поля видимости Гугла, нужно добавить директиву noindex.

Важно! Даже если запретить индексацию в robot txt для какой-то веб-страницы, то она все равно может быть проиндексирована роботом Googlebot, при условии, что на нее есть ссылки с других сайтов. Это относится только к контенту в формате HTML. А вот заблокированные файлы PDF, изображения или видео будут надежно спрятаны от Google. Чтобы гарантированно исключить индексацию страницы с контентом в формате HTML в Гугле, нужно использовать директиву noindex в мета теге или HTTP-заголовке ответа.

Это относится только к контенту в формате HTML. А вот заблокированные файлы PDF, изображения или видео будут надежно спрятаны от Google. Чтобы гарантированно исключить индексацию страницы с контентом в формате HTML в Гугле, нужно использовать директиву noindex в мета теге или HTTP-заголовке ответа.

А теперь, внимание, рассказываем, как задать в robots.txt директивы для роботов Google. Чтобы индексировать сайт в Гугл, необходимо в файле robots.txt позволить агентам роботов Googlebot, AdsBot-Google, Googlebot-Image позволить сканировать веб-ресурс. Для этого нужно добавить в файл robots.txt следующие строки:

- User-agent: Googlebot

Disallow:

- User-agent: AdsBot-Google

Disallow:

- User-agent: Googlebot-Image

Disallow:

Включены приватные настройки

Иногда сайт не индексируется Гуглом по самой банальной причине – в CMS включены приватные настройки. CMS – это движок сайта, например WordPress, Joomla, OpenCart. CMS — это набор скриптов, которые позволяют создавать, редактировать и управлять контентом на website.Чтобы индексация страницы состоялась, нужно проверить настройки страницы в конкретной CMS.

CMS – это движок сайта, например WordPress, Joomla, OpenCart. CMS — это набор скриптов, которые позволяют создавать, редактировать и управлять контентом на website.Чтобы индексация страницы состоялась, нужно проверить настройки страницы в конкретной CMS.

Сайт закрыт от индексации в noindex в метатегах

Мета-теги (HTML) нужны для того, чтобы структурировать содержимое веб-страницы. Как правило, мета-теги указываются в заголовке HTML-документа. Обязательным является атрибут content, а уже к нему добавляются остальные.

Появление meta noindex nofollow означает, что интернет-боты не должны трогать (индексировать) эту страницу. Причина запрета может быть в том, что страница имеет временное содержимое, быть версией для печати или содержать приватную информацию. Детальную инструкцию, какие страницы нужно закрыть от индексации, смотрите на нашем сайте.

Вот как meta noindex выглядит в HTML-документе, блокируя этим бота Google:

<meta name="googlebot" content="noindex">

Чтобы заблокировать видимость веб-страницы в глазах бота MSN’s bot, пишем «волшебные слова»:

<meta name="msnbot" content="noindex">

Чтобы отключить индексацию целой страницы убираем слово «noindex» из кода.

Наличие метатега robots в коде страницы в сочетании со словом noindex показывает поисковым роботам запрет на индексирование сайта в Гугл.

Выглядит robots txt noindex в HTML-документе вот так:

<meta name="robots" content="noindex">

Где искать информацию про robots noindex? Заходим в Google Search Console. Открываем отчет «Индекс», выбираем «Покрытие», переходим во вкладку «Исключено». Если там написано, что индексирование страницы запрещено тегом rel noindex, то становится понятным, почему веб-ресурс закрыт от индексации. Ах, да, и не забудьте снять запрет, если ищете способ, как как проиндексировать страницу в Гугл.

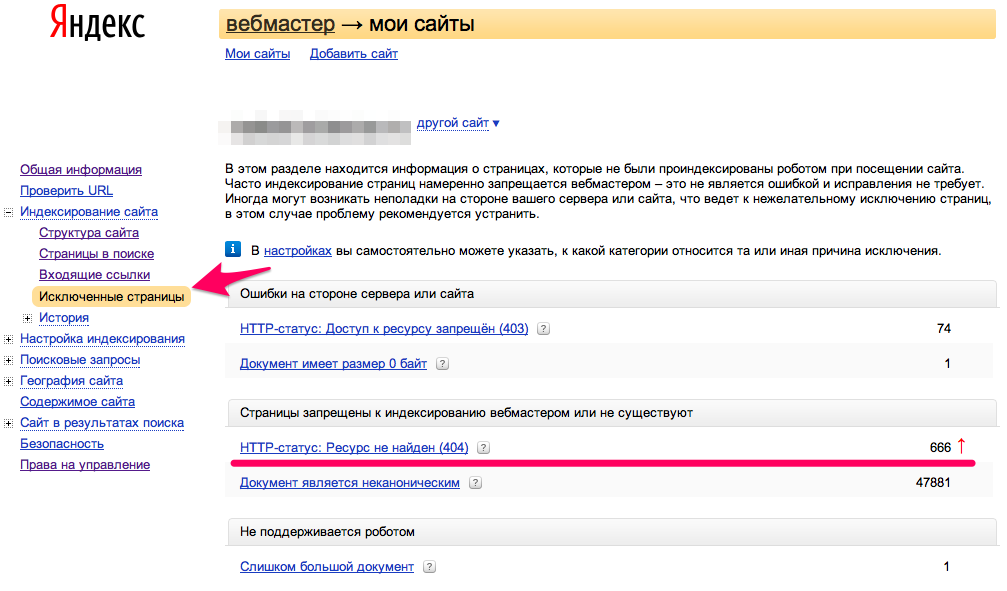

Ошибки сканирования

Ошибки сканирования также останавливают индексацию в Гугл, ранжирование сайта в выдаче, а также отношение посетителей к веб-ресурсу. Эксперты выделяют три группы причин ошибок сканирования:

- Ошибки в настройках сервера (серверов).

- Сбои CMS (система управления контентом).

- Изменение структуры URL.

Ошибки сканирования можно найти в инструментах Google Search Console. Для этого потребуется зайти в статистику сканирования web-ресурса. Если вы вычислили «свою» ошибку, то рядом должно быть объяснение для вебмастера – причина ее появления и способы ликвидации. Но, мы тоже подготовили для вас текст, как устранить ошибки сканирования. Пользуйтесь!

Важно! Информация в Search Console попадает с небольшой оттяжкой во времени. Поэтому ошибки могут быть уже устранены, а в консоли по-прежнему будет отображаться их наличие.

Сайт заблокирован в .htaccess

Сайт может быть заблокирован в .htaccess. Это делается для того, чтобы лишить случайных посетителей доступа к какому-то файлу, папке, админ-панели сайта. Пароль на эти структурные элементы владелец ставить не хочет, но и непрошенных гостей здесь не ждет. Для этого в папке с инкогнито нужно создать 1 файл с именем htaccess.

В коде запрет доступа по IP адресу к файлу file.php выглядит вот так:

<Files file.php> Order Deny,Allow Deny from all Allow from Ваш IP адрес </Files>

После этого все обращения к указанному файлу с чужого IP будет давать ответ 403 «Access denied». Если владелец ресурса хочет ограничить доступ ко всем файлам с одним расширением, то первую строчку делают вот такой <Files «*.conf»>. Если расширений несколько, то они пишутся через разделитель <Files ~ «\.(inc|conf|cfg)$»>.

Чтобы проверить, находим на сервере файл .htaccess. Высматриваем в коде, не были ли когда-то закрыт сайт или его часть. Редко кто думает в этом направлении, но этот вариант обязательно нужно проверить, когда ищешь причины, почему сайт закрыт от поисковика.

Хостинг или сервер работает нестабильно

Если хостинг или сервер работают с перебоями, то это может стать причиной того, что индексация не состоялась. Представьте себе ситуацию: поисковый бот пришел на сайт (заглянул в гости) проиндексировать страницы, а там никого нет. Поэтому задача владельца ресурса — озаботиться тем, чтобы сервер был качественным, а хостинг — стабильным.

Представьте себе ситуацию: поисковый бот пришел на сайт (заглянул в гости) проиндексировать страницы, а там никого нет. Поэтому задача владельца ресурса — озаботиться тем, чтобы сервер был качественным, а хостинг — стабильным.

Контроль за состоянием доступа к сайту ведем с помощью множества сервисов. Подбираем их в поисковиках по запросу uptime checker – получаем множество вариантов сервисов, которые позволяют отследить стабильность работы хостинга. А также читаем нашу статью, как выбрать надежный хостинг для сайта, если услуга доказано некачественная.

Проблемы с AJAX/JavaScript

Google также индексирует AJAX и JavaScript, но делает это не так просто, как HTML. Поэтому разработчик должен вручную настроить все для поиска AJAX и JavaScript, чтобы «насильственно» заставить Гугл проиндексировать сайт и нужные вам страницы. Если интересно, то вот мнение экспертов про то, как устранить проблемы с видимостью сайтов на JavaScript-движках.

У вас на сайте много дублированного контента

Дублированный контент в 2021-2022 году после появления фильтров и, особенно, Панды, может стать одной из ключевых причин, почему на сайт накладывают санкции, а задача, как поднять сайт в поисковике, начинает «выедать» время и финансы.

Дублированный контент может быть в страницах, а может и в метатегах. Чтобы исключить дублированный контент, нужно сначала отыскать все дубликаты страниц на сайте, а потом удалить их или закрыть от индексации. Читайте, нашу статью про то, как найти и удалить дубли страниц на сайте, чтобы зря не злить поисковых роботов.

Очень медленная скорость загрузки сайта

Скорость загрузки сайта является одним из факторов ранжирования и попадания в первую десятку топ-выдачи. В это понятие входит запрос к стороннему серверу, его ответ, загрузка скриптов/стилей/изображений, а также компиляция страницы – ее отрисовка на стороне пользователя. Доказано, что большинство пользователей говорит сайту «досвидос», если нужная им страница грузится больше, чем 3 секунды.

Поэтому скорость загрузки сайта прямо влияет на конверсию, снижает количество отказов, увеличивает глубину просмотра страниц, поэтому косвенно дает рост среднего чека и выручки. В общем, если сайт грузится долго, а страницы открываются удручающе медленно, то и индексироваться поисковиками он нормально тоже не будет.

В общем, если сайт грузится долго, а страницы открываются удручающе медленно, то и индексироваться поисковиками он нормально тоже не будет.

Чтобы уменьшить размер страниц на сайте, нужно сократить объем графики, убрать лишние изображения, сократить объем загружаемых страницы путем сжатия gzip, кэшировать данные, сократить размер кода CSS и JavaScript.

Одновременно с этим можно озаботиться тем, как увеличить скорость загрузки сайта. Для этого проводятся исследования скорости загрузки страниц. Потом находятся слабые места и устраняются поштучно. Считается, что ускорение загрузки страниц сайта даже на 0,5 секунд дает отличные результаты в 80% случаев.

На всякий случай ловите 8 основных способов, как ускорить загрузку сайта, с примерами и картинками. А также абсолютно уникальный мануал про то, как ускорить загрузку верхней части страницы сайта – header.

Ваш домен ранее был забанен

Иногда вебмастер делает хороший сайт, регистрирует для него хороший и звучный домен, заказывает отличный дизайн, наполняет его уникальным, экспертным контентом, проводит перелинковку, выстраивает систему обратных ссылок, а поисковые системы не видят этот веб-ресурс принципиально. Как сделать чтобы сайт отображался в поисковике? Причина нелюбви Гугла может быть в домене, который ранее был забанен.

Как сделать чтобы сайт отображался в поисковике? Причина нелюбви Гугла может быть в домене, который ранее был забанен.

Чтобы решить эту задачу нужно:

- Продолжать развивать проект.

- Написать в Google, на форум, чтобы выяснить причину блокировки, а потом ее устранять.

- Развивать проект на другом домене, чтобы сэкономить время и деньги.

У вас нет sitemap на сайте

Одной из возможных причин того, что вам потребуется проверка факта индексации сайта, может быть отсутствие на нем sitemap (список веб-страниц в пределах домена). Поисковые боты, которые заходят на сайт, рандомно индексируют несколько страниц, а потом, удовлетворенные этим, уходят. Поэтому сайтмап нужно сделать. Вот одна из лучших инструкций, как создать и настроить карту сайта (sitemap.xml) для Google, а уже потом добавить ее в Google Search Console.

Полезно! Если хотите, то ту же инструкцию, как создать XML карту сайта, можно посмотреть для видео.

Это отдельный, масштабный, как пирамида Хеопса и Великая Китайская стена взятые вместе, кусок работы по созданию карты сайта для новостей или другого динамического информационного контента. Для блока новостей делают собственную XML карту сайта, потом отправляют запрос в Новости Google и добавляют ее в news.google.com, чтобы поисковые роботы находили и индексировали такой контент еще быстрее.

Кроме того, собственная карта сайта – Image sitemap XML создается для изображений. Она нужна, чтобы обеспечить быстрое, правильное, естественное индексирование картинок. Ловите детальный мануал, как создать XML карту сайта для изображений.

Хотите узнать, как с помощью Serpstat оптимизировать сайт?

Нажимайте на космонавта и заказывайте бесплатную персональную демонстрацию сервиса! Наши специалисты вам все расскажут! 😉

Почему сайт не индексируется в Гугле?

Первейшая причина – поисковая система Гугл просто «не видит» ваш сайт.

Почему не индексируются страницы сайта?

Одна из самых распространенных причин — страницы сайта закрыты в robots.txt.

Как часто Гугл индексирует сайт?

Google проводит индексацию постоянно – поисковые роботы загружают страницы сайта, а потом выкладывают их в обновленный индекс.

Выводы

Индексация сайта — один из первейших моментов в деле поискового продвижения сайта. Если сайт поисковики не видят, то ищем причину, а потом ее устраняем. В идеале, лучше не допускать проблем с индексацией сайта вообще.

Финальный чек-лист, почему сайт не индексируется в Гугле?

- Google пока не нашел ваш сайт.

Ждем, пока увидят, или вручную ускоряем процесс индексации.

Ждем, пока увидят, или вручную ускоряем процесс индексации. - Сайт или страницы закрыты в robots.txt. Открываем.

- Включены приватные настройки в CMS. Открываем.

- Сайт закрыт от индексации в noindex в метатегах. Убираем noindex из метатегов.

- Ошибки сканирования. Ищем одну из трех известных ошибок сканирования: ошибки в настройках сервера, сбои CMS, изменение структуры URL. Устраняем.

- Сайт заблокирован в .htaccess — проверяем файл .htaccess., удаляем из него страницы и папки, которые нуждаются в индексации.

- Хостинг или сервер работает нестабильно — отслеживаем проблему, меняем хостинг.

- Проблемы с AJAX/JavaScript – вручную настраиваем все для поиска AJAX и JavaScript и уговариваем Гугл проиндексировать сайт (страницы).

- У вас на сайте много дублированного контента, находим и удаляем дубли.

- Очень медленная скорость загрузки сайта, облегчаем (сжимаем) контент.

- Ваш домен ранее был забанен – пишем запрос на апелляцию или развиваем ресурс на другом, чистом, домене.

- Сайт лишен sitemap – нужно сделать и добавить сайтмап в Search Console.

Чтобы быть в курсе всех новостей блога Serpstat, подписывайтесь рассылку. А также вступайте в чат любителей Серпстатить и подписывайтесь на наш канал в Telegram.

Мнение авторов гостевого поста может не совпадать с позицией редакции и специалистов компании Serpstat.

Оцените статью по 5-бальной шкале

5 из 5 на основе 3 оценок

Нашли ошибку? Выделите её и нажмите Ctrl + Enter, чтобы сообщить нам.

Рекомендуемые статьи

SEO

Анастасия Сотула

Как оптимизировать плотность ключевых слов

SEO

Инна Arsa

Голосовой поиск: как получать больше трафика из мобильной выдачи

SEO +1

Анастасия Сотула

Топ-20 SEO-мифов и заблуждений

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.

Поделитесь статьей с вашими друзьями

Вы уверены?

Спасибо, мы сохранили ваши новые настройки рассылок.

Сообщить об ошибке

Отменить

Как заставить Google быстро проиндексировать ваш сайт

Если и есть что-то в мире SEO, что хочет видеть каждый SEO-специалист, так это способность Google быстро сканировать и индексировать их сайт.

Индексация важна. Он выполняет множество начальных шагов к успешной стратегии SEO, в том числе обеспечивает отображение ваших страниц в результатах поиска Google.

Но это только часть истории.

Индексирование — это всего лишь один шаг в полной серии шагов, необходимых для эффективной стратегии SEO.

Эти этапы включают следующее, и их можно свести к трем этапам всего процесса:

- Сканирование.

- Индексация.

- Рейтинг.

Хотя это можно свести к минимуму, это не обязательно единственные шаги, которые использует Google. Реальный процесс намного сложнее.

Если вы запутались, давайте сначала рассмотрим несколько определений этих терминов.

Почему определения?

Они важны, потому что, если вы не знаете, что означают эти термины, вы рискуете использовать их взаимозаменяемо, что является неправильным подходом, особенно когда вы сообщаете о своей работе клиентам и заинтересованным сторонам.

Что вообще такое сканирование, индексирование и ранжирование?

Проще говоря, это этапы процесса Google по обнаружению веб-сайтов во всемирной паутине и отображению их на более высоких позициях в результатах поиска.

Каждая страница, обнаруженная Google, проходит один и тот же процесс, включающий сканирование, индексирование и ранжирование.

Сначала Google просматривает вашу страницу, чтобы определить, стоит ли включать ее в свой индекс.

Шаг после сканирования называется индексированием.

Предполагая, что ваша страница проходит первую оценку, это шаг, на котором Google включает вашу веб-страницу в свой собственный категоризированный индекс базы данных всех доступных страниц, которые он просканировал до сих пор.

Ранжирование — последний шаг в этом процессе.

Здесь Google покажет результаты вашего запроса. Хотя чтение вышеизложенного может занять несколько секунд, Google выполняет этот процесс — в большинстве случаев — менее чем за миллисекунду.

Наконец, веб-браузер выполняет процесс рендеринга, чтобы он мог правильно отображать ваш сайт, позволяя его сканировать и индексировать.

Во всяком случае, рендеринг — это процесс, столь же важный, как сканирование, индексирование и ранжирование.

Давайте рассмотрим пример.

Допустим, у вас есть страница с кодом, который отображает теги noindex, но показывает теги index при первой загрузке.

К сожалению, многие SEO-специалисты не понимают разницы между сканированием, индексированием, ранжированием и рендерингом.

Они также используют эти термины взаимозаменяемо, но это неправильный способ сделать это — и только запутывает клиентов и заинтересованных лиц относительно того, что вы делаете.

Как специалисты по поисковой оптимизации, мы должны использовать эти термины для дальнейшего разъяснения того, что мы делаем, а не для создания дополнительной путаницы.

В любом случае, идем дальше.

Если вы выполняете поиск в Google, единственное, что вы просите Google сделать, это предоставить вам результаты, содержащие все релевантные страницы из его индекса.

Часто миллионы страниц могут соответствовать тому, что вы ищете, поэтому у Google есть алгоритмы ранжирования, которые определяют, какие результаты должны отображаться как лучшие, а также наиболее релевантные.

Итак, образно говоря: сканирование — это подготовка к вызову, индексация — это выполнение вызова, и, наконец, ранжирование — это победа в вызове.

Хотя это простые концепции, алгоритмы Google совсем не такие.

Страница должна быть не только ценной, но и уникальной

Если у вас возникли проблемы с индексацией вашей страницы, вы должны убедиться, что страница ценна и уникальна.

Но не заблуждайтесь: то, что вы считаете ценным, может не совпадать с тем, что считает ценным Google.

Google также вряд ли будет индексировать страницы низкого качества из-за того, что эти страницы не представляют никакой ценности для пользователей.

Если вы прошли технический контрольный список SEO на уровне страницы и все проверено (это означает, что страница индексируется и не страдает от каких-либо проблем с качеством), вам следует спросить себя: действительно ли эта страница — и мы имеем в виду действительно — ценный?

Просмотр страницы свежим взглядом может быть полезным, потому что это может помочь вам выявить проблемы с контентом, которые иначе вы бы не обнаружили. Кроме того, вы можете найти то, чего раньше не замечали.

Один из способов определить эти конкретные типы страниц — выполнить анализ страниц низкого качества и с очень небольшим органическим трафиком в Google Analytics.

Затем вы можете принять решение о том, какие страницы оставить, а какие удалить.

Однако важно отметить, что вы не просто хотите удалить страницы, на которых нет трафика. Они все еще могут быть ценными страницами.

Если они освещают тему и помогают вашему сайту стать актуальным авторитетом, не удаляйте их.

Это только навредит вам в долгосрочной перспективе.

Имейте регулярный план, предусматривающий обновление и повторную оптимизацию старого контента

Результаты поиска Google постоянно меняются, как и веб-сайты в этих результатах поиска.

Большинство веб-сайтов, входящих в первую десятку результатов Google, всегда обновляют свой контент (по крайней мере, они должны быть) и вносят изменения в свои страницы.

Важно отслеживать эти изменения и выборочно проверять изменяющиеся результаты поиска, чтобы знать, что нужно изменить в следующий раз.

Регулярная ежемесячная или ежеквартальная проверка вашего сайта — в зависимости от размера вашего сайта — имеет решающее значение для того, чтобы оставаться в курсе событий и быть уверенным, что ваш контент продолжает превосходить конкурентов.

Если ваши конкуренты добавляют новый контент, узнайте, что они добавили и как вы можете их превзойти. Если они по какой-либо причине внесли изменения в свои ключевые слова, узнайте, что это были за изменения, и обойдите их.

Ни один SEO-план не является реалистичным предложением «установил и забыл». Вы должны быть готовы оставаться приверженными регулярной публикации контента наряду с регулярными обновлениями старого контента.

Удалите некачественные страницы и создайте регулярное расписание удаления контента

Со временем вы можете обнаружить, просматривая свою аналитику, что ваши страницы не работают так, как ожидалось, и у них нет показателей, на которые вы надеялись.

В некоторых случаях страницы также являются заполнителями и не улучшают блог с точки зрения вклада в общую тему.

Эти некачественные страницы также обычно не полностью оптимизированы. Они не соответствуют передовым практикам SEO, и у них обычно нет идеальной оптимизации.

Обычно вы хотите убедиться, что эти страницы должным образом оптимизированы и охватывают все темы, которые ожидаются от этой конкретной страницы.

В идеале вы хотите, чтобы шесть элементов каждой страницы всегда оптимизировались:

- Заголовок страницы.

- Мета-описание.

- Внутренние ссылки.

- Заголовки страниц (теги h2, h3, h4 и т.д.).

- изображений (альтернатива изображения, название изображения, физический размер изображения и т. д.).

- Разметка Schema.org.

Но то, что страница не полностью оптимизирована, не всегда означает, что она низкого качества. Влияет ли это на общую тему? Тогда вы не хотите удалять эту страницу.

Ошибочно сразу удалять все страницы, которые не соответствуют определенному минимальному количеству трафика в Google Analytics или Google Search Console.

Вместо этого вы хотите найти страницы, которые не работают хорошо с точки зрения каких-либо показателей на обеих платформах, а затем расставить приоритеты, какие страницы удалить на основе релевантности и того, вносят ли они вклад в тему и ваш общий авторитет.

Если нет, то вы хотите удалить их полностью. Это поможет вам исключить сообщения-заполнители и создать лучший общий план, чтобы ваш сайт был максимально сильным с точки зрения содержания.

Кроме того, убедитесь, что ваша страница написана на темы, интересующие вашу аудиторию, и это очень поможет.

Убедитесь, что ваш файл robots.txt не блокирует сканирование каких-либо страниц

Вы обнаружили, что Google вообще не сканирует и не индексирует какие-либо страницы на вашем веб-сайте? Если это так, возможно, вы случайно полностью заблокировали сканирование.

Проверить это можно в двух местах: на панели управления WordPress в разделе Общие > Чтение > Включить сканирование и в самом файле robots.txt.

Вы также можете проверить файл robots.txt, скопировав следующий адрес: https://domainnameexample.com/robots.txt и введя его в адресную строку веб-браузера.

Если ваш сайт настроен правильно, при переходе на него ваш файл robots. txt должен отображаться без проблем.

txt должен отображаться без проблем.

В robots.txt, если вы случайно полностью отключили сканирование, вы должны увидеть следующую строку:

User-agent: * disallow: /

Косая черта в строке запрета указывает поисковым роботам прекратить индексировать ваш сайт, начиная с корневой папки в public_html.

Звездочка рядом с агентом пользователя сообщает всем возможным поисковым роботам и агентам пользователя, что им запрещено сканировать и индексировать ваш сайт.

Убедитесь, что у вас нет мошеннических тегов Noindex

Без надлежащего надзора можно позволить тегам noindex опередить вас.

Возьмем, к примеру, следующую ситуацию.

У вас много контента, который вы хотите сохранить в индексе. Но вы создаете сценарий без вашего ведома, где кто-то, кто его устанавливает, случайно настраивает его до такой степени, что он не индексирует большой объем страниц.

А что случилось, что этот объем страниц не проиндексирован? Скрипт автоматически добавил целую кучу мошеннических тегов noindex.

К счастью, эту конкретную ситуацию можно исправить, выполнив относительно простой поиск и замену базы данных SQL, если вы используете WordPress. Это может помочь гарантировать, что эти мошеннические теги noindex не вызовут серьезных проблем в будущем.

Ключ к исправлению ошибок такого типа, особенно на веб-сайтах с большим объемом контента, заключается в том, чтобы убедиться, что у вас есть способ исправить любые ошибки, подобные этой, достаточно быстро — по крайней мере, в достаточно короткие сроки, чтобы это не привело к негативным последствиям. повлиять на любые показатели SEO.

Убедитесь, что страницы, которые не проиндексированы, включены в вашу карту сайта

Если вы не включили страницу в свою карту сайта и она не имеет взаимосвязанных ссылок где-либо еще на вашем сайте, у вас может не быть возможности сообщить об этом Google что он существует.

Когда вы отвечаете за большой веб-сайт, это может уйти от вас, особенно если не осуществляется надлежащий контроль.

Допустим, у вас есть большой веб-сайт о здоровье на 100 000 страниц. Возможно, 25 000 страниц никогда не попадут в индекс Google, потому что по какой-то причине они просто не включены в XML-карту сайта.

Это большое число.

Вместо этого вы должны убедиться, что остальные из этих 25 000 страниц включены в вашу карту сайта, потому что они могут значительно повысить ценность вашего сайта в целом.

Даже если они не работают, если эти страницы тесно связаны с вашей темой и хорошо написаны (и качественно), они добавят авторитета.

Кроме того, может случиться так, что внутренняя ссылка ускользнет от вас, особенно если вы программно не заботитесь об этой индексации с помощью каких-либо других средств.

Добавление страниц, которые не проиндексированы, в вашу карту сайта может помочь убедиться, что все ваши страницы обнаружены правильно, и что у вас нет серьезных проблем с индексированием (вычеркните еще один пункт контрольного списка для технического SEO).

Убедитесь, что на сайте не существует мошеннических канонических тегов

Если у вас есть мошеннические канонические теги, эти канонические теги могут помешать индексации вашего сайта. И если у вас их много, то это может еще больше усугубить проблему.

Допустим, у вас есть сайт, на котором ваши канонические теги должны иметь следующий формат:

Но на самом деле они отображаются как:

Это пример мошеннического канонического тега. Эти теги могут нанести ущерб вашему сайту, вызвав проблемы с индексацией. Проблемы с этими типами канонических тегов могут привести к следующему:

- Google не видит ваши страницы должным образом — особенно если конечная страница назначения возвращает ошибку 404 или программную ошибку 404.

- Путаница – Google может выбрать страницы, которые не окажут большого влияния на ранжирование.

- Напрасный краулинговый бюджет . Сканирование страниц Google без надлежащих канонических тегов может привести к нерациональному расходованию краулингового бюджета, если ваши теги установлены неправильно.

Когда ошибка распространяется на многие тысячи страниц, поздравляем! Вы потратили краулинговый бюджет на то, чтобы убедить Google, что эти страницы нужно сканировать, тогда как на самом деле Google должен был сканировать другие страницы.

Когда ошибка распространяется на многие тысячи страниц, поздравляем! Вы потратили краулинговый бюджет на то, чтобы убедить Google, что эти страницы нужно сканировать, тогда как на самом деле Google должен был сканировать другие страницы.

Первый шаг к их устранению — найти ошибку и исправить свой недосмотр. Убедитесь, что обнаружены все страницы с ошибкой.

Затем создайте и реализуйте план дальнейшего исправления этих страниц в достаточном объеме (в зависимости от размера вашего сайта), чтобы это имело значение. Это может отличаться в зависимости от типа сайта, над которым вы работаете.

Убедитесь, что неиндексированная страница не потеряна

Страница-сирота — это страница, которая не отображается ни на карте сайта, ни во внутренних ссылках, ни в навигации и не может быть обнаружена Google ни одним из вышеперечисленных методов. .

Другими словами, это потерянная страница, которая не идентифицируется должным образом с помощью обычных методов сканирования и индексирования Google.

Как это исправить?

Если вы обнаружите, что страница является потерянной, вам необходимо восстановить ее. Вы можете сделать это, включив свою страницу в следующие места:

- Карта сайта XML.

- Навигация по верхнему меню.

- Обеспечение большого количества внутренних ссылок с важных страниц вашего сайта.

Сделав это, у вас будет больше шансов убедиться, что Google просканирует и проиндексирует эту потерянную страницу, включив ее в общий расчет рейтинга.

Исправить все внутренние ссылки nofollow

Хотите верьте, хотите нет, но nofollow буквально означает, что Google не будет переходить или индексировать эту конкретную ссылку. Если у вас их много, то вы тормозите индексацию Google страниц вашего сайта.

На самом деле существует очень мало ситуаций, когда вы должны использовать nofollow по внутренней ссылке. Добавление nofollow к вашим внутренним ссылкам — это то, что вы должны делать только в случае крайней необходимости.

Если подумать, как владелец сайта, вы контролируете свои внутренние ссылки. Зачем вам nofollow по внутренней ссылке, если это не страница вашего сайта, которую вы не хотите, чтобы посетители видели?

Например, подумайте о частной странице входа веб-мастера. Если пользователи обычно не заходят на эту страницу, вы не хотите включать ее в обычное сканирование и индексирование. Таким образом, это должно быть noindexed, nofollow и удалено из всех внутренних ссылок в любом случае.

Но если у вас много nofollow-ссылок, это может вызвать у Google вопрос о качестве, и в этом случае ваш сайт может быть помечен как более неестественный (в зависимости от серьезности nofollow-ссылок).

Если вы включаете nofollow в свои ссылки, то, вероятно, лучше их удалить.

Из-за этих nofollow вы говорите Google не доверять этим конкретным ссылкам.

Дополнительные сведения о том, почему эти ссылки не являются качественными внутренними ссылками, можно узнать из того, как Google в настоящее время обрабатывает ссылки nofollow.

Видите ли, долгое время существовал один тип ссылок nofollow, до недавнего времени, когда Google изменил правила и то, как классифицируются ссылки nofollow.

В новых правилах nofollow Google добавил новые классификации для различных типов ссылок nofollow.

Эти новые классификации включают пользовательский контент (UGC) и спонсируемую рекламу (рекламу).

В любом случае, с этими новыми классификациями nofollow, если вы их не включите, это может фактически быть сигналом качества, который Google использует, чтобы решить, следует ли индексировать вашу страницу.

Вы также можете запланировать их включение, если вы делаете интенсивную рекламу или пользовательский контент, например, комментарии в блогах.

А поскольку комментарии в блогах, как правило, генерируют много автоматического спама, сейчас самое время правильно пометить эти nofollow-ссылки на вашем сайте.

Убедитесь, что вы добавили мощные внутренние ссылки

Существует разница между обычной внутренней ссылкой и «мощной» внутренней ссылкой.

Обычная внутренняя ссылка — это просто внутренняя ссылка. Добавление многих из них может — или не может — сильно повлиять на ваш рейтинг целевой страницы.

Но что, если вы добавите ссылки со страниц, у которых есть обратные ссылки, передающие значение? Даже лучше!

Что, если вы добавите ссылки с более мощных страниц, которые уже представляют ценность?

Вот как вы хотите добавить внутренние ссылки.

Почему внутренние ссылки так важны для SEO? По следующим причинам:

- Они помогают пользователям перемещаться по вашему сайту.

- Они передают полномочия с других страниц, обладающих большими полномочиями.

- Они также помогают определить общую архитектуру веб-сайта.

Перед случайным добавлением внутренних ссылок вы должны убедиться, что они мощные и имеют достаточную ценность, чтобы помочь целевым страницам конкурировать в результатах поиска.

Отправьте свою страницу в консоль поиска Google

Если у вас по-прежнему возникают проблемы с индексацией вашей страницы Google, вы можете рассмотреть возможность отправки своего сайта в консоль поиска Google сразу после того, как вы нажмете кнопку публикации.

Это позволит быстро сообщить Google о вашей странице, и это поможет вам сделать так, чтобы ваша страница была замечена Google быстрее, чем другие методы.

Кроме того, это обычно приводит к индексации в течение нескольких дней, если ваша страница не страдает от каких-либо проблем с качеством.

Это должно помочь двигаться в правильном направлении.

Используйте плагин мгновенного индексирования Rank Math

Чтобы быстро проиндексировать ваше сообщение, вы можете рассмотреть возможность использования плагина мгновенного индексирования Rank Math.

Использование плагина мгновенного индексирования означает, что страницы вашего сайта обычно быстро сканируются и индексируются.

Плагин позволяет сообщить Google о добавлении страницы, которую вы только что опубликовали, в приоритетную очередь сканирования.

Плагин мгновенного индексирования Rank Math использует API мгновенного индексирования Google.

Улучшение качества вашего сайта и процессов его индексации означает, что он будет оптимизирован для более быстрого ранжирования за более короткий промежуток времени

Улучшение индексации вашего сайта включает в себя уверенность в том, что вы улучшаете качество своего сайта, а также то, как он сканируется и индексируется.

Сюда также входит оптимизация краулингового бюджета вашего сайта.

Убедившись, что ваши страницы имеют самое высокое качество, что они содержат только сильное содержание, а не заполняющий контент, и что они имеют надежную оптимизацию, вы увеличиваете вероятность того, что Google быстро проиндексирует ваш сайт.

Кроме того, сосредоточение ваших оптимизаций на улучшении процессов индексации с помощью плагинов, таких как Index Now, и других типов процессов также создаст ситуации, когда Google сочтет ваш сайт достаточно интересным, чтобы быстро просканировать и проиндексировать ваш сайт.

Правильная оптимизация этих типов элементов оптимизации контента означает, что ваш сайт будет принадлежать к тем сайтам, которые любит видеть Google, и значительно упростит достижение результатов индексирования.

Дополнительные ресурсы:

- 14 основных причин, по которым Google не индексирует ваш сайт

- Как проиндексировать сайт перед запуском и почему это важно

- Продвинутое техническое SEO: полное руководство

Рекомендуемое изображение: BestForBest/Shutterstock

Категория Техническое SEO

SEO: как проиндексировать страницу в Google

5 января 2023 г.

• Ann Smarty

• Ann SmartyGoogle генерирует органические списки поиска из своей базы данных, содержащей сотни миллиардов веб-страниц. Добавление страницы в эту базу данных — первый шаг Google в определении рейтинга.

«Индексация» на языке Google означает добавление URL-адреса в базу данных вместе с ключевой информацией — на странице (заголовки, основной текст, метатеги) и вне ее (внутренние и внешние ссылки, текст вокруг этих ссылок, информация об авторе). ). Google использует эту информацию в результатах поиска и регулярно обновляет индекс.

Компания может заблокировать страницу из индекса Google с помощью команды robots.txt, хотя это не является надежным, и Google все равно может проиндексировать ее, используя информацию за пределами страницы.

Учитывая огромный объем индекса, Google может потребоваться несколько дней, чтобы обнаружить и добавить новую страницу. И новые страницы индексируются быстрее, чем обновления.

Как проиндексировать страницу?

Google обычно обнаруживает и быстро индексирует страницы веб-сайтов с менее чем несколькими тысячами URL-адресов, при условии, что на каждую из этих страниц есть внутренние ссылки. Внешние ссылки ускорят поиск, как и отправка XML-карты сайта в Search Console.

Внешние ссылки ускорят поиск, как и отправка XML-карты сайта в Search Console.

После индексации Google будет регулярно проверять сайт на наличие изменений.

Google разрешает запросы на повторное сканирование сайта. Но частые запросы часто указывают на технические проблемы. Поэтому вместо повторного сканирования проверьте свой сайт, чтобы убедиться, что внутренние ссылки действительны и легко сканируются. Может помочь сторонний инструмент сканирования, такой как Screaming Frog.

Карты сайта в формате XML особенно полезны для крупных сайтов, управляемых базами данных, с тысячами страниц продуктов и сотнями категорий. Файлы Sitemap позволят Google легче получать доступ к более глубоким страницам и сообщать (через Search Console) о структурных проблемах или проблемах с индексацией.

Как подтвердить индексацию?

Есть два способа узнать, проиндексировал ли страницу Google:

- Найдите в Google site:full-url — например, site:practicalecommerce.

com. Если он проиндексирован, URL-адрес появится в органических результатах.

com. Если он проиндексирован, URL-адрес появится в органических результатах. - Проверьте отчет «Страницы» в Search Console.

Обратите внимание, что Google может индексировать страницу, но не кэшировать ее.

Следите за вкладкой «Страницы» на предмет ошибок индексации. Прокрутите вниз до отчета «Просканировано — в настоящее время не проиндексировано», чтобы увидеть список страниц, не включенных в индекс Google, и причину. Отчет обычно включает несколько неиндексированных страниц. Однако, если их число растет или их больше нескольких, проверьте свой сайт на наличие основных проблем.

При просмотре этого отчета я часто нахожу URL-адреса, которые действительно проиндексированы, что указывает на то, что отчет устарел.

Тем не менее, неиндексированный URL-адрес может сигнализировать о более широкой проблеме. Итак, еще раз исключите эту возможность, прежде чем запрашивать повторное сканирование.

В отчете «Просканировано — в настоящее время не проиндексировано» перечислены страницы, не входящие в индекс Google, и причина.

Ждем, пока увидят, или вручную ускоряем процесс индексации.

Ждем, пока увидят, или вручную ускоряем процесс индексации.

Когда ошибка распространяется на многие тысячи страниц, поздравляем! Вы потратили краулинговый бюджет на то, чтобы убедить Google, что эти страницы нужно сканировать, тогда как на самом деле Google должен был сканировать другие страницы.

Когда ошибка распространяется на многие тысячи страниц, поздравляем! Вы потратили краулинговый бюджет на то, чтобы убедить Google, что эти страницы нужно сканировать, тогда как на самом деле Google должен был сканировать другие страницы. com. Если он проиндексирован, URL-адрес появится в органических результатах.

com. Если он проиндексирован, URL-адрес появится в органических результатах.