Как найти ключевые слова с низкой конкуренцией для SEO

Joshua Hardwick

Глава отдела контента в Ahrefs (проще говоря, я отвечаю за то, чтобы каждый пост в блоге был КРУТЫМ).

Поделиться этой статьей

Содержание

Все хотят ранжироваться по конкурентным ключевым словам, но это редко удается в краткосрочной перспективе. Если ваш веб-сайт новый или относительно неизвестный, вы вряд ли в ближайшее время сможете ранжироваться по конкурентным ключевым словам.

Означает ли это, что вам не следует нацеливаться на конкурентные ключевые слова? Нет. Но это значит, что в краткосрочной перспективе вам следует использовать ключевые слова с меньшей конкуренцией.

Из этого поста вы узнайте, как всего за несколько простых шагов найти ключевые слова, не требующие больших усилий, и как убедиться, что эти ключевые слова действительно имеют низкую конкуренцию и по ним легко ранжироваться.

Как найти ключевые слова с низкой конкуренцией

Выполните эти три шага, чтобы быстро найти тысячи ключевых слов с низкой конкуренцией и высокой частотой поиска.

1. Соберите список тем

Подумайте, что ваша целевая аудитория может искать в Google, и запишите свои идеи. Здесь вам необязательно угадывать точные фразы, просто отметьте общие темы.

Например, если вы продаете компьютеры и комплектующие через Интернет, это могут быть:

- компьютер

- ноутбук

- макбук

- imac

- жесткий диск

Не нужно мудрствовать. Просто записывайте, что приходит в голову.

Когда у вас будет 5–10 идей, переходите ко второму шагу.

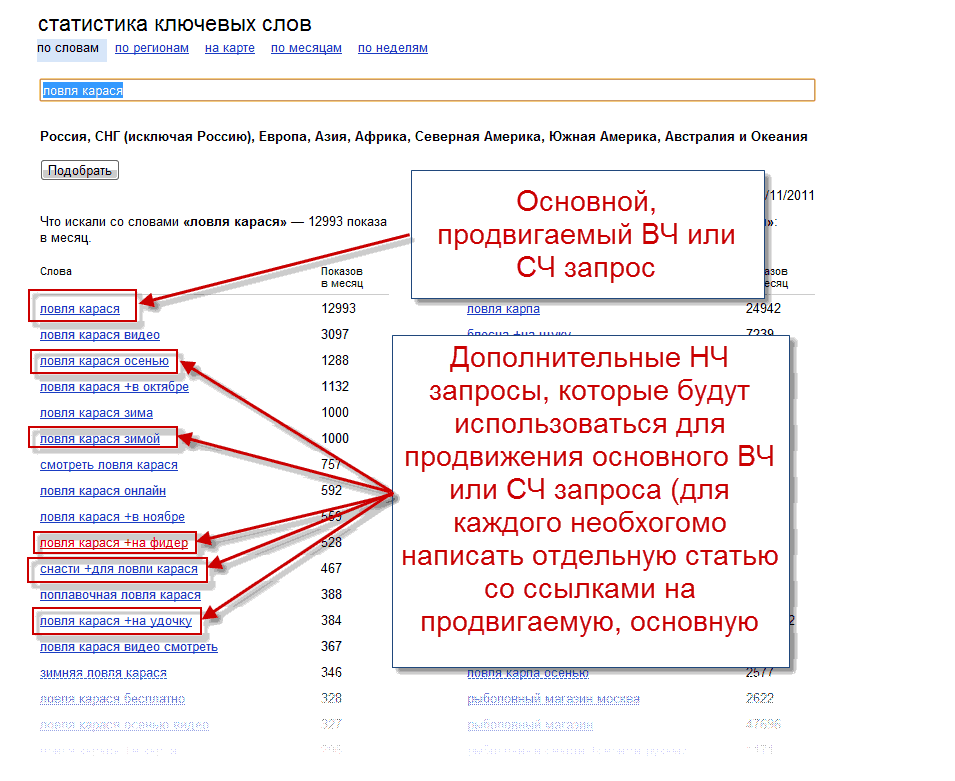

2. Расширьте список идей с помощью инструмента анализа ключевых слов

Вставьте идеи в инструмент анализа ключевых слов, например, в Анализ ключевых слов Ahrefs, а затем перейдите к отчету Фразовое соответствие. Вы увидите варианты ключевых слов, включающие одно или несколько введенных вами слов и фраз, а также ежемесячную частоту поиска и другие метрики SEO.

3. Отфильтруйте ключевые слова с низкой “сложностью”

Многие инструменты анализа ключевых слов предоставляют оценку сложности. В нашем инструменте она называется сложностью ключевого слова (KD). Это числовое представление того, насколько сложно будет ранжироваться в топ-10 Google по конкретному поисковому запросу.

В нашем инструменте она называется сложностью ключевого слова (KD). Это числовое представление того, насколько сложно будет ранжироваться в топ-10 Google по конкретному поисковому запросу.

В отчете Фразовое соответствие отфильтруйте ключевые слова с оценкой KD от 0 до 10, чтобы найти ключевые слова с низкой конкуренцией.

Как видно выше, нам удалось найти более 167 000 ключевых слов всего по пяти “базовым” темам. Если вы хотите сузить список, просто добавьте фильтр по минимальной ежемесячной частоте поиска.

Неужели найти ключевые слова с низкой конкуренцией так просто?

И да и нет.

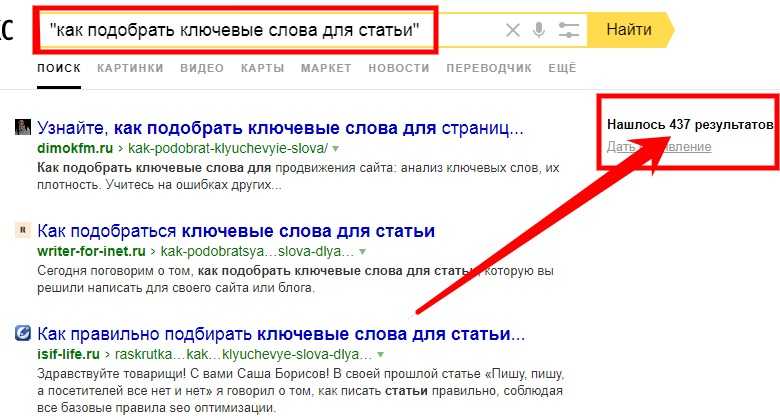

Google использует сотни сигналов ранжирования, поэтому никакие сторонние SEO-инструменты просто не способны расшифровать их все и вычислить “точную” метрику сложности ключевых слов. Это на грани невозможного, особенно если учесть, что многие из этих факторов ранжирования являются всего лишь предположениями, которые не были подтверждены Google.

Также важно понимать, что каждый SEO-инструмент использует уникальную формулу оценки сложности ключевого слова, поэтому эти оценки часто сильно разнятся от инструмента к инструменту:

В Ahrefs наш расчет сложности ключевых слов прост: мы берем средневзвешенное количество ссылающихся доменов (ссылающихся веб-сайтов), указывающих на страницы в топ-10. Это означает, что страницы, ранжирующиеся в топе по ключевым словам с высокой KD, имеют много обратных ссылок, а страницы, ранжирующиеся в топе по ключевым словам с низкой KD, имеют мало обратных ссылок.

Это означает, что страницы, ранжирующиеся в топе по ключевым словам с высокой KD, имеют много обратных ссылок, а страницы, ранжирующиеся в топе по ключевым словам с низкой KD, имеют мало обратных ссылок.

Примечание.

Если вы используете другой инструмент для анализа ключевых слов, обратитесь в их службу поддержки и уточните, как они рассчитывают свою оценку сложности ключевых слов. Вы не сможете использовать ее эффективно, если не знаете, как она рассчитывается.

Учитывая, что обратные ссылки являются, возможно, наиболее важным фактором ранжирования, наша оценка сложности ключевых слов является достойным показателем сложности ранжирования. Если у ключевого слова низкая оценка KD в Ahrefs, это означает, что оно “имеет низкую конкуренцию” в том смысле, что вам, вероятно, не придется строить или зарабатывать много обратных ссылок, чтобы конкурировать по ним.

Но не стоит судить о конкуренции исключительно по этой метрике. Есть и другие факторы, которые необходимо учитывать перед нацеливанием на ключевое слово.

Есть и другие факторы, которые необходимо учитывать перед нацеливанием на ключевое слово.

Давайте рассмотрим три самых важных из них.

- Поисковое намерение

- Авторитет веб-сайта

- Высококачественные обратные ссылки

Поисковое намерение

Даже если ключевое слово имеет сверхнизкую сложность, вам будет сложно ранжироваться по нему, не создавая контента, который ищут пользователи. Поэтому при анализе ключевых слов стоит искать ключевые слова, которые действительно подходят для того типа контента, который вы собираетесь создавать.

Есть четыре основных типа ключевых слов:

- Информационные. Пользователь, выполняющий поиск, ищет информацию по теме.

- Навигационные. Пользователь, выполняющий поиск, ищет определенный веб-сайт.

- Коммерческого исследования. Пользователь, выполняющий поиск, хочет купить конкретный продукт или услугу, но еще не решил, что именно выбрать.

- Транзакционные. Пользователь, выполняющий поиск, хочет что-то купить.

Часто можно определить, в какую группу попадает ваше ключевое слово, по модификаторам ключевых слов в запросе. Если он содержит такие слова, как “купить” или “дешево”, скорее всего, это транзакционный запрос. Если он содержит такие слова, как “как”, “что” или “где”, то это, вероятно, информационный запрос.

Ниже вы найдете краткую памятку по модификаторам ключевых слов.

В Анализе ключевых слов Ahrefs вы можете найти варианты ключевых слов, которые попадают в какую-либо из этих групп, с помощью фильтра “Включить”.

Например, если бы вы хотели найти транзакционные ключевые слова с низкой конкуренцией, вот как это можно было бы сделать:

- Введите базовые ключевые слова

- Выберите отчет “Фразовое соответствие”, содержащий идеи ключевых слов

- Отфильтруйте ключевые слова с низкой конкуренцией с помощью фильтра по KD (KD <10)

- Добавьте такие слова, как “купить” и “дешево” в фильтр “Включить”.

- Включите параметр “Любое слово”

Если вы ищете информационные ключевые слова с низкой конкуренцией для блога, вы можете сделать то же самое, используя информационные модификаторы. Но еще более быстрый способ — использовать отчет Вопросы, в котором представлены варианты ключевых слов в форме вопросов.

Только не забывайте, что, хотя фильтрация по ключевым словам с модификаторами работает, она далеко не надежна, потому что такие ключевые слова не всегда соответствуют ожидаемому типу поискового запроса.

Давайте посмотрим на такое ключевое слово, как “best buy coffee makers” (выгодно купить кофеварки).

Несмотря на то, что он содержит модификатор транзакции “buy” (купить), это не является транзакционным ключевым словом. Это навигационный запрос, потому что люди ищут результаты с Best Buy — популярного магазина электроники в Северной Америке.

Это еще раз подчеркивает, как поисковое намерение может влиять на конкуренцию по ключевым словам. Хотя у этого запроса оценка сложности ключевого слова равна 1, он не является низкоконкурентным, поскольку относится к навигационной группе ключевых слов. Вы никогда не превзойдете Best Buy, что бы вы ни делали, потому что они занимают все 10 позиций на первой странице Google по этому запросу.

Хотя у этого запроса оценка сложности ключевого слова равна 1, он не является низкоконкурентным, поскольку относится к навигационной группе ключевых слов. Вы никогда не превзойдете Best Buy, что бы вы ни делали, потому что они занимают все 10 позиций на первой странице Google по этому запросу.

Авторитет веб-сайта

Рейтинг домена (DR) измеряет авторитет веб-сайта по шкале от нуля до ста на основе профиля обратных ссылок.

Многие специалисты по SEO считают, что Google использует какую-то метрику авторитета веб-сайта в своем алгоритме ранжирования, но Джон Мюллер из Google много раз публично заявлял, что это неправда.

We don’t use domain authority at all in our algorithms.

— 🍌 John 🍌 (@JohnMu) February 24, 2020

Мы совсем не используем авторитет домена в наших алгоритмах.

В любом случае, по некоторым, казалось бы, низкоконкурентным ключевым словам с низкими оценками KD все страницы, ранжирующиеся в топе, поступают с сайтов с очень высоким DR.

Яркий пример — запрос “черные сандалии”.

Несмотря на то, что оценка сложности ключевого слова составляет всего 1, средний DR для первой страницы результатов составляет 86, а самый низкий DR — 76.

Доказывает ли это, что авторитет веб-сайта является фактором ранжирования?

Не совсем. Можно утверждать, что это больше связано с авторитетом бренда, чем с авторитетом веб-сайта. Крупные бренды, вероятно, доминируют в поисковой выдаче, потому что именно у них большинство людей хотят делать покупки.

К сожалению, вы ничего не можете с этим поделать, если у вас более “слабые” веб-сайт и бренд. Вам, вероятно, будет сложно ранжироваться по ключевым словам, для которых играет роль авторитет бренда.

Это подводит нас к важному моменту:

Cложность ранжирования относительна.

Если вы Target, “черные сандалии” — ключевое слово с низкой конкуренцией, потому что у вас есть достаточный авторитет веб-сайта и бренда для ранжирования. Если вы маленький семейный бизнес, то “черные сандалии” — ключевое слово с высокой конкуренцией, потому что вы находитесь на совсем другом уровне по сравнению с крупными брендами, которые доминируют в поисковой выдаче.

Если вы маленький семейный бизнес, то “черные сандалии” — ключевое слово с высокой конкуренцией, потому что вы находитесь на совсем другом уровне по сравнению с крупными брендами, которые доминируют в поисковой выдаче.

Означает ли это, что менее авторитетные и известные бренды не могут опередить сильных игроков? Нет. Это просто будет сложнее и об этом следует помнить при поиске ключевых слов с низкой конкуренцией.

Высококачественные обратные ссылки

Сложность ключевых слов учитывает количество обратных ссылок на страницы, ранжирующиеся в топе, но не их качество. Чтобы оценить качество ссылки, вам нужно будет учесть множество вещей, в том числе:

- Релевантность ссылающихся сайта и страницы

- Авторитет ссылающихся сайта и страницы

- Расположение ссылки на странице

- Текст анкора ссылки

- Статусы Follow и Nofollow

Практически невозможно учесть все эти и многие другие моменты при составлении оценки сложности ключевого слова, поэтому мы придерживаемся простого и последовательного подхода, обращая внимание исключительно на среднее количество ссылающихся доменов (ссылающихся веб-сайтов), указывающих на страницы в топ-10.

По этой причине всегда стоит вручную проверять ссылочные профили страниц, ранжирующихся в топе, потому что количество — это еще не все.

Чтобы продемонстрировать это, давайте посмотрим на количество ссылающихся доменов у страниц, ранжирующихся в топе по двум ключевым словам с одинаково низкими оценками KD:

На первый взгляд кажется, что ранжироваться по второму ключевому слову проще, потому что у страницы, с которой вы конкурируете, меньше ссылок. Но что действительно важно, так это качество ссылок.

У этой страницы 14 ссылающихся доменов и 94% обратных ссылок имеют статус follow, а большинство из них поступают с релевантных и авторитетных страниц и веб-сайтов. У них также в основном релевантные анкоры.

У этой страницы 92 ссылающихся домена и 96% обратных ссылок имеют атрибут nofollow, а большинство из них поступают с низкоавторитетных веб-сайтов, предоставляющих купоны. У них также практически все анкоры голые.

Примечание.

Атрибут nofollow намекает Google, что ссылки не должны влиять на ранжирование, но они могут проигнорировать эту подсказку. Подробнее здесь.

Фактически, есть только две “стоящие” обратные ссылки, указывающие на страницу с 92 ссылающимися доменами. В это же время, большинство ссылок, указывающих на страницу всего с 14 ссылающимися доменами, актуальные и качественные.

В заключение, при прочих равных страницу с 92 ссылающимися доменами было бы проще превзойти, чем страницу с 14 ссылающимися доменами. Таким образом, несмотря на одинаковые оценки KD, ключевое слово “лучший кофе для холодного заваривания”, возможно, менее конкурентное, чем “лучшие снасти для ловли на мушку для новичков”.

Нужно ли избегать ключевые слова с высокой конкуренцией?

Многие люди концентрируются на ключевых словах с низкой конкуренцией, потому что думают, что не смогут ранжироватьсся по другим словам. Даже если это верно в краткосрочной перспективе, ключевые слова с высокой конкуренцией могут быть хорошей возможностью по разным причинам.

Помните, что оценка сложности ключевых слов Ahrefs основана на обратных ссылках. Это означает, что в среднем страницы, ранжирующиеся в топе по ключевым словам с высокой KD, имеют множество обратных ссылок.

Другими словами, ключевые слова с высокой конкуренцией часто являются отличными темами, которые просто притягивают ссылки — это контент, заточенный под привлечение ссылок.

Чтобы найти эти темы, нужно сделать противоположное тому, что вы делали раньше. Вместо отфильтровывания ключевых слов с низкими оценкам KD, обратите внимание на ключевые слова с высокими оценками KD.

Например, если у вас есть сайт с резюме, вот что вам нужно сделать:

- Откройте Анализ ключевых слов

- Введите релевантное “базовое” ключевое слово (например, “резюме”).

- Перейдите в отчет Вопросы

- Отфильтруйте ключевые слова с высокими оценками KD (например, 50+)

Если вы посмотрите на обзор SERP по любому из этих ключевых слов, вы обнаружите, что многие страницы, ранжирующиеся в топе, имеют множество обратных ссылок.

В таком случае, если вы создадите лучшее в сети руководство по составлению резюме, люди, уже ссылающиеся на эти существующие страницы, станут отличными возможностями для получения ссылок. Вам просто нужно обратиться к ним, указав вескую причину, по которой им стоит сослаться на вас.

Получите достаточно высококачественных обратных ссылок на свою страницу, и, скорее всего, вы сможете подняться в выдаче, даже если вам не хватает авторитета веб-сайта и бренда.

В любом случае у нацеливания на ключевые слова с высокой конкуренцией есть еще два преимущества (даже если вы не ранжируетесь).

- Вы можете повысить авторитет сайта. Авторитет бренда не вырастает на пустом месте. В первую очередь он является побочным продуктом ссылок.

- Вы можете передать этот “авторитет” важным страницам.. Используйте внутренние ссылки с авторитетной “наживки” для продвижения релевантных страниц, нацеленных на менее конкурентные ключевые слова.

Это второе преимущество — то, что мы называем техникой посредника.

Это удобный способ повысить “авторитет” скучных страниц, на которые сложно получить ссылки.

Рекомендовано к прочтению. Простая SEO-стратегия (метод “посредника”)

Заключение

Конкуренция по ключевым словам относительна. Поскольку оценка сложности ключевых слов не учитывает все аспекты, которые влияют на конкурентность, вы всегда должны вручную проверять страницы, ранжирующиеся в топе, перед созданием контента.

В противном случае вы можете выбрать ключевые слова, которые не являются на самом деле низкоконкурентными. Хоть в этом и нет ничего плохого, такие ключевые слова должны быть среднесрочными или долгосрочными целями, а не краткосрочными.

Есть вопросы? Напишите мне в Twitter.

Перевела Олеся Коробка, владелец Fajela.com

keyT5 или генерация ключевых слов из текста / Хабр

Я попытался обучить русскоязычную модель ruT5-base и ruT5-large на задаче извлечения ключевых слов из текста.

Github — text2keywords

HuggingFace — keyt5-base | keyt5-large

Передо мной стояла задача — найти быструю модель, которая поддерживает CPU для лёгкого и эффективного встраивания в проект. Я искал достаточно долго… Наткнулся на несколько платных сервисов, которые предоставляют возможность создать SEO ключевые слова. Мне это не подходит, нужно искать слова по смыслу, а не для «поисковиков». На Хабре было несколько решений данной проблемы, но они либо закрытые, либо не до конца понятные.

Я искал достаточно долго… Наткнулся на несколько платных сервисов, которые предоставляют возможность создать SEO ключевые слова. Мне это не подходит, нужно искать слова по смыслу, а не для «поисковиков». На Хабре было несколько решений данной проблемы, но они либо закрытые, либо не до конца понятные.

Поэтому я решил создать свою, уникальную, неповторимую, единственную модель! И конечно, сделать доступ к ней, открытым.

Ладно, это просто переобученная модель T5 от Google. Они позиционировали своё творение как «трансформер, с помощью которого можно решить любую, текстовую задачу!», звучит громко, я решил попробовать…

За основу взята русскоязычная версия T5, ruT5.

Сбор данных

Мне нужно было найти какой-нибудь сервис, у которого уже есть каталог статьей и ключевые слова к нему. И возможность спарсить всё это.

Классические новостные издательства не подходили, да и ключевых слов у них не было… Была идея остановиться на dtf.ru, vc.ru, tjournal.ru, но ключевых слов в конце постов было слишком мало или их не было совсем.

У меня не было много времени, для поиска лучшего варианта, поэтому остановился я на habr.com, много текста, много статей, много ключевых слов.

красота…Для создания набора данных я решил взять и Теги и Хабы. Сразу сделал «стоп-слова». Они отсеивают англоязычные слова и «Блог компании компания«:

stop_words = ['Блог', 'a', 'b', 'c', 'd', 'e', 'f', 'g', 'h', 'i', 'j',

'k', 'l', 'm', 'n', 'o', 'p', 'q', 'r', 's', 't', 'u',

'v', 'w', 'x', 'y', 'z', 'A', 'B', 'C', 'D', 'E', 'F',

'G', 'H', 'I', 'J', 'K', 'L', 'M', 'N', 'O', 'P', 'Q',

'R', 'S', 'T', 'U', 'V', 'W', 'X', 'Y', 'Z']Чтобы не записывать огромные статьи по несколько абзацев и не доставлять себе лишних проблем, я подключил «суммартизатор» (BERT модель), который сжимает огромную статью, в маленький, аккуратный абзац:

Код суммартизатораfrom transformers import MBartTokenizer, MBartForConditionalGeneration model_name = "IlyaGusev/mbart_ru_sum_gazeta" tokenizer = MBartTokenizer.from_pretrained(model_name) model = MBartForConditionalGeneration.from_pretrained(model_name) def summ(article_text): input_ids = tokenizer( [article_text], max_length=600, # максимальная длинна текста на выходе padding="max_length", truncation=True, return_tensors="pt", )["input_ids"] output_ids = model.generate( input_ids=input_ids, no_repeat_ngram_size=4 )[0] summary = tokenizer.decode(output_ids, skip_special_tokens=True) return summary

print(summ('Огромная статья'))Посты программа получает из rss Хабов (список rss каналов тут).

И так, алгоритм работы скрипта collect.py:

Получаем rss канал из cache

Получаем пост

Переходим к посту и парсим текст и теги

Записываем в cvs файл

Ничего сложного. Всё, что было сказано в этом разделе лежит в репозитории в папке «dataset»

Обучение и первые проблемы

Обучалась модель ruT5 на сервере Google Colab (Nvidia Tesla P100). Более подробные детали обучения:

Более подробные детали обучения:

# | loss | epoch | batch | step |

keyT5-base | 1.8 | 6 | 8 | 200 |

keyT5-large | 1.3 | 10 | 2 | 200 |

Обучать дольше не было смысла: результат оставался на прежнем месте. Размер батча пришлось уменьшить на large версии для экономии ОЗУ. Модели в общей сложности обучались 14 часов.

Т.к. Хабр — узконаправленный сервис, модель запомнила очень много «сложных слов». Особенно этим грешит слабая модель. Она применяет сложные термины (часто, ошибачно) к статьям, не относящееся к области IT. Эту проблему удалось решить, увеличив эпохи с 3 до 6. С keyT5-large всё прекрасно.

Проблемы на данный момент

Все модели очень часто повторяются, особенно в «монотонных» статьях:

1Reuters сообщил об отмене 3,6 тыс. авиарейсов из-за «омикрона» и погоды Наибольшее число отмен авиарейсов 2 января пришлось на американские авиакомпании SkyWest и Southwest, у каждой — более 400 отмененных рейсов. При этом среди отмененных 2 января авиарейсов — более 2,1 тыс. рейсов в США. Также свыше 6400 рейсов были задержаны.

авиарейсов из-за «омикрона» и погоды Наибольшее число отмен авиарейсов 2 января пришлось на американские авиакомпании SkyWest и Southwest, у каждой — более 400 отмененных рейсов. При этом среди отмененных 2 января авиарейсов — более 2,1 тыс. рейсов в США. Также свыше 6400 рейсов были задержаны.

[‘авиаперевозки’, ‘отмена авиарейсов’, ‘отмена рейсов’, ‘отмена авиарейсов’, ‘отмена рейсов’, ‘отмена авиарейсов’]

Но не всегда

2В России может появиться новый штамм коронавируса «омикрон», что может привести к подъему заболеваемости в январе, заявил доцент кафедры инфекционных болезней РУДН Сергей Вознесенский. Он отметил, что вариант «дельта» вызывал больше летальных случаев, чем омикрон, именно на фоне «дельты» была максимальная летальность.

[‘омикрон’, ‘коронавирус’, ‘вакцина от коронавируса’, ‘научно-популярное’, ‘биотехнологии’, ‘здоровье’]

Эту проблему можно отчасти решить, выкрутив параметр top_p до 1:

generate(article, top_p=1.0)

Ноутбуки со всеми примерами хранятся тут.

Примеры работы моделей

В Колумбии задержан колумбиец Марио Антонио Паласиос, которого считают одним из главных подозреваемых в убийстве президента Гаити Жоневеля Моиза. Ранее сообщалось, что четверо полицейских, ранее задержанных в рамках расследования убийства Моиза, были временно освобождены.

large: [‘гаити’, ‘задержание подозреваемых’, ‘занимательные задачки’]

base: [‘гаити’]

Хакеры взломали две израильские газеты в годовщину смерти Сулеймани. Президент США Дональд Трамп еще в июне прошлого года согласился на спецоперацию по ликвидации главы иранского элитного подразделения «Аль-Кудс» Касема Сулеймани, однако поставил условие для выполнения этого приказа, сообщает телеканал NBC со ссылкой на бывших и действующих чиновников из окружения Трампа. По их словам, это условие было выполнено, когда при обстреле шиитскими боевиками базы в Ираке 27 декабря погиб американский гражданский служащий, работавший там по контракту.

large: [‘личная безопасность’]

base: [‘информационная безопасность’, ‘криптовалюты’]

Российский транзит газа через Украину в Словакию снова резко снизился. 2 января он упал почти на 30 процентов. Ранее в январе сообщалось, что транзит российского газа в направлении Словакии упал до самого низкого уровня со 2 ноября.

2 января он упал почти на 30 процентов. Ранее в январе сообщалось, что транзит российского газа в направлении Словакии упал до самого низкого уровня со 2 ноября.

large: [‘транзит’, ‘словакия’, ‘транзит’]

base: [‘транзит газа’]

«Поиграться» с моделью всегда можно тут.

Заключение

Да, мне удалось достичь удовлетворительного результата, но есть куда стремиться. Возможно, найдя больше данных, я переобучу модели.

Github — text2keywords

HuggingFace — keyt5-base | keyt5-large

Всё, что вам нужно, вы найдёте в репозитории.

Бесплатный инструмент для извлечения ключевых слов | Writesonic

Бесплатный инструмент для извлечения ключевых слов | Writesonic — AI WriterИзвлекайте наиболее релевантные ключевые слова из любого текста за считанные секунды с помощью этого бесплатного и мощного экстрактора ключевых слов.

Что-то пошло не так

Войдите, чтобы получить больше возможностей! Начать бесплатно

Поиск ключевых слов в любом тексте.

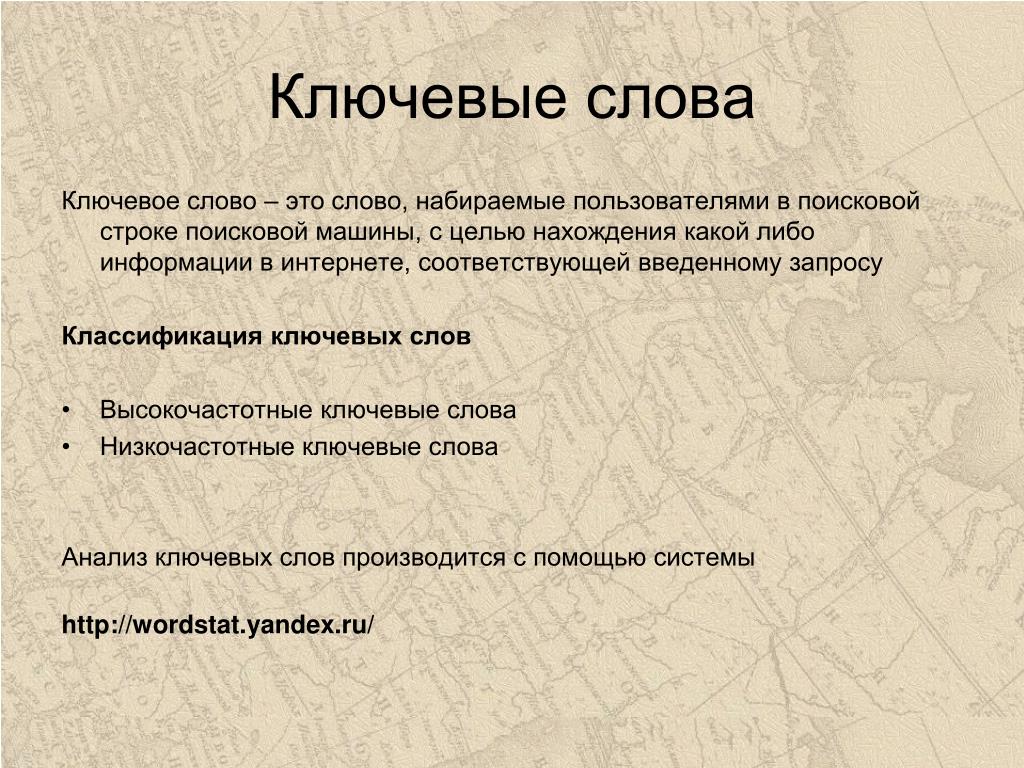

Ключевые слова – это слова и словосочетания, описывающие основную тему текста. Они необходимы для оптимизации вашего онлайн-контента.

Вставьте свой текст

Скопируйте и вставьте содержимое, которое вы хотите проанализировать

Выберите язык

Выберите из 25+ языков

Нажмите «Создать»

Нажмите «Создать», как только вы предоставите вышеуказанную информацию.

Что такое экстрактор ключевых слов?

Keyword Extractor — это инструмент для ключевых слов на основе искусственного интеллекта, который может анализировать любой текст и извлекать для вас наиболее релевантные ключевые слова. Он использует искусственный интеллект, чтобы понять контекст и значение вашего текста и определить ключевые слова, которые лучше всего его представляют.

Некоторые возможные цели извлечения ключевых слов:

Обобщение основных тем или тем текста.

Для облегчения поиска информации и поисковой оптимизации.

Для поддержки анализа текста.

Для сравнения текста и измерения сходства между конкурентом и вашим брендом.

Для облегчения генерации текста и перефразирования.

Как Writesonic может помочь мне с извлечением ключевых слов?

С инструментами для письма на базе искусственного интеллекта вы можете быстро достичь своих целей по ключевым словам! Writesonic Keyword Extractor — это инструмент для письма с искусственным интеллектом, который может помочь вам извлекать ключевые слова из любого фрагмента контента до 10 раз в день.

Вот как можно использовать извлеченные ключевые слова:

Замените их синонимами, вариантами и ключевыми словами с длинным хвостом, чтобы разнообразить контент и избежать повторения.

Создание внутренних и внешних ссылок на соответствующие страницы и источники

Создайте кластеры контента и тематические центры вокруг ваших основных ключевых слов

Генерируйте новые идеи контента и заполните пробелы в вашей стратегии контента раз в день бесплатно.

Если вы хотите извлечь больше, используйте Экстрактор ключевых слов AI. Зарегистрируйтесь сейчас, чтобы получить свои первые 2500 слов бесплатно!

Если вы хотите извлечь больше, используйте Экстрактор ключевых слов AI. Зарегистрируйтесь сейчас, чтобы получить свои первые 2500 слов бесплатно!Как использовать инструмент Writesonic для извлечения ключевых слов?

Мы создали Keyword Extractor, бесплатный и мощный инструмент для извлечения ключевых слов, чтобы помочь вам в создании оптимизированного контента. Если вы хотите оптимизировать свой веб-сайт, сообщения в блогах, сообщения в социальных сетях, рекламу или любой другой тип контента, вы можете использовать этот инструмент, чтобы найти лучшие ключевые слова для вашей аудитории и ниши. Чтобы использовать этот инструмент, просто выполните следующие три шага:

Шаг 1 — Скопируйте и вставьте свой контент в указанное выше поле.

Шаг 2 — Выберите язык.

Шаг 3 — Нажмите кнопку «Создать» или просто нажмите клавишу ввода.

Бесплатное средство извлечения ключевых слов Writesonic создаст для вас набор релевантных ключевых слов.

Скопируйте список ключевых слов и используйте его по своему усмотрению. Вы можете бесплатно извлекать ключевые слова из 10 различных материалов в день.

Скопируйте список ключевых слов и используйте его по своему усмотрению. Вы можете бесплатно извлекать ключевые слова из 10 различных материалов в день.Часто задаваемые вопросы

Как извлечь ключевые слова из фрагмента текста?

Существуют различные возможные подходы к извлечению ключевых слов из фрагмента контента, но лучшим из них является использование экстрактора ключевых слов Writesonic. Этот инструмент искусственного интеллекта можно использовать бесплатно, и он может анализировать любой контент за считанные секунды.

Как вы извлекаете ключевые слова?

Если вы хотите понять важные ключевые слова, которые используются в части контента, вы выполняете извлечение ключевых слов. Обычно этот процесс включает чтение всего контента построчно и поиск релевантных ключевых слов часами. Но с помощью бесплатного инструмента искусственного интеллекта Writesonic для извлечения ключевых слов вы можете сделать это за считанные секунды.

Какова цель извлечения ключевых слов?

Существуют различные возможные цели извлечения ключевых слов в зависимости от контекста и приложения, но в целом извлечение ключевых слов представляет собой процесс идентификации и выбора наиболее релевантных и информативных слов или фраз из текста или набора текстов.

Чтобы узнать больше, попробуйте бесплатный инструмент для извлечения ключевых слов от Writesonic.

Чтобы узнать больше, попробуйте бесплатный инструмент для извлечения ключевых слов от Writesonic.Могу ли я использовать экстрактор ключевых слов Writesonic для любой ниши или темы?

Да, можно. Экстрактор ключевых слов Writesonic может генерировать ключевые слова для любой ниши или темы, о которой вы только можете подумать. Просто предоставьте контент, из которого вы хотите извлечь ключевые слова, и нажмите «Создать». Все остальное сделает ИИ.

Как использовать извлечение ключевых слов для SEO и контент-маркетинга?

Инструмент извлечения ключевых слов Writesonic может помочь вам улучшить SEO и контент-маркетинг разными способами. Вот некоторые из преимуществ извлечения ключевых слов для вашего онлайн-бизнеса:

- Оптимизируйте свой контент для ключевых слов, которые ищет ваша аудитория

- Откройте для себя новые возможности ключевых слов и расширьте охват

- Создавайте контент, который соответствует намерениям и потребностям вашей аудитории

- Отслеживайте ключевые слова и стратегии ваших конкурентов

- Измеряйте свое ключевое слово производительность и эффективность

Существующие бесплатные инструменты

Идеи для списков

Создавайте интересные идеи для списков для публикации на различных платформах.

Попробуйте эту функцию бесплатно

Интро для блога

Попробуйте эту функцию бесплатно

Создавайте привлекательные вступления для сообщений в блоге одним щелчком мыши.

Ответы Quora

С легкостью создавайте содержательные ответы на вопросы Quora.

Попробуйте эту функцию бесплатно

Идеи YouTube

Идеи YouTube

Попробуйте эту функцию бесплатно

Создайте уникальный набор идей для своего следующего видео на YouTube.

Перефразирование содержимого

Откройте для себя разные способы записи одного и того же. Новые слова, новый стиль.

Попробуйте эту функцию бесплатно

Sentence Expander

Не хватает слов? Составьте свои предложения здесь.

Попробуйте эту функцию бесплатно

Sonic Editor (GPT-3)

Перефразируйте, расширяйте, сокращайте, проверяйте, редактируйте и публикуйте свой контент в этом редакторе.

Попробуйте эту функцию бесплатно

Идеи для блога

Создавайте броские заголовки для блогов всего одним словом.

Попробуйте эту функцию бесплатно

Извлечение ключевых слов с помощью KeyBERT

KeyBERT — это пакет Python с открытым исходным кодом, который упрощает извлечение ключевых слов. текста всего тремя строками кода. KeyBERT имеет более 1,5 тыс. звезд и был создан автором BERTopic с 2,5 тыс. звезд. Таким образом, вы можете быть уверены, что пакет пользуется уважением в сообществе НЛП.

Методология

Прежде чем мы обсудим, как использовать KeyBERT, полезно получить общее представление о том, как работает пакет. Это позволило бы нам лучше понять, что означают выходные данные, а также ограничения и возможности пакета.

KeyBERT выполняет четыре шага для получения прогнозов. Эти шаги основаны на этой статье автора, которая содержит более подробные объяснения. На верхнем уровне пакет вычисляет вектор, представляющий число , означающее 9.0200 для каждого возможного слова/фразы и вектора для значения всего документа, чтобы затем определить слова/фразы, которые наиболее похожи на весь документ, используя вычисленные векторы.

Шаг 1: извлечение слов/фраз

Первым шагом является определение возможных слов и фраз. Автор использовал CountVectorizer scikit-learn для определения возможных слов/фраз. CountVectorizer токенизирует текстовый ввод и позволяет программисту указать диапазон n-грамм, которые мы хотели бы рассмотреть. Он подсчитывает количество вхождений каждого диапазона n-грамм. Но KeyBERT не учитывает количество вхождений каждого диапазона n-грамм, а вместо этого рассматривает только те n-граммы, которые произошли независимо от их частоты.

Пример:

В приведенном ниже примере показано входное предложение «Король и Королева встретились, чтобы обсудить вечеринку Короля». Стоп-слова удаляются, и они преобразуются в форму без заглавных букв, в результате чего получается текст «король, королева встретился, обсудил вечеринку короля». Отсюда мы можем извлечь униграммы и биграммы.

Рисунок 1: Униграммы и биграммы, определенные с помощью CountVectorizerШаг 2: Векторы

Следующим шагом является использование пакета Sentence Transformers library для вычисления векторов, которые представляют значение как извлеченных слов/фраз, так и общий документ.

Рисунок 2: Векторные представления для отдельных сущностей Рисунок 3: Векторные представления для предложений Недавно я опубликовал полную статью о Sentence Transformers, которую я рекомендую вам прочитать, чтобы узнать больше. Но если кратко объяснить, вы, возможно, слышали о таких инструментах, как Word2vec, которые могут вычислять векторы, представляющие значение отдельных объектов, как показано на рис. 2. Теперь авторы Sentence Transformers нашли способ эффективного вычисления векторов для представления значение целых документов. На рис. 3 показан пример отображения векторов в трехмерном пространстве для коротких предложений. Обратите внимание, как похожие предложения расположены близко друг к другу.

Недавно я опубликовал полную статью о Sentence Transformers, которую я рекомендую вам прочитать, чтобы узнать больше. Но если кратко объяснить, вы, возможно, слышали о таких инструментах, как Word2vec, которые могут вычислять векторы, представляющие значение отдельных объектов, как показано на рис. 2. Теперь авторы Sentence Transformers нашли способ эффективного вычисления векторов для представления значение целых документов. На рис. 3 показан пример отображения векторов в трехмерном пространстве для коротких предложений. Обратите внимание, как похожие предложения расположены близко друг к другу.Шаг 3: Сравнение векторов

Затем автор KeyBERT сравнил векторы, полученные для слов/фраз, с вектором, созданным для всего документа. Он использовал сходство косинусов между векторами в качестве метрики для определения расстояния между ними.

Итак, в качестве верхних ключей были выбраны векторы для ключей, которые были близки к вектору для документа.

Итак, в качестве верхних ключей были выбраны векторы для ключей, которые были близки к вектору для документа.Шаг 4: Диверсификация

Автор применил приемы диверсификации выбранных ключей. Без применения этих методов модель может выбрать очень похожие слова/фразы в качестве верхних ключей. Например, если есть статья о фруктах, которая включает много разных видов фруктов и не применяет эту технику, то тремя верхними ключами могут быть «зеленое яблоко», «большое яблоко», «желтое яблоко». Вместо этого мы можем захотеть, чтобы программа включала различные виды фруктов в верхние ключи, даже если один из них был более распространенным в статье.

В этом уроке я не буду объяснять методы применения диверсификации. Если вам интересно узнать больше, я рекомендую вам прочитать статью автора KeyBERT, которая более подробно объясняет эту тему.

Код

Установить

Начнем с установки keybert из PyPI.

pip install keybert

Import

Давайте импортируем класс KeyBERT для загрузки модели.

из импорта ключей KeyBERT

Модель

Давайте не будем создавать объект, используя наш класс KeyBERT. По умолчанию используется модель all-MiniLM-L6-v2 . Но можно использовать и другие модели с этой веб-страницы. Чтобы использовать альтернативную модель, передайте имя модели в первый позиционный параметр. Автор рекомендует использовать модель под названием paraphrase-multilingual-MiniLM-L12-v2 для многоязычного текста.

kw_model = KeyBERT() kw_model_multi = KeyBERT('парафраз-многоязычный-MiniLM-L12-v2')Данные

Мы будем использовать текст из одной из моих статей под названием «Создание обучающих данных для классификации текста с помощью моделей преобразователя с нулевым импульсом». контролируемая модель может быть обучена. Таким образом, мы должны ожидать, что ключевые слова включают такие слова, как «классификация текста» и «данные для обучения».

документ = """ Классификация текста с нулевым выстрелом — это действительно преобразующая технология. Эти модели могут классифицировать текст по произвольным категориям без какой-либо тонкой настройки [1].

Эта технология обеспечивает два основных преимущества по сравнению с традиционными подходами к обучению с классификацией текста под наблюдением.

Во-первых, они позволяют выполнять классификацию текста, когда размеченных данных не существует, поскольку тонкая настройка не требуется.

Далее, единую модель можно использовать для классификации тысяч различных меток.

Однако модели классификации текста с нулевым выстрелом часто бывают большими.

Например, одна из самых популярных моделей классификации текста с нулевым выстрелом основана на архитектуре BART-большого преобразователя, которая имеет более 400 миллионов параметров.

В этой статье будет обсуждаться, как использовать модель классификации текста с нулевым выстрелом для создания обучающих данных, а затем использовать сгенерированные обучающие данные для обучения небольшой модели, которая по-прежнему хорошо работает.

Эти модели могут классифицировать текст по произвольным категориям без какой-либо тонкой настройки [1].

Эта технология обеспечивает два основных преимущества по сравнению с традиционными подходами к обучению с классификацией текста под наблюдением.

Во-первых, они позволяют выполнять классификацию текста, когда размеченных данных не существует, поскольку тонкая настройка не требуется.

Далее, единую модель можно использовать для классификации тысяч различных меток.

Однако модели классификации текста с нулевым выстрелом часто бывают большими.

Например, одна из самых популярных моделей классификации текста с нулевым выстрелом основана на архитектуре BART-большого преобразователя, которая имеет более 400 миллионов параметров.

В этой статье будет обсуждаться, как использовать модель классификации текста с нулевым выстрелом для создания обучающих данных, а затем использовать сгенерированные обучающие данные для обучения небольшой модели, которая по-прежнему хорошо работает.

Теперь нам просто нужно вызвать метод extract_keywords() нашего объекта KeyBERT для вывода результатов. Мы предоставим документ первому позиционному параметру, а затем укажем количество ключей, которые мы хотели бы получить, в параметре «top_n».

Выходные данные представляют собой список кортежей, где первый индекс в кортеже — это строковое значение ключа, а второе значение — это расстояние ключа, которое можно рассматривать как оценку, отражающую модель определенно между диапазон от 0 до 1 с более высокими значениями.

ключевых слов = kw_model.extract_keywords(doc, top_n=10) print(keywords)

Вывод:

[(‘текст’, 0.3842), (‘классификация’, 0.3567), (‘nlp’, 0.3539), (‘под наблюдением’, 0.3105), (‘обучение’ , 0,3065), (‘классифицировать’, 0,2866), (‘выстрел’, 0,2855), (‘модели’, 0,2615), (‘метки’, 0,2446), (‘категории’, 0,2385)]

Мы видим, что модель действительно смогла идентифицировать слова, которые, по-видимому, отражают смысл текста.

Подсветка ключевых слов

Мы можем вызвать наш KeyBERT extract_keywords() , установив для параметра Highlight значение True, чтобы напечатать вывод, чтобы показать результат.

keywords = kw_model.extract_keywords(doc, highlight=True)

Настройки

Фразы

В предыдущем примере мы рассматривали отдельные токены/слова как потенциальные ключи. Мы можем настроить это, чтобы рассматривать диапазон токенов в качестве возможных ключей. Это достигается предоставлением кортежа для keyphrase_ngram_range параметр.

ключевых слов = kw_model.extract_keywords(doc, keyphrase_ngram_range=(2, 2), top_n=10) print(keywords)

Вывод:

[(‘выделенный текст’, 0.5327), (‘классифицировать текст’, 0.5255), (‘классификация текста’, 0.5198), (‘контролируемый текст’, 0.5055), («нулевой выстрел», 0,4965), («модели классификации», 0,3962), («данные для обучения», 0,367), («ноль меток», 0,366), («модель классификации», 0,3593), («обучение классификации» , 0,353)]

Сходство максимальной суммы

Мы можем захотеть, чтобы модель создавала более разнообразный набор ключей.

В приведенном выше примере выходные данные содержали слово «классификация» четыре раза вместе со словом классифицировать в первых десяти ключах. Мы используем алгоритм, называемый сходством максимальной суммы, чтобы разнообразить вывод, рассматривая параметр use_maxsum как true и предоставляя целое число для nr_candidates .

В приведенном выше примере выходные данные содержали слово «классификация» четыре раза вместе со словом классифицировать в первых десяти ключах. Мы используем алгоритм, называемый сходством максимальной суммы, чтобы разнообразить вывод, рассматривая параметр use_maxsum как true и предоставляя целое число для nr_candidates .ключевых слов = kw_model.extract_keywords(doc, keyphrase_ngram_range=(2, 2), use_maxsum=True, top_n=10, nr_candidates=20) печать(ключевые слова)

[(‘популярный ноль’, 0,3028), (‘сгенерированное обучение’, 0,3075), (‘подходы к обучению’, 0,3217), (‘разрешить НЛП’, 0,3218), (‘практики НЛП’, 0,3245), (‘ истинная классификация», 0,345), («модели классифицируют», 0,3507), («выполняют текст», 0,3522), («метки ноль», 0,366), («нулевой выстрел», 0,4965)]

ЗаключениеИ вот и все! Отсюда я рекомендую вам ознакомиться с моей предыдущей статьей, посвященной моделированию тем с помощью BERTopic — пакета, который позволяет вам определять, какие темы являются частью текста.

from_pretrained(model_name)

model = MBartForConditionalGeneration.from_pretrained(model_name)

def summ(article_text):

input_ids = tokenizer(

[article_text],

max_length=600, # максимальная длинна текста на выходе

padding="max_length",

truncation=True,

return_tensors="pt",

)["input_ids"]

output_ids = model.generate(

input_ids=input_ids,

no_repeat_ngram_size=4

)[0]

summary = tokenizer.decode(output_ids, skip_special_tokens=True)

return summary

from_pretrained(model_name)

model = MBartForConditionalGeneration.from_pretrained(model_name)

def summ(article_text):

input_ids = tokenizer(

[article_text],

max_length=600, # максимальная длинна текста на выходе

padding="max_length",

truncation=True,

return_tensors="pt",

)["input_ids"]

output_ids = model.generate(

input_ids=input_ids,

no_repeat_ngram_size=4

)[0]

summary = tokenizer.decode(output_ids, skip_special_tokens=True)

return summary