Индексация страниц сайта поисковыми системами: что это, как происходит

#SEO #ИндексацияИндексация (с латинского index — «указатель, список, реестр») — процесс, в рамках которого роботы поисковых систем (ПС) обрабатывают страницы сайтов и добавляют их в поисковую выдачу, или исключают из нее.

Индексатор — приложение поисковой системы (робот), которое проводит анализ и обработку данных о новых или обновившихся страницах на веб-ресурсе. Если этот робот найдет новый контент и он будет соответствовать требованиям поисковой системы, робот добавит ее в выдачу.

Индексация в SEO-продвижении сайтов

Индексация играет первостепенную роль в продвижении сайтов. И здесь крайне важно понимать принципы работы поисковых систем и их алгоритмов, чтобы страница действительно попала в индекс поисковой системы и ее смогли находить пользователи.

Никому достоверно неизвестно, по каким именно алгоритмам поисковые системы со своими роботами индексируют страницы и ранжируют их в выдаче. У разных ПС эти алгоритмы отличаются, и эксперты, занимающиеся раскруткой сайтов, опираются скорее на свой и чужой опыт, нежели на какие-то руководства по максимально быстрой индексации сайтов.

Некоторые тонкости индексации веб-ресурсов поисковыми системами

Важно понимать, что сайт не будет проиндексирован автоматически сразу после размещения на хостинге. Поисковые роботы не созданы для того, чтобы постоянно отслеживать появление новых веб-ресурсов и страниц на них.

Поэтому лучше сразу после базовой настройки и публикации новых страниц на сайте добавить его в поисковую систему (ее базу данных). И лишь после всего вышеописанного роботы ПС смогут выполнить обход страниц и проиндексировать контент веб-ресурса. Делается это с помощью Яндекс.Вебмастера и Google Search Console.

Для ускорения индексации сайта в ПС эксперты рекомендуют:

- Как только сайт будет доступен после размещения на хостинге, нужно подключить для него Яндекс.

Вебмастер и Google Search Console и добавить ссылку на карту сайта в соответствующих разделах этих систем.

Вебмастер и Google Search Console и добавить ссылку на карту сайта в соответствующих разделах этих систем. - Параллельно с добавлением сайта в базу ПС стоит регистрировать веб-ресурс в социальных закладках (сервисах, где пользователи сохраняют закладки для того, чтобы вернуться к ним позже).

- Проводить дополнительные мероприятия по ускорению индексации сайта (создать карту сайта, сделать перелинковку, правильно оформить файл Robots.txt.).

В итоге новый веб-ресурс будет быстрее проиндексирован поисковыми системами, а социальные закладки со ссылкой на него станут вспомогательным «указателем» роботу поисковой системы на новый проект.

Быстрая индексация ресурса (или его новой страницы) играет крайне важную роль в развитии веб-проекта. Особенно это важно для коммерческих и общественно важных сайтов.

Только после индексации сайта поисковыми системами он появится в выдаче, и на него смогут заходить посетители или потенциальные клиенты.

Что такое индексация сайта веб индексация

Индексация сайта – это процесс, во время которого робот поисковой системы проводит сбор сведений о страницах ресурса. Вся собранная информация сохраняется в базе, поисковом индексе. Все это дает возможность системе понять, что ресурс не просто присутствует в Интернете, но на нем размещены тематические статьи и прочее, представляющее интерес для пользователя, а потому, он заслуживает верхних позиций в списке выдачи.

Вся собранная информация сохраняется в базе, поисковом индексе. Все это дает возможность системе понять, что ресурс не просто присутствует в Интернете, но на нем размещены тематические статьи и прочее, представляющее интерес для пользователя, а потому, он заслуживает верхних позиций в списке выдачи.

- Отличия индексации сайта от сканирования

- Что такое индексирование

- Сайт не индексируется: вероятные проблемы

- Индексация и админки

- Индексация сайтов различных типов

- Особенности индексации сайтов на JavaScript

- Индексация сайта в Google и Яндекс

- Индексация в Google

- Индексация в Яндекс

- Сколько времени занимает попадание в индекс

- Как проверить индексацию

- Проверка индексации сайта в поисковых системах

- Специальные операторы

- Сервисы для вебмастеров

- Сторонние сервисы

- Как ускорить индексацию

- Обход страниц через Яндекс.Вебмастер

- Использование Google Search Console

- Создание файла robots.

txt

txt - Создание файла sitemap.xml

- Создание карты HTML

- Создание понятной структуры

- Оптимизация скорости загрузки

- Создание внутренней перелинковки

- Внешние сигналы

- Использование ловца ботов

- Как запретить индексацию

Отличия индексации сайта от сканирования

Различие существует только в терминологии двух основных поисковых систем: Яндекса и Google.

- У Яндекса индексация сайта — это весь процесс целиком.

- У Google индексация – это вторая стадия процесса, благодаря которому они оказываются в списках поисковой выдачи. Сканирование сайтов, в свою очередь, является начальным этапом, “проверкой”, во время которой роботы посещают ресурс, пользуясь сторонними ссылками, либо информацией, указанной непосредственно пользователем, изучают его и размещенный контент, от текстов до видеороликов и фотографий.

Что такое индексирование

Если не разделять индексацию на сканирование и индексирование страниц, то процесс проходит по следующему алгоритму:

- По той причине, что возможности ПС имеют определенные границы, робот-планировщик составляет очередность обхода страниц на сайте, отталкиваясь от критерия их полезности, популярности и т.

д. Для каждого сайта рассчитывается свой краулинговый бюджет. Расчёт ведется исходя из скоростных характеристик ресурса, а так же из уровня заспамленности, соотношения полезны/мусорных страниц, наличия малополезных автоматически нагенерированных страниц и циклических ссылок и других немаловажных факторов.

д. Для каждого сайта рассчитывается свой краулинговый бюджет. Расчёт ведется исходя из скоростных характеристик ресурса, а так же из уровня заспамленности, соотношения полезны/мусорных страниц, наличия малополезных автоматически нагенерированных страниц и циклических ссылок и других немаловажных факторов. - Обнаружение, загрузка и разбор роботом новой или старой страницы.

- Анализ по списку параметров: доступность к индексации, код ответа сервера, является ли дублем и т.д.

- Если проверка пройдена — страница добавляется в индекс.

Подобный алгоритм характерен для всех систем. Да, между Яндекс и его близкими аналогами, будь то Google или Рамблер, есть некоторые различия, но они незначительны, касаются больше технических тонкостей и нюансов, нежели базового принципа.

Сайт не индексируется: вероятные проблемы

Трудности с индексацией сайта, как правило, возникают по следующим причинам:

- Неоптимизированный краулинговый бюджет. Большое количество автоматически генерируемых URL-адресов, циклические ссылки, низкое качество страниц, для индексации которых требуется слишком много времени.

- Блокировки robots.txt. Следует открыть /robots.txt, при наличии такового, и проверить, что необходимые разделы не заблокированы. Часто бывает, что некоторые разделы сайта оказываются закрытыми от индексации, например, папки с графикой или видео. Распространена ситуация и с директивой «Disallow:», из-за которой поисковые роботы обделяют вниманием весь ресурс.

- Блокировка в админке. Характерный пример – панель администратора WordPress, где по умолчанию при запуске сайта предусмотрена специальная функция, при активации которой роботы не занимаются индексацией. Для исправления ситуации достаточно просто отключить ее.

- Блокировка через meta-robots. Данный тег находится внутри <head>, часто используется разработчиками и администраторами для того, чтобы запретить индексирование — «noindex, nofollow». Главное в таком случае – не забыть удалить тег после окончательного запуска сайта, публикации на нем интересного содержимого.

- Блокировка X-Robots-Tag в заголовке HTTP. Те же директивы «noindex, nofollow», только на уровне ответа сервера.

- Санкции, наложенные поисковой системой. Пример ситуации – взлом сайта и публикация на нем вредоносного кода. При обнаружении этого система блокирует индексирование до тех пор, пока не будет восстановлен рейтинг доверия. Также проблемы возникают с ресурсами, не представляющими ценности для посетителей, созданными исключительно для систем поиска, сайтами с негативной доменной историей, либо копиями уже работающих, принадлежащих тому же собственнику, но размещенных на другом домене.

- Страницы со «специальными» статусами от ПС. «Просканирована, но не проиндексирована», «неканоническая», «дубль», «малоценный и малополезный контент». Поисковая система исключила данные страницы из индекса и присвоила им тот или иной статус, указывающий на наличие проблемы.

- Код ответа сервера страницы не 200.

И такое бывает — страница доступна для пользователей, а для поисковых роботов нет.

И такое бывает — страница доступна для пользователей, а для поисковых роботов нет.

Индексация и админки

- Тильда. Индексация сайта проходит автоматически, для ее ускорения следует прописать теги, от h2 до более низких, обозначить понятные адреса всех страничек, убедиться в корректности переадресации, добавить ресурс в поисковую консоль Google и сервис Вебмастер от Яндекс.

- Bitrix. В целом, для ускорения индексации можно использовать стандартные инструменты, но платформа предлагает и дополнительные уникальные решения, упрощающие работу. Например, модуль Сотбит позволяет администратору быстрее и точнее проставить внутренние ссылки, сформировать карту, добавить уникальные мета-теги.

- WordPress. Опять же, основные методы индексации в такой системе вполне стандартны. Дополнительно через панель администратора стоит прописать в пункте «Сервисы обновления» пинг-адреса, благодаря которым машины Яндекс и Google будут получать уведомления о новых публикациях.

Это действие приведет к тому, что странички окажутся в индексе в максимально короткие сроки, за 7-10 дней.

Это действие приведет к тому, что странички окажутся в индексе в максимально короткие сроки, за 7-10 дней.

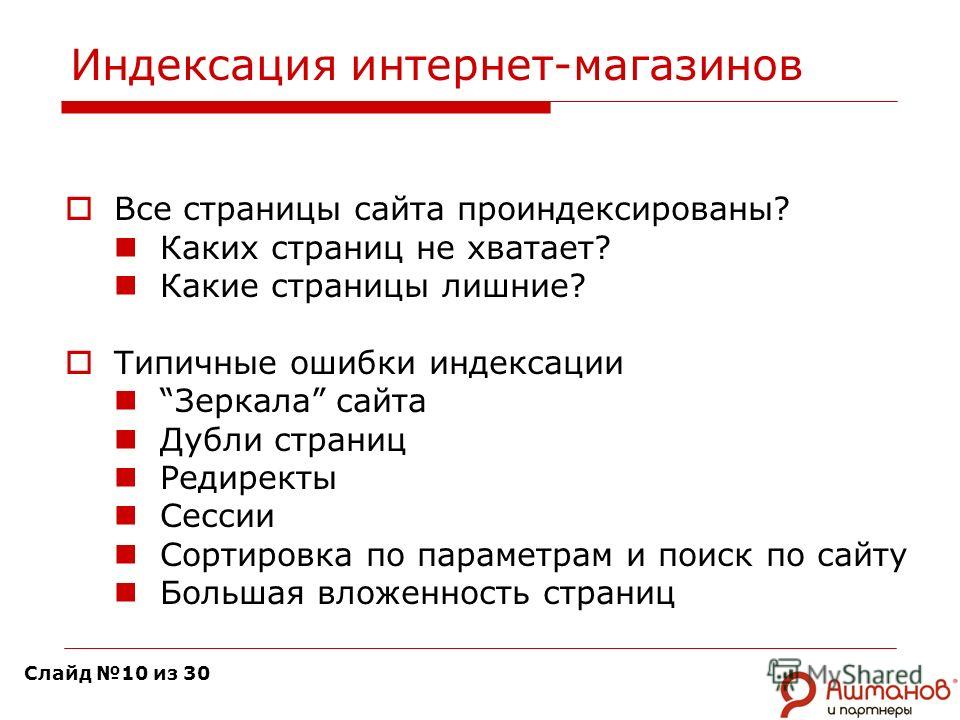

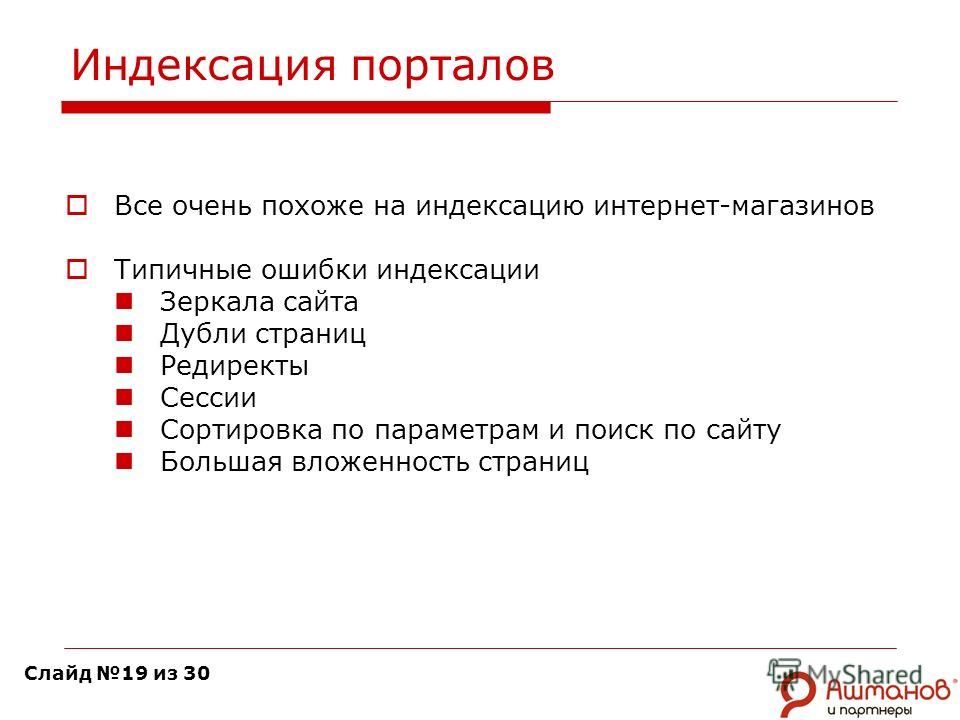

Индексация сайтов различных типов

Тонкости индексации сайта в значительной степени зависят от его специфики:

- Новостные сайты. Яндекс использует для индексации новостных ресурсов специального быстробота. Для исключения проблем нужно регулярно публиковать свежие новости, уникальные, проверенные, соответствующие российскому законодательству, следить, чтобы все странички открывались быстро, не были слишком удалены от главной страницы.

- Интернет-магазины. Нужно следить, чтобы на сайте не было пустых страниц, ведущих на несуществующие, распроданные товары, к числу важных факторов относится и скорость открытия страничек.

- Блоги. Поисковая система при индексации отдает предпочтение сайтам с хорошей скоростью загрузки, регулярно наполняемых интересными уникальными материалами.

Особенности индексации сайтов на JavaScript

Поисковые системы не индексируют контент в JavaScript. Если зайти в сохраненную копию страницы сделанной на JavaScript, то она будет пустая.

Если зайти в сохраненную копию страницы сделанной на JavaScript, то она будет пустая.

Один из эффективных инструментов для решения подобной проблемы– это технология Prerender.

Если коротко, то:

- пользователь видит динамическую версию страницы на скриптах,

- поисковой робот получает копию страниц в формате html.

Основные проблемы с которыми вы можете столкнуться:

- проблема со скоростью загрузки,

- необходимость еженедельной модерации html версии сайта,

- скорость внедрения тех или иных задач из-за сложности технологии растягивается.

Индексация сайта в Google и Яндекс

Конкретные алгоритмы индексации – коммерческая тайна, простому администратору доступ к ней строго закрыт. Впрочем, практика позволила обнаружить некоторые отличия между основными системами, Яндекс и Google, которые вполне можно применять в работе.

Индексация в Google

Главная особенность – проведение индексации с применением метода Mobile-first. Он предполагает, что сначала роботу оценят мобильный вариант ресурса, так что его разработке нужно уделить максимум внимания, экономия скажется и на статусе основной версии. Второй момент – “краулинговый бюджет”, частота и длительность посещения сайта роботами. Чем он выше, тем меньше времени требуется для попадания новых страниц в списке выдачи, однако, конкретные сведения об алгоритмах расчета “краулингового бюджета” отсутствуют, также относятся к разряду коммерческой тайны.

Он предполагает, что сначала роботу оценят мобильный вариант ресурса, так что его разработке нужно уделить максимум внимания, экономия скажется и на статусе основной версии. Второй момент – “краулинговый бюджет”, частота и длительность посещения сайта роботами. Чем он выше, тем меньше времени требуется для попадания новых страниц в списке выдачи, однако, конкретные сведения об алгоритмах расчета “краулингового бюджета” отсутствуют, также относятся к разряду коммерческой тайны.

Инструкция по отправке на переобход страницы выглядит следующим образом:

- Открытие Google Search Console сайта.

- В поисковую строку необходимо ввести страницу, которую вы хотите отправить на переобход, нажать enter. Далее нажать кнопку — «запросить индексирование».

Индексация в Яндекс

Как индексировать сайт в Яндексе? Первым делом, индексируется версия для ПК. Данная система не оперирует понятием “краулингового бюджета”, так что он не сказывается на функционировании роботов. Практика показывает, что преимущество имеют популярные ресурсы с высоким уровенем посещаемости, чем интереснее страница реальным пользователям, тем скорее она появится в списках выдачи. Также следует учесть, что Яндекс обделяет вниманием документы, вес которых превышает 10 мегабайт.

Практика показывает, что преимущество имеют популярные ресурсы с высоким уровенем посещаемости, чем интереснее страница реальным пользователям, тем скорее она появится в списках выдачи. Также следует учесть, что Яндекс обделяет вниманием документы, вес которых превышает 10 мегабайт.

Инструкция для повторной отправки на индексацию такова:

- Регистрация в системе, открытие меню Вебмастера.

- Добавление сайта.

- Добавление домена.

- Подтверждение прав собственника на обозначенный ресурс, для чего требуется представление метатега, указание записи DNS или файла HTML.

- Постановка ресурса в очередь для дальнейшего индексирования.

Сколько времени занимает попадание в индекс

К сожалению, заставить роботов работать, ускорить индексацию сайтов невозможно. Единственное, что можно сделать для улучшения результата и уменьшения времени ожидания – оптимизация страниц, что упрощает их обнаружение, исключает трудности со сканированием.

Конкретные сроки завершения индексации сразу обозначить невозможно, иногда они составляют всего несколько дней, иногда – растягиваются на недели. Ожидать, что все работы с сайтом будут закончены на 2-3 дня не стоит, подобны заявления – обман.

Ожидать, что все работы с сайтом будут закончены на 2-3 дня не стоит, подобны заявления – обман.

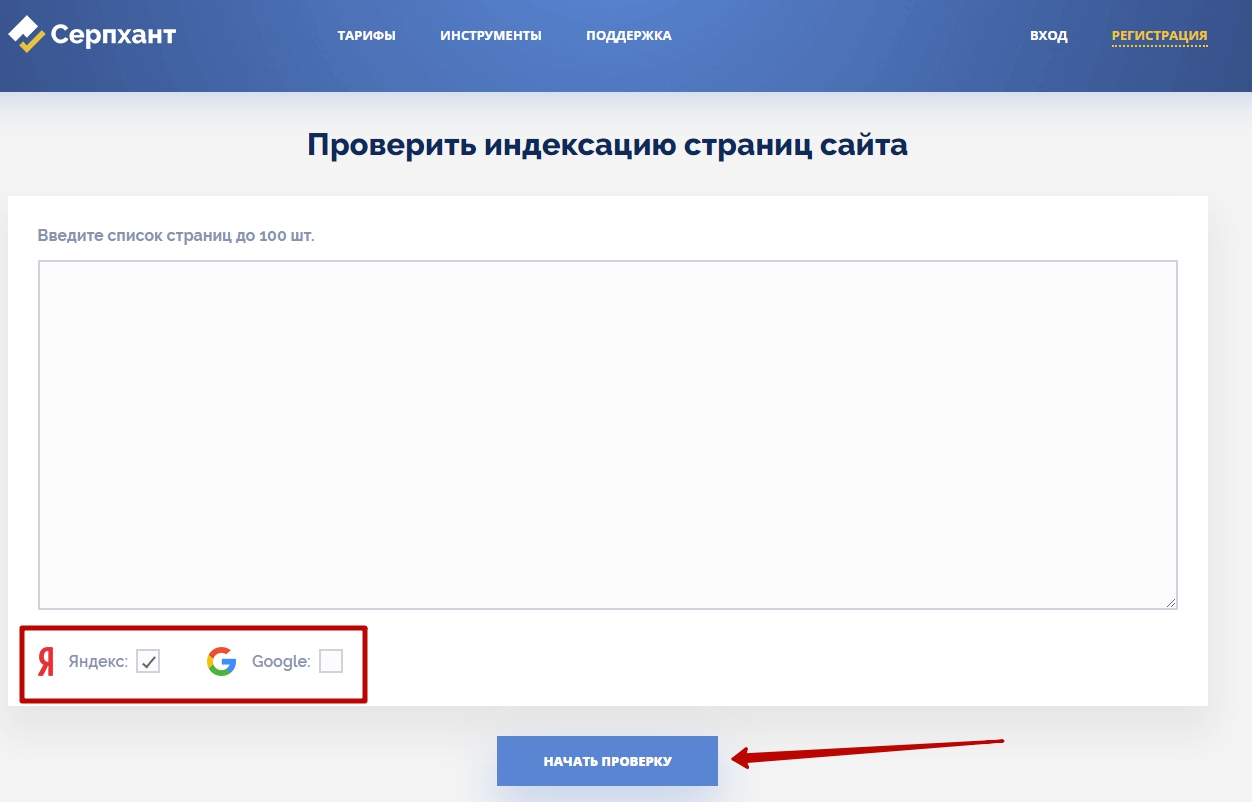

Как проверить индексацию

Для проверки индексации доступны различные инструменты, как встроенные в поисковые системы, так и сторонние сервисы. Ими обязательно стоит воспользоваться, чтобы определить текущий статус процесса, обратить внимание на ошибки, принять меры по их устранению, сделать сайты максимально видимыми, улучшить их позицию в списках выдачи, увеличить посещаемость и другие показатели.

Проверка индексации сайта в поисковых системах

Анализ сайтов доступен в обеих популярных системах:

- Google Search Console. Для проверки необходимо лишь указать адрес интересующей страницы в строке, если ранее она уже была проиндексирована, появится соответствующее уведомление.

- Вебмастер от Яндекс. Принцип тот же, что и в предыдущем случае, в поисковой строке соответствующего раздела нужно указать адрес странички и провести проверку.

Специальные операторы

В Google можно воспользоваться еще одним простым методом – указанием в поисковой строке запроса вида «site:[интересующее доменное имя]». Ответом станет формирование полного списка поисковых результатов, удастся понять, не проигнорировали ли роботы значимые страницы.

Ответом станет формирование полного списка поисковых результатов, удастся понять, не проигнорировали ли роботы значимые страницы.

Сервисы для вебмастеров

Лучше всего зарекомендовали себя специальные плагины, максимально удобные, понятные, но эффективные. К примеру, в браузер Chrome можно поставить дополнение RDS Bar, оно совершенно бесплатно, но позволяет в одно нажатие получить все сведения об интересующем сайте, в том числе и о его индексировании.

Rush Analytics

Проверить есть ли та или иная страница в индексе можно в нашем сервисе за несколько кликов.

Как ускорить индексацию

Любой владелец ресурса в Веб заинтересован в том, чтобы индексирование заняло минимум времени, это позволит быстрее начать извлекать прибыль, получать заказы, размещать рекламную информацию, объявления. Для решения такой задачи доступно несколько способов.

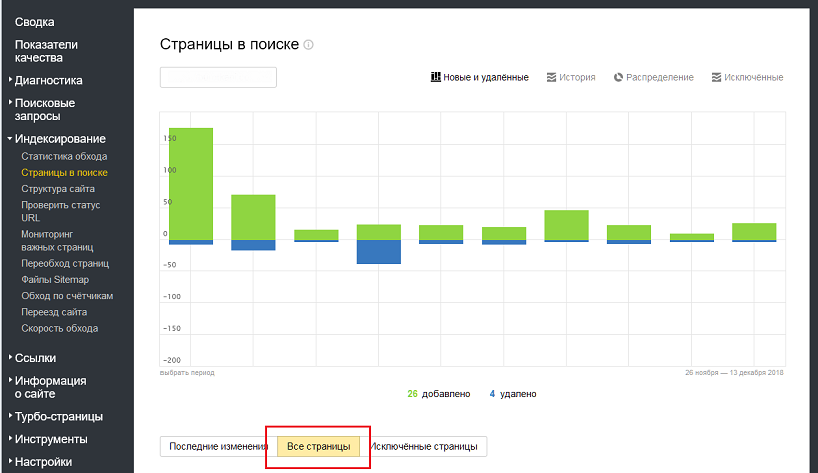

Обход страниц через Яндекс Вебмастер

Этот инструмент от Яндекс, как уже было отмечено, максимально полезен и эффективен, позволяет с минимальными тратами времени решать различные задачи, связанные с индексацией. Возможно проведение как первичных проверок, так и повторных, что актуально при изменении страниц, добавлении новой информации. Алгоритм действий таков:

Возможно проведение как первичных проверок, так и повторных, что актуально при изменении страниц, добавлении новой информации. Алгоритм действий таков:

- Добавление сайта с подтверждением права собственника.

- Открытие личного кабинета и вкладки «Индексирование».

- Указание адресов страничек для проверки.

Использование Google Search Console

Данный инструмент, по сути, аналогичен Яндекс. Он не просто помогает эффективно справиться с индексацией сайта, но используется для подготовки отчета, получение рекомендаций по разработке мобильной версии ресурса, достижения верхних позиций в списке выдачи. Алгоритм действий таков:

- Регистрация ресурса, подтверждение права владения.

- Указание URL страницы для проведения проверки.

- Запрос индексации.

Создание файла robots.txt

Адрес его размещения — site.ru/robots.txt. Помимо создания, требуется соответствующая настройка, отсутствие запрета на индексацию, а также блокировка доступа к файлам системы, авторским страничкам и прочему, что бесполезно в поиске, затягивает процесс, не позволяет роботам сосредоточиться на наиболее важном содержимом.

Создание файла sitemap.xml

Данный файл, по сути, необходим для уверенной навигации поисковых роботов по сайту. В нем обозначаются ссылки на все странички, которые должны индексироваться, причем расположены эти ссылки в приоритетном порядке, наверху расположены основные страницы, ниже – вторичные. Если речь идет о небольшом сайте, то создать файл можно вручную, это не займет слишком много времени, для крупных ресурсов лучше использовать плагины CMS и особые сервисы.

Создание карты HTML

Предыдущий файл упрощает навигацию по сайту роботам, а карта – реальным пользователям. По сути, она является отдельной страничкой, получение доступа к которой возможно из любого раздела, содержащей гиперссылки на важнейшие рубрики. Да, она не оказывает прямого влияния на индексацию, однако, улучшает внутреннюю перелинковку, что уже действительно помогает в ускорении работы роботов.

Создание понятной структуры

На сложном с точки зрения структуры сайте сложно и роботам, и пользователям. Общее для всех сайтов, независимо от объема, правило – возможность добраться до любой странички не больше, чем за три нажатия клавиши мыши. Чем больше “щелчков” требуется для попадания на определенную вкладку, тем меньше вероятность того, что робот быстро проиндексирует ее.

Общее для всех сайтов, независимо от объема, правило – возможность добраться до любой странички не больше, чем за три нажатия клавиши мыши. Чем больше “щелчков” требуется для попадания на определенную вкладку, тем меньше вероятность того, что робот быстро проиндексирует ее.

Оптимизация скорости загрузки

Бывает так, что страницы не индексируются из-за того, что грузятся слишком медленно. Наиболее распространенная причина – некорректное, нестабильное функционирование сервера. Вполне возможно, стоит задуматься о переходе на альтернативный, более надежный.

Создание внутренней перелинковки

Ссылки в пределах сайта крайне важны для корректной работы роботов независимо от системы, будь то Google или Яндекс. Нужно оптимизировать навигацию, исключить появление страниц-сирот, которые не связаны с базовой иерархической структурой. Для оптимизации используется следующее:

- Сайдбары как в основном меню, так и в шапке сайта.

- Рекомендационные блоки.

- Размещение ссылок на новые странички внутри тех, что уже были успешно проиндексированы.

Внешние сигналы

Размещение обратных ссылок на сторонних сайтах способствует увеличению общего объема ссылочной массы, что положительно сказывается на скорости индексирования. Особое внимание стоит уделять популярным сайтам с высокой посещаемостью, пользующихся вниманием у роботов Яндекс. Такими сайтами могут быть как крупные рейтинги, так и небольшие тематические площадки, форумы, блоги. Главное – аккуратное, корректное, естественное внедрение ссылки.

Использование Ловца ботов

Его задача – демонстрация ссылок на страницы, которые еще не индексировались, при каждом новом заходе робота системы, в том или ином блоке перелинковки. Скорее всего, он обратит на них внимание и проведет индексирование. Технология сложная, но рабочая. Читать подробнее про Ловец ботов.

Как запретить индексацию

Ограничение доступа к служебным адресам, страничкам, разработка которых пока не завершена – в таких случаях рекомендуется запретить индексацию. Способов несколько:

- Добавление команды Disallow в файл robots.

txt.

txt. - Прописка тега noindex в HTML-коде странички, которая не должна посещаться роботами.

- Применение авторизации. Блокировка доступа авторизацией – оптимальное решение для того, чтобы ограничить доступ в персональный кабинет и на черновые странички, разработка которых находится в процессе. Такой метод отличается максимальной надежностью.

Что значит индексировать сайт? Самый простой ответ – помочь ему как можно быстрее оказаться в списке поисковой выдачи. В конечном итоге, это положительно скажется на его популярности, посещаемости и, как следствие, коммерческом успехе!

5 наиболее распространенных проблем индексации Google в зависимости от размера веб-сайта

Google не скрывает, что индексирует не все страницы, которые может найти. Используя консоль поиска Google, вы можете увидеть страницы вашего сайта, которые не проиндексированы.

Консоль поиска Google также предоставляет полезную информацию о конкретной проблеме, из-за которой страница не может быть проиндексирована.![]()

К этим проблемам относятся ошибки сервера, ошибки 404 и намеки на то, что на странице может быть недостаточное или дублированное содержимое.

Но мы никогда не увидим данных, показывающих, какие проблемы наиболее распространены во всей сети.

Итак… Решил сам собрать данные и составить статистику!

В этой статье мы рассмотрим наиболее распространенные проблемы индексации, из-за которых ваши страницы не отображаются в поиске Google.

Индексирование 101

Индексирование похоже на создание библиотеки, за исключением того, что Google имеет дело не с книгами, а с веб-сайтами.

Если вы хотите, чтобы ваши страницы отображались в поиске, они должны быть должным образом проиндексированы. Проще говоря, Google должен найти их и сохранить.

Затем Google может проанализировать их содержание, чтобы решить, для каких запросов они могут быть актуальны.

Индексирование является необходимым условием для получения органического трафика от Google. Чем больше страниц вашего сайта индексируется, тем больше у вас шансов появиться в результатах поиска.

Чем больше страниц вашего сайта индексируется, тем больше у вас шансов появиться в результатах поиска.

Вот почему вам очень важно знать, может ли Google индексировать ваш контент.

Вот что я сделал для выявления проблем с индексированием

Мои повседневные задачи включают оптимизацию веб-сайтов с технической точки зрения SEO, чтобы сделать их более заметными в Google, и в результате у меня есть доступ к нескольким десяткам сайтов в поиске Google. Консоль.

Я решил использовать это, чтобы, надеюсь, сделать популярные проблемы с индексацией… ну, менее популярными.

Для прозрачности я разбил методологию, которая привела меня к некоторым интересным выводам.

Методология

Я начал с создания выборки страниц, объединив данные из двух источников:

- Я использовал данные наших клиентов, которые были мне легко доступны.

- Я попросил других специалистов по поисковой оптимизации поделиться со мной анонимными данными, опубликовав опрос в Твиттере и связавшись напрямую с некоторыми оптимизаторами.

оптимизаторов, мне нужно 3-10 минут вашего времени.

Можете ли вы помочь мне с исследованием индексации и поделиться со мной некоторыми неконфиденциальными статистическими данными GSC?

Когда я найду интересные идеи, я опубликую об этом статью.Заранее спасибо! Пожалуйста, R/T

🙏🙏 https://t.co/vAwMulQtsx

— Томек Рудзки (@TomekRudzki) 9 ноября 2020 г.

Оба источника информации оказались полезными.

За исключением неиндексируемых страниц

В ваших интересах не индексировать некоторые страницы. К ним относятся старые URL-адреса, статьи, которые больше не актуальны, параметры фильтрации в электронной торговле и многое другое.

Веб-мастера могут убедиться, что Google их игнорирует несколькими способами, включая файл robots.txt и тег noindex.

Принятие во внимание таких страниц отрицательно повлияет на качество моих выводов, поэтому я удалил из выборки страницы, соответствующие любому из следующих критериев:

- Заблокирован файлом robots.

txt.

txt. - Помечен как noindex.

- Перенаправлено.

- Возврат кода состояния HTTP 404.

Исключение неценных страниц

Чтобы еще больше повысить качество моего образца, я рассмотрел только те страницы, которые включены в карты сайта.

Исходя из моего опыта, карты сайта являются наиболее четким представлением ценных URL-адресов с данного веб-сайта.

Конечно, есть много веб-сайтов, которые содержат мусор в своих картах сайта. Некоторые даже включают одни и те же URL-адреса в свои карты сайта и файлы robots.txt.

Но я позаботился об этом на предыдущем шаге.

Категоризация данных

Я обнаружил, что популярные проблемы с индексацией зависят от размера веб-сайта.

Вот как я разделил данные:

- Небольшие веб-сайты (до 10 тыс. страниц).

- Средние сайты (от 10к до 100к страниц).

- Крупные сайты (до миллиона страниц).

- Огромных сайтов (более 1 миллиона страниц).

Из-за различий в размерах сайтов в моей выборке мне пришлось найти способ нормализовать данные.

Один очень большой веб-сайт, борющийся с определенной проблемой, может перевесить проблемы, которые могут возникнуть на других, более мелких веб-сайтах.

Поэтому я просмотрел каждый веб-сайт в отдельности, чтобы разобраться с проблемами индексации, с которыми они сталкиваются. Затем я присвоил баллы проблемам индексации в зависимости от количества страниц, затронутых данной проблемой на данном веб-сайте.

Вердикт…

Вот пять основных проблем, которые я нашел на веб-сайтах всех размеров.

- Просканировано — в настоящее время не проиндексировано (проблема качества).

- Дублированный контент.

- Обнаружено — в настоящее время не проиндексировано (проблема с бюджетом сканирования/качеством).

- Мягкий 404.

- Проблема со сканированием.

Давайте разберем их.

Качество

Проблемы с качеством включают в себя недостаточное содержание ваших страниц, вводящие в заблуждение или чрезмерно предвзятые.

Если на вашей странице нет уникального ценного контента, который Google хочет показать пользователям, вам будет трудно его проиндексировать (и не стоит удивляться).

Дублированный контент

Google может распознать некоторые из ваших страниц как дублированный контент, даже если вы этого не хотели.

Распространенной проблемой являются канонические теги, указывающие на разные страницы. В результате исходная страница не индексируется.

Если у вас есть дублированный контент, используйте атрибут канонического тега или перенаправление 301.

Это поможет вам убедиться, что одни и те же страницы вашего сайта не конкурируют друг с другом за просмотры, клики и ссылки.

Бюджет сканирования

Что такое бюджет сканирования? В зависимости от нескольких факторов робот Googlebot будет сканировать только определенное количество URL-адресов на каждом веб-сайте.

Это означает, что оптимизация жизненно важна; не позволяйте ему тратить свое время на страницы, которые вам не нужны.

Soft 404s

404 ошибки означают, что вы отправили на индексацию удаленную или несуществующую страницу. Мягкие 404 отображают информацию «не найдено», но не возвращают серверу код состояния HTTP 404.

Распространенной ошибкой является перенаправление удаленных страниц на другие, нерелевантные.

Множественные перенаправления также могут отображаться как программные ошибки 404. Стремитесь максимально сократить цепочки переадресации.

Проблема со сканированием

Существует много проблем со сканированием, но важной из них является проблема с robots.txt. Если робот Googlebot найдет файл robots.txt для вашего сайта, но не сможет получить к нему доступ, он вообще не будет сканировать сайт.

Наконец, давайте посмотрим на результаты для разных размеров сайтов.

Небольшие веб-сайты

Размер выборки: 44 сайта

- Просканировано, в настоящее время не проиндексировано (проблема с качеством или краулинговым бюджетом).

- Дублированный контент.

- Проблема с бюджетом сканирования.

- Мягкий 404.

- Проблема со сканированием.

Средние веб-сайты

Размер выборки: 8 сайтов

- Дублированный контент.

- Обнаружен, в настоящее время не проиндексирован (проблемы с бюджетом сканирования/качеством).

- Просканировано, в настоящее время не проиндексировано (проблема качества).

- soft 404 (проблема качества).

- Проблема со сканированием.

Крупные веб-сайты

Размер выборки: 9 сайтов

- Просканировано, в настоящее время не проиндексировано (проблема качества).

- Обнаружен, в настоящее время не проиндексирован (проблемы с бюджетом сканирования/качеством).

- Дублированный контент.

- Мягкий 404.

- Проблема со сканированием.

Крупные веб-сайты

Размер выборки: 9 сайтов

- Просканировано, в настоящее время не проиндексировано (проблема качества).

- Обнаружен, в настоящее время не проиндексирован (проблемы с бюджетом сканирования/качеством).

- Дублированный контент (дублированный, отправленный URL-адрес не выбран в качестве канонического).

- Мягкий 404.

- Проблема со сканированием.

Основные выводы по общим проблемам индексации

Интересно, что, согласно этим выводам, два размера веб-сайтов страдают от одних и тех же проблем. Это показывает, насколько сложно поддерживать качество в случае больших веб-сайтов.

- Больше 100 тыс., но меньше 1 миллиона.

- Более 1 миллиона.

Выводы, однако, таковы:

- Даже относительно небольшие веб-сайты (более 10 000) могут быть не полностью проиндексированы из-за недостаточного краулингового бюджета.

- Чем больше веб-сайт, тем острее становятся проблемы с бюджетом/качеством сканирования.

- Проблема с дублированием содержимого является серьезной, но ее характер меняется в зависимости от веб-сайта.

П.С. Примечание о неизвестных URL-адресах для Google

Во время моего исследования я понял, что есть еще одна распространенная проблема, которая препятствует индексации страниц.

Возможно, он не заслужил своего места в приведенном выше рейтинге, но по-прежнему важен, и я был удивлен, увидев, что он по-прежнему так популярен.

Я говорю о страницах-сиротах.

Некоторые страницы вашего веб-сайта могут не иметь внутренних ссылок, ведущих на них.

Если робот Googlebot не может найти страницу на вашем веб-сайте, он может вообще ее не найти.

Какое решение? Добавьте ссылки со связанных страниц.

Вы также можете исправить это вручную, добавив потерянную страницу в карту сайта. К сожалению, многие веб-мастера до сих пор пренебрегают этим.

Дополнительные ресурсы:

- 11 SEO-советов и рекомендаций по улучшению индексации

- GoogleBot не индексирует нужные страницы? Google предлагает 5 способов исправить ошибку

- Продвинутое техническое SEO: полное руководство

Категория SEO

Что такое проиндексированные страницы и как проиндексировать веб-страницу Google

Знаете ли вы, что если ваши веб-страницы не сканируются и не индексируются Google или другими поисковыми системами, ваш сайт никогда не появится в поисковых запросах пользователей? Это означает отсутствие рейтинга, трафика, потенциальных клиентов или конверсий.

Если вы не имеете ни малейшего представления об индексируемых страницах или бесконечно ищете быстрые способы индексации вашей веб-страницы Google или другими поисковыми системами, эта статья ответит на все ваши вопросы и расскажет, как услуги SEO для малого бизнеса могут вам помочь.

Но, прежде чем углубиться в понимание того, как Google проиндексирует сайт, давайте сначала разберемся, что такое сканирование и индексирование Google.

Что такое индексирование и сканирование веб-страниц Google?

Когда вы (веб-мастер) отправляете уникальные URL-адреса веб-сайта через ссылки вместе с картой сайта в формате XML в Инструменты Google для веб-мастеров, Google находит эти ссылки и карту сайта и сканирует их, чтобы оценить ценность контента по каждой данной ссылке и определить, связано это с поисковыми запросами пользователей или нет. Кроме того, поисковая система добавляет эти веб-ссылки в свой индекс с помощью веб-паука под названием «Googlebot». Добавление веб-ссылок в индекс Google — это процесс индексации Google.

Выделим несколько терминов:

- Сканирование Google — процесс перехода по гиперссылкам на веб-страницах для идентификации и извлечения контента, связанного с поиском пользователя.

- Google Indexing — процесс хранения веб-страниц в базе данных Google.

- Web Spider — программа под названием «Googlebot», предназначенная для автоматического обнаружения и сканирования веб-сайтов путем перехода по ссылкам с одной веб-страницы на другую.

После отправки веб-страниц в инструменты Google для веб-мастеров нет гарантии, что все веб-страницы будут проиндексированы. Вы можете увидеть комбинацию неиндексированных и проиндексированных страниц.

Давайте выясним, что означают проиндексированные страницы и неиндексированные страницы в Google.

Что такое проиндексированные страницы в Google?

Бесконечный поиск «Что такое проиндексированные страницы?». Проиндексированные страницы — это страницы, которые были успешно идентифицированы поисковыми роботами и имеют качественный или релевантный контент по поисковым фразам пользователей.

Проиндексированные страницы хорошо ранжируются в результатах поиска и помогают привлечь органический трафик на веб-сайты.

Что такое неиндексированные страницы?

Нет необходимости, чтобы Google сканировал и индексировал каждый ваш веб-адрес. Если вы недавно добавили много новых веб-страниц, эти недавно добавленные веб-страницы могут не индексироваться вместе с первоначальными веб-страницами. Если вы только что добавили новые веб-страницы или улучшили свою карту сайта в SEO, дайте поисковой системе некоторое время, чтобы обработать ваши веб-страницы для индексации.

Но если прошло достаточно много времени, а ваши веб-страницы по-прежнему отмечены как «не проиндексированные», могут быть другие причины, такие как плохая структура вашей карты сайта или качество иерархии веб-страницы.

Страницы, которые Google не может просканировать или проиндексировать, включают

- Категория блога и авторские страницы

- Страницы перенаправляются на 404, страница не найдена или ошибки сервера.

- Плохая структура страниц

- Дублированный/идентичный контент на веб-страницах

- Страницы с определенными кодами и каноническими тегами указывают поисковым системам, что их нельзя индексировать

- Веб-страницы не имеют достаточных полномочий для обоснования всех веб-страниц

Давайте узнаем, индексируются ли ваши веб-страницы Google или нет, или как проверить страницы, проиндексированные Google.

Как найти проиндексированные страницы в Google Checker?

1. Для проверки проиндексированных веб-страниц через результаты поисковой системы

- Посетите Google или другие поисковые системы, в строке поиска введите название своего веб-сайта. Возьмем, к примеру, «JanBask Digital Design».

- При поиске URL-адреса вашего веб-сайта в строке поиска вы увидите числовое значение рядом с «результатами».

Эти цифры показывают количество веб-страниц, проиндексированных Google.

Эти цифры показывают количество веб-страниц, проиндексированных Google.

Если вы хотите увидеть статус индекса URL вашей конкретной веб-страницы, вы можете сделать это следующим образом:

- Введите URL-адрес веб-сайта/имя страницы. Возьмем «janbaskdigitaldesign.com/portfolio».

- Здесь вы снова увидите некоторые числовые значения рядом с «результатами». Обратите внимание, что результаты не будут отображаться, если ваша веб-страница еще не проиндексирована.

2. Проверка проиндексированных веб-страниц с помощью отчета Google Search Console

Если вам нужна подробная информация о статусе индексации ваших веб-страниц, вы можете воспользоваться помощью Google Search Console — Отчет о статусе покрытия индекса.

- Откройте консоль поиска Google, нажмите «индекс», а затем «покрытие».

- Там вы увидите раздел действительной страницы (как с предупреждением, так и без).

- Если сумма этих действительных страниц равна любому числу, отличному от нуля, похоже, что определенные ваши веб-страницы успешно проиндексированы в Google.

Если вам сложно успешно индексировать страницы и вы застряли в статусе «не проиндексированные», мы собрали простые шаги, чтобы эффективно отправить веб-страницы в инструменты Google для веб-мастеров и позволить вашим веб-страницам быть проиндексированными программой проверки Google. быстро.

Простые шаги о том, как быстро проиндексировать ваш веб-сайт в Google

Устали искать точные способы, как заставить Google проиндексировать ваш веб-сайт или шаги для проиндексированных страниц, которые поддерживает Google?

Ниже приведены краткие инструкции по быстрому сканированию и индексированию веб-страниц в поисковых системах, таких как Google.

1. Убедитесь, что ваша веб-страница включена в карту сайта

Карта сайта в формате XML является важным аспектом, сообщающим поисковым системам, какие страницы на вашем веб-сайте важны.

Нет необходимости получать индексацию Google, если вы добавили страницы в карту сайта, но отсутствие добавления каких-либо важных страниц в карту сайта определенно означает, что Google не проиндексирует ни одной страницы.

После создания карты сайта отправьте ее в поисковую консоль Google. Вы можете просмотреть статус карты сайта с помощью отчета Sitemaps в консоли поиска Google.

Проверьте отчет, чтобы увидеть, добавлены ли страницы, которые вы хотите видеть проиндексированными, и не добавлены ли страницы, которые вы не обязательно хотите индексировать.

2. Создание качественных обратных ссылок

Это неправда, что Google сканирует и индексирует веб-страницы только с обратными ссылками. Он также сканирует и ранжирует страницы без каких-либо обратных ссылок. Но если у вас есть высококачественные обратные ссылки, Google увидит, что ваши веб-страницы важны, и будет быстрее сканировать и повторно сканировать ваши страницы быстрее, чем те, у кого нет ни одной обратной ссылки.

Чем больше ссылок вы получите с заслуживающих доверия сайтов, тем выше будет ваша ценность в глазах поисковой системы.

Когда вы получите ссылку с других сторонних сайтов, поисковые роботы на этих сторонних сайтах перейдут по ссылке на вашу веб-страницу и быстрее проиндексируют вашу веб-страницу.

Если у вас есть опыт создания органических ссылок, вы будете знать, насколько полезным может быть получение ссылок из надежных источников. Если вы не специализируетесь на линкбилдинге, вы можете заранее разработать мощную стратегию продвижения. Можно так:

- Поиск платформ, продвигающих синдикацию контента. Повторно публикуйте только что опубликованный контент на таких сайтах, как Medium, чтобы получить эффективные обратные ссылки. Такие веб-сайты, как Medium, автоматически используют тег rel=canonical, с которым вам не придется беспокоиться о проблемах с дублированием контента. Medium предлагает свой инструмент импорта, с помощью которого вы можете импортировать уже опубликованный контент из любого места.

Инструмент извлечет ваш контент с тем же форматированием текста, заголовками, ссылками и списками. Однако изображения не будут импортированы автоматически, вам придется немного повозиться, чтобы добавить эти изображения вручную. Если вы раньше не публиковали изображения в этом контенте или считаете, что в нем плохие изображения, у вас будет возможность добавить новые привлекательные изображения.

Инструмент извлечет ваш контент с тем же форматированием текста, заголовками, ссылками и списками. Однако изображения не будут импортированы автоматически, вам придется немного повозиться, чтобы добавить эти изображения вручную. Если вы раньше не публиковали изображения в этом контенте или считаете, что в нем плохие изображения, у вас будет возможность добавить новые привлекательные изображения.

- Вы можете получить отличные обратные ссылки, поделившись инфографикой со своей ссылкой на каталоги инфографики. Задача создания и размещения инфографики в этих каталогах может показаться несложной, но в конечном итоге вы добьетесь максимальной ценности в глазах поисковых систем.

- Создавайте свой контент на импульсе LinkedIn. Пульс Linkedin отличается от обычных статей, которые вы пишете и публикуете в Linkedin. С помощью LinkedIn Pulse вы можете поделиться некоторыми выдержками из вашей полной версии контента и завершить его ссылкой с призывом к действию (перенаправление на ваш подробный контент) со словами, такими как «продолжить читать дальше» или «прочитать полную версию статьи здесь».

Благодаря этому вы можете быстро заработать читателей или новых клиентов.

Благодаря этому вы можете быстро заработать читателей или новых клиентов.

3. Будьте активны в социальных сетях

Многие из вас задаются вопросом, какое отношение социальные сети имеют к сканированию и индексации, поскольку они не имеют прямой связи с методами SEO.

Социальные сети — отличный инструмент для информирования аудитории о каждом новом публикуемом контенте. Когда вы обновляете ссылки на свои последние страницы на сайт социальной сети в сочетании с броским заголовком или слоганом, поисковые роботы идентифицируют и получают доступ к ним, чтобы ускорить процесс индексации.

Создание плана действий в социальных сетях эффективно для быстрого индексирования веб-страниц Google Checker. Если вы еще не думали об инвестировании в план действий в социальных сетях, вот как вы можете это сделать:

- Создавайте учетные записи в социальных сетях на таких популярных платформах, как Facebook и Twitter. Если вы B2B, вы должны размещаться на LinkedIn, а если вы представляете бизнес, ориентированный на возрастную группу от 18 до 24 лет, вы можете подтвердить свою личность в Instagram.

- Разработайте мощную стратегию обслуживания клиентов в социальных сетях, определив, как вы обычно публикуете сообщения, каким контентом вы будете делиться, сохраните ли вы один и тот же или другой контент для каждой платформы социальных сетей или нет, и многое другое.

- Свяжитесь с влиятельными лицами, которые могли бы распространять положительные слова о вашем бренде.

- Инвестируйте в платную рекламу, чтобы увеличить охват аудитории.

Когда вы сосредоточитесь на том, чтобы больше делиться своими страницами через каналы социальных сетей, Google будет рассматривать ваши веб-страницы как авторитетные и будет быстро принимать меры для их более быстрого извлечения и индексации. Даже ваши недавно добавленные страницы будут проиндексированы в более короткие сроки.

4. Вести блог

«Веб-сайты с разделом блога имеют в среднем на 434% больше проиндексированных страниц».

Алгоритм Google направлен на то, чтобы предоставить людям недавно обновленный и актуальный контент для пользователей поиска.

Таким образом, веб-сайты, которые сосредоточены на добавлении нового контента на свои веб-сайты через регулярные промежутки времени, как правило, получают преимущества быстрой индексации.

Для любого веб-сайта блоги являются единственной областью, которая может создавать разнообразный свежий и обновленный контент, который хотят видеть пользователи. Если вы не ведете активно блог, пришло время это сделать. Чем больше качественного и обновленного контента вы публикуете в разделе блога, тем больше будет скорость пауков, чтобы сканировать ваши веб-страницы и индексировать их в Google.

Если вы только начинаете, вы можете начать с курирования и загрузки контента блога, который уже публикуют конкуренты, таким образом вы одержите победу над последовательностью и будете иметь твердую хватку, чтобы продолжать дальше. Вот 6 эффективных советов о том, как написать сообщение в блоге, чтобы стать мастером ведения блога.

Вот 6 эффективных советов о том, как написать сообщение в блоге, чтобы стать мастером ведения блога.

Позже вы можете проанализировать и найти конкурентов и их наиболее эффективные темы в блогах, чтобы определить, о какой теме вам нужно написать.

5. Блокировать некачественные страницы из индекса Google

Если у вас так много некачественных веб-страниц, упомянутых в карте сайта, скорее всего, вы столкнетесь с задержкой при сканировании этих эффективных и качественных страниц.

Наличие слишком большого количества низкокачественных страниц на вашем веб-сайте в конечном итоге сократит количество сканируемых и индексируемых веб-страниц.

Если вы считаете, что размещаете слишком много страниц с нерелевантным и плохим содержанием, вы должны либо удалить их, либо заблокировать в Google для их индексации.

Страницы, которые не представляют ценности для вашей аудитории, должны быть:

- Блокируется через файл Robots.

txt, когда они предоставляют нулевое значение для поисковых систем

txt, когда они предоставляют нулевое значение для поисковых систем - 301 перенаправляется туда, где блоги не представляют большей ценности для аудитории и поисковых систем. Вы можете сделать это со старыми сообщениями в блогах, которые уже имеют трафик и ссылки.

- Удалено 404, если страницы не представляют никакой ценности для поисковых систем и аудитории, а также не имеют существующих ссылок или трафика.

- Блокируется через файл Robots.

- Отмечено NOINDEX, когда страницы представляют ценность для аудитории, но не для поисковых систем, таких как целевые страницы или страницы благодарности.

- Создание мощных внутренних ссылок

Google идентифицирует новый контент при сканировании вашего веб-сайта, но если вам не удастся установить внутренние ссылки на новые страницы, поисковые системы могут столкнуться с трудностями при сканировании этих новых страниц.

Самый простой способ просканировать и проиндексировать эти новые добавленные страницы — это внутренне связать их с предыдущими страницами, которые Google легко идентифицирует для индексации.

Свяжите свои недавно добавленные страницы со страницами, которые преуспевают с точки зрения производительности поисковых систем, а также охвата аудитории. Таким образом, Google будет легко извлекать и индексировать эти недавно добавленные веб-страницы.

Чтобы иметь успешную внутреннюю перелинковку, убедитесь, что структура вашего веб-сайта не упущена из виду. Убедитесь:

- Ваш веб-сайт имеет логическую веб-структуру и возможности навигации, которые облегчают просмотр. Придерживайтесь простой структуры, которую легко оценить аудитории.

- У вас есть хорошо спланированная архитектура веб-сайта, поскольку помимо людей сканерам также потребуется структура веб-сайта, которую легко просмотреть. Поскольку внутренние ссылки будут направлять сканеры на другие части веб-сайтов, убедитесь, что поток и взаимосвязь между каждой страницей являются систематическими и понятными.

- Создавайте узловые страницы, чтобы помочь пользователям и поисковым системам эффективно понять макет вашего сайта.

Эти узловые страницы будут служить указателем для ваших похожих сгруппированных страниц и помогут поисковым роботам легко их читать. Вы можете создавать узловые страницы, группируя сообщения блога на похожие темы под одной крышей, похожие продукты в одном разделе (если вы занимаетесь продажей продуктов), группируя связанные новости или события (если вы занимаетесь редакцией новостей или управлением событиями). .

Эти узловые страницы будут служить указателем для ваших похожих сгруппированных страниц и помогут поисковым роботам легко их читать. Вы можете создавать узловые страницы, группируя сообщения блога на похожие темы под одной крышей, похожие продукты в одном разделе (если вы занимаетесь продажей продуктов), группируя связанные новости или события (если вы занимаетесь редакцией новостей или управлением событиями). . - Свяжите недавно добавленные страницы с качественными страницами вашего веб-сайта, чтобы упростить пользователям и поисковым роботам задачи по обработке вашего веб-сайта.

- Сделать оглавление в начале содержимого. Практике можно следовать при написании блогов или новостей. Вы можете разместить понятное оглавление вверху, чтобы обратиться к пользователям со всеми разделами, которые может предложить следующий контент. Благодаря этому они перейдут к разделу, о котором хотели узнать больше всего, не отвлекаясь на стены текста в вашем длинном посте в блоге.

Это в фоновом режиме улучшит общую структуру вашего веб-сайта, а также процесс внутренней перелинковки. И сканеры будут благодарны вам за то, что вы так хорошо структурировали свой сайт и облегчили их бремя.

Это в фоновом режиме улучшит общую структуру вашего веб-сайта, а также процесс внутренней перелинковки. И сканеры будут благодарны вам за то, что вы так хорошо структурировали свой сайт и облегчили их бремя.

Заключение

В приведенном выше сообщении в блоге объясняется, что такое проиндексированные страницы и как заставить Google проиндексировать ваш веб-сайт в кратчайшие сроки.

Вместо того, чтобы зацикливаться на том, какие и почему ваши определенные страницы не перешли из категории «неиндексированные», лучше сосредоточьтесь на курировании и создании контента, который будет полезен пользователям и поисковым роботам. Сосредоточьтесь на создании и добавлении веб-страниц в карту сайта, которые принесут большую пользу поисковым роботам. Краткий обзор того, как проиндексировать Google:

- Отправьте обновленные и четко определенные карты сайта в инструменты для веб-мастеров

- Сосредоточьтесь на создании и распространении только подлинного и авторитетного контента на сторонних сайтах и в социальных сетях

- Оптимизируйте свои веб-страницы, чтобы их было легко обрабатывать поисковыми системами, такими как Google

- Повысьте доверие к своей веб-странице и ее доступность в поисковых системах, получив обратные ссылки с авторитетных веб-сайтов.

Если вам нужен кто-то, кто позаботится о производительности вашего веб-сайта с помощью эффективных методов SEO + маркетинга в социальных сетях, чтобы понять, какие шаги для проиндексированных страниц Google распознает для факторов ранжирования поисковой системы, мы будем рады управлять вашей лодкой, пока ваше присутствие в Интернете не перестанет t расти и помочь вам привлечь потенциальных клиентов.

Вы все еще просматриваете приведенный выше контрольный список для решения проблем с индексацией? Не волнуйтесь, наши эксперты по SEO-услугам для малого бизнеса всегда готовы помочь вам занять более высокие позиции в рейтинге за короткое время.

Ищете профессиональные услуги SEO?

- Охват потенциальной аудитории

- Повышение вовлеченности клиентов

- Создание онлайн-лидов и продаж

Позвольте нам дать вам идеи!

Часто задаваемые вопросы

1. Что означает индекс Google?

Веб-страница проиндексирована Google означает, что поисковый робот Google посетил эту веб-страницу, проанализировал ее содержимое, включая значение, и сохранил его в индексе Google.

Вебмастер и Google Search Console и добавить ссылку на карту сайта в соответствующих разделах этих систем.

Вебмастер и Google Search Console и добавить ссылку на карту сайта в соответствующих разделах этих систем. txt

txt д. Для каждого сайта рассчитывается свой краулинговый бюджет. Расчёт ведется исходя из скоростных характеристик ресурса, а так же из уровня заспамленности, соотношения полезны/мусорных страниц, наличия малополезных автоматически нагенерированных страниц и циклических ссылок и других немаловажных факторов.

д. Для каждого сайта рассчитывается свой краулинговый бюджет. Расчёт ведется исходя из скоростных характеристик ресурса, а так же из уровня заспамленности, соотношения полезны/мусорных страниц, наличия малополезных автоматически нагенерированных страниц и циклических ссылок и других немаловажных факторов.

И такое бывает — страница доступна для пользователей, а для поисковых роботов нет.

И такое бывает — страница доступна для пользователей, а для поисковых роботов нет. Это действие приведет к тому, что странички окажутся в индексе в максимально короткие сроки, за 7-10 дней.

Это действие приведет к тому, что странички окажутся в индексе в максимально короткие сроки, за 7-10 дней.

txt.

txt.

txt.

txt.

Эти цифры показывают количество веб-страниц, проиндексированных Google.

Эти цифры показывают количество веб-страниц, проиндексированных Google.

Инструмент извлечет ваш контент с тем же форматированием текста, заголовками, ссылками и списками. Однако изображения не будут импортированы автоматически, вам придется немного повозиться, чтобы добавить эти изображения вручную. Если вы раньше не публиковали изображения в этом контенте или считаете, что в нем плохие изображения, у вас будет возможность добавить новые привлекательные изображения.

Инструмент извлечет ваш контент с тем же форматированием текста, заголовками, ссылками и списками. Однако изображения не будут импортированы автоматически, вам придется немного повозиться, чтобы добавить эти изображения вручную. Если вы раньше не публиковали изображения в этом контенте или считаете, что в нем плохие изображения, у вас будет возможность добавить новые привлекательные изображения. Благодаря этому вы можете быстро заработать читателей или новых клиентов.

Благодаря этому вы можете быстро заработать читателей или новых клиентов.

txt, когда они предоставляют нулевое значение для поисковых систем

txt, когда они предоставляют нулевое значение для поисковых систем Эти узловые страницы будут служить указателем для ваших похожих сгруппированных страниц и помогут поисковым роботам легко их читать. Вы можете создавать узловые страницы, группируя сообщения блога на похожие темы под одной крышей, похожие продукты в одном разделе (если вы занимаетесь продажей продуктов), группируя связанные новости или события (если вы занимаетесь редакцией новостей или управлением событиями). .

Эти узловые страницы будут служить указателем для ваших похожих сгруппированных страниц и помогут поисковым роботам легко их читать. Вы можете создавать узловые страницы, группируя сообщения блога на похожие темы под одной крышей, похожие продукты в одном разделе (если вы занимаетесь продажей продуктов), группируя связанные новости или события (если вы занимаетесь редакцией новостей или управлением событиями). . Это в фоновом режиме улучшит общую структуру вашего веб-сайта, а также процесс внутренней перелинковки. И сканеры будут благодарны вам за то, что вы так хорошо структурировали свой сайт и облегчили их бремя.

Это в фоновом режиме улучшит общую структуру вашего веб-сайта, а также процесс внутренней перелинковки. И сканеры будут благодарны вам за то, что вы так хорошо структурировали свой сайт и облегчили их бремя.