Индексация сайта и ее основные принципы

12 мин — время чтения

Фев 18, 2020

Поделиться

Когда-нибудь задумывались, как сайты попадают в выдачу поисковых систем? И как поисковикам удается выдавать нам тонны информации за считанные секунды?

Секрет такой молниеносной работы — в поисковом индексе. Его можно сравнить с огромным и идеально упорядоченным каталогом-архивом всех веб-страниц. Попадание в индекс означает, что поисковик вашу страницу увидел, оценил и запомнил. А, значит, он может показывать ее в результатах поиска.

Предлагаю разобраться в процессе индексации с нуля, чтобы понимать, как сайты попадают в выдачу, можно ли управлять этим процессом и что нужно знать про индексирование ресурсов с различными технологиями.

Что такое сканирование и индексация?

Сканирование страниц сайта — это процесс, когда поисковая система отправляет свои специальные программы (мы знаем их как поисковых роботов, краулеров, спайдеров, пауков) для сбора данных с новых и измененных страниц сайтов.

Индексация страниц сайта — это сканирование, считывание данных и добавление их в индекс (каталог) поисковыми роботами. Поисковик использует полученную информацию, чтобы узнать, о чем же ваш сайт и что находится на его страницах. После этого он может определить ключевые слова для каждой просканированной страницы и сохранить их копии в поисковом индексе. Для каждой страницы он хранит URL и информацию о контенте.

В результате, когда пользователи вводят поисковый запрос в интернете, поисковик быстро просматривает свой список просканированных сайтов и показывает только релевантные страницы в выдаче. Как библиотекарь, который ищет нужные вам книги в каталоге — по алфавиту, тематике и точному названию.

Индексация сайтов в разных поисковых системах отличается парой важных нюансов. Давайте разбираться, в чем же разница.

Индексация сайта в GoogleКогда мы гуглим что-то, поиск данных ведется не по сайтам в режиме реального времени, а по индексу Google, в котором хранятся сотни миллиардов страниц. Во время поиска учитываются разные факторы ― ваше местоположение, язык, тип устройства и т. д.

Во время поиска учитываются разные факторы ― ваше местоположение, язык, тип устройства и т. д.

В 2019 году Google изменил свой основной принцип индексирования сайта — вы наверняка слышали о запуске Mobile-first. Основное отличие нового способа в том, что теперь поисковик хранит в индексе мобильную версию страниц. Раньше в первую очередь учитывалась десктопная версия, а теперь первым на ваш сайт приходит робот Googlebot для смартфонов — особенно, если сайт новый. Все остальные сайты постепенно переходят на новый способ индексирования, о чем владельцы узнают в Google Search Console.

Еще несколько основных отличий индексации в Google:

- индекс обновляется постоянно;

- процесс индексирования сайта занимает от нескольких минут до недели;

- некачественные страницы обычно понижаются в рейтинге, но не удаляются из индекса.

В индекс попадают все просканированные страницы, а вот в выдачу по запросу — только самые качественные. Прежде чем показать пользователю какую-то веб-страницу по запросу, поисковик проверяет ее релевантность по более чем 200 критериям (факторам ранжирования) и отбирает самые подходящие.

Что поисковые роботы делают на вашем сайте, мы разобрались, а вот как они попадают туда? Существует несколько вариантов.

Как поисковые роботы узнают о вашем сайте

Если это новый ресурс, который до этого не индексировался, нужно «представить» его поисковикам. Получив приглашение от вашего ресурса, поисковые системы отправят на сайт своих краулеров для сбора данных.

Вы можете пригласить поисковых ботов на сайт, если разместите на него ссылку на стороннем интернет-ресурсе. Но учтите: чтобы поисковики обнаружили ваш сайт, они должны просканировать страницу, на которой размещена эта ссылка. Этот способ работает для обоих поисковиков.

Также можно воспользоваться одним из перечисленных ниже вариантов:

- Создайте файл Sitemap, добавьте на него ссылку в robots.txt и отправьте файл Sitemap в Google.

- Отправьте запрос на индексацию страницы с изменениями в Search Console.

Каждый сеошник мечтает, чтобы его сайт быстрее проиндексировали, охватив как можно больше страниц. Но повлиять на это не в силах никто, даже лучший друг, который работает в Google.

Но повлиять на это не в силах никто, даже лучший друг, который работает в Google.

Скорость сканирования и индексации зависит от многих факторов, включая количество страниц на сайте, скорость работы самого сайта, настройки в веб-мастере и краулинговый бюджет. Если кратко, краулинговый бюджет — это количество URL вашего сайта, которые поисковый робот хочет и может просканировать.

На что же мы все-таки можем повлиять в процессе индексации? На план обхода поисковыми роботами нашего сайта.

Как управлять поисковым роботом

Поисковая система скачивает информацию с сайта, учитывая robots.txt и sitemap. И именно там вы можете порекомендовать поисковику, что и как скачивать или не скачивать на вашем сайте.

Файл robots.txtЭто обычный текстовый файл, в котором указаны основные сведения — например, к каким поисковым роботам мы обращаемся (User-agent) и что запрещаем сканировать (Disallow).

Указания в robots.txt помогают поисковым роботам сориентироваться и не тратить свои ресурсы на сканирование маловажных страниц (например, системных файлов, страниц авторизации, содержимого корзины и т. д.). Например, строка Disallow:/admin запретит поисковым роботам просматривать страницы, URL которых начинается со слова admin, а Disallow:/*.pdf$ закроет им доступ к PDF-файлам на сайте.

д.). Например, строка Disallow:/admin запретит поисковым роботам просматривать страницы, URL которых начинается со слова admin, а Disallow:/*.pdf$ закроет им доступ к PDF-файлам на сайте.

Также в robots.txt стоит обязательно указать адрес карты сайта, чтобы указать поисковым роботам ее местоположение.

Чтобы проверить корректность robots.txt, воспользуйтесь отдельным инструментом в Google Search Console.

Файл SitemapЕще один файл, который поможет вам оптимизировать процесс сканирования сайта поисковыми роботами ― это карта сайта (Sitemap). В ней указывают, как организован контент на сайте, какие страницы подлежат индексации и как часто информация на них обновляется.

Если на вашем сайте несколько страниц, поисковик наверняка обнаружит их сам. Но когда у сайта миллионы страниц, ему приходится выбирать, какие из них сканировать и как часто. И тогда карта сайта помогает в их приоритезации среди прочих других факторов.

Также сайты, для которых очень важен мультимедийный или новостной контент, могут улучшить процесс индексации благодаря созданию отдельных карт сайта для каждого типа контента. Отдельные карты для видео также могут сообщить поисковикам о продолжительности видеоряда, типе файла и условиях лицензирования. Карты для изображений ― что изображено, какой тип файла и т. д. Для новостей ― дату публикации. название статьи и издания.

Чтобы ни одна важная страница вашего сайта не осталась без внимания поискового робота, в игру вступают навигация в меню, «хлебные крошки», внутренняя перелинковка. Но если у вас есть страница, на которую не ведут ни внешние, ни внутренние ссылки, то обнаружить ее поможет именно карта сайта.

А еще в Sitemap можно указать:

- частоту обновления конкретной страницы — тегом <changefreq>;

- каноническую версию страницы ― атрибутом rel=canonical;

- версии страниц на других языках ― атрибутом hreflang.

Карта сайта также здорово помогает разобраться, почему возникают сложности при индексации вашего сайта. Например, если сайт очень большой, то там создается много карт сайта с разбивкой по категориям или типам страниц. И тогда в консоли легче понять, какие именно страницы не индексируются и дальше разбираться уже с ними.

Проверить правильность файла Sitemap можно в Google Search Console вашего сайта в разделе «Файлы Sitemap».

Итак, ваш сайт отправлен на индексацию, robots.txt и sitemap проверены, пора узнать, как прошло индексирование сайта и что поисковая система нашла на ресурсе.

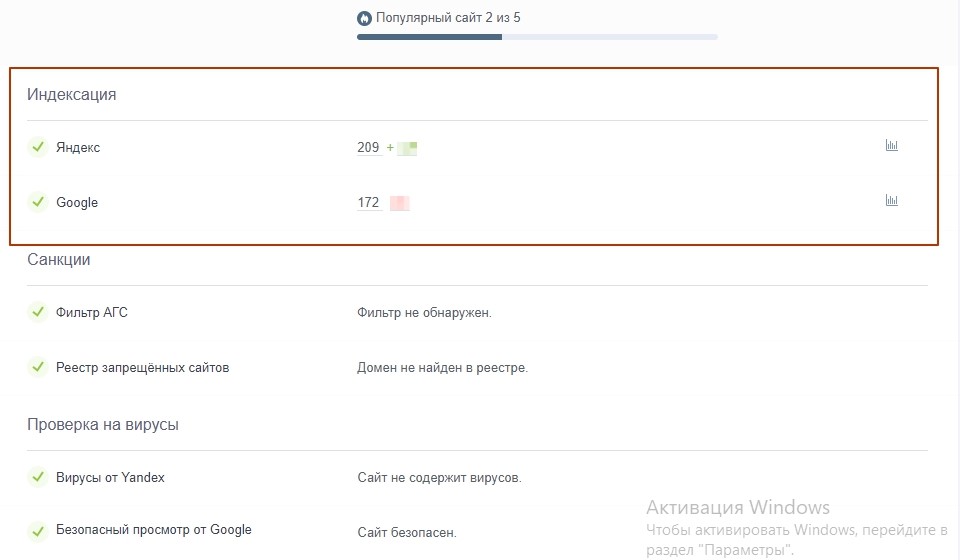

Как проверить индексацию сайта

Проверка индексации сайта осуществляется несколькими способами:

1. Через оператор site: в Google. Этот оператор не дает исчерпывающий список страниц, но даст общее понимание о том, какие страницы в индексе. Выдает результаты по основному домену и поддоменам.

2. Через Google Search Console. В консоли вашего сайта есть детальная информация по всем страницам ― какие из них проиндексированы, какие нет и почему.

3. Воспользоваться плагинами для браузера типа RDS Bar или специальными инструментами для проверки индексации. Например, узнать, какие страницы вашего сайта попали в индекс поисковика можно в инструменте «Проверка индексации» SE Ranking.

Для этого достаточно ввести нужную вам поисковую систему (Google, Yahoo, Bing), добавить список урлов сайта и начать проверку. Чтобы протестировать работу инструмента «Проверка индексации», зарегистрируйтесь на платформе SE Ranking и откройте тул в разделе «Инструменты».

В этом месте вы можете поднять руку и спросить «А что, если у меня сайт на AJAX? Он попадет в индекс?». Отвечаем 🙂

Особенности индексирования сайтов с разными технологиями

AjaxСегодня все чаще встречаются JS-сайты с динамическим контентом ― они быстро загружаются и удобны для пользователей. Одно из основных отличий таких сайтов на AJAX — все содержимое подгружается одним сплошным скриптом, без разделения на страницы с URL.![]() Вместо этого ― страницы с хештегом #, которые не индексируются поисковиками. Как следствие — вместо URL типа https://mywebsite.ru/#example поисковый робот обращается к https://mywebsite.ru/. И так для каждого найденного URL с #.

Вместо этого ― страницы с хештегом #, которые не индексируются поисковиками. Как следствие — вместо URL типа https://mywebsite.ru/#example поисковый робот обращается к https://mywebsite.ru/. И так для каждого найденного URL с #.

В этом и кроется сложность для поисковых роботов, потому что они просто не могут «считать» весь контент сайта. Для поисковиков хороший сайт ― это текст, который они могут просканировать, а не интерактивное веб-приложение, которое игнорирует природу привычных нам веб-страниц с URL.

Буквально пять лет назад сеошники могли только мечтать о том, чтобы продвинуть такой сайт в поиске. Но все меняется. Уже сейчас в справочной информации Google есть данные о том, что нужно для индексации AJAX-сайтов и как избежать ошибок в этом процессе.

Сайты на AJAX с 2019 года рендерятся Google напрямую — это значит, что поисковые роботы сканируют и обрабатывают #! URL как есть, имитируя поведение человека. Поэтому вебмастерам больше не нужно прописывать HTML-версию страницы.

Но здесь важно проверить, не закрыты ли скрипты со стилями в вашем robots.txt. Если они закрыты, обязательно откройте их для индексирования поисковыми роботам. Для этого в robots.txt нужно добавить такие команды:

User-agent: Googlebot Allow: /*.js Allow: /*.css Allow: /*.jpg Allow: /*.gif Allow: /*.pngФлеш-контент

С помощью технологии Flash, которая принадлежит компании Adobe, на страницах сайта можно создавать интерактивный контент с анимацией и звуком. За 20 лет своего развития у технологии было выявлено массу недостатков, включая большую нагрузку на процессор, ошибки в работе флеш-плеера и ошибки в индексировании контента поисковиками.

В 2019 году Google перестал индексировать флеш-контент, ознаменовав тем самым конец целой эпохи.

Поэтому не удивительно, что поисковик предлагает не использовать Flash на ваших сайтах. Если же дизайн сайта выполнен с применением этой технологии, сделайте и текстовую версию сайта. Она будет полезна как пользователям, у которых не установлена совсем или установлена устаревшая программа отображения Flash и пользователям мобильных устройств (они не отображают flash-контент).

Она будет полезна как пользователям, у которых не установлена совсем или установлена устаревшая программа отображения Flash и пользователям мобильных устройств (они не отображают flash-контент).

Фрейм это HTML-документ, который не содержит собственного контента, а состоит из разных областей ― каждая с отдельной веб-страницей. Также у него отсутствует элемент BODY.

Как результат, поисковым роботам просто негде искать полезный контент для сканирования. Страницы с фреймами индексируются очень медленно и с ошибками.

Вот что известно от самого поисковика: Google может индексировать контент внутри встроенного фрейма iframe. Именно iframe поддерживается современными технологиями, так как он позволяет встраивать фреймы на страницы без применения тега <iframe>.

А вот теги <frame>, <noframes>, <frameset> устарели и уже не поддерживаются в HTML5, поэтому и не рекомендуется использовать их на сайтах. Ведь даже если страницы с фреймами будут проиндексированы, то трудностей в их продвижении вам все равно не избежать.

Ведь даже если страницы с фреймами будут проиндексированы, то трудностей в их продвижении вам все равно не избежать.

Что в итоге

Поисковые системы готовы проиндексировать столько страниц вашего сайта, сколько нужно. Только подумайте, объем индекса Google значительно превышает 100 млн гигабайт ― это сотни миллиардов проиндексированных страниц, количество которых растет с каждым днем.

Но зачастую именно от вас зависит успех этого мероприятия. Понимая принципы индексации поисковых систем, вы не навредите своему сайту неправильными настройками. Если вы все правильно указали в robots.txt и карте сайта, учли технические требования поисковиков и позаботились о наличии качественного и полезного контента, поисковики не оставят ваш сайт без внимания.

Помните, что индексирование ― это не о том, попадет ваш сайт в выдачу или нет. Намного важнее ― сколько и каких страниц окажутся в индексе, какой контент на них будет просканирован и как он будет ранжироваться в поиске. И здесь ход за вами!

1352 views

Что такое индексация сайта и как ее скорость сказывается на раскрутке сайта

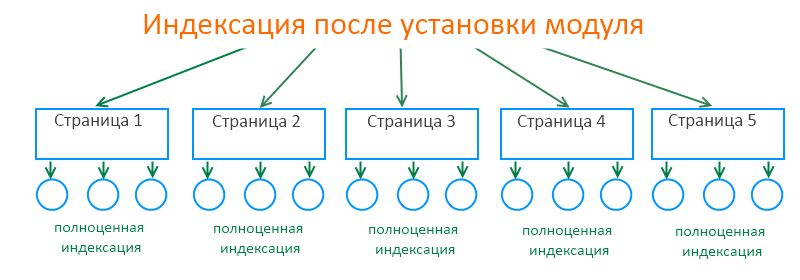

Индексация продвигаемых страниц – необходимое условие раскрутки сайта. Естественным путем процесс происходит в течение периода от одной недели до нескольких месяцев. Специалисты по поисковому продвижению сайта имеют возможность привлечь робота на ресурс и, таким образом, ускорить индексацию страниц с помощью следующих приемов.

Естественным путем процесс происходит в течение периода от одной недели до нескольких месяцев. Специалисты по поисковому продвижению сайта имеют возможность привлечь робота на ресурс и, таким образом, ускорить индексацию страниц с помощью следующих приемов.

- Ручное добавление ресурса. О созданном ресурсе робот может «узнать» благодаря ручному добавлению URL сайта через специальную форму поисковика. Таким образом, веб-мастер сообщает системе о новом ресурсе, адрес которого попадает в очередь на индексацию. В данном случае добавляется только главная страница, на остальные поисковые роботы перейдут по внутренним ссылкам.

- Простановка внешних ссылок. Поисковые системы находят сайт самостоятельно в случае наличия внешних ссылок на его страницы. В данном случае ресурс индексируется от 2 дней до 2 недель. Быстрее остальных систем ресурсы добавляет Google.

Требования к сайту

Чтобы поисковые системы проанализировали ресурс полностью, при поисковой оптимизации сайта соблюдают следующие правила.

- Любая внутренняя страница должна быть расположена не далее трех переходов от главной. Если структура ресурса этого не позволяет, создается карта сайта, указывающая роботам путь к вложенным подкаталогам.

- Не используются идентификаторы сессий, затрудняющие работу поисковых ботов.

- Обычно поисковые системы индексируют на странице до 100-200 Кб текста. В случае большего размера анализируется только часть материала. Если необходима полная индексация такой страницы, информация на ней сокращается или разбивается на несколько разделов.

- Для управления действиями поисковых роботов заполниется файл robots.txt, в котором прописываются инструкции по запрету или разрешению индексации отдельных страниц или директорий сайта. Для этих же целей в процессе оптимизации под Google и Яндекс используется тег «NOINDEX» (поддерживается только российскими поисковиками).

Факторы, влияющие на индексацию

Поисковые базы данных регулярно обновляются, поэтому число проиндексированных страниц сайта может меняться. Переиндексация происходит тем быстрее, чем больше внешних ссылок на сайт. Для отслеживания процесса индексации анализируются лог-файлы сервера, в которые заносятся данные обо всех визитах поисковых ботов.

Переиндексация происходит тем быстрее, чем больше внешних ссылок на сайт. Для отслеживания процесса индексации анализируются лог-файлы сервера, в которые заносятся данные обо всех визитах поисковых ботов.

Другие термины на букву «И»

AdSenseAJAXAllSubmitterAltApacheAPIBegunBlogunCAPTCHACMSCookieCopylancerCPACPCCPLCPMCPOCPSCPVCRMCS YazzleCSSCTR, CTB, CTI, VTRDescriptionDigital-агентствоDigital-маркетингDMOZDoS и DDoS атакиEmailFaviconFeedBurnerFTPGoGetLinksGoogle AdWordsGoogle AnalyticsGoogle ChromeGoogle MapsGoogle webmasters toolsGoogle Мой бизнесhCardhProducthRecipehreflanghtaccessHTTP-заголовкиHTTP-протоколHTTPS-протоколInternet ExplorerIP-адресJavaScriptJoomlaKeywordsKPILanding PageLiexLiveinternetLTVMash-upMiralinksMozilla FirefoxMSNNofollow и noindexOperaPageRank и тИЦPerformance MarketingPHPPinterestPPAPPCPush-уведомленияRobots.txtROI (ROMI)RookeeRotapostRSSSafariSapeSEO-продвижениеSEO-трафикSeoPultSeozavrSERPSidebarSitemap.xmlSMMSocial Media OptimizationSSL сертификатыSubcribe.

Все термины SEO-Википедии

Теги термина

Техническая оптимизацияПродвижение сайтов

Какие услуги тебе подходят

Продвижение сайтов в Москве

SEO-оптимизация сайта

Оптимизация сайта под Google

Продвижение сайта в Яндексе

Продвижение интернет-магазина

SEO-продвижение лендинга в поисковых системах

Продвижение медицинских сайтов

Продвижение молодого сайта

SEO-продвижение с гарантией

Продвижение по ключевым словам

Продвижение сайта в ТОП 10 Яндекса и Google

Продвижение туристических сайтов

Продвижение сайтов в ТОП 3 Яндекса и Google

Оптимизация сайта под Яндекс

Раскрутка сайтов за рубежом

Продвижение сайта в Google

Продвижение сайта по позициям

Продвижение сайта по трафику

Оптимизация сайта в мобильной выдаче

SEO аудит

Поисковый аудит сайта

Заказать продвижение сайта

Продвижение сайтов в Москве: проверенные решения от профессионалов

Продвижение стоматологической клиники

Продвижение сайтов медицинских клиник

Продвижение салона красоты

Продвижение автомобильных сайтов

Продвижение магазина автозапчастей

Продвижение и раскрутка автосервиса

Продвижение отелей и гостиниц

SEO-продвижение сайта в Новосибирске

SEO-продвижение сайта в Екатеринбурге

SEO-продвижение сайта в Самаре

SEO-продвижение сайта в Омске

SEO-продвижение сайта в Нижнем Новгороде

SEO-продвижение сайта в Казани

SEO-продвижение сайта в Челябинске

SEO-продвижение сайта в Красноярске

Поисковое продвижение сайтов в Перми: эффективно, профессионально, прозрачно

Поисковое продвижение сайтов в Ростове-на-Дону

Поисковое продвижение сайтов в Уфе

SEO-продвижение сайта в Воронеже

SEO-продвижение сайта в Волгограде

SEO-продвижение сайта в Краснодаре

Продвижение интернет-магазина бытовой техники

Продвижение интернет-магазина одежды

Продвижение интернет-магазина зоотоваров

Продвижение интернет-магазина книг

Продвижение интернет-магазина мебели

Продвижение интернет-магазина обуви

Продвижение интернет-магазина сантехники

Продвижение интернет-магазина спортивных товаров

Продвижение интернет-магазина стройматериалов

Продвижение интернет-магазина часов

Маркетинговый аудит сайта

Продвижение автосалона

Поисковое продвижение сайтов в Тольятти

Что такое индексирование веб-страниц?

Как найти веб-страницы?

Веб-страницы обнаруживаются путем индексации. Индексирование — это процесс посещения поисковыми системами и анализа новых и обновленных веб-страниц перед добавлением их в свой индекс (базу данных) веб-страниц. Индексацию можно выполнить тремя способами:

Индексирование — это процесс посещения поисковыми системами и анализа новых и обновленных веб-страниц перед добавлением их в свой индекс (базу данных) веб-страниц. Индексацию можно выполнить тремя способами:

Предоставить работу поисковым роботам

Отправить карту сайта (в формате XML)

Запросить индексирование вручную

Если разработчик вашего веб-сайта добавил на страницу Директиву об управляемых контентом роботах, чтобы редакторы контента могли контролировать, как страница индексируется, то достаточно просто установить для страницы значение NOINDEX/NOFOLLOW. Это означает, что страница вашего сайта не будет проиндексирована, а ее внутренние ссылки не будут отслеживаться поисковыми системами.

Это означает, что страница вашего сайта не будет проиндексирована, а ее внутренние ссылки не будут отслеживаться поисковыми системами.

Однако, если для редакторов контента нет поля «Директива о роботах», то для назначения директивы может потребоваться поговорить с вашей командой разработчиков, которая обновит файл robots.txt.

Почему важны индексированные веб-страницы

Индексация URL-адресов необходима для того, чтобы их могли найти поисковые системы, а затем найти потенциальных клиентов, заинтересованных в вашем продукте или услуге.

Если веб-страницы не предназначены для индексации, они не будут найдены и, следовательно, не будут ранжироваться.

Рейтинг URL-адреса и авторитет домена не являются статическими. Помимо зависимости от постоянной оптимизации, в игру вступают и другие факторы. Например:

Как часто публикуется контент

Насколько авторитетным и релевантным является контент 007

Конкурирующие страницы

Поведение пользователя при ссылке в поисковой выдаче просматривается

Работа поисковых систем постоянна. Индексация сайта никогда не прекращается. Поисковые роботы периодически возвращаются на веб-сайты, чтобы проверить наличие обновлений и оценить их рейтинг. Вот почему важно убедиться, что ваши веб-страницы созданы для достижения наилучших результатов ранжирования.

Индексация сайта никогда не прекращается. Поисковые роботы периодически возвращаются на веб-сайты, чтобы проверить наличие обновлений и оценить их рейтинг. Вот почему важно убедиться, что ваши веб-страницы созданы для достижения наилучших результатов ранжирования.

В Codehouse все сборки наших веб-сайтов включают директиву о роботах, которая позволяет редакторам контента назначать следующее:

ИНДЕКС / ПОДПИСАТЬСЯ: Индексировать страницу/Перейти по ее ссылкам

ИНДЕКС / NOFOLLOW : Индекс страница/Не переходить по ее ссылкам

NOINDEX / FOLLOW: Не индексировать страницу/Переходить по ее ссылкам

NOINDEX / NOFOLLOW: Не индексировать страницу/Не подписываться его ссылки

Работа с Codehouse

Наша опытная команда специалистов по цифровым технологиям и сертифицированные эксперты Google помогут вашему бизнесу максимально эффективно использовать стратегию контент-маркетинга. Свяжитесь с нами, чтобы узнать больше.

Свяжитесь с нами, чтобы узнать больше.

Индексирование Интернета | Американское общество индексирования

Навигация

Индексирование в стиле Back-of-the-Book

Индексируемые сайты

Метаданные и веб-индексирование

Индексирование предметного дерева

Технологии поисковых систем

Индексирование Интернета — непростая задача, и для удовлетворения информационных потребностей веб-пользователей развиваются три различных вида индексирования: традиционный стиль жестко закодированных индексных ссылок на веб-сайте, предметный деревья просмотренных сайтов и поисковые системы. Члены ASI, интересующиеся этой специализированной областью индексирования, могут присоединиться к SIG по индексированию цифровых публикаций ASI.

Некоторые организации видят, что включение указателей на их веб-сайты так же важно, как и включение указателей в книги и онлайн-руководства. Мы видели некоторые хорошие и некоторые плохие, некоторые сгенерированные компьютером, некоторые явно не созданные профессиональными индексаторами, а некоторые профессионально подготовленные. В любом случае следует поблагодарить всех владельцев сайтов за осознание необходимости индекса. Мы хотели бы поделиться с вами некоторыми интересными индексами и информацией о том, как работает индексирование в поисковых системах. Посмотрите и посмотрите, какую ценность добавляют эти индексы! Этот список будет время от времени меняться, поэтому не забудьте добавить в закладки, распечатать, загрузить или сохранить другими способами те, к которым, как вы думаете, вы вернетесь позже.

В любом случае следует поблагодарить всех владельцев сайтов за осознание необходимости индекса. Мы хотели бы поделиться с вами некоторыми интересными индексами и информацией о том, как работает индексирование в поисковых системах. Посмотрите и посмотрите, какую ценность добавляют эти индексы! Этот список будет время от времени меняться, поэтому не забудьте добавить в закладки, распечатать, загрузить или сохранить другими способами те, к которым, как вы думаете, вы вернетесь позже.

Веб-индексирование в стиле Back-of-the-Book

Многие веб-сайты предоставляют функцию поиска по сайту. Хотя это, безусловно, лучше, чем ничего, пользователи сталкиваются с теми же проблемами в этом сценарии, что и при поиске в других полнотекстовых базах данных. Основная проблема, конечно же, в релевантности найденных в поиске предметов. Например, на сайте издателя программного обеспечения поиск продукта под названием Home Office приводит к получению всех документов со словом «офис», потому что в конце каждой страницы есть слово «дом». Если есть индекс сайта, вы можете перейти прямо в раздел «H» и найти одну релевантную страницу, тем самым сэкономив время для других проектов. Индекс не только отсеет такие нерелевантные элементы, но и подзаголовки многих релевантных подзаголовков дадут пользователям подсказку о том, какие из них с большей вероятностью ответят на их вопросы.

Если есть индекс сайта, вы можете перейти прямо в раздел «H» и найти одну релевантную страницу, тем самым сэкономив время для других проектов. Индекс не только отсеет такие нерелевантные элементы, но и подзаголовки многих релевантных подзаголовков дадут пользователям подсказку о том, какие из них с большей вероятностью ответят на их вопросы.

Эти выбранные сайты представляют собой просто набор сайтов с интересными индексами, с которыми нам довелось столкнуться. Описания написаны теми, кто представляет предложение сайта. Перечисленные здесь сайты предназначены только для образовательных целей. Американское общество индексирования не поддерживает информационное содержание этих сайтов.

ПРИМЕЧАНИЕ ПО ПРЕДСТАВЛЕНИЯМ: мы приветствуем любые предложения от пользователей о сайтах для добавления. Предлагаемые URL-адреса должны сопровождаться (1) инструкциями о том, как перейти к индексу с главной страницы сайта, и (2) описанием полезного или необычного в индексе.

проиндексированных сайтов

- BC Гидро

- Чтобы перейти к указателю сайта, прокрутите до нижней части домашней страницы и щелкните ссылку «Указатель сайта». Этот алфавитный указатель с гиперссылками отображает удобную для пользователя типографику и макет.

- История Рочестера Индекс

- Это периодический указатель с гиперссылками на статьи, включая несколько гиперссылок по некоторым темам.

- UNIXhelp для пользователей

- Это интерактивное руководство содержит как индекс для просмотра, так и индекс для поиска по ключевым словам. Выберите «Ручной указатель» в меню на главной странице.

- Бюро переписи населения США

- Чтобы перейти к указателю, нажмите «Указатель от А до Я» на главной странице.

Метаданные и веб-индексирование

Тег META в HTML использовался с целью дать поисковым системам подсказки о содержании веб-страницы. Злоупотребление META-тегами со стороны веб-мастеров, которые пытаются искусственно повысить релевантность страницы, наполняя META-теги терминами, не связанными с фактическим содержанием страницы, приобрело угрожающие масштабы. Большинство коммерческих поисковых систем в настоящее время придают очень мало значения тексту, найденному в тегах META.

Злоупотребление META-тегами со стороны веб-мастеров, которые пытаются искусственно повысить релевантность страницы, наполняя META-теги терминами, не связанными с фактическим содержанием страницы, приобрело угрожающие масштабы. Большинство коммерческих поисковых систем в настоящее время придают очень мало значения тексту, найденному в тегах META.

В ответ на это появились движения по стандартизации содержимого тегов META. Корпорации и правительственные органы, имеющие множество веб-сайтов, часто создают общедоступные порталы для своего веб-контента. Они могут улучшить результаты поиска для пользователей за счет тщательного использования структурированных мета-тегов, чтобы направлять свои поисковые системы на сайте. Индексаторы могут применить свои навыки анализа для создания этих структурированных тегов. Вот ссылки о метаданных, метатегах и индексации веб-страниц.

- Цифровая система идентификации объектов

- Цифровой идентификатор объекта (DOI) — это система для идентификации и обмена интеллектуальной собственностью в цифровой среде.

Он обеспечивает основу для управления интеллектуальным контентом, для связи клиентов с поставщиками контента, для облегчения электронной коммерции и обеспечения автоматического управления авторскими правами для всех типов носителей. Использование DOI делает управление интеллектуальной собственностью в сетевой среде намного проще и удобнее, а также позволяет создавать автоматизированные услуги и транзакции для электронной коммерции.

Он обеспечивает основу для управления интеллектуальным контентом, для связи клиентов с поставщиками контента, для облегчения электронной коммерции и обеспечения автоматического управления авторскими правами для всех типов носителей. Использование DOI делает управление интеллектуальной собственностью в сетевой среде намного проще и удобнее, а также позволяет создавать автоматизированные услуги и транзакции для электронной коммерции. - Инициатива по метаданным Dublin Core

- Инициатива по метаданным Dublin Core — это открытый форум, занимающийся разработкой интероперабельных стандартов онлайн-метаданных, которые поддерживают широкий спектр целей и бизнес-моделей. Деятельность DCMI включает в себя рабочие группы, основанные на консенсусе, глобальные семинары, конференции, взаимодействие по стандартам и образовательные мероприятия, направленные на широкое распространение стандартов и практик метаданных.

- Как использовать метатеги

- В этой статье SearchEngine Watch 2007 года объясняются метатеги, включая их ограничения.

- Служба поиска правительственной информации США (GILS)

- Цель Глобальной службы поиска информации — облегчить людям поиск всей необходимой им информации. GILS — это открытый стандарт для поиска основных информационных описаний. Такие описания могут быть вставлены в веб-документы с помощью таких инструментов, как TagGen, сгенерированы из баз данных с помощью таких инструментов, как MetaStar и Microsoft Access; или отредактированные каталогизаторами и просто сохраненные как документы. Основанный на стандарте поиска ISO 23950, GILS включает в себя наиболее часто понимаемые понятия, с помощью которых люди во всем мире находят источники информации в библиотеках, — такие понятия, как название, автор, издатель, дата и место.

Тематическое дерево и индексы проверенных сайтов

Некоторые инструменты веб-поиска просматривают каждый сайт человеческими глазами и мозгом, чтобы решить, какие категории и ключевые слова подходят сайту, а затем индексируют его соответствующим образом. Примером может служить Yahoo, где толпы людей создают индекс для Интернета, который также доступен для поиска с помощью поисковой системы.

Примером может служить Yahoo, где толпы людей создают индекс для Интернета, который также доступен для поиска с помощью поисковой системы.

Технологии поисковых систем

Подавляющее большинство индексаций в Интернете выполняется автоматически, с высоким уровнем поиска и низкой степенью релевантности. Большинство индексаторов считают, что уровень точности, предоставляемый большинством поисковых систем, просто не так хорош, как настоящая индексация. Но по мере того, как технологии поисковых систем становятся все более изощренными, мы должны увидеть некоторые изменения в уровне разочарования людей, использующих эти инструменты. Большинство поисковых систем на самом деле выполняют поиск по индексу — списку терминов, которые роботы возвращают из своих путешествий. Индексы можно манипулировать или создавать для использования этими механизмами, особенно во внутренней сети, путем осторожного использования тега META. Это область, которую индексаторы должны исследовать и понимать, чтобы мы могли индексировать для этих движков.

Он обеспечивает основу для управления интеллектуальным контентом, для связи клиентов с поставщиками контента, для облегчения электронной коммерции и обеспечения автоматического управления авторскими правами для всех типов носителей. Использование DOI делает управление интеллектуальной собственностью в сетевой среде намного проще и удобнее, а также позволяет создавать автоматизированные услуги и транзакции для электронной коммерции.

Он обеспечивает основу для управления интеллектуальным контентом, для связи клиентов с поставщиками контента, для облегчения электронной коммерции и обеспечения автоматического управления авторскими правами для всех типов носителей. Использование DOI делает управление интеллектуальной собственностью в сетевой среде намного проще и удобнее, а также позволяет создавать автоматизированные услуги и транзакции для электронной коммерции.