Запрет индексации в robots.txt | REG.RU

Чтобы убрать весь сайт или отдельные его разделы и страницы из поисковой выдачи Google, Яндекс и других поисковых систем, их нужно закрыть от индексации. Тогда контент не будет отображаться в результатах поиска. Рассмотрим, с помощью каких команд можно выполнить в файле robots.txt запрет индексации.

Зачем нужен запрет индексации сайта через robots.txt

Первое время после публикации сайта о нем знает только ограниченное число пользователей. Например, разработчики или клиенты, которым компания прислала ссылку на свой веб-ресурс. Чтобы сайт посещало больше людей, он должен попасть в базы поисковых систем.

Чтобы добавить новые сайты в базы, поисковые системы сканируют интернет с помощью специальных программ (поисковых роботов), которые анализируют содержимое веб-страниц. Этот процесс называется индексацией.

После того как впервые пройдет индексация, страницы сайта начнут отображаться в поисковой выдаче. Пользователи увидят их в процессе поиска информации в Яндекс и Google — самых популярных поисковых системах в рунете. Например, по запросу «заказать хостинг» в Google пользователи увидят ресурсы, которые содержат соответствующую информацию:

Например, по запросу «заказать хостинг» в Google пользователи увидят ресурсы, которые содержат соответствующую информацию:

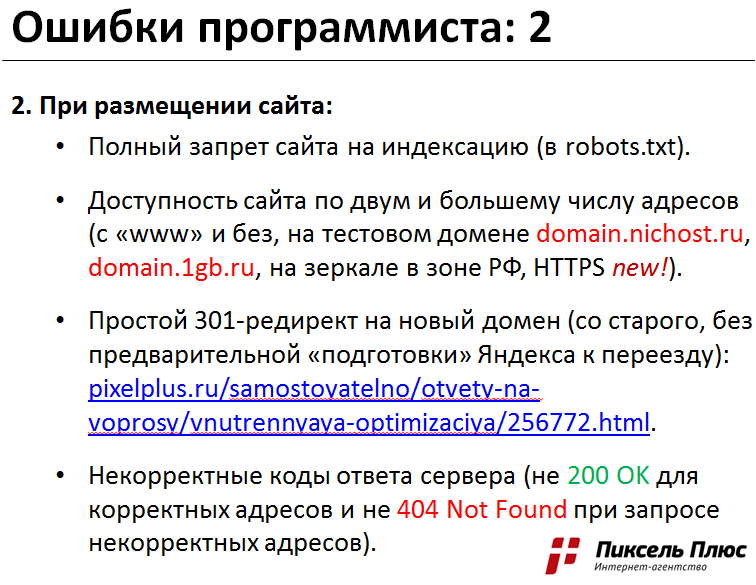

Однако не все страницы сайта должны попадать в поисковую выдачу. Есть контент, который интересен пользователям: статьи, страницы услуг, товары. А есть служебная информация: временные файлы, документация к ПО и т. п. Если полезная информация в выдаче соседствует с технической информацией или неактуальным контентом — это затрудняет поиск нужных страниц и негативно сказывается на позиции сайта. Чтобы «лишние» страницы не отображались в поисковых системах, их нужно закрывать от индексации.

Кроме отдельных страниц и разделов, веб-разработчикам иногда требуется убрать весь ресурс из поисковой выдачи. Например, если на нем идут технические работы или вносятся глобальные правки по дизайну и структуре. Если не скрыть на время все страницы из поисковых систем, они могут проиндексироваться с ошибками, что отрицательно повлияет на позиции сайта в выдаче.

Для того чтобы частично или полностью убрать контент из поиска, достаточно сообщить поисковым роботам, что страницы не нужно индексировать. Для этого необходимо отключить индексацию в служебном файле robots.txt. Файл robots.txt — это текстовый документ, который создан для «общения» с поисковыми роботами. В нем прописываются инструкции о том, какие страницы сайта нельзя посещать и анализировать, а какие — можно.

Прежде чем начать индексацию, роботы обращаются к robots.txt на сайте. Если он есть — следуют указаниям из него, а если файл отсутствует — индексируют все страницы без исключений. Рассмотрим, каким образом можно сообщить поисковым роботам о запрете посещения и индексации страниц сайта. За это отвечает директива (команда) Disallow.

Как запретить индексацию сайта

О том, где найти файл robots.txt, как его создать и редактировать, мы подробно рассказали в статье. Если кратко — файл можно найти в корневой папке. А если он отсутствует, сохранить на компьютере пустой текстовый файл под названием robots.

Чтобы запретить индексацию всего сайта:

- 1.

Откройте файл robots.txt.

- 2.

Добавьте в начало нужные строки.

- Чтобы закрыть сайт во всех поисковых системах (действует для всех поисковых роботов):

User-agent: * Disallow: /

- Чтобы запретить индексацию в конкретной поисковой системе (например, в Яндекс):

User-agent: Yandex Disallow: /

- Чтобы закрыть от индексации для всех поисковиков, кроме одного (например, Google)

User-agent: * Disallow: / User agent: Googlebot Allow: /

- 3.

Сохраните изменения в robots.txt.

Готово. Ресурс пропадет из поисковой выдачи выбранных ПС.

Ресурс пропадет из поисковой выдачи выбранных ПС.

Запрет индексации папки

Гораздо чаще, чем закрывать от индексации весь веб-ресурс, веб-разработчикам требуется скрывать отдельные папки и разделы.

Чтобы запретить поисковым роботам просматривать конкретный раздел:

- 1.

Откройте robots.txt.

- 2.

Укажите поисковых роботов, на которых будет распространяться правило. Например:

- Все поисковые системы:

User-agent: *

— Запрет только для Яндекса:

User-agent: Yandex

- 3.

Задайте правило Disallow с названием папки/раздела, который хотите запретить:

Disallow: /catalog/

Где вместо catalog — укажите нужную папку.

org/HowToStep»>

4.

Сохраните изменения.

Готово. Вы закрыли от индексации нужный каталог. Если требуется запретить несколько папок, последовательно пропишите для каждой директиву Disallow.

Как закрыть служебную папку wp-admin в плагине Yoast SEO

Как закрыть страницу от индексации в robots.txt

Если нужно закрыть от индексации конкретную страницу (например, с устаревшими акциями или неактуальными контактами компании):

- 1.

Откройте файл robots.txt на хостинге или используйте плагин Yoast SEO, если сайт на WordPress.

- 2.

Укажите, для каких поисковых роботов действует правило.

- 3.

Задайте директиву Disallow и относительную ссылку (то есть адрес страницы без домена и префиксов) той страницы, которую нужно скрыть.

Например:

Например:User-agent: * Disallow: /catalog/page.html

Где вместо catalog — введите название папки, в которой содержится файл, а вместо page.html — относительный адрес страницы.

- 4.

Сохраните изменения.

Готово. Теперь указанный файл не будет индексироваться и отображаться в результатах поиска.

Помогла ли вам статья?

Да

раз уже

помогла

Как закрыть страницу сайта, поддомен, фильтр или текст от индексации в Яндекс и Google с помощью файла robots.txt или meta-тега

Январь 31, 2018

Основы SEO Инструкции к Labrika Алгоритмы

Что такое индексация?

Индексация — это процесс анализа страниц сайта поисковыми системами и внесение информации о них в Базу Данных (индекс) для последующего использования ее в ранжировании web-ресурсов и формирования поисковой выдачи.

Зачем нужны запреты от индексации?

Как правило, от поисковых систем закрывают информацию, которая не должна отображаться в поисковой выдаче — это разного рода техническая, служебная и конфиденциальная информация, страницы с непригодным для продвижения контентом. Чаще всего оптимизаторы запрещают для индекса дубли страниц, корзину, результаты поиска на сайте, личный кабинет пользователя.

Методы блокировок от индексации

На эту тему существует подробная инструкция от Google. Выделим два основных метода запрета индексации страницы:

С помощью robots.txt

Robots.txt — это специальный текстовый файл, в котором содержатся рекомендации для поисковых систем о том, какие страницы можно индексировать, а какие не следует. Яндекс.Помощь дает подробное разъяснение по использованию файла

robots.txt, почитать которое можно здесь.Чтобы заблокировать страницу от индексации поисковых систем в

robots.txt, необходимо воспользоваться директивой Disallow. Пример от Яндекс:

Пример от Яндекс:При помощи тега <meta> robots с атрибутом noindex.

О правилах употребления noindex вы можете прочитать в нашей статье Страницы с тегом <noindex>. Чтобы заблокировать страницу с помощью этого атрибута, необходимо добавить в раздел страницы

<head>следующие строчки:<meta name="robots" content="noindex">— страница будет заблокирована для большинства поисковых роботовТакже можно закрыть страницу от какой-либо конкретной поисковой системы, например:

<meta name="googlebot" content="noindex">

Как обнаружить на сайте заблокированные от индексации страницы?

Иметь информацию о таких страницах необходимо хотя бы потому, что некоторые из них могут быть закрыты случайно, например, из-за ошибки при употреблении директив в robots.txt. К тому же, ссылаться на заблокированные URL не рекомендуется, потому что это нарушает передачу статического веса страниц. Посмотреть данные обо всех страницах вашего сайта с блокировкой от индексации вы можете с помощью сервиса Labrika. Находится отчет в подразделе «Блокировки индексации» раздела «SEO-аудит» в левом боковом меню:

Посмотреть данные обо всех страницах вашего сайта с блокировкой от индексации вы можете с помощью сервиса Labrika. Находится отчет в подразделе «Блокировки индексации» раздела «SEO-аудит» в левом боковом меню:

На странице отчета вы можете увидеть следующую информацию:

- Кнопка для обновления данных по сайту. При ее нажатии вы сможете получить свежий SEO-анализ по всем важным параметрам, в том числе — по блокировкам от индексации.

- На этой вкладке содержатся данные обо всех страницах, которые закрыты от индексации.

- Данные исключительно об ошибках в блокировках:

- URL страницы, которая закрыта от индексации.

- Информация о директиве в

robots.txt, если страница заблокирована этим способом. В данном случае, заблокированы все страницы, которые содержат в URL знак «?». - В случае, если блокировка прописана МЕТА-тегом robots, тут будут указываться данные о его содержимом.

Читать дальше подобные статьи

- Тег noindex: запрещенные к индексированию страницы

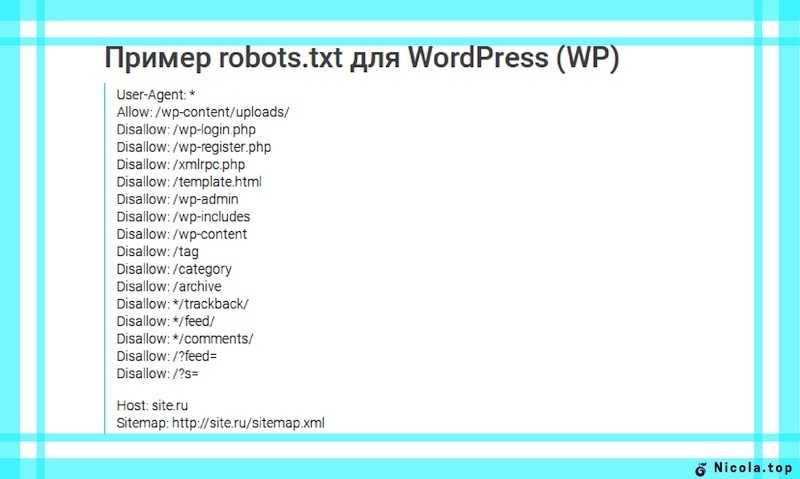

- Файл robots.

txt для WordPress, Modx. Как не закрыть сайт от индексации?

txt для WordPress, Modx. Как не закрыть сайт от индексации? - Исправляем ошибки и правильно настраиваем файл robots.txt

- Ошибки в файле карты сайта sitemap.xml

Online SEO-инструменты для продвижения сайтов

Проверьте свой сайт и сайты конкурентов на 205 факторов поисковых систем.

файлов robots.txt | Search.gov

Файл /robots.txt — это текстовый файл, в котором автоматизированные веб-боты инструктируются о том, как сканировать и/или индексировать веб-сайт. Веб-команды используют их для предоставления информации о том, какие каталоги сайта следует или не следует сканировать, как быстро следует получать доступ к контенту и какие боты приветствуются на сайте.

Как должен выглядеть мой файл robots.

txt?

txt?Подробную информацию о том, как и где создать файл robots.txt, см. в протоколе robots.txt. Основные моменты, на которые следует обратить внимание:

- Файл должен находиться в корне домена, и для каждого поддомена нужен свой файл.

- Протокол robots.txt чувствителен к регистру.

- Легко случайно заблокировать сканирование всего:

-

Запретить: /означает запретить все. -

Disallow:означает ничего не запрещать, то есть разрешать все. -

Разрешить: /означает разрешить все. -

Разрешить:означает ничего не разрешать, что запрещает все.

-

- Инструкции в файле robots.txt являются руководством для ботов, а не обязательными требованиями — вредоносные боты могут игнорировать ваши настройки.

Как оптимизировать файл robots.txt для Search.gov?

Задержка сканирования

В файле robots. txt может быть указана директива «задержка сканирования» для одного или нескольких пользовательских агентов, которая сообщает боту, как быстро он может запрашивать страницы с веб-сайта. Например, задержка сканирования, равная 10, означает, что сканер не должен запрашивать новую страницу чаще, чем каждые 10 секунд.

txt может быть указана директива «задержка сканирования» для одного или нескольких пользовательских агентов, которая сообщает боту, как быстро он может запрашивать страницы с веб-сайта. Например, задержка сканирования, равная 10, означает, что сканер не должен запрашивать новую страницу чаще, чем каждые 10 секунд.

500 000 URL-адресов

x 10 секунд между запросами

5 000 000 секунд на все запросы

5 000 000 секунд = 58 дней, чтобы проиндексировать сайт один раз.

Мы рекомендуем установить задержку сканирования в 2 секунды для нашего пользовательского агента usasearch и установить более высокую задержку сканирования для всех остальных ботов. Чем меньше задержка сканирования, тем быстрее Search.gov сможет проиндексировать ваш сайт. В файле robots.txt это будет выглядеть так:

Агент пользователя: usasearch Задержка сканирования: 2 Пользовательский агент: * Задержка сканирования: 10

XML-карты сайта

В файле robots.txt также должны быть перечислены одна или несколько ваших XML-карт сайта. Например:

Например:

Карта сайта: https://www.example.gov/sitemap.xml Карта сайта: https://www.example.gov/independent-subsection-sitemap.xml Карта сайта: https://www.example.gov/rss-feed-of-uploaded-files.xml Карта сайта: https://other.example.gov/cross-submitted-sitemap.xml

- Список всех карт сайта для домена, в котором находится файл robots.txt. Карта сайта другого субдомена должна быть указана в файле robots.txt этого субдомена.

- Мы также поддерживаем каналы RSS 2.0 и Atom 2.0 в качестве карт сайта. Если вы перечислите эти фиды в файле robots.txt как карты сайта, наша система автоматически проиндексирует URL-адреса фидов.

- При необходимости вы можете «перекрестно отправить» карту сайта для URL-адресов этого домена, используя карту сайта, размещенную в другом домене. Прочтите протокол карты сайта XML, чтобы обеспечить правильную реализацию.

Разрешить только тот контент, который вы хотите найти

Мы рекомендуем запретить любые каталоги или файлы, которые не должны быть доступны для поиска. Например:

Например:

Запретить: /архив/ Запретить: /news-1997/ Запретить: /reports/duplicative-page.html

- Обратите внимание: если вы запретите каталог после того, как он был проиндексирован поисковой системой, это может не привести к удалению этого содержимого из индекса. Вам нужно будет зайти в инструменты поисковой системы для веб-мастеров, чтобы запросить удаление.

- Также обратите внимание, что поисковые системы могут индексировать отдельные страницы в запрещенной папке, если поисковая система узнает об URL-адресе из метода, не связанного со сканированием, например, по ссылке с другого сайта или из вашей карты сайта. Чтобы данная страница не была доступна для поиска, установите на этой странице метатег robots.

Настройка параметров для разных ботов

Вы можете установить разные разрешения для разных ботов. Например, если вы хотите, чтобы мы проиндексировали ваш заархивированный контент, но не хотите, чтобы Google или Bing индексировали его, вы можете указать следующее:

Агент пользователя: usasearch Задержка сканирования: 2 Разрешить: /архив/ Пользовательский агент: * Задержка сканирования: 10 Запретить: /архив/

Контрольный список robots.

txt

txt 1. В корневом каталоге сайта создан файл robots.txt ( https://example.gov/robots.txt )

2. Файл robots.txt запрещает любые каталоги и файлы, которые автоматические боты не должны сканировать

3. Файл robots.txt содержит одну или несколько карт сайта XML

4. Формат файла robots.txt прошел проверку

Дополнительные ресурсы

Полное руководство Yoast SEO по Robots.txt

Google «Узнайте о файлах robots.txt»

Запретить поисковым системам индексировать ваши веб-сайты

- Применяется к: Сетке

- Сложность: Легко

- Необходимое время: 10

- Необходимые инструменты: wp-admin. FTP-клиент, текстовый редактор

- Применяется к: VPS-хостингу

- Сложность: Легко

- Необходимое время: 10

- Необходимые инструменты: wp-admin, FTP-клиент, текстовый редактор

- Применяется к: управляемому WordPress

- Сложность: Легко

- Необходимое время: 10

- Необходимые инструменты: wp-admin, FTP-клиент, текстовый редактор

Обзор

Веб-роботы, также известные как веб-бродяги, поисковые роботы или пауки, представляют собой программы, которые перемещаются по сети автоматически. Поисковые системы, такие как Google или Yahoo, используют их для индексации веб-контента вашего сайта. Однако их также можно использовать ненадлежащим образом, например, спамеры используют их для сканирования адресов электронной почты. Ниже приведены несколько методов, которые вы можете использовать, чтобы предотвратить это.

Поисковые системы, такие как Google или Yahoo, используют их для индексации веб-контента вашего сайта. Однако их также можно использовать ненадлежащим образом, например, спамеры используют их для сканирования адресов электронной почты. Ниже приведены несколько методов, которые вы можете использовать, чтобы предотвратить это.

ЗАЯВЛЕНИЕ О ПОДДЕРЖКЕ:

Имейте в виду, что устранение неполадок в конфигурации/функциональности сторонних приложений не входит в наше заявление о поддержке. Эти ресурсы были предоставлены в качестве любезности, чтобы помочь вам в меру наших возможностей. Для получения дополнительной информации о нашем заявлении о поддержке щелкните здесь.

Инструкции

WordPress

Если вы используете WordPress в качестве CMS, есть встроенная функция, позволяющая запретить поисковым системам индексировать ваш сайт.

- Войдите в панель администратора WordPress.

- Нажмите Настройки >> Чтение.

- Убедитесь, что установлен флажок Видимость для поисковых систем .

Как следует из описания, поисковые системы не будут индексировать ваш сайт, но поисковая система должна выполнить этот запрос.

Robots.txt

В качестве альтернативы описанному выше решению WordPress вы также можете использовать файл robots.txt, чтобы поисковые роботы не запрашивали ваш сайт.

- Используйте файловый менеджер File Manager или FTP FTP FTP для перехода в корневой каталог вашего веб-сайта

- Отредактируйте файл robots.txt или создайте новый, если его еще нет.

- Введите в robots.txt следующее:

Агент пользователя: * Запретить: /

- Сохраните изменения. Вот и все!

Если вам нужны дополнительные инструкции для файла robots.txt, ознакомьтесь с приведенной ниже информацией. Не забудьте удалить знак # для любой команды, которой вы хотите, чтобы роботы следовали, но обязательно не раскомментируйте описание команды. Для получения подробной информации обо всех правилах, которые вы можете создать, посетите: http://www. robotstxt.org/

robotstxt.org/

# Пример robots.txt из (mt) Media Temple # Узнайте больше на http://mediatemple.net # (мт) Форумы - http://forum.mediatemple.net/ # (mt) Статус системы - http://status.mediatemple.net # (mt) Заявление о поддержке - http://mediatemple.net/support/statement/ # Как проверить, что мой файл robots.txt работает должным образом # http://www.google.com/support/webmasters/bin/answer.pyanswer=35237 # Для просмотра списка роботов посетите: http://www.robotstxt.org/db.html # Инструкции # Удалите "#", чтобы раскомментировать любую строку, которую вы хотите использовать, но убедитесь, что не раскомментировали описание. # Предоставить доступ роботам ################################################### ###################################### # В этом примере всем роботам разрешен доступ ко всем файлам, поскольку подстановочный знак "*" указывает всех роботов: #User-agent: * #Запретить: #Чтобы разрешить одного робота, вы должны использовать следующее: #Агент пользователя: Google #Запретить: #User-agent: * #Запретить: / # Запретить доступ роботам ################################################### ###################################### # Этот пример удерживает всех роботов: #User-agent: * #Запретить: / # Следующий пример указывает всем поисковым роботам не входить в четыре каталога веб-сайта: #User-agent: * #Запретить: /cgi-bin/ #Запретить: /изображения/ #Запретить: /tmp/ #Запретить: /частное/ # Пример, который сообщает определенному сканеру не входить в один конкретный каталог: #Агент пользователя: BadBot #Запретить: /частное/ # Пример, который сообщает всем поисковым роботам не вводить один конкретный файл с именем foo.

Например:

Например: Пример от Яндекс:

Пример от Яндекс: txt для WordPress, Modx. Как не закрыть сайт от индексации?

txt для WordPress, Modx. Как не закрыть сайт от индексации?