Игорь Ашманов: Кризис поисковой оптимизации и нехорошие тренды – статьи про интернет-маркетинг

Обсуждение провокационного доклада Игоря Ашманова возникло еще до начала РИФа на форуме searchengines.ru. После того, как доклад был прочитан, обсуждение переместилось в другую ветку, но что показательно, по сути доклада большинство из участников форума не стали спорить. Там же на форуме есть тезисы секции ‘Поисковая оптимизация’. Андрей Иванов развивает тему на форуме Seochase.com — Нужно ли смотреть на истинное лицо оптимизаторщины?.

Обзор прошедшего РИФа можно прочитать на Вебпланете: два отчета названные Звезды РИФа: первый день и Звезды РИФа: день второй. Также есть обзоры РИФ-2007: рекламная перегрузка, гуглопшик и user-generated банкет и РИФ-2007. Почему в Америке нет своей ‘Мамбы’, продажные ИТ-кадры и таргетинг на порносайтах на сайте TelNews и заметка о докладе Михаила Козлова на сайте dp.ru. Любителям блогов — веселый отчет с фотографиями о поездке на РИФ и о некоторых докладах.

Алексей Тутубалин представил вторую часть своего исследования ссылок в Рунете — ‘Ссылочное ранжирование в Рунете: реципиенты ссылок, тексты ссылок’. В качестве выводов Алексей сообщил, что среди платных ссылок очень много уникальных текстов ссылок, но при этом, разнообразие словарного состава платных ссылок невелико. Также в этом исследовании дана оценка среднего бюджета на покупку ссылок только с ‘морд’ в зоне RU — около $2000.

Важные новости, касающиеся SEM и SEO, обозначены звездочкой красного цвета .

100 ведущих веб-студий Рунета

Экспертная группа Tagline опубликовала топ-100 веб-студий Рунета. Методику исследования и комментарии экспертов можно прочитать на сайте 2007.tagline.ru, а на Вебпланете — анализ позиций студий и сравнение с исследованием прошлого года.

РБК владеет Loveplanet.ru

Вышло официальное подтверждение о сделке РБК и Loveplanet: компания ‘Медиа Мир’, которая является дочерним предприятием ‘РБК Информационные Системы’, приобрело контрольную долю Loveplanet.ru. Как сообщается в пресс-релизе, после этой сделки вторая по масштабу система знакомств будет превращаться в мощный многофункциональный сервис.2 миллиарда веб-страниц

Статистика Яндекса сообщает, что поиск ведется по более чем двум миллиардам веб-страниц. Цифра на главной странице Яндекса — 2 104 139 966. Цифра на странице ‘О компании’ пока еще не обновилась — 1 885 944 124.

Электронные книги в Нигме

Google создает систему для покупки рекламы на ТВ

Google совместно со спутниковой телекомпанией EchoStar намеревается создать систему по покупке и размещению рекламы на телевидении. EchoStar транслирует 125 каналов для аудитории более 13 млн. человек. Читать подробнее >>

Рекламные объявления Yahoo станут короче

Yahoo рассказала, что короткие рекламные сообщения работают лучше и сообщила о том, что с июня 2007 будут приниматься только объявления длиной 70 символов. Сейчас объявления могут составлять 190 символов. Напомним, что недавно Бегун провел подобное сокращение длины текстовых объявлений также до 70 символов.

Визитка в Яндекс.Директе обновилась

Виртуальная визитка — это страница рекламодателя Яндекс.Директа с контактной информацией. Теперь на этой странице добавились поля для указания e-mail, номера для обмена мгновенными сообщениями (ICQ, Jabber, GoogleTalk, Mail.ru Агент, Skype) и поле для краткой дополнительной информации. Если на компьютере пользователя установлен Skype, то номер телефона превращается в ссылку, по клику на которой можно сразу позвонить, как пример — виртуальная визитка одной из компаний.

Контекст Бегуна в программах 1С

www.ashmanov.com

Игорь Ашманов: «Поисковая система гораздо сложнее, чем ракетная промышленность»

Олег Саламаха, бизнес-аналитик компании Netpeak, побеседовал с генеральным директором компании «Ашманов и партнеры», специалистом в области искусственного интеллекта, разработки программного обеспечения и управления проектами, кандидатом технических наук —

Игорем Ашмановым.В своем интервью Игорь Станиславович рассказал про поисковую систему для Вьетнама, тренды поискового рынка и регулирование интернета.

Олег Саламаха: — Чем вас привлек вьетнамский рынок?

Игорь Ашманов: — Вьетнамцы сами нашли нас в интернете и предложили создать поисковую систему. Им от нас были нужны технологии по оптимизации и другие разработки.

Олег Саламаха: — Зачем Вьетнаму своя поисковая система?

Игорь Ашманов: — Национальные поисковые рынки, за исключением всего нескольких, заполнены вакуумом. Чаще всего в странах есть Google, который занял своё место лидера так же, как газ занимает выделенный объем. Пользователи могут даже не знать, что бывают другие поисковики.

Но Google особенно не старается быть дружественным и релевантным. Компания не тратится на захват рынка и привлечение пользователей, а поддержкой морфологии языков занимается по остаточному принципу. Этот сценарий повторился и во Вьетнаме.

Олег Саламаха: — Почему они сами не сделали поисковик?

Игорь Ашманов: — Это может показаться странным, но не каждая страна может себе это позволить. Поисковая система гораздо сложнее, чем, например, ракетная промышленность: многие страны производят ракеты, но собственный поисковик и машинный переводчик есть лишь у единиц.

Найти разработчиков или людей с готовой технологией во Вьетнаме невозможно. Поэтому техническая команда Wada находится в Москве, а маркетинг, продажи и генеральный директор — во Вьетнаме.

Олег Саламаха: — Насколько Вьетнам привлекателен для высокотехнологичных разработок?

Игорь Ашманов: — Во-первых, это очень быстро развивающийся рынок. Во Вьетнаме около 90 миллионов населения, и больше половины из них — молодые люди. Поэтому и рост аудитории интернета в ближайшие несколько лет будет очень быстрым.

Когда мы в первый раз приехали туда три года назад, в стране было порядка 20-22 млн. интернет-пользователей, а сейчас — больше 30 миллионов.

Во-вторых, есть простое соотношение: сколько рекламных долларов на пользователя в год зарабатывает или «вытрачивается» в национальном интернете. В России это 20-25 долларов, потому что рекламный рынок больше миллиарда долларов, а пользователей — 60-70 миллионов. Во Вьетнаме это примерно доллар на пользователя, а, может быть, уже и близко к двум. Получается разница в 10-15 раз, даже если поделить на разницу душевых ВВП. Люди зарабатывают во Вьетнаме меньше, чем в России, а значит — получается запас в несколько раз на ближайшие годы…

Читать далее

www.searchengines.ru

Интервью с Игорем Ашмановым о трендах 2016 года – статьи про интернет-маркетинг

Тренды 2016 года в интернет-маркетинге

Какие основные изменения на рынке поискового маркетинга вы можете отметить? Чего ждать в 2017 году?

Все больше и больше развивается именно комплексный поисковый маркетинг, само по себе SEO окончательно перестает быть самостоятельным инструментом. Про ссылки рынок уже не говорит совсем, хоть они и продолжают работать. Массовости использования нет, оптимизаторская индустрия переключилась на другие темы и методы, такие как внешний и внутренний контент-маркетинг, крауд-маркетинг, развитие сайта, социальные сети и т.д.

Как, на ваш взгляд, повлияет недавний запуск нового алгоритма «Палех» в Яндексе на работу оптимизаторов?

Я считаю, что запуск «Палеха» пока мало что меняет в SEO. Это новшество сейчас затрагивает лишь соответствие заголовков страниц пользовательскому интересу, выраженному при помощи низкочастотного запроса. Александр Садовский из Яндекса недавно на нашей конференции пообещал, что следующим этапом развития технологии станет применение Палеха к тексту страниц. Тогда и можно будет поговорить о влиянии этого обновления на SEO.

На Optimization 2016 многие докладчики говорили о необходимости перехода на HTTPS в связи с тем, что Google со следующего года делает наличие HTTPS позитивным фактором ранжирования. На ваш взгляд, надо ли торопиться с переходом?

Есть ощущение, что пока мало кто понимает необходимость перехода на HTTPS или наблюдает какой-то позитивный эффект от этого. Однако из-за постоянной пропаганды перехода поисковыми системами мы имеем выраженную тенденцию к переходу.

По моему мнению, основная ценность в переходе на HTTPS для поисковиков — это скрытие запросов и других пользовательских данных от внешних наблюдателей. Серьезных оснований переводить сайты на шифрованное соединение с пользователями — нет.

По данным Google, уже больше половины трафика в Рунете — мобильный. На какие инструменты бизнесу стоит сейчас обратить внимание, чтобы успешнее продвигаться в этом канале?

Из свежих технологий я бы отметил Accelerated Mobile Pages (AMP). Сейчас о ней все говорят, а самые продвинутые начинают использовать. Стоит также учитывать заявление Google, что в следующем году он будет показывать в десктопной выдаче мобильные версии сайтов, если они есть. Необходимо будет отдельно оптимизировать мобильную версию, если сайт не адаптивный. Приоритеты по ранжированию: AMP — Mobile — Desktop.

Усилится ли влияние коммерческих факторов ранжирования в ближайшем будущем?

Скорее, наоборот — уменьшится. Подавляющее большинство сайтов в топе уже довели использование этих факторов до максимума. Должен будет появиться новый сильный фактор. Возможно, это будут упоминания бренда и эмоциональная окраска этих упоминаний — например, на основе данных Яндекс.Медианы. Мы видим, что Яндекс уже начал собирать мнения о некоторых компаниях и качестве их услуг прямо на странице результатов поиска.

Главные поисковики в Рунете теперь так или иначе используют нейронные сети. Каковы ваши прогнозы на применение нейросетей в поисковых системах в ближайшем будущем?

Это скорее обещания. Например, Google даже машинное обучение использует не как основной инструмент ранжирования. Яндекс использует традиционное машинное обучение, но заменить его нейронными сетями — это не быстро. Потребуется много обновлений с географическими именами, мне кажется.

Вероятно, нейронные сети рано или поздно «прикрутят» к ранжированию в поиске, но не в ближайшие полгода.

Буквально месяц назад полмира увлеченно играло в Quick, Draw!, заставляя нейросеть Google угадывать нарисованные объекты. В поиске эта технология пока не используется, но будущее применение хорошо просматривается. Какие непростые или даже нерешенные раньше поисковые задачи сейчас становятся под силу нейросетям?

Там много что можно сделать, но надо понимать, что очень многие методы ранжирования, известные в науке о поиске текстов десятки лет, не использовались поисковиками. По той простой причине, что они существенно увеличивают время индексирования или ранжирования на лету — это делает поиск с его сотнями миллионов запросов в день практически невозможным. Среди этих методов всякие предвычисления, разбор синтаксиса предложений, запуск серии итеративных предзапросов перед вычислением результата и т.п. Весь «интеллект», который утяжеляет — не используется.

Добавление одной секунды на запрос полностью убивает современный поиск. Поэтому внедрение нейронных сетей будет идти не быстро и очень осторожно.

А так их можно применять много где: при семантическом поиске по картинкам и видео, на сравнении пользовательских сессий, при удалении дублей, при поиске оригиналов, при выявлении спама, при сегментации пользователей, при голосовых запросах, при предсказании пробок и т.п.

Какие технологии сегментирования аудитории кажутся вам наиболее перспективными?

Сейчас и Яндекс, и Google активно развивают инструменты, позволяющие дробить аудиторию по каким-то признакам. В 2016 Яндекс запустил сервис Яндекс.Аудитории, который позволяет таргетироваться на пользователей, которые уже являются вашими клиентами, а также строить сегменты пользователей, которые похожи на клиентов по поведению.

Конечно, наиболее эффективно сегментирование аудитории в социальных сетях, где пользователи идентифицируются не по «кукам» (которые живут не очень долго) или идентификаторам браузера, например, а по реальным именам и аккаунтам, и сообщают о себе практически всё.

В этом смысле таргетированная реклама в соцсетях гораздо перспективнее. Ну и примыкающий к ней programmatic, который всасывает в себя все большие пользовательские данные и все больше видов и форматов рекламы.

Как сказывается тенденция комплексного подхода к продвижению бизнеса на контекстной рекламе?

Уже давно никому не интересно простое заведение и ведение контекстной рекламы. Рекламодателю нужно управление рекламой на основе бизнес-показателей, таких как возврат инвестиций (ROI) и доля рекламных расходов (ДРР). Нужно единое окно для агрегирования данных со всех систем аналитики и площадок, причем данные веб-аналитики должны быть связаны с реальными данными бизнеса и с CRM. Бизнес хочет принимать обоснованные решения, без серьёзной аналитики это невозможно.

Надо сказать, что комплексность в контекстной рекламе подразумевает не только оптимизацию рекламных кампаний, но и параллельную оптимизацию сайтов. Такой подход позволит не потерять посетителей, пришедших на сайт.

Какие наиболее важные тренды в медийной рекламе стоит сейчас принимать во внимание рекламодателям и агентствам?

Продолжает расти видеореклама. В этом году для десктопов она составляет почти треть (31%) показов. При этом немного подросла и доля мобильной рекламы — как баннеров (с 10% до 14%), так и видео (с 20% до 22%).

Мы ожидаем роста programmatic. В России этот вид рекламы имеет долю порядка 18%. Для сравнения, в США это уже 59%.

Но самое главное — со стороны брендов будет расти интерес к измеримости рекламных кампаний и работе на качественные показатели со стороны агентств. Просто имидж и охват покупать уже не будут.

В конечном счете на вершине будут те агентства, которые смогут агрегировать все данные в «едином окне», которые окажутся способны доказывать и обосновывать необходимость и влияние каждого из инструментов рекламы, в частности, инструментов медийных. В целом же на рынке останутся преимущественно сильные игроки с качественным трафиком.

Можно ли сказать, что в 2016 году были какие-то мощные сдвиги в поведении аудитории соцсетей? И что с этим делать брендам?

Все сдвиги в соцсетях какие-то негативные. Больше фейков, вбросов, больше ругани, тексты становятся все короче, восприятие все более клиповое. Есть сильный сдвиг аудитории в сторону мессенджеров.

Что делать брендам? Строить работу с соцсетями. Мониторинг, реагирование и так далее. Нельзя полагаться на ботов или написание фальшивых отзывов, нужно сегментировать аудиторию, вести списки аккаунтов, искать лидеров мнений, следить за тем, что она пишет, как реагирует на бренд, общаться напрямую, иметь для этого «послов» бренда. Создавать свои площадки. Всё это достаточно очевидно.

www.ashmanov.com

Как продвигать СМИ? Интервью с Галиной Бакушевой, seo-специалистом Известий и Russia Today – статьи про интернет-маркетинг

Галина, с какими СМИ Вы работали? Каких результатов удалось достигнуть?

Работала инхаус в Известиях, Russia Today, на аутсорсе работаю с Вечерней Москвой, СПИД.ЦЕНТР Антона Красовского, с января консультирую проект HYPEBEAST.COM.

К сожалению из-за NDA не могу вообще разговаривать о каких-либо результатах на проектах, где я работала инхаус. Уже были прецеденты. Могу сказать только за текущий проект. Вечерняя Москва выехала на технической оптимизации сайта, спасибо команде и руководству за свободу действий и быстрое реагирование отдела разработки. Мне нравится этот клиент и я его ценю. Поисковый трафик в Yandex с ноября по сегодня увеличился в 2,8 раз, в Google за тот же промежуток времени в 1,6 раз (планируем начать ссылочное с конца февраля). Опять же повторюсь, спасибо оперативной работе отдела разработки. У меня был пул задач по техничке и они здорово справились.

Задачи были классические — вылезал http, не закрыты поддомены, дубли страниц, не оптимизированы разводящие, ужасающая структура (как у большинства СМИ).

Сегодня я работаю с проектами, которые приносят мне удовольствие. Либо это хорошие люди, либо интересные проекты для меня, либо классная команда.

В чем особенности продвижения медиа? Изменились ли они в последнее время, можно ли выделить какие-то тренды?

Если мы говорим в целом обо всех каналах продвижения в digital, то я бы выделила следующее.

Крупным СМИ сложно конкурировать с нишевыми ресурсами в поисковой выдаче. Как говорится, если ты во всем по чуть-чуть, то ты ни там, ни там не на максималках. Нишевые СМИ считаются более сконцентрированными на экспертизе в своей нише, им больше доверия по определенным темам, поэтому например, Известиям никогда не обогнать разделом о грибах сайт для грибников на домене грибник.ру. И никакой ИКС гигантский не поможет. Вот такой пример. Это как обратиться к диджитал директору за настройкой контекстной рекламы. Он настроит, но либо давно этого не делал, либо не сильно углубленно знает нюансы, так как ему это особо не надо, чтобы зарабатывать деньги. А может и вовсе не настроит. На контексте зарабатывает деньги контекстолог, вот к нему лучше и обратиться.

СМИ очень зависимы от сервисов поисковых систем, таких как Яндекс и Google Новости, Яндекс. Дзен, агрегаторы и партнеры. Эта зависимость приводит к страшным вещам. Я видела нервный срыв у человека из-за Яндекс.Дзен, работа алгоритмов которого загадка для большинства. Представляете, приходите утром на работу, а трафик с Дзена равен нулю. А он у вас составляет 60% от общего. Вы белеете и зеленеете. И никто ничего не может с этим поделать.

Тренды… Можно я просто скажу, кто хорошо пишет из медиа под SEO и вы сами все поймете? Тинькофф-журнал, НОЖ медиа, МЕЛ, Канобу. Нишево, но очень доходчиво. Низкочастотные заголовки, полностью совпадающие с ключевым запросом — для меня это тренд, люблю такое. Близкое человеку, конкретное, полезное для потребления, экспертное, порой от первого лица. За этим будущее. Пользователь очень дорожит своим временем сегодня и, задав конкретный вопрос, хочет получить не менее конкретный ответ, а не размазанную кашу по тарелке.

Особенно удивляет иллюзия «мы сейчас сделаем спецпроект с чем-нибудь е-коммерческим внутри сайта, оптимизируем заголовки и выйдем в топ за счет хорошего ИКСа!»

Да не будет такого никогда. Если СМИ делает спецпроект, сначала подумайте, с помощью какого канала дистрибуции контента будете его продвигать. Забудьте про SEO. Выдача коммерциализирована (особенно в Яндексе) сегодня, и новостной портал никогда не выйдет в топ по коммерческому запросу или запросу с брендом, который не является названием этого самого СМИ.

С какими основными проблемами сталкиваются медиа при продвижении?

Я скажу о SEO продвижении:

-

Главная ошибка СМИ в том, что они не привлекают SEO-специалиста на этапе идеи сайта/проекта. Рисовать прототип, структуру каждого типа страниц, план перелинковки, информационную структуру необходимо вместе с сеошником, тем более если планируется привлекать трафик не только из агрегаторов и партнерский, но и поисковый. Да и вообще подход часто очень странный — «тяп-ляп и в продакшн».

-

Много технических моментов не учитывается в итоге. Разработчик не обязан знать как работают поисковые системы, он не обязан знать считает ли поисковик дублями урлы со слэшем и без него. Но ведь, если таковые урлы присутствуют одновременно на сайте, значит, пора ставить 301 редирект с одного на другой во избежание дублей.

-

Отсутствие микроразметки, не уникальные мета-данные, не придается значение также разводящим страницам — тегам, разделам, сюжетам. Они часто используются как свойства материала, а не как самостоятельный тип страницы со своими мета-полями.

-

Страх новых форматов, внедрения вечно-зеленых фишек — календарей, вики-разделов, рубрик.

-

Ресурсозатраты. SEO требует внимания практически всех подразделений — разработчиков, редакции, дизайнеров, согласования руководства. Надо быть готовым к этому, если вы решили заняться SEO в большой компании.

То есть получается, что любая seo-проблема становится основной. Как снежный ком.

Как вы бы посоветовали выстроить взаимодействие SEO-специалиста и журналистов?

Исходя из опыта работы в крупных СМИ, я считаю, что надо проводить совещания с шеф-редактором или главным редактором, который поможет донести важность ставить правильные теги к материалам, не сильно играть с заголовками до неузнаваемости и правильно анкорить ссылки при перелинковке материалов (это совсем боль!). Без административного рычага будет сложнее.

Часто у журналистов и редакторов есть KPI и премии за просмотры материалов, поэтому есть вариант объяснить в том ключе. А именно то, что правильное формирование статьи даст больше охвата и просмотров, в том числе из поисковых систем.

В чем основные ошибки, которые совершают медиа? Как их исправить?

Я сразу отмечу, на что стоит обратить внимание.

-

Закрывайте технические поддомены от индексации. Если на них скрипты, стили или картинки — закрывайте директории выборочно, не ленитесь.

-

Сделайте шаблонизацию мета с переменными, один раз сделал — всю жизнь отдыхаешь.

-

Соблюдайте чистоту контента конечной страницы (например, страницу новости, публикации). Не надо обвешивать ее рекламой и пихать в h2-h3-h4 технические заголовки и заголовки партнерских блоков и материалов.

-

Не усложняйте, пишите для людей.

-

Не увлекайтесь новостными агрегаторами. С них сложно слезть и это трепит нервы. Можно стремиться к максимальной независимости с помощью SEO, что приведет к самостоятельному контролю над трафиком и его стабильности.

Какие факторы могут помочь выйти в лидеры в поисковой выдаче? Что обязательно нужно учитывать в работе?

Если мы говорим только о SEO, то прежде всего важно:

-

Грамотно составленная структура информации на сайте и логичная иерархия, в том числе адресная.

-

Корректная sitemap или несколько sitemap.

-

Микроразметка типов материалов.

-

Скорость загрузки и мобильная версия ресурса.

-

Не забывать про ссылочный вес.

-

Писать для людей, не брезговать ключевыми словами.

-

Ну и так как мы играем по правилам поисковых систем, надо стараться внедрять все новшества и учитывать их рекомендации.

Как автоматизируете работу?

Последнее время моя работа полна креатива и аналитики, поэтому не получается ничего автоматизировать, кроме мета-данных, сбора ключей под проект.

Пользуюсь Serpstat, Ahrefs.

Как измеряете результаты? Какие показатели считаете хорошими?

Для каждого проекта свои цели и свои результаты. Кто-то хочет увеличить время проведения на сайте одного пользователя, кто-то — увеличить CTR или продажи (у меня есть еще и еcom-проекты), кто-то — трафик.

Измеряю разными инструментами. Трафик — Метрикой, она удобная и наглядная. Позиции — Топвизор и свои таблицы. CTR — Google Analytics.

Я всегда смотрю Яндекс.Метрику. Каждое божье утро.

Хорошие показатели для СМИ… Количество отказов на проектах, с которыми я работаю сегодня, — 8-10%. Не знаю хорошо это или плохо, но на некоторых, я слышала, бывает 25-30%.

Время пребывания на сайте в среднем — порядка 4-7 минут. Тоже не могу сказать, что хорошо, а что плохо. Это очень сложно. Все СМИ спроектированы по-разному. Кто-то обвешивает всем подряд, в связи с чем пользователь тыкает по баннерами и обвесам, кто-то сдержан и содержит страницу публикации в чистоте. Кто-то неправильно выстраивает рекомендательные статьи, время на сайте соответственно снижается.

Используете ли Яндекс.Дзен для привлечения дополнительного трафика? В чем особенности работы с ним?

Я боялась вопроса про Яндекс.Дзен.

Особенность во всем. Он вообще настолько особенный, что не знаешь с какой стороны к нему подойти и с каким контентом в кармане.

Если хотите трафика через фид rss — пишите вручную в канал хотя бы 2-3 статьи в неделю, один нарратив, вне зависимости от того, отдаете вы контент через фид или нет.

Дзен любит нативных авторов. Можно бомбить новостями, но дольше собирают трафик статьи на широкую аудиторию. Особенно Ольга Бузова хорошо идет. Кстати, лайфхак — можно каждый день заглядывать в Инстаграм Ольги Бузовой и просто описывать то, что она выложила или что делает.

Или тот же метод, но с Аллой Борисовной Пугачевой, например.

И будет вам трафик хороший, стабильный.

Важно помнить, что название сервиса Дзен — от одноименного слова «дзен», то есть релакс, медитация и прочий фен-шуй, развлечения. Там надо писать для тех, кто заходит на главную Яндекса. Моя мама любит читать Дзен. И мамы из школьного чата моей дочери в ватсапе тоже часто делятся публикациями из Дзена.Нельзя трэш и мясо. Людоедов, расчлененку и прочее. Сразу бан на месяц и пессимизация доступности для новых пришедших пользователей Дзена.

Я часто посещала закрытые мероприятия Яндекс. Дзен и получала подарки от них. У них классный мерч. Качественный, добротно сшитый. Сумки, свитшоты, рюкзаки, дождевики, футболки. Классные вещи.

Но не так давно решила устроить акцию и раздать весь этот классный мерч своим друзьям с посылом о том, что пока не будет понимания как работают их алгоритмы, я не смогу носить ни одну их вещь.

Разлетелись вещи как горячие пирожки!Дзен — хорошая идея. Думаю, это только начало и все у них будет хорошо. А вот будет ли хорошо в Дзене СМИ — это большой вопрос.

Какие интересные исследования или эксперименты могли бы посоветовать изучить для продвижения медиа? Что почитать или посмотреть, чтобы разобраться в теме еще лучше?

Курс Игоря Баньковского по техническому SEO, Python для SEO от Черненко Сергея и если есть возможность, то хоть раз в жизни стоит послушать Алексея Чекушина, где бы он ни выступал.

Эти материалы помогут понять, как действовать, и стоят не дорого.

С Галиной Бакушевой говорила Татьяна Половиченко, главный редактор «Ашманов и партнеры».

www.ashmanov.com

Оптимизация в Google: 16 интересных seo-экспериментов – статьи про интернет-маркетинг

Широко известно, что seo оптимизация не является точной наукой. В отличие от химии, здесь не бывает формул, которые гарантируют заранее известный и точно воспроизводимый результат. Поэтому по мере развития поисковых систем специалистам по продвижению приходится постоянно экспериментировать и выявлять новые закономерности.

В Search Engine Journal была опубликована подборка SEO-экспериментов. Мы отобрали наиболее интересные и показательные среди них и добавили подробности.

1. URL простым текстом без ссылки

Суть эксперимента: группа маркетологов из академического сектора заметила, что на некоторых веб-сайтах университетов и колледжей при публикации научных работ ссылка на них прописывалась простым текстом, без тега a /. Они решили проверить, как именно это влияет на обнаружение страниц поисковыми системами.

Для этого был создан новый домен с единственной страницей, оптимизированный под некоторую ключевую фразу. После этого исследователи начали с некоторым временным интервалом одну за другой публиковать страницы, содержащие ссылки на этот домен простым текстом.

Результат: все 20 опубликованных страниц были закэшированы Google, но на позицию домена в выдаче это никак не сказалось. Сами ссылки при этом действительно были обнаружены.

2. Влияние Google+ и Twitter на результаты поиска

Суть эксперимента: когда компания Google представила функцию выдачи результатов поиска в реальном времени, туда стали попадать твиты. Вскоре после этого вывод твитов в выдачу был отключен, но вопрос остался: как твиты влияют на позиции и стоит ли их использовать? Оправдана ли оптимизация сайта для google с ними?

Исследователи провели три теста:

-

Попытка привлечь внимание к одной непроиндексированной поисковиками странице. Исходный твит получил больше 400 ретвитов (и, как следствие, некоторое количество лайков в Facebook и LinkedIn) и к концу дня попал на первое место выдачи в Google по уникальной ключевой фразе.

-

То же самое, но после того, как Google отключил прямой доступ к данным Twitter. Google и Bing понадобилось до 8 часов, чтобы закэшировать страницу. Через некоторое время по новой уникальной ключевой фразе страница вышла на первое место в поисковой выдаче.

-

Тест на скорость кэширования двух уникальных страниц при постинге в Twitter и Google+. Страница, на которую была поставлена ссылка в Twitter, вышла на первое место по заданной ключевой фразе в течение 13 минут. Страница, на которую ссылка была поставлена в Google+, на первое место вышла через два часа.

Довольно быстро стало ясно, что хотя у Google больше нет прямого доступа к ленте Twitter, многочисленные агрегаторы и скрейперы делают твиты доступными для поисковой системы, пусть и с некоторым отставанием.

Результат: вне всякого сомнения, твиты и посты в Google+ влияют на результаты поиска, и оптимизация сайта под google не может без них обойтись. Кроме того, значение имеет и количество ретвитов: чем их больше, тем выше страница поднимается в результатах поиска.

3. Стоит ли ставить ссылки со страниц, где их и так уже много

Суть эксперимента: влияет ли количество исходящих ссылок с авторитетного сайта на темпы роста PageRank страниц-акцепторов.

Для эксперимента было создано два совершенно новых сайта и один промежуточный домен. Оба сайта в течение контрольного отрезка времени сохраняли примерно одинаковые позиции. После этого на второй сайт через промежуточный домен была поставлена ссылка с сайта debian.org, имеющего 4225 исходящих ссылок (прим. пер. — эксперимент проводился в августе-сентябре 2012 года, т.е. после запуска Penguin).

После получения обратной ссылки позиции первого сайта сначала повысились (со 113 до 82), а затем ушли вниз (до позиции #186). В то же время позиции второго сайта, получившего новую ссылку, резко пошли вверх и к моменту окончания измерений зафиксировались на седьмой позиции в топе.

Результат: испытание показало, что ставить ссылки со страниц, уже имеющих большое количество исходящих ссылок и высокий PageRank, всё же имеет смысл.

4. Эксперимент с активной публикаций материалов в блоге

Суть эксперимента: как активная публикация новых материалов влияет на позиции сайта в поисковой выдаче и конверсию.

На сайте небольшой финансовой фирмы наблюдалось отсутствие как роста, так и падения посещаемости на протяжении месяцев. В среднем в неделю на сайт заходило около 90 человек, которые преимущественно искали контактные данные компании.

Проверяя, как сработает оптимизация сайта под гугл в рамках экспертимента, специалист попросил свою аудиторию в Twitter, Facebook и LinkedIn задать интересующие их вопросы по страхованию. Из 135 полученных вопросов он отобрал 100 и по каждому из них записал и опубликовал короткий видеоролик с ответом. Всего было опубликовано 100 таких роликов, по одному в день.

Результат: посещаемость блога начала быстро расти — во многом, благодаря взаимодействию с аудиторией в социальных сетях, но также и за счёт поисковых систем.

Анализ показал, что примерно трёхкратный прирост заходов из поисковиков произошёл, главным образом, за счёт низкочастотных запросов.

Что касается конверсий, рост дохода за исследуемый период составил $4975. С учётом того, что временные затраты составляли 15 минут в день, это означает доход $200 за час.

5. Выкидывание оригинальной страницы из результатов поиска

Суть эксперимента: алгоритм работы поисковика Google старается отсеивать дубликаты страниц в результатах поиска; может ли в таком случае посторонний сайт, скопировавший существующую страницу, выкинуть оригинальный сайт из выдачи за счёт обратных ссылок с авторитетных доменов?

Для эксперимента на сайте оптимизатора был создан поддомен, на котором была опубликована полная копия страницы другого сайта (с разрешения владельца). На эту страницу были размещены ссылки с авторитетных доменов.

Через пять дней дубликат вытеснил оригинал из топа выдачи. Затем эксперимент был повторен с другой страницей, которая была вытеснена со своего места уже через два дня.

Однако через две недели оптимизатор получил предупреждение в Google Webmaster Tools о том, что он применяет нерекомендуемые методы продвижения. Владельцу «сайта-копии» было предложено внести изменения и отправить сайт на повторную индексацию.

Результат: эксперимент показал, что новый сайт действительно может вытолкнуть существующий сайт из поисковой выдачи, скопировав его контент и проставив на свою копию ссылки с авторитетных доменов. Однако это работает очень недолго и чревато баном в поисковой системе; таким образом оптимизировать страницы не стоит.

6. Значение кнопки Google +1

Суть эксперимента: в прошлом году компания Google представила функцию «Search Plus My World», повысив влияние Google+ на результаты поиска. Но как именно влияет +1 на позиции ваших страниц?

Для эксперимента исследователи выбрали три запроса, измерили результаты, щёлкнули +1 и проверили изменения в поисковой выдаче.

Результат: в одном случае страница с пятой позиции перешла на третью, в другом — с седьмой на шестую, в третьем случае никаких изменений не было.

Исследователи пришли к выводу, что помимо самого факта щелчка +1 значение имеет и соответствие страницы запросу. Иными словами, чем выше релевантность страницы запросу, тем большее влияние оказывает +1.

7. Восстановление сайта после пессимизации

Суть эксперимента: если причины бана или существенного понижения в выдаче известны, насколько просто восстановить прежние позиции?

Падение трафика из Google началось 24 апреля 2012 года. Анализ показал, что порядка 11% обратных ссылок содержат переоптимизированный текст анкора и ведут с одного сайта, который, к счастью, контролировался самим оптимизатором.

Все 77 анкоров были переписаны так, чтобы выглядеть естественно. Примерно через 6 дней сайт снова появился в поисковой выдаче, но уже не на первом, а на втором месте.

Результат: восстановить позиции сайта после пессимизации можно, но это непростая задача, особенно если у вас нет возможности внести изменения в уже размещённые ссылки.

8. Тестирование нерекомендуемых методик продвижения

Суть эксперимента: маркетологи рекомендуют придерживаться исключительно «белых» методов продвижения, разрешённых Google. Но так ли это важно на самом деле?

Чтобы проверить утверждение, на сайт, держащийся на третьей позиции по определенному ключевому слову, было размещено множество спамных ссылок: 7000 ссылок на форумах, 45000 комментариев в блогах и 4000 ссылок в боковых панелях блогов.

Результат: потеря позиций произошла практически мгновенно. Менее чем за месяц сайт упал на 14-е место в выдаче по тому же ключевому слову.

9. Быстрое ранжирование нового сайта

Суть эксперимента: с введением алгоритма Penguin маленьким сайтам стало сложнее быстро наращивать позиции в сравнении со старыми, авторитетными сайтами. Насколько реально быстро поднять позиции нового сайта по некоторому ключевому слову?

В порядке эксперимента на некоторый новый сайт были размещены ссылки с авторитетных интернет-площадок. При этом в анкоре фигурировала не только искомая ключевая фраза, но и похожие по смыслу фразы, а сами ссылки были «размазаны» по множеству доменов.

Результат: менее чем через два месяца после начала оптимизированного эксперимента сайт вышел на четвертую позицию по заданному ключевому слову. Таким образом даже после введения новых алгоритмов совершенно новый сайт может быстро набрать вес, используя грамотные методики продвижения.

10. Как найти ссылки на страницы, которыми вы не управляете

Суть эксперимента: при использовании Google Webmaster Tools можно посмотреть обратные ссылки на свои страницы. Можно ли «добавить» страницы конкурента?

Для этого экспериментатор разместил у себя полные копии страниц другого сайта и дождался их индексации.

Результат: Google посчитал скопированные страницы легитимными копиями «каноничных» страниц, а поскольку у дубликатов нет своих входящих ссылок, то в GWT остался список ссылок с других сайтов на «каноничные» страницы. Стоит, однако, учитывать, что этот способ относится скорее к серым методам, и потому рекомендовать его нельзя.

11. Влияние разнообразного текста анкоров на ранжирование

Суть эксперимента: алгоритм Penguin затронул немало сайтов, на которые были проставлены ссылки с одинаковым текстом анкора. Задачей эксперимента было проверить, как сказывается на ранжировании использование варьирующегося текста.

В порядке эксперимента был создан новый сайт на WordPress с шестью статьями, посвящёнными кредитному статусу. Затем была написана серия гостевых постингов с обратными ссылками, содержащими вариации основной ключевой фразы.

Результат: спустя 53 дня после начала эксперимента по основному запросу «650 credit score» сайт поднялся до четвертой позиции в Google. На момент публикации исследования он перемещался между второй и четвёртой позициями.

12. Действительно ли бесполезны ссылки с аттрибутом nofollow?

Суть эксперимента: широко распространённое мнение гласит, что при наборе ссылочной массы надо опираться на обычные ссылки без атрибута rel=»nofollow», иначе эти ссылки будут проигнорированы. Но действительно ли ссылки с nofollow бесполезны?

Исследователи проверили это утверждение на нескольких новых сайтах, ссылки на которые проставлялись с атрибутом rel=»nofollow» в течение пяти недель.

Результат: удивительно, но за этот период рейтинг рос прямо пропорционально увеличению числа обратных ссылок. Несмотря на то, что все эти ссылки содержали указанный атрибут и, скорее всего, по этой причине передавали меньший вес, они всё же учитывались при ранжировании.

13. Действенность инструмента отклонения ссылок в Google Webmaster Tools

Суть эксперимента: мало кому понравилось бы получить от Google предупреждение о том, что на сайт ведёт слишком много спамных ссылок. К счастью, компания создала инструмент дезавуирования обратных ссылок. В рамках эксперимента исследователи проверили, насколько хорошо он справляется с задачей восстановления репутации сайта в глазах поисковика.

Результат: порядка 96% некачественных обратных ссылок удалось снять. Вскоре после этого доступность сайта в Google была восстановлена, а трафик к моменту публикации исследования вернулся на отметку примерно в 50% от прежнего уровня.

14. Соседство текста анкора в сссылках

Суть эксперимента: текст анкора в ссылках несомненно влияет на ранжирование, но как насчет окружающих элементов? Будет ли страница ранжироваться лучше в зависимости от того, где будет помещена ссылка — внутри абзаца текста, рядом с изображением, или просто на пустой странице?

В рамках эксперимента было создано несколько новых доменов, на которые были проставлены четыре типа обратных ссылок:

- анкор с точной ключевой фразой на пустой странице;

- анкор с точной ключевой фразой внутри текста;

- ссылка с картинки, в атрибуте alt которой прописана точная ключевая фраза;

- текст, содержащий ключевую фразу перед ссылкой с текстом «click me».

Результат: судя по результатам, размещение ссылки действительно имеет значение. Ссылки на пустых страницах едва передавали вес, ссылки внутри текста работали хорошо, а ссылки с картинок — лучше всех.

15. Ссылки в пресс-релизах

Суть эксперимента: нередко можно услышать, что эра пресс-релизов закончилась, и ссылки в них не имеют веса. Так ли это на самом деле?

В порядке эксперимента был написан пресс-релиз с уникальной ключевой фразой в анкоре и ссылкой на блог Мэтта Каттса.

Результат: через три дня после публикации пресс-релиза сайт занял третье место в выдаче по ключевой фразе в анкоре.

16. Насколько внутренняя оптимизация сайта может увеличить поисковый трафик

Суть эксперимента: у любого крупного сайта со временем накапливаются ошибки, приводящие к потере поискового трафика. Это и дубликаты контента, и некорректная карта сайта, и неудачно подобранные тэги статей. Как сильно всё это сказывается на посещаемости?

Результат: внутренние изменения (удаление дублирующегося контента, обеспечение корректной индексации, оптимизация кода страниц, перелинковка с другими веб-проектами компании) на популярном сайте TechCrunch привели к удвоению трафика из поисковых систем и общему увеличению трафика на 30%. Этот результат ярко свидетельствует о том, насколько важна грамотная on-site оптимизация.

Материал статьи основан на публикации «Top 31 SEO Experiments You Want To Know About» Mikhail Tuknov.

www.ashmanov.com

Игорь Ашманов о голосовом помощнике «Алиса» – статьи про интернет-маркетинг

Где-то полтора-два года назад начался довольно серьезный бум так называемых чат-ботов. Под чат-ботами, конечно, понимались виртуальные собеседники, которые человечество пытается сделать примерно последние 30-40 лет.

В этот раз хайп, то есть шум, вокруг них возник потому, что были сделаны платформы, на которых удобно хостить и разрабатывать этих чат-ботов, а не потому, что появились новые технологии. Одновременно начали появляться голосовые помощники для мобильных телефонов и устройства типа колонки Alexa.

Единственное, что отличало эту волну виртуальных собеседников от предыдущих (их было пять или шесть) — это то, что с помощью нейронных сетей научились распознавать голос. Сейчас с ними можно нормально разговаривать, потому что хорошо заработаны технологии распознавания голоса.

Почему я это комментирую

Я сам занимаюсь искусственным интеллектом примерно с 87 года, то есть тридцать лет. Начинал я в вычислительном центре Академии Наук как раз с систем общения на естественном языке. Последние 12 лет у меня есть компания «Наносемантика», которая занимается как раз разработкой виртуальных собеседников. Мы их всегда называли «инфами», а не ботами, потому что мы считаем, что это понятие — информационный эльф, инф — немного шире, чем чат-бот, которыми сейчас все занимаются.

Я хотел прокомментировать выпуск Яндексом так называемой «Алисы». Я так понимаю, что Яндекс планирует выпустить и устройство, которое будет разговаривать, аналог говорящей колонки от Амазона под названием Alexa. Но пока это просто голосовой помощник и, фактически, разъем к поиску, голосовой поиск. Такой же есть у Google, естественно. Он ее довольно часто рекламирует — «Ок, google». Что про них можно сказать?

Немного истории

Первый виртуальный собеседник появился в США. Его сделал Джозеф Вейценбаум больше 30 лет назад. Он назвал его «Элиза». Это был виртуальный психотерапевт, который просто переиначивал ваши реплики, превращал их в вопросы. Довольно простая штука. Особенно просто ее было сделать потому, что английский язык несложен с точки зрения изменения слов.

Тем не менее, эта Элиза вызвала совершенно чудовищный ажиотаж в Америке. СМИ начали писать, что вот изобретен наконец искусственный разум. Там были мнения, что мы же очень больная нация, нам не хватает психотерапевтов, у людей не хватает денег на них — а теперь мы можем сделать 100 тысяч психотерапевтов, миллион психотерапевтов, и вылечить всю нацию.

Джозефа Вейценбаума эта реакция совершенно поразила, потому что это был простой код. И код был открыт, он его показывал другим, и было понятно, что там нет никакого разума. Тем не менее, люди отказывались в это верить. Он, например, застукал свою собственную секретаршу, которая разговаривала с этой самой Элизой. Когда Джозеф вошел в комнату, она начала закрывать экран, краснеть и говорить, что он нарушает ее приватность, потому что в этот момент она рассказывала про свои отношения с отцом.

Джозеф по этому поводу написал книгу «Возможности вычислительных машин и человеческий разум», где он попытался объяснить людям, что проблема не в том, хорошо ли работает искусственный интеллект — проблема в том, что нельзя ему передавать ответственность. То есть передавать ему право решать, или лечить, или судить, или присуждать штрафы и так далее.

Надо понимать, что современные виртуальные собеседники как бы наследуют Элизе, поэтому, как я думаю, виртуальный собеседник от Яндекса называется Алиса, а у Амазона — Alexa и так далее. То есть, они как бы продолжают дело Вейценбаума, но, к сожалению, с тех пор все забыли о том, что можно отдавать машине, а что нет. И сейчас нам новые евангелисты искусственного интеллекта рассказывают, что скоро мы все отдадим машинам, а сами будем жить на безусловном базовом доходе.

Недостатки современных голосовых помощников

Надо сказать, что некоторые функции сейчас успешно имитируются, например, распознавание лиц, предметов и так далее. Но разговор на естественном языке и прочие лингвистические функции имитируются пока не слишком хорошо. Вообще в прикладной лингвистике, то есть в обработке естественного языка, есть такие две вершины, условно говоря, Эверест и К-2: это машинный перевод и общение на естественном языке.

Машинный перевод наконец хоть немного заработал. До последнего года он был очень плохой, несмотря на то, что и Google, и Яндекс им занимались последние 10 лет. Но применение нейронных сетей сейчас позволило его улучшить, он стал гораздо более гладким.

С диалогом на естественном языке так не получается. Возьмем, допустим, Алису. Что мы про нее можем рассказать?

Стандартные шаблоны

Если вы посмотрите внимательно, то увидите, что в есть какое-то количество шаблонов, которые занесены вручную, запрограммированы. Это касается самой Алисы: когда она отвечает, сколько ей лет, кто она такая и так далее. Есть некоторое количество шаблонов реагирования на мат, на оскорбления. Такие вещи все равно приходится делать руками, и от этого никуда уйти нельзя, потому что реакция должна быть предопределенной.

Все остальное вроде бы разработчики рассчитывают сделать с помощью обучения нейронной сети, на примерах диалогов. Что вы видите, когда общаетесь с Алисой? Это, на самом деле, можно сказать и про Siri, и про Alexa, голосовую колонку от Amazon.

Шаблонов мало. Чуть-чуть в сторону — и собеседник тебя не понимает.

Нет модели собеседника

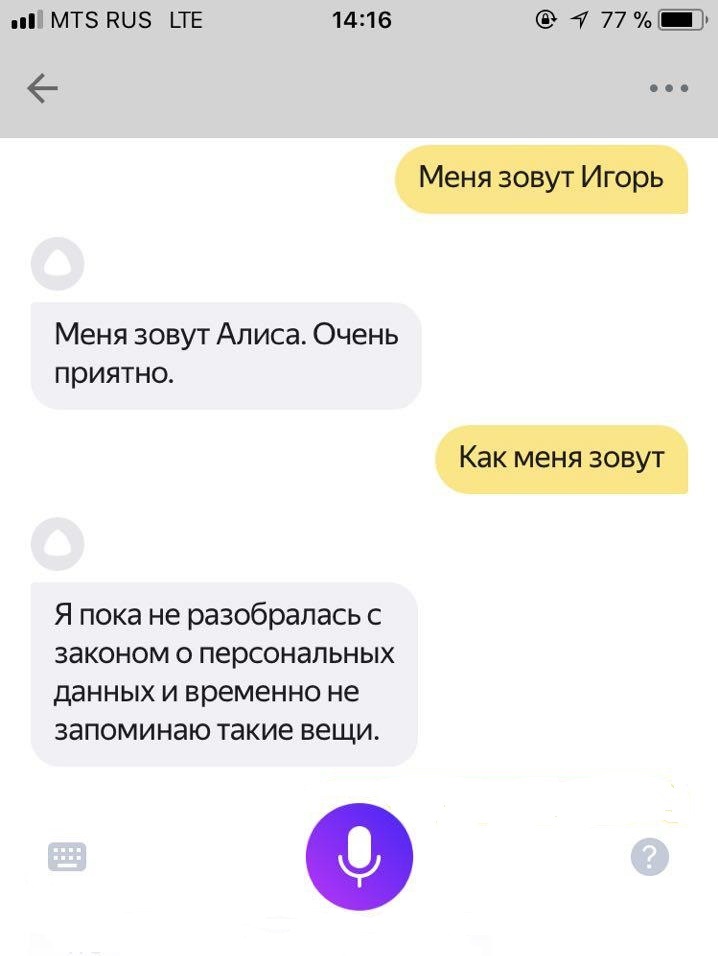

У Алисы нет модели пользователя, она не запоминает даже имя. Например, если сказать Алисе, что меня зовут так-то, и потом спросить как меня зовут — она начнет отговариваться тем, что не запоминает персональные данные.

Кроме того, там нет модели самой Алисы, насколько я могу понять. То есть надо понимать, что виртуальный собеседник такого масштаба, который так рекламируется — это медийный проект. Для него нужен сценарист, продюсер и так далее. Похоже, этих людей не нанимали.

То есть у Алисы, например, нет персонажа. Его не удается увидеть. У нее нет ни характера, ни каких-то особенностей.

Кроме того, конечно, база данных диалогов, по которым учили эти нейронные сети, была, похоже, небольшой. Возможно, разработчики рассчитывали, что они должны раздать сначала этого виртуального собеседника, а потом он обучится на тех диалогах, которые будут с ним вести люди. На самом деле, у меня, как у разработчика таких систем, есть серьезные сомнения, что нейронные сети могут позволить всерьез научиться диалогам. Там есть огромный разрыв по количеству информации между тем, что может спросить человек, и тем, что есть в реальных диалогах. Всегда этот разрыв будет, поэтому научиться будущим вопросам в общем нельзя; то есть, это значит, что нужно программировать также сценарии диалогов.

Глубина диалога равна единице

У Алисы, как вы сами могли заметить, глубина диалога в среднем равна единице, то есть она отвечает репликой на реплику. Она не запоминает что было, не использует параметры из предыдущих реплик для того, чтобы сформировать следующую реплику и так далее.

Я думаю, что это, в частности, потому, что разработчикам кажется это зазорным; они считают, что нейронные сети все сделают за них. Делать что-то руками в Яндексе вообще, как правило, считается зазорным. Мы знаем, что они руками не регулируют обработку запросов и так далее. Все должен делать искусственный интеллект. Здесь та же самая история.

Общий эффект этого таков, что получилось довольно тупое существо, которое, в общем, не отвечает на большинство вопросов, но имеет некоторое количество функций.

Например, можно спросить, какое сегодня число. Если спросишь, какой сегодня месяц, Алиса уже не понимает. Точнее, она тебе снова сообщает, какое сегодня число. Если спросить какой сегодня год, она опять же не понимает этого, или, в крайнем случае, скажет тебе опять, что сегодня понедельник такое-то число месяца.

Главная проблема голосовых помощников

Почему так происходит? Во-первых, как я уже сказал, этот проект нужно было делать как медийный, но основная проблема не в этом. Дело в том, что есть две разные постановки задачи для информационного помощника.

Вы можете делать именно помощника, который вам помогает выполнять какие-то функции на компьютере. Это значит, что эти функции вам все равно придется запрограммировать, и нейронная сеть не поможет это сделать. Например, этот помощник может там организовывать что-то на вашем компьютере или заказывать билеты (как нам обычно рассказывают евангелисты искусственного интеллекта) и так далее.

Проблема в том, что, во-первых, таких функций не может быть очень много. А во-вторых, неизвестно, нужны ли они людям.

Помощник на экране человеку в принципе не нужен. Очень мало кто хочет смотреть в экран и разговаривать с ним: это неудобно делать в публичных помещениях или в офисе, это странно делать даже в семье. Кроме того, на экране есть кнопки, и нажимать их гораздо быстрее, чем разговаривать.

То есть, если мы задумаемся, где вообще применимы информационные помощники, то выбор окажется ограниченным: это те места, где у человека руки заняты и можно захватить голосовой канал, например, в автомобиле, или, например, при звонке по телефону в колл-центр. Там, где уже гораздо проще говорить голосом, чем наоборот, нажимать кнопки (нажмите один, нажмите два и так далее).

То есть сами применения голосового помощника оказываются довольно узкими, и это показывает обычно время удержания внимания этим самым голосовым помощником. На самом деле, мало об этом пишут, но и у Siri, и у любых таких приложений от частных игроков, от сторонних компаний, удержание внимания — примерно сутки. Это проблема не Алисы, а постановки задачи.

Информационный помощник в общем-то — это ложная постановка задачи. Он похоже не очень нужен. Я могу ошибаться, но я над этим долго размышлял.

Не помощник, а компаньон

А что же тогда нужно? Похоже, что людям в смысле голосового общения с компьютером (и текстового, то есть на естественном языке), нужен личный компаньон, с которым можно много о чем поговорить. Скорее всего, он нужен не всем. Он буден полезен детям (условно говоря, с 4-5 до 13-14 лет) и пожилым людям. Этот персонаж должен быть очень умным, он должен уметь поддерживать разговор на довольно широкие темы. Он не должен быть просто разъемом поисковой машины.

Сделать такого помощника гораздо труднее. Именно поэтому таких пока не появилось ни одного. Сейчас, скажем, говорящая колонка от Амазона Alexa имеет много функций, но, естественно, ее основное предназначение — помогать в покупках на Амазоне. Для этого ее и выпускали. Она может выполнять много разных функций, но свободный диалог поддерживать не сможет.

При этом лично у меня есть опыт создания инфов или чат-ботов, которые поддерживают свободный диалог. Мы делаем их последние 12, наверное, лет, и там очень интересные эффекты: людям реально хочется общаться, даже если они знают, что с ними разговаривает робот.

Самые большие сессии, которые у нас были, когда мы своих инфов ставили в мессенджеры, составляли примерно полторы тысячи реплик. Это означает, что человек разговаривал с этим виртуальным собеседникам весь день, не переставая. Представьте себе, что такое полторы тысячи реплик — это 12-15 часов разговора. Это значит, что человека затягивает именно сам процесс общения, сама метафора общения — даже если человек знает, что общается с роботом. А современный информационный помощник «не цепляет». Этот «хайп» вокруг чат-ботов начинает спадать, и это понятно: сделать хорошо говорящего чат-бота оказалось сложно. Платформы есть, а сделать невозможно, слишком много работы.

Эйфория о том, что мы сейчас сделаем таких помощников, скорее всего, закончится тем, что на рынке останется несколько компаний, которые в это очень серьезно вложились, а остальные переключатся на то, чтобы заниматься чем-то другим.

Я думаю, что перспективы голосовых помощников таковы.

Приложения на телефонах умрут, ими никто не будет пользоваться.

Распознавание речи будет встроено практически в любое устройство, которое в состоянии эту речь принять и обработать, там, где есть узкая предметная область (в чайник, стиральную машину, микроволновку и так далее). Большинство людей не читают инструкцию, и используют обычно несколько процентов функциональности своих устройств. Если туда встроить голосового помощника, устройство можно будет использовать эффективнее. Там все будет прекрасно работать, потому что распознавание речи уже работает, а в узкой предметной области можно запрограммировать понимание довольно полно. Голосовые помощники будут и в банкоматах, и в торговых центрах, и так далее.

Голосовые помощники будут везде, где есть массовое обслуживание. «Наносемантика» продает своих инфов в крупные компании для оказания технической поддержки или приема заказов, это и будет продолжаться и развиваться. В скором времени на входе в очень крупные сервисы вас будет встречать механическая женщина, которая будет вас расспрашивать, что вам нужно, и проводить вас по тем же примерно деревьям выбора, по которым сейчас проводят IVR.

В конце концов, конечно, будет сделан домашний компаньон, товарищ ребенка, который примерно его уровня по развитию интеллекта, но гораздо более начитанный. У него будет доступ в википедию, в поисковики, к курсам, он сможет научить английскому и так далее. И самое главное, сможет поддерживать естественный свободный диалог на обычном языке. Сделать это будет непросто. Я думаю, что до появления таких домашних помощников, которые свободно разговаривают, остается примерно года два-три. Кстати говоря, я не уверен, что там для этого будут применяться нейронные сети.

www.ashmanov.com