Панда, Пингвин и Колибри – убийцы авторитетов

Многие СЕО-оптимизаторы давно уже знают о таких алгоритмах Google, как Панда, Пингвин и Колибри. Кто-то и сам пострадал от них, кому-то удалось успешно избежать их действия.

Но большинство новичков, которые стремятся раскрутить свои сайты в поисковых системах, совершенно неправильно понимают, на что конкретно направлены удары этих алгоритмов.

Есть немалая часть вебмастеров, которые вообще не учитывают их при создании сайтов. А вместе с тем, хотя разрушительное действие Панды, Пингвина и Колибри косит каждый день множество сайтов, обойти их не так уж и трудно, если правильно во всем разобраться и правильно всё сделать.

Вообще-то принципы, по которым эти алгоритмы действуют, не такие уж и новые, просто появление их позволило значительно упорядочить борьбу Гугла с не качественными (на его взгляд) сайтами, и проводить очистку выдачи более результативно.

Итак, приступим к рассмотрению.

Поисковый алгоритм Google — Панда

Самый первый из этой троицы (2011 г.), и самый, на взгляд новичков, страшный. В принципе, поисковый алгоритм Панда страшный не для самих новичков, а для их небрежного отношения к создаваемым сайтам.

Конечно, каждый вебмастер – полный хозяин своего веб-сайта, как он хочет, так его и создаёт, и тут ему никакой Гугл не указ. Однако не следует забывать, что и Гугл – полный хозяин своей выдачи, и какие сайты хочет – те в свою выдачу и пускает, а какие не хочет – не пускает. Для этого используются поисковые алгоритмы Google.

Панда явилась самым первым инструментом протеста поисковых систем против ошибок и небрежностей не только новичков, но и против разгильдяйского отношения к поисковым системам (и к своим собственным проектам в том числе) со стороны всяких «авторитетов». Дело в том, что очень многие крупные сайты, в основном коммерческие – магазины, сервисы, справочники и им подобные — допускают создание страниц с похожим контентом.

В основном это описание товаров или услуг, сходных по основным параметрам, но различающихся только некоторыми мелкими деталями, например:

- размером;

- цветом;

- ценой и т. п.

Основной контент, таким образом, на таких страницах одинаковый, часто схожесть достигает 90 и больше процентов. Со временем на сайте накапливается очень большое количество страниц-клонов. Конечно, посетителям это никак не мешает, но выдача поисковых систем буквально засоряется однотипными веб-документами.

До того, как был введен алгоритм Панда, Гугл просто «склеивал» такие дубли, то есть в выдачу пускал только одну из них, а остальную помещал в категорию «дополнительные результаты». Но, как говорится, всё хорошо до поры до времени и появились новые поисковые алгоритмы google. И наступил момент, когда даже «дополнительные результаты» не могли улучшить картину.

Алгоритм Панда направлен на поиск и выявление таких веб-страниц, определение допустимого их количества и принятие мер к проектам, на которых количество таких страниц слишком чрезмерно.

Как только алгоритм Панда начал действовать в полную силу, очень многие авторитетные сайты послетали со своих «вкусных» позиций в топах выдачи, и, соответственно, очень сильно «просели» по трафику.

Конечно, владельцы этих веб-сайтов, разобравшись в причинах такой катастрофы (изучив новые алгоритмы Google), постарались как можно быстрее исправить положение, но назад на «хлебные места» вернулись далеко не все. Их места заняли более удачливые конкуренты, которые вовремя среагировали на поисковые алгоритмы google, или вообще не нарушали новоявленных правил изначально.

Алгоритм Google: Пингвин

Следующий алгоритм – Пингвин (2012 г.) – нацелен совершенно на другие сферы, и не касается сайтов непосредственно, а бьёт их только косвенно – по ссылочной массе. Многие вебмастера и даже достаточно опытные СЕО-оптимизаторы до недавнего времени очень небрежно относились к ссылкам, которые они приобретали на свои сайты с чужих веб-ресурсов. И когда было объявлено, что новый алгоритм (Пингвин) будет разбираться со ссылочным ранжированием, основная масса владельцев «авторитетных» сайтов практически не придала этому значения.

Конечно, и задолго до появления Пингвина было известно, что поисковые системы очень негативно относятся к покупным ссылкам, и всячески ведут борьбу с нарушителями. Наиболее здравомыслящие вебмастера не связывались со ссылочными биржами, и приобретали ссылки, так сказать, в частном порядке, полагая, что раз их невозможно связать с биржами, то и не последует никакого наказания.

Однако они не учли того, что многие сайты-доноры сами являлись покупателями ссылок, и большая часть их «засыпалась», когда Пингвин начал активно действовать. Естественно, все ссылки, ведущие с этих сайтов, исчезли, и «третьи» сайты попросту лишились значительной части своей ссылочной массы.

А когда сайт лишается части ссылочной массы, то, естественно, он проседает в выдаче и теряет заметную часть своего трафика.

Кто-то из не разобравшихся в ситуации владельцев посчитал это как наказание за несуществующие прегрешения. Однако в итоге оказалось, что никаким наказанием тут и не пахнет. Наказанными были те сайты, причастность к закупке ссылок которых удалось доказать. А те сайты, которые, в свою очередь, были связаны с ними ссылками, просто «оказались не в том месте и не в то время».

Таким образом мы видим, что алгоритм Колибри «накрыл» огромный сегмент выдачи Гугла, связанный с закупкой ссылок. А потому он оказался гораздо эффективнее «точечных» ударов – теперь практически все сайты интернета, которые свой трафик (и доходы вместе с ним) получают из выдачи Гугла, то есть зависят от этой поисковой системы, будут внимательно следить за своей ссылочной массой и стараться избегать получения ссылок с сайтов, насчет которых имеется хотя бы малкйшее подозрение, что они свои ссылки, в свою очередь покупают на биржах.

Кто-то, конечно, проклинает Гугл, обвиняя его в нечестной игре, но не следует забывать о том, что, во-первых, Гугл никогда не играет нечестно – этого ему не позволяют ни американская мораль, ни американские законы, а во-вторых, ничего более эффективного в борьбе против эпидемии покупных ссылок пока еще никто не изобрел.

Алгоритм Гугл: Колибри

Третий алгоритм, который очень сильно ударил по множеству сайтов – это Колибри, появившийся в 2013-м году

Очень многие пользователи Гугла при поиске нужной информации вводят в строку поиска «упрощенные», или «неправильные» запросы, например, «трусы купить где», «отдых таиланд» или «ресторан новосибирск», а кто-то вообще допускает в запросах множество ошибок.

Конечно, Гугл «подгоняет» к таким запросам наиболее релевантные им страницы сайтов, на которых, естественно, запросы в таком «неправильном» виде не встречаются, но зато логически отвечают им более полно.

Вроде бы что тут такого? Но дело в том, что все запросы, вводимые в строку поиска, Гугл сохраняет в своей базе, а этой базой постоянно пользуются дорвейщики и производители «клоачных» сайтов. Как правило, с помощью автоматизированных средств они «затачивают» страницы своих «произведений» под такие «неправильные» запросы, и тем самым сразу же выдают себя с потрохами.

Индексирующие роботы, анализируя содержимое страниц сайтов, постоянно сверяются с ключевой базой Гугла, и если таких «неправильных» фраз на страницах слишком много, то весь сайт попадает под подозрение.

Кто-то даже упускает из виду, что Гугл обращает внимание даже на то, с какой буквы начинаются имена собственные или географические названия – с большой или с маленькой. Ну, если кто-то пишет текст и пару раз неправильно напишет имя или название, то это не страшно. Но если название городов или имена людей на всем сайте – с маленькой буквы, то это уже сигнал не совсем (или совсем не) качественного сайта.

Итог анализа алгоритмов Google

Итак, мы рассмотрели три самых главных алгоритма Гугла, которые сообща охватывают очень важные сферы создания и продвижения веб-ресурсов. Все они стоят на страже дела улучшения качества веб-контента. Конечно, есть множество умельцев, которые очень успешно обходят все эти алгоритмы и продолжают наполнять выдачу Гугла некачественными сайтами, но это уже не тот объём, который был до появления Панды, Пингвина и Колибри.

Можно ожидать, что эти алгоритмы со временем будут усовершенствоваться, будут появляться более мощные их модификации. Потому лучше всего сразу нацелиться на честную работу и не допускать досадных оплошностей, которые в итоге могут существенно навредить вашему веб-детищу, с помощью которого вы собрались покорять топы выдачи Гугла!

защищаем сайт от Google Penguin (Пингвин)

На конференции SMX Advanced (которая прошла 2-3 июня 2015) Гарри Илш сообщил о том, что в скором времени алгоритм Пингвин будет обновляться в режиме реального времени.

Напомню, что Google Penguin (Пингвин) направлен на борьбу с неестественными внешними ссылками.

С декабря 2014 года алгоритм работает в режиме реального времени, но обновляется вручную, в среднем раз в год. Последнее серьезное обновление Пингвин 3.0 было еще в октябре 2014, тогда пострадало огромное количество сайтов.

Гарри Илш сообщил, что предположительно до конца лета алгоритм перейдет полностью на автоматическое обновление и будет работать в режиме реального времени.

Признаки Пингвина:

- позиции проседают на 30-50 пунктов;

- резко падает трафик из Google.

Как защитить свой сайт от Пингвина?

Как известно, Пингвин наказывает за спамные ссылки. Поэтому, если продвигаете сайт ссылками, в первую очередь нужно проанализировать все входящие ссылки на сайт и найти среди них спамные.

О том, как отличить спамную ссылку от естественной, мы уже писали – рекомендую прочитать статью, чуть позже эти знания нам пригодятся.

Проводим анализ ссылочного профиля самостоятельно

Кстати, провести подобный аудит будет полезно любому сайту, даже если вы уверены, что никакие «Минусински» и Пингвины вам не страшны.

Итак, в помощь нам сервисы:

- ahrefs.com

- majesticseo.com

- linkpad.ru

- Google Webmaster и Яндекс.Вебмастер

- moz.com/researchtools/ose/

- xseo.in

Анализируем свой сайт с помощью данных инструментов, смотрим на:

- Общее число ссылок

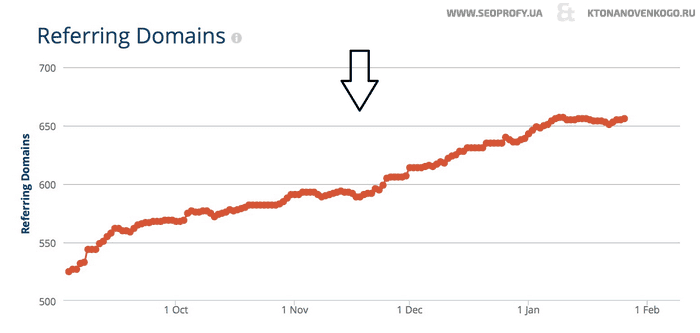

- Динамика должна быть постоянной и положительной. Скриншот с сервиса linkpad.ru:

Если видим обратную картину – ссылки снимаются массово, значит, получены были неестественным путем. Думаем, как это исправить, ибо Google любит положительную динамику.

- Прирост ссылок постепенный, без скачков. Доноров до 900, если больше, то ваш сайт может оказаться в зоне риска «Минусинска» (Яндекса), дальше нужно смотреть с оглядкой на Яндекс.

- Количество ссылающихся доменов и ссылающихся доноров должно быть примерно одинаковым, если есть сильные перекосы, то, скорее всего, на ваш сайт есть сквозные ссылки (то есть они стоят со всех страниц ссылающегося сайта), много таких ссылок быть не должно, Google их не жалует. По возможности закройте их в nofollow и уберите из них коммерческий анкор.

- Динамика должна быть постоянной и положительной. Скриншот с сервиса linkpad.ru:

- Качество ссылающихся ресурсов (доноров)

Если вы поленились и до сих пор не прочитали статью о том, что такое SEO-ссылки, которую я рекомендовала выше, сейчас ее уже просто необходимо прочитать, так как пришло время искать эти самые ссылки у себя.

- Смотрим, какие сайты ссылаются и на какие страницы.

Откройте несколько ссылающихся ресурсов выборочно, посмотрите, что это за сайты, какой тематики, насколько они качественные. Скриншот из веб-мастера Google:

В идеале ссылаться должны на все страницы сайта, а не только на главную. Продвигайте весь сайт одновременно!

- Где и как размещена ссылка. Откройте несколько сайтов-доноров. Скриншот с сервиса linkpad.ru:

Посмотрите, где размещена ссылка на ваш сайт. Лучше, если она будет стоять в тексте, а не в подвале; если страница, где размещена ссылка, будет соответствовать вашей тематике; ссылок на другие сайты с этой страницы не будет.

- В сервисе ahrefs.com смотрим на ссылающиеся подсети:

Посмотрите на сайты разных сетей, поищите некачественные сети со спамными ссылками, скорее всего, некачественные ссылки будут у всей сети. Так можно легко найти некачественные ссылки всей сети и убрать их.

- Смотрим, какие сайты ссылаются и на какие страницы.

- Анализируем анкоры

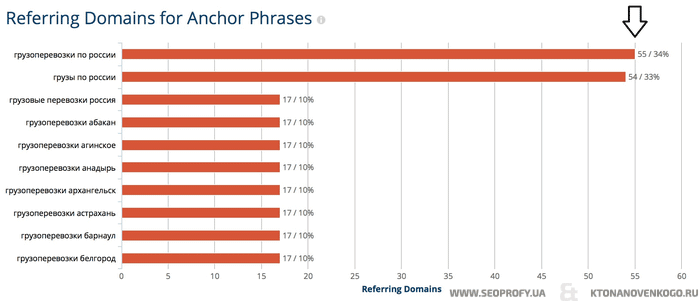

Самый главный сигнал, который провоцирует наложение Пингвина – заспамленность анкор-листа. Данному пункту уделите особое внимание! Смотрим список анкоров:

Скриншот сервиса ru.ahrefs.com:

Скриншот сервиса linkpad.ru:

Если на ваш сайт ведут ссылки со слов, включающих только коммерческие запросы с прямым вхождением ключа: «туры в Болгарию 2015», «купить пластиковое окно», «железные двери цены» и т. п. (т.е. те слова, которые человек вбивает в строку поиска, когда хочет что-то купить или заказать), значит, пора менять стратегию, иначе Пингвина не миновать.

Прямое вхождение – это, конечно, мощный фактор ранжирования, но и основание для поисковых систем присмотреться к вашему сайту, поэтому все должно быть в меру. Список анкоров делайте максимально разнообразным, с упором на брендовые запросы.

О том, какими в идеале должны быть ссылки по характеру, из каких источников, в каком соотношении, мы уже тоже писали – читайте по ссылке.

Что делать, если на моем сайте спамные ссылки?

Если нашли спамные ссылки – постарайтесь заменить их на естественные или отклоните с помощью специального инструмента от Google. Google веб-мастер – вообще очень хороший инструмент, например, он может показать, были ли наложены санкции «вручную», в том числе Пингвин:

Правда, Пингвин может быть наложен и в автоматическом режиме. Узнать, применен ли к сайту Пингвин можно в статье «Кто виноват – Пингвин или Панда?»

Итоги: кому стоит бояться Пингвина?

Как правило, Пингвин налагается за:

- прямые анкоры;

- отрицательную динамику;

- низкое качество ссылок.

В первую очередь проверяйте это.

Если сомневаетесь в качестве ссылок или покупаете ссылки, лучше закрывайте их в nofollow (о том, как работает nofollow, написано тут).

Успехов в продвижении сайта! Если остались вопросы, пишите в комментариях.

Или заказывайте комплексное продвижение сайта у нас – мы за белые методы, экологическое SEO и безопасные ссылки =) Подарки от нас и партнеров к каждому заказу!

Что такое алгоритмы Панда, Пингвин, Колибри (перевод moz.com)

Если Вы давно читаете блог Moz, то у Вас, вероятно, есть хорошее понимание Google и изменений его алгоритмов. Но существует большой процент клиентов, которые до сих пор путаются в возможных эффектах, которые Panda, Пингвин и Колибри могут оказать на Ваш сайт. Я писал в прошлом году о главных различиях между Пингвином и ручными санкциями Google, если вы ее не читали, данная статья будет вам полезна.

Цель этой статьи — объяснить на пальцах, для чего каждый из этих алгоритмов предназначены. Надеюсь, это хороший материал, который Вы можете показать своим клиентам, если Вы хотите объяснить изменение алгоритма и не нагружать их техническими деталями вроде 301 редиректа, тегов canonicals, ошибки сканирования и другой запутанной терминологией SEO.

Что такое апдейт алгоритма?

Прежде всего, давайте начнем с обсуждения алгоритме Google. Сейчас они чрезвычайно сложные и продолжает усложняться, как Google делает все возможное, чтобы предоставлять поисковикам информацию, которая им нужна На заре становления поисковых систем сео- специалисты могли легко найти способы заставить поисковую систему думать, что сайт их клиента был тем, который должен занять высокое место. В некоторых случаях это было очень просто, достаточно включение некоторого кода веб-сайта, который называется Мета тег keywords. Мета-тег keywords бы сообщить поисковым системам, что страница была о:

Поскольку Google развился, его инженеры, которые прежде всего фокусировались на создании результатов поисковой системы, максимально полезных пользователям, продолжали работать над способами чтобы уберечь людей от обмана, и нашел другие способы, чтобы показать наиболее релевантные страницы в верхней части поиска. Алгоритм теперь учитывает сотни различных факторов. Есть некоторые, которые мы точно знаем, что они являются важными, таких как например информация в Заголовке браузера (между тегами <title></title> теги в коде.) И есть много других, которые влияние которых только предположительно и не доказано, например нажатие кнопки Google +1 может способствовать росту сайта в рейтинге.

В прошлом алгоритм Google изменялся очень нечасто. Если Ваш сайт находился в ТОП-1 для определенного ключевого слова, это гарантировано станется там до следующего обновления (апдейта), которых могло не быть в течение многих недель или месяцев. Затем происходило другое обновление, и позиции резко изменятся. Они будут оставаться до тех пор, пока не грядет очередное обновление. Если вам интересно, какие Google использовал алгоритмы для передачи обновлений из своего индекса в 2002 году, вы можете прочитать на форуме эту запись.

Все изменилось с запуском алгоритма «Кофеин» в 2010 году. Благодаря новому алгоритму индексации, результатах поиска меняется несколько раз в день, а не каждые несколько недель. Спустя год Google передает 600 изменений в своем алгоритме, причем о подавляющем большинстве их не объявляют. Но, когда Google вносит действительно большое изменение, они дают ему имя, делают заявление, и все в мире SEO сходят с ума, пытаясь выяснить, как объяснить эти изменения и использовать их в своих интересах.

Три самых больших изменений, которые произошли в последние несколько лет, называются алгоритмом Panda, алгоритмом Пингвина и Колибри.

Что такое алгоритм Панда?

Panda была впервые запущена 23 февраля 2011 года. Это было гран диозное меропредприятие. Целью Панды была попытка показать высококачественные сайты выше в результатах поиска и понизить сайты, которые могут быть более низкого качества. Этот алгоритм вышел без названия, и специалисты между собой называли его «фермер» поскольку, алгоритм должен был повлиять на фермы контента. (Фермы Контента — это сайты, содержащие агрегированную информацию из многих источников, часто украденной с других сайтов, для того, чтобы создать большое количество страниц с единственной целью – высокое ранжирование в Google для различных ключевых слов. Такие сайты бесполезны для людей и служат лишь для заработка на рекламе)

диозное меропредприятие. Целью Панды была попытка показать высококачественные сайты выше в результатах поиска и понизить сайты, которые могут быть более низкого качества. Этот алгоритм вышел без названия, и специалисты между собой называли его «фермер» поскольку, алгоритм должен был повлиять на фермы контента. (Фермы Контента — это сайты, содержащие агрегированную информацию из многих источников, часто украденной с других сайтов, для того, чтобы создать большое количество страниц с единственной целью – высокое ранжирование в Google для различных ключевых слов. Такие сайты бесполезны для людей и служат лишь для заработка на рекламе)

Это изменение алгоритма было неназванным, когда оно сначала выходило, и многие из нас вызывали его обновление «Фермера», поскольку это, казалось, влияло на фермы содержания. (Фермы содержания — сайты, что совокупная информация из многих источников, часто крадя ту информацию от других сайтов, чтобы создать большие количества страниц с единственной целью занять место хорошо в Google для многих различных ключевых слов.) Алгоритм влиял на очень большое количество сайтов. Алгоритм изменения итоге был официально назван в честь одного из ее создателей, Нэвнита Пэнды (Navneet Panda).

Сразу после введения Panda, на многих SEOs форумах звучало, что этот алгоритм предназначался для фильтрации сайтов с неестественными (покупными) ссылками. Однако оказывается, что ссылки не учитываются алгоритмом Panda. Она включает в себя только качество сайта.

В большинстве случаев сайты, которые пострадали от панды попали под жесткие санкции. Но, я также видел сайтов, которые имели небольшие потери на дату обновления Panda. Panda, как правило, оценивает весь сайт, это означает, что алгоритм обнаружив на некоторых страницах факторы, попадающие под панду, фильтр не только может понизить некоторые страницы вашего сайта в результатах поиска — вместо этого, рассматривает весь сайт как ресурс более низкого качества. Хотя в некоторых случаях панда может повлиять только на раздел сайта, такие как новости, блог или одного конкретного поддомена.

Всякий раз, когда сотрудников Google спрашивают о том, что необходимо сделать чтобы оправиться от панда, они ссылаются на блог сотрудника Google Амит Сингхала, который дает контрольный список, который можно использовать на вашем сайте, чтобы определить, действительно ваш сайт высокого качества или нет. Вот список:

- Стали бы вы доверять информации, размещенной на вашем сайте?

- Есть ли на сайте страницы с дублированным или очень схожим контентом?

- Вы бы доверили данные вашей кредитной карточки подобному сайту?

- Содержатся ли в статьях орфографические или стилистические ошибки, опечатки?

- Статьи для сайта пишутся с учетом интересов читателей или же только с целью попасть в результаты поиска по определенным запросам?

- Есть ли на сайте оригинальный контент (исследования, отчеты, аналитика)?

- Выделяется ли ваш сайт среди конкурентов, которые выдаются вместе с ним на странице результатов поиска?

- Пользуется ли ваш сайт авторитетом в своей сфере?

- Уделяете ли вы должное внимание редактированию статей?

- Предоставляют ли статьи на сайте полные и информативные ответы на вопросы пользователей?

- Вы бы стали добавлять сайт/страницу в закладки или рекомендовать его друзьям?

- Могли бы вы встретить подобную статью в печатном журнале, книге или энциклопедии?

- Не отвлекает ли внимание читателей реклама на сайте?

- Уделяете ли вы внимание деталям при создании страниц?

Фух! Что ж. список весьма впечатляет! Эти пункты не обязательно означают, что Google может алгоритмически определить, являются ли ваши статьи полезны, или их никто не станет читать. Все эти факторы могут способствовать, чтобы понять, как в реальной жизни пользователи будут оценивать качество вашего сайта. Никто не знает всех факторов, которые Google использует для определения качества вашего сайта глазами панды. В конце концов, сосредоточиться на создании лучшего сайта удовлетворяющего требования пользователей. Важно и то, что только лучший материал хранит Google в индексе. Есть несколько факторов, на которые необходимо больше всего обратить внимание в отношении Panda:

Неполный (Недостаточный) контент.

В данном контексте термин «недостаточный» подразумевает, что контент на вашем сайте не представляет новизны или ценности для читателя, так как не раскрывает тему должным образом. И дело вовсе не в количестве символов, так как иногда даже пара предложений может нести немалую смысловую нагрузку и полностью раскрыть тему (но часто на страницах с очень небольшим количеством слов, не очень полезны). В любом случае, если большинство страниц вашего сайта будут содержать обрывки текста из нескольких предложений, Google сочтет его некачественным.

Дублированный контент

Панда посчитает ваш сайт некачественным в том случае, если большая часть его контента скопирована из других источников или если на сайте есть страницы с дублированным или схожим контентом. Например, если у вас есть блог, в который вы копипастите чужие статьи, он вероятно попадет под фильтр. Это распостраненная проблема Интернет-магазинов. Например, каждый продукт имеет отдельную страницу для каждого цвета и размера. Но, все эти страницы заполнены одинаковым описанием. Если один продукт поставляется в 20 различных цветов, и каждый представлен 6 разных размеров, то это означает, что у вас есть 120 страниц одного и того же продукта, все из которых почти идентичны для поисковых систем. А теперь представьте, что вы продаете 4000 товаров. Это означает, что вы получили почти полмиллиона страниц, тогда как важны индексировать Google только 4000 страниц. В такой ситуации для ршения этой проблемы нужно использовать тег canonical. МОЗ делал очень хорошее руководство по использованию тег canonical здесь, а также д-р Пит написал эту большую статью о использование тег canonical.

Низкокачественный контент

Google высоко ранжирует сайты, которые постоянно обновляются, поэтому многие оптимизаторы рекомендуют ежедневно публиковать новые материалы. Однако если вы будете публиковать некачественный контент, не представляющей ценности для пользователей, то такая тактика принесет больше вреда.

Например, допустим, я водопроводчик. Мне сказали, что я должен вести блоге регулярно, поэтому я несколько раз в неделю публикую статьи на 2-3 абзаца по теме «как исправить протекающей кран» или «как прочистить туалет.» Но я был занят и не имел много времени, чтобы наполнять мой веб-сайт, и поэтому в каждой статье которую я написал, содержатся ключевые слова в заголовке и несколько раз в содержании, но вот смысл не глубок, не раскрывает тему, и не в том, что нужно для читателей. Если большинство страниц на сайте содержат информацию, которая никого не привлекает, то это станет признаком низкого качества в глазах алгоритм Panda. Есть и другие факторы, которые, вероятно, работают в алгоритм Panda. Гленн Гейб недавно написал отличную статью по его оценке сайтов, подверженных воздействию последнего апдейта Panda. Вот и весь список атрибутов, которые необходимо улучшить, если вы стали жертвой Панды.

Как воостановить аозиции после Панды?

Google обновляет алгоритм Panda примерно раз в месяц. Google ежемесячно обновляет алгоритм Панда. После каждого обновления поисковые роботы пересматривают все сайты и проверяют их на соответствие установленным критериям. Если вы попали под фильтр Панда, после чего внесли изменения на сайте (изменили недостаточный, некачественный и неуникальный контент), позиции вашего сайта улучшатся после очередного обновления. Когда обновление происходит, это означает, что Google изменил критерии, которые они использовали, чтобы определить, что не считается высококачественным сайтом. 20 мая 2014 года компания Google сделала самое большое обновление алгоритма, которое они назвали Panda 4.0. Это вызвало изменение позиций множества сайтов, что явно показывает влияние Panda:

Не каждый апдейт Panda имеет такое сильное влияние. Но, если вы пострадали от Panda и вы будете усердно работать, чтобы исправить ошибки вашего сайта, вы скоро должны увидеть некоторое улучшение.

Что такое Google Пингвин ?

Алгоритм Google Пингвин был запущен 24 апреля 2012 года. В отличие от Панды, этот алгоритм нацелен на борьбу с неестественными обратными ссылками.

Авторитет и значимость сайта в глазах поисковых систем во многом зависит от того, какие сайты на него ссылаются. При этом одна ссылка с авторитетного источника может иметь такой же вес, как десятки ссылок с малоизвестных сайтов. Также важным в алгоритмах Google является анкорный текст. Анкорный текст — это текст, который указывается в ссылке. Так, в этой ссылке отличный SEO блог, анкорный текст это : «SEO блог.» Если эта страница сайта получает большое число сайтов со ссылками на них, используя фиксированный анкорный текст «SEO блог», то это сигнал для Google, что на поисковый запрос «SEO блог», следует показать сайт Moz в результатах поиска. Поэтому раньше оптимизаторы стремились всеми возможными путями получить максимальное количество внешних ссылок.

Google научился распознавать разные манипуляции с ссылками. Как именно работает Пингвин, известно только его разработчикам. Все, что известно оптимизаторам, так это то, что этот алгоритм охотится за некачественными ссылками, созданными веб-мастерами вручную с целью повлиять на позиции сайта. Сюда относятся:

- покупные ссылки;

- обмен ссылками;

- ссылки с нерелевантных сайтов;

- ссылки с сайтов-сателлитов;

- участие в ссылочных схемах;

- другие манипуляции.

На мой взгляд, алгоритм пингвин для Google создает «коэффициент доверия» относительно вашей ссылки. Я раньше рассказывал людям, что пингвин может повлиять на сайт, на отдельные страницы или даже на уровне ключевых слов, но сотрудник Google Джон Мюллер отметил, что теперь пингвин изменился процесс выполнения алгоритма. Если пингвин алгоритм определяет, что большое количество ссылок на ваш сайт не заслуживают доверия, то это приводит к уменьшению доверия Google для всего вашего сайта. Поэтому сайт будет понижен в ранжировании по всем запросам. При этом большинство сайтов получили незначительные понижения в рейтинге – это зависит от качества внешних ссылок.

Как избавится от фильтра Пингвин?

Пингвин – такой же фильтр, как и Панда. Это означает, что он регулярно обновляется и пересматривает сайты (правда не так часто, последний раз апдейт был 4 октября, 2013). Чтобы выйти из-под фильтра Пингвин, вам нужно избавиться от всех неестественных ссылок и ждать обновления. Если вы не можете просто удалить их, вы можете попросить Google перестать учитывать их с помощью disavow tool

Если вы добросовестно последуете рекомендациям Google и не будете пытаться получить ссылки нечестным путем, то сможете вернуть себе расположение поисковых систем. Однако чтобы вернуть первые позиции, вам не достаточно будет просто удалить некачественные ссылки. Вместо них вам нужно заработать естественные редакторские ссылки с трастовых сайтов.

Если Вы не уверены в том, что знаете как определить, какие ссылки на ваш сайт являются неестественными, вот некоторые полезные ресурсы для вас: • Что является неестественной ссылкой — подробный обзор в Google Quality Guidelines • Принципы построения ссылок от Google Quality Guidelines Не используйте инструмент disavow tool если не понимаете, как это работает, иначе принесете больше вреда, чем пользы для вашего сайта, если вы отклоните не те неправильные ссылки. Вот некоторые сведения об использовании disavow tool: • Документация Google по disavow tool • 7 вещей, которые вы могли не знать о Google disavow tool • disavow tool – секреты. Самый непонятный инструмент Google Важно отметить, что, когда сайты «избавился» от пингвина, они часто не занимает вершины рейтинга, так как ранее высокие рейтинги были, вероятно, благодаря влиянию ссылок, которые сегодня считаются неестественными. Вот некоторая информация о том, что ожидать, когда вы вышли из фильтров. Кроме того, алгоритм пингвин — это не то же самое, как и ручной бан занеестественные ссылки. Вы не должны подавать запрос на пересмотр сайта, чтобы избавится от пингвина. Кроме того, вам не нужно писать письмо в поддержку, с отчетом что вы сделали для того, чтобы ссылки были удалены, так как не сотрудника Google будет вручную проверять ваши работы.

Что такое Колибри?

Алгоритм Колибри – это совсем другой «зверь», чем пингвин или панда. (Да, знаю… это был плохой каламбур.) Я много получал писем по электронной почте с жалобами мне, что колибри уничтожил их сайт в поиске. Я бы сказал, что почти в каждом случае, это было не так. Google объявил о запуске этого обновления 26 сентября 2013 года, но он также упомянул о том, что этот алгоритм действует уже на протяжении месяца. Вот почему владельцы сайтов, позиции которых упали в начале октября 2013 года, ошибочно полагают, что они попали под фильтр Колибри. Если бы это действительно было так, они ощутили бы действие этого алгоритма на месяц раньше. Вы спросите, а что же в таком случае послужило причиной снижения трафика? Скорее всего, это было очередное обновление Пингвина, которое вступило в силу 4 октября того же года.

Колибри — это фундаментальные изменения в алгоритме Google. Если Panda и Penguin – это скорее косметические изменения, которые не затронут основных принципов, то Hummingbird – это новое направление. Цель алгоритма Колибри для Google — лучше понимать запросы пользователя. Bill Slawski, пишет в блоге Google, приводит замечательный пример в своем посте здесь. Он объясняет, что когда кто-то ищет «Какое лучшее место, чтобы найти и съесть в Чикаго больщое блюдо пиццы?», Колибри в состоянии понять, что под словом «место» пользователь скорее всего хочет увидеть результаты, которые показывают сайты «ресторанов». Есть предположение, что эти изменения были необходимы, чтобы голосовой поиск Google быть более эффективным. Цель Hummingbird в том, чтобы лучше понять, что пользователи имеют в виду, когда они задают подобные запросы.

Как соответствовать новым требования Колибри?

Как вы поняли прочитав текст выше, ответ на этот вопрос по сути заключается в создании контента, который отвечает на запросы пользователей, а не просто содержит определенные ключевые слова для поднятия в поиске. Но, это то, что вы давно уже должны делать!

Похоже, что цель компании Google с введением всех этих изменений алгоритмов (панда, Пингвин и колибри) заставить веб-мастеров публиковать контент, который будет лучшим в своем роде. Google стремится предоставлять ответы на людей, которые ищут. Если вы можете производить контент, который дает полные ответы на вопросы людей, то вы на правильном пути.

Я знаю, что это расплывчатая формулировка, и трудно дать точный рецепт, чтобы восстановить сайт от колибри. Колибри действительно отличается от панда и пингвин. Когда сайт был понижен алгоритмом панда и пингвин, это потому, что Google потеряла доверие к качеству сайта, были ли это сомнения в качестве контента или законность его обратные ссылки. Если вы исправить эти требования качества, вы можете восстановить доверие алгоритма и впоследствии увидеть улучшения. Но, если ваш сайт, потерял трафик с момента запуска колибри, то тут нет гарантированного способа восстановить упавшие рейтинги ключевого слова. Возможно вам понадобится полная переделка сайта или отдельной страницы.

У вас остались вопросы?

Моя цель в написании этой статьи была создать ресурс, чтобы показывать людям, когда у них возникали вопросы о основах Панда, Пингвин и Колибри. Тем не менее я понял из вопросов на форумах, что многие люди, далекие от мира SEO, сильно пострадали от нового алгоритма, но не нашли много информации о том, что произошло на их сайте. У Вас есть еще вопросы о панда, пингвин или Колибри? Если так, то я был бы рад ответить на них в комментариях. Я также с удовольствием пообщаюсь с теми из вас, кто имеет опыт работы с веб-сайтами, попавших и успешно выведенных из-под фильтров.

оригинал: http://moz.com/blog/google-algorithm-cheat-sheet-panda-penguin-hummingbird

Вам не восстановиться от воздействия алгоритма Penguin. На что влияет Google «Пингвин»

Мы выпустили новую книгу «Контент-маркетинг в социальных сетях: Как засесть в голову подписчиков и влюбить их в свой бренд».

Фильтр Google Пингвин — это один из последних алгоритмов, которые компания использует при ранжировании сайтов в поисковой выдаче.

На сегодняшний день Google при ранжировании сайтов принимает во внимание более двух сотен факторов. Чтобы учесть их все, одного алгоритма не хватит, необходимы несколько, каждый из которых будет решать собственные задачи.

Главная задача фильтра Пингвин – выявление и блокировка сайтов, использующих нечестные методы продвижения, основным из которых является закупка ссылочной массы. Алгоритм постоянно совершенствуется и в настоящее время апдейт фильтра Google Penguin выполняется практически непрерывно.

История разработки алгоритма Пингвин

Google Penguin вышел в мир в апреле 2012 года. В течение следующих двух месяцев он дважды обновлялся, разработчики корректировали первую версию фильтров. Вторая версия алгоритма появилась почти через год, обновленный Пингвин действовал уже тоньше и учитывал не только уровень ссылочного спама, но и общий уровень страницы.

Осенью 2014 года алгоритм вновь был обновлен. Надо сказать, что в тот период он действовал таким образом, что попавшим под его фильтры сайтам приходилось после коррекции долго дожидаться выхода очередного обновления, чтобы вновь пройти проверку. Ситуация изменилась в 2016 году, после выхода Google Penguin 4.0, который действовал в режиме реального времени и обновлялся непрерывно. Последние версии алгоритма действуют предельно мягко – учитывается уровень сайта, качество страниц, а некачественные ссылки аннулируются без отправки всего сайта в бан.

За что наказывает Google Penguin

Специалисты полагают, что алгоритм Пингвин должен дополнять алгоритм Google Панда, отвечающий за проверку контента сайтов. Чтобы ваш ресурс не попал под фильтр Google Пингвин, необходимо внимательно работать с внешними ссылками на сайт и избегать того, что специалисты называют манипулированием ссылочной массой. Основными способами такого манипулирования считаются:

- «Торговля» ссылками, когда владелец сайта за деньги или другую плату публикует на своем ресурсе ссылки на чужие сайты.

- Явно искусственный обмен ссылками, когда сайты ссылаются друг на друга из-за сговора владельцев, а не из-за качества контента.

- Использование на сайте большого количества текстов, в которых много «притянутых за уши» анкоров и ключевых слов.

- Использование сервисов, которые автоматически генерируют ссылки на сайт.

- Наличие на сайте ссылок, имеющих в анкоре прямое вхождение ключевиков.

- Использование сквозных ссылок с анкором-ключевиком в сайдбаре и футере сайта.

- Комментарии к материалам сайта со ссылками на спам-ресурсы.

- Чрезмерное количество контекстной рекламы на главной странице сайта.

За применение таких недобросовестных ссылочных схем фильтр Гугла Пингвин быстро и надежно «уронит» ваш сайт на много страниц в выдаче. Более того, вам будет очень непросто вернуть занимаемые позиции, поскольку проверка сайта Google Penguin выполняется всего лишь дважды в год.

Как узнать, что Google Penguin применил санкции

В отличие от алгоритма Google , работающего только в автоматическом режиме, Пингвин используется и при ручной модерации. Если вы обнаружили резкое падение трафика, зайдите на Google Webmaster Tools, в раздел «Меры принятые вручную» и проверьте, нет ли там сообщения от модераторов.

Если письмо есть, вам останется только исправить указанные в нем недочеты и отправить запрос о новой проверке.

Однако чаще всего алгоритм срабатывает автоматически. В этом случае стоит зайти на Moz.com и проверить, не было ли недавно обновлений Пингвина. Если обновления были, значит, диагноз установлен верно, и пора приступать к «лечению» сайта. Выявить это соответствие можно также с помощью сервиса PenguinTool, с сайта Barracuda. Правда для этого вам придется дать сервису доступ к своему аккаунту в Google Analytics, чтобы он сравнил период падения трафика и время выхода нового обновления. Результат сравнения поможет понять, попали вы под фильтры Пингвина или нет.

Что делать? если Google Penguin вас поймал

Если вы попали под фильтры этого алгоритма, то самое худшее, что можно сде

Алгоритм Google Penguin — Как не попасть под Пингвин ли выйти из под фильтра

Google Penguin – алгоритм работы поисковой системе Google, который запущен в апреле 2012 года. Задача данного алгоритма – борьба с неестественными обратными ссылками.

Значимость и авторитет любого ресурса зависит от множества факторов, в том числе от того, какие сайты ссылаются на этот ресурс. Одна ссылка с раскрученного сайта может иметь такой же вес, как и сотни ссылок с менее посещаемых источников.

Поэтому до внедрения алгоритма Google Penguin оптимизаторы старались получить как можно больше внешних обратных ссылок, используя для этого не всегда законные методы и недостаточно качественные площадки. Однако со временем поисковые системы научились распознавать неприемлемые манипуляции со ссылками, особенно преуспел в этом Google.

Google Penguin и SEO

По наблюдением оптимизаторов и аналитиков работа алгоритма Google Penguin предназначена для выявления сайтов, закупающих ссылки низкого качества, с коммерческими анкорами и используемые для влияния на позиции сайта в поисковой выдаче.

Алгоритм Google Penguin наказывает за:

- Чрезмерное использование продвигаемых ключевых слов и фраз в анкорах.

- Насыщение внутренних и внешних ссылок ключевыми словами и фразами.

- Использование в продвижении большого количества покупных ссылок.

- Продвижение сайтов спамом в блогах.

Чтобы защитить продвигаемый сайт от санкций фильтра Google Penguin, придерживайтесь следующих рекомендаций:

- Пишите адекватные пресс-релизы и размещайте в них ссылки на продвигаемый сайт.

- Своевременно удаляйте избыточные редиректы, дубли, битые ссылки и спам.

- Ведите блог, постоянно пополняйте его интересным и актуальным контентом.

- Посещайте тематические ресурсы и оставляйте адекватные комментарии.

- Размещайте на продвигаемом сайте ссылки на полезные источники.

- Не торопитесь отправлять запросы на пересмотр позиций сайта.

- Создавайте ресурсы, принадлежащие реальному бизнесу.

- Создавайте качественные микросайты и сети блогов.

- Не занимайтесь бессистемной деоптимизацией.

- Делитесь контентом в социальных сетях.

- Не экономьте на качественном контенте.

- Не обрубайте все ссылки одновременно.

- Позиционируйте себя как эксперта.

- Разнообразьте ссылки и анкоры.

- Соблюдайте требования Google.

Как выйти из-под Google Penguin

Чтобы избавиться от санкций Пингвина, нужно постепенно удалять неестественные ссылки, проверяя сайты-доноры и их заспамленность (общее количество исходящих ссылок с домена). Также рекомендуется снизить общее количество анкорных ссылок, разбавив их безанкорными. Но, чтобы вернуть продвигаемый сайт в ТОП, потребуется не только удалить некачественные ссылки, но и наработать естественные с трастовых сайтов.

Наши услуги по снятию Пингвина.

Читайте также:

Алгоритм Google Пингвин | Частный вебмастер

Алгоритм Google Penguin был запущен в апреле 2012 года. Алгоритм призван защитить поисковую выдачу от веб-спама и исключить из выдачи сайты, для продвижения которых используются покупные ссылки. После запуска алгоритма, сайты, на которые сняли покупные ссылки или деактивировали их через инструмент Google disavow links tool могут вернуться в поисковую выдачу. Новые сайты, которые не были прежде замечены в поисковом спаме, могут попасть под алгоритм Пингвин.

Что любит Пингвин

Вот три основных правила, которые требуется соблюдать, чтобы не попасть под Пингвина:

- Не злоупотреблять вхождением ключевых слов в анкоры. Вполне очевидный и логичный шаг. Тут без комментариев.

- Соблюдать тематичность сайта донора. То чего я долго ждал от гугла. Долгое время гугл не обращал внимание не тематичность сайта донора. То есть, при продвижении сайта по продаже мягких игрушек можно было закупить ссылки на сайтах по изготовлению покрышек или на сайте медицинской тематики и это могло дать результат. Теперь же важно соблюдать тематичность. Безусловно, какой-то процент ссылок с не тематических ресурсов допустим, но здесь главное не переборщить.

- Работать над естественностью ссылок. Если гугл увидит что на ваш сайт стоит слишком много однообразных ссылок, скорее всего пингвин сделает вывод что все они купленные. Это так называемая искусственная ссылочная масса. Старайтесь размещать ссылки на сайт разными способами. Например, в статьях, на форумах, в соцсетях, создавайте профили со ссылками, ставьте ссылки с картинок, пишите заметки, оставляйте качественные комментарии в блогах. И самое главное: работайте над сайтом, пишите интересный контент, чтобы посетители сайта сами были заинтересованы поставить на вас ссылку. Все это и есть естественность ссылочной массы.

Алгоритм Пингвин не только работает с ссылочными факторвми, но и берется с попытками обмана поисковой системы Google. Вот наиболее популярные хитрости вебмастеров, которые могут привести к тому что сайт будет отпингвинен:

- Использование скрытого текста

- Использование скрытых ссылок

- Использование скрытой переадресации на другой ресурс

- Использование дорвеев

- Использование автоматических запросов в Google

Это наиболее часто встречающиеся нарушения, за которые сайт может быть наказан.

Инструмент Disavow сервиса Google Webmasters

Отличный инструмент для быстрого вывода сайта из под Пингвина. Инструмент позволяет сказать Гуглу, что данная ссылка не должна стоять на ваш сайт. Таким образом можно отказываться временно или навсегда с купленной ссылкой. Практика показывает, что это работает намного быстрее чем просто снять ссылку и ждать следующей переиндексации.

Если ваш сайт оказался под пингвином, не отчаивайтесь. Приведите его в порядок, устраните все нарушения и дождитесь следующего апдейта алгоритма. Если вы все исправили, ваш сайт вернется на прежние позиции.

Google Penguin (Гугл Пингвин) – новый алгоритм от поисковой системы Google. Ключевые изменения и обновления алгоритма Penguin

Если вы задаетесь вопросами: как вывести сайт из под Пингвина ? Как снять ручной фильтр Google ? То, данное руководство поможет вам решить эти проблемы, вернуть позиции и посещаемость.

В поисковой системе Google существуют десятки известных фильтров, которые могут сильно повлиять на продвижение, а так же сотни, про которые мало кто знает.

Сегодня речь пойдет про самые основные и распространенные фильтры. А именно:

- Автоматический фильтр Google за обратные ссылки

Все они так или иначе относятся к алгоритму под названием Google Penguin, который вступил в силу более года назад и уже успел наделать много шума.

Симптомы такого фильтра

- обвал позиций

- резкий спад посещаемости сайта

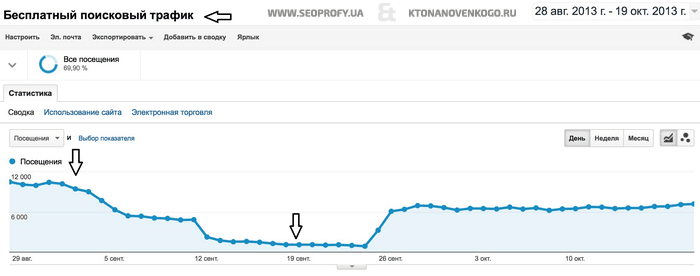

На практике это выгладит таким образом:

Не совсем приятная ситуация. Особенно когда в большинстве случаев ваш основной источник привлечения посетителей поисковый трафик.

А теперь рассмотрим детально для каждого типа фильтра за обратные ссылки.

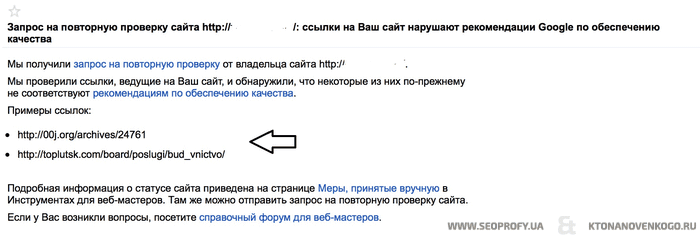

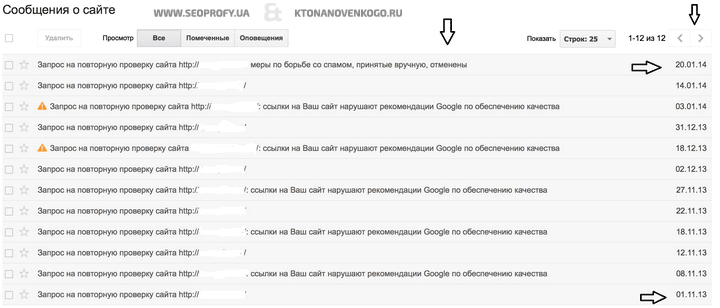

Ручной фильтр Google за искусственные входящие ссылки

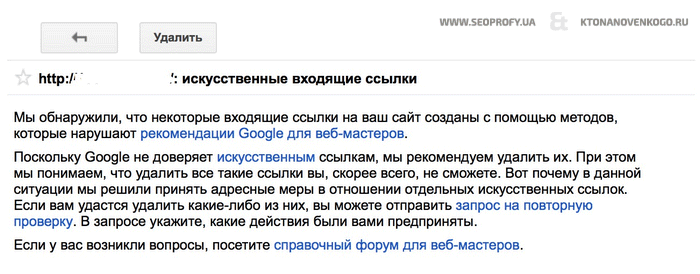

Зачастую все начинается с того, что приходит сообщение в панели для Вебмастеров Google. Выглядит оно так:

В уведомлении сообщение такого характера:

Сообщения бывают разные, например:

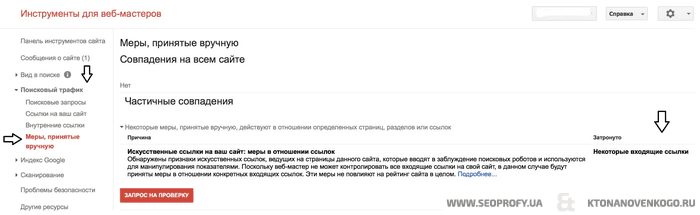

Чтобы найти сообщения о ручном фильтре, для этого:

После того, как приходит уведомление об искусственных входящих ссылках, обычно такие последствия:

А) В течении 2-3 недель позиции сильно падают, после чего пропадает посещаемость из поиска Google

Б) Сразу вылетают позиции и посещаемость падает

Причины ручного фильтра Google

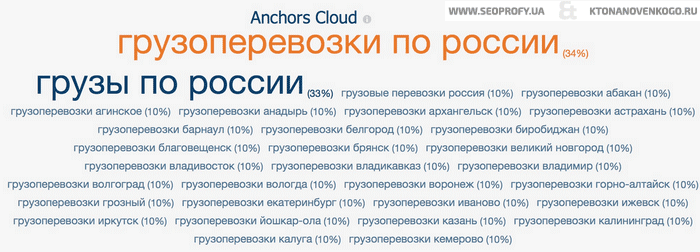

Основной сигнал, из-за которого приходит такое уведомление – это анкор ссылки и его переспам.

В примере, текст обратных ссылок на один из сайтов, который затронул фильтр. Основная причина фильтра – переспам анкором.

Еще пример :

Если посмотреть по уникальным доменам, то получается такая картина:

Использование обратных ссылок с коммерческими или другими ключевыми словами приводит к ручному фильтру, потери позиций и посещаемость.

Что же тогда делать и как быть?

Решение предельно простое – не использовать большой процент ссылок с ключевыми словами.

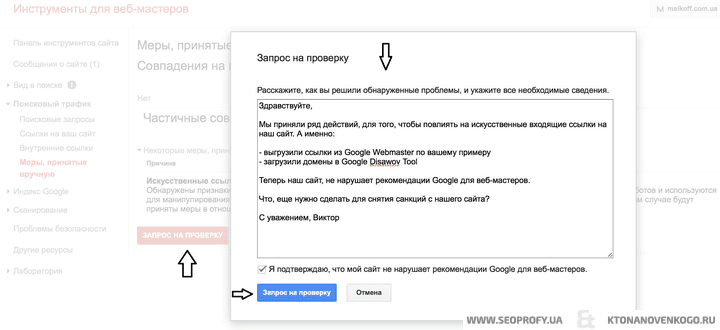

Пошаговая инструкция по снятию ручного фильтра Google

- Уведомление в Google

Проверяем, есть ли уведомление в Google Webmaster Tools. Если есть, то переходим к следующему пункту. - Запрос на пересмотр

В первом запросе на пересмотр важно уточнить какие именно ссылки нарушают правила поиска, и спросить, что необходимо сделать для снятия ручных санкций. - Получаем ответ

В большинстве случаев в ответе указывают те ссылки, по мнению которых сайт нарушает правила поиска. Например:

В итоге мы можем определить на какие именно ссылок обращает внимание Google и считает их спамными.

- Производим указанные действия

Дальнейшие действия сильно зависят от вашего ссылочного профиля.

Ситуация 1

На ваш сайт стоит большое количество арендованных ссылок, и в большинстве случаев это прямые анкоры, в которых содержаться ключевые слова.

В таком случае – необходимо :

- почистить ссылки с анкорами (в том числе те, которые есть в примере Гугл)

- переходить к следующем пункту – новый запрос на пересмотр

Если действительно убрать большую часть таких ссылок, то ручной фильтр можно снять с одного – двух запросов.

Ситуация 2

В там случае – необходимо :

- просмотреть все обратные ссылки (можно с помощью сервисов проверки обратных ссылок, например: Ahrefs, MajesticSeo, LinkPad)

- составить список ссылок, которые нежелательные (основные критерии: анкор, низкое качество сайта)

- добавить ссылки в Disawov Tool — https://www.google.com/webmasters/tools/disavow-links-main?/

- подождать 1-2 недели (из практики необходимо для того, чтобы ссылки пере индексировались)

- Отправляем новый запрос на пересмотр

В запросе на пересмотр необходимо:

- четко описать что вы сделали

- просто и понятно

- и уточнить, что еще необходимо сделать для снятия фильтра

После чего, необходимо немного времени для пересмотра вашего сайта. Это может занять от пару дней до 3-4 недель.

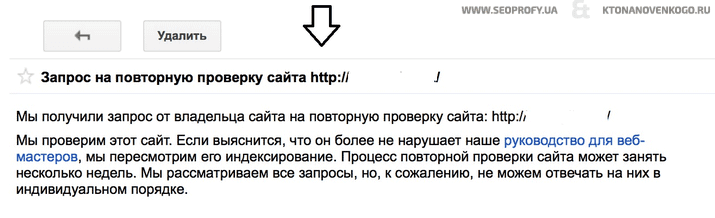

- Промежуточный ответ

В промежуточном ответе обычно содержание такого характера:

Это уведомление от Google приходит практически сразу после отправки запроса на пересмотр.

- Ждем решения

Ответ приходит обычно в течении 1-2 недель, иногда дольше, а иногда быстрее.

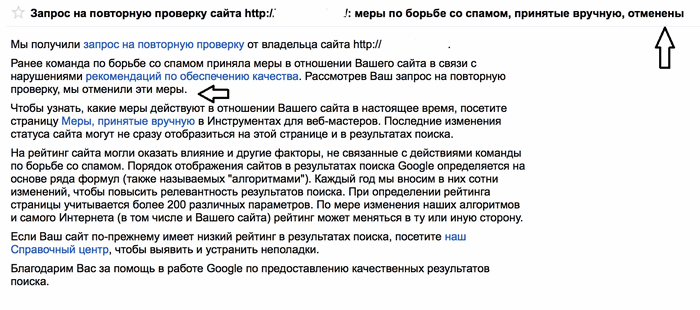

В нем либо негативный ответ, например:

Если ответ негативный , то:

- заново пересматриваем ссылки

- добавляем в Google Disawov

- или просто снимаем ссылки

- в любом случае нужно сделать действия

- отправляем новый запрос на пересмотр

Но ответ после выше проделанных действий может быть и позитивный , например:

В этом случае – поздравляю вас! Ручной фильтр Google снят.

В нашем примере – был не быстрый способ вывода сайта из под ручного фильтра Google, вот так выглядит хронология событий:

Важные моменты при самостоятельно снятии фильтра:

- не сдаваться

- делать действия (а не просто слать запросы на пересмотр)

- если сделать все, как выше описано, то ручной фильтр от Гугл снимется, вы вернете позиции и трафик

Вот информация, которая дополнит данный материал и поможет вам успешно снять фильтр:

- тематики под США

- Кейс — как снять ручные санкции Google с помощью Disavow Tool, вернуть позиции и посещаемость

- Кейс — как снять ручные санкции Google, вернуть позиции и трафик

В ручном фильтре нет ничего страшного, самое главное не поленится и сделать ряд действий, который приведет к нужному результату.

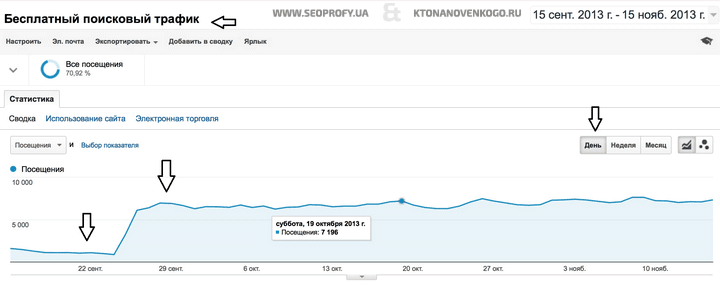

Как результат – это возвращение посещаемости на прежний уровень, например:

В данном примере рассмотрены пару сайтов, фильтры с которых снимались в разное время.

По времени снятия фильтра :

- рекорд за 4 дня

- самый долгий срок 3.5 месяца

Но в любом случае нужно действовать оперативно, а так же учитывать выше описанные моменты.

Автоматический фильтр за обратные ссылки

С автоматическим фильтром от Google – все на порядок сложнее. Так как о нем не приходит сообщение.

Важно: автоматические санкции могут сняться при официальном обновлении алгоритма Google Penguin, которое в среднем происходит раз в 2-4 месяца.

Чтобы вы не делали, до обновления алгоритма – ничего не изменится, если это автоматические санкции.

Мы не раз снимали автоматический фильтр, но не всегда все происходит быстро.

Признаки фильтра

Все тоже самое, как и с ручным, только не приходит никакого уведомления.

- позиции сначала проседают в – 30-50

- падает трафик на сайт

И потом долгое время не возвращается.

Основные причины:

- Прямое вхождение анкора ссылки

- Некачественные обратные ссылки

Пошаговое руководство по снятию автоматического фильтра

В данном случае в отличии от ручного все на порядок дольше, и сложнее.

В заключение про фильтр Google Penguin

Алгоритм был запущен в 2012 году и постоянно дорабатывается. Его основной задачей является – борьба со спамом и искусственным манипулированием результатов поиска.

Чтобы не попасть под фильтр , необходимо:

- не использовать прямой анкор лист сильно заметно, или не использовать вовсе

- привлекать качественные ссылки на сайт

- стараться делать акцент на продукте и его качестве, чтобы получать естественные ссылки (да, это можно делать даже в реалиях рунета)

- соблюдать динамику – Google любит постоянную динамику

Тогда у вас не возникнет вопросов с фильтр