история развития голосового синтеза Яндекса / Хабр

Четыре года назад мы запустили Алису. С самого начала она обладала собственным, узнаваемым голосом. Хотя проблемы тоже были: интонации хромали, эмоции скакали от слова к слову, а омонимы и вовсе ставили синтез в тупик. Алиса звучала пусть и не как робот, но ещё и не как человек.

Исследования показывают, что желание общаться с голосовым помощником напрямую зависит от того, насколько точно он имитирует речь людей. Поэтому мы постоянно работаем над «очеловечениванием» голоса Алисы. С тех пор сменилось несколько поколений нашего голосового синтеза. Мы научились расставлять интонации, отличать «замОк» от «зАмка» и многое другое.

Сейчас мы переходим на следующий уровень: учим Алису управлять эмоциями и стилем своей речи, распознавать шёпот и отвечать на него шёпотом. Казалось бы, что в этом сложного и почему всё это было невозможно ещё несколько лет назад? Вот об этом я и расскажу сегодня сообществу Хабра.

Ранний параметрический синтез: эпоха до Алисы

Мы начали заниматься голосовыми технологиями в 2012 году. Через год родился SpeechKit. Ещё через год мы научились синтезировать голос — возможно, вы помните YaC 2014 и экспериментальный проект Яндекс.Диктовка. С тех пор прогресс не останавливается.

Через год родился SpeechKit. Ещё через год мы научились синтезировать голос — возможно, вы помните YaC 2014 и экспериментальный проект Яндекс.Диктовка. С тех пор прогресс не останавливается.Исторически речевой синтез бывает двух видов: конкатенативный и параметрический. В случае с первым, есть база кусочков звука, размеченных элементами речи — словами или фонемами. Мы собираем предложение из кусочков, конкатенируя (то есть склеивая) звуковые сегменты. Такой метод требует большой базы звука, он очень дорогой и негибкий, зато до пришествия нейросетей давал самое высокое качество.

При параметрическом синтезе базы звука нет — мы рисуем его с нуля. Из-за большого прыжка в размерности end2end работает плохо даже сейчас. Лучше разделить это преобразование на два шага: сначала нарисовать звук в особом параметрическом (отсюда название метода) пространстве, а затем преобразовать параметрическое представление звука в wav-файл.

В 2014 году нейросетевые методы речевого синтеза только зарождались. Тогда качеством правил конкатенативный синтез, но нам в эру SpeechKit было необходимо легковесное решение (для Навигатора), поэтому остановились на простом и дешёвом параметрическом синтезе. Он состоял из двух блоков:

Тогда качеством правил конкатенативный синтез, но нам в эру SpeechKit было необходимо легковесное решение (для Навигатора), поэтому остановились на простом и дешёвом параметрическом синтезе. Он состоял из двух блоков:

- Первый — акустическая модель. Она получает лингвистические данные (разбитые на фонемы слова и дополнительную разметку) и переводит их в промежуточное состояние, которое описывает основные свойства речи — скорость и темп произнесения слов, интонационные признаки и артикуляцию — и спектральные характеристики звука. К примеру, в начале, до появления Алисы, в качестве модели мы обучали рекуррентную нейросеть (RNN) с предсказанием длительности. Она достаточно хорошо подходит для задач, где нужно просто последовательно проговаривать фонемы и не надо рисовать глобальную интонацию.

- Затем данные передаются на второй блок — вокодер — который и генерирует звук (то есть создаёт условный wav) по его параметрическому представлению. Вокодер определяет низкоуровневые свойства звука: sampling rate, громкость, фазу в сигнале.

Наш вокодер в первой системе был детерминированным DSP-алгоритмом (не обучался на данных) — подобно декодеру mp3, он «разжимал» параметрическое представление звука до полноценного wav. Естественно, такое восстановление сопровождалось потерями — искусственный голос не всегда был похож на оригинал, могли появляться неприятные артефакты вроде хрипов для очень высоких или низких голосов.

Наш вокодер в первой системе был детерминированным DSP-алгоритмом (не обучался на данных) — подобно декодеру mp3, он «разжимал» параметрическое представление звука до полноценного wav. Естественно, такое восстановление сопровождалось потерями — искусственный голос не всегда был похож на оригинал, могли появляться неприятные артефакты вроде хрипов для очень высоких или низких голосов.

Схема параметрического синтеза

Это стандартная архитектура для любой ранней параметрики со своими достоинствами и недостатками. Главный плюс — для обучения модели нужно мало данных (нам хватило 5-10 часов записей человеческой речи). Можно синтезировать любой произвольный текст, который даже будет плавно звучать. К сожалению, слишком плавно: недостатком раннего параметрического синтеза было то, что полученный голос звучал неестественно. Он был слишком гладким, лишённым интонаций и эмоций, звенел металлом. Люди так не говорят.

Вот как звучал голос при раннем параметрическом синтезе:

Причина неестественности синтезированного голоса кроется в самой архитектуре. У акустической модели мало информации о тексте в целом. Даже рекуррентная нейросеть, которая, казалось бы, умеет запоминать предыдущие состояния, очень быстро забывает их и фактически не учитывает полный текст. При этом человек обычно произносит речь, понимая, что только что прозвучало и что будет дальше по тексту.

У акустической модели мало информации о тексте в целом. Даже рекуррентная нейросеть, которая, казалось бы, умеет запоминать предыдущие состояния, очень быстро забывает их и фактически не учитывает полный текст. При этом человек обычно произносит речь, понимая, что только что прозвучало и что будет дальше по тексту.Кроме того, человеческая речь мультимодальна — есть несколько способов произнести текст, каждый из которых описывается сигналом и звучит более-менее нормально. Но среднее между этими способами звучит неестественно. Проблема стандартных регрессионных методов глубокого обучения в том, что они ищут одну моду — «хорошее среднее» — и попадают в такие «провалы неестественности». В результате оказывается, что лучше случайно выбрать один из двух способов, чем попасть в среднее между ними.

Впрочем, даже если акустическая модель и смогла бы разобраться в контексте и выдать обогащённое информацией промежуточное состояние, то с ним уже не мог справиться примитивный вокодер. Поэтому мы не остановились и стали искать более совершенные решения.

Поэтому мы не остановились и стали искать более совершенные решения.

Конкатенативный синтез: рождение Алисы

В 2016 году мы решили создать Алису — сразу было понятно, что это более амбициозная задача, чем всё, чем занимались раньше. Дело в том, что в отличие от простых TTS-инструментов, голосовой помощник должен звучать человечно, иначе люди просто не станут с ним (или с ней) общаться. Предыдущая архитектура совершенно не подходила. К счастью, был и другой подход. Точнее, даже два.Тогда как раз набирал обороты нейропараметрический подход, в котором задачу вокодера выполняла сложная нейросетевая модель. Например, появился проект WaveNet на базе свёрточной нейросети, которая могла обходиться и без отдельной акустической модели. На вход можно было загрузить простые лингвистические данные, а на выходе получить приличную речь.

Первым импульсом было пойти именно таким путём, но нейросети были совсем сырые и медленные, поэтому мы не стали их рассматривать как основное решение, а исследовали эту задачу в фоновом режиме. На генерацию секунды речи уходило до пяти минут реального времени. Это очень долго: чтобы использовать синтез в реальном времени, нужно генерировать секунду звука быстрее, чем за секунду.

На генерацию секунды речи уходило до пяти минут реального времени. Это очень долго: чтобы использовать синтез в реальном времени, нужно генерировать секунду звука быстрее, чем за секунду.

Что же делать? Если нельзя синтезировать живую речь с нуля, нужно взять крошечные фрагменты речи человека и собрать из них любую произвольную фразу. Напомню, что в этом суть конкатенативного синтеза, который обычно ассоциируется с методом unit selection. Пять лет назад он уже давал наилучшее качество (при достаточном количестве данных) в задачах, где была нужна качественная речь в реальном времени. И здесь мы смогли переиспользовать нейросети нашей старой параметрики. Работало это следующим образом:

- На первом шаге мы использовали нейросетевую параметрику, чтобы синтезировать речь с нуля — подобному тому, как делали раньше. Напомню, что по качеству звучания результат нас не устраивал, но мог использоваться как референс по содержанию.

- На втором шаге другая нейросеть подбирала из базы фрагментов записанной речи такие, из которых можно было собрать фразу, достаточно близкую к сгенерированной параметрикой.

Схема конкатенативного синтеза

У такого подхода тоже есть плюсы и минусы. Среди достоинств — более естественное звучание голоса, ведь исходный материал не синтезирован, а записан вживую. Правда, есть и обратная сторона: чем меньше данных, тем более грубо будут звучать места склейки фрагментов. Для шаблонных фраз всё более-менее хорошо, но шаг влево или вправо — и вы замечаете склейку. Поэтому нужно очень много исходного материала, а это требует многих часов записи голоса диктора. К примеру, в первые несколько лет работы над Алисой нам пришлось записать несколько десятков часов. Это несколько месяцев непрерывной работы с актрисой Татьяной Шитовой в студии.

Среди достоинств — более естественное звучание голоса, ведь исходный материал не синтезирован, а записан вживую. Правда, есть и обратная сторона: чем меньше данных, тем более грубо будут звучать места склейки фрагментов. Для шаблонных фраз всё более-менее хорошо, но шаг влево или вправо — и вы замечаете склейку. Поэтому нужно очень много исходного материала, а это требует многих часов записи голоса диктора. К примеру, в первые несколько лет работы над Алисой нам пришлось записать несколько десятков часов. Это несколько месяцев непрерывной работы с актрисой Татьяной Шитовой в студии.

При этом нужно не просто «прочитать текст по листочку». Чем более нейтрально будет звучать голос, тем лучше. Обычно от актёров ждут эмоциональности, проявления темперамента в своей речи. У нас ровно обратная задача, потому что нужны универсальные «кубики» для создания произвольных фраз.

Вот характерный пример работы синтеза:

В этом главный недостаток метода unit selection: несмотря на все усилия, фрагменты речи не будут идеально соответствовать друг другу по эмоциям и стилю. Из-за этого сгенерированная речь Алисы постоянно «переключалась» между ними. На коротких фразах это не всегда заметно, но если хотите услышать произвольный ответ длиной хотя бы в пару предложений (например, быстрый ответ из поиска), то недостатки подхода становятся очевидны.

Из-за этого сгенерированная речь Алисы постоянно «переключалась» между ними. На коротких фразах это не всегда заметно, но если хотите услышать произвольный ответ длиной хотя бы в пару предложений (например, быстрый ответ из поиска), то недостатки подхода становятся очевидны.В общем, unit selection перестал нас устраивать и нужно было развиваться дальше.

Иногда они возвращаются: опять параметрический синтез

В результате мы вернулись к архитектуре из двух последовательных блоков: акустическая модель и вокодер. Правда, на более низком уровне обновилось примерно всё.1. Акустическая модель

В отличие от старой параметрики, новую модель мы построили на основе seq2seq-подхода с механизмом внимания.Помните проблему с потерей контекста в нашей ранней параметрике? Если нет нормального контекста, то нет и нормальной интонации в речи. Решение пришло из машинного перевода.

Дело в том, что в машинном переводе как раз возникает проблема глобального контекста — смысл слов в разных языках может задаваться разным порядком или вообще разными структурами, поэтому порой для корректного перевода предложения нужно увидеть его целиком. Для решения этой задачи исследователи предложили механизм внимания — идея в том, чтобы рассмотреть всё предложение разом, но сфокусироваться (через softmax-слой) на небольшом числе «важных» токенов.

Для решения этой задачи исследователи предложили механизм внимания — идея в том, чтобы рассмотреть всё предложение разом, но сфокусироваться (через softmax-слой) на небольшом числе «важных» токенов.

При генерации каждого нового выходного токена нейросеть смотрит на обработанные токены (фонемы для речевого синтеза или символы языка для перевода) входа и «решает», насколько каждый из них важен на этом шаге. Оценив важность, сеть учитывает её при агрегировании результатов и получает информацию для генерации очередного токена выхода.

Таким образом нейросеть может заглянуть в любой элемент входа на любом шаге и при этом не перегружается информацией, поскольку фокусируется на небольшом количестве входных токенов. Для синтеза важна подобная глобальность, так как интонация сама по себе глобальна и нужно «видеть» всё предложение, чтобы правильно его проинтонировать.

На тот момент для синтеза была хорошая seq2seq-архитектура Tacotron 2 — она и легла в основу нашей акустической модели.

2. Мел-спектрограмма

Параметрическое пространство можно сжать разными способами. Более сжатые представления лучше работают с примитивными акустическими моделями и вокодерами — там меньше возможностей для ошибок. Более полные представления позволяют лучше восстановить wav, но их генерация — сложная задача для акустической модели. Кроме того, восстановление из таких представлений у детерминированных вокодеров не очень качественное из-за их нестабильности. С появлением нейросетевых вокодеров сложность промежуточного пространства стала расти и сейчас в индустрии одним из стандартов стала мел-спектрограмма.Она отличается от обычного распределения частоты звука по времени тем, что частоты переводятся в особую мел-частоту звука. Другими словами, мел-спектрограмма — это спектрограмма, в которой частота звука выражена в мелах, а не герцах. Мелы пришли из музыкальной акустики, а их название — это просто сокращение слова «мелодия».

Строение улитки уха (из Википедии)

Эта шкала не линейная и основана на том, что человеческое ухо по-разному воспринимает звук различной частоты. Вспомните строение улитки в ухе: это просто канал, закрученный по спирали. Высокочастотный звук не может «повернуть» по спирали, поэтому воспринимается достаточно короткой частью слуховых рецепторов. Низкочастотный же звук проходит вглубь. Поэтому люди хорошо различают низкочастотные звуки, но высокочастотные сливаются.

Вспомните строение улитки в ухе: это просто канал, закрученный по спирали. Высокочастотный звук не может «повернуть» по спирали, поэтому воспринимается достаточно короткой частью слуховых рецепторов. Низкочастотный же звук проходит вглубь. Поэтому люди хорошо различают низкочастотные звуки, но высокочастотные сливаются.

Мел-спектрограмма как раз позволяет представить звук, акцентируясь на той части спектра, которая значимо различается слухом. Это полезно, потому что мы генерируем звук именно для человека, а не для машины.

Вот как выглядит мел-спектрограмма синтеза текста «Я — Алиса»:

У мел-спектрограммы по одному измерению [X на рисунке выше] — время, по другому [Y] — частота, а значение [яркость на рисунке] — мощность сигнала на заданной частоте в определенный момент времени. Проще говоря, эта штуковина показывает, какое распределение по мощностям было у различных частот звука в конкретный момент. Мел-спектрограмма непрерывна, то есть с ней можно работать как с изображением.

А так звучит результат синтеза:

3. Новый вокодер

Вероятно, вы уже догадались, что мы перешли к использованию нового нейросетевого вокодера. Именно он в реальном времени превращает мел-спектрограмму в голос. Наиболее близкий аналог нашего первого решения на основе нейросетей, которое вышло в 2018 году — модель WaveGlow.Архитектура WaveGlow основана на генеративных потоках — довольно изящном методе создания генеративных сетей, впервые предложенном в статье про генерацию лиц. Сеть обучается конвертировать случайный шум и мел-спектрограмму на входе в осмысленный wav-сэмпл. За счёт случайного шума на входе обеспечивается выбор случайной wav-ки — одной из множества соответствующих мел-спектрограмме. Как я объяснил выше, в домене речи такой случайный выбор будет лучше детерминированного среднего по всем возможным wav-кам.

В отличие от WaveNet, WaveGlow не авторегрессионен, то есть не требует для генерации нового wav-сэмпла знания предыдущих. Его параллельная свёрточная архитектура хорошо ложится на вычислительную модель видеокарты, позволяя за одну секунду работы генерировать несколько сотен секунд звука.

Затем вышла модель HiFi-GAN, которая сильно выигрывала по качеству у других решений. HiFi-GAN — доработка генеративно-состязательной сети MelGAN, создающей wav-сэмплы на основе мел-спектрограммы.

Главное отличие, за счёт которого HiFi-GAN обеспечивает гораздо лучшее качество, заключается в наборе подсетей-дискриминаторов. Они валидируют натуральность звука, смотря на сэмплы с различными периодами и на различном масштабе. Как и WaveGlow, HiFi-GAN не имеет авторегрессионной зависимости и хорошо параллелится, при этом новая сеть намного легковеснее, что позволило при реализации ещё больше повысить скорость синтеза. Кроме того, оказалось, что HiFi-GAN лучше работает на экспрессивной речи, что в дальнейшем позволило запустить эмоциональный синтез — об этом подробно расскажу чуть позже. Летом 2021 года мы полностью перешли на HiFi-GAN.

Схема HiFi-GAN из статьи авторов модели

Комбинация этих трёх компонентов позволила вернуться к параметрическому синтезу голоса, который звучал плавно и качественно, требовал меньше данных и давал больше возможностей в кастомизации и изменении стиля голоса.

Параллельно мы работали над улучшением отдельных элементов синтеза:

- Летом 2019 года выкатили разрешатор омографов (homograph resolver) — он научил Алису правильно ставить ударения в парах «зАмок» и «замОк», «белкИ» и «бЕлки» и так далее. Здесь мы нашли остроумное решение. В русском языке эти слова пишутся одинаково, но в английском написание отличается, например, castle и lock, proteins и squirrels. Поэтому мы воспользовались моделью машинного перевода: взяли энкодер переводческой нейросети ru->en и извлекли эмбеддинг русского текста. Из этого представления легко выделить информацию о том, как произносить омограф, ведь перевод должен различать формы для корректного подбора английского варианта. Буквально на 20 примерах можно выучить классификатор для нового омографа, чтобы по эмбеддингу перевода понимать, какую форму нужно произнести.

- Летом 2020 года допилили паузер для расстановки пауз внутри предложения. Язык — хитрая штука. Не все знаки препинания в речи выражаются паузами Например, после вводного слова «конечно» на письме мы ставим запятую, но в речи обычно не делаем паузу.

А там, где знаков препинания нет, мы часто делаем паузы. Если эту информацию не передавать в акустическую модель, то она пытается её выводить и не всегда успешно. Первая модель Алисы из-за этого могла начать вздыхать в случайных местах длинного предложения. Задача паузера — предсказать класс паузы (отсутствует/короткая/средняя/длинная) после каждого слова. Для этого мы взяли датасет, разметили его детектором активности голоса, сгруппировали паузы по длительности, ввели класс длины паузы, на каждое слово навесили тэг и на этом корпусе обучили ещё одну голову внимания из тех же нейросетевых эмбеддингов, что использовались для детекции омографов.

А там, где знаков препинания нет, мы часто делаем паузы. Если эту информацию не передавать в акустическую модель, то она пытается её выводить и не всегда успешно. Первая модель Алисы из-за этого могла начать вздыхать в случайных местах длинного предложения. Задача паузера — предсказать класс паузы (отсутствует/короткая/средняя/длинная) после каждого слова. Для этого мы взяли датасет, разметили его детектором активности голоса, сгруппировали паузы по длительности, ввели класс длины паузы, на каждое слово навесили тэг и на этом корпусе обучили ещё одну голову внимания из тех же нейросетевых эмбеддингов, что использовались для детекции омографов. - Осенью 2020 года мы перевели на трансформеры нормализацию — в синтезе она нужна, чтобы решать сложные случаи, когда символы читаются не «буквально», а по неким правилам. Например, «101» нужно читать не как «один-ноль-один», а как «сто один», а в адресе yandex.ru нужно произносить точку — «яндекс точка ру». Обычно нормализацию делают через комбинацию взвешенных трансдьюсеров (FST) — правила напоминают последовательность замен по регулярным выражениям, где выбирается замена, имеющая наибольший вес.

Мы долго писали правила вручную, но это отнимало много сил, было очень сложно и не масштабируемо. Тогда решили перейти на трансформерную сеть, «задистиллировав» знания наших FST в нейронку. Теперь новые «правила раскрытия» можно добавлять через доливание синтетики и данных, размеченных пользователями Толоки, а сеть показывает лучшее качество, чем FST, потому что учитывает глобальный контекст.

Мы долго писали правила вручную, но это отнимало много сил, было очень сложно и не масштабируемо. Тогда решили перейти на трансформерную сеть, «задистиллировав» знания наших FST в нейронку. Теперь новые «правила раскрытия» можно добавлять через доливание синтетики и данных, размеченных пользователями Толоки, а сеть показывает лучшее качество, чем FST, потому что учитывает глобальный контекст.

С чувством, толком, расстановкой: стили голоса Алисы

Один и тот же текст можно произнести десятком разных способов, при этом сам исходный текст, как правило, никаких подсказок не содержит. Если отправить такой текст в акустическую модель без дополнительных меток и обучить её на достаточно богатом различными стилями и интонациями корпусе, то модель сойдёт с ума — либо переусреднит всё к металлическому «голосу робота», либо начнёт генерировать случайный стиль на каждое предложение. Это и произошло с Алисой: в начале она воспроизводила рандомные стили в разговоре. Казалось, что у неё менялось настроение в каждом предложении.

Это и произошло с Алисой: в начале она воспроизводила рандомные стили в разговоре. Казалось, что у неё менялось настроение в каждом предложении.Вот пример записи с явными перебоями в стилях:

Чтобы решить проблему, мы добавили в акустическую модель стили: в процессе обучения нейросети специально ввели «утечку». Суть в том, что через очень lossy-пространство (всего 16 чисел на всё предложение) разрешаем сетке посмотреть на ответ — истинную мел-спектрограмму, которую ей и нужно предсказать на обучении. За счёт такой «шпаргалки» сеть не пытается выдумывать непредсказуемую по тексту компоненту, а для другой информации не хватит размерности шпаргалки.На инференсе мы генерируем стилевую подсказку, похожую на те, что были в обучающем сете. Это можно делать, взяв готовый стиль из обучающего примера или обучив специальную подсеть генерировать стили по тексту.

Если эту подсеть обучить на особом подмножестве примеров, можно получить специальные стили для, скажем, мягкого или дружелюбного голоса. Или резкого и холодного. Или относительно нейтрального. Чтобы определиться со стилем по умолчанию, мы устроили турнир, где судьями выступали пользователи Толоки. Там не было разметки, мы просто нашли кластеры стилей и провели между ними соревнование. Победил кластер с очень мягкой и приятной интонацией.

Или резкого и холодного. Или относительно нейтрального. Чтобы определиться со стилем по умолчанию, мы устроили турнир, где судьями выступали пользователи Толоки. Там не было разметки, мы просто нашли кластеры стилей и провели между ними соревнование. Победил кластер с очень мягкой и приятной интонацией.

Дальше началось самое интересное. Мы взяли образцы синтезированной «мягкой» речи Алисы и фрагменты речи актрисы Татьяны Шитовой, которые относились к более резкому стилю. Затем эти образцы с одним и тем же текстом протестировали вслепую на толокерах. Оказалось, что люди выбирают синтезированный вариант Алисы, несмотря на более плохое качество по сравнению с реальной речью человека. В принципе, этого можно было ожидать: уверен, многие предпочтут более ласковый разговор по телефону (то есть с потерей в качестве) живому, но холодному общению.

К примеру, так звучал резкий голос:

А так — мягкий:Результаты турниров позволили нам выделить во всем обучающем датасете данные, которые относятся к стилю-победителю, и использовать для обучения только их. Благодаря этому Алиса по умолчанию стала говорить более мягким и дружелюбным голосом.

Благодаря этому Алиса по умолчанию стала говорить более мягким и дружелюбным голосом.Этот пример показывает, что с точки зрения восприятия важно работать не только над качеством синтеза, но и над стилем речи. После этого оставалось только обогатить Алису новыми эмоциями.

Бодрая или спокойная: управляем эмоциями Алисы

Когда вы включаете утреннее шоу Алисы или запускаете автоматический перевод лекции на YouTube, то слышите разные голоса — бодрый в первом случае и более флегматичный в другом. Эту разницу сложно описать словами, но она интуитивно понятна — люди хорошо умеют распознавать эмоции и произносить один и тот же текст с разной эмоциональной окраской. Мы обучили этому навыку Алису с помощью той же разметки подсказок, которую применили для стилей.У языка есть интересное свойство — просодия, или набор элементов, которые не выражаются словами. Это особенности произношения, интенсивность, придыхание и так далее. Один текст можно произнести со множеством смыслов. Как и в случае со стилями речи, можно, например, выделить кластеры «веселая Алиса», «злая Алиса» и так далее.

Как и в случае со стилями речи, можно, например, выделить кластеры «веселая Алиса», «злая Алиса» и так далее.

Поскольку стилевой механизм отделяет просодию («как говорим») от артикуляции («что говорим»), то новую эмоцию можно получить буквально из пары часов данных. По сути, нейросети нужно только выучить стиль, а информацию о том, как читать сочетания фонем, она возьмёт из остального корпуса.

Прямо сейчас доступны три эмоции. Например, часть пользователей утреннего шоу Алисы слышат бодрую эмоцию. Кроме того, её можно услышать, спросив Алису «Кем ты работаешь?» или «Какую музыку ты любишь?». Флегматичная эмоция пригодилась для перевода видео — оказалось, что голос по умолчанию слишком игривый для этой задачи. Наконец, радостная эмоция нужна для ответов Алисы на специфические запросы вроде «Давай дружить» и «Орёл или решка?». Ещё есть негативная эмоция, которую пока не знаем, как использовать — сложно представить ситуацию, когда людям понравится, что на них ругается робот.

Первый корпус эмоций мы записали ещё при WaveGlow, но результат нас не устроил и выкатывать его не стали. С переходом на HiFi-GAN стало понятно, что он хорошо работает с эмоциями, это позволило запустить полноценный эмоциональный синтез.

Наконец, мы решили внедрить шёпот. Когда люди обращаются к Алисе шёпотом, она должна и отвечать шёпотом — это делает её человечнее. При этом шёпот — не просто тихая речь, там слова произносятся без использования голосовых связок. Спектр звука получается совсем другим.

С одной стороны, это упрощает детекцию шёпота: по «картинке» мел-спектрограммы можно понять, где заканчивается обычная речь и начинается шепот. С другой стороны, это усложняет синтез шёпота: привычные механизмы обработки и подготовки речи перестают работать. Поэтому шёпотный синтез нельзя получить детерминированным преобразованием сигнала из речи.

Так выглядят мел-спектрограммы обычной речи и шёпота при произнесении одной и той же фразы:

Так звучит обычная речь:

Для этого обучили нейросеть различать спектры звука для обычного голоса и шёпота. Система смотрит на спектр звука и решает, когда говорят шёпотом, а когда — голосом.

Для этого обучили нейросеть различать спектры звука для обычного голоса и шёпота. Система смотрит на спектр звука и решает, когда говорят шёпотом, а когда — голосом.В процессе обучения оказалось, что спектры шёпота и речи курильщиков похожи, так что пришлось научить нейросеть их различать. Для этого собрали больше пограничных данных с речью курильщиков и простуженных людей и донастроили нейросеть на них.

Чтобы научить Алису говорить шёпотом, мы записали несколько часов шёпота речи в исполнении Татьяны Шитовой. Сложности начались уже на предобработке данных: наш VAD (детектор тишины в речи) сломался на шёпотных гласных — трудно отличить сказанное шёпотом «а!» от обычного громкого вздоха. Починить его удалось, только совместив признаки энергии сигнала и данные от распознавания речи, при этом под шёпот конструкцию пришлось калибровать отдельно.

Затем записанные данные добавили в обучающий корпус акустической модели. Мы решили рассматривать шёпот как еще один «стиль» речи или, в терминах нашего синтеза, «эмоцию». Добавив данные в трейнсет, мы дали акустической модели на вход дополнительную информацию — шёпот или эмоцию она сейчас проигрывает. По этому входу модель научилась по команде пользователя переключаться между генерацией речи и шёпота.

Добавив данные в трейнсет, мы дали акустической модели на вход дополнительную информацию — шёпот или эмоцию она сейчас проигрывает. По этому входу модель научилась по команде пользователя переключаться между генерацией речи и шёпота.

Сгенерированный шёпот по качеству не отличался от обычной речи. По нашей метрике PSER (Pronunciation Sentence Error Rate — средняя доля ошибок произношения в предложении) он оказался даже лучше. Оказалось, что ряд ошибок интонации в шёпотной речи были значительно менее ярко выражены.

Этот голос будет полезен при общении с Алисой ночью, чтобы не мешать близким. Можно задавать вопросы тихим голосом и Алиса будет отвечать шёпотом. Кроме того, такой стиль ещё и звучит очень приятно — поклонники ASMR оценят.

Послушайте, как шепчет Алиса:

На этом мы не останавливаемся — в планах дальнейшее развитие голосового синтеза, добавление новых стилей и эмоций. Обязательно продолжим рассказывать о том, как Алиса учится говорить по-человечески.

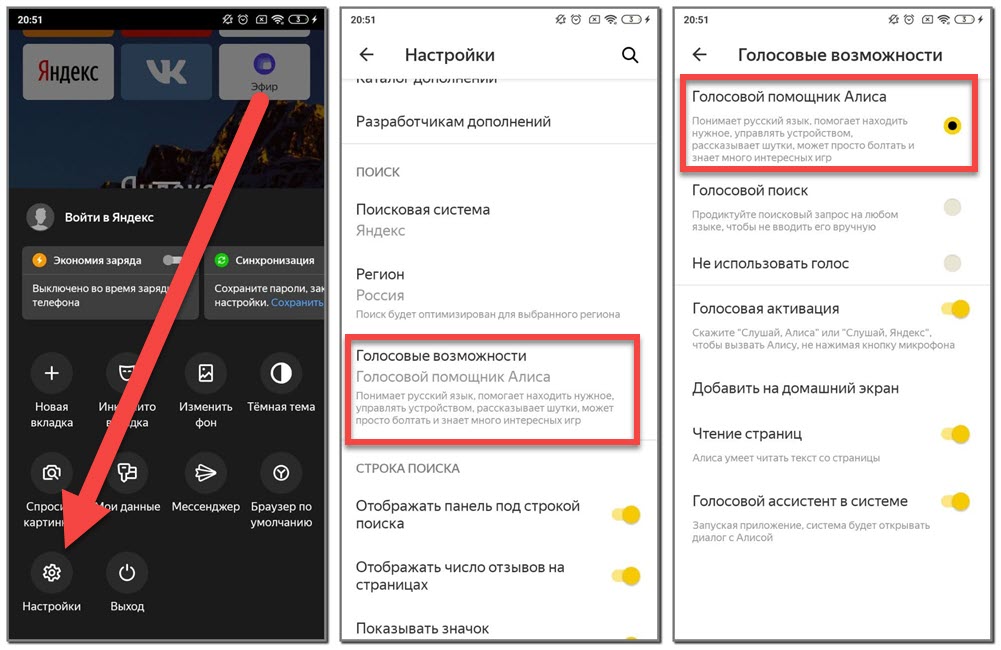

Как поменять голосового помощника Google на Алису Яндекс в смартфоне HUAWEI (honor)?

от SabitovAdmin

.

На сегодняшний день самая передовая отрасль в IT-индустрии – это разработка программ искусственного интеллекта. По признанию аналитиков, страна, опережающая в этой отрасли, получает стратегическое преимущество перед всеми другими. Поэтому в гонку за лидерство вовлечены все крупнейшие компании IT-индустрии.

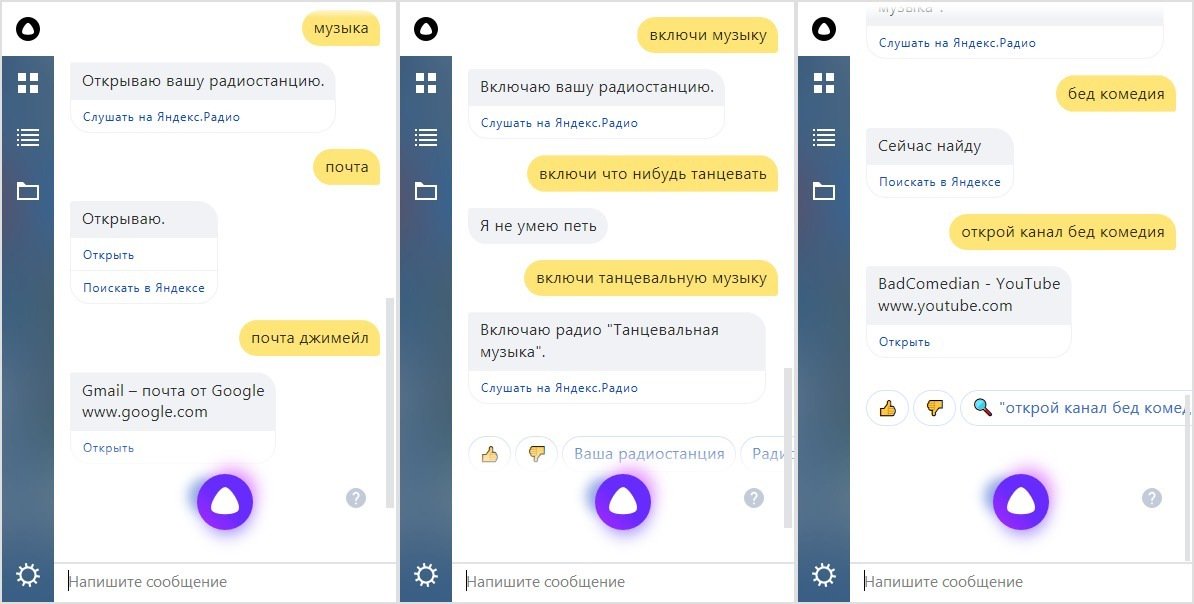

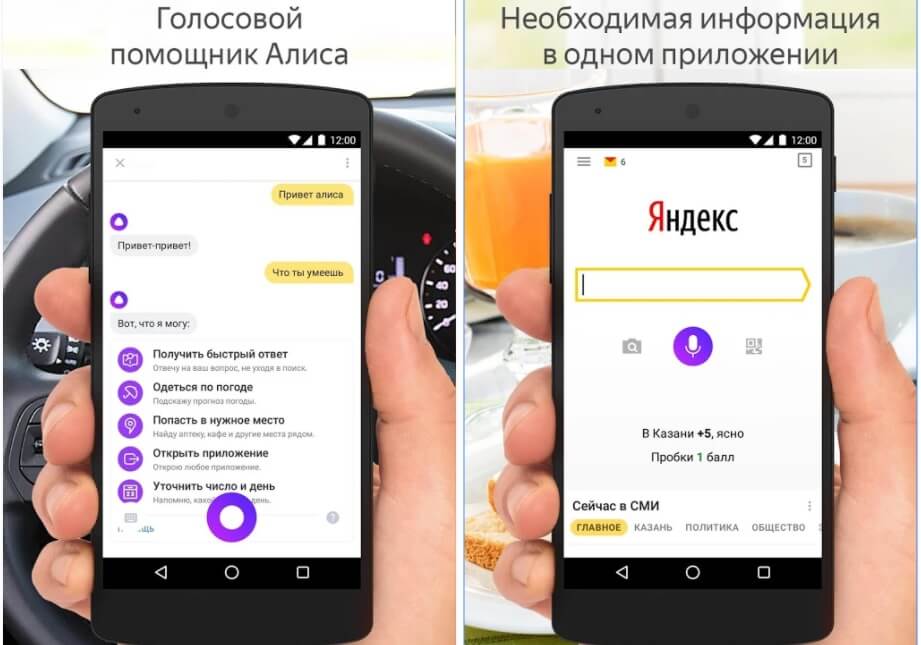

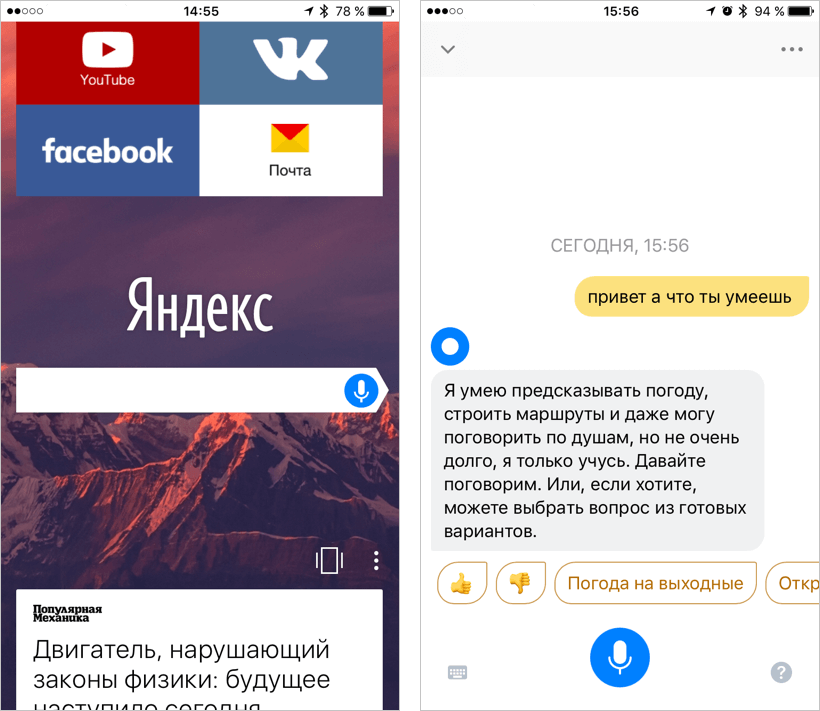

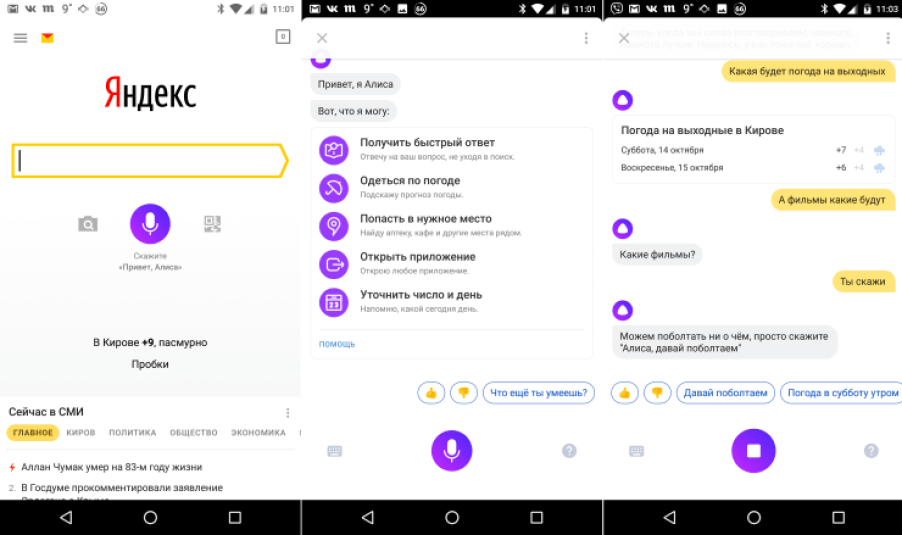

Голосовой Помощник Алиса Яндекс — это программа самообучающегося искусственного интеллекта, разработанная в России с использованием нейронной сети, которая уже сейчас может говорить на русском, украинском, английском и турецком языках. Алиса хорошо понимает русский язык: с Алисой можно общаться как через микрофон, так и через клавиатуру.

Основная функция Алисы — помощь в решении повседневных задач: поиск информации в интернете, найти определённое место, проложить маршрут, показать прогноз погоды и т. д. Для решения этих задач Алиса может привлекать сервисы не только компании «Яндекс» (Поиск, Карты, Музыка, Новости и пр.), но и сервисы других компаний.

д. Для решения этих задач Алиса может привлекать сервисы не только компании «Яндекс» (Поиск, Карты, Музыка, Новости и пр.), но и сервисы других компаний.

И ещё: Алиса может развлечь вас, рассказать анекдот или историю, поддержать диалог. И это она порой делает даже остроумно.

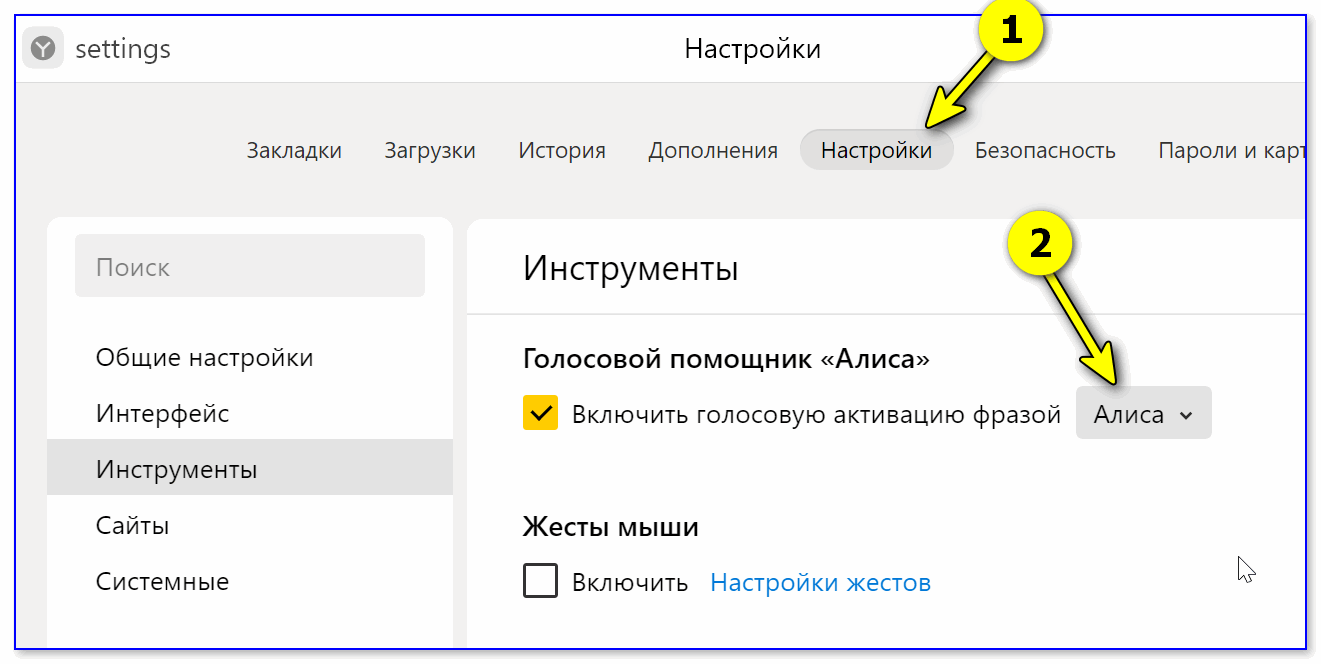

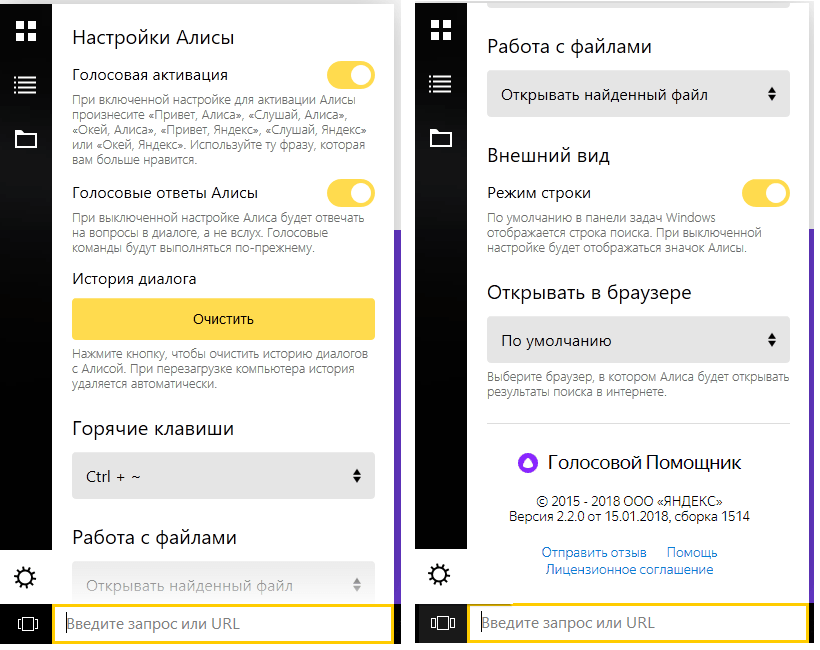

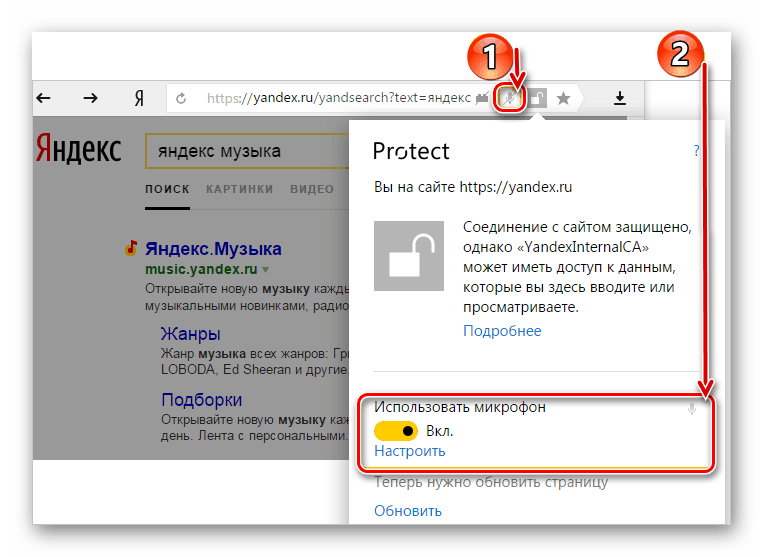

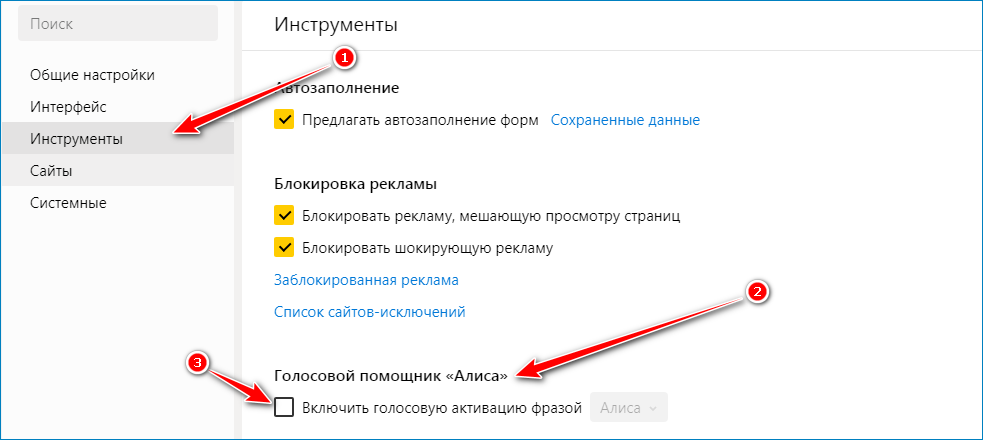

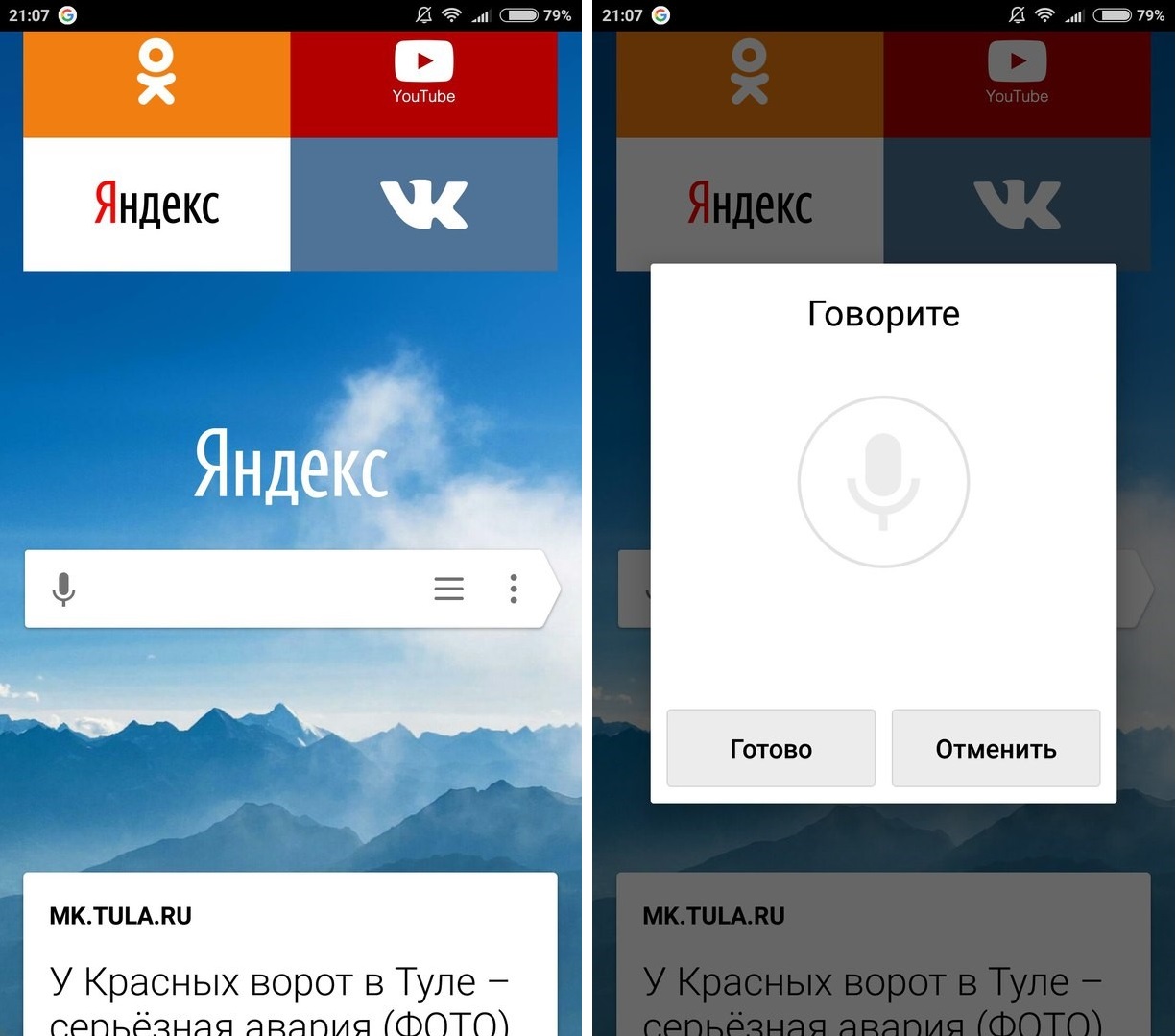

В стандартный набор приложений телефонов HUAWEI (honor) входят приложения «Яндекс» и «Яндекс.Браузер», которые с октября 2017 года оснащены голосовым Помощником Алиса.

В тоже время компания Google, которая является разработчиком операционной системы Android, стоящей на большинстве смартфонов HUAWEI (honor), постаралась, чтобы только её продукт Google Assistant был основным голосовым Помощником. Этот Помощник запускается очень легко: достаточно нажать и удерживать некоторое время кнопку «Домой» («Главный экран») на панели навигации.

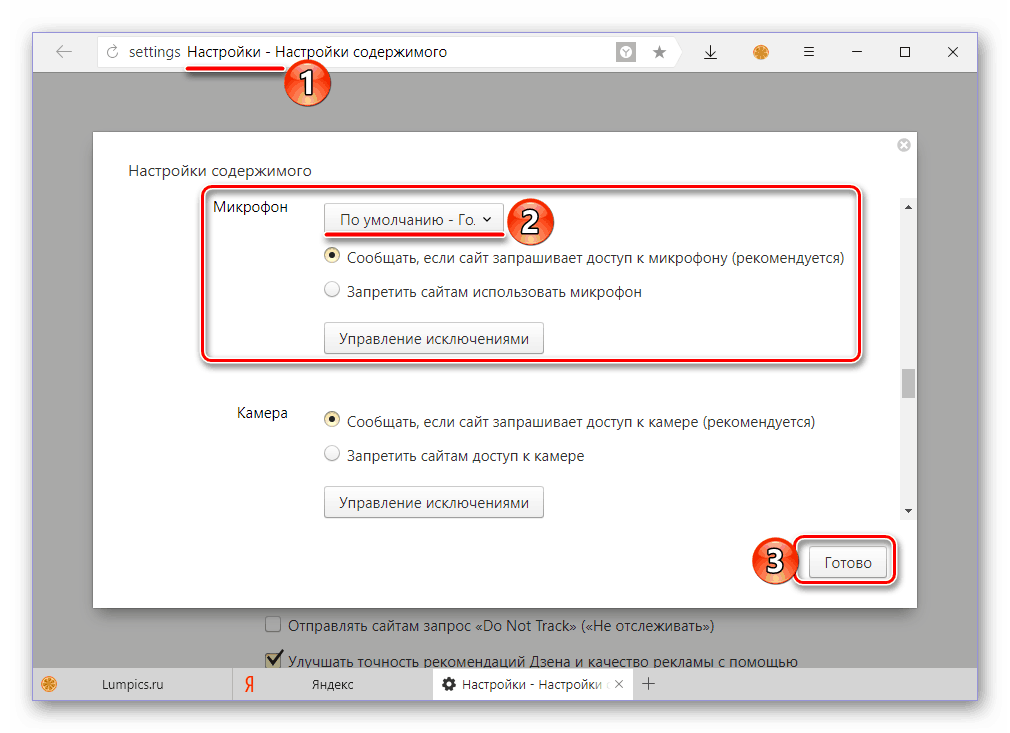

Порядок смены голосового Помощника на телефонах HUAWEI (honor)

1. Запустить приложение Настройки телефона.

Запустить приложение Настройки телефона.

2. Войти в раздел «Приложения и уведомления» на главной странице Настроек.

Экран №1 смартфона – запустить Настройки телефона. Экран №2 смартфона – выбрать раздел «Приложения и уведомления».3. В разделе «Приложения и уведомления» выбрать пункт «Приложения по молчанию».

4. В разделе «Приложения по молчанию» выбрать пункт «Помощь и голосовой ввод».

Экран №3 смартфона – выбрать пункт «Приложения по умолчанию». Экран №4 смартфона – выбрать пункт «Помощь и голосовой ввод».5. Далее выбрать пункт «Помощник».

6. Для смены Помощника в окне «Выбор помощника» выбрать приложение «Яндекс».

Экран №5 смартфона – выбрать пункт «Помощник». Экран №6 смартфона – выбрать позицию «Яндекс».7. Теперь у вас в качестве Помощника установлена приложение Яндекс с голосовым Помощником Алиса.

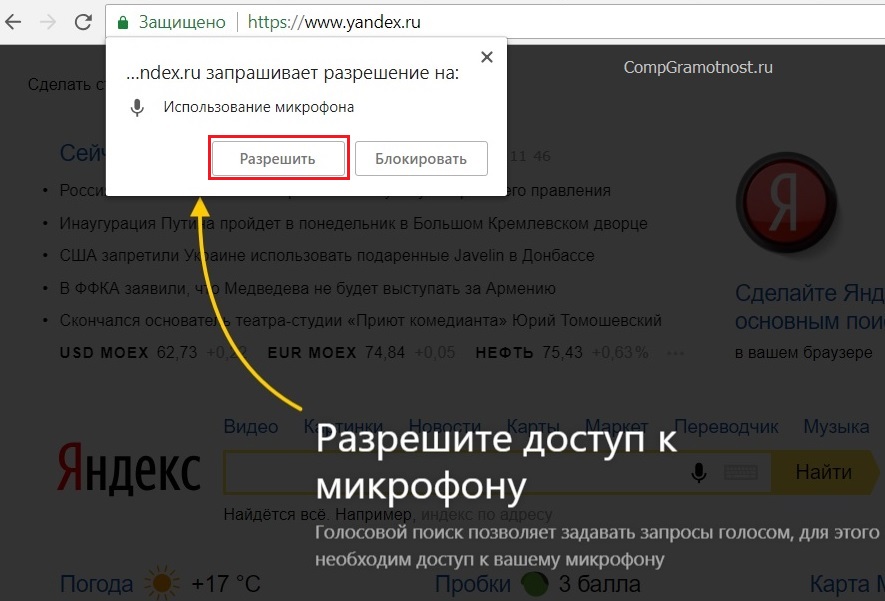

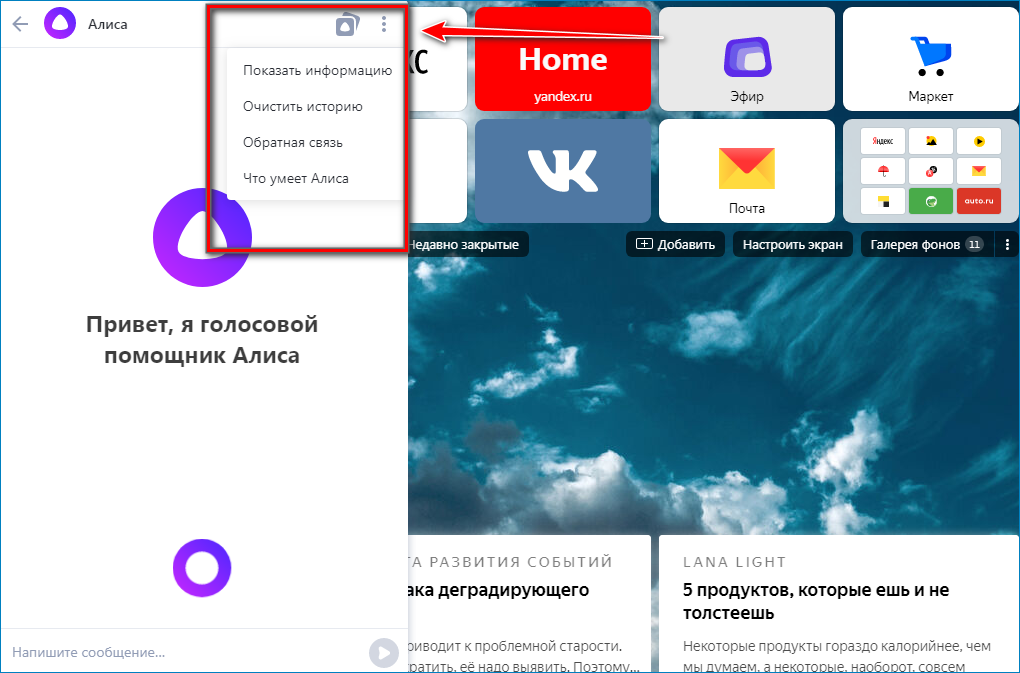

Для того чтобы запустить Помощник Алису вам нужно нажать и удерживать некоторое время кнопку «Домой» («Главный экран»). После этого на экране появится сообщение «Что Вас интересует? Скажите или напишите сообщение».

После этого на экране появится сообщение «Что Вас интересует? Скажите или напишите сообщение».

При этом внизу экрана появится пульсирующее фиолетовое кольцо – это Алиса ждёт вашей устной команды.

Экран №7 смартфона — нажимаем и удерживаем значок «Домой». Экран №8 смартфона — вид экрана при запуске Помощник Алиса.8. В случае необходимости вы можете задать вопрос через клавиатуру. Для этого вам вначале нужно нажать на значок «клавиатура» внизу в левом углу экрана и далее набрать вопрос с клавиатуры.

Экран №9 смартфона — вид экрана при вводе запроса с клавиатуры.9. Вы также можете воспользоваться камерой смартфона, и Алиса попробует распознать объект на фотографии. Чтобы перейти в режим фотосъёмки нужно нажать на значок «Фото» внизу в правом углу экрана.

В случае обнаружения текста на фото Алиса может распознать его и, в случае необходимости, может перевести его на русский язык.

Экран №10 смартфона — вид экрана при фотографировании через Помощник Алиса.

Статьи, связанные с этой темой:

— Что может голосовой Помощник Алиса на смартфоне HUAWEI (honor)?

— Голосовое управление смартфоном HUAWEI (honor) с помощью Google Ассистент.

— Как позвонить с помощью голосового Помощника Google по телефону HUAWEI (honor)?

— Как отправить СМС-сообщение с помощью голосового Помощника Google Ассистент на смартфоне HUAWEI (honor)?

— Как по Viber отправить сообщение с помощью голосового Помощника Google на смартфоне HUAWEI (honor)?

Глава российского «Яндекса» предстанет перед судом за «пропаганду ЛГБТ»

Новая Шотландия > БизнесЛюси Папахристу | Размещено: 19 часов назад | Обновлено: 19 часов назад | 2 минуты чтения

ИСТОРИЯ ПРОДОЛЖАЕТСЯ ПОД ЭТИМИ ВИДЕО SALTWIRE

youtube.com/embed/videoseries?list=PLWMvgY1LgJYX_AraFzEggttd7CrHydzDX» title=»SaltWire Videos» frameborder=»0″ allow=»accelerometer; clipboard-write; encrypted-media; gyroscope; picture-in-picture» allowfullscreen=»»>Люси Папахристу

(Рейтер) — Исполнительному директору интернет-компании «Яндекс», зарегистрированной на бирже Nasdaq, грозит судебное преследование в российском суде за предполагаемые правонарушения в соответствии с так называемым законом о «пропаганде ЛГБТ», говорится в сообщении на сайте суда в среду. .

Ходатайство о возбуждении уголовного дела против Артема Савиновского, дата судебного заседания по которому не указана, было принято на следующий день после того, как другой суд наложил штраф в размере 1 млн рублей (11 048 долларов США) на базу данных онлайн-фильмов, принадлежащую Яндексу, в соответствии с тем же законом.

Когда агентство Reuters связалось с Яндексом, оно заявило, что подаст апелляцию в суд на решение своего генерального директора.

На сайте суда не приводится конкретная информация о том, за какие предполагаемые правонарушения Савиновский привлекался к уголовной ответственности, кроме того, что они связаны с «пропагандой ЛГБТ». Дело является административным, а не уголовным, то есть касается нарушений законодательства, не причиняющих существенного вреда или общественной опасности.

Россия усиливает подавление прав ЛГБТ, которые президент Владимир Путин пытался представить как свидетельство морального разложения в западных странах, от которых Россия должна быть защищена.

В декабре прошлого года Путин подписал закон, расширяющий ограничения на пропаганду того, что он называет «пропагандой ЛГБТ», фактически запрещающий любое публичное выражение поведения или образа жизни лесбиянок, геев, бисексуалов или трансгендеров в России.

18+ LABEL

В прошлом месяце нижняя палата парламента, Государственная Дума, впервые поддержала закон, запрещающий операции по смене пола для трансгендеров.

Штраф к кинобазе Кинопоиск Яндекса был наложен за то, что он не прикрепил ярлык 18+ к семи фильмам на своем сайте, включая британскую романтическую комедию «Дневник Бриджит Джонс», британскую черную комедию «Жадность» и итальянскую комедию «Идеальные незнакомцы». ».

Кинопоиск в свою защиту утверждал, что фильмы можно смотреть только по подписке, которая доступна только зрителям старше 18 лет, но суд отклонил этот аргумент, сообщает независимая «Новая газета».

Ведущая российская технологическая компания «Яндекс» изо всех сил пытается сбалансировать внутреннее давление с интересами своих западных инвесторов с тех пор, как Москва вторглась в Украину в феврале прошлого года.

В прошлом месяце суд оштрафовал компанию на 2 миллиона рублей (24 242 доллара США) за неоднократный отказ предоставить российским службам безопасности информацию о своих пользователях.

Холдинговая компания Яндекса, зарегистрированная в Нидерландах, Yandex NV работает над корпоративной реструктуризацией, в результате которой будет выделен основной доходный бизнес внутри России и отдельно созданы четыре новых подразделения за границей.

Савиновский стал генеральным директором в апреле прошлого года после того, как предыдущий руководитель Яндекса Елена Бунина ушла в отставку вскоре после вторжения России в Украину. По данным «Коммерсанта», он пришел в компанию в 2008 году и ранее возглавлял ее медиа-отдел, курируя «Кинопоиск» и другие службы.

(Репортаж Люси Папахристоу; редакция Дэвида Холмса)

Поделиться историей:9 лучших поисковых систем распознавания лиц для поиска по лицу, а не по имени Ритеш Джа в ИИ | Последнее обновление: 30 мая 2023 г.

Поделись на:

Сканер безопасности веб-приложений Invicti — единственное решение, обеспечивающее автоматическую проверку уязвимостей с помощью Proof-Based Scanning™.

Вы бы поверили мне, если бы я сказал вам, что наши нынешние технологии намного опережают то, что мы используем сегодня? Возможно, вы помните дни, когда мы вводили чье-то имя в поисковую систему, чтобы найти его в Интернете. Сегодня единственное, что нам нужно, — это лицо, и мы можем получить всю информацию, связанную с этим лицом.

Это стало возможным благодаря нескольким поисковым системам распознавания лиц. Кроме того, эти поисковые системы предоставляют потребителям совершенно новый способ работы в Интернете. В прошлом мы собирали информацию о человеке или продукте с помощью словесных описаний, таких как имена. Сегодня с помощью поисковых систем распознавания лиц достаточно изображения или изображения. Итак, без лишних слов, давайте посмотрим на преимущества поиска по распознаванию лиц.

Поисковые системы распознавания лиц — будущее интернет-серфинга

В настоящее время подавляющее большинство людей в мире пользуются социальными сетями. Являетесь ли вы суперзвездой или обычным человеком, социальные сети доступны для всех. В Интернете ежедневно обмениваются и публикуются миллионы изображений. Поскольку потребление визуального контента в Интернете растет такими быстрыми темпами, необходимо развитие технологий.

В Интернете ежедневно обмениваются и публикуются миллионы изображений. Поскольку потребление визуального контента в Интернете растет такими быстрыми темпами, необходимо развитие технологий.

Из-за этого обратный поиск изображений сделал распознавание лиц невероятно полезным инструментом для определения профиля человека по его изображениям. Технология распознавания лиц (FRT) в настоящее время широко используется в государственном и частном секторах. FRT нужен для идентификации без пароля, типа Face ID. Единственное, что вам может быть интересно, это то, как работает поиск по распознаванию лиц. Итак, вот ответ.

Как работает поисковая система распознавания лиц?

Человеческий мозг в основном основан на распознавании образов. Возможный результат натолкнул на мысль поделиться этой способностью распознавания образов с роботами, также известными как искусственный интеллект. В сфере ИИ задачи распознавания лиц становятся все более важными.

Идентификация и верификация — два процесса, составляющие алгоритм работы FRT. Личность человека определяется на первом этапе, а его подлинность как человека, за которого он себя выдает, проверяется на втором этапе.

Личность человека определяется на первом этапе, а его подлинность как человека, за которого он себя выдает, проверяется на втором этапе.

В этой статье мы рассмотрим некоторые поисковые системы распознавания лиц. Итак, не теряя времени, вот список лучших поисковых систем, где вы можете использовать фотографию человека, чтобы получить всю информацию о нем в Интернете.

PimEyes

PimEyes – это поисковая система, которая использует обратный поиск изображений и может искать изображение или лицо на миллионах веб-сайтов (10 миллионов в зависимости от веб-сайта). За короткий период времени он заработал солидную репутацию.

Поисковая система быстро извлекает информацию о любом изображении из своей огромной базы данных изображений. Если вы ищете фотографии известных людей, это работает точно. Он будет давать точные результаты и включает почти 1 ТБ новых изображений.

PimEyes является как бесплатным, так и платным, что следует упомянуть в данном контексте. Однако бесплатное использование позволяет вам доказать, что изображения находятся в сети. Более того, для всех остальных опций, включая Deep Search, создание PDF-файлов и результаты на онлайн-сайтах, требуется платная подписка.

Однако бесплатное использование позволяет вам доказать, что изображения находятся в сети. Более того, для всех остальных опций, включая Deep Search, создание PDF-файлов и результаты на онлайн-сайтах, требуется платная подписка.

FaceCheck.id

FaceCheck.id имеет уникальный и яркий пользовательский интерфейс. Он использует искусственный интеллект, чтобы предложить вам учетные записи социальных сетей и веб-аккаунты человека, чье изображение вы используете. Возможность увидеть криминальную историю человека (если таковая имеется) была одним из самых интригующих аспектов, которые я видел. Людям, которые используют интернет-знакомства, будет разумно тщательно исследовать человека, с которым вы собираетесь встретиться (шучу, или я?😜)

Это один из тех сайтов с большим трафиком; поэтому вы можете оказаться в очереди. Да, вы не ослышались, но это еще не все. Чтобы отправить фотографию, вы также должны заявить, что не будете использовать информацию, полученную через этот веб-сайт, для противостояния, преследования, преследования или шантажа кого-либо.

Например, я исследовал информацию в Интернете, используя свою фотографию. Первое, с чем я столкнулся, это долгое ожидание в 45 запросов; через десять минут наконец настало мое время. Я был разочарован, так как ни один из результатов не имел ко мне никакого отношения. Это не означает, что сайт ненадежен. Вы можете выполнить поиск любой знаменитости и получить точные результаты.

Betaface

Betaface может быть привлекательным и приятным и может использоваться как в профессиональных, так и в личных целях. Первое, что вы увидите при загрузке фотографии или URL-адреса изображения, — это прямоугольник, охватывающий лицо. Затем на лице появится несколько точек, анализирующих несколько элементов лица, включая возраст, привлекательность и различные выражения лица и эмоции.

Инструмент можно использовать в качестве демонстрационной версии, но он не является бесплатным. После загрузки фотографии вы можете использовать кнопки для сравнения лиц, поиска известных людей и поиска в Википедии. Инструмент позволяет выполнять массовую загрузку и сравнение изображений. В дополнение к классификации лиц с использованием 101 профессиональной черты лица и 22 основных черт лица

Инструмент позволяет выполнять массовую загрузку и сравнение изображений. В дополнение к классификации лиц с использованием 101 профессиональной черты лица и 22 основных черт лица

Было бы лучше попробовать этот инструмент, так как вы также можете найти своего знаменитого двойника. Меня интересует мой знаменитый двойник.

TinEye

TinEye — еще одна поисковая система распознавания лиц, которая использует обратный поиск изображений для получения точных результатов. Веб-сайт утверждает, что они создали самые быстрые и точные в мире API-интерфейсы для распознавания изображений. Вы можете искать изображения, вставляя URL-адреса и загружая изображения.

Я решил попробовать, так как они сказали, что они самые быстрые и точные в мире. Сначала я протестировал его со своей фотографией, но, поскольку я не очень известен (на данный момент, может быть, в будущем), я получил «0 результатов найдено» в мгновение ока. Затем я сфотографировал Дуэйна «Скалу» Джонсона, и менее чем за секунду у меня было 38 результатов, связанных с изображением.

Исходя из собственного опыта, я уверен, что TinEye соответствует заявленным требованиям и заслуживает внимания. Кроме того, вы можете сразу же использовать его на своем телефоне или ПК, чтобы сэкономить время и место.

Image Raider

Благодаря простому пользовательскому интерфейсу и непосредственному сосредоточению на своей цели, Image Raider — это простой и удобный инструмент для распознавания изображений. На веб-сайте говорится, что они сосредоточены на обслуживании юридических компаний, фотографов и разработчиков. Несмотря на то, что это премиальная услуга, доступна бесплатная пробная версия, чтобы вы могли решить, стоит ли она того. Если вы оцените все детализированные функции, вы сможете купить план, который лучше всего соответствует требованиям вашей компании.

Моя любопытная голова снова хочет, чтобы я проверил инструмент. Поэтому я начал с образа Дуэйна Джонсона, который использовал ранее. Кроме того, я прошел капчу, чтобы продемонстрировать, что я не робот (по понятным причинам). Вскоре я наткнулся на более 30 результатов, связанных с изображением. Однако следует отметить, что данные изображения взяты из общедоступного источника, и инструмент не дает гарантий точности.

Вскоре я наткнулся на более 30 результатов, связанных с изображением. Однако следует отметить, что данные изображения взяты из общедоступного источника, и инструмент не дает гарантий точности.

В мире, наполненном поддельными вещами и фальшивыми людьми, вы должны быть осторожны на каждом шагу, который вы предпринимаете в Интернете при знакомстве с новыми людьми. Весь процесс становится более доступным для вас с помощью Social Catfish, который предоставляет вам все данные, связанные с изображением человека, которое вы загрузили с помощью платформы.

Лучшая особенность инструмента заключается в том, что он предоставляет информацию на основе изображения в дополнение к электронным письмам, именам, номерам телефонов, адресам и другим критериям. Это просто потрясающе!

Кроме того, вы не можете пользоваться услугой бесплатно, но вы можете заплатить за 5-дневный пробный период, прежде чем переходить на полноценную подписку.

Приложение сканирует метаданные изображений и информацию об устройстве, ищет личности мошенников в социальных сетях и т. д. Помните, однако, что вы не можете получить информацию об одном изображении, если не заплатите.

д. Помните, однако, что вы не можете получить информацию об одном изображении, если не заплатите.

Яндекс

Яндекс можно сравнить с поиском картинок Google, если вы когда-либо им пользовались. Вы получите ряд фрагментов информации на основе изображения при его загрузке. Данные включают в себя распознавание лица человека и одежду, которую он носит, среди других деталей.

Вы получите много результатов в зависимости от изображения, что является одним из недостатков, который я заметил, и иногда он кажется ненужным. Наконец, инструмент может быстро искать изображения, что позволяет сэкономить время. Вы можете иметь неограниченное количество совпадающих элементов, присутствующих на изображении, и видеть изображения, похожие на то, которое вы загрузили.

Bing

Пришло время гигантам присоединиться к списку. Технология распознавания изображений Bing, разработанная Microsoft, может распознавать широкий спектр изображений и быстро предоставлять вам результаты. Вы можете напрямую загружать фотографии с устройства или добавлять URL-адреса изображений; в любом случае вы мгновенно получите сотни результатов. Более того, это совершенно бесплатно.

Вы можете напрямую загружать фотографии с устройства или добавлять URL-адреса изображений; в любом случае вы мгновенно получите сотни результатов. Более того, это совершенно бесплатно.

После смены названия с Bing на Microsoft Bing поисковая система перешла на новый уровень. Поиск изображений был одним из многочисленных аспектов поисковой системы, на улучшение которого был направлен этот ребрендинг. Результаты поиска изображений Bing могут отображаться на нескольких вкладках, чтобы вы могли видеть их на других страницах.

Поиск изображений — одна из бесчисленных функций, которые предоставляет Google, пионер интернет-революции. Когда дело доходит до получения нескольких точных результатов, это совершенно бесплатно. Однако инструмент поиска изображений не использует распознавание лиц при поиске фотографий. Тем не менее, это может помочь вам найти похожие изображения.

Для начала найдите значок камеры в строке поиска и перетащите туда свое изображение, чтобы начать использовать поиск картинок Google.

Наш вокодер в первой системе был детерминированным DSP-алгоритмом (не обучался на данных) — подобно декодеру mp3, он «разжимал» параметрическое представление звука до полноценного wav. Естественно, такое восстановление сопровождалось потерями — искусственный голос не всегда был похож на оригинал, могли появляться неприятные артефакты вроде хрипов для очень высоких или низких голосов.

Наш вокодер в первой системе был детерминированным DSP-алгоритмом (не обучался на данных) — подобно декодеру mp3, он «разжимал» параметрическое представление звука до полноценного wav. Естественно, такое восстановление сопровождалось потерями — искусственный голос не всегда был похож на оригинал, могли появляться неприятные артефакты вроде хрипов для очень высоких или низких голосов.

А там, где знаков препинания нет, мы часто делаем паузы. Если эту информацию не передавать в акустическую модель, то она пытается её выводить и не всегда успешно. Первая модель Алисы из-за этого могла начать вздыхать в случайных местах длинного предложения. Задача паузера — предсказать класс паузы (отсутствует/короткая/средняя/длинная) после каждого слова. Для этого мы взяли датасет, разметили его детектором активности голоса, сгруппировали паузы по длительности, ввели класс длины паузы, на каждое слово навесили тэг и на этом корпусе обучили ещё одну голову внимания из тех же нейросетевых эмбеддингов, что использовались для детекции омографов.

А там, где знаков препинания нет, мы часто делаем паузы. Если эту информацию не передавать в акустическую модель, то она пытается её выводить и не всегда успешно. Первая модель Алисы из-за этого могла начать вздыхать в случайных местах длинного предложения. Задача паузера — предсказать класс паузы (отсутствует/короткая/средняя/длинная) после каждого слова. Для этого мы взяли датасет, разметили его детектором активности голоса, сгруппировали паузы по длительности, ввели класс длины паузы, на каждое слово навесили тэг и на этом корпусе обучили ещё одну голову внимания из тех же нейросетевых эмбеддингов, что использовались для детекции омографов. Мы долго писали правила вручную, но это отнимало много сил, было очень сложно и не масштабируемо. Тогда решили перейти на трансформерную сеть, «задистиллировав» знания наших FST в нейронку. Теперь новые «правила раскрытия» можно добавлять через доливание синтетики и данных, размеченных пользователями Толоки, а сеть показывает лучшее качество, чем FST, потому что учитывает глобальный контекст.

Мы долго писали правила вручную, но это отнимало много сил, было очень сложно и не масштабируемо. Тогда решили перейти на трансформерную сеть, «задистиллировав» знания наших FST в нейронку. Теперь новые «правила раскрытия» можно добавлять через доливание синтетики и данных, размеченных пользователями Толоки, а сеть показывает лучшее качество, чем FST, потому что учитывает глобальный контекст.