какие симптомы и как лечить

Маленький мишутка фильтр Панда от Google не такой уж милый и безобидный, как мы привыкли думать, вспомнив об этом зверьке. Он подстерегает многие сайты. И особенно Панде по вкусу творения начинающих оптимизаторов, которые только делают свои первый шаги в продвижении сайтов и толком ничего не понимают. Будьте бдительны!

Другие фильтры Google:

Другие фильтры Google:Функции

Главная функция фильтра Панда – устранить из первых мест поисковой выдачи материалы, которые потенциально не понравится пользователям, то есть те, который будут НЕполезны и НЕудобны. Говоря простыми словами – НЕкачественные статьи в топ выдачи не попадут.

Фильтр Панда способствует тому, что на первых местах в Google оказываются только качественные сайты, которые действительно полезны своим содержанием и удобны для большинства пользователей.

Симптомы и диагноз

Симптомы этой болезни очевидны — резкое ухудшение трафика из Google на одну или несколько страниц с некачественным материалом. По мнению некоторых оптимизаторов, фильтр Панда может даже выкинуть сайт из поиска полностью, то есть забанить. Но это, пожалуй, крайняя степень психопатии медведя.

При обнаружении влияния Панды от Google на некоторые страницы сайта, не допускайте распространения этого алгоритма на остальную часть вашего проекта. Всегда создавайте качественные и интересные материалы.

Применение фильтра Панды к сайту начинается с момента его обновления, которое происходит периодически. Поэтому ставить диагноз можно и на основное данных об апдейтах алгоритма, сопоставив их с падением посещаемости. Проследить это можно на удобном сервисе Barracuda, который также показывает и данные о другом фильтре Пингвин. Этот инструмент будет полезен только в том случае, если на вашем сайте установлен счётчик Google Analytics.

Причины

По каким аспектам Google с помощью фильтра Панда определяет некачественный сайт? Вот перечень признаков, при наличии которых есть риск словить фильтр:

- Много копипаста. То есть, если на сайте большое количество неуникального материала, это будет причиной для фильтра. Я бы вообще рекомендовал следить за тем, чтобы все статьи были уникальными.

- Много страниц, содержание которых не соответствует заголовку. Если вы объявили о том, что будете писать об улитках, то рассказывайте в статье только об улитках, и не отвлекайтесь сильно на тараканов. Заголовок должен быть релевантен содержанию, статьи должны быть релевантны рубрикам, рубрики должны быть релевантны сайту.

- Слишком частое употребление ключевых слов в статье, это ещё называют переоптимизация. Это мания, которой страдают начинающие оптимизаторы – они натыкают в статью кучу ключевых запросов и ждут хорошего результата. На самом деле, от этого ничего хорошего не будет, и Панда понизит сайт. Ключи нужно применять умеренно.

- Высокий показатель отказов, а равно и небольшое время пребывания посетителей на сайте. Если человек приходит на сайт и тут же с него уходит – это признак плохого проекта. Google фиксирует такие явления и если их станет слишком много, то принимает меры.

- Реклама на сайте, не соответствующая содержанию всего проекта, может стать причиной применения фильтра Панда.

- Отсутствие структуризации статей (без подзаголовков, выделений, списков, изображений и проч.) также провоцирует этот фильтр. Поэтому нужно добиваться удобочитаемости.

Лечение

Фильтр Панда в большинстве случаев – это не смертельно, и лечится. Совершите следующие действия, чтобы избавиться от него:

- Узнайте, по какой из выше перечисленных причин фильтр был применён к страницам вашего сайта. Наличие того или иного явления в ваших статьях и в поведении пользователей вам подскажет.

- Устраните причину. То есть, если вы поняли, что фильтр наложен за переоптимизацию ключами, то уберите лишние повторения запросов; если причиной явился высокий показатель отказов, то наполните текст более полезными материалами и сделайте его интересным.

- Проведите комплексное лечение. Когда основная причина устранена, не останавливайтесь. Если снизили переоптимизацию, то не помешает и улучшить структуризацию текста; если вы сделали статью интересней, то неплохо было бы поднять её уникальность. Это даст вам дополнительные балы.

После проведения лечения ждите следующего апдейта, и найдетесь, что ситуация исправиться. И никогда не опускайте руки!

Статьи по теме:

Фильтр Google Panda – кратко о главном : WEBCodius

Google.com – самый крупный поисковик в мире. Если говорить про рунет, то тут его доля, примерно 50%. И его основная задача, как поисковика, выдать максимально полезный ответ на запрос пользователя. И в этом деле, ему помогает, в том числе, фильтр Панда.

В интернете, между поисковыми системами, такими как Гугл или Яндекс, и вебмастерами, идет постоянная борьба. Вебмастера идут на самые различные уловки, чтобы их сайты оказались в топе выдаче поисковиков. При этом, вебмастера используют самые разные методы.

Сюда относятся в первую очередь белые методы, то есть, создание максимально полезного для людей контента. Но используются не только белые методы, которые поисковики сами рекомендуют, но также используются самые разные черные методы.

И для борьбы с черными методами, поисковики постоянно совершенствуют свои алгоритмы, с помощью которых они определяют, насколько тот или иной сайт, полезен для посетителей.

И если говорить про Google, то одной из важных вех, стало создание и внедрение алгоритма, задача которого, определять «плохие» сайты. И назвали этот алгоритм – Пандой.

Появление Панды.

Интересный факт. Хотя в интернете название алгоритма ассоциируется с этим милым зверьком, но на самом деле, имя было взято не с него. Истинный виновник появления этого алгоритма Навнет Панда (Navneet Panda). Это бывший студент из Индии, который закончил Индийский технологический институт. И затем он защитил доктора компьютерных наук в Калифорнийском Университете в Санта Барбаре (University of California Santa Barbara). Ну и затем он стал работать на Google.

Но вернемся к алгоритму. Первоначально, самая первая версия алгоритма 1.0 была запущена в работу 24 февраля 2011 года. Затем, спустя буквально пару месяцев, 11 апреля того же года, была запущена вторая версия 2.0. Затем, каждые несколько месяцев, выходили все новые обновления этого алгоритма.

В конечном итого, было выпущено 28 версий Панды. Последнее обновление было под номером 4.2 было выпущено 18 июля 2015 года. После чего, в конце 2015 года, Панда перестал быть отдельным алгоритмом и вошел в состав основного ядра поискового алгоритма.

Какие сайты затрагивает Панда.

Хотя Панда перестал быть отдельным алгоритмом, но он по прежнему работает. А значит, вебмастерам нужно знать, что он из себя представляет и как его избежать.

Можно сказать очень кратко, какие сайты Google любит и не любит. А любит он, качественные сайты. И соответственно, не любит, некачественные сайты.

И тут нужно сказать одну вещь, с Пандой шутить не стоит. В случае, если сайт попадает под его действие, то под удар попадает целый домен, то есть, весь сайт, а не отдельные страницы. И тогда, о поисковом трафике из Гугла, можно забыть. То есть, если наряду с плохими статьями, на сайте есть и хорошие, то под удар попадут и те, и другие.

Но все же, вот краткий список, чего нужно избегать.

Обилие рекламы. Если на сайте слишком много рекламы, много всплывающих блоков, мешающих просмотру полезного содержимого, то такой сайт, очень рискует.

Низкое качество статей. Различный машинный перевод, большое количество грамматических ошибок. Очень маленькие статьи, под микрочастотные запросы.

Дублированный контент. Это может касаться как ворованного контента с других сайтов, так и дублей на самом сайте. Поэтому все лишние разделы сайта, которые не должны попасть в поиск, нужно закрыть от индексации, например в файле robots.txt, а также используйте тег rel canonical

Переспам ключами. Не нужно вставлять ключи в каждое предложение. Вообще, пишите текст, ориентированный на пользователя, а не поисковую систему. У статей не должно быть определенной плотности ключей, как это делалось раньше.

Много страниц 404. Если удаляете статью, то и почистите внутренние ссылки, которые вели на эту статью. Или, в крайнем случае, поставьте с этих страниц 301й редирект, на другие, похожие статьи.

Плохие поведенческие факторы. Посмотрите, насколько комфортно посетителям на вашем сайте. Насколько текст контрастен к фону, насколько хорошо шрифт читабелен. Не слишком ли он мелкий, не слишком ли он крупный. Не слишком ли он экзотический, что его тяжело читать. Насколько легко перейти из одного раздела сайта на другой. Насколько легко найти определенную страницу сайта.

Посмотрите на такие показали, как процент отказов, глубина и время просмотра. Все это, может стать причиной попадания по Панду.

Как убрать фильтр Панда

Прежде всего, вам нужно понять, что вы попали именно под этот фильтр. Но к сожалению, точных инструментов, для этого нет. Однако, поскольку этот фильтр накладывается сразу на весь сайт, то это и может послужить своеобразным маячком. Если вы в один день, вдруг обнаружили, что траф с Гугл внезапно «испарился», и при этом, вы не меняли перед этим файл robots.txt, и при этом вы использовали рискованные методы продвижения сайта, значит у вас Панда.

Но в Панде хорошо то, что этот фильтр снимается. Вам достаточно устранить недостатки сайта, и спустя определенное время, около месяца, Гугл вернет сайт обратно в поиск.

Пройдитесь по всем статьям сайта. Просмотрите их. Насколько они написаны грамотным языком. Насколько они отвечают на запросы пользователя.

Если с этим все в порядке, то проверьте дубликаты страниц. Для проверки дублей страниц внутри сайта, есть различные сервисы и программы. Например Netpeak Spider. Это программа с большими возможностями по поиску ошибок на сайте, в том числе, дублей страниц. Программа платная, но имеет полнофункциональный, пробный период.

Также будет не лишним проверить, не своровали ли ваш контент для других сайтов. В этом случае, вам придется использовать сервисы или программы для антиплагиата. Например, адвего плагиутус. Так вы сможете увидеть, есть ли дубли у ваших страниц.

Проверьте комментарии на сайте. Панда оценивает не только основное содержимое сайта, но и комментарии тоже. Поэтому, убедитесь, что в комментариях, у вас нет ничего лишнего.

Заключение.

Я привел вам только основы по алгоритму Панда. Зная про этот фильтр, вы сможете его избежать. Для этого, вам нужно создавать уникальный, нужный контент для ваших читателей. И в этом случае, вам можно не боятся этого фильтра.

Что такое Google Panda: Полное руководство для SEO | Как выйти из-под фильтра

Google Panda – один из фильтров Google, который наказывает страницы низкого качества, чтобы поднять в результатах поиска страницы с качественным контентом. При этом Panda остается одним из самых непонятных алгоритмов.

Как сказал представитель Google:

Алгоритм Panda применяется целиком к сайту и является одним из основных факторов ранжирования. Он измеряет качество, о котором вы можете прочитать в нашем руководстве. Panda позволяет нам принимать во внимание качество и на его основе корректировать позиции в поиске.

[Примечание: Panda стала частью основного алгоритма Google]

Многие SEO-шники пытались проанализировать Panda редактируя сайты, которые падали или росли при очередном обновлении, но так и не обнаружили взаимосвязи.

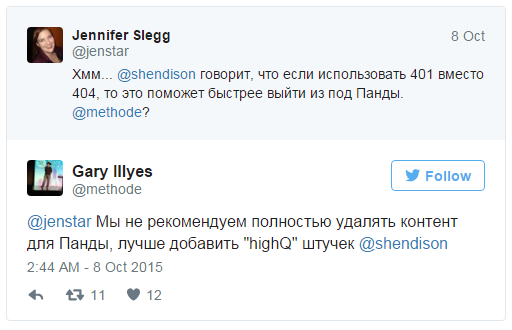

В копилку мифов о Panda добавляют случаи, когда вебмастера в попытках исправить ситуацию, делают своему сайту только хуже. Прекрасным тому примером служит распространенное мнение, что для выхода из-под фильтра, нужно удалить весь контент с сайта.

А учитывая нынешние длительные сроки развертывания этого фильтра, порой вообще сложно сказать повлияла ли на сайт именно Panda или один из несколько сотен других факторов ранжирования, которые также обновляются каждый год.

Что мы знаем наверняка, и сам Google это подтверждает, так это то, что вебмастерам, которые заподозрили приход Panda, не стоит рвать на себе волосы, все можно восстановить.

Гэри Иллиес (Gary Illyes) из Google сказал, что не рекомендует удалять контент в попытках снять Panda. И смысл в его словах есть, хотя некоторые оптимизаторы не согласны с этим. Удаление контента, который, как вам кажется, стал причиной фильтра, может привести к бОльшим проблемам для вашего сайта.

Удаление неправильного контента

Самая большая проблема в том, что вебмастера могут удалить контент, который Google считает хорошим, высоко ранжируется и приносит трафик.

При помощи Search Analytics в Google Search Concol можно найти страницы с нулевым трафиком из Google. Это хороший способ выявить потенциальных кандидатов, которым необходима доработка.

Представитель Google посоветовал пойти дальше и предложил использовать этот инструмент для поиска страниц, на которые были переходы с несоответствующих ее содержанию запросов. “Если вы считаете, что ваш сайт затронул алгоритм Panda, то в Search Analytics можно выявить переходы по запросам на страницы, которые явно не удовлетворяют потребность пользователя по данному запросу.”

Суммируя удаление не того, что нужно, может нанести значительный вред, так как вы теряете как качественный, с точки зрения Google контент, так и трафик. И в зависимости от числа удаленных страниц, может показаться, что трафик продолжает падать из-за Panda или других фильтров, в действительности же это результат ваших опрометчивых действий.

Кроме того, удалив качественный контент, вы можете потерять трафик из других поисковиков. Зачастую, когда люди смотрят на переходы из поисковых систем, они смотрят только на Google из-за его доли на рынке, забывая что при фильтре Panda, доля трафика из Google отличается от доли из других поисковиков.

Удаление vs исправление

Когда Иллиес сказал, что контент следует исправлять а не удалять, многие стали изменять свою стратегию “тотального удаления”, которую ранее рекомендовали эксперты по Panda. Если посмотреть все предыдущие высказывания Иллиеса или Джона Мюллера (John Mueller) по этой теме, то там всегда были рекомендации добавить новый качественный контент и исправить старый. И среди них не было ни слова про удаление. Вместо этого, если у кого-то все же чешутся руки, было предложено закрывать этот контент от индексации в robots.txt или noindex’ом.

В итоге, единственный план действий, который предложил Google для тех, кто не хочет улучшать некачественный контент – закрыть его от индексации, а не удалять полностью.

Джон Мюллер во время Google Webmaster Office Hours в марте 2014 все-таки упомянул удаление, но он говорил про агрегированные данные из RSS-каналов или комментарии пользователей.

В целом качество сайта должно быть значительно улучшено, тогда мы сможем доверять его контенту. Иногда на сайте мы видим много некачественного контента, который возможно был агрегирован из других источников, возможно это пользовательский контент, например не очень качественные статьи. Глядя на них, вы должны понимать нужны ли вам они, и если нужны, то предотвратите их появление поиске.

Можете использовать noindex в таком случае. А можете полностью удалить их, если не хотите, чтобы контент низкого качества был на вашем сайте. В любом случае, вам следует объективно взглянуть на ваш сайт и принять решение, которое улучшит положение дел.

Закрытый от индексации контент пользователи, при необходимости, смогут найти самостоятельно, а вы в свою очередь сможете отследить сохраняется ли естественный трафик на эти страницы. Это будет одним из признаков того, что вы ошибочно посчитали контент плохим.

Это же предлагала Майли Ойи (Maile Ohye) в далеком 2011-ом, когда Panda только запустилась. Она предлагала временно закрывать самый плохие страницы в noindex, пока на них не добавится уникальный контент.

Представитель Goolge, говоря про некачественные страницы, так же это подтвердил: “Вашей целью должно стать не удаление плохих страниц, а создание хороших, с уникальным контентом для ваших пользователей, которые будут доверять вашему сайту в будущем, видя его в результатах поиска.”

Когда необходимо удаление

Однако бывают случаи, когда удаление единственное верное решение. Например, если форум наводнен спамом и нет никакого другого способа избавиться от постов про “Купить виагру” или “Купить угги”.

Тоже самое можно сказать, когда на сайте транслируются rss-ленты и вебмастер не хочет переписывать все эти стать, добавляя новый свежий контент.

На Popcon Гэри Иллиес дал лучшую рекомендацию для тех, кто предпочитает удалять контент, а не улучшать его. Он посоветовал закрыть его от индексации, а ссылки на страницы добавить в карту сайта, чтобы Google быстрее учел это.

Добавление нового качественного контента

Добавление нового контента на сайт является отличным решением при Panda. Ведь сайт всегда выиграет от нового качественного контента, даже если некоторая его часть попала под фильтр.

Сайты под Panda могут ранжироваться

Бытует мнение, что сайт, который попал под Panda, перестает ранжироваться. Это заблуждение. Безусловно, если сайт в целом низкого качества, то фильтр накладывается на весь сайт. Но если на сайте есть качественные страницы, то они продолжают нормально ранжироваться.

И представитель Google это подтверждает:

Алгоритм Panda может продолжать показывать такой сайт в выдаче по конкретным и очень релевантным запросам, но его видимость будет уменьшена по запросам, где выгода владельца сайта непропорциональная к выгоде пользователя.

Это еще один аргумент в пользу слов Google: удаление – не лучшее решение. Удаление спама – это хорошо, но если дело просто в бедном контенте на странице, то добавление на нее дополнительного содержания, и на сайт в целом, поможет исправить ситуацию.

Все страницы должны быть качественными, чтобы сайт считался качественным?

Раз страницы хорошего качества могут хорошо ранжироваться, несмотря на некоторые страницы попавшие под Panda, то и сайт может считаться качественным несмотря на такие страницы. Однако это справедливо только в том случае, когда качественных страниц большинство.

Как нам говорит представитель Google:

В целом сайты высокого качества содержат полезный для пользователей контент на подавляющем большинстве своих страниц.

Таким образом, сайт с небольшим числом низкокачественных страниц все еще может считаться качественным. Поэтому, хотя рекомендация улучшать плохие страницы остается в силе, вебмастерам не стоит сильно волноваться, если несколько страниц хуже, чем все остальные. Но они должны быть уверены, что таких страниц действительно меньшество.

Ожидания посетителей

Вы отвечаете на поисковые запросы ваших посетителей? Как часто говорит Google:

Вы должны быть уверены, что обладаете контентом, удовлетворяющим ваших пользователей. Вы можете иметь потрясающий контент, но если, ранжируясь по специфическим запросам, вы не даете людям то, что они ищут, Google может посчитать такой контент плохим.

Представитель Google дал простое пояснение:

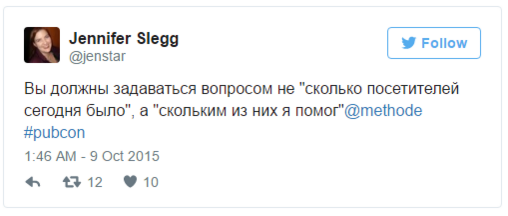

В конце концов, владельцы контента не должны спрашивать сколько посетителей к ним приходит за день, а скольким посетителям они помогли.

Это похоже на то, что сказал Иллиес выступая на PubCon в октябре 2015 года.

Дублированный контент

Многие предполагали, что фильтр дублированного контента был частью Panda, но это не так. Джон Мюллер подтвердил, что Panda и фильтр дублированного контента – “две отдельные и независимые вещи”.

В любом случае, независимо от того является ли фильтр частью Панды или нет, он отлично справляется с удалением дубликатов. А при массовом злоупотреблении дубликатами, может стать сигналом для ручных санкций.

Мюллер, отвечая на вопросы о сайте пораженном Пандой, сказал что даже с точки зрения SEO, вы должны больше беспокоится о том, что ваш контент лучше всех, а дубликаты имеют куда меньший приоритет.

Если бы вы спросили меня, что стоит делать на сайте в первую очередь, то я бы поставил удаление дубликатов в конец списка. Несомненно, этим стоит заниматься, но точно не в первую очередь. Наши алгоритмы довольно лояльны к дубликатам в пределах одного сайта. Если вы решили продать автомобиль, то помыть его будет хорошей идеей, но если у автомобиля есть серьезные технические проблемы, то мытьем дело не исправишь.

Другими словами, внутренние дубликаты не являются причиной Panda, особенно в среде неопытных владельцев сайтов на WordPress, случайно дублирующих страницы. Это лишь малая часть в алгоритмической головоломке.

Схожее содержание

Вы должны внимательно подходить к своему контенту, особенно на сайтах тематики “how to”, где есть много очень схожих текстов. Если на сайте много статей на одну и ту же тему, то вероятно не все из них хорошего качества.

Например, у eHow есть больше ста статей (может и больше, но я перестал считать после сотой) о том, как прочистить туалет. Если сайт не претендует на роль самого лучшего сайта всех времен и народов чистимтуалеты.ком, то есть смысл объединить некоторые из этих статей. Тем более очень маловероятно, что на все 100 страниц есть трафик из Google.

Посмотрите на страницы на которые идет трафик с поиска, вероятно Google считает их достаточно хорошими и поэтому высоко ранжирует. А вот страницы с нулевым трафиком требуют внимательного изучения.

Если у вас есть много страниц со схожим содержанием и проблемы с Panda, то имеет смысл объединить те из них, что плохо ранжируются, повысить качество, а затем настроить редирект со старых URL.

404 – страницы не найдены

404 ошибки на Panda не оказывают влияния вообще.

Это справедливо. Иначе конкурентам было бы очень просто поставить кучу ссылок на несуществующие URL, если бы Google учитывал 404 ошибки в Panda или в основном алгоритме.

Агрегированный контент

Google, кажется, довольно низко оценивает агрегаторы, но с некоторыми исключениями.

Джон Мюллер объяснил низкую оценку агрегаторов тем, что пользователи хотят видеть непосредственно источник. И Google не видит смысла заставлять пользователя дважды переходить куда-то чтобы найти то, что они хотят.

Есть одна вещь, которую вы должны принять во внимание, наши алгоритмы сосредотачиваются на уникальном, убедительном и высококачественном контенте. Если на сайте представлен просто список ссылок на другие сайты, то какой смысл показывать его в поиске, лучше провести пользователя непосредственно к месту назначения. Поэтому, вместо того, чтобы заниматься техническими проблемами вроде индексации, я настоятельно рекомендую сделать шаг назад и пересмотреть модель вашего сайта.

Но есть и исключения – Techmeme.com – пример агрегатора, который отлично себя чувствует в Google.

Свежий взгляд на сайт

Одна из вещей, которую Джон Мюллер многократно рекомендовал за эти годы вебмастерам, которые хотят узнать насколько хорош их контент – это попросить посетить сайт человека несвязанного с сайтом, а затем поделиться фидбеком.

Кроме всего прочего, я также рекомендую пройтись по 23 вопросам Амита вместе с кем-то, кто не связан с вашим сайтом, после того как вы попросите выполнить некоторые задания на вашем сайте и других подобных сайтах. Вы упоминаете Panda, как алгоритм концентрирующий внимание на качестве контента, я в свою очередь предлагаю вам подобно Panda трезво оценить собственный контент.

Многие оптимизаторы считают, что их контент потрясающий, неважно писали ли они его сами или заказали, но по факту им сложно оценить его непредвзято.

Вторая часть статьи здесь, а за третьей сюда.

Источник: TheSEMPost

Перевод: webit

все, что нужно знать (Panda, Penguin…)

Официально (!) 400 тыс. сайтов в месяц попадают под ручные фильтры поисковой системы Google

…количество сайтов, попадающих под алгоритмические (автоматические) санкции Google еще больше.

Но только 20 из 400 тыс. подают заявку на снятие фильтров. Отсюда следуют интересные выводы…

Вывод №1. Всего лишь 5% сайтов узнают, что попали под фильтры Гугла.

Вывод №2. Количество ресурсов, которым удается выбраться из под санкций в десятки раз меньше тех, которые под них попали.

В этой статье вы узнаете, какие фильтры бывают у поисковой системы Google, и как не попасть под них.

А если вы все-таки попали под них, вы узнаете, как быстро выбраться.

Быстрая навигация1. Санкции за некачественный контент (Google Panda)

Помните главного персонажа из мультфильма “Кунг-Фу Панда”? Забавно, но этому довольно неуклюжему герою всегда удавалось побеждать своих более мастеровитых соперников.

Мораль такова:

Если на вашем сайте много некачественного контента, вы проиграете также, как и все соперники героя мультфильма.

Но кому именно грозит фильтр Google Panda?

Он грозит тем ресурсам, контент которых :

- Не несет ценности.

- Напичкан ключевыми словами (переоптимизация).

- Содержит много рекламы.

Все вышеперечисленные проблемы делают ваш сайт бесполезным в глазах поисковых систем.

Помимо низкокачественного контента, есть еще 3 ситуации, которые могут спровоцировать наложение данного фильтра.

Во-первых, это дубли контента. Бывает, статья на блоге относится к разным рубрикам и доступна по разным URL адресам:

www.site.ru/mercedes/mercedes-s-500

www.site.ru/nemetskie-avto/mercedes-s-500

Во-вторых, это каннибализация ключевых слов. Такое происходит, когда вы создаете несколько страниц для одного и того же запроса:

www.site.ru/kak-puteshestvovat-besplatno

www.site.ru/kak-puteshestvovat-besplatno-po-miru

Обе страницы в примере выше продвигаются по одному запросу, тем самым мешая друг-другу. Но существуют более опасные ситуации: когда для одного запроса создаются 7-8 разных страниц.

Посмотрев на примеры выше, вы могли подумать, что каннибализация ключевых слов встречается только у информационных ресурсов, но это не так. Часто и у коммерческих проектов можно встретить страницы, продвигающиеся под один и тот же запрос.

В-третьих, к фильтру Google Panda может привести воровство контента. Это не самая лучшая идея — брать контент с других сайтов и размещать у себя.

Возможно, один такой случай ни к чему плохому и не приведет (с точки зрения SEO), но частое пренебрежение моральной чистоплотностью могут привести к санкциям.

Интересный факт…

Гугл Панда был запущен в 2011 году. Сразу после релиза в англоязычном интернете под фильтр попало около 12% всех сайтов. В марте 2013 года было объявлено, что фильтр Google Panda стал частью алгоритма Google.

Как определить, что сайт попал под фильтр Google Panda…

Ответ на этот вопрос, а также о том, как проходить лечение вы узнаете чуть позже. А пока мы переходим к следующему фильтру.

2. Манипуляция ссылками (Google Penguin)

Если вы когда-либо слышали о том, что ссылки помогают в поисковом продвижении, не торопитесь бежать на специализированные биржи и закупать их пачками.

Это как минимум может привести к сливу денег в унитаз. Как максимум, ваш сайт может попасть под фильтр Гугл Пингвин.

Поисковая система Google не любит, когда вебмастера манипулируют ссылками в надежде заполучить высокие позиции в выдаче. На это могут указывать следующие факты:

- Неестественно быстрый рост ссылок (ссылочный взрыв).

- Ссылки с некачественных или нетематических ресурсов.

- Повторяющиеся анкоры (тексты ссылок).

Фильтр Гугла Пингвин был запущен в 2012 году, а в 2016 году он стал частью алгоритма поисковой системы. После релиза от Пингвина пострадали 3.1% англоязычных сайтов.

О том, как диагностировать Google Penguin и как выйти из под него вы узнаете чуть позже. А пока мы подходим к одному из самых важных “фигурантов”…

3. “Песочница” Гугла (фильтр Sandbox)

“Песочницей” принято называть период, в течении которого новый сайт не получает высоких позиций в поиске.

Существует ли на самом деле “Песочница”?

Есть много разных мнений на этот счет. Но все сходятся в одном: молодой ресурс в 99,99% случаев не способен получить ТОПовые позиции по высокочастотным запросам.

Почему такое происходит? Есть разные теории…

Теория №1. Корысть. Google хочет, чтобы вебмастера вкладывали деньги в контекстную рекламу, пока их сайт не начнет более или менее хорошо ранжироваться в органической выдаче.

Теория №2. Логичное объяснение. Google хочет, чтобы новый ресурс прошел так называемый испытательный срок.

Поисковой системе требуется время чтобы понять, насколько качественным является сайт и насколько хорошо он удовлетворяет потребности пользователей.

Соответственно, Google смотрит на следующие метрики:

- Количество ссылающихся доменов

- Количество уникальных посетителей

- Показатель отказов

- Среднее время

- Упоминания бренда

- и так далее…

На сбор всех этих данных требуется немало времени. Именно поэтому молодой ресурс не получает ТОПовых позиций в течение долгого времени после запуска.

Теория №3. Отсутствие ссылок. Некоторые считают, что молодые сайты не могут высоко ранжироваться по высокочастотным запросам по той простой причине, что у них слабый ссылочный профиль.

Итак, сколько же длится период “Песочницы”?

Всегда по-разному. Но обычно от нескольких месяцев до 1 года. Многое зависит от ниши, конкуренции и многих других факторов.

Обычно, в таких тематиках как “медицина” и “юриспруденция” новички дольше находятся в “Песочнице”. И это логично, ведь недостоверная информация по этим темам может навредить жизни человека.

Можно ли быстро выбраться из “Песочницы”…

Можно. Есть 2 варианта, как это сделать. Хотя, второй вариант зачастую от нас не зависит…

Вариант 1. Если запуская интернет-магазин вы разработаете максимально широкое и грамотное семантическое ядро, есть вероятность, что Google сразу начнет давать вам достаточно трафика.

Вариант 2. Иногда Google может с самого начала (по своему усмотрению) дать новому сайту много трафика:

Источник изображения ahrefs

Он это делает для того, чтобы оценить поведенческие факторы.

Как быстрее выбраться из “Песочницы”…

Во-первых, удостоверьтесь, что ваш сайт не закрыт от индексации. Вам этот совет может показаться очевидным, но позвольте не согласиться.

Очень часто программисты во время проведения работ закрывают доступ роботам поисковых систем. Но при запуске рабочей версии они забывают убрать соответствующую запись в файле robots.txt и он остается “закрытым”.

Бывает и такое, когда сами владельцы временно закрывают его от индексации и при публикации контента забывают об этом.

Во-вторых, делайте ставку на низкочастотные запросы. По менее популярным запросам даже молодые ресурсы могут хорошо ранжироваться.

В-третьих, публикуйте качественный контент, который позволит увеличить брендированные запросы.

Чем больше людей будут вводить в поиск название вашей компании, название вашего продукта или ваше имя, тем быстрее получится выйти из “Песочницы”.

В-четвертых, делайте ставку не только на SEO, но и на другие направления маркетинга, например PR.

Делайте коллаборации с другими компаниями, возможно из смежных отраслей. Публикуйте гостевые посты, проводите совместные мероприятия или интервью с экспертами.

Суть в том, что о вас должны заговорить, про вас должны узнать. Это способно помочь вам быстрее пройти “испытательный срок” поисковой системы.

4. Удобство сайта

Находятся ли в зоне риска сайты, не заботящиеся об удобстве пользователя? Определенно, да.

Я бы хотел выделить 3 проблемы, которые в совокупности или по-отдельности могут привести ваш ресурс к фильтрам поисковой системы Google.

Битые ссылки

Большое количество битых (неработающих) ссылок негативно сказывается на пользователе.

Переходя по такой ссылке человек оказывается на пустой странице с “Ошибкой 404”.

Второй негативный момент заключается в том, что поисковый робот также переходит по этим ссылкам и эти переходы ничего хорошего не дают

…впустую растрачивается краулинговый бюджет.

В общем, от битых ссылок нужно избавляться.

С одной стороны, можно поменять их на рабочие.

Другой вариант — это сделать 301 редирект на релевантную страницу.

В крайнем случае, можно такую ссылку просто удалить.

Как массово находить и удалять битые ссылки рассказывается в моей новой электронной книге.

Неадаптивный дизайн

Если ваш сайт все еще не имеет адаптивной верстки, вам грозит соответствующий фильтр (алгоритмический).

Наказание простое — вы начнете терять трафик мобильных пользователей. При этом, трафик с декстопов может не проседать.

Решение простое — сделать сайт адаптивным, чтобы и мобильные пользователи могли получать удовольствие от его посещения.

Даже если с вашим сайтом все в порядке, я советую сделать проверку адаптивности (Google) перейдя по этой ссылке.

Порой, даже нормальные сайты не проходят проверку из-за неправильной настройки файла robots.txt.

Если это ваш случай, напишите об этом в комментариях и мы поможем решить проблему.

Долгая загрузка сайта

Долгая загрузка может привести к немилости Гугла. Вы увидите негативные последствия в виде проседания позиций.

Это может случиться как в мобильной выдаче, так и в декстопной.

Чтобы проверить скорость загрузки сайта, воспользуйтесь сервисом GTMetrix. Вполне нормально, если ваш он загружается в течение 3 секунд.

Хочу заметить, что здесь работает правило “Средней температуры по больнице”.

То есть, в некоторых нишах сайты грузятся дольше. В некоторых — быстрее. Google все это учитывает.

5. Мобильный редирект

Мобильный редирект — это когда пользователь переходит на страницу вашего сайта из поиска, а вы его перенаправляете на другой ресурс.

При этом, вы не делаете такого перенаправления для десктопных пользователей.

За это вы можете получить фильтр Google под названием“Мобильный редирект”. Это является разновидностью ручных санкций, о наличии которых вы можете узнать в Google Search Console.

Чтобы решить проблему, вам нужно убрать подобные редиректы с вашего сайта. Порой, причиной могут быть зараженные или взломанные скрипты, плагины.

6. Спам в микроразметке Гугл

Микроразметка контента позволяет Гуглу более точно понимать контент страницы, а вам — улучшить видимость сайта. Но помимо очевидных плюсов, могут быть и минусы.

Если вы, используя микроразметку прибегаете к спаму, на вас могут наложить соответствующий фильтр. Узнать об этот вы можете двумя путями.

Во-первых, вы можете получить сообщение в Google Search Console о том, что на вашем сайте обнаружен спам в разметке страниц.

Во-вторых, вы можете заметить, что расширенные результаты вашего сайта больше не появляются в результатах выдачи Гугла.

Чтобы выйти из данного фильтра проверьте все страницы на корректность разметки. Следуйте правилам поисковой системы.

Также, вы можете сделать проверку микроразметки Google с помощью специального инструмента.

7. Google Колибри (Hummingbird)

Многие ошибочно полагают, что “Колибри” — это фильтр поисковой системы Google. На самом же деле “Колибри” (Hummingbird на англ.) — это алгоритм поисковой системы Google.

Выше рассмотренные Panda, Penguin и RankBrain являются частью этого самого алгоритма.

Что делать, если сайт попал под фильтр Гугла (+ диагностика)

Во-первых, нужно знать, какие вообще могут быть последствия за неправильное продвижение:

- Полноценный бан — это когда сайт полностью исключается из индекса поисковых систем

- Пессимизация — это когда определенные страницы теряют свои позиции в поиске

- Выборочное исключение — это когда из индекса выпадают некоторые страницы.

Во-вторых, нужно проверить сайт на санкции. Для этого нужно держать в голове простую мысль. А именно, что в природе существует 2 вида фильтров:

- Ручные санкции Google

- Алгоритмические санкции

Если на ваш ресурс наложили ручной фильтр, вы можете легко узнать об этом открыв Google Search Console. В этом случае появится сообщение в разделе «Меры, принятые вручную»:

Определить алгоритмические фильтры Google гораздо сложнее. Здесь, в качестве симптомов могут служить:

- Выпадение страниц из индекса (можно узнать, проверив количество страниц в индексе)

- Понижение позиций по определенным или всем запросам

- Плохая индексация “свежих” страниц.

В третьих, обязательно нужно принять меры для выхода из под фильтра.

С ручными санкциями все просто: в сообщении от поисковой системы вы узнаете причину наложения.

Например, если вам наложили фильтр из-за манипуляции ссылками, вы их удаляете.

Если удалить не получается, например у вас нет выхода на владельца этого ресурса, или это арендованные ссылки, вы используете Google Disavow Tool.

Многие думают, что после исправления ошибок нужно связаться со службой поддержки Google. На самом деле, вам просто нужно подать заявку на пересмотр в Google Search Console.

Не забудьте указать, какие именно ссылки вы отклонили.

Сложность выхода из под алгоритмических фильтров состоит в том, что вам нужно определить причину наложения. Здесь вам на помощь придет простая логика.

Если вы не закупаете ссылки, но контент на вашем сайте оставляет желать лучшего (дубли, некачественные материалы, переоптимизация), то скорее всего вы имеете дело с “Пандой”.

Чтобы выйти из под данного фильтра вам нужно сделать аудит контента. Вот краткое изложение этого процесса…

- Спарсите все страницы своего сайта (Выгрузка из Google Analytics, XML карта и др.)

- Разделите полученные страницы на 4 категории:

- У которых частотность выше Х (значение по вашему усмотрению) и уникальный, качественный контент

- У которых частотность ниже Х и уникальный, качественный контент

- У которых частотность выше Х и НЕуникальный, НЕкачественный или Ворованный контент

- У которых частотность ниже Х и НЕуникальный, НЕкачественный или Ворованный контент

- Страницы из 1 и 2 категории мы не трогаем. Страницы из 4 категории мы нещадно удаляем. Если на них ведут много ссылающихся доменов, или они являются сервисными страницами, мы можем закрыть их от индексации, использовать canonical и так далее. Но большую часть мы все равно удалим. Страницы из 3 категории мы переписываем, делая контент уникальным и качественным. После снятия фильтра есть шанс получить по ним позиции.

После исправления всех недочетов имеет смысл запросить переиндексацию страницы через Google Search Console.

Также, люди часто спрашивают, есть ли онлайн сервисы для проверки на наличие фильтров Google.

Такие сервисы есть, и один из них — Fruition. Из минусов — сервис на английском и вам придется дать ему доступ к Google Analytics. Из плюсов — вы можете сделать до 2 проверок бесплатно.

Послесловие…

Итак, теперь вы узнали:

- Как не попасть под фильтры поисковой системы Google

- Что делать, если это уже случилось.

Если вы считаете, что данная статья была полезна, или что она может принести пользу кому-то еще — поделитесь ею сделав репост в социальных сетях.

«Буду рад, если вы в комментариях поделитесь своими мыслями …»

Гугл Панда — какие сайты попадают под фильтр и как избежать фильтра

Фильтр Google Panda в свое время наделал много паники в seo-кругах. Одни сайты просто вылетели из топа, у других произошла заметная просадка в позициях. Так поисковик объявил войну откровенно некачественным проектам, которые не представляют пользы для посетителей. Действие фильтра «Панда» можно сопоставить с эффектом АГС от Яндекса: и та, и другая поисковая система активно стала бороться с некачественными сайтами.

Какие сайты могут попасть под фильтр Гугла «Панда»?

Под санкции могут угодить интернет-проекты:

- с копипастом;

- которые используют приемы «черной» оптимизации и переоптимизируют страницы;

- использующие шаблонные решения (как в плане дизайна, так и в плане создания контента).

Поисковик не терпит переспамленные тексты, поэтому фильтр «Панда» от Гугла призван наказывать сайты за использование подобных методов оптимизации. Вхождение каждого слова и словосочетания должно быть естественным.

Под фильтр Panda Google могут попасть как новые, так и старые сайты. Однако у новичков больше шансов, т.к. они еще не завоевали доверие поисковика. Поэтому владельцам вновь созданных интернет-ресурсов нужно больше уделять времени белым методам оптимизации, добавлять только качественный контент, улучшать поведенческие факторы, проводить аудит сайта на ошибки.

Что учитывает алгоритм Google Panda?

Алгоритм «Панда» от Гугл постоянно совершенствуется, с момента его введения в начале 2011 года произошло множество обновлений. После каждого апдейта могла кардинально поменяться выдача по тому или иному запросу. Первое время обновления шли один за другим. Сейчас Panda – это не просто фильтр, а один из методов ранжирования поисковика. Это значит, что информации об апдейтах больше не будет – изменения могут вступать в силу автоматически с обновлением основного алгоритма. Официально Гугл никак не комментирует, как теперь будут внедряться изменения алгоритма.

Как избежать Google Panda?

Чтобы не попасть под санкции и сохранить позиции в выдаче, нужно точно знать, за что можно угодить под фильтр. Поисковик на основе содержимого страницы присваивает ей определенную ценность. Если на сайте размещена бесполезная информация, то даже при уникальном контенте велик шанс угодить под действие фильтра. Поэтому нужно заботиться не только об оригинальности, но и о полезности.

Панда не приветствует копипаст и спам. Если на сайте размещено много навязчивой рекламы, то проект тоже будет в зоне риска. Причиной понижения позиций может стать переизбыток ссылок, если по мнению поисковика они мешают пользователю. Не стоит размещать много рекламы, однозначно нужно отказаться от тизерных кампаний.

За что Гугл «Панда» не накладывает санкции?

Если у сайта есть проблемы с перечисленными ниже признаками и у него посыпались позиции, не стоит грешить на «панду», это произошло из-за других алгоритмов. К фильтру эти факторы ранжирования не имеют отношения:

- страницы с 404 ошибкой;

- отсутствие текстов;

- небольшие объемы статей;

- дублирование контента и мета-тегов;

- социальные сигналы, отражающие вовлеченность пользователя.

Поскольку фильтр Гугл «Панда» интегрирован в основной поисковый механизм, стало сложно понимать, почему в поисковике понизились позиции сайта. Стоит комплексно работать над проектом, постоянно улучшать его, заботиться о качестве контента, делать его полезным, удобным для прочтения. Ключевые слова нужно использовать без переспама, аккуратно вписывать их в текст. Стоит придерживаться общих рекомендаций поисковика по продвижению интернет-ресурса.

Фильтры Google — Пингвин и Панда. Как выйти из под фильтра

Фильтры Google могут создать много проблем как молодому сайту, так и устоявшемуся крупному порталу. Причины попадания под фильтр могут быть разнообразны, но эффект будет ощутим: трафик сайта существенно просядет.

Как не попасть под фильтр?

Продвигая и оптимизируя свой сайт в сети, необходимо знать принципы ранжирования в поисковых системах. Несоблюдение правил установленных поисковиками может повлечь ряд санкций, итогом которых чаще всего является блокировка сайта. Блокировка сайта заключается в том, что он будет запрещен к показу в выдаче той или иной поисковой системы, что несомненно повлечет за собой потери посетителей сайта.

Механизмом накладывания санкций является фильтр поисковой системы, который проверяет сайт на наличие грубых нарушений. Под грубыми нарушениями подразумевается искусственное продвижение различными способами, следствием чего является искажение поисковой выдачи. Данная проблема является самой распространенной у всех поисковых систем, но, как можно заметить, с появлением новых фильтров — интернет стал гораздо чище.

На данный момент существует около сотни различных фильтров у одного только Гугла — не все знают о них, так как лишь малая часть может коснуться веб-мастеров. Совсем недавно я рассказывал об относительно новом фильтре Яндекс Минусинск, о котором я также советую прочитать.

Фильтр Google Пингвин

Особенности Penguin

Фильтр вышел в свет в 2012 году и своим появлением навел много шума. После первого апдейта многочисленные сайты потеряли свои позиции, после чего встал острый вопрос: как выйти из под фильтра?

Характерность Google Пингвин:

- аномальная потеря позиций в выдаче

- исходя из первого — большие потери в посещаемости

Попадание под фильтр трудно не заметить, но трудно понять какой именно это фильтр и каовы причины попадания под него. Пингвин относился с вниманием к внешним ссылкам и мог распознавать такие проблемы как:

- изобилие ключевых слов

- дефицит вхождений в виде адреса сайта

- отсутствие или дефицит именно тематических доноров

- обмен ссылками

- некачественные или заспамленные доноры

- неравномерность распределения ссылочной массы по страницам

- дубли контента

Таким образом, основной задачей фильтра стала именно блокировка некачественных ресурсов, на которые ссылались некачественные сайты. Более того, эти ссылки должны быть естественными: сайт должен иметь не только влиятельные ссылки, но и те, которые не несут в себе никакого веса.

Помимо внешних ссылок, требования затронули и исходящие. При указании таковой ссылки, следует убедится в качестве сайта, в ином случае можно залететь под Пингвина. Особенно это касается коммерческих проектов, на которые уделяется особое внимание. Самое простое решение проблемы — для большинства ссылок указывать nofollow.

Как я уже упоминал, важным критерием фильтра является — естественность ссылок. Нельзя допускать резкого повышения ссылок — только по мере развития проекта. Даже если ссылки будут высокого качества, резкое их появление в большом количестве непременно приведет к одному — попадание под фильтр, а то и не один.

Ещё один критерий стоит учесть, дабы избежать неприятностей с Пингвином: дублированный контент. Пингвин анализирует ваш сайт в поиске и при наличии дублей — так же может наложить санкции. Стоит заметить, что Пингвин занимается лишь поверхностным анализом контента, в отличие от следующего фильтра, который мы рассмотрим.

Как выйти из под фильтра Google Penguin

Если всё-таки вы попали под фильтр — не стоит отчаиваться. Выйти можно и нужно, это лишь вопрос времени — главное понять под какой фильтр вы попали. Специально для этого существует удобный сервис — Barracuda, которому придётся предоставить данные из Google Analitics. С помощью него можно сопоставить спад посещаемости и апдейт определенного фильтра.

При попадании под фильтр — в Google Webmaster будет соответствующее уведомление. Если это Пингвин, то я бы начал с отсеивания некачественных входящих ссылок: именно в этом и заключается смысл фильтра — бороться с покупными ссылками. После выявления мусорных ссылок — необходимо от них избавиться. Специально для этого случая Google предоставил сервис для удаления ссылок.

Для того, чтобы выявить заспамленные ссылки, необходимо выгрузить список всех ссылок из Google Webmasters в формате Excel (CSV):

Далее всё зависит от вас и от объёмов ссылочной массы: если ссылок небольшое количество или у вас много времени — всегда можно самостоятельно провести аудит и отсеять заспамленные ссылки. В ином случае — можно воспользоваться специальном сервисом Checktrust, который выполнит всю работу за вас.

После перехода на сайт, открываем в меню «BackLinks Cheker» и загружаем ранее полученный файл в формате CSV:

Следующим этапом будет выбор типа очистки:

- Легкая чистка — удалятся только бэклинки с самых некачественных сайтов;

- Умеренная чистка — удалятся все сайты по качеству ниже среднего;

- Отличная чистка — полная очистка от всех подозрительных ссылок;

- Жесткая чистка — останутся только самые качественные ссылки;

- Нужны все варианты — получить несколько вариантов очистки.

После проделанной операции будет предложен файл для сохранения в текстовом формате, в котором будут 2 файла:

- список качественных ссылок

- список некачественных ссылок

После этого можно смело отправляться в сервис удаления ссылок Google, который я упоминал выше и просто добавить файл с некачественными ссылками. Самое интересное то, что для операций в Google Webmasters всё уже подготовлено — некачественные ссылки приведены в правильный формат в сервисе BackLinks.

После этого остаётся лишь ожидать очередного апдейта и снятия санкций.

Если у вас нет желания проверять качество каждого сайта, на который вы устанавливали исходящую ссылку — достаточно запретить по ней следовать с помощью nofollow. О запрете к индексации я уже говорил в данной статье.

Фильтр Google Панда

Особенности Panda

Фильтр начал своё существование в 2011 году и вызвал большой ажиотаж во всей сети. Пожалуй, основной интерес веб-мастеров вызвал тот факт, что Панда действовала не совсем однозначно: одни сайты понижались в позициях, а другие наоборот быстро поднимались. Долгое время Панда вносила диссонанс в понимание веб-мастеров — это стало действительно серьёзной проблемой.

Спустя какое-то время, начали появляться первые обзоры и догадки касательно алгоритма фильтра и его возможных критериев. Как ни странно, на этот раз Google преподнёс сюрприз в виде детальной проверки контента сайтов и выявление таких критериев, как:

- наличие копипаста

- объём информации в статьях

- полезность материала

- переоптимизация контента

- изобилие рекламы на сайте

Уникальность контента, как никогда, стала ценится после появления Панды. И это здорово — теперь трудно найти в ТОПе выдачи некачественный скопированный материал. То же самое касается и объёма статьи — короткие или сверхбольшие статьи могут стать причиной попадания под фильтр (чаще всего это лишь дополнительный фактор).

Полезность материала определяется расчётом вышеописанных критериев, а также показателя отказов и времени, проведенного на сайте. Напомню, что показатель отказов является одним из важных поведенческих факторов, по которому учитывается качество сайта.

К переоптимизации контента стоит отнести злоупотребление ключевыми словами в статье, которые также называются академической тошнотой. Частое употребление ключевых слов расценивается как спам и однозначно будет внесено под фильтр. Напомню, что не стоит использовать ключевые слова с плотностью выше 2,5%.

Именно Панда стала основным оружием в искоренении рекламы на сайтах веб-мастеров, которые были вынуждены существенно ограничить её количество. С появлением данного фильтра было выбито из ТОПа большое количество сайтов, среди которых остались лишь действительно качественные, либо те, кто смог исправить и адаптировать свой проект под новые условия.

Как выйти из под фильтра Panda

Если вы столкнулись с таким фильтром, как Panda — это совсем неутешительные новости. Выбраться из-под данного фильтра достаточно сложно, но вполне возможно. Основной проблемой является то, что санкции Панды касаются в основном контента, которого может быть большое количество, что затрудняет процесс «реабилитации».

Чтобы выбраться из фильтра Панды придётся провести серьёзную работу с контентом, его качеством и характеристиками сайта в целом. Необходимо найти возможные проблемы поведенческого характера, либо наличие назойливой рекламы (если таковая есть). Если проблема всё-таки кроется в самом контенте — предстоит долгий процесс анализа и правок.

Чаще всего вся проблема кроется в переоптимизации текста, что расценивается как спам. Кстати, даже если таких страниц будет 2-3 — они потянут за собой весь сайт: поэтому стоит проверить каждую страницу сайта на предмет наличия спама.

Именно поэтому я советую не стараться влиять всеми силами на поисковую систему, а писать текст для людей, используя ключевые слова в достаточном количестве.

Это интересно

Подписаться на новостиПингвин и Панда — новые фильтры Гугла

Более года назад многие оптимизаторы и владельцы сайтов открыли для себя новые понятия. Именно тогда Гугл презентовал два своих фильтра – Панда и Пингвин. В одной из своих статей «Фильтры Гугла – чудо зверинец» я детально проанализировал все основные санкции которые вы можете получить за нарушение правил оптимизации сайта. Пингвин и Панда – это новая ветвь эволюции предыдущих фильтров. Они более совершенны, работают жестко, четко и точечно. Каждый фильтр наказывает сайты за конкретные нарушения. Сегодня мы постараемся детально разобраться с этим зверинцем от Гугла, проанализируем основные ошибки из-за каких сайт может попасть под фильтр, и поговорим о том, как выйти из под Пингвина или Панды.

Фильтр Панда от Гугла

Все началось в феврале 2011 года. Многие оптимизаторы, проснувшись утром и выпив чашечку кофе, занялись уже привычных для себя дело – проверка позиций и посещаемости своих сайтов. И каково было их удивление, когда в заветном ТОП5 их сайтов не оказалось, хотя еще вчера они были там, а трафик упал в несколько раз. Как сейчас помню, переполох на всех СЕО форумах и блогах был невероятный. Многие не могли понять, в чем причина, чего так резко упал трафик с гугла, и как с этим бороться. Как оказалось, всему причиной стал запуск нового алгоритма Гугл Панда, который задел не только откровенные ГС, но и вполне белые сайты, крепко закрепившиеся в ТОПе и работающие не первый год.

Гугл как всегда впереди планеты всей. Веб мастерам ничего не объяснили, никаких сведений про новый фильтр практически не было, как из под него выйти тоже мало кто понимал. Спустя несколько недель, представители поисковика удостоились выложить список факторов за которые нападает Панда. Но это был не ответ, а, скорее всего, издевательство.

1. Большое количество не уникального контента

2. Множество рекламы и всплывающих окон

3. Высокие показатели отказов и плохие поведенческие факторы

4. Не качественные исходящие и входящие ссылки.

Как вы видите, стандартный перечень базовых нарушений из-за которых можно попасть под совершенно любой фильтр. Пользы от такого ответы практически нет, ведь каждый, кто делает СДЛ и так избегает всех этих нарушений, но от Панды и их это не спасло.

Уже со временем стало понятно, что в основном фильтр Панда направлен на борьбу с не качественным контентом.

Как работает Панда?

Если у Вас на сайте очень много дублирующихся страниц, страниц с копипастом или переспамленным текстом, то они очень сильно понижаются в выдаче и уходят далеко за ТОП100. Также Панда бьет по пустым, техническим и не несущих никакой пользы читателю страницам.

Как не попасть под фильтр?

Вроде бы и раньше были санкции за все вышеперечисленные нарушения, но с приходом Пингвина поисковики стали более строже относится к сайтам, анализ стал глубже и тщательней. Если раньше вы могли себе позволить допускать ошибки, то теперь нужно свести их в минимуму.

Вот что нужно сделать в первую очередь:

1. Закрываем от индексации все пустые страницы, те которые не предназначены для пользователя или несут не уникальную информацию. К таким страницам можно отнести профили на форумах, формы регистрации, страницы с копипастом, странице которые находятся в разработке и т.д

2. Максимально избавляемся от всех дублирующихся страниц. Как это сделать я детально написал в статье «Дубли страниц. Как от них избавиться?».

3. Панда – это настолько привередливый фильтр, что даже несколько плохих страниц могут пошатнуть весь сайт. Внимательно следите за контентом, особенно на тех сайтах, где пользователи имеют возможность его добавлять.

4. Поднимайте социальную активность. Добавьте на все страницы кнопки соц. Сетей, чтоб пользователь мог рассказать про интересный материал.

5. Длина контента тоже может повлиять на качество страницы и всего сайта. Если у Вас маленький текст (до 1000 символов), то делайте его максимально интересным. Если же пишите больше статьи, то обязательно структурируйте, используя для этого теги разметки h2-h6.

6. Не ставте навязчивую рекламу. Если уже и хотите монетизировать сайт, то рекламные блоки должны дополнять контент, а не заменять его.

Не стоит путать Панду с новым алгоритмом ранжирования. Это не так. Панда – классический фильтр Гугла, который время от времени с распростертыми объятьями заходит в гости к сайтам. У Яндекса есть аналог – фильтр АГС, и с каждым днем эти два «монстра» становятся все больше и больше похожи. По этому, если вы делаете все правильно, то никакая Панда и АГС вам не страшны.

Стоит отметить, что с момента своего первого запуска и по сегодняшний день, фильтр Панда уже несколько раз менялся и дополнялся. Основа осталась такой же, но роботы стали более умнее, и делают меньше ошибок.

Вот совсем недавно Мэтт Каттс, руководитель компании Гугл, заявил, что Панда усовершенствуется каждый месяц, а глобальные обновления проходят раз в 3-4 месяца. Одно из последних было анонсировано 11 июня 2013 года. Как всегда, у Гугла с креативом хорошо – данный апдейт назвали Танец Панды.

Фильтр Пингвин – продолжение зверинца Гугла

Не успели оптимизаторы приспособится к одному зверю, как Гугл анонсировал выход нового фильтра Пингвин. Вот мне всегда было интересно, почему такие милые названия для столь жестких фильтров. Наверное это аналогия с самыми ужасными ураганами, которые называют женскими именами типа Сенди или Лиза.

24 апреля 2012 года – в этот солнечный день на просторах Рунета начал свою деятельность милый Пингвин. Но милым и пушистым он будет только для тех, кто не переусердствует с покупными ссылками, а если и покупает, то делает это грамотно и с умом. Также фильтр борется с поисковым спамом и черным СЕО с помощью которого пользователь пытается манипулировать выдачей.

Что ж нужно понимать под поисковым спамом:

1. Клоакинг – скрытие части текста или какого-то элемента страницы от пользователя, но в тоже время оставив видимым для поискового робота.

2. Переспам ключами в текстах.

3. Наличие неестественных ссылок которые ведут на Ваш сайт.

Больше всего проблем возникло именно с третьим пунктом. Если у Вас очень много одинаковых анкоров ведущих на сайт, преобладают ссылки с нетематических сайтов, очень быстрый прирост беков и качество этих беков оставляет желать лучшего, то Пингвин может клюнуть достаточно сильно.

В связи с этим, многие СЕО специалисты стали отмечать, что для продвижении в Гугле нужно использовать как минимум 50% безанкорных ссылок, и не более 20% анкоров с прямым вхождением ключа.

Как не попасть под фильтр?

Пингвин направлен на отслеживание внешних факторов продвижения вашего сайта. В связи в этим нужно соблюдать просты правила:

1. Не занимайтесь массовыми прогонами своего сайта по тысячам каталогов и форумов

2. Если покупаете ссылки, то старайтесь брать с трастовых сайтов. Ссылки должны быть вечные и в тематических статьях. О том как выбрать хорошего донора читайте в моей статье «Качественны сайт донор – отлично продвижение»

3. Около 50% ссылок ведущих на ваш сайт должны быть безанкорные, и не более 20% с прямым вхождением ключа.

4. Также обратите внимание на перелинковку на сайте. Это не 100%, но есть мнение, что внутренние ссылки тоже желательно делать с разными анкорами и максимально разбавлять.

Последнее обновление фильтра Пингвин произошло 22 мая 2013 года. Именно тогда многие веб мастера получили в сообщения в Веб Мастере Гугла о том, что на их сайт ведут неестественные ссылки, и если не принять никаких мер, то сайт сильно потеряет позиции. Я знаю людей, у которых трафик упал на 90-95%, с 10.000 до 500-700 человек в день.

Фильтры Панда и Пингвин — выводы

И в конце статьи можно сделать вывод, что запуском Пингвина и Панды Гугл постарался структурировать и объединить все существующие фильтры в два разных фильтра. Один из них отвечает за качество внутренней составляющей сайт, другой за внешнюю оптимизацию и продвижение. Скажу так, что если делать все грамотно, создавать сайт для людей, не переусердствовать с закупкой ссылок и придерживаться основ внутренней оптимизации, то никакие звери Вам не страшны. Развивайте свои сайты, пишите хорошие статьи, зарабатывайте деньги.

ПОДПИСАТЬСЯ НА НАШ YOUTUBE КАНАЛ

ПОДПИСАТЬСЯ НА НАШ VIULY КАНАЛ

Тут дают 10 токенов VIU за подтвержденую регистрацию

Вступить в закрытый Телеграм Чат

]]]]]]]]>]]]]]]>]]]]>]]>С уважением проект Анатомия Бизнеса

Рубрики:

- SEO для бизнеса

Если Вам понравился опубликованный материал – поделитесь им с Вашими друзьями: