рекомендации Яндекса — Блог Миралинкс

В официальном блоге для вебмастеров Яндекс рассказал, что относит к дублям страниц, и дал рекомендации, что с ними делать.

Дубли страниц для ЯндексаДублированными Яндекс считает страницы с идентичным или очень похожим контентом. Наличие таких страниц негативно сказывается на сайт в поиске.

Основные риски дублированных страниц:

- замедленная индексация важных для сайта/бизнеса страниц — робот не определяет и не исключает дубли, обходит каждую страницу наравне. Роботу требуется больше времени на обход;

- до того, как алгоритм признает страницы дублирующимися, они могут конкурировать в поиске;

- сложность сбора и аналитики данных, так как поиск показывает только одну страницу из группы дублей. Но может менять ее с обновлением базы. На выбор показываемой в поиске страницы влияют сотни факторов, повлиять на это невозможно.

Дублированные страницы появляются из-за технических ошибок или неверных настроек:

- CMS создает страницы как с ЧПУ, так и сохраняет страницу с техническим URL;

- некорректная настройка относительных ссылок приводит к появлению ссылок по адресам, которых физически не существует, но они отдают тот же контент, что и основные страницы сайта;

- ссылки с незначащими GET-параметрами, к примеру, для отслеживания переходов из определенного источника трафика;

- слеш и его отсутствие в конце ссылки.

Для поиска https://example.com/page_1 и https://example.com/page_1/ — это разные ссылки.

Для поиска https://example.com/page_1 и https://example.com/page_1/ — это разные ссылки.

Дублированными Яндекс также сочтет страницы с разными изображениями, но одинаковым текстом.

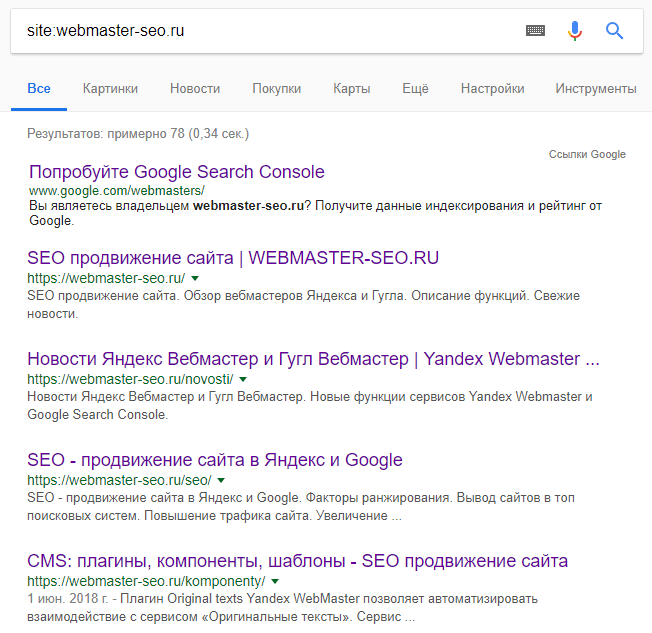

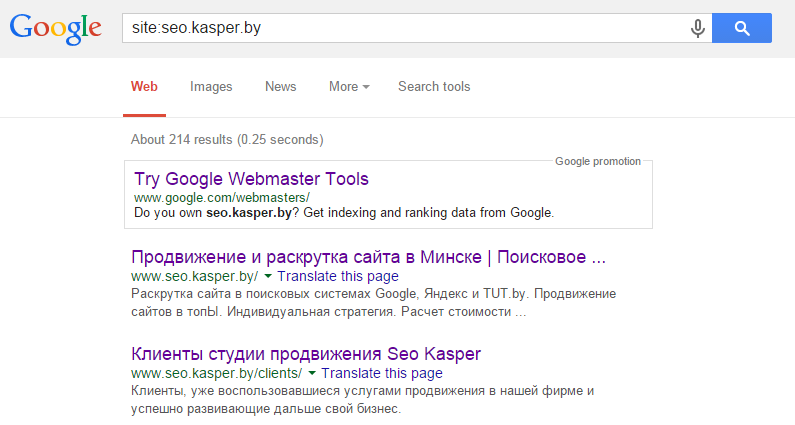

Как найти и что делать с дублями страницЯндекс упрощает задачу по поиску дублей. В Вебмастере в разделе Диагностика отображаются уведомления про большую часть дублей на сайте. Сообщение приходит с задержкой до 3 дней, это обусловлено сбором и обработкой необходимых данных. Иногда уведомление может приходить про уже исправленные страницы.

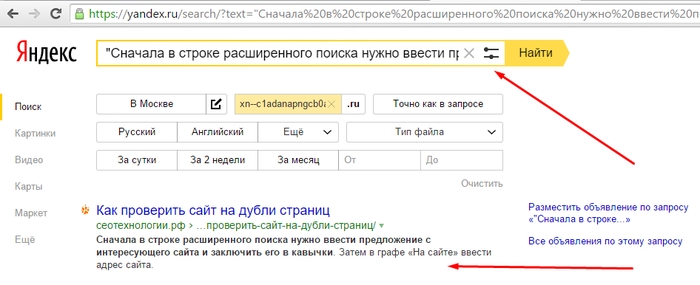

Также можно находить дубли страниц самостоятельно. Для этого в Я.Вебмастере необходимо:

- перейти на вкладку Индексирование;

- открыть раздел Страницы в поиске;

- в правой части кликнуть Исключенные.

В правом нижнем углу появится ссылка на скачивание таблицы. У дублированных страниц будет статус DUPLICATE.

Яндекс признает дублями не все страницы, на которых имеется идентичный контент. Такое может быть потому, что в момент индексации содержимое страниц отличалось либо на странице часть контента динамически обновляется, вследствие чего поисковая система при сканировании может каждый раз получать разные версии страницы. Чаще всего это относится к страницам с обновляемой лентой похожих товаров. Если вы знаете, что определенные страницы являются дублями, то стоит оставить в поиске только основные страницы.

Такое может быть потому, что в момент индексации содержимое страниц отличалось либо на странице часть контента динамически обновляется, вследствие чего поисковая система при сканировании может каждый раз получать разные версии страницы. Чаще всего это относится к страницам с обновляемой лентой похожих товаров. Если вы знаете, что определенные страницы являются дублями, то стоит оставить в поиске только основные страницы.

Для “мусорных” страниц Яндекс предлагает такие решения:

- запретить индексирование дублированных страниц через файл robots.txt с директивой Disallow

- применение метатега noindex для страниц, индексирование которых нельзя ограничить при помощи robots.txt

- настроить HTTP-код ответа 403/404/410 — наименее предпочтительный метод, так как на такие страницы смогут попадать пользователи, если на них ведут внешние и внутренние ссылки

Для дублей Яндекс предлагает использовать:

- дерективу Clean-param в файле robots.

txt

txt - 301 редирект

- атрибут rel=canonical

В последнем случае Яндекс предупреждает, что если страницы будут отличаться, либо их содержимое будет часто обновляться, то они обе могут попадать в выдачу.

Для ссылок со слешем Яндекс указывает, что основной можно выбрать любую. Для индексирования нет особой разницы. Для таких случаев лучше использовать 301 редирект.

Обратные ситуация: Яндекс признает дублями отличающиеся страницыСлучается так, что алгоритм признает дублями отличающиеся страницы, часть контента которых совпадает. Причина в шаблоне сайте и большом объеме шаблонного текста: меню навигации, футер сайта. Для решения таких ситуаций Яндекс предлагает следующие решения:

- изменить основной текстовый контент, чтобы страницы стали отличаться еще больше;

- добавить возможность комментирования на страницу;

- использовать noindex для шаблонных частей сайта.

Если Яндекс признает дублями страницы товаров, которые отличаются только изображениями, но цена и текстовое описание одинаковые, то в таком случае поиск рекомендует изменить структуру сайта, так как такие страницы не смогут отображаться в выдаче по релевантным запросам.

Больше рекомендаций по работе с дублями в Яндексе на странице Справки.

Читайте нас в Дзене!

Критичная ошибка «Найдены страницы-дубли с GET-параметрами»

6184 просмотров

С лета 2021 года Яндекс.Вебмастер стал информировать вебмастеров о наличии на сайтах страниц-дублей с GET-параметрами, причем помечается эта проблема как критичная, что многих пользователей приводит в ужас. Здесь мы расскажем что это за проблема и как от нее избавиться проще всего.

Что же такое GET-параметр — это динамический параметр в URL, с помощью которого возможно изменение содержимого документа. Самым частым примером URL с GET-параметром в интернет магазинах являются страницы пагинации, например, site/category?page=2 или сортировки, например, site/category?sotr=abc. page и sort являются параметрами. Таких параметров может быть бесконечное множество. Они могут генерироваться как изнутри самим сайтом (CMS), так и снаружи, например, добавляя UTM-метки для рекламных компаний вы создаете дубли страниц для поисковых систем.

Как решить проблему дублей?

Для этого Яндекс даже выпустил собственный подробный гайд.

Но он не раскрывает все методы, не рассказывает об их сильных и слабых сторонах и не описывает как эффективно комбинировать разные способы. Сначала мы опишем основные методы по отдельности, с их достоинствами и недостатками, а в конце самый эффективный способ комбинирования их.

Clean-param

Как использовать:

В файл robots.txt добавить директиву Clean-param с перечислением всех возможных GET-параметров через амперсанд, например, для страниц site/category?page=2 и site/category?sotr=abc Clean-param: page&sort

Кроме исключения дублей из поисковой базы, директива позволяет эффективно передавать параметры со страницы с GET-параметром на страницу без него.

Недостатки:

1. Так как GET-параметров может быть бесконечное количество, вам придется отслеживать появление новых параметров в поисковой выдаче и периодически обновлять директиву, поэтому способ подходит для небольших сайтов, либо для сайтов, которые генерируют мало GET-параметров.

2. Данная директива работает только для поисковой системы Яндекс.

3. Ограничение в 500 символов, при всем желании, не даст перечислить абсолютно все параметры в одной директиве.

rel=canonical

Как использовать:

Проставлять на страницах с GET-параметром атрибут с указанием URL канонической страницы, например, для site/category?page=2 тег будет выглядеть так <link rel=»canonical» href=»site/category» />

Такой способ тоже позволяет передавать параметры страницы, но менее эффективно.

Недостатки:

Является не строгим правилом для поисковых систем, поэтому значительная часть страниц может без проблем попадать в поисковую базу.

Disallow

Как использовать

В файле robots.txt прописать директиву Disallow: *?*, чтобы закрыть от индексации абсолютно все страницы с GET-параметрам. Более жесткое правило для поисковых роботов, поэтому достаточно эффективно убирает дубли страниц из поисковой выдачи.

Недостатки:

1. Не позволяет передавать параметры на нужную страницу.

2. Полностью исключает посещение поисковым роботом закрытых страниц.

Метатег robots

Как использовать:

Проставлять на страницах с GET-параметром <meta name=»robots» content=»noindex» />, что позволяет закрывать их от индексации, но не закрывает возможность посещать данные страницы поисковым роботам.

Недостатки:

Не передает параметры страницы.

Наиболее эффективный способ избавления от дублей

Сделав это раз вам больше не будет нужно мониторить появление новых дублей с GET-параметрами. Лучше всего комбинировать два метода Метатег robots и rel=canonical. Каждый из них будет дополнять друг-друга и компенсировать недостатки, а именно, canonical будет передавать все параметры со страницы с GET на основную, при этом, noindex будет более строгим правилом, что позволит сократить количество дублей страниц до минимума. Кроме того, оба этих способа работают для всех поисковых систем, а не только для Яндекс.

Чтобы внедрить данный метод к себе на сайт можно либо поставить ТЗ на разработку и разместить теги на всех страницах с GET-параметром (или только на нужных, либо поискать для своих систем управления готовые решения, например, на CMS Webasyst/Shop-Script есть несколько плагин, которые позволяют автоматизировать процесс простановки тегов по определенным условиям.

Переверзев Алексей

Руководитель отдела SEO-продвижения

дубликатов страниц — Вебмастер. Справка

Если страницы сайта доступны по разным адресам, но имеют одинаковое содержание, робот Яндекса может считать их дубликатами и объединять их в группу дубликатов.

Примечание. Дубликаты — это страницы на одном сайте. Например, страницы на региональных поддоменах с одинаковым содержанием не считаются дубликатами.

Если на вашем сайте есть дубликаты страниц:

Нужная вам страница может исчезнуть из результатов поиска, если робот выбрал другую страницу из группы дубликатов.

В некоторых случаях при наличии GET-параметров страницы могут не группироваться и участвовать в поиске как разные документы. В результате они конкурируют друг с другом. Это может повлиять на рейтинг сайта в результатах поиска.

В зависимости от того, какая страница остается в поиске, адрес документа может измениться. Это может повлиять, например, на достоверность статистики в сервисах веб-аналитики.

Роботу-индексатору требуется больше времени для обхода страниц сайта, а значит, данные о важных для вас страницах медленнее отправляются в поисковую базу. Также робот может создать дополнительную нагрузку на ваш сайт.

- Как определить, есть ли на вашем сайте дубликаты страниц

- Как избавиться от дубликатов страниц

Дубликаты страниц появляются по разным причинам:

Естественно. Например, если страница с описанием товара есть в нескольких категориях интернет-магазина).

Относится к функциям сайта или его CMS.

Чтобы узнать, какие страницы исключены из поиска из-за дублирования:

В Яндекс.Вебмастере перейдите на страницу Доступные для поиска страницы и выберите Исключенные страницы.

Щелкните значок и выберите статус «Удалено: Дубликат».

Вы также можете скачать архив. Для этого выберите формат файла внизу страницы. В файле дубликаты страниц имеют статус DUPLICATE. Подробнее о статусах

Если дубликаты были созданы из-за добавления GET-параметров в URL, уведомление об этом появится на странице «Устранение неполадок» в Яндекс.Вебмастере.

Примечание. Дубликат страницы может быть как обычной страницей сайта, так и ее быстрой версией, например страницей AMP.

Чтобы в результатах поиска была нужная страница, укажите ее для робота Яндекса. Это можно сделать несколькими способами в зависимости от типа URL.

URL-адрес страницы, включая путь к странице, отличается. В URL-адресе отображается URL-адрес главной страницы сайта. URL-адрес присутствует или отсутствует /Параметры GET различаются в тегах URLURL (UTM, from и т. д.) URL содержит параметры AMP-страницы

Пример для обычного сайта:

http://example.com/page1/ и http://example.com/page2/

В данном случае:

Настроить 301 редирект с одной страницы-дубликата другому. В этом случае цель редиректа будет включена в результаты поиска.

Укажите предпочтительный (канонический) URL страницы, которая будет включена в поиск.

Пример сайта с AMP-страницами:

http://example.com/page/ и http://example.com/AMP/page/

В этом случае добавьте директиву Disallow в файл robots.txt для предотвращения дублирования индексации страниц.

https://example.com и https://example.com/index.php

В данном случае:

Настройте редирект 301 с одной страницы-дубликата на другую. В этом случае цель редиректа будет включена в результаты поиска.

Укажите предпочтительный (канонический) URL страницы, которая будет включена в поиск.

http://example.com/page/ и http://example.com/page

В этом случае настройте редирект 301 с одной страницы-дубликата на другую. В этом случае цель редиректа будет включена в результаты поиска.

http://example.com/page/, http://example.com/page?id=1 и http://example.com/page?id=2

В этом случае:

Добавьте директиву Clean-param в файл robots.txt, чтобы робот не учитывал параметры URL. Если Яндекс.Вебмастер показывает уведомление о дублировании страницы из-за GET-параметров, этот метод исправит ошибку. Уведомление исчезнет, когда робот узнает об изменениях.

Укажите предпочтительный (канонический) URL страницы, которая будет включена в поиск.

http://example.com/page?utm_source=link&utm_medium=cpc&utm_campaign=new и http://example.com/page?utm_source=instagram&utm_medium=cpc

В этом случае добавьте директиву Clean-param в файл robots.txt, чтобы робот игнорировал параметры в URL.

Робот узнает об изменениях при следующем посещении вашего сайта. Как только это произойдет, страница, которая не должна быть включена в поиск, будет исключена из него в течение трех недель. Если на сайте много страниц, это может занять больше времени.

Проверить, что изменения вступили в силу, можно в разделе Страницы в поиске Яндекс.Вебмастера.

Если вы следовали приведенным выше рекомендациям, но изменения не повлияли на результаты поиска по прошествии трех недель, заполните форму ниже. В форме укажите образцы страниц.

Страницы с разным содержанием могут считаться дубликатами, если они ответили роботу сообщением об ошибке (например, в случае страницы-заглушки на сайте). Проверьте, как страницы реагируют сейчас. Если страницы возвращают другой контент, отправьте их на переиндексацию — так они быстрее вернутся в результаты поиска.

Проверьте, как страницы реагируют сейчас. Если страницы возвращают другой контент, отправьте их на переиндексацию — так они быстрее вернутся в результаты поиска.

Чтобы предотвратить исключение страниц из поиска, если сайт временно недоступен, настройте код ответа HTTP 503.

Новый формат сохраненной копии страницы в Яндексе

волк

4844

В октябре 2019 года Яндекс втихаря, без всяких объявлений и рекламы, подменил сохраненную копию формата страницы. Перейдя по ссылке «Кэшировать» в сниппете, попадаем на домен yandexwebcache.net, который ранее не использовался для хранения сохраненной копии.

На самом деле этот домен был зарегистрирован не далее как в августе 2019 года:

Шапка оформления страниц кэшированная копия служебной информации изменилась:

Хорошая новость — ссылка на текстовую копию стала работать в отличие от старый формат сохраненки. Доступна по ссылке «Полный текст», URL страницы текстовая версия сохраненная копия URL отличается от полной версии наличием get-setting режим = текст:

Доступна по ссылке «Полный текст», URL страницы текстовая версия сохраненная копия URL отличается от полной версии наличием get-setting режим = текст:

Но есть очень неприятная особенность нового формата хранимых копий — полностью исчезла подсветка ключевых слов в запросе как в полной версии, так и в тексте:

К счастью , выделение ключевых слов все же можно увидеть, применив простой лайфхак. Получается, что с введением нового формата хранимых копий Яндекс еще не убрал возможность использовать старый формат. Для доступа к сохраненке в старом формате нам нужно заменить URL домена на имя сохраненки https://yandexwebcache.net/ на https://hghltd.yandex.net/

Следует иметь в виду, что запустив полную версию сохраненной копии Яндекс может очистить URL в опции командной строки браузера get-sign (по крайней мере, для сохраненной копии исследования обращайтесь на главную страницу Яндекса).

Для получения текстовой версии хранимой копии старого формата с подсветкой, необходимо построить контактный URL полной версии, добавить сохраненки get-parameter &cht=1, , т.к. ссылка «Просмотреть копию текста», как я уже упоминал выше, работает некорректно:

Надо иметь в виду тот факт, что время жизни текущего значения параметра get-sign в URL сохраняются версии обоих новый и старый формат ограничен. А если мы начинаем при попытке скачать выдавать ошибку 404, то нужно обновить страницу с результатами поиска и извлечь сниппетную ссылку на сохраненную копию с новым значением параметра get-sign, , которые будут работать какое-то время. Например, за время написания статьи рабочее значение параметра get-sign в URL сохраненных копий этого примера менялось несколько раз, что видно на скриншотах.

Например, за время написания статьи рабочее значение параметра get-sign в URL сохраненных копий этого примера менялось несколько раз, что видно на скриншотах.

Буду надеяться, что сотрудники Яндекса восстановят подсветку ключевых слов в запросе сохраненки нового формата. А пока приходится делать вот такие вот танцы с бубнами с возвратом к старому формату для продуктивного разбора хранимых страниц копий. Проблема возможного несоответствия показаний версии хранимой копии страницы и той, что находится в индексе и используется для ранжирования, о которой я писал ранее, к сожалению, до сих пор актуальна.

- Артикул

- SEO

Современные проблемы SEO-специалистов

Доклад Сергея Кокшарова, SEO-аналитика, консультанта, автора блога devaka…

Турбо-страницы на реальных проектах

Так внедрять на турбо-страницу или нет? Доклад Ильи Горбачева (Ракурс) об оптимизации 2019конференция.

Для поиска https://example.com/page_1 и https://example.com/page_1/ — это разные ссылки.

Для поиска https://example.com/page_1 и https://example.com/page_1/ — это разные ссылки.  txt

txt

com и https://example.com/index.php

com и https://example.com/index.php