Какие страницы следует закрывать от индексации — SEO

Индексирование сайта – это процесс, с помощью которого поисковые системы, подобные Google и Yandex, анализируют страницы веб-ресурса и вносят их в свою базу данных. Индексация выполняется специальным ботом, который заносит всю необходимую информацию о сайте в систему – веб-страницы, картинки, видеофайлы, текстовый контент и прочее. Корректное индексирование сайта помогает потенциальным клиентам легко найти нужный сайт в поисковой выдаче, поэтому важно знать обо всех тонкостях данного процесса.

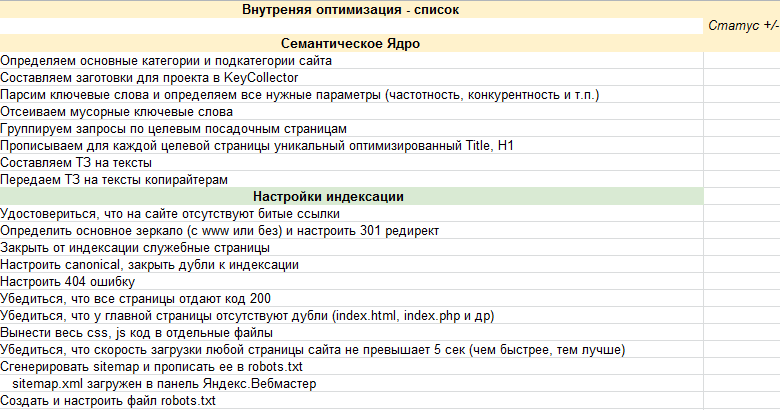

Почему важно ограничивать индексацию страниц

Заинтересованность в индексации есть не только у собственника веб-ресурса, но и у поисковой системы – ей необходимо предоставить релевантную и, главное, ценную информацию для пользователя. Чтобы удовлетворить обе стороны, требуется проиндексировать только те страницы, которые будут интересны и целевой аудитории, и поисковику.

Прежде чем переходить к списку ненужных страниц для индексации, давайте рассмотрим причины, из-за которых стоит запрещать их выдачу.

- Уникальность контента – важно, чтобы вся информация, передаваемая поисковой системе, была неповторима. При соблюдении данного критерия выдача может заметно вырасти. В противном случае поисковик будет сначала искать первоисточник – только он сможет получить доверие.

- Краулинговый бюджет – лимит, выделяемый сайту на сканирование. Другими словами, это количество страниц, которое выделяется каждому ресурсу для индексации. Такое число обычно определяется для каждого сайта индивидуально. Для лучшей выдачи рекомендуется избавиться от ненужных страниц.

В краулинговый бюджет входят: взломанные страницы, файлы CSS и JS, дубли, цепочки редиректов, страницы со спамом и прочее.

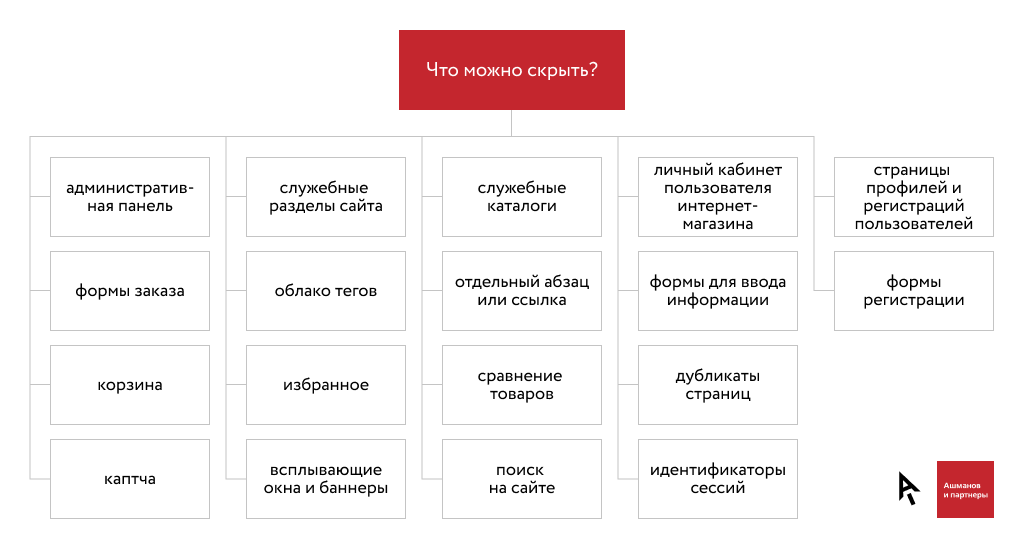

Что нужно скрывать от поисковиков

В первую очередь стоит ограничить индексирование всего сайта, который еще находится на стадии разработки. Именно так можно уберечь базу данных поисковых систем от некорректной информации.

PDF и прочие документы

Часто на сайтах выкладываются различные документы, относящиеся к контенту определенной страницы (такие файлы могут содержать и важную информацию, например, политику конфиденциальности).

Рекомендуется отслеживать поисковую выдачу: если заголовки PDF-файлов отображаются выше в рейтинге, чем страницы со схожим запросом, то их лучше скрыть, чтобы открыть доступ к наиболее релевантной информации. Отключить индексацию PDF и других документов вы можете в файле robots.txt.

Разрабатываемые страницы

Стоит всегда избегать индексации разрабатываемых страниц, чтобы рейтинг сайта не снизился. Используйте только те страницы, которые оптимизированы и наполнены уникальным контентом. Настроить их отображение можно в файле robots.txt.

Копии сайта

Если вам потребовалось создать копию веб-ресурса, то в этом случае также необходимо все правильно настроить. В первую очередь укажите корректное зеркало с помощью 301 редиректа. Это позволит оставить прежний рейтинг у исходного сайта: поисковая система будет понимать, где оригинал, а где копия. Если же вы решитесь использовать копию как оригинал, то делать это не рекомендуется, так как возраст сайта будет обнулен, а вместе с ним и вся репутация.

Веб-страницы для печати

Иногда контент сайта требует уникальных функций, которые могут быть полезны для клиентов. Одной из таких является «Печать», позволяющая распечатать необходимые страницы на принтере. Создание такой версии страницы выполняется через дублирование, поэтому поисковые роботы могут с легкостью установить копию как приоритетную. Чтобы правильно оптимизировать такой контент, необходимо отключить индексацию веб-страниц для печати. Сделать это можно с использованием AJAX, метатегом <meta name=»robots» content=»noindex, follow»/> либо в файле robots.

Формы и прочие элементы сайта

Большинство сайтов сейчас невозможно представить без таких элементов, как личный кабинет, корзина пользователя, форма обратной связи или регистрации. Несомненно, это важная часть структуры веб-ресурса, но в то же время она совсем бесполезна для поисковых запросов. Подобные типы страниц необходимо скрывать от любых поисковиков.

Страницы служебного пользования

Формы авторизации в панель управления и другие страницы, используемые администратором сайта, не несут никакой важной информации для обычного пользователя. Поэтому все служебные страницы следует исключить из индексации.

Личные данные пользователя

Вся персональная информация должна быть надежно защищена – позаботиться о ее исключении из поисковой выдачи нужно незамедлительно. Это относится к данным о платежах, контактам и прочей информации, идентифицирующей конкретного пользователя.

Страницы с результатами поиска по сайту

Как и в случае со страницами, содержащими личные данные пользователей, индексация такого контента не нужна: веб-страницы результатов полезны для клиента, но не для поисковых систем, так как содержат неуникальное содержание.

Сортировочные страницы

Контент на таких веб-страницах обычно дублируется, хоть и частично. Однако индексация таких страниц посчитается поисковыми системами как дублирование. Чтобы снизить риск возникновения таких проблем, рекомендуется отказаться от подобного контента в поисковой выдаче.Пагинация на сайте

Пагинация – без нее сложно представить существование любого крупного веб-сайта. Чтобы понять ее назначение, приведу небольшой пример: до появления типичных книг использовались свитки, на которых прописывался текст. Прочитать его можно было путем развертывания (что не очень удобно). На таком длинном холсте сложно найти нужную информацию, нежели в обычной книге. Без использования пагинации отыскать подходящий раздел или товар также проблематично.

Пагинация позволяет разделить большой массив данных на отдельные страницы для удобства использования. Отключать индексирование для такого типа контента нежелательно, требуется только настроить атрибуты rel=»canonical», rel=»prev» и rel=»next».

Помимо всего вышесказанного, рекомендуется закрывать такие типы страниц, как лендинги для контекстной рекламы, страницы с результатами поиска по сайту и поиск по сайту в целом, страницы с UTM-метками.

Какие страницы нужно индексировать

Ограничение страниц для поисковых систем зачастую становится проблемой – владельцы сайтов начинают с этим затягивать или случайно перекрывают важный контент. Чтобы избежать таких ошибок, рекомендуем ознакомиться с нижеуказанным списком страниц, которые нужно оставлять во время настройки индексации сайта.

- В некоторых случаях могут появляться страницы-дубликаты. Часто это связано со случайным созданием дублирующих категорий, привязкой товаров к нескольким категориям и их доступность по различным ссылкам. Для такого контента не нужно сразу же бежать и отключать индексацию: сначала проанализируйте каждую страницу и посмотрите, какой объем трафика был получен.

И только после этого настройте 301 редиректы с непопулярных страниц на популярные, затем удалите те, которые совсем не эффективны.

И только после этого настройте 301 редиректы с непопулярных страниц на популярные, затем удалите те, которые совсем не эффективны. - Страницы смарт-фильтра – благодаря им можно увеличить трафик за счет низкочастотных запросов. Важно, чтобы были правильно настроены мета-теги, 404 ошибки для пустых веб-страниц и карта сайта.

Соблюдение индексации таких страниц может значительно улучшить поисковую выдачу, если ранее оптимизация не проводилась.

Как закрыть страницы от индексации

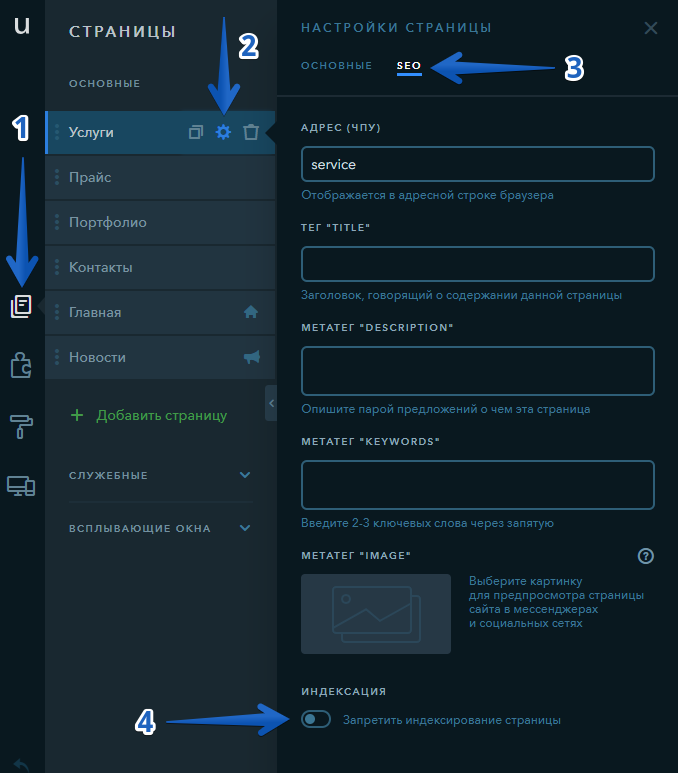

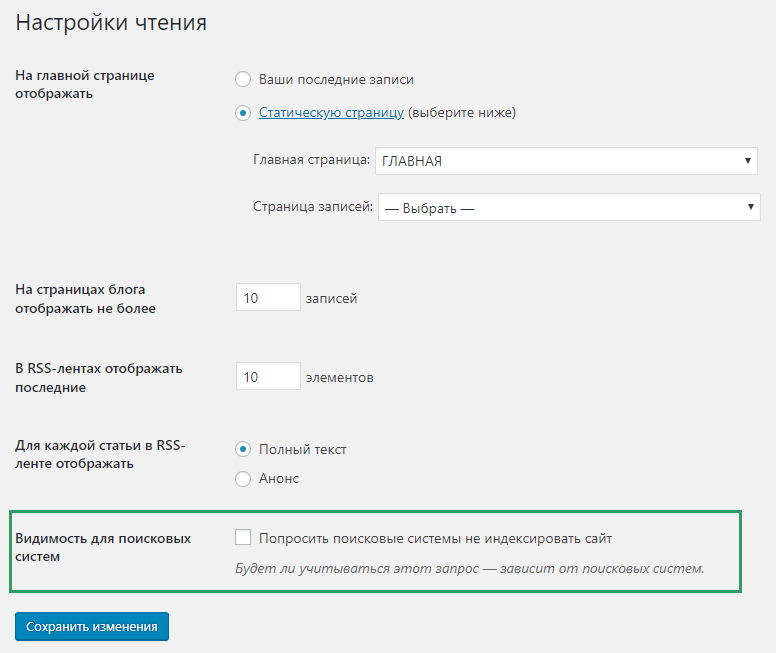

Мы детально рассмотрели список всех страниц, которые следует закрывать от поисковых роботов, но о том, как это сделать, прошлись лишь вскользь – давайте это исправлять. Выполнить это можно несколькими способами: с помощью файла robots.txt, добавления специальных метатегов, кода, сервисов для вебмастеров, а также с использованием дополнительных плагинов. Рассмотрим каждый метод более детально.

Скачать robots.txt для Invision Community

Способ 1: Файл robots. txt

txt

Данный текстовый документ – это файл, который первым делом посещают поисковики. Он предоставляет им информацию о том, какие страницы и файлы на сайте можно обрабатывать, а какие нет. Его основная функция – сократить количество запросов к сайту и снизить на него нагрузку. Он должен удовлетворять следующим критериям:

- наименование прописано в нижнем регистре;

- формат указан как .txt;

- размер не должен превышать 500 Кб;

- местоположение – корень сайта;

- находится по адресу URL/robots.txt, при запросе сервер отправляет в ответ код 200.

Прежде чем переходить к редактированию файла, рекомендую обратить внимание на ограничивающие факторы.

- Директивы robots.txt поддерживаются не всеми поисковыми системами. Большинство поисковых роботов следуют тому, что написано в данном файле, но не всегда придерживаются правил. Чтобы полностью скрыть информацию от поисковиков, рекомендуется воспользоваться другими способами.

- Синтаксис может интерпретироваться по-разному в зависимости от поисковой системы. Потребуется узнать о синтаксисе в правилах конкретного поисковика.

- Запрещенные страницы в файле могут быть проиндексированы при наличии ссылок из прочих источников. По большей части это относится к Google – несмотря на блокировку указанных страниц, он все равно может найти их на других сайтах и добавить в выдачу. Отсюда вытекает то, что запреты в robots.txt не исключают появление URL и другой информации, например, ссылок. Решить это можно защитой файлов на сервере при помощи пароля либо директивы noindex в метатеге.

Файл robots.txt включает в себя такие параметры, как:

- User-agent – создает указание конкретному роботу.

- Disallow – дает рекомендацию, какую именно информацию не стоит сканировать.

- Allow – аналогичен предыдущему параметру, но в обратную сторону.

- Sitemap – позволяет указать расположение карты сайта sitemap.

xml. Поисковый робот может узнать о наличии карты и начать ее индексировать.

xml. Поисковый робот может узнать о наличии карты и начать ее индексировать. - Clean-param – позволяет убрать из индекса страницы с динамическими параметрами. Подобные страницы могут отдавать одинаковое содержимое, имея различные URL-страницы.

- Crawl-delay – снижает нагрузку на сервер в том случае, если посещаемость поисковых ботов слишком велика. Обычно используется на сайтах с большим количеством страниц.

Теперь давайте рассмотрим, как можно отключить индексацию определенных страниц или всего сайта. Все пути в примерах – условные.

Пропишите, чтобы исключить индексацию сайта для всех роботов:

User-agent: * Disallow: /

User-agent: * Disallow: /

Закрывает все поисковики, кроме одного:

User-agent: * Disallow: / User-agent: Google Allow: /

Запрет на индексацию одной страницы:

User-agent: * Disallow: /page.html

Закрыть раздел:

User-agent: * Disallow: /category

Все разделы, кроме одного:

User-agent: * Disallow: / Allow: /category

Все директории, кроме нужной поддиректории:

User-agent: * Disallow: /direct Allow: /direct/subdirect

Скрыть директорию, кроме указанного файла:

User-agent: * Disallow: /category Allow: photo.png

Заблокировать UTM-метки:

User-agent: * Disallow: *utm=

Заблокировать скрипты:

User-agent: * Disallow: /scripts/*.js

Мы рассмотрели один из главных файлов, просматриваемых поисковыми роботами. Он использует лишь рекомендации, и не все правила могут быть корректно восприняты.

Способ 2: HTML-код

Отключение индексации можно осуществить также с помощью метатегов в блоке <head>. Обратите внимание на атрибут «content», он позволяет:

- активировать индексацию всей страницы;

- деактивировать индексацию всей страницы, кроме ссылок;

- разрешить индексацию ссылок;

- индексировать страницу, но запрещать ссылки;

- полностью индексировать веб-страницу.

Чтобы указать поискового робота, необходимо изменить атрибут «name», где устанавливается значение yandex для Яндекса и googlebot – для Гугла.

Пример запрета индексации всей страницы и ссылок для Google:

<html>

<head>

<meta name="googlebot" content="noindex, nofollow" />

</head>

<body>. Yandex" search_bot

Yandex" search_botСпособ 4: Сервисы для вебмастеров

В Google Search Console мы можем убрать определенную страницу из поисковика. Для этого достаточно перейти в раздел «Индекс Google» и удалить выбранный URL.

Процедура запрета на индексацию выбранной страницы может занять некоторое время. Аналогичные действия можно совершить в Яндекс.Вебмастере.

Как закрыть сайт от индексации в robots.txt

Вы уже знаете, как защитить свой сайт от кражи контента и что делать, если его все же украли. Сегодня продолжим говорить о проработке SEO. У веб-мастеров часто появляется необходимость ограничить доступ ко всему сайту или каким-либо его разделам. Практически на любом ресурсе есть то, что стоит спрятать и от поисковых роботов, и от посетителей.

Речь идет о дубликатах, профилях пользователей и других страницах с малосодержательным или неуникальным контентом. Их обязательно нужно закрывать от индексации, чтобы сайт не терял позиции в поисковой выдаче. Еще один момент — краулинговый бюджет. Это количество страниц конкретного сайта, которое роботы сканируют за определенное время. Если краулинговый бюджет расходуется на малополезные разделы, то важные данные могут вообще не проиндексироваться.

Еще один момент — краулинговый бюджет. Это количество страниц конкретного сайта, которое роботы сканируют за определенное время. Если краулинговый бюджет расходуется на малополезные разделы, то важные данные могут вообще не проиндексироваться.

Ограничить доступ ко всему сайту или конкретным страницам можно по-разному:

- через HTML-код с помощью тега noindex;

- в конфигурационном файле .htaccess;

- через системный файл robots.txt.

Вот о последнем способе мы и расскажем в этой статье.

Что такое файл robots.txt

Иногда встречается название «роботс.тхт», но мы будем говорить правильно — robots.txt. Представим, что этот системный файл выполняет функцию охранника большого офисного центра, т. е. сайта. Когда приходят посетители — поисковые роботы, robots.txt объясняет, куда гостям можно пройти, а где их не ждут. При запрете доступа ко всему ресурсу боты вообще не попадут в «здание».

Файл robots.txt должен быть на любом сайте. Не имеет значения, на какой CMS работает ресурс, — «1С-Битрикс», WordPress и т. д. Например, поисковые роботы могут зайти и увидеть, что на сайте много страниц с фильтрацией, которые генерируются для всех указанных в фильтре свойств. Ботам вряд ли понравится такой «грязный» ресурс. Они решат, что сайт не заслуживает хорошего ранжирования.

Найти системный файл легко. Достаточно добавить к адресу сайта /robots.txt, и все появится.

*Системный файл robots.txt на сайте Rubix.su

Что можно спрятать с помощью robots.txt

Разберемся, какие секреты умеет хранить системный файл.

*Ваши секреты точно останутся с вами

Фильтрация

Здесь не идет речь о посадочных страницах, которые оптимизированы под поисковые запросы. Их закрывать не нужно. Другое дело, если на сайте много страниц с фильтрацией, которые практически не содержат полезного контента. Их наличие может негативно повлиять на позиции ресурса в выдаче.

Их наличие может негативно повлиять на позиции ресурса в выдаче.

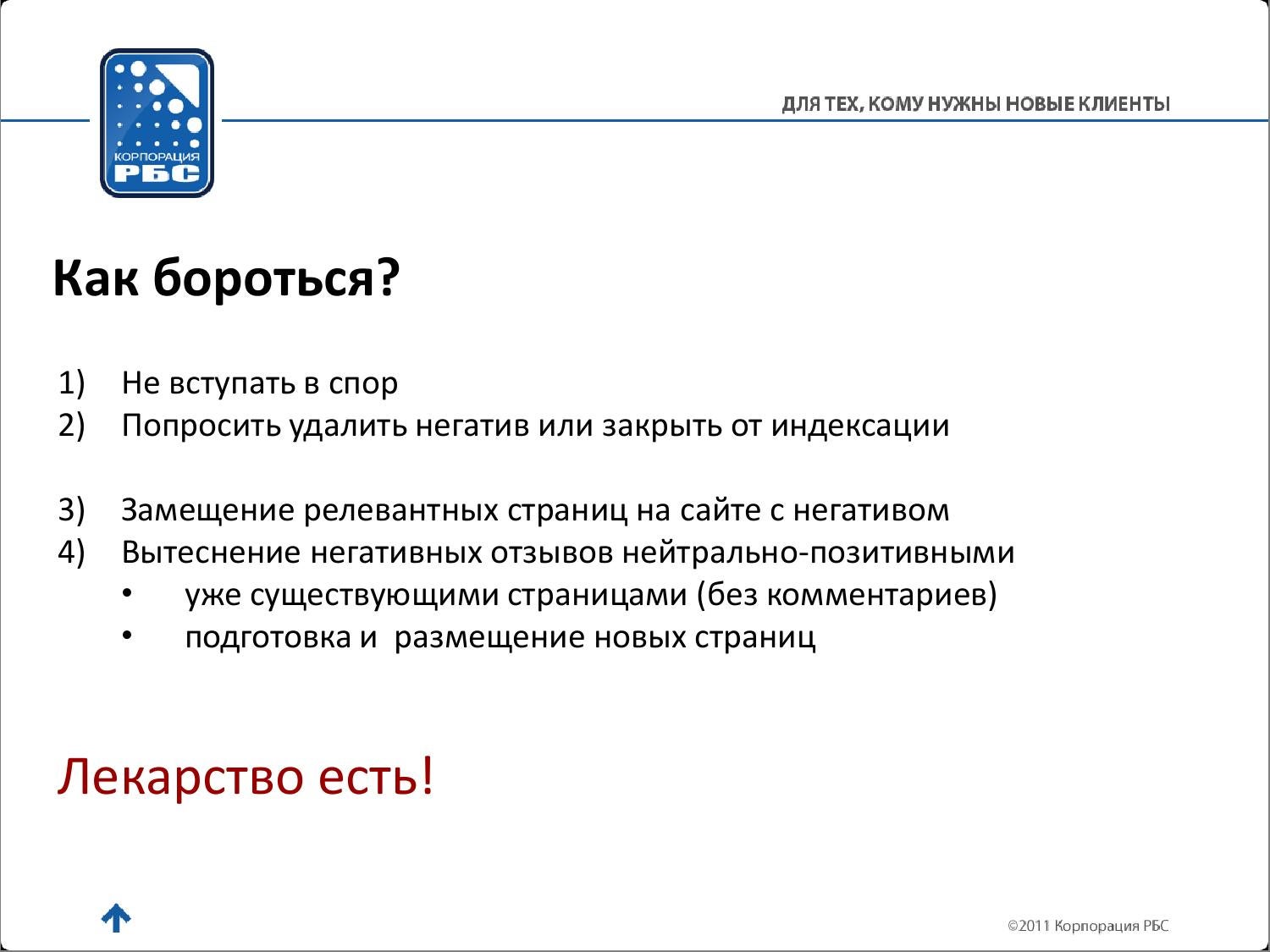

Дубли страниц

Это практически неотличимые друг от друга «близнецы» с разными URL, но одинаковым содержимым. Наличие дублей приводит к нескольким проблемам:

- Снижается скорость индексации новых страниц, т. к. поисковым роботам нужно обходить копии, чтобы добраться до свежих данных.

- Поисковые системы «склеивают» дубликаты и самостоятельно определяют, какой вариант будет основным. Здесь возникает риск, что выбранная копия не будет целевой страницей.

- Все дубли остаются доступными для индексации. В таком случае копии начинают конкурировать друг с другом, а это негативно влияет на ранжирование сайта.

Избежать таких проблем помогает robots.txt.

Документы для скачивания

Иногда веб-мастеру нужно скрыть от роботов файлы в формате .doc, PDF и т. д. Решить эту задачу можно с помощью robots. txt.

txt.

Здесь важно все тщательно взвесить. Например, внутренние документы и файлы с конфиденциальными данными нужно спрятать. Они не представляют интереса ни для посетителей сайта, ни для поисковых систем. Другое дело, если мы говорим о документах с полезной информацией — ГОСТах, инструкциях по применению и т. д. Такие файлы будут источником дополнительного трафика. После запрета индексации документов важно отслеживать посещаемость.

Страницы в стадии разработки

Проведение редизайна, отсутствие контента, дублирование содержимого — все это причины ограничить доступ к странице. Оставлять ее открытой точно не следует. Дело в том, что недоработанные страницы часто не нравятся поисковым системам и поэтому могут выпадать из индекса. Оптимальный вариант — скрыть «заготовки» с помощью специальной формы либо оставить к ним доступ только для администратора ресурса. Это поможет себя подстраховать. На боевой версии сайта могут случайно остаться ссылки на недоработанные страницы, а полное ограничение доступа позволит избежать неприятностей.

Служебные страницы

Технические страницы без полезного контента также стоит скрыть от роботов. Личный кабинет, корзина, результаты поиска по сайту — все это только мешает индексации.

Папки

Как правило, файлы сайта распределяются по папкам — категориям, каталогам и т. д. Robots.txt позволяет веб-мастеру быстро решить вопрос, если тот или иной раздел полностью устарел. В таком случае можно не тратить время на ограничение доступа к каждой неактуальной странице, а сразу закрыть всю папку. Главное — случайно не спрятать файлы, которые могут быть полезны для ранжирования.

Изображения

С помощью robots.txt веб-мастера могут запретить индексацию не только страниц или разделов, но и картинок. Если речь идет об уникальных полезных изображениях, то ограничивать к ним доступ не стоит.

Ссылки

Запретить индексирование конкретной ссылки с помощью robots.txt не получится. Для выполнения этой задачи подходит атрибут rel. Что касается robots.txt, то он позволяет:

Для выполнения этой задачи подходит атрибут rel. Что касается robots.txt, то он позволяет:

- скрыть страницу, на которой размещается ссылка;

- ограничить доступ к странице, на которую ведет ссылка.

Отдельные блоки

Здесь robots.txt тоже не работает. Чтобы скрыть отдельные блоки от поисковых роботов Яндекса, можно использовать тег noindex. С Google немного сложнее, но и здесь есть выход. Можно воспользоваться одним из нескольких способов — каждый из них по-своему хорош.

*Это лучше спрятать

Мы разобрались с тем, что позволяет спрятать robots.txt. Перейдем к тому, какими способами можно скрывать информацию с помощью системного файла.

Как запретить индексацию всего сайта

Чтобы ресурс стал для поисковых систем невидимкой, нужно открыть robots.txt и написать в нем две строки:

User-agent: *

Disallow: /

Директива user-agent связана с роботом, который подчиняется описанным в robots. txt правилам. Символ * указывает, на какие поисковые системы распространяется запрет. При необходимости спрятать сайт от конкретного робота, в user-agent нужно внести его название — Yandex или Googlebot.

txt правилам. Символ * указывает, на какие поисковые системы распространяется запрет. При необходимости спрятать сайт от конкретного робота, в user-agent нужно внести его название — Yandex или Googlebot.

Слово disallow означает «запретить». Косой слеш указывает на то, что все страницы сайта должны быть закрытыми от поисковиков.

Альтернативная директива allow — «разрешить» — позволяет открыть ресурс только для одного бота. Чтобы ее применить, нужно написать следующие строки:

User-agent: *

Disallow: /

User-agent: YandexImages

Allow: /

В нашем примере мы закрываем сайт для всех поисковых роботов. Доступ к ресурсу остается только у того бота, который сканирует изображения для Яндекс.Картинок. Директива allow также позволяет закрыть сайт от одного конкретного поисковика и оставить доступ для других.

Как запретить индексацию отдельной страницы

Здесь тоже нет ничего сложного. Нужно открыть robots.txt и написать:

Нужно открыть robots.txt и написать:

User-agent: *

Disallow: /page.html

В этом случае директива disallow включает относительный адрес той страницы, которую необходимо спрятать от ботов. Не нужно полностью прописывать URL, указывать префикс и домен — достаточно части ссылки после первого слеша.

Чтобы закрыть от индексации сразу несколько страниц, следует использовать директиву disallow для каждой из них отдельно. Перечислить их через пробел не получится — это ошибка.

Как запретить индексацию папки

Для решения этой задачи снова потребуется директива disallow. С ее помощью можно скрыть конкретный раздел либо папку с файлами. Например, нужно спрятать от ботов каталог. Для этого необходимо добавить в robots.txt следующее:

User-agent: *

Disallow: /catalog/

Вместо /catalog/ можно написать имя любой папки, к которой нужно ограничить доступ. Важно: с обеих сторон от названия должен стоять косой слеш.![]() Если все сделано правильно, поисковые роботы не будут замечать все страницы или файлы внутри директории.

Если все сделано правильно, поисковые роботы не будут замечать все страницы или файлы внутри директории.

Иногда веб-мастеру нужно ограничить доступ к папке, но таким образом, чтобы оставить открытым для индексации конкретный объект. В таком случае потребуется директива allow:

User-agent:*

Disallow: /catalog/

Allow: /catalog/file.php

Здесь file.php — это имя конкретного файла. Можно сделать еще проще. Если заменить название символом *, получится *.php. Таким образом, можно скрыть все файлы с расширением PHP, которые содержит конкретная папка.

Как запретить индексацию изображений

Для полного ограничения доступа к картинкам нужно прописать:

User-Agent: *

Disallow: *.png

Disallow: *.jpg

Disallow: *.gif

Чтобы избежать ошибки, важно правильно указать формат.

Как ограничить доступ к поддомену

Обычно у каждого поддомена есть свой robots. txt — он находится в корневой папке. Чтобы запретить индексацию, нужно открыть системный файл и написать:

txt — он находится в корневой папке. Чтобы запретить индексацию, нужно открыть системный файл и написать:

User-agent: *

Disallow: /

Список наиболее популярных поисковых роботов

Файл robots.txt позволяет обратиться по имени к боту конкретной поисковой системы. Вот список основных роботов:

- Yandex (Яндекс).

- Googlebot (Google).

- SputnikBot (Спутник).

- MSNBot (Microsoft Network Search).

- Slurp (Yahoo!).

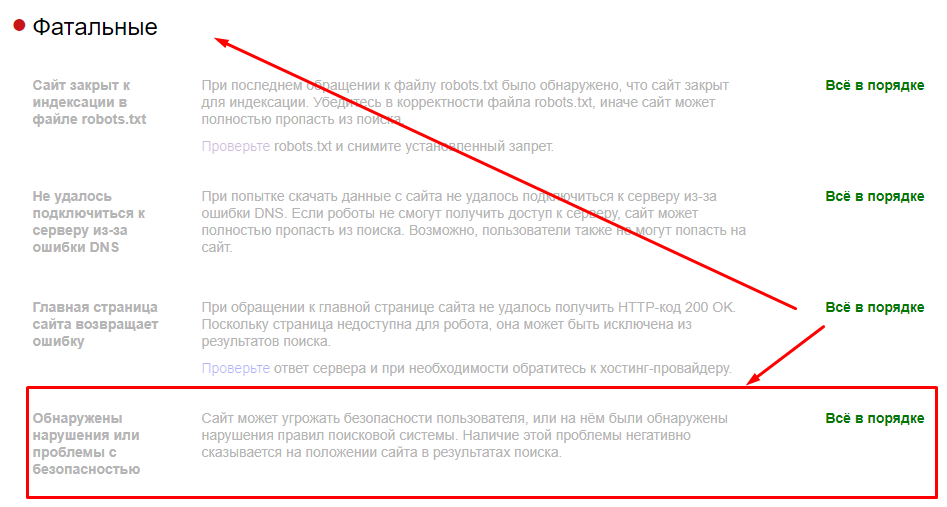

Как проверить robots.txt

Сначала нужно убедиться, что файл без проблем открывается. Для этого необходимо ввести в строку браузера адрес своего сайта и добавить к нему robots.txt. Это должно выглядеть так:

https://sitename.ru/robots.txt

Затем нужно проверить файл с помощью «Яндекс.Вебмастера» и Google Search Console. Разберемся, как это сделать.

«Яндекс.

Вебмастер»

Вебмастер»Нужно зайти в «Инструменты» и открыть «Анализ robots.txt». Содержимое файла должно отобразиться в строке. После этого нужно нажать «Проверить». Если в файле обнаружатся ошибки «Яндекс.Вебмастер» предложит способы их исправить.

*Проверка robots.txt через Яндекс.Вебмастер

Google Search Console

Веб-мастеру нужно авторизоваться в аккаунте и зайти в инструмент проверки robots.txt. После этого откроется окно, в котором отобразится подгруженная информация из файла. Если она не появится, ее можно будет вставить из браузера. После этого Google Search Console проверит файл на наличие ошибок и предложит методы их устранения.

*robots.txt можно проверить и через Google Search Console

Еще раз о главном

Robots.txt позволяет ограничить доступ к малосодержательному контенту — техническим страницам, служебным документам, конфиденциальным данным пользователей и т. д. С помощью системного файла можно полностью закрыть ресурс от индексации, если на сайте проводятся работы.

д. С помощью системного файла можно полностью закрыть ресурс от индексации, если на сайте проводятся работы.

Выяснить, какие страницы видны роботам, а какие нет, позволяют «Яндекс.Вебмастер» и Google Search Console. Эти же сервисы помогают проверить, правильно ли заполнен системный файл.

Благодаря robots.txt вы легко можете закрыть от индексации страницу, раздел или весь сайт целиком. Выполнение этой задачи не требует много времени и усилий. А чтобы не пропускать статьи об интернет-маркетинге от Rubix подписывайтесь на наш Telegram-канал!

API закрытого индекса | Elasticsearch Guide [7.17]

Доступна более новая версия. Актуальную информацию см. документация по текущему выпуску.

Закрывает индекс.

POST /my-index-000001/_close

Requestedit

POST /

Prerequisitesedit

90 003- Если функции безопасности Elasticsearch включены, вы должны иметь

для управления. привилегия index для целевого индекса или псевдонима индекса.

привилегия index для целевого индекса или псевдонима индекса.

Descriptionedit

API закрытия индексов используется для закрытия открытых индексов.

Закрытый индекс заблокирован для операций чтения/записи и не позволяет все операции, которые позволяют открытые индексы. Не возможно индексировать документов или для поиска документов в закрытом индексе. Это позволяет закрытые индексы, чтобы не поддерживать внутренние структуры данных для индексации или поиска документов, что приводит к меньшим накладным расходам на кластер.

При открытии или закрытии индекса мастер отвечает за перезапуск осколков индекса, чтобы отразить новое состояние индекса. Затем осколки пройдут обычный процесс восстановления. данные открытых/закрытых индексов автоматически реплицируются кластер, чтобы обеспечить безопасное хранение достаточного количества копий шардов во все времена.

Вы можете открывать и закрывать несколько индексов. Возникает ошибка

если запрос явно ссылается на отсутствующий индекс. Такое поведение может быть

отключено с помощью параметра

Такое поведение может быть

отключено с помощью параметра ignore_unavailable=true .

Все индексы могут быть открыты или закрыты одновременно, используя _all в качестве имени индекса

или указать шаблоны, которые идентифицируют их все (например, * ).

Определение индексов с помощью подстановочных знаков или _all можно отключить, установив action.destructive_requires_name флаг в конфигурационном файле на true .

Этот параметр также можно изменить с помощью API настроек обновления кластера.

Закрытые индексы потребляют значительный объем дискового пространства, что может привести к

проблемы в управляемых средах. Закрытие индексов можно отключить в настройках кластера

API, установив cluster.indices.close.enable на false . По умолчанию true .

Редактирование параметров пути

-

<индекс> (Необязательно, строка) Список имен индексов, разделенных запятыми, или выражение с подстановочными знаками.

используется для ограничения запроса.

используется для ограничения запроса.Чтобы закрыть все индексы, используйте

_allили*. Чтобы запретить закрытие индексов с помощью_allили выражений с подстановочными знаками, измените настройку кластераaction.destructive_requires_nameнаtrue. Вы можете обновить этот параметр в файле elasticsearch.yml. или с помощью API настроек обновления кластера.

Изменить параметры запроса

-

разрешить_no_indices (необязательно, логическое значение) Если

false, запрос возвращает ошибку, если какое-либо выражение с подстановочными знаками, псевдоним индекса или значение_allнацелены только на отсутствующие или закрытые индексы. Это поведение применяется, даже если запрос нацелен на другие открытые индексы. Для например, запрос, нацеленный наfoo*,bar*, возвращает ошибку, если индекс начинается сfoo, но ни один индекс не начинается сbar.

По умолчанию

true.-

expand_wildcards (необязательно, строка) Тип индекса, которому могут соответствовать шаблоны подстановочных знаков. Если запрос может ориентироваться на данные потоки, этот аргумент определяет, соответствуют ли выражения с подстановочными знаками скрытым данным. потоки. Поддерживает значения, разделенные запятыми, например

открытое, скрытое. Допустимые значения являются:-

все - Сопоставьте любой поток данных или индекс, включая скрытые.

-

открыть - Сопоставьте открытые, нескрытые индексы. Также соответствует любому нескрытому потоку данных.

-

закрытый - Соответствие закрытым, нескрытым индексам. Также соответствует любому нескрытому потоку данных. Данные потоки не могут быть закрыты.

-

скрытый - Сопоставьте скрытые потоки данных и скрытые индексы.

Должен сочетаться с

Должен сочетаться с открыть,закрытыйили оба. -

нет - Подстановочные знаки не принимаются.

По умолчанию

открыть.-

-

ignore_unavailable - (Необязательно, логическое значение) Если

false, запрос возвращает ошибку, если он нацелен на отсутствующий или закрытый индекс. По умолчаниюfalse. -

wait_for_active_shards (Необязательно, строка) Количество копий сегментов, которые должны быть активны, прежде чем приступить к операции. Установите в

все,индекс-настройкаили любой положительный целое число до общего количества осколков в индексе (количество_реплик+1). Значениеindex-settingозначает ожидание в соответствии с настройкой индексаindex.write.wait_for_active_shards. По умолчанию:0, то есть не ждать никаких осколки должны быть готовы.

См. Активные осколки.

-

master_timeout - (Необязательно, единицы времени)

Период ожидания подключения к главному узлу. Если ответ не получен

до истечения тайм-аута запрос завершается сбоем и возвращает ошибку. По умолчанию

30 с. -

тайм-аут - (Необязательно, единицы времени)

Срок ожидания ответа. Если ответ не получен до истечения времени ожидания

истекает, запрос терпит неудачу и возвращает ошибку. По умолчанию

30 с.

Examplesedit

В следующем примере показано, как закрыть индекс:

POST /my-index-000001/_close

API возвращает следующий ответ:

{

«признано»: верно,

"shards_acknowledged": правда,

"индексы": {

"мой-индекс-000001": {

"закрыто": правда

}

}

} Отключите индексирование в Windows для повышения производительности

Если вы отключите функцию поискового индекса Windows на своих жестких дисках, вы можете повысить производительность Windows 10. Сначала давайте посмотрим, почему вы можете это сделать. После этого мы объясним, как это сделать.

Сначала давайте посмотрим, почему вы можете это сделать. После этого мы объясним, как это сделать.

Иногда вы можете не захотеть отключать индексацию поиска Windows. Это зависит от того, какое оборудование вы используете. Ниже приведены несколько ярких примеров того, когда вы должны или не должны отключать его.

Содержание

Кроме того, давайте быстро развеем миф. Индексация поиска Windows по-прежнему используется в Windows 10 и работает почти так же, как и в более старых версиях Windows. Имея это в виду, вот что мы предлагаем:

- Хороший процессор и стандартный жесткий диск = продолжить индексирование

- Медленный процессор и любой жесткий диск = отключить индексирование

- Любой процессор с SSD = отключить индексирование

Если у вас медленный жесткий диск и хороший процессор, это имеет больше смысла чтобы индексация поиска была включена, но в противном случае лучше ее отключить. Это особенно актуально для тех, у кого есть твердотельные накопители, потому что они могут очень быстро читать ваши файлы.

Для любопытных: поисковое индексирование никак не повредит вашему компьютеру. Если он включен, все поисковые запросы индексируются, поэтому поиск выполняется быстрее, однако индексатор поиска использует ЦП и ОЗУ, поэтому при его отключении вы сэкономите эти ресурсы.

Отключить выборочное индексирование поиска WindowsУ вас есть возможность отключить индексирование для определенных папок, поэтому, если вы регулярно выполняете поиск в областях на своем ПК, возможно, стоит сохранить индексирование для них и отключить его в других местах.

Мы начнем с этого варианта, потому что это отличная золотая середина для экономии ресурсов ПК и высокой скорости поиска. Для этого откройте меню «Пуск» и введите Indexing . Щелкните Параметры индексирования .

На странице параметров индексирования вы увидите список, в котором показаны все включенные и исключенные местоположения для индексации. Это будет включать ваше меню «Пуск», историю Internet Explorer и, что наиболее важно, папку «Пользователи» и все, что внутри нее. Это означает все, например, папки с документами, загрузками, изображениями и видео.

Это будет включать ваше меню «Пуск», историю Internet Explorer и, что наиболее важно, папку «Пользователи» и все, что внутри нее. Это означает все, например, папки с документами, загрузками, изображениями и видео.

Эти папки могут содержать множество файлов, которые вы редко просматриваете. Если это так, вам следует отключить индексирование. Нажмите Изменить , затем на новой странице прокрутите вниз до отмеченной папки «Пользователи» и снимите ее. После нажмите OK . Обратите внимание, что папок пользователей может быть несколько, поэтому убедитесь, что вы нашли ту, которая отмечена галочкой.

Вы можете пойти дальше, щелкнув стрелку раскрывающегося списка в папке «Пользователи» и сняв галочки с отдельных папок. Это может быть полезно, например, если вы часто посещаете мои документы, но редко касаетесь других папок.

Если вы продолжаете добавлять файлы в каждую папку, индексация будет продолжаться, расходуя больше ресурсов, поэтому лучше отключить это для папок, в которые вы редко заходите, для экономии системных ресурсов.

По умолчанию Microsoft Outlook не отображается на странице индексирования поиска. Вместо этого нам нужно пройти через Microsoft Outlook. Итак, откройте Outlook, затем нажмите Файл — Параметры .

На странице «Параметры» нажмите кнопку Search слева, а затем нажмите выделенную синим цветом кнопку Параметры индексирования… . Далее вы увидите меню, похожее на предыдущее, но теперь вы увидите Microsoft Outlook в списке.

Чтобы отключить индексирование поиска Outlook, сначала щелкните Microsoft Outlook в списке, чтобы выделить его. Затем нажмите Изменить , а затем установите флажок в новом окне, чтобы снять его. Наконец, нажмите OK .

Отключить индексирование поиском Windows для определенных дисков Если вы хотите отключить индексацию поиска Windows для определенных дисков, вы можете сделать это с помощью другого процесса. Рекомендуется отключить поисковое индексирование для дисков, к которым вы редко прикасаетесь, например, для резервных копий.

Рекомендуется отключить поисковое индексирование для дисков, к которым вы редко прикасаетесь, например, для резервных копий.

Для этого сначала откройте меню «Пуск», введите ПК и нажмите Этот ПК , когда он появится в результатах поиска.

Затем щелкните правой кнопкой мыши диск и выберите Свойства .

На вкладке Общие снимите флажок Разрешить индексацию содержимого файлов на этом диске в дополнение к свойствам файла внизу. После нажмите Применить .

Вам будет предложено выбрать все файлы или только сам диск. Обязательно выберите Применить изменения к Диску X:\, вложенным папкам и файлам . После нажмите OK .

Следующий шаг займет некоторое время. Теперь ваш компьютер будет применять этот новый атрибут к каждому файлу на этом диске. К счастью, вы можете позволить ему работать в фоновом режиме, и это не должно сильно влиять на вашу производительность, если только вы не применяете его к диску, на котором используете Windows.

Если появятся какие-либо сообщения об отказе в доступе, просто нажмите Игнорировать все — это системные файлы или другие файлы, которые в данный момент используются.

Полностью отключить индексированиеЕсли вы хотите полностью отключить индексирование поиска в Windows 10, вы должны использовать другой метод. Вышеуказанные методы могут остановить индексирование поиска для определенных файлов и папок, но служба индексирования поиска все еще работает.

Этот вариант рекомендуется только в том случае, если поиск Windows не работает или ваш процессор очень медленный и имеет проблемы с производительностью. Выполните следующие действия, чтобы отключить поиск Windows.

Вы можете начать, нажав Клавиша Windows + R , набрав services.msc и нажав OK .

Найдите Windows Search в списке служб. Чтобы упростить поиск, дважды нажмите кнопку Имя , чтобы упорядочить в алфавитном порядке от Z до A.

И только после этого настройте 301 редиректы с непопулярных страниц на популярные, затем удалите те, которые совсем не эффективны.

И только после этого настройте 301 редиректы с непопулярных страниц на популярные, затем удалите те, которые совсем не эффективны.

xml. Поисковый робот может узнать о наличии карты и начать ее индексировать.

xml. Поисковый робот может узнать о наличии карты и начать ее индексировать. png

png Yandex" search_bot

Yandex" search_bot привилегия index для целевого индекса или псевдонима индекса.

привилегия index для целевого индекса или псевдонима индекса. используется для ограничения запроса.

используется для ограничения запроса.

Должен сочетаться с

Должен сочетаться с