Что такое JBOD | Настройка серверов windows и linux

Что такое JBOD

Что такое JBOD

JBOD (от англ. Just a bunch of disks, просто пачка дисков) — дисковый массив, в котором единое логическое пространство распределено по жёстким дискам последовательно. Однако в некоторых RAID-контроллерах режимом «JBOD» назван режим, при котором контроллер работает как обычный IDE- или SATA-контроллер, не задействуя механизмы объединения дисков в массив, то есть в таком случае каждый диск будет виден как отдельное устройство в операционной системе. Этот факт указывает на то, что термин JBOD, как режим функционирования дисков, ещё окончательно не «устоялся». Часть IT-специалистов трактует его буквально как «пучок» или «куча» дисков, каждый из которых функционирует независимо друг от друга, а понятие «spanning» (то есть «охват» данными нескольких дисков) относят уже не к JBOD, а к RAID-технологиям, поскольку имеет место организация дисков в простейший массив.

Что такое JBOD

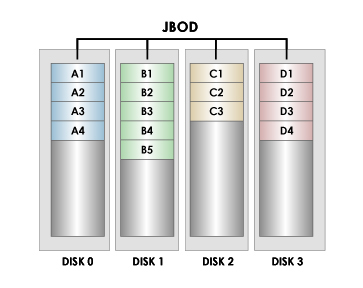

Пример распределения файлов по JBOD-массиву (разные файлы выделены разными цветами)

- Характеристики JBOD массива

- Ёмкость массива равна сумме ёмкостей составляющих дисков

- Вероятность отказа приблизительно равна сумме вероятностей отказа каждого диска в массиве (избыточность не предусмотрена)

- Скорость чтения и записи зависит от области данных; она не выше, чем у самого быстрого диска в массиве и не ниже чем у самого медленного

- Нагрузка на процессор при работе минимальная (сравнимая с нагрузкой при работе с единичным диском)

- Особенности JBOD массива

- Отказ одного диска позволяет восстановить файлы на остальных дисках (если ни один из их фрагментов не принадлежит повреждённому диску)

- В ряде случаев возможно обеспечение высокой скорости работы нескольких приложений (при условии, что приложения работают с областями данных на разных дисках)

- Массив может состоять из дисков различной ёмкости и скорости

- Массив легко расширяется дополнительными дисками по мере надобности

В операционной системе Windows JBOD-массив называется составным томом (spanned volume) (возможно создание только на динамических дисках), linux raid называет подобный тип компоновки linear RAID, в FreeBSD аналогичную задачу решает GEOM класс geom_concat.

Что лучше JBOD или RAID

Ранее я вам описывал виды RAID массивом и принципы их работы, давайте теперь попробуем зная данную информацию, сравнить их с JBOD.

- Емкость дисков диска — В то время, напоминаю, что чаще всего при выборе RAID вы получите не полный объем из-за избыточности, а JBOD использует полную емкость на каждом отдельном диске. Так, например, конфигурация JBOD, состоящая из четырех дисков емкостью 260 ГБ, обеспечит в общей сложности 1040 ГБ используемого пространства, в вот уже при RAID 1,5,6, 50, 60 уже нет.

- Производительность системы — В большинстве случаев RAID превосходит JBOD по производительности. Например, RAID 0 увеличивает скорость операций чтения и записи, используя несколько дисков, чтобы компенсировать ограничения одного. Фактически, все конфигурации RAID так или иначе улучшают производительность. Для сравнения, JBOD может оказать негативное влияние на производительность, поскольку система должна последовательно обрабатывать каждый диск.

- Избыточность и доступность — Одним из наиболее известных преимуществ RAID является предоставление дополнительного уровня защиты для серверов и устройств хранения. На самом деле RAID 0 — это единственный уровень, который не обеспечивает некоторой степени отказоустойчивости, критической функции, которая позволяет системе постоянно работать без потери данных или простоев в случае отказа исходной системы. Хотя JBOD может обеспечить избыточность для таких компонентов, как блоки питания и охлаждающие вентиляторы, на уровне дисков их нет. По сути это означает, что в случае сбоя диска в массиве вы потеряете все данные, для которых нет резервной копии.

- Расширение диска — Вы можете расширить как JBOD, так и RAID. Расширить JBOD обычно так же просто, как добавить еще один диск в коробку. Вы также можете использовать диски разных размеров, что дает немного больше гибкости. Масштабирование системы RAID немного сложнее. Пул дисков — это единое целое, для которого требуется, чтобы каждый диск был одинакового размера и типа модели. В любом случае расширение массивов хранения потребует от администраторов определения количества необходимых дополнительных дисков, размера этих дисков и рассматриваемых вариантов подключения.

- Экономическая эффективность — В целом, архитектура JBOD значительно дешевле в реализации, чем система на основе RAID. Корпуса JBOD могут быть заполнены дисками и контроллерами SATA, которые намного дешевле, чем оборудование SAS и SSCI, обычно используемое в конфигурациях RAID. Варианты расширения для JBOD одинаково доступны. Это позволяет вам включать функциональные возможности предприятия по более высокой цене, чем обычно предлагает RAID.

- Когда использовать RAID — RAID — это проверенный и надежный вариант хранения. Конечно, есть разные конфигурации для разных сценариев. Например, RAID 0 идеален, когда вам нужно решение для хранения, которое легко внедрить и которое максимально использует ваше дисковое пространство. Это одна конфигурация RAID без лишних затрат, поэтому вы получаете максимальную емкость хранилища. RAID 1 может быть хорошим вариантом, когда вам нужна высокая производительность и доступность. Этот уровень может оказаться полезным для бухгалтерской фирмы, которой необходимо максимально увеличить время бесперебойной работы для критически важных ИТ-систем, или даже для домашнего пользователя, стремящегося обеспечить пуленепробиваемую емкость хранилища на своем ПК.

На этом у меня все, с вами был Иван Семин, автор и создатель IT портала Pyatilistnik.org.

Иван Семинpyatilistnik.org

Что такое JBOD? | Composter 2.0

Когда-то JBOD считался дисковым массивом для тех, у кого не хватило денег на продвинутый RAID-контроллер или если со временем собралась разношерстная группа накопителей, а ресурсов и технологий для того чтобы управиться с ними оказалось недостаточно. Сегодня ситуация кардинально поменялась.

Чем же примечательна конструкция, предназначенная для установки нескольких десятков HDD/SSD, которую несколько фамильярно называют «просто комплект дисков» — Just a Bunch Of Disks (JBOD)? Будем разбираться.

JBOD как класс

JBOD как отдельный класс серверного оборудования возник на переломе технологий — объем HDD стал критической величиной для выживаемости RAID-массивов, а энтропия информации стала безжалостно заполнять любое свободное пространство. В ответ на эти вызовы появилось программно-определяемое хранение, способное включать в свою орбиту дисковые массивы, обслуживаемые SAS-интерфейсом (либо любой другой приемлемой альтернативой ему).

Теперь монолитный ранее «сторидж» предоставляет доступ ко всему своему содержимому: к каждому модулю хранения, ко всем портам интерфейса и внеполосного управления. Осталось оснастить управляющие контроллеры умными функциями, оперирующими дисковыми корзинами. JBOD — это именно автономная дисковая корзина, зона физического комфорта накопителей. Хранящимися в них данными управляют «внешние» силы — серверы. Они же мониторят состояние всех систем JBOD, убеждая владельца информации в том, что данные в безопасности.

Дисковые корзины: конструктивный подход

Для хранения больших массивов информации уместно использовать специально предназначенные для этого конструкции. Просто так взять и разместить несколько десятков магнитных дисков в первый попавшийся корпус не получится — возникает ряд технических проблем, для решения которых требуется особый инженерный подход. Что же это за проблемы и каким способом они решаются? Рассмотрим один из удачных вариантов реализации дискового массива — UltraStar Data60 от Western Digital.

Против вибрации

Массивы жестких магнитных дисков при плотной компоновке могут страдать от взаимного влияния. Источником проблем становится соленоид актуатора, позиционирующий блок головок над рабочей поверхностью. Его вибрации оказывают заметное влияние на соседние устройства. Точность позиционирования головок снижается, потому что любое воздействие на диск при зазоре между головкой и поверхностью менее 10 нанометров становится критичным — и контроллер HDD вынужден снова выполнять поиск нужного цилиндра.

В сеансе ОС сервер обращается сразу ко всем дискам, формирующим программно-определяемую инфраструктуру. Каждый из них, едва заметно подрагивая корпусом, постоянно осуществляет свою программу позиционирования (поиска нужной дорожки) — в итоге цепочка вибрационного взаимовлияния замедляет работу всех накопителей в JBOD, заметно снижая скорость доступа к данным (что плохо, но не фатально) и существенно сокращая срок жизни дисков (что катастрофически плохо).

Для борьбы с этим явлением Western Digital JBOD Ultrastar Data60 применяет остроумное демпфирование. Его суть, составляющая основу патентованной технологии IsoVibe, состоит в следующем. Каналом, по которому распространяются вибрации, оказалась плата бэкплейна, к которой подключаются HDD. Посему в текстолите PCB сделаны специальные фигурные вырезы, сообщающие гибкость тому участку, где распаян SAS-разъем. Это практически сводит на нет взаимное влияние дисков в JBOD — вибрация каждого из них отлично амортизируется хитрым подвесом разъема.

Дополнительным фактором, гасящим вибрацию, надежное безрезьбовое крепление накопителя в отсеке, особенно эффективное при установке 2,5″ устройств. С учетом технологии Isovibe, это почти на две трети снижает вибрационную нагрузку на магнитные диски в JBOD, что благотворно влияет на режим их работы и продлевает срок их службы.

Охлаждение

Гелий-наполненные диски, которые и разработаны для JBOD, в активной фазе чтения/записи потребляют значительный ток, что приводит к их нагреву. Утилизация тепла преследует те же цели, что и подавление вибрации: продление жизненного цикла накопителей и стабильность дисковых операций. В Ultrastar Data60 они достигаются благодаря концепции ArcticFlow.

Терморегуляция ArcticFlow — это технология, запатентованная компанией Western Digital технология. Ее суть сводится к формированию раздельных потоков воздуха, охлаждающих фронтальную и тыльную зоны JBOD.

Воздух, охлаждающий передние ряды HDD, нагревается и уходит по боковым коридорам мимо тыльной зоны. Туда, вглубь JBOD, подается холодный воздух по специально спроектированному центральному воздуховоду. Он минует нагретые диски фронтальной зоны и разделяется на периферийные потоки, обеспечивая эффективное охлаждение тыльной зоны — задних рядов накопителей.

Центральный воздушный коридор выполняет и задачу терморегуляции еще одного ответственного узла: двух блоков питания по 1,6 КВт каждый и модулей ввода/вывода — SAS-экспандеров. Еще недавно компоновка JBOD строилась по типовой схеме: экспандеры размещались на тыльной стороне шасси, обдуваемые горячим отработанным воздухом. Их перенос в зону центрального коридора — фирменный почерк хранилищ семейства Ultrastar.

Для них формируется независимый поток? В результате вентиляторы работают тише? ли вибрация снижается на 60%. Как воздух рециркулирует? Почему нельзя заглушек дюжину добавить к HDD?

Аэродинамика

Технология ArcticFlow построена с учетом аэродинамических характеристик шасси JBOD. По этой причине порядок установки накопителей регламентирован: первыми заполняются свободные отсеки тыльной зоны. В дальнейшем популяция расширяется в сторону фронтальной зоны, заселяя свободные отсеки в строгой очередности.

Минимально требуется 24 накопителя для эффективного отвода тепла внутри корпуса JBOD, что продиктовано особенностью воздушных потоков в двухзонной конфигурации хранилища. При меньшем количестве устройств в корзине JBOD возникает риск паразитной рециркуляции, в результате которой отработанный горячий воздух через центральный коридор может снова попасть в систему охлаждения.

Исключение из правил — установка SSD. Ultrastar Data60 от Western Digital позволяет занять твердотельными накопителями 24 отсека из 60 имеющихся. SSD всегда размещаются в тыльной зоне, ближе к вентиляторам, так как греются сильнее магнитных дисков.

Даже, если понадобится всего один SSD, его нужно ставить в последний ряд, блокируя незанятые отсеки специальными заглушками. Они требуются для корректного, с точки зрения аэродинамики, распределения воздушных потоков.

Культура регулярности

JBOD, как агрегат для объемного хранения, должен интересовать нас в первую очередь своей масштабируемостью. Его возможности выгодно отличаются от проприетарных систем. В отличие от них, JBOD-инфраструктура не связана ограничениями программного слоя, вычислительной мощностью управляющих контроллеров и способом их подключения в сеть.

Забота об утилизации лучших качеств данного типа хранилищ — в культуре регулярности. С пониманием относясь к универсальным возможностям Ultrastar Data60, пользователь должен отдавать себе отчет, что наилучшим его применением будет однородная среда HDD, способная к переопределению в соответствии с меняющимися задачами. А эксперименты с SSD, хотя и поддерживаются функциональностью JBOD, остаются исключением из правил. Твердотельным накопителям лучше будет в JBOF. Но это уже другая история.

composter.com.ua

19.10.2012 15:59JBOD массив, истоки

JBOD (Just a Bunch Of Disks) представляет собой отдельный тип RAID массивов дисков. В настоящее время сам по себе термин JBOD, как отдельный режим функционирования дисков еще окончательно не устоялся. По этой причине можно дать два определения. Первое, что в массиве общее пространство распределено по всем жестким дискам последовательно. Вторым же определением является то, что в ряде контроллеров так назван режим, при переходе на который контроллер работает как обычный IDE, SATA. В этом случае каждый диск будет восприниматься операционной системой как отдельное устройство.

JBOD (Just a Bunch Of Disks) представляет собой отдельный тип RAID массивов дисков. В настоящее время сам по себе термин JBOD, как отдельный режим функционирования дисков еще окончательно не устоялся. По этой причине можно дать два определения. Первое, что в массиве общее пространство распределено по всем жестким дискам последовательно. Вторым же определением является то, что в ряде контроллеров так назван режим, при переходе на который контроллер работает как обычный IDE, SATA. В этом случае каждый диск будет восприниматься операционной системой как отдельное устройство.

По этой причине, можно выделить также определение, согласно которому JBOD представляется как набор отдельных дисков, функционирующих независимо, но объединенных в один массив.

Типы и характеристики JBOD массивов

В настоящее время отдельных типов данного массива выделено не было, и по этой причине о различных режимах говорить просто не приходится. Это связано с тем, что данный массив является отдельным элементом расширенного класса режимов RAID. Хоть и можно отметить, что понятие JBOD с SPAN или же BIG, учитывая то, что данные типы массивов все же имеют некоторые отличия в построении логической структуры.

К характеристикам массивов данного класса можно отнести:

• равные суммы емкостей массива относительно всех входящих в него дисков;• минимальную нагрузку на рабочий процессор;

• скорость записи баз данных на диск и их дальнейшего чтения не выше чем у самого быстрого диска, входящего в массив;

• вероятность выхода из строя массива равна общей сумме вероятности выхода из строя каждого диска.

Особенности JBOD массивов и восстановление информации

Массив при этом обладает целым рядом положительных особенностей. Так, к примеру, массив может включать в себя диски самой разной скорости и емкости, и включает в себя также возможность добавления дополнительных устройств, по мере надобности. Что очень важно, так это возможность обеспечить достаточно высокую скорость работы одновременно для нескольких предложений. Это особенно актуально при условии, что все приложения должны работать с данными, находящимися на разных дисках. Также можно отметить, что нарушение функциональных возможностей в работе одного диска позволяет восстановить данные на остальных носителях информации. Восстановление данных с JBOD массивов должен производить надежный сервис, в котором сразу же определится причина выхода из строя, сохранность баз данных на дисках.

Можно будет просто отформатировать разделы и создать базу данных заново. Если это получится, можно будет восстановить информацию. Нарушения в работе могут быть вызваны предельно разными причинами, в частности может быть нарушена целостность шлейфов, либо же что-то еще. В первую очередь в сервисе смогут определить порядок дисков. Если в массиве их находится больше двух, задача усложняется, и потребуется дополнительно произвести анализ таблиц, из которых вычислить порядок нахождения адреса начала директории, либо же файла, что и позволит узнать очередность дисков. В том случае если даже один или же несколько дисков массива вышли из строя, информацию, при подходе к вопросу профессионалов все же возможно извлечь, хоть и частично.

www.dfacto.ru

Наращиваем дисковую массу без стероидов. Обзор 102-дисковой полки Western Digital Ultrastar Data102 и конфигурации СХД

Чем хороши большие JBOD’ы?

Новый JBOD Western Digital на 102 диска по 12ТБ получился мощным. При разработке этого JBOD были учтены предыдущий опыт с двумя поколениями 60-дисковых полок.

Data102 получился на редкость для таких гигантов сбалансированным по объему и производительности.

Зачем же нужны такие большие дисковые корзины, когда в мире растет популярность гиперконвергентных систем?

Задачи, при которых требования по объемам хранения значительно превышают требования по вычислительной мощности, могут раздуть бюджет заказчика до невероятных размеров. Вот лишь несколько примеров и сценариев:

- Replication Factor 2 или 3, применяемый при строительстве Scale-out систем, на нескольких петабайтах данных — решение недешевое.

- Интенсивные последовательные операции чтения/записи заставляют узел кластера выходить за пределы локального хранилища, что грозит такими проблемами, как long-tail latency. В этом случае следует предельно внимательно отнестись к построению сети.

- Распределенные системы прекрасно справляются с задачами типа «множество приложений работают с множеством своих файлов» и посредственно справляются с записью и чтением с сильно-связанного кластера, особенно в режиме N-to-1.

- При задачах типа «увеличить глубину видеоархива в 2 раза» гораздо дешевле накинуть большой JBOD, чем увеличить количество серверов в кластере в 2 раза.

- Используя внешние СХД с JBOD, мы можем четко выделить для наших приоритетных приложений объем и производительность, зарезервировав для них определенные диски, кэш, порты, и при этом сохранив необходимый уровень гибкости и масштабируемости.

Как правило, дисковые полки уровня Data102 разрабатывается производителями дисков, которые хорошо понимают, как с этими дисками работать и знают все подводные камни. В таких устройствах все в порядке с уровнем вибрации и охлаждением, а энергопотребление соответствует реальным потребностям по хранению данных.

Чем хорош JBOD от Western Digital?

Мы прекрасно понимаем, что модульные системы ограничены по масштабируемости возможностями контроллеров и что сеть всегда создает задержки. Но при этом такие системы обладают более низким стоимостью IOps, GBps и ТБ хранения.

Есть две вещи, за которые инженеры RAIDIX полюбили Data102:

- JBOD не просто позволяет разместить > 1 PB данных на 4U. Он реально очень быстрый и на потоковых операциях не уступает многим all-flash решениям: 4U, 1PB, 23 ГБ/с — хорошие показатели для дискового массива.

- Data102 прост в обслуживании и не требует инструментов, вроде отвертки.

Сотрудники нашей группы тестирования ненавидят отвертки, которые уже снятся им по ночам. Когда они услышали, что HGST/WD делает 102-дискового монстра, и представили, как придется иметь дело с 408 мелкими винтиками, в соседнем магазине закончился крепкий алкоголь.

Зря боялись. Заботясь об инженерах, в Western Digital придумали новый способ крепления диска, который позволяет облегчить обслуживание. Диски крепятся к шасси c помощью фиксирующих зажимов, без болтов и винтов. Все диски механически изолируются с помощью эластичных крепежей на задней панели. Новая прошивка сервопривода и акселерометры отлично компенсируют вибрацию.

Что у нас в коробке?

В коробке — корпус корзины, набитый дисками. Купить можно минимум 24 диска, а масштабируется решение наборами по 12 дисков. Делается это для того, чтобы обеспечить правильное охлаждение и бороться с вибрацией наилучшим образом.

Кстати, именно развитие двух вспомогательных технологий — IsoVibe и ArcticFlow — сделали возможным рождение нового JBOD’а.

Состоит IsoVibe из следующих компонентов:

- Специализированная прошивка дисков, которая с помощью датчиков управляет сервоприводами и предиктивно снижает уровень вибраций.

- Вибрационно изолированные разъемы на задней панели сервера (рис. 1).

- Ну и, конечно, специальные крепления дисков, которые не требуют винтов.

Рис. 1. Вибрационно изолированные разъемы

Температура — это второй после вибрации фактор, убивающий жесткие диски. При средней температуре работы выше 55C наработка на отказ жесткого диска будет в два раза меньше расчетной.

От плохого охлаждения особенно страдают серверы с большим количеством дисков и большие дисковые полки. Зачастую задние ряды дисков греются на 20 и более градусов больше, чем диски, находящиеся вблизи от холодного коридора.

ArcticFlow — это запатентованная Western Digital технология охлаждения полки, смысл которой заключается в создании дополнительных воздуховодов внутри шасси, которые позволяют протягивать холодный воздух к задним рядам дисков напрямую из холодного коридора, минуя передние ряды.

Рис. 2. Принцип работы ArcticFlow

Отдельный поток холодного воздуха построен для охлаждения модулей ввода-вывода и блоков питания.

Результат — великолепная термальная карта работающей полки. Разброс температур между передними и задними рядами дисков — 10 градусов. Самый горячий диск — 49C при температуре в «холодном» коридоре +35C. На охлаждение каждого диска тратится 1.6Вт — в два раза меньше, чем у других подобных шасси. Вентиляторы работают тише, вибрация меньше, диски живут дольше и работают быстрее.

Рис. 3. Температурная карта Ultrastar Data 102

Учитывая бюджет по питанию в 12Вт на один диск, полку легко можно сделать гибридной — из 102 дисков 24 могут быть SAS SSD. Их можно установить и использовать как в гибридном режиме, так и настроив SAS Zoning и передав хосту, нуждающемуся в all-flash.

Еще у нас в коробке есть салазки для крепления в стойку. Для установки JBOD нужна парочка физически сильных инженеров. Вот с чем они столкнутся:

- Полка в сборе весит 120 кг, а без дисков — 32 кг

- Глубокая стойка в данном случае начинается от 1200 мм

- Ну и добавляем кабели SAS и питания

Крепления и кабелировка JBOD разработаны таким образом, что можно «на горячую» выполнять обслуживание. Отметим также вертикальную установку модуля ввода-вывода (IOM).

Давайте взглянем на эту систему. Спереди все просто и лаконично.

Рис. 4. Ultrastar Data 102. Вид спереди

Одной из самых интересных особенностей JBOD является установка IO-модулей сверху!

Рис. 5. Ultrastar Data 102

Рис. 6. Ultrastar Data 102. Вид сверху

Рис. 7. Ultrastar Data 102. Вид сверху без дисков

Сзади у JBOD для каждого IO-модуля есть по 6 SAS 12G портов. Итого мы получаем 28800 MBps пропускной способности бэкенда. Порты можно использовать как для подключения к хостам, так и частично для каскадирования. Портов для питания системы два (80+ Platinum rated 1600W CRPS).

Рис. 8. Ultrastar Data 102. Вид сзади

Производительность

Как мы и говорили, Data102 не просто огромен — он быстрый! Результаты тестов, проведенных вендором, таковы:

На 12 серверов:

Последовательная нагрузка

- Чтение = 24.2GB/s max. @ 1MB (237 MB/s per HDD max.)

- Запись =23.9GB/s max. @ 1MB (234 MB/s per HDD max.)

Случайная нагрузка

- Чтение 4kB с глубиной очереди = 128: >26k IOps

- Запись 4kB с глубиной очереди 1–128: >45k IOps

На 6 серверов:

Последовательная нагрузка

- Чтение = 22.7GB/s max. @ 1MB (223 MB/s per HDD max.)

- Запись =22.0GB/s max. @ 1MB (216 MB/s per HDD max.)

Случайная нагрузка

- Чтение 4kB с глубиной очереди = 128: >26k IOps

- Запись с глубиной очереди = 1–128: >45k IOps

Рис. 9. Параллельная нагрузка с 12-ти серверов

Рис. 10. Параллельная нагрузка с 6-ти серверов

Управление

Управлять JBOD со стороны софта можно двумя способами:

- По SES

- По RedFish

RedFish позволяет находить компоненты, зажигая LED, получать информацию о «здоровье» компонентов, а также обновлять прошивку.

Кстати, шасси поддерживает T10 Power Disabling (Pin 3) для отключения питания и ресета индивидуальных дисков.

Это полезно использовать, если у вас диск подвешивает всю SAS-шину.

Типовые конфигурации

Для того, чтобы использовать возможности такого JBOD с максимальной пользой, нам потребуются RAID-контроллеры или программное обеспечение. Здесь на выручку и приходит ПО RAIDIX.

Для создания отказоустойчивой СХД нам потребуются два узла хранения и одна или более корзин с SAS дисками. Если же мы не хотим внедрять защиту от отказа узла или использовать репликацию данных, то можно подключить к корзине один сервер и использовать SATA диски.

Двухконтроллерная конфигурация

В качестве контроллеров для СХД на основе RAIDIX могут использоваться практически любые серверные платформы архитектуры x86: Supermicro, AIC, Dell, Lenovo, HPE и многие другие. Мы постоянно ведем работу над сертификацией нового оборудования и портируем наш код под различные архитектуры (например, «Эльбрус» и OpenPower).

Для примера возьмем платформу Supermicro и попытаемся достичь максимально возможной пропускной способности и плотности вычислений. При «сайзинге» серверов будем использовать шину PCI-E, куда установим back-end и front-end контроллеры.

Также нам понадобятся контроллеры для подключения дисковой полки, не менее двух AVAGO 9300-8e. Альтернативно: пара 9400-8e или один 9405W-16e, но для последнего понадобится полноценный слот x16.

Следующий компонент — слот для канала синхронизации. Это может быть Infiniband или SAS. (Для задач, где пропускная способность и задержки не критичны, можно обойтись синхронизацией через корзину без выделенного слота.)

Ну и, конечно, нам будут нужны слоты для хост-интерфейсов, которых тоже должно быть никак не менее двух.

Итого: каждому контроллеру нужно иметь от 5 слотов x8 (без запаса для дальнейшего масштабирования). Для построения недорогих систем, ориентированных на производительность в 3–4 ГБ/с на узел, мы можем обойтись всего двумя слотами.

Варианты конфигурации контроллеров

Supermicro 6029P-TRT

Контроллеры можно разместить в двух 2U серверах 6029P-TRT. Они не самые богатые в плане PCI-E cлотов, но зато на них установлена стандартная материнская плата без рейзеров. На этих платах гарантированно «заведутся» NVDIMM-N модули от Micron для защиты кэша от отказов питания.

Для подключения дисков возьмем Broadcom 9400 8e. Грязные сегменты кэша будем синхронизировать через IB 100Gb.

Внимание! Приведенные ниже конфигурации рассчитаны на максимальную производительность и функционирование всех имеющихся опций. Для вашей конкретной задачи спецификация может быть существенно сокращена. Обращайтесь к нашим партнерам.

Конфигурация системы, которая у нас получилась:

| № | Наименование | Описание | P/N | Кол-во на один RAIDIX DC |

|---|---|---|---|---|

| 1 | Платформа | SuperServer 6029P-TRT | SYS-6029P-TRT | 2 |

| 2 | CPU | Intel Xeon Silver 4112 Processor | Intel Xeon Silver 4112 Processor | 4 |

| 3 | Memory | 16GB PC4-21300 2666MHz DDR4 ECC Registered DIMM Micron MTA36ASF472PZ-2G6D1 | MEM-DR416L-CL06-ER26 | 12 |

| 4 | System Disk | SanDisk Extreme PRO 240GB | SDSSDXPS-240G-G25 | 4 |

| 5 | Hot-swap 3.5″ to 2.5″ SATA/SAS Drive Trays | Tool-less black hot-swap 3.5-to-2.5 converter HDD drive tray (Red tab) | MCP-220-00118-0B | 4 |

| 6 | HBA for cache-sync | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 7 | HBA for JBOD connection | Broadcom HBA 9400-8e Tri-Mode Storage Adapter | 05-50013-01 | 4 |

| 8 | Ethernet patchcord | Ethernet patch cord for cache sync 0.5m | 1 | |

| 9 | Cable for cache sync | Mellanox passive copper cable, VPI, EDR 1m | MCP1600-E001 | 2 |

| 10 | HBA for host connection | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 11 | SAS cable | Storage Enclosure Ultrastar Data102 Cable IO HD mini-SAS to HD mini-SAS 2m 2Pack | 8 | |

| 12 | JBOD | Ultrastar Data102 | 1 | |

| 13 | RAIDIX | RAIDIX 4.6 DC/NAS/iSCSI/FC/SAS/IB/SSD-cache/QoSmic/SanOpt/Extended 5 years support/unlimited disks/ | RX46DSMMC-NALL-SQ0S-P5 | 1 |

Вот примерная схема:

Рис. 11. Конфигурация на базе Supermicro 6029P-TRT

Supermicro 2029BT-DNR

Если мы хотим побороться за пространство в серверной, то за основу контроллеров хранения можно взять Supermicro Twin, например, 2029BT-DNR. Данные системы имеют по 3 PCI-E слота и по одному IOM-модулю. Среди IOM есть нужный нам Infiniband.

Конфигурация:

| № | Наименование | Описание | P/N | Кол-во на один RAIDIX DC |

|---|---|---|---|---|

| 1 | Платформа | SuperServer 2029BT-DNR | SYS-2029BT-DNR | 1 |

| 2 | CPU | Intel Xeon Silver 4112 Processor | Intel Xeon Silver 4112 Processor | 4 |

| 3 | Memory | 16GB PC4-21300 2666MHz DDR4 ECC Registered DIMM Micron MTA36ASF472PZ-2G6D1 | MEM-DR416L-CL06-ER26 | 12 |

| 4 | System Disk | Supermicro SSD-DM032-PHI | SSD-DM032-PHI | 2 |

| 5 | HBA for cache-sync | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 6 | HBA for JBOD connection | Broadcom HBA 9405W-16e Tri-Mode Storage Adapter | 05-50044-00 | 2 |

| 7 | Ethernet patchcord | Ethernet patch cord for cache sync 0.5m | 1 | |

| 8 | Cable for cache sync | Mellanox passive copper cable, VPI, EDR 1m | MCP1600-E001 | 2 |

| 9 | HBA for host connection | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 10 | SAS cable | Storage Enclosure Ultrastar Data102 Cable IO HD mini-SAS to HD mini-SAS 2m 2Pack | 8 | |

| 11 | JBOD | Ultrastar Data102 | 1 | |

| 12 | RAIDIX | RAIDIX 4.6 DC/NAS/iSCSI/FC/SAS/IB/SSD-cache/QoSmic/SanOpt/Extended 5 years support/unlimited disks | RX46DSMMC-NALL-SQ0S-P5 | 1 |

Вот примерная схема:

Рис. 12. Конфигурация на базе Supermicro 2029BT-DNR

Платформа 1U

Часто возникают задачи, где требуется максимальная плотность размещения больших объемов данных, но не требуется, например, полная отказоустойчивость по контроллерам. В этом случае мы берем за основу систему 1U и подключаем к ней максимальное количество дисковых полок.

Scale-Out система

В качестве последнего упражнения в нашей тренировке построим горизонтально-масштабируемую систему на основе HyperFS. Для начала мы выберем 2 типа контроллеров – для хранения данных и для хранения метаданных.

Контроллерами хранения назначим SuperMicro 6029P-TRT.

Для хранения метаданных используем несколько SSD накопителей в корзине, которые мы объединим в RAID и отдадим MDC через SAN. На одну систему хранения мы можем подключить до 4 JBOD каскадом. Итого в одной глубокой стойке размещаем X PB данных с единым пространством имен.

| № | Наименование | Описание | P/N | Кол-во на один RAIDIX DC |

|---|---|---|---|---|

| 1 | Платформа | SuperServer 6029P-TRT | SYS-6029P-TRT | 2 |

| 2 | CPU | Intel Xeon Silver 4112 Processor | Intel Xeon Silver 4112 Processor | 4 |

| 3 | Memory | 16GB PC4-21300 2666MHz DDR4 ECC Registered DIMM Micron MTA36ASF472PZ-2G6D1 | MEM-DR416L-CL06-ER26 | 16 |

| 4 | System Disk | SanDisk Extreme PRO 240GB | SDSSDXPS-240G-G25 | 4 |

| 5 | Hot-swap 3.5″ to 2.5″ SATA/SAS Drive Trays | Tool-less black hot-swap 3.5-to-2.5 converter HDD drive tray (Red tab) | MCP-220-00118-0B | 4 |

| 6 | HBA for cache-sync | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 7 | HBA for JBOD connection | Broadcom HBA 9400-8e Tri-Mode Storage Adapter | 05-50013-01 | 4 |

| 8 | Ethernet patchcord | Ethernet patch cord for cache sync 0.5m | 1 | |

| 9 | Cable for cache sync | Mellanox passive copper cable, VPI, EDR 1m | MCP1600-E001 | 2 |

| 10 | HBA for host connection | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 11 | SAS cable | Storage Enclosure Ultrastar Data102 Cable IO HD mini-SAS to HD mini-SAS 2m 2Pack | 8 | |

| 12 | JBOD | Ultrastar Data102 | 1 | |

| 13 | RAIDIX | RAIDIX 4.6 DC/NAS/iSCSI/FC/SAS/IB/SSD-cache/QoSmic/SanOpt/Extended 5 years support/unlimited disks/ | RX46DSMMC-NALL-SQ0S-P5 | 1 |

| 14 | Платформа (MDC HyperFS) | SuperServer 6028R-E1CR12L | SSG-6028R-E1CR12L | 1 |

| 15 | CPU (MDC HyperFS) | Intel Xeon E5-2620v4 Processor | Intel Xeon E5-2620v4 Processor | 2 |

| 16 | Memory (MDC HyperFS) | 32GB DDR4 Crucial CT32G4RFD424A 32Gb DIMM ECC Reg PC4-19200 CL17 2400MHz | CT32G4RFD424A | 4 |

| 17 | System Disk (MDC HyperFS) | SanDisk Extreme PRO 240GB | SDSSDXPS-240G-G25 | 2 |

| 18 | Hot-swap 3.5″ to 2.5″ SATA/SAS Drive Trays (MDC HyperFS) | Tool-less black hot-swap 3.5-to-2.5 converter HDD drive tray (Red tab) | MCP-220-00118-0B | 2 |

| 19 | HBA (MDC HyperFS) | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 1 |

Вот примерная схема подключения:

Рис. 13. Конфигурация Scale-Out системы

Заключение

Работа с большими объемами данных, особенно на write-intensive паттернах – очень непростая задача для СХД, классическим решением которой является приобретение shared-nothing scale-out систем. Новый JBOD от Western Digital и ПО RAIDIX позволит построить СХД на несколько петабайт и несколько десятков GBps производительности значительно дешевле, чем при использовании горизонтально-масштабируемых систем, и мы советуем обратить ваше внимание на такое решение.

UPD

Добавили спецификацию системы с NVMDIMM-N от Micron:

| № | Наименование | Описание | P/N | Кол-во на один RAIDIX DC |

|---|---|---|---|---|

| 1 | Платформа | SuperServer 6029P-TRT | SYS-6029P-TRT | 2 |

| 2 | CPU | Intel Xeon Silver 4112 Processor | Intel Xeon Silver 4112 Processor | 4 |

| 3 | Memory | 16GB PC4-21300 2666MHz DDR4 ECC Registered DIMM Micron MTA36ASF472PZ-2G6D1 | MEM-DR416L-CL06-ER26 | 12 |

| 4 | NVRAM | 16GB (x72, ECC, SR) 288-Pin DDR4 Nonvolatile RDIMM MTA18ASF2G72PF1Z | MTA18ASF2G72PF1Z-2G6V21AB | 4 |

| 5 | System Disk | SanDisk Extreme PRO 240GB | SDSSDXPS-240G-G25 | 4 |

| 6 | Hot-swap 3.5″ to 2.5″ SATA/SAS Drive Trays | Tool-less black hot-swap 3.5-to-2.5 converter HDD drive tray (Red tab) | MCP-220-00118-0B | 4 |

| 7 | HBA for cache-sync | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 8 | HBA for JBOD connection | Broadcom HBA 9400-8e Tri-Mode Storage Adapter | 05-50013-01 | 4 |

| 9 | Ethernet patchcord | Ethernet patch cord for cache sync 0.5m | 1 | |

| 10 | Cable for cache sync | Mellanox passive copper cable, VPI, EDR 1m | MCP1600-E001 | 2 |

| 11 | HBA for host connection | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 12 | SAS cable | Storage Enclosure Ultrastar Data102 Cable IO HD mini-SAS to HD mini-SAS 2m 2Pack | 8 | |

| 13 | JBOD | Ultrastar Data102 | 1 | |

| 14 | RAIDIX | RAIDIX 4.6 DC/NAS/iSCSI/FC/SAS/IB/SSD-cache/QoSmic/SanOpt/Extended 5 years support/unlimited disks/ | RX46DSMMC-NALL-SQ0S-P5 | 1 |

habr.com

Разница между СХД и полкой и что такое JBOD

Давайте попробуем определить, что за устройство на картинке.

Правильно — по “морде” определить невозможно. Нужно смотреть на тыльную часть. И варианты могут быть разные:

А. Сервер

B. Система хранения данных (СХД)

C. Дисковая полка SAS-1 c двумя контроллерами JBOD (HP MSA2000sa AJ750A)

Думаю, читатели данной статьи хорошо знают, что такое сервер, но имеют смутное представление об СХД и полках. СХД и полка похожи, но тем не менее между ними существенная разница.

СХД — система хранения данных — это не полка.

СХД (система хранения данных) намного сложнее полки, они дороже и имеют значительно больше нюансов.

Отличие СХД от полки это наличие “Мозга”. Контроллеры СХД это мини-серверы, со своими процессорами, памятью и операционной системой. СХД собирают из дисков RAID массивы, и передают данные по протоколам высокого уровня (iSCSI, NFS), контролируют целостность данных, позволяют создавать снапшоты и многое другое. СХД нужна если наша задача построить отказоустойчивый кластер

Однако, в случае если мы просто хотим добавить дисков в сервер, наличие “мозга” создаёт сложности: Не все СХД понимают диски объемом более 2Tb. Редкие СХД принимают от независимых производителей. Несмотря на то, что СХД полезное устройство — в этой статье мы не будем рассматривать использование СХД. Сегодня давайте разберёмся с полками.

Полка — это не СХД.

Полка — достаточно простое устройство. Корпус, два блока питания, бэкплэйн и JBOD* контроллеры. Задача полки, без какой либо обработки, передать данные из накопителя в адаптер (карту RAID или HBA). Любая полка поддерживает диски любого объёма и любого производителя. Всё решает карточка в сервере. Контроллер полки — это набор микросхем с жесткой логикой.

Так выглядит подключение дисков внутри сервера

Так подключение сервер + полка.

С точки зрения схемотехники (и операционной системы), диски, установленные в полку, ничем не отличаются от дисков установленных в сервер**.

Полка имеет отдельный корпус, отдельные блоки питания, но в обоих случаях подключение производиться через RAID карточку установленную в сервер -, отличие лишь в том, что в случае с полкой, кабель подключается не по внутреннему а по внешнему разъёму.

*JBOD = Just A Bunch of Disks ( просто пачка дисков )

** Если быть совсем точным, полку можно сравнивать с сервером в котором установлен SAS экспандер — это серверы в которых количество дисков превышает 8. Для операционной системы SAS экспандер не заметен.

Вот широко распространённый RAID контроллер LSI9260-8i

8i означает 8 внутренних портов SAS/SATA

А вот его брат LSI9280-4i4e

4 внутренних и 4 внешних порта

Как называется вот этот контроллер, я думаю вы уже догадались )

Правильно — это LSI9280-8e

Все эти контроллеры собраны на одном и том же чипе LSI2108. Они обеспечивают работу по протоколам SAS/SATA со скоростью 6Gb/s и “понимают” диски объёмом более 2Tb. Попутно замечу, что на этом чипе собраны RAID контроллеры в серверах Supermicro, Intel, IBM, DELL, Fujitsu и CISCO. Многие из производителей даже не утруждают себя разработкой собственной печатной платы — меняют только прошивку. Но впрочем RAID и HBA — тема для отдельной статьи.

Вывод: если не хватает места для дисков — можно просто подключить к серверу полку. Новый сервер покупать не обязательно.

Еще несколько нюансов.

Полки бывают не только SAS, но других типов, например FC (скорее всего они вам не нужны).

Полки могут быть 3, 6 и 12Gb/s. Не все знают, что в одном кабеле mini-SAS четыре канала. Это значит, что для вычисления скорости обмена полка-контроллер показатель 3,6,12 нужно умножить на 4, а в случае если полка и контроллер соединяются двумя кабелями, на 8. Для примера 3-х гигабитная полка сможет отдавать в сервер 3×4 = 12 Гигабит! Что очень неплохо, особенно, если вы устанавливаете шпиндельные накопители. Для работы диска с сервером важна не скорость передачи данных а количество операций ввода-вывода IOPS. Об этом читайте в пункте 7.

Не важно Supermicro, IBM, DELL или HP. Любая SAS полка будет работать с любым SAS контроллером. Брэнд имеет значение только когда вы подключаете полку к СХД.

Полки можно собирать в гирлянду — подключая к одному контроллеру сразу несколько полок.***

*** Если вы используете SATA диски, длина подключения не должна превышать 1М.

При использовании SAS дисков (или SATA дисков с интерпозерами) можно подключать полку по двум путям, через два контроллера. Это позволяет избежать отказа в случае выхода их строя одного из контроллеров.

Полки можно добавлять по мере роста количества данных, подключая их двумя путями

“в гирлянду” вот так:

SFF* полки ( обычно бывают 2U на 24-25 дисков)

Для чего нужны SFF полки?Типичный сервер редко перекидывает большие блоки данных — в основном он производит хаотичные запросы чтения или записи маленьких блоков из совершенно разных мест массива. Скорость по этому показателю измеряется не в Гигабитах в секунду, а в количестве операций ввода-вывода (IOPS). И именно IOPS, а не трансфер основной параметр которому следует уделять внимание. Пользователи ПК сравнивают диски по показателям 3Gb/s, 6Gb/s, 12Gb/s, но зачастую, скорость потока диск — сервер это не Гигабиты, и даже не Мегабиты, а Килобиты! Скорости 3Gb/s, которую обеспечивают даже устаревшие интерфейсы в большинстве случаев достаточно. Сильно ошибаются те, кто думают, что улучшат производительность, сменив диски 3Gb/s на 12Gb/s. Если не изменился форм-фактор и обороты диска — скорость IOPS не измениться.

На увеличение IOPS положительно влияют: увеличение оборотов, уменьшение физического размера, увеличение числа дисков в массиве.

LFF диски, (особенно низкооборотистые 7200RPM) не предназначены на работу в режиме случайного доступа — их назначение хранение ColdData (например бэкапов)

*SFF Small Form Factor — это диски 2,5” Обычно это высоко-оборотистые 10-15К SAS диски объёмом 300-1200GB. Не стоит путать их с ноутбучными дисками.

LFF Large Form Factor — это диски 3,5” Обычно низко-оборотистые 7200 диски, объёмом 2TB и более.И наконец, если у вас уже есть СХД, добавив полку вы можете увеличить не только объём, но и существенно повысить скорость работы. Ведь показатель IOPS напрямую зависит от количества дисков.

У нас имеются полки для наиболее распространённых СХД производства NetAPP, HP, Dell, IBM.

На этом всё.

Остались вопросы — звоните, будем рады помочь.

Полки б/у

Внешние RAID & HBA б/у

Внешние кабели SAS

forpro.ru

JBOD — это… Что такое JBOD?

JBOD (от англ. Just a bunch of disks, просто пачка дисков) — дисковый массив, в котором единое логическое пространство распределено по жёстким дискам последовательно. Однако в некоторых RAID-контроллерах режимом «JBOD» назван режим, при котором контроллер работает как обычный IDE- или SATA-контроллер, не задействуя механизмы объединения дисков в массив, то есть в таком случае каждый диск будет виден как отдельное устройство в операционной системе. Этот факт указывает на то, что термин JBOD, как режим функционирования дисков, ещё окончательно не «устоялся». Часть IT-специалистов трактует его буквально как «пучок» или «куча» дисков, каждый из которых функционирует независимо друг от друга, а понятие «spanning» (то есть «охват» данными нескольких дисков) относят уже не к JBOD, а к RAID-технологиям, поскольку имеет место организация дисков в простейший массив[1].

Пример распределения файлов по JBOD-массиву (разные файлы выделены разными цветами)

Пример распределения файлов по JBOD-массиву (разные файлы выделены разными цветами)- Характеристики JBOD массива

- Ёмкость массива равна сумме ёмкостей составляющих дисков

- Вероятность отказа приблизительно равна сумме вероятностей отказа каждого диска в массиве (избыточность не предусмотрена)

- Скорость чтения и записи зависит от области данных; она не выше, чем у самого быстрого диска в массиве и не ниже чем у самого медленного

- Нагрузка на процессор при работе минимальная (сравнимая с нагрузкой при работе с единичным диском)

- Особенности JBOD массива

- Отказ одного диска позволяет восстановить файлы на остальных дисках (если ни один из их фрагментов не принадлежит повреждённому диску)

- В ряде случаев возможно обеспечение высокой скорости работы нескольких приложений (при условии, что приложения работают с областями данных на разных дисках)

- Массив может состоять из дисков различной ёмкости и скорости

- Массив легко расширяется дополнительными дисками по мере надобности

В операционной системе Windows JBOD-массив называется составным томом (spanned volume) (возможно создание только на динамических дисках), Red Hat называет подобный тип компоновки linear RAID[2], в FreeBSD аналогичную задачу решает GEOM класс geom_concat.

Примечания

dic.academic.ru

JBOD — Википедия

Материал из Википедии — свободной энциклопедии

JBOD (от англ. Just a bunch of disks, просто пачка дисков) — дисковый массив, в котором единое логическое пространство распределено по жёстким дискам последовательно. Однако в некоторых RAID-контроллерах режимом «JBOD» назван режим, при котором контроллер работает как обычный IDE- или SATA-контроллер, не задействуя механизмы объединения дисков в массив, то есть в таком случае каждый диск будет виден как отдельное устройство в операционной системе. Этот факт указывает на то, что термин JBOD как режим функционирования дисков ещё окончательно не устоялся. Часть IT-специалистов трактует его буквально как «пучок» или «куча» дисков, каждый из которых функционирует независимо друг от друга, а понятие «spanning» (то есть «охват» данными нескольких дисков) относят уже не к JBOD, а к RAID-технологиям, поскольку имеет место организация дисков в простейший массив[1].

Пример распределения файлов по JBOD-массиву (разные файлы выделены разными цветами)- Характеристики массива JBOD

- Ёмкость массива равна сумме ёмкостей составляющих дисков

- Вероятность отказа приблизительно равна сумме вероятностей отказа каждого диска в массиве (избыточность не предусмотрена)

- Скорость чтения и записи зависит от области данных; она не выше, чем у самого быстрого диска в массиве и не ниже чем у самого медленного

- Нагрузка на процессор при работе минимальная (сравнимая с нагрузкой при работе с единичным диском)

- Особенности массива JBOD

- Отказ одного диска позволяет восстановить файлы на остальных дисках (если ни один из их фрагментов не принадлежит повреждённому диску)

- В ряде случаев возможно обеспечение высокой скорости работы нескольких приложений (при условии, что приложения работают с областями данных на разных дисках)

- Массив может состоять из дисков различной ёмкости и скорости

- Массив легко расширяется дополнительными дисками по мере надобности

В операционной системе Windows массив JBOD называется составным томом (spanned volume) (возможно создание только на динамических дисках), linux raid называет подобный тип компоновки linear RAID[2], в FreeBSD аналогичную задачу решает GEOM класс geom_concat.

См. также

- RAID — избыточный дисковый массив независимых жёстких дисков, воспринимаемых внешней системой как единое целое.

Примечания

wikipedia.green