Индексация сайта в поисковых системах

Что такое индексация в поисковых системах

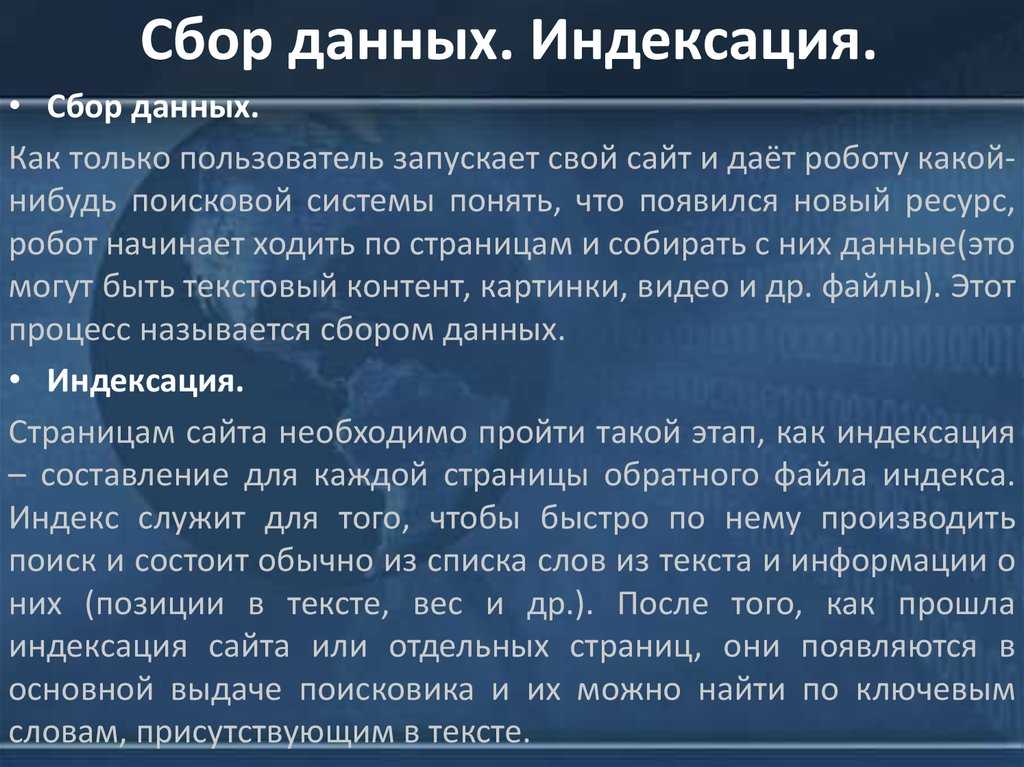

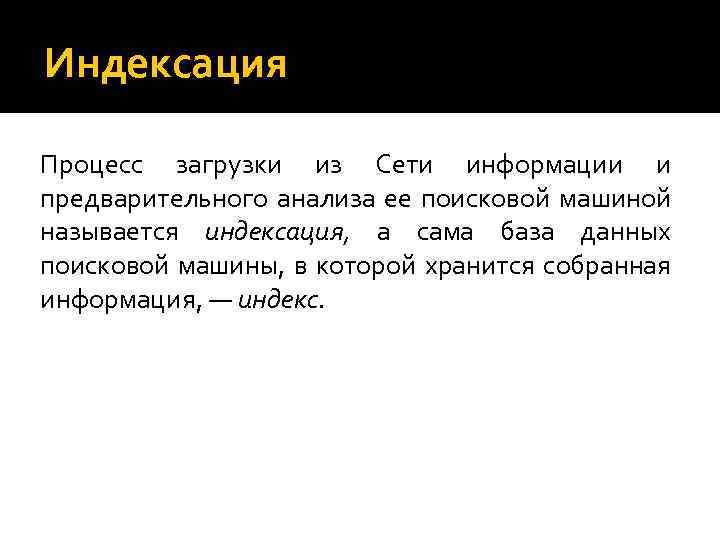

Индексирование сайта — это процесс, в ходе которого поисковые системы получают и обрабатывают информацию о страницах ресурса. Эти данные хранятся в базе, которая называется поисковым индексом. Таким образом Яндекс, Google и другие поисковики узнают, что сайт существует и наполнен каким-то контентом. Индексация необходима для того, чтобы юзеры могли быстро найти страницы при поиске, а на формирование результатов выдачи уходили всего доли секунды.

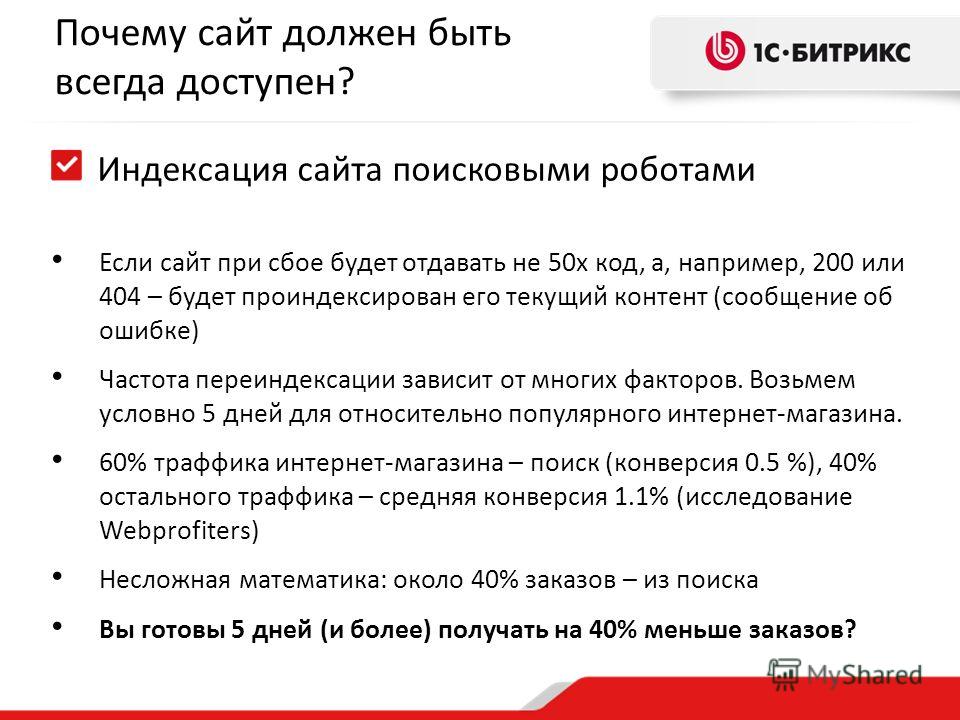

Индексация контента — основная часть работы по продвижению ресурса. Лишь позже добавляются все остальные элементы по оптимизации сайта. Если у веб-страницы есть проблемы с индексированием, бизнес не получит клиентов с сайта и, соответственно, будет нести убытки.

Для индексирования поисковик — Яндекс или Google — отправляет на сайт роботов, которые считывают код, а впоследствии регулярно посещают страницы ресурса. Периодичность зависит от того, с какой частотой меняется контент, от количества страниц и объема трафика.

Упорядочивание и учет: индексация позволяет создать “БД” для последующего моментального поиска по заранее известным данным.

Как происходит индексация

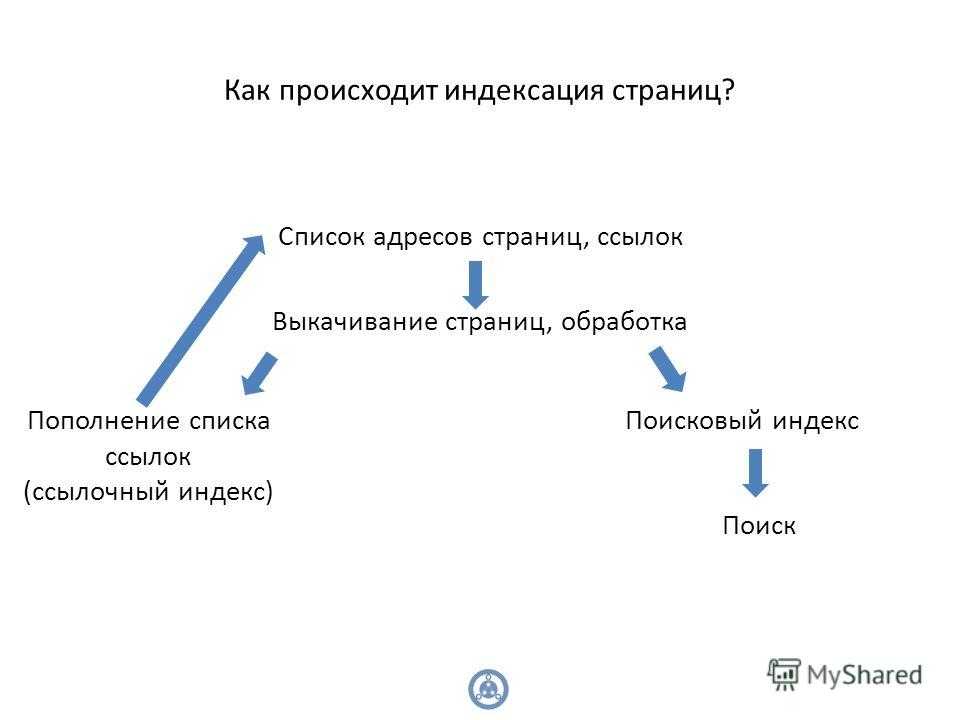

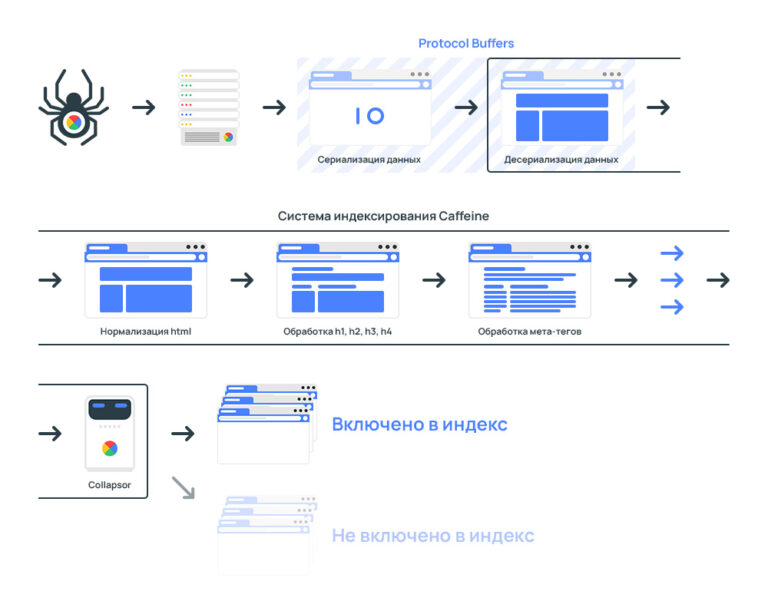

Рассмотрим, как происходит процесс индексирования страниц сайта.

- Поисковый робот (краулер) обходит ресурс и находит на нем новую страницу.

- Данные анализируются: проводится очистка контента от ненужной информации, формируется список лексем. Лексема — совокупность всех значений и грамматических форм слова в языке.

- Вся информация упорядочивается, лексемы расставляются по алфавиту. Одновременно с этим происходит обработка данных, поисковая машина относит информацию к соответствующим темам.

- Формируется индексная запись.

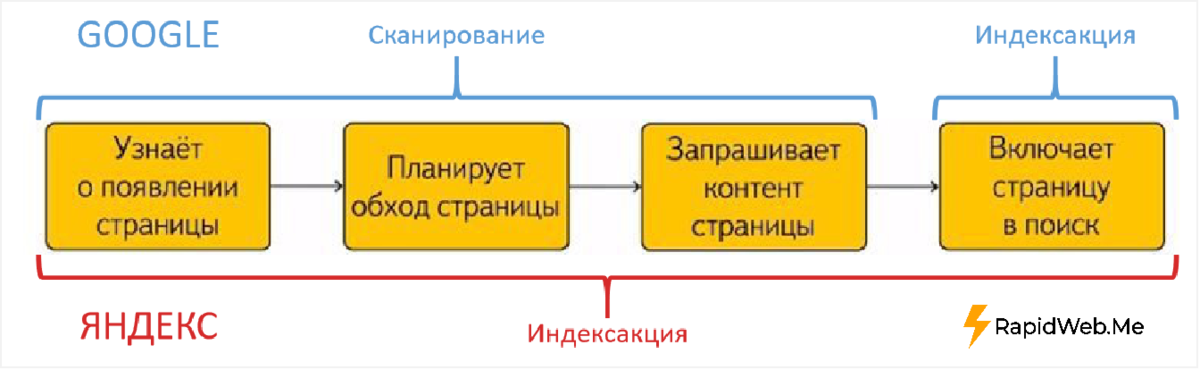

Это стандартный процесс индексации документов для поисковых систем. При этом у Яндекса и Google есть некоторые отличия в технических моментах.

Сканирование страниц

Сканирование страниц

— это главная задача поискового робота. Когда он попадает на новую страницу, то получает два набора данных:

Когда он попадает на новую страницу, то получает два набора данных:

- Содержание, информацию о сервере и служебные данные.

- Основные метаданные и Robots Meta (команды для робота)

- Список ссылок на страницах.

После этого робот передает данные в обработку, а затем сохраняет их в базе. Наиболее простой способ индексации страниц в рамках домена — создание карты сайта sitemap.xml.

Подробнее о XML карте вы можете прочитать в отдельной статье

Чтобы Google и Яндекс могли увидеть ваш сайт, нужно в первую очередь добавить его в сервисы, а после этого прикрепить ссылку на файл Sitemap в Google Search Console и Яндекс.Вебмастере. Это специальные сервисы для вебмастеров, которые помогают работать с индексацией и отслеживать ошибки на сайте.

Чтобы добавить файл Sitemap в Google Search Console, нужно зайти в сервис, добавить свой сайт и перейти в раздел «Индекс». В пункте «Файлы Sitemap» нужно выбрать «Добавить файл Sitemap» и вставить ссылку на файл Sitemap.

Добавление карты сайта в Search Console

В Яндекс.Вебмастере путь примерно такой же: зайдите в аккаунт, выберите нужный сайт. После этого в левом меню нажмите на раздел «Индексирование» и выберите вкладку «Файлы Sitemap». В строку «Добавить файл Sitemap» нужно вставить ссылку файла и нажмите «Добавить». Кстати, если вы внесли какие-либо в карту сайта, просто отправьте карту на перепроверку, нажав на стрелки рядом с файлом Sitemap.

Добавление XML карты в Вебмастер

Обработка страниц

После сбора роботами информация будет обработана, а затем попадет в базу данных. Это важно для ускорения дальнейшего поиска.

Сначала программа формирует страницу со всем содержимым: скрипты, эффекты, стили. Очень важно, чтобы робот имел полный доступ ко всем файлам, поскольку без них индексатор не сможет точно увидеть структуру.

Вы можете посмотреть, одинаково ли отображается страница для пользователей и поискового робота. Для этого нужно зайти в Google Search Console и выбрать отчет «Посмотреть как Googlebot» в разделе «Сканирование».

Для этого нужно зайти в Google Search Console и выбрать отчет «Посмотреть как Googlebot» в разделе «Сканирование».

После этого робот анализирует текст страницы: упрощает слова и определяет частоту упоминания ключевого слова, проверяет уникальность. Если размещенный контент уже индексировался в интернете, у страниц будет низкая уникальность. Следовательно, робот может не добавить их в поисковый индекс. Поэтому важно наполнять свой сайт преимущественно уникальным и полезным контентом

Технологии и алгоритмы индексации

Важно понимать, что точные алгоритмы индексирования — это строго закрытая коммерческая информация. Поисковые системы тщательно охраняют эти данные.

«Яндекс» при индексации ориентируется преимущественно на файл robots.txt, а Google — на файл sitemap.xml.

Главным отличием считается использование технологии Mobile-first. Она предполагает первоочередное сканирование и индексацию мобильной версии сайта. В индексе хранится именно мобильная версия. Получается, если страница сайта при показе на мобильных устройствах будет содержать мало важной информации или в целом проигрывать основной версии по качеству, высок риск, что в индекс она не попадет.

Получается, если страница сайта при показе на мобильных устройствах будет содержать мало важной информации или в целом проигрывать основной версии по качеству, высок риск, что в индекс она не попадет.

Кроме этого, Google подтверждает наличие «краулингового бюджета» — регулярности и объема посещения сайта роботом. Чем больше краулинговый бюджет, тем быстрее новые страницы будут оказываться в индексе. Увы, точных данных о способах расчета данного показателя в компании не раскрывают. По наблюдениям специалистов, в этом случае существенное влияние оказывают возраст сайта и частота обновлений.

«Яндекс»

В «Яндексе» главной версией сайта считается десктопная, поэтому в первую очередь сканироваться будет именно она. Официально краулингового бюджета нет, поэтому индексирование проводится вне зависимости от траста и других показателей ресурса. Еще влиять может количество выложенных в сеть страниц. Речь идет о страницах, которые конкуренты и другие пользователи публикуют одновременно с вами.

Приоритет при индексации имеют сайты с большей посещаемостью. Чем выше посещаемость, тем быстрее новая страница будет отображаться в поисковой выдаче.

Отдельно отметим, что Яндекс не индексирует документы с весом более 10 Мб. Это следует учитывать при создании страниц сайта.

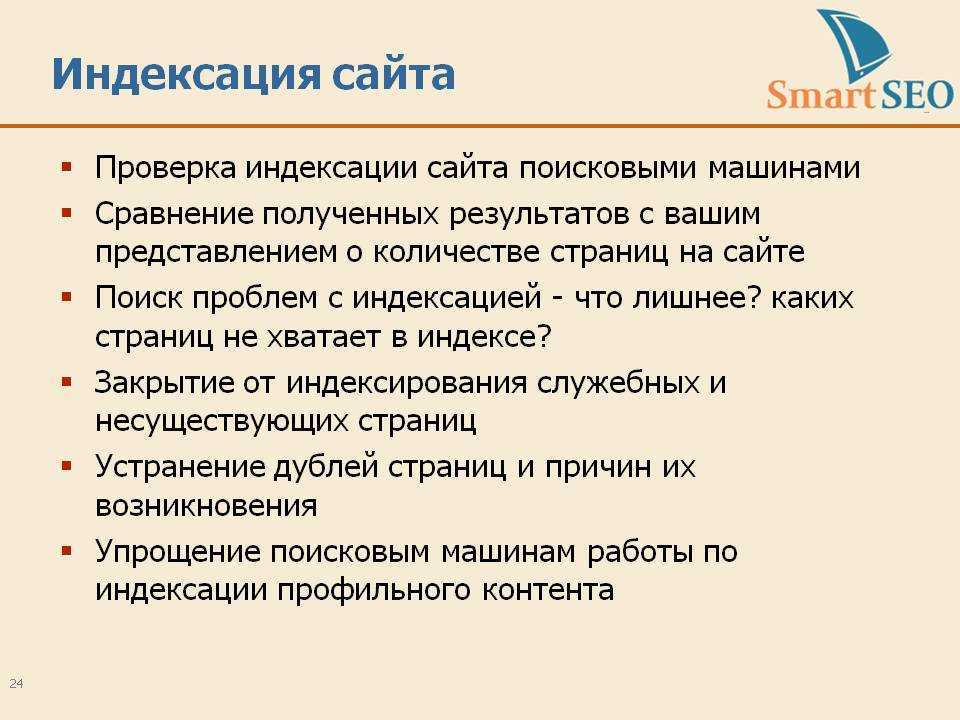

Как эффективно проиндексировать сайт

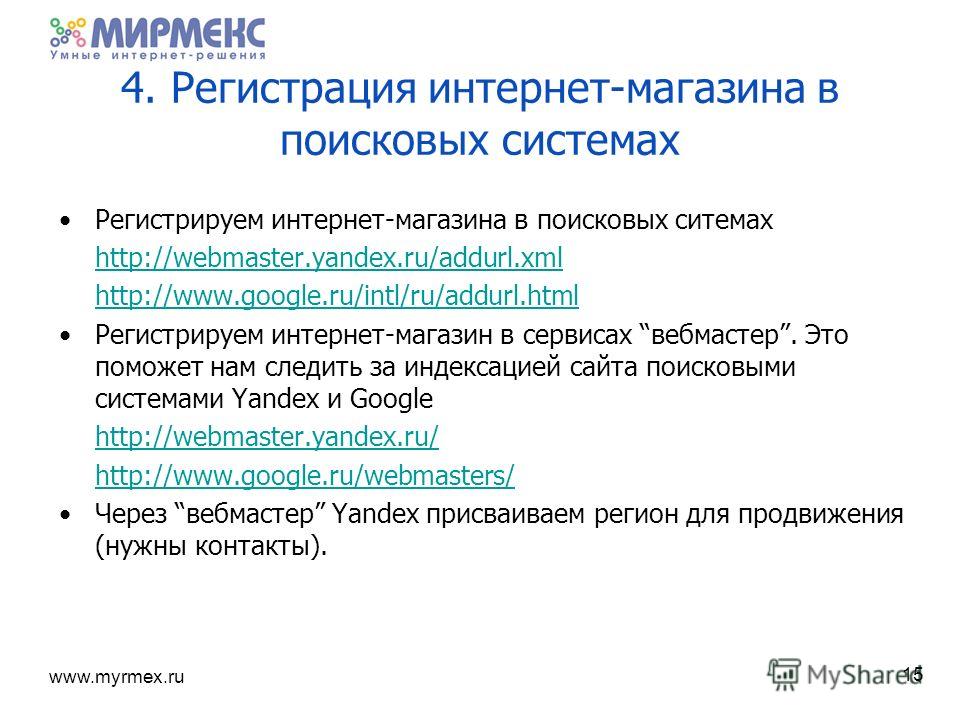

Чтобы сайт начал как можно быстрее индексироваться поисковыми системами, его следует добавить в базу поисковиков через инструменты для вебмастеров.

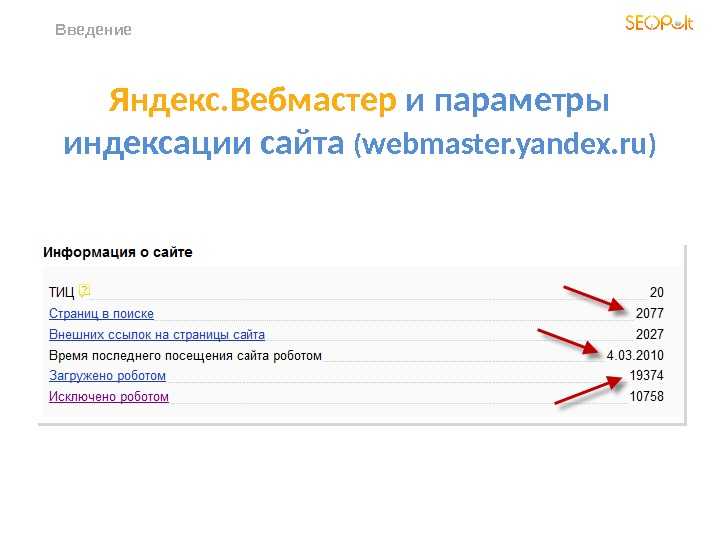

Добавьте сайт в Яндекс.Вебмастер

Для начала нужно зайти в личный кабинет в сервисе и добавить сайт в главном меню.

Добавление нового сайта в Вебмастер

На следующем шаге нужно скопировать код подтверждения и добавить его в исходный код страниц сайта в раздел <head>.

Код подтверждения в конце тега <head>

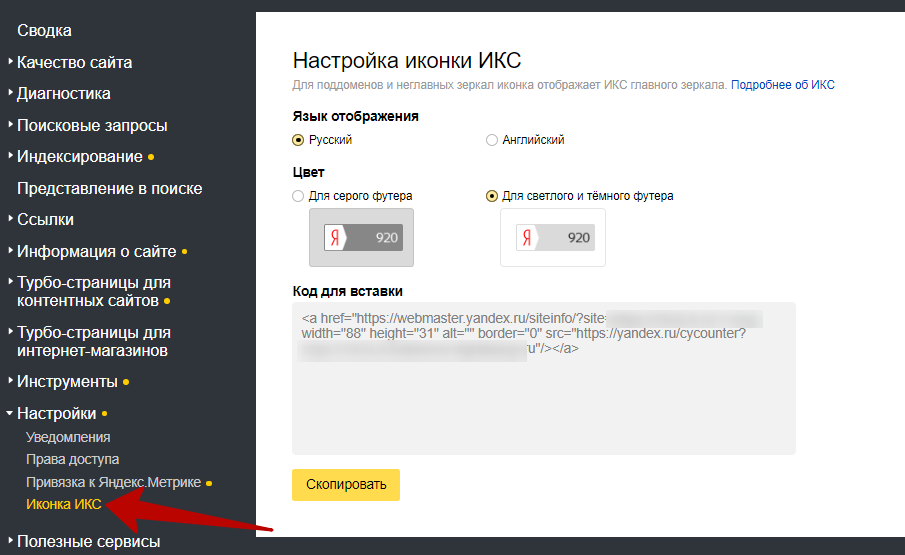

Для повышения точности данных нужно привязать Яндекс.Метрику к сайту в пункте Настройки -> Привязка к Яндекс. Метрике. Информацию из Метрики робот будет использовать во время обходов.

Метрике. Информацию из Метрики робот будет использовать во время обходов.

Привязка к Яндекс.Метрике

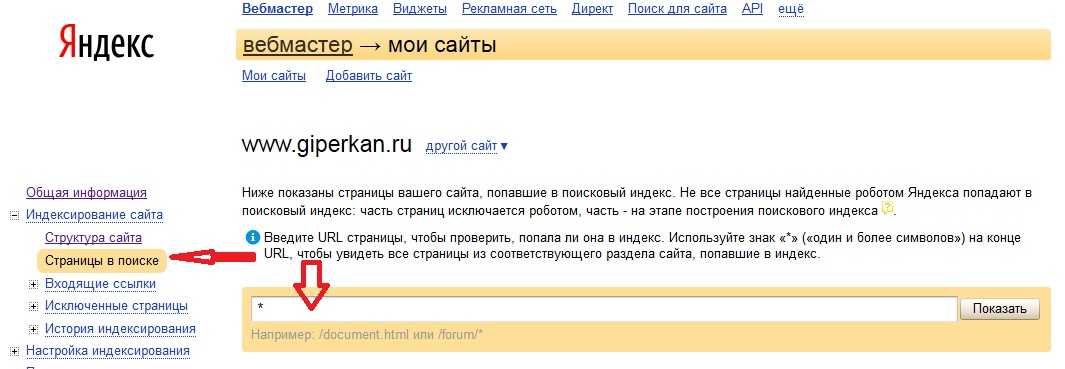

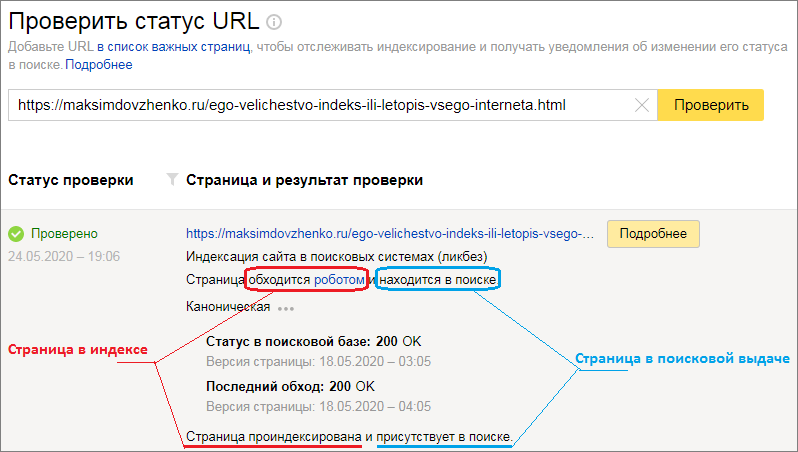

Чтобы проверить, проиндексированы ли те или иные страницы на текущий момент, нужно перейти в меню Индексирование -> Проверить статус URL.

В том же меню можно увидеть информацию о том, когда и с каким результатом робот обходил страницы, какие из них присутствуют в поиске. Там же есть функция добавления Sitemap, запуска переобхода и настройки скорости обхода.

Добавьте сайт в Google Search Console

Нужно перейти на https://search.google.com/search-console/welcome и войте в учётную запись. Добавьте сайт в систему.

Добавление сайта в Google Search Console

Как и в Яндекс.Вебмастере, инструмент предлагает большое количество отчетов о состоянии индексации сайта. Можно увидеть, какие страницы проиндексированы и добавлены в поиск, какие есть внутренние и внешние ссылки и многое другое.

Если Яндекс автоматически обнаруживает файлы Sitemap и имеет довольно гибкие настройки переиндексации, то у Google Search Console с этим могут возникнуть проблемы. Иногда он не может увидеть файлы Sitemap — тогда их следует загрузить вручную. Настройки повторного обхода страниц после обновлений не столь удобны — в первую очередь необходимо проверить конкретный URL, а лишь после этого появится кнопка “Запросить индексирование”.

Иногда он не может увидеть файлы Sitemap — тогда их следует загрузить вручную. Настройки повторного обхода страниц после обновлений не столь удобны — в первую очередь необходимо проверить конкретный URL, а лишь после этого появится кнопка “Запросить индексирование”.

Добавление сайта в прочие поисковые системы

В российском сегменте интернета доля поисковых систем, кроме Яндекса и Google, близка к нулю. Тем не менее, пренебрегать ими не стоит, если сайт является важным имиджевым элементом крупной компании или проекта.

- Рамблер. Этот поисковик основан на тех же данных индексации, которые собирает Яндекс — в этом случае дополнительные настройки не нужны.

- Mail.ru. У него есть свой кабинет для вебмастеров — https://webmaster.mail.ru/. В нём предлагается минимальный набор инструментов для управления и отслеживания индексации в системе.

- Yahoo и Bing. В определённый момент Bing, который принадлежит Microsoft, поглотил поисковый движок Yahoo, объединив их сервисы для вебмастеров — https://www.

bing.com/toolbox/webmaster/.

bing.com/toolbox/webmaster/.

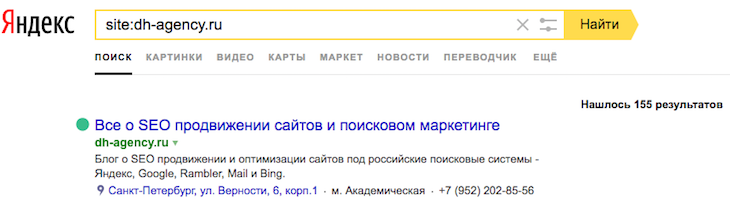

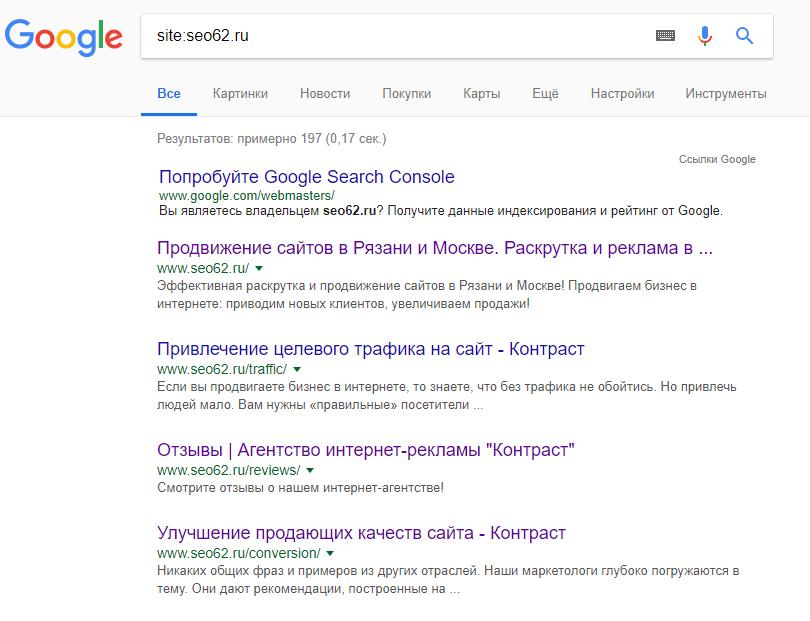

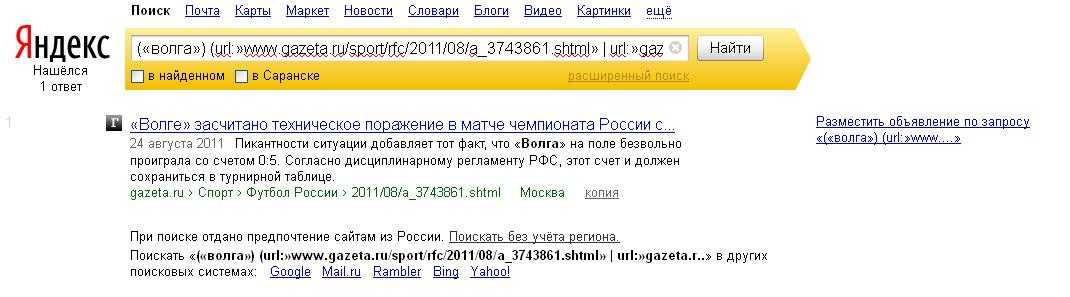

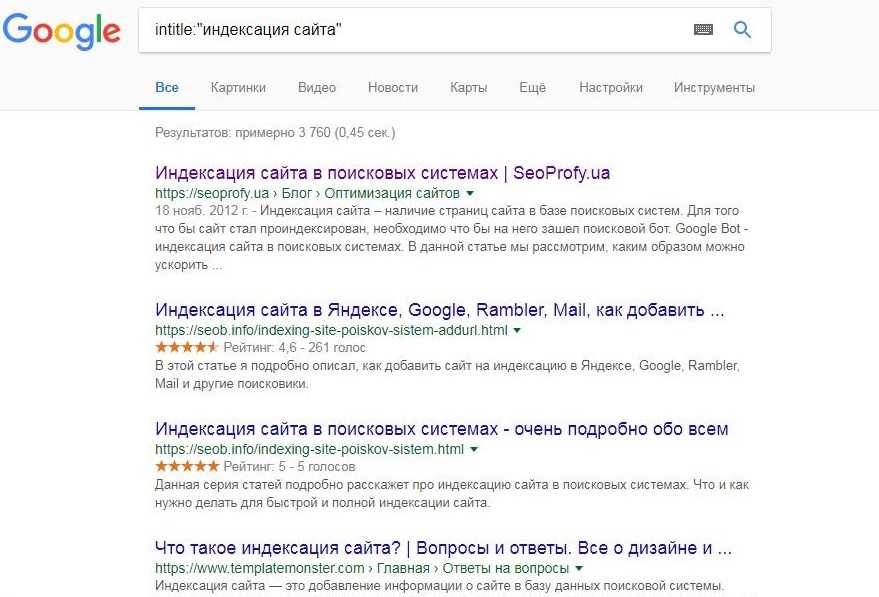

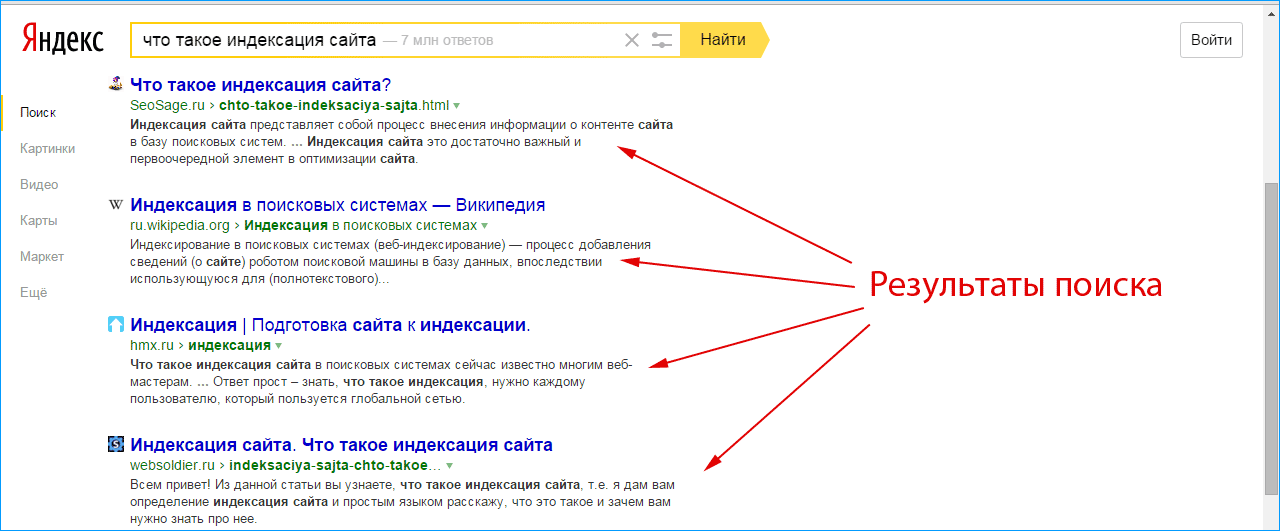

Как проверить индексацию

Есть три способа проверки того, отображается ли сайт в поисковиках: запрос в поисковой системе, использование бесплатных сервисов для автоматической проверки, а также специальные сервисы для веб-мастеров.

Поисковая строка

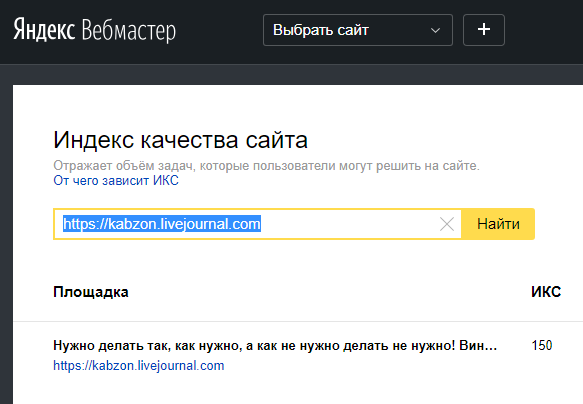

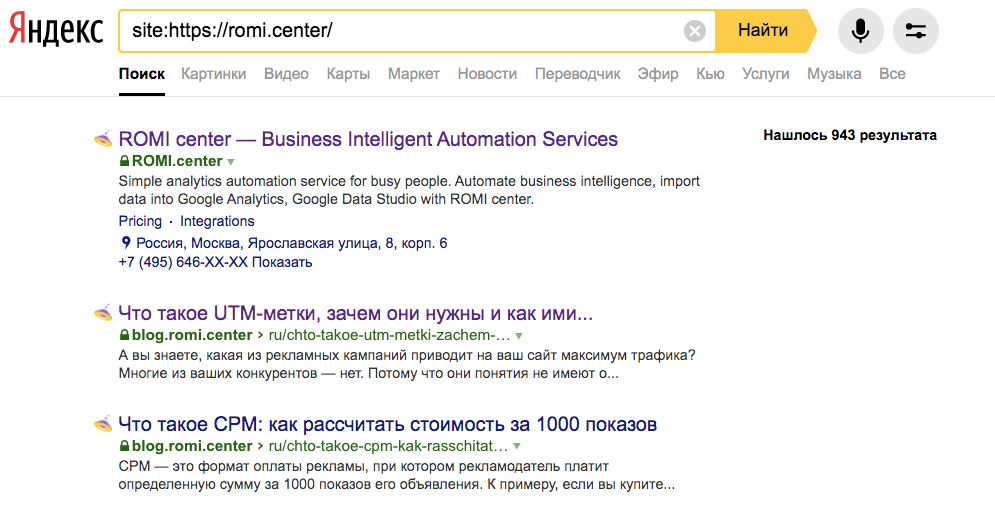

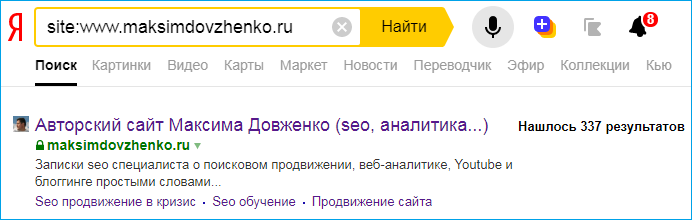

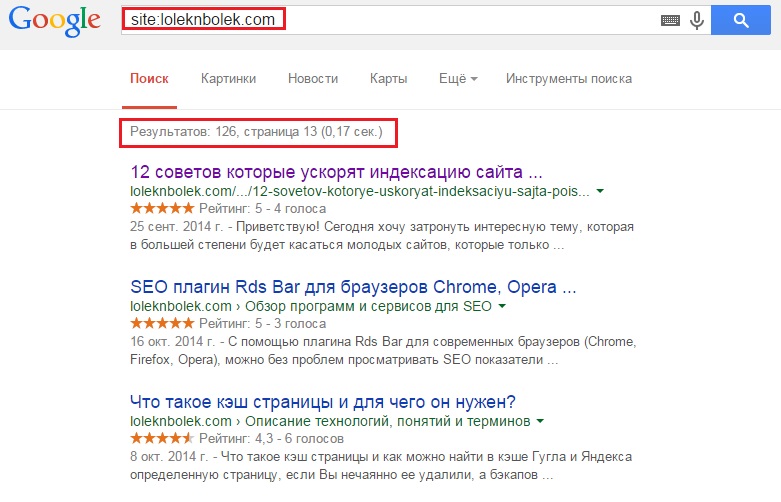

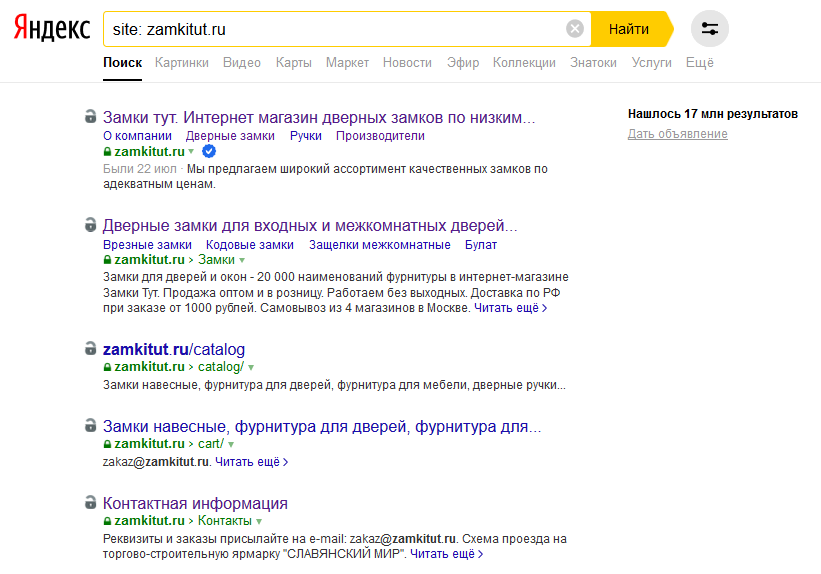

Наиболее простой и быстрый способ проверки индексации. Яндекс и Google поддерживают оператор site, который отображает проиндексированные страницы. Базовый синтаксис использования: site:sitename.com

Например: site:mosreg.ruОднако поисковые системы могут ограничить работу этих операторов для снижения нагрузки. Поэтому лучше использовать дополнительные способы проверки.

Бесплатные плагины

Можно использовать бесплатные сервисы, например, BE1 и PR-CY. Для проверки нужно ввести адрес сайта в специальную строку и нажмите «Проверить». Обычно такие сервисы, кроме количества страниц в индексе популярных поисковиков, предоставляют еще много полезных и интересных данных.

Анализ показателей сайта через сервис Be1, в том числе количество проиндексированных страниц

Как ускорить индексацию сайта

Современные поисковые роботы достаточно быстро собирают информацию о ресурсе: обычно новые страницы появляются в индексе уже через 20–40 минут. Но так бывает не всегда, поскольку может произойти сбой или другая нештатная ситуация, и страница будет индексироваться очень долго.

Стоит учесть, что появление адреса в списке проиндексированных страниц «Яндекс.Вебмастера» не совпадает с реальным моментом индексации. На практике URL оказывается в индексе намного раньше, а в кабинете — лишь при очередном апдейте.

При этом есть ситуации, когда индексирование важно ускорить:

- Сайт выходит из-под фильтров.

- Молодой ресурс обладает небольшим краулинговым бюджетом.

В обоих случаях можно и нужно “подтолкнуть” поисковых роботов. Отметим, что для «Яндекса» и Google подход будет отличаться.

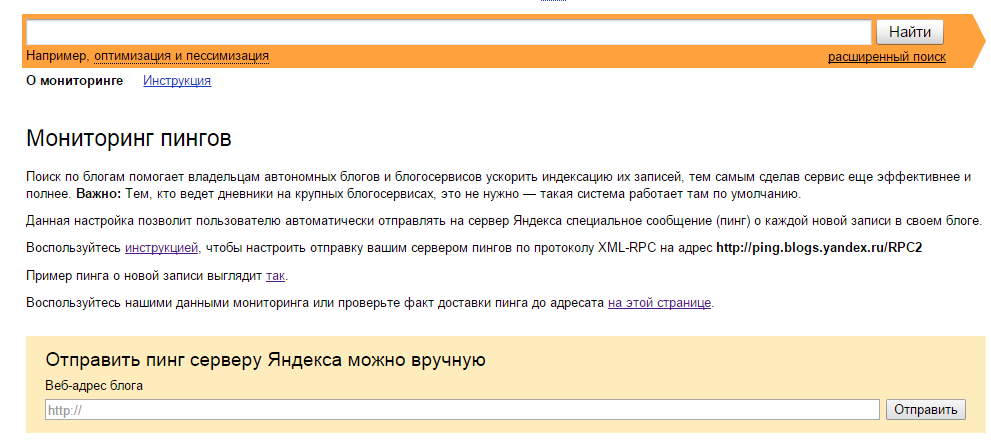

Начнем с российской поисковой системы. Заходим в «Яндекс.Вебмастер» и в меню слева, во вкладке «Индексирование», находим ссылку «Переобход страниц». Переходим по ней.

На следующей вкладке нужно ввести URL новой страницы, а затем нажать кнопку «Отправить». Отследить статус заявки можно в списке ниже.

Яндекс.Вебмастер — «Переобход страниц»

То же самое можно делать не только с новыми страницами, но и с уже имеющимися, если в них были изменения. Нужно помнить, что количество отправок в сутки ограничено, и все зависит от возраста и траста сайта.

В самом «Вебмастере» для ускорения индексирования рекомендуется подключать переобход по счетчику «Яндекс.Метрики». Это не самое хорошее решение. Все потому, что поисковый робот может ходить по всем страницам — даже тем, которые не требуется индексировать, причем в приоритете будут наиболее посещаемые документы. Может возникнуть ситуация, когда старые страницы робот обошел, а новые — не увидел. Или вовсе в поиск попадут технические страницы: например, страница авторизации или корзина интернет-магазина.

Или вовсе в поиск попадут технические страницы: например, страница авторизации или корзина интернет-магазина.

У Google ускорение индексации состоит из двух этапов. Сначала нужно перейти в Search Console, где на главной странице вверху можно увидеть поле «Проверка всех URL». В него следует вставить адрес страницы, которую требуется проиндексировать. Далее нажимаем на клавиатуре «Enter».

Ждем около минуты. Некоторое время поисковая машина будет проверять, можно ли проиндексировать адрес. Если все прошло успешно, Google сообщит, что страница отправлена на индексирование. Остается лишь дождаться результатов.

При отправке на индексирование страниц сайта важно помнить, что Google до сих пор очень ценит ссылки. Поэтому есть и другой способ ускорения индексации — Twitter. Сразу после публикации страницы можно отправиться в Twitter и сделать твит с нужным адресом. Буквально через полчаса URL будет уже в индексе Google.

Лучше всего использовать эти способы совместно — так надежнее.

Как закрыть сайт от индексации

Закрыть сайт от индексации — значит, запретить поисковым роботам доступ к сайту, к некоторым его страницам, части текста или изображению. Как правило, это делается, чтобы скрыть от публичного доступа определенную секретную информацию, технические страницы, сайты на уровне разработки, дублированные страницы и проч.

Сделать это можно несколькими способами:

1. С помощью robots.txt можно запретить индексацию всего сайта или определенных страниц. Для этого в корне веб-сайта нужно создать текстовый документ, в котором будут указаны правила для роботов поисковых систем. Они состоят из двух частей: первая (User-agent) указывает на адресата, а вторая (Disallow) запрещает индексацию того или иного объекта.

Например, запрет индексации всего сайта для всех поисковых ботов выглядит так:

User-agent: *

Disallow: /

2. При помощи мета-тега robots, который считается наиболее правильным для закрытия одной конкретной страницы от индексирования. Теги noindex и nofollow помогут запретить роботам любых поисковых систем индексировать сайт, страницу или часть текста.

Теги noindex и nofollow помогут запретить роботам любых поисковых систем индексировать сайт, страницу или часть текста.

Запись для запрета индексации всего документа будет выглядеть так:

<meta name=»robots» content=»noindex, nofollow»/>

Можно создать запрет для определенного робота:

<meta name=»googlebot» content=»noindex, nofollow»/>

Что делать, если сайт не индексируется

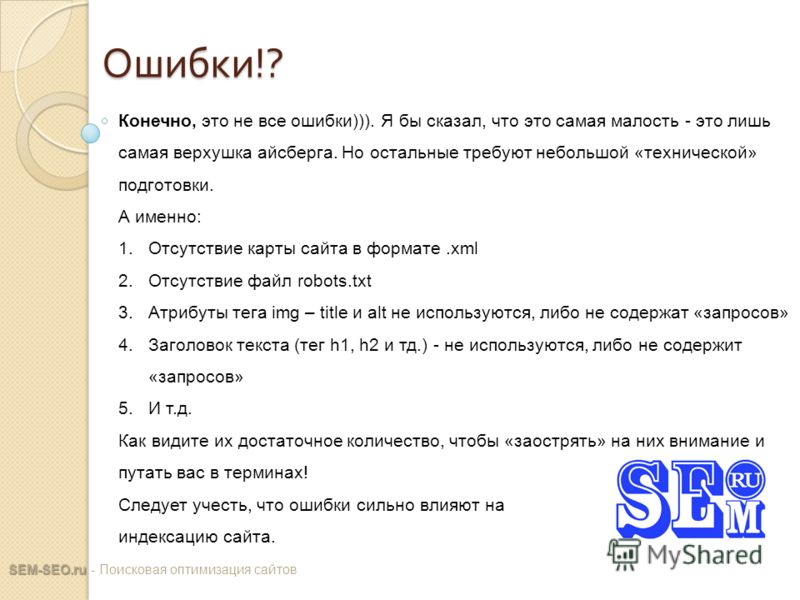

Есть большое количество причин, почему сайт не индексируется. Условно их можно разделить на технические и контентные.

Технические причины

Сайт может быть случайно закрыт от сканирования роботами, например, из-за ошибки разработчиков. Это можно обнаружить, если проверить:

- Директиву Disallow в файле robots.txt. Она, как мы говорили ранее, закрывает конкретные страницы от индексации.

- Мета-теги в разделе <head> HTML-документа, например, <meta name=»robots» content=»noindex» />.

Они помогают определить отношение к сканированию контента в документе.

Они помогают определить отношение к сканированию контента в документе. - HTTP-заголовок X-Robot-Tag — информация о запрете или разрешении индексации сайта в HTTP-заголовках ответа сервера.

- Код ответа сервера. В индекс попадают лишь доступные страницы с кодом ответа сервера 200 Ок, а ресурсы с другими кодами ответа удаляются. Изменение кода ответа — один из способов управления индексацией.

- Настройки сервера. Для разных IP адресов, User-agent и иных параметров серверная часть ресурса может регулировать как скорость, так и саму отдачу информации о странице и ее содержимом.

- Отсутствие входящих внутренних или внешних ссылок (так называемые страницы-сироты). Индекс может исключать их.

- Низкий трафик. Это может быть следствием недостаточно полезной страницы или отсутствием семантического спроса со стороны пользователей по конкретному контенту.

Контентные причины

Стоит помнить, что индексация всегда занимает определенное время. Поэтому, если страницы нет в индексе, иногда это может говорить о том, что роботы поисковых систем просто не успели до нее дойти. Также есть риск, что присутствуют ошибки в контентном наполнении страниц:

Поэтому, если страницы нет в индексе, иногда это может говорить о том, что роботы поисковых систем просто не успели до нее дойти. Также есть риск, что присутствуют ошибки в контентном наполнении страниц:

- Отсутствие индексируемого контента. Контент может быть реализован на технологии, которую поисковые системы не способны считывать или плохо воспринимают к индексации. Так векторная графика, например, Flash, не индексируется.

- Контент без пользы или вредный для пользователей. Сюда относятся спам, малый по объему контент, устаревшая информация, которая не будет пользоваться популярностью, наличие вирусов или фишинга.

- Дублирующийся контент. Поисковые системы обычно не индексируют или удаляют из выдачи страницы, которые содержат одинаковую информацию.

Иные причины

Более редкие случаи неиндексации бывают связаны, например, с фильтром «для взрослых».

Возможен редкий случай неиндексации — «плохая история» домена. В этом случае, например, был куплен домен, на котором ранее был поисковый спам, плохие ссылки, adult-контент. Также он мог быть ранее замечен в других черных способах продвижения, поэтому сайт сразу окажется под фильтром. Поэтому перед покупкой домена стоит проверить его историю.

В этом случае, например, был куплен домен, на котором ранее был поисковый спам, плохие ссылки, adult-контент. Также он мог быть ранее замечен в других черных способах продвижения, поэтому сайт сразу окажется под фильтром. Поэтому перед покупкой домена стоит проверить его историю.

Выводы

Индексация страниц сайта проводится, как правило, достаточно быстро. При правильной настройке документы могут попадать в индекс поиска уже спустя полчаса после размещения.

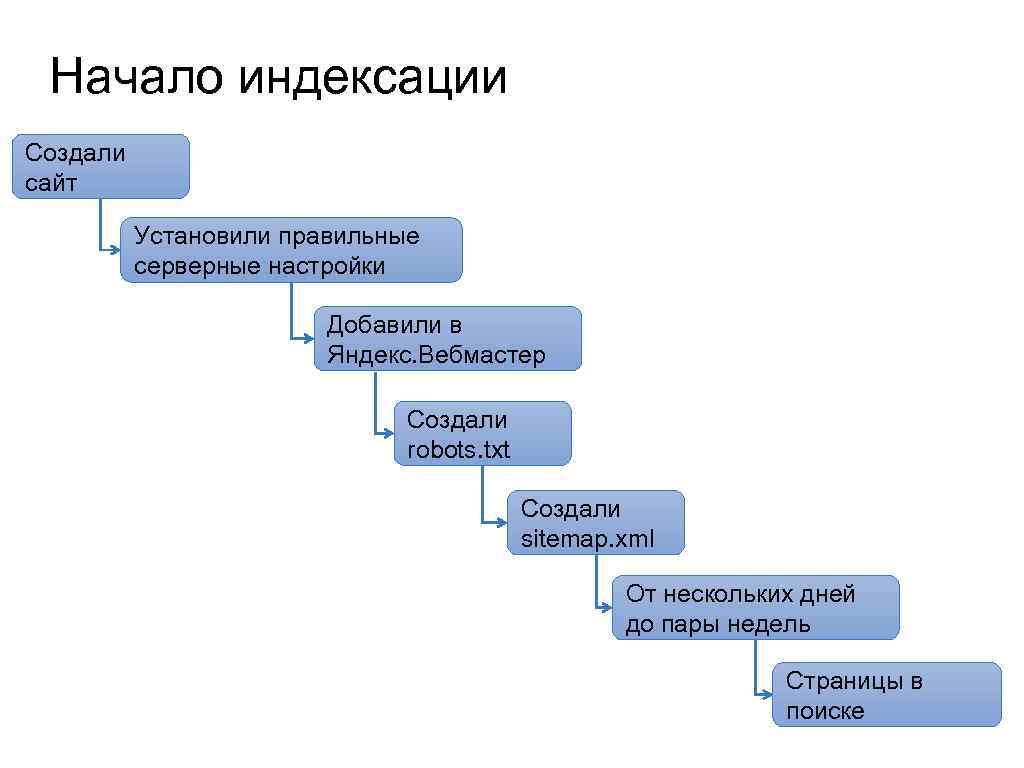

Настройка сводится к созданию правильных конфигурационных файлов, а также удобных условий для поискового робота для перехода по страницам сайта. Вот какие шаги следует предпринять для правильной индексации:

- Создать и правильно настроить файл robots.txt.

Подробнее о robots.txt вы можете прочитать в другом материале

- Создать файл sitemap.xml.

- Зарегистрировать сайт в сервисах Google Search Console и «Яндекс.Вебмастер».

- Каждый раз после размещения новой статьи или страницы отправлять URL на проверку.

- Использовать дополнительные инструменты: размещение ссылок в Twitter и на других трастовых ресурсах.

- Проводить контроль качества HTML верстки. Большое количество ошибок в HTML коде часто приводит к некорректной индексации документа.

- Проводить проверку внутренней оптимизации: перелинковка страниц

- Проводить работы над уникальностью контента на страницах. Яндекс часто исключает страницы с неуникальным контентом из индекса и помечает их как “малополезные”.

После этого вероятность возникновения проблем с индексированием будет минимальной. Теперь можно переходить к наращиванию позиций в топе, но это уже тема другой статьи.

Индексация сайта в поисковых системах

Индексация сайта – это сбор информации поисковым роботом о контенте, ключевых фразах, ссылках, изображениях, находящихся на страницах. Полученные сведения сохраняются в базе данных — поисковом индексе. Эта информация необходима для того, чтобы в дальнейшем выдавать пользователям результаты, отвечающие на введенные запросы.

Как происходит индексация сайта поисковыми системами

Один запрос — это тысячи адресов, потенциально содержащих ответ. По сути, Google знает его до того, как пользователь ввел запрос в поисковую строку. Индексация — непрерывный процесс, так как веб-роботы регулярно сканируют новые и обновленные сайты, добавляя полученную информацию в индекс (базу данных). Получается, когда пользователь что-то ищет в интернете, на самом деле он ищет индекс.

Подстраницы сайта, то есть, дочерние, идущие после основной, индексируются по одной. После ввода запроса робот выполняет поиск по индексу и находит все соответствующие ему страницы. Таким образом, мы получаем действительно огромное количество результатов.

Чтобы дать пользователю наиболее точный ответ, Google использует алгоритмы, которые выбирают сайты в индексе на основе нескольких сотен различных факторов. Они учитывают не только количество и размещение ключевых слов, релевантных словосочетаний, но и качество, юзабилити сайта, насколько хорошо он защищает конфиденциальные данные. Факторов ранжирования множество, и соответствовать нужно каждому. При этом сам процесс определения позиции сайта и отображения результатов поиска занимает у Google примерно полсекунды.

Факторов ранжирования множество, и соответствовать нужно каждому. При этом сам процесс определения позиции сайта и отображения результатов поиска занимает у Google примерно полсекунды.

Сколько www-адресов в индексе? Сотни миллиардов. Они занимают более 100 000 000 гигабайт. Google назначает сайт для индекса в соответствии со словами, которые он содержит.

Загрузка, индексация и работа алгоритмов

Чтобы определить сайт, который лучше всего отвечает на запросы пользователя, должны сработать поисковые алгоритмы. Именно благодаря им результаты в индексе выбираются и упорядочиваются в определенном порядке. Google постоянно работает над улучшением своих алгоритмов, поэтому он может распознавать ключевые слова, контекст и даже опечатки, которые могут появляться при вводе запроса. При этом алгоритмы оценивают не только текст, но и другие аспекты, например, доверие к сайту, достоверность и информативность контента, качество ссылок и даже намерения пользователя.

Провести анализ индексации сайта в поисковых системахАдрес сайта

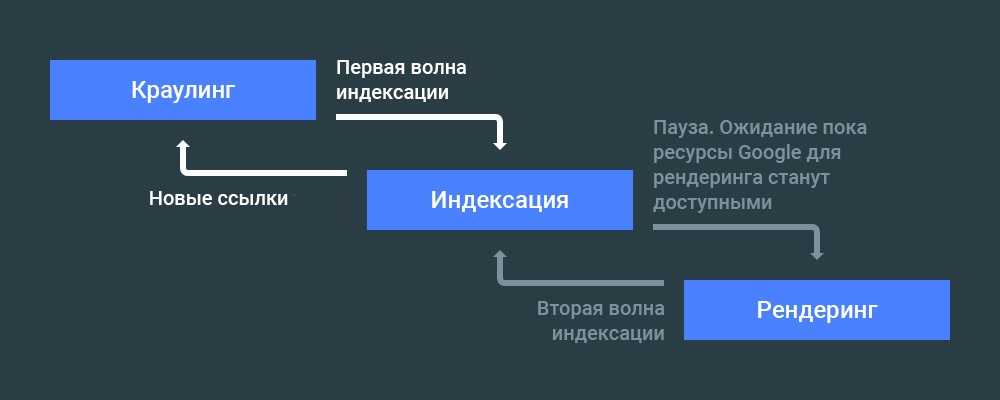

Индексирование и сканирование

Что такое индексация страниц, мы рассмотрели. Однако в контексте поисковых систем вы также можете найти термин «сканирование». Сканирование еще не индексирует страницы, а только перемещает робота между ними.

Однако в контексте поисковых систем вы также можете найти термин «сканирование». Сканирование еще не индексирует страницы, а только перемещает робота между ними.

Crawling — это отправка бота на анализируемый сайт, тогда как индексирование — это загрузка, обработка и сбор данных для включения его в индекс поисковой системы. Сканирование не означает, что адрес был проиндексирован и появится в результатах поиска.

Размещение веб-адреса в индексе — это следующий этап после сканирования. Не каждая просканированная страница индексируется, но каждая проиндексированная была просканирована ранее.

Краулинговый бюджет сканирования

Краулинговый бюджет — это максимальный объем данных, которые поисковая система может получить с домена за одно посещение роботом. Чтобы извлечь максимальную пользу из обхода роботом, необходимо рассмотреть два аспекта:

- ограничение скорости сканирования;

- ускорение индексирования сайта.

Во время одного посещения сайта роботы хотят просканировать максимально возможное количество URL-адресов. Ограничение скорости сканирования заключается в том, чтобы они делали обход без перегруза сервера. Если краулер будет загружать слишком большое количество страниц, сайт начнет грузиться медленнее, а это, в свою очередь, разочарует его посетителя.

Ограничение скорости сканирования заключается в том, чтобы они делали обход без перегруза сервера. Если краулер будет загружать слишком большое количество страниц, сайт начнет грузиться медленнее, а это, в свою очередь, разочарует его посетителя.

Ранее для этого ограничения нужно было указывать директиву crawl-delay в файле robots.txt. Сегодня она считается устаревшей, так как поисковые системы сами управляют скоростью. Если нагрузка на сервер слишком большая, сканирование прекращается автоматически, поэтому «тяжелые» странички необходимо оптимизировать, чтобы их вес уменьшился, и на их обработку роботы тратили меньше времени.

Чтобы ускорить индексирование, бота принудительно возвращают на сайт. Для этого новые или обновленные страницы отправляются на повторное сканирование через панель вебмастера. Стоит отметить, что популярные и часто обновляемые сайты обрабатываются чаще, так как изменения на них привлекают внимание поисковых роботов. Именно поэтому прекращение работ по оптимизации становится причиной снижения позиций в выдаче.

Если кратко, бюджет индексации сайта — количество URL-адресов, которые поисковая система может и хочет проиндексировать. Выражается в мегабайтах (Мб).

На каждый домен выделен ежедневный бюджет. Боты просматривают страницы до предела и прекращают индексирование после его израсходования. Затем они возвращаются, чтобы проверить обновления на уже загруженных адресах. Если архитектура сайта плохо проработана, страницы, расположенные слишком глубоко, могут вообще не индексироваться. Чтобы этого избежать, нужно делать упор не столько на красивом дизайне, сколько на юзабилити с учетом дальнейшей оптимизации. Важные подстраницы должны находиться в числе первых в иерархии структуры сайта, остальные упорядочиваются по мере снижения приоритетности.

Когда поисковый робот возвращается на сайт, никто не знает. По идее, сканирование осуществляется каждый день, но нигде не указано, когда именно бот его прекращает и в какое время возобновляет.

Циклическая индексация

Индексирование носит циклический характер, поэтому нужно постоянно заботиться о качестве сайта и вносимых обновлениях, чтобы занимать высокие позиции в результатах выдачи. После первого посещения роботы время от времени возвращаются, чтобы проверить и проиндексировать любые изменения. Чем чаще они встречают новый, ценный контент, тем больше вероятность, что вернутся вновь. И как итог: чем раньше он будет проиндексирован, тем быстрее появится в результатах поиска.

После первого посещения роботы время от времени возвращаются, чтобы проверить и проиндексировать любые изменения. Чем чаще они встречают новый, ценный контент, тем больше вероятность, что вернутся вновь. И как итог: чем раньше он будет проиндексирован, тем быстрее появится в результатах поиска.

Часто возникающие вопросы в процессе индексации сайтов.

1. Почему я не могу найти свою страницу в Google?

1.1. Время индексации.

Сколько времени занимает индексация страницы в Google? На этот вопрос нет однозначного ответа. Однако практика веб-мастеров показывает — загрузка нового сайта в индекс поисковой системы может занять от пары дней до нескольких месяцев. В этой статье мы рассмотрим факторы, которые ускоряют и замедляют этот процесс, и попытаемся ответить на вопрос, можно ли оценить реальное время индексации страницы в Google.

Как проверить, была ли страница сохранена в поисковой системе?

Способ 1: введите сайт в окно поисковой системы ссылку Вашего сайта. Если вы получаете результаты, сайт был проиндексирован. Отсутствие ссылок на сайт означает, что он, вероятно, еще не обработан роботом Google.

Если вы получаете результаты, сайт был проиндексирован. Отсутствие ссылок на сайт означает, что он, вероятно, еще не обработан роботом Google.

Способ 2: проверить статистический отчет в консоли Google для веб-мастеров. Он содержит информацию о действиях на сайте, выполненных поисковым роботом за последние 90 дней.

1.2. Когда Google не сохраняет адрес в индексе?

Google не сохраняет url сайта по разным причинам. Несколько примеров, почему это может произойти:

- неправильно настроенный robots.txt. При этом поисковая система по-прежнему может просматривать страницу, заблокированную в файле robots.txt, но не будет видеть ее содержимое. В этом случае рядом с результатом появится сообщение: «Описание этого результата недоступно из-за robots.txt»,

ограничено выбранными каталогами,

например:

User-agent: *

Disallow: / images /

Disallow: / private /

Здесь мы не блокируем индексацию всей страницы, а только элементы, хранящиеся в двух каталогах, то есть, images и Private.

Или

User-agent: *

Disallow: /

Здесь блокируем доступ ко всему сайту.

- неправильно настроенный файл .htaccess, который позволяет, среди прочего, блокировать пользователей, например, по IP-адресам. Если администратор случайно заблокировал IP-адреса Google, страница не проиндексируется;

- устаревшая карта сайта;

- низкокачественный сайт.

1.3. Когда стоит переиндексировать сайт?

Отправка запросов в панели веб-мастера на сканирование страниц не является обязательной, но может помочь ускорить посещение сайта роботом Google. Помните, что бот автоматически возвращается, чтобы получить актуальную информацию о его содержимом. Таким образом, запрос на индексирование можно повторить, но на практике это необязательно, потому что толком неизвестно, действительно ли это ускорит процесс. В общих рекомендациях, доступных в Справке Google, есть информация о том, что индексация занимает от пары дней до нескольких недель (в некоторых случаях даже месяцев), и отправка большого количества запросов на повторное сохранение одного и того же URL-адреса никак не ускорит ее.

2. Как ускорить индексацию страницы в Google?

2.1. Изменения на сайте и индексация.

Систематическое обновление сайта новым и полезным контентом может привести к тому, что роботы поисковых систем будут чаще его посещать, тем самым ускоряя индексацию. Это, конечно, только один метод, но очень важный с точки зрения поискового продвижения. Прежде чем мы узнаем, почему некоторые адреса сканируются быстрее, а другие замедляются, стоит изучить способы ускорения всего процесса.

2.2. Способы ускорения индексации страницы.

Вот несколько SEO-методов, которые помогут ускорить индексацию сайта:

- добавление ссылок на страницы с большим трафиком.

Чем больше ссылок связано с сайтом, тем выше вероятность того, что он будет проиндексирован. Также контент, который нужно быстро проиндексировать, должен быть связан с главной. Кроме того, чем ближе к ней находится важная страница, тем лучше. Теоретически, поисковая система должна сканировать ее быстрее. Вот почему стоит учитывать это при планировании структуры сайта. Чтобы ускорить этот процесс, стоит также разместить важные ссылки в своем блоге, социальных сетях, тематическом форуме или написать статью, содержащую ссылку;

Вот почему стоит учитывать это при планировании структуры сайта. Чтобы ускорить этот процесс, стоит также разместить важные ссылки в своем блоге, социальных сетях, тематическом форуме или написать статью, содержащую ссылку;

- использование карт XML и HTML.

Карта сайта поможет ускорить процесс индексации сайта, хотя в целом отсутствие файлов XML и HTML не помешает роботу сделать это и без них. Карта сайта — это перечень имеющихся подстраниц. Она минимизирует количество переходов бота по страницам, благодаря чему уменьшается время на их поиски;

- отправка запроса на индексацию страниц с помощью Google Search Console.

Внимание! Ускорение индексации — это не то же самое, что увеличение позиции сайта в результатах поиска. Индексация напрямую не влияет на нее, но сильно сказывается на самом продвижении. Непроиндексированный контент не будет включен в результаты поиска, но в то же время индексирование не означает, что позиции страницы будут высокими.

3. Быстрая индексация страниц в Google: сколько времени это займет?

3.1. Почему один адрес сканируется быстрее, чем другой?

Как обычно бывает с Google, когда дело доходит до индексации, эксперты компании ничего не объясняют напрямую. В 2018 году Джон Мюллер из Google подтвердил, что URL-адреса сохраняются в соответствии с различными факторами, и что поисковая система не сканирует URL-адреса с одинаковой частотой все время. Поэтому неудивительно, что некоторые сайты роботы будут посещать ежедневно, другие – каждую неделю, третьи — раз в несколько месяцев или даже через полгода.

Стоит подчеркнуть, что редкое сканирование сайта не означает, что с ним что-то не так с технической стороны. Период обработки в несколько месяцев вполне нормальный и естественный. В качестве примера следует добавить, что внесение значительных изменений на сайте приведет к тому, что часть страниц проиндексируется быстро. Остальным же придется какое-то время подождать. Почему так происходит? На это влияют многие факторы: перелинковка, структура страницы, частота изменений. Например, если сайт давно не обновлялся, поисковая система может не отправить к нему бота. Тем не менее, когда происходит обновление, это может занять какое-то время, но в конечном итоге робот Google обязательно посетит изменившуюся страницу.

Почему так происходит? На это влияют многие факторы: перелинковка, структура страницы, частота изменений. Например, если сайт давно не обновлялся, поисковая система может не отправить к нему бота. Тем не менее, когда происходит обновление, это может занять какое-то время, но в конечном итоге робот Google обязательно посетит изменившуюся страницу.

3.2. Как быстро поисковая система может проиндексировать страницу?

В большинстве случаев на это требуется несколько дней. Это может занять до 24 часов, хотя нельзя сказать, что это происходит на постоянной основе. Веб-мастера признают, что бывает и иначе: страница может появиться в индексе в тот же день, через неделю или даже месяц.

3.3. Сколько времени занимает индексация изменений на страницах?

На этот вопрос нет однозначного ответа. Google работает в определенном темпе, но известно, что, помимо частоты обновлений, он также учитывает и другие факторы. Чтобы поисковый робот посещал сайт чаще, его нужно регулярно обновлять. После внесенных изменений, например, удаление или добавление страниц, отправьте запрос на переобход через панель вебмастера. Можно также оставлять ссылки на новый контент в социальных сетях, блогах, тематических форумах.

После внесенных изменений, например, удаление или добавление страниц, отправьте запрос на переобход через панель вебмастера. Можно также оставлять ссылки на новый контент в социальных сетях, блогах, тематических форумах.

3.4. От индексации к ранжированию.

Без индексации вы не сможете получить высоких позиций в результатах поиска, потому что это необходимый шаг для включения сайта в индекс Google. Само индексирование иногда занимает несколько месяцев. После сохранения сайта в кеше Google нужно время, чтобы оценить изменения. На данный момент страница уже находится на каком-то уровне в рейтинге. Вы вносите изменения, чтобы улучшить рейтинг, и цикл начинается снова.

4. Медленная индексация страниц в Google.

4.1. Ожидание индексации: сколько времени это занимает, в чем причина?

4.1.1. Долгое ожидание индексации: последствия для сайта.

Время, необходимое для индексации, влияет на время продвижения в целом. Поднятие позиций или изменений в ранжировании можно наблюдать только после индексации страницы.

4.2. Медленная индексация новых страниц.

Для появления новой страницы в результатах поиска может потребоваться от 24 часов до нескольких месяцев. Это из-за того, что сайт новый, он не имеет входящих ссылок.

Ожидание в течение нескольких недель появления адреса в результатах поиска — естественный процесс. Как пользователи интернета, мы привыкли к мгновенному получению ответов на запросы, но с другой стороны, веб-мастера, это происходит не так быстро, как хотелось бы. Чтобы повысить вероятность быстрого сканирования страницы, выполните действия, описанные в разделе «Как ускорить индексацию страницы в Google?».

4.3. Медленная индексация измененных страниц.

Стоит понимать, что регулярное и частое обновление контента ускоряет индексацию и, следовательно, повышает шанс подняться в рейтинге поисковой системы. Чем чаще что-то происходит на сайте, тем больше вероятность того, что Google сочтет его активным и будет чаще отправлять свой сканер для анализа изменений.

КОМПЛЕКСНАЯ ОПТИМИЗАЦИЯ САЙТОВ

Комплексное продвижение и оптимизация сайта поможет вашему ресурсу встать в ТОП выдачи и привлечет на сайт целевую аудиторию и увеличить популярность бренда

>Стоимость от 15 000 грн.

Получить консультацию

Наш менеджер ответит на все ваши вопросы, а также найдет оптимальное решение вашей проблемы и посоветует услуги, наиболее подходящие вашим бизнес-целям

Все, что вам нужно знать

Сканирование и индексирование веб-сайтов — это первый шаг в сложном процессе понимания того, о чем веб-страницы, чтобы представить их в качестве ответов на запросы пользователей.

Поисковые системы постоянно совершенствуют методы сканирования и индексации веб-сайтов.

Понимание того, как Google и Bing подходят к задаче сканирования и индексации веб-сайтов, полезно при разработке стратегий улучшения видимости в поиске.

Как сегодня работают поисковые системы: индексирование

Давайте рассмотрим основные принципы работы поисковых систем.

Эта статья посвящена индексации. Итак, давайте углубимся в…

Индексирование

Индексирование — это то, с чего начинается процесс ранжирования после сканирования веб-сайта.

Индексирование, по сути, означает добавление содержимого веб-страницы в Google для рассмотрения при ранжировании.

Когда вы создаете новую страницу на своем сайте, ее можно проиндексировать несколькими способами.

Самый простой способ проиндексировать страницу — ничего не делать.

Поисковые роботы Google переходят по ссылкам, и, таким образом, при условии, что ваш сайт уже находится в индексе и что новый контент связан с вашим сайтом, Google в конечном итоге обнаружит его и добавит в свой индекс. Подробнее об этом позже.

Как ускорить индексацию страницы

Но что, если вы хотите, чтобы робот Googlebot быстрее попадал на вашу страницу?

Это может быть важно, если у вас своевременный контент или если вы внесли важное изменение на страницу, о которой нужно знать Google.

Я использую более быстрые методы, когда оптимизирую важную страницу или корректирую заголовок и/или описание, чтобы повысить число кликов. Я хочу конкретно знать, когда они были обнаружены и отображены в поисковой выдаче, чтобы знать, с чего начинается измерение улучшения.

В таких случаях можно использовать несколько дополнительных методов.

1. XML-карты сайта

XML-карты сайта — это самый старый и в целом надежный способ привлечь внимание поисковых систем к контенту.

XML-карта сайта предоставляет поисковым системам список всех страниц вашего сайта, а также дополнительную информацию о нем, например дату последнего изменения.

Карта сайта может быть отправлена в Bing через Bing Webmaster Tools, а также в Google через Search Console.

Однозначно рекомендуется!

Но когда вам нужна немедленная индексация страницы, это не особо надежно.

2. Запросить индексирование с помощью Google Search Console

В Search Console вы можете «Запросить индексирование».

Вы начинаете с нажатия на верхнее поле поиска, которое по умолчанию гласит: «Проверить и URL-адрес в домене.com».

Введите URL-адрес, который вы хотите проиндексировать, затем нажмите Enter.

Если страница уже известна Google, вам будет представлена куча информации о ней. Мы не будем вдаваться в это здесь, но я рекомендую войти в систему и посмотреть, что там, если вы еще этого не сделали.

Важная кнопка для наших целей здесь появляется независимо от того, была ли страница проиндексирована или нет — это означает, что она подходит для обнаружения контента или просто для запроса Google, чтобы понять недавнее изменение.

Вы найдете кнопку, как показано ниже.

Скриншот из Google Search Console, октябрь 2019 г.

В течение от нескольких секунд до нескольких минут вы можете выполнить поиск нового контента или URL-адреса в Google и найти измененный или новый контент.

3. Примите участие в Bing IndexNow

Bing использует открытый протокол, основанный на методе принудительного оповещения поисковых систем о новом или обновленном содержимом.

Этот новый протокол индексации поисковой системы называется IndexNow.

Он называется push-протоколом, потому что его идея состоит в том, чтобы предупреждать поисковые системы с помощью IndexNow о новом или обновленном контенте, который заставит их прийти и проиндексировать его.

Примером протокола извлечения является старый способ XML Sitemap, который зависит от сканера поисковой системы, который решает посетить и проиндексировать его (или получить его с помощью Search Console).

Преимущество IndexNow заключается в том, что он тратит меньше ресурсов веб-хостинга и центра обработки данных, что не только безвредно для окружающей среды, но и экономит ресурсы полосы пропускания.

Однако самым большим преимуществом является более быстрая индексация содержимого.

IndexNow в настоящее время используется только Bing и Яндекс.

Внедрить IndexNow очень просто:

- Существует плагин IndexNow для WordPress.

- Модуль Drupal IndexNow.

- IndexNow на Duda включен по умолчанию.

- IndexNow поддерживается Cloudflare.

- IndexNow поддерживается Akamai.

4. Инструменты Bing для веб-мастеров

Помимо участия в IndexNow рассмотрите возможность использования учетной записи Bing для веб-мастеров.

Если у вас нет учетной записи Bing Webmaster Tools, я не могу ее рекомендовать.

Предоставленная здесь информация является существенной и поможет вам лучше оценить проблемные области и улучшить свой рейтинг в Bing, Google и где-либо еще, а также, возможно, обеспечит лучший пользовательский опыт.

Но для того, чтобы ваш контент был проиндексирован, вам просто нужно щелкнуть: Настроить мой сайт > Отправить URL-адреса.

Оттуда вы вводите URL-адреса, которые хотите индексировать, и нажимаете «Отправить».

Скриншот из Bing Webmaster Tools, октябрь 2019 г.

Итак, это почти все, что вам нужно знать об индексировании и о том, как это делают поисковые системы (с прицелом на то, куда идут дела).

Дополнительные сведения см. на странице справки Инструментов для веб-мастеров Bing.

Существует также Bing Webmaster Tools Indexing API, который также может сократить время появления контента в результатах поиска Bing до нескольких часов. Подробнее об API индексирования Bing здесь.

Бюджет сканирования

Мы не можем говорить об индексации, не говоря о бюджете сканирования.

По сути, краулинговый бюджет — это термин, используемый для описания количества ресурсов, которые Google будет расходовать на сканирование веб-сайта.

Назначенный бюджет основан на сочетании факторов, двумя основными из которых являются:

- Насколько быстро работает ваш сервер (т.

- Насколько важен ваш сайт.

Если у вас крупный новостной сайт с постоянно обновляемым контентом, пользователи поисковых систем захотят знать, что ваш сайт будет часто сканироваться (осмелюсь сказать… постоянно).

Если вы управляете небольшой парикмахерской, имеете пару десятков ссылок и по праву не считаетесь важным в этом контексте (вы можете быть важным парикмахером в этом районе, но вы не важны, когда речь идет о краулинговом бюджете), тогда бюджет будет меньше.

Подробнее о краулинговых бюджетах и о том, как они определяются, можно прочитать в объяснении Google здесь.

У Google есть два вида сканирования

Индексирование Google начинается с сканирования, которое имеет два вида.

Первым видом сканирования является обнаружение, когда Google обнаруживает новые веб-страницы для добавления в индекс.

Второй вид сканирования — это обновление, когда Google находит изменения на уже проиндексированных веб-страницах.

Узнайте, как работают поисковые системы

Оптимизация веб-сайтов для поисковых систем начинается с хорошего контента и заканчивается его отправкой на индексацию.

Независимо от того, делаете ли вы это с помощью XML-карты сайта, инструмента отправки URL-адреса Google Search Console, инструментов Bing для веб-мастеров или IndexNow, индексация этого контента — это момент, когда ваша веб-страница начинает свой путь к вершине результатов поиска (если все работает !).

Вот почему важно понимать, как работает поисковая индексация.

Как работают поисковые системы рассматривает принципы работы поисковых систем и ключевые факторы, влияющие на страницы результатов поиска.

Загрузите его здесь.

Категория SEO

Основы работы индексации в поисковых системах

Поисковая оптимизация (SEO) — важный способ повысить видимость вашего веб-сайта и привлечь больше органического трафика. Однако это сложная стратегия, основанная на понимании алгоритмов и использовании широкого спектра факторов ранжирования. Если вы хотите стать экспертом в области SEO, вам необходимо понимать индексацию поисковыми системами.

В этом посте мы объясним, как поисковые системы индексируют веб-сайты и как вы можете повысить свой рейтинг. Мы также ответим на некоторые часто задаваемые вопросы об этой концепции SEO. Давайте начнем!

Что такое индексация поисковыми системами?

Индексация поисковой системой — это процесс, при котором поисковая система (например, Google) организует и сохраняет онлайн-контент в центральной базе данных (ее индекс). Затем поисковая система может анализировать и понимать контент и предоставлять его читателям в ранжированных списках на своих страницах результатов поисковой системы (SERP).

Затем поисковая система может анализировать и понимать контент и предоставлять его читателям в ранжированных списках на своих страницах результатов поисковой системы (SERP).

Перед индексацией веб-сайта поисковая система использует «сканеры» для изучения ссылок и контента. Затем поисковая система берет просканированный контент и упорядочивает его в своей базе данных:

.Источник изображения: Seobility – Лицензия: CC BY-SA 4.0

В следующем разделе мы подробно рассмотрим, как работает этот процесс. На данный момент индексирование можно рассматривать как онлайн-систему хранения записей и страниц веб-сайтов, видео, изображений и другого контента. Когда дело доходит до Google, эта система представляет собой огромную базу данных, известную как индекс Google.

Как поисковая система индексирует сайт?

Поисковые системы, такие как Google, используют «сканеры» для изучения онлайн-контента и его классификации. Эти сканеры представляют собой программные боты, которые переходят по ссылкам, сканируют веб-страницы и собирают как можно больше данных о веб-сайте. Затем они доставляют информацию на серверы поисковой системы для индексации:

Затем они доставляют информацию на серверы поисковой системы для индексации:

Источник изображения: Seobility – Лицензия: CC BY-SA 4.0

Каждый раз, когда контент публикуется или обновляется, поисковые системы сканируют и индексируют его, чтобы добавить информацию о нем в свои базы данных. Этот процесс может происходить автоматически, но вы можете ускорить его, отправив карты сайта в поисковые системы. Эти документы описывают инфраструктуру вашего веб-сайта, включая ссылки, чтобы помочь поисковым системам более эффективно сканировать и понимать ваш контент.

Сканеры поисковых систем работают на «краулинговом бюджете». Этот бюджет ограничивает количество страниц, которые боты будут сканировать и индексировать на вашем веб-сайте в течение установленного периода. (Однако они возвращаются.)

Сканеры собирают информацию о важных данных, таких как ключевые слова, даты публикации, изображения и видеофайлы. Поисковые системы также анализируют взаимосвязь между различными страницами и веб-сайтами, следуя и индексируя внутренние ссылки и внешние URL-адреса.

Обратите внимание, что сканеры поисковых систем не будут отслеживать все URL-адреса на веб-сайте. Они будут автоматически сканировать dofollow-ссылки, игнорируя их nofollow-эквиваленты. Поэтому вам нужно сосредоточиться на ссылках dofollow в своих усилиях по созданию ссылок. Это URL-адреса с внешних сайтов, которые указывают на ваш контент.

Если внешние ссылки исходят из высококачественных источников, они будут передавать свой «ссылочный вес», когда сканеры перейдут по ним с другого сайта на ваш. Таким образом, эти URL-адреса могут повысить ваш рейтинг в поисковой выдаче:

Источник изображения: Seobility – Лицензия: CC BY-SA 4.0

Кроме того, имейте в виду, что некоторый контент не сканируется поисковыми системами. Если ваши страницы скрыты за формами входа, паролями или в ваши изображения встроен текст, поисковые системы не смогут получить доступ и проиндексировать этот контент. (Однако вы можете использовать замещающий текст, чтобы эти изображения отображались в результатах поиска сами по себе. )

)

4 инструмента для индексации в поисковых системах

Вы можете использовать несколько инструментов, чтобы управлять тем, как Google и другие поисковые системы сканируют и индексируют ваш контент. Давайте рассмотрим несколько наиболее полезных вариантов!

1. Карты сайта

Имейте в виду, что существует два вида карт сайта: XML и HTML. Эти два понятия легко спутать, так как оба они являются типами карт сайта, которые заканчиваются на -ML , но они служат разным целям.

HTML-карты сайта — это удобные для пользователя файлы, в которых перечислены все материалы вашего веб-сайта. Например, вы обычно найдете одну из этих карт сайта в нижнем колонтитуле сайта. Прокрутите Apple.com до конца вниз, и вы найдете это, карту сайта в формате HTML:

Эта карта сайта позволяет посетителям легко перемещаться по вашему сайту. Он действует как общий каталог и может положительно повлиять на SEO и обеспечить надежный пользовательский опыт (UX).

Карта сайта XML, напротив, содержит список всех основных страниц вашего веб-сайта. Вы отправляете этот документ поисковым системам, чтобы они могли более эффективно сканировать и индексировать ваш контент:

Имейте в виду, что мы будем ссылаться на XML-документы, когда будем говорить о картах сайта в этой статье. Мы также рекомендуем ознакомиться с нашим руководством по созданию XML-карты сайта, чтобы у вас был готовый документ для различных поисковых систем.

2. Консоль поиска Google

Если вы хотите сосредоточить свои усилия по поисковой оптимизации на Google, консоль поиска Google является важным инструментом для освоения:

В консоли вы можете получить доступ к отчету об индексировании, в котором сообщается, какие страницы были проиндексированы Google, и выделяются любые проблемы в процессе. Здесь вы можете проанализировать проблемные URL-адреса и устранить неполадки, чтобы сделать их «индексируемыми».

Кроме того, вы можете отправить свою XML-карту сайта в Google Search Console. Этот документ действует как «дорожная карта» и помогает Google более эффективно индексировать ваш контент. Кроме того, вы можете попросить Google повторно просканировать определенные URL-адреса и части вашего сайта, чтобы обновленные темы всегда были доступны для вашей аудитории, не дожидаясь, пока поисковые роботы Google вернутся на ваш сайт.

Этот документ действует как «дорожная карта» и помогает Google более эффективно индексировать ваш контент. Кроме того, вы можете попросить Google повторно просканировать определенные URL-адреса и части вашего сайта, чтобы обновленные темы всегда были доступны для вашей аудитории, не дожидаясь, пока поисковые роботы Google вернутся на ваш сайт.

3. Альтернативные консоли поисковых систем

Хотя Google является самой популярной поисковой системой, это не единственный вариант. Ограничение себя Google может закрыть ваш сайт для трафика из альтернативных источников, таких как Bing:

Мы рекомендуем ознакомиться с нашими руководствами по отправке файлов Sitemap в формате XML в Инструменты для веб-мастеров Bing и Инструменты для веб-мастеров Яндекса. К сожалению, другие поисковые системы, в том числе Yahoo и DuckDuckGo, не позволяют отправлять карты сайта.

Имейте в виду, что каждая из этих консолей предлагает уникальные инструменты для мониторинга индексации и рейтинга вашего сайта в поисковой выдаче. Поэтому мы рекомендуем попробовать их, если вы хотите расширить свою SEO-стратегию.

Поэтому мы рекомендуем попробовать их, если вы хотите расширить свою SEO-стратегию.

4. Роботы.txt

Мы уже рассмотрели, как вы можете использовать карту сайта, чтобы указать поисковым системам индексировать определенные страницы на вашем веб-сайте. Кроме того, вы можете исключить определенный контент, используя файл robots.txt .

Файл robots.txt содержит информацию об индексации вашего сайта. Он хранится в корневом каталоге и состоит из двух строк: user-agent строка, указывающая поисковый робот, и директива disallow , которая блокирует определенные файлы.

Например, файл robots.txt может выглядеть примерно так:

Агент пользователя: * Запретить: /example_page/ Запретить: /example_page_2/

В этом примере * охватывает все сканеры поисковых систем. Затем строки disallow указывают определенные файлы или URL-адреса.

Вам просто нужно создать простой текстовый файл и назвать его robots. txt . Затем добавьте данные , запрещающие , и загрузите файл в корневой каталог с помощью клиента протокола передачи файлов (FTP).

txt . Затем добавьте данные , запрещающие , и загрузите файл в корневой каталог с помощью клиента протокола передачи файлов (FTP).

Часто задаваемые вопросы

До сих пор мы рассмотрели основы индексации поисковыми системами. Если у вас все еще есть вопросы об этой концепции SEO, мы ответим на них здесь! (И если он у вас все еще есть, дайте нам знать в комментариях, чтобы мы могли ответить на него там!)

Как улучшить индексацию поисковыми системами?

Вы можете улучшить индексацию поисковыми системами, создав карты сайта, проверив их на наличие ошибок сканирования и отправив их в несколько поисковых систем. Кроме того, вам следует подумать об оптимизации вашего контента для мобильных устройств и сокращении времени загрузки, чтобы ускорить сканирование и индексирование.

Частое обновление контента также может побудить поисковые системы сканировать и индексировать ваши «новые» страницы. Наконец, мы рекомендуем запретить поисковым системам сканировать повторяющийся контент, используя файл robots. txt или удалив его.

txt или удалив его.

Должен ли я запрашивать поисковые системы для сканирования моего сайта?

Поисковые системы будут сканировать новый общедоступный контент в Интернете, но этот процесс может занять недели или месяцы. Поэтому вы можете предпочесть ускорить процесс, отправив карту сайта в поисковые системы по вашему выбору.

Должен ли я предупреждать поисковые системы, если я публикую новый контент?

Мы рекомендуем обновлять карту сайта при публикации нового контента. Такой подход гарантирует, что ваши сообщения будут сканироваться и индексироваться быстрее. Мы рекомендуем использовать плагин, такой как Yoast SEO, чтобы легко создавать карты сайта.

Мой контент когда-либо удалялся из Google или других поисковых систем?

Google может удалить сообщение или страницу из своего индекса, если содержание нарушает условия обслуживания. Это означает, что контент во многих случаях нарушает конфиденциальность, клевету, авторские права или другие законы. Google также удаляет из своего индекса личные данные, такие как идентифицируемая финансовая или медицинская информация. Наконец, Google может наказывать страницы, использующие черные методы SEO.

Google также удаляет из своего индекса личные данные, такие как идентифицируемая финансовая или медицинская информация. Наконец, Google может наказывать страницы, использующие черные методы SEO.

Как я могу повторно проиндексировать свой контент, если он был удален?

Вы можете попросить Google переиндексировать ваш контент, изменив его в соответствии с рекомендациями поисковой системы по обеспечению качества для веб-мастеров. Затем вы можете отправить запрос на пересмотр и дождаться ответа Google.

Как запретить поисковым системам индексировать определенные страницы?

Вы можете запретить поисковым системам индексировать определенные страницы, добавив метатег noindex к странице 9раздел 0064. Кроме того, если ваш контент представляет собой медиафайл, вы можете добавить его в файл robots.txt . Наконец, Инструменты Google для веб-мастеров позволяют скрыть страницу с помощью инструмента «Удалить URL-адреса».

Заключение

SEO — это широкая область, которая охватывает все, от алгоритмов поисковых систем до методов внешней оптимизации.

bing.com/toolbox/webmaster/.

bing.com/toolbox/webmaster/. Они помогают определить отношение к сканированию контента в документе.

Они помогают определить отношение к сканированию контента в документе.