Поисковый алгоритм Яндекса «Палех»

«Палех» – новый поисковый алгоритм Яндекса

Эволюция поисковых интернет-машин за последние 16 лет проделала огромный путь. Начиная когда-то развитие с простого обнаружения слов, сегодня крупные поисковики пришли к алгоритму так называемого «умного поиска» при помощи нейронных сетей.

Не отстаёт от актуальных мировых трендов и российский Яндекс – в начале ноября 2016 года в корпоративном блоге интернет-компании появилась статья с анонсом запуска нового поискового алгоритма «Палех».

Что такое нейронные сети – краткий ликбез, понятный и гуманитарию

Само понятие нейронных сетей появилось ещё на заре тотальной компьютеризации и зарождения интернета, однако, актуализировалось только в последние годы. Название программистами было выбрано по аналогии с научным термином биологических нейронов, которые, как известно, организуют работу нервной системы человека (и в том числе головного мозга). Ключевая задача каждого нейрона заключается в организации электрохимического импульса, – с его помощью один нейрон осуществляет взаимосвязь со всеми другими нейронами.

Ключевая задача каждого нейрона заключается в организации электрохимического импульса, – с его помощью один нейрон осуществляет взаимосвязь со всеми другими нейронами.

И этот же принцип общего одновременного взаимодействия одной части поступающих запросов с другими частями большой сети лежит в основе работы компьютерных нейросетей.

Биология нейронных сетей в виде единого живого организма

К прорывной технологической особенности машинных нейронных сетей можно отнести их «умение» работать с образами. Привычная классика подхода к обработке информация заключается в последовательной (алгоритмической) обработке символов, тогда как нейронные сети способны уже параллельно друг другу распознавать образы.

В сфере поисковых систем под символами и образами понимаются те «слова», которые люди вбивают в строку браузеров. Символы отличаются от образов своей размерностью, – условный размер вторых может на несколько порядков превышать размер символов.

«Палех» – низкочастотный словесный хвост поискового трафика Яндекса

Наглядности схематичной работе современных компьютерных нейросетей могут добавить простые факты результативности работы: сегодня машины способны работать с изображениями, звуками, текстом и другими образчиками образного мышления (присущего, казалось бы, только человеку). Машину можно обучить различать на картинках любые объекты действительности: людей, машины, животных, еду и т. д.

Работа поискового алгоритма «Палех» настроена на различении смысла забиваемых в поисковик пользователями слов. Притом даже не простых, популярных в народе, а – сложных, многосоставных, неконкретных, имеющих очень далёкое отношение к тому, что человек пытается найти (то есть, по сути образных).

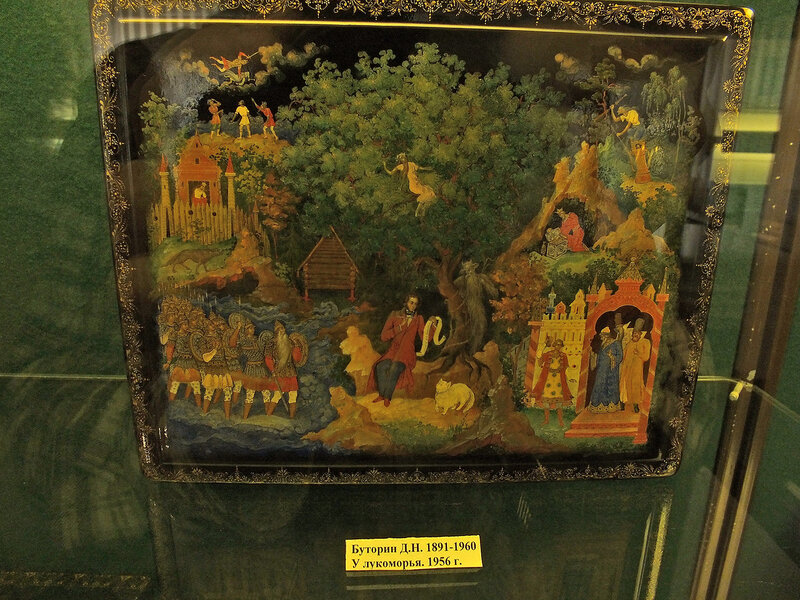

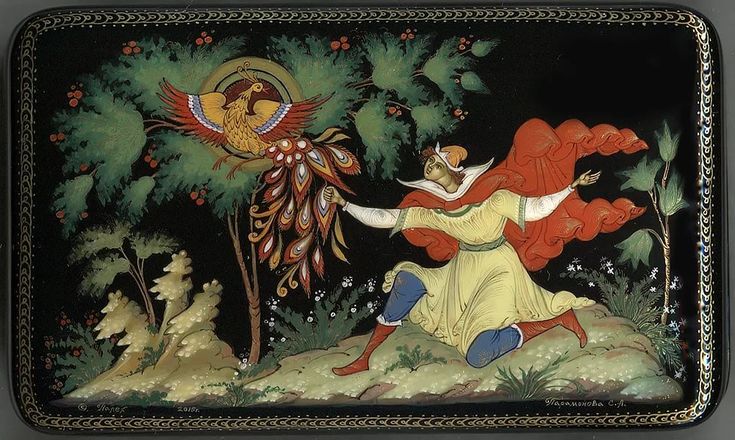

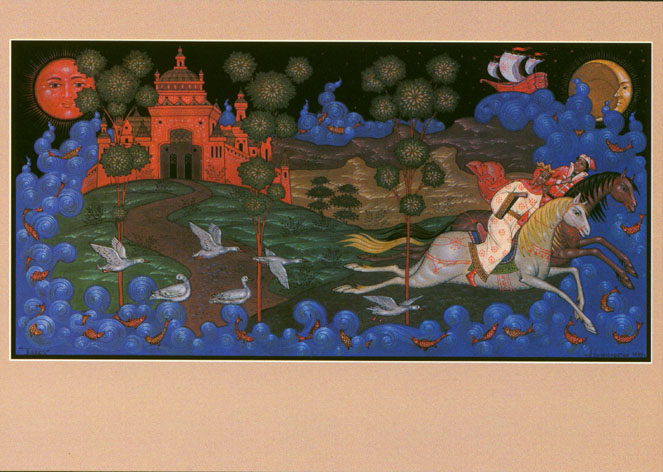

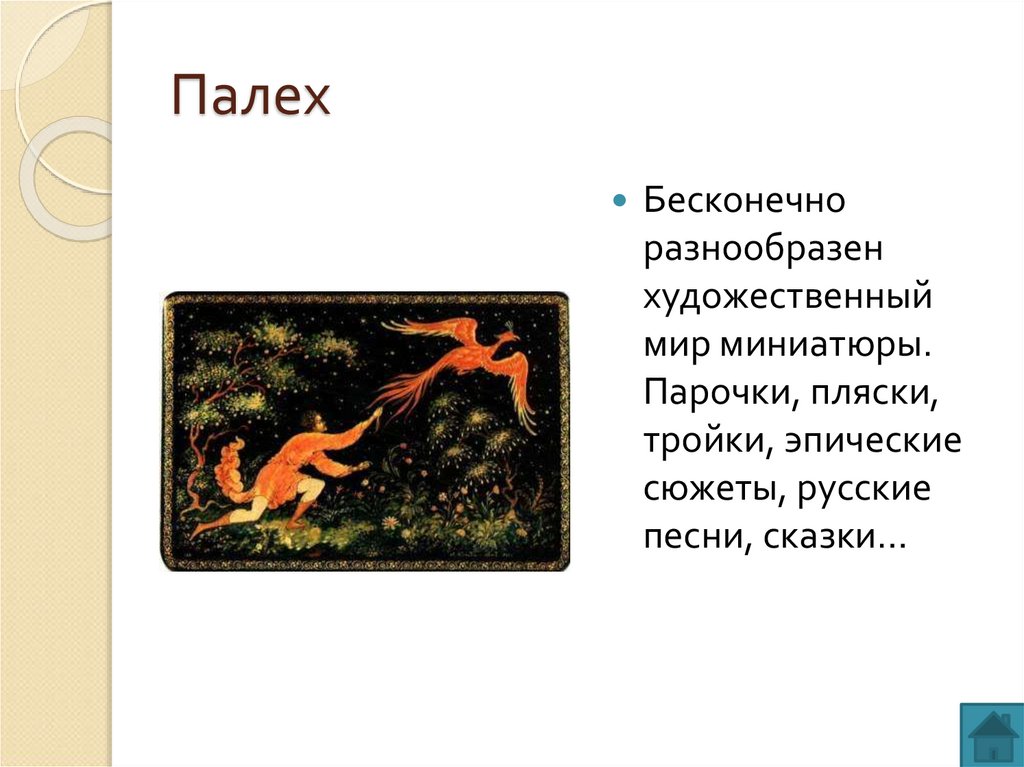

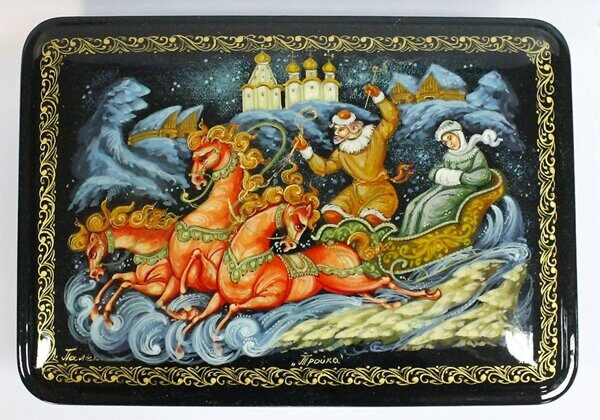

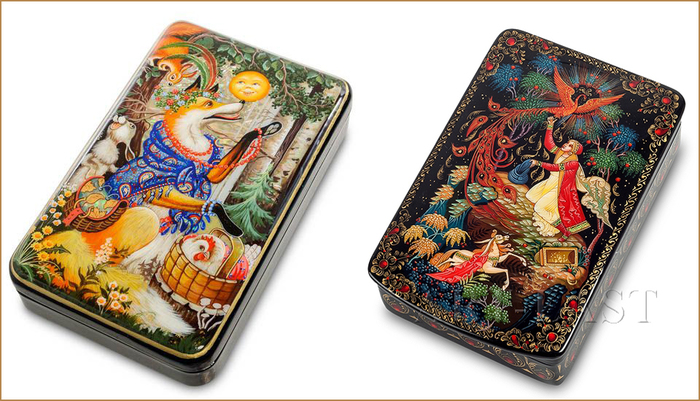

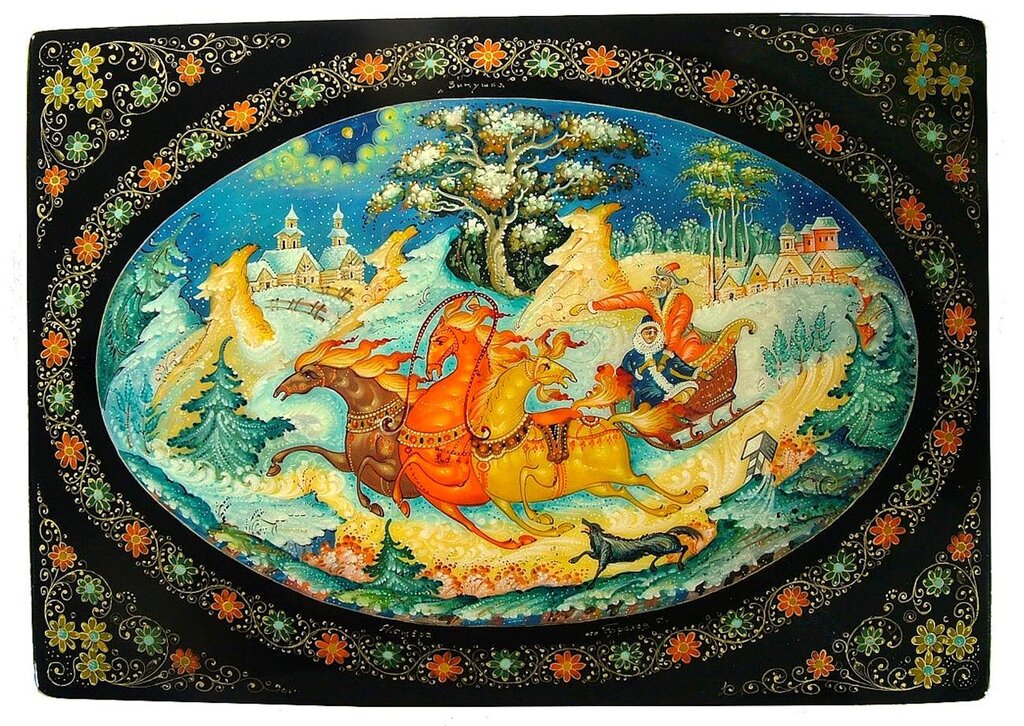

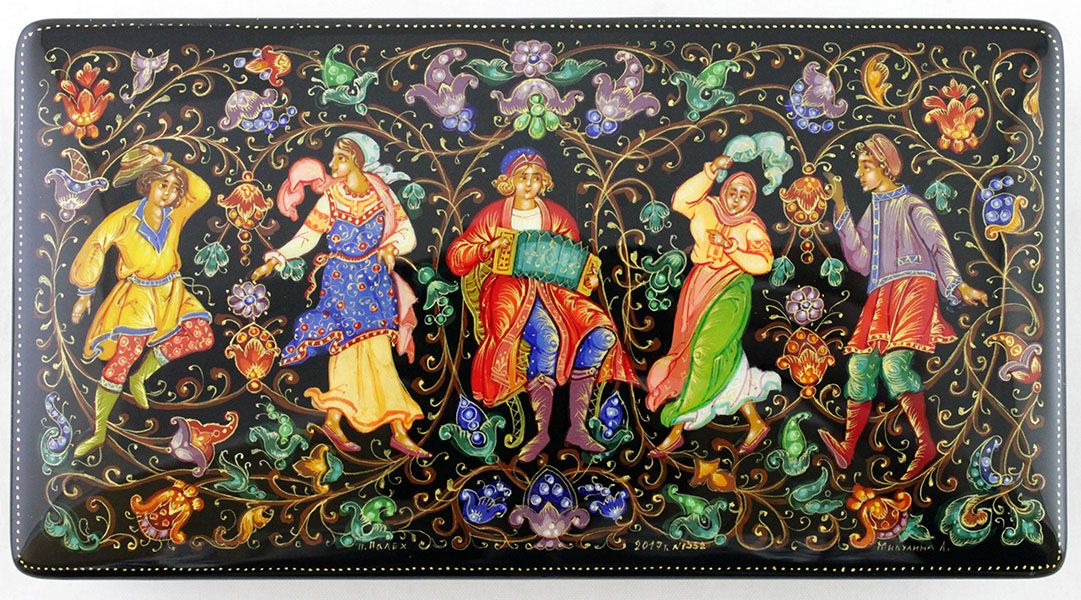

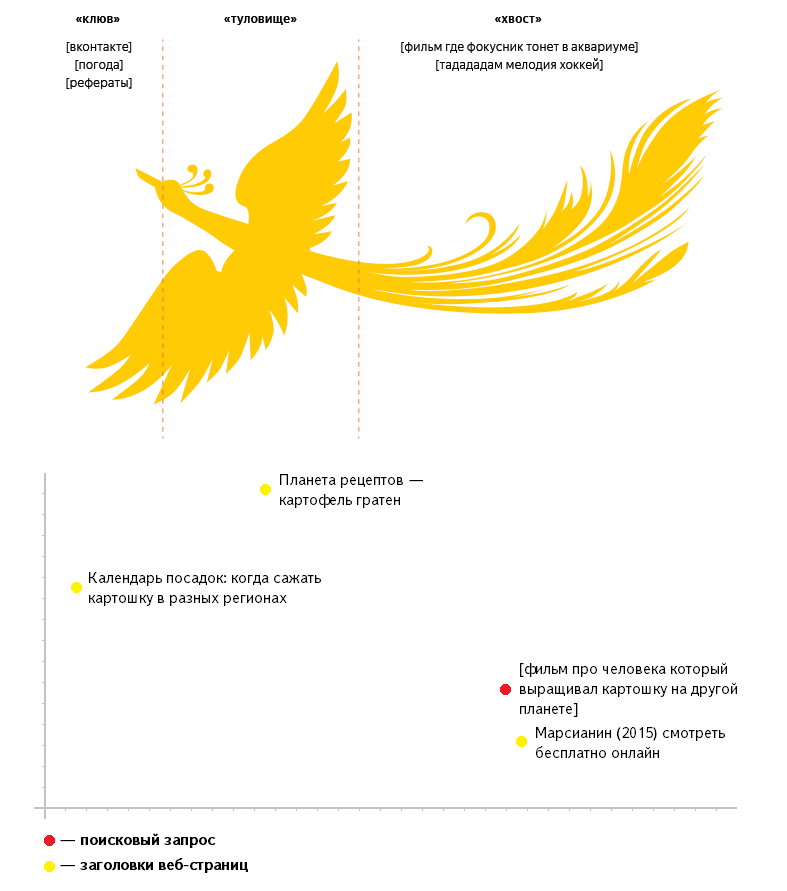

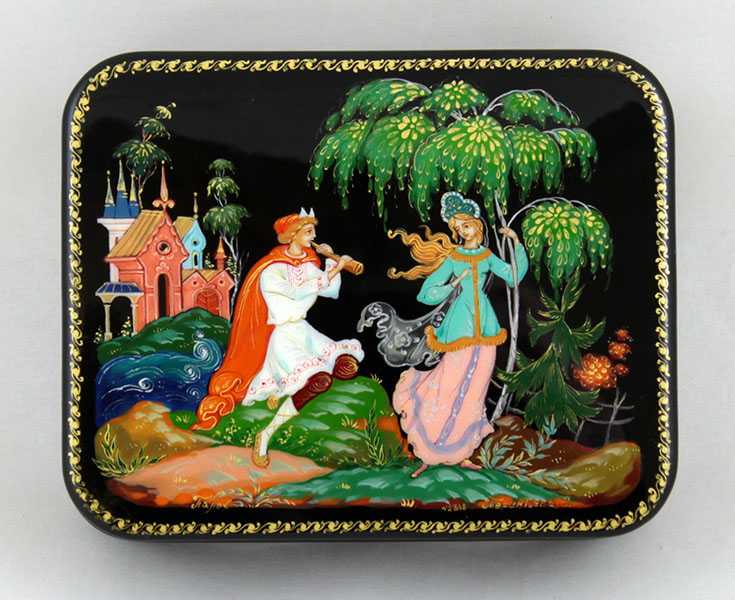

Почему, собственно, новый алгоритм называется «Палехом»? Разработчики Яндекса все пользовательские запросы разделили на три части, представив их в виде туловища мифологической Жар-птицы, частой героини, отображаемой на изделиях в стиле русского палехского ремесла.

Палехская Жар-птица – мифологическое существо, как символ поискового потока Яндекса

Примеры фантастических, ассоциативно-образных многочастотных запросов

Примеры многочастотных образных запросов в Рунете бывают поистине причудливыми, если не сказать даже фантастическими. Ищущие фильм «Бойцовский клуб» люди, например, могут вбить в поисковик следующее: «офисный клерк и его воображаемый друг фильм». Интересующиеся днём Благодарения, но забывшие название торжества люди обращаются за помощью с запросом «праздник с курицами в Америке».

Понятно, что такие длинные и сложные по семантике запросы машинная система Яндекса встречает гораздо реже, чем короткие, одночастотные из «клюва» условной Жар-птицы. Соответственно, и чётко работающего алгоритма для понимания того, что всё же нужно человеку в каждом конкретном случае нет. Задача нередко осложняется тем, что человеческое слово многозначно: в поисковой выдаче вообще может выпадать с десяток ссылок на источники не имеющие отношения к искомой информации.

В решении этой сложной проблемы понимания образного, ассоциативного мышления человека и участвует нейронные системы нового поискового алгоритма «Палех».

Суть работы «Палеха» – немного простейшей математики

Для представления того, как функционирует нейросети русскоязычного поисковика при обработке многочастотных запросов, нужно понимать, что они накапливают внутри себя необходимую статистику правильности/неправильности соответствия выдачи страниц тому, что ищут люди. Эта статистика основывается на поведенческом факторе пользователей: если в выдаче нет сайтов с нужной информации, – человек ни по одной странице просто не кликнет. Или, кликнув и поняв, что на том или ином сайте необходимая информация отсутствует, он её тут же, в течение двух-трёх секунд закроет.

Эта статистика основывается на поведенческом факторе пользователей: если в выдаче нет сайтов с нужной информации, – человек ни по одной странице просто не кликнет. Или, кликнув и поняв, что на том или ином сайте необходимая информация отсутствует, он её тут же, в течение двух-трёх секунд закроет.

Понятно, что количество удачных (или неудачных) соответствий запросов с веб-страницами миллиарды. Нейронная сеть «Палех» позволяет для внутреннего математического удобства переводить это количество соответствий в группы, состоящие из трёхсот чисел каждая. Способ обработки запросов с близкими им вероятными ответами в трёхсотмерной системе координат называется семантическим вектором.

Математика семантического вектора помогает человеку искать нужную информацию

Поисковая технология семантического вектора имеет в интернете огромный потенциал развития. Она позволяет, к примеру, работать, анализировать не только заголовки, но и сами тексты различных документов. Более того, в качестве семантического вектора можно представить всю совокупность сведений о пользователе в интернете – взятые со страничек соцсетей интересы, статистику предыдущих поисковых запросов и переходов по ссылкам, и это очень полезная информация не только для поисковиков, но и для маркетологов, веб-мастеров и других, связанных с интернет-бизнесом, людей.

Более того, в качестве семантического вектора можно представить всю совокупность сведений о пользователе в интернете – взятые со страничек соцсетей интересы, статистику предыдущих поисковых запросов и переходов по ссылкам, и это очень полезная информация не только для поисковиков, но и для маркетологов, веб-мастеров и других, связанных с интернет-бизнесом, людей.

Не исключено, что в перспективе алгоритмы нейронных поисковых систем по способу образного мышления, понимания запросов вплотную приблизятся к людям. И как знать, каким будет этот самый интернет в эпоху, когда поисковики будут понимать любого человека буквально с полуслова…

Алгоритм «Палех». Или нейронные сети на службе Яндекса – Блог ITC MEDIA

Компания Яндекс совершенствует поисковые механизмы, распознающие запросы пользователей и определяющие, какие сайты и статьи наиболее полно соответствуют поступившим запросам. И самое последнее изобретение — алгоритм «Палех», анализирующий не только ключевые слова из запросов и сайтов, но и смысловую нагрузку выбранных статей. В основе алгоритма — нейронные сети.

В основе алгоритма — нейронные сети.

«Хвост жар-птицы»

Ежедневно поисковые алгоритмы Яндекса дают ответы почти на 300 миллионов запросов. Многие запросы повторяются из минуты в минуту, другие являются уникальными. Уникальный запрос может никогда больше ни в этот день, ни в этом столетии не повториться. Но ежедневно Яндекс дает ответы на сто миллионов уникальных запросов.

График частотного распределения запросов любой поисковой системы, в частности, Яндекса, можно изобразить в виде птицы: есть клюв, шея, туловище и огромный хвост. Все наиболее часто встречающиеся запросы можно считать клювом. Подобных запросов (стандартных) много, но разнообразием они не отличаются. Запросы, менее популярные, но достаточно часто встречающиеся можно отнести к шее и туловищу птицы. А в хвосте «собираются» те запросы, которые имеют сравнительно низкую частоту. Но подобных запросов много, они могут отличаться деталями. И в итоге «хвост» образуется очень значительных размеров.

И разработка нового алгоритма позволит давать ответы на все самые сложные, экзотические вопросы вне зависимости от длины «хвоста». Почему алгоритм получил название «Палех»? Все очень просто. В российской сказочной культуре очень часто упоминается «жар-птица», имевшая дивный длинный хвост. А мастерицы Палеха на своих изделиях очень часто ее изображали во всей красе. И название появилось само собой.

Все запросы, составляющие хвост, достаточно разнообразны. Но и их можно определенным образом классифицировать и разделить на группы:

- запросы от детей или лиц, не имеющих опыта обращения с «поисковиками». В таких запросах можно встретить обращения к Яндексу, как к живому человеку, просьбы — «покажи, пожалуйста»;

- в отдельную группу можно выделить запросы, в которых пользователь четко не знает, что ему нужно, а может только приблизительно указать, что это было (например, американское кино про войны с империей). Можно выделить и другие типы запросов.

Запросы, составляющие «клюв» птицы однообразны. Они не представляют никакой сложности для поисковых роботов. И по таким запросам уже сформирована определенная статистика. Соответственно, при поступлении нового запроса из «клюва» нет необходимости опять пересматривать все необъятные просторы интернета. Ответ поступает в течение миллисекунд. Если же запрос относится к «хвосту», то никакой статистики подобных запросов у Яндекса нет и быть не может. И сложность заключается еще и в том, что запрос может быть сформулирован «коряво» или противоречиво. В такой ситуации определить, какие из найденных страниц будут релевантными запросу, очень непросто.

Но разработчики Яндекса полагают, что ни один из поступивших запросов не должен оставаться без ответа. И на помощь призваны нейронные сети, способствующие лучшему поиску.

Семантический вектор

Разработкой нейронных сетей или искусственного интеллекта и ученые, и программисты заинтересовались давно.

В случае с поиском ответа на запросы от пользователей Яндекса ситуация обстоит так же. Только вместо картинок нужно искать текст. Система так же обучается и использованием примеров, соответствующих и не соответствующих запросу. В данном случае обучение начинается с поиска соответствия между запросами пользователей и заголовками страниц, попавших в «поле зрения» поискового робота. И нейронная сеть накапливает определенный багаж знаний, позволяющих выделять нужное.

И нейронная сеть накапливает определенный багаж знаний, позволяющих выделять нужное.

Изначально, еще в те времена, когда компьютеры только появились, вся обрабатываемая информация для простоты переводилась в цифровое выражение. Каждому символу соответствовало некоторое двоичное выражение. И с того времени ничего не изменилось. По-прежнему, каждый набор знаков переводится в формат числа. И поисковые роботы в процессе поиска соответствий запросам от пользователей последовательно сравнивают коды запросов с кодами заголовков страниц. А для простоты поиска все заголовки страниц уже сгруппированы по триста единиц. И поисковое пространство Яндекса стало трехсот мерным.

И в получившейся трехсот мерной системе координат каждому веб-адресу соответствует определенная точка, к которой и обращается поисковая система при обработке запросов. Запрос пользователя в свою очередь так же переводится в числовое выражение и размещается в той же системе координат. И, если координаты запроса и веб-страницы совпали, то ответ на запрос пользователя найден. Если же координаты не совпали полностью, то есть все основания предполагать, что веб-страницы с максимально близкими координатами так же содержат ответы на запрос пользователя.

Если же координаты не совпали полностью, то есть все основания предполагать, что веб-страницы с максимально близкими координатами так же содержат ответы на запрос пользователя.

У разработчиков такой метод поиска ответов на заданные вопросы получил название «семантического вектора». И этот вариант обработки запросов, как никакой другой актуален, если нужно найти ответ на запрос, относящийся к «длинному хвосту». Метод позволяет быстро и качественно обрабатывать запросы, имеющие низкую частотность, по которым не сформирована статистика. Главное достоинство метода: он позволяет формировать ответы на те запросы, которые сформулированы нечетко, содержат только приблизительные данные.

Компания Яндекс перешла на использование «семантического вектора» в своих поисковых алгоритмах уже несколько месяцев назад. Нейронные модели за это время прошли сложное обучение, научились преобразовывать полученные запросы в цепочки цифр и анализировать их положение в пространстве.

Развитие на этом не останавливается

Поисковая система Яндекс — не единственная, основанная на использовании семантических векторов. По такому же принципу работают Картинки. Пользователь может задать текстовый запрос и получить в качестве ответа некоторое изображение.

В дальнейших планах перевод на поиск по семантическим векторам не только заголовков сайтов и страниц, но и полностью текстов документов. В идеальном варианте пользователь будет получать ответы, полностью соответствующие его запросам. В планах разработчиков — вывод компьютерных нейронных сетей на один уровень с человеческим мозгом. Это позволит «читать мысли» и организовывать поиск соответствий даже тем запросам, которые еще не введены в поисковую строку.

Поисковый алгоритм Яндекс «Палех»

2-го ноября 2016 года Яндекс анонсировал поисковый алгоритм «Палех», основанный на нейронных сетях.

Поиск Яндекс использует нейронные сети для того, чтобы находить документы не по словам, которые используются в запросе и в самом документе, а по смыслу запроса и заголовка.

Исследователи постоянно бьются над проблемой семантического поиска, в котором документы ранжируются, исходя из смыслового соответствия запросу. Поисковый алгоритм «Палех» – это реализация семантического поиска и важный шаг в будущее.

Искусственный интеллект или машинное обучение?

Почти все знают, что современные поисковые системы работают с помощью машинного обучения. Почему об использовании нейронных сетей для его задач надо говорить отдельно? И почему только сейчас?

Поиск в интернете — сложная система, которая появилась достаточно давно.

Сначала это был просто поиск страничек, потом он превратился в решателя задач, и сейчас становится полноценным помощником. Чем больше интернет, и чем больше в нём людей, тем выше их требования, тем сложнее приходится становиться поиску.

Эпоха наивного поиска

Сначала был просто поиск слов — инвертированный индекс. Потом страниц стало слишком много, их стало нужно ранжировать. Начали учитываться разные усложнения — частота слов, tf-idf.

Эпоха ссылок

Потом страниц стало слишком много на любую тему, произошёл важный прорыв — начали учитывать ссылки, появился PageRank.

Эпоха машинного обучения

Интернет стал коммерчески важным, и появилось много жуликов, пытающихся обмануть простые алгоритмы, существовавшие в то время. Произошёл второй важный прорыв — поисковики начали использовать свои знания о поведении пользователей, чтобы понимать, какие страницы хорошие, а какие — нет.

На этом этапе человеческого разума перестало хватать на то, чтобы придумывать, как ранжировать документы. Произошёл следующий переход — поисковики стали активно использовать машинное обучение.

Один из лучших алгоритмов машинного обучения изобрели в Яндексе — это Матрикснет.

Можно сказать, что ранжированию помогает коллективный разум пользователей и «мудрость толпы».

Информация о сайтах и поведении людей преобразуется во множество факторов, каждый из которых используется Матрикснетом для построения формулы ранжирования. Фактически, формулу ранжирования пишет машина (получалось около 300 мегабайт).

Фактически, формулу ранжирования пишет машина (получалось около 300 мегабайт).

Но у «классического» машинного обучения есть предел: оно работает только там, где очень много данных.

Небольшой пример. Миллионы пользователей вводят запрос [вконтакте], чтобы найти один и тот же сайт. В данном случае их поведение является настолько сильным сигналом, что поиск не заставляет людей смотреть на выдачу, а подсказывает адрес сразу при вводе запроса. Но люди сложнее, и хотят от поиска всё больше.

Сейчас уже до 40% всех запросов уникальны, то есть не повторяются хотя бы дважды – в течение всего периода наблюдений. Это значит, что у поиска нет данных о поведении пользователей в достаточном количестве, и Матрикснет лишается ценных факторов. Такие запросы в Яндексе называют «длинным хвостом», поскольку (все вместе) они составляют существенную долю обращений к поиску.

Эпоха искусственного интеллекта

Компьютеры становятся быстрее и данных становится больше, поэтому назрела необходимость использовать нейронные сети.

На основе технологий нейронных сетей основан машинный интеллект (или искусственный интеллект). Он основан потому, что нейронные сети построены по образу нейронов в нашем мозге и пытаются эмулировать работу некоторых его частей.

Машинный интеллект гораздо лучше старых методов справляется с задачами, которые могут делать люди: например, распознаванием речи или образов на изображениях.

Так каким образом это может помочь поиску?

Как правило, низкочастотные и уникальные запросы довольно сложны для поиска и найти качественный ответ по ним заметно труднее.

Как это сделать?

У Яндекс нет подсказок от пользователей (какой документ лучше, а какой — хуже), поэтому для решения поисковой задачи нужно научиться лучше понимать смысловое соответствие между двумя текстами: запросом и документом.

Итак, искусственные нейросети – это один из методов машинного обучения. Нейронные сети показывают впечатляющие результаты в области анализа естественной информации — звука и образов. Это происходит уже несколько лет. Но почему их до сих пор не так активно применяли в поиске? Простой ответ — потому что говорить о смысле намного сложнее, чем об образе на картинке, или о том, как превратить звуки в расшифрованные слова.

Это происходит уже несколько лет. Но почему их до сих пор не так активно применяли в поиске? Простой ответ — потому что говорить о смысле намного сложнее, чем об образе на картинке, или о том, как превратить звуки в расшифрованные слова.

Тем не менее, в поиске смыслов, искусственный интеллект действительно стал приходить из той области, где он уже давно является лидирующим — из поиска по картинкам.

Несколько слов о том, как это работает в поиске по картинкам.

Вы берёте изображение и с помощью нейронных сетей преобразуете его в вектор в N-мерном пространстве.

Берете запрос (который может быть как в текстовом виде, так и в виде другой картинки) и делаете с ним то же самое. А потом сравниваете эти векторы.

Чем ближе векторы друг к другу, тем больше картинка соответствует запросу и, соответственно, если это работает в картинках, почему не применить эту логику в web-поиске?

Таим образом можно сформулировать задачу.

В поиске Яндекс, на входе, есть запрос пользователя и заголовок страницы. Нужно понять, насколько они соответствует друг другу по смыслу.

Нужно понять, насколько они соответствует друг другу по смыслу.

Для этого необходимо представить текст запроса и текст заголовка в виде таких векторов, скалярное умножение которых было бы тем больше, чем релевантнее запросу документ с данным заголовком. Иначе говоря, мы хотим обучить нейронную сеть так, чтобы для близких по смыслу текстов она генерировала похожие векторы, а для семантически-несвязанных запросов и заголовков векторы должны отличаться.

Сложность этой задачи заключается в подборе правильной архитектуры и метода обучения нейронной сети.

Из научных публикаций известно довольно много подходов к решению проблемы. Вероятно, самым простым методом здесь является представление текстов в виде векторов с помощью алгоритма word2vec (к сожалению, практический опыт говорит о том, что для рассматриваемой задачи это довольно неудачное решение).

Что пробовали в Яндекс, как добились успеха и как смогли обучить то, что получилось.

DSSM

В 2013 году исследователи из Microsoft Research описали свой подход, который получил название Deep Structured Semantic Model.

На вход модели подаются тексты запросов и заголовков. Для уменьшения размеров модели, над ними производится операция, которую авторы называют word hashing. К тексту добавляются маркеры начала и конца, после чего он разбивается на буквенные триграммы. Например, для запроса [палех] мы получим триграммы [па, але, лех, ех].

Поскольку количество разных триграмм ограничено, то мы можем представить текст запроса в виде вектора размером в несколько десятков тысяч элементов (размер нашего алфавита в 3 степени). Соответствующие триграммам запроса элементы вектора будут равны 1, остальные — 0.

По сути, мы отмечаем вхождение триграмм из текста в словарь, состоящий из всех известных триграмм.

Если сравнить такие векторы, то можно узнать только о наличии одинаковых триграмм в запросе и заголовке, что не представляет особого интереса. Поэтому теперь их надо преобразовать в другие векторы, которые уже будут иметь нужные нам свойства семантической близости.

После входного слоя, расположено несколько скрытых слоёв как для запроса, так и для заголовка.

Последний слой размером в 128 элементов и служит вектором, который используется для сравнения.

Выходом модели является результат скалярного умножения последних векторов заголовка и запроса (если быть совсем точным, то вычисляется косинус угла между векторами).

Модель обучается таким образом, чтобы для положительны обучающих примеров выходное значение было большим, а для отрицательных — маленьким. Иначе говоря, сравнивая векторы последнего слоя, мы можем вычислить ошибку предсказания и модифицировать модель таким образом, чтобы ошибка уменьшилась.

В Яндекс тоже активно исследуются модели на основе искусственных нейронных сетей, поэтому заинтересовались моделью DSSM.

Характерное свойство алгоритмов, описываемых в научной литературе, состоит в том, что они не всегда работают «из коробки». «Академический» исследователь и исследователь из индустрии находятся в существенно разных условиях.

В качестве отправной точки (baseline), с которой автор научной публикации сравнивает своё решение, должен выступать какой-то общеизвестный алгоритм — так обеспечивается воспроизводимость результатов.

Исследователи берут результаты ранее опубликованного подхода, и показывают, как их можно превзойти. Например, авторы оригинального DSSM сравнивают свою модель по метрике NDCG с алгоритмами BM25 и LSA.

В случае с прикладным исследователем, который занимается качеством поиска в реальной поисковой машине, отправной точкой служит не один конкретный алгоритм, а всё ранжирование в целом.

Цель разработчика Яндекс состоит не в том, чтобы обогнать BM25, а в том, чтобы добиться улучшения на фоне всего множества ранее внедренных факторов и моделей. Таким образом, baseline для исследователя в Яндекс чрезвычайно высок, и многие алгоритмы, обладающие научной новизной и показывающие хорошие результаты при «академическом» подходе, оказываются бесполезными на практике, поскольку не позволяют реально улучшить качество поиска.

В случае с DSSM в Яндекс столкнулись с этой же проблемой. В практических экспериментальных условиях точная реализация модели из статьи показала скромные результаты. Потребовался ряд существенных «доработок напильником», прежде чем в Яндекс смогли получить результаты, интересные с практической точки зрения.

Потребовался ряд существенных «доработок напильником», прежде чем в Яндекс смогли получить результаты, интересные с практической точки зрения.

Об основных модификациях оригинальной модели, чтобы сделать её более мощной.

В оригинальной модели DSSM входной слой представляет собой множество буквенных триграмм. Его размер равен 30000.

У подхода на основе триграмм есть несколько преимуществ:

во-первых, их относительно мало, поэтому работа с ними не требует больших ресурсов;

во-вторых, их применение упрощает выявление опечаток и ошибок в словах.

Однако, эксперименты показали, что представление текстов в виде «мешка» триграмм заметно снижает выразительную силу сети, поэтому в Яндекс радикально увеличили размер входного слоя, включив в него, помимо буквенных триграмм, ещё около 2 миллионов слов и словосочетаний. Таким образом, в Яндекс представляют тексты запроса и заголовка в виде совместного «мешка» слов, словесных биграмм и буквенных триграмм, а использование большого входного слоя приводит к увеличению размеров модели, длительности обучения и требует существенно больших вычислительных ресурсов.

Как нейронная сеть боролась сама с собой и научилась на своих ошибках

Обучение исходного DSSM состоит в демонстрации сети большого количества положительных и отрицательных примеров. Эти примеры берутся из поисковой выдачи (судя по всему, для этого использовался поисковик Bing).

Положительными примерами служат заголовки кликнутых документов выдачи, отрицательными — заголовки документов, по которым не было клика.

У этого подхода есть определённые недостатки. Например, отсутствие клика далеко не всегда свидетельствует о том, что документ нерелевантен. Справедливо и обратное утверждение — наличие клика не гарантирует релевантности документа.

По сути, обучаясь описанным в исходной статье образом, алгоритм стремится предсказывать аттрактивность заголовков при условии того, что они будут присутствовать в выдаче. Это, конечно, неплохо, но имеет достаточно косвенное отношение к главной цели — научиться понимать семантическую близость.

Во время экспериментов в Яндекс обнаружили, что результат можно заметно улучшить, если использовать другую стратегию выбора отрицательных примеров.

Для достижения цели хорошими отрицательными примерами являются такие документы, которые гарантированно нерелевантны запросу, но при этом помогают нейронной сети лучше понимать смыслы слов. Откуда их взять?

Сначала, в качестве отрицательного примера, возьмём заголовок случайного документа. Например, для запроса [палехская роспись] случайным заголовком может быть «Правила дорожного движения 2016 РФ».

Разумеется, полностью исключить то, что случайно выбранный из миллиардов документ будет релевантен запросу, нельзя, но вероятность этого настолько мала, что ей можно пренебречь. Таким образом мы можем очень легко получать большое количество отрицательных примеров.

Казалось бы, теперь мы можем научить сеть тому, чему хочется отличать хорошие документы, которые интересуют пользователей, от документов, не имеющих к запросу никакого отношения.

К сожалению, обученная на таких примерах модель оказалась довольно слабой. Нейронная сеть – штука умная, и всегда найдет способ упростить себе работу. В данном случае, она просто начала выискивать одинаковые слова в запросах и заголовках: есть — хорошая пара, нет — плохая. Но это Яндекс и сам умеет делать. Важно – чтобы сеть научилась различать неочевидные закономерности.

В данном случае, она просто начала выискивать одинаковые слова в запросах и заголовках: есть — хорошая пара, нет — плохая. Но это Яндекс и сам умеет делать. Важно – чтобы сеть научилась различать неочевидные закономерности.

Следующий эксперимент состоял в том, чтобы добавлять в заголовки отрицательных примеров слова из запроса. Например, для запроса [палехская роспись] случайный заголовок выглядел как [Правила дорожного движения 2016 РФ роспись]. Нейронной сети пришлось чуть сложнее, но, тем не менее, она довольно быстро научилась хорошо отличать естественные пары от составленных вручную. Стало понятно, что такими методами мы успеха не добьемся.

Многие очевидные решения становятся очевидны только после их обнаружения. Так получилось спустя некоторое время и обнаружилось, что лучший способ генерации отрицательных примеров — это заставить сеть «воевать» против самой себя – учиться на собственных ошибках.

Среди сотен случайных заголовков в Яндекс выбирали такой, который текущая нейросеть считала наилучшим. Но, так как этот заголовок всё равно случайный, с высокой вероятностью он не соответствует запросу. И именно такие заголовки экспериментаторы стали использовать в качестве отрицательных примеров.

Но, так как этот заголовок всё равно случайный, с высокой вероятностью он не соответствует запросу. И именно такие заголовки экспериментаторы стали использовать в качестве отрицательных примеров.

Другими словами, можно показать сети лучшие из случайных заголовков, обучить её, найти новые лучшие случайные заголовки, снова показать сети и так далее.

Раз за разом повторяя данную процедуру, экспериментаторы видели, как заметно улучшается качество модели, и всё чаще лучшие из случайных пар становились похожи на настоящие положительные примеры. И в итоге – проблема была решена.

Подобная схема обучения в научной литературе обычно называется hard negative mining.

Следует также отметить, что, схожие по идее, решения получили широкое распространение в научном сообществе для генерации реалистично выглядящих изображений, подобный класс моделей получил название Generative Adversarial Networks.

В качестве положительных примеров исследователи из Microsoft Research использовались клики по документам. Однако, как уже было сказано, это достаточно ненадежный сигнал о смысловом соответствии заголовка запросу.

Однако, как уже было сказано, это достаточно ненадежный сигнал о смысловом соответствии заголовка запросу.

В конце концов, задача состоит не в том, чтобы поднять в поисковой выдаче самые посещаемые сайты, а в том, чтобы найти действительно полезную информацию. Поэтому в Яндекс пробовали, в качестве цели обучения, использовать другие характеристики поведения пользователя. Например, одна из моделей предсказывала, останется ли пользователь на сайте или уйдет. Другая – насколько долго он задержится на сайте.

Как оказалось, можно заметно улучшить результаты, если оптимизировать такую целевую метрику, которая свидетельствует о том, что пользователь нашёл то, что ему было нужно.

Так что нам дает это на практике?

Если сравнить поведение нейронной модели Яндекс и простого текстового фактора, основанного на соответствии слов запроса и текста — это алгоритм BM25, который удобно использовать – как базовый уровень.

В качестве примера возьмем запрос [келлская книга] и посмотрим, какое значение принимают факторы на разных заголовках. Для контроля добавим в список заголовков явно нерелевантный результат.

Для контроля добавим в список заголовков явно нерелевантный результат.

Все факторы в Яндекс нормируются в интервал [0;1]. Ожидается, что BM25 имеет высокие значения для заголовков, которые содержат слова запроса. И предсказуемо, что этот фактор получает нулевое значение на заголовках, не имеющих общих слов с запросом.

Если обратить внимание на то, как ведет себя нейронная модель, то она одинаково хорошо распознаёт связь запроса как с русскоязычным заголовком релевантной страницы из Википедии, так и с заголовком статьи на английском языке! Кроме того, кажется, что модель «увидела» связь запроса с заголовком, в котором не упоминается келлская книга, но есть близкое по смыслу словосочетание («ирландские евангелия»). Значение же модели для нерелевантного заголовка существенно ниже.

Если посмотреть, как будут себя вести наши факторы, если переформулировать запрос, не меняя его смысла: [евангелие из келлса], то для BM25 переформулировка запроса превратилась в настоящую катастрофу — фактор стал нулевым на релевантных заголовках, а модель Яндекс демонстрирует отличную устойчивость к переформулировке: релевантные заголовки по-прежнему имеют высокое значение фактора, а нерелевантный заголовок — низкое. Кажется, что именно такое поведение мы и ожидали от штуки, которая претендует на способность «понимать» семантику текста.

Кажется, что именно такое поведение мы и ожидали от штуки, которая претендует на способность «понимать» семантику текста.

Итак, нейронная модель оказалась способна высоко оценить заголовок с правильным ответом, несмотря на полное отсутствие общих слов с запросом. Более того, стало очевидным то, что заголовки, не отвечающие на запрос, но всё же связанные с ним по смыслу, получают достаточно высокое значение фактора (как будто модель Яндекс «прочитала» рассказ Брэдбери и «знает», что это именно о нём идёт речь в запросе).

И что дальше?

Специалисты Яндекс находятся в самом начале интересного пути. Судя по всему, нейронные сети имеют отличный потенциал для улучшения ранжирования. Уже понятны основные направления, которые нуждаются в активном развитии. Например, очевидно, что заголовок содержит неполную информацию о документе, и хорошо бы научиться строить модель по полному тексту (как оказалось, это не совсем тривиальная задача).

Далее, можно представить себе модели, имеющие существенно более сложную архитектуру, нежели DSSM и есть основания предполагать, что таким образом Яндекс сможет лучше обрабатывать некоторые конструкции естественных языков.

Долгосрочную цель специалисты Яндекс видят в создании моделей, способных «понимать» семантическое соответствие запросов и документов на уровне, сравнимом с уровнем человека.

Статья основана на материалах Яндекс о том, как работает новый поисковый алгоритм «Палех»

Как алгоритм «Палех» работает с поисковыми подсказками

11799 2

| SEO | – Читать 4 минуты |

Прочитать позже

Игорь Горбенко

Эксперт по диджитал-маркетингу в Serpstat

Яндекс запустил новый поисковый алгоритм «Палех». С его помощью поисковик лучше понимает пользователя и находит страницы, которые соответствуют его запросам по смыслу, а не по словам.

Я решил узнать, как спустя неделю работает обновленный поиск Яндекса, а именно, как он ведет себя с поисковыми подсказками. Начну с самого начала.

Почему «Палех» и на чем строится новый алгоритм?

Новый алгоритм основан на нейронных сетях и помогает Яндексу находить соответствие между поисковым запросом и заголовками страниц, даже если у них нет общих ключевых фраз.

Например, при вводе в поиск «фильм про Джека-воробья» поисковик покажет несколько страниц с названием исходного фильма «Пираты Карибского моря»:

Казалось бы, у словосочетаний «Фильм про Джека-Воробья» и «Пираты Карибского моря» лексически мало общего, зато по смыслу связь очевидна. И Яндекс это хорошо теперь понимает.

«Палех» создан чтобы эффективнее работать с LSI. Для тех, кто забыл, что такое латентно-семантическое индексирование, ловите простое объяснение Алексея Чекушина 😉

Простые же смертные используют следующее определение латентное семантического индексирования:

LSI предполагает, что поисковый робот выделяет из текста не отдельные фразы, которые часто встречаются среди вводимых в поисковую строку, а выбирает тематику страницы на основании целого комплекса используемых на ней слов, включая словоформы, синонимы и близкотематические фразы. Вот так просто.

LSI-ключи учитываются поисковиком и тогда, когда нет достаточной статистики, чтобы предоставить более очевидные (на первый взгляд) результаты. Особенно, это касается редких низкочастотных фраз, по-настоящему уникальных.

В Яндексе график частотного распределения представляют в виде жар-птицы, у которых есть клюв, туловище и длинный хвост:

- Клюв — самые высокочастотные запросы. Список таких запросов не очень большой, но их задают очень-очень часто.

- Туловище — среднечастотные запросы.

- Хвост — низкочастотные и микронизкочастотные запросы. «По отдельности они встречаются редко, но вместе составляют существенную часть поискового потока и поэтому складываются в длинный хвост».

Такой хвост принадлежит Жар-птице, которая часто появляется на палехской миниатюре. Именно поэтому алгоритм получил название «Палех».

Как дела обстоят с поисковыми подсказками?

Выходит, что теперь с запуском нового алгоритма в Яндексе будет проще продвигаться по фразе, используя ее описательный анализ. Но где брать такие фразы, и как узнать, работают ли они?

Но где брать такие фразы, и как узнать, работают ли они?

Один из выходов — поисковые подсказки. Подсказки у Яндекса существуют уже давно. Это варианты наиболее популярных запросов, которые начинаются с той же буквы, что и вводимый запрос. Они появляются в специальном блоке под поисковой строкой и обновляются по мере набора новых символов в строке.

Подсказки — это своеобразные рекомендации поисковика, его предположения о том, что в действительности пытается найти пользователь. Если хотите продвинуть сайт по низкочастотным ключам, то можете использовать поисковые подсказки.

У нас, в Serpstat можно получить поисковые подсказки бесплатно (!), чтобы найти дополнительные LSI-фразы по интересующей теме. Они подгружаются в реальном времени.

Просто введите свой ключевик в поиск сервиса, выберите регион (в нашем случае, Яндекс) и перейдите в подраздел «SEO-анализ» → «Поисковые подсказки».

Используя подсказки, вы найдете связь между ключом и соответствующим ему LSI-ключем, и тем самым узнаете, как продвинуть этот ключ.

Заключение

Вспомним ключевые моменты этой статьи:

Новый алгоритм Яндекса «Палех» основан на нейронных сетях и помогает поисковику находить соответствие между поисковым запросом и заголовками страниц, даже если у них нет общих ключевых фраз.

LSI-ключи используются для ответов к редким низкочастотным фразам, по-настоящему уникальных.

«Палех» дает возможность продвигаться по ключевым фразам, используя их описательные аналоги.

Такие аналоги можно поискать в поисковых подсказках.

Оцените статью по 5-бальной шкале

5 из 5 на основе 1 оценок

Нашли ошибку? Выделите её и нажмите Ctrl + Enter, чтобы сообщить нам.

Рекомендуемые статьи

Обновления Serpstat +1

Анастасия Сотула

«Видимость» сайта в Serpstat: что это и как считается?

SEO

Author

Как с помощью Google карт попасть в топ поиска: подробное руководство

SEO +2

Игорь Мутерко

Как Serpstat помогает SEO- и PPC-менеджеру

Кейсы, лайфхаки, исследования и полезные статьи

Не успеваешь следить за новостями? Не беда! Наш любимый редактор подберет материалы, которые точно помогут в работе. Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Только полезные статьи, реальные кейсы и новости Serpstat раз в неделю. Присоединяйся к уютному комьюнити 🙂

Нажимая кнопку, ты соглашаешься с нашей политикой конфиденциальности.

Поделитесь статьей с вашими друзьями

Вы уверены?

Спасибо, мы сохранили ваши новые настройки рассылок.

Сообщить об ошибке

Отменить

Палех Яндекс: особенности нового алгоритма

Друзья, я рада приветствовать вас на Blog-Bridge.ru. Вы, наверное, уже слышали новость о новом алгоритме Палех? Яндекс как поисковая система постоянно совершенствует свои алгоритмы обработки информации.

Вот и в этом году он анонсировал запуск нового алгоритма с креативным названием «Палех».

Я буквально недавно узнала эту новость и сразу обратила на это внимание. Думаю, что многие блогеры и веб-мастера тоже заинтересовались данной информацией.

Кроме того, мы ведь не так давно запустили новый эксперимент и я теперь полностью погружена в его реализацию.

Эксперимент «Комплексное продвижение блога». В ходе данного эксперимента вы узнаете: какими методами мы будем продвигать блог, какие из них окажутся эффективными и какие результаты они принесут; какой прирост посещаемости будет у нас ежемесячно; какими способами мы будем набирать подписную базу; как будут задействованы социальный сети; какими сервисами мы будем пользоваться для выполнения поставленных задач; и многое другое.

В ходе данного эксперимента вы узнаете: какими методами мы будем продвигать блог, какие из них окажутся эффективными и какие результаты они принесут; какой прирост посещаемости будет у нас ежемесячно; какими способами мы будем набирать подписную базу; как будут задействованы социальный сети; какими сервисами мы будем пользоваться для выполнения поставленных задач; и многое другое.

Ведь что мы сейчас наблюдаем в Сети? Сайтов, блогов и веб-порталов становится всё больше и больше, и вот чтобы давать максимально точные ответы на запросы пользователей, Яндекс начал использовать нестандартные подходы в обучении своих поисковых роботов.

Цель создания нового поискового алгоритма – улучшить качество предоставляемых ответов в выдаче для пользователей. Предыдущие поисковые модели подбирали информацию по соответствию ключевым словам. Новая модель на основе нейронных сетей умеет подбирать информацию по смыслу. Представляете? И это не фантастика!

Ещё одна интересная разработка нового метода поиска «Палех» — распознавание изображений. Поисковые роботы смогут различать образы на картинках – например, деревья или дома. И это тоже не фантастика 🙂

Поисковые роботы смогут различать образы на картинках – например, деревья или дома. И это тоже не фантастика 🙂

Итак, друзья, если вам хочется узнать побольше про этот подход и познакомиться с Жар-птицей Яндекса поближе, то приглашаю к прочтению

Содержание статьи:

- 1 Как соотносятся запросы с образом Жар-Птицы

- 2 Как используются нейронные сети в алгоритме «Палех» Яндекс

- 3 Как информация обрабатывается в трёхсотмерном пространстве

- 4 Перспективы развития семантического вектора

Как соотносятся запросы с образом Жар-Птицы

Наверняка, первый вопрос, который возникает, после прочтения названия алгоритма: «А почему собственно Палех?» Кстати, я подумала об этом в первую очередь. Есть еще среди моих читателей такие индивиды?

Название алгоритма у Яндекса «Палех» напрямую связано с палехской живописью. Ведь если вспомнить, то именно на росписях знаменитых художников часто использовался образ Жар-птицы. Я даже помню на уроках ИЗО пыталась нарисовать что-то из этого художественного жанра.

Но вернемся к теме нашей статьи.

Яндекс разделяет все поисковые запросы на три большие группы, которые соответствуют клюву, туловищу и длинному хвосту Жар-птицы.

- Первая группа – это высокочастотные запросы. Люди запрашивают ответы на них ежесекундно. О чем это могут быть запросы? Это новости, погода, такие распространённые вопросы «Как сбить температуру?» и тому подобные. Сам список высокочастотных запросов не велик – поэтому они составляют клюв Жар-птицы.

- Вторая группа — среднечастотные запросы. Их список значительно шире, поэтому они составляют туловище птицы.

- Третья группа – низкочастотные запросы. Это очень редкие и своеобразные запросы, многие из которых задаются единожды в истории поиска. Если все эти уникальные запросы сложить вместе, получится гигантская цифра: 100 млн. запросов ежедневно. Вы только вдумайтесь в эту цифру! Именно поэтому низкочастотные запросы составляют пышный и длинный хвост Жар-птицы.

Алгоритм «Палех» призван находить релевантные ответы на запросы из «длинного хвоста», чтобы не оставлять миллионы пользователей без ответа.

Статья в тему:

Как проверить релевантность страницы онлайн: самый крутой сервис

Что такое поисковая выдача Яндекса и Гугл или зачем нужен ТОП

Чем отличаются редкие запросы от обычных?

Редкие запросы не рассчитаны на прежние алгоритмы поисковых роботов. Например, люди пытаются, так сказать, по-человечески спросить у Яндекса ту или иную информацию.

Приведу конкретный пример из моего недавнего опыта. Решила дать послушать дочке песенку, которая нравилась мне в детстве, но я не помню ни её названия, ни кто поёт. И в поисковую строку Яндекса мне пришлось вбивать единственную строчку, которая всплыла в моей памяти «растет на болоте зеленая трава». Яндекс, конечно же, нашел мне эту песню, и мы и наслушались, и натанцевались под нее. Вот мой запрос — это редкий, поскольку не все ведь будут искать эту песню именно по этой строчке 🙂

Сюда же можно отнести и запросы от детей и подростков: «какой мне посмотреть интересный мультик, только не про пони».

Согласитесь, что высокочастотные запросы обрабатываются тысячи раз, поэтому Яндексу известна статистика поведения пользователей на каждый запрос из выдачи. А редкие запросы требуют индивидуального подхода, потому что по ним нет статистики – какие ответы подходят, а какие нет.

Вот чтобы различать и понимать смысл уникальных вопросов и были придуманы нейронные сети.

Как используются нейронные сети в алгоритме «Палех» Яндекс

Давайте теперь поговорим немного о нейронной сети.

В последние несколько лет они положительно зарекомендовали себя в обработке естественной информации: текстовой, звуковой и графической.

Что же из себя представляют эти сети?

Нейронные сети — это «искусственный интеллект», который после машинного обучения успешно распознает информацию.

Например, во время обучения им показывают картинки слона в ряду с другими картинками, обозначая изображения со слонами за положительные примеры, а все остальные – за отрицательные. Или сообщают нейронной сети набор характерных черт слона: длинный хобот, большие уши и так далее.

Или сообщают нейронной сети набор характерных черт слона: длинный хобот, большие уши и так далее.

Изображения без слонов и не характерные черты выдают за отрицательные примеры. Это позволяет находить верные изображения на запрос: «картинка со слоном» из миллиона других.

Принцип обучения нейронных сетей в алгоритме «Палех» тот же, только он помогает роботам соотносить поисковые запросы с текстами и заголовками на сайтах. Нейронной сети показывают ряд примеров: положительных и отрицательных.

Таким образом, нейросеть учится распознавать, насколько заголовок и текст отражают информацию, которую ищут люди.

Как информация обрабатывается в трёхсотмерном пространстве

Думаю, сложно поспорить с тем фактом, что особенность любого компьютера в том, что ему легче работать с числами. Поэтому Яндекс и придумал, чтобы нейронные сети переводили заголовки страниц на ресурсах в числа.

В Сети размещаются миллиарды различных заголовков. Они разбиваются нейронными сетями на группы, каждая из которых состоит из трёхсот чисел. Таким образом, все документы, занесённые после обработки информации в базу Яндекса, измеряются координатами в трёхсотмерном пространстве. Да, друзья, вы не ослышались, именно трёхсотмерное!

Таким образом, все документы, занесённые после обработки информации в базу Яндекса, измеряются координатами в трёхсотмерном пространстве. Да, друзья, вы не ослышались, именно трёхсотмерное!

В этом же ключе планируется работать с текстами веб-порталов.

Разобраться в такой системе для робота так же просто, как человеку представить систему координат с двумя осями х и y. Только для человека понятно двухмерное пространство, а для робота – трёхсотмерное. После того как заголовки или текст переводятся в числа и попадают в трёхсотмерное пространство, они представляют собой точку с координатами на оси (почти как в учебнике по алгебре).

Переведённые в числовой эквивалент заголовок и текст запроса располагают в одной системе координат. Таким образом, они представляют собой две точки в трёхсотмерном пространстве. В принципе все логично и достаточно просто.

Благодаря нахождению запроса и ответа в одном измерении, нейронной сети легко понять, насколько они друг другу соответствуют. Близкое расположение говорит о том, что текст точно отвечает на вопрос. И тогда именно его робот и даст в выдаче.

Близкое расположение говорит о том, что текст точно отвечает на вопрос. И тогда именно его робот и даст в выдаче.

Технология перевода информации в числа и их последующего измерения в системе координат получила название семантического вектора.

Перспективы развития семантического вектора

Изначально технология семантического вектора была задумана для улучшения качества выдачи на редкие запросы из «хвоста Жар-птицы». Но после короткого промежутка времени она дала положительные результаты, и стала использоваться в других сервисах.

Сейчас технология семантического вектора помогает выдавать максимально точные изображения на запросы пользователя. А в обозримом будущем предполагается исследовать в трёхсотмерном пространстве целые полотна текстов с ресурсов. Вообщем то ли еще будет 🙂

Нейронные сети всё время совершенствуются и выводят на новый уровень взаимодействие человека и компьютера. Благодаря нестандартному подходу подбора информации по смыслу – поисковая система в перспективе сможет отвечать на вопросы не хуже, чем человек. К этому в принципе все и движется.

К этому в принципе все и движется.

***

Друзья, на этом буду заканчивать свой пост. Интересна ли вам была данная информация? Как планируете ею воспользоваться? Делитесь в комментариях ))

С вами была Екатерина Калмыкова,

пока-пока!

что такое, как использовать и почему это хорошо?

По статистике каждый день поисковик получает до 100 млн. уникальных или просто редких запросов. В связи с этим Яндекс запустил новый алгоритм «Палех», основанный на работе нейронных сетей. Он помогает системе точнее отвечать на любые сложные запросы людей.

Почему «Палех»?

График распределения запросов по их популярности в Яндексе представлен в виде птицы, у которой клюв — высокочастотные запросы, туловище — среднечастотные и длинный хвост — низкочастотные. Соединив все 3 части, мы получаем очертания Жар-птицы, которая нередко встречается в палехской миниатюре (тип русской росписи яркими красками на темном фоне). Отсюда и необычное название.

На основе высокочастотных запросов накоплено немало поведенческой статистики в поисковой системе. Благодаря этому она быстрее находит нужный вам результат. С редкими запросами дело обстоит иначе — статистка зачастую отсутствует. Поэтому, когда вы вводите запрос типа «фильм, где фокусник тонет в аквариуме», Яндексу сложнее понять, какой результат лучше соответствует. Как решить эту задачу? На помощь пришли нейронные сети.

Благодаря этому она быстрее находит нужный вам результат. С редкими запросами дело обстоит иначе — статистка зачастую отсутствует. Поэтому, когда вы вводите запрос типа «фильм, где фокусник тонет в аквариуме», Яндексу сложнее понять, какой результат лучше соответствует. Как решить эту задачу? На помощь пришли нейронные сети.

Что такое нейронные сети?

Это способ машинного обучения, основанный на анализе картинок, звука и текста. Например, чтобы научить сеть идентифицировать разные объекты, вначале ей показывают множество изображений. По ним она учится отличать деревья от собак, людей от домов, легковые машины от грузовиков и т.д.

По той же схеме нейросеть учится распознавать тексты. Основу составляют примеры «запрос-заголовок», собранные с помощью накопленной пользовательской статистики. Среди множества таких пар нейросеть научилась находить те, где слова в заголовке и запросе совпадают. Самый подходящий заголовок становился лучшим, но в большинстве случаев он все равно не соответствовал изначальной потребности по смыслу. Чтобы добиться нужного результата, разработчики стали использовать такие случаи в качестве отрицательного примера. Изучая все больше и больше сочетаний, нейросеть постепенно начинала понимать смысловое соответствие между запросом и заголовками страниц. В результате – самые удачные из них действительно соответствуют запросу. Даже самому сложному.

Чтобы добиться нужного результата, разработчики стали использовать такие случаи в качестве отрицательного примера. Изучая все больше и больше сочетаний, нейросеть постепенно начинала понимать смысловое соответствие между запросом и заголовками страниц. В результате – самые удачные из них действительно соответствуют запросу. Даже самому сложному.

Одно из главных преимуществ технологии «Палех» Яндекса в том, что ему не страшны даже переформулировки. Теперь Яндексу осталось решить единственную и самую важную задачу — развить алгоритм до такой степени, чтобы он понимал все содержимое страницы.

Как нововведение повлияет на SEO?

Теперь сайты могут ранжироваться не только на точных ключевых словах, но и на близких по смыслу фразах, которые собраны в пользовательской базе российского поисковика. Например, понятия «seo» и «продвижение сайтов» одинаковые по смыслу, поэтому человеку будет выдаваться дополненная информация.

Новый алгоритм, в первую очередь, затронул те сайты, на которых контент размещен в большом объеме. Одни и те же ключи приобрели новый смысл и начали ранжироваться по таким запросам, по которым ранее они не находились. Если контента не только много, но он еще и качественный, то каждое слово в составе текста может находиться наравне с ключевым словом, схожим по тематике. Чтобы сайт хорошо ранжировался с учетом нового алгоритма, нужно выполнить три условия:

Одни и те же ключи приобрели новый смысл и начали ранжироваться по таким запросам, по которым ранее они не находились. Если контента не только много, но он еще и качественный, то каждое слово в составе текста может находиться наравне с ключевым словом, схожим по тематике. Чтобы сайт хорошо ранжировался с учетом нового алгоритма, нужно выполнить три условия:

- создавать много текстов,

- повышать качество текстов: учитывать пользу и вдумчиво прописывать ключи,

- размещать контент на сайт, которому доверяют.

Какой вывод мы делаем из вышесказанного? Если вы создавали тексты исключительно для поисковых роботов и обильно пичкали их ключевыми фразами, не задумываясь над качеством и количеством написанного, то пришло время это менять. Выполнив все три критерия создания контента, со временем вы заметите, что «Палех» пойдет на пользу. Более того, вы сможете повысить свои позиции, используя запросы с низкой частотностью. Их доля в сутки равна 30% от общей массы запросов, поэтому при грамотной оптимизации сайт начнет расти естественным путем.

Как с помощью «Палеха» получить новых клиентов?

Допустим, у вас нет возможности наполнить свой сайт контентом, который будет соответствовать критериям нового алгоритма Яндекса «Палех» и одновременно нравиться пользователям. Стоит обратиться к нам за грамотно написанным и оптимизированным текстом. Для начала мы проанализируем специфику вашей торговой ниши, чтобы понять, о чем писать и в какой форме преподносить информацию вашей целевой аудитории. Мы прекрасно понимаем, что материал создается для пользователя, а не поисковых роботов. Он должен снимать все возражения и вопросы о вашем товаре или услуге. Мы внедряем ключевые фразы и слова в разумном количестве и читабельном виде так, что они не выбиваются из общего полотна текста.

Прогнозируем результат

Мы тоже решили воспользоваться нейронными сетями во благо и разработали свой уникальный алгоритм прогнозирования. Он учитывает тысячи факторов, влияющих на поисковую выдачу, и предсказывает результат продвижения в сети. В конечном итоге мы получаем план работ над проектом, который помогает нам максимально быстро, эффективно и с минимальными затратами добиться высоких позиций. Нейросети предоставляют бесконечные возможности для развития сайтов и разработки новых смелых стратегий продвижения.

В конечном итоге мы получаем план работ над проектом, который помогает нам максимально быстро, эффективно и с минимальными затратами добиться высоких позиций. Нейросети предоставляют бесконечные возможности для развития сайтов и разработки новых смелых стратегий продвижения.

Если вы задумались о повышении прибыли, прочитайте полезные советы: 5 способов поднять продажи без крупных вложений

Как ИИ повлияет на контент?

1. Появление поисковых систем

Системы поисковых систем были разработаны в соответствии с ростом количества материалов в Интернете. Чем больше документов находили поисковые системы, тем более сложные алгоритмы использовались. Сначала поисковые системы с искусственным интеллектом были предназначены только для выполнения поиска по страницам, затем они решали простые задачи, а теперь отвечали на всестороннюю помощь пользователей.

Поисковые системы прошли следующие этапы развития:

- Шаблон наивного поиска — был поиск по словам, также называемый «инвертированный индекс».

Также пользователи должны учитывать частоту слов и ранжирование страниц

Также пользователи должны учитывать частоту слов и ранжирование страниц - Ссылочное ранжирование – с увеличением количества страниц возникла необходимость ранжирования страниц, и ранжирование важности страниц было привязано к системам ранжирования. Рейтинг важности страниц зависел от качества и количества ссылок на эти страницы.

- Машинное обучение — сначала для Яндекса использовалась система под названием «Матрикснет». В 2017 году Яндекс начал использовать новую систему машинного обучения под названием Cat Boost. Cat Boost дает более точный рейтинг.

Искусственный интеллект (ИИ)

2. Искусственный интеллект

ИИ основан на разработках машинного обучения. О разработках в этом направлении известно с 2013 года, когда были проведены первые исследования в области семантического анализа и возможностей системы Word2Vec. Google создала самообучающуюся систему с ИИ — Rank Brain — на основе этой программы. Система была запущена в 2015 году. Целью этого алгоритма было уловить смысл текстов путем поиска связей между отдельными словами.

Целью этого алгоритма было уловить смысл текстов путем поиска связей между отдельными словами.

Rank Brain — это часть алгоритма Hummingbird в Google. Когда эта система находит незнакомые слова, она ищет подсказки и синонимы по запросу. Найденные аналогии становятся основой для фильтрации данных. В настоящее время Rank Brain является одним из трех наиболее важных критериев оценки страницы вместе со ссылками и текстом.

В 2016 году Яндекс объявил о запуске нового алгоритма «Палех» на основе нейронных связей. Этот алгоритм позволяет осуществлять поиск страниц, соответствующих запросам как по ключевым словам, так и по смыслу. «Палех» анализирует заголовки страниц и находит скрытые смысловые связи.

Еще один алгоритм «Королев» был представлен в 2017 году. В отличие от «Палеха», «Королев» сравнивает семантические векторы запросов и целых страниц. Ранее для этой цели использовались заголовки. Кроме того, кроме нейронных связей, используется машинное обучение, основанное на поведении человека. Таким образом, миллионы пользователей выступают в роли оценщиков. Все алгоритмы имеют аналогичную процедуру с 1 задачей, которая предназначена для улучшения понимания сложных словесных запросов.

Таким образом, миллионы пользователей выступают в роли оценщиков. Все алгоритмы имеют аналогичную процедуру с 1 задачей, которая предназначена для улучшения понимания сложных словесных запросов.

3. Как изменилась SEO-оптимизация

Проникновение ИИ коренным образом изменило результаты запросов и правила SEO. Использование ИИ связано с определенными преимуществами:

- Увеличилась точность вывода по нечастым и низкочастотным запросам – поисковые системы понимают простой человеческий язык;

- В выдаче преобладают более качественные ресурсы – фильтруется спам и переоптимизация по ключевым словам;

- SEO-тексты не обязательны — учитываются только потребности пользователей. LSI-копирайтинг используется для оптимизации текстов под запросы пользователей.

- Можно выполнить деоптимизацию поисковой системы, чтобы удалить ссылки, связанные с определенным термином.

Несмотря на многочисленные преимущества, связанные с ИИ, есть и определенные недостатки:

- Нечеткие результаты поиска — робот не может точно определить нужный контекст, если значение многозначно.

Поэтому предлагает несколько вариантов.

Поэтому предлагает несколько вариантов. - Непрозрачная система ранжирования – пользователь не может указать область поиска, подбирая словосочетания, так как поисковые системы выбирают то, что считают нужным.

- Нетематические ресурсы в выдаче — часто в результатах поиска появляются сайты, не относящиеся к теме поиска, или в выдаче может быть найден некачественный контент.

5. ИИ можно использовать для оптимизации контент-стратегий

Менеджеры по контент-маркетингу сталкиваются с проблемами, связанными с принятием решения о том, какой тип контента использовать для привлечения клиентов и как побудить клиентов от этапа знакомства с брендом до совершения покупок. Once может разработать подробные профили клиентов и удовлетворить потребности целевой аудитории. Иногда ИИ может объяснить, что нужно клиентам, даже если они не могут сформулировать свои настоящие потребности. Анализируя профили в социальных сетях и отслеживая обсуждения в тематических блогах (форумах), ИИ может понять потребности клиентов. Многие известные бренды используют эти инструменты искусственного интеллекта, чтобы оправдать ожидания клиентов. Бренды могут создавать образы клиентов, изучая SEO-результаты целевой аудитории с помощью инструмента SEO-мониторинга. Кроме того, ИИ помогает решить эти проблемы, поскольку он позволяет идентифицировать личность покупателя с помощью анализа трафика, поведения в социальных сетях и взаимодействиях по электронной почте.

Многие известные бренды используют эти инструменты искусственного интеллекта, чтобы оправдать ожидания клиентов. Бренды могут создавать образы клиентов, изучая SEO-результаты целевой аудитории с помощью инструмента SEO-мониторинга. Кроме того, ИИ помогает решить эти проблемы, поскольку он позволяет идентифицировать личность покупателя с помощью анализа трафика, поведения в социальных сетях и взаимодействиях по электронной почте.

6. Новый взгляд на контент

ИИ позволяет создавать гиперперсонализированный контент со ссылкой на профили целевой аудитории. Это будет новая эра контент-маркетинга, поскольку он предлагает мощные инструменты для более эффективного управления удовлетворенностью клиентов. Раньше это было невозможно. Старомодные приемы больше не работают, и маркетологи должны воспользоваться преимуществами новых алгоритмов для создания потрясающего контента и маркетинговых стратегий.

7. Заключительные мысли

Имея в виду недавние изменения в подходах к поисковой оптимизации, маркетологи смогут разрабатывать более подробные маркетинговые стратегии, используя различные инструменты и устройства управления контентом. ИИ позволяет маркетологам сосредоточиться на потребностях клиентов на основе факторов ранжирования. ИИ — отличный помощник для маркетологов с разных точек зрения, поскольку он предлагает инструменты для создания контента, ожидаемого клиентами.

ИИ позволяет маркетологам сосредоточиться на потребностях клиентов на основе факторов ранжирования. ИИ — отличный помощник для маркетологов с разных точек зрения, поскольку он предлагает инструменты для создания контента, ожидаемого клиентами.

Яндекс — Вики | Golden

Яндекс — технологическая компания, которая создает интеллектуальные продукты и услуги на основе машинного обучения. Их цель — помочь потребителям и компаниям лучше ориентироваться в онлайн- и офлайн-мире. С 1997 года Яндекс предоставляет локальные поисковые и информационные услуги мирового класса. Кроме того, они разработали ведущие на рынке транспортные услуги по запросу, навигационные продукты и другие мобильные приложения для миллионов потребителей по всему миру. Яндекс, у которого более 30 офисов по всему миру, котируется на NASDAQ с 2011 года9.0005

Яндекс заблокирован на территории украины в 2017 году.

Хронология

Яндекс запустил проект «Рука помощи» для поддержки врачей, медсестер и других медицинских работников, а также всех, кто оказался в трудной ситуации. Службы доставки Яндекса развивались экспоненциально, в том числе из-за роста числа клиентов, вызванного карантином. Новый скачок в поисковых технологиях и главное улучшение за последние десять лет получило название YATI. Яндекс.Маркет, пионер системы сравнения покупок, снова присоединился к экосистеме Яндекса. у яндекс

Службы доставки Яндекса развивались экспоненциально, в том числе из-за роста числа клиентов, вызванного карантином. Новый скачок в поисковых технологиях и главное улучшение за последние десять лет получило название YATI. Яндекс.Маркет, пионер системы сравнения покупок, снова присоединился к экосистеме Яндекса. у яндекс

Экспресс-доставка продуктов и товаров для дома на дом менее чем за 15 минут после оформления заказа запускает летом Яндекс.Лавка. Яндекс запускает первую в России экосистему умного дома на базе Алисы. Яндекс представляет крупное обновление поиска (Vega). Яндекс добился значительного прогресса в беспилотных технологиях, протестировав в дорожных условиях автономного робота для доставки малогабаритных грузов и протестировав лидары собственной разработки. Образовательная инициатива Яндекса стартует в сентябре, когда компания объявляет об инвестициях в пять миллиардов рублей в подготовку 100 000 специалистов для ИТ-сектора в течение трех лет.

Яндекс представляет свой первый аппаратный продукт — Яндекс. Станцию, умную колонку, оснащенную русскоязычным голосовым помощником компании на основе искусственного интеллекта. Яндекс выводит свой автономный автомобиль из лаборатории на дорогу. В начале этого года Яндекс запускает два сервиса: каршеринг Яндекс.Драйв и сервис доставки заказов Яндекс.Еда. Яндекс выпускает большое обновление своей поисковой системы, которое включает в себя более тысячи улучшений.

Станцию, умную колонку, оснащенную русскоязычным голосовым помощником компании на основе искусственного интеллекта. Яндекс выводит свой автономный автомобиль из лаборатории на дорогу. В начале этого года Яндекс запускает два сервиса: каршеринг Яндекс.Драйв и сервис доставки заказов Яндекс.Еда. Яндекс выпускает большое обновление своей поисковой системы, которое включает в себя более тысячи улучшений.

Яндекс запустил первого диалогового ИИ-помощника, не ограниченного набором предопределенных сценариев, под названием «Алиса». Компания открыла исходный код CatBoost, новой библиотеки машинного обучения, основанной на повышении градиента. Яндекс разработал и внедрил новый поисковый алгоритм Королев. Компания начала тестировать свою беспилотную автомобильную технологию. «Яндекс.Такси» и Uber договорились об объединении бизнеса в России, Азербайджане, Армении, Беларуси, Грузии и Казахстане. Яндекс.Переводчик добавил нейронную модель машинного перевода. Компания также представила ряд новых услуг и продуктов для бизнеса, в том числе многофункциональное голосовое решение для подключенных автомобилей «Яндекс. Авто» и платформу для совместной работы на рабочем месте «Яндекс.Коннект».

Авто» и платформу для совместной работы на рабочем месте «Яндекс.Коннект».

Яндекс запустил новый алгоритм поиска, использующий нейронные сети для извлечения результатов поиска по смыслу, а не по ключевым словам. Назван в честь села Палех. Компания запустила образовательный проект «Яндекс.Лицей» по обучению программированию 14-15-летних. В браузер Яндекса и лаунчер Яндекса встроена технология персонализированных рекомендаций по контенту под названием Дзен. Яндекс запускает программу, направленную на развитие и поддержку образовательных веб-проектов по истории, литературе, языкознанию, искусству и философии. Также в этом году было выпущено приложение для записи на прием к врачу «Яндекс.Здоровье», а также новые сервисы для бизнеса — виртуальная автоматизированная система общения с клиентами «Яндекс.Телефония» и «Яндекс.Аудитория».

Яндекс разработал собственную технологию прогнозирования погоды под названием Meteum. Новые правила в Яндекс.Директе. В этом году запущено мобильное приложение «Яндекс. Паркинг» для водителей и «Яндекс.Радио». Также была выпущена бета-версия Яндекс.Транспорта. Заработали два сервиса для бизнеса: летом агрегатор логистических услуг «Яндекс.Доставка»; а осенью медиа-сервис, который, как автоматическое информационное агентство.

Паркинг» для водителей и «Яндекс.Радио». Также была выпущена бета-версия Яндекс.Транспорта. Заработали два сервиса для бизнеса: летом агрегатор логистических услуг «Яндекс.Доставка»; а осенью медиа-сервис, который, как автоматическое информационное агентство.

Яндекс открыл Yandex Data Factory, международный проект, предоставляющий решения для работы с большими данными корпоративным и корпоративным клиентам. Яндекс и Московская Высшая школа экономики совместно открыли факультет информатики, который готовит специалистов по двум направлениям — программной инженерии и прикладной математике и информатике. Выпущено мобильное новостное приложение и два новых сервиса — «Яндекс.Город» и «Яндекс.Мастер». Первый помогал пользователям находить и выбирать предприятия и организации до 2016 года, а второй помогал людям находить специалистов для своих бытовых задач и был закрыт через год после запуска.

На конференции ЯК-2013 Яндекс представил собственную технологию распознавания голоса SpeechKit и API для работы с ней. Яндекс стал ассоциированным членом CERN openlab. Яндекс открыл Yandex.Store, магазин приложений для Android.

Яндекс стал ассоциированным членом CERN openlab. Яндекс открыл Yandex.Store, магазин приложений для Android.

Яндекс выпустил браузер собственной разработки. Яндекс внедрил Real Time Bidding — технологию аукциона показов рекламы. Яндекс открыл свой облачный сервис хранения данных Яндекс.Диск. Яндекса

В мае Яндекс провел IPO на фондовой бирже NASDAQ в Нью-Йорке. Акции компании торгуются под тикером YNDX. Компания вышла за пределы постсоветского пространства, открыв 20 сентября в Турции портал yandex.com.tr. Он предлагает Яндекс.Поиск, Яндекс.Карты, Яндекс.Почту и другие сервисы для турецких пользователей. «Яндекс» представил свою новую технологию «Крипта», которая может классифицировать разные группы пользователей на основе их поведения в сети. Компания организовала соревновательный чемпионат по программированию «Яндекс.Алгоритм. Запущен Яндекс.Переводчик.

Продукты

Приобретения

Патенты

Дополнительные ресурсы

Воспроизведение видео в браузере — бета-версия браузера. Справка

Справка

Яндекс

ЯК 2021: Как живет Яндекс

8 декабря 2021

Яндекс — История — История Яндекса FinSMEs

FinSMEs

20 сентября 2021

FinSMEs

О компании | Рекламировать | Контакты | Отказ от ответственности | Новости | Ежедневный информационный бюллетень сделок FinSMEs.com от FinSMEs находится под лицензией Creative Commons Attribution-NonCommercial-NoDerivs 3.0 Unported License.

Яндекс выкупает долю Uber в Yandex Self-Driving Group, Eats, Lavka и Delivery за 1 млрд долларов

Ребекка Беллан

31 августа 2021 Российская компания 100% владеет всеми четырьмя предприятиями.

The Station: Рождение Rimac-Bugatti, Tesla выпускает бета-версию FSD v9 и Ola привлекает 500 миллионов долларов настоящие и будущие средства перемещения людей и посылок из пункта А в пункт Б. Я вернулся из своего путешествия и плаваю в электронных письмах. Если вы отправили мне сообщение в Твиттере, по электронной почте или в голубиной почте, пожалуйста, дайте мне несколько дней […]

Если вы отправили мне сообщение в Твиттере, по электронной почте или в голубиной почте, пожалуйста, дайте мне несколько дней […]

Yandex Self-Driving Group сотрудничает с Grubhub для роботизированной доставки в кампусы колледжей , объявила о партнерстве со службой доставки еды Grubhub, которая станет ее многолетним поставщиком роботизированной доставки в кампусах американских колледжей. По словам Дмитрия Полищука, генерального директора Yandex Self-Driving Group, Яндекс начнет работать этой осенью с десятками автомобилей и надеется достичь […]

Яндекс выступает против решения России ограничить иностранное владение стриминговыми сервисами до…

Надежда Цыденова

22 декабря 2020 г.

DealStreetAsia

Яндекс может быть затронут, поскольку он зарегистрирован на фондовой бирже Nasdaq.

ПОКАЗАТЬ ЕЩЕ

Ссылки

Яндекс Королев — пиар-ход, а не революция — Реальное время

09:00, 05. 09.2017

09.2017

Яндекс обновил свой поисковик и представил новый алгоритм ранжирования Королев. Презентация прошла с помпой, об этом написали практически все российские СМИ, а некоторые эксперты сочли этот шаг российских интернет-компаний революционным. Основное отличие от предыдущей версии в том, что новый алгоритм оценивает запросы не по ключевым словам, а по смыслу, причем — с высокой точностью за счет использования обучающихся нейронных сетей. «Реальному времени» удалось побеседовать с вице-президентом Российско-Тунисского делового совета и IT-предпринимателем Эльбрусом Латыповым, который доступным языком объяснил, как будет работать «Королев», как скоро пользователи заметят разницу в выдаваемых им результатах, будет ли Яндекс пионер и сколько людей сейчас обучает нейросеть российской компании.

«Хороший пиар-ход, больше направленный на привлечение доли рынка в России»

Эльбрус, как вы оцениваете Королев? Правда ли, что этот алгоритм можно назвать революционным?

Что касается революционности, то это скорее пиар-ход. В данном случае Яндекс перенимает опыт американских партнеров с намерением представить что-то «новое». На самом деле, если взять Google, аналогичный алгоритм под названием Hummingbird они разработали еще в 2013 году. Google в то время вел себя скромнее — они разработали алгоритм и представили его исключительно в профессиональной сфере, а не широкой публике.

В данном случае Яндекс перенимает опыт американских партнеров с намерением представить что-то «новое». На самом деле, если взять Google, аналогичный алгоритм под названием Hummingbird они разработали еще в 2013 году. Google в то время вел себя скромнее — они разработали алгоритм и представили его исключительно в профессиональной сфере, а не широкой публике.

Есть ли другие компании, кроме Google и Яндекса, которые используют нейросеть?

Нейронная сеть сегодня является модным словом. Машинное обучение, нейросети, искусственный интеллект — это своего рода тренд, за ним не будущее, а настоящее. В общем, объем информации в Интернете таков, что старые алгоритмы, разработанные Google и Яндексом, уже не подходят. Линейный анализ запросов больше не работает. Существует огромное количество информации, которая пересекается с другой информацией, и люди, которые используют поисковые системы, не получают должных результатов.

»Если взять Google, то аналогичный алгоритм под названием Hummingbird они разработали еще в 2013 году.паблик». Фото siteclinic.ru

Колибри, Королев, Палех – такая система эффективна, когда человек пытается найти, например, название фильма или песни, но у него есть только часть ее описания. В этом случае линейный поиск не работает. Здесь он должен работать как человеческий мозг – анализировать картинку в целом и давать ответ не линейный, а смысловой. Человеческий мозг оперирует значениями, а не какими-то конкретными линейными показателями.

Например, вы ищете фильм Армагеддон , но забыли его название. Вы пишете в поиске: «Люди летят на метеор и спасают Землю». Линейный поиск даст вам несколько отдельных ссылок на каждое слово или фразу. Он даст вам метеор, Землю, какие-то актуальные образы, но не сам фильм. Новый алгоритм ищет значение всех слов вместе, объединяет их и дает единственный правильный ответ, который нашел бы человеческий мозг.

Если вернуться к Гуглу и Яндексу, то после элементарного анализа получим тот же результат. У Google и Яндекса почти одинаковые алгоритмы. Мы их не знаем, мы их не видим — это тайна, но в итоге имеем почти тот же результат. Ни одна из систем не имеет какого-либо серьезного преимущества.

Мы их не знаем, мы их не видим — это тайна, но в итоге имеем почти тот же результат. Ни одна из систем не имеет какого-либо серьезного преимущества.

Естественно, Яндекс более корректно работает с русскими запросами. Однако Google в последние годы также продвинулся в этой области и дает правильные ответы. Кстати, у Google релевантность выше, чем у Яндекса.

Поэтому тут сложно что-то сказать о революционности. Это хорошая презентация, хороший пиар-ход, но больше направленный на привлечение доли рынка на российском рынке.

«Яндекс привлек более миллиона волонтеров, которые обучают нейросети на личном опыте. Каждому человеку дается задание: что-то поискать и выбрать побольше правильных ответов. Так нейросеть учится». Фото inorehovo.ru

Нейронная сеть сейчас находится в процессе обучения. Как вы думаете, сколько времени потребуется, чтобы показать публике ощутимый результат?

Нейронная сеть — это алгоритм, который обучается с участием реальных людей. На сегодняшний день, по имеющейся у меня информации, Яндекс привлек более миллиона добровольцев, которые обучают нейросети на личном опыте. Каждому человеку дается задание: что-то поискать и выбрать побольше правильных ответов. Так учится нейронная сеть. Эффективность нейронной сети будет больше зависеть от алгоритмов, которые смогут обрабатывать информацию. По сути, это некий порог и подобие искусственного интеллекта, который будет анализировать сам, а пока ему нужно учиться у реальных людей.

На сегодняшний день, по имеющейся у меня информации, Яндекс привлек более миллиона добровольцев, которые обучают нейросети на личном опыте. Каждому человеку дается задание: что-то поискать и выбрать побольше правильных ответов. Так учится нейронная сеть. Эффективность нейронной сети будет больше зависеть от алгоритмов, которые смогут обрабатывать информацию. По сути, это некий порог и подобие искусственного интеллекта, который будет анализировать сам, а пока ему нужно учиться у реальных людей.

Проблема в том, что человеческий мозг работает намного мощнее любой техники. Все существующие нейронные сети очень примитивны по сравнению с нашим мозгом. Сегодня трудно сказать, сколько времени потребуется, чтобы технология приблизилась к человеческим возможностям, к анализу и восприятию на том же уровне.

«По большому счету, нейронные сети и искусственный интеллект находятся в зачаточном состоянии»

Согласны ли вы с теми, кто говорит, что благодаря Королеву качество выдаваемого контента повысится? Когда пользователь это увидит?

Думаю теперь будет сложно заметить. Эта огромная работа будет заметна через несколько лет. Увидеть это «невооруженным глазом» пока невозможно. По большому счету, нейронные сети и искусственный интеллект находятся в зачаточном состоянии, и нас ждет огромная работа. Думаю, на данный момент еще и 10% работы не сделано.

Эта огромная работа будет заметна через несколько лет. Увидеть это «невооруженным глазом» пока невозможно. По большому счету, нейронные сети и искусственный интеллект находятся в зачаточном состоянии, и нас ждет огромная работа. Думаю, на данный момент еще и 10% работы не сделано.

Вы наверняка слышали об исследовании, результаты которого показывают, что женщины обычно формулируют свой запрос более подробно, а мужчины используют ключевые слова. Унифицирует ли алгоритм этот момент, как вы думаете?