Как провести A/B-тестирование: 6 простых шагов

A/B-тестирование — это неотъемлемая часть процесса работы над продуктом. Это эксперимент, который позволяет сравнить две версии чего-либо, чтобы проверить гипотезы и определить, какая версия лучше. Должны ли кнопки быть черными или белыми, какая навигация лучше, какой порядок прохождения регистрации меньше всего отпугивает пользователей? Продуктовый дизайнер из Сан-Франциско Лиза Шу рассказывает о простой последовательности шагов, которые помогут провести базовое тестирование.

Кому нужно A/B-тестирование

— Продакт-менеджеры могут тестировать изменения ценовых моделей, направленные на повышение доходов, или оптимизацию части воронки продаж для увеличения конверсии.

— Маркетологи могут тестировать изображения, призывы к действию (call-to-action) или практически любые другие элементы маркетинговой кампании или рекламы с точки зрения улучшения метрик.

— Продуктовые дизайнеры могут тестировать дизайнерские решения (например, цвет кнопки оформления заказа) или использовать результаты тестирования для того, чтобы перед внедрением определить, будет ли удобно пользоваться новой функцией.

Вот шесть шагов, которые нужно пройти, чтобы провести тестирование. В некоторые из пунктов включены примеры тестирования страницы регистрации выдуманного стартапа.

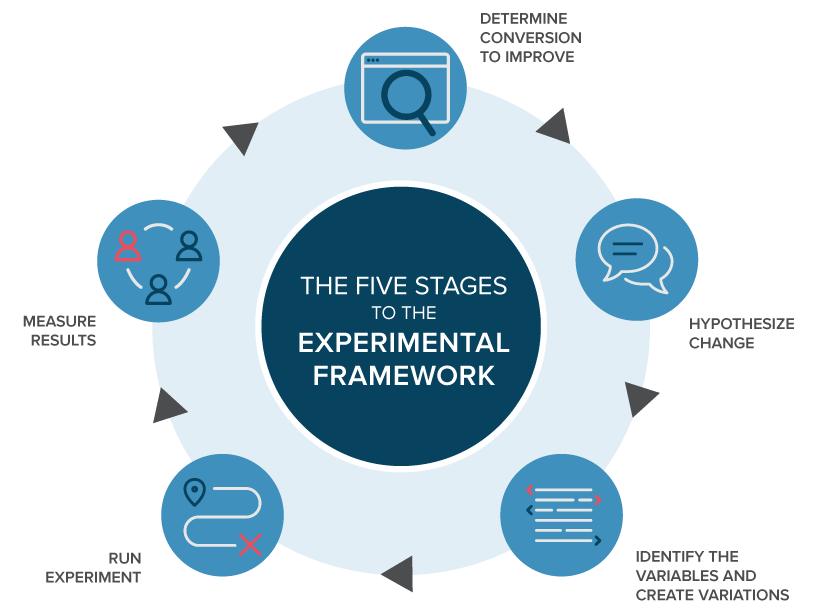

1. Определите цели

Определите основные бизнес-задачи вашей компании и убедитесь, что цели A/B-тестирования с ними совпадают.

Пример: Допустим, вы менеджер продукта в «компании X» на стадии стартапа. Руководству нужно добиться роста количества пользователей. В частности, компания стремится к росту количества активных пользователей (метрика DAU), определяемых как среднее количество зарегистрированных пользователей сайта в день за последние 30 дней. Вы предполагаете, что этого можно добиться либо путем улучшения показателей удержания (процент пользователей, возвращающихся для повторного использования продукта), либо путем увеличения числа новых регистрирующихся пользователей.

В процессе исследования воронки вы замечаете, что 60% пользователей уходят до завершения регистрации. Это означает, что можно повысить количество регистраций, изменив страницу регистрации, что, в свою очередь, должно помочь увеличить количество активных пользователей.

2. Определите метрику

Затем вам нужно определить метрику, на которую вы будете смотреть, чтобы понять, является ли новая версия сайта более успешной, чем изначальная. Обычно в качестве такой метрики берут коэффициент конверсии, но можно выбрать и промежуточную метрику вроде показателя кликабельности (CTR).

Пример: В нашем примере в качестве метрики вы выбираете долю зарегистрированных пользователей (registration rate), определяемую как количество новых пользователей, которые регистрируются, поделенное на общее количество новых посетителей сайта.

3. Разработайте гипотезу

Затем нужно разработать гипотезу о том, что именно поменяется, и, соответственно, что вы хотите проверить. Нужно понять, каких результатов вы ожидаете и какие у них могут быть обоснования.

Пример: Допустим, на текущей странице регистрации есть баннер и форма регистрации. Есть несколько пунктов, которые вы можете протестировать: поля формы, позиционирование, размер текста, но баннер на главной странице визуально наиболее заметен, поэтому сначала надо узнать, увеличится ли доля регистраций, если изменить изображение на нём.

Общая гипотеза заключается в следующем: «Если изменить главную страницу регистрации, то больше новых пользователей будут регистрироваться внутри продукта, потому что новое изображение лучше передает его ценности».

Нужно определить две гипотезы, которые помогут понять, является ли наблюдаемая разница между версией A (изначальной) и версией B (новой, которую вы хотите проверить) случайностью или результатом изменений, которые вы произвели.

— Нулевая гипотеза предполагает, что результаты, А и В на самом деле не отличаются и что наблюдаемые различия случайны. Мы надеемся опровергнуть эту гипотезу.

— Альтернативная гипотеза — это гипотеза о том, что B отличается от A, и вы хотите сделать вывод об её истинности.

Решите, будет ли это односторонний или двусторонний тест. Односторонний тест позволяет обнаружить изменение в одном направлении, в то время как двусторонний тест позволяет обнаружить изменение по двум направлениям (как положительное, так и отрицательное).

4. Подготовьте эксперимент

Для того, чтобы тест выдавал корректные результаты сделайте следующее:

— Создайте новую версию (B), отражающую изменения, которые вы хотите протестировать.

— Определите контрольную и экспериментальную группы. Каких пользователей вы хотите протестировать: всех пользователей на всех платформах или только пользователей из одной страны? Определите группу испытуемых, отобрав их по типам пользователей, платформе, географическим показателям и т. п. Затем определите, какой процент исследуемой группы составляет контрольная группа (группа, видящая версию A), а какой процент — экспериментальная группа (группа, видящая версию B). Обычно эти группы одинакового размера.

— Убедитесь, что пользователи будут видеть версии A и B в случайном порядке. Это значит, у каждого пользователя будет равный шанс получить ту или иную версию.

— Определите уровень статистической значимости (α). Это уровень риска, который вы принимаете при ошибках первого рода (отклонение нулевой гипотезы, если она верна), обычно α = 0. 05. Это означает, что в 5% случаев вы будете обнаруживать разницу между A и B, которая на самом деле обусловлена случайностью. Чем ниже выбранный вами уровень значимости, тем ниже риск того, что вы обнаружите разницу, вызванную случайностью.

05. Это означает, что в 5% случаев вы будете обнаруживать разницу между A и B, которая на самом деле обусловлена случайностью. Чем ниже выбранный вами уровень значимости, тем ниже риск того, что вы обнаружите разницу, вызванную случайностью.

— Определите минимальный размер выборки. Калькуляторы есть здесь и здесь, они рассчитывают размер выборки, необходимый для каждой версии. На размер выборки влияют разные параметры и ваши предпочтения. Наличие достаточно большого размера выборки важно для обеспечения статистически значимых результатов.

— Определите временные рамки. Возьмите общий размер выборки, необходимый вам для тестирования каждой версии, и разделите его на ваш ежедневный трафик, так вы получите количество дней, необходимое для проведения теста. Как правило, это одна или две недели.

Пример: На существующем сайте в разделе регистрации мы изменим главную страницу — это и будет нашей версией B. Мы решаем, что в эксперименте будут участвовать только новые пользователи, заходящие на страницу регистрации. Мы также обеспечиваем случайную выборку, то есть каждый пользователь будет иметь равные шансы получить A или B, распределенные случайным образом.

Мы также обеспечиваем случайную выборку, то есть каждый пользователь будет иметь равные шансы получить A или B, распределенные случайным образом.

Важно определить временные рамки. Допустим, ежедневно на нашу страницу регистрации в среднем приходит трафик от 10 000 новых пользователей, это означает, что только 5000 пользователей могут увидеть каждую версию. Тогда минимальный размер выборки составляет около 100 000 просмотров каждой версии. 100 000/ 5000 = 20 дней — столько должен продлиться эксперимент.

5. Проведите эксперимент

Помните о важных шагах, которые необходимо выполнить:

— Обсудите параметры эксперимента с исполнителями.

— Выполните запрос на тестовой закрытой площадке, если она у вас есть. Это поможет проверить данные. Если ее нет, проверьте данные, полученные в первый день эксперимента.

— В самом начале проведения тестирования проверьте, действительно ли оно работает.

— И, наконец, не смотрите на результаты! Преждевременный просмотр результатов может испортить статистическую значимость. Почему? Читайте здесь.

Почему? Читайте здесь.

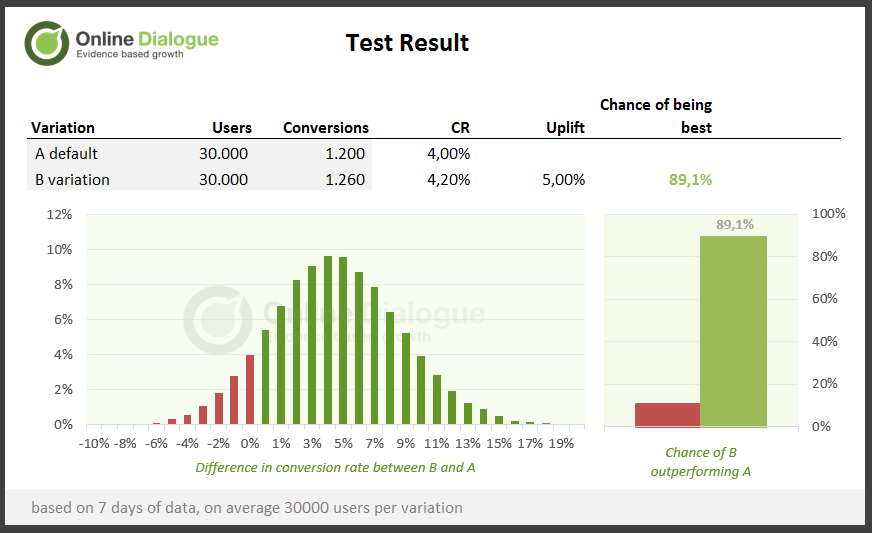

6. Анализируйте результаты. Наконец-то самое интересное

Вам нужно получить данные и рассчитать значения выбранной ранее метрики успеха для обеих версий (A и B) и разницу между этими значениями. Если не было никакой разницы в целом, вы также можете сегментировать выборку по платформам, типам источников, географическим параметрам и т. п., если это применимо. Вы можете обнаружить, что версия B работает лучше или хуже для определенных сегментов.

Проверьте статистическую значимость. Статистическая теория, лежащая в основе этого подхода, объясняется здесь, но основная идея в том, чтобы выяснить, была ли разница в результатах между A и B связана с изменениями или это результат случайности или естественных изменений. Это определяется путем сравнения тестовых статистических данных (и полученного p-значения) с вашим уровнем значимости.

Если p-значение меньше уровня значимости, то можно отвергнуть нулевую гипотезу, имея доказательства для альтернативы.

Если p-значение больше или равно уровню значимости, мы не можем отвергнуть нулевую гипотезу о том, что A и B не отличаются друг от друга.

A/B-тестирование может дать следующие результаты:

— Контрольная версия, А выигрывает или между версиями нет разницы. Если исключить причины, которые могут привести к недействительному тестированию, то проигрыш новой версии может быть вызван, например, плохим сообщением и брендингом конкурентного предложения или плохим клиентским опытом.

В этом сценарии вы можете углубиться в данные или провести исследование пользователей, чтобы понять, почему новая версия не работает так, как ожидалось. Это, в свою очередь, поможет собрать информацию для следующих тестов.

— Версия B выигрывает. A/B-тест подтвердил вашу гипотезу о лучшей производительности версии B по сравнению с версией A. Отлично! Опубликовав результаты, вы можете провести эксперимент на всей аудитории и получить новые результаты.

Заключение

Независимо от того, был ли ваш тест успешным или нет, относитесь к каждому эксперименту как к возможности для обучения. Используйте то, чему вы научились, для выработки вашей следующей гипотезы. Вы можете, например, использовать предыдущий тест или сконцентрироваться на другой области, требующей оптимизации. Возможности бесконечны.

Используйте то, чему вы научились, для выработки вашей следующей гипотезы. Вы можете, например, использовать предыдущий тест или сконцентрироваться на другой области, требующей оптимизации. Возможности бесконечны.

Что такое A/B-тестирование и как провести его правильно. Урок 1 — Коптельня на vc.ru

Перед вами — гайд по A/B-тестированию, который расскажет, в чем разница между A/B-тестированием и мультивариативным тестированием, как проводить тесты структурировано и последовательно, и как понять, какой эксперимент стоит выбрать, чтобы выжать максимум.

3046 просмотров

Автор английской версии: Янив Навот, CMO, Dynamic Yield

Вы читаете перевод бесплатного курса по A/B тестированию от компании Dynamic Yield. Над переводом работали Оля Жолудова и Ринат Шайхутдинов. При поддержке koptelnya.ru.

Коптельня — команда по быстрой разработке веб-приложений и сайтов.

Иллюстрация Jack Daly: https://dribbble. com/shots/3474087-Curated-Living

com/shots/3474087-Curated-Living

А/В-тестирование — это метод сравнения двух версий страницы или приложения, который помогает понять, какая из них работает лучше в контексте какой-то конкретной задачи.

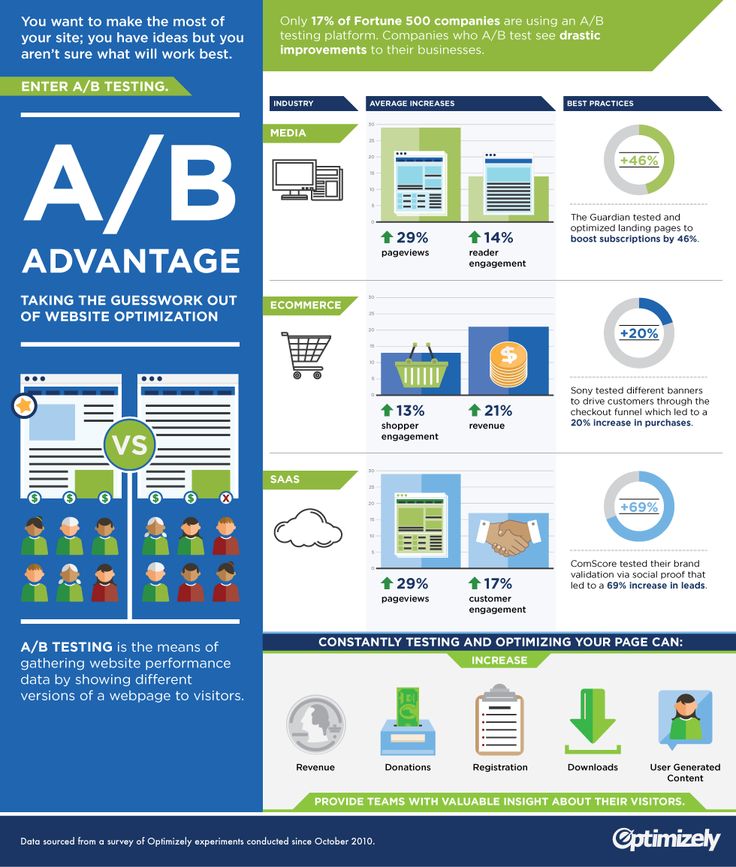

При помощи контролируемых экспериментов маркетологи, продакт-менеджеры и разработчики могут быстро проверять свои творческие идеи на жизнеспособность и, отталкиваясь от объективных данных, быстро и гибко внедрять самые удачные из них в продукт. Короче говоря, вам больше не надо рассуждать, почему тот или иной вариант страницы (или шага в пользовательском сценарии) более удачный — эксперимент все скажет сам за себя. Этот метод идеально подходит, когда нужно поднять конверсию, увеличить выручку, нарастить базу подписчиков или привлечь побольше клиентов и лидов.

Содержание:

Глобальные компании, такие как Google, Amazon, Fb и Netflix выстроили процессы в бизнесе так, чтобы проводить тысячи экспериментов в год и оперативно внедрять их результаты в работу.

Успех Amazon зависит от того, сколько экспериментов мы сможем провести в год, в месяц, в неделю, в день

Джефф Безос

В технологическом блоге Netflix в апреле 2016 года прозвучала такая фраза: «Благодаря эмпирическому подходу к работе, мы точно знаем, что изменения в продукте продиктованы не вкусами и мнениями самых авторитетных сотрудников компании, а объективными данными. То есть наши зрители сами подсказывают нам, что им нравится».

И Марк Цукерберг в одном из интервью признался, что успех Fb кроется в их уникальной системе тестирования, чем предприниматель очень гордится: «В любую секунду в мире работает не одна версия Fb, а порядка 10,000».

Что такое A/B тест и в чем его ценность для развития цирфорового продукта?

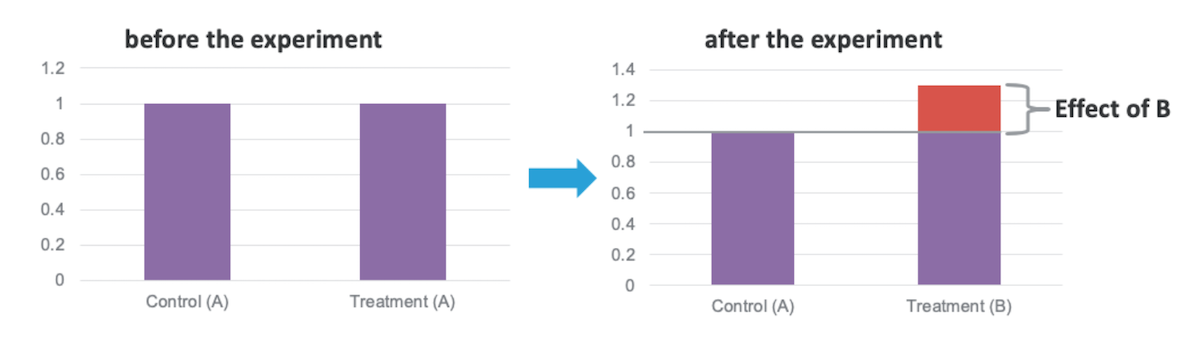

В классическом A/B тесте, мы, первым делом, определяем, что будем тестировать и какова наша задача. Далее мы создаем одну или несколько вариаций исходного веб-элемента (еще его называют контрольной группой или точкой отсчета) . Далее, мы делим трафик пополам (в случайном порядке: то есть распределяем пользователей согласно некой вероятности) , и, наконец, собираем данные (метрики) о том, как работает каждая версия страницы. Спустя какое-то время, мы анализируем данные и оставляем ту версию, которая отработала лучше, а менее удачную — выключаем.

Далее мы создаем одну или несколько вариаций исходного веб-элемента (еще его называют контрольной группой или точкой отсчета) . Далее, мы делим трафик пополам (в случайном порядке: то есть распределяем пользователей согласно некой вероятности) , и, наконец, собираем данные (метрики) о том, как работает каждая версия страницы. Спустя какое-то время, мы анализируем данные и оставляем ту версию, которая отработала лучше, а менее удачную — выключаем.

Очень важно проводить тесты грамотно: иначе вы не только не получите осмысленные и полезные результаты, но и можете выбрать ошибочный путь. В целом, контролируемые эксперименты могут помочь в решении следующих задач и дают следующую ценность:

- Разобраться с недочетами UX и популярными барьерами для клиентов (pain points)

- Повысить эффективность существующего трафика (поднять конверсию (conversions) и выручку (revenue) , оптимизировать затраты на привлечение клиентов (customer acquisition costs))

- Поднять вовлеченность (снизить показатель отказов (bounce rate), повысить показатель кликабельности (click-through rate) и т.

д.)

д.)

Нужно помнить, что когда мы отдаем предпочтение тому или иному рианту, мы по сути масштабируем результаты, полученные к этому моменту, на всю аудиторию потенциальных пользователей. Это настоящий прыжок веры, и каждое такое действие должно быть обосновано. Внедряя решения без веских оснований, мы обязательно сделаем хоть один неверный шаг — что негативно скажется на продукте в долгосрочной перспективе. Процесс сбора таких обоснований мы называем тестированием гипотез, а искомые обоснования —статистической значимостью.

Вот несколько примеров A/B тестов:

- Тестирование разных типов сортировки в меню навигации сайта (как в этом примере крупного немецкого продавца электроники)

- Тестирование и оптимизация лендингов (как в этом примере ведущей европейской компании по защите авиапассажиров)

- Тестирование маркетинговых сообщений: например, рассылок или баннеров (как в этом примере международного розничного продавца натуральной косметики)

Как рождается A/B тест: Изучаем ситуацию и формулируем гипотезу

В основе любого A/B теста лежит проблема (ситуация) , которую нам надо решить (разрешить) или некое поведение пользователя, которое нам нужно изменить или, наоборот, закрепить. Выявив проблему или задачу, маркетолог формулирует гипотезу — обоснованное предположение, которое либо подтверждается, либо опровергается в результате эксперимента.

Выявив проблему или задачу, маркетолог формулирует гипотезу — обоснованное предположение, которое либо подтверждается, либо опровергается в результате эксперимента.

Пример продуктовой гипотезы: Если мы добавим значок с социальным доказательством на страницу с описанием продукта, посетители узнают о популярности нашего продукта, и количество добавлений в корзину вырастет на 10%.

Разбор гипотезы: В этом случае, когда мы выявили проблему (низкий показатель добавлений в корзину, к примеру) и сформулировали гипотезу (решение: отображение значка с социальным доказательством стимулирует пользователей добавлять товар в корзину чаще) , можно приступать к тестированию на сайте.

Классический подход к A/B тестированию: как организуется эксперимент и распределяется трафик между версиями

В простом A/B тесте трафик распределяется между двумя версиями. Одна из версий — с оригинальным (текущим) контентом и дизайном — считается контрольной. Вторая версия — это вариация. Изменения могут быть разными: к примеру, можно протестировать разные варианты заголовка, кнопки call-to-action, лейаут, дизайн и т. п.

Одна из версий — с оригинальным (текущим) контентом и дизайном — считается контрольной. Вторая версия — это вариация. Изменения могут быть разными: к примеру, можно протестировать разные варианты заголовка, кнопки call-to-action, лейаут, дизайн и т. п.

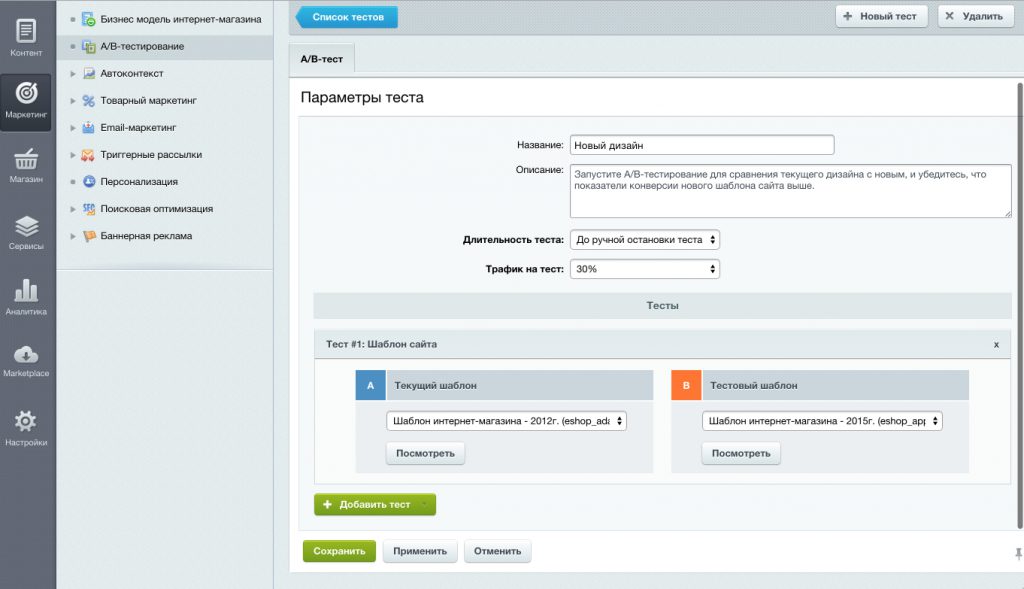

В классическом эксперименте на уровне одной страницы, нам даже не нужно делать два URL для тестирования. Большинство решений для A/B тестирования позволяют динамически менять контент, лейаут и дизайн страницы.

Однако, если вы хотите включить в тестирование 2+ набора страниц, тогда нужно проводить сплит тестирование и использовать несколько URL.

В каких случаях проводить сплит тестирование

Сплит тестирование (иногда его называют многостраничным тестированием) в целом похоже на A/B тестирование, но позволяет проводить эксперименты с использованием отдельного URL для каждой вариации. Другими словами, сплит тестирование можно провести между двумя существующими URL-адресами, что особенно полезно, если у вас динамический контент.

Допустим, у вас уже есть два страницы, и вы хотите узнать, какая из них работает лучше. К примеру, вы запускаете рассылку и у вас есть две разные версии потенциального лендинга. Проведите сплит тестирование — и поймете, какой лендинг показывает лучшие результаты в рамках этой кампании.

В A/B тест можно включить и больше двух вариаций

Если вы хотите протестировать более двух вариаций, проведите A/B/n тест. С его помощью можно сравнить эффективность трех или более вариаций, вместо того, чтобы тестировать каждую вариацию относительно одной и той же контрольной вариации (то есть проводить цепочку независимых A/B тестов) . Если на сайте высокий трафик, при помощи A/B/n тестирования можно проверять множество вариаций разом, тем самым сокращая время тестирования и получая результаты быстрее.

Однако я не рекомендую вносить слишком много изменений в вариацию. Если вы внесете только самые важные и значимые изменения, по результатам эксперимента вам будет проще понять возможные причинно-следственные связи. А если вы хотите протестировать сразу ряд изменений, проведите лучше мультивариативный тест.

А если вы хотите протестировать сразу ряд изменений, проведите лучше мультивариативный тест.

Что такое мультивариативное тестирование

Мультивариативные тесты (иногда их называют мультивариантными тестами) позволяют протестировать изменения сразу в нескольких разделах одной страницы. Чтобы понять принцип, проведите мультивариативный тест на одном из своих лендингов, а потому поменяйте на нем пару элементов. В первой вариации замените главное фото на странице формой для обратной связи. Во второй вариации, добавьте на страницу видео. Теперь система сгенерирует на базе ваших изменений еще одну возможную вариацию — с видео И формой обратной связи.

Всего получится 2 x 2 = 4 вариации страницы

V1 — контрольная версия (без формы обратной связи и без видео)

V2 — вариация с формой обратной связи

V3 — вариация с видео

V4 — вариация с формой обратной связи + видео

Поскольку в ходе мультивариативного тестирования проверяются все возможные комбинации, не рекомендуется добавлять много вариантов — если только у вас не сайт с очень и очень высоким трафиком. Если проводить мультивариативное тестирование с множеством переменных на сайте с низким трафиком, есть риск получить недостаточно значимые результаты, по которым не получится сделать никакие весомые выводы. Для такого вида тестирования нужно как минимум несколько тысяч посещений в месяц.

Если проводить мультивариативное тестирование с множеством переменных на сайте с низким трафиком, есть риск получить недостаточно значимые результаты, по которым не получится сделать никакие весомые выводы. Для такого вида тестирования нужно как минимум несколько тысяч посещений в месяц.

Пример мультивариантного теста на продуктовой странице онлайн-магазина

Какой тест применить в зависимости от ситуации

A/B тест поможет найти ответы вопросы типа: “на какую из этих двух вариаций страницы посетители реагируют лучше? ”

А мультивариантные тесты помогут ответить такие вопросы:

- Посетители лучше реагируют на видео или на форму обратной связи?

- Или лучше работает только форма обратной связи, без видео?

- Или лучше оставить видео и убрать форму обратной связи?

Как оценить эффективность платформы для A/B тестирования

Чтобы оценить эффективность платформы для A/B тестирования, можно провести A/A тест. Для этого вам нужно создать две одинаковые версии страницы и запустить A/B тест. В идеале, система должна выдать ответ, что обе вариации показали примерно одинаковые результаты. Подробнее про A/A тесты читайте здесь.

Для этого вам нужно создать две одинаковые версии страницы и запустить A/B тест. В идеале, система должна выдать ответ, что обе вариации показали примерно одинаковые результаты. Подробнее про A/A тесты читайте здесь.

Вывод и рекомендации: разбираем путь к результативным A/B тестам

Я не провалил тест, я просто нашел 100 способов выполнить его неправильно

Бенджамин Франклин

При проведении A/B тестирования очень важна четкая и адекватная методология. Только в этом случае мы можем доверять результатам теста и принимать эффективные решения на их основании.

A/B тестирование дает нам фреймворк, который позволяет сравнить реакцию посетителей сайта на различные вариации страниц (и паттерны движения к цели), и если одна из вариаций работает лучше — установить статистическую значимость результата и в какой-то мере причинно-следственную связь.

Что такое A/B-тестирование? — Optimizely

Что такое A/B-тестирование?

A/B-тестирование (также известное как сплит-тестирование или групповое тестирование) — это метод сравнения двух версий веб-страницы или приложения друг с другом, чтобы определить, какая из них работает лучше. A/B-тестирование — это, по сути, эксперимент, в котором два или более варианта страницы демонстрируются пользователям случайным образом, а статистический анализ используется для определения того, какой вариант лучше подходит для данной цели конверсии.

A/B-тестирование — это, по сути, эксперимент, в котором два или более варианта страницы демонстрируются пользователям случайным образом, а статистический анализ используется для определения того, какой вариант лучше подходит для данной цели конверсии.

Запуск A/B-теста, который напрямую сравнивает вариант с текущим опытом, позволяет вам задавать конкретные вопросы об изменениях на вашем веб-сайте или в приложении, а затем собирать данные о влиянии этих изменений.

Тестирование избавляет от догадок при оптимизации веб-сайта и позволяет принимать решения на основе данных, которые переводят деловые разговоры с «мы думаем» на «мы знаем». Измеряя влияние изменений на ваши показатели, вы можете убедиться, что каждое изменение приводит к положительным результатам.

Как работает A/B-тестирование

В A/B-тестировании вы берете веб-страницу или экран приложения и модифицируете его, чтобы создать вторую версию той же страницы. Это изменение может быть таким же простым, как один заголовок, кнопка или полная переделка страницы. Затем половине вашего трафика показывается исходная версия страницы (известная как контрольная или A), а половине — измененная версия страницы (вариант или B).

Затем половине вашего трафика показывается исходная версия страницы (известная как контрольная или A), а половине — измененная версия страницы (вариант или B).

По мере того, как посетители получают либо контрольную, либо вариативную версию, их взаимодействие с каждым опытом измеряется и собирается на информационной панели, а затем анализируется с помощью статистического механизма. Затем вы можете определить, имело ли изменение опыта (вариация или Б) положительный, отрицательный или нейтральный эффект по сравнению с базовым уровнем (контроль или А).

Зачем вам A/B-тестирование

A/B-тестирование позволяет отдельным лицам, командам и компаниям вносить осторожные изменения в свой пользовательский опыт, одновременно собирая данные о влиянии, которое оно оказывает. Это позволяет им строить гипотезы и узнавать, какие элементы и оптимизации их опыта больше всего влияют на поведение пользователей. С другой стороны, можно доказать их неправоту — их мнение о наилучшем опыте для данной цели может быть доказано ошибочным с помощью A/B-тестирования.

A/B-тестирование может использоваться не только для ответа на разовый вопрос или разрешения разногласий, но и для постоянного улучшения определенного опыта или улучшения одной цели, например оптимизации коэффициента конверсии (CRO) с течением времени.

Технологическая компания B2B может захотеть улучшить качество и объем потенциальных клиентов с помощью целевых страниц кампании. Для достижения этой цели команда попробует провести A/B-тестирование изменений в заголовке, строке темы, полях формы, призыве к действию и общем макете страницы, чтобы оптимизировать для снижения показателя отказов, увеличения количества конверсий и потенциальных клиентов и улучшения показатель кликабельности.

Тестирование одного изменения за раз помогает определить, какие изменения повлияли на поведение посетителей, а какие нет. Со временем они могут объединить эффект нескольких выигрышных изменений из экспериментов, чтобы продемонстрировать измеримое улучшение нового опыта по сравнению со старым.

Этот метод внесения изменений в взаимодействие с пользователем также позволяет оптимизировать взаимодействие для достижения желаемого результата и может сделать важные этапы маркетинговой кампании более эффективными.

Тестируя текст объявления, маркетологи могут узнать, какие варианты привлекают больше кликов. Тестируя следующую целевую страницу, они могут узнать, какой макет лучше всего конвертирует посетителей в клиентов. Общие расходы на маркетинговую кампанию можно реально уменьшить, если элементы каждого шага работают максимально эффективно для привлечения новых клиентов.

A/B-тестирование также может использоваться разработчиками и дизайнерами продуктов для демонстрации влияния новых функций или изменений на взаимодействие с пользователем. Адаптация продукта, взаимодействие с пользователем, модальные окна и взаимодействие с продуктом — все это можно оптимизировать с помощью A/B-тестирования, если цели четко определены и у вас есть четкая гипотеза.

Процесс A/B-тестирования

Ниже представлена структура A/B-тестирования, которую можно использовать для запуска тестов:

Собрать данные: Ваш аналитический инструмент (например, Google Analytics) часто дает представление о том, с чего начать оптимизацию. Это помогает начать с областей с высокой посещаемостью вашего сайта или приложения, чтобы вы могли быстрее собирать данные. Для оптимизации коэффициента конверсии обязательно ищите страницы с высоким показателем отказов или отказов, которые можно улучшить. Также обращайтесь к другим источникам, таким как тепловые карты, социальные сети и опросы, чтобы найти новые области для улучшения.

Определение целей: Цели конверсии — это показатели, которые вы используете, чтобы определить, является ли вариант более успешным, чем исходная версия. Цели могут быть любыми: от нажатия кнопки или ссылки до покупки продукта.

Создание тестовой гипотезы: После того, как вы определили цель, вы можете начать генерировать идеи A/B-тестирования и проверять гипотезы, почему вы думаете, что они будут лучше, чем текущая версия.

Когда у вас есть список идей, определите их приоритетность с точки зрения ожидаемого воздействия и сложности реализации.

Когда у вас есть список идей, определите их приоритетность с точки зрения ожидаемого воздействия и сложности реализации.Создайте различные варианты: С помощью программного обеспечения для A/B-тестирования (например, Optimizely Experiment) внесите необходимые изменения в элемент своего веб-сайта или мобильного приложения. Это может быть изменение цвета кнопки, изменение порядка элементов в шаблоне страницы, скрытие элементов навигации или что-то совершенно индивидуальное. Многие ведущие инструменты A/B-тестирования имеют визуальный редактор, который упрощает эти изменения. Обязательно протестируйте свой эксперимент, чтобы убедиться, что разные версии соответствуют ожиданиям.

Запустите эксперимент: Начните свой эксперимент и дождитесь участия посетителей! На этом этапе посетители вашего сайта или приложения будут случайным образом распределены либо по элементу управления, либо по варианту вашего опыта. Их взаимодействие с каждым опытом измеряется, подсчитывается и сравнивается с базовым уровнем, чтобы определить, как работает каждый.

Дождитесь результатов теста: В зависимости от размера вашей выборки (целевой аудитории) получение удовлетворительного результата может занять некоторое время. Хорошие результаты эксперимента подскажут вам, когда результаты статистически значимы и заслуживают доверия. В противном случае было бы трудно сказать, действительно ли ваше изменение оказало влияние.

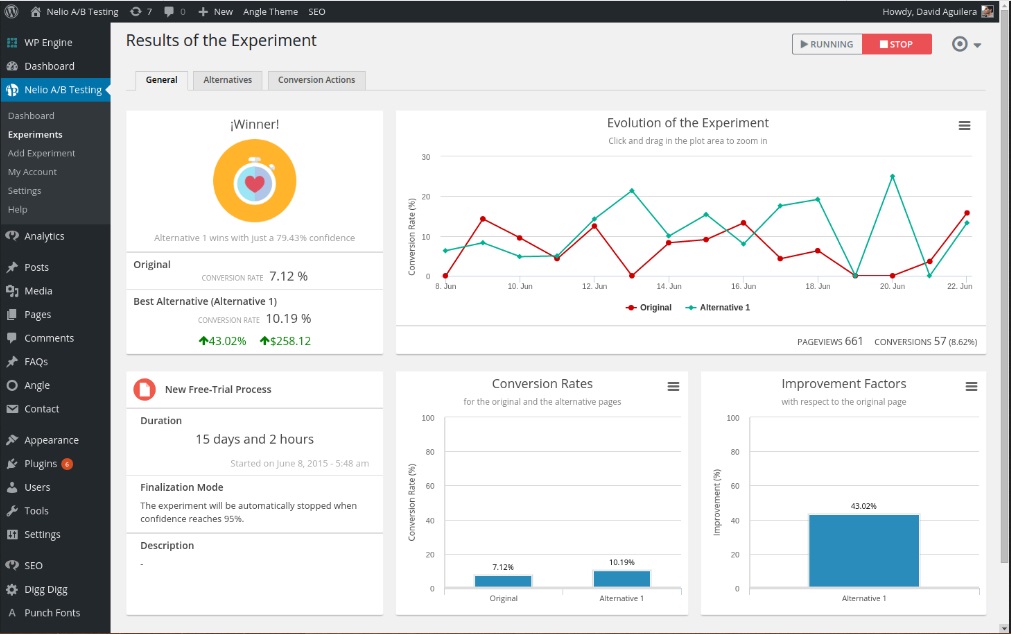

- Анализ результатов: После завершения эксперимента пришло время проанализировать результаты. Ваше программное обеспечение для A/B-тестирования представит данные эксперимента и покажет вам разницу между эффективностью двух версий вашей страницы и наличием статистически значимой разницы. Важно получить статистически значимые результаты, чтобы вы были уверены в результате теста.

Если ваш вариант выиграл, поздравляем 🎉! Посмотрите, сможете ли вы применить результаты эксперимента на других страницах вашего сайта, и продолжайте повторять эксперимент, чтобы улучшить свои результаты. Если ваш эксперимент дал отрицательный результат или не дал никакого результата, не волнуйтесь. Используйте эксперимент как опыт обучения и сформулируйте новую гипотезу, которую вы сможете проверить.

Если ваш эксперимент дал отрицательный результат или не дал никакого результата, не волнуйтесь. Используйте эксперимент как опыт обучения и сформулируйте новую гипотезу, которую вы сможете проверить.

Каким бы ни был результат вашего эксперимента, используйте свой опыт для информирования будущих тестов и постоянно оптимизируйте работу своего приложения или сайта.

Результаты A/B-тестирования

В зависимости от типа веб-сайта или приложения, которое вы тестируете, цели будут различаться. Например, розничный веб-сайт будет проводить больше тестов для оптимизации покупок, тогда как веб-сайт B2B может проводить больше экспериментов для оптимизации потенциальных клиентов.

Это также означает, что ваши результаты будут выглядеть по-разному в зависимости от типа вашего сайта или приложения. Как правило, цели устанавливаются перед началом A/B-тестирования и оцениваются в конце. Некоторые инструменты A/B-тестирования позволяют вам просматривать результаты в режиме реального времени по мере их поступления или изменять цели ваших тестов после завершения эксперимента.

Панель результатов тестирования показывает 2 (или более) варианта, их соответствующую аудиторию и достижение цели. Допустим, вы оптимизируете клики по призыву к действию (CTA) на веб-сайте, типичный просмотр будет содержать посетителей и клики, а также коэффициент конверсии — процент посетителей, которые привели к конверсии.

Сегментация A/B-тестов

Крупные сайты и приложения часто используют сегментацию для своих A/B-тестов. Если количество посетителей достаточно велико, это ценный способ проверить изменения для определенных групп посетителей. Обычный сегмент, используемый для A/B-тестирования, — разделение новых посетителей и постоянных посетителей. Это позволяет тестировать изменения в элементах, которые применяются только для новых посетителей, таких как формы регистрации.

С другой стороны, распространенная ошибка A/B-тестирования заключается в том, что для тестов создается слишком маленькая аудитория. Поэтому может потребоваться много времени, чтобы получить статистически значимые результаты и сказать, какое влияние ваше изменение оказало на конкретных посетителей веб-сайта. Поэтому важно проверить, насколько велики ваши сегменты, прежде чем начинать эксперимент, чтобы предотвратить ложные срабатывания.

Поэтому важно проверить, насколько велики ваши сегменты, прежде чем начинать эксперимент, чтобы предотвратить ложные срабатывания.

A/B-тестирование и SEO

Google разрешает и поощряет A/B-тестирование и заявляет, что выполнение A/B-тестирования или многовариантного тестирования не представляет неотъемлемого риска для поискового рейтинга вашего сайта. Однако можно поставить под угрозу ваш поисковый рейтинг, злоупотребив инструментом A/B-тестирования в таких целях, как маскировка. Google сформулировал некоторые рекомендации, чтобы этого не произошло:

Нет маскировки: Маскировка — это практика показа поисковым системам контента, отличного от того, который мог бы увидеть обычный посетитель. Маскировка может привести к тому, что ваш сайт будет понижен или даже удален из результатов поиска. Чтобы предотвратить маскировку, не злоупотребляйте сегментацией посетителей, чтобы отображать другой контент для робота Googlebot на основе пользовательского агента или IP-адреса.

Используйте rel=»canonical»: Если вы запускаете сплит-тест с несколькими URL-адресами, вы должны использовать атрибут rel=»canonical», чтобы указать варианты на исходную версию страницы. Это поможет роботу Googlebot не запутаться в нескольких версиях одной и той же страницы.

Используйте перенаправления 302 вместо 301: Если вы запускаете тест, который перенаправляет исходный URL-адрес на альтернативный URL-адрес, используйте перенаправление 302 (временное) вместо перенаправления 301 (постоянное). Это сообщает поисковым системам, таким как Google, что перенаправление является временным и что они должны оставить в индексе исходный URL-адрес, а не тестовый URL-адрес.

Медиа-компания может захотеть увеличить количество читателей, увеличить количество времени, которое читатели проводят на своем сайте, и расширить свои статьи с помощью социальных сетей. Для достижения этих целей они могут тестировать варианты:

- Модальные формы регистрации по электронной почте

- Рекомендуемое содержимое

- Кнопки социальных сетей

Туристическая компания может захотеть увеличить количество успешных бронирований, выполненных на своем веб-сайте или в мобильном приложении, или увеличить доход от дополнительных покупок. Чтобы улучшить эти показатели, они могут протестировать следующие варианты:

Чтобы улучшить эти показатели, они могут протестировать следующие варианты:

- Модальные окна поиска на главной странице

- Страница результатов поиска

- Презентация вспомогательного продукта

Компания электронной коммерции может захотеть улучшить качество обслуживания клиентов, что приведет к увеличению количества завершенных касс, средней стоимости заказа или увеличению праздничных продаж. Для этого они могут провести A/B-тестирование:

- Рекламные акции на главной странице

- Элементы навигации

- Компоненты кассовой воронки

Технологическая компания может захотеть увеличить количество потенциальных клиентов для своего отдела продаж, увеличить количество пользователей с бесплатным пробным периодом или привлечь определенного типа покупателей. Они могут проверить:

- Поля формы для потенциальных клиентов

- Процедура регистрации бесплатной пробной версии

- Обмен сообщениями и призыв к действию на главной странице

Примеры A/B-тестирования

Эти тематические исследования A/B-тестирования показывают типы результатов, которые самые инновационные компании мира получили в результате A/B-тестирования с Optimizely Experiment:

Discovery A/B протестировал компоненты своих видеоплеер, чтобы участвовать в их телешоу «суперфанат». Результат? Увеличение вовлеченности видео на 6%.

Результат? Увеличение вовлеченности видео на 6%.

15 шагов для идеального сплит-теста

Когда такие маркетологи, как мы, создают целевые страницы, пишут сообщения электронной почты или разрабатывают кнопки с призывом к действию, может возникнуть соблазн использовать нашу интуицию, чтобы предсказать, что заставит людей нажать и подключиться.

Однако гораздо лучше проводить A/B-тестирование, чем основывать маркетинговые решения на «чувствах», так как это может отрицательно сказаться на ваших результатах.

Продолжайте читать, чтобы узнать, как проводить весь процесс A/B-тестирования до, во время и после сбора данных, чтобы вы могли принимать наилучшие решения на основе полученных результатов.

Что такое A/B-тестирование?

A/B-тестирование в маркетинге

Как проводить A/B-тестирование

Примеры A/B-тестирования

Что такое A/B-тестирование?

A/B-тестирование, также известное как сплит-тестирование, представляет собой маркетинговый эксперимент, в ходе которого вы разделяете свою аудиторию, чтобы протестировать несколько вариантов кампании и определить, какие из них работают лучше. Другими словами, вы можете показать версию А маркетингового контента одной половине аудитории, а версию Б — другой.

Другими словами, вы можете показать версию А маркетингового контента одной половине аудитории, а версию Б — другой.

A/B-тестирование может быть полезным, потому что разные аудитории ведут себя по-разному. То, что работает для одной компании, может не сработать для другой. На самом деле, эксперты по оптимизации коэффициента конверсии (CRO) ненавидят термин «лучшие практики», потому что на самом деле это может не быть лучшей практикой для вас . Но такое тестирование может быть сложным, если вы не будете осторожны.

Давайте рассмотрим, как работает A/B-тестирование, чтобы убедиться, что вы не делаете неверных предположений о том, что нравится вашей аудитории.

Как работает A/B-тестирование?

Чтобы запустить A/B-тест, вам нужно создать две разные версии одного фрагмента контента с изменениями одной переменной . Затем вы покажете эти две версии двум аудиториям одинакового размера и проанализируете, какая из них работала лучше в течение определенного периода времени (достаточно долгого, чтобы сделать точные выводы о ваших результатах).

Источник изображения

A/B-тестирование помогает маркетологам наблюдать, как одна версия маркетингового контента работает по сравнению с другой. Вот два типа A/B-тестов, которые вы можете провести, чтобы повысить коэффициент конверсии вашего веб-сайта:

Пример 1: Тест взаимодействия с пользователем

Возможно, вы хотите проверить, улучшит ли перемещение определенной кнопки с призывом к действию (CTA) вверху главной страницы вместо того, чтобы оставить ее на боковой панели, рейтинг кликов.

Для A/B-тестирования этой теории вы должны создать еще одну альтернативную веб-страницу, использующую новое размещение CTA. Существующий дизайн с боковой панелью CTA — или « control » — это версия A. Версия B с CTA вверху — это « претендент ». Затем вы должны протестировать эти две версии, показав каждую из них заранее определенному проценту посетителей сайта. В идеале процент посетителей, увидевших любую версию, одинаков.

Узнайте, как легко провести A/B-тестирование компонента вашего веб-сайта с помощью Marketing Hub HubSpot.

Пример 2. Тестирование дизайна

Возможно, вы хотите узнать, может ли изменение цвета кнопки призыва к действию (CTA) повысить ее рейтинг кликов.

Для A/B-тестирования этой теории вы должны разработать альтернативную кнопку CTA с другим цветом кнопки, которая ведет на ту же целевую страницу , что и элемент управления. Если вы обычно используете красную кнопку призыва к действию в своем маркетинговом контенте, а зеленый вариант получает больше кликов после вашего A/B-теста, возможно, стоит изменить цвет кнопок призыва к действию по умолчанию на зеленый с этого момента. на.

Чтобы узнать больше об A/B-тестировании, загрузите наше бесплатное вводное руководство здесь.

A/B-тестирование в маркетинге

A/B-тестирование имеет множество преимуществ для маркетинговой команды в зависимости от того, что именно вы решили протестировать. Однако, прежде всего, эти тесты ценны для бизнеса, потому что они дешевы, но приносят большую прибыль.

Однако, прежде всего, эти тесты ценны для бизнеса, потому что они дешевы, но приносят большую прибыль.

Допустим, вы нанимаете создателя контента с зарплатой 50 000 долларов в год. Этот создатель контента публикует пять статей в неделю для блога компании, всего 260 статей в год. Если средний пост в блоге компании генерирует 10 лидов, вы можете сказать, что он стоит чуть более 19 долларов.2, чтобы привлечь 10 потенциальных клиентов для бизнеса (зарплата 50 000 долларов США ÷ 260 статей = 192 доллара США за статью). Это солидный кусок изменений.

Теперь, если вы попросите этого создателя контента потратить два дня на разработку A/B-теста для одной статьи вместо написания двух статей за этот период времени, вы можете потерять 192 доллара, потому что публикуете на одну статью меньше. . Но если этот A/B-тест обнаружит, что вы можете увеличить коэффициент конверсии каждой статьи с 10 до 20 потенциальных клиентов, вы только что потратили 192 доллара, чтобы потенциально удвоить количество клиентов, которых ваш бизнес получает от своего блога.

Если тест не пройден, вы, конечно, потеряли 192 доллара, но теперь вы можете сделать свой следующий A/B-тест еще более информативным. Если этот второй тест удвоит коэффициент конверсии вашего блога, вы в конечном итоге потратите 384 доллара, чтобы потенциально удвоить доход своей компании. Независимо от того, сколько раз ваш A/B-тест терпит неудачу, его конечный успех почти всегда перевешивает затраты на его проведение.

Избранный ресурс

Полный комплект A/B-тестирования для маркетологов

Заполните эту форму, чтобы получить комплект.

Существует множество типов сплит-тестов, которые вы можете запустить, чтобы в конечном итоге эксперимент стоил того. Вот некоторые общие цели, которые маркетологи ставят перед своим бизнесом при A/B-тестировании:

- Увеличение посещаемости веб-сайта: Тестирование различных заголовков сообщений в блогах или заголовков веб-страниц может изменить количество людей, которые нажимают на заголовок с гиперссылкой, чтобы попасть на ваш сайт.

. В результате это может увеличить посещаемость сайта.

. В результате это может увеличить посещаемость сайта. - Более высокий коэффициент конверсии: Тестирование различных мест, цветов или даже якорного текста на ваших CTA может изменить количество людей, которые нажимают на эти CTA, чтобы попасть на целевую страницу. Это может увеличить количество людей, которые заполняют формы на вашем веб-сайте, отправляют вам свои контактные данные и «конвертируют» их в потенциальных клиентов.

- Более низкий показатель отказов: Если посетители вашего веб-сайта быстро покидают его (или «уходят») после посещения вашего веб-сайта, тестирование различных вводных статей в блогах, шрифтов или рекомендуемых изображений может снизить этот показатель отказов и удержать больше посетителей.

- Нижняя корзина Брошенные: В компаниях электронной коммерции в среднем 70% клиентов покидают свой веб-сайт с товарами в корзине. Это известно как «брошенная корзина» и, конечно же, наносит ущерб любому интернет-магазину.

Тестирование различных фотографий продуктов, дизайнов страниц оформления заказа и даже отображения стоимости доставки может снизить этот показатель отказов.

Тестирование различных фотографий продуктов, дизайнов страниц оформления заказа и даже отображения стоимости доставки может снизить этот показатель отказов.

Теперь давайте пройдемся по контрольному списку для настройки, запуска и измерения A/B-тестирования.

Как проводить A/B-тестирование

Воспользуйтесь нашим бесплатным комплектом для A/B-тестирования со всем необходимым для проведения A/B-тестирования, включая шаблон отслеживания тестирования, практическое руководство для получения инструкций и вдохновения, и калькулятор статистической значимости, чтобы увидеть, были ли ваши тесты выигрышными, проигрышными или безрезультатными.

До A/B-тестирования

Давайте рассмотрим шаги, которые необходимо предпринять перед началом A/B-тестирования.

1. Выберите одну переменную для тестирования.

При оптимизации веб-страниц и электронной почты вы можете обнаружить ряд переменных, которые необходимо протестировать. Но чтобы оценить, насколько эффективно изменение, вам нужно выделить одну « независимую переменную » и измерить ее эффективность. В противном случае вы не можете быть уверены, какая именно переменная отвечает за изменение производительности.

Но чтобы оценить, насколько эффективно изменение, вам нужно выделить одну « независимую переменную » и измерить ее эффективность. В противном случае вы не можете быть уверены, какая именно переменная отвечает за изменение производительности.

Вы можете протестировать более одной переменной для одной веб-страницы или электронной почты — просто убедитесь, что вы тестируете их по одной за раз.

Чтобы определить свою переменную, просмотрите элементы в ваших маркетинговых ресурсах и их возможные альтернативы по дизайну, формулировкам и макету. Другие вещи, которые вы можете протестировать, включают строки темы электронной почты, имена отправителей и различные способы персонализации ваших электронных писем.

Имейте в виду, что даже простые изменения, такие как изменение изображения в сообщении электронной почты или слов на кнопке с призывом к действию, могут привести к значительным улучшениям. На самом деле такие изменения обычно легче измерить, чем более крупные.

Примечание: В некоторых случаях имеет смысл протестировать несколько переменных, а не одну переменную. Этот процесс называется многовариантным тестированием. Если вам интересно, следует ли вам запускать тест A/B или многовариантный тест, вот полезная статья от Optimizely, в которой сравниваются два процесса.

2. Определите свою цель.

Несмотря на то, что вы будете измерять несколько метрик во время любого теста, выберите основную метрику, чтобы сосредоточиться на до вы запускаете тест. На самом деле, сделайте это еще до того, как настроите второй вариант. Это ваша «зависимая переменная », которая изменяется в зависимости от того, как вы манипулируете независимой переменной.

Подумайте, где вы хотите, чтобы эта зависимая переменная находилась в конце сплит-теста. Вы можете даже сформулировать официальную гипотезу и изучить свои результаты, основанные на этом прогнозе.

Если вы отложите решение вопроса о том, какие показатели важны для вас, каковы ваши цели и как предлагаемые вами изменения могут повлиять на поведение пользователей, возможно, вы не настроите тест наиболее эффективным образом.

3. Создайте «контроль» и «претендент».

Теперь у вас есть независимая переменная, зависимая переменная и желаемый результат. Используйте эту информацию, чтобы настроить неизмененную версию того, что вы тестируете, в качестве сценария управления. Если вы тестируете веб-страницу, это неизмененная страница, поскольку она уже существует. Если вы тестируете целевую страницу, это будет дизайн и текст целевой страницы, которые вы обычно используете.

Оттуда создайте претендента — измененный веб-сайт, целевую страницу или электронную почту, которые вы будете тестировать против своего контроля. Например, если вам интересно, повлияет ли добавление отзыва на целевую страницу на конверсию, настройте контрольную страницу без отзывов. Затем создайте своего претендента с отзывом.

4. Разделите группы образцов поровну и случайным образом.

Для тестов, в которых у вас есть больший контроль над аудиторией — например, с электронными письмами — вам нужно протестировать две или более равных аудиторий, чтобы получить окончательные результаты.

То, как вы это сделаете, зависит от используемого вами инструмента A/B-тестирования. Например, если вы являетесь клиентом HubSpot Enterprise и проводите A/B-тестирование электронной почты, HubSpot автоматически разделит трафик на ваши варианты, чтобы каждый вариант получал случайную выборку посетителей.

5. Определите объем выборки (если применимо).

То, как вы определяете размер выборки, также зависит от вашего инструмента A/B-тестирования, а также от типа проводимого вами A/B-тестирования.

Если вы проводите A/B-тестирование электронной почты, вы, вероятно, захотите отправить A/B-тестирование подмножеству вашего списка, достаточно большому для получения статистически значимых результатов. В конце концов, вы выберете победителя и отправите выигрышный вариант остальным участникам списка. (Подробнее о расчете размера выборки см. в электронной книге «Наука о сплит-тестировании» в конце этой статьи.)

Если вы являетесь клиентом HubSpot Enterprise, вам может помочь определить размер группы выборки с помощью ползунка. Это позволит вам провести A/B-тестирование 50/50 для любого размера выборки, хотя для всех других выборок требуется список не менее 1000 получателей.

Это позволит вам провести A/B-тестирование 50/50 для любого размера выборки, хотя для всех других выборок требуется список не менее 1000 получателей.

Если вы тестируете что-то, что не имеет ограниченную аудиторию, например, веб-страницу, то то, как долго вы будете выполнять тест, напрямую повлияет на размер вашей выборки. Вам нужно, чтобы ваш тест работал достаточно долго, чтобы получить значительное количество просмотров. В противном случае будет трудно сказать, была ли статистически значимая разница между вариациями.

6. Решите, насколько значительными должны быть ваши результаты.

После того, как вы выбрали целевую метрику, подумайте, насколько значительными должны быть ваши результаты, чтобы оправдать выбор одного варианта над другим. Статистическая значимость — очень важная часть процесса A/B-тестирования, которую часто неправильно понимают. Если вам нужно освежить знания, я рекомендую прочитать этот пост в блоге о статистической значимости с точки зрения маркетинга.

Чем выше процент вашего уровня уверенности, тем больше вы можете быть уверены в своих результатах. В большинстве случаев вам понадобится уровень достоверности 9.Минимум 5%, а лучше даже 98%, особенно если на настройку эксперимента ушло много времени. Однако иногда имеет смысл использовать более низкий уровень достоверности, если вам не нужно, чтобы тест был таким строгим.

Мэтт Реулт, старший инженер-программист HubSpot, любит думать о статистической значимости как о размещении ставки. На какие коэффициенты вам удобно делать ставки? Сказать «Я на 80% уверен, что это правильный дизайн, и я готов поставить на него все» — это все равно, что провести A/B-тестирование до значимости 80%, а затем объявить победителя.

Rheault также говорит, что вам, вероятно, понадобится более высокий порог достоверности при тестировании чего-то, что лишь немного повышает коэффициент конверсии. Почему? Потому что случайная дисперсия, скорее всего, сыграет большую роль.

«Примером, когда мы могли бы чувствовать себя в большей безопасности, снизив порог достоверности, является эксперимент, который, вероятно, повысит коэффициент конверсии на 10% или более, например, переработанный главный раздел», — пояснил он.

«Вывод из этого таков: чем радикальнее изменение, тем менее научным он должен быть в отношении процесса. Чем более конкретным является изменение (цвет кнопки, микрокопия и т. д.), тем более научным мы должны быть, потому что изменение с меньшей вероятностью окажет большое и заметное влияние на коэффициент конверсии».

7. Убедитесь, что вы запускаете только один тест за раз в любой кампании.

Тестирование нескольких вещей для одной кампании, даже если они не относятся к одному и тому же активу, может усложнить результаты. Например, если вы проводите A/B-тестирование кампании по электронной почте, которая ведет на целевую страницу, одновременно с A/B-тестированием этой целевой страницы, как узнать, какое изменение вызвало увеличение числа лидов?

Во время A/B-тестирования

Давайте рассмотрим шаги, которые нужно предпринять во время A/B-тестирования.

8. Используйте инструмент A/B-тестирования.

Чтобы провести A/B-тестирование на своем веб-сайте или в электронном письме, вам потребуется инструмент для A/B-тестирования. Если вы являетесь клиентом HubSpot Enterprise, программное обеспечение HubSpot имеет функции, которые позволяют проводить A/B-тестирование электронных писем (узнайте, как здесь), призывов к действию (узнайте, как здесь) и целевых страниц (узнайте, как здесь).

Если вы являетесь клиентом HubSpot Enterprise, программное обеспечение HubSpot имеет функции, которые позволяют проводить A/B-тестирование электронных писем (узнайте, как здесь), призывов к действию (узнайте, как здесь) и целевых страниц (узнайте, как здесь).

Для клиентов, не являющихся пользователями HubSpot Enterprise, другие варианты включают Google Analytics, который позволяет проводить A/B-тестирование до 10 полных версий одной веб-страницы и сравнивать их эффективность с использованием случайной выборки пользователей.

9. Протестируйте оба варианта одновременно.

Время играет важную роль в результатах вашей маркетинговой кампании, будь то время суток, день недели или месяц года. Если бы вы запускали версию A в течение одного месяца, а версию B — через месяц, как бы вы узнали, вызвано ли изменение производительности другим дизайном или другим месяцем?

При выполнении A/B-тестов вам нужно будет запускать два варианта одновременно, иначе вы можете сомневаться в своих результатах.

Единственным исключением здесь является случай, когда вы проверяете само время, например, находите оптимальное время для отправки электронных писем. Это отличная вещь для тестирования, потому что в зависимости от того, что предлагает ваш бизнес и кто ваши подписчики, оптимальное время для взаимодействия с подписчиками может значительно различаться в зависимости от отрасли и целевого рынка.

10. Дайте тесту A/B достаточно времени, чтобы получить полезные данные.

Опять же, вы должны убедиться, что ваш тест выполняется достаточно долго, чтобы получить существенный размер выборки. В противном случае будет трудно сказать, была ли статистически значимая разница между двумя вариантами.

Сколько времени хватит? В зависимости от вашей компании и того, как вы проводите A/B-тестирование, получение статистически значимых результатов может занять часы… или дни… или недели. Большая часть того, сколько времени требуется для получения статистически значимых результатов, зависит от того, сколько трафика вы получаете, поэтому, если ваш бизнес не получает много трафика на ваш веб-сайт, вам потребуется гораздо больше времени для запуска A / B. тест.

тест.

Прочтите этот пост в блоге, чтобы узнать больше о размере выборки и сроках.

11. Спросите отзывы у реальных пользователей.

A/B-тестирование во многом связано с количественными данными… но это не обязательно поможет вам понять , почему люди предпочтут одни действия другим. Пока вы проводите A/B-тестирование, почему бы не собрать качественную обратную связь от реальных пользователей?

Один из лучших способов узнать мнение людей — это опрос или опрос. Вы можете добавить на свой сайт выходной опрос, который спрашивает посетителей, почему они не нажали на определенный CTA, или на страницы благодарности, который спрашивает посетителей, почему они нажали кнопку или заполнили форму.

Например, вы можете обнаружить, что многие люди нажимают на призыв к действию, который приводит их к электронной книге, но как только они видят цену, они не конвертируются. Такая информация даст вам понимание того, почему ваши пользователи ведут себя определенным образом.

После A/B-тестирования

Наконец, давайте рассмотрим шаги, которые нужно предпринять после A/B-тестирования.

12. Сосредоточьтесь на целевом показателе.

Опять же, несмотря на то, что вы будете измерять несколько показателей, сосредоточьтесь на основном показателе цели при проведении анализа.

Например, если вы протестировали два варианта электронного письма и выбрали потенциальных клиентов в качестве основного показателя, не зацикливайтесь на коэффициенте открытия или рейтинге кликов. Вы можете увидеть высокий рейтинг кликов и низкие коэффициенты конверсии, и в этом случае вы можете в конечном итоге выбрать вариант с более низким рейтингом кликов.

13. Измерьте значимость ваших результатов с помощью нашего калькулятора A/B-тестирования.

Теперь, когда вы определили, какой вариант работает лучше всего, пришло время определить, являются ли ваши результаты статистически значимыми. Другими словами, достаточно ли их, чтобы оправдать изменение?

Чтобы это выяснить, вам нужно провести тест на статистическую значимость. Вы можете сделать это вручную… или просто ввести результаты своего эксперимента в наш бесплатный калькулятор A/B-тестирования.

Вы можете сделать это вручную… или просто ввести результаты своего эксперимента в наш бесплатный калькулятор A/B-тестирования.

Для каждого протестированного вами варианта вам будет предложено ввести общее количество попыток, например количество отправленных электронных писем или просмотренных показов. Затем введите количество достигнутых целей — обычно вы смотрите на клики, но это могут быть и другие типы конверсий.

Калькулятор выдаст уровень достоверности ваших данных для выигрышного варианта. Затем измерьте это число по сравнению со значением, которое вы выбрали для определения статистической значимости.

14. Примите меры на основе ваших результатов.

Если один вариант статистически лучше другого, вы выиграли. Завершите тест, отключив проигрышный вариант в инструменте A/B-тестирования.

Если ни один из вариантов статистически не лучше, вы только что узнали, что тестируемая вами переменная не повлияла на результаты, и вам придется пометить тест как неубедительный. В этом случае придерживайтесь исходного варианта или проведите еще один тест. Вы можете использовать неудачные данные, чтобы помочь вам определить новую итерацию вашего нового теста.

В этом случае придерживайтесь исходного варианта или проведите еще один тест. Вы можете использовать неудачные данные, чтобы помочь вам определить новую итерацию вашего нового теста.

Хотя A/B-тесты помогают вам влиять на результаты в каждом конкретном случае, вы также можете применять уроки, извлеченные из каждого теста, и применять их в будущих усилиях.

Например, если вы проводили A/B-тестирование в своем маркетинге по электронной почте и неоднократно обнаруживали, что использование чисел в строках темы электронной почты повышает рейтинг кликов, вы можете рассмотреть возможность использования этой тактики в других своих электронных письмах.

15. Спланируйте следующее A/B-тестирование.

A/B-тест, который вы только что закончили, возможно, помог вам найти новый способ повысить эффективность маркетингового контента, но не останавливайтесь на достигнутом. Всегда есть место для большей оптимизации.

Вы даже можете попробовать провести A/B-тестирование другой функции той же веб-страницы или электронного письма, которое вы только что тестировали. Например, если вы только что протестировали заголовок на целевой странице, почему бы не провести новый тест на основном тексте? Или цветовая схема? Или изображения? Всегда следите за возможностями увеличить коэффициент конверсии и количество потенциальных клиентов.

Например, если вы только что протестировали заголовок на целевой странице, почему бы не провести новый тест на основном тексте? Или цветовая схема? Или изображения? Всегда следите за возможностями увеличить коэффициент конверсии и количество потенциальных клиентов.

Вы можете использовать комплект для отслеживания A/B-тестов HubSpot, чтобы планировать и организовывать свои эксперименты.

Загрузите этот шаблон сейчас

Как читать результаты A/B-тестирования

Как маркетолог вы знаете ценность автоматизации. Учитывая это, вы, вероятно, используете программное обеспечение, которое обрабатывает расчеты A/B-тестирования для вас — огромная помощь. Но после того, как расчеты сделаны, вам нужно знать, как читать ваши результаты. Давайте рассмотрим, как.

1. Проверьте показатель цели.

Первым шагом в чтении результатов вашего A/B-теста является просмотр вашего целевого показателя, которым обычно является коэффициент конверсии. После того, как вы введете свои результаты в калькулятор A/B-тестирования, вы получите два результата для каждой тестируемой версии. Вы также получите значительный результат для каждого из ваших вариантов.

Вы также получите значительный результат для каждого из ваших вариантов.

2. Сравните коэффициенты конверсии.

Глядя на свои результаты, вы, вероятно, сможете определить, работает ли один из вариантов лучше, чем другой. Однако истинный критерий успеха заключается в том, являются ли полученные результаты статистически значимыми. Это означает, что один вариант работал лучше, чем другой на значительном уровне, потому что, скажем, текст CTA был более привлекательным.

Допустим, вариант А имел коэффициент конверсии 16,04%, а вариант Б — 16,02%, и ваш доверительный интервал статистической значимости равен 9.5%. Вариант А имеет более высокий коэффициент конверсии, но результаты не являются статистически значимыми, а это означает, что вариант А не улучшит ваш общий коэффициент конверсии значительно.

3. Сегментируйте свою аудиторию для получения дополнительной информации.

Независимо от значимости, важно разбить результаты по сегментам аудитории, чтобы понять, как каждая ключевая область отреагировала на ваши варианты. Общие переменные для сегментирования аудитории:

Общие переменные для сегментирования аудитории:

- Тип посетителя или какая версия лучше всего работает для новых посетителей по сравнению с повторными посетителями.

- Тип устройства или версия, которая лучше всего работает на мобильных устройствах или на настольных компьютерах.

- Источник трафика или версия, которая показала наилучшие результаты в зависимости от источника трафика для ваших двух вариантов.

Давайте рассмотрим несколько примеров экспериментов A/B, которые вы можете провести для своего бизнеса.

Примеры A/B-тестирования

Мы обсудили, как A/B-тестирование используется в маркетинге и как его проводить, но как оно выглядит на практике?

Как вы могли догадаться, мы проводим множество A/B-тестов, чтобы увеличить вовлеченность и повысить конверсию на нашей платформе. Вот пять примеров A/B-тестов, которые вдохновят вас на собственные эксперименты.

1. Поиск по сайту

Панели поиска по сайту помогают пользователям быстро найти то, что им нужно на определенном веб-сайте. HubSpot обнаружил из предыдущего анализа, что посетители, которые взаимодействовали с панелью поиска на сайте, с большей вероятностью конвертировались в сообщения в блоге. Итак, мы провели A/B-тестирование, пытаясь увеличить взаимодействие с панелью поиска.

HubSpot обнаружил из предыдущего анализа, что посетители, которые взаимодействовали с панелью поиска на сайте, с большей вероятностью конвертировались в сообщения в блоге. Итак, мы провели A/B-тестирование, пытаясь увеличить взаимодействие с панелью поиска.

В этом тесте функциональность панели поиска была независимой переменной, а просмотры на странице с предложением контента — зависимой переменной. В эксперименте мы использовали одно контрольное условие и три контрольных условия.

В контрольном состоянии (вариант А) строка поиска осталась без изменений.

В варианте B панель поиска была увеличена и стала более заметной, а текст-заполнитель был установлен на «поиск по теме».

Вариант C был идентичен варианту B, но выполнялся поиск только в блоге HubSpot, а не на всем веб-сайте.

В варианте D панель поиска была увеличена, но текст заполнителя был установлен на «поиск в блоге». Этот вариант также выполнял поиск только в блоге HubSpot 9. 0006

0006

Вариант D оказался наиболее эффективным: он увеличил конверсию на 3,4% по сравнению с контролем и увеличил процент пользователей, которые использовали панель поиска, на 6,5%.

2. Мобильные CTA

HubSpot использует несколько CTA для предложений контента в сообщениях нашего блога, в том числе в тексте сообщений, а также внизу страницы. Мы тщательно тестируем эти CTA, чтобы оптимизировать их работу.

Для наших мобильных пользователей мы провели A/B-тест, чтобы определить, какой тип призыва к действию внизу страницы лучше всего конвертируется. Для нашей независимой переменной мы изменили дизайн панели CTA. В частности, в нашем тесте мы использовали один контрольный образец и три претендента. В качестве зависимых переменных мы использовали просмотры страниц на странице благодарности с призывом к действию и клики по призыву к действию.

Контрольное условие включало наше обычное размещение CTA внизу сообщений. В варианте B у CTA не было опций закрытия или минимизации.

В варианте C мобильные читатели могли закрыть CTA, коснувшись значка X. Как только он был закрыт, он больше не появлялся.

В вариант D мы включили возможность минимизировать CTA с помощью курсора вверх/вниз.

Наши тесты показали, что все варианты успешны. Вариант D оказался наиболее успешным, с увеличением конверсии на 14,6% по сравнению с контролем. За ним последовал вариант C с увеличением на 11,4% и вариант B с увеличением на 7,9%.% увеличивать.

3. Авторские призывы к действию

В ходе другого эксперимента HubSpot проверил, будет ли добавление слова «бесплатно» и другого описательного языка к авторским призывам к действию в верхней части постов в блоге увеличивать лиды контента. Прошлые исследования показали, что использование слова «бесплатно» в тексте призыва к действию приведет к увеличению числа конверсий, а текст с указанием типа предлагаемого контента будет полезен для SEO и доступности.

В тесте независимой переменной был текст CTA, а основной зависимой переменной был коэффициент конверсии в форме предложения контента.

В контрольном состоянии текст призыва к действию автора не изменился (см. оранжевую кнопку на изображении ниже).

В варианте Б к тексту СТА добавлено слово «бесплатно».

В варианте C в текст CTA в дополнение к «бесплатно» была добавлена описательная формулировка.

Интересно, что вариант B показал снижение количества отправленных форм на 14% по сравнению с контролем. Это было неожиданно, поскольку включение слова «бесплатно» в текст предложения контента считается лучшей практикой.

Между тем, отправка формы в варианте C превзошла контрольную на 4%. Был сделан вывод, что добавление описательного текста к призыву к действию автора помогло пользователям понять предложение и, таким образом, повысило вероятность их загрузки.

4. Содержание блога

Чтобы помочь пользователям лучше ориентироваться в блоге, HubSpot протестировал новый модуль содержания (TOC). Цель состояла в том, чтобы улучшить пользовательский опыт, предоставив читателям желаемый контент быстрее. Мы также проверили, повысит ли конверсию добавление CTA в этот модуль TOC.

Мы также проверили, повысит ли конверсию добавление CTA в этот модуль TOC.

Независимой переменной этого A/B-теста было включение и тип модуля TOC в сообщениях блога, а зависимыми переменными были коэффициент конверсии при отправке форм предложения контента и клики по CTA внутри модуля TOC.

Условие контроля не включало новый модуль оглавления — в контрольных постах либо не было оглавления, либо был простой маркированный список анкорных ссылок в теле поста вверху статьи (на фото ниже).

В варианте Б в записи блога добавлен новый модуль оглавления. Этот модуль был липким, то есть он оставался на экране, когда пользователи прокручивали страницу вниз. Вариант B также включал призыв к действию с предложением контента в нижней части модуля.

Вариант C включал модуль, идентичный варианту B, но с удаленным CTA.

Оба варианта B и C не увеличили конверсию постов в блогах. Условие контроля превзошло вариант B на 7% и работало так же, как вариант C. Кроме того, немногие пользователи взаимодействовали с новым модулем TOC или CTA внутри модуля.

Кроме того, немногие пользователи взаимодействовали с новым модулем TOC или CTA внутри модуля.

5. Уведомления об отзывах

Чтобы определить лучший способ сбора отзывов клиентов, мы провели сплит-тест уведомлений по электронной почте и уведомлений в приложении. Здесь независимой переменной был тип уведомления, а зависимой переменной — процент тех, кто оставил отзыв, от всех, кто открыл уведомление.

В элементе управления HubSpot отправил текстовое уведомление по электронной почте с просьбой оставить отзыв. В варианте B HubSpot отправлял электронное письмо с изображением сертификата, включая имя пользователя.

Для варианта C HubSpot отправил пользователям уведомление в приложении.

В конечном итоге оба письма работали одинаково и превосходили уведомления в приложении. Около 25% пользователей, открывших электронное письмо, оставили отзыв по сравнению с 10,3%, открывшими уведомления в приложении. Электронные письма также чаще открывались пользователями.

Когда у вас есть список идей, определите их приоритетность с точки зрения ожидаемого воздействия и сложности реализации.

Когда у вас есть список идей, определите их приоритетность с точки зрения ожидаемого воздействия и сложности реализации.

. В результате это может увеличить посещаемость сайта.

. В результате это может увеличить посещаемость сайта.