Что такое A/B test — Ringostat Blog

Кто не рискует, тот не пьет шампанское, а кто не экспериментирует — со временем теряет конверсию. Сегодня поговорим о методе, который позволяет проверять гипотезы и делает эксперименты над сайтом и рекламой безопасными. A/B тестирование активно используют Google, Amazon и eBay, чтобы становиться еще популярней. Читайте о возможностях метода и как правильно проводить тесты.

АБ Тест — что это?

А/В тесты — это маркетинговый метод, который позволяет сравнить эффективность двух вариантов какой-либо переменной. Например, цветовой гаммы в оформлении лендинга, заголовков объявления, размещения CTA-элементов и т. д.

Для проведения A/B тестирования аудитория разделяется на две группы. Первой показывают вариант А, второй —вариант B, а потом выбирают результат с лучшими показателями.

Представим ситуацию: у маркетолога есть гипотеза, что при изменении цветовой гаммы лендинга на голубую конверсия повысится. Но пользователи уже привыкли к старому оформлению, и это может навредить. Чтобы проверить гипотезу, одной части посетителей показывают контрольный вариант А — существующую версию лендинга. Другой части — вариант B, в голубой цветовой гамме. Спустя две недели оказывается, что пользователи из второй группы охотней заказывают товар. Теперь компания может смело менять дизайн.

Отличительная черта A/B тестирования — то, что с его помощью сравниваются только два варианта чего-либо. Например, вы хотите добавить на главную страницу видео, изменить ее заголовок и разместить отзыв покупателя. В таком случае уже будет сравниваться конверсия разных сочетаний этих элементов. Видео + старый заголовок + отзыв, без видео + новый заголовок + без отзыва и т. д. Такой метод называется мультивариантное тестирование (MVT).

Что может меняться на сайте:

- заголовок и подзаголовки;

- блоки с информацией;

- CTA-кнопки;

- форма регистрации;

- ссылки;

- формулировки;

- изображения и видео;

- отзывы и т. д.

Несмотря на кажущуюся простоту, A/B тестирование широко используется крупными компаниями. Так, в 2000 Google впервые провел подобный тест, чтобы выявить оптимальное количество результатов для страницы поисковой выдачи. Но даже у них во время первого теста произошел сбой из-за слишком долгой загрузки. Со временем технологии изменились, и уже в 2011 году Google успешно провел 7000+ A/B тестов.

Как проводится A/B test

- Сбор данных. Сначала необходимо собрать информацию о том, какие элементы нуждаются в улучшении. Например, страницы с низкой конверсией или высоким показателем отказов. В этом поможет Google Analytics или другие аналитические системы, которые отслеживают поведение пользователей. Например, Kissmetrics или К50.

- Определение целей. Подумайте, по каким показателям будете оценивать, что один вариант успешней, чем другой. Это может быть что угодно: оформление заявки, подписка на рассылку, нахождение на странице дольше заданного времени.

- Разработка гипотезы. Сформулируйте, почему новая версия должна работать лучше, чем старая. Например, будет больше звонков от клиентов, если разместить телефон вверху главной страницы, а не мелким шрифтом в футере, как в текущей версии сайта.

- Создание вариантов. Внесите изменение в сайт или приложение с помощью одного из специализированных сервисов. Например, измените цвет CTA-кнопки, порядок расположения блоков с информацией, скройте или добавьте элементы навигации.

- Запуск эксперимента. На этом этапе посетителям вашего сайта будет случайным образом показываться или А вариант, или B. Их взаимодействия с каждым из них измеряются, подсчитываются и сравниваются.

- Анализ результатов. Сервис предоставляет данные, как отработали оба варианта страницы. Тут важно учитывать, является ли разница статистически значимой. Для проверки этого можно использовать специальный калькулятор.

Аналогичные тесты также можно проводить для рассылок, меняя текст приветствия или элементы оформления. Результатом может стать такой отчет:

Источник: reachmail.zendesk.com

А/В тесты: преимущества

- Повышение конверсии. Зная, как пользователи взаимодействуют с вашим сайтом, рассылкой или рекламой, вы можете повысить ее эффективность. Для этого не придется вносить много изменений, достаточно внедрить тот вариант, который получил лучшие результаты.

- Принятие решений на основе четких данных. Тестирование превращает догадки в конкретные данные. Так вы не рискуете, внося изменения, а можете гарантированно получить хороший результат. Оно позволяет строить гипотезы и лучше узнать, что положительно влияет на продвижение пользователя к целевой конверсии.

- Соответствие предпочтениям аудитории. Цифровой мир постоянно меняется, поэтому оставаться на одном месте невозможно. Регулярно тестируя отдачу пользователей, вы будете не слепо следовать трендам, а адаптироваться под изменение вкусов аудитории. Так ваш сайт, рассылка, реклама будут по-настоящему актуальными и эффективными.

Советы по проведению A/B тестирования

- Начинайте с простого. Если вы ранее не проводили подобные тесты, лучше не замахиваться на что-то серьезное. Когда вы лучше поймете, как это работает, вы сможете проводить более сложные эксперименты.

- Различия между версиями А и B должны быть заметными. Если вы добавите одну запятую или мелкий элемент дизайна на странице «Контакты», этого никто не заметит.

- Не прекращайте тест раньше времени, даже если вам кажется, что одна из версий уже «победила». Так компания Distilled специально увеличила время тестирования в два, четыре и восемь раз дольше, чем планировалось. По их мнению, только в третьем случае они приблизились к 90%-ой достоверности данных. Но это не значит, что тест должен длиться бесконечно — завершайте его, как только достигните достаточного уровня статистической значимости.

- Правильно определяйте цели. Например, если интернет-магазин будет фокусироваться только на конверсии по добавлениям в корзину, он получит искаженные данные. Все просто — большинство людей предпочитает звонить, а не заполнять формы или молча покупать онлайн. И это справедливо для многих ниш бизнеса. Поэтому перед выбором целей сначала анализируйте свою воронку продаж.

- Следите. чтобы изменения дублировались на других страницах. Например, если вы тестируете разные варианты цены, замените ее всюду на сайте.

Для проведения A/B тестирования не обязательно быть программистом. Существует множество сервисов, которые предоставляют такую возможность. Например, конструкторы сайтов, сервисы динамической подмены контента и даже Google Marketing Platform. Преимущество в том, что интерфейс понятен, а результаты предоставляются в удобном виде.

Пример результатов A/B теста в интерфейсе сервиса Optimizely

Некоторые сервисы позволяют оценить эффективность вариантам не только по онлайн-конверсиям, но и по звонкам. Так Yagla, предназначенная для динамической подмены контента, интегрирована с Ringostat. При проведении тестов эта система может учитывать, сколько звонков поступило по вариантам A и B.

Источник: yagla.ru

Резюме

- A/B тестирование — это метод который позволяет сравнить две переменные и эффективность каждой из них. Например, можно добавить фото на главной странице и посмотреть, как она конвертируется с ним и без него.

- В процессе тестирования нужно четко определиться, что будет считаться целью: звонок, добавление в корзину, подписка на рассылку,

- A/B тестирование можно проводить без специальных знаний. Большинство сервисов, которые предоставляют такую функцию, делают этого процесс легким и понятным, а данные показываются в удобном формате.

- Подобное тестирование позволяет повысить конверсию, проверять гипотезы и проводить безопасные эксперименты.

Если вы нашли ошибку — выделите её и нажмите Ctrl + Enter или нажмите сюда.

Почему A/B-тесты уменьшают конверсию — опыт российской компании Driveback

В Driveback мы постоянно сталкиваемся с необходимостью проведения A/B-тестов для проверки тех или иных гипотез. На проведении многих A/B-тестов настаивают наши клиенты. Нередко мы тратим по несколько часов, чтобы объяснить, почему тот или иной тест делать абсолютно бессмысленно.

В своей практике мы крайне редко встречали маркетологов, которые бы до конца осознавали, как правильно делать A/B-тесты. Хуже того, большинство из них делают тесты абсолютно неправильно.

В этой статье мы постараемся показать, как неправильно проведенные A/B-тесты c виду могут показать превосходные результаты, которые, однако, будут всего лишь иллюзией успеха. В лучшем случаев, это приведет к бесполезным изменениям на сайте, и потере времени и денег. В худшем — к изменениям, которые в действительности могут повредить конверсии и прибыли.

Базовые понятия

Начать стоит прежде всего с базовых понятий, которые известны каждому математику, но забыты многими новоиспеченными специалистами по модному нынче A/B-тестированию.

Это такие понятия, как « статистическая мощность», «статистическая значимость», «множественные сравнения» и «регрессия». Понимая эти принципы вы сможете защититься от дезинформации и заблуждений, которые наводнили индустрию A/B-тестирования, и отличать иллюзорные результаты от реальных.

Статистическая мощность

Статистическая мощность — это всего-навсего вероятность (в процентах) того, что тест определит разницу между двумя вариантами, если эта разница действительно существует.

Предположим, вы хотите определить, есть ли разница между ростом женщин и мужчин. Если вы измерите всего лишь одну женщину и всего лишь одного мужчину, может оказаться так, что вы не заметите того факта, что мужчины выше женщин. Быть может вам попалась волейболистка и мужчина роста ниже среднего.

Однако, измерив достаточное количество разных мужчин и женщин, вы придете к выводу, что на самом деле мужчины выше. Все это потому, что статистическая мощность увеличивается при увеличении размера выборки.

Абсолютно таким же образом это работает и в применении к конве

Математика A/B тестирования | Статьи SEOnews

Простой способ ускорить A/B тестирование – улучшить распределение времени между тестами.

Простой способ ускорить A/B тестирование – улучшить распределение времени между тестами.В интернет-маркетинге, особенно при запуске стартапа, мы вынуждены проводить множество А/B тестов. Однако, математика, которую мы используем в A/B тестировании, не всегда адекватна нашим задачам.

Использование более адекватных методик тестирования не только сократит время, необходимое на тесты, но и снизит требования к матподготовке и более оптимально распределит время между между тестами.

Стандартный научный подход

Сейчас обычно используют методику тестирования, перекочевавшую в интернет-маркетинг из методики проведения научных экспериментов. Обычно ее называют стандартный научный подход проверки гипотез/теорий. Мы будем называть ее СНП.

Сама методика состоит в следующем:

- Выбираем гипотезу “Если мы поменяем цвет кнопки на красный, то конверсия улучится с 1% до 1.1%”.

- Выбираем нулевую гипотезу (альтернативу). “Смена цвета не улучшит конверсию (или вообще ухудшит).”

- Считаем число кликов, которые нужно чтобы доказать нашу гипотезу или нулевую гипотезу.

- Начинаем тест, случайным образом распределяя клики между двумя вариантами.

- Через определенное число кликов, мы оцениваем данные.

У нас может быть три исхода A/B теста:

- Гипотеза подтверждена – меняем цвет

- Гипотеза опровергнута – это не значит, что красный цвет хуже, это значит, что он дает меньше чем 1.1% конверсии.

- Ничего не понятно. Результаты не дают ни достоверного подтверждения, ни опровержения гипотезы.

Последний вариант самый интересный. Может показаться, что нужно еще подождать некоторое время, пока не станет что-то понятно. Но это не так. Нужно заново проводить тест и игнорировать старые данные.

Фундаментальная проблема СНП в том, что его цель – проверить какую-то гипотезу. Но мы проводим тесты не ради научного любопытства, а для улучшения конверсии. Это рождает целый ряд проблем:

- Мы сравниваем не варианты, а гипотезы. Хотя нам нужно выбрать вариант с лучшей конверсией.

- Сложность проведения, требования к подготовке экспериментатора.

- Мы не можем остановить тест, когда уже есть очевидный победитель. В этом случае мы бы проводили тесты быстрее и быстрее бы увеличили конверсию.

- Возможность исхода: “ничего не понятно”.

- А главное, на такой тест нужно просто астрономическое число кликов.

Число кликов

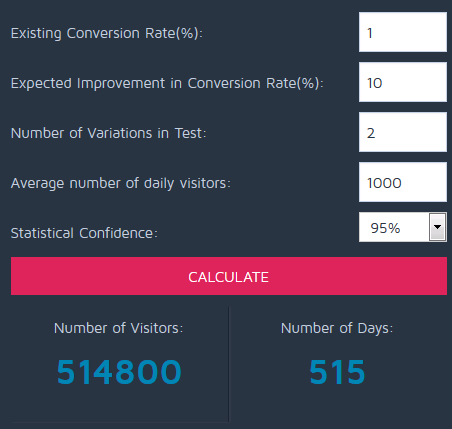

Допустим у нас есть сайт с 1000 кликов в день. Конверсия 1%, мы предполагаем, что смена цвета кнопки повысит конверсию до 1.1%. Гуглим “A/B test duration calculator” и все калькуляторы выдадут нам 515 дней. Почти 2 года.

Такие цифры получились из-за порядка цифр в интернет-маркетинге. Если мы повысим конверсию с 1% до 1.1%, то это хороший результат. А если мы изобретем лекарство, повышающее шанс выздороветь с 1% до 1.1%, то его никто не купит.

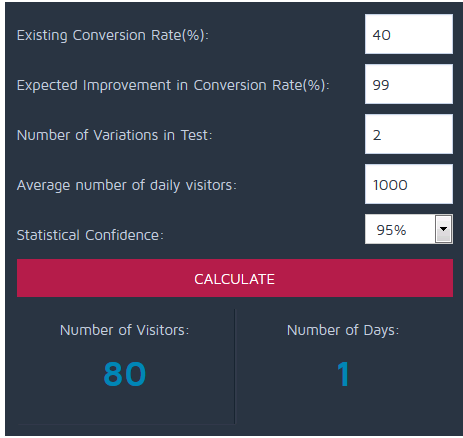

Допустим мы придумали лекарство, увеличивающее шанс выздоровления с 40% до 80%, то для его клинических испытаний нужно всего 80 человек:

Видно, что математика, заложенная в СНП, адекватна клиническим испытаниям, но не интернет-маркетингу.

Lean-подходы

Проблемы СНП породили множество различных подходов. Основная черта которых – остановка теста при достижении какого-то условия. Например, шанса побить равного 95%.

Среди метрик остановки могут быть:

- шанс побить,

- p-value,

- статистическая значимость,

- доверительные интервалы.

Эти метрики выражают примерно одно и тоже – вероятность того, что один вариант лучше другого. Но они не учитывают на сколько лучше. Все эти метрики качественные (вероятностно-качественные), а не количественные.

Например, если конверсия одного варианта равна 1%, а второго 1.000001%, то нам по большому счету все равно, какой вариант выбрать. Однако, такие тесты при lean-подходе могут длиться очень долго. A/A тест может длиться бесконечно долго. Из-за чего на тесты, не повышающие нашу конверсию, мы тратим неоправданно много времени.

Все это рождает целый ряд проблем:

- Время между тестами распределяется не оптимально,

- Тест может “зависнуть”,

- Сильный разброс во времени проведения тестов.

Perfomance-подход

Сейчас я расскажу о новом подходе, который избавляет от недостатков других методик.

Основа перфоманс-подхода в том, что нужно выбрать цель, адекватную бизнес-задачам. Например, увеличить конверсию.

Цена спешки

Нам нужно ввести количественный показатель. Это одно из главных требований перфоманс-подхода в принципе.

В идеальном случае, мы проводим тест бесконечно долго и выбираем лучший вариант. Но на практике нам рано или поздно нужно прекратить тест.Поэтому существует вероятность ошибки (1 – шанс_побить). Шанс побить – это качественная метрика, и нам нужно учесть, как сильно вредит конверсии наша ошибка. Нужно помножить вероятность ошибки на ожидаемые потери от нее. Назовем это число «ценой спешки».

Цена спешки – это ожидаемые потери при остановке теста сейчас по сравнению с бесконечно долгим тестом. Т.е. продолжение теста улучшит конверсию в среднем не более чем на цену спешки.

Допустим, мы откуда-то узнали, что с вероятностью в 50% у варианта А конверсия равна 9% и с вероятностью в 50% равна 20%. А у варианта B равновероятны следующие конверсии 10% и 11%. Какова цена спешки у А, т.е. ожидаемые потери при выборе варианта A?

Получим 4 равновероятный комбинации

A |

B |

Потери |

|

9% |

10% |

1% (10%-9%) |

|

9% |

11% |

2% (11%-9%) |

|

20% |

10% |

0 (20%>10%) |

|

20% |

11% |

0 (20%>11%) |

В среднем потери составляют (1%+2%)/4 = 0.75%

Схема тестирования

- Выбираем допустимую цену спешки. Например, 0.01%. Это допустимые средние потери в конверсии из-за спешки из-за того, что наше время ограничено.

- Раз в семь дней смотрим, достигли ли мы хотя бы по десять конверсий в обоих вариантах. В этом случае смотрим цену спешки. Ее можно посчитать бесплатным онлайн-калькулятором.

- Если хотя-бы у одного из вариантов цена спешки меньше целевой, то останавливаем тест и выбираем вариант, в котором выше показатель конверсии.

Пример

Допустим, у нас есть сайт с конверсией 1% и 2000 кликов в день. Выбираем необходимую для завершения теста цену спешки. Например, 0.01%. Запускаем тест.

Через неделю получаем по 7000 кликов на каждом из вариантов. У первого варианта 66 конверсий, а у второго — 73. Вводим данные в калькулятор:

Поскольку 0.0087%

Время тестирования

Время тестирования можно вычислить по очень простой формуле. Для каждого варианта в среднем нужно следующее число кликов:

100 * Конверсия/цена спешки

Например, если у нас конверсия равна 1%, а цена спешки 0.01%, то получаем 100*(1/0,01)=10.000. Для каждого варианта нужно по 10 тыс. кликов.

Сравнение эффективности

Наше время ограничено, причем у нас есть несколько изменений, которые нужно проверить. Поэтому задачу А/Б тестирования можно свести к оптимальному распределению времени между тестами.

С помощью R-Studio я провел 100.000 серий по 3 A/B теста, чтобы протестировать оптимальное условие остановки.

|

|

Недели |

Финальная конверсия |

|

Каждый тест длится 5 недель |

15 ∓0 |

1.37% |

|

Шанс побить > 80% |

14.8 ∓24 |

1.37% |

|

Цена спешки |

14.7 ∓7 |

1.40% |

|

Теоретический максимум |

бесконечность |

1.46% |

Другие численные эксперименты показали, что остановка по цене спешки при любых входящих данных дает в среднем лучшую финальную конверсию, чем аналогичные методики.

Заключение

Перфоманс подход к А/B тестированию лучше существующих методик:

- Лучше распределяет время между тестами, что увеличивает скорость роста конверсии.

- Имеет более стабильное время тестирования, которое слабо зависит от отличий между вариантами.

- Нет зависаний при тестах близких к А/А.

- Более простая методика, в которой нет неприятных сюрпризов, когда тест не дает никаких результатов.

- Ниже требования к теоретической подготовке исполнителя.

А/Б-тестирование на уровне различных маркетинговых каналов: 3 реальных примера

А/Б-тестирование, также известное как сплит-тестирование – это инструмент исследования, которым должен владеть любой уважающий себя маркетолог. Используя его, вы сможете понять, насколько эффективны ваши маркетинговые усилия, и совершенствовать их, руководствуясь полученными выводами. Наверняка, многие из вас знают метод сплит-тестирования не понаслышке, и не раз применяли его в своей практике. Однако, у остальных этот термин до сих пор вызывает непонимание.

Итак, что же такое А/Б-тестирование? Это метод исследования, при котором маркетинговые переменные сравниваются друг с другом с целью определить вариант, который находит наибольший отклик у аудитории.

Как видно из названия, мы имеем дело с двумя переменными: А (исходный или контрольный вариант) и Б (новый или итоговый вариант). Они поочередно демонстрируются двум однородным группам потенциальных клиентов в течение определенного времени, пока не будет достигнута высокая степень статистической достоверности. Затем, полученные результаты сопоставляются, чтобы определить наиболее выигрышный вариант. В большинстве случаев, исследователи предполагают, что вариант Б изменит уровень конверсии в лучшую сторону (хотя подобные ожидания не всегда оправдываются).

Сфера применения А/Б-тестирования в интернет-маркетинге крайне обширна. Вы можете тестировать варианты заголовков посадочной страницы, лид-форм, изображений, баннеров, торговых призывов и т.д. В нашей статье мы подробнее остановимся на трех маркетинговых каналах (посадочной странице, электронной рассылке и призыве к действию, расположенном на продающих страницах сайта), а также приведем примеры соответствующих А/Б-тестов, которые проводились маркетинговыми специалистами компании HubSpot.

Посадочная страница

Посадочная страница – это, пожалуй, самый популярный и излюбленный объект А/Б-тестирования интернет-маркетологов. Это связано с тем, что она состоит из множества элементов: заголовка, подзаголовка, текста, кнопки призыва к действию, изображения, лид-формы и некоторых других. Более того, каждый из вышеперечисленных компонентов можно исследовать с разных сторон. Взять хотя бы заголовок: вы можете экспериментировать с его формулировкой, размером и цветом шрифта, расположением и т.д.

Как правило, А/Б-тестирование лэндингов проводится с использованием специальных приложений. Вот наиболее популярные примеры подобных инструментов: Google Analytics, Visual Website Optimizer, Optimizely, Unbounce и др.

Некоторые маркетологи предпочитают не разбивать посадочную страницу на отдельные части, а рассматривают ее как одну переменную. Поэтому при проведении А/Б-теста, они одновременно изменяют несколько параметров своего лэндинга.

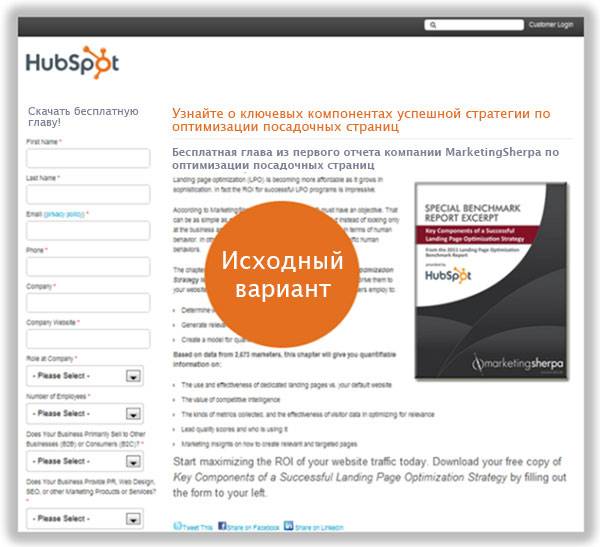

Подобный тест был проведен командой HubSpot в рамках конференции по оптимизации посадочной страницы. Участникам эксперимента (группе представителей ЦА) была предложена следующая исходная страница, и они должны были внести в нее изменения, которые, на их взгляд, скажутся положительным образом на уровне конверсии сайта:

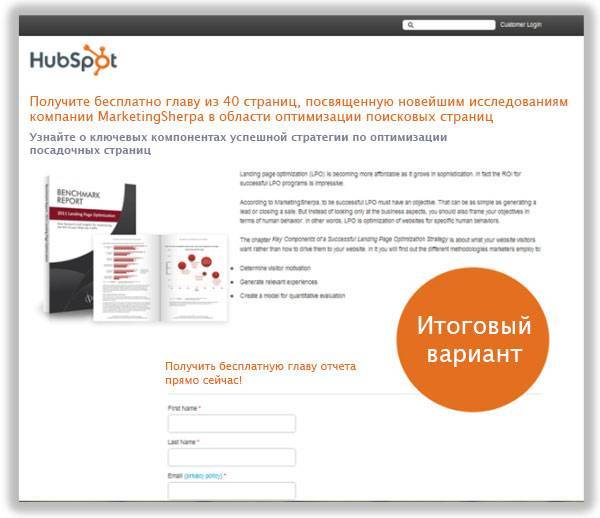

А вот итоговый вариант, получившийся в ходе целого ряда преобразований:

Как видите, страница приобрела совершенно новый вид. Во-первых, изменилось изображение, а также его положение на странице. Во-вторых, текст стал значительно короче. Сократилась и длина лид-формы, а также ее местоположение. В-третьих, изменилась формулировка заголовка.

Учитывая масштаб преобразований, можно было ожидать впечатляющих результатов повышения конверсии. Однако в реальности все вышло иначе. Результаты А/Б-теста показали, что уровень конверсии повысился на ничтожно маленькое значение – всего 0,33% (было 47.91%, стало 48,24%). Почему же так получилось?

Урок для маркетологов: оптимизируйте лишь те посадочные страницы, на которых действительно низкий уровень конверсии.

В данном случае, А/Б-тестирование провалилось по следующей причине: аудитория уже была заинтересована маркетинговым предложением (получить бесплатный материал), поэтому не придавала особого значения другим элементами посадочной страницы: длине текста и лид-формы, их расположению и т.д. Отсюда вывод: проводите А/Б-тесты только на посадочных страницах с относительно низким уровнем конверсии, ведь не так просто конкурировать с лэндингами, которые уже конвертирует более 47% от общего трафика.

Призыв к действию

Призыв к действию также предоставляет маркетологам большой простор для экспериментов. Вы можете изменить как его содержание (например, предложить своим читателям подписаться на новую рассылку), так и форму (использовать другой цвет и размер шрифта, изменить его положение на странице).

К примеру, специалисты компании HubSpot решили изменить срок действия своего маркетингового предложения и посмотреть, что из этого выйдет. Изначально, они предлагали бесплатную пробную версию своей программы на 7 дней. Им стало любопытно, увеличится ли число их подписчиков, если они продлят срок действия предложения до 30 дней:

Результаты теста показали, что продление срока действия бесплатного предложения до 30 дней привлекло много новых посетителей. При этом уровень конверсии сайта возрос на целых 110% (с 32,6% до 70,9%). Как видите, «щедрость» команды HubSpot окупилась сполна.

Урок для маркетологов: начинайте процесс оптимизации призыва к действию с тестирования вашего предложения.

Проанализировав данный А/Б-тест, можно сформулировать следующий вывод: тип вашего маркетингового предложения может оказать колоссальное влияние на процесс лидогенерации. Поэтому начинайте оптимизацию ваших призывов к действию с сопоставления различных маркетинговых предложений. Подобные эксперименты помогут вам лучше понять, что именно способствует превращению посетителей вашего сайта в лидов.

Электронная почта

Проводя А/Б-тесты, e-mail маркетологи чаще всего сравнивают различные варианты строки темы. И это не случайно, ведь правильно подобранная тема письма может привлечь внимание получателей и положительно повлиять на уровень кликабельности. Однако с помощью сплит-тестирования можно исследовать и другие аспекты электронных писем, например имя отправителя.

В 2011-м году, компания HubSpot решила проверить, действительно ли такой, на первый взгляд, несущественный нюанс, как имя отправителя, может повысить эффективность e-mail-рассылки. В имени отправителя сначала указывалось название компании “HubSpot”, а затем конкретное имя специалиста из отдела маркетинга. Вот, что получилось в итоге:

График показывает, что уровень кликабельности на ссылку в исходном варианте сообщения достигал 0,73%, а в итоговом варианте – 0,96%. Так что перед нами бесспорный победитель – вариант В (статистическая достоверность равна 99,9%).

Урок для маркетологов: ваше электронное сообщение с большей вероятностью вызовет интерес у клиентов, если вы отправите его от имени реального человека, а не компании.

Пожалуй, здесь и так все понятно. Люди больше доверяют письмам, полученным от конкретного человека, а не от абстрактной компании. Им хочется знать, кто именно вступает с ними в диалог. Так почему бы не удовлетворить их желание?

Тестируйте, делайте выводы и… еще раз тестируйте

А/Б-тестирование – это многогранный и довольно непредсказуемый метод исследования. Бывает, думаешь: «Вот этот заголовок точно «взорвет» уровень конверсии на моем сайте!», а в реальности все оказывается иначе. В лучшем случае, получаешь скромные результаты, а в худшем – никакие. Так что не стоит полагаться на свое субъективное мнение – лучше проверить все с помощью А/Б-тестирования, которое покажет вам истинное положение вещей.

Самое главное – не останавливаться на достигнутом. Допустим, вы перенесли кнопку призыва к действию в зону «первого экрана», за счет чего показатель конверсии вашего сайта увеличился на 50%. Это просто замечательно, поздравляем! Теперь, вы можете поэкспериментировать с ее цветом, например изменить его с серого на ярко-желтый. И вам необязательно ограничиваться сайтом: А/Б-тесты можно проводить и на страничках в социальных сетях, и в блоге и т.д. Как говорится, нет предела совершенству.

Перевод и адаптация материала Магдалены Георгиевой A/B Testing in Action: 3 Real-Life Marketing Experiments.

a-b-testirovanie-na-urovne-razlichnykh-marketingovykh-kanalov-3-realnykh-primeraОтветы на 20 самых распространенных вопросов по A/B тестированию

A/B тестирование — относительно новый, но очень эффективный инструмент повышения конверсии. В Google Trends интерес к нему растёт на 50-90 % в месяц. Это порождает много вопросов, ответы на которые непросто найти. Раньше было непросто найти.

Это один из самых эффективных методов повышения конверсии. A/B тестирование позволяет определить, какой вариант страницы лучше конвертирует посетителей в покупателей.

Таким образом, вы можете точно узнать как изменение дизайна страницы или какого-либо определенного элемента влияет на показатель конверсии. Мало того, что A/B тестирование позволяет изменять сайт только в лучшую сторону, так как все решения основываются на статистических данных, собранных в ходе эксперимента. Так это ещё позволяет избавиться от всех предположений и разногласий в вашей команде относительно сайта, когда каждый пытается навязать свою точку зрения.

A/B тестирование – это только цифры. Цифры, основанные на действиях посетителей. Результаты экспериментов говорят сами за себя и направляют вас на верный путь. Конечная цель A/B тестирования – повысить показатели прибыли, регистраций, скачиваний и т.п. И достигается эта цель за счёт полноценного понимания своей аудитории.

Как провести A/B тестирование сайта?

Есть два варианта: бесплатный и платный.

Бесплатно провести эксперимент можно с помощью Google Analytics Content Experiment либо самописных скриптов.Чтобы создать эксперимент через Google Analytics, нужно перейти во вкладку «Поведение» > «Эксперименты». И там уже можно создать эксперимент.

Что касается самописных скриптов для распределения трафика, то более подробную информацию можно найти здесь. Лично я никогда не пользовался этим вариантом и не собираюсь этого делать.

Главный недостаток этих двух вариантов – тестовые варианты страницы придётся создавать самостоятельно.

Фактически, нужно будет сверстать новую страницу с определённым изменением. Новая страница будет иметь ссылку типа www.boosta.ru/?variation=1. Ещё один недостаток бесплатных способов – отсутствие дополнительных функций, которые предоставляют сервисы.

Но гораздо удобнее и быстрее проводить эксперименты с помощью специальных сервисов:

- Changeagain.me (Наш сервис для тех, кто использует Google Analytics. Есть русскоязычная версия)

- Optimizely.com (Самая крупная компания в сфере A/B тестирования. Сконцентрирована на работе с крупными клиентами)

- VWO.com (Крупный игрок на рынке A/B тестирования с хорошим функционалом)

- Convert.com

Подробный список сервисов для A/B тестирования с описанием функционала и стоимостью можно найти здесь

В чём преимущества сервисов:

- простота создания тестовых вариантов через визуальный редактор (без знаний программирования)

- дополнительный функционал

- единовременная установка кода (эксперименты обновляются автоматически)

Главное преимущество сервисов для A/B тестов – визуальный редактор для создания тестовых вариантов

В некоторых средних/крупных компаниях разработчики пишут софт конкретно под свои потребности. Это вполне целесообразно, если функционала сервисов недостаточно. Сколько это стоит – сложно сказать. И тут уже в каждом конкретном примере нужно оценивать рациональность собственной разработки.

С чего лучше всего начать A/B тестирование?

В первую очередь нужно тестировать те элементы, которые напрямую влияют на конверсию. Это СТА-кнопки, формы на сайте, текстовые элементы на посадочной странице, изображения, видеоролики. Каждый перечисленный элемент играет важное значение в воронке продаж.

Попадая на страницу, посетитель чаще всего сталкивается с текстами (заголовки, подзаголовки, описания), изображениями, видеороликами продукта. С этого начинается знакомство с продуктом. Соответственно, изменяя эти элементы, можно влиять на его восприятие, первое впечатление.

Далее ему предлагается заполнить форму: оставить номер, свой e-mail, ввести личные данные и т.п. На этом этапе отваливается большое количество потенциальных клиентов. Соответственно оптимизация форм может значительно повысить конверсию.

После заполнения формы посетителю в любом случае необходимо отправить её и здесь уже происходит взаимодействие с СТА-кнопками (кнопками призыва к действию). Кликабельность кнопки может зависеть от текста, цвета, расположения, размера кнопки и т.п.

Таким образом, все эти элементы играют важную роль в процессе взаимодействия посетителя с сайтом. Поэтому начинать тестирование лучше с них. Запускать такие эксперименты относительно просто. И вероятность получения положительного/отрицательного результата гораздо выше.

Сколько изменений можно делать в тестовом варианте страницы?

Одно из правил A/B тестирования: 1 тест – 1 гипотеза.

Пример гипотезы: «Если мы уберём поле «Имя» из формы подписки, то больше людей будут заполнять форму, в результате чего увеличится база подписчиков». Правильный A/B тест подразумевает одно изменение. Анализируя результаты такого эксперимента, вы будете точно знать, что именно это изменение повлияло на конверсию.

Если в этом примере мы ещё изменим текст кнопки «Подписаться», её цвет, и текст, стимулирующий заполнить форму, то по окончанию эксперимента будет сложно сказать, что именно повлияло на показатель конверсии. Возможно, она увеличилась за счёт поясняющего текста, а измененная кнопка наоборот негативно повлияла на конверсию. Но первое перевесило второе. А, может, нет? Никто уже не узнает этого.

Как долго должен продолжаться эксперимент для получения достоверных результатов?

Минимальная длительность A/B теста – 7 дней.

Неделя выбрана не случайно, т.к. эксперимент будет показан в каждый день недели. 7 дней нужно ждать, т.к.

поведение посетителей может различаться в пятницу и субботу. В пятницу мы сидим на работе и выбираем, что купить, а в субботу, в спокойной обстановке, лёжа на диване, совершаем покупку. Или наоборот. Это неважно.

Факт остаётся фактом: поведение пользователей отличается в разные дни недели. Подтверждение ниже:

Это отчёт одного крупного интернет-магазина. В четверг конверсия почти в два раза выше, чем в субботу.

Если вы будете тестировать менее недели, то результаты могут быть неточными. Вообще, Peep Laja, эксперт в области увеличения конверсии и создатель соответствующего агентства ConversionXL , советует проводить A/B тест 2-4 недели для получения достоверных результатов.

Сколько трафика и конверсий нужно, чтобы провести A/B эксперимент правильно?

Недостаток трафика и конверсий – одна из самых главных проблем в A/B тестировании на небольших сайтах. Полагаться на результаты экспериментов с маленькой выборкой опасно. Слишком велика вероятность ошибки.

Часто говорят про 100 конверсий на каждый вариант страницы: оригинальный и тестовый. Но этого может быть недостаточно.

Если в оригинальном варианте количество конверсий 100, а в тестовом 110, то сделать достоверный вывод сложно.

С другой стороны, если разница между показателями значительная, например, 100 и 170 конверсий, и соблюдаются остальные условия (эксперимент длится не менее 7 дней, статистическая достоверность (значимость) более 95 %), то сделать достоверный вывод будет легко.

Здесь же стоит сказать и о статистической достоверности. Результат можно считать статистически достоверным, если мала вероятность его случайного возникновения. Во всех сервисах для A/B тестирования встроены алгоритмы, которые рассчитывают достоверность автоматически. Если же хотите лично перепроверить результат, то можете воспользоваться калькулятором компании Driveback.

Минимум 100 конверсий на каждый вариант. Статистическая достоверность – от 95 %

Как вы уже поняли, не получится провести достоверный эксперимент на сайте, где в день 1-2 конверсии. Слишком сложно будет получить достоверные результаты.

Нужно ли владеть навыками программирования для запуска A/B эксперимента?

Если запускать тесты через Google Analytics Content Experiment, собственные разработки или самописные скрипты, то без знаний программирования не обойтись.

Если использовать платные сервисы, то чаще всего можно обойтись без этого. При условии, что вы проводите не слишком сложные эксперименты, которые требуют использования JS/jQuery. Для большинства экспериментов визуального редактора достаточно. Все изменения делаются в режиме WYSIWYG (What You See Is What You Get – Что видите, то и получаете).

Каким образом происходит запуск эксперимента через специальные сервисы?

После создания тестового варианта в визуальном редакторе, настройки цели эксперимента, выбора таргетинга и других дополнительных функций, вам даётся специальный js-код. Этот код размещается в страницы, на которой вы собираетесь проводить A/B эксперимент. Код нужно обязательно разместить до закрывающего тега , иначе эксперимент либо вообще не будет работать, либо будет работать неправильно.

Ещё один важный нюанс установки кода – его нельзя вставлять на сайт через Google Tag Manager. Если поставить код через GTM, то при загрузке страницы будет происходить мигание, т.к. сначала будет загружаться оригинальная страница, а только потом тестовая.

Если вы имеете доступ к админке сайта и знаете, как его поставить в , то сами осилите эту задачу. Если нет, придётся просить программиста, который отвечает за ваш сайт. Хорошо то, что коды платных сервисов устанавливаются лишь один раз, после чего запуск эксперимента происходит автоматически, и уже не придётся дергать программиста.

После того, как код размещён на странице, весь трафик автоматически распределяется 50/50 (если вы тестируете 2 страницы: оригинал и тестовый вариант. При 3-ёх вариантах распределение будет следующим: 33%/33%/33%). Распределение происходит автоматически и абсолютно случайно через алгоритмы сервисов.

В начале эксперимента количество показов тестового и оригинального варианта может отличаться. Но по мере увеличения выборки эти цифры становятся практически одинаковыми. Тут та же ситуация, что и с подбрасыванием монетки. Подбросим больше – получим практически одинаковый результат. Подбросим 10 раз – может 7 раз выпасть один и тот же вариант.

A/B тесты негативно влияют на SEO-оптимизацию сайта?

A/B тесты никак не влияют на SEO-оптимизацию сайта. Это миф.

Этот факт был подтвержден ещё в 2012 году сотрудником компании Google.

Тестовый вариант загружается динамически, когда пользователь заходит на сайт. Для отображения используются Javascript и куки. А Googlebot и другие поисковики не поддерживают Javascript и куки. Поэтому они видят только оригинальный вариант. Благодаря этому можно спокойно делать A/B тесты.

A/B тестирование замедляет загрузку сайта?

При использовании сервисов для A/B тестирования или Google Analytics Content Experiment сайт грузится точно так же, как и в обычном режиме. Абсолютно ничего не меняется в плане скорости загрузки. Так происходит благодаря тому, что все сервисы используют асинхронный код, т.е. он не мешает загрузке других компонентов веб-страницы.

Откуда брать идеи для A/B тестирования?

Идеи для A/B тестов нужно брать из веб-аналитики, анализа поведения юзеров, общения с ними

Это идеальный вариант.

Для генерации хороших идей придётся воспользоваться дополнительными сервисами типа Google Analytics, Яндекс.Метрика, сервисами опросов и т.п.

У нас на сайте есть целый раздел, посвящённый инструментам для увеличения конверсии. Там вы можете более подробно ознакомиться со всеми сервисами.

Типичный пример генерации идей для A/B тестирования:

У вас на сайте есть форма регистрации. Заходим в Яндекс.Метрику и использует «Аналитику форм». В ходе анализа вы понимаете, что при заполнении поля «Компания», большинство людей стопорится. 50 % из них закрывают сайт. 50 % тратят на заполнение в два раза больше времени, чем на остальные поля формы.

Какой из этого можно сделать вывод?

Этот вопрос ставит в ступор ваших потенциальных клиентов. Если эта информация не является ключевой, то в тестовом варианте можно убрать это поле и посмотреть, как изменится количество регистраций.

Это простой пример гипотезы для A/B тестирования, основанный на анализе сайта.

Другой вариант – использование идей, которые работают на чужих сайтах. Мы составили огромный список из 100 идей для A/B тестов, которые были применены на практике. Здесь можно ознакомиться с ними:Часть первая и Часть вторая.

Но я советую вам не полагаться полностью на такие списки идей. Они могут направить ваши мысли в нужное русло, но просто взять оттуда идею и реализовать на своём сайте – это не самый лучший вариант.

Анализируйте свой сайт, анализируйте поведение пользователей на нём, общайтесь со своими потенциальными и текущими клиентами. И вы точно будете знать, что не так на сайте и что на нём можно изменить.

Можно ли полагаться на результаты чужих A/B экспериментов?

Чужие кейсы можно и нужно анализировать. Особенно, если это кейсы ваших конкурентов или компаний, которые работают в смежной отрасли или имеют одинаковую целевую аудиторию. Но полагаться полностью на чужие кейсы, как и на подборки идей, — это плохая практика.

Что работает на одном сайте, необязательно будет работать на другом. Каждый сайт индивидуален. Целевая аудитория разная. Взаимодействие с ней – разное. Реализация чужого успешного кейса может даже негативно повлиять на эффективность сайта. Поэтому никогда не полагайтесь на 100 % на результаты чужих тестов.

Тестируйте всё сами и только на основе этого делайте вывод об эффективности изменений.

Статья в тему: 10 успешных кейсов A/B тестирования

Какие A/B эксперименты чаще всего приносят положительный результат?

Если вкратце, то в большинстве A/B тестов положительно работают следующие идеи:

- Статическое изображение с одним УТП лучше, чем автоматический слайдер с несколькими УТП

- Меню в стиле «Гамбургер» + слово «Меню» работает лучше, что просто гамбургер

- Фиксированные хедер (шапка) или футер (подвал) с призывом к действию («Подписаться», «Заказать звонок» и т.п.) всегда увеличивают конверсию

- Видео с описанием продукта/услуги положительно влияют на конверсию

- Уменьшение количества полей в формах

- Размещений контактной информации всегда заметной для посетителя

- Живой чат

- Использование реальных отзывов работает лучше, чем их полное отсутствие

- Добавление возможности совершить покупку без регистрации. Покупаешь в режиме «гостя», и только потом тебя просят зарегистрироваться.

- Бесплатная доставка

Как правильно анализировать результаты A/B тестов?

При создании эксперимента всегда выбирается 1 цель (в некоторых сервисах есть возможность выбрать сразу несколько целей), по которой будет измеряться успешность эксперимента. Например, кликабельность кнопки «Узнать цену» (1-ый этап воронки продаж).

Анализ эксперимента начинается именно с этого показателя. Если он увеличился и все условия A/B тестирования соблюдены – окей, поздравляю! Скорее всего, вы провели успешный A/B тест. Но! На этом анализ не заканчивается.

Если вы делаете A/B тест через Google Analytics, Changeagain.me или другие сервисы, где реально настроить интеграцию с GA, то у вас есть возможность провести подробный анализ эксперимента.

А именно вы можете:

- посмотреть, как изменились показатели конверсии других целей, установленных на этом сайте

- применить любой сегмент к результатам эксперимента и сделать анализ в разрезе отдельных групп пользователей

- посмотреть, как изменились базовые показатели взаимодействия с сайтом – показатель отказов, средняя продолжительность сеанса, среднее количество просмотренных страниц.

Анализ влияния на другие цели в воронке продаж – очень важный нюанс при работе с результатами A/B эксперимента. Если этого не делать, то можно оказаться в ситуации, когда кликабельность на первом этапе воронки продаж увеличилась, а конверсия на последнем этапе – уменьшилась.

Вот очень показательный кейс на эту тему. Всем урок, так сказать – Самая большая ошибка в A/B тестировании

Можно ли проводить параллельно несколько тестов?

Да, можно. Но есть один очень важный нюанс. Аудитория этих A/B тестов не должна пересекаться. Если она не пересекается, то всё окей. Делайте хоть сколько экспериментов одновременно.

Если пересекается, то возникает проблема. Например, на главной странице посетитель может увидеть тестовый вариант страницы. Далее, во втором эксперименте, на следующей странице он увидит оригинальную версию, а в третьем эксперименте – опять тестовую. В итоге получается полная путаница. В конечном счёте, это повлияет на достоверность результатов.

Можно ли получить быстрые результаты от A/B тестирования?

Нет. Скорее всего, у вас не получится за счёт одного эксперимента повысить конверсию сайта и улучшить эффективность бизнеса.

Это не волшебная пилюля, которая помогает решить все проблемы на сайте. Большая часть A/B экспериментов не будут успешными.

Чтобы A/B тестирование было успешным, нужно систематично работать над этим. Нужно тестировать гипотезу за гипотезой, делать выводы и продолжать тестирование. Только в таком случае оно будет приносить результаты.

Кстати, неудачные A/B тесты – это тоже отличный источник информации о своей целевой аудитории. Вы узнаете, что гипотеза не сработала, значит, это изменение никак не влияет на поведение пользователей. После этого гипотезу можно вычеркнуть из плана и идти дальше к пониманию аудитории.

Как часто нужно проводить A/B тесты?

В идеале, тесты нужно проводить постоянно, один за другим. Схема работы над увеличением конверсии должна представлять нечто подобное: Формулировка гипотеза – Приоретизация гипотез – Тестирование гипотезы – Сбор данных – Анализ данных – Тестирование другой гипотезы (при этом учитывая результаты предыдущих экспериментов)

Если вы не проводите тесты на сайте, то фактически каждый день упускаете возможность увеличить конверсию сайта. Трафик постоянно идёт, а вы не пользуетесь моментом. Это что-то вроде упущенной выгоды: в вашем бизнесе всё круто, но ведь может быть и лучше.

Чем A/B тестирование отличается от мультивариантого и сплит-тестирования?

A/B тестирование: В тестовом варианте(ах) меняется только один элемент (Например, кнопка «Оформить заказ» вместо «Купить»).

Сплит-тестирование: Тестовый вариант(ы), как правило, сильно отличается от оригинальной версии, т.е. изменено много элементов на странице. В сплит-тестировании изменения делаются не в визуальном редакторе, а подготавливаются разработчиками сайта. После этого тестовому варианту присваивается ссылка типа Boosta.ru/?variation-1 и весь трафик распределяется между оригиналом и тестовым вариантом(ами).

Мультивариантное тестирование: В тестовых вариантах используются различные комбинации изменений (Например, 4 варианта текста заголовка и 6 вариантов текста кнопки – в итоге получается 24 тестовых варианта. Вот пример мультивариантного тестирования президенсткой кампании Барака Обамы.

Недостаток мультивариантного тестирования – для его проведения нужен большой объём трафика. Очень большой объём трафика, если у вас так же, как и у Обамы, будет 24 тестовых варианта.

Кроме страниц сайта, что ещё можно тестировать?

A/B тесты можно проводить не только на сайтах. Также у вас есть возможность тестировать:

Источник

Байесовские многорукие бандиты против A/B тестов / Open Data Science corporate blog / Habr

Здравствуйте, коллеги. Рассмотрим обычный онлайн-эксперимент в некоторой компании «Усы и когти». У неё есть веб-сайт, на котором есть красная кнопка в форме прямоугольника с закругленными краями. Если пользователь нажимает на эту кнопку, то где-то в мире мурлычет от радости один котенок. Задача компании — максимизация мурлыкания. Также есть отдел маркетинга, который усердно исследует формы кнопок и то, как они влияют на конверсию показов в клико-мурлыкания. Потратив почти весь бюджет компании на уникальные исследования, отдел маркетинга разделился на четыре противоборствующие группировоки. У каждой группировки есть своя гениальная идея того, как должна выглядеть кнопка. В целом никто не против формы кнопки, но красный цвет раздражает всех маркетологов, и в итоге было предложено четыре альтернативных варианта. На самом деле, даже не так важно, какие именно это варианты, нас интересует тот вариант, который максимизирует мурлыкания. Маркетинг предлагает провести A/B/n-тест, но мы не согласны: и так на эти сомнительные исследования спущено денег немерено. Попробуем осчастливить как можно больше котят и сэкономить на трафике. Для оптимизации трафика, пущенного на тесты, мы будем использовать шайку многоруких байесовских бандитов (bayesian multi-armed bandits). Вперед.

Будем считать, что клик — это некоторая случайная переменная , принимающая значения или с вероятностями и соответственно. Такая величина имеет распределение Бернулли с параметром :

Вспомним, что среднее значение распределения Бернулли равно , а дисперсия равна .

Попробуем для начала решить проблему с помощью обычного A/B/n-теста, n здесь означает, что тестируются не две гипотезы, а несколько. В нашем случае это пять гипотез. Но мы рассмотрим сначала ситуацию тестирования старого решения против нового, а затем обобщим на все пять случаев. В бинарном случае у нас есть две гипотезы:

Мы не можем знать истинное значение конверсии на текущей вариации кнопки (на красной), но мы можем его оценить. Для этого у нас есть два механизма, которые работают сообща. Во-первых, это закон больших чисел, который утверждает, что какое бы ни было распределение случайной величины, если мы посемплируем достаточное количество примеров и усредним, то такая оценка будет близка к истинному значению среднего значения распределения (опустим пока индекс для ясности):

Во-вторых, это центральная предельная теорема, которая утверждает следующее: допустим, есть бесконечный ряд независимых и одинаково распределенных случайных величин , с истинным матожиданием и дисперсией . Обозначим конечную сумму как , тогда

или эквивалентно тому, что при достаточно больших выборках оценка среднего значения имеет нормальное распределение с центром в и дисперсией :

Казалось бы, бери да запускай два теста: раздели трафик на две части, жди пару дней, и сравнивай средние значения кликов по первому механизму. Второй механизм позволяет нам применять t-тест для оценки статистической значимости разницы средних значений выборок (потому что оценки средних имеют нормальное распределение). А также, увеличивая размер выборки , мы уменьшаем дисперсию оценки среднего, тем самым увеличивая свою уверенность. Но остается один важный вопрос: а какое количество трафика (пользователей) пустить на каждую вариацию кнопки? Статистика нам говорит, что если разница не нулевая, то это еще совсем не значит, что значения не равны. Возможно, просто не повезло, и первые пользователей люто ненавидели какой-то цвет, и нужно подождать еще. И возникает вопрос, а сколько пользователей пустить на каждую вариацию кнопки, чтобы быть уверенным, что если разница и есть, то она существенная. Для этого нам придется еще раз встретиться с отделом маркетинга и задать им несколько вопросов, и, вероятно, нам придется им объяснить, что такое ошибки первого и второго рода. В общем, это может быть чуть ли не самым сложным во всем тесте. Итак, вспомним, что это за ошибки, и определим вопросы, которые следует задать отделу маркетинга, чтобы оценить количество трафика на вариацию. В конечном счете именно маркетинг принимает окончательно решение о том, какой цвет кнопки оставить.

Введем еще несколько понятий. Обозначим вероятность ошибки первого рода как , т.е. вероятность принятия альтернативной гипотезы при условии, что на самом деле верна нулевая гипотеза. Эта величина называется статистической значимостью (statistical significance). Также нам понадобится ввести вероятность ошибки второго рода . Величина называется статистической мощностью (statistical power).

Рассмотрим изображение ниже, чтобы проиллюстрировать смысл статистической значимости и мощности. Предположим, что среднее значение распределения случайной величины на контрольной группе равно , а на тестовой . Выберем некоторый критический порог выше которого гипотеза отвергается (вертикальная зеленая линия). Тогда если значение было правее порога, но из распределения контрольной группы, то мы его ошибочно припишем к распределению тестовой группы. Это будет ошибка первого рода, а значение — это площадь, закрашенная красным цветом. Соответственно, площадь области, закрашенной синим цветом, равна . Величина , которую мы назвали статистической мощностью, по сути показывает, сколько значений, соответствующих альтернативной гипотезе, мы действительно отнесем к альтернативной гипотезе. Проиллюстрируем вышеописанное.

# средние значение двух распределений

mu_c = 0.1

mu_t = 0.6

# дисперсии двух распределений

s_c = 0.25

s_t = 0.3

# порог: наблюдая значение исследуемой величины выше этого порога,

# мы относим ее к синему распределению

c = 1.3*(mu_c + mu_t)/2Отрисовка графика

support = np.linspace(

stats.norm.ppf(0.0001, loc=mu_c, scale=s_c),

stats.norm.ppf(1 - 0.0005, loc=mu_t, scale=s_t), 1000)

y1 = stats.norm.pdf(support, loc=mu_c, scale=s_c)

y2 = stats.norm.pdf(support, loc=mu_t, scale=s_t)

fig, ax = plt.subplots()

ax.plot(support, y1, color='r', label='y1: control')

ax.plot(support, y2, color='b', label='y2: treatment')

ax.set_ylim(0, 1.1*np.max([

stats.norm.pdf(mu_c, loc=mu_c, scale=s_c),

stats.norm.pdf(mu_t, loc=mu_t, scale=s_t)

]))

ax.axvline(c, color='g', label='c: critical value')

ax.axvline(mu_c, color='r', alpha=0.3, linestyle='--', label='mu_c')

ax.axvline(mu_t, color='b', alpha=0.3, linestyle='--', label='mu_t')

ax.fill_between(support[support <= c],

y2[support <= c],

color='b', alpha=0.2, label='b: power')

ax.fill_between(support[support >= c],

y1[support >= c],

color='r', alpha=0.2, label='a: significance')

ax.legend(loc='upper right', prop={'size': 20})

ax.set_title('A/B test setup for sample size estimation', fontsize=20)

ax.set_xlabel('Values')

ax.set_ylabel('Propabilities')

plt.show()Обозначим этот порог буквой . Справедливо следующее равенство при условии, что случайная величина имеет нормальное распределение:

где — это квантильная функция.

В нашем случае мы можем записать систему из двух уравнений для и соответственно: